网络爬虫(python实现)

- 格式:pptx

- 大小:828.10 KB

- 文档页数:10

基于Python的网络爬虫技术综述【摘要】网络爬虫是一种自动化获取网页内容的技术,在现代互联网时代发挥着重要作用。

本文围绕基于Python的网络爬虫技术展开综述,包括网络爬虫的概念、Python在网络爬虫中的应用、工作原理、发展趋势和应用领域等内容。

通过对这些方面的分析和总结,我们可以深入了解网络爬虫技术的发展和应用现状,为相关研究和实践提供参考。

值得注意的是,随着互联网的不断发展,网络爬虫技术也将不断演化和创新,为信息检索、数据挖掘等领域带来更多可能。

未来,我们可以更加深入地探讨网络爬虫技术在实际应用中的挑战和机遇,为该领域的进一步研究和发展提供新的思路和方向。

【关键词】网络爬虫技术、Python、概念、应用、工作原理、发展趋势、应用领域、总结、展望、研究展望、研究背景、研究目的、研究意义1. 引言1.1 研究背景以往的网络爬虫技术主要侧重于搜索引擎、数据采集等方面,但随着人工智能、大数据等技术的不断发展,网络爬虫的应用领域和功能需求也在不断扩展和深化。

对基于Python的网络爬虫技术进行深入研究和探讨,有助于揭示其在当前互联网背景下的应用前景和发展趋势,为解决实际问题提供更为有效的技术支持。

本文旨在对基于Python的网络爬虫技术进行综述,探讨其在不同领域的应用及未来发展方向,希望能为相关领域的研究和实践提供一定的参考和借鉴。

1.2 研究目的研究目的是为了深入探讨基于Python的网络爬虫技术,从而进一步推动这一技术的发展和应用。

通过对网络爬虫技术的原理和应用进行系统性的整理和总结,可以帮助研究者更好地理解和掌握网络爬虫技术的关键技术和方法,提高信息获取的效率和准确性。

通过对网络爬虫的发展趋势和应用领域进行分析和展望,可以为相关研究和应用提供参考和借鉴,促进网络爬虫技术在各个领域的广泛应用和推广。

本文的研究目的在于全面了解和探讨基于Python的网络爬虫技术,为相关研究和实践提供有益的参考和指导。

Python网络爬虫中的在线视频与直播数据抓取随着互联网和数字技术的快速发展,在线视频和直播已经成为人们日常娱乐和获取信息的重要方式。

Python作为一种强大的编程语言,可以用于实现网络爬虫,并能够帮助我们抓取在线视频和直播数据,为用户提供更好的观看体验和使用感受。

本文将介绍Python网络爬虫中抓取在线视频和直播数据的方法和技巧。

一、在线视频数据抓取在网络上,有许多平台提供了丰富多样的在线视频资源,如优酷、腾讯视频、爱奇艺等。

我们可以利用Python编写网络爬虫程序,来抓取这些平台上的视频数据。

1. 网页分析与解析首先,我们需要通过发送HTTP请求,获取目标网页的HTML源代码。

然后,利用Python中的解析库(如BeautifulSoup、lxml等)对源代码进行解析和提取,从而获取视频的相关信息,如标题、播放量、评论等。

2. URL拼接与下载接下来,我们需要从视频信息中提取出视频的URL链接。

有些平台可能会对视频链接进行加密或者隐藏,我们可以通过分析网页中的JavaScript脚本,来获取真实的视频链接。

获取到视频链接后,我们可以使用Python的下载库(如requests、urllib等)来进行视频的下载。

3. 视频解码与播放在下载完成后,视频文件通常是经过编码的,我们可以使用Python 的解码库(如ffmpeg、cv2等)来进行视频解码工作,并通过Python 的图形库(如opencv、pygame等)来进行视频的播放。

二、直播数据抓取与在线视频不同,直播数据是实时生成的,我们需要通过爬虫程序来实时抓取直播平台上的数据。

1. 弹幕数据抓取直播平台上,观众可以实时发送消息,这些消息通常以弹幕的形式出现在视频画面上。

我们可以通过网络爬虫程序抓取直播平台的弹幕数据,进而进行分析和处理。

2. 实时数据采集与展示除了弹幕数据,直播平台上还会提供其他实时数据,如在线观看人数、点赞数量等。

我们可以编写爬虫程序,实时获取这些数据,并通过可视化工具(如matplotlib、Tableau等)进行展示和分析。

python爬虫的实验报告一、实验目的随着互联网的迅速发展,大量有价值的数据散落在各个网站中。

Python 爬虫作为一种获取网络数据的有效手段,具有广泛的应用前景。

本次实验的目的是通过使用 Python 编写爬虫程序,深入理解网络爬虫的工作原理,掌握基本的爬虫技术,并能够成功获取指定网站的数据。

二、实验环境1、操作系统:Windows 102、开发工具:PyCharm3、编程语言:Python 3x三、实验原理网络爬虫的基本原理是模拟浏览器向服务器发送请求,获取服务器返回的 HTML 页面,然后通过解析 HTML 页面提取所需的数据。

在Python 中,可以使用`requests`库发送请求,使用`BeautifulSoup`或`lxml`库解析 HTML 页面。

四、实验步骤(一)安装所需库首先,需要安装`requests`、`BeautifulSoup4`和`lxml`库。

可以通过以下命令使用`pip`安装:```pip install requestspip install beautifulsoup4pip install lxml```(二)分析目标网站选择一个要爬取的目标网站,例如具体网站地址。

对该网站的页面结构进行分析,确定要获取的数据所在的位置以及页面的链接规律。

(三)发送请求获取页面使用`requests`库发送 HTTP 请求获取目标页面的 HTML 内容。

以下是一个简单的示例代码:```pythonimport requestsdef get_html(url):response = requestsget(url)if responsestatus_code == 200:return responsetextelse:print("请求失败,状态码:", responsestatus_code)return Noneurl =""html = get_html(url)```(四)解析页面提取数据使用`BeautifulSoup`或`lxml`库对获取到的 HTML 内容进行解析,提取所需的数据。

Python 网络爬虫练习题及答案网络爬虫是一种自动化程序,用于从互联网上抓取数据。

Python 作为一种简洁而强大的编程语言,被广泛应用于网络爬虫开发。

本文将介绍几个 Python 网络爬虫的练习题,并提供相应的答案。

1. 练习题:抓取网页标题编写一个 Python 程序,实现如下功能:- 输入一个网页的 URL;- 程序自动抓取该网页的标题内容,并将其打印出来。

答案:```pythonimport requestsfrom bs4 import BeautifulSoupdef get_page_title(url):try:response = requests.get(url)soup = BeautifulSoup(response.content, 'html.parser')title = soup.title.stringprint("网页标题:", title)except:print("无法访问该网页或获取标题失败")url = input("请输入要抓取的网页 URL:")get_page_title(url)```2. 练习题:抓取网页图片编写一个 Python 程序,实现如下功能:- 输入一个网页的 URL;- 程序自动抓取该网页中的所有图片,并将其保存到本地。

答案:```pythonimport requestsfrom bs4 import BeautifulSoupimport osdef download_images(url):try:response = requests.get(url)soup = BeautifulSoup(response.content, 'html.parser')img_tags = soup.find_all('img')for i, img_tag in enumerate(img_tags):img_url = img_tag['src']response = requests.get(img_url)if response.status_code == 200:with open(f'img_{i}.jpg', 'wb') as f:f.write(response.content)except:print("无法访问该网页或获取图片失败")url = input("请输入要抓取的网页 URL:")download_images(url)```3. 练习题:抓取网页新闻编写一个 Python 程序,实现如下功能:- 输入一个新闻网站的 URL;- 程序自动抓取该网站的新闻标题和摘要,并将其打印出来。

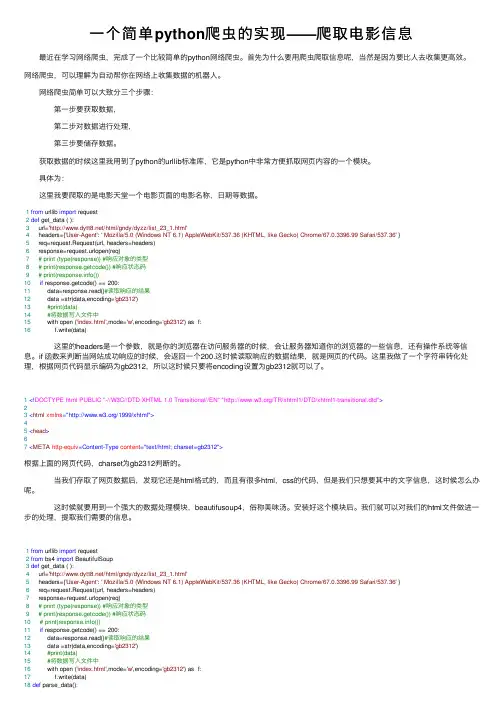

⼀个简单python爬⾍的实现——爬取电影信息 最近在学习⽹络爬⾍,完成了⼀个⽐较简单的python⽹络爬⾍。

⾸先为什么要⽤爬⾍爬取信息呢,当然是因为要⽐⼈去收集更⾼效。

⽹络爬⾍,可以理解为⾃动帮你在⽹络上收集数据的机器⼈。

⽹络爬⾍简单可以⼤致分三个步骤: 第⼀步要获取数据, 第⼆步对数据进⾏处理, 第三步要储存数据。

获取数据的时候这⾥我⽤到了python的urllib标准库,它是python中⾮常⽅便抓取⽹页内容的⼀个模块。

具体为: 这⾥我要爬取的是电影天堂⼀个电影页⾯的电影名称,⽇期等数据。

1from urllib import request2def get_data ( ):3 url='/html/gndy/dyzz/list_23_1.html'4 headers={'User-Agent': ' Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/67.0.3396.99 Safari/537.36' }5 req=request.Request(url, headers=headers)6 response=request.urlopen(req)7# print (type(response)) #响应对象的类型8# print(response.getcode()) #响应状态码9# print(())10if response.getcode() == 200:11 data=response.read()#读取响应的结果12 data =str(data,encoding='gb2312')13#print(data)14#将数据写⼊⽂件中15 with open ('index.html',mode='w',encoding='gb2312') as f:16 f.write(data) 这⾥的headers是⼀个参数,就是你的浏览器在访问服务器的时候,会让服务器知道你的浏览器的⼀些信息,还有操作系统等信息。

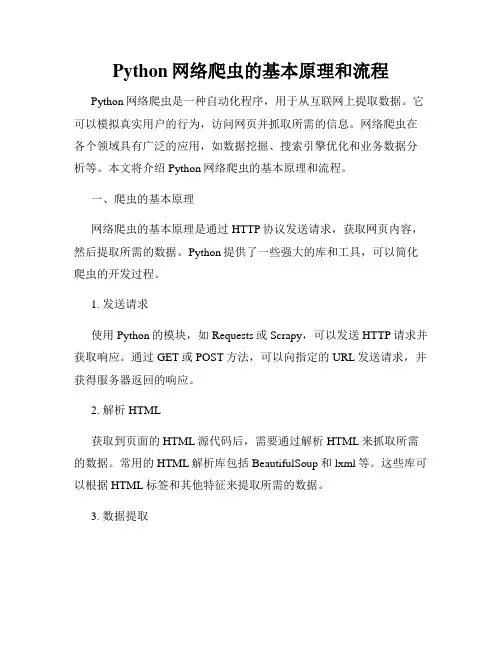

Python网络爬虫的基本原理和流程Python网络爬虫是一种自动化程序,用于从互联网上提取数据。

它可以模拟真实用户的行为,访问网页并抓取所需的信息。

网络爬虫在各个领域具有广泛的应用,如数据挖掘、搜索引擎优化和业务数据分析等。

本文将介绍Python网络爬虫的基本原理和流程。

一、爬虫的基本原理网络爬虫的基本原理是通过HTTP协议发送请求,获取网页内容,然后提取所需的数据。

Python提供了一些强大的库和工具,可以简化爬虫的开发过程。

1. 发送请求使用Python的模块,如Requests或Scrapy,可以发送HTTP请求并获取响应。

通过GET或POST方法,可以向指定的URL发送请求,并获得服务器返回的响应。

2. 解析HTML获取到页面的HTML源代码后,需要通过解析HTML来抓取所需的数据。

常用的HTML解析库包括BeautifulSoup和lxml等。

这些库可以根据HTML标签和其他特征来提取所需的数据。

3. 数据提取在解析HTML的基础上,可以使用CSS选择器或XPath表达式来定位和提取特定的数据。

这些工具提供了灵活的方式来选择DOM元素,并获取其对应的值。

4. 数据存储一旦获取了所需的数据,可以将其存储到数据库或文件中。

Python提供了各种数据库和文件处理的库,如MySQL、MongoDB和CSV等。

二、爬虫的基本流程Python网络爬虫的基本流程包括以下几个步骤:1. 发送请求使用Python的Requests库,通过GET或POST方法向目标网站发送请求。

可以设置请求头部信息,模拟真实用户的行为。

2. 获取响应收到服务器的响应后,可以获取页面的HTML源码。

通过解码和解析HTML,可以获取页面中的各种元素和数据。

3. 解析HTML使用合适的HTML解析库,如BeautifulSoup或lxml,解析HTML源码,并根据预先定义好的规则提取所需的数据。

4. 数据提取通过CSS选择器或XPath表达式,定位和提取特定的数据。

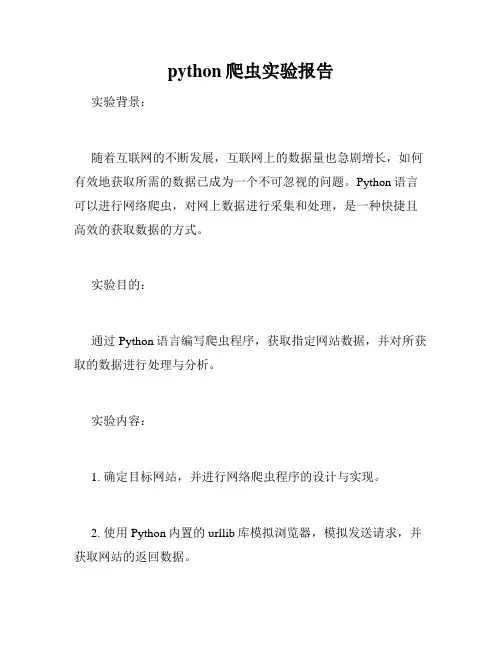

python爬虫实验报告实验背景:随着互联网的不断发展,互联网上的数据量也急剧增长,如何有效地获取所需的数据已成为一个不可忽视的问题。

Python语言可以进行网络爬虫,对网上数据进行采集和处理,是一种快捷且高效的获取数据的方式。

实验目的:通过Python语言编写爬虫程序,获取指定网站数据,并对所获取的数据进行处理与分析。

实验内容:1. 确定目标网站,并进行网络爬虫程序的设计与实现。

2. 使用Python内置的urllib库模拟浏览器,模拟发送请求,并获取网站的返回数据。

3. 对获取到的数据进行初步处理,如过滤无用数据、提取有用数据等。

4. 将处理后的数据存储在数据库中,以备后续的分析和使用。

实验步骤:1. 确定要爬取的目标网站,查看该网站的robots.txt文件,了解是否能进行爬取。

2. 使用Python内置的urllib库,构建一个请求对象,模拟浏览器访问目标网站,获取网站的返回数据。

3. 对获取到的数据进行初步处理,如去除无用的html标签、提取有用的数据信息等。

4. 将处理后的数据保存在数据库中,以备后续的分析和使用。

5. 对所获得的数据进行进一步的分析和处理,如数据可视化、数据挖掘等。

6. 最终将分析和处理后的数据呈现在前端页面上,供用户访问和使用。

实验结果:本次实验使用Python编写的爬虫程序成功地获取了指定网站数据,并对所获取的数据进行了处理与分析。

通过此次实验,我们掌握了Python网络爬虫的基本原理和方法,以及如何使用Python 进行数据的处理与分析。

结论:通过此次实验,我们深入了解了Python在网络爬虫和数据处理方面的应用,这将为我们在更广泛的领域中进行数据的获取和处理提供强有力的技术支持。

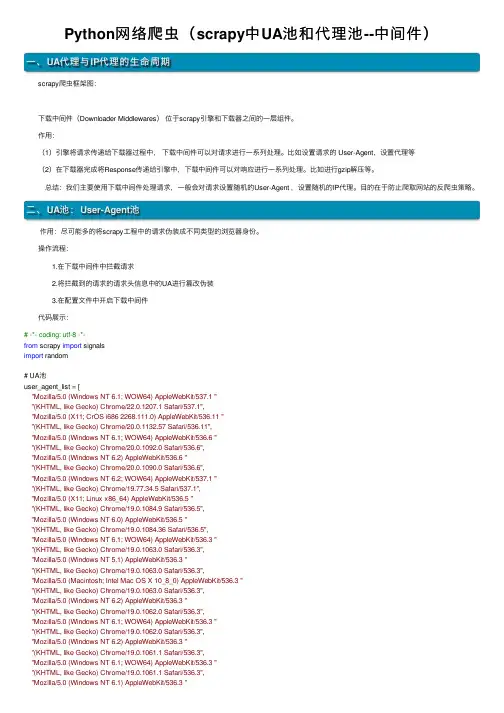

Python⽹络爬⾍(scrapy中UA池和代理池--中间件)⼀、UA代理与IP代理的⽣命周期 scrapy爬⾍框架图: 下载中间件(Downloader Middlewares)位于scrapy引擎和下载器之间的⼀层组件。

作⽤:(1)引擎将请求传递给下载器过程中,下载中间件可以对请求进⾏⼀系列处理。

⽐如设置请求的 User-Agent,设置代理等(2)在下载器完成将Response传递给引擎中,下载中间件可以对响应进⾏⼀系列处理。

⽐如进⾏gzip解压等。

总结:我们主要使⽤下载中间件处理请求,⼀般会对请求设置随机的User-Agent ,设置随机的IP代理。

⽬的在于防⽌爬取⽹站的反爬⾍策略。

⼆、UA池:User-Agent池 作⽤:尽可能多的将scrapy⼯程中的请求伪装成不同类型的浏览器⾝份。

操作流程: 1.在下载中间件中拦截请求 2.将拦截到的请求的请求头信息中的UA进⾏篡改伪装 3.在配置⽂件中开启下载中间件 代码展⽰:# -*- coding: utf-8 -*-from scrapy import signalsimport random# UA池user_agent_list = ["Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.1 ""(KHTML, like Gecko) Chrome/22.0.1207.1 Safari/537.1","Mozilla/5.0 (X11; CrOS i686 2268.111.0) AppleWebKit/536.11 ""(KHTML, like Gecko) Chrome/20.0.1132.57 Safari/536.11","Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/536.6 ""(KHTML, like Gecko) Chrome/20.0.1092.0 Safari/536.6","Mozilla/5.0 (Windows NT 6.2) AppleWebKit/536.6 ""(KHTML, like Gecko) Chrome/20.0.1090.0 Safari/536.6","Mozilla/5.0 (Windows NT 6.2; WOW64) AppleWebKit/537.1 ""(KHTML, like Gecko) Chrome/19.77.34.5 Safari/537.1","Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/536.5 ""(KHTML, like Gecko) Chrome/19.0.1084.9 Safari/536.5","Mozilla/5.0 (Windows NT 6.0) AppleWebKit/536.5 ""(KHTML, like Gecko) Chrome/19.0.1084.36 Safari/536.5","Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/536.3 ""(KHTML, like Gecko) Chrome/19.0.1063.0 Safari/536.3","Mozilla/5.0 (Windows NT 5.1) AppleWebKit/536.3 ""(KHTML, like Gecko) Chrome/19.0.1063.0 Safari/536.3","Mozilla/5.0 (Macintosh; Intel Mac OS X 10_8_0) AppleWebKit/536.3 ""(KHTML, like Gecko) Chrome/19.0.1063.0 Safari/536.3","Mozilla/5.0 (Windows NT 6.2) AppleWebKit/536.3 ""(KHTML, like Gecko) Chrome/19.0.1062.0 Safari/536.3","Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/536.3 ""(KHTML, like Gecko) Chrome/19.0.1062.0 Safari/536.3","Mozilla/5.0 (Windows NT 6.2) AppleWebKit/536.3 ""(KHTML, like Gecko) Chrome/19.0.1061.1 Safari/536.3","Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/536.3 ""(KHTML, like Gecko) Chrome/19.0.1061.1 Safari/536.3","Mozilla/5.0 (Windows NT 6.1) AppleWebKit/536.3 ""(KHTML, like Gecko) Chrome/19.0.1061.1 Safari/536.3","Mozilla/5.0 (Windows NT 6.2) AppleWebKit/536.3 ""(KHTML, like Gecko) Chrome/19.0.1061.0 Safari/536.3","Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/535.24 ""(KHTML, like Gecko) Chrome/19.0.1055.1 Safari/535.24","Mozilla/5.0 (Windows NT 6.2; WOW64) AppleWebKit/535.24 ""(KHTML, like Gecko) Chrome/19.0.1055.1 Safari/535.24"]class ImgpilelineproDownloaderMiddleware(object):# 拦截正常的请求def process_request(self, request, spider):# UA伪装request.headers['User-Agent'] = random.choice(user_agent_list)return None# 拦截响应def process_response(self, request, response, spider):return response# 拦截发⽣异常的请求对象def process_exception(self, request, exception, spider):return request # 重新发送请求三、IP代理池 作⽤:尽可能多的将scrapy⼯程中的请求的IP设置成不同的。

python7个爬虫小案例详解(附源码)Python 7个爬虫小案例详解(附源码)1. 爬取百度贴吧帖子使用Python的requests库和正则表达式爬取百度贴吧帖子内容,对网页进行解析,提取帖子内容和发帖时间等信息。

2. 爬取糗事百科段子使用Python的requests库和正则表达式爬取糗事百科段子内容,实现自动翻页功能,抓取全部内容并保存在本地。

3. 抓取当当网图书信息使用Python的requests库和XPath技术爬取当当网图书信息,包括书名、作者、出版社、价格等,存储在MySQL数据库中。

4. 爬取豆瓣电影排行榜使用Python的requests库和BeautifulSoup库爬取豆瓣电影排行榜,并对数据进行清洗和分析。

将电影的名称、评分、海报等信息保存到本地。

5. 爬取优酷视频链接使用Python的requests库和正则表达式爬取优酷视频链接,提取视频的URL地址和标题等信息。

6. 抓取小说网站章节内容使用Python的requests库爬取小说网站章节内容,实现自动翻页功能,不断抓取新的章节并保存在本地,并使用正则表达式提取章节内容。

7. 爬取新浪微博信息使用Python的requests库和正则表达式爬取新浪微博内容,获取微博的文本、图片、转发数、评论数等信息,并使用BeautifulSoup 库进行解析和分析。

这些爬虫小案例涵盖了网络爬虫的常见应用场景,对初学者来说是很好的入门教程。

通过学习这些案例,可以了解网络爬虫的基本原理和常见的爬取技术,并掌握Python的相关库的使用方法。

其次,这些案例也为后续的爬虫开发提供了很好的参考,可以在实际应用中进行模仿或者修改使用。

最后,这些案例的源码也为开发者提供了很好的学习资源,可以通过实战来提高Python编程水平。

Python爬虫入门教程[Python]网络爬虫(一):网络爬虫的定义网络爬虫,即Web Spider,是一个很形象的名字。

把互联网比喻成一个蜘蛛网,那么Spider就是在网上爬来爬去的蜘蛛。

网络蜘蛛是通过网页的链接地址来寻找网页的。

从网站某一个页面(通常是首页)开始,读取网页的内容,找到在网页中的其它链接地址,然后通过这些链接地址寻找下一个网页,这样一直循环下去,直到把这个网站所有的网页都抓取完为止。

如果把整个互联网当成一个网站,那么网络蜘蛛就可以用这个原理把互联网上所有的网页都抓取下来。

这样看来,网络爬虫就是一个爬行程序,一个抓取网页的程序。

网络爬虫的基本操作是抓取网页。

那么如何才能随心所欲地获得自己想要的页面?我们先从URL开始。

二、浏览网页的过程抓取网页的过程其实和读者平时使用IE浏览器浏览网页的道理是一样的。

比如说你在浏览器的地址栏中输入 这个地址。

打开网页的过程其实就是浏览器作为一个浏览的“客户端”,向服务器端发送了一次请求,把服务器端的文件“抓”到本地,再进行解释、展现。

HTML是一种标记语言,用标签标记内容并加以解析和区分。

浏览器的功能是将获取到的HTML代码进行解析,然后将原始的代码转变成我们直接看到的网站页面。

三、URI和URL的概念和举例简单的来讲,URL就是在浏览器端输入的 这个字符串。

在理解URL之前,首先要理解URI的概念。

什么是URI?Web上每种可用的资源,如HTML文档、图像、视频片段、程序等都由一个通用资源标志符(Universal Resource Identifier,URI)进行定位。

URI通常由三部分组成:①访问资源的命名机制;②存放资源的主机名;③资源自身的名称,由路径表示。

如下面的URI:/myhtml/html1223/我们可以这样解释它:①这是一个可以通过HTTP协议访问的资源,②位于主机上,③通过路径“/html/html40”访问。

四、URL的理解和举例URL是URI的一个子集。

使用Python实现一个网络爬虫

Python是一种功能强大的编程语言,可用于实现多种应用的

开发。

其中之一就是实现网络爬虫。

网络爬虫是搜索引擎的重要组成部分,可以自动收集有价值的信息,并把它们存储在后台数据库中。

要使用Python实现网络爬虫,首先需要准备所需的工具和库,例如urllib、Beautiful Soup和Selenium等。

urllib模块用来实

现跨平台HTTP访问,Beautiful Soup模块用于解析HTML文档,而Selenium模块可以实现浏览器自动化,从而实现更精

细的爬取控制。

此外,还可以使用Python中的线程模块实现多线程爬取,可

以实现更快的爬取速度。

Python中的多线程模块不仅可以创

建新的线程,还可以实现线程的暂停、恢复和停止等操作。

最后,使用Python编写的爬虫程序一般会将抓取到的数据存

储到MySQL、MongoDB或者Hadoop等后端数据库中。

这样,就可以方便地根据用户要求从数据库中检索出想要的数据。

总而言之,Python可以很好地支持网络爬虫的实现,可以利

用大量功能强大的模块和库快速开发出功能完善的爬虫程序,从而实现网络数据的抓取和存储。

Python爬虫实现教程一. Python爬虫概述Python爬虫是指利用Python编写程序从网络上获取数据的技术。

Python爬虫可以用来获取各种数据,如新闻、图片、视频、音频、文本等。

Python爬虫技术简单易学,使用方便,目前被广泛应用于数据挖掘、信息收集、搜索引擎优化等领域。

二. Python爬虫入门Python爬虫入门主要包括以下几个步骤:1. 安装Python语言环境2. 安装Python爬虫库3. 编写Python爬虫程序4. 运行Python爬虫程序三. Python爬虫常用库Python爬虫常用库包括以下几种:1. Requests:用于发送HTTP/1.1请求,支持HTTP/2。

2. BeautifulSoup4:用于解析HTML和XML文档。

3. Scrapy:适用于大规模数据采集的框架。

4. Selenium:用于模拟用户操作浏览器获取数据。

5. Pyquery:用于解析HTML文档。

四. Python爬虫实战Python爬虫实战主要包括以下几个方面:1. 网络爬虫技术:获取Web页面数据。

2. 数据解析技术:提取有价值的数据。

3. 网络协议技术:HTTP、TCP/IP等。

4. 多线程/多进程技术:提高爬取效率。

5. 数据存储技术:将爬取的数据存储到数据库中。

五. Python爬虫应用案例Python爬虫应用案例包括以下几个方面:1. 网站数据的采集和分析。

2. 社交媒体数据的采集和分析。

3. 互联网金融数据的采集和分析。

4. 人口、地图和气象等数据的采集和分析。

六. Python爬虫的优缺点Python爬虫的优点:1. 自动化程度高,省时省力。

2. 可以爬取任意网站上的数据。

3. 数据处理能力强大。

4. 基于Python语言,易于上手。

Python爬虫的缺点:1. 数据来源不稳定,有可能会失效。

2. 需要注意法律法规和道德准则。

3. 可能会被反爬虫机制阻挡。

4. 需要考虑数据存储和安全问题。

Python开发能做什么-python编程能实现什么学好Python,前端,后端,测试,〔大数据〕分析,爬虫等这些工作你都能胜任;其中主要有这些应用:网络爬虫、网站开发、人工智能以及自动化运维。

以下是关于Python开发能做什么的具体介绍。

1、网络爬虫网络爬虫又称网络蜘蛛,是指按照某种规则在网络上爬取所必须内容的脚本程序。

众所周知,每个网页通常包涵其他网页的入口,网络爬虫则通过一个网址依次进入其他网址获取所必须内容。

爬虫做垂直搜索引擎(google,baidu等)。

科学研究:在线人类行为,在线社群演化,人类动力学研究,计量社会学,复杂网络,数据挖掘,等领域的实证研究都必须要大量数据,网络爬虫是收集相关数据的利器。

2、网站开发那开发网站必须要用到哪些知识呢?〔python〕基础,因为用python开发的,所以python指定要会,最起码你也得会条件推断,循环,函数,类这些知识;html、css的基础知识,因为要开发网站,网页都html和css写的,最起码这些知识你得会,就算不会写前端,开发不出来特别美丽的页面,网站。

最起码要能看懂html标签;数据库基础知识,因为开发一个网站的话,数据存在哪里,就是在数据库里,那你最起码要会数据库的增删改查吧,要不然怎么存数据,取数据呢。

3、人工智能人工智能,英文缩写为AI。

它是研究、开发用于模拟、延伸和扩大人的智能的理论、方法、技术及应用系统的一门新的技术科学。

Python正在成为机器学习的语言。

大多数机器语言课程都是使用Python语言编写的,大量大公司使用的也是Python,让许多人认为它是将来的主要〔编程〕语言。

4、自动化运维Python能满足绝大部分自动化运维的必须求,又能做后端C/S 架构,又能用WEB框架快速开发出高大上的WEB界面,只有当你自已有能力做出一套运维自动化系统的时候,你的价值才体现出来。

2python编程能实现什么1.web开发:服务器端编程,具有丰富的Web开发框架,如Django和TurboGears,快速完成一个网站的开发和Web服务。

一、实验背景随着互联网的飞速发展,网络信息日益丰富,为了方便用户获取所需信息,网络爬虫技术应运而生。

网络爬虫是一种自动抓取互联网上公开信息的程序,能够高效地从网页中提取所需数据。

本实验旨在让学生了解网络爬虫的基本原理,掌握Python语言编写网络爬虫的方法,并学会利用网络爬虫技术获取所需数据。

二、实验目的1. 理解网络爬虫的基本原理和常用技术;2. 掌握Python语言编写网络爬虫的方法;3. 学会利用网络爬虫技术获取所需数据;4. 培养学生独立思考和解决问题的能力。

三、实验环境1. 操作系统:Windows 10;2. 编程语言:Python3.8;3. 开发工具:PyCharm;4. 库:requests、BeautifulSoup、lxml。

四、实验内容1. 网络爬虫原理网络爬虫主要分为三个步骤:抓取网页、解析网页、提取数据。

(1)抓取网页:通过网络请求获取网页内容。

(2)解析网页:解析网页结构,提取所需数据。

(3)提取数据:从解析后的网页中提取所需数据。

2. Python网络爬虫实现(1)使用requests库抓取网页```pythonimport requestsurl = ""response = requests.get(url)print(response.status_code)print(response.text)```(2)使用BeautifulSoup解析网页```pythonfrom bs4 import BeautifulSoupsoup = BeautifulSoup(response.text, "html.parser") print(soup.title.text)```(3)使用lxml解析网页```pythonfrom lxml import etreetree = etree.HTML(response.text)print(tree.xpath('//title/text()')[0])```3. 网络爬虫应用(1)爬取指定网站新闻```pythonimport requestsfrom bs4 import BeautifulSoupdef get_news(url):response = requests.get(url)soup = BeautifulSoup(response.text, "html.parser") news_list = soup.find_all("div", class_="news-list") for news in news_list:title = news.find("a").textprint(title)url = "/news"get_news(url)```(2)爬取指定网站图片```pythonimport requestsfrom bs4 import BeautifulSoupdef get_images(url):response = requests.get(url)soup = BeautifulSoup(response.text, "html.parser") image_list = soup.find_all("img")for image in image_list:print(image["src"])url = "/images"get_images(url)```五、实验结果与分析1. 实验结果通过实验,成功实现了网络爬虫的基本功能,包括抓取网页、解析网页、提取数据等。

基于Python的网络爬虫系统的设计与实现

摘要

互联网技术的成熟和网络招聘方式的兴起使得大学生越来越倾向于选择互联网行业就业。

为了帮助人们了解招聘状况并提供求职指导,本文利用数据挖掘技术挖掘了拉勾网的招聘数据,设计实现了一个数据分析系统,提供清晰的数据展示和洞察。

该系统具备数据获取、导入、处理、分析和可视化展示等关键功能。

通过网络爬虫技术从拉勾网获取职位信息,经过数据导入和处理,系统运用聚类、关键词提取和关联规则挖掘等算法进行数据分析,提供热门职位、技能关键词和相关规则的分析结果。

系统采用Python开发语言和Django框架进行实现。

通过网络爬虫获取职位信息,并通过数据导入和处理模块对数据进行清洗和预处理。

系统运用聚类、关键词提取和关联规则挖掘算法进行数据分析,最后利用可视化库实现数据的直观展示。

关键词:网络爬虫;数据分析;关键词提取;关联规则挖掘;可视化展示

1。

一、实验目的1. 理解网络爬虫的基本原理和常用技术。

2. 掌握Python编程语言在爬虫开发中的应用。

3. 实践网络爬虫的编写,实现对目标网站的抓取和分析。

二、实验环境1. 操作系统:Windows 102. 编程语言:Python3.83. 爬虫框架:Scrapy4. 数据库:SQLite三、实验内容1. 网络爬虫的基本原理2. Python编程语言在爬虫开发中的应用3. Scrapy框架的使用4. 数据存储与处理四、实验步骤1. 网络爬虫的基本原理(1)了解网络爬虫的定义和作用;(2)熟悉HTTP协议和网页结构;(3)掌握爬虫的工作流程。

2. Python编程语言在爬虫开发中的应用(1)安装Python环境;(2)学习Python基本语法和常用库;(3)编写Python爬虫代码。

3. Scrapy框架的使用(1)安装Scrapy框架;(2)创建Scrapy项目;(3)定义爬虫;(4)实现数据存储。

4. 数据存储与处理(1)选择合适的数据库存储数据;(2)编写数据存储代码;(3)数据清洗与处理。

五、实验结果与分析1. 网络爬虫的基本原理实验结果表明,通过学习网络爬虫的基本原理,我们能够理解爬虫的工作流程,掌握HTTP协议和网页结构,为编写爬虫代码打下基础。

2. Python编程语言在爬虫开发中的应用通过学习Python编程语言,我们能够熟练运用Python编写爬虫代码,实现数据的抓取和分析。

3. Scrapy框架的使用实验结果表明,Scrapy框架能够帮助我们快速开发网络爬虫,提高开发效率。

在Scrapy框架中,我们定义了爬虫、管道、下载器等组件,实现了数据的抓取、处理和存储。

4. 数据存储与处理通过选择合适的数据库存储数据,我们能够方便地对数据进行查询和分析。

在数据清洗与处理过程中,我们使用了Python的pandas库,对数据进行筛选、排序和统计。

六、实验总结本次实验使我们掌握了网络爬虫的基本原理和常用技术,熟悉了Python编程语言在爬虫开发中的应用,学会了Scrapy框架的使用,并实现了数据的存储与处理。