1.高速网络InfiniBand加速大数据应用

- 格式:pdf

- 大小:3.54 MB

- 文档页数:40

InfiniBand 连接现在和未来InfiniBand是致力于服务器端的高性能互联技术,它的使命是:使处理器级的带宽,从处理器到系统I/O、到存储网络,穿越整个数据中心,形成一张统一的、包括服务器互连、服务器与存储互连、存储网络在内的神经网络。

InfiniBand技术是一种开放标准的高带宽、高速网络互联技术。

目前,它的发展速度非常快,而且越来越多的大厂商正在加入或者重返到它的阵营中来,包括Cisco、IBM、HP、Sun、NEC、Intel等。

可以说,InfiniBand已经成为目前主流的高性能计算机互连技术之一。

而且,目前基于InfiniBand技术的网络卡的单端口带宽最大可达到20Gbps,基于InfiniBand的交换机的单端口带宽最大可达60Gbps,单交换机芯片可以支持达480Gbps的带宽,为目前和未来对于网络带宽要求非常苛刻的应用提供解决方案。

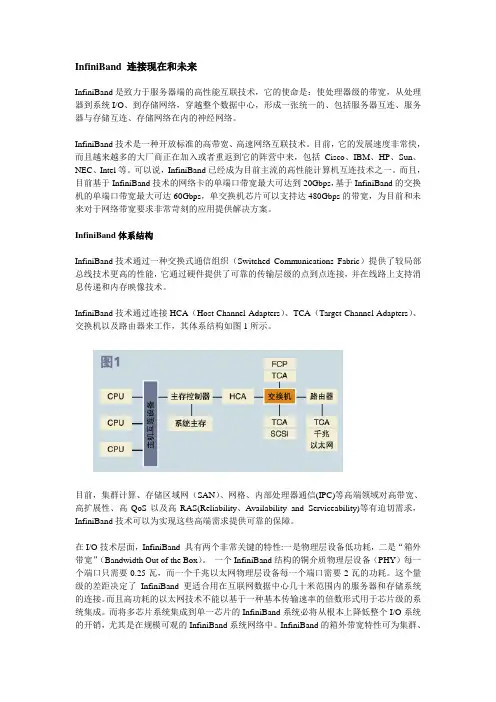

InfiniBand体系结构InfiniBand技术通过一种交换式通信组织(Switched Communications Fabric)提供了较局部总线技术更高的性能,它通过硬件提供了可靠的传输层级的点到点连接,并在线路上支持消息传递和内存映像技术。

InfiniBand技术通过连接HCA(Host Channel Adapters)、TCA(Target Channel Adapters)、交换机以及路由器来工作,其体系结构如图1所示。

目前,集群计算、存储区域网(SAN)、网格、内部处理器通信(IPC)等高端领域对高带宽、高扩展性、高QoS以及高RAS(Reliability、A vailability and Serviceability)等有迫切需求,InfiniBand技术可以为实现这些高端需求提供可靠的保障。

在I/O技术层面,InfiniBand 具有两个非常关键的特性:一是物理层设备低功耗,二是“箱外带宽”(Bandwidth Out of the Box)。

200G QSFP DD AOC在InfiniBand网络中的应用随着数据中心的不断深入与高需求,人们对于此领域的拓展研究也在不断更迭最新技术与开发最优性能产品及解决方案。

前段时间易飞扬(Gigalight)发布了200G QSFP DD PSM8光模块,标志着基于NRZ调制的200G低成本数据中心内部平行光互连方案基本完成,也象征着公司在200G解决方案上的领先地位。

不同于业界主张的400G方案,易飞扬(Gigalight)坚持200G的数据中心解决方案,可为客户提供一站式的服务和解答。

本文主要根据现阶段超算中心的发展进程,来分析当前交换机之间InfiniBand技术的特征以及应用领域,其中以200G QSFP DD AOC为例,说明了超算中心互连技术的端口封装形式朝着更高工作带宽发展的现状。

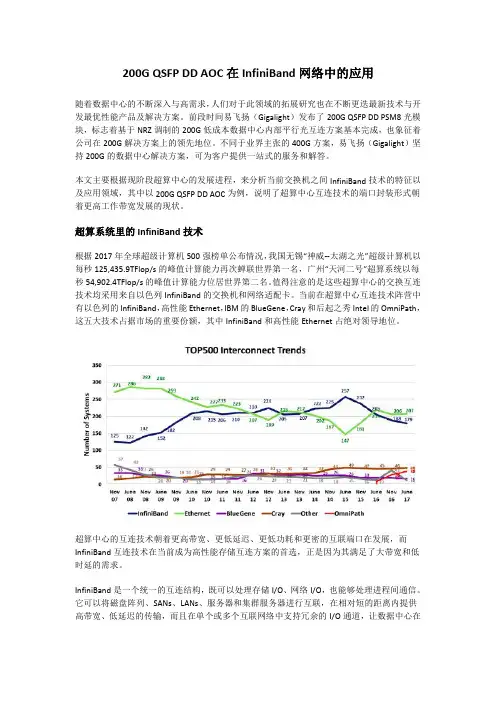

超算系统里的InfiniBand技术根据2017年全球超级计算机500强榜单公布情况,我国无锡“神威--太湖之光”超级计算机以每秒125,435.9TFlop/s的峰值计算能力再次蝉联世界第一名,广州“天河二号”超算系统以每秒54,902.4TFlop/s的峰值计算能力位居世界第二名。

值得注意的是这些超算中心的交换互连技术均采用来自以色列InfiniBand的交换机和网络适配卡。

当前在超算中心互连技术阵营中有以色列的InfiniBand,高性能Ethernet,IBM的BlueGene,Cray和后起之秀Intel的OmniPath,这五大技术占据市场的重要份额,其中InfiniBand和高性能Ethernet占绝对领导地位。

超算中心的互连技术朝着更高带宽、更低延迟、更低功耗和更密的互联端口在发展,而InfiniBand互连技术在当前成为高性能存储互连方案的首选,正是因为其满足了大带宽和低时延的需求。

InfiniBand是一个统一的互连结构,既可以处理存储I/O、网络I/O,也能够处理进程间通信。

它可以将磁盘阵列、SANs、LANs、服务器和集群服务器进行互联,在相对短的距离内提供高带宽、低延迟的传输,而且在单个或多个互联网络中支持冗余的I/O通道,让数据中心在局部故障时仍能运转。

高速交换网络时间:2014-02-24 11:01 点击:441 次InfiniBand 技术是什么?InfiniBand是一种全新的基于通道和交换的开放互连结构标准。

它能够连接多个独立的处理器平台、I/O平台以及I/O设备,在同一物理网络上支持一个或者多个计算机系1.InfiniBand技术是什么?InfiniBand是一种全新的基于通道和交换的开放互连结构标准。

它能够连接多个独立的处理器平台、I/O平台以及I/O设备,在同一物理网络上支持一个或者多个计算机系统之间的I/O通信和内部处理器之间的通信。

InfiniBand技术不是用于一般网络连接的,它的主要设计目的是针对服务器端的连接问题的。

因此,InfiniBand技术将会被应用于服务器与服务器(比如复制,分布式工作等),服务器和存储设备(比如SAN和直接存储附件)以及服务器和网络之间(比如LAN, WANs和the Internet)的通信。

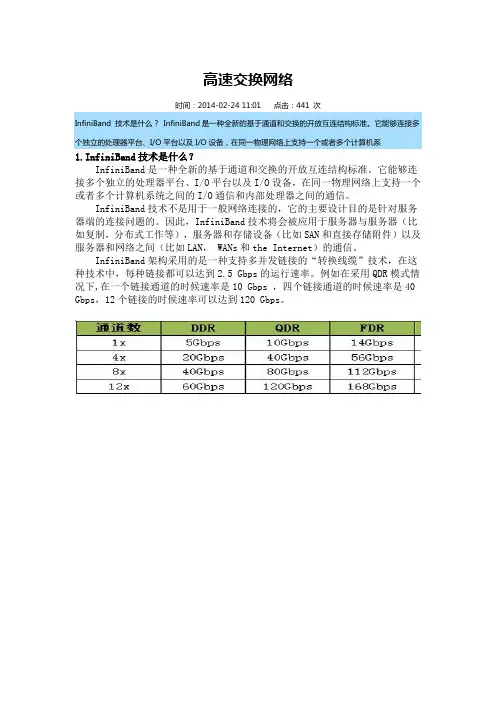

InfiniBand架构采用的是一种支持多并发链接的“转换线缆”技术,在这种技术中,每种链接都可以达到2.5 Gbps的运行速率。

例如在采用QDR模式情况下,在一个链接通道的时候速率是10 Gbps ,四个链接通道的时候速率是40 Gbps,12个链接的时候速率可以达到120 Gbps。

2.为什么需要InfiniBand?采用Intel架构的处理器的输入/输出性能会受到总线的限制。

总线的吞吐能力是由总线时钟和总线的宽度决定的。

这种速度上的限制制约了服务器和存储设备、网络节点以及其他服务器通讯的能力。

而在InfiniBand的技术中,InfiniBand直接集成到系统板内,并且直接和CPU以及内存子系统互动,在传输层上,它提供了可靠的点对点连接,不同于PCI,Infiniband允许多个I/O外设无延迟、无拥塞地同时向处理器发出数据请求。

Infiniband技术与其他网络协议(如TCP/IP)相比,InfiniBand具有更高的传输效率。

InfiniBand高速互连网络徐迪威广州广东省计算中心,510033摘要:InfiniBand是目前发展最快的高速互连网络技术,具有高带宽、低延迟和易扩展的特点。

通过研究和实践,对InfiniBand技术的数据包、数据传输、层次结构、与以太网技术的对比、虚拟化、交换机制、发展愿景等进行了全面探索,提出了InfiniBand最终成为高速互连网络首选的观点。

关键词:InfiniBand;高速互连网络;数据包;结构模型;虚拟化;交换机制Research on Design of InfiniBand High Speed InterconnectionAbstract: InfiniBand is a fast growing technology of high speed interconnection (HSI), whose characteristics are high bandwidth, low latency and easy extension. Via researching and practicing, the paper explores on InfiniBand data packets, data transfer, multilevel architectures, comparing with Ethernet, virtualization, switching mechanism, roadmap, etc. The author presents the viewpoint that InfiniBand will become the first choice in setting up HSI.Keywords: InfiniBand(IB); High Speed Interconnection(HSI); Data Packet; Hierarchy Model; Virtualization; Switching Mechanism1引言随着中央处理器(CPU)运算能力的极速增长,高速互连网络(High Speed Interconnection, HSI)已成为高性能计算机研制的关键所在。

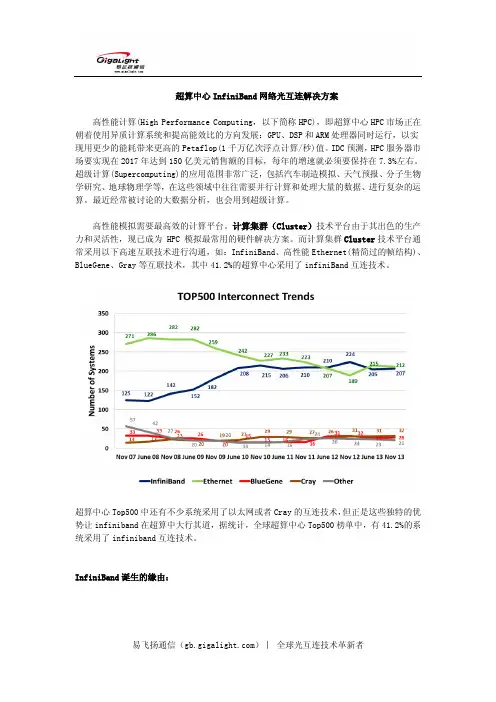

超算中心InfiniBand网络光互连解决方案高性能计算(High Performance Computing,以下简称HPC),即超算中心HPC市场正在朝着使用异质计算系统和提高能效比的方向发展:GPU、DSP和ARM处理器同时运行,以实现用更少的能耗带来更高的Petaflop(1千万亿次浮点计算/秒)值。

IDC预测,HPC服务器市场要实现在2017年达到150亿美元销售额的目标,每年的增速就必须要保持在7.3%左右。

超级计算(Supercomputing)的应用范围非常广泛,包括汽车制造模拟、天气预报、分子生物学研究、地球物理学等,在这些领域中往往需要并行计算和处理大量的数据、进行复杂的运算。

最近经常被讨论的大数据分析,也会用到超级计算。

高性能模拟需要最高效的计算平台。

计算集群(Cluster)技术平台由于其出色的生产力和灵活性,现已成为 HPC 模拟最常用的硬件解决方案。

而计算集群Cluster技术平台通常采用以下高速互联技术进行沟通,如:InfiniBand、高性能Ethernet(精简过的帧结构)、BlueGene、Gray等互联技术,其中41.2%的超算中心采用了infiniBand互连技术。

超算中心Top500中还有不少系统采用了以太网或者Cray的互连技术,但正是这些独特的优势让infiniband在超算中大行其道,据统计,全球超算中心Top500榜单中,有41.2%的系统采用了infiniband互连技术。

InfiniBand诞生的缘由:InfiniBand是一种输入输出(I/O)宽带结构,可以提高服务器各设备之间、网络子系统之间的通信速度,为将来的计算机系统提高更高性能和无限扩展性的宽带服务。

InfiniBand 技术不是用于一般网络连接的,它的主要设计目的是针对服务器端的连接问题的。

因此,InfiniBand技术将会被应用于服务器与服务器(比如复制,分布式工作等),服务器和存储设备(比如SAN和直接存储附件)以及服务器和网络之间(比如LAN, WANs和the Internet)的通信。

干货:InfiniBand技术究竟是何方神圣?我们经常听到关于某超算中心又用了什么先进的技术,而在这些技术中,InfiniBand技术则是人们谈论最多的话题。

那么InfiniBand到底有多牛?关于更多Infiniband技术架构请参考:InfiniBand知识和架构。

文章内容:1、InfiniBand技术背景和现状2、InfiniBand为超算中心提供超强传输性能3、InfiniBand技术玩家和如今巨头4、盘点全球超算系统哪家强?①、超算为何被视为超级明星①、超算为何被视为超级明星③、采用的处理器类型和份额④、超级计算机中的核心数量⑤、各国的超算系统的数量⑥、各用途和超算供应商的总体处理能力⑦、处理器和各领域的总处理能力⑧、超算系统历史和未来发展去向简单来说,InfiniBand是一种支持多并发链接的转换线缆技术,它既可以处理存储I/O、网络I/O,也能够处理进程间通信(IPC),这样它即可以将磁盘阵列、SANs、LANs、服务器和集群服务器进行互联,也可以连接外部网络(比如WAN、VPN、互联网)。

1、InfiniBand技术背景和现状设计InfiniBand的目的主要是用于企业数据中心,大型的或超大型的数据中心,为了实现高的可靠性、可用性、可扩展性和高的性能。

并且InfiniBand可以在相对短的距离内提供高带宽、低延迟的传输,而且在单个或多个互联网络中支持冗余的I/O通道,因此能保持数据中心在局部故障时仍能运转。

Infiniband网络是一种高带宽低延时的网络,相比传统的以太网络,最新一代的Infiniband网络带宽可达100Gbps,点到点的延时低于0.6us。

Infiniband网络主要用于高性能计算场景,通过高速的Infiniband网络,将一台台多路服务器构建为一个高性能计算集群,集群性能基本上是单台服务器性能的线性叠加,可以说正是因为有Infiniband网络技术,才能催生出超算高性能集群架构。

大数据技术与5G通信技术融合的应用目录1. 大数据技术 (2)1.1 数据采集 (3)1.1.1 传感器技术 (4)1.1.2 数据爬取技术 (5)1.2 数据存储 (6)1.2.1 分布式文件系统 (7)1.2.2 数据库管理系统 (8)1.3 数据处理 (10)1.3.1 数据清洗 (11)1.3.2 数据分析 (12)1.4 数据挖掘 (14)1.4.1 关联规则挖掘 (15)1.4.2 分类与聚类 (16)1.5 数据可视化 (18)1.5.1 图表展示 (19)1.5.2 地理信息可视化 (20)2. 5G通信技术 (22)2.1 5G基础概念 (23)2.1.1 5G网络架构 (24)2.1.2 5G业务场景 (26)2.2 5G传输技术 (27)2.2.1 非正交多址接入技术(NOMA) (28)2.2.2 大规模MIMO技术 (29)2.3 5G网络优化 (30)2.3.1 资源分配策略 (32)2.3.2 网络性能优化 (33)2.4 5G应用场景 (34)2.4.1 物联网 (36)2.4.2 自动驾驶 (37)2.5 5G安全与隐私保护 (38)2.5.1 加密算法 (40)2.5.2 身份认证技术 (41)1. 大数据技术在当前信息化快速发展的时代背景下,大数据技术已经成为一种重要的技术手段,广泛应用于各行各业。

大数据技术是指通过特定技术处理难以用常规手段管理和处理的数据集的技术总称。

其核心内容包括数据收集、存储、管理、分析和挖掘等。

通过大数据技术,我们可以从海量数据中提取有价值的信息,为决策提供支持。

数据量大:大数据技术能够处理的数据规模非常庞大,可以是结构化的数据,也可以是非结构化的数据。

数据类型多样:大数据技术能够处理多种类型的数据,包括文本、图像、音频、视频等。

处理速度快:大数据技术能够在短时间内对大量数据进行处理和分析,提供实时的数据分析和决策支持。

决策支持:通过数据挖掘和机器学习等技术,大数据技术能够从数据中提取有价值的信息,为企业的决策提供依据。

存储HCIP试题库+参考答案一、单选题(共38题,每题1分,共38分)1.下列选项中关于配额与统计描述错误的是:A、可供统计的桶资源包括桶的空间大小、拥有的桶数量以及桶中的对象数量。

B、当帐户的桶容量总数达到所配置的帐户配额后,该帐户无法再进行写入操作。

C、可供统计的帐户资源包括帐户配额、拥有的桶数量、对象数量及容量总大小。

D、当桶容量达到所配置的桶配额后,无法再对该桶进行写入操作。

正确答案:D2.华为分布式存储对象服务使用哪种协议获取租户、桶的资源统计情况()A、SNMPB、SSLC、RESTD、SMI-S正确答案:A3.以下哪个不是 NAS 系统的体系结构中必须包含的组件?A、可访问的磁盘阵列B、文件系统C、访问文件系统的接口D、访问文件系统的业务接口正确答案:D4.以下关于 Oceanstor 9000 的物理分域描述错误的是哪一项?A、物理分域是一种隔离故障的有效手段B、某些节点故障,会造成与这些节点在一个物理分域内的其他节点上的数据的可靠性级别降低C、Oceanstor 9000 通过节点池与分级的方法来实现物理分域D、管理员最少要将 2 个存储节点加入一个分域中正确答案:D5.帐户是使用对象存储服务(兼容 Amazon S3 接口)的凭证,其管理功能不包括:A、签约业务管理B、帐户基本管理C、证书管理D、跨域访问策略管理正确答案:D6.大数据时代对传统技术升级已经满足不了了大数据处理的需求,以下哪一项不是大数据时代技术发展的方向?A、计算向集群化发展B、由非关系型数据库想关系型数据库发展C、网络向更高苏,协议开销更低,更有效的方向发展D、向虚拟化方向发展正确答案:B7.站点 A 需要的存储容量为 2543GB.,站点 B 需要的存储容量为3000GB.,站点 B 的备份数据远程复制到站点 A保存。

考虑复制压缩的情况,压缩比为 3,计算站点 A 需要的后端存储容量是多大?A、3543GB.B、4644GB.C、3865GB.D、4549GB.正确答案:A8.华为 Oceanstor 9000 InfoTier 文件池策略将决定文件创建的存储位置,以及文件重条带化时的目标分级,以下关于文件池策略说法不正确的是哪一项?A、default 策略可以被修改B、default 策略优先级最低C、最多可支持配置 128 条文件池策略D、策略参数组合间为“或”的关系正确答案:D9.以下那个特性不能提升华为混合闪存存储产品的性能?A、SmartPartitionB、SmartCacheC、SmartVirtualizationD、SmartTier正确答案:C10.以下关于 CIFS 的工作原理说法正确的是哪一项?A、在建立共享连接之前,先建立回话,然后进行协议协商B、建立共享连接之后才能进行文件操作C、在协议协商阶段进行安全认证D、文件操作完成后,不需要客户端请求,服务器将自动断开共享连接正确答案:B11.NAS 系统专注对于以下哪种类型的数据存储和管理?A、大块数据B、文件数据C、小块数据D、连接数据块正确答案:B12.InfiniBand 协议特点不包括以下哪一项?A、速度高B、远程直接内存存取功能C、基于标准协议开发D、传输卸载,可将数据包路由从芯片级转到 os正确答案:D13.pcie 协议的特点不包括哪一项?A、高可靠B、基于帧结构的传输C、并行总线结构D、点对点连接正确答案:C14.以下描述正确的是?1 备份的目标是为了防止人为误操作或系统问题,保存的是历史数据,恢复时间相对长 2 备份方案通常使用快照、镜像或复制技术来实现。

高性能计算平台的设计与实现技术研究第一章:引言随着科技的迅猛发展,高性能计算平台已经越来越广泛地应用在科学计算、金融、人工智能、大数据等领域。

作为一种计算机系统,高性能计算平台能够提供极高的计算速度和算力,在处理大规模数据、复杂问题等方面展现出独特的优势。

因此,高性能计算平台的设计与实现技术研究成为当前待解决的重要问题。

本文将详细介绍高性能计算平台的设计与实现技术研究,包括计算节点的选型、网络结构的优化、分布式存储系统的设计等方面。

通过这些技术的研究,可以为高性能计算平台的开发提供有效的支撑,促进相关领域的发展。

第二章:计算节点选型计算节点是高性能计算平台的核心组件,其计算能力、存储能力、网络带宽等性能的优劣直接影响着整个系统的性能。

因此,在选择计算节点时需要综合考虑各种因素,以最大化地发挥计算节点的性能。

2.1 CPU选型在计算节点中,CPU是最基本的计算组件。

目前,CPU的性能主要依赖于核心数量、频率和缓存容量等因素。

为了提高系统的计算能力,需要选择具有高性能的CPU。

目前,主流的CPU产品线中,英特尔的Xeon系列和AMD的Opteron系列是比较受欢迎的选择。

这两个系列的CPU均采用了多核心技术,能够为高性能计算平台提供更高的计算能力。

同时,它们也具备较高的频率、大容量的缓存等优点。

2.2 存储选型高性能计算平台需要支持大规模数据的读写操作,因此,存储设备的选型也是十分关键的。

对于计算节点来说,主要需要考虑的存储设备包括SSD和HDD等。

目前,SSD的读写速度较快,能够更好地满足高性能计算平台的需求。

而且,SSD的功耗也相对较低,能够降低整个系统的能耗。

因此,对于高性能计算平台的计算节点,SSD是比较理想的存储选择。

2.3 网络组件选型高性能计算平台的计算节点之间需要进行高效的互联,因此,网络组件的选型也是十分重要的。

在选择网络组件时,主要需要考虑带宽、纬度、延迟等因素。

目前,InfiniBand和Ethernet是比较常用的两种网络技术。

企业数据中心超融合架构的特点和发展趋势研究作者:冷迪来源:《科技创新与应用》2015年第35期摘要:近年来,企业数据中心计算与存储融合的超融合架构相对于传统计算网络存储分离架构发起了强有力的挑战。

文章通过分析传统企业数据中心基础架构面临的弊端,提出了传统构架向超融合架构的演进趋势。

并对超融合架构的概念、组成和主要特点进行了详细分析和介绍,从产品和市场角度分析了超融合架构的发展和应用趋势。

最后,作者对超融合架构在电力行业云数据中心的应用给出了展望。

关键词:云数据中心;超融合架构;分布式存储;Server SAN1 企业数据中心基础设施架构演进趋势1.1 云计算趋势下,企业数据中心建设面临的挑战数据中心在不断进行演进过程中,云计算、大数据、移动互联的需求日益高涨,基于此需求的近实时或实时数据分析(OLAP、OLTP)等商业智能分析应用得到越来越多企业用户的关注。

不论是私有云、公有云或是混合云,都面临企业云数据中心建设的关键问题,即如何提高数据中心的资源利用率、如何降低整体成本、优化管理、如何应对业务的快速变化、如何伸缩自如等,这些都是数据中心建设者们需要积极思考的问题。

目前企业云数据中心的建设通常对服务器、存储、网络设备、平台及应用软件等部件独立采购,而后再集成的方式。

这在一定程度上降低了数据中心的初始购置成本。

然而,随着云数据中心规模的不断扩大,传统的构架会使企业将在后续运维运营上消耗过多的人力物力,进而导致IT效率低下,终将阻碍业务发展。

企业需要不断寻求改善IT环境的解决方法,来保证业务能够稳定、敏捷地运行。

可以预见,未来企业IT希望购买到的是一个数据中心基础设施整体方案,通过更多聚焦于IT技术对业务的响应,为公司业务提供增值辅助,从而将传统的成本中心转为“利润“中心。

1.2 超融合架构是企业云数据中心基础设施架构的大势所趋为应对当下云计算、虚拟化和大数据发展的趋势,2014年第三方权威调查机构Wikibon 提出Server SAN名词,自被提出就获得很多关注和热烈讨论。

【002】什么是大模型集群管理?(译文)集群管理是管理一组互连计算机(称为集群)的过程,以实现一组所需的目的或目的。

集群通常用于大规模计算应用,例如高性能计算(HPC)、大数据处理和云计算。

集群管理的主要目标是确保集群以最佳且高效的方式运行,并有效地利用资源来满足集群上运行的应用程序的需求。

这涉及一系列任务,例如监控各个节点和整个集群的性能、管理资源分配以及协调作业的调度和执行。

在本文中,我们将讨论三种类型的计算集群中的集群管理:•计算集群中管理哪些类型的资源?•Kubernetes 集群管理•HPC集群管理•NVIDIA 集群管理•7 集群管理最佳实践•使用Run:ai 管理集群计算集群中管理哪些类型的资源?计算集群旨在有效地分配和管理各种类型的资源以执行复杂的计算和任务。

以下是计算集群中管理的最常见资源:•CPU:中央处理单元 (CPU) 是计算集群中的主要处理单元。

它们处理通用计算并管理不同组件之间的数据流。

CPU 负责执行计算机程序中的指令,并且可以通过多线程同时处理多个任务。

•GPU:图形处理单元 (GPU) 是专用处理器,旨在处理并行处理任务,特别是与图形渲染相关的任务。

然而,它们执行并行计算的能力也使它们适用于其他任务,例如机器学习、深度学习和科学模拟。

在计算集群中,GPU 可以通过从 CPU 卸载特定任务来加速计算。

•TPU:张量处理单元 (TPU) 是 Google 开发的专用 ASIC(专用集成电路),用于加速机器学习工作负载。

它们特别适合运行基于 TensorFlow 的深度学习模型。

TPU 提供高性能矩阵处理能力,非常适合处理计算集群中的大规模计算。

•内存:计算集群中的内存是至关重要的资源,因为它在处理过程中临时存储 CPU、GPU 和 TPU 的数据和指令。

有两种主要类型的存储器:随机存取存储器(RAM)和高速缓冲存储器。

RAM 用于临时存储数据和指令,而高速缓冲存储器是一种更小、更快的存储器,用于存储经常访问的数据。

Infiniband:新一代集群系统的新宠【IT168 专稿】InfiniBand 在2001年完成第一颗芯片的流片之后,关于这种技术的种种话题就热闹起来。

在HPC、存储等领域经历了起起伏伏,为了给大家一个清楚的对InfiniBand(以下简称为IB)的认识,本文对该技术以及目前的应用情况进行一个综述性的介绍。

IB:新一代集群的新宠传统的集群架构一般需要有三套网络来支持集群中不同数据的传输:存储、管理(TCP/IP)和计算(MPI)。

问题是系统日常硬件管理工作非常复杂,一旦需要对系统进行扩展,意味着巨额的成本投入和工作量,例如需要增加10个节点,即需要增加30片卡,同时增加大量的线缆,需要对三套网络进行重新配置。

产生该问题的根源在于这是传统集群的特点——以计算节点为核心进行构建集群,如图1。

图1 以计算节点为核心的传统集群所以,为了解决传统集群中由于采用计算节点为核心的网络架构所带来的“性能差,结构复杂和扩展能力差”等问题,业界提出了集群架构转变为以交换为核心的体系架构。

然而,为了满足这种要求,必须要有一套开放、高带宽、低延迟、高可靠以及满足集群无限扩展能力的交换网络和技术,IB技术应运而生。

图2 是以交换为核心的新型集群架构。

即节点之间采用IB互联,直接连接到IB交换机,而其他所有网络比如存储、以太网、FC等网络都通过IB交换扩展,即直接形成了以IB交换机为核心的集群系统。

图2 以交换为核心的集群系统IB:发展历程潮起潮落IB是由IB行业协会所倡导的,IBTA (Infiniband Trade Association)于1999年成立,协会先后主要成员有:康柏、戴尔、惠普、IBM、Intel、微软和Sun。

从历史的角度看,IB代表了两种计算潮流的融合:下一代I/O(NGIO)和未来的I-O(FIO)。

大部分NGIO和FIO潮流的成员都加入了IB阵营。

IB发展也是经历了两次浪潮,当IB第一次提出时受到了主流服务器生产链上的厂商的一致青睐和热捧,但由于协议的问题以及软件支持的问题,以及最初的定位问题,导致应用受到限制,包括Intel等厂商一度撤出投资。