Python中文编码

- 格式:pdf

- 大小:185.70 KB

- 文档页数:2

python中⽂乱码问题深⼊分析在本⽂中,以'哈'来解释作⽰例解释所有的问题,“哈”的各种编码如下:1. UNICODE (UTF8-16),C854;2. UTF-8,E59388;3. GBK,B9FE。

⼀直以来,python中的中⽂编码就是⼀个极为头⼤的问题,经常抛出编码转换的异常,python中的str和unicode到底是⼀个什么东西呢?在python中提到unicode,⼀般指的是unicode对象,例如'哈哈'的unicode对象为u'\u54c8\u54c8'⽽str,是⼀个字节数组,这个字节数组表⽰的是对unicode对象编码(可以是utf-8、gbk、cp936、GB2312)后的存储的格式。

这⾥它仅仅是⼀个字节流,没有其它的含义,如果你想使这个字节流显⽰的内容有意义,就必须⽤正确的编码格式,解码显⽰。

例如:对于unicode对象哈哈进⾏编码,编码成⼀个utf-8编码的str-s_utf8,s_utf8就是是⼀个字节数组,存放的就是' e5 93 88 e5 93 88',但是这仅仅是⼀个字节数组,如果你想将它通过print语句输出成哈哈,那你就失望了,为什么呢?因为print语句它的实现是将要输出的内容传送了操作系统,操作系统会根据系统的编码对输⼊的字节流进⾏编码,这就解释了为什么utf-8格式的字符串“哈哈”,输出的是“鍝堝搱”,因为 ' e5 93 88 e5 93 88'⽤GB2312去解释,其显⽰的出来就是“鍝堝搱”。

这⾥再强调⼀下,str记录的是字节数组,只是某种编码的存储格式,⾄于输出到⽂件或是打印出来是什么格式,完全取决于其解码的编码将它解码成什么样⼦。

这⾥再对print进⾏⼀点补充说明:当将⼀个unicode对象传给print时,在内部会将该unicode对象进⾏⼀次转换,转换成本地的默认编码(这仅是个⼈猜测)⼆、str和unicode对象的转换str和unicode对象的转换,通过encode和decode实现,具体使⽤如下:将GBK'哈哈'转换成unicode,然后再转换成UTF8三、Setdefaultencoding如上图的演⽰代码所⽰:当把s(gbk字符串)直接编码成utf-8的时候,将抛出异常,但是通过调⽤如下代码:import sysreload(sys)sys.setdefaultencoding('gbk')后就可以转换成功,为什么呢?在python中str和unicode在编码和解码过程中,如果将⼀个str直接编码成另⼀种编码,会先把str解码成unicode,采⽤的编码为默认编码,⼀般默认编码是anscii,所以在上⾯⽰例代码中第⼀次转换的时候会出错,当设定当前默认编码为'gbk'后,就不会出错了。

python-PEP8编码规范-中⽂简版

代码布局

缩进:每⼀⾏的缩进使⽤4个空格。

续⾏应该与其包裹的元素对齐,要么使⽤圆括号,⽅括号和花括号内的隐式⾏连接来垂直对齐,要么使⽤挂⾏缩进对齐。

当使⽤挂⾏缩进时,应该考虑到第⼀⾏不应该有参数,以及使⽤缩进以区分⾃⼰是续⾏。

推荐:

制表符还是空格?

空格是⾸选的缩进⽅式。

制表符追能⽤于同样使⽤制表符缩进的代码保持⼀致。

Python3不允许同时使⽤空格和制表符的缩进

混合使⽤制表符和空格的Python2代码应该统⼀转成空格。

当在命令中加⼊-t选项执⾏Python2时,它会发出关于⾮法混⽤制表符与空格的警告。

当使⽤-tt时,这些警告会变成错误,强烈建议使⽤这样的参数。

⾏的最⼤长度

所有⾏限制的最⼤字符数为79.

没有结构化限制的⼤块⽂本(⽂档字符或者注释),每⾏的最⼤字符数限制在72.

限制编辑器窗⼝宽度可以使多个⽂件并⾏打开,并且使⽤代码检查⼯具时⼯作的很好。

python 中文编解码

在Python中,如果需要将字符串进行编码或解码,可以使用内置函数`encode()`和`decode()`。

编码(encode)是将字符串转换为字节序列的过程,而解码(decode)则是将字节序列转换为字符串的过程。

下面是一些常用的编码和解码方法:- 将字符串编码为字节序列:使用字符串的`encode()`方法,可以指定要使用的编码格式。

例如,将字符串编码为UTF-8格式的字节序列可以使用以下方式:pythons = "中文"b = s.encode('utf-8')- 将字节序列解码为字符串:使用字节序列的`decode()`方法,也可以指定要使用的解码格式。

例如,将UTF-8格式的字节序列解码为字符串可以使用以下方式:pythonb =

b'\xe4\xb8\xad\xe6\x96\x87's = b.decode('utf-8')需要注意的是,编码和解码时要使用相同的编码格式,否则可能会导致解码错误或乱码。

通常情况下,UTF-8编码是一种常用且较为通用的选择。

同时,还可以使用`str.encode()`和`bytes.decode()`方法进行编码和解码,其用法与上述方法相同。

pythons = "中文"b = str.encode(s, 'utf-8')s = bytes.decode(b, 'utf-8')以上是在Python 中进行中文编解码的基本方法,需要根据具体使用场景和需求来选择合适的编码格式和方法。

python中unicode、utf8、gbk等编码问题为什么会报错“UnicodeEncodeError: 'ascii' codec can't encode characters in position 0-1: ordinal not in range(128)”?本⽂就来研究⼀下这个问题。

字符串在Python内部的表⽰是unicode编码,因此,在做编码转换时,通常需要以unicode作为中间编码,即先将其他编码的字符串解码(decode)成unicode,再从unicode编码(encode)成另⼀种编码。

decode的作⽤是将其他编码的字符串转换成unicode编码,如str1.decode('gb2312'),表⽰将gb2312编码的字符串str1转换成unicode编码。

encode的作⽤是将unicode编码转换成其他编码的字符串,如str2.encode('gb2312'),表⽰将unicode编码的字符串str2转换成gb2312编码。

因此,转码的时候⼀定要先搞明⽩,字符串str是什么编码,然后decode成unicode,然后再encode成其他编码代码中字符串的默认编码与代码⽂件本⾝的编码⼀致。

如:s='中⽂'如果是在utf8的⽂件中,该字符串就是utf8编码,如果是在gb2312的⽂件中,则其编码为gb2312。

这种情况下,要进⾏编码转换,都需要先⽤decode⽅法将其转换成unicode编码,再使⽤encode⽅法将其转换成其他编码。

通常,在没有指定特定的编码⽅式时,都是使⽤的系统默认编码创建的代码⽂件。

如果字符串是这样定义:s=u'中⽂'则该字符串的编码就被指定为unicode了,即python的内部编码,⽽与代码⽂件本⾝的编码⽆关。

因此,对于这种情况做编码转换,只需要直接使⽤encode⽅法将其转换成指定编码即可。

python查看字符编码的方法Python是一种广泛使用的高级编程语言,许多人都使用它来完成各种任务。

在Python中,了解如何查看字符编码是非常重要的。

通过查看字符编码,您可以了解与文本编码相关的详细信息。

在本文中,我们将分步介绍如何使用Python来查看字符编码。

步骤一:使用Python检测编码方式Python提供了一种以通用的方式读写文件的方法,这种方法可以识别和处理各种文本编码。

在Python中,要读取文件并检测编码方式,我们可以使用codecs库。

codecs库可以以通用的方式读取文件并检测编码方式。

请按以下步骤操作:1.导入codecs库:import codecs2.打开文件并使用codecs库检测编码方式:with codecs.open('file.txt','r',encoding='utf-8') as f:content = f.read()print(content)在上面的代码中,我们使用codecs库的open函数打开文件,并指定编码方式。

在这种情况下,我们将编码方式设置为"utf-8"。

步骤二:使用Python的chardet库来检测编码方式Python还提供了一个称为"chardet"的库,可以帮助我们更好地识别编码方式。

要使用它,请按以下步骤操作:1.安装chardet库:使用以下命令在Windows上安装chardet库:pip install chardet使用以下命令在Linux和Mac上安装chardet库:sudo pip install chardet2.使用chardet库检测文件的编码方式:import chardetwith open('file.txt', 'rb') as f:result = chardet.detect(f.read())print(result['encoding'])在上面的代码中,我们使用chardet库分析文件内容的编码方式。

Python——关于encoding=ISO-8859-1和utf-8的介绍Unicode、UTF-8 和 ISO8859-1和乱码问题在下⾯的描述中,将以"中⽂"两个字为例,经查表可以知道其GB2312编码是"d6d0 cec4",Unicode编码为"4e2d 6587",UTF编码就是"e4b8ade69687"。

注意,这两个字没有iso8859-1编码,但可以⽤iso8859-1编码来"表⽰"。

2. 编码基本知识最早的编码是iso8859-1,和ascii编码相似。

但为了⽅便表⽰各种各样的语⾔,逐渐出现了很多标准编码,重要的有如下⼏个。

2.1. iso8859-1属于单字节编码,最多能表⽰的字符范围是0-255,应⽤于英⽂系列。

⽐如,字母a的编码为0x61=97。

很明显,iso8859-1编码表⽰的字符范围很窄,⽆法表⽰中⽂字符。

但是,由于是单字节编码,和计算机最基础的表⽰单位⼀致,所以很多时候,仍旧使⽤ iso8859-1编码来表⽰。

⽽且在很多协议上,默认使⽤该编码。

⽐如,虽然"中⽂"两个字不存在iso8859-1编码,以gb2312编码为例,应该是"d6d0 cec4"两个字符,使⽤iso8859-1编码的时候则将它拆开为4个字节来表⽰:"d6 d0 ce c4"(事实上,在进⾏存储的时候,也是以字节为单位处理的)。

⽽如果是UTF编码,则是6个字节"e4 b8 ad e6 96 87"。

很明显,这种表⽰⽅法还需要以另⼀种编码为基础。

2.2. GB2312/GBK这就是汉⼦的国标码,专门⽤来表⽰汉字,是双字节编码,⽽英⽂字母和iso8859-1⼀致(兼容iso8859-1编码)。

其中gbk编码能够⽤来同时表⽰繁体字和简体字,⽽ gb2312只能表⽰简体字,gbk是兼容gb2312编码的。

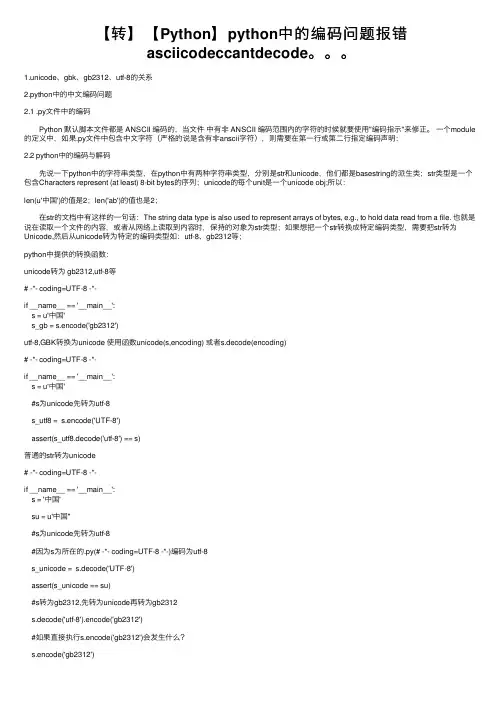

【转】【Python】python中的编码问题报错asciicodeccantdecode。

1.unicode、gbk、gb2312、utf-8的关系2.python中的中⽂编码问题2.1 .py⽂件中的编码 Python 默认脚本⽂件都是 ANSCII 编码的,当⽂件中有⾮ ANSCII 编码范围内的字符的时候就要使⽤"编码指⽰"来修正。

⼀个module 的定义中,如果.py⽂件中包含中⽂字符(严格的说是含有⾮anscii字符),则需要在第⼀⾏或第⼆⾏指定编码声明:2.2 python中的编码与解码 先说⼀下python中的字符串类型,在python中有两种字符串类型,分别是str和unicode,他们都是basestring的派⽣类;str类型是⼀个包含Characters represent (at least) 8-bit bytes的序列;unicode的每个unit是⼀个unicode obj;所以:len(u'中国')的值是2;len('ab')的值也是2; 在str的⽂档中有这样的⼀句话:The string data type is also used to represent arrays of bytes, e.g., to hold data read from a file. 也就是说在读取⼀个⽂件的内容,或者从⽹络上读取到内容时,保持的对象为str类型;如果想把⼀个str转换成特定编码类型,需要把str转为Unicode,然后从unicode转为特定的编码类型如:utf-8、gb2312等;python中提供的转换函数:unicode转为 gb2312,utf-8等# -*- coding=UTF-8 -*-if __name__ == '__main__':s = u'中国's_gb = s.encode('gb2312')utf-8,GBK转换为unicode 使⽤函数unicode(s,encoding) 或者s.decode(encoding)# -*- coding=UTF-8 -*-if __name__ == '__main__':s = u'中国'#s为unicode先转为utf-8s_utf8 = s.encode('UTF-8')assert(s_utf8.decode('utf-8') == s)普通的str转为unicode# -*- coding=UTF-8 -*-if __name__ == '__main__':s = '中国'su = u'中国''#s为unicode先转为utf-8#因为s为所在的.py(# -*- coding=UTF-8 -*-)编码为utf-8s_unicode = s.decode('UTF-8')assert(s_unicode == su)#s转为gb2312,先转为unicode再转为gb2312s.decode('utf-8').encode('gb2312')#如果直接执⾏s.encode('gb2312')会发⽣什么?s.encode('gb2312')# -*- coding=UTF-8 -*-if __name__ == '__main__':s = '中国'#如果直接执⾏s.encode('gb2312')会发⽣什么?s.encode('gb2312')这⾥会发⽣⼀个异常:Python 会⾃动的先将 s 解码为 unicode ,然后再编码成 gb2312。

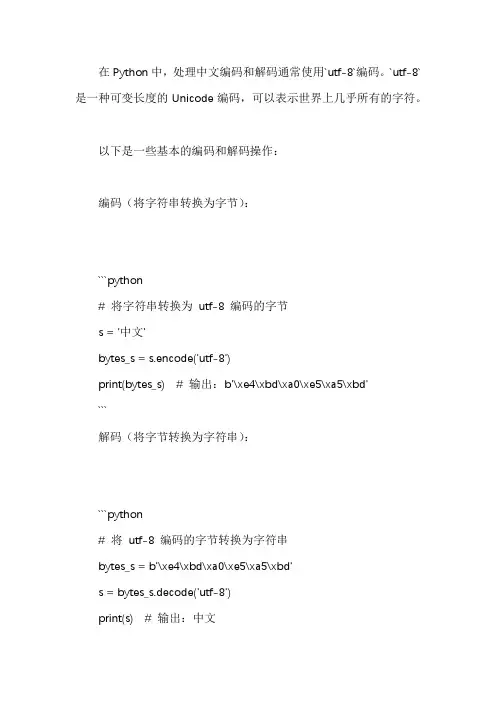

在Python中,处理中文编码和解码通常使用`utf-8`编码。

`utf-8`是一种可变长度的Unicode编码,可以表示世界上几乎所有的字符。

以下是一些基本的编码和解码操作:

编码(将字符串转换为字节):

```python

# 将字符串转换为utf-8 编码的字节

s = '中文'

bytes_s = s.encode('utf-8')

print(bytes_s) # 输出:b'\xe4\xbd\xa0\xe5\xa5\xbd'

```

解码(将字节转换为字符串):

```python

# 将utf-8 编码的字节转换为字符串

bytes_s = b'\xe4\xbd\xa0\xe5\xa5\xbd'

s = bytes_s.decode('utf-8')

print(s) # 输出:中文

```

如果你需要处理的文本包含多种不同的字符集,可能需要使用更加复杂的编码方案,例如`base64`或者`quopri`等。

注意,Python 3 默认使用`utf-8` 编码,因此在大多数情况下,你不需要显式地指定编码。

但是,如果你需要处理一些特殊的字符集,或者与旧的API交互,那么显式地指定编码可能会很有用。

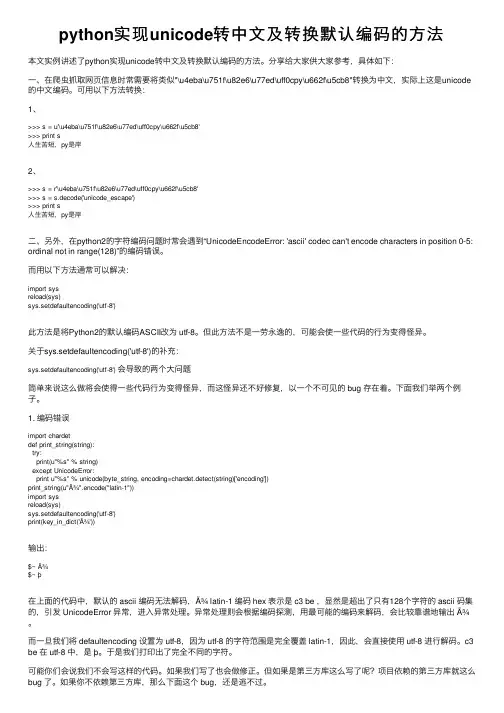

python实现unicode转中⽂及转换默认编码的⽅法本⽂实例讲述了python实现unicode转中⽂及转换默认编码的⽅法。

分享给⼤家供⼤家参考,具体如下:⼀、在爬⾍抓取⽹页信息时常需要将类似"\u4eba\u751f\u82e6\u77ed\uff0cpy\u662f\u5cb8"转换为中⽂,实际上这是unicode 的中⽂编码。

可⽤以下⽅法转换:1、>>> s = u'\u4eba\u751f\u82e6\u77ed\uff0cpy\u662f\u5cb8'>>> print s⼈⽣苦短,py是岸2、>>> s = r'\u4eba\u751f\u82e6\u77ed\uff0cpy\u662f\u5cb8'>>> s = s.decode('unicode_escape')>>> print s⼈⽣苦短,py是岸⼆、另外,在python2的字符编码问题时常会遇到“UnicodeEncodeError: 'ascii' codec can't encode characters in position 0-5: ordinal not in range(128)”的编码错误。

⽽⽤以下⽅法通常可以解决:import sysreload(sys)sys.setdefaultencoding('utf-8')此⽅法是将Python2的默认编码ASCII改为 utf-8。

但此⽅法不是⼀劳永逸的,可能会使⼀些代码的⾏为变得怪异。

关于sys.setdefaultencoding('utf-8')的补充:sys.setdefaultencoding('utf-8') 会导致的两个⼤问题简单来说这么做将会使得⼀些代码⾏为变得怪异,⽽这怪异还不好修复,以⼀个不可见的 bug 存在着。

python字符串编码python默认编码 python 2.x默认的字符编码是ASCII,默认的⽂件编码也是ASCII。

python 3.x默认的字符编码是unicode,默认的⽂件编码是utf-8。

中⽂乱码问题 ⽆论以什么编码在内存⾥显⽰字符,存到硬盘上都是⼆进制,所以编码不对,程序就会出错。

常见编码有ascii编码(美国),GBK编码(中国),shift_JIS编码(⽇本),unicode(统⼀编码)等。

需要注意的是,存到硬盘上时是以何种编码存的,再从硬盘上读出来时,就必须以何种编码读,要不然就会出现乱码问题。

常见的编码错误的原因有如下,出现乱码时,按照编码之前的关系,挨个排错就能解决问题。

python解释器的默认编码; Terminal使⽤的编码; python源⽂件⽂件编码; 操作系统的语⾔设置。

Python⽀持中⽂的编码:utf-8、gbk和gb2312。

uft-8为国际通⽤,常⽤有数据库、编写代码。

gbk如windows的cmd使⽤。

编码转换 如果想要中国的软件可以正常的在美国⼈的电脑上实现,有下⾯两种⽅法: 让美国⼈的电脑都装上gbk编码 让你的软件编码以utf-8编码 第⼀种⽅法不可现实,第⼆种⽅法⽐较简单,但是也只能针对新开发的软件,如果之前开发的软件就是以gbk的编码写的,上百万⾏代码已经写出去了,重新编码成utf-8格式也会费很⼤⼒⽓。

所以,针对已经⽤gbk开发的软件项⽬如何进⾏编码转换,利⽤unicode的⼀个包含了跟全球所有国家编码映射关系的功能,就可以实现编码转换。

⽆论以什么编码存储的数据,只要我们的软件把数据从硬盘上读到内存,转成unicode来显⽰即可,由于所有的系统、编程语⾔都默认⽀持unicode,所有我们的gbk编码软件放在美国电脑上,加载到内存⾥⾯,变成了unicode,中⽂就可正常展⽰。

类似⽤如下的转码的过程: 源有编码 -> unicode编码 -> ⽬的编码 decode("UTF-8") 解码 --> unicode --> encode("gbk") 编码#_*_coding:utf-8_*_ 的作⽤ 在python2⽂件中,经常在⽂件开头看到“ #_*_coding:utf-8 _*_ ”语句,它的作⽤是告诉python解释器此.py⽂件是utf-8编码,需要⽤utf-8的编码去读取这个.py⽂件。

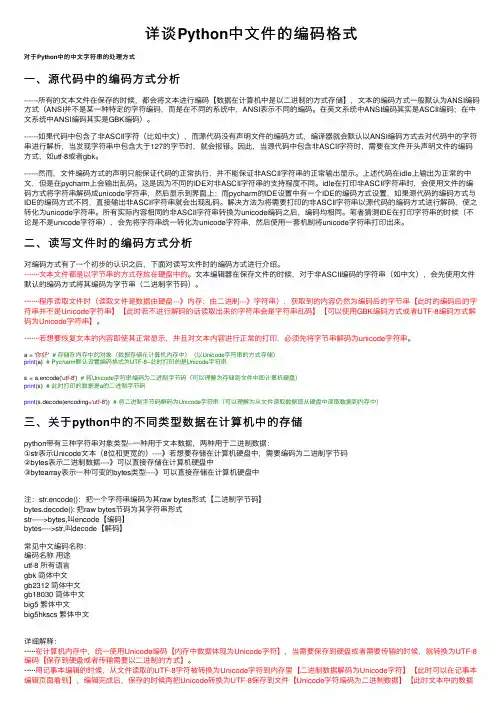

详谈Python中⽂件的编码格式对于Python中的中⽂字符串的处理⽅式⼀、源代码中的编码⽅式分析------所有的⽂本⽂件在保存的时候,都会将⽂本进⾏编码【数据在计算机中是以⼆进制的⽅式存储】,⽂本的编码⽅式⼀般默认为ANSI编码⽅式(ANSI并不是某⼀种特定的字符编码,⽽是在不同的系统中,ANSI表⽰不同的编码。

在英⽂系统中ANSI编码其实是ASCII编码;在中⽂系统中ANSI编码其实是GBK编码)。

------如果代码中包含了⾮ASCII字符(⽐如中⽂),⽽源代码没有声明⽂件的编码⽅式,编译器就会默认以ANSI编码⽅式去对代码中的字符串进⾏解析,当发现字符串中包含⼤于127的字节时,就会报错。

因此,当源代码中包含⾮ASCII字符时,需要在⽂件开头声明⽂件的编码⽅式,如utf-8或者gbk。

------然⽽,⽂件编码⽅式的声明只能保证代码的正常执⾏,并不能保证⾮ASCII字符串的正常输出显⽰。

上述代码在idle上输出为正常的中⽂,但是在pycharm上会输出乱码。

这是因为不同的IDE对⾮ASCII字符串的⽀持程度不同。

idle在打印⾮ASCII字符串时,会使⽤⽂件的编码⽅式将字符串解码成unicode字符串,然后显⽰到界⾯上;⽽pycharm的IDE设置中有⼀个IDE的编码⽅式设置,如果源代码的编码⽅式与IDE的编码⽅式不同,直接输出⾮ASCII字符串就会出现乱码。

解决⽅法为将需要打印的⾮ASCII字符串以源代码的编码⽅式进⾏解码,使之转化为unicode字符串。

所有实际内容相同的⾮ASCII字符串转换为unicode编码之后,编码均相同。

笔者猜测IDE在打印字符串的时候(不论是不是unicode字符串),会先将字符串统⼀转化为unicode字符串,然后使⽤⼀套机制将unicode字符串打印出来。

⼆、读写⽂件时的编码⽅式分析对编码⽅式有了⼀个初步的认识之后,下⾯对读写⽂件时的编码⽅式进⾏介绍。

Python中⽂GBK编码解决实例x = u"中⽂你好"print s运⾏上述代码,Python会给出下⾯的错误提⽰说是遇到⾮ASCII字符了,并让我们参考pep-0263。

PEP-0263(Python Enhancement Proposal)上⾯说得很清楚了,Python也意识到了国际化问题,并提出了解决⽅案。

根据提案上⾯的要求,我们有如下代码# -*- coding:gb2312 -*- #必须在第⼀⾏或者第⼆⾏print "-------------code 1----------------"a = "中⽂a我爱你"print aprint a.find("我")b = a.replace("爱", "喜欢")print bprint "--------------code 2----------------"x = "中⽂a我爱你"y = unicode(x, "gb2312")print y.encode("gb2312")print y.find(u"我")z = y.replace(u"爱", u"喜欢")print z.encode("gb2312")print "---------------code 3----------------"print y程序运⾏的结果如下:-------------code 1----------------中⽂a我爱你5中⽂a我喜欢你--------------code 2----------------中⽂a我爱你3中⽂a我喜欢你---------------code 3----------------Traceback (most recent call last):File "G:\Downloads\eclipse\workspace\p\src\hello.py", line 16, in <module>print yUnicodeEncodeError: 'ascii' codec can't encode characters in position 0-1: ordinal not in range(128)我们可以看到,通过引⼊编码声明,我们可以正常地在使⽤中⽂了,⽽且在code 1和2中,控制台也能正确的把中⽂打印出来。

python实现中文和unicode转换Python提供了多种方法来实现中文和Unicode的转换。

下面是一些常用的方法:1. 使用encode(和decode(方法:```# 将中文转换为Unicodechinese = "你好"unicode_chinese = chinese.encode('unicode_escape')# 将Unicode转换为中文unicode_string = b"\\u4f60\\u597d"chinese_string = unicode_string.decode('unicode_escape')```2. 使用str(和repr(函数:```# 将中文转换为Unicodechinese = "你好"unicode_chinese = repr(chinese)# 将Unicode转换为中文unicode_string = r"\u4f60\u597d"chinese_string = eval('"' + unicode_string + '"')```3. 使用codecs模块:```import codecs# 将中文转换为Unicodechinese = "你好"unicode_chinese = codecs.unicode_escape_encode(chinese)[0] # 将Unicode转换为中文unicode_string = "\\u4f60\\u597d"chinese_string =codecs.unicode_escape_decode(unicode_string)[0]```4. 使用unicode字符串和普通字符串之间的转换:```# 将中文转换为Unicodechinese = u"你好"unicode_chinese = chinese.encode('unicode_escape')# 将Unicode转换为中文unicode_string = u"\\u4f60\\u597d"chinese_string = unicode_string.decode('unicode_escape')```以上方法都可以实现中文和Unicode的转换,并且可以根据具体的需求选择适合的方法来使用。

pythonunicode转中⽂及转换默认编码汉字前⾯加个u就可以把汉字转换成unicode编码格式In [1]: s = u"学海⽆涯,回头是岸"In [2]: sOut[2]: u'\u5b66\u6d77\u65e0\u6daf\uff0c\u56de\u5934\u662f\u5cb8'In [3]: print s学海⽆涯,回头是岸1.在爬⾍抓取⽹页信息时常需要将类似 '\u82e6\u6d77\u65e0\u6daf\u56de\u5934\u662f\u5cb8' 转换为中⽂,实际上这是unicode的中⽂编码。

可⽤以下⽅法转换(注意⼀个前⾯有u⼀个没有):In [1]: s = '\u82e6\u6d77\u65e0\u6daf\u56de\u5934\u662f\u5cb8'In [2]: print s.decode("unicode_escape")苦海⽆涯回头是岸In [3]:或者:In [7]: s = u'\u82e6\u6d77\u65e0\u6daf\u56de\u5934\u662f\u5cb8'In [8]: print s苦海⽆涯回头是岸2.在python2的字符编码问题时常会遇到“UnicodeEncodeError: 'ascii' codec can't encode characters in position 0-5: ordinal not in range(128)”的编码错误。

可以⽤以下⽅法通常可以解决:import sysreload(sys)sys.setdefaultencoding('utf-8')此⽅法是将Python2的默认编码ASCII改为 utf-8。

但此⽅法不是⼀劳永逸的,可能会使⼀些代码的⾏为变得怪异。

在Python 中,字符编码是指将字符映射到二进制数据的规则。

在处理中文文本时,常见的字符编码包括 UTF-8、UTF-16、GB2312、GBK 等。

下面是一些常见的Python 中文编码相关的知识点:

1. 字符串和编码:

在 Python 3 中,字符串默认使用 Unicode 编码,这使得处理多语言字符变得更加方便。

你可以使用str.encode()方法将字符串编码为指定的字节序列,或者使用bytes.decode()方法将字节序列解码为字符串。

2. 文件编码:

在处理文件时,通常需要注意文件的编码。

打开文件时可以指定编码,例如:

3. Python 源代码文件编码:

在 Python 源代码文件的开头,可以使用特定的注释来指定源代码文件的编码,以

确保正确解析中文注释和字符串。

4. 处理不同编码之间的转换:

如果你需要在不同编码之间转换,可以使用encode()和decode()方法,同时注意处

理可能的编码错误。

5. 使用chardet库检测文件编码:

如果你不确定文件的编码,可以使用第三方库chardet来检测文件编码。

这是一些基本的关于 Python 中文编码的知识点,确保在处理中文字符时正确选择和使用编码是非常重要的。

PythonPEP8编码规范中⽂版Code lay-out 代码布局Indentation 缩进Tabs or Spaces 制表符还是空格Maximum Line Length ⾏的最⼤长度Should a line break before or after a binary operator 在⼆元运算符之前应该换⾏吗Blank Lines 空⾏Source File Encoding 源⽂件编码Imports 导⼊Module level dunder names 模块级的呆名String Quotes 字符串引号Whitespace in Expressions and Statements 表达式和语句中的空格Pet Peeves 不能忍受的事情Other Recommendations 其他建议Comments 注释Block Comments 块注释Inline Comments ⾏内注释Documentation Strings ⽂档字符串Naming Conventions 命名规范Overriding Principle 最重要的原则Descriptive Naming Styles 描述命名风格Prescriptive Naming Conventions 约定俗成命名约定Names to Avoid 应避免的名字Package and Module Names 包名和模块名Class Names 类名Exception Names 异常名Global Variable Names 全局变量名Function Names 函数名Function and method arguments 函数和⽅法参数Method Names and Instance Variables ⽅法名和实例变量Constants 常量Designing for inheritance 继承的设计Public and internal interfaces 公共和内部的接⼝Programming Recommendations 编程建议Function Annotations 功能注释。

彻底搞懂Python字符编码不论你是有着多年经验的 Python ⽼司机还是刚⼊门 Python 不久,你⼀定遇到过UnicodeEncodeError、UnicodeDecodeError 错误,每当遇到错误我们就拿着 encode、decode 函数翻来覆去的转换,有时试着试着问题就解决了,有时候怎么试都没辙,只有借⽤ Google ⼤神帮忙,但似乎很少去关⼼问题的本质是什么,下次遇到类似的问题重蹈覆辙,那么你有没有想过⼀次性彻底把 Python 字符编码给搞懂呢?完全理解字符编码与 Python 的渊源前,我们有必要把⼀些基础概念弄清楚,虽然有些概念我们每天都在接触甚⾄在使⽤它,但并不⼀定真正理解它。

⽐如:字节、字符、字符集、字符码、字符编码。

字节字节(Byte)是计算机中数据存储的基本单元,⼀字节等于⼀个8位的⽐特,计算机中的所有数据,不论是保存在磁盘⽂件上的还是⽹络上传输的数据(⽂字、图⽚、视频、⾳频⽂件)都是由字节组成的。

字符你正在阅读的这篇⽂章就是由很多个字符(Character)构成的,字符⼀个信息单位,它是各种⽂字和符号的统称,⽐如⼀个英⽂字母是⼀个字符,⼀个汉字是⼀个字符,⼀个标点符号也是⼀个字符。

字符集字符集(Character Set)就是某个范围内字符的集合,不同的字符集规定了字符的个数,⽐如 ASCII 字符集总共有128个字符,包含了英⽂字母、阿拉伯数字、标点符号和控制符。

⽽ GB2312 字符集定义了7445个字符,包含了绝⼤部分汉字字符。

字符码字符码(Code Point)指的是字符集中每个字符的数字编号,例如 ASCII 字符集⽤ 0-127 连续的128个数字分别表⽰128个字符,例如 "A" 的字符码编号就是65。

字符编码字符编码(Character Encoding)是将字符集中的字符码映射为字节流的⼀种具体实现⽅案,常见的字符编码有 ASCII 编码、UTF-8 编码、GBK 编码等。