高等代数7.4 特征值与特征向量

- 格式:pdf

- 大小:479.58 KB

- 文档页数:30

特征值与特征向量特征值与特征向量是线性代数中的重要概念,它们在矩阵理论、物理学、工程等领域有着广泛的应用。

本文将对特征值与特征向量进行详细讲解,并介绍它们的一些重要性质和应用。

一、特征值与特征向量的定义在线性代数中,给定一个n阶方阵A,非零向量x若满足Ax=kx,其中k为一个标量,那么我们称k为矩阵A的特征值,x为矩阵A对应于特征值k的特征向量。

特征值和特征向量是矩阵A的固有性质,它们描述了矩阵在线性变换下的一些重要特性。

二、求解特征值与特征向量要求解一个矩阵的特征值与特征向量,我们可以通过求解特征方程来实现。

特征方程是一个关于特征值的多项式方程,形式为|A-kI|=0,其中I为单位矩阵,k为特征值。

解特征方程可以得到特征值的值,然后将特征值代入到(A-kI)x=0中,求解线性方程组即可得到特征向量。

特征值与特征向量是成对存在的,对于矩阵A的每一个特征值k,都对应着一个特征向量。

一个矩阵最多有n个特征值,但是可能有重复的特征值。

三、特征值与特征向量的重要性质特征值与特征向量具有以下重要性质:1. 特征向量与特征值的个数相等,一一对应。

2. 特征值可以为实数或复数,特征向量可以为实向量或复向量。

3. 若特征值为k,则对应的特征向量不唯一,可乘以一个非零常数得到不同的特征向量。

4. 矩阵的迹等于特征值的和,行列式等于特征值的积。

特征值与特征向量的这些性质在实际问题中有着重要的应用,可以用于矩阵的对角化、求解线性方程组、图像处理、物理模型的求解等领域。

四、特征值与特征向量的应用1. 数据降维在数据处理中,我们经常会遇到维度灾难,即特征维度非常高,而样本量较小。

利用特征值与特征向量,我们可以将高维度的数据降低到低维度,从而简化计算和数据处理过程,提高算法效率。

2. 图像处理图像可以用矩阵来表示,而图像的特性往往由矩阵的特征值与特征向量来描述。

利用特征值与特征向量,我们可以进行图像的压缩、图像的特征提取、图像的增强等图像处理操作。

特征值与特征向量在数学中,特征值和特征向量是矩阵与线性变换的重要概念。

特征值可以帮助我们理解线性变换对向量运动的影响,而特征向量则描述了这种影响的方向。

本文将介绍特征值与特征向量的定义、性质以及它们在实际问题中的应用。

一、特征值与特征向量的定义对于一个n维向量空间中的线性变换T,如果存在一个非零向量v使得T(v) = λv 成立,其中λ为一个标量,那么我们称λ为T的特征值,v为T对应于特征值λ的特征向量。

特征值和特征向量可以通过求解线性方程组来获得。

设A是一个n×n的矩阵,并且v是一个非零向量,则有Av = λv 成立。

这是一个齐次线性方程组。

解该方程组即可得到特征值和特征向量。

二、特征值与特征向量的性质1. 特征值与特征向量的存在性和唯一性对于一个n×n的矩阵A,它的特征值存在和特征向量存在的条件是相同的。

一个矩阵最多有n个不同的特征值,每个特征值对应的特征向量也可以有多个。

但是特征向量一定是线性相关的。

2. 特征值与特征向量的性质(1)特征值的和等于矩阵的迹如果A是一个n×n的矩阵,λ₁、λ₂、...、λₙ是其特征值,则有λ₁+λ₂+...+λₙ = tr(A),其中tr(A)表示矩阵A的迹。

(2)特征值的乘积等于矩阵的行列式如果A是一个n×n的矩阵,则特征值的乘积等于矩阵的行列式,即λ₁*λ₂*...*λₙ = det(A),其中det(A)表示矩阵A的行列式。

(3)特征值的倒数等于矩阵的逆矩阵的特征值如果A是一个可逆矩阵,λ₁、λ₂、...、λₙ是其特征值,则A的逆矩阵的特征值为λ₁⁻¹、λ₂⁻¹、...、λₙ⁻¹。

三、特征值与特征向量的应用特征值和特征向量在实际问题中有广泛的应用。

下面列举了其中的几个应用领域:1. 特征值分解特征值分解是将一个矩阵分解为特征值和特征向量的形式。

特征值分解在许多领域中都有广泛的应用,如信号处理、图像压缩和降维等。

特征值和特征向量的基本定义及运算特征值和特征向量是线性代数中的两个重要概念,广泛应用于机器学习、图像处理、信号处理等领域中。

本文旨在介绍特征值和特征向量的基本定义及运算,并探讨其在实际中的应用。

一、特征值与特征向量的定义在线性代数中,矩阵是一个非常重要的概念。

一个 n × n 的矩阵 A 是由 n 行 n 列的元素组成的,并且可以用列向量的形式表示为 A = [a1, a2, ..., an]。

其中,ai 表示矩阵 A 的第 i 列的列向量。

矩阵 A 的特征向量是指一个非零向量 v,满足Av = λv,其中λ 是一个常数,称作该矩阵的特征值。

通常情况下,特征向量 v 与特征值λ 是成对出现的,即一个特征向量对应一个特征值。

二、特征值与特征向量的求解特征值和特征向量的求解是线性代数中的一个经典问题。

一般情况下,可以通过求解矩阵 A 的特征多项式来求解其特征值。

设矩阵 A 的特征多项式为f(λ) = |A - λI|,其中 I 表示单位矩阵。

则 A 的特征值即为方程f(λ) = 0 的根。

对于每个特征值λ,可通过解如下方程组来求解对应的特征向量:(A - λI)v = 0其中,v 表示特征向量,0 表示零向量。

上述方程组的解空间为 A - λI 的零空间,也称为矩阵 A 的特征子空间。

如果矩阵 A 的特征值λ 是重根,则λ 对应的特征向量有多个线性无关的向量。

此时,可求解齐次线性方程组 (A - λI)v = 0 的基础解系,从中选取线性无关的向量作为特征向量。

三、特征值与特征向量的性质特征值与特征向量有一些重要的性质,其中较为常见的包括:1. 特征值的和等于矩阵的迹设矩阵 A 的特征值为λ1, λ2, ..., λn,则有:λ1 + λ2 + ... + λn = tr(A)其中,tr(A) 表示矩阵 A 的迹,即主对角线上元素的和。

2. 特征值的积等于矩阵的行列式设矩阵 A 的特征值为λ1, λ2, ..., λn,则有:λ1 λ2 ... λn = |A|其中,|A| 表示矩阵 A 的行列式。

特征值和特征向量特征值和特征向量是线性代数中重要的概念,广泛应用于各个领域的数学和科学问题中。

特征值和特征向量的理解和运用对于解决线性代数中的矩阵方程、特征分解以及一些实际问题有着重要的意义。

一、特征值与特征向量的定义在线性代数中,对于一个n阶方阵A,如果存在一个非零向量x,使得下式成立:A·x=λ·x其中,λ为一个复数,称为矩阵A的特征值,x称为对应于特征值的特征向量。

对于方阵A,可能存在多个特征值和对应的特征向量。

二、特征值和特征向量的性质1. 特征向量的长度无关紧要:特征向量的长度没有具体的要求,只要方向相同即可。

2. 特征向量是线性的:如果v是一个A的特征向量,那么对于任意标量k都有kv仍是A的特征向量。

3. 不同特征值对应的特征向量是线性无关的:如果λ1≠λ2,则对应的特征向量v1和v2线性无关。

三、求解特征值和特征向量的方法针对不同的方阵A,求解特征值和特征向量的方法也有所不同,常用的方法有以下几种:1. 特征方程法:令A-λI=0,其中I是单位矩阵,解方程A-λI=0可以得到方阵A的特征值λ。

然后将特征值带入方程(A-λI)x=0,求解得到方阵A对应特征值的特征向量。

2. 幂法:通过迭代的方法求解矩阵的特征值和特征向量。

先随机选择一个向量x0,然后通过迭代运算得到序列x0,Ax0,A^2x0,...,A^nx0,其中n为迭代次数。

当n足够大时,序列将收敛到A的特征向量。

3. Jacobi方法:通过迭代矩阵的相似变换,将矩阵对角化。

该方法通过交换矩阵的不同行和列来逐步减小非对角元素,最终得到对角矩阵,对角线上的元素即为特征值。

四、特征值和特征向量的应用特征值和特征向量在很多领域中都有广泛的应用,包括以下几个方面:1. 图像处理:特征值和特征向量可用于图像的降维和特征提取,通过对图像的特征向量进行分析,可以获得图像的主要特征。

2. 特征分析:特征值和特征向量可用于分析复杂系统的稳定性、动态响应和振动特性,如机械系统、电路系统等。

特征值与特征向量特征值与特征向量是线性代数中重要的概念,它们在矩阵理论和多个领域中都有广泛的应用。

特征值与特征向量的理解对于深入理解线性代数的基础及其应用具有重要的意义。

本文将简要介绍特征值与特征向量的概念、性质及其应用,并通过示例加深理解。

1. 概念特征值和特征向量是矩阵理论中一个重要的概念。

对于一个n阶矩阵A,如果存在一个非零向量x,使得Ax=kx,其中k为一个常数,那么k称为矩阵A的特征值,x称为对应于特征值k的特征向量。

特征值与特征向量总是成对出现的,一个特征向量对应一个特征值。

2. 性质(1)特征值是矩阵的本征性质,是一个与矩阵本身相关的特征。

(2)特征向量是矩阵A的一个零空间的非零向量,表示在矩阵A 的作用下,该向量只发生一个伸缩变换,方向不变。

(3)特征值和特征向量存在一定的关系,特征值为k的特征向量与特征值为-1/k的特征向量互为相反数。

(4)特征值的个数等于矩阵的秩,特征向量的个数与矩阵的阶数相同。

3. 应用特征值与特征向量在多个学科领域具有广泛的应用,以下列举几个常见的应用案例:(1)数据降维:在机器学习和数据挖掘中,通过对数据矩阵的特征值分解,可以实现数据的降维处理,减少冗余信息,提高计算效率。

(2)图像处理:图像处理中常常利用矩阵的特征值与特征向量进行图像的压缩、滤波、边缘检测等操作。

例如,利用特征值分解进行图像去噪处理。

(3)网络分析:在网络分析中,可以利用特征值与特征向量来研究网络结构的特征,如网络的连通性、中心性等。

(4)量子力学:量子力学中的波函数也可以通过特征值和特征向量的计算得到,从而得到物理系统的某些性质。

通过以上示例,我们可以看到特征值与特征向量在多个领域中的重要性。

对于线性代数的学习,深入理解特征值与特征向量的概念、性质及其应用,对于进一步的学术研究和应用都具有重要的意义。

总结:特征值与特征向量是矩阵理论中重要的概念,它们在多个学科领域中有广泛的应用。

特征值是矩阵的本征性质,特征向量表示在矩阵作用下只发生一个伸缩变换。

特征值和特征向量首先,我们先来了解一下矩阵。

矩阵是由一个矩形的数组组成的,其中的每个元素都可以是实数或复数。

例如,3x3的矩阵可以写为:A=[abc][def][ghi]Av=λv那么v就是矩阵A的特征向量,λ就是矩阵A的特征值。

换句话说,特征向量在矩阵的变换下只发生拉伸或缩放,而不发生旋转或扭曲。

特征值表示特征向量被拉伸或缩放的比例。

det(A - λI) = 0其中,det表示矩阵的行列式,I是单位矩阵。

通过解特征方程,我们可以求得特征值λ。

然后,我们可以将每个特征值代入原方程Av =λv中,从而求得对应的特征向量v。

1.矩阵的对角化:特征值和特征向量可以帮助我们将一个复杂的矩阵对角化,即将矩阵表示为对角矩阵的形式。

对角化后的矩阵更容易进行计算和分析,也更便于推导矩阵的性质。

2.矩阵的相似性:如果一个方阵A和B有相同的特征值和特征向量,那么A和B是相似的。

相似的矩阵在一些数学和物理问题中具有相同的性质和行为,因此,通过特征值和特征向量可以判断矩阵的相似性。

3.矩阵的主成分分析(PCA):主成分分析是一种常用的数据降维方法,它可以通过计算矩阵的特征值和特征向量,将高维数据降低到低维空间中。

通过PCA,我们可以找到数据中最重要的特征和主要方向,从而减少冗余信息。

4.矩阵的奇异值分解(SVD):奇异值分解是矩阵分解的一种重要方法,它可以将一个任意形状的矩阵表示为三个矩阵的乘积。

在奇异值分解中,矩阵的特征值和特征向量扮演了重要的角色。

5.线性变换和矩阵的谱:特征值和特征向量可以帮助我们理解和描述线性变换和矩阵的谱。

谱是矩阵A的特征值的集合,它可以提供关于矩阵的一些性质信息,比如矩阵的正定性、对称性、收敛性等。

总结起来,特征值和特征向量是矩阵理论中非常重要的概念。

它们可以帮助我们理解和描述矩阵的性质和变换,以及在许多实际问题中的应用。

特征值和特征向量的计算和应用对于数学、物理、工程和计算机科学等领域都有重要意义。

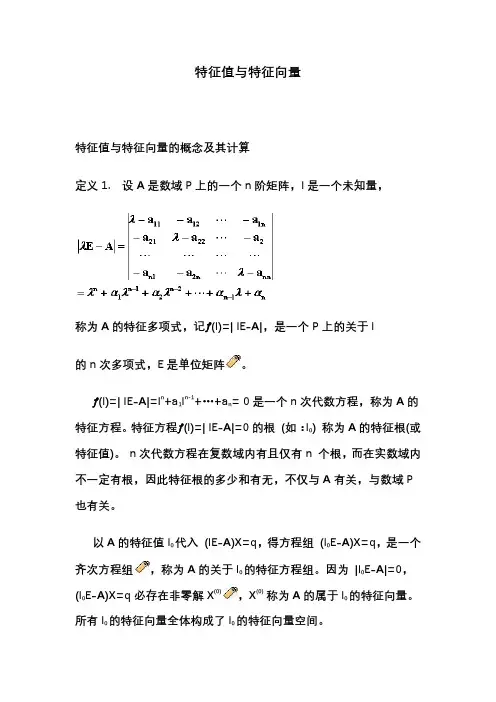

特征值与特征向量特征值与特征向量的概念及其计算定义1. 设A是数域P上的一个n阶矩阵,l是一个未知量,称为A的特征多项式,记ƒ(l)=| lE-A|,是一个P上的关于l的n次多项式,E是单位矩阵。

ƒ(l)=| lE-A|=l n+a1l n-1+…+a n= 0是一个n次代数方程,称为A的特征方程。

特征方程ƒ(l)=| lE-A|=0的根(如:l0) 称为A的特征根(或特征值)。

n次代数方程在复数域内有且仅有n 个根,而在实数域内不一定有根,因此特征根的多少和有无,不仅与A有关,与数域P 也有关。

以A的特征值l0代入(lE-A)X=q,得方程组(l0E-A)X=q,是一个齐次方程组,称为A的关于l0的特征方程组。

因为|l0E-A|=0,(l0E-A)X=q必存在非零解X(0),X(0) 称为A的属于l0的特征向量。

所有l0的特征向量全体构成了l0的特征向量空间。

一.特征值与特征向量的求法对于矩阵A,由AX=l0X,l0EX=AX,得:[l0E-A]X=q即齐次线性方程组有非零解的充分必要条件是:即说明特征根是特征多项式|l 0E-A| =0的根,由代数基本定理有n个复根l1, l2,…, l n,为A的n个特征根。

当特征根l i (I=1,2,…,n)求出后,(l i E-A)X=q是齐次方程,l i均会使|l i E-A|=0,(l i E-A)X=q必存在非零解,且有无穷个解向量,(l i E-A)X=q 的基础解系以及基础解系的线性组合都是A的特征向量。

例1. 求矩阵的特征值与特征向量。

解:由特征方程解得A有2重特征值l1=l2=-2,有单特征值l3=4对于特征值l1=l2=-2,解方程组(-2E-A)x=q得同解方程组x1-x2+x3=0解为x1=x2-x3 (x2,x3为自由未知量)分别令自由未知量得基础解系所以A的对应于特征值l1=l2=-2的全部特征向量为x=k1x1+k2x2 (k1,k2不全为零)可见,特征值l=-2的特征向量空间是二维的。

特征值与特征向量_一、特征值与特征向量的定义在线性代数中,对于一个nxn的矩阵A,如果存在一个非零向量v,使得Av=λv,其中λ是一个常数,则称λ为矩阵A的特征值,v为对应的特征向量。

特征向量是指矩阵在一些方向上的不发生变化的向量,而特征值则表示该方向上的缩放比例。

矩阵乘以特征向量v等于用特征值λ来放缩这个向量。

二、特征值与特征向量的性质1.特征值和特征向量总是成对出现,即一个特征向量对应一个特征值,可能有多个特征向量对应同一个特征值。

2.特征值可以为复数,但如果A是实对称矩阵,则特征值一定是实数。

3.矩阵的特征值可以通过求解方程,A-λI,=0得到,其中I是单位矩阵。

4.特征向量可以通过求解方程(A-λI)v=0得到,其中0是全零向量。

5.特征值的和等于矩阵的迹(所有主对角线上的元素之和),特征值的乘积等于矩阵的行列式。

三、特征值与特征向量的应用1.特征值分解特征值分解是矩阵分析中非常重要的一种分解方法,对于一个nxn的矩阵A,其特征值分解为A=VΛV^(-1),其中V是由特征向量构成的矩阵,Λ是由特征值构成的对角矩阵。

特征值分解可以用于求解线性方程组、矩阵的幂次计算、矩阵的逆等问题,也可以用于降维和数据压缩等领域。

2.特征值与特征向量的几何意义特征向量可以表示矩阵的一些方向上的不变性,通过求解矩阵的特征向量,可以了解矩阵对于不同方向上的变化情况。

例如,在计算机图形学中,可以通过矩阵的特征向量来描述形状的变化、旋转、缩放等操作。

3.矩阵的谱分析通过分析矩阵的特征值和特征向量,可以了解矩阵的性质和结构。

例如,对于对角矩阵,其特征值就是主对角线上的元素,特征向量为标准基向量。

四、总结特征值与特征向量是线性代数中的重要概念,具有广泛的应用。

特征值与特征向量可以用于矩阵分解、线性方程组求解、数据压缩和图形变换等问题,对于理解和分析矩阵的性质和结构有着重要的意义。

深入理解特征值与特征向量的概念和性质,对于掌握线性代数和应用数学具有重要的作用。

特征值与特征向量高等代数应用解析在高等代数中,特征值与特征向量是矩阵理论中一对非常重要且密切相关的概念。

它们在解析几何、线性代数、物理学等领域中都有着广泛的应用。

本文将对特征值与特征向量这一概念进行详细解析,并探讨它们在高等代数中的应用。

一、特征值与特征向量的定义特征值与特征向量是矩阵理论中的基本概念。

对于一个n阶方阵A,如果存在一个非零向量X,使得AX=kX,其中k为常数,则称k为矩阵A的特征值,X为矩阵A对应于特征值k的特征向量。

特征值和特征向量的计算可以通过求解矩阵A的特征方程来完成。

设A为一个n阶方阵,则特征方程的形式为|A-λI|=0,其中λ为特征值,I为n阶单位矩阵。

解特征方程可以得到矩阵A的所有特征值,然后通过将特征值代入(A-λI)X=0求解方程组,可以得到对应于每个特征值的特征向量。

二、特征值与特征向量的性质特征值与特征向量具有一些重要的性质和特点,其中包括:1. 特征值与特征向量是成对出现的。

一个矩阵可以有一个或多个特征值,每个特征值都对应着一个特征向量。

2. 矩阵的特征值与其行列式、迹有关。

矩阵的特征值之和等于其行列式,特征值的乘积等于其行列式并且等于矩阵的迹。

3. 特征向量之间线性无关。

对于不同的特征值对应的特征向量,它们线性无关,即它们不能表示为其中任意一个特征向量的线性组合。

4. 特征值与特征向量的数目相等。

一个矩阵的特征值的数目等于其阶数,也就是方阵的维数。

三、特征值与特征向量的应用特征值与特征向量在高等代数中有着广泛的应用,下面将介绍它们在解析几何、线性代数和物理学等领域中的应用。

1. 解析几何中的应用:特征向量可以用来描述图形的基本特性,比如旋转、缩放和平移等操作。

利用特征值与特征向量可以进行主成分分析,用于数据降维、图像处理等领域。

2. 线性代数中的应用:特征值与特征向量可以帮助我们解决线性方程组的问题,求解矩阵的幂,计算矩阵的奇异值等。

它们还被广泛应用于网络分析、量子力学等领域。

特征值与特征向量1.特征值与特征向量的数学定义在矩阵论中,一个n阶方阵A的特征值(eigenvalue)是一个数λ,使得存在一个非零n维向量x,满足以下关系式:Ax=λx其中x称为该特征值对应的特征向量(eigenvector)。

特征向量x是与特征值λ对应的“向量空间”中的非零向量,它描述了特征值所对应的变换方向或拉伸比例。

2.特征值与特征向量的性质(1)特征值与特征向量的关系:对于方阵A和其特征值λ,Ax=λx。

这意味着矩阵A将特征向量x拉伸(或压缩)了λ倍。

(2)特征值的重要性质:矩阵A的特征值λ满足特征多项式的方程式p(λ) = det(A-λI) = 0,其中I是单位矩阵。

这个方程式的根就是矩阵A的特征值。

(3)特征向量的线性组合:如果x1、x2、..、xk是矩阵A的特征向量,对应的特征值分别是λ1、λ2、..、λk,那么对于任意常数a1、a2、..、ak,它们的线性组合a1x1+a2x2+...+akxk也是矩阵A的特征向量。

(4)特征值的数量:对于一个n阶方阵A,一般有n个不同的特征值。

3.特征值与特征向量的应用(1)矩阵对角化:通过求解矩阵的特征值和特征向量,可以将一个方阵对角化。

对角化后的矩阵能更方便地进行计算和理解,例如求解高阶矩阵的幂、指数函数等。

(2)主成分分析(PCA):PCA是一种经典的降维方法,它通过求解协方差矩阵的特征值和特征向量,将高维特征转换为低维特征,从而实现数据的降维和可视化。

(3)图像处理:特征值和特征向量在图像压缩、图像增强和图像分析等领域中有广泛应用。

例如,可以利用图像的特征值和特征向量进行边缘检测、纹理提取和目标识别。

(4)量子力学中的态矢量:在量子力学中,态矢量可以看成是一个特殊的向量,它对应于系统的一个可观测性质。

量子态的演化过程可以用特征向量和特征值来描述。

总结:特征值与特征向量是矩阵理论中的重要内容,它们可以描述线性变换的特性,并且在多个学科领域中有广泛的应用。

高等代数中的特征值与特征向量在高等代数中,特征值与特征向量是研究矩阵性质和变换的重要工具。

特征值和特征向量描述了矩阵在线性变换下的一些重要特性,对于理解和解决许多实际问题具有重要意义。

一、特征值与特征向量的定义特征值是指矩阵A与其特征向量x相乘的结果与x的线性关系,即Ax=kx,其中k为常数。

特征向量是指在矩阵A的作用下,保持方向不变,只改变长度的非零向量。

二、特征值与特征向量的计算要计算矩阵的特征值与特征向量,可以通过求解特征方程来实现。

特征方程是通过将矩阵A减去kI(其中I为单位矩阵)后求解行列式的方式得到的,即det(A-kI)=0。

解特征方程可以得到矩阵的特征值,将特征值代入原方程可以求解对应的特征向量。

三、特征值与特征向量的应用特征值与特征向量在许多实际问题中有广泛的应用。

以下是几个常见的应用案例:1. 矩阵对角化通过求解矩阵的特征值与特征向量,可以将矩阵对角化,即将矩阵表示为对角矩阵与特征向量的乘积。

对角化可以简化矩阵计算,使得问题的求解更加容易。

2. 线性变换特征值与特征向量描述了线性变换的一些重要性质。

通过求解矩阵的特征值与特征向量,可以了解线性变换对空间的拉伸、压缩、旋转等变化。

这对于图像处理、机器学习等领域有着重要的应用。

3. 差分方程的稳定性分析差分方程是描述离散时间系统动态行为的重要工具。

通过求解差分方程对应的矩阵的特征值,可以判断差分方程的稳定性。

稳定性分析对于控制系统设计、信号处理等领域非常重要。

4. 特征脸识别特征脸识别是一种基于特征值与特征向量的人脸识别方法。

通过将人脸图像转换为特征向量,并计算特征向量之间的距离,可以判断两张人脸是否相似。

这种方法在人脸识别、安防等领域得到了广泛应用。

四、特征值与特征向量的性质特征值与特征向量具有一些重要的性质:1. 矩阵的特征值之和等于其迹(矩阵对角线元素之和),特征值之积等于其行列式的值。

2. 矩阵的特征向量是线性无关的,且特征向量对应不同特征值的特征向量也是线性无关的。

特征值与特征向量特征值和特征向量是线性代数中的重要概念,广泛应用于矩阵和向量的分析与计算。

它们在物理、工程、计算机科学等领域起到了至关重要的作用。

本文将介绍特征值和特征向量的定义、性质以及它们的应用。

一、特征值与特征向量的定义在矩阵理论中,我们定义了特征值和特征向量的概念。

给定一个n阶矩阵A,若存在一个非零向量x使得Ax=kx,其中k是一个标量,那么k就称为矩阵A的特征值,而x称为对应于特征值k的特征向量。

特征值和特征向量的定义可以表示为以下矩阵方程:Ax=kx。

这个方程可以进一步变形为(A-kI)x=0,其中I是n阶单位矩阵。

由于x是非零向量,所以(A-kI)必须是一个奇异矩阵,即它的行列式为0。

因此,我们可以通过求解(A-kI)的行列式为零的特征值,然后代入到(A-kI)x=0中,解出特征向量。

二、特征值与特征向量的性质特征值和特征向量有许多重要性质。

首先,特征值的个数等于矩阵的阶数。

其次,特征值可以是实数或复数。

对于实数矩阵,特征值可以是实数或复数共轭对。

对于复数矩阵,其特征值必定是复数。

特征向量也有一些重要性质。

首先,特征向量的长度可以为任意值,但是通常被归一化为单位向量。

其次,不同特征值所对应的特征向量是线性无关的。

最后,特征向量所张成的向量空间称为特征空间,特征空间的维度等于特征值的个数。

三、特征值与特征向量的应用特征值和特征向量在许多领域都有广泛的应用。

在物理学中,特征值和特征向量被用于描述量子力学中的态矢量和算子。

在工程学中,特征值和特征向量被用于结构动力学分析、振动模态分析等。

在图像处理和模式识别领域,特征值和特征向量被用于图像压缩、人脸识别等应用。

特征值和特征向量还有一些其他的应用。

在机器学习中,特征值和特征向量被用于降维算法,如主成分分析(PCA)。

在网络分析中,特征值和特征向量被用于识别网络中的重要节点。

在数值计算中,特征值和特征向量被用于求解线性方程组。

总之,特征值和特征向量是线性代数中的基本概念,为矩阵和向量的分析提供了有力的工具。

特征值和特征向量特征值和特征向量是线性代数中重要的概念。

它们在各个领域中有广泛的应用,如机器学习、图像处理、网络分析等。

本文将介绍特征值和特征向量的定义、性质和应用,并对其进行深入剖析。

特征值和特征向量是矩阵和线性变换的关键元素。

在线性代数中,矩阵可以看作是一个线性变换的表示,而特征值和特征向量则可以描述这个变换的一些重要性质。

首先,我们先定义特征值和特征向量。

对于一个n × n的方阵A,如果存在一个非零向量v和一个标量λ,使得满足Av = λv,则λ称为A的特征值,v称为对应于特征值λ的特征向量。

特征值描述了线性变换的缩放因子,特征向量则描述了变换后保持方向不变的向量。

特征值和特征向量有以下重要性质:1. 特征值可以是复数。

虽然特征值的定义要求它是一个标量,但实际上特征值可以是复数。

复数特征值对于某些问题的求解非常重要。

2. 特征向量的数量和特征值的数量相等。

对于一个n ×n的方阵A,它的特征值的数量和特征向量的数量都是n。

3. 特征向量可以线性相关但不能是零向量。

特征向量之间可能存在线性相关的关系,但不能是零向量,否则就不满足该方程。

特征值和特征向量在各个领域中有广泛的应用。

在机器学习中,特征值和特征向量可以用来进行数据降维和特征选择。

通过计算矩阵的特征值和特征向量,可以找到数据中最关键的特征,从而提高模型的性能。

在图像处理中,特征值和特征向量可以用来进行图像压缩和图像识别。

通过对图像进行矩阵变换,可以得到图像的特征向量。

利用这些特征向量,我们可以将图像压缩为更小的表示,或者用于图像的分类和识别。

在网络分析中,特征值和特征向量可以用来衡量网络的结构和节点的重要性。

通过对网络的邻接矩阵进行特征值分解,可以得到网络中的特征向量。

利用这些特征向量,我们可以评估网络的连通性、聚集性和节点的中心性,从而帮助我们理解和分析复杂的网络结构。

总结起来,特征值和特征向量是线性代数中重要的概念。