Hadoop项目实战教程67 - Mahout数据挖掘工具(3)

- 格式:ppt

- 大小:2.98 MB

- 文档页数:12

技术平台基于Hadoop电商大数据的挖掘与分析技术研究陈娥祥(福州工商学院,福建 福州 350715)摘 要:随着社会经济水平的不断提高和互联网时代的不断发展,全球数据逐渐呈现出大规模增长的趋势,为了满足海量数据处理需求,大数据挖掘与分析技术应运而生。

Hadoop的出现和应用不仅能科学、高效地处理海量数据,还能可视化展现海量数据最终处理结果,为电商企业的健康、可持续发展提供重要的数据参考和支持。

基于以上情况,以福州地区美容行业的电商系统为例,在介绍相关理论与技术的基础上分析了数据挖掘算法,从系统的整体设计、数据准备、数据挖掘分析三个方面入手,研究了电商大数据挖掘系统的设计,从实验环境、实验数据准备和实验结果分析三方面入手,探讨了系统可视化实现与效果。

希望通过这次深度分析与研究,对公司的运营决策提供有力帮助,为电商平台各方参与者、相关领域技术人员提供有效的借鉴和参考。

关键词:Hadoop;电商大数据;挖掘分析;可视化技术随着社交媒体的不断发展,企业处理数据的途径日益增加、规模日益扩大,并形成了海量的数据流。

在这样的背景下,我国逐渐进入了大数据时代,大数据的生成速度呈现出指数爆炸形式,加上数据在处理的过程中无法分解为常用的数据库,这无疑增加了企业访问和处理数据的难度。

目前,在我国电商行业的迅猛发展下,数据规模递增,为了实现对消费者购买行为相关数据的深入、全面挖掘,进一步提高电商企业的销售业绩,在Hadoop框架的应用背景下,加大对大数据挖掘与分析技术的科学应用,实现数据挖掘技术与电商平台的有效融合,是相关领域技术人员必须思考和解决的问题。

1 相关理论与技术研究1.1 Hadoop平台相关技术研究Hadoop作为一种开源编程框架,被广泛应用于Apache基础项目中。

该框架的编写语言主要以Java语言为主,能够为海量数据集的分布处理提供重要支持。

同时,在部署的过程中,使用的服务器购买价格普遍较低,缩小了物力成本,这样一来,作为开发人员就可以投入较低的成本,实现Hadoop集群搭建,极大地提高了开发效率和效果。

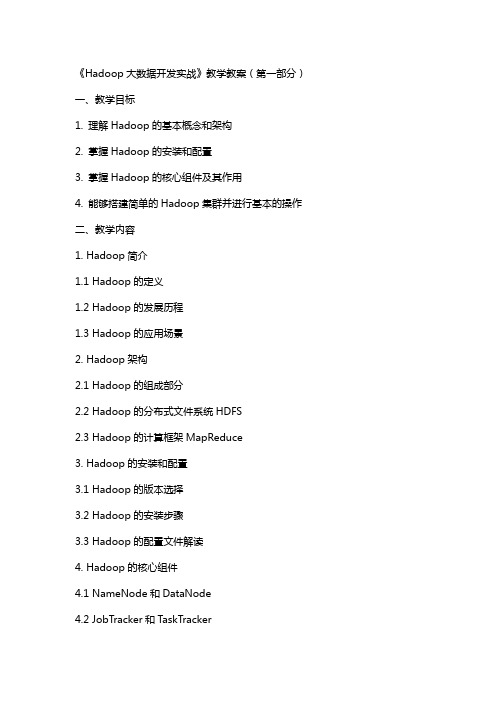

《Hadoop大数据开发实战》教学教案(第一部分)一、教学目标1. 理解Hadoop的基本概念和架构2. 掌握Hadoop的安装和配置3. 掌握Hadoop的核心组件及其作用4. 能够搭建简单的Hadoop集群并进行基本的操作二、教学内容1. Hadoop简介1.1 Hadoop的定义1.2 Hadoop的发展历程1.3 Hadoop的应用场景2. Hadoop架构2.1 Hadoop的组成部分2.2 Hadoop的分布式文件系统HDFS2.3 Hadoop的计算框架MapReduce3. Hadoop的安装和配置3.1 Hadoop的版本选择3.2 Hadoop的安装步骤3.3 Hadoop的配置文件解读4. Hadoop的核心组件4.1 NameNode和DataNode4.2 JobTracker和TaskTracker4.3 HDFS和MapReduce的运行原理三、教学方法1. 讲授法:讲解Hadoop的基本概念、架构和组件2. 实践法:引导学生动手实践,安装和配置Hadoop,了解其运行原理3. 讨论法:鼓励学生提问、发表观点,共同探讨Hadoop的应用场景和优缺点四、教学准备1. 教师准备:熟悉Hadoop的安装和配置,了解其运行原理2. 学生准备:具备一定的Linux操作基础,了解Java编程五、教学评价1. 课堂参与度:学生提问、回答问题的积极性2. 实践操作:学生动手实践的能力,如能够独立完成Hadoop的安装和配置3. 课后作业:学生完成课后练习的情况,如编写简单的MapReduce程序4. 综合评价:结合学生的课堂表现、实践操作和课后作业,综合评价学生的学习效果《Hadoop大数据开发实战》教学教案(第二部分)六、教学目标1. 掌握Hadoop生态系统中的常用组件2. 理解Hadoop数据存储和处理的高级特性3. 学会使用Hadoop进行大数据处理和分析4. 能够运用Hadoop解决实际的大数据问题七、教学内容1. Hadoop生态系统组件7.1 YARN的概念和架构7.2 HBase的概念和架构7.3 Hive的概念和架构7.4 Sqoop的概念和架构7.5 Flink的概念和架构(可选)2. Hadoop高级特性8.1 HDFS的高可用性8.2 HDFS的存储策略8.3 MapReduce的高级特性8.4 YARN的资源管理3. 大数据处理和分析9.1 Hadoop在数据处理中的应用案例9.2 Hadoop在数据分析中的应用案例9.3 Hadoop在机器学习中的应用案例4. Hadoop解决实际问题10.1 Hadoop在日志分析中的应用10.2 Hadoop在网络爬虫中的应用10.3 Hadoop在图像处理中的应用八、教学方法1. 讲授法:讲解Hadoop生态系统组件的原理和应用2. 实践法:引导学生动手实践,使用Hadoop进行数据处理和分析3. 案例教学法:分析实际应用案例,让学生了解Hadoop在不同领域的应用九、教学准备1. 教师准备:熟悉Hadoop生态系统组件的原理和应用,具备实际操作经验2. 学生准备:掌握Hadoop的基本操作,了解Hadoop的核心组件十、教学评价1. 课堂参与度:学生提问、回答问题的积极性2. 实践操作:学生动手实践的能力,如能够独立完成数据处理和分析任务3. 案例分析:学生分析实际应用案例的能力,如能够理解Hadoop在不同领域的应用4. 课后作业:学生完成课后练习的情况,如编写复杂的MapReduce程序或使用Hadoop生态系统组件进行数据处理5. 综合评价:结合学生的课堂表现、实践操作、案例分析和课后作业,综合评价学生的学习效果重点和难点解析一、Hadoop的基本概念和架构二、Hadoop的安装和配置三、Hadoop的核心组件四、Hadoop生态系统组件五、Hadoop数据存储和处理的高级特性六、大数据处理和分析七、Hadoop解决实际问题本教案涵盖了Hadoop的基本概念、安装配置、核心组件、生态系统组件、数据存储和处理的高级特性,以及大数据处理和分析的实际应用。

Hadoop实战应用与详解Hadoop是一个由Apache软件基金会开发的开放源代码框架。

它能够存储和处理大量的数据集,这将是未来几年内的重要趋势之一。

Hadoop能够自动处理数据,将它们分布在跨越多个服务器的群集上,然后在群集上执行计算任务。

Hadoop已经被广泛应用于各大行业,包括政府、金融、医疗、广告、媒体、教育等,已经成为大数据时代的重要基础设施。

一、概述Hadoop主要有两个组成部分:HDFS和MapReduce。

HDFS是一个分布式文件系统,它将大文件切分成小块,然后分散在多台机器上,可以很好地解决文件系统容量的问题。

MapReduce则是一种计算模型,它基于分布式处理,并且能够优化数据的处理,MapReduce对非常大的数据集的处理非常有效。

Hadoop本身是使用Java语言书写的,因此需要在Java环境下使用。

然而,通过一些第三方开源工具,可以使Hadoop更灵活,更容易使用。

例如,有些工具可以在Hadoop上运行SQL查询,有些工具可以将数据从关系数据库移动到Hadoop中,有些工具可以轻松地使用Hadoop分析海量的日志数据。

二、Hadoop工具的使用1. SqoopSqoop是一种用于将数据从一个关系数据库中移动到Hadoop中的工具。

Sqoop可以与MySQL、PostgreSQL、Oracle等数据库共同使用。

使用Sqoop,您可以轻松地将数据从关系数据库中提取,然后将其放入HDFS文件系统中,以便MapReduce处理。

Sqoop是Hadoop中一大工具,日常使用中必不可缺的。

2. Hive和PigHive和Pig是两种比较流行的Hadoop上的数据分析工具。

Hive基于SQL-like查询语言,使得它与关系数据库非常相似。

其查询语言HiveQL 可以与Hadoop上的HDFS、Hbase、Amazon S3和其他存储系统上的数据交互。

Pig则可与Hadoop集成,用于生成数据流处理代码,可在Hadoop环境中进行数据加工和分析。

大数据建模与分析挖掘技术已经逐步地应用到新兴互联网企业(如电子商务网站、搜索引擎、社交网站、互联网广告服务提供商等)、银行金融证券企业、电信运营等行业,给这些行业带来了一定的数据价值增值作用。

本次课程面向有一定的数据分析挖掘算法基础的工程师,带大家实践大数据分析挖掘平台的项目训练,系统地讲解数据准备、数据建模、挖掘模型建立、大数据分析与挖掘算法应用在业务模型中,结合主流的Hadoop与Spark大数据分析平台架构,实现项目训练。

结合业界使用最广泛的主流大数据平台技术,重点剖析基于大数据分析算法与BI技术应用,包括分类算法、聚类算法、预测分析算法、推荐分析模型等在业务中的实践应用,并根据讲师给定的数据集,实现两个基本的日志数据分析挖掘系统,以及电商(或内容)推荐系统引擎。

本课程基本的实践环境是Linux集群,JDK1.8, Hadoop 2.7.*,Spark 2.1.*。

学员需要准备的电脑最好是i5及以上CPU,4GB及以上内存,硬盘空间预留50GB(可用移动硬盘),基本的大数据分析平台所依赖的软件包和依赖库等,讲师已经提前部署在虚拟机镜像(VMware镜像),学员根据讲师的操作任务进行实践。

本课程采用技术原理与项目实战相结合的方式进行教学,在讲授原理的过程中,穿插实际的系统操作,本课程讲师也精心准备的实际的应用案例供学员动手训练。

大纲 Outline业界主流的数据仓库工具和大数据分析挖掘工具1.业界主流的基于Hadoop和Spark的大数据分析挖掘项目解决方案2.业界数据仓库与数据分析挖掘平台软件工具3.Hadoop数据仓库工具Hive4.Spark实时数据仓库工具SparkSQL5.Hadoop数据分析挖掘工具Mahout6.Spark机器学习与数据分析挖掘工具MLlib7.大数据分析挖掘项目的实施步骤大数据分析挖掘项目的数据集成操作训练1.日志数据解析和导入导出到数据仓库的操作训练2.从原始搜索数据集中抽取、集成数据,整理后形成规范的数据仓库3.数据分析挖掘模块从大型的集中式数据仓库中访问数据,一个数据仓库面向一个主题,构建两个数据仓库4.同一个数据仓库中的事实表数据,可以给多个不同类型的分析挖掘任务调用5.去除噪声基于Hadoop的大型数据仓库管理平台—HIVE数据仓库集群的多维分析建模应用实践6.基于Hadoop的大分布式数据仓库在行业中的数据仓库应用案例7.Hive数据仓库集群的平台体系结构、核心技术剖析8.Hive Server的工作原理、机制与应用9.Hive数据仓库集群的安装部署与配置优化10.Hive应用开发技巧11.Hive SQL剖析与应用实践12.Hive数据仓库表与表分区、表操作、数据导入导出、客户端操作技巧13.Hive数据仓库报表设计14.将原始的日志数据集,经过整理后,加载至Hadoop + Hive数据仓库集群中,用于共享访问Spark大数据分析挖掘平台实践操作训练15.Spark大数据分析挖掘平台的部署配置16.Spark数据分析库MLlib的开发部署17.Spark数据分析挖掘示例操作,从Hive表中读取数据并在分布式内存中运行聚类分析建模与挖掘算法的实现原理和技术应用18.聚类分析建模与算法原理及其在Spark MLlib中的实现与应用,包括:a)Canopy聚类(canopy clustering)b)K均值算法(K-means clustering)c)模糊K均值(Fuzzy K-means clustering)d)EM聚类,即期望最大化聚类(Expectation Maximization)e)以上算法在Spark MLib中的实现原理和实际场景中的应用案例。

Mahout使用入门感谢:《使用mahout进行数据挖掘》/blog/804146一、简介Mahout 是Apache Software Foundation(ASF)旗下的一个开源项目,提供一些可扩展的机器学习领域经典算法的实现,旨在帮助开发人员更加方便快捷地创建智能应用程序。

Apache Mahout项目已经发展到了它的第三个年头,目前已经有了三个公共发行版本。

Mahout包含许多实现,包括集群、分类、推荐过滤、频繁子项挖掘。

此外,通过使用Apache Hadoop 库,Mahout 可以有效地扩展到云中。

二、下载与准备程序下载下载hadoop /apache-mirror/hadoop/common/下载适合版本的包(本文采用稳定版hadoop-0.20.203.0rc1.tar.gz )下载mahout /apache-mirror/mahout/(本文采用mahout-distribution-0.5.tar.gz)如需更多功能可能还需下载maven 和mahout-collections数据下载数据源:/databases/里面有大量经典数据提供下载(本文使用synthetic_control 数据,synthetic_control.tar.gz)三、安装与部署为了不污染Linux root环境,本文采用在个人Home目录安装程序,程序目录为$HOME/local。

程序已经下载到$HOME/Downloads,使用tar命令解压:tar zxvf hadoop-0.20.203.0rc1.tar.gz -C ~/local/cd ~/localmv hadoop-0.20.203.0 hadooptar zxvf mahout-distribution-0.5.tar.gz -C ~/local/cd ~/localmv mahout-distribution-0.5 mahout修改.bash_profile / .bashrcexport HADOOP_HOME=$HOME/local/hadoopexport HADOOP_CONF_DIR=$HADOOP_HOME/conf为方便使用程序命令,可把程序bin目录添加到$PA TH下,或者直接alias 。

机器学习与数据挖掘实验报告一、第一部分: 实验综述二、实验工具介绍三、WEKA是新西兰怀卡托大学开发的开源项目, 全名是怀卡托智能分析环境(Waikato Environment for Knowledge Analysis)。

WEKA是由JAVA编写的, 它的源代码可通过/ml/weka/得到, 是一款免费的, 非商业化的机器学习以及数据挖掘软件。

WEKA作为一个公开的数据挖掘工作平台, 集合了大量能承担数据挖掘任务的学习算法, 包括对数据进行预处理, 分类, 回归, 聚类, 关联规则以及在新的交互式界面上的可视化。

数据挖掘就是通过分析存在于数据库里的数据来解决问题, WEKA的出现使得数据挖掘无需编程即可轻松搞定。

四、实验环境搭建在PC机上面安装java运行环境即JDK环境, 然后安装WEKA。

三、实验目的(1)探索数据集大小与C4.5模型的精度之间的关系。

(2)探索属性的个数对数据集大小与C4.5模型精度之间关系的影响。

四、实验理论依据测试分类模型精度的方法依据如下表所示。

Accuracy=(a+d)/(a+b+c+d)五、实验思路(1)为探索数据集大小与C4.5模型精度之间的关系, 采用实例数据集的训练集进行测试。

对数据集进行多次筛选采样, 通过移除不同百分比的数据实例形成大小的训练集(wake设置为Filter.filters.unsupervised.instance.RemovePercentage), 在分类测试中采用use training set 方法进行测试, 并记录测试模型的精度, 在实验过程中不改变属性值得个数。

换用不同的数据集, 重复该实验过程, 并记录实验结果, 最后进行实验分析总结得出实验结论。

(2)为探索属性的个数对数据集大小与C4.5模型精度之间关系的影响, 使用一个数据集, 采用一个带筛选器的分类器。

对该数据集的属性进行随机抽样筛选, 并对处理后的训练集进行测试, 采用Cross-validation方法, 并记录测试结果。