Hadoop + Hive应用实例(附源码)

- 格式:docx

- 大小:2.54 MB

- 文档页数:46

一、文档说明熟悉Hive功能,了解基本开发过程,及在项目中的基本应用。

注意:本文档中但凡有hive库操作的语句,其后面的“;”是语句后面的,非文档格式需要。

每个hive语句都要以“;”来结束,否则将视相邻两个分号“;”之间的所有语句为一条语句。

二、Hive(数据提取)概述Hive是构建在HDFS 和Map/Reduce之上的可扩展的数据仓库。

是对HADOOP的Map-Reduce进行了封装,类似于sql语句(hive称之为HQL)计算数据从而代替编写代码对mapreduce的操作,数据的来源还是HDFS上面的文件。

Hive中的表可以分为托管表和外部表,托管表的数据移动到数据仓库目录下,由Hive管理,外部表的数据在指定位置,不在Hive的数据仓库中,只是在Hive元数据库中注册。

创建外部表采用“create external tablename”方式创建,并在创建表的同时指定表的位置。

Hive本身是没有专门的数据存储格式,也没有为数据建立索引,只需要在创建表的时候告诉Hive数据中的列分隔符和行分隔符,Hive就可以解析数据。

所以往Hive表里面导入数据只是简单的将数据移动到表所在的目录中(如果数据是在HDFS上;但如果数据是在本地文件系统中,那么是将数据复制到表所在的目录中)。

三、Hive的元数据Hive中的元数据包括表的名字,表的列和分区及其属性,表的属性(是否为外部表等),表的数据所在目录等。

由于Hive的元数据需要不断的更新、修改,而HDFS系统中的文件是多读少改的,这显然不能将Hive的元数据存储在HDFS中。

目前Hive将元数据存储在数据库中,如Mysql、Derby中。

Hive metastore 三种存储方式:Hive的meta 数据支持以下三种存储方式,其中两种属于本地存储,一种为远端存储。

远端存储比较适合生产环境。

1、使用derby数据库存储元数据(内嵌的以本地磁盘作为存储),这称为“内嵌配置”。

使用Hive进行数据处理和分析的实战案例数据处理和分析在当今大数据时代中变得越来越重要。

为了满足这一需求,Hive在Hadoop生态系统中扮演了重要的角色。

Hive是一个基于Hadoop的数据仓库基础设施,它提供了一个类似于SQL的查询语言(HiveQL)来处理和分析大规模结构化数据。

本文将通过一个实际案例来展示如何使用Hive进行数据处理和分析。

任务是分析一个电子商务公司的销售数据,了解最受欢迎的产品类别和购买时段,以及不同客户群体的购买习惯。

首先,我们需要准备好销售数据。

假设我们已经有一个包含销售记录的CSV 文件,其中每一行包含产品ID、产品名称、产品类别、销售数量、销售日期等字段。

我们可以使用Hive将CSV文件导入Hive表中,并创建一个与CSV文件结构相匹配的表。

以下是创建表的HiveQL语句:```sqlCREATE TABLE sales (product_id INT,product_name STRING,category STRING,quantity INT,sales_date DATE)ROW FORMAT DELIMITEDFIELDS TERMINATED BY ','STORED AS TEXTFILE;```导入数据到Hive表中的语句如下:```sqlLOAD DATA LOCAL INPATH '/path/to/sales.csv' INTO TABLE sales;```现在,我们已经将销售数据导入到Hive表中,可以开始进行数据处理和分析了。

首先,我们将分析最受欢迎的产品类别。

我们可以使用Hive的聚合函数和GROUP BY子句来完成这个任务。

以下是查询语句:```sqlSELECT category, SUM(quantity) AS total_quantityFROM salesGROUP BY categoryORDER BY total_quantity DESCLIMIT 5;```上述查询语句将按照产品类别对销售数据进行分组,并计算每个类别的销售总数量。

java代码连接hive的样例代码以下是Java代码连接Hive的样例代码:1.导入必要的包```import java.sql.Connection;import java.sql.DriverManager;import java.sql.ResultSet;import java.sql.SQLException;import java.sql.Statement;```2.定义连接Hive的方法```public static Connection getConnection() throws ClassNotFoundException, SQLException {//设置Hive的JDBC驱动Class.forName("org.apache.hive.jdbc.HiveDriver");//连接Hive服务器String hiveUrl = "jdbc:hive2://localhost:10000/default";Connection connection =DriverManager.getConnection(hiveUrl, "", "");return connection;}```3.执行Hive查询语句的方法```public static ResultSet executeQuery(Connection connection, String query) throws SQLException {//创建Statement对象Statement statement = connection.createStatement();//执行查询语句ResultSet resultSet = statement.executeQuery(query); return resultSet;}```4.示例代码```public static void main(String[] args) {try {//获取Hive连接Connection connection = getConnection();//查询语句String query = "SELECT * FROM mytable";//执行查询语句ResultSet resultSet = executeQuery(connection, query);//处理查询结果while (resultSet.next()) {String column1 = resultSet.getString("column1");int column2 = resultSet.getInt("column2");System.out.println("column1: " + column1 + ", column2: " + column2);}//关闭连接和资源resultSet.close();connection.close();} catch (ClassNotFoundException | SQLException e) {e.printStackTrace();}}```以上代码是一个简单的Java程序,用于连接Hive并执行查询语句。

Hive数据仓库在Hadoop大数据环境下数据的导入与应用张艳丽;吴淮北

【期刊名称】《电脑编程技巧与维护》

【年(卷),期】2022()12

【摘要】对Hive数据仓库的创建与启动的过程进行了介绍,着重讲解了通过Load 命名加载数据的两种方式,即通过本地将数据文件加载到Hive表中,通过HDFS将数据文件加载到Hive表中。

这两种方式在实际生产环境中,应用十分广泛。

【总页数】3页(P97-99)

【作者】张艳丽;吴淮北

【作者单位】安徽城市管理职业学院;安徽江淮汽车集团股份有限公司

【正文语种】中文

【中图分类】TP3

【相关文献】

1.物联网环境下基于上下文的Hadoop大数据处理系统模型

2.数据仓库环境下的数据追加方案——TVL的设计和应用

3.大数据环境下动态数据仓库的应用研究

4.Hive大数据仓库构建与应用—以大陆在美上市股票数据为例

5.分布式系统数据仓库工具Hive的工作原理及应用

因版权原因,仅展示原文概要,查看原文内容请购买。

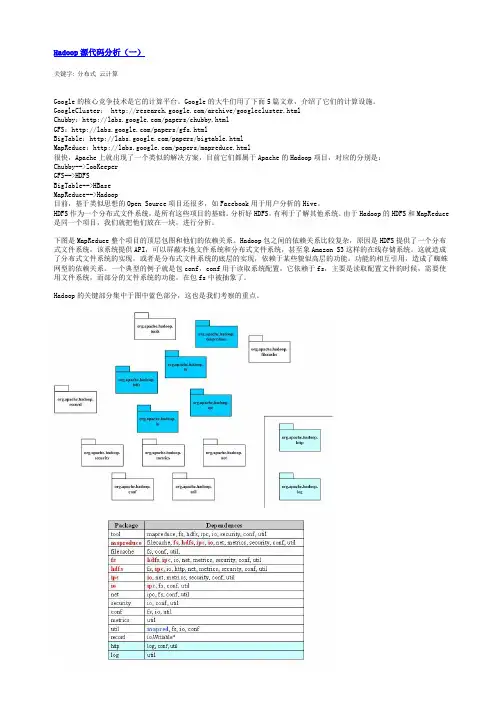

关键字: 分布式云计算Google的核心竞争技术是它的计算平台。

Google的大牛们用了下面5篇文章,介绍了它们的计算设施。

GoogleCluster: /archive/googlecluster.htmlChubby:/papers/chubby.htmlGFS:/papers/gfs.htmlBigTable:/papers/bigtable.htmlMapReduce:/papers/mapreduce.html很快,Apache上就出现了一个类似的解决方案,目前它们都属于Apache的Hadoop项目,对应的分别是:Chubby-->ZooKeeperGFS-->HDFSBigTable-->HBaseMapReduce-->Hadoop目前,基于类似思想的Open Source项目还很多,如Facebook用于用户分析的Hive。

HDFS作为一个分布式文件系统,是所有这些项目的基础。

分析好HDFS,有利于了解其他系统。

由于Hadoop的HDFS和MapReduce 是同一个项目,我们就把他们放在一块,进行分析。

下图是MapReduce整个项目的顶层包图和他们的依赖关系。

Hadoop包之间的依赖关系比较复杂,原因是HDFS提供了一个分布式文件系统,该系统提供API,可以屏蔽本地文件系统和分布式文件系统,甚至象Amazon S3这样的在线存储系统。

这就造成了分布式文件系统的实现,或者是分布式文件系统的底层的实现,依赖于某些貌似高层的功能。

功能的相互引用,造成了蜘蛛网型的依赖关系。

一个典型的例子就是包conf,conf用于读取系统配置,它依赖于fs,主要是读取配置文件的时候,需要使用文件系统,而部分的文件系统的功能,在包fs中被抽象了。

Hadoop的关键部分集中于图中蓝色部分,这也是我们考察的重点。

下面给出了Hadoop的包的功能分析。

Hadoop源代码分析(三)由于Hadoop的MapReduce和HDFS都有通信的需求,需要对通信的对象进行序列化。

hive项目实训案例Hive是一个基于Hadoop的数据仓库工具,用于处理和分析大数据。

以下是几个Hive项目实训案例,可以帮助你深入了解Hive的应用和实践:1. 数据仓库建模在这个案例中,你将使用Hive构建一个数据仓库模型,其中包括事实表、维度表和桥接表。

你可以使用一个现有的数据集,如电商交易数据,将其导入到Hive中,并使用Hive的DDL语句创建表和分区。

然后,你可以使用Hive的SQL查询语句进行数据分析,例如计算销售额、订单数量等指标。

2. 数据清洗和转换在这个案例中,你将使用Hive进行数据清洗和转换。

你可以使用Hive的内置函数和UDF(用户自定义函数)对数据进行处理,例如去除重复记录、填充缺失值、转换数据类型等。

然后,你可以将处理后的数据导出到另一个数据存储系统,例如关系型数据库或数据湖。

3. 数据分析和可视化在这个案例中,你将使用Hive进行数据分析和可视化。

你可以使用Hive的SQL查询语句对数据进行聚合、过滤和连接操作,例如计算销售额的分布、找出购买最多的商品等。

然后,你可以将分析结果导出到Excel或其他可视化工具中进行展示。

4. 数据挖掘和机器学习在这个案例中,你将使用Hive进行数据挖掘和机器学习。

你可以使用Hive 的MLlib库进行分类、聚类、回归等机器学习算法的实现。

然后,你可以将训练好的模型导出到另一个系统进行部署和应用。

以上是几个Hive项目实训案例,可以帮助你深入了解Hive的应用和实践。

通过这些案例的学习和实践,你可以更好地掌握Hive的使用方法和技巧,提高你的大数据处理和分析能力。

Hadoop十大应用及案例Hadoop是一个分布式计算框架,可用于处理和分析大规模数据集。

以下是Hadoop的十大应用场景和案例:1.数据分析Hadoop在数据分析中非常有用,特别是对于大数据集。

它允许用户在集群中并行处理数据,从而使分析更快速和高效。

一种典型的应用是客户行为分析,通过分析大量客户的交易数据和交互数据,企业可以更好地了解客户需求,以制定更加精准的营销策略。

2.搜索引擎搜索引擎是Hadoop的另一个常见应用场景。

例如,Hadoop被用来处理和索引网页,使得用户可以在搜索引擎中快速找到他们需要的信息。

Hadoop的分布式处理能力使得这种大规模的索引和查询操作成为可能。

3.数据仓库Hadoop可以作为数据仓库使用,存储大规模的数据集。

与传统的关系型数据库不同,Hadoop可以处理大规模的半结构化和非结构化数据,而且可以高效地进行查询和分析。

例如,企业可以使用Hadoop作为其数据仓库,存储和分析销售、市场、财务等各个方面的数据。

4.机器学习Hadoop为机器学习提供了强大的支持。

由于Hadoop可以处理大规模的数据集,并且可以在集群中并行执行任务,因此它非常适合进行机器学习算法的训练。

例如,可以使用Hadoop进行大规模的图像识别或者语音识别训练。

5.文本处理Hadoop可以高效地处理文本数据。

例如,可以使用Hadoop对大规模的文本文件进行分词、词频统计、情感分析等操作。

这种操作在传统的单台计算机上是不可能完成的,因为它的计算和存储能力有限。

但是,在Hadoop中,这些操作可以在集群中并行执行,使得它们变得可能并且更加高效。

6.推荐系统Hadoop可以用于构建推荐系统。

推荐系统通常需要分析大量的用户数据以找出用户可能感兴趣的物品或服务。

Hadoop的分布式计算能力使得这种分析能够在短时间内完成。

例如,电子商务网站可以使用Hadoop来分析用户的购买记录和浏览行为,以提供个性化的商品推荐。

读取hive-sit.xml java 通用方法【实用版3篇】目录(篇1)1.Hive 和 Hadoop 的关系2.Hive-sit.xml 的作用3.Java 读取 hive-sit.xml 的通用方法4.示例代码正文(篇1)Hive 是一个基于 Hadoop 的数据仓库工具,可以用来处理和分析大规模的结构化数据。

Hadoop 是一个分布式计算框架,提供了数据存储和处理的基础设施。

Hive 依赖于 Hadoop 来执行查询和操作数据,因此了解 Hive 和 Hadoop 的关系对于使用 Hive 至关重要。

Hive-sit.xml 是 Hive 的配置文件,用于存储 Hive 的设置和参数。

这个文件通常位于 Hive 的安装目录下,比如在 Linux 系统中,它可能位于/etc/hive/conf 目录下。

在实际使用中,我们需要读取这个文件来获取 Hive 的配置信息,以便更好地使用 Hive。

对于 Java 程序来说,读取 hive-sit.xml 的通用方法是使用 XML 解析库,比如 DOM 和 SAX。

这里我们以 DOM 解析库为例,给出一个简单的示例代码:```javaimport java.io.FileInputStream;import java.io.IOException;import javax.xml.parsers.DocumentBuilder;import javax.xml.parsers.DocumentBuilderFactory;import org.w3c.dom.Document;public class ReadHiveConfig {public static void main(String[] args) {try {FileInputStream fis = newFileInputStream("/etc/hive/conf/hive-sit.xml");DocumentBuilderFactory dbFactory = DocumentBuilderFactory.newInstance();DocumentBuilder dBuilder =dbFactory.newDocumentBuilder();Document doc = dBuilder.parse(fis);doc.getDocumentElement().normalize();System.out.println(doc.getDocumentElement().getNodeValue());fis.close();} catch (IOException e) {e.printStackTrace();}}}```这段代码首先使用 FileInputStream 读取 hive-sit.xml 文件,然后使用 DocumentBuilderFactory 创建一个 DocumentBuilder 实例,接着使用这个实例解析文件内容,并将解析后的文档打印出来。

hadoop实际案例Hadoop是一个开源的分布式计算平台,被广泛应用于处理大规模数据集的分布式存储和计算任务中。

下面列举了十个Hadoop的实际应用案例,展示了它在不同领域的应用和价值。

1. 电商数据分析一个电商企业需要分析大量的用户数据、销售数据和日志数据,以了解用户行为和购买习惯,优化推荐算法和营销策略。

Hadoop集群可以存储和处理这些海量数据,并通过MapReduce等计算模型进行高效的数据分析和挖掘。

2. 金融风控银行、保险公司等金融机构需要对客户的信用风险进行评估和监测。

Hadoop可以帮助这些机构处理大量的客户数据和交易数据,通过机器学习和数据挖掘技术进行风险模型的建立和分析,提供准确的风险评估和预警。

3. 医疗影像分析医院需要处理大量的医疗影像数据,如CT、MRI等。

Hadoop可以存储和处理这些大规模的医疗影像数据,并通过分布式计算进行影像分析、疾病诊断和治疗方案制定,提高医疗诊断的准确性和效率。

4. 物流路径优化物流公司需要优化货物的配送路径,降低成本和提高效率。

Hadoop可以处理包括实时位置数据、交通状况数据等在内的大量数据,通过分布式计算和算法优化,提供最佳的货物配送路径和调度方案。

5. 天气预测气象局需要利用历史气象数据、卫星云图等数据进行天气预测和气候模拟。

Hadoop可以存储和处理这些大规模的气象数据,通过分布式计算和气象模型,提供准确的天气预测和气候模拟结果,帮助决策者做出相应的应对措施。

6. 社交网络分析社交媒体平台需要对用户的社交网络关系和行为进行分析,以提供个性化的推荐和广告投放。

Hadoop可以存储和处理海量的社交网络数据,通过图计算等技术,进行社交网络分析和用户行为预测,提供更精准的推荐和广告效果评估。

7. 电力负荷预测电力公司需要根据历史负荷数据、天气数据等进行电力负荷预测,以合理调度发电设备和优化电力供应。

Hadoop可以存储和处理这些大规模的电力数据,通过分布式计算和时间序列分析,提供准确的电力负荷预测结果,帮助电力公司进行合理的电力调度和规划。

hive 高级sql开发场景和案例Hive是一个用于处理Hadoop中结构化数据的数据仓库基础设施,可以使用类似SQL的查询语言(HiveQL或HQL)进行操作。

以下是一些Hive高级SQL开发的场景和案例:1. 复杂查询:对于大数据集,使用Hive进行复杂查询是一个常见的场景。

例如,你可以使用JOIN操作连接多个表,进行数据聚合、过滤和排序等操作。

在Hive中,你可以使用JOIN语句将不同的表连接起来,通过共享的列来组合数据。

2. 数据聚合:Hive提供了强大的聚合函数,如SUM、AVG、COUNT等,用于对数据进行汇总和分析。

你可以使用这些函数来计算总和、平均值、中位数等统计信息。

3. 分区和分桶:Hive支持对表进行分区和分桶,以优化查询性能。

分区是将表中的数据按照某个列或多个列的值进行拆分,而分桶是将数据按照某个列的值进行哈希处理,将相同哈希值的数据存储在一起。

通过合理地使用分区和分桶,可以提高查询的效率和准确性。

4. 自定义函数:Hive允许你编写自定义函数(UDF)来扩展Hive的功能。

你可以使用Java、Python等语言编写UDF,并在Hive中调用它们。

通过编写自定义函数,你可以实现对数据的特殊处理和转换。

5. 数据湖分析:数据湖是一个存储大量原始数据的平台,可以用于存储和分析大量数据。

Hive可以作为数据湖分析的工具之一,从数据湖中读取数据并进行分析。

你可以使用Hive进行ETL(提取、转换、加载)操作,将数据从数据湖中提取出来并进行处理,然后将结果加载到另一个系统中。

6. 数据挖掘和机器学习:Hive提供了多种机器学习算法和统计方法,可以用于数据挖掘和机器学习任务。

例如,你可以使用Hive进行分类、聚类、关联规则挖掘等操作,发现数据中的模式和规律。

7. 数据可视化:通过与数据可视化工具集成,Hive可以用于生成各种图表和报告,直观地展示数据和分析结果。

你可以使用工具如Tableau、Power BI等来连接Hive并加载数据,然后进行可视化分析和展示。

#hadoop⼊门第六篇:Hive实例前⾔ 前⾯已经讲了如何部署在hadoop集群上部署hive,现在我们就做⼀个很⼩的实例去熟悉HIVE QL.使⽤的数据是视频播放数据包括视频编码,播放设备编码,⽤户账号编码等,我们在这个数据基础上做⼀些简单查询统计等。

这是20170901 14点的部分播放⽇志动起来同步数据 实际上我这块数据是通过flume收集⽇志到hdfs上的,后续我也会简单介绍⼀下怎么通过flume收集⽇志到hdfs。

当然,下载我们的样例数据以后也可以通过${HADOOP_HOME}/bin/hdfs dfs -put命令建⽴相关⽬录:⽐如我的放在${HADOOP_HOME}/bin/hdfs dfs -mkdir /user/admin/logs/video_play/20170901/14 每层建⽴,最好两层是对应的表分区day ,hour建表:create external table log_video_play_request (logindex string,request_date string,video_auiddigest string,puiddigest string ,ver int,auiddigest string comment 'account identify',duiddigest string comment 'device identify',device_sign string ,xy_app_key string,ip string,port bigint,user_agent string, fromparameter string,zone bigint,sns_name string,sns_type bigint,country_code string,consume_country_code string,play_duration bigint,video_duration bigint,trace_id string,review_state int)partitioned by (day string ,hour string) row format delimitedfields terminated by '&'stored as textfilelocation '/user/admin/logs/video_play'接下来就是hive表加载数据了,⼤家可以参考这篇博⽂在这⾥⼤家在hive⾥⾯执⾏alter table log_video_play_request add partition(day='20170901',hour='14');注:select * from .. limit 10;试⼀下,如果结果为空,使⽤Load data inpath '/user/admin/logs/vide_play/20170901/14' overwrite into table log_video_play_request partition(day='20170901',hour='14')hive QL DDL语句表操作语句通⽤建表语句CREATE [EXTERNAL] TABLE [IF NOT EXISTS] table\_name[(col\_name data\_type [col\_comment],...)][COMMENT table\_comment][PARTITIONED BY (col\_name data\_type [col\_comment], col\_name data\_type [COMMENT col\_comment],...)][ROW FORMAT row\_format][STORED AS file\_format][LOCATION hdfs\_path]重命名表: ALTER TABLE table_name RENAME TO new_table_name添加字段:ALTER TABLE table_name ADD COLUMNS(col_name data_type [COMMENT col_comment],...)添加或者删除分区: ALTER TABLE table_name ADD PARTITION(pt1='xx',....) LOCATION 'hdfs_path'ALTER TABLE table_name DROP PARTITION(....)删除表: DROP TABLE table_name其他操作语句创建/删除视图 hive不⽀持物化视图,⽽从数仓的⾓度来说视图应⽤场景基本没有 CREATE VIEW [col_name] as SELECT ...创建/删除函数 udf udaf等后续会专门介绍show/describe: show paratitios table_name describe table_name[DOT col_name] describle table_name partition_spechive QL DML语句插⼊数据到表向数据表中加载⽂件:LOAD DATA [LOCAL] INPATH 'filepath' [OVERWRITE]INOT TABLE table\_name[PARTITION (partcol1=val1,partcol2=val2 ...)]将查询结果插⼊数据表中INSERT OVERWRITE TABLE tablename [PARTITION (partcol1=val1,partcol2=val2 ...)]select ....SQL操作基本语法:select where groupby distinct having join 等多路插⼊: multi insertFROM srcinsert overwrite table1 select ... where ...insert overwrite table2 select ... where ...多路插⼊还是很常见并且⾮常好的应⽤,⼀张⽇志表往往有多次的计算,⽤multi insert 可以节省多次的IO开销实例根据我们上⾯的log_video_play_requestselect * from log\_video\_play\_request where day = 20170901 limit 10;#查看各个模块播放select count(1) as total ,fromparameter from log\_video\_play\_request where day = 20170901 group by fromparameter order by total desc limit 100;#查看top创作者(视频被播放次数最多的⽤户)select count(1) as total,video\_auiddigest from log\_video\_play\_request where day = 20170901 group by video\_auiddigest order by total desc limit 100;。

apache hop 应用案例

Apache Hadoop是一个开源的分布式存储和计算框架,它可以

处理大规模数据集并提供高性能和可靠性。

以下是一些Apache Hadoop的应用案例:

1. 大数据分析,Hadoop可以用于处理和分析大规模数据集,

包括结构化数据和非结构化数据。

许多企业使用Hadoop来进行市场

分析、用户行为分析、日志分析等,以便更好地了解他们的业务和

客户。

2. 数据仓库,许多组织使用Hadoop作为其数据仓库解决方案,用于存储和管理大量的数据。

Hadoop的分布式存储和计算能力使其

成为一个理想的数据仓库平台。

3. 搜索引擎,一些搜索引擎公司使用Hadoop来处理和索引互

联网上的大量数据,以提供更快速和准确的搜索结果。

4. 日志处理,许多互联网公司使用Hadoop来处理其服务器日志,以便监控系统性能、分析用户行为和进行故障排除。

5. 社交媒体分析,社交媒体公司可以利用Hadoop来分析用户生成的数据,以了解用户趋势、情感分析和推荐系统等。

6. 金融风险管理,银行和金融机构可以使用Hadoop来分析交易数据、客户信息和市场数据,以评估风险并做出更明智的决策。

总之,Apache Hadoop的应用案例非常广泛,涵盖了许多不同的行业和领域。

它的分布式存储和计算能力使其成为处理大规模数据的理想选择,许多组织都在利用Hadoop来解决其大数据挑战。

Hive和Hadoop是大数据生态系统中两个流行的工具,它们合作为存储,处理和分析大量数据提供了强大的评台。

在本篇文章中,我们将探讨Hive和Hadoop的工作原则及其如何相互补充,以便能够进行有效的数据处理和分析。

Hadoop是一个开源的分布式处理框架,旨在处理分布式服务器集裙的大量数据。

它基于MapReduce编程模型,该模型能够对集裙中多个节点的数据进行平行处理。

Hadoop的核心组件包括用于存储数据的Hdoop分布式文件系统(HDFS)和并行处理数据的MapReduce 框架。

另Hive是Hadoop顶部建设的数据仓库基础设施,提供类似SQL的接口,用于查询和分析存储在Hadoop的数据。

它允许用户编写SQL 查询与存储在Hadoop的数据互动,使得SQL—savvy分析师和数据科学家更容易与大数据合作。

Hive和Hadoop的工作原则是密切交织在一起的。

当用户通过蜂巢提交SQL查询时,该查询会被蜂巢查询编译器翻译成一系列的MapReduce工作。

这些 MapReduce 任务随后在 Hadoop 集裙上执行,该集裙处理数据并将结果返回 Hive 。

然后蜂巢以表格格式向用户介绍查询结果,使用户易于分析和可视化数据。

Hive和Hadoop如何合作的一个例子是数据储存和商业情报。

在传统的数据存储环境中,分析师和数据工程师经常使用基于SQL的工具来查询和分析存储在集中数据库中的数据。

然而,随着数据量的持续增长,传统的数据仓库可能难以跟上现代数据的规模和复杂性。

这是哈多普和蜂巢游戏的地方通过利用Hadoop的分布式处理能力和Hive的类似SQL的接口,各组织可以建立一个可扩展和成本效益高的数据存储解决方案,可以处理现代应用程序和系统产生的大量数据。

数据可以被摄入Hadoop的分布式文件系统,使用MapReduce框架并行处理,并使用Hive的SQL接口进行询问和分析。

临Τ 蜂巢提供了丰富的工具和图书馆生态系统,可以扩展其功能,如与Apache Spark进行实时处理的集成,以及支持机器学习和数据可视化工具。

Hadoop + Hive应用实例(附源码)基于消费者对商品购买数据统计1 引言当前许多企业逐渐将电子商务作为商业交易、营销等商业行为的工具及载体,视网络购物为新一轮企业竞争的主要手段,同时,越来越多的个人也将在INTERNET 上开设自己的网络商店作为创业的一种方式。

调查显示,全球在家上网人口于 2002 年为 5 亿 3,130 万人,预计至 2009 年,全球网络交易金额将突破 1 兆美元。

开设网络商店,与开实体店面相比;创业所需成本、费用、设备,低廉许多。

但也因网络商店进入门坎较低,加之许多网络商店经营者缺乏经营经验和对市场应有的分析,往往导致在茫茫网络中,难以脱颖而出,甚至难以为继。

许多网络商店的经营者往往把经营重心放在吸引新的顾客,经常是提供各种优惠或广告手法吸引顾客上网消费,而忽略顾客真正需求。

本文以某娱乐商品销售网络商店为例,从网络商店特性、商品特性、消费者购买行为等几个方面,根据消费者购买的订单表(orders.csv)和订单对应商品的表( order_products_prior.csv)统计出如下几项内容:1. 每个用户平均每个订单商品数量 2. 每个用户购买订单的最大最小间隔 3.每个用户最喜爱购买的三个product 4.每个用户总商品数量和去重后的商品数量(下划线连接)然后将这每个用户对应的四个信息做成一个表格导入到hadoop的hive中。

根据得到的统计信息形成用户的消费特征,从而对用户间的消费进行建模,合理推销商品探讨他们之间的关联性,建立了影响消费者网络购物因素的研究总体框架,目的是希望为想在网络创业及网络商店经营者提供有益的参考。

2 国内外研究现状(1)国外研究现状如何把握网络消费者的购买喜好及其忠诚度的培养,如何全方位地管理网络品牌。

被誉为“全球定位之父”的美国著名营销大师阿尔·里斯在《打造网络品牌的 11条法则》一书中,提出在网络消费时代中最成功的的品牌将是一种“交互式”的品牌,强调了消费者信息在网络购物中的重要作用,并且指导企业如何以 11 条精炼的法则来完成其网络品牌建设。

国外其他对网络与品牌关系有所研究的学者还有迪尔德丽·布瑞肯里奇(Deirdre Breakenridge)所编著的《品牌的革命》以及马克·布朗斯坦(Marc Braunstein)的《网络品牌》,分别讲述了品牌如何应对网络所带来的大量挑战与机遇以及网络品牌区别于传统品牌的建设方式,对企业来说有着实际的指导作用。

网络信息技术的发展影响了品牌的运营方式,而大数据的普遍出现与应用则能进一步改变网络商业模式。

被誉为“大数据商业应用第一人”的美国著名学者维克托·迈尔-舍恩伯格(Viktor Mayer-Schönberger)在其著作《大数据时代》一书中提出,大数据将为人类的生活创造前所未有可量化的维度,并且以亚马逊、谷歌、Facebook 等网络商业巨头为案例,更加深入的向读者说明大数据的价值所在。

(2)国内研究现状我国虽然在网络购物方面起步较晚,但是凭借着自身优势,其发展速度却远远超过了世界上大部分国家。

在网络品牌理论方面,国内也有许多学者及成功的企业家提出了自己独到的见解。

中国互联网品牌营销专家杨小辉在其著作《当品牌遇上网络:悄然兴起的互联网品牌营销》讲述了在互联网时代下,品牌进行网络营销的重要性和必要性,在分析多个实际品牌案例后,结合自身的网络品牌营销经验,提出了颇具创意的网络品牌生态树理论,从品牌定位、产品策划、网络推广等多个方面来引导企业网络品牌有效地进行网络营销。

《中高端男装网络品牌营销策略分析》(章思思东华大学)一文中,以现代中高端网络男装品牌为主要研究对象,实例分析了国内中高端男装网络品牌的定位方向、产品策略、价格策略、渠道策略、促销策略,总结出中高端男装网络品牌的定位与建设不仅仅是产品本身,更重要的是一种品牌文化的推崇,对现代男装品牌线上网络营销策略有一定的借鉴意义。

《男装品牌网络形象塑造的研究与应用》(程利西安工程科技学院)针对国内男装品牌现状,详细分析了在网络环境下男装品牌形象塑造的不足之处与可行性应对策略。

《基于 BtoC 电子商务模式的服装品牌商品企划研究》(陈红星东华大学)阐述了国内 BtoC 电子商务模式的概况与特点,并且在此基础上针对服装品牌的品牌策略、产品企划等多方面进行了详细的介绍与深入分析,为 BtoC 模式下的服装品牌系统合理地规划产品开发提供理论指导。

《大数据的商业价值》(陈宪宇)一文全面的向读者介绍了大数据的概念、特征,并且从各个商业角度阐释了大数据为其带来的巨大价值,尤其在网络购物方面,数据的作用已经上升为品牌的重要战略资源。

3 方案设计整个数据分析过程包括环境搭建、数据准备与预处理、MapReduce算法设计三方面,详细方案设计如下。

2.1实验环境操作系统:CentOS6.5集群环境:Hadoop2.6.5 + Hive2.3.6 + Haproxy1.7.9结点:名称结点:nna + MySQL Server + Haproxy数据结点:dn1 + HiveServer程序语言:JDK1.8 + Centos6 ShellHive集群的搭建不再赘述。

2.2 数据预处理orders.csv文件保存的是用户订单和用户的对应关系,order_products_prior.csv文件保存的是用户的订单与商品的对应关系,各个字段的描述如图所示:整个数据集包含200万个用户,342万个订单和3423万个商品,考虑用MapReduce来做数据统计。

数据的统计涉及用户和商品的对应关系,而user_id和product_id分别在两张表中,为了减少程序计算的复杂性,将两张表合成一张表,通过增加数据冗余来降低计算复杂度,提高统计效率。

在hive中创建orders表和order_products_prior,并将对应文件的本地文件中的数据导入到两张表中。

将csv文件中的数据导入到两个表中,如下:两个表的结构如下:建表过程如下:Hive支持直接通过命令将文件导入到hive数据仓库中,并且也支持将对数据库的操作转化为MapReduce任务,数据的查询效率高。

通过order_id在orders表和order_products_prior表上做联合查询,并将查询的结果写入到user_order_product表中,该过程自动生成MapReduce任务:查看合成表的数据格式:将合成的数据表通过命令行的方式导出到本地,方便自己编写的MapReduce程序读取数据:查看导出文件的数据格式:将导出的user_order_product.txt, 订单表文件orders.csv, 订单与商品对应关系表order_products__prior.csv上传到hdfs:数据的统计即可以直接从Hive读取数据,也可以从HDFS读取数据,但在不知道user_id的情况下,直接读取HDFS的数据无疑是更好的选择,且若从Hive 读取数据,需要对每个user做一次查询,不如直接从本地顺序读取数据效率好。

2.3 算法设计与实现2.3.1 每个用户平均每个订单商品数量●算法描述1)Map阶段a)按行读取user_order_product.txt文件的数据b)将 key: user_id , value: order_id写入上下文2)Reduce阶段a)统计key中相同value的个数,存入HashMapb)计算每个用户的订单数和总商品数c)计算平均每个订单的商品数量d)将计算结果写入HDFS,输出格式为key : user_id, value : 订单数 + 商品总数 + 平均每个订单的商品数量●算法流程实验结果如下:2.3.2 每个用户购买订单的最大最小间隔算法描述1)Map阶段a)按行读取orders.csv文件的数据b)将 key: user_id , value: order_number + hour + day写入上下文2)Reduce阶段a)将value中的hour和day按格式order_number: hour,order_number:day写入TreeMapb)从TreeMap中读取相邻两个订单的时间,计算时间差c)得到每个用户购买订单的最大、最小时间差d)将计算结果写入HDFS,输出格式为key : user_id,value : 最小时间间隔 + 最大时间间隔此处应该注意的是,TreeMap中的元素会自动根据order_number排序,因此得到的TreeMap序列是有序的。

●算法流程●实验结果2.3.3每个用户最喜爱购买的三个product●算法描述1)Map阶段a)按行读取按行读取user_order_product.txt文件的数据b)将 key: user_id , value: product_id写入上下文2)Reduce阶段a)统计product_id出现的次数,按Entry(key:product_id, value:number)写入TreeMapb)将TreeMap转化为ArrayList,并通过比较器对Entry的value进行降序排序c)得到每个用户最喜欢的三个productd)将计算结果写入HDFS,结果的格式为key : user_id,value : 最喜欢商品1.id + 最喜欢商品2.id + 最喜欢商品3.id●算法流程●实验结果2.3.4 每个用户总商品数量和去重后的商品数量●算法描述1)Map阶段a)按行读取按行读取user_order_product.txt文件的数据b)将 key: user_id , value: product_id写入上下文2)Reduce阶段a)统计product_id出现的次数,按Entry(key:product_id, value:number)写入TreeMapb)key的数量为去重后的商品数量,value的和为总商品数量c)将计算结果写入HDFS,结果格式为key : user_id, value : 商品总数 +去重后的商品数量●算法流程●实验结果2.3.5统计结果合并上述四个MapReduce任务输出的结果可能不在同一个文件,因此需要先将结果通过命令行的当时下载到本地,重命名后重新上传到HDFS,该过程可通过编写shell脚本来执行。

脚本代码如下:通过MapReduce将个文件中需要的数据合并到一个文件(Data_To_Table),算法流程与上述类似,执行的结果如下:将最终的结果上传到Hive,该过程也通过shell脚本来实现,代码如下:统计的最终结果如下(部分):3 技术/非技术可行性评价3.1 技术层面MapReduce 构建于基于 Key/value 存储的分布式存储系统之上,通过元数据集中存储、数据以 chunk 为单位分布存储和数据chunk 冗余复制 (默认为三复本) 来保证其高可用性MapReduce 是一种并行编程模型,它把计算过程分解为两个主要阶段,即 Map 阶段和 Reduce 阶段。