《信息论》期末考试B卷答案[1]

- 格式:doc

- 大小:152.00 KB

- 文档页数:3

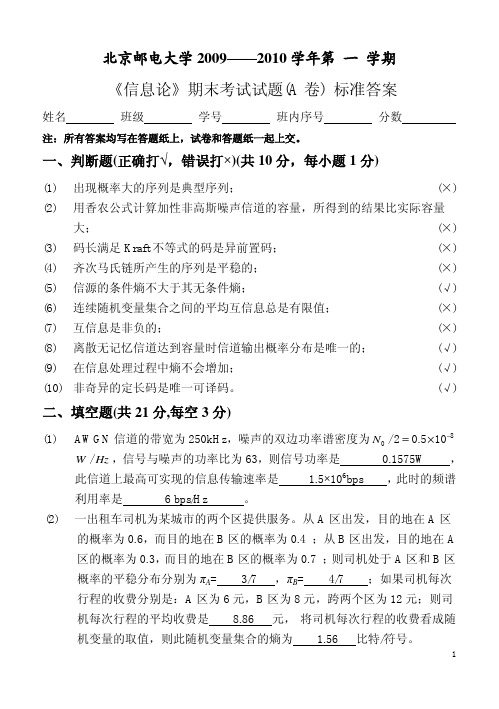

《信息论基础》试卷(期末)(B卷)重庆邮电⼤学2007/2008学年2学期《信息论基础》试卷(期末)(B 卷)(半开卷)⼀、填空题(共20分,每空1分)1、通信系统中,编码的主要⽬的有两个,分别是和。

2、离散⽆记忆信源存在剩余度的原因是。

3、当时,信源熵为最⼤值。

⼋进制信源的最⼤熵为,最⼩熵为。

4、⽆失真信源编码的平均码长最⼩理论极限制为。

5、⼀个事件发⽣概率为0.125,则⾃相关量为。

6、根据信原输出随机序列中随机变量前后之间有⽆统计依赖性,信原可以分为和。

7、噪声瞬时值的概率密度函数服从分布,同时功率谱密度为的噪声称为⾼斯⽩噪声。

8、当时,信源与信道达到匹配。

9、若连续信源输出信号的平均功率为2σ,则输出信号幅度的概率密度是⾼斯分布或正态分布或时,信源具有最⼤熵,其值为值。

9、在下⾯空格中选择填⼊数学符号“,,,=≥≤>”或“?” (1)H(XY) H(Y)+H(X|Y) H(Y)+H(X)(2)假设信道输⼊⽤X 表⽰,信道输出⽤Y 表⽰。

在有噪⽆损信道中, H(X/Y) 0, H(Y/X) 0, I(X;Y) H(X)。

⼆、(6分)若连续信源输出的幅度被限定在【1,3】区域内,当输出信号的概率密度是均匀分布时,计算该信源的相对熵,并说明该信源的绝对熵为多少。

三、(16分)已知信源12345S P 0.250.20.20.20.15s s s s s =(1)⽤霍夫曼编码法编成⼆进制变长码;(4分)(2)计算平均码长—L ;(4分)(3)计算编码信息率R ';(4分)(4)计算编码后信息传输率R ;(2分)(5)计算编码效率η。

(2分)四、(12分)已知⼀个平均功率受限的连续信号,通过带宽W 10MHz =的⾼斯⽩噪声信道,试计算(1)若信噪⽐为10,信道容量为多少?(4分)(2)若信道容量不变,信噪⽐降为5,信道带宽为多少?(4分)(3)若信道通频带减为5MHz 时,要保持相同的信道容量,信道上的信号与噪声的平均功率⽐值应等于多少?(4分)五、(16分)某个信息源发出符号的概率为:12()(),P a P a =3()0.4,P a =假设该信息源发出的符号前后有关联,其依赖关系为:112122321333312133(|);(|);(|);(|);(|);(|);443344P a a P a a P a a P a a P a a P a a ======(1)画出状态转移图(4分)(2)计算稳态概率(4分)(3)计算信源的极限熵(4分)(4)计算稳态下H1,H2及其对应的剩余度。

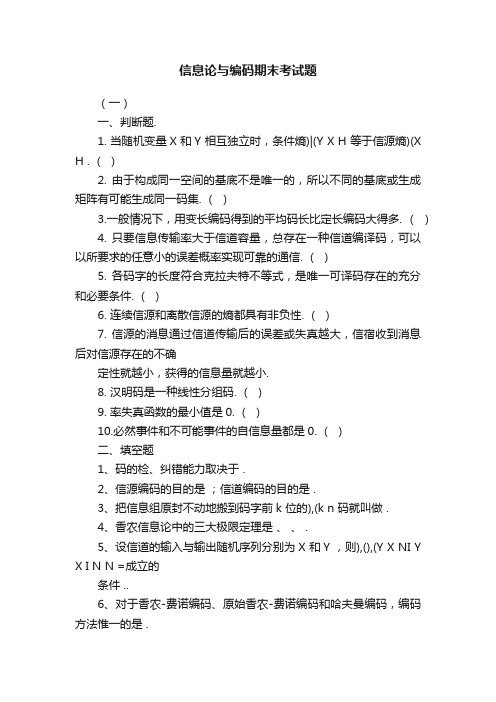

信息论与编码期末考试题(一)一、判断题.1. 当随机变量X 和Y 相互独立时,条件熵)|(Y X H 等于信源熵)(XH . ()2. 由于构成同一空间的基底不是唯一的,所以不同的基底或生成矩阵有可能生成同一码集. ()3.一般情况下,用变长编码得到的平均码长比定长编码大得多. ()4. 只要信息传输率大于信道容量,总存在一种信道编译码,可以以所要求的任意小的误差概率实现可靠的通信. ()5. 各码字的长度符合克拉夫特不等式,是唯一可译码存在的充分和必要条件. ()6. 连续信源和离散信源的熵都具有非负性. ()7. 信源的消息通过信道传输后的误差或失真越大,信宿收到消息后对信源存在的不确定性就越小,获得的信息量就越小.8. 汉明码是一种线性分组码. ()9. 率失真函数的最小值是0. ()10.必然事件和不可能事件的自信息量都是0. ()二、填空题1、码的检、纠错能力取决于 .2、信源编码的目的是;信道编码的目的是 .3、把信息组原封不动地搬到码字前k 位的),(k n 码就叫做 .4、香农信息论中的三大极限定理是、、 .5、设信道的输入与输出随机序列分别为X 和Y ,则),(),(Y X NI Y X I N N =成立的条件 ..6、对于香农-费诺编码、原始香农-费诺编码和哈夫曼编码,编码方法惟一的是 .7、某二元信源01()1/21/2X P X =,其失真矩阵00a D a ??=,则该信源的max D = . 三、计算题.1、某信源发送端有2种符号i x )2,1(=i ,a x p =)(1;接收端有3种符号i y )3,2,1(=j ,转移概率矩阵为1/21/201/21/41/4P ??=. (1)计算接收端的平均不确定度()H Y ;(2)计算由于噪声产生的不确定度(|)H Y X ;(3)计算信道容量以及最佳入口分布.(二)一、填空题1、信源编码的主要目的是,信道编码的主要目的是。

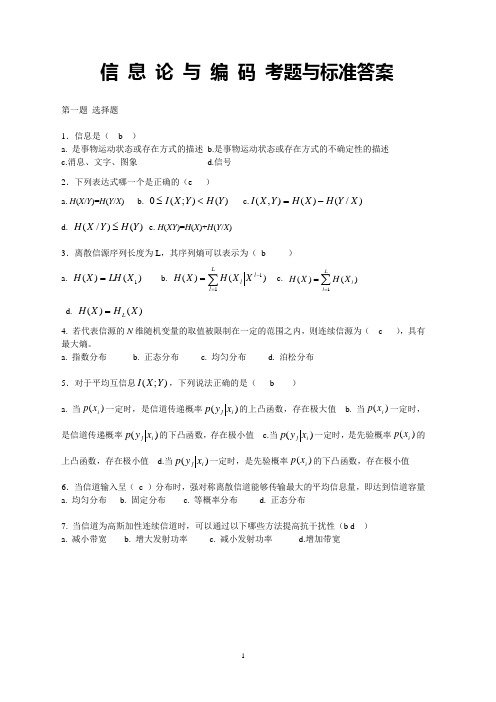

信 息 论 与 编 码 考题与标准答案第一题 选择题1.信息是( b )a. 是事物运动状态或存在方式的描述b.是事物运动状态或存在方式的不确定性的描述c.消息、文字、图象d.信号 2.下列表达式哪一个是正确的(e )a. H (X /Y )=H (Y /X )b. )();(0Y H Y X I <≤c.)/()(),(X Y H X H Y X I -=d. )()/(Y H Y X H ≤e. H (XY )=H (X )+H (Y /X )3.离散信源序列长度为L ,其序列熵可以表示为( b )a. )()(1X LH X H =b.c. ∑==Ll lXH X H 1)()(d. )()(X H X H L =4.若代表信源的N 维随机变量的取值被限制在一定的范围之内,则连续信源为( c ),具有最大熵。

a. 指数分布b. 正态分布c. 均匀分布d. 泊松分布 5.对于平均互信息);(Y X I ,下列说法正确的是( b )a. 当)(i x p 一定时,是信道传递概率)(i j x y p 的上凸函数,存在极大值b. 当)(i x p 一定时,是信道传递概率)(i j x y p 的下凸函数,存在极小值c.当)(i j x y p 一定时,是先验概率)(i x p 的上凸函数,存在极小值d.当)(i j x y p 一定时,是先验概率)(i x p 的下凸函数,存在极小值 6.当信道输入呈( c )分布时,强对称离散信道能够传输最大的平均信息量,即达到信道容量 a. 均匀分布 b. 固定分布 c. 等概率分布 d. 正态分布7.当信道为高斯加性连续信道时,可以通过以下哪些方法提高抗干扰性(b d ) a. 减小带宽 b. 增大发射功率 c. 减小发射功率 d.增加带宽第二题 设信源 ⎥⎦⎤⎢⎣⎡=⎥⎦⎤⎢⎣⎡6.04.0)(21x x X p X 通过一干扰信道,接收符号为Y={y 1,y 2},信道传递矩阵为⎥⎦⎤⎢⎣⎡43416165 求:(1) 信源 X 中事件 x 1 和 x 2 分别含有的自信息量。

信息论与编码期末考试题信息论与编码期末考试题(一)一、判断题. 1. 当随机变量和相互独立时,条件熵等于信源熵. () 2.由于构成同一空间的基底不是唯一的,所以不同的基底或生成矩阵有可能生成同一码集. () 3.一般情况下,用变长编码得到的平均码长比定长编码大得多. () 4. 只要信息传输率大于信道容量,总存在一种信道编译码,可以以所要求的任意小的误差概率实现可靠的通信.() 5. 各码字的长度符合克拉夫特不等式,是唯一可译码存在的充分和必要条件. () 6. 连续信源和离散信源的熵都具有非负性. () 7.信源的消息通过信道传输后的误差或失真越大,信宿收到消息后对信源存在的不确定性就越小,获得的信息量就越小.8. 汉明码是一种线性分组码. () 9. 率失真函数的最小值是. () 10.必然事件和不可能事件的自信息量都是. ()二、填空题 1、码的检、纠错能力取决于 . 2、信源编码的目的是;信道编码的目的是 . 3、把信息组原封不动地搬到码字前位的码就叫做. 4、香农信息论中的三大极限定理是、、 . 5、设信道的输入与输出随机序列分别为和,则成立的条件.. 6、对于香农-费诺编码、原始香农-费诺编码和哈夫曼编码,编码方法惟一的是 . 7、某二元信源,其失真矩阵,则该信源的= . 三、计算题. 1、某信源发送端有2种符号,;接收端有3种符号,转移概率矩阵为. (1)计算接收端的平均不确定度;(2)计算由于噪声产生的不确定度;(3)计算信道容量以及最佳入口分布. 2、一阶马尔可夫信源的状态转移图如右图所示,信源的符号集为. (1)求信源平稳后的概率分布;(2)求此信源的熵;(3)近似地认为此信源为无记忆时,符号的概率分布为平稳分布.求近似信源的熵并与进行比较. 3、设码符号为,信源空间为试构造一种三元紧致码. 4、设二元线性分组码的生成矩阵为. (1)给出该码的一致校验矩阵,写出所有的陪集首和与之相对应的伴随式;(2)若接收矢量,试计算出其对应的伴随式并按照最小距离译码准则试着对其译码. (二)一、填空题1、信源编码的主要目的是,信道编码的主要目的是。

信息论与编码试题集与答案(新)1. 在⽆失真的信源中,信源输出由 H (X ) 来度量;在有失真的信源中,信源输出由 R (D ) 来度量。

2. 要使通信系统做到传输信息有效、可靠和保密,必须⾸先信源编码,然后_____加密____编码,再______信道_____编码,最后送⼊信道。

3. 带限AWGN 波形信道在平均功率受限条件下信道容量的基本公式,也就是有名的⾹农公式是log(1)C W SNR =+;当归⼀化信道容量C/W 趋近于零时,也即信道完全丧失了通信能⼒,此时E b /N 0为 -1.6 dB ,我们将它称作⾹农限,是⼀切编码⽅式所能达到的理论极限。

4. 保密系统的密钥量越⼩,密钥熵H (K )就越⼩,其密⽂中含有的关于明⽂的信息量I (M ;C )就越⼤。

5. 已知n =7的循环码42()1g x x x x =+++,则信息位长度k 为 3 ,校验多项式 h(x)= 31x x ++ 。

6. 设输⼊符号表为X ={0,1},输出符号表为Y ={0,1}。

输⼊信号的概率分布为p =(1/2,1/2),失真函数为d (0,0) = d (1,1) = 0,d (0,1) =2,d (1,0) = 1,则D min = 0 ,R (D min )= 1bit/symbol ,相应的编码器转移概率矩阵[p(y/x )]=1001??;D max = 0.5 ,R (D max )= 0 ,相应的编码器转移概率矩阵[p(y/x )]=1010??。

7. 已知⽤户A 的RSA 公开密钥(e,n )=(3,55),5,11p q ==,则()φn = 40 ,他的秘密密钥(d,n )=(27,55) 。

若⽤户B 向⽤户A 发送m =2的加密消息,则该加密后的消息为 8 。

⼆、判断题1. 可以⽤克劳夫特不等式作为唯⼀可译码存在的判据。

(√ )2. 线性码⼀定包含全零码。

(√ )3. 算术编码是⼀种⽆失真的分组信源编码,其基本思想是将⼀定精度数值作为序列的编码,是以另外⼀种形式实现的最佳统计匹配编码。

信息论参考答案信息论参考答案信息论是一门研究信息传输和编码的学科,它的核心概念是信息的度量和传输。

信息论的发展可以追溯到上世纪40年代,由克劳德·香农提出,并逐渐成为计算机科学、通信工程等领域的重要理论基础。

本文将从信息的定义、信息的度量以及信息的传输三个方面,探讨信息论的相关知识。

一、信息的定义信息是指能够改变接收者知识状态的事实或数据。

在信息论中,信息的基本单位是比特(bit),它表示一个二进制的选择,即0或1。

比特是信息论中最小的单位,可以用来表示一个简单的选择问题,如是或否、真或假等。

当然,在实际应用中,比特往往被扩展为更大的单位,如字节、千字节等。

二、信息的度量信息的度量是信息论的核心问题之一。

克劳德·香农提出了信息熵的概念,用来度量信息的不确定性或者说信息的平均量。

信息熵的计算公式为:H(X) = -ΣP(x)log2P(x),其中H(X)表示随机变量X的信息熵,P(x)表示随机变量X取值为x的概率。

信息熵越大,表示信息的不确定性越高,反之亦然。

除了信息熵,信息论还引入了条件熵、相对熵和互信息等概念。

条件熵表示在已知某些信息的情况下,对另一个随机变量的不确定性进行度量。

相对熵用来衡量两个概率分布之间的差异,而互信息则表示两个随机变量之间的相关程度。

三、信息的传输信息的传输是信息论的另一个重要问题。

在信息论中,通过信道来传输信息。

信道可以是有线的或者无线的,可以是噪声的或者非噪声的。

为了保证信息的可靠传输,需要对信息进行编码和解码。

编码是将信息转化为能够在信道中传输的信号的过程。

常见的编码方法有霍夫曼编码、香农-费诺编码等。

编码的目标是尽量减少信息的冗余,提高信息的传输效率。

解码是将经过信道传输的信号恢复为原始信息的过程。

解码的目标是尽量减少信息的失真,保证信息的可靠性。

常见的解码方法有最大似然解码、Viterbi解码等。

信息论的应用广泛,不仅在通信领域发挥着重要作用,还在数据压缩、密码学、人工智能等领域有着广泛的应用。

(一)一、判断题.1. 当随机变量X 和Y 相互独立时,条件熵)|(Y X H 等于信源熵)(X H . ( )2. 由于构成同一空间的基底不是唯一的,所以不同的基底或生成矩阵有可能生成同一码集. ( )3.一般情况下,用变长编码得到的平均码长比定长编码大得多. ( )4. 只要信息传输率大于信道容量,总存在一种信道编译码,可以以所要求的任意小的误差概率实现可靠的通信. ( )5. 各码字的长度符合克拉夫特不等式,是唯一可译码存在的充分和必要条件. ( )6. 连续信源和离散信源的熵都具有非负性. ( )7. 信源的消息通过信道传输后的误差或失真越大,信宿收到消息后对信源存在的不确 定性就越小,获得的信息量就越小.8. 汉明码是一种线性分组码. ( ) 9. 率失真函数的最小值是0. ( ) 10.必然事件和不可能事件的自信息量都是0. ( ) 二、填空题1、码的检、纠错能力取决于 .2、信源编码的目的是 ;信道编码的目的是 .3、把信息组原封不动地搬到码字前k 位的),(k n 码就叫做 .4、香农信息论中的三大极限定理是 、 、 .5、设信道的输入与输出随机序列分别为X 和Y ,则),(),(Y X NI Y X I N N =成立的 条件 .6、对于香农-费诺编码、原始香农-费诺编码和哈夫曼编码,编码方法惟一的是 .7、某二元信源01()1/21/2X P X ⎡⎤⎧⎫=⎨⎬⎢⎥⎣⎦⎩⎭,其失真矩阵00a D a ⎡⎤=⎢⎥⎣⎦,则该信源的max D = .三、计算题.1、某信源发送端有2种符号i x )2,1(=i ,a x p =)(1;接收端有3种符号i y )3,2,1(=j ,转移概率矩阵为1/21/201/21/41/4P ⎡⎤=⎢⎥⎣⎦.(1)计算接收端的平均不确定度()H Y ;(2) 计算由于噪声产生的不确定度(|)H Y X ; (3) 计算信道容量以与最佳入口分布.(二)一、填空题1、信源编码的主要目的是 ,信道编码的主要目的是 。

第1 页 共3 页

北方民族大学试卷

课程代码: 01100622 课程: 信息理论及编码 B 卷答案

说明:此卷为《信息理论及编码》B 卷答案

一、概念简答题(每小题6分,共30分)

1、比较平均自信息(信源熵)与平均互信息的异同。

答:平均自信息为 ()()()1

log q

i

i

i H X P a P a ==-

∑,表示信源的平均不确定度,也表示平均

每个信源消息所提供的信息量。

………………………………………(3分)

平均互信息()()()

()

,;log X Y

y

P x I X Y P xy P y =

∑。

表示从Y 获得的关于每个X 的平均信息量,也

表示发X 前后Y 的平均不确定性减少的量,还表示通信前后整个系统不确定性减少的量。

………………………………………(3分)

2、简述香农第一定理。

答:对于离散信源S 进行r 元编码,只要其满足

()

_

log H s N

N

r

L ≥

,…………………(3分) 当N 足够长,总可以实现无失真编码。

………………………………………(3分)

3、简述唯一可译变长码的判断方法?

答:将码C 中所有可能的尾随后缀组成一个集合F ,当且仅当集合F 中没有包含任一码字时,码C 为唯一可译变长码。

构成集合F 的方法:…………………(2分)

首先,观察码C 中最短的码字是否是其他码字的前缀。

若是,将其所有可能的尾随后缀排列出。

而这些尾随后缀又可能是某些码字的前缀,再将由这些尾随后缀产生的新的尾随后缀列出。

依此下去,直至没有一个尾随后缀是码字的前缀或没有新的尾随后缀产生为止。

…………………(2分)

接着,按照上述步骤将次短的码字直至所有码字可能产生的尾随后缀全部列出,得到尾随后

缀集合F 。

…………………(2分)

4、简述最大离散熵定理。

答:最大离散熵定理为:对于离散无记忆信源,当信源等概率分布时熵最大。

……(3分)

对于有m 个符号的离散信源,其最大熵为log m 。

…………………………(3分)

5、什么是汉明距离;两个二元序列1230210,0210210i j αβ==,求其汉明距离。

答:长度相同的两个码字之间对应位置上不同的码元的个数,称为汉明距离。

…………………(3分)

(),5i j D αβ=………………………………………(3分)

二、判断题(每小题2分,共10分)

1、信息是事物运动状态或存在方式的不确定性的描述。

( √ )

2、当信源与信道连接时,若信息传输率达到了信道容量,则称此信源与信道达到匹配。

( √ )

3、二元霍夫曼码一定是最佳即时码。

( √ )

4、单符号离散信源的自信息和信源熵都是一个确定值。

( × )

5、平均错误概率只与译码准则有关系。

( × )

三、计算题(每小题10分,共40分)

1、设离散无记忆信源()1

234012*********a a a a X P x ====⎡⎤

⎡⎤⎢⎥=⎢⎥⎢⎥⎣⎦⎢⎥⎣⎦。

其发生的消息为()202123021302201320200231201320,求:(1)此消息的自信息是多少?(2)在此消息中平均每个符号携带的自信息是多少? 答: (1)自信息量()()()()()()

9log 05log 111log 25log 359.74I a P P P P =----≈比特……………(5分)

(2)()

259.74

1.9930

I =≈比特符号………………………………………(5分)

第2 页 共3 页

2、计算以下2个信道的信道容量C :

11

1

1133661111636

3P ⎡⎤

⎢⎥

=⎢

⎥⎢⎥

⎢⎥⎣⎦, 200

101

00000010

10

0P ⎡⎤⎢⎥⎢

⎥=⎢⎥⎢⎥⎣⎦

答:1P 为准对称信道,其信道容量∑=-

'''-=n

k k k

s M N

p p p H r C 1

211log ),,,(log ………………(2分)

其中3个子矩阵为⎥

⎥⎥⎦

⎤

⎢⎢⎢⎣⎡=316161311B ,⎥⎥⎥⎦⎤⎢⎢⎢⎣⎡=31312B ,⎥⎥⎥⎦⎤⎢⎢⎢⎣⎡=61613B ,所以61

,31,21321===N N N

3

1,32,21321===M M M ,

则)/(0407.0)31

log 6132log 3121log 21()61,61,31,31(2log 1symbol bit H C =++--=………(4分)

2P 为一一对应信道,其信道容量)/(24log )(max 22symbol

bit X H C ===………………(4分)

3、信源空间为⎥⎦

⎤⎢⎣⎡=⎥⎦⎤⎢⎣⎡05.005.005.005.01.01.02.04.0)(87654

321s s s s s s s s s P S ,试构造二元霍夫曼码,并计

算其平均码长和编码效率。

答:霍夫曼编码如下表所示

………………(6分)

平均码长信源符号)

(码符号/6.224.022.0231.04405.0=⨯+⨯+⨯⨯+⨯⨯=L ………(2分) 编码效率97.06.2)05.01

log 05.041.01log 1.022.01log 2.04.01log 4.0()(=⨯+⨯++==L

S H η(2分)

4、设某二元码为{}00000011011011111010C =。

(1)计算此码的最小距离min d ;(2)计算此码的码率R ,假设码字等概率分布;(3)采用最小距离译码准则,接收到序列00100,01010,00111和

00101应译成什么码字。

答:(1) min 3d =………………(3分) (2) ()

log log 4

0.45

m R n =

==比特码符号………………(3分)

(3)序列00100译成00000,………………(1分)

序列01010译成11010,………………(1分) 序列00111译成10111,………………(1分) 序列00101译成01101………………(1分)

四、综合题(20分)

1、二元对称信道的信道矩阵为⎥

⎦

⎤

⎢

⎣⎡=9.01.01.09.0P ,信道传输速度为1500二元符号/秒,设信源为等概率分布,信源消息序列共有13000个二元符号,问:

(1)试计算能否在10秒内将信源消息序列无失真传送完?

(2)若信源概率分布为3.0)1(,7.0)0(==P P ,求无失真传送以上信源消息序列至少需要多长时间? 答:(1)此信道为二元对称信道,信源等概分布时,信道传输率达最大-C 。

信源熵

)/(12log )(symbol bit S H ==………………(1分)

)/(531.0469.011.0log 1.09.0log 9.01)(122symbol bit P H C =-=--=-=………………(1分)

)(113000)(7965531.0101500bit bit ⨯<=⨯⨯,所以10秒内不能传完。

………………(3分)

第3 页 共3 页

(2)信源不等概分布,信息传输率达不到C

)/(88129.052109.03602.03

.01log 3.07.01log

7.0)(symbol bit S H =+=+=………………(1分) 130000个信源符号所含信息量为:)(77.11456)(130000bit S H =⨯………………(2分)

[][]34.066.09.01.01.09.03.07.0)(=⎥

⎦⎤

⎢⎣⎡⨯=y P ………………(1分) ⎥⎦

⎤

⎢⎣⎡=⎥⎦⎤⎢⎣⎡⨯⨯⨯⨯=27.003.007.063.03.09.03.01.07.01.07.09.0)(xy P ………………(1分)

信息传输率:

)/(4558.034

.09

.0log 27.066.01.0log 03.034.01.0log 07.066.09.0log

63.0)

()/(log )();(2

symbol bit y P x y P y x P Y X I R XY

j i j j i =+++===∑………(5分)

要无失真传送130000个二元符号的信源消息序列至少需要的时间:

s T 757.161500

4558.077

.11456=⨯≥

………………(5分)。