Q博士语音识别机器人制作

- 格式:docx

- 大小:1.06 MB

- 文档页数:24

机器人的语音识别功能的实现与硬件设计摘要目前语音识别系统在机器人上的应用逐步得到了扩展,其主要的硬件基础是基于单机芯片的发展和完善。

因此,在机器人语音识别功能时,需要以单机芯片为核心,完善整个硬件系统设计,并以此达到连贯的语音控制。

关键词语音识别;硬件系统;硬件模块;系统设计1 语音智能识别原理概述语音识别是建立在对人类语言的交互与判断上的,这是一种多维度的识别过程,一般可以分为两个阶段,即信息汇集和识别。

具体的识别过程包括了语音信号的前期处理、语音特征提取、建立语音模型库、进行模型的匹配、后期处理等主要的环节。

机器人的语音识别实际上一种仿生式的模式,即将语音转化为一直可以对别的语音特征,然后与储存的信息进行对比,并形成对其含义的判断,人类对语音的含义的判断也是这样的过程,只不过人类使用的是大脑而机器人利用的是数据库和芯片,目前占有主导地位的语音识别技术的技术基础是统计模式的识别理论。

2 机器人语音识别系统的硬件设计2.1 硬件系统的整体构成语音识别的硬件系统中体的构成应当为了两个大系统构成,即发射端和接收端,即利用主要的芯片系统来接收语音信号,并进行计算和识别,然后利用信号输出端口将形成的指令传输给接收端的执行系统,并以此控制机器人的各个电机和肢体部件,来完成整个语音指令的执行。

在这个系统中主要的硬件系统有:微处理器、音频模块、电机驱动模块、避障系统、机器人系统、电源控制模块。

具体的系统构成如图1。

2.2 硬件系统的设计在具有语音识别功能的机器人硬件系设计中应当对前面提到的各种功能模块进行单独的设计和实现,然后利用线路和端口将整个系统连接起来,这样就实现了机器人硬件系统的搭建。

1)电子芯片(微处理器)。

在这里应用的是SPCE061A单机芯片。

这种语音识别的专业芯片来构建机器人的语音识别和控制系统可以实现机器人的自动运行。

这种语音系统的硬件基础就是SPCE061A控制器为核心的语音识别平台。

这种SPCE061A是一种具有语音特色的16位控制器,采用的是模块化的结构,内部集成了在线仿真处理器,闪存、静态内存、通用的端口、定时和计数器、中断控制器、通道转换器、电压监控等模块。

q博士智能机器人用法一、简介Q博士智能机器人是一款基于人工智能技术的家庭智能助手,它能够协助您完成各种任务,如查询信息、购物、控制智能家居等。

本文档将向您介绍Q博士智能机器人的用法,让您轻松驾驭这款智能助手。

二、安装与连接1. 打开您的家庭网络,确保您的智能机器人与您的计算机或移动设备处于同一网络下。

2. 下载并安装Q博士智能机器人的应用软件。

3. 打开应用软件,按照提示连接您的Q博士智能机器人。

三、基本用法1. 语音控制:使用口头指令控制Q博士智能机器人,如“Q博士,帮我查询天气”、“Q博士,播放音乐”等。

2. 文字输入:通过手机或计算机输入文字,让Q博士智能机器人执行相应任务。

3. 语音识别:Q博士智能机器人能够识别多种语言和方言,并为您提供准确的服务。

4. 语音合成:Q博士智能机器人能够以语音形式为您提供回复和帮助。

四、高级用法1. 智能家居控制:通过Q博士智能机器人控制家庭中的各种智能设备,如灯光、空调、电视等。

2. 购物与支付:使用Q博士智能机器人进行在线购物,并支持多种支付方式。

3. 查询服务:Q博士智能机器人提供多种查询服务,如地图、公交、列车时刻表、黄页等。

4. 知识问答:Q博士智能机器人拥有丰富的知识库,能够回答各种问题,如历史、文化、科学等。

5. 语音翻译:Q博士智能机器人支持多语言翻译,让您轻松与世界各地的人交流。

五、常见问题及解决方法1. 问题一:Q博士智能机器人无法连接网络,怎么办?答:请检查您的网络设置是否正确,并尝试重新启动Q博士智能机器人和路由器。

2. 问题二:我口音不标准,Q博士智能机器人的语音识别效果不好怎么办?答:您可以尝试在语音识别前进行一些简单的口语练习,以提高语音识别效果。

同时,建议您在使用过程中保持耐心和积极的态度。

3. 问题三:使用过程中出现错误或异常情况,如何解决?答:请查看应用软件的错误提示,并根据提示进行相应的操作。

如果无法解决问题,建议您联系客服人员寻求帮助。

基于语音识别技术的机器人控制系统设计随着技术的发展,人工智能已经成为了一个备受关注的话题,尤其是近年来,机器人技术的进步更是让人感到惊讶。

在以前的时候,我们想要控制机器人,往往需要使用遥控器或者是键盘等设备,但是这样的方法使得控制过程不够方便,这也促进了语音识别技术的发展。

基于语音识别技术的机器人控制系统在控制过程中可以大大提高我们的控制体验以及控制效率,本文将从以下几个方面来探讨基于语音识别技术的机器人控制系统设计。

一、语音识别技术的介绍语音识别技术是一种将人类声音转化成电子信号的技术,它利用电子设备将声音转化为数字信号,然后通过计算机处理,最终将这些数据转化为文本或命令等信息的过程。

语音识别技术目前已经在生活中得到普遍应用,在智能手机的语音助手中,语音识别技术已经成为了我们日常生活的一部分。

二、基于语音识别技术的机器人控制系统的设计基于语音识别技术的机器人控制系统的设计需要包括如下几个方面:1.声音采集:首先,采集到声音信号是控制机器人的第一步。

常用的方法是利用麦克风将声音信号采集下来,然后通过A/D转换将其转化为数字信号。

2.信号处理:语音信号的采样频率通常很高,但是大部分的音频处理器和计算机都无法处理如此高频率的数据,因此需要对数据进行预处理。

这个过程包括抽样率转换、去除白噪声、滤波、降噪等。

3.特征提取:在预处理过程中,声音信号转化为了数字信号,但这仅仅是一个基础工作,我们在使用机器人控制系统时,还需要对语音信号进行进一步的分析和处理。

特征提取是一种将语音信号转换为能够计算机理解的数字特征向量的过程,这个过程中主要需要提取信号的时域、频域和功率等信息。

4.语音识别:在特征提取之后,我们就可以将其输入到语音识别模型中,进行语音识别。

语音识别模型通常分为前端和后端。

前端主要完成特征提取和信号归一化的工作,后端则负责计算语音识别结果。

在算法方面,现在主流的语音识别算法包括基于HMM和深度学习的算法等。

q博士智能机器人用法-回复Q博士智能机器人用法智能机器人已经成为现代社会中的重要工具,为人们的生活带来了许多便利和创新。

而其中,Q博士智能机器人作为一款先进的机器人产品,更是备受关注。

本文将从使用前的激活步骤开始,介绍Q博士智能机器人的用法,并逐步展示其功能和特点。

一、激活和初始化使用Q博士智能机器人前,首先需要进行激活和初始化。

使用者可以根据附带的说明书,按照指引包括插入电源适配器和设置无线网络连接等步骤,将Q博士智能机器人连接到电源和互联网。

二、语音唤醒和交互操作激活和初始化完成后,使用者可通过语音唤醒Q博士智能机器人。

只需说出设定的语音唤醒词,如“Hello Q博士”,机器人将立即进入交互模式。

用户可以直接与Q博士进行语音对话,并通过语音指令来控制机器人的各项功能。

三、语音助手功能Q博士智能机器人搭载了强大的语音助手功能,可提供各种实用信息和服务。

用户可以通过简单的语音指令,询问天气状况、新闻资讯、股票行情等实时信息;也可以提出问题,如数学计算和百科知识查询,Q博士都能提供准确的答案。

四、智能家居控制Q博士智能机器人是一款智能家居的控制中心,可以与家中的智能设备进行联动。

用户通过语音指令,可以控制智能灯光的亮度和颜色,调节温度和湿度等环境参数,甚至可以远程控制家中的电器设备开关。

这使得家居生活更加便利和智能化。

五、娱乐和休闲功能Q博士智能机器人还拥有丰富的娱乐和休闲功能,能够为用户带来欢乐和放松。

机器人可以播放音乐、讲故事、唱歌、给孩子们讲睡前故事等。

此外,Q博士还具备语音识别和智能对话技术,可陪用户进行有趣的对话和互动。

六、教育和学习辅助在教育领域,Q博士智能机器人也具有重要的作用。

机器人可以提供学习资料和学习辅导,帮助孩子们学习语言、数学、科学等知识。

通过与机器人的互动,孩子们可以更加主动地学习和探索,提高学习效果。

七、健康监测Q博士智能机器人还能提供健康监测功能。

机器人配备了传感器和摄像头等设备,能够实时监测使用者的心率、血压、体重等健康指标,并生成健康报告。

人工智能聊天机器人的语音识别实现方法人工智能技术的迅速发展为我们的生活带来了诸多便利,其中之一就是语音识别技术的应用。

人工智能聊天机器人作为一种常见的应用形式,其语音识别技术的实现方法至关重要。

本文将从几个方面介绍人工智能聊天机器人的语音识别实现方法。

首先,人工智能聊天机器人的语音识别涉及到语音信号的获取和预处理。

在获取语音信号方面,可以使用麦克风或其他音频设备。

在预处理方面,必要的环境噪声滤波和采样率转换将有助于提高语音信号的质量。

这一步骤的目标是规范和优化语音信号以提高后续处理的准确性。

其次,语音识别算法是人工智能聊天机器人语音识别的核心部分。

现阶段,比较流行的语音识别算法包括基于隐马尔可夫模型(HMM)的语音识别、深度神经网络(DNN)的语音识别和转移学习技术的语音识别。

这些算法的共同目标是将语音信号转化为可识别的文本信息。

对于基于隐马尔可夫模型的语音识别方法,其基本思想是将语音信号表示为一系列状态,然后通过计算状态概率来得到最可能的识别结果。

这一方法需要训练大量的语音样本来建立模型,并通过使用概率论的方法进行推断。

然而,由于隐马尔可夫模型无法很好地建模长期依赖关系,该方法的识别准确度有限。

为了解决基于隐马尔可夫模型的语音识别的限制,深度神经网络的语音识别方法应运而生。

该方法通过构建多层神经网络来学习语音信号的高级特征,并进一步使用这些特征进行文本信息的识别。

深度神经网络的主要优点是能够很好地处理长期依赖关系,并且在大规模数据集上取得了很好的性能。

除了传统的语音识别方法外,转移学习技术也逐渐应用于人工智能聊天机器人的语音识别中。

通过从一个领域学习的知识应用到另一个领域中,转移学习可以大大降低训练数据的需求,并提高语音识别的准确性。

例如,可以通过在大规模的通用语音数据集上训练网络,并使用学到的特征来进行特定领域的语音识别任务。

最后,人工智能聊天机器人的语音识别还需要考虑用户交互的实时性和稳定性。

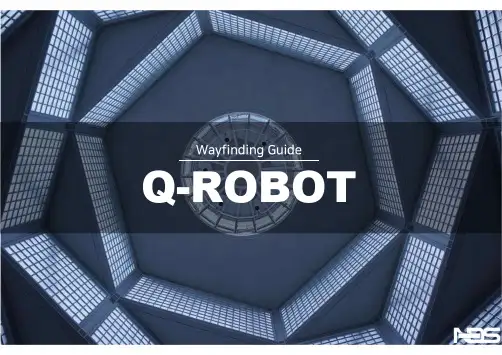

Wayfinding GuideQ-ROBOT硬件室内、户外广告机视频墙&显示镜面显示智能广告机软件信息发布综合管理系统触摸寻路制作软件支持Window/Android/cloudContent3D寻路系统菜单栏人体感应&人脸识别会议室系统解决方案系统企划&引入自行安装&安装指导系统稳定化售后服务NDS Solution Co., Ltd.DESIGN01语音识别引路机器人设计以及外设PREMIUMMain FunctionSmart Responding to Customer InquiriesHD 摄像头LCD安保摄像头麦克风脸部识别摄像头마이크신분증인식QR扫描机摄像头触摸屏开关超声波传感器传感器打印机Lidar 传感器移动底盘触摸传感器灯条触摸传感器功放充电口HD 摄像头LCD安保摄像头麦克风脸部识别摄像头触摸屏开关超声波传感器Lidar 传感器移动底盘灯条功放充电口客户服务广告和信息播放商务咨询简单的业务处理位置引路避免碰撞自动躲避多任务处理人脸识别技术系统集成SPECIFICATION01语音识别引路机器人参数SORT STANDARD PREMIUMSIZE L590*W590*H1590WEIGHT60KGMATERIAL ABS 部件,纤维强化塑料外壳RATED POWER80WAMBIENT LIGHT手臂*2SPEAKER15W通道HiFi 内置音箱MICAIUI 麦阵列麦克风识别距离:最大5M,角度:0-180°,降噪特点:回声消除与声源定位,全双工尺寸交互CAMERA人脸识别摄像上下左右可视角度:125°,抗逆光,分辨率300 万-3D 体感摄像头SCREEN23.6 英寸,1920*1080P,电容式(触摸区域:高529mm 宽295mm)眼睛液晶屏Lcd 高清液晶屏,分辨率:320*240MOVING头部关节:水平转动角度:±40°,垂直转动角度:±10°适应坡度:±3°(注:不能在坡度中停留)越障高度:<10mm最快速度:≤1m/sPERIPHERALS -58mm 打印机-NFC-QR扫描仪BATTERY24V30Ah 锂电池组,续航约10h,待机约24hSORT STANDARD PREMIUMSENSOR超声波传感器*2:探测有效距离: 1900mm ,探测上下左右角度:±30°人体传感器*2:探测有效距离:5M,探测角度:±45°CHARGE输入电压:200-240VAC,充电电流:6ASYSTEM Android5.1CPU RK3368INTERNET WIFI 2.4G/5GRAM DDR4_2400 4GSSD128GNAVIGATION视野:360°测量盲区:0.1m测量分辨率:3cm通讯速率:256000bps工作距离:白色物体:40米(白色漫反射面)黑色物体:10 米(反射率10%)测量精度:±5cm*工作电压:典型值5V功率:3W工作温度:摄氏度典型值25°C视野:270°工作距离:0.05∼10 米响应时间:67ms%10 反射率最大工作距离:8m系统误差:±60 mm统计误差:±20 mm工作电压:0 V DC-28 V DC功耗:典型值3 W(无输出负载)防护等级:IP 65 (EN60529/A1:2000-02)AVOIDANCESYSTEM激光雷达探测距离:0.05~8M,探测辐射角度:270°超声波传感器*2探测有效距离: 1900mm,探测上下左右角度:±30°DEVELOPMENT API, SDK应用范围客户服务通过自动识别目标和人物,欢迎和道别成为可能,可按照指定的路线进行移动。

人工智能语音助手的语音合成算法随着人工智能的发展和智能设备的普及,语音助手正逐渐成为我们日常生活中不可或缺的一部分。

无论我们使用的是智能手机、智能音箱还是智能电视,语音助手都可以通过语音交互来为我们提供各种服务。

其中,语音合成算法是实现语音助手功能的关键技术之一。

一、语音合成的基本原理语音合成,简称TTS(Text-to-Speech),是将文字转化为人类可以听懂的语音信号的技术过程。

它主要包括文本处理、音素转换、参数生成和语音合成四个主要步骤。

1. 文本处理:将输入的文本进行分词处理,去除标点符号和空格,并进行词性标注。

这一步的目的是为了将输入的文本转化为可供后续处理的形式。

2. 音素转换:将每个词转化为对应的音素,即语音的最小单位。

根据汉语拼音规则或者其他语音库,将词与音素进行对应,以便后续的参数生成和语音合成。

3. 参数生成:根据转换后的音素序列,生成音色、音调、语速等参数。

参数生成方法有多种,包括基于规则的方法和统计机器学习方法。

其中,统计机器学习方法如隐马尔可夫模型和深度神经网络等,已经成为目前主流的参数生成技术。

4. 语音合成:根据生成的参数,结合语音合成模型和语音合成引擎,将参数转化为人类可以听懂的语音信号。

语音合成模型通常包括声码器、声音质量增强模块等,通过将参数转换为音频信号实现语音合成。

二、常见的语音合成算法1. 基于规则的方法:基于规则的语音合成算法是早期的一种方法。

它通过事先定义一些规则和规则集合,将文本转化为语音。

这些规则可以是音素到音节的映射、音节到音素的映射,或者其他一些语音规则。

基于规则的方法虽然可以实现一定程度上的语音合成,但是由于规则的复杂性和难以覆盖所有情况,其语音合成效果往往不够自然和流畅。

2. 隐马尔可夫模型(HMM):隐马尔可夫模型是一种统计建模方法,在语音合成中得到了广泛的应用。

隐马尔可夫模型通过学习语音和特征之间的统计关系,将输入的文本转化为相应的参数序列,再通过声码器将参数序列转换为语音信号。

基于语音合成的智能问答机器人系统设计智能问答机器人是一种利用人工智能和自然语言处理技术,通过语音合成技术与用户进行对话,并提供相关问题的答案和解决方案的系统。

本文将主要介绍基于语音合成的智能问答机器人系统设计原理及实现方法。

一、系统设计原理基于语音合成的智能问答机器人系统设计基于以下几个核心原理:1. 语音识别:通过声音信号的处理和模式识别,将用户的语音输入转化为文字信息,方便后续的自然语言处理。

2. 自然语言理解:通过自然语言处理技术,将用户的提问进行语义分析和实体抽取,理解用户的意图和需要。

3. 知识图谱构建:通过构建知识图谱,将大量的结构化和半结构化的信息进行组织和处理,为机器人提供丰富的知识基础。

4. 答案生成:基于用户提问的内容以及构建的知识图谱,通过模板匹配、规则推理等技术,生成对应的答案。

5. 语音合成:将生成的答案通过语音合成技术,转化为自然流畅的语音信号输出给用户。

二、系统实现方法基于上述设计原理,可以采用以下实现方法来开发基于语音合成的智能问答机器人系统:1. 数据收集和预处理:收集和整理大量的用户问答数据,进行数据清洗、去重和标注,构建适用于机器学习的训练数据集。

2. 语音识别模型训练:利用训练数据集,采用深度学习技术如循环神经网络(RNN)或卷积神经网络(CNN),训练语音识别模型,实现语音到文本的转化。

3. 自然语言理解模型训练:利用标记好的问答数据集,使用自然语言处理技术如分词、词性标注、依存句法分析等,训练自然语言理解模型,实现问题意图和实体的识别。

4. 知识图谱构建:从互联网上收集相关的知识和信息,并将其进行结构化处理,构建知识图谱,以便机器人可以根据用户问题作出相关的回答。

5. 答案生成模型训练:利用标记好的问题-答案数据集,使用机器学习或推理技术,训练答案生成模型,根据用户提问生成合适的答案。

6. 语音合成模型训练:使用大量的语音数据及其对应的文本标签,训练语音合成模型,将文本转化为流畅自然的语音信号。

制作聊天机器人的方法制作聊天机器人的方法有多种,以下是其中几种常见的方法。

1. 基于规则的机器人:这种机器人使用预先定义的规则和语法来回答用户的问题。

开发者需要建立一系列规则,将问题的模式和可能的答案进行匹配。

这种方法适用于对话内容较为固定和有限的场景,例如帮助中心的常见问题解答。

2. 基于统计的机器人:这种机器人基于统计分析和机器学习算法来生成回答。

通过对大量的语料库进行训练,机器可以学习到词语之间的关系和上下文信息,并根据概率模型生成回答。

这种方法适用于对话内容复杂多样的场景,例如智能客服和智能助手。

3. 混合方法:也可以结合规则和统计方法,通过规则过滤和统计模型生成回答,以增强机器人的准确性和灵活性。

开发者可以根据具体场景的需求选择合适的方法。

另外,开发聊天机器人还需要进行以下步骤:1. 收集和整理训练数据:收集大量的语料库作为训练数据,涵盖机器人可能遇到的各种对话场景和问题。

2. 数据预处理:对训练数据进行处理,包括分词、去除停用词、词性标注等,以便机器能够更好地理解和处理文本。

3. 训练模型:根据选择的机器学习算法,使用训练数据进行模型训练,构建用于生成回答的模型。

4. 评估和调整:对训练得到的模型进行评估,评估指标可以包括准确率和召回率等。

根据评估结果,对模型进行调整和优化。

5. 部署和测试:将训练好的模型部署到实际的聊天机器人系统中,进行测试和调试,确保机器人能够正确地理解和回答用户的问题。

通过以上步骤,可以制作一个基本的聊天机器人。

随着技术的发展,还可以结合深度学习和自然语言处理等最新技术,进一步提升机器人的对话能力和智能水平。

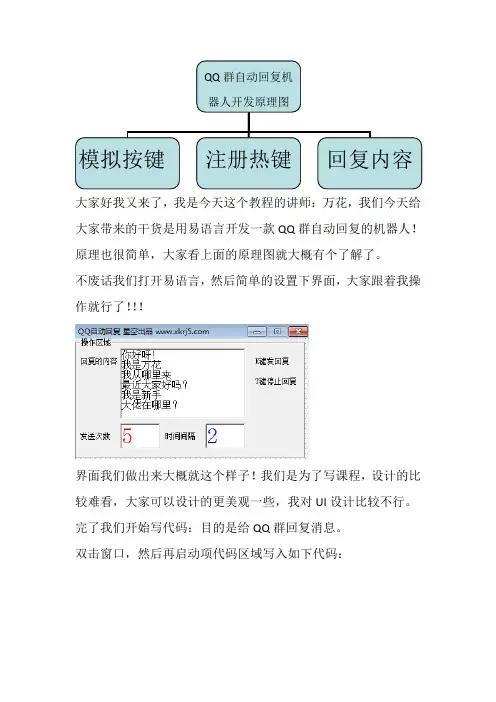

QQ群自动回复机

器人开发原理图

模拟按键注册热键回复内容大家好我又来了,我是今天这个教程的讲师:万花,我们今天给大家带来的干货是用易语言开发一款QQ群自动回复的机器人!原理也很简单,大家看上面的原理图就大概有个了解了。

不废话我们打开易语言,然后简单的设置下界面,大家跟着我操作就行了!!!

界面我们做出来大概就这个样子!我们是为了写课程,设计的比较难看,大家可以设计的更美观一些,我对UI设计比较不行。

完了我们开始写代码:目的是给QQ群回复消息。

双击窗口,然后再启动项代码区域写入如下代码:

这样的话我们就注册好了一个热键,当我们按下K键的时候热点就开始反馈事件了。

接下来我们在标签处写反馈事件的代码!

加入一个判断,方便我们后期的调试工作,然后写一个关于发送消息的子程序()

通过这段代码我们就可以实现自动QQ群消息的功能了,是通过

热键K执行,那么停止的热键T我们也需要写代码的。

这段代码就OK

完了我们运行一下看效果咋样?

看来是没问题的,可以实现自动回复群消息和发送次数以及发送的时间间隔,通过我们提供的代码都可以实现哈!今天就更新到这里,拜拜!。

基于人工智能的语音识别系统设计与实现基于人工智能的语音识别系统设计与实现摘要:语音识别系统是一种基于人工智能的技术,旨在将人类语音转化为文字或者命令。

本论文旨在介绍基于人工智能的语音识别系统的设计与实现。

首先,我们将介绍语音识别系统的原理与工作原理,包括信号预处理、特征提取与分类器。

接着,我们将详细介绍语音信号的预处理方法,包括噪音消除与语音分段。

然后,我们将介绍特征提取的方法,包括时域与频域特征提取。

最后,我们将介绍常用的分类器模型,包括隐马尔可夫模型、深度神经网络和转移学习等。

通过对这些技术的综合应用,我们可以实现高效准确的语音识别系统。

关键词:人工智能、语音识别、信号预处理、特征提取、分类器1. 引言语音识别技术是一种允许计算机将人类语音转化为文本或命令的技术,是近年来人工智能领域的研究热点之一。

随着人工智能技术的快速发展,语音识别系统已经广泛应用于语音助手、智能家居、自动驾驶等各个领域。

本论文将介绍基于人工智能的语音识别系统的设计与实现,旨在提供一个较为全面的概述,以帮助更多人开展相关研究。

2. 语音识别系统原理语音识别系统一般包括三个主要模块:信号预处理、特征提取和分类器。

信号预处理模块用于去除语音信号中的噪音和干扰,提高信号的质量。

特征提取模块用于从语音信号中提取关键特征,并将其表示为计算机可以处理的形式。

分类器模块则用于将提取的特征与已知模式进行匹配,从而实现语音的识别与分类。

3. 语音信号的预处理语音信号预处理是语音识别的第一步,其主要目的是去除信号中的噪音和干扰,提高信号的质量。

常用的预处理技术包括噪音消除和语音分段。

3.1 噪音消除噪音消除是一种常见的信号处理技术,其目的是将语音信号从环境噪声中分离出来。

常用的噪音消除方法包括滤波、谱减法和自适应滤波等。

滤波方法是一种基于数学模型的噪音消除方法,其通过对信号进行滤波来降低噪音的影响。

谱减法是一种基于频域的噪音消除方法,其通过将频谱中的噪音部分减去,来恢复原始语音信号。

智能语言教学机器人的制作流程制作智能语言教学机器人可以分为以下几个主要步骤:1.确定需求和目标:在开始制作之前,需要确定机器人的主要功能和使用场景。

例如,是用于基础语言学习还是专业语言学习,是用于幼儿教育还是成人学习等。

同时,还需要明确机器人的目标用户群体和他们的学习需求。

2.设计语言教学内容:根据目标和需求,设计合适的语言教学内容。

这可以包括基础的词汇和语法教学,听力和口语练习,阅读和写作知识等。

同时,还要考虑如何利用机器人的语音合成和语音识别功能进行真实对话模拟和听力练习。

3.开发语音识别功能:制作智能语言教学机器人首先需要实现语音识别的功能,以便能够听取用户的发音并给予反馈。

这可能涉及到使用自然语言处理(NLP)技术和机器学习算法来识别用户的发音,并将其与正确的发音进行比较。

4.实现语音合成功能:为了能够与用户进行对话和提供反馈,机器人需要有语音合成的功能。

语音合成技术可以将文字转换为自然语言的语音输出,使得用户可以听到机器人的回答和指导。

5.设计用户界面和互动功能:为了提供良好的用户体验,需要设计一个易于使用且具有互动性的用户界面。

这可能包括语音控制、触摸屏幕或者按钮来与机器人进行操作和交互。

6.整合云服务和数据库:在机器人中加入云服务和数据库功能,可以使得机器人能够获取更多的语言学习资源和实时更新的信息。

例如,可以连接在线词典、语法库和文本语料库来增加机器人的语言学习知识。

7.测试和改进:在完成机器人的制作之后,需要进行测试以确保其性能和功能的稳定性。

可以邀请一些目标用户进行试用,并收集他们的反馈和建议来改进和优化机器人的表现。

8.持续改进和更新:语言教学是一个不断发展的领域,需要不断学习和更新。

因此,制作智能语言教学机器人后,需要持续关注语言学习的新动态,并根据用户的反馈和需求来进行改进和更新。

总结起来,制作智能语言教学机器人需要明确定义需求和目标,设计语言教学内容,开发语音识别和合成功能,设计用户界面和互动功能,整合云服务和数据库,测试和改进,并持续改进和更新。

小型智能机器人制作全攻略简介小型智能机器人是近年来备受关注的领域,它能够实现人机互动、自主导航、语音识别等功能,成为了现代科技的新宠儿。

本文将介绍如何制作一台小型智能机器人,供爱好者参考和实践。

所需材料在开始制作小型智能机器人之前,请确保准备了以下材料:1.Arduino主控板2.舵机3.超声波传感器4.电池5.杜邦线6.面包板7.轮子和底盘8.蓝牙模块(可选)步骤1. 硬件组装第一步是组装硬件部分。

按照以下步骤进行操作:1.将Arduino主控板固定在面包板上,确保稳固。

2.连接舵机和轮子,将它们装在底盘上,使机器人能够运动。

3.连接超声波传感器,并将其放置在机器人的前方,用于测量距离。

4.将电池连接到Arduino主控板,以供机器人供电。

5.如果需要,连接蓝牙模块,以便通过手机或电脑控制机器人。

2. 编程完成硬件组装后,开始编写机器人的控制程序。

使用Arduino IDE或其他集成开发环境进行编程:#include <Servo.h>Servo motor;void setup() {motor.attach(9);//连接舵机到引脚9//进行其他设置}void loop() {//在这里实现机器人的行为逻辑}以上是一个基本的Arduino程序框架,你可以根据需要添加更多功能。

例如,你可以使用超声波传感器来测量距离,根据不同的距离来控制机器人的移动方向;也可以使用蓝牙模块实现手机遥控机器人等。

3. 调试和优化编写完控制程序后,将程序上传到Arduino主控板,连接电池并启动机器人。

在使用过程中,你可能会遇到一些问题,如机器人行走不稳定、超声波测距不准确等。

这时需要进行调试和优化,具体方法有:•检查硬件连接是否正确,确保电路没有松动或短路。

•确保舵机的角度调整正确,以便控制机器人的转向。

•校准超声波传感器,确保测量距离的准确性。

•逐步调整程序中的参数和算法,以改进机器人的性能。

4. 扩展功能一旦你完成了基本的小型智能机器人制作,你可以继续扩展它的功能。

使用ChatGPT开发聊天室机器人的流程和关键技术指南聊天室机器人的流程和关键技术指南随着人工智能的快速发展,聊天室机器人作为其应用之一,正逐渐成为人们生活中不可或缺的一部分。

本文将为您介绍使用ChatGPT开发聊天室机器人的流程和关键技术指南。

一、机器人开发流程1. 定义机器人的目标和功能在开发聊天室机器人之前,首先需要明确机器人的目标和功能。

机器人可以是一个营销工具,帮助用户了解产品信息,也可以是一个娱乐伙伴,提供笑话、音乐等娱乐内容。

根据不同的目标和功能,机器人的设计和实现方式也会有所不同。

2. 收集数据并准备训练集要让聊天室机器人能够进行智能回复,需要大量的对话数据来进行训练。

因此,收集和准备训练集是非常重要的一步。

可以通过爬虫、API接口或人工收集对话数据,并对数据进行清洗和格式化处理。

3. 模型训练和调整选择适合的机器学习模型来训练聊天室机器人是关键的一步。

ChatGPT是一种基于Transformer的模型,可以用于生成自然语言文本。

将准备好的训练集输入到ChatGPT中进行训练,并根据实际需求进行模型调整和优化。

4. 部署和集成完成训练后,将训练好的模型部署到服务器上进行模型服务的搭建。

同时,为了方便用户与机器人交互,需要将机器人集成到聊天室平台或网站中,并将用户输入传递给机器人,并将机器人的回复返回给用户。

5. 监测和迭代一旦机器人开始使用,就需要进行监测和迭代。

监测机器人与用户的对话,收集用户的反馈和建议,并根据反馈优化机器人的回复,提升用户体验。

二、关键技术指南1. 数据预处理在准备训练集时,需要将对话数据进行预处理,包括去除冗余信息、过滤敏感内容和标点符号等操作。

此外,还需要对对话数据进行分词、去除停用词、词干化等操作,以便机器能够更好地理解和生成回复。

2. 模型训练优化在训练过程中,可以采用一些优化策略来提高模型性能。

例如,使用更大的训练集、调整模型的超参数、使用更复杂的模型架构等。

语音识别机器人制作编辑:robotain 来源:网络2009-12-06 发表评论方案简介说明书1 方案概述语音识别机器人可以充分发挥学生的创新能力,增加学生的动手实践能力,增加学生学习单片机的兴趣爱好。

本方案以SPCE061A 单片机为核心,改装市场上的玩具机器人,使改装后的机器人具有语音识别能力,根据识别的语音完成跳舞等动作,这也是智能机器人的一个方面。

1.1 设计要求利用SPCE061A 单片机、机器人机体(包括2 个用于走路的电机、1 个用于头部旋转的电机、1 个用于加速1 个用于弹射的电机等),要求语音识别机器人具有下述功能:1. 通过语音命令对其进行控制。

2. 两种跳舞模式。

3. 走步功能、转向功能、转头功能。

4. 发射飞盘功能。

1.2 技术要求1. 要求语音识别机器人可以识别15 条命令。

2. 要求语音识别机器人具有2 种跳舞模式。

2 方案设计简介2.1 硬件框图系统以SPCE061A 为核心,结合机器人机体,如下图所示。

2.2 功能框图SPCE061A 应用方案SPCE061A 在语音识别机器人中的应用在现代社会机器人这个词语已经不再新鲜,而且形形色色的机器人出现在我们的日常生活中。

为了提高广大单片机爱好者学习单片机的兴趣与爱好,凌阳科技大学计划教育推广中心推出了应用SPCE061A 控制的兴趣产品语音识别机器人,本文对语音识别机器人的软硬件制作进行介绍。

1 引言为了提高广大单片机爱好者学习单片机的兴趣,凌阳科技大学计划教育推广中心推出了应用SPCE061A 作为主控制器,外加电机驱动电路制作的语音识别机器人。

该机器人采用特定人语音识别对机器人进行控制,可以完成向前走、倒退、左转、右转、跳两首舞曲、向左瞄准、向右瞄准、发射、连续发射等功能。

该语音识别机器人可以大大提高在校学生学习单片机的兴趣。

2 设计要求2.1 设计要求利用SPCE061A 单片机、机器人机体(包括2 个用于走路的电机、1 个用于头部旋转的电机、1个用于加速1 个用于弹射的电机等),要求语音识别机器人具有下述功能:通过语音命令对其进行控制。

两种跳舞模式。

走步功能、转向功能、转头功能。

发射飞盘功能。

2.2 技术要求要求智能机器人可以识别15 条命令。

要求智能机器人具有2 种跳舞模式。

模组特性简介3.1 SPCE061A 特性简介SPCE061A 是凌阳科技研发生产的性价比很高的一款十六位单片机,使用它可以非常方便灵活的实现语音的录放系统,该芯片拥有8 路10 位精度的ADC,其中一路为音频转换通道,并且内置有自动增益电路。

这为实现语音录入提供了方便的硬件条件。

两路10 精度的DAC,只需要外接功放(SPY0030A)即可完成语音的播放。

另外凌阳十六位单片机具有易学易用的效率较高的一套指令系统和集成开发环境。

在此环境中,支持标准C 语言,可以实现C 语言与凌阳汇编语言的互相调用,并且,提供了语音录放的库函数,只要了解库函数的使用,就会很容易完成语音录放,这些都为软件开发提供了方便的条件:SPCE061A 片内还集成了一个ICE(在线仿真电路)接口,使得对该芯片的编程、仿真都变得非常方便,而ICE 接口不占用芯片上的硬件资源,结合凌阳科技提供的集成开发环境(unSP IDE)用户可以利用它对芯片进行真实的仿真;而程序的下载(烧写)也是通过该接口进行下载。

下图为SPCE061A 单片机的内部结构框图:3.2 芯片特性简介SPCE061A 性能简介:z 16 位u’nSP 微处理器z 工作电压(CPU)VDD 为3.0~3.6V,(I/O)VDDH 为3.0~5.5Vz CPU 时钟:0.32~49.152MHzz 内置2K 字SRAMz 内置32K 字FLASHz 可编程音频处理z 晶体振荡器z 系统处于备用状态下(时钟处于停止状态),耗电仅为2uA/3.6Vz 2 个16 位可编程定时器/计数器(可自动预置初始计数值)z 2 个10 位DAC(数/模转换)输出通道z 32 位通用可编程输入/输出通道z 14 个中断源可来自定时器A/B、时基、2 个外部时钟源输入和键唤醒z 具备触键唤醒的功能z 使用凌阳音频编码SACM_S480 可以播放压缩的语音资源z 锁相环PLL 振荡器提供系统时钟信号z 32768Hz 实时时钟z 7 通道10 位电压模/数转换器(ADC)和单通道声音模/数转换器z 声音模/数转换器输入通道内置麦克风放大器,并具有自动增益控制(AGC)功能z 具备串行设备接口z 具备低电压复位功能和低电压检测功能z 内置在线仿真电路接口z 具有WatchDog 功能3.3 SPCE061A 精简开发板SPCE061A 精简开发板(简称61 板),是以凌阳16 位单片机SPCE061A 为核心的精简开发-仿真-实验板,大小相当于一张扑克牌,是“凌阳科技大学计划”专为大学生、电子爱好者等进行电子实习、课程设计、毕业设计、电子制作及电子竞赛所设计的,也可作为单片机项目初期研发使用。

61 板除了具备单片机最小系统电路外,还包括有电源电路、音频电路(含MIC 输入部分和DAC 音频输出部分)、复位电路等,采用电池供电,方便学生随身携带!!!使学生在掌握软件的同时,熟悉单片机硬件的设计制作,锻炼学生的动手能力,也为单片机学习者和开发者创造了一个良好的学习条件和开发新产品的机会!61 板上有调试器接口(Probe 接口)以及下载线(EZ_Probe)接口,分别可接凌阳科技的在线调试器、简易下载线,配合unSP IDE,可方便地在板上实现程序的下载、在线仿真调试。

61 板上的主要功能模块如下:SPCE061A 单片机最小系统外围电路模块;电源输入模块;音频电路(包含MIC 输入、DAC 音频功放输出)模块;按键模块;I/O 端口接口模块;调试、下载接口模块;下图为61 板的实物图:3.4 机器人模组简介3.4.1 机器人驱动电路图机器人驱动电路图如所示:机器人驱动电路采用功率较大的三极管搭成H 桥来驱动电机,可以实现电机的正向旋转与电机的反向旋转。

这些电机包括2 个用于走路的电机与一个头部转向的电机。

另外用了一个三极管驱动单向旋转的电机,包括加速电机与发射电机,驱动电路比较简单。

3.4.2 主要功能通过语音命令对其进行控制;可以跳两首舞曲;走步功能、转向功能、转头功能;发射飞盘功能;3.4.3 机器人实物图3.4.4 注意事项机器人在发射飞盘时不要面向人,避免受伤机器人要轻拿轻放应该避免摔打在安装电池时注意正负极,否则容易烧坏机器人电机或主控制板4 系统总体方案介绍用61 板来控制机器人,使用了IOB7-IOB15 资源,另外使用了扬声器。

如图 4-1 所示:61 板与机器人连线图,如图 4-2 所示:系统主要由61 板与机器人驱动电路构成。

61 板作为整个系统的主控板,驱动电路驱动电机。

在主控板61 板的控制下完成各个动作。

另外增加了特定人语音识别的功能,通过命令来控制机器人,使机器人智能化。

5 系统的硬件设计5.1 SPCE061A 周边模块5.1.1 SPCE061A 最小系统SPCE061A 最小系统当中,包括SPCE061A 芯片外围的基本模块,有:晶振输入模块(OSC)、锁相环外围电路(PLL)、复位电路(RESET)、指示灯(LED)等,如下图所示。

本系统,有关SPCE061A 单片机的最小系统的各个模块都做在61 板当中,读者可以查阅61 板的电路原理图。

5.1.2 电源模块SPCE061A 的内核供电为3.3V,而I/O 端口可接3.3V 也可以接5V,所以在电源模块(61 板上)中有一个端口电平选择跳线,如图中的J5,下图为61 板上的电源模块图。

由于本系统需要的端口高电平为5V,所以图图 5-2 当中的J5 跳线需要跳到1 和2 上。

5.1.3 放音模块交通灯换向时有语音提示。

放音利用的是SPCE061A 内部的DAC,电路如图 5-3 所示。

图中的SPY0030是凌阳公司的产品。

和LM386 相比,SPY0030 还是比较有优势的,比如LM386 工作电压需在4V 以上,而SPY0030 仅需2.4V (两颗电池)即可工作;LM386 输出功率100mW 以下,SPY0030 约700mW。

其他特性请参考SPY0030 的数据手册。

5.1.4 机器人硬件驱动电路机器人硬件原理图如图 5-4 所示:机器人驱动电路采用功率较大的三极管搭成H 桥来驱动电机,可以实现电机的正向旋转与电机的反向旋转。

这些电机包括2 个用于走路的电机与一个头部转向的电机。

另外用了一个三极管驱动单向旋转的电机,包括加速电机与发射电机,驱动电路比较简单。

6 所用语音算法介绍6.1 语音识别算法简介6.1.1 语音识别概述:根据对说话人的依赖程度,分为:z 特定人语音识别(SD):只能辨认特定使用者的语音,训练->使用z 非特定人语音识别(SI):可辨认任何人的语音,无须训练根据对说话方式的要求,分为:z 孤立词识别:每次只能识别单个词汇z 连续语音识别:用者以正常语速说话,即可识别其中的语句6.1.2 语音识别原理语音识别原理参看下图:6.1.3 SPCE061A 实现语音识别的步骤SPCE061A 实现语音识别的步骤,分为训练部分与识别部分,以及在训练、识别过程中中断的情况,参考下图:6.1.4 语音识别API 介绍BSR_InitRecognizer(int AudioSource);初始化识别器BSR_Train(int WordID,int TrainMode);语音训练BSR_DeleteSDGroup(int SDGroupNo);清除内存BSR_PauseRecognizer()暂停识别,但不释放中断等资源BSR_ResumeRecognizer()恢复被暂停的识别BSR_GetRecognizerScore()获得识别结果的可信度,返回值从-4096 到4096,数值越大表示输入语音与特征模型的匹配度越高。

BSR_EnableCPUIndicator()开启CPU 状态监测功能。

开启该功能后,IOA0 和IOA1 将发出每16ms 电平变化一次的方波。

BSR_DisableCPUIndicator()关闭CPU 状态监测功能。

BSR_ExportSDWord(int CommandID)使用函数库时,会自动创建一个100 Word 的数组BSR_SDModel[100],可以把某条训练命令的特征模型数据导出到这个数组中。

BSR_ImportSDWord(int CommandID)可以把BSR_SDModel 数组中的数据导入为某条语音命的特征模型。

unsigned int BSR_SDModel[];配合BSR_ExportSDWord(int CommandID)与BSR_ImportSDWord(int CommandID)函数使用,此数组的作用相当于一个暂时的存储区。