Markov过程

- 格式:ppt

- 大小:695.00 KB

- 文档页数:32

马尔可夫决策过程简介马尔可夫决策过程(Markov Decision Process,MDP)是一种在人工智能和运筹学领域广泛应用的数学模型。

它可以描述一类随机决策问题,并提供了一种优化决策的框架。

在现实世界中,许多问题都可以被建模为马尔可夫决策过程,比如自动驾驶车辆的路径规划、机器人的行为控制和资源分配等。

1. 马尔可夫决策过程的基本概念在马尔可夫决策过程中,问题被建模为一个五元组(S, A, P, R, γ):- S 表示状态空间,包括所有可能的状态;- A 表示动作空间,包括所有可能的动作;- P 表示状态转移概率,描述了在某个状态下采取某个动作后转移到下一个状态的概率分布;- R 表示奖励函数,描述了在某个状态下采取某个动作后获得的即时奖励;- γ(gamma)表示折扣因子,用于平衡当前奖励和未来奖励的重要性。

2. 马尔可夫决策过程的模型马尔可夫决策过程的模型可以用有向图表示,其中节点表示状态,边表示从一个状态到另一个状态的动作,边上的权重表示状态转移概率和即时奖励。

通过对模型进行分析和计算,可以找到最优的决策策略,使得在长期累积奖励最大化的情况下,系统能够做出最优的决策。

3. 马尔可夫决策过程的求解方法对于小规模的马尔可夫决策过程,可以直接使用动态规划方法进行求解,比如值迭代和策略迭代。

值迭代是一种迭代算法,通过不断更新状态值函数来找到最优策略;策略迭代则是一种迭代算法,通过不断更新策略函数来找到最优策略。

这些方法可以保证最终收敛到最优解,但是计算复杂度较高。

对于大规模的马尔可夫决策过程,通常采用近似求解的方法,比如蒙特卡洛方法、时序差分学习方法和深度强化学习方法。

蒙特卡洛方法通过对大量样本进行采样和统计来估计状态值函数和策略函数;时序差分学习方法则是一种在线学习算法,通过不断更新估计值函数来逼近真实值函数;深度强化学习方法则是一种基于神经网络的方法,通过端到端的学习来直接从环境中学习最优策略。

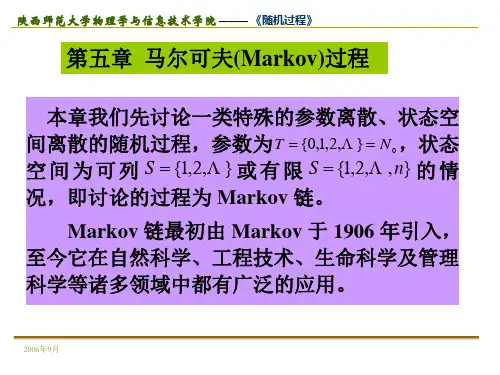

第四章 Markov 过程本章我们先讨论一类特殊的参数离散状态空间离散的随机过程,参数为0{0,1,2,}T N ==L ,状态空间为可列{1,2,}I =L 或有限{1,2,,}I n =L 的情况,即讨论的过程为Markov 链。

Markov 链最初由Markov 于1906年引入,至今它在自然科学、工程技术、生命科学及管理科学等诸多领域中都有广泛的应用。

之后我们将讨论另一类参数连续状态空间离散的随机过程,即纯不连续Markov 过程。

§4.1 Markov 链的定义与性质一、Markov 链的定义定义 4.1设随机序列{;0}n X n ≥的状态空间为I ,如果对0n N ∀∈,及0110011,,,,,{,,,}0n n n n i i i i I P X i X i X i +∈===>L L ,有:11001111{,,,}{}n n n n n n n n P X i X i X i X i P X i X i ++++=======L (4.1.0)则称{;0}n X n ≥为Markov 链。

注1:等式(4.1.0)刻画了Markov 链的特性,称此特性为Markov 性或无后效性,简称为马氏性。

Markov 链也称为马氏链。

定义4.2 设{;0}n X n ≥为马氏链,状态空间为I ,对于,i j I ∀∈,称1{}()ˆn n i j P X j X i p n +===为马氏链{;0}n X n ≥在n 时刻的一步转移概率。

注2:一步转移概率满足:()0,,()1,i j i jj Ip n i j Ipn i I ∈≥∈=∈∑若对于,i j I ∀∈,有1{}()ˆn n i j i j P X j X i p n p +===≡即上面式子的右边与时刻n 无关,则称此马氏链为齐次(或时齐的)马氏链。

设{}0()(0),p i P X i i I ==∈,如果对一切i I ∈都有00()0,()1i Ip i p i ∈≥=∑,称0()p i 为马氏链的初始分布。

马尔可夫过程收敛性判定准则构造马尔可夫过程(Markov process)是一类具有“无记忆性”的随机过程,其转移概率仅与当前状态有关,与之前的状态无关。

在实际应用中,我们常常关注马尔可夫链的收敛性质,即随着时间的推移,该过程是否趋于稳定。

本文将介绍马尔可夫过程收敛性判定的准则构造方法。

马尔可夫链(Markov chain)是马尔可夫过程的离散形式,在离散状态空间上进行转移。

为了判定马尔可夫链的收敛性,我们需要构造相关的准则。

下面将从马尔可夫链的不可约性、遍历性和正则性三个方面进行详细探讨。

一、不可约性(Irreducibility)马尔可夫链的不可约性是指状态空间中的任意两个状态都可以互相转换,即任意状态到达任意状态的转移概率大于0。

我们可以通过构建状态转移矩阵来判断马尔可夫链的不可约性。

如果状态转移矩阵是不可约的,则该马尔可夫链是不可约的。

二、遍历性(Aperiodicity)马尔可夫链的遍历性是指从任意状态出发,经过有限步骤后回到该状态的概率大于零。

遍历性与状态的周期有关,周期为1的状态是遍历的基本单位。

如果马尔可夫链中不存在周期大于1的状态,则该马尔可夫链是遍历的。

三、正则性(Regularity)马尔可夫链的正则性是指从任意状态出发,经过若干步骤后达到其他所有状态的概率大于零。

正则性与状态的连通性有关,连通性是指任意两个状态之间存在有限步骤的转移路径。

如果马尔可夫链是不可约的且存在一步骤可达到任意状态的状态,则该马尔可夫链是正则的。

根据上述准则,我们可以通过以下步骤来构造马尔可夫过程收敛性判定的准则:步骤一:构建状态转移矩阵根据问题的具体场景,我们确定马尔可夫过程的状态和状态转移概率,并将其表示为一个状态转移矩阵。

状态转移矩阵的元素表示从某一状态到达另一状态的概率。

步骤二:判断不可约性对状态转移矩阵进行分析,判断是否存在任意两个状态之间的转移概率都大于0。

如果存在,则该马尔可夫链是不可约的,否则需要重新构造状态转移矩阵。

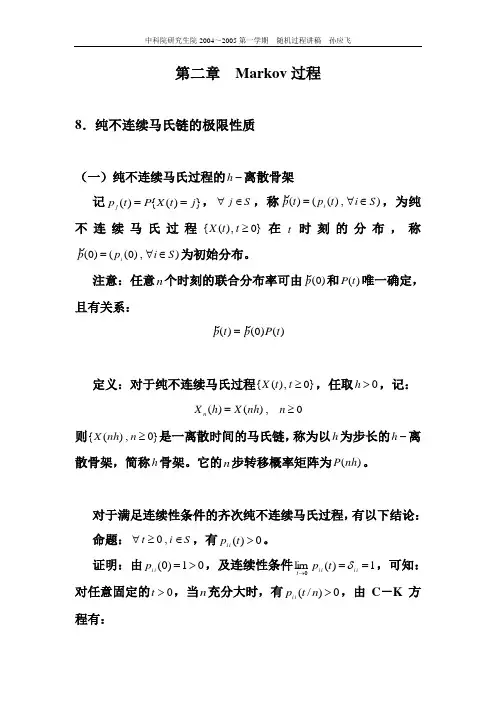

第二章 Markov 过程8.纯不连续马氏链的极限性质(一)纯不连续马氏过程的-h 离散骨架记})({)(j t X P t p j ==,S j ∈∀,称),)(()(S i t p t p i ∈∀=ρ,为纯不连续马氏过程}0,)({≥t t X 在t 时刻的分布,称),)0(()0(S i p p i ∈∀=ρ为初始分布。

注意:任意n 个时刻的联合分布率可由)0(p ρ和)(t P 唯一确定,且有关系:)()0()(t P p t p ρρ=定义:对于纯不连续马氏过程}0,)({≥t t X ,任取0>h ,记:0,)()(≥=n nh X h X n则}0,)({≥n nh X 是一离散时间的马氏链,称为以h 为步长的-h 离散骨架,简称h 骨架。

它的n 步转移概率矩阵为)(nh P 。

对于满足连续性条件的齐次纯不连续马氏过程,有以下结论: 命题:S i t ∈≥∀,0,有0)(>t p i i 。

证明:由01)0(>=i i p ,及连续性条件1)(lim 0==→i i i i t t p δ,可知: 对任意固定的0>t ,当n 充分大时,有0)/(>n t p i i ,由C -K 方程有:)()()()()(t p s p t p s p t s p i i i i Sk i k k i i i ≥=+∑∈因此可得:0)]/([)(>≥n i i i i n t p t p由此命题可知:对所有的0>h 及正整数n ,及S i ∈∀,有0)(>nh p i i ,这意味着对每一个离散骨架}0,)({≥n nh X ,每一个状态都是非周期的。

因此对于纯不连续的马氏过程,无需引入周期的概念。

定义:若存在0>t ,使得0)(>t p j i ,则称由状态i 可达状态j ,记为j i →;若对一切0>t ,有0)(=t p j i ,则称由状态i 不可达状态j ;若j i →且i j →,则称状态i 与j 相通,记作j i ↔。

marchc原理"马尔科夫过程"(Markov Process,也叫马尔可夫链)最初是由俄国数学家安德烈·马尔科夫(Andrey Markov)在1906年提出的一种概率模型。

直观地说,它用来描述随机过程中某个状态的变化规律,具体来说,就是某一时刻的状态只与它的上一个状态有关。

马尔科夫过程的核心是状态和状态转移概率。

我们可以用一个简单的例子来说明:假设某人要从A地到B地,他有三种选择:步行、骑自行车或者开车。

每种选择都有它的概率,而这个概率又受到很多影响因素,比如天气,交通状况等等。

我们可以将这个过程抽象成一个马尔科夫过程。

在这个例子中,人的状态就是他所在的位置,即可以在A地、B地、还是在路上。

每个状态都有一个概率来表示这个状态的出现频率,此外,状态之间还有相应的转移概率,即人从一个状态到另一个状态的概率。

比如,假设这个人开始在A地,步行和骑自行车的概率都是0.3,而开车的概率是0.4。

当他选择步行前往B地时,步行的概率为1,即100%。

但在路上,他可能会被大雨浇湿,或者遇到了交通堵塞,这又会影响到下一步的选择,比如他可能会转而选择骑自行车或开车。

马尔科夫过程的核心就在于这些概率的推导和计算,需要针对具体的场景进行建模,而这个过程又叫做“马尔科夫链的建模”。

马尔科夫链的建模可以应用于很多实际领域中,比如自然语言处理、机器学习、金融风险模型等等。

其中最为著名的例子就是Google公司的PageRank算法,这个算法就是基于马尔科夫链的思想实现的,用来衡量网页的重要性。

通过计算网页之间的链接关系和点击率等信息,可以建立网页之间的转移概率矩阵,然后通过迭代计算,得到每个网页的PageRank值,从而实现搜索引擎排名的计算。

总之,马尔科夫过程是一种非常有用的概率模型,可以用来描述许多随机过程中的状态变化规律,具有广泛的应用前景。

马尔可夫决策过程引论

马尔可夫决策过程(Markov Decision Process,MDP)是一种数学模型,用于描述具有随机性的决策问题。

它以俄国数学家Andrey Markov的名字命名,用于分析和解决序列决策问题,特别是在存在随机性和不完全信息的情况下。

MDP模型通常由以下要素组成:

1.状态(State):表示决策过程中系统可能处于的不同状态。

状态可以是离散的或连续的,根据具体问题的特点而定。

2.动作(Action):表示在每个状态下可选的行动或策略。

动

作也可以是离散的或连续的,取决于具体问题。

3.转移概率(Transition Probability):描述从一个状态转移到

下一个状态的概率分布。

转移概率表示了系统在不同状态

下采取不同动作后的状态转移情况。

4.即时奖励(Immediate Reward):表示在每个状态下采取特

定动作的即时奖励。

即时奖励是针对每个状态和动作组合

而给出的反馈,用于评估动作的优劣。

基于以上要素,马尔可夫决策过程定义了一个决策过程中的状态转移、奖励和决策策略。

根据这个模型,我们可以通过数学方法来求解最优的决策策略,即使在存在不确定性和随机性的情况下,也能达到最佳决策的目标。

MDP模型在多个领域中有广泛应用,例如人工智能领域的强化学习、运筹学中的最优化问题、金融市场中的投资决策等。

通

过应用MDP模型,我们可以通过建立状态、动作和奖励的关系,找到最优的决策策略,优化系统的性能和效益。

马尔可夫决策过程例子

马尔可夫决策过程(Markov Decision Process,MDP)是一种

数学框架,用于描述具有不确定性的决策问题。

以下是一个简单的马尔可夫决策过程的例子:

假设有一只机器人在一个迷宫中,它可以向上、向下、向左或向右移动。

每个移动的结果是随机的,有一定的概率会成功移动到目标位置,而有一定的概率也可能移动到相邻位置。

机器人初始时位于迷宫的起始位置,目标是尽快到达迷宫的出口位置。

在这个例子中,状态空间是所有可能的位置(包括迷宫内部和出口位置),动作空间是向上、向下、向左和向右移动的行为,奖励函数可以定义为到达出口位置时获得的奖励。

同时,还会考虑到在迷宫内移动过程中可能的碰撞和遇到墙壁的惩罚。

为了解决这个问题,我们可以使用马尔可夫决策过程来建立一个策略,该策略将根据当前状态选择一个最佳的动作以优化总体奖励。

通过迭代改进策略,最终可以找到一个最优策略,使得机器人可以在最短的时间内到达出口位置。

马尔可夫决策过程(MDP)提供了一种数学形式来描述包含

不确定性和随机性的决策问题,可以通过定义状态空间,动作空间,奖励函数和转移概率来描述问题,并通过策略优化算法来找到最优的策略。

这种方法在许多领域,如人工智能、强化学习和运筹学中被广泛应用。

马尔可夫决策过程公式马尔可夫决策过程(Markov Decision Process,简称 MDP)公式,听起来是不是有点让人头大?别担心,让我来给您好好说道说道。

咱先从一个简单的例子入手哈。

比如说,您正在玩一个游戏,每次您做出一个选择,比如向左走还是向右走,游戏的状态就会发生变化,而且这种变化还带有一定的随机性。

这就有点像马尔可夫决策过程啦。

在 MDP 中,有几个关键的概念。

首先是状态(State),这就好比游戏中的不同场景或者位置。

然后是动作(Action),就是您能做出的选择。

还有奖励(Reward),这是您做出某个动作后得到的反馈,可能是加分,也可能是减分。

那马尔可夫决策过程的公式到底是啥呢?简单来说,它就是用来计算在不同状态下,采取不同动作所能获得的长期期望奖励的。

比如说,您在一个迷宫里,有多个房间,每个房间就是一个状态。

您可以选择打开某个门进入另一个房间,这就是动作。

而进入新房间后可能会找到宝藏得到奖励,也可能会遇到怪物受到惩罚。

这个公式就像是一个魔法公式,能帮您算出怎么选择动作才能在长期来看获得最多的奖励。

还记得我之前有一次参加一个解谜活动,就有点类似马尔可夫决策过程。

那个活动是在一个大仓库里,里面布置了各种谜题和障碍。

我每走到一个区域,都要决定是先解谜题还是先跨越障碍,而每次的选择都会影响我最终能否顺利到达终点并获得奖励。

一开始,我盲目地选择,看到啥就干啥,结果走了不少弯路。

后来我冷静下来,仔细分析每个选择可能带来的后果,就有点像在运用马尔可夫决策过程的思路。

我会考虑当前所处的状态,可能采取的动作,以及预估能得到的奖励。

就像在一个状态下,面前有一道谜题和一个需要跨越的大坑。

解谜题可能会花费一些时间,但成功后能获得较多的分数;跨越大坑则相对简单,但得到的分数较少。

这时候,我就得用那个公式在心里默默计算一下,权衡利弊,做出最优的选择。

其实在我们的生活中,也经常会遇到类似的情况。

比如您在考虑是先学习数学还是先学习语文,或者是选择坐公交还是打车去上班。

概率论中的马尔可夫过程与随机游走马尔可夫过程(Markov process)和随机游走(random walk)是概率论中重要的概念与方法,它们在各个领域都有广泛的应用。

本文将介绍马尔可夫过程和随机游走的基本概念、特点以及在实际问题中的应用。

一、马尔可夫过程马尔可夫过程是指具有“无后效性”(即过去的状态对未来的发展没有直接影响)的随机过程。

它是以俄国数学家马尔可夫命名的,主要用于描述系统的演化。

1.1 基本概念在马尔可夫过程中,最基本的元素是状态和状态转移概率。

一个马尔可夫过程是由一系列离散状态组成的,例如{s1, s2, s3, ...}。

任意时刻,系统只处于其中的某个状态之一。

马尔可夫过程的演化具有“马尔可夫性”,即未来状态的转移只依赖于当前状态,与过去的状态无关。

这种性质由转移概率所决定。

设Pij表示在时刻t系统由状态Si转移到状态Sj的概率,则对于任意的i、j和k(i、j、k ∈状态集合),满足以下条件:P(Sk|Si, Sj, ..., Sk-1) = P(Sk|Sk-1) = Pij其中P(Sk|Sj, ..., Sk-1)表示给定Sj, ..., Sk-1的条件下Sk出现的概率。

1.2 马尔可夫链马尔可夫链是一类特殊的马尔可夫过程,它具有离散时间和离散状态的特点。

马尔可夫链的状态空间可以是有限的,也可以是可数无穷的。

对于一个马尔可夫链来说,其状态转移概率可以用状态转移矩阵来表示。

设P为状态转移矩阵,Pij表示在一步时间内系统由状态Si转移到状态Sj的概率,则P = (Pij)。

1.3 马尔可夫过程的应用马尔可夫过程在许多领域中有重要的应用。

其中,最典型的是马尔可夫链在统计学中的应用。

马尔可夫链模型可以用来描述、分析一些复杂系统的性质,例如人口模型、金融市场模型等。

此外,马尔可夫链还广泛应用于自然语言处理、机器学习和图像处理等领域。

通过对于系统的建模和分析,可以得到关于状态转移、概率分布等重要的信息。

吸收态markov过程

吸收态Markov过程是指在一些状态中存在吸收态,一旦进入其中一个吸收态,过程就无法再从该吸收态外的状态转移而来。

该过程具有如下特征:

1. 状态空间中存在吸收态。

2. 从非吸收态到达吸收态的概率为1。

3. 从吸收态到达其他状态的概率为0。

4. 过程在第一次到达吸收态时停止。

吸收态Markov过程可以用有限状态自动机或状态转移矩阵来表示。

其中,状态转移矩阵的形式为:

其中,P是状态转移矩阵,Q是非吸收态的子矩阵,R是非吸收态到吸收态的子矩阵,0是零矩阵,I是单位矩阵。

吸收态Markov过程在很多领域中都有应用,如生物学、通信网络、货物运输等。

在生物学中,它可以用来描述物种灭绝的过程;在通信网络中,它可以用来描述信号传输的过程;在货物运输中,它可以用来描述货物到达目的地的过程等。

吸收态Markov过程有许多重要的性质,如吸收态的期望时间、吸收态的概率分布等。

这些性质对于深入理解该过程的行为和应用非常有帮助。

- 1 -。