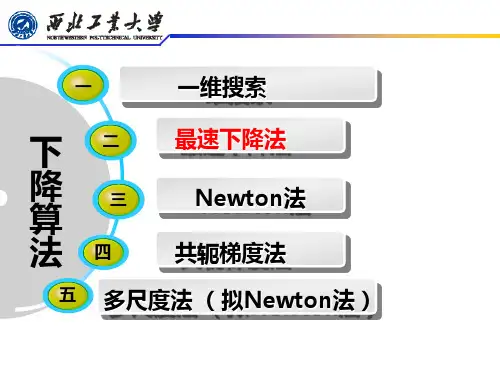

最优化搜索算法结构

- 格式:ppt

- 大小:1.77 MB

- 文档页数:31

最优化问题的算法迭代格式最优化问题的算法迭代格式最优化问题是指在一定的条件下,寻找使某个目标函数取得极值(最大值或最小值)的变量取值。

解决最优化问题的方法有很多种,其中较为常见的是迭代法。

本文将介绍几种常用的最优化问题迭代算法及其格式。

一、梯度下降法梯度下降法是一种基于负梯度方向进行搜索的迭代算法,它通过不断地沿着目标函数的负梯度方向进行搜索,逐步接近极值点。

该方法具有收敛速度快、易于实现等优点,在许多应用领域中被广泛使用。

1. 算法描述对于目标函数 $f(x)$,初始点 $x_0$ 和学习率 $\alpha$,梯度下降算法可以描述为以下步骤:- 计算当前点 $x_k$ 的梯度 $\nabla f(x_k)$;- 更新当前点 $x_k$ 为 $x_{k+1}=x_k-\alpha\nabla f(x_k)$;- 如果满足停止条件,则输出结果;否则返回第 1 步。

2. 算法特点- 沿着负梯度方向进行搜索,能够快速收敛;- 学习率的选择对算法效果有重要影响;- 可能会陷入局部极小值。

二、共轭梯度法共轭梯度法是一种基于线性方程组求解的迭代算法,它通过不断地搜索与当前搜索方向共轭的新搜索方向,并在该方向上进行一维搜索,逐步接近极值点。

该方法具有收敛速度快、内存占用少等优点,在大规模问题中被广泛使用。

1. 算法描述对于目标函数 $f(x)$,初始点 $x_0$ 和初始搜索方向 $d_0$,共轭梯度算法可以描述为以下步骤:- 计算当前点 $x_k$ 的梯度 $\nabla f(x_k)$;- 如果满足停止条件,则输出结果;否则进行下一步;- 计算当前搜索方向 $d_k$;- 在当前搜索方向上进行一维搜索,得到最优步长 $\alpha_k$;- 更新当前点为 $x_{k+1}=x_k+\alpha_k d_k$;- 计算新的搜索方向 $d_{k+1}$;- 返回第 2 步。

2. 算法特点- 搜索方向与前面所有搜索方向都正交,能够快速收敛;- 需要存储和计算大量中间变量,内存占用较大;- 可以用于非线性问题的求解。

基于随机程序优化的最优化搜索算法研究随机程序优化算法(Stochastic Optimization Algorithm,SOA)是指在概率论的基础上,通过一定的随机性生成搜索点,并利用产生的搜索点来解决最优化问题的一类求解算法。

基于此,结合最优化搜索的研究,本文将探究基于随机程序优化的最优化搜索算法。

一、概述最优化搜索算法是一种经典的求解最优化问题的方法。

而SOA则是建立在优化算法上的一种新型概率型寻优方法。

相比其他优化方法,其具有寻优速度快,局部最优解碳化概率低的优点,适用于许多传统方法无法解决的问题。

因此,基于SOA的最优化搜索算法被广泛应用于复杂多变的工程实践中。

二、基本原理SOA中随机性体现在搜索点的生成中,即搜索点的位置不是由优化算法决定的,而是通过随机过程生成的。

这样,搜索过程有其随机性,从而避免了落入局部最优解的风险。

SOA的基本思想是利用随机过程生成一批搜索点,然后根据一定的仿真和评价方法对这些点进行探测、筛选和改进,最终得到全局最优解。

通常,SOA算法依赖于种群,其搜索过程以种群作为单位进行进化。

每个个体都由一组参数表示,在每一次进化中,种群中的每一个个体根据一定的概率互相交叉、变异或选择,从而模拟自然界中生物进化过程。

在SOA中,通常使用适应度函数作为评价函数,以在搜索过程中对个体进行筛选和改进。

适应度函数评价每个搜索点的好坏程度。

通过这样的经过筛选后,留下更适合解决问题的点,并从中产生新的搜索点。

这样不断重复迭代,最终找到全局最优解。

三、常用算法在随机程序优化的最优化搜索算法中,遗传算法(GA)和模拟退火算法(SA)是两种应用广泛的方法。

1、遗传算法(GA)遗传算法是模拟生物进化规律,通过模拟交叉、变异等生物遗传学的基本操作,人工地将优秀个体的基因遗传到下一代中,并改变其中部分基因的目标函数值。

从而实现种群的进化性质,最终选取进化完成的个体,得到全局最优解。

2、模拟退火算法(SA)模拟退火算法是一种类似于物理退火过程的优化算法。

基于最优化方法的结构可靠度计算及matlab程序实现一、引言随着科技的飞速发展,现代化的工程、机械、技术装备等趋于复杂,对其结构可靠性提出了更高的要求。

结构可靠度分析是为了确保这些工程在设计、施工、管理、应用等环节能够安全、可靠地运行。

最优化方法作为一种求解问题的有效手段,在结构可靠度计算中得到了广泛的应用。

本文将探讨基于最优化方法的结构可靠度计算及MATLAB程序实现,以期为相关领域的研究和工程实践提供参考。

二、最优化方法的理论基础1.优化算法的选择在结构可靠度计算中,优化算法主要用于求解最优化问题。

常见的优化算法有梯度下降法、牛顿法、拟牛顿法、信赖域反射算法等。

针对结构可靠度计算的特点,本文选取一种适用于求解非线性规划问题的优化算法——梯度下降法。

2.适应度函数的构建适应度函数是衡量优化算法搜索过程中解的质量的重要依据。

在结构可靠度计算中,适应度函数应包含结构参数、载荷、材料性能等因素,以反映结构的可靠度水平。

构建适应度函数时,需考虑以下几个方面:(1)极限状态方程:根据结构设计要求,建立极限状态方程,用以描述结构在承受载荷时的应力、应变关系。

(2)失效概率:根据极限状态方程,计算结构在不同条件下失效的概率。

(3)可靠度指标:结合失效概率,构建结构可靠度指标,用于评价结构的可靠度水平。

三、结构可靠度计算的最优化方法1.极限状态方程的建立根据结构设计要求和相关规范,建立极限状态方程,用以描述结构在承受载荷时的应力、应变关系。

极限状态方程一般形式为:σ= F(x)其中,σ表示结构应力,x表示结构参数,F(x)为应力函数。

2.失效概率的计算根据极限状态方程,计算结构在不同条件下失效的概率。

失效概率可通过以下公式计算:P(σ > σ_0) = 1 / (1 + k)其中,P(σ > σ_0)表示失效概率,k为安全系数,σ_0为极限应力。

3.可靠度指标的求解结合失效概率,构建结构可靠度指标:β= ∫(1 / (1 + k)) dx其中,β为可靠度指标,积分范围为结构参数x的取值范围。

数学建模中的最优化算法数学建模是一项综合性强、难度较大的学科,涉及到数学和实际问题的结合。

在数学建模中,最常见的问题是优化问题,即在给定的约束条件下,求出最优解。

最优化算法是解决优化问题的重要手段,包括线性规划、非线性规划、动态规划等。

这些算法在不同的问题中有不同的应用,下面我们将分别介绍。

一、线性规划线性规划是一种数学工具,它可以在一系列线性约束条件下最大化或最小化具有线性关系的目标函数。

在数学建模中,线性规划被广泛应用于资源分配问题、制造流程优化等方面。

线性规划的求解方法主要有单纯形法、对偶理论、内点法等。

其中单纯形法是最常用的方法之一,它通过迭代搜索寻找最优解。

但是对于规模较大的问题,单纯形法的效率会降低,因此近年来对于线性规划的求解,研究者们也开始关注内点法这种算法。

内点法通过可行路径寻找最优解,因此在理论和实际的问题中都有广泛的应用。

二、非线性规划非线性规划主要是解决一些非线性问题,这种问题在实际问题中很常见。

与线性规划不同的是,非线性规划的目标函数往往是非线性的。

非线性规划的求解方法主要有牛顿法、梯度法、共轭梯度法等。

其中,牛顿法是一种迭代法,通过利用函数的一、二阶导数进行求解。

梯度法则是利用函数的一阶导数进行搜索最优解。

共轭梯度法是一种联合使用前两种方法的算法,比前两种算法更加高效。

三、动态规划动态规划是一个将一个问题分解为相互重叠的子问题的技巧,并将子问题的解决方法组合成原问题的解决方法。

动态规划的优势在于能够处理具有重叠子问题和最优子结构等性质的问题。

在数学建模中,动态规划通常被用来处理具有最优子结构的优化问题。

动态规划的求解方法主要有记忆化搜索、状态转移方程等。

其中,记忆化搜索是一种保存结果以便后续使用的技术。

状态转移方程则是一种寻找题目的最优子结构的方法,它通过减小问题规模寻找最优解。

总之,数学建模中的最优化算法是解决现实问题的有效手段。

通过学习和掌握这些算法,我们可以更加深入地理解和解决实际问题。

最优化算法(⽜顿、拟⽜顿、梯度下降)1、⽜顿法 ⽜顿法是⼀种在实数域和复数域上近似求解⽅程的⽅法。

⽅法使⽤函数f (x)的泰勒级数的前⾯⼏项来寻找⽅程f (x) = 0的根。

⽜顿法最⼤的特点就在于它的收敛速度很快。

具体步骤: ⾸先,选择⼀个接近函数f (x)零点的x0,计算相应的f (x0) 和切线斜率f ' (x0)(这⾥f ' 表⽰函数f 的导数)。

然后我们计算穿过点(x0, f (x0)) 并且斜率为f '(x0)的直线和x 轴的交点的x坐标,也就是求如下⽅程的解: 我们将新求得的点的x 坐标命名为x1,通常x1会⽐x0更接近⽅程f (x) = 0的解。

因此我们现在可以利⽤x1开始下⼀轮迭代。

迭代公式可化简为如下所⽰: 已经证明,如果f ' 是连续的,并且待求的零点x是孤⽴的,那么在零点x周围存在⼀个区域,只要初始值x0位于这个邻近区域内,那么⽜顿法必定收敛。

并且,如果f ' (x)不为0, 那么⽜顿法将具有平⽅收敛的性能. 粗略的说,这意味着每迭代⼀次,⽜顿法结果的有效数字将增加⼀倍。

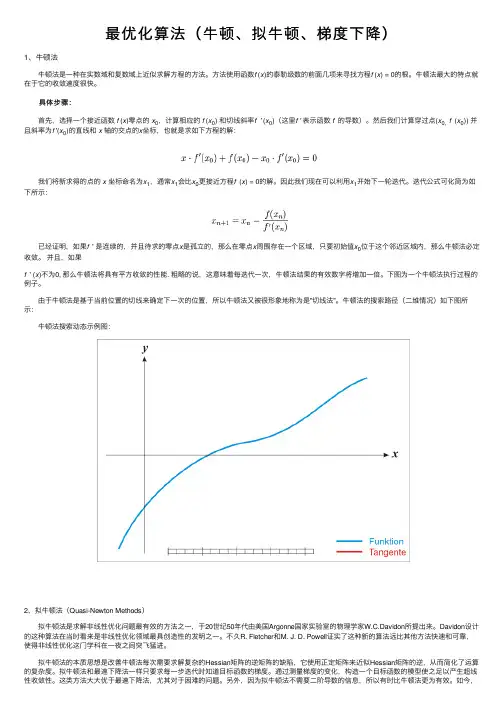

下图为⼀个⽜顿法执⾏过程的例⼦。

由于⽜顿法是基于当前位置的切线来确定下⼀次的位置,所以⽜顿法⼜被很形象地称为是"切线法"。

⽜顿法的搜索路径(⼆维情况)如下图所⽰: ⽜顿法搜索动态⽰例图:2、拟⽜顿法(Quasi-Newton Methods) 拟⽜顿法是求解⾮线性优化问题最有效的⽅法之⼀,于20世纪50年代由美国Argonne国家实验室的物理学家W.C.Davidon所提出来。

Davidon设计的这种算法在当时看来是⾮线性优化领域最具创造性的发明之⼀。

不久R. Fletcher和M. J. D. Powell证实了这种新的算法远⽐其他⽅法快速和可靠,使得⾮线性优化这门学科在⼀夜之间突飞猛进。

拟⽜顿法的本质思想是改善⽜顿法每次需要求解复杂的Hessian矩阵的逆矩阵的缺陷,它使⽤正定矩阵来近似Hessian矩阵的逆,从⽽简化了运算的复杂度。

最优化理论与算法一维搜索一维是最优化问题求解中常用的一种算法。

在一维中,我们需要在给定的区间内寻找函数的最小值或最大值。

一维算法的基本思想是通过不断的迭代,在区间内不断缩小最优解的范围,最终找到最优解。

常用的一维算法包括黄金分割法、斐波那契法、插值法等。

黄金分割法是一种较为简单且常用的一维算法。

该算法基于黄金分割点的性质,通过不断缩小区间来逼近最优解。

黄金分割法的具体步骤如下:1.初始化区间的上下界,确定迭代终止条件;2.计算黄金分割点的位置;3.根据黄金分割点分割区间;4.更新区间的上下界;5.判断是否满足迭代终止条件,如果满足,则输出最优解;如果不满足,则返回第2步。

斐波那契法是另一种常用的一维算法。

该算法通过斐波那契数列的性质,不断缩小区间来逼近最优解。

斐波那契法的具体步骤如下:1.初始化斐波那契数列,确定迭代终止条件;2.计算斐波那契点的位置;3.根据斐波那契点分割区间;4.更新区间的上下界;5.判断是否满足迭代终止条件,如果满足,则输出最优解;如果不满足,则返回第2步。

插值法是一种基于函数插值的一维算法。

该算法通过插值函数来拟合原函数,并通过求解插值函数的最小值或最大值来近似求解原函数的最小值或最大值。

插值法的具体步骤如下:1.初始化区间的上下界,确定迭代终止条件;2.根据插值函数拟合原函数,得到插值函数的表达式;3.求解插值函数的最小值或最大值;4.更新区间的上下界;5.判断是否满足迭代终止条件,如果满足,则输出最优解;如果不满足,则返回第2步。

除了上述算法,还存在其他一维算法,如割线法、牛顿法等。

这些算法各有特点,适用于不同类型的最优化问题。

一维算法的优势在于其计算简单、耗时少的特点。

然而,一维算法也存在一些缺点,例如容易陷入局部最优解、收敛速度较慢等。

因此,对于一些复杂的最优化问题,可能需要使用更高维度的算法进行求解。

总之,一维是最优化问题求解中常用的一种算法。

通过在给定的区间内不断迭代,可以逼近最优解。

最优化算法【线搜索-黄⾦分割(0.618)算法】使⽤条件优化函数在搜索区间内为单峰函数算法算法类似于⼆分查找算法,能够求单峰函数在搜索区间的极值算法如下:step0:确定单峰函数f(x)的搜索区间[a0,b0];容错误差δ=a−b, ϵ=f(b)−f(a) ,t=0.618;p=a0+(1−t)(b0−a0),q=a0+t(b0−a0) step1:f(p)<=f(q)yes,to step 2 no,to step 3step2:if |f(b)-f(a)| >= $\epsilon or |b-a|>=\delta$b=q,f(b)=f(q), q=p, f(q)=f(p);p=a+(1-t)(b-a), resolve f(p);elsestop;print p;\\p为求得极值点step3:if |f(b)-f(a)| >= $\epsilon or |b-a|>\delta$a=p,f(a)=f(p), p=q, f(p)=f(q);q=a+t(b-a), resolve f(q);elsestop;print q;\\p为求得极值点算法实现函数:function [R,loos,loos_t] = xiansousuo_golds(func,a,b,delta,epsilon,iterate) t = (sqrt(5)-1)/2;p = a+(1-t)*(b-a);q = a+t*(b-a);f_a=func(a);f_b=func(b);f_p = func(p);f_q = func(q);R=zeros(1,2);loos_t = zeros(iterate,1);loos = zeros(1,2);%step1k=0;while abs(f_b-f_a)>=epsilon || abs(b-a) >= delta || k < iteratek=k+1;loos_t(k,1)=abs(f_b-f_a);if f_p <= f_qb=q;f_b=f_q;q=p;f_q =f_p;p=a+(1-t)*(b-a);f_p = func(p);elsea=p;f_a=f_p;p=q;{f_p =f_q;q=a+t*(b-a);f_q=func(q);end%disp([p,abs(f_b-f_a)]);endif f_p <= f_qR(1,1)=p;R(1,2)=func(p);elseR(1,1)=q;R(1,2)=func(q);endloos=[abs(b-a),abs(f_b-f_a)];endmain函数clc;close all;iterate=30;func=@(s) s^2-sin(s);[R,loos,loos_t]=xiansousuo_golds(func,0,1,1e-4,1e-5,iterate);disp(R);disp(loos);figure(1);plot(1:iterate,loos_t);figure(2);t=linspace(0,1,iterate);y=zeros(iterate,1);for i =1:iteratey(i,1)=func(t(i));endplot(t,y);hold on;minimum = fminbnd(func,0,1);f_min=func(minimum);plot(minimum,f_min,'rp','MarkerSize',10);text(minimum,f_min,['(',num2str(minimum),',',num2str(f_min),')'],'color','b'); disp([minimum,f_min]);epsilon随迭代变化所求函数及极⼩值conclusion1. 算法求得结果和matlab极⼩值函数结果相同,精度较⾼;2. 对于应⽤范围有限制【单峰函数】。

第二章 一维搜索§2.1. 引言一、精确与非精确一维搜索如前所述,最优化算法的迭代格式为:1k k k k x x d α+=+因而算法的关键就是选择合适的搜索方向,然后再确定步长因子k α。

若设()()k k f x d ϕαα=+现在的问题是从k x 出发,沿k d 方向搜索,希望找到k α,使得()(0)k ϕαϕ<,这就是所谓的一维搜索或称为线搜索(line search )问题。

⑴ 若求得的k α,使目标函数沿方向k d 达到最小,即使得()min ()k k k k k f x d f x d ααα>+=+或 0()min ()k αϕαϕα>=,则称为最优一维搜索,或精确一维搜索。

相应的k α称为最优步长因子。

⑵ 如果选取k α,使目标函数获得可以接受的改善,即()()0k k k k f x f x d α-+>,则称之为近似一维搜索,或非精确一维搜索。

注:精确搜索与非精确搜索在最优化算法中均广泛应用,它们存在各自的优缺点。

二、一维搜索的基本框架一维搜索实际上是一元函数的极值问题,其基本的解决框架是: ⑴ 确定包含最优解的初始搜索区间;⑵ 采用某些区间分割技术或插值方法不断缩小搜索区间,最后得到解。

注:值得注意的是,这样得到的解大多数情况下均为近似解。

因此,即便采用精确一维搜索策略,只要应用了数值方法,最终得到的结果都不一定是真正数学意义上的最佳步长因子。

初始搜索区间的确定定义2.1 设:R R ϕ→,*[0,)α∈+∞是函数()ϕα的最小值点,即*()min ()αϕαϕα≥=。

若存在闭区间[,][0,)a b ⊂+∞,使 *[,]a b α∈,则称[,]a b 为一维极小化问题0min ()αϕα≥的搜索区间。

确定初始搜索区间的进退法基本思想:从一点出发,按一定步长探测,试图找到函数值呈高-低-高变化的三点。

具体地,从初始点0α出发,取初始步长为0h 。

最优化问题的算法迭代格式什么是最优化问题?最优化问题是指在给定约束条件下寻找某个目标函数取得最大值或最小值的问题。

这类问题在实际应用中非常广泛,例如在工程、经济学、物理学等领域中都会遇到最优化问题。

最优化问题的分类最优化问题可以根据目标函数和约束条件的性质进行分类。

根据目标函数的性质,最优化问题可以分为线性规划、非线性规划、整数规划等。

根据约束条件的性质,最优化问题可以分为等式约束问题和不等式约束问题。

传统的最优化问题求解方法在传统的最优化问题求解方法中,常用的方法有穷举法、梯度下降法、牛顿法等。

这些方法的共同点是需要迭代求解,通过不断迭代逼近最优解。

其中,穷举法是一种朴素的求解方法,通过枚举所有可能的解,并计算目标函数的取值来找到最优解。

然而,穷举法的计算复杂度通常很高,不适用于大规模的最优化问题。

迭代法求解最优化问题为了解决传统方法中计算复杂度高的问题,研究者们逐渐提出了一系列迭代算法来求解最优化问题。

迭代法通过不断更新解的估计值来逼近最优解。

迭代法的主要思想是从一个初始解开始,通过一定的迭代格式来计算下一个解的估计值,直到满足终止条件为止。

在迭代法中,需要确定三个要素:初始解、迭代格式和终止条件。

初始解的选择通常对最后的结果有一定的影响,较好的初始解可以加速算法的收敛速度。

迭代格式是指通过给定的规则来计算下一个解的估计值,不同的迭代格式适用于不同类型的最优化问题。

终止条件是指满足一定条件时终止迭代过程,通常可以选择解的变化不超过一定阈值,或者迭代次数达到一定的上限。

常见的最优化问题迭代算法1. 梯度下降法梯度下降法是一种常用的迭代算法,用于求解无约束的最优化问题。

梯度下降法的思想是通过沿着目标函数梯度的反方向移动,不断逼近最优解。

具体来说,梯度下降法通过以下迭代格式计算下一个解的估计值:x k+1=x k−α∇f(x k)其中,x k+1是下一个解的估计值,x k是当前解的估计值,α是步长,∇f(x k)是目标函数在x k处的梯度。

一阶最优化算法

一阶最优化算法是指仅利用一阶导数(或梯度)信息进行最优化求解的算法。

常见的一阶最优化算法包括:

1. 梯度下降法(Gradient Descent):依据负梯度方向逐步迭代搜索最小值点;

2. 随机梯度下降法(Stochastic Gradient Descent):每次从样本中选择一个样本进行梯度更新;

3. 批量梯度下降法(Batch Gradient Descent):利用全部样本计算梯度并进行更新;

4. 牛顿法(Newton's Method):利用泰勒展开式的前两项进行近似优化;

5. 共轭梯度法(Conjugate Gradient):在寻找最佳搜索方向时,避免梯度方向重复的问题;

6. 拟牛顿法(Quasi-Newton):利用近似的海森矩阵进行更新,避免重复计算海森矩阵;

以上一阶最优化算法的具体实现方式有所不同,各自的优缺点也不同,需要根据具体场景选择合适的算法。