三支决策与聚类大数据分析

- 格式:pptx

- 大小:1.06 MB

- 文档页数:26

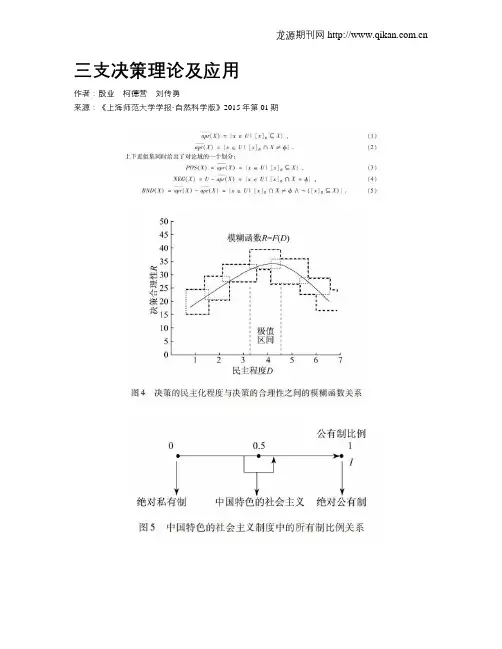

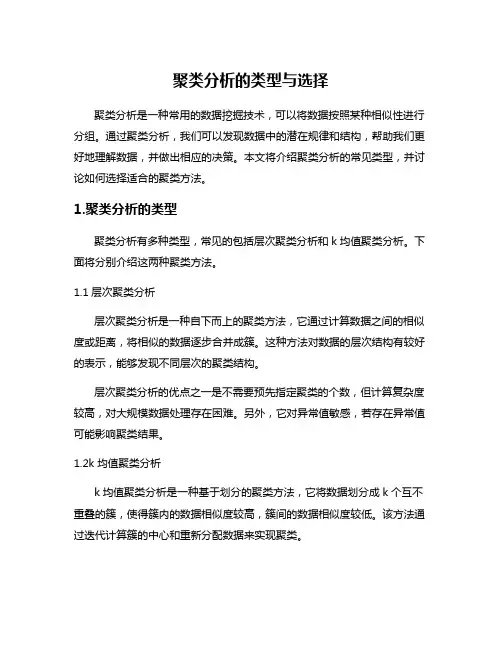

三支决策理论及应用作者:殷业柯德营刘传勇来源:《上海师范大学学报·自然科学版》2015年第01期摘要:三支决策理论自从2009年被提出后,已成为学术界的一个热门研究方向.马云的成功是三支决策中的一个典型案例.许多创业的年轻人视马云为榜样,所以能否从马云的成功案例中找到可复制的规律是非常值得研究的问题.对马云成功案例做了详细的分析,得出马云案例实际上是将传统二支决策转化为三支决策的过程.分析了马云案例的要素,对马云案例进行了数学建模,并举一反三,用三支决策分析了“货币的起源”和“中庸之道”决策思想,从中可以看到三支决策是人类处理不确定问题普遍采用的有效方法,也说明了系统研究三支决策理论及应用的重要性.关键词:三支决策;粗糙集理论;电子商务;马云;大数据;数学模型中图分类号: TP 181 文献标志码: A 文章编号: 1000-5137(2015)01-0095-100 引言三支决策作为一种方法早就被应用,但对这种方法的系统理论研究是最近十几年的事.加拿大里贾纳大学的姚一豫教授1989年提出了决策粗糙集理论[1],2009年又提出了三支决策理论[2],从而学术界开始了三支决策方法的系统理论研究[15-16].最常被列举的三支决策案例有两个:(1)论文的延迟录用;(2)医生的再诊断看病.二支决策对论文录用只取两种可能性,录用和不录用;三支决策则有三种可能性:录用、待定和不录用.三支决策的优点是可以减少决策的失误,使决策更合理.对于那些要求最终决策是二分的,三支决策通过信息的再收集,对待定部分进行进一步的决策,从而使最终的二支决策更合理.如:对待定论文的格式、语法等要求修改,修改后再做决策,可以使一些具有优秀思想的论文不被遗漏.三支决策在国内和国际上已有许多大学和研究机构在深入开展工作,在国内如:南京大学、西南交通大学、同济大学、闽南师范大学、上海师范大学等,国际上姚一豫教授所在的加拿大University of Regina是研究主力,2013年7月国内出版了《三支决策与粒计算》一书,全面地介绍了三支决策方面的国内外研究动向.“马云成功”案例是又一个三支决策典型案例,因为马云是许多创业年轻人的偶像,所以分析马云案例具有重要价值.本文作者对“马云成功”案例进行了分析和数学建模,并举一反三分析了“货币的起源”和“中庸之道”决策思想,从中可以看到三支决策是人类处理不确定性问题普遍采用的有效方法,也说明了系统研究三支决策理论及应用的重要性.1 集合论与三支决策理论Cantor集合边界为空,BND(X)=,Zadeh集合边界非空,BND(X)≠,这是两种集合的本质区别.模糊集理论和粗糙集理论给出了两种不同的对边界非空集合的刻画理论,模糊集理论对边界的刻画采用直接方法,粗糙集理论对边界的刻画采用间接方法,可以创造出无数种边界刻画方法和理论.人们已经有模糊粗糙集、粗糙模糊集、概率粗糙集、0.5概率粗糙集、随机集、区间集、云模型、II型模糊集、广义粗糙集、阴影集、灰度集等等理论,这些由概念的排列组合创造的新理论存在等价或部分等价性,显然需要理论的融合和归类.二支决策是指决策的结果只有两种可能性:肯定或否定,它们对应的逻辑真值为1或0.三支决策是指决策的结果有3种可能性:肯定、不确定、否定,对应的逻辑真值为1、(0,1)、0,其中的不确定部分又可看成是“不决策”或“延迟决策”部分,因为这部分中的对象最终是划入肯定或否定,需要进一步的决策信息.三支决策方法是人类处理不确定性问题时常用的代价较小的有效方法.三支决策理论的形成是从粗糙集理论、决策粗糙集理论、三支决策理论一路演化而来,下面分别说明各理论的主旨思想.1.1 粗糙集理论与决策粗糙集理论Rough set是波兰数学家Z.Pawlak 1982年提出的一种刻画边界非空集合的理论,和模糊集理论不同,它采用间接刻画边界的方法,用两个分明的上下近似集合,限定了边界的范围.这种方法的最大优点是:用分类思想粗粒度地对概念进行定义,从而具有更广泛的适用性.分类思想贯穿了粗糙集理论的全部,因为分类是人类认识外部世界的主要方法,所以粗糙集理论获得了广泛的应用.在信息系统S上定义粗糙集X,假设粗糙集X为目标概念,[x]R为U上含x的等价类,用等价类的并集作上下近似集去近似逼近粗糙集X,也同时定义了粗糙集X,令:其中(3)为正域,(4)为负域,(5)为边界域.粗糙集对三个区域并没有做语义上的定义,在实际应用中给予语义定义可以使粗糙集应用于具体的问题求解,这也是三支决策和粗糙集相互关联的原因.当从信息系统中获取知识时,立刻会碰到一个问题,对论域的划分的标准或方法是什么?粗糙集给出了分类思想,但并没有给出所有的分类方法,不同的分类方法对应获得知识的不同手段[12-13].Bayes决策论给出了基于概率分布的风险最小分类方法,将这种方法与粗糙集结合,就产生了决策粗糙集理论.若单类决策的代价矩阵如表1所示.1.2 三支决策理论关于三支决策理论存在这样两个问题:(1)三支决策和粗糙集的关系?(2)三支决策理论是怎样的一种理论?从姚一豫教授的文献看,三支决策思想来源于对粗糙集正域、负域、边界域语义解释的思考.所以三支决策理论应该是来源于对粗糙集理论的研究,但三支决策作为一种方法早已被人们使用过,只是在不自觉中,没有理论指导情况下使用.就三支决策和粗糙集的相关性而言,似乎两者没有必然的蕴涵关系,而更像是一种并列关系,也就是三支决策可以和任何与它相关的理论结合产生新思想.这样就产生了三支决策理论到底是怎样一种理论的问题?从众多实例可以看到,在1965年L.A.Zadeh博士提出fuzzy set之前,人类早就有了处理不确定性问题,除了概率方法外,三支决策方法是所有处理不确定性问题中代价较小的方法,所以从这个角度考虑,三支决策理论应该是一种处理不确定性问题的代价较小的有效数学方法.以上模型从评价函数应该遵循的代数序结构广义地定义了三支决策概念.三支决策理论和粗糙集理论最主要的不同是存在再决策机制,粗糙集理论由于对正域、负域和边界域没有赋予语义,所以也就不存在再决策问题,而三支决策赋予边界待定决策的语义,所以就存在对边界的进一步刻画问题.三支决策的再决策和粗糙集的属性约简有相同的作用,粗糙集的属性约简是在决策属性中对分类无效的属性的剔除,而三支决策首先选择最重要决策属性对论域进行粗分类,在获得边界域后,再选择属性对边界进行细分类,依此类推直到获得满意结果.三支决策的这种分类思想实际上就是粒计算由粗到细的分析方法,这种方法在一些具体问题中比直接的属性约简效率更高.2 马云成功的三支决策案例分析与建模传统交易是一手交钱一手交货,所以支付决策只需要二支的,即:支付或不支付.但电子商务存在空间和时间距离,不能实现一手交钱一手交货,这样就存在电子商务二支支付决策的风险问题:如果客户在网上订货后立刻支付,会面临商家不发货或发货不符合要求的风险;如果客户订货后不支付,风险留给了商家,商家也不发货,完成不了交易.所以二支支付决策不适合电子商务.马云正是看到了这一点,马云所做的是帮助客户实现了三支决策,即增加了“延迟支付”.这样有效地减少了客户的交易风险,也帮助商家实现了网上销售.马云做到这一点所使用的方法,就是通常所说的做老娘舅,客户订货后首先将货款打入支付宝,支付宝收到货款后通知商家发货,客户收到货物后检查确认,通知支付宝,支付宝再将货款打给商家,完成交易.马云还建立了客户损失的先赔付制度,先赔付可能会有损失,但不良商家毕竟是少数,从概率计算获得的信誉大于损失,这样就将客户交易风险降到了最低,实现了一个成功的商业模式.可能马云当时设计商业模式时,并没有意识到他所使用的是将支付二支决策改成三支决策,但他实际实现的就是提供“延迟支付服务”,让客户从传统的支付或不支付决策,变成支付、不支付、待定支付的三支决策.对待定支付通过交易过程中提供的更多信息,最后决定是否支付.当然如果客户和商家已有充分的信任,直接支付或不支付也可以,毕竟马云提供的服务是要收份子钱的.能否通过对马云案例的分析,给出一个数学模型,以便所有的人在他们所在的专业或行业进行马云案例的复制,这是一个非常值得研究的问题.首先这是一个决策问题,在生活和工作中人人都要做决策.马云成功案例是将一个古老的二支决策,因为交易环境的改变,由原来的当面交易变成网络交易,而不再适用改成了三支决策.当二支决策改成三支决策后会多出许多工作,马云将其变成“服务”,当然提供服务不是无偿的,从中就形成了新的商业模式.如果考虑更复杂的情况,如:大数据中的数据挖掘,将原来的二支决策分类改成三支决策分类,并由计算机自动完成,这时就需要建立适当的数学模型.马云案例中的相关要素是:(1)存在一个传统的二支决策,最终决策也要求是二分的;(2)由于决策的条件、环境改变或需要决策最优化,原二支决策不再适用或非最优;(3)将二支决策改为三支决策,其中的待定部分需要进一步的信息,以便进行再决策,获得这些信息需要新方法或新服务,从中得到创新思想或创新商业模式;(4)如果一层三支决策不满足要求可进行多层三支决策,直到满足需要的最终二支决策精度.根据上述要素可给出马云案例的一个数学模型.其中U为对象论域,任何决策都存在决策的客观主体,在马云案例中为已订购的货物,论文录用案例中是投稿论文,看病诊断案例中是就诊者;A为对象的所有属性集合,人类认识事物总是通过属性进行的,如认识一个人总是通过他的相貌、性格、习惯等属性去认识,原则上说对象的属性是无限多的,在实际问题中只取用到的属性;D为决策属性,是决策中用到的所有属性,包括条件属性和它们组合决定的属性.具体的决策,总是可以等价为根据某些属性对对象归属类的划分,如马云案例中,对已定货物的交易属性进行划分,付款或不付款.对对象集刻画的精度取决于独立属性集的势,一般来说要提高分类精度就必须将更多的属性作为决策属性,即DD′;I为决策属性的映射量化值集,在马云案例中,可为交易的风险.(2)在信息系统S上存在一个传统的二支决策问题,如马云案例中的支付决策,即:3 基于三支决策的商业模式设计运用上述模型复制马云案例的商业模式设计.取3个不太相关的名词:体育官员、商业模式、三支决策.设想体育官员是某奥运主办国的组委会主席,或国际泳联主席,他或她想设计一个商业模式帮助体育赛事成功,毕竟谁都不想做赔本的买卖,方法是运用上述模型复制马云成功案例.步骤1:找一个传统的二支决策.体育比赛中有许多项目是通过打分来决定胜负的,如:花样游泳、跳水比赛、体操比赛等.裁判员给运动员A、B打分,分高者胜出,这可以看成是一个二支决策,即:{winner|A>B,loser|A步骤2:决策优化.这是寻找新商业模式的动因.裁判给出相同的分数,说明裁判无法判断A、B的胜负,这相当于三支决策中的待定决策.如果要对待定的情况进一步做出判决,就需要新的信息,马云的成功实际上就是在新信息上做了文章,那么对体育比赛的相同分,能否也可在获得新信息上产生新的商业模式呢?步骤3:运用三支决策.要对裁判打出的相同分作出进一步的决策,新信息已不能再从裁判那里来,有一个好的来源:观众,观众是体育比赛的组成部分,没有观众就没有体育比赛.观众来看体育比赛,尤其是打分类比赛,是来欣赏美的,观众也有权利对比赛做出自己的评判.所以可以在每位观众座位上安装一个打分器,当出现相同分数时,规定由观众打出的观赏分的高低决定运动员的胜负.这里对三支决策中边界域的再决策,使用的新属性量化值集是观众的打分I′={观众打分},根据观众打分完成决策.这样做的代价:增加了打分设备.但现在的无线或有线打分设备非常普通和实用,从经济和技术上不存在什么问题.这样做的好处:(1)提高了观众的参与积极性;(2)提高门票收入;(3)给了裁判员更多的选择余地;(4)使比赛更合理,更精彩.代价和收益相比,收益远远大于代价,所以是一个可能的成功商业模式.4 货币的起源与三支决策运用马云案例来分析货币的起源及本质.商品交换的最初形式是易货交换,即:等价货物与等价货物的直接交换.例如1匹马换10头羊、1头猪换3头羊、1匹布换5个陶罐等等.但原始人类在产品交换时会碰到一个问题,当他有多余产品时却可能暂时没有他所需要的产品可交换,这时就产生了货币的需求,即:公认的等价交换物,比如羊,贵金属金、银等.首先与等价物交换,延迟易货交易,如果发现有人有他所需要的货物时,再用等价物去交换.原始货币是“公认的等价交换物”,起到的作用是延迟易货交易.从三支决策的角度看,就是将交易决策由原来的:易货交易和不易货交易的二支决策,改变成:易货交易、不易货交易、延迟易货交易的三支决策.实现延迟易货交易的方法就是使用货币,这样货币就产生了.开始货币是有真实价值的等价物,如金银,但货币的作用就是证明产品价值的凭证,既然仅仅是一种凭证,凭证本身的价值就不重要了,这样纸币就产生了.因为纸币本身没有价值,所以需要有一定的信用作为担保,如商号信用,国家信用等.网络时代的到来使货币又一次改变它的形态:存储器中的数字符号,产生了电子货币.一个亿万富翁可能一无所有,有的只是银行存储器中的1串数字,占有的空间肉眼都看不清.因此从三支决策角度看,货币的本质是延迟商品交换的等价符号,有了这样的认识,就很容易理解大量的货币的货币的本质,如:股票、期货,货币衍生品等等.作为应用来考虑债务链的问题.商品交易中经常会出现债务,所谓债务链(如图1所示)就是A欠B一百万,B欠C一百万,C欠D一百万…,有时债务链会很长,但无论债务链有多长,只要债务链是封闭的,就可以在所有相关债务方同意的情况下,一次性销账,因为货币是符号,所以仅对符号的操作可以以最小的代价解决实际问题.但往往由于信息的不畅通,相关债务方并不知道存在封闭债务链,这样就可以产生一种新服务,依靠国家信誉,进行债务链的智能检索,一旦发现存在封闭债务链,就可以通知相关债务方,如获授权,就可以及时销账,使经营正常.通常情况下,债务链是不封闭,经济危机就是由于债务链的断裂,导致企业的连锁倒闭,员工失业产生的.显然债务链智能检索系统,可以预测经济运行状态,预防经济危机的发生.5 中庸之道与三支决策中庸之道是中国传统儒家思想的精髓之一,中庸之道本质上也是一种三支决策,但和上述马云案例略有不同.马云案例中三支决策是中间过渡态,要求最终结果是二支决策,而中庸之道将三支决策中的中间部分,即边界作为最终的输出.世界充满矛盾,所以在对象的决策属性中充满相互对立的矛盾属性,如:[好,坏],[美,丑],[肯定,否定],[民主,独裁],[喜欢,不喜欢]等.将矛盾的两个对立面作为决策属性分类,可得到二支决策.如:将人分成好人和坏人,将画分成美和丑,将学生分成好学生和坏学生.中庸之道认为,世界上不存在绝对的事物,任何事物都可能同时存在矛盾对立面的两个方面,而不是只据其一,所以在做决策时,正确的方法是根据客观事实取中间部分作为决策结果,这就是中庸之道,又称中庸决策.中庸之道是一个纯社会科学理念,从来没有定量化研究过,这里我们首先给出中庸之道的一种定量数学描述方法.中庸之道决策思想可以用图2表示.其中0,1表示矛盾的两个对立面,中间区间(α,β)表示中庸决策区间,如果决策信息足够完整,则中庸决策区间可缩小为一点I0,该点即为最优决策点;在信息不够充分的情况下,中庸决策区间宽度不为0,表明决策具有一定的不确定性,但不可能是两个极端点.I为属性变量,用属性程度表示,定义:对中庸决策区间(α,β)的估值可根据具体情况由数据统计计算得到,例如:对历史人物的评价,可以列出这个人物从生到死参与的所有重要事件ei,并按重要性排列{e1,e2,…,eN},重要性程度权重为wi∈[0,1],i=1,2,…,N.历史学家可以根据个人的判断对他所做事的好坏度进行评分ei∈[0,1],i=1,2,…,N,根据评分和事件的重要性程度权重,用加权统计公式(17)可计算出已知事件的好坏决策点:这样就可以对这个历史人物有一个数量上的相对客观的认识,如取(α,β)中的点I0得:3-7开或4-6开,前数表示不好的评价,后数表示好的评价.注意以前对历史人物的评价都是通过历史学家的脑袋主观进行的,现在可以用计算机进行一些辅助的工作了(如将历史人物做过的所有重要的事用计算机检索罗列出来,进行估值统计),这样可使评判更客观,这也是所讨论方法的意义.一个人只能是既有优点也有缺点,人与人之间的不同在于统计出的中庸评判区间不同,有人好事做得多一点,有人坏事做得多一点.图3是对历史人物评判的中庸决策图:中庸决策的关键是定位三支决策的边界区域,可以使用各种方法,上面介绍了加权统计法,另外还有如:模糊集的α截集逼近计算方法,粗糙集的上下近似集逼近方法等.下面举两个运用中庸三支决策的例子:例1:决策的民主化程度D与决策的合理性R之间的关系?如果要做一个决策,是发扬民主好还是独裁好?这个问题中的矛盾对立面是[绝对民主,绝对独裁].首先考虑二支决策是否是最优的,也就是要么绝对民主,要么绝对独裁,显然二支决策对获得最合理的决策不是最优的.绝对独裁不是最优的例子很多,一个人的知识是有限的,世界上不存在一个对什么都能做出正确决策的人,所以发扬民主对合理决策是必要的;绝对民主也不是最优的,因为决策有时效性,民主决策是需要花时间的,如果在有效时效内决策不能完成,那么这个决策就是无效的.例如:打仗时一架飞机飞来,看不清是敌机还是友机,如果用绝对民主的方法来决策导弹打还是不打,那么也许敌机发起攻击时还没有完成决策,所以打仗时一般由长官来判断,而不是发扬民主.通常情况下,决策的合理性和决策的民主化程度之间存在一定的模糊函数关系R=F(D),其中D和R均为模糊数,这个函数关系由决策的环境和条件决定,并存在一个中间极值区间,这个区间对应的决策民主化程度就是最合理的,如图4所示.例2:经济制度是绝对公有制好还是绝对私有制好?这个问题关系到一个国家全体人民的福祉,所以是非常重要的.公有制和私有制的选择历史上争论不休,甚至到今天也没有结论.这里用中庸三支决策的方法来分析这个问题.该问题中的矛盾对立面是[绝对私有制,绝对公有制],首先来看看历史和现实中存在过的经济制度.美国是绝对私有制吗?不是,美国的原子弹也是公有的,如果原子弹也私有化那世界就离毁灭不远了.苏联是绝对公有制吗?也不是,至少个人的衣物是私有的.所以到目前为止,世界上存在的经济制度都不是绝对的公有制或绝对的私有制.这样就产生了一个经济制度中公有制成份和私有制成份比例为多少时是最优的问题?这个比例只能取决于当时国家的经济发展水平、生产力水平、人民的文明程度、自然资源情况等一系列主客观因素,这些因素决定了怎样的公有制成份比例是最优的.邓小平对中国的最大贡献就是他让中国选择了走中国特色的社会主义道路,也就是混合经济的道路.图5说明了中国特色的社会主义制度中的所有制的比例关系.中国改革开放的成功使许多国家都希望向中国学习,也就是所谓的北京共识或北京模式,但如果从中庸之道看,北京共识的精髓恰恰是“不要照搬任何固有模式”,每个国家都有自己的条件和环境,只有根据自己的条件和环境决定自己的路才是最优的选择,这才是中国经验.运用中庸之道做决策的例子很多,从以上例子可以看到,中华文明中的精髓不但过去有用,今天也有用,只是需要赋予新的内涵、新的解释.6 总结电子商务中马云的成功案例,货币的起源和本质,儒家哲学思想中的“中庸之道”这3个原本风马牛不相及的事却在三支决策中联系了起来,它们都是将同一种方法运用到不同方面得到的结果.从这里可以清楚地看到,三支决策方法是人类处理不确定性问题时经常采用的有效方法,研究三支决策理论及应用具有重要的意义.人类以往运用三支决策是不自觉的自发式的,一旦有了三支决策理论的指导就可以自觉地使用它,为人类创造出更多的合理的商业模式和人工智能方法.参考文献:[1] YAO Y Y,WONG S K M,Lingras P A.A decision theoretic rough set model:Proceedings of the 5th International Symposium on Methodologies for Intelligent Systems[C].New York:North-Holland,1990.[2] YAO Y Y.Three-way decision:An interpretation of rules in rough set theory:Proceedings of the 4th International Conference on Rough Sets and Knowledge Technology[C].Berlin-Verlag:Springer,2009.。

聚类分析的类型与选择聚类分析是一种常用的数据挖掘技术,可以将数据按照某种相似性进行分组。

通过聚类分析,我们可以发现数据中的潜在规律和结构,帮助我们更好地理解数据,并做出相应的决策。

本文将介绍聚类分析的常见类型,并讨论如何选择适合的聚类方法。

1.聚类分析的类型聚类分析有多种类型,常见的包括层次聚类分析和k均值聚类分析。

下面将分别介绍这两种聚类方法。

1.1层次聚类分析层次聚类分析是一种自下而上的聚类方法,它通过计算数据之间的相似度或距离,将相似的数据逐步合并成簇。

这种方法对数据的层次结构有较好的表示,能够发现不同层次的聚类结构。

层次聚类分析的优点之一是不需要预先指定聚类的个数,但计算复杂度较高,对大规模数据处理存在困难。

另外,它对异常值敏感,若存在异常值可能影响聚类结果。

1.2k均值聚类分析k均值聚类分析是一种基于划分的聚类方法,它将数据划分成k个互不重叠的簇,使得簇内的数据相似度较高,簇间的数据相似度较低。

该方法通过迭代计算簇的中心和重新分配数据来实现聚类。

k均值聚类分析的优点在于计算简单、效果较好,适用于大规模数据集。

但该方法对初始簇中心的选择较为敏感,容易收敛于局部最优解。

2.选择合适的聚类方法在选择聚类方法时,应根据数据的特点和目标进行判断。

下面列举几个常见的选择因素,供参考:2.1数据特点需要考虑数据的特点,如数据的维度、规模、密度等。

对于高维度数据,层次聚类分析可能更适用;而对于大规模数据,k均值聚类分析常常更为合适。

2.2聚类目标需要考虑聚类的目标。

如果希望发现层次结构、发现数据的内在关联性,层次聚类分析是一个不错的选择。

而如果目标是将数据划分成互不重叠的簇,并且希望聚类结果能较好地解释数据的差异性,k均值聚类分析更为合适。

2.3数据质量数据质量也是选择聚类方法的重要因素。

层次聚类分析对异常值比较敏感,如果数据中存在异常值,使用k均值聚类分析可能更好。

选择合适的聚类方法需要综合考虑数据特点、聚类目标和数据质量等因素。

如何利用大数据分析进行决策大数据分析是近年来非常热门的话题,它可以帮助企业在决策过程中更好地了解客户和市场,发现商机和问题。

那么,如何利用大数据分析进行决策呢?一、数据收集和清洗收集数据是大数据分析的第一步。

针对企业的特定目标和需求,可以从多个数据源中收集数据,包括网站分析工具、社交媒体、客户关系管理系统等。

此外,还可以从第三方数据提供商处购买数据,如市场调研公司、数据交易平台等。

但需要注意的是,不同来源的数据可能格式迥异,需要经过清洗和转换,确保准确性和数据统一性,提高分析的有效性。

二、数据挖掘和分析拥有大量的数据,但没有任何分析带来的收益。

大数据分析的重要性在于挖掘数据中的信息和知识。

这一步需要使用数据挖掘技术,包括聚类分析、分类分析、关联规则挖掘等等。

通过对数据的分析和挖掘,可以发现隐藏在数据背后的规律和趋势,为决策提供有力的支撑。

三、可视化和报告数据挖掘出来的知识需要以可视化和易懂的方式呈现,即数据报告。

此步需要根据所挖掘处理的数据,使用可视化技术呈现分析结论。

常见的数据报告形式包括统计图表、热力图等。

当然,这里也要根据实际情况选择合适的工具,例如Power BI、Tableau等大数据可视化工具。

四、决策落地经过前面三步的分析,我们已经得出了很多有价值的结论和信息。

但对于企业来说,真正有价值是这些分析带来的决策。

大数据分析需要在这一步得到落地和实施。

此步应非常实用、可操作,以决策表和操作指南的形式,将分析结论贴切地运用到企业决策之中。

综上,大数据分析是对企业管理的一种手段。

借助于大数据分析,企业可以更好地了解市场环境、了解客户需求、发现潜在问题和机遇。

在分析之前,需要明确企业的目标并根据目标制定策略。

企业还需要建立有效的数据采集和分析机制,人员需要拥有统计学、计算机等相关专业知识。

最终的目的是为了将数据分析所得的结论和行动同步,使企业获得最佳运营效益。

常见的9种大数据分析方法在当今数据驱动的时代,大数据分析已经成为企业和组织决策的重要组成部分。

通过对大量数据的处理和分析,企业可以获得有价值的见解,以便更好地了解市场趋势、客户需求和业务运营等方面。

本文将介绍九种常见的大数据分析方法。

1. 描述性统计分析描述性统计分析是最基本、最常见的数据分析方法之一。

它通过整理和描述数据的特征和概括,揭示数据的总体情况。

通过描述性统计分析,我们可以了解数据的集中趋势(例如平均值、中位数)和离散程度(例如标准差、方差),对数据的基本特征有一个全面的认识。

2. 相关性分析相关性分析用于确定两个或多个变量之间的关系。

通过计算相关系数(如皮尔逊相关系数),我们可以了解变量之间的线性相关性强弱。

相关性分析可以帮助我们确定哪些变量之间存在密切的关联,从而指导决策。

3. 群组分析群组分析是一种将数据分为不同群组或类别的方法,以便发现数据内在的结构和相似性。

通过群组分析,我们可以发现潜在的市场细分、客户群体或产品类别,以便为定制化营销和个性化服务做准备。

4. 预测分析预测分析是通过利用过去的数据和模式来预测未来趋势和结果的方法。

它使用统计和机器学习算法来构建预测模型,以便对未来事件进行预测。

预测分析可以帮助企业准确地预测销售量、客户需求和库存需求等,为未来的决策提供指导。

5. 时间序列分析时间序列分析是研究时间相关数据的一种方法。

它通过分析时间序列的趋势、周期性和季节性等特征,揭示数据随时间的变化规律。

时间序列分析可以帮助我们预测未来的时间趋势、了解季节性销售波动和制定基于时间的策略。

6. 文本挖掘文本挖掘是从大量的文本数据中挖掘和提取有用信息的过程。

通过文本挖掘,我们可以自动分析和理解大量的文本数据,发现其中隐藏的模式和关系。

用于情感分析、舆情监测和内容推荐等方面。

7. 决策树分析决策树分析是一种用于分类和预测的机器学习方法。

它通过构建一棵树型结构,根据不同的特征属性对数据进行划分,最终得出决策结果。

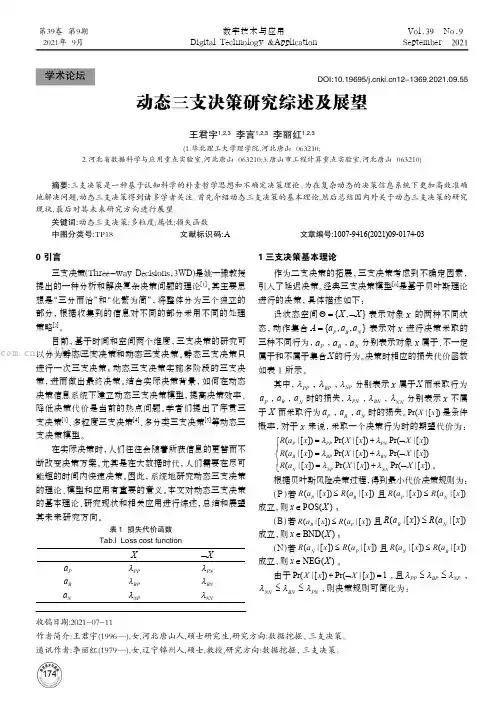

1740 引言三支决策(Three-way Decisions,3WD)是姚一豫教授提出的一种分析和解决复杂决策问题的理论[1]。

其主要思想是“三分而治”和“化繁为简”,将整体分为三个独立的部分,根据收集到的信息对不同的部分采用不同的处理策略[2]。

目前,基于时间和空间两个维度,三支决策的研究可以分为静态三支决策和动态三支决策。

静态三支决策只进行一次三支决策;动态三支决策实施多阶段的三支决策,进而做出最终决策。

结合实际决策背景,如何在动态决策信息系统下建立动态三支决策模型,提高决策效率、降低决策代价是当前的热点问题。

学者们提出了序贯三支决策[3]、多粒度三支决策[4]、多分类三支决策[5]等动态三支决策模型。

在实际决策时,人们往往会随着所获信息的更替而不断改变决策方案。

尤其是在大数据时代,人们需要在尽可能短的时间内快速决策。

因此,系统地研究动态三支决策的理论、模型和应用有重要的意义。

本文对动态三支决策的基本理论、研究现状和相关应用进行综述,总结和展望其未来研究方向。

1 三支决策基本理论作为二支决策的拓展,三支决策考虑到不确定因素,引入了延迟决策。

经典三支决策模型[6]是基于贝叶斯理论进行的决策,具体描述如下:设状态空间{,}X X Θ=⌝表示对象 x 的两种不同状态,动作集合{,,}P B N A a a a =表示对 x 进行决策采取的三种不同行为,P a ,B a ,N a 分别表示对象 x 属于、不一定属于和不属于集合X 的行为。

决策时相应的损失代价函数如表1所示。

其中,PP λ,BP λ,NP λ分别表示 x 属于X 而采取行为P a ,B a ,N a 时的损失,PN λ,BN λ,NN λ分别表示 x 不属于 X 而采取行为P a ,B a ,N a 时的损失。

Pr(|[])X x 是条件概率,对于 x 来说,采取一个决策行为时的期望代价为:(|[])Pr(|[])Pr(|[])(|[])Pr(|[])Pr(|[])(|[])Pr(|[])Pr(|[])P PP PN B BP BN N NP NN R a x X x X x R a x X x X x R a x X x X x λλλλλλ=+⌝⎧⎪=+⌝⎨⎪=+⌝⎩。

聚类分析算法在工业大数据分析中的应用研究随着工业化进程的不断推进,工业生产中产生的数据规模也越来越大。

如何从这些数据中挖掘出有价值的信息,成为了现代工业领域需要解决的一个重要问题。

聚类分析算法是其中一种经典的数据挖掘手段,具有较为广泛的应用前景。

本文将探讨聚类分析算法在工业大数据分析中的应用研究。

一、聚类分析算法简介聚类分析算法是指依据一定的距离度量或相似度,将数据点分组的一种方法。

其目的是将相似的数据点划分到同一组中,不相似的数据点则划分到不同组中。

聚类分析主要分为层次聚类和非层次聚类两种类型。

(1) 层次聚类:层次聚类是将数据点以一定的层次结构进行分组。

其优点是易于理解和解释,缺点是对于大规模数据计算量较大。

(2) 非层次聚类:非层次聚类又称为划分式聚类。

其基本思想是将数据点划分到不同的类别中,每个类别代表着一类数据点。

该算法常采用K-means算法,其计算快,但需要合理选择聚类簇的个数。

二、聚类分析算法在工业大数据分析中的应用能否找到一种有效的数据挖掘方法,对于工业生产的管理和运营至关重要。

聚类分析算法可应用在各种类型的工业大数据中。

其具体应用范围包括但不限于以下几个领域。

(1) 工业生产重点领域的数据分析钢铁、煤炭、电力等工业生产的数据规模十分庞大。

据此通过聚类分析算法,可将工业生产中的数据进行分类分析,达到对工业生产中多个方面进行深入分析的目的。

如通过对消耗能源的类型和数量聚类,可以合理统计出能源使用的情况;通过对物料的种类进行聚类,可以分辨出不同的物料使用情况;通过对重要操作的数据分析,可以判断出操作是否正常。

聚类分析算法应用在工业生产领域的数据分析中,不仅有助于诊断和预测可能的生产问题,更能在改进生产方法及提高资源利用率等方面发挥重要作用。

(2) 工业大数据的分类与预测工业大数据的分类与预测是聚类分析算法的两个重要应用。

数据可以通过聚类分析的方法进行分组,以便进行深入分析,从而预测未来可能出现的相关情况。

聚类分析数据聚类分析是一种数据挖掘技术,用于将一组数据分成不同的组或者类别,使得同一类别内的数据相似度较高,不同类别间的数据相似度较低。

聚类分析可以匡助我们发现数据中的隐藏模式和结构,从而更好地理解数据和做出决策。

在进行聚类分析之前,我们需要明确以下几个步骤:1. 数据采集:首先,我们需要采集相应的数据。

数据可以来自于各种渠道,如数据库、文件、传感器等。

采集到的数据应该能够反映我们所关注的问题或者目标。

2. 数据预处理:在进行聚类分析之前,我们需要对数据进行预处理,以确保数据的质量和可用性。

预处理包括数据清洗、数据变换和数据规范化等步骤。

数据清洗可以去除异常值和缺失值,数据变换可以将数据转换为适合聚类分析的形式,数据规范化可以将数据缩放到相同的范围内。

3. 特征选择:在进行聚类分析之前,我们需要选择合适的特征或者变量。

特征选择可以匡助我们减少数据维度,提高聚类分析的效果。

选择合适的特征需要考虑特征的相关性、重要性和可解释性等因素。

4. 聚类算法选择:选择合适的聚类算法是进行聚类分析的关键步骤。

常用的聚类算法包括K均值聚类、层次聚类和密度聚类等。

不同的聚类算法适合于不同的数据类型和问题场景。

我们可以根据数据的特点和需求选择合适的聚类算法。

5. 聚类分析:在选择了合适的聚类算法之后,我们可以开始进行聚类分析。

聚类分析的目标是将数据分成不同的组或者类别,使得同一类别内的数据相似度较高,不同类别间的数据相似度较低。

聚类分析可以通过计算样本之间的距离或者相似度来实现。

聚类分析的结果可以通过可视化或者统计指标来展示。

6. 结果解释和应用:最后,我们需要对聚类分析的结果进行解释和应用。

我们可以通过可视化、统计分析和模型评估等方法来解释聚类分析的结果。

聚类分析的结果可以匡助我们发现数据中的隐藏模式和结构,从而更好地理解数据和做出决策。

总结起来,聚类分析是一种数据挖掘技术,用于将一组数据分成不同的组或者类别。

在进行聚类分析之前,我们需要进行数据采集、数据预处理、特征选择、聚类算法选择、聚类分析和结果解释和应用等步骤。

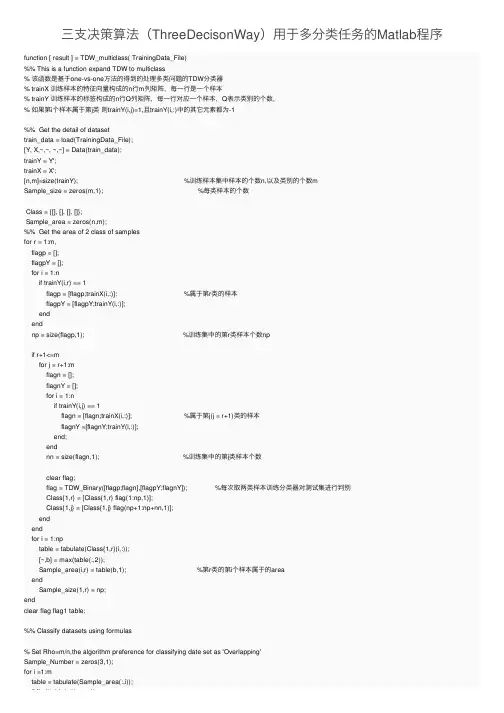

三⽀决策算法(ThreeDecisonWay)⽤于多分类任务的Matlab程序function [ result ] = TDW_multiclass( TrainingData_File)%% This is a function expand TDW to multiclass% 该函数是基于one-vs-one⽅法的得到的处理多类问题的TDW分类器% trainX 训练样本的特征向量构成的n⾏m列矩阵,每⼀⾏是⼀个样本% trainY 训练样本的标签构成的n⾏Q列矩阵,每⼀⾏对应⼀个样本,Q表⽰类别的个数,% 如果第i个样本属于第j类则trainY(i,j)=1,且trainY(i,:)中的其它元素都为-1%% Get the detail of datasettrain_data = load(TrainingData_File);[Y, X,~,~, ~,~] = Data(train_data);trainY = Y';trainX = X';[n,m]=size(trainY); %训练样本集中样本的个数n,以及类别的个数mSample_size = zeros(m,1); %每类样本的个数Class = {[], [], [], []};Sample_area = zeros(n,m);%% Get the area of 2 class of samplesfor r = 1:m,flagp = [];flagpY = [];for i = 1:nif trainY(i,r) == 1flagp = [flagp;trainX(i,:)]; %属于第r类的样本flagpY = [flagpY;trainY(i,:)];endendnp = size(flagp,1); %训练集中的第r类样本个数npif r+1<=mfor j = r+1:mflagn = [];flagnY = [];for i = 1:nif trainY(i,j) == 1flagn = [flagn;trainX(i,:)]; %属于第j(j = r+1)类的样本flagnY =[flagnY;trainY(i,:)];end;endnn = size(flagn,1); %训练集中的第j类样本个数clear flag;flag = TDW_Binary([flagp;flagn],[flagpY;flagnY]); %每次取两类样本训练分类器对测试集进⾏判别Class{1,r} = [Class{1,r} flag(1:np,1)];Class{1,j} = [Class{1,j} flag(np+1:np+nn,1)];endendfor i = 1:nptable = tabulate(Class{1,r}(i,:));[~,b] = max(table(:,2));Sample_area(i,r) = table(b,1); %第r类的第i个样本属于的areaendSample_size(1,r) = np;endclear flag flag1 table;%% Classify datasets using formulas% Set Rho=m/n,the algorithm preference for classifying date set as 'Overlapping'Sample_Number = zeros(3,1);for i =1:mtable = tabulate(Sample_area(:,i));if find(table(:,1) == -1)if find(table(:,1) == -1)a = find(table(:,1) == -1);Sample_Number(1,1) = Sample_Number(1,1) + table(a,2); %第⼀⾏为各类样本负域的个数,第⼆⾏为正域的个数,第三⾏为边界域的个数 endif find(table(:,1) == 1)a = find(table(:,1) == 1);Sample_Number(2,1) = Sample_Number(2,1) + table(a,2);endif find(table(:,1) == 2)a = find(table(:,1) == 2);Sample_Number(3,1) = Sample_Number(3,1) + table(a,2);endendRho = m/n; %设定分界参数 For now,how to determine the partermeter is the main problemRatio_NP = Sample_Number(1,1)/n; %负域样本⽐例Ratio_BN = Sample_Number(3,1)/Sample_Number(1,1); %边界域样本与负域样本⽐值Ratio_BP = Sample_Number(3,1)/n; %边界域样本⽐例Sample_Number(3,1)if Ratio_NP > Rho && Ratio_BN < 1result = ['Outlier'];elseif Ratio_BP > 10*Rho && Ratio_BN > 1result = ['Overlapping'];elseresult = ['Inter|Intar'];enddisp(['DatasetCategory=',result]);endfunction [DatasetCategory] = TDW_Func(TrainingData_File)%% ***This function aim to classify dataset(binary only)*** %%%% Set dataset and initialization% TrainingData_File=['adult.csv'];train_data = load(TrainingData_File);[train_target, P,NumberofData,NumberofInputNeurons, ~,~] = Data(train_data);n=0;k=0;%% Distance between each sample and the rest of the sampleDistance=zeros(NumberofData-1,NumberofData);for i=1:1:NumberofDatafor j=1:1:NumberofDatasum=0;if i>jfor k=1:NumberofInputNeuronssum=sum+power((P(k,i)-P(k,j)),2);Distance(j,i)=sqrt(sum);endelseif i<jfor k=1:NumberofInputNeuronssum=sum+power((P(k,i)-P(k,j)),2);Distance(j-1,i)=sqrt(sum);endendendend% size(Distance)% Distance1= Distance;% Distance(Distance==0)=[];% size(Distance)% Distance=reshape(Distance,NumberofData-1,NumberofData); %The i-th column is the distance% %of the i-1th sample and the remaining i-1 samples%% Determining the value of neighborhood%Distance_sorted=zeros(NumberofData-1,NumberofData);w=0.1; %Range(0,1),it the key to determining the number of neigborhood samplesw=0.1; %Range(0,1),it the key to determining the number of neigborhood samplesfor i=1:NumberofDataDistance_c=Distance(:,i);table=tabulate(Distance_c);[n,m]=size(table);Distance_sorted(1:n,i)=table(:,1); %Arrange thr distance from large to smallendDelata=zeros(1,NumberofData); %For every sample has a Delatafor i=1:NumberofDataDelata(1,i)=min(Distance_sorted(:,i))+w*(max(Distance_sorted(:,i))-min(Distance_sorted(:,i))); end%% Get the sample belongs to the neighborhoodDistance_neig=zeros(NumberofData-1,NumberofData,2);for i=1:NumberofDatak=1;for j=1:NumberofData-1if Distance(j,i)<Delata(1,i)Distance_neig(k,i,1)=Distance(j,i);if j<iDistance_neig(k,i,2)=train_target(1,j);elseDistance_neig(k,i,2)=train_target(1,j+1);endk=k+1;endendend%% Determining which area the sample isalph=5;beta=-5/6; %Partition parameterNumberofPos=0;NumberofBnd=0;NumberofNeg=0; %Initialize the number of different area samplefx=zeros(NumberofData,1);table=tabulate(train_target(1,:));if table(1,2)<table(2,2); %Find which class is majoritylable=-1;elselable=1;endfor i=1:NumberofDataN1=0; %Initialize the number of minorityN0=0; %Initialize the number of majorityfor j=1:NumberofDataif Distance_neig(j,i,2)==lableN1=N1+1; %Number of minorityelseif Distance_neig(j,i,2)==-lableN0=N0+1; %Number of majorityelseif Distance_neig(j,i,2)==0break;endendif train_target(1,i)==1fx(i)=(N1-N0)/(N0+1);elseif train_target(1,i)==-1fx(i)=(N0-N1)/(N1+1);endif fx(i)>alphNumberofPos=NumberofPos+1;PosData(1,NumberofPos)=train_target(1,i);PosData(2:NumberofInputNeurons+1,NumberofPos)=P(:,i);elseif fx(i)<=alph && fx(i)>=betaNumberofBnd=NumberofBnd+1;NumberofBnd=NumberofBnd+1;BndData(1,NumberofBnd)=train_target(1,i);BndData(2:NumberofInputNeurons+1,NumberofBnd)=P(:,i);elseif fx(i)<betaNumberofNeg=NumberofNeg+1;NegData(1,NumberofNeg)=train_target(1,i);NegData(2:NumberofInputNeurons+1,NumberofNeg)=P(:,i);endendif NumberofNeg<0.1*NumberofData && NumberofPos>0.7*NumberofDataDatasetCategory=['Inter_calss'];elseif NumberofNeg>0.1*NumberofData && NumberofBnd<0.2*NumberofDataDatasetCategory=['Outlier'];elseif NumberofBnd>0.3*NumberofData && NumberofNeg<0.1*NumberofDataDatasetCategory=['Overlapping'];elseDatasetCategory=['Intraclass'];enddisp(['NumberofPos=',num2str(NumberofPos)]);disp(['NumberofBnd=',num2str(NumberofBnd)]);disp(['NumberofNeg=',num2str(NumberofNeg)]);disp(['DatasetCategory=',DatasetCategory]);end20200811补上鸽了很久很久的TDW_Binary( X,Y )代码function [ result ] = TDW_Binary( X,Y )%% This function is aim to get the Negative,Boundary and Postive sample of a dataset%% intilizitionglobal K;a = find(Y(1,:) == 1); %标签标识的训练⽬标,需将其数值化(1,-1)为⾏向量train_target = Y(:,a)';P = X';[NumberofInputNeurons,NumberofData] = size(P);PBN = zeros(NumberofData,1);n=0;k=0;%% Distance between each sample and the rest of the sampleDistance=zeros(NumberofData-1,NumberofData);for i=1:1:NumberofDatafor j=1:1:NumberofDatasum=0;if i>jfor k=1:NumberofInputNeuronssum=sum+power((P(k,i)-P(k,j)),2);Distance(j,i)=sqrt(sum);endelseif i<jfor k=1:NumberofInputNeuronssum=sum+power((P(k,i)-P(k,j)),2);Distance(j-1,i)=sqrt(sum);endendendend%% Determining the value of neighborhood%Distance_sorted=zeros(NumberofData-1,NumberofData);w=0.05; %Range(0.01,0.05),it's the key to determining the number of neigborhood samples for i=1:NumberofDataDistance_c=Distance(:,i);table=tabulate(Distance_c);[n,m]=size(table);Distance_sorted(1:n,i)=table(:,1); %Arrange the distance from large to smallendDelata=zeros(1,NumberofData); %For every sample has a Delatafor i=1:NumberofDataDelata(1,i)=min(Distance_sorted(:,i))+w*(max(Distance_sorted(:,i))-min(Distance_sorted(:,i)));end%% Get the sample belongs to the neighborhoodDistance_neig=zeros(NumberofData-1,NumberofData,2);for i=1:NumberofDatak=1;for j=1:NumberofData-1if Distance(j,i)<Delata(1,i)Distance_neig(k,i,1)=Distance(j,i);if j<iDistance_neig(k,i,2)=train_target(1,j);elseDistance_neig(k,i,2)=train_target(1,j+1);endk=k+1;endendend%% Use KNN to get the K nearest samplek = 15; %if use KNN,the k is a key partemeterIDX = knnsearch(P',P', 'K', k, 'Distance', 'euclidean'); %返回每个样本的K近邻样本,每⾏代表每个样本的K近邻样本的索引值%% Determining which area the sample isalph=K; % 正域与边界域的阈值beta=-K/(K+1); % Partition parameterNumberofPos=0;NumberofBnd=0;NumberofNeg=0; % Initialize the number of different area samplefx=zeros(NumberofData,1);table=tabulate(train_target(1,:));if table(1,2)<table(2,2); % Find which class is minjoritylable=table(1,1);elselable=table(2,1);endfor i=1:NumberofDataN1=0; %Initialize the number of minorityN0=0; %Initialize the number of majority%% Use My_methord to count the neighborhood sample categorier for each samplefor j=1:NumberofDataif Distance_neig(j,i,2)==lableN1=N1+1; %Number of minorityelseif Distance_neig(j,i,2)==-lableN0=N0+1; %Number of majorityelseif Distance_neig(j,i,2)==0break;endend%% Use KNN to count the neighborhood sample categorier for each sample% ind = find(IDX(i,:) ~= i);% indmax = find(train_target(1,IDX(i,ind)) == -lable);% N0 = length(indmax);% indmin = find(train_target(1,IDX(i,ind)) == lable);% N1 = length(indmin);if train_target(1,i)==lablefx(i)=(N1-N0)/(N0+1);elseif train_target(1,i)==-lablefx(i)=(N0-N1)/(N1+1);endif fx(i)>=alph %正域判断NumberofPos=NumberofPos+1;PosData(1,NumberofPos)=train_target(1,i);PosData(2:NumberofInputNeurons+1,NumberofPos)=P(:,i);PBN(i,1) = 1;elseif fx(i)<alph && fx(i)>beta %边界域判断 NumberofBnd=NumberofBnd+1;BndData(1,NumberofBnd)=train_target(1,i);BndData(2:NumberofInputNeurons+1,NumberofBnd)=P(:,i);PBN(i,1) = 2;elseif fx(i)<=beta %负域判断NumberofNeg=NumberofNeg+1;NegData(1,NumberofNeg)=train_target(1,i);NegData(2:NumberofInputNeurons+1,NumberofNeg)=P(:,i);PBN(i,1) = -1;endendresult = PBN;end。

聚类算法在大规模数据分析中的应用随着信息技术的不断发展,数据的规模和数量呈指数级增长,各类应用场景所需的数据也越来越丰富。

分析大规模数据的能力逐渐成为企业和组织面临的一个重要挑战。

与此同时,机器学习和数据挖掘领域的发展为海量数据分析提供了新的思路和方法。

其中,聚类算法是一种常用的数据分析方法,其可将具有相似特征的对象归为一类。

在大规模数据分析领域,聚类算法可运用于许多场景,例如在社交媒体中通过用户属性和行为数据发现群体,或是通过电商平台顾客订单数据分析用户消费行为等。

一、聚类算法的基本原理聚类是一类无监督学习技术,其通过将数据集中的数据按照特定的规则或者距离度量方式分成不同的类别。

聚类算法通常依据数据对象的相似度或距离度量,将真实世界事物映射到一些相邻的区域内。

常用的聚类算法有k-means、DBSCAN、层次聚类等等。

其中,k-means算法细粒度聚类的应用较为广泛。

k-means算法的基本思想是:首先在数据集中随机选择k个中心点,然后将数据集中的每个数据点归属于和它距离最近的中心点。

对于所有归属于同一中心点的数据点,将其计算出来同属于一个簇。

之后,重新计算每个簇的质心,这个过程会不断循环,直到簇的质心不再变化或达到预设的最大迭代次数。

二、聚类算法的应用场景2.1.电商平台的用户行为分析在电商平台中,数据分析是提高用户购物体验、实现量身定制化的关键。

而聚类算法通过分析顾客订单数据,将用户划分为不同的类群,可发现不同的用户群体之间的特征和差异。

例如,通过数据分析可以发现一个用户购买同一款商品的次数和购买周期,从而预测该用户未来可能会购买的商品,以提高营销效果。

2.2.社交媒体的用户群体分析社交媒体平台上的用户量庞大,用户行为复杂。

而通过聚类算法,可以划分出用户的群体,提供给运营者或广告商进行定向广告投放。

例如,微博可以通过用户的性别、年龄、地域等特征,将用户分为不同的用户群体。

特定的粉丝基础会对特定产品产生逐渐累积的效应,而通过聚类算法也可以锁定更精准、更有价值的用户群体。

大数据分析师如何进行数据分析的聚类分析聚类分析是大数据分析师常用的一种数据分析方法,用于将一组数据划分为多个不同的簇(Cluster)。

每个簇内的数据点具有相似的特征,而不同簇之间的数据点有着较大的差异。

本文将介绍大数据分析师如何进行数据分析的聚类分析的步骤和方法。

一、数据预处理在进行聚类分析之前,大数据分析师首先需要对数据进行预处理。

数据预处理包括数据清洗、缺失值处理、异常值处理等步骤。

通过数据预处理,可以消除数据中的噪音和不完整性,提高聚类分析的准确性。

二、选择合适的聚类算法在进行聚类分析时,大数据分析师需要选择合适的聚类算法。

常用的聚类算法包括K均值聚类、层次聚类、DBSCAN等。

每种聚类算法都有其适用的场景和特点,选择合适的聚类算法可以提高聚类分析的结果准确性。

三、确定聚类数目在进行聚类分析之前,大数据分析师需要确定聚类的数目。

聚类数目的确定可以根据实际问题的需求和数据的特点进行评估。

常用的聚类数目确定方法包括手肘法、轮廓系数等。

四、设置合适的距离度量聚类分析需要对数据点之间的相似度进行度量,常用的距离度量方法包括欧氏距离、曼哈顿距离、余弦相似度等。

选择合适的距离度量方法可以更准确地刻画数据点之间的差异。

五、进行聚类分析在确定了聚类数目、选择了合适的聚类算法和距离度量方法后,大数据分析师可以开始进行聚类分析。

聚类分析的过程中,需要根据选择的聚类算法进行数据点的分组,并计算每个簇的中心。

六、评估聚类分析结果在完成聚类分析后,大数据分析师需要对聚类结果进行评估。

常用的评估指标包括轮廓系数、Davies-Bouldin指数等。

评估聚类结果可以判断聚类分析的准确性和可解释性。

七、可视化聚类结果为了更好地理解聚类结果,大数据分析师可以使用数据可视化的方法展示聚类结果。

常用的可视化方法包括散点图、热力图等。

通过可视化聚类结果,可以更直观地观察数据点的分布情况和簇间的关系。

八、应用聚类结果聚类分析得到的结果可以应用于各种实际问题中。

基于三支决策的灰色可能度聚类方法及应用

杜俊良;刘思峰;刘勇;李志远;张维亮

【期刊名称】《运筹与管理》

【年(卷),期】2024(33)1

【摘要】针对经典的灰色可能度聚类评估模型难以判定决策对象的灰类归属和过度聚类等问题,利用三支决策的思想和方法,通过引入三支灰类的概念描述决策对象和灰类之间的不确定聚类关系;将其代替灰色定权聚类中的灰类和严格的聚类关系,构建基于三支决策的灰色可能度聚类方法,并采用决策粗糙集中的贝叶斯推理确定聚类阈值;最后,以案例验证所提方法的有效性和合理性。

结果表明:本文所构建的模型是经典灰色可能度聚类评估模型的拓展和泛化,可以有效避免过度聚类,降低决策风险,提高聚类可靠性。

【总页数】6页(P23-28)

【作者】杜俊良;刘思峰;刘勇;李志远;张维亮

【作者单位】西北工业大学管理学院;南京航空航天大学灰色系统研究所;江南大学商学院

【正文语种】中文

【中图分类】N941.5

【相关文献】

1.用基于邓氏灰色关联度的聚类方法对煤种进行聚类的研究

2.基于q近邻的不完备数据三支决策聚类方法

3.基于k-means的自动三支决策聚类方法

4.基于聚类与排序并重的灰色聚类决策方法改进

5.基于指标信息量的灰色可能度聚类模型研究

因版权原因,仅展示原文概要,查看原文内容请购买。

基于k—means的自动三支决策聚类方法作者:于洪毛传凯来源:《计算机应用》2016年第08期摘要:应用广泛的k-means算法结果是一种二支决策的结果,即对象要么属于某个类要么不属于这个类,这种决策方式难以适用于一些具有不确定现象的环境,因此提出三支决策聚类方法来反映对象与类之间的关系,即:对象确定属于某类、可能属于某类或确定不属于某类。

显然,二支决策是三支决策的一种特例。

此外,从类内紧凑性和考虑近邻类间分离性角度出发,定义了分离性指数、聚类结果评估有效性指数,并提出了一种自动三支决策聚类算法。

该方法为处理具有不确定信息的基于k-means算法框架的聚类数目自动确定的难题提供了一种新的解决思路。

在人工数据集和UCI真实数据集上的初步对比实验结果表明所提出的方法是有效的。

关键词:聚类;三支决策;有效性指数;k-means算法中图分类号:TP391文献标志码:A0引言k-means算法[1]自提出50多年来,在聚类分析中得到了广泛应用,更多的介绍请参见文献[2]。

但是,k-means算法存在一个突出的问题,即需要预先设定聚类数目。

所以,本文针对如何自动获取k-means的聚类数目进行了研究。

为了确定聚类数目,许多学者从聚类有效性指数方面进行了研究,该类成果大多数都结合了类内紧凑性和类间分离性这两个因素[3-10]。

一般说来,这些方法用类中对象和类中心距离的平均值及其变形来衡量类内紧凑性,用类中心之间的距离来衡量类间分离性。

它们较少考虑类中对象数目的多少以及对象的分布情况,因此在某些情况下不能很好地度量类间的分离情况。

本文从类内紧凑性和考虑近邻的类间分离性出发,定义新的分离性指数,并设计了新的有效性指数。

另一方面,k-means算法得到的结果实际上是一种二支决策结果,只考虑了对象与类的两种关系,即:对象要么属于一个类要么不属于一个类。

这种聚类结果没有反映某些应用背景下的对象与类的不确定性关系,即对象可能属于某个类。

数据分析与决策支持计划三篇《篇一》数据分析与决策支持计划是一项重要的工作,它可以帮助我更好地理解和利用数据,从而做出更准确的决策。

在这个计划中,详细阐述工作内容、工作规划、工作设想、工作计划、工作要点、工作方案和工作安排,以确保这项工作的顺利进行。

1.数据收集:收集相关的数据和信息,包括市场数据、竞争对手数据、客户数据等。

2.数据整理:对收集到的数据进行整理和清洗,去除无效数据和重复数据,确保数据的准确性和完整性。

3.数据分析:利用统计学方法和数据分析工具,对整理后的数据进行分析和挖掘,找出数据中的规律和趋势。

4.决策支持:根据数据分析的结果,为决策依据和建议,帮助做出更准确和明智的决策。

5.阶段一:数据收集和整理(1个月)在这个阶段,重点收集和整理相关的数据,包括市场数据、竞争对手数据和客户数据。

2.阶段二:数据分析(2个月)在这个阶段,利用统计学方法和数据分析工具,对整理后的数据进行分析和挖掘,找出数据中的规律和趋势。

3.阶段三:决策支持(1个月)在这个阶段,根据数据分析的结果,为决策依据和建议。

1.通过数据分析,能够更好地了解市场情况和竞争对手的动态,为决策准确的信息。

2.通过对客户数据的分析,能够更好地了解客户需求和行为,为产品设计和市场推广依据。

3.通过对数据的持续分析和监控,能够及时发现和应对市场变化,保持竞争优势。

4.数据收集和整理:每天定期收集相关的数据,并进行整理和清洗,确保数据的准确性和完整性。

5.数据分析:每周进行一次数据分析,利用统计学方法和数据分析工具,找出数据中的规律和趋势。

6.决策支持:每个月向决策者一次决策支持报告,包括数据分析的结果和建议。

7.数据的准确性和完整性是数据分析的基础,要确保数据的质量和可靠性。

8.选择合适的统计学方法和数据分析工具,以提高分析的准确性和效率。

9.与决策者保持良好的沟通,确保决策支持报告能够满足决策者的需求。

10.数据收集和整理:每天工作开始时,先收集相关的数据,并进行整理和清洗。

大数据分析与决策支持系统1. 前言在现代商业和社会活动中,数据已经成为一种重要的资产。

大数据分析作为一种挖掘和利用这些数据的方法,已经成为企业、政府及其他组织提高效率、降低成本、增加收入的重要手段。

决策支持系统(Decision Support Systems, DSS)则是帮助管理层做出更明智决策的工具。

将大数据分析与决策支持系统相结合,可以为组织提供更加精准、实时的决策支持。

2. 大数据分析大数据分析是指对海量数据进行挖掘、处理、分析和解释,以提取有用信息和洞察力。

大数据分析的主要特点是数据量庞大、数据类型多样、数据处理速度快。

大数据分析的工具和技术包括数据挖掘、机器学习、深度学习、自然语言处理等。

通过大数据分析,组织可以发现数据之间的隐藏关系,预测未来趋势,从而指导决策。

3. 决策支持系统决策支持系统是一种计算机化的信息系统,目的是辅助管理层做出更明智的决策。

决策支持系统可以处理结构化和非结构化的数据,通过数据分析和模型建立,为用户提供决策相关的信息和选项。

决策支持系统的核心功能包括数据收集、数据处理、数据分析、决策制定和决策评估。

4. 大数据分析与决策支持系统的结合将大数据分析与决策支持系统相结合,可以实现更高效、精准的决策支持。

大数据分析提供了丰富的数据和洞察力,决策支持系统则为管理层提供了决策的工具和模型。

这种结合可以使组织在以下方面受益:1.提高决策效率:大数据分析可以为决策支持系统提供实时、准确的数据,减少数据收集和处理的时间,从而提高决策效率。

2.提高决策质量:大数据分析可以发现数据之间的隐藏关系和趋势,为决策提供更有价值的参考。

决策支持系统可以为管理层提供多种决策选项和评估结果,帮助他们做出更明智的决策。

3.优化资源配置:大数据分析可以帮助组织了解各种资源的利用情况和潜在需求,从而优化资源配置,提高运营效率。

4.降低风险:通过大数据分析,组织可以预测潜在的风险和挑战,并提前采取应对措施。