随机森林课件

- 格式:ppt

- 大小:1.23 MB

- 文档页数:33

举例说明随机森林的原理和计算流程Random forest, as the name suggests, is a collection of decision trees that work together to make predictions. It is a versatile and powerful machine learning algorithm that can be used for both classification and regression tasks. 随机森林,顾名思义,是一组决策树,它们共同工作以进行预测。

这是一种多功能且强大的机器学习算法,既可以用于分类任务,也可以用于回归任务。

The basic principle behind random forest is to build a large numberof decision trees during training and then make predictions based on the majority vote of all the trees. Each decision tree is built using a different subset of the training data, and at each split, a random subset of features is considered. This helps to reduce overfitting and makes the random forest more robust. 随机森林的基本原理是在训练期间构建大量的决策树,然后根据所有树的多数投票进行预测。

每个决策树都是使用训练数据的不同子集构建的,在每次分裂时,都会考虑一组随机特征。

这有助于减少过拟合,使随机森林更加健壮。

The calculation process of the random forest algorithm can be broken down into the following steps. First, a random subset of thetraining data is selected. Then, a decision tree is built using this subset of data, considering only a random subset of features at each split. This process is repeated for a predefined number of trees. Once all the trees are built, the random forest can make predictions by aggregating the predictions of each individual tree. 随机森林算法的计算过程可以分解为以下步骤。

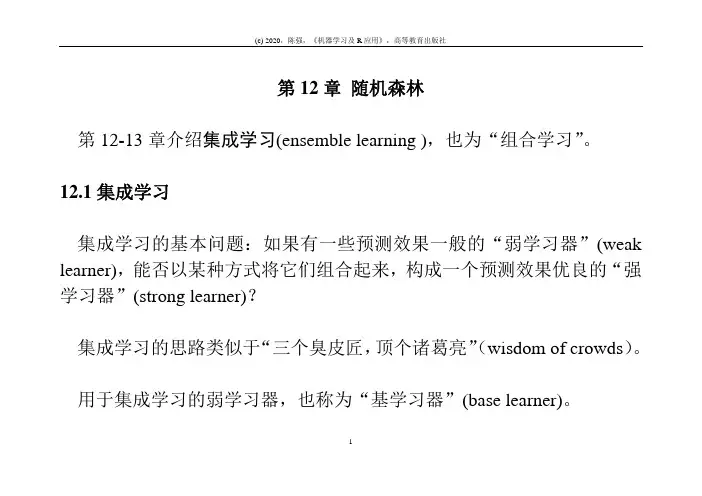

第12章随机森林第12-13章介绍集成学习(ensemble learning ),也为“组合学习”。

12.1集成学习集成学习的基本问题:如果有一些预测效果一般的“弱学习器”(weak learner),能否以某种方式将它们组合起来,构成一个预测效果优良的“强学习器”(strong learner)?集成学习的思路类似于“三个臭皮匠,顶个诸葛亮”(wisdom of crowds)。

用于集成学习的弱学习器,也称为“基学习器”(base learner)。

1决策树是最常见的基学习器。

给定数据与算法,则监督学习的估计结果是基本确定的(可能由于随机分组的不同而略有差异),这可表示为数据算法结果(12.1)+=怎么才能得到不同..呢?..结果一种方法是,给定数据,但使用不同的算法,然后将所得的不同结果组合在一起;比如加权平均,而权重以交叉验证来确定。

23 以回归问题为例,假设共有三种不同的算法(比如线性回归、KNN 与决策树),其预测结果分别为1ˆ()f x ,2ˆ()f x 与3ˆ()f x ;则集成算法的最终预测结果为1122123ˆˆˆˆ()()()(1)()f f f f αααα=++--x x x x(12.2)其中,10α≥,20α≥,且121αα+≤。

最优调节参数1α与2α可通过交叉验证来确定。

由于算法1ˆ()f x ,2ˆ()f x 与3ˆ()f x 皆为集成算法ˆ()f x 的特例,故ˆ()f x 的预测效果肯定优于(至少不差于)这三种单独的算法。

类似地,对于分类问题,则可将不同算法的预测结果,进行加权求和,按多数票规则投票;而投票权重可通过交叉验证确定。

集成学习的另一方式为,给定算法(比如以决策树的CART算法为基学习器),然后“搅动数据”,得到不同的决策树模型,再组合在一起,即所谓“Perturb + Combine”的模式。

本章介绍的装袋法与随机森林属于这种方式。

4512.2装袋法Breiman(1996)提出“装袋法”(bootstrap aggregating ,简记bagging)。

随机森林θk);k=1,......}定义:随机森林是一个分类器,它有一系列的单株树决策器{h(X,,θk}是独立同分布的随机变量。

再输入X时,每一棵树只投一票给来组成,其中{它认为最合适的类。

在机器学习中,随机森林是一个包含多个决策树的分类器,并且其输出的类别是由个别树输出的类别的众数而定,构成随机森林的基础分类器称为决策树。

Leo Breiman和Adele Cutler发展出推论出随机森林的算法。

这个术语是1995年由贝尔实验室的Tin Kam Ho所提出的随机决策森林(random decision forests)而来的。

这个方法则是结合Breimans 的"Bootstrap aggregating" 想法和Ho 的"random subspace method"" 以建造决策树的集合。

随机森林是一个组合分类器,构成随机森林的基础分类器是决策树。

决策树算法决策树可以视为一个树状预测模型,它是由结点和有向边组成的层次结构。

树中包含3个节点:根节点。

内部节点,终节点(叶子节点)。

决策树只有一个根节点,是全体训练集的结合。

树中的每个内部节点都是一个分裂问题,它将到达该节点的样本按某个特定的属性进行分割,可以将数据集合分割成2块或若干块。

每个终结点(叶子节点)是带有分裂标签的数据集合,从决策树的根节点到叶子节点的每一条路径都形成一个类;决策树的算法很多,例如ID3算法,CART算法等。

这些算法均采用自上而下的贪婪的算法,每个内部节点选择分类效果最好的属性进行分裂节点,可以分为两个或若干个子节点,继续此过程到这可决策树能够将全部训练数据准确的分类,或所有属性都被用到为止。

具体步骤如下:1)假设T为训练样本集。

2)选择一个最能区分T中样本的一个属性。

3)创建一个数的节点,它的值是所选择的属性,创建此节点的子节点,每个子链代表所选属性的唯一值,适用子链的值进一步将样本细分为子类。