开源搜索引擎比较

- 格式:doc

- 大小:51.00 KB

- 文档页数:5

目前市面上有很多开源的BI 工具可供选择,以下是几个免费、开源且可以商用的BI 工具,并且支持和Doris 数据库结合使用:Superset:由Airbnb 发起的开源BI 工具,带有可视化和交互式仪表盘功能。

Superset 支持多种数据源,其中包括Doris 数据库。

Metabase:一个简单易用的BI 工具,支持数据可视化和SQL 查询。

Metabase 支持多种数据库,包括Doris 数据库。

Redash:一个开源的数据查询和可视化工具,支持多种数据源,包括Doris 数据库。

这些工具都支持多种数据源,包括Doris 数据库,并提供了直观的查询和可视化界面,可以帮助分析师更好地理解和分析数据。

下面是Datart 和上述三种开源BI 工具的优缺点对比:DatartDatart 是一个功能强大、易于使用的商业智能工具,可以满足复杂的数据分析需求。

Datart 支持多种数据源,包括Doris 数据库,并提供了数据清洗、数据可视化、数据建模等多种功能,可以帮助分析师更好的理解和分析数据。

然而,由于Datart 是商业软件,其使用和技术支持可能需要一定的成本投入。

SupersetSuperset 是一个由Airbnb 发起的开源BI 工具,带有可视化和交互式仪表盘功能。

Superset 使用简便,具有良好的报表和图表设计能力,并支持多种数据源,包括Doris 数据库。

但是相对于Datart,Superset 的数据建模和数据处理能力相对较弱。

Metabase:Metabase 是一个简单易用的开源BI 工具,具有良好的可视化和查询功能,并支持多种数据源,包括Doris 数据库。

然而与Datart 相比,Metabase 的数据处理和数据建模能力相对较弱。

RedashRedash 是一个开源的数据查询和可视化工具,支持多种数据源,包括Doris 数据库。

Redash 方便易用,具有良好的查询和可视化功能,但是相对于Datart,其扩展性和定制化能力相对较弱。

各种搜索引擎算法的分析和比较在互联网上搜索所需信息或资讯,搜索引擎成为了人们必不可少的工具。

然而,搜索引擎的搜索结果是否准确、全面,搜索速度是否快速等方面,关键在于搜索引擎的算法,因此,搜索引擎算法成为了搜索引擎核心竞争力的来源。

目前,主流的搜索引擎包括Google、Baidu、Yahoo、Bing等,但它们的搜索结果和排序结果却存在着很大的差异。

这些搜索引擎的搜索结果背后都有不同的算法,下面将对目前主流的几种搜索引擎的算法进行分析和比较。

1. Google算法Google算法是目前全球最流行的搜索引擎算法,其搜索结果广受用户信任。

Google算法最重要的要素是页面权重(PageRank),其名字最初来源于Google的创始人之一拉里·佩奇的名字。

页面权重是根据页面链接的数量和链接网站的权重计算得到的一个评分系统,也就是所谓的“链接分”。

除此之外,Google还有很多其他的评分规则,比如页面初始状态、页面内部链接等。

可以说,Google的算法非常复杂,它使用了很多技术来确保其搜索引擎结果的质量。

2. Baidu算法Baidu是中国主流的搜索引擎,其搜索算法相较于Google来说较为简单。

Baidu的搜索结果主要依靠页面的标题、关键词、描述等元素,因此其搜索结果的可靠性稍逊于Google。

不过,Baidu的形态分析算法却是非常出色的,可以识别图片和视频等多种形态的信息。

除此之外,Baidu还使用了一些人工智能技术,例如深度学习算法来优化搜索结果。

3. Bing算法Bing是由微软开发的搜索引擎,其搜索结果以关键词匹配为核心来实现。

在关键词匹配的基础上,Bing还使用了一些机器学习和推荐算法来优化搜索结果。

另外,Bing还使用类似Google的页面权重评分系统来实现页面的排序。

除此之外,Bing还注重在搜索结果页面中显示质量较高的结果,而不局限于排序前十的结果。

4. Yahoo算法Yahoo算法是基于文本内容分析的搜索引擎算法。

国外7个源代码库搜索引擎网站转——国外7个源代码/库搜索引擎网站2011-10-25 16:16 146人阅读评论(0) 收藏举报现如今编程似乎成为一种潮流,程序员越来越多,任何一个程序员都必须学习至少一门编程语言,但是学习编程语言总是不那么容易的,前些时候在SitePoint社区进行的如何更好的学习编程语言的讨论中,大家一致认为认真学习别人的代码是一种非常有效的方法,以下七个源代码搜索引擎网站是由网友们提供的、寻找源代码最高效的地方!让我们一起来了解一下吧!1 . GitHubGitHub是非常受欢迎的开源代码库和版本控制服务提供者,前段时间推出了一项新的源代码搜索服务,虽然GitHub才刚刚进入源代码搜索服务领域不久,但是GitHub已经成为了这一领域非常受欢迎的搜索服务提供者,并且已经拥有了数以亿计的代码储存量,正如一篇博客中提到的,GitHub中的确有”很多东西”!2 . KrugleKrugle声称他们的搜索包含超过25亿行代码,这一数量使他们成为互联网上最大的源代码搜索引擎之一,并且还称他们的搜索结果包含了全球三分之一开发者的源代码!同时他们还分别为全球多家大型公司或企业,如Amazone、IBM、、、Yahoo!等提供企业级的代码搜索服务!3 . KodersKoders号称其能够搜索的代码数目超过10亿行,并且深受Ruby 程序员的青睐!在Koders被黑鸭软件公司(Black Duck Software)收购之后,该网站关于Ruby的搜索比过去四年的总和激增了20倍,超过了该站PHP、Perl和Python的搜索数目!并且Ruby已成为该网站继Java、 C/C、和 C#之后搜索次数最多的语言。

4 . CodaesCodaes在这个源代码搜索领域似乎并不起眼,能够搜索到的代码数量也只有2.5亿条,究其原因可能是该网站的搜索服务发展似乎已经停滞好几年了。

Codaes主要关注的是关于Linux方面的C/C++项目代码,但这在今天似乎有些过时了!除非这就是你要找的内容,否则除此之外你有更好的搜索选择。

英文十大搜索引擎十大搜索引擎排名中文搜索引擎Google搜索引擎(/)目前最优秀的支持多语种的搜索引擎之一,约搜索3,083,324,652 张网页。

提供网站、图像、新闻组等多种资源的查询。

包括中文简体、繁体、英语等35个国家和地区的语言的资源。

百度(baidu)中文搜索引擎(/)全球最大中文搜索引擎。

提供网页快照、网页预览/预览全部网页、相关搜索词、错别字纠正提示、新闻搜索、Flash搜索、信息快递搜索、百度搜霸、搜索援助中心。

北大天网中英文搜索引擎(/)由北京大学开发,简体中文、繁体中文和英文三个版本。

提供全文检索、新闻组检索、FTP 检索(北京大学、中科院等FTP站点)。

目前大约收集了100万个WWW页面(国内)和14万篇Newsgroup(新闻组)文章。

支持简体中文、繁体中文、英文关键词搜索,不支持数字关键词和URL名检索。

新浪搜索引擎(/)互联网上规模最大的中文搜索引擎之一。

设大类目录18个,子目1万多个,收录网站20余万。

提供网站、中文网页、英文网页、新闻、汉英辞典、软件、沪深行情、游戏等多种资源的查询。

雅虎中国搜索引擎(/)Yahoo!是世界上最著名的目录搜索引擎。

雅虎中国于1999年9月正式开通,是雅虎在全球的第20个网站。

Yahoo!目录是一个Web资源的导航指南,包括14个主题大类的内容。

搜狐搜索引擎(/)搜狐于1998年推出中国首家大型分类查询搜索引擎,到现在已经发展成为中国影响力最大的分类搜索引擎。

每日页面浏览量超过800万,可以查找网站、网页、新闻、网址、软件、黄页等信息。

网易搜索引擎(/)网易新一代开放式目录管理系统(ODP)。

拥有近万名义务目录管理员。

为广大网民创建了一个拥有超过一万个类目,超过25万条活跃站点信息,日增加新站点信息500~1000条,日访问量超过500万次的专业权威的目录查询体系。

3721网络实名/智能搜索(/)3721公司提供的中文上网服务――3721"网络实名",使用户无须记忆复杂的网址,直接输入中文名称,即可直达网站。

21款开源搜索引擎项目介绍搜索引擎的主流语言是Java,要研究和开发搜索引擎,最好从Lucene开始,下面介绍一些开源搜索引擎系统,包含开源Web搜索引擎和开源桌面搜索引擎。

Lucene一个全文搜索引擎工具包,但只支持文本文件以及少量语种的索引;通过Lucene提供的接口,我们可以自己开发具体语言的分词器,针对具体文档的文本解析器等;Lucene是索引数据结构事实上的标准;Apache Lucene是一个基于Java全文搜索引擎,利用它可以轻易地为Java软件加入全文搜寻功能。

Lucene的最主要工作是替文件的每一个字作索引,索引让搜寻的效率比传统的逐字比较大大提高,Lucen提供一组解读,过滤,分析文件,编排和使用索引的API,它的强大之处除了高效和简单外,是最重要的是使使用者可以随时应自已需要自订其功能。

Sphider Sphider是一个轻量级,采用PHP开发的web spider和搜索引擎,使用mysql来存储数据。

可以利用它来为自己的网站添加搜索功能。

Sphider非常小,易于安装和修改,已经有数千网站在使用它。

RiSearch PHPRiSearch PHP是一个高效,功能强大的搜索引擎,特别适用于中小型网站。

RiSearch PHP非常快,它能够在不到1秒钟内搜索5000-10000个页面。

RiSearch是一个索引搜索引擎,这就意味着它先将你的网站做索引并建立一个数据库来存储你网站所有页面的关键词以便快速搜索。

Risearch是全文搜索引擎脚本,它把所有的关键词都编成一个文档索引除了配置文件里面的定义排除的关键词。

RiSearch使用经典的反向索引算法(与大型的搜索引擎相同),这就是为什么它会比其它搜索引擎快的原因。

Xapian使用C++编写,提供绑定程序使得其他语言能够方便地使用它;便于进行二次开发PhpDigPhpDig是一个采用PHP开发的Web爬虫和搜索引擎。

通过对动态和静态页面进行索引建立一个词汇表。

OpenSearch 数据库原理OpenSearch 是一个开源的分布式搜索引擎,它基于Apache Lucene 构建。

OpenSearch 提供了强大的搜索功能,包括全文搜索、结构化搜索、地理搜索等。

它还支持多种数据源,包括关系型数据库、NoSQL 数据库、文件系统等。

OpenSearch 的基本原理是将数据索引到一个分布式的倒排索引中。

倒排索引是一种数据结构,它将词语映射到包含该词语的文档的列表。

当用户进行搜索时,OpenSearch 会将搜索词语查询倒排索引,并返回包含该词语的所有文档的列表。

OpenSearch 的索引过程分为两步:1. 分词:将文档中的词语拆分成单个的词元。

2. 索引:将词元添加到倒排索引中。

OpenSearch 的搜索过程分为三步:1. 查询解析:将用户输入的搜索词语解析成一个查询表达式。

2. 查询执行:将查询表达式应用于倒排索引,并返回包含查询词语的所有文档的列表。

3. 结果排序:对返回的文档列表进行排序,并返回最相关的文档。

OpenSearch 还支持多种聚合功能,可以对搜索结果进行分组和统计。

聚合功能包括:求和:计算文档中某个字段的值的总和。

平均值:计算文档中某个字段的值的平均值。

最大值:计算文档中某个字段的值的最大值。

最小值:计算文档中某个字段的值的最小值。

计数:计算文档中某个字段的值出现的次数。

OpenSearch 是一个功能强大的搜索引擎,它可以用于构建各种各样的搜索应用程序。

OpenSearch 的开源特性也使其非常灵活,可以根据不同的需求进行定制。

OpenSearch 的优点开源:OpenSearch 是一个开源的搜索引擎,这意味着它可以免费使用和修改。

分布式:OpenSearch 是一个分布式的搜索引擎,这意味着它可以横向扩展以满足不断增长的搜索需求。

可扩展:OpenSearch 是一个可扩展的搜索引擎,这意味着它可以随着数据量的增加而扩展。

高性能:OpenSearch 是一个高性能的搜索引擎,这意味着它可以快速地处理搜索请求。

开源知识库向企业文档管理,市场上有非常多的开源知识库产品,其中就包含:1、PingCode Wiki;2、飞书文档;3、坚果云;4、Notion;5、有道云笔记;6、Bitrix 24;7、Bloomfire;8、Tettra;9、IntelligenceBank。

企业的任何工作流程都离不开文档管理,面对复杂的业务流程、频繁的文档编辑任务和跨区域的文件共享需求,优秀的文档管理体系能够帮助企业实现安全的文档存储,高效的文档搜索,便捷的文档协作和有效的文档权限、版本、行为管控。

由于各个产品切入文档管理市场的角度各不相同,所以有些人将开源知识库工具分为三类:储存型产品(如企业云网盘)、协同型产品(如石墨文档、腾讯文档)、文档型产品(如PingCode Wiki、语雀),但随着这些年的发展,这三类其实边界已经越来越模糊。

而本文将来给大家盘点一下国内外最顶级的一些企业开源知识库工具。

1、更适合产研团队的开源知识库:PingCode WikiPingCode Wiki 是一款更适合软件研发团队使用的开源知识库工具,因为它和Confluence 一样,能够将文档直接关联到软件研发过程中的某个用户故事、缺陷、测试用例等等,研发过程中的需求、测试任务、缺陷等也可插入文档。

PingCode Wiki 是一站式研发管理工具PingCode 中的重要模块之一,虽然它被广泛用于研发项目管理、需求管理、测试管理、缺陷管理、开源知识库管理、目标管理等。

但这并不意味着其他团队不能使用,其他团队只是像上面提到的一些功能只是用不到,它仍旧是一个和语雀一样的开源知识库工具,你能够用它制作帮助文档、FAQ、产品手册、项目文档等等。

产品能力:以结构化的方式像书本一样管理文档、支持多人实时协同编辑、支持Markdown、富文本等多种编辑方式、支持水印、分享、页面级的权限管理、有丰富的模板库、支持一键开启演示模式等等。

软件优势:数据安全:网银级的数据安全保护以及异地备份;无存储空间上限;操作简单,上手速度快,开箱即用;25人以下可免费使用基础版本,支持私有部署、定制开发、saas 等;与PingCode Wiki 类似的还有confluence等产品。

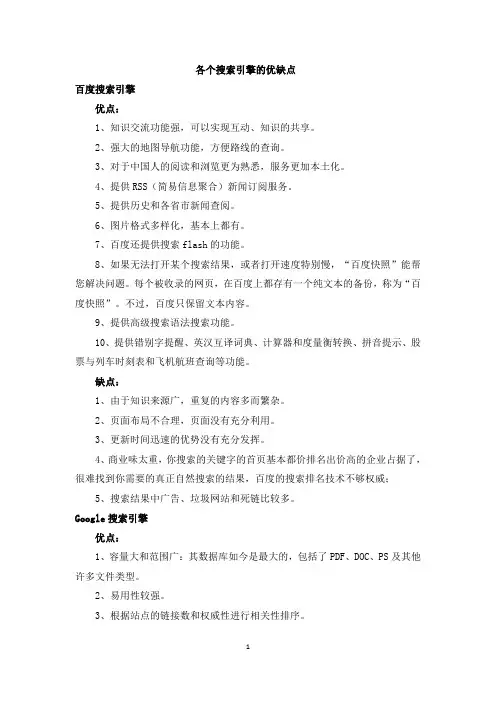

各个搜索引擎的优缺点百度搜索引擎优点:1、知识交流功能强,可以实现互动、知识的共享。

2、强大的地图导航功能,方便路线的查询。

3、对于中国人的阅读和浏览更为熟悉,服务更加本土化。

4、提供RSS(简易信息聚合)新闻订阅服务。

5、提供历史和各省市新闻查阅。

6、图片格式多样化,基本上都有。

7、百度还提供搜索flash的功能。

8、如果无法打开某个搜索结果,或者打开速度特别慢,“百度快照”能帮您解决问题。

每个被收录的网页,在百度上都存有一个纯文本的备份,称为“百度快照”。

不过,百度只保留文本内容。

9、提供高级搜索语法搜索功能。

10、提供错别字提醒、英汉互译词典、计算器和度量衡转换、拼音提示、股票与列车时刻表和飞机航班查询等功能。

缺点:1、由于知识来源广,重复的内容多而繁杂。

2、页面布局不合理,页面没有充分利用。

3、更新时间迅速的优势没有充分发挥。

4、商业味太重,你搜索的关键字的首页基本都价排名出价高的企业占据了,很难找到你需要的真正自然搜索的结果,百度的搜索排名技术不够权威;5、搜索结果中广告、垃圾网站和死链比较多。

Google搜索引擎优点:1、容量大和范围广:其数据库如今是最大的,包括了PDF、DOC、PS及其他许多文件类型。

2、易用性较强。

3、根据站点的链接数和权威性进行相关性排序。

4、网页缓存归档,浏览过的网页被编入索引。

5、还有其他数据库:Google群组、新闻和目录等数据库。

缺点:1、网页排版不新颖,美观度不高。

2、搜索特性有限,没有嵌套搜索,没有截词搜索,不支持全部的布尔逻辑检索。

3、链接搜索不完整。

死链率比较高,中文网站检索的更新频率不够高,不能及时淘汰过时的链接。

4、只能把网页的前101KB和PDF的大约前120KB编入索引。

5、可能会在不告诉你的情况下,检索复数单数、同义词和语法变体。

雅虎搜索引擎优点:1、搜索引擎数据库庞大而且新颖。

2、包括页面的缓存拷贝。

3、也包括指向雅虎目录的链接。

4、支持全部的布尔逻辑检索。

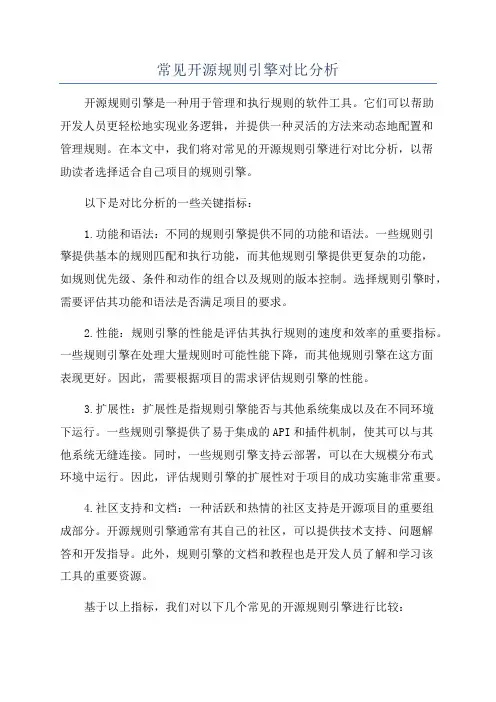

常见开源规则引擎对比分析开源规则引擎是一种用于管理和执行规则的软件工具。

它们可以帮助开发人员更轻松地实现业务逻辑,并提供一种灵活的方法来动态地配置和管理规则。

在本文中,我们将对常见的开源规则引擎进行对比分析,以帮助读者选择适合自己项目的规则引擎。

以下是对比分析的一些关键指标:1.功能和语法:不同的规则引擎提供不同的功能和语法。

一些规则引擎提供基本的规则匹配和执行功能,而其他规则引擎提供更复杂的功能,如规则优先级、条件和动作的组合以及规则的版本控制。

选择规则引擎时,需要评估其功能和语法是否满足项目的要求。

2.性能:规则引擎的性能是评估其执行规则的速度和效率的重要指标。

一些规则引擎在处理大量规则时可能性能下降,而其他规则引擎在这方面表现更好。

因此,需要根据项目的需求评估规则引擎的性能。

3.扩展性:扩展性是指规则引擎能否与其他系统集成以及在不同环境下运行。

一些规则引擎提供了易于集成的API和插件机制,使其可以与其他系统无缝连接。

同时,一些规则引擎支持云部署,可以在大规模分布式环境中运行。

因此,评估规则引擎的扩展性对于项目的成功实施非常重要。

4.社区支持和文档:一种活跃和热情的社区支持是开源项目的重要组成部分。

开源规则引擎通常有其自己的社区,可以提供技术支持、问题解答和开发指导。

此外,规则引擎的文档和教程也是开发人员了解和学习该工具的重要资源。

基于以上指标,我们对以下几个常见的开源规则引擎进行比较:1. Drools:Drools 是一个Java规则引擎,具有强大的规则匹配和执行引擎。

它提供了广泛的规则语法和表达方式,支持规则动态加载和修改,并具有高性能和可扩展性。

Drools 还有一个活跃的社区,并提供了详尽的文档和指南。

2. Jess:Jess 是一个基于Java的规则引擎,拥有强大的推理能力和灵活的语法。

它支持基于规则的编程和基于事件的规则执行,能够快速地处理大量的规则。

然而,Jess 的学习曲线较陡,并且该项目的社区支持相对较小。

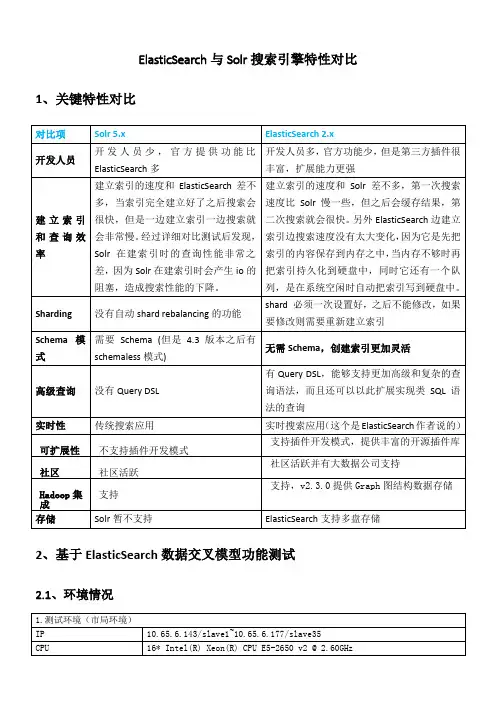

ElasticSearch与Solr搜索引擎特性对比1、关键特性对比2、基于ElasticSearch数据交叉模型功能测试2.1、环境情况2.2、测试结果3、ElasticSearch与Solr的压力测试对比3.1、测试环境2.数据环境Solr中单索引库中索引条数为5000W,ElasticSearch中单索引库中索引条数为1亿。

3.2、测试工具3.3、测试结果3.4、总结✧在本次测试中,每次测试总的访问次数为10000,从以上图表中可以看出随着并发数的增加,Solr和ElasticSearch的每秒响应请求数都是先增加,然后稳定在一定数值,在超过某个阈值之后极速下降;✧从平均每秒响应请求次数来看,ElasticSearch性能指标优于Solr;在不同的并发数下,ElasticSearch的每秒响应请求数在500~800之间,而Solr的每秒响应请求数在300~600之间,ElasticSearch采用默认分词进行中文模糊搜索时速度非常慢,经分析更换ik中文分词后性能有明显提高;✧从连接平均返回时间来看,在低并发时,ElasticSearch和Solr相差不大,但是随着并发数量的增加,ElasticSearch返回时间的增长速度大于Solr;✧从不同的并发数下的成功次数来看,ElasticSearch性能指标优于Solr,Solr在并发数达到500的时候出现大面积错误;ElasticSearch直到并发数为1000的时候才出现了错误;✧Solr集群不太稳定,12月30日简单测试过一次,当时并发达到1000时才开始出现性能大幅下降,并且平均每秒响应请求数在600左右,而31日则在并发500时表现有较大差距。

4、ElasticSearch与Hadoop平台的融合4.1、ElasticSearchonYarnElasticSearch可以通过Yarn来运行,官网有相关教程,但由于Yarn资源的限制,目前ElasticSearchforHadoop还是beta版,并不包含ElasticSearch的所有功能。

比较Google、百度、Excite等搜索引擎的异同一搜索引擎的概念搜索引擎是指根据一定的策略、运用特定的计算机程序从互联网搜集信息,在对信息进行组织和处理后,为用户提供检索服务,将用户检索相关的信息展示给用户的系统。

搜索引擎包括全文索引、目录索引、元搜索引擎、垂直搜索引擎、集合式搜索引擎、门户搜索引擎与免费链接列表等。

百度、谷歌、Excite等是搜索引擎的代表。

二搜索引擎的分类1.全文索引全文搜索引擎是名副其实的搜索引擎,国外代表有Google,国内则有著名的百度搜索。

它们从互联网提取各个网站的信息(以网页文字为主),建立起数据库,并能检索与用户查询条件相匹配的记录,按一定的排列顺序返回结果。

根据搜索结果来源的不同,全文搜索引擎可分为两类,一类拥有自己的检索程序(Indexer),俗称“蜘蛛”(Spider)程序或“机器人”(Robot)程序,能自建网页数据库,搜索结果直接从自身的数据库中调用,上面提到的Google和百度就属于此类;另一类则是租用其他搜索引擎的数据库,并按自定的格式排列搜索结果,如Lycos搜索引擎。

2.目录索引目录索引虽然有搜索功能,但严格意义上不能称为真正的搜索引擎,只是按目录分类的网站链接列表而已。

用户完全可以按照分类目录找到所需要的信息,不依靠关键词(Keywords)进行查询。

目录索引中最具代表性的莫过于大名鼎鼎的Yahoo!、新浪分类目录搜索。

3.元搜索引擎元搜索引擎(META Search Engine)接受用户查询请求后,同时在多个搜索引擎上搜索,并将结果返回给用户。

著名的元搜索引擎有InfoSpace、Dogpile、Vivisimo等,中文元搜索引擎中具代表性的是搜星搜索引擎。

在搜索结果排列方面,有的直接按来源排列搜索结果,如Dogpile;有的则按自定的规则将结果重新排列组合,如Vivisimo。

其他非主流搜索引擎形式(1)集合式搜索引擎:该搜索引擎类似元搜索引擎,区别在于它并非同时调用多个搜索引擎进行搜索,而是由用户从提供的若干搜索引擎中选择,如HotBot在2002年底推出的搜索引擎。

三大搜索引擎对比分析表

六度空间理论:

六度空间理论是一个数学领域的猜想,名为Six Degrees of Separation,中文翻译包括以下几种:六度分割理论或小世界理论等。

理论指出:你和任何一个陌生人之间所间隔的人不会超过六个,也就是说,最多通过六个人你就能够认识任何一个陌生人。

这就是六度分割理论,也叫小世界理论。

这种现象,并不是说任何人与人之间的联系都必须要通过六个层次才会产生联系,而是表达了这样一个重要的概念:任何两位素不相识的人之间,通过一定的联系方式,总能够产生必然联系或关系。

显然,随着联系方式和联系能力的不同,实现个人期望的机遇将产生明显的区别。

手持移动电视市场:

移动电视是指采用数字广播技术(主要指地面传输技术)播出,接收终端一是安装在公交汽车、地铁、城铁、出租车、商务车和其他公共场所的电视系统,二是手持接收设备(如手机、笔记本、PMP、超便携PC等)等满足移动人

群收视需求的电视系统。

本文主要讨论支持第二类的移动终端,即手持移动电视的技术应用状况。

目前手持移动电视产品中占绝对数量的是手机电视。

33款可用来抓数据的开源爬虫软件工具要玩大数据,没有数据怎么玩?这里推荐一些33款开源爬虫软件给大家。

爬虫,即网络爬虫,是一种自动获取网页内容的程序。

是搜索引擎的重要组成部分,因此搜索引擎优化很大程度上就是针对爬虫而做出的优化。

网络爬虫是一个自动提取网页的程序,它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成。

传统爬虫从一个或若干初始网页的URL开始,获得初始网页上的URL,在抓取网页的过程中,不断从当前页面上抽取新的URL放入队列,直到满足系统的一定停止条件。

聚焦爬虫的工作流程较为复杂,需要根据一定的网页分析算法过滤与主题无关的链接,保留有用的链接并将其放入等待抓取的URL队列。

然后,它将根据一定的搜索策略从队列中选择下一步要抓取的网页URL,并重复上述过程,直到达到系统的某一条件时停止。

另外,所有被爬虫抓取的网页将会被系统存贮,进行一定的分析、过滤,并建立索引,以便之后的查询和检索;对于聚焦爬虫来说,这一过程所得到的分析结果还可能对以后的抓取过程给出反馈和指导。

世界上已经成型的爬虫软件多达上百种,本文对较为知名及常见的开源爬虫软件进行梳理,按开发语言进行汇总。

虽然搜索引擎也有爬虫,但本次我汇总的只是爬虫软件,而非大型、复杂的搜索引擎,因为很多兄弟只是想爬取数据,而非运营一个搜索引擎。

Java爬虫1、ArachnidArachnid是一个基于Java的web spider框架.它包含一个简单的HTML剖析器能够分析包含HTML内容的输入流.通过实现Arachnid 的子类就能够开发一个简单的Web spiders并能够在Web站上的每个页面被解析之后增加几行代码调用。

Arachnid的下载包中包含两个spider应用程序例子用于演示如何使用该框架。

特点:微型爬虫框架,含有一个小型HTML解析器许可证:GPL2、crawlzillacrawlzilla 是一个帮你轻松建立搜索引擎的自由软件,有了它,你就不用依靠商业公司的搜索引擎,也不用再烦恼公司內部网站资料索引的问题。

83款⽹络爬⾍开源软件Nutch 是⼀个开源Java 实现的搜索引擎。

它提供了我们运⾏⾃⼰的搜索引擎所需的全部⼯具。

包括全⽂搜索和Web爬⾍。

尽管Web搜索是漫游Internet的基本要求, 但是现有web搜索引擎的数⽬却在下降. 并且这很有可能进⼀步演变成为⼀个公司垄断了⼏乎所有的web...最近更新:发布于 20天前Grub Next Generation 是⼀个分布式的⽹页爬⾍系统,包含客户端和服务器可以⽤来维护⽹页的索引。

最近更新:发布于 3年前Soukey采摘⽹站数据采集软件是⼀款基于.Net平台的开源软件,也是⽹站数据采集软件类型中唯⼀⼀款开源软件。

尽管Soukey采摘开源,但并不会影响软件功能的提供,甚⾄要⽐⼀些商⽤软件的功能还要丰富。

Soukey采摘当前提供的主要功能如下: 1. 多任务多线... PhpDig是⼀个采⽤PHP开发的Web爬⾍和搜索引擎。

通过对动态和静态页⾯进⾏索引建⽴⼀个词汇表。

当搜索查询时,它将按⼀定的排序规则显⽰包含关键字的搜索结果页⾯。

PhpDig包含⼀个模板系统并能够索引PDF,Word,Excel,和PowerPoint⽂档。

PHPdig适⽤于专业化更...Snoopy是⼀个强⼤的⽹站内容采集器(爬⾍)。

提供获取⽹页内容,提交表单等功能。

NWebCrawler是⼀款开源的C#⽹络爬⾍程序Heritrix是⼀个开源,可扩展的web爬⾍项⽬。

⽤户可以使⽤它来从⽹上抓取想要的资源。

Heritrix设计成严格按照robots.txt⽂件的排除指⽰和META robots标签。

其最出⾊之处在于它良好的可扩展性,⽅便⽤户实现⾃⼰的抓取逻辑。

Heritrix是⼀个爬⾍框架,其组织结... Scrapy 是⼀套基于基于Twisted的异步处理框架,纯python实现的爬⾍框架,⽤户只需要定制开发⼏个模块就可以轻松的实现⼀个爬⾍,⽤来抓取⽹页内容以及各种图⽚,⾮常之⽅便~最近更新:发布于 6个⽉前webmagic的是⼀个⽆须配置、便于⼆次开发的爬⾍框架,它提供简单灵活的API,只需少量代码即可实现⼀个爬⾍。

开源搜索引擎的比较

1.N utch

简介:

Nutch是一个用java实现的基于Lucene的开源搜索引擎框架,主要包括爬虫和查询两部分组成。

Nutch所使用的数据文件主要有以下三种:1)是webDb,保存网页链接结构信息,只在爬虫工作中使用。

2)是segment,存储网页内容及其索引,以产生的时间来命名。

segment文件内容包括CrawlDatum、Content、ParseData、ParseText四个部分,其中CrawlDatum保存抓取的基本信息,content 保存html脚本,ParseData和ParseText这两个部分是对原内容的解析结果。

3)是index,即索引文件,它把各个segment的信息进行了整合。

爬虫的搜索策略是采用广度优先方式抓取网页,且只获取并保存可索引的内容。

Nutch0.7需要java1.4以上的版本,nutch1.0需要java1.6。

特点:

1、遵循robots.txt,当爬虫访问一个站点时,会首先检查该站点根目录下是否存在robots.txt,如果存在,搜索机器人就会按照该文件中的内容来确定访问的范围;如果该文件不存在,所有的搜索蜘蛛将能够访问网站上所有没有被口令保护的页面。

2、采用基于Hadoop的分布式处理模型,支持分布式的实现。

3、Nutch可以修剪内容,或者对内容格式进行转换。

4、Nutch使用插件机制,可以很好的被用户定制和集成。

5、Nutch采用了多线程技术。

6、将爬取和建索引整合在了一起,爬取内容的存储方式是其自己定义的

segment,不便于对爬取的内容进行再次处理,需要进行一定的修改。

7、因为加入了对页面分析,建索引等功能其效率与heritrix相比要相对较低。

2.H eritrix

简介:

Heritrix是一个用Java实现的基于整个web的可扩展的开源爬虫框架。

Heritrix主要由三大部件:范围部件,边界部件,处理器链组成。

范围部件主要按照规则决定将哪个URI入队;边界部件跟踪哪个预定的URI将被收集,和已经被收集的URI,选择下一个 URI,剔除已经处理过的URI;处理器链包含若干处理器获取URI,分析结果,将它们传回给边界部件。

采用广度优先算法进行爬取。

heritrix用来获取完整的、精确的、站点内容的深度复制。

包括获取图像以及其他非文本内容。

抓取并存储相关的内容。

对内容来者不拒,不对页面进行内容上的修改。

重新爬行对相同的URL不针对先前的进行替换。

特点:

1、各个部件都具有较高的可扩展的,通过对各个部件的修改可以实现自己的抓

取逻辑。

2、可以进行多种的配置,包括可设置输出日志,归档文件和临时文件的位置;

可设置下载的最大字节,最大数量的下载文档,和最大的下载时间;可设置工作线程数量;可设置所利用的带宽的上界;可在设置之后一定时间重新选择;包含一些可设置的过滤机制,表达方式,URI路径深度选择等等。

3、采用多线程技术。

4、保存的内容是原始的内容,采用镜像方式存储,即按照斜杠所划分出的层次

结构进行存储,同时也会爬取图片等信息。

5、同样也遵守robots.txt规范。

6、在硬件和系统失败时,恢复能力很差。

3.W ebSPHINX

简介:

WebSPHINX是一个Java类包和Web爬虫的交互式开发环境。

WebSPHINX由两部分组成:爬虫工作平台和WebSPHINX类包。

爬虫工作台提供接口实现对爬虫的配置;类包则提供对爬虫进行扩展需要的一些支持。

其工作原理为从一个基点网站出发,遍历其中的所有有用信息,同时抽去其中的链接信息放入队列,以待有空闲蠕虫(worm)时,从队列中读取,发出request 请求,继续进行信息抽取和链接入队列的工作。

特点:

1、保存网页的原始内容。

2、采用多线程技术。

3、采用广度优先遍历算法进行爬取。

4、支持HTML解析,URL过滤,页面配置,模式匹配等等。

5、适用于爬取小规模的网页,例如爬取单一的个人站点。

4.W eblech

简介:

WebLech是一个用Java实现的功能强大的Web站点下载与镜像工具。

它支持按功能需求来下载web站点并能够尽可能模仿标准Web浏览器的行为。

WebLech有一个功能控制台并采用多线程操作。

特点:

1、支持多线程技术。

2、可维持网页的链接信息,可配置性较强,配置较为灵活,可设置需获取的网页文件的类型、起始地址、抓取策略等14 项内容。

3、采用广度优先遍历算法爬取网页。

4、保存网页的原始内容。

5.J spider

简介:

JSpider是一个完全用Java实现的可配置和定制的Web Spider引擎.你可以利用它来检查网站的错误(内在的服务器错误等),网站内外部链接检查,分析网站的结构(可创建一个网站地图),下载整个Web站点,你还可以写一个JSpider插件来扩展你所需要的功能。

Jspider主要由规则、插件和事件过滤器三部分组成,规则决定获取和处理什么资源;插件可以根据配置叠加和替换功能模块;事件过滤器选择处理什么事件或则独立的插件。

特点:

1、扩展性较强,容易实现对爬虫功能的扩展。

2、目前只支持下载HTML,不支持下载动态网页。

3、保存原始网页内容。

6.S pindle

简介:

spindle是一个构建在Lucene工具包之上的Web索引和搜索工具.它包括一个用于创建索引的HTTPspider和一个用于搜索这些索引的搜索类。

spindle项目提供了一组JSP标签库使得那些基于JSP的站点不需要开发任何Java类就能够增加搜索功能。

该项目长期没有更新且功能不完善。

7.J obo

简介:

JoBo是一个用于下载整个Web站点的简单工具。

它本质是一个WebSpider。

与其它下载工具相比较它的主要优势是能够自动填充form(如:自动登录)和使用cookies来处理session。

JoBo还有灵活的下载规则(如:通过网页的URL,大小,MIME类型等)来限制下载。

8.S noics-reptile

简介:

snoics-reptile是用纯Java开发的,用来进行网站镜像抓取的工具,可以使用配制文件中提供的URL入口,把这个网站所有的能用浏览器通过GET的方式获取到的资源全部抓取到本地,包括网页和各种类型的文件,如:图片、flash、mp3、zip、rar、exe等文件。

可以将整个网站完整地下传至硬盘内,并能保持原有的网站结构精确不变。

只需要把抓取下来的网站放到web服务器(如:Apache)中,就可以实现完整的网站镜像。

9.A rachnid

简介:

Arachnid是一个基于Java的webspider框架.它包含一个简单的HTML剖析器能够分析包含HTML内容的输入流.通过实现Arachnid的子类就能够开发一个简单的Webspiders并能够在Web站上的每个页面被解析之后增加几行代码调用。