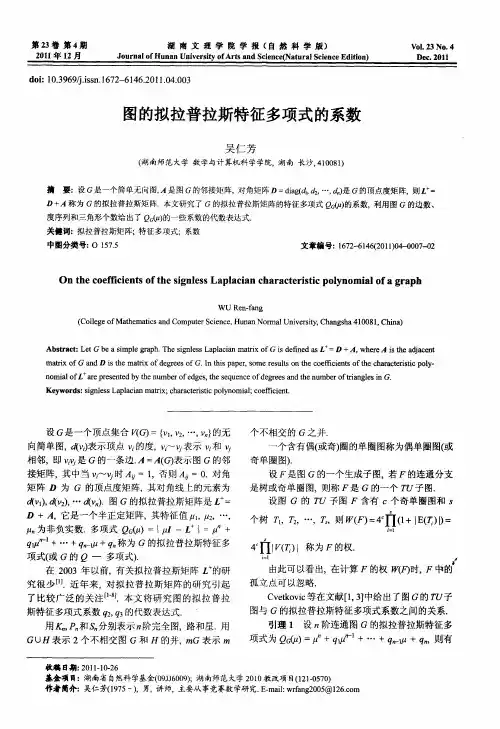

图的拉普拉斯矩阵

- 格式:doc

- 大小:209.18 KB

- 文档页数:9

最大流问题的求解方法及应用

最大流问题,是指在一个有向图中,从源点 s 到汇点 t 的最大

流量。

在实际应用中,最大流问题往往用于描述网络传输、油管输送等流量分配问题。

求解最大流问题的方法包括以下几种:

1. 网络流算法:这是一种基于图论和线性规划的算法。

通过构建网络流图,将最大流问题转化为最小割问题,再利用线性规划求解最小割问题的对偶问题来求解最大流问题。

2. 增广路算法:这是一种经典的最大流算法,其基本思想是不断找到增广路径,即从源点 s 到汇点 t 的一条路径,沿途边权

均有剩余容量,使得该路径上的边的剩余容量中的最小值最大化,最终得到最大流。

3. 矩阵树定理:这是一种基于图论和矩阵运算的算法,适用于有向图和无向图。

通过计算图的拉普拉斯矩阵的行列式等方法,求得图的生成树个数,从而计算最大流。

4. Dinic算法:是对增广路算法的改进。

在增广路算法中,每

次查找增广路径的过程需要遍历整个图,为了提高效率,

Dinic算法引入了分层图的概念,将图分层之后只在图的一层

中查找增广路径,最终求得最大流。

这些方法在实际应用中常常被用来解决路由选择、网络流量优化、模拟电路分析等问题。

例如,最大流可以被用来优化数据传输、流水线设计、流量管道的运营和管理,提高资源利用率和数据传输速度。

《深入浅出图神经网络:GNN原理解析》阅读随笔目录一、前言 (2)1.1 本书的目的和价值 (3)1.2 图神经网络简介 (3)二、图神经网络基础 (5)2.1 图的基本概念 (6)2.2 神经网络的基本概念 (8)2.3 图神经网络与神经网络的结合 (9)三、图神经网络的分类 (10)3.1 基于消息传递的图神经网络 (12)3.2 基于能量函数的图神经网络 (12)3.3 基于图注意力机制的图神经网络 (14)四、图神经网络的训练方法 (15)4.1 迭代训练法 (16)4.2 随机梯度下降法 (17)4.3 动量法 (19)4.4 自适应学习率方法 (20)五、图神经网络的优化技术 (21)5.1 局部优化算法 (22)5.2 全局优化算法 (24)5.3 混合优化算法 (26)六、图神经网络的评估与可视化 (27)6.1 评估指标 (28)6.2 可视化方法 (29)6.3 实战案例分析 (31)七、图神经网络的未来发展方向与应用前景 (32)7.1 当前研究的热点和挑战 (34)7.2 未来可能的技术创新 (35)7.3 图神经网络在各个领域的应用前景 (37)八、结语 (38)8.1 对本书内容的总结 (39)8.2 对未来图神经网络发展的展望 (40)一、前言在人工智能领域,图神经网络(Graph Neural Networks, GNNs)作为一种强大的深度学习模型,近年来得到了广泛的关注和研究。

它们能够处理非结构化数据,如社交网络、分子结构、知识图谱等,因此在许多应用中具有重要的地位。

尽管GNNs在学术界和工业界都取得了显著的成功,但它们的原理和应用仍然是一个活跃的研究课题。

特别是对于初学者来说,理解和掌握GNN的原理解析及其在实际问题中的应用,是一个不小的挑战。

为了帮助读者更好地理解GNNs,本文将从基础到高级逐步展开,深入剖析GNN的核心概念、模型架构以及最新的研究进展。

结合具体的代码实现和实验结果,我们将展示GNN在实际应用中的强大能力。

常见聚类方法聚类是一种无监督机器学习方法,将数据集中的样本分成若干个子集,使得每个子集内部的样本相似度尽可能高,而不同子集间的相似度尽可能低。

在现实生活中,聚类应用广泛,比如将市场上的消费者分成不同的群体,或将某个领域的文献分类。

本文将介绍常见的聚类方法。

1. K-means聚类K-means是一种基于距离的聚类方法,它将数据集分成K个簇,每个簇的中心被称为质心。

算法的核心是不断地迭代更新质心,直到质心不再发生变化或达到最大迭代次数。

K-means聚类的缺点是对初始质心的选择敏感,可能会陷入局部最优解。

2. 层次聚类层次聚类是一种基于距离的聚类方法,将数据集中的样本逐层合并成越来越大的簇。

具体来说,它分为自上而下和自下而上两种方法。

自上而下的方法从整个数据集开始,每次将最相似的两个样本合并成一个簇,直到只剩下一个簇。

自下而上的方法从每个样本开始,逐步将相似度高的样本合并成簇,直到只剩下一个簇。

层次聚类的优点是不需要预设簇的数量,缺点是计算复杂度高,难以处理大规模数据集。

3. 密度聚类密度聚类是一种基于密度的聚类方法,将样本分为若干个密度相似的区域。

具体来说,它以每个样本为中心,计算在一定距离范围内的样本个数,若该数目超过预设阈值,则将它们归为同一簇。

密度聚类的优点是能够处理任意形状的簇,缺点是对参数的设定比较敏感,容易陷入噪声区域。

4. 谱聚类谱聚类是一种基于图论的聚类方法,将样本看作图中的节点,节点之间的相似度看作边的权重,然后通过图的拉普拉斯矩阵进行谱分解得到特征向量,最后将特征向量作为新的样本空间进行聚类。

谱聚类的优点是能够处理非凸的簇,缺点是计算复杂度较高。

不同的聚类方法有各自的优缺点,需要根据具体的应用场景来选择合适的方法。

![[转载]图的拉普拉斯矩阵学习-Laplacian](https://uimg.taocdn.com/528874d72dc58bd63186bceb19e8b8f67c1cefa5.webp)

[转载]图的拉普拉斯矩阵学习-Laplacian Matrices of Graphs We all learn one way of solving linear equations when we first encounter linearalgebra: Gaussian Elimination. In this survey, I will tell the story of some remarkable connections between algorithms, spectral graph theory, functional analysisand numerical linear algebra that arise in the search for asymptotically faster algorithms.I will only consider the problem of solving systems of linear equationsin the Laplacian matrices of graphs. This is a very special case, but it is also avery interesting case. I begin by introducing the main characters in the story.1. Laplacian Matrices and Graphs. We will consider weighted, undirected,simple graphs G given by a triple (V,E,w), where V is a set of vertices, Eis a set of edges, and w is a weight function that assigns a positive weight toevery edge. The Laplacian matrix L of a graph is most naturally defined bythe quadratic form it induces. For a vector x ∈ IRV , the Laplacian quadraticform of G is:Thus, L provides a measure of the smoothness of x over the edges in G. Themore x jumps over an edge, the larger the quadratic form becomes.The Laplacian L also has a simple description as a matrix. Define theweighted degree of a vertex u by:Define D to be the diagonal matrix whose diagonal contains d, and definethe weighted adjacency matrix of G by:We haveL = D − A.It is often convenient to consider the normalized Laplacian of a graph insteadof the Laplacian. It is given by D−1/2LD−1/2, and is more closely related tothe behavior of random walks.Regression on Graphs. Imagine that you have been told the value of afunction f on a subset W of the vertices of G, and wish to estimate thevalues of f at the remaining vertices. Of course, this is not possible unlessf respects the graph structure in some way. One reasonable assumption isthat the quadratic form in the Laplacian is small, in which case one mayestimate f by solving for the function f : V → IR minimizing f TLf subjectto f taking the given values on W (see [ZGL03]). Alternatively, one couldassume that the value of f at every vertex v is the weighted average of f atthe neighbors of v, with the weights being proportional to the edge weights.In this case, one should minimize:|D-1Lf|subject to f taking the given values on W. These problems inspire manyuses of graph Laplacians in Machine Learning.。

给定团数的图的距离无符号拉普拉斯谱半径李金溪;杨墁;尤利华【摘要】设G是n阶简单连通图,T(G)表示图G的点传递度对角矩阵,D(G)表示距离矩阵,G的距离无符号拉普拉斯矩阵定义为:Q(G)=T(G)+D(G),相应的谱半径(即最大特征值)记作qD(G).图G中一个相互邻接的顶点子集称为G的一个团,定义G的团数为其最大团的顶点个数,记作ω(G).图G的一个正常着色是指使得G中任意2个相邻的顶点着不同颜色的一种着色方案.在G的所有正常着色中,所需颜色数目的最小值称为G的色数,记作X(G).显见,X(G)≥ω(G).为了研究给定团数ω(G)=ω的n 阶简单连通图G中取得最小距离无符号拉普拉斯谱半径的极图,文中综合运用代数、矩阵论与图论等方法,分如下2种情形进行讨论:(1)X(G)=ω(G)=ω;(2)X(G)>ω(G)=ω.证明了Turán图Ln.ω是团数为ω的n阶简单连通图中具有最小距离无符号拉普拉斯谱半径的唯一图.【期刊名称】《华南师范大学学报(自然科学版)》【年(卷),期】2016(048)006【总页数】6页(P118-123)【关键词】连通图;团数;距离无符号拉普拉斯谱半径【作者】李金溪;杨墁;尤利华【作者单位】华南师范大学数学科学学院,广州510631;华南师范大学数学科学学院,广州510631;华南师范大学数学科学学院,广州510631【正文语种】中文【中图分类】O151.21Key words: connected graph; clique number; distance signless Laplacian spectral radius关于图的距离谱半径的研究已经有很多年了,早期的工作可追溯到1978年[1],而距离无符号拉普拉斯谱半径是2013年才提出并研究的. 文献[2]刻画了树、单圈图和二部图中取得最小距离无符号拉普拉斯谱半径的极图,以及给定悬挂点或者连通度的连通图中取得最小距离无符号拉普拉斯谱半径的极图. 文献[3]得到了在双圈图中取得最小和第二小距离(距离无符号拉普拉斯)谱半径的极图. 2015年,文献[4]证明了图的最大、第二大距离拉普拉斯特征值和第二大距离无符号拉普拉斯特征值的猜想[5],DAS[6]证明了树中(最大度为n-2 的一棵n阶树)是取得第二小距离无符号拉普拉斯谱半径的极图.另一方面,关于给定团数的图或有向图的谱半径、拉普拉斯或无符号拉普拉斯谱半径的研究,请参看文献[7-13].所使用的方法技巧得益于文献[7]的启发,刻画了给定团数的连通图中取得最小距离无符号拉普拉斯谱半径的极图.设M是n×n矩阵,1,2,…,n为M的特征值. 一般来说,M不是对称矩阵,所以其特征值可能是复数. 不妨假设|1|≥|2|≥…≥|n|. 把M的特征值的模的最大值|1|定义为M 的谱半径,记为ρ(M). 由Perron-Frobenius定理可知:若M是非负矩阵,则其谱半径ρ(M)是M的一个特征值; 若M是非负不可约矩阵,则其谱半径ρ(M)=1是单根. 设G=(V(G),E(G))是连通图,其顶点集为V(G)={v1,v2,…,vn},边集为E(G). 对于任意的u,vV(G),以G中连接u、v的最短路的长度表示u、v两者之间的距离,记作dG(u,v)或duv. 对于任意的uV(G),以顶点u到G中其他所有顶点的距离的和表示顶点u 的传递度(transmission),记作TG(u). 如果G中所有点的传递度相等,即TG(v1)=TG(v2)=…=TG(vn),称图G是距离正则图.G的距离矩阵是n×n矩阵,记作D(G)=(dij),其中dij=dvivj. 显见,连通图G 的距离矩阵是非负不可约矩阵,其距离谱半径定义为其距离矩阵D(G)的谱半径,即为D(G)的最大特征值,记作ρD(G). 事实上,顶点vi的传递度TG(vi)是D(G)的第i行的行和,其中1≤i≤n. 称对角矩阵T(G)=diag(TG(v1),TG(v2),…,TG(vn))为G的点传递度对角矩阵. AOUCHICHE和HANSEN[5]定义G 的距离无符号拉普拉斯矩阵为:Q(G)=T(G)+D(G). 显见Q(G)是非负不可约的、对称的、半正定的. 定义连通图G 的距离无符号拉普拉斯谱半径是其距离无符号拉普拉斯矩阵Q(G)的谱半径,即为Q(G)的最大特征值,记作qD(G).V(G)中相互邻接的顶点子集是图G的一个团,定义G中最大团的顶点个数为G 的团数,记作ω(G). 定义图G 的一个正常着色是指使得G中任意2个相邻的顶点着不同颜色的一种着色方案. 在G的所有正常着色中,所需颜色数目的最小值称为G的色数,记作(G). 由于G包含一个大小为ω(G)的团,所以至少需要ω(G)种颜色来给G 正常着色,因此(G)≥ω(G).以Kn表示n阶完全图,顶点划分为V1,V2,…,Vr的完全r部图记作K|V1|,|V2|,…,|Vr|. 如果某个n阶完全r部图的顶点划分满足其每个部分的顶点个数尽可能相等,则称其为Turn图,记作Tn,r. 显然ω(Tn,r)=r.其他的定义、术语以及未提到的符号可参看文献[14-20].给出基本符号和定义后,紧接着寻求和证明在给定团数的连通图中取得最小距离无符号拉普拉斯谱半径的极图.以下所考虑的图G为n阶简单连通图,其顶点集为V(G)={v1,v2,…,vn},边集为E(G),显见Q(G)=(qij)是不可约的、非负的、对称的和半正定的. 由Perron-Frobenius 定理,qD(G)是单根并且有一个正的单位特征向量x=(x1,x2,…,xn)Tn与之对应,这里x被称作Q(G)的Perron向量. 从而,由和Q(G)x=qD(G)x,易得.定义1[16]26 设A=(aij)、B=(bij)是n×n阶矩阵. 如果对于所有的i和j都有aij≤bij,记作A≤B. 如果A≤B并且A≠B,记作A<B. 如果对于所有的i和j都有aij<bij,记作A≪B.引理1[16]27 设A、B为n×n非负矩阵,其谱半径分别为ρ(A)、ρ(B). 如果A≤B,则ρ(A)≤ρ(B). 此外,如果A<B且B是不可约,则ρ(A)<ρ(B).根据引理1及Q(G)和qD(G)的定义,可得以下以图的语言来描述的推论.推论1 设G是n阶图,H是G的生成子图,H和G均是连通的. 则(i) qD(H)≥qD(G).(ii) 如果H是G的真子图,则qD(H)> qD(G).推论2[2]1379 设G为连通图,u、v是G中任意2个不邻接的顶点,G+uv表示G 添加边uv,则qD(G+uv)<qD(G).引理2 设G为连通图,x=(x1,x2,…,xn)T是Q(G)的Perron向量,NG(v)是G中与顶点v相邻的点集,vr,vsV(G). 若NG(vr)\{vs}=NG(vs)\{vr},则xr=xs.证明记U=V(G)\{vr,vs}. 由NG(vr)\{vs}=NG(vs)\{vr}及G的连通性,可知对任意的vtU有drt=dst,进而,由可得TG(vr)=TG(vs).注意到故(qD(G)+drs-TG(vr))(xr-xs)=0.再由qD(G)>TG(vr),可得xr=xs.引理3 设G是n阶连通图,其团数为ω(G)=ω. 若其色数(G)=ω(G)=ω,则qD(G)≥qD(Tn,ω),且等式成立当且仅当G≅Tn,ω.证明以Fn,ω表示所有色数等于ω 的n 阶图的集合. 不妨设GFn,ω是所有色数为ω的n阶图中具有最小距离无符号拉普拉斯谱半径的图. 下面将证明G≅Tn,ω.由于添加边会减小距离无符号拉普拉斯谱半径,所以G必定是完全ω部图. 令V1,V2,…,Vω 是V(G) 的一个划分使得G=K|V1|,|V2|,…,|Vω|. 不失一般性,对任意的k{1,2,…,ω},假设|Vk|=nk,且|V1|≤|V2|≤…≤|Vω|.如果对任意1≤i<j≤ω,都有||Vi|-|Vj||≤1,则G≅Tn,ω. 否则,存在i,j{1,2,…,k}使得||Vi|-|Vj||>1. 不失一般性,假设|V1|≤|V2|-2(即n1≤n2-2). 记H=K|U1|,|U2|,…,|Uω|,这里U1=V1∪{u},其中uV2,U2=V2\{u}且对任意的k{3,…,ω},均有Uk=Vk(图1). 显见HFn,ω. 下面,将证明qD(G)>qD(H).设y为Q(H)的Perron向量. 由引理2可知Uk 的所有顶点具有相同的Perron分量. 用yk表示Uk 中顶点的Perron分量,其中k=1,2,…,ω. 显见,由于Perron向量y≫0,故对任意的k{1,2,…,ω}有yk>0. 注意到对任意viV1,有 dG(u,vi)-dH(u,vi)=-1成立,对任意vjV2\{u}=U2, 有dG(u,vj)-dH(u,vj)=1成立,且对任意的点对vs和vt,有dG(vs,vt)-dH(vs,vt)=0成立,故以下几个结论成立: (1) TG(u)-TH(u)=n2-n1-1;(2)对任意viV1,有TG(vi)-TH(vi)=-1;(3)对任意vjV2\{u}=U2,有TG(vj)-TH(vj)=1;(4)对任意vtV(G)\(V1∪V2),有TG(vt)-TH(vt)=0.再由n1≤n2-2<n2-1,瑞利商定理[17]及上述结论(1)~(4),可得qD(G)-qD(H)≥yT(Q(G)-Q(H))y=).下面证明y2≥y1. 注意到qD (H)y1=(n+n1-1)y1+2n1y1+(n2-1)y2+∑k=3,4,…,ωnkyk,∑k=3,4,…,ωnkyk,则从而,再由n1≤n2-2可得y2≥y1.综上,,这与G的定义矛盾.设G是n阶连通图,其团数为ω(G)=ω. 下面分几种情形讨论:(i) ω|n; (ii) ω>n/2; (iii) ω<n/2且(G)>ω(G)=ω. 分别证明qD(G)≥qD(Tn,ω),且等式成立当且仅当引理4(Turn’s Theorem)[7]387 设G是不含ω+1团的n阶连通图,则G的边数e(G)≤e(Tn,ω),且等式成立当且仅当G≅Tn,ω.设G为n阶连通图,G的Wiener指数是指G中所有点对的距离之和,记作σ(G). 易见,).引理5[3]3957 设G是n阶连通图,则q(G)≥4σ(G)/n,且等式成立当且仅当G 是距离正则图.引理6 设G是n阶连通图,其团数为ω(G)=ω,则(i)qD(G)≥4σ(Tn,ω)/n,且等式成立当且仅当G≅Tn,ω.(ii)若ω|n,则qD(G)≥qD(Tn,ω)=2(n+n/ω-2),且等式成立当且仅当G≅Tn,ω.证明易见G有e(G)个点对距离为1,并且有-e(G)个点对距离大于等于2. 若GTn,ω,由引理4可知).再由引理5,得因此(i)成立.若ω|n,则Tn,ω是距离正则的,从而,且). 再由(i)知(ii)成立.设ω、n是正整数且ω<n,定义G(|V1|,|V2|,…,|Vω|)是满足如下条件的n阶图:(1)完全图Kω是它的真子图,其中V(Kω)={v1,v2,…,vω};(2)完全图Kn-ω是它的真子图,其中V(Kn-ω)=V1∪V2∪…∪Vω,这里|V1|≤|V2|≤…≤|Vω|且对任意的k{1,2,…,ω},连接vk与V(Kn-ω)\Vk中的每一个顶点(图2). 显然G(|V1|,|V2|,…,|Vω|)是连通的. 若ω>n/2,则某些Vk可能为空集. 易见G(0,0,…,0,1,1,…,1)≅Tn,ω.令}. 若ω>n/2,可以看到,在n,ω中除了Tn,ω之外,其他图的团数都大于ω. 下面将证明Tn,ω是n,ω中具有最小距离无符号拉普拉斯谱半径的惟一图.引理7 设ω、n为正整数且ω>n/2,Gn,ω,则qD(G)≥qD(Tn,ω),且等式成立当且仅证明不妨设H=G(|V1|,|V2|,…,|Vω|)是集合n,ω 中具有最小距离无符号拉普拉斯谱半径的图. 若HG(0,0,…,0,1,1,…,1),那么必存在某个k{1,2,…,ω}使得|Vk|≥2. 不失一般性,我们假设i是最小的指数使得|Vi|=ni≥2,j是最大的指数使得Vj=∅(事实上,这样的j一定存在,因为令H1=G(|U1|,|U2|,…,|Uω|),其中V(Kω)={v1,v2,…,vω},U=U1∪ U2∪…∪Uω=V(Kn-ω),且存在某个顶点uVi 使得Ui=Vi\{u}, Uj={u},而对任意的k{1,2,…,ω}\{i,j}均有Uk=Vk(图3). 显见,H1n,ω.下面证明qD(H)>qD(H1). 令y是Q(H1)的Perron向量且分量yvk对应顶点vk(k=1,2,…,ω),由引理2,Uk的所有顶点有相同的Perron分量,并且用yk表示Uk 中的顶点的Perron分量,其中k=1,2,…,ω. 很显然,由y≫0 可知对任意的k=1,2,…,ω,有yk>0 且yvk>0. 注意到dH(u,vi)-dH1(u,vi)=1,dH(u,vj)-dH1(u,vj)=-1,对任意的点对s和t,dH(s,t)-dH1(s,t)=0,且TH(vi)-TH1(vi)=1,TH(vj)-TH1(vj)=-1,对任意的点v,TH(v)-TH1(v)=0. 从而由瑞利商定理,可得qD(H)-qD(H1)≥yT(Q(H)-Q(H1))y=(yvi+yvj+2yj)(yvi-yvj).下面证明yvi≥yvj. 注意到,,从而,qD(H1)(yvi-yvj)=(n+ni-3)yvi-(n-1)yvj+(ni-1)yi-yj. 又由ni≥2 可知n+ni-3≥n-1,ni-1≥1,因此另一方面,注意到,,从而由式(1)和式(2),可得由qD(H1)>n,有从而yvi≥yvj,进而qD(H)≥qD(H1).若qD(H)=qD(H1),则yvi=yvj,yi=yj且y也是Q(H)的Perron向量. 所以,0=qD(H)(yvi-yvj)=(n+ni-2)yvi-(n-2)yvj+niyi>0,矛盾. 因此,qD(H)>qD(H1),这也与H 的定义矛盾. 证明完毕.引理8 设G是团数ω(G)=ω的n阶连通图. 若ω>n/2,则qD(G)≥qD(Tn,ω),且等式成立当且仅当G≅Tn,ω.证明设U={v1,v2,…,vω}是G的一个团,且记W=V(G)\U. 由于团数ω(G)=ω,从而对于V中的任意顶点来说,其最多有ω-1个邻点在U中. 这就意味着在图的同构的意义下,存在W的某个划分V1∪V2∪…∪Vω,使得G是G(|V1|,|V2|,…,|Vω|)的生成子图. 再由推论1和引理7,有qD(G)≥qD(G(|V1|,|V2|,…,|Vω|))≥qD(Tn,ω),且等式成立当且仅当G≅Tn,ω.引理9 设ω、n为正整数且ω≤n,则x1=q-(n+2k-4)q-(n+2k-2)x2.由式(4)和式(6),可得q2-(3n+4k-6)q+(2n2+4k2-10n-12k+4nk+2k2ω+2kω+8)=0.解方程(7),易见式(3)成立.令ω=n,由引理9可得推论3[5]30 qD(Kn)=2n-2.引理10[21] 设G是团数ω(G)≤ω的n阶连通图. 若(G)>ω且,则e(G)≤e(Tn,ω)-⎣.引理11 设G是团数ω(G)=ω的n阶连通图. 若(G)>ω且ω<n/2,则qD(G)≥qD(Tn,ω),且等式成立当且仅当G≅Tn,ω.证明令k=⎣,且GTn,ω. 下面证明qD(G)>qD(Tn,ω).由引理5和引理10,可得.显见e(Tn,ω)=(n2-n-2nk+k2ω+kω)/2,因此有为了证明qD(G)>qD(Tn,ω),由式(3)和式(8),只需证明.化简式(9),接下来证明nk(k+1)(n-ω-2kω)+[(k2ω+kω)-2(k-1)]2+(k-1)(n2+2n+4nk)>0.令n=kω+k0,其中0≤k0<ω. 那么由式(10),有4(k-1)2+kω[(k-1)(kω-2)+k0(k-3)]+(k2+2k-1)k02+2k0(2k+1)(k-1)>0.为了证明式(11)是正确的,需证注意到ω<n/2,从而k≥2. 由k≥2和k0<ω可知式(12)是正确的.定理1 设G是n阶连通图,其团数为ω(G)=ω,则qD(G)≥qD(Tn,ω),且等式成立当且仅当G≅Tn,ω.证明因为色数(G)≥ω(G)=ω,可以分以下情形来证明.情形1:(G)=ω(G). 此时,由引理3可知结论成立.情形2: (G)>ω(G).子情形2.1: ω=n/2. 此时,由引理6可知结论成立.子情形2.2: ω>n/2. 此时,由引理8可知结论成立.子情形2.3: ω<n/2. 此时,由引理11可知结论成立.结合以上情形的讨论,结论证明完毕.【相关文献】[1] GRAHAM R L,LOVSZ L. Distance matrix polynomials of trees[J]. Department of Mathematics,1978,29:60-88.[2] XING R D,ZHOU B,LI J P. On the distance signless Laplacian spectral radius of graphs[J]. Linear and Multilinear Algebra,2014,62:1377-1387.[3] XING R D,ZHOU B. On the distance and distance signless Laplacian spectral radii of bicyclic graphs[J]. Linear Algebra and Its Applications,2013,439:3955-3963.[4] TIAN F L,WONG D,ROU J L. Proof for four conjectures about the distance Laplacian and distance signless Laplacian eigenvalues of a graph[J]. Linear Algebra and Its Applications,2015,471:10-20.[5] AOUCHICHE M,HANSEN P. Two Laplacians for the distance matrix of a graph[J]. Linear Algebra and Its Applications,2013,439:21-33.[6] DAS K C. Proof of conjectures on the distance signless Laplacian eigenvalues of graphs[J]. Linear Algebra and Its Applications,2015,467:100-115.[7] ZHAI M Q,YU G L,SHU J L. Clique number and distance spectral radii of graphs[J]. Ars Combinatoria,2012,104:385-392.D,HANSEN P. The minimum spectral radius of graphs with a given clique number[J]. Electron Journal of Linear Algebra,2008,17:110-117.[9] LIN H Q,SHU J L,WU Y R,et al. Spectral radius of strongly connected digraphs[J]. Discrete Mathematics,2012,312:3663-3669.[10]GUO J M,LI J X,SHIU W C. The smallest Laplacian spectral radius of graphs with a given clique number[J]. Linear Algebra and Its Applications,2012,437:1109-1122.[11]HE B,JIN Y L,ZHANG X D. Sharp bounds for the signless Laplacian spectral radius in terms of clique number[J]. Linear Algebra and Its Applications,2013,438:3851-3861.[12]ZHANG J M,HUANG T Z,GUO J M. The smallest signless Laplacian spectral radius of graphs with a given clique number[J]. Linear Algebra and ItsApplications,2013,439:2562-2576.[13]HONG W X,YOU L H. Spectral radius and signless Laplacian spectral radius of strongly connected digraphs[J]. Linear Algebra and Its Applications,2014,457:93-113.[14]BONDY J A,MURTY U S R. Graph theory with applications[M]. London:Macmillan,1976.[15]BONDY J A,MURTY U S R. Graph theory[M]. New York:Springer,2008.[16]BERMAN A,ROBERT J P. Nonnegative matrices in the mathematical sciences[M]. New York:Academic Press,1979.[17]HORN R A,JOHNSON C R. Matrix analysis[M]. England:Cambridge University,1986.[18]MINC H. Nonnegative matrices[M]. New York:John Wiley and Sons Inc,1988.[19]JENSEN J B,GUTIN G. Digraphs theory[M]. New York:Springer,2001.[20]BOLLOBS B. Extremal graph theory[M]. New York:Academic Press,1978.[21]KANG M,PIKHURKO O. Maximum Kr+1-free graphs which are not r-partite[J]. Matematychni Studii,2005,24:13.。

拉普拉斯分块矩阵公式知乎拉普拉斯分块矩阵公式是一种用于解决线性方程组的方法。

它通过将矩阵分解为较小的子矩阵,并对这些子矩阵进行操作,从而简化了求解过程。

本文将介绍拉普拉斯分块矩阵公式的原理和应用。

拉普拉斯分块矩阵公式的原理是基于矩阵分块的思想。

在线性代数中,矩阵分块是一种将一个大矩阵拆分成若干个小矩阵的方法。

通过将矩阵分块,我们可以利用小矩阵的性质来简化计算。

在拉普拉斯分块矩阵公式中,我们将待求解的矩阵表示为一个特殊的形式,即拉普拉斯矩阵。

拉普拉斯矩阵是一个对角线元素全为0,其余元素由子矩阵组成的矩阵。

通过对拉普拉斯矩阵进行分块,并对子矩阵进行操作,我们可以得到线性方程组的解。

拉普拉斯分块矩阵公式的应用非常广泛。

它可以用于求解线性方程组、计算矩阵的行列式和逆矩阵、求解特征值和特征向量等。

在实际应用中,我们经常会遇到大型的线性方程组,而拉普拉斯分块矩阵公式可以有效地简化计算过程,提高求解效率。

为了更好地理解拉普拉斯分块矩阵公式的原理和应用,我们可以通过一个具体的例子来说明。

假设我们有一个3x3的线性方程组,形式为Ax=b,其中A是一个未知的3x3矩阵,x和b是已知的向量。

我们可以将A和b分别表示为拉普拉斯矩阵的形式,即A=|A11 A12 A13|,b=|b1|,其中A11、A12、A13、b1都是已知的子矩阵或向量。

根据拉普拉斯分块矩阵公式的原理,我们可以将方程组分解为若干个小的线性方程组。

在这个例子中,我们可以将原方程组分解为3个2x2的线性方程组,形式为:A11x1 + A12x2 = b1A21x1 + A22x2 = b2A31x1 + A32x2 = b3通过求解这些小的线性方程组,我们可以得到原方程组的解x。

在实际应用中,我们可以利用矩阵的性质和运算规则,通过对子矩阵进行操作,进一步简化计算过程。

总结一下,拉普拉斯分块矩阵公式是一种用于解决线性方程组的方法。

它通过将矩阵分解为较小的子矩阵,并对这些子矩阵进行操作,从而简化了求解过程。

自适应谱聚类算法研究

自适应谱聚类算法是谱聚类算法的一种改进方法,旨在解决传统谱聚类算法对于数据集的参数选择敏感的问题。

传统的谱聚类算法将数据集转化成一个图的拉普拉斯矩阵,然后对该矩阵进行特征值分解,得到特征向量,最后通过K-means聚类算法对特征向量进行聚类。

传统谱聚类算法的关键

在于如何选择图的邻接矩阵和拉普拉斯矩阵的参数,例如领域的大小、相似度的度量等。

自适应谱聚类算法通过自适应选择参数,降低了对参数选择的依赖性。

具体而言,自适应谱聚类算法首先对原始数据集进行降维处理,以减少计算复杂度和避免维度灾难。

然后,通过计算相似度矩阵,选择合适的邻接矩阵和拉普拉斯矩阵的参数。

最后,对特征向量进行K-means聚类,得到最终的聚类结果。

自适应谱聚类算法的优点是能够自动选择参数,减少了人工调参的工作量,同时可以根据不同的数据集选择最佳的参数,提高了聚类算法的性能。

然而,该算法的缺点是计算复杂度较高,需要进行降维和计算相似度矩阵等操作。

总的来说,自适应谱聚类算法是一种改进的谱聚类算法,通过自适应选择参数,提高了聚类算法的性能和适用性。

在实际应用中,可以根据具体情况选择合适的谱聚类算法来解决聚类问题。

一些图的(无符号)拉普拉斯谱及其应用引言:图论作为一门探究图的性质和结构的学科,已经广泛应用于许多领域,如社交网络分析、图像处理、数据开掘等。

而拉普拉斯矩阵是图论中重要的工具之一,它能够刻画图的性质和特征。

本文将介绍一些图的(无符号)拉普拉斯矩阵的基本观点和性质,并探讨其在图论中的应用。

一、无符号拉普拉斯矩阵的定义无符号拉普拉斯矩阵是描述无向图拓扑结构的矩阵,它由度矩阵和邻接矩阵计算得出。

设G=(V,E)是一个无向图,其中V是顶点集合,E是边集合。

图的度矩阵D是一个对角矩阵,其对角元素为每个顶点的度数,邻接矩阵A是一个对称矩阵,其元素a_ij表示顶点i和顶点j之间是否存在边。

无符号拉普拉斯矩阵L定义为L=D-A。

二、无符号拉普拉斯矩阵的性质1. 零空间:无符号拉普拉斯矩阵的零空间由全部满足Lx=0的向量x组成。

零空间的维度等于图的连通重量数目,可以用于裁定图的连通性。

2. 特征值和特征向量:无符号拉普拉斯矩阵的特征值是非负实数,且有一个特殊的特征值0。

对应于0特征值的特征向量x=(x_1,x_2,...,x_n)满足Lx=0,即存在一组非零向量满足Ax=b,其中b=(x_1,x_2,...,x_n)。

其他非零特征值对应的特征向量可以用来描述图的结构特征。

3. 广义拉普拉斯算子:无符号拉普拉斯矩阵的广义拉普拉斯算子定义为Lf=D^{-1/2}LD^{-1/2},其中D^{-1/2}是度矩阵D的平方根的逆矩阵。

广义拉普拉斯算子具有与无符号拉普拉斯矩阵类似的性质,但更适用于权重图。

三、无符号拉普拉斯谱的应用1. 图划分:无符号拉普拉斯矩阵的特征向量可以用于图划分问题。

通过找到特征向量对应的分界点,可以将图分成两个或多个连通子图,从而实现图的分割。

2. 图嵌入:无符号拉普拉斯矩阵的特征向量可以用于图的嵌入问题。

通过选择特征向量作为特征空间的基,可以将图的节点映射到低维空间中,从而实现图的可视化和降维。

3. 图聚类:无符号拉普拉斯矩阵的特征向量可以用于图聚类问题。

半监督学习中的半监督聚类算法详解半监督学习是一种介于监督学习和无监督学习之间的学习范式,它利用带有标签的数据和未标签的数据来进行学习。

半监督学习在现实生活中有着广泛的应用,尤其在数据挖掘和机器学习领域中扮演着重要的角色。

在半监督学习中,半监督聚类算法是其中的一个重要分支,它旨在利用少量的标记样本和大量的未标记样本来进行聚类。

半监督聚类算法的核心思想是将已标记的数据点和未标记的数据点同时考虑在内,通过一定的方式来实现对数据的聚类。

在半监督聚类算法中,一些经典的算法如拉普拉斯特征映射(Laplacian Eigenmaps)、谱聚类(Spectral Clustering)和半监督K均值(Semi-Supervised K-means)等都有较为成熟的应用和理论基础。

首先,让我们来详细了解一下拉普拉斯特征映射算法。

拉普拉斯特征映射算法是一种基于图的半监督聚类算法,它通过构建数据点之间的相似度图,并利用这个图的拉普拉斯矩阵进行特征分解来实现聚类。

具体来说,拉普拉斯矩阵包括度矩阵和相似度矩阵,通过对拉普拉斯矩阵进行特征分解,可以得到数据点的特征向量,利用这些特征向量来进行聚类。

在实际应用中,拉普拉斯特征映射算法能够有效地处理高维数据和非线性数据,并且具有较好的稳健性和鲁棒性。

其次,谱聚类算法也是半监督聚类中的一个重要方法。

谱聚类算法同样是基于图的聚类方法,它通过对数据点之间的相似度矩阵进行特征分解来实现聚类。

谱聚类算法的核心思想是将数据点投影到低维空间中,然后利用这个低维空间中的数据点来进行聚类。

谱聚类算法在处理大规模数据和复杂数据时具有较好的效果,尤其在图像分割和文本聚类等领域有着广泛的应用。

最后,半监督K均值算法是一种基于K均值的半监督聚类方法。

K均值算法是一种经典的无监督聚类算法,它通过不断地迭代更新簇中心来实现聚类。

在半监督K均值算法中,除了利用未标记数据进行簇中心的更新外,还可以利用标记数据来指导聚类的过程。

分块矩阵的拉普拉斯定理分块矩阵是一种将矩阵按照块分割成多个子矩阵的方法。

这种方法在高维数据的处理中非常常见,可以快速地对一个大型矩阵进行分析和操作。

而其中的拉普拉斯定理则是对分块矩阵中的边界点进行加权平均的一种定理,它非常有用,可以用来求解各种问题。

下面我们就来详细探讨一下分块矩阵的拉普拉斯定理。

一、分块矩阵的基础在我们深入讨论拉普拉斯定理之前,我们需要先了解一些基本概念。

分块矩阵是一种非常特殊的矩阵,它将一个大型的矩阵按照一定的规则分割成多个小矩阵。

分块矩阵的一个典型例子就是二维矩阵的分块。

假设我们有一个5×5的矩阵A,我们可以将它分成四个2×2的小矩阵A11、A12、A21、A22,如下所示:$$A=\begin{pmatrix} A_{11} & A_{12}\\ A_{21} & A_{22}\\ \end{pmatrix}$$这样的分块矩阵一般用来处理高维数据,因为在计算机视觉、机器学习等领域,经常需要对大量的图像或数据进行快速处理。

而按照块状分割的方法可以大大提高效率,减少计算量。

二、拉普拉斯矩阵当我们将矩阵按照块分割后,便可以进一步探讨拉普拉斯矩阵的概念了。

拉普拉斯矩阵可以理解为一种描述矩阵之间相互关系的矩阵,它的本质是一种偏微分算子。

在二维空间中,它的形式如下:$$L=\begin{pmatrix} D- W_1 & W_2 & \cdots &W_k\\ W_1 & D - W_2 & \cdots & W_k\\ \vdots &\vdots & \ddots & \vdots\\ W_1 & W_2 &\cdots & D - W_k\\ \end{pmatrix}$$其中,$D$是一个对角矩阵,$D_{ii}$表示第$i$个节点的度数(度数即节点相邻边的条数),$W_i$是一个和$D$一样大小的矩阵,$W_{ij}$表示第$i$个节点和第$j$个节点之间的边的权重。

拉普拉斯分块矩阵公式概述说明引言是一篇文章的开头部分,它提供了读者对整篇文章的概述。

在本文中,引言将主要涵盖三个方面:概述、文章结构和目的。

1.1 概述拉普拉斯分块矩阵公式是一种重要的数学工具,在各个领域中广泛应用。

它以其独特的定义和特点被广泛引用,并且在实际问题中有着广泛的应用价值。

本文将详细介绍拉普拉斯分块矩阵公式的定义、特点、构建方法以及在实际问题中的应用案例。

1.2 文章结构本文共分为五个主要部分:引言、拉普拉斯分块矩阵公式、构建拉普拉斯分块矩阵公式的方法、拉普拉斯分块矩阵公式在实际问题中的应用举例以及结论与展望。

引言部分为全文开篇,介绍了本文所涉及内容和结构;第二部分将详细讲解拉普拉斯分块矩阵公式的定义、特点和应用领域;接着,第三部分将介绍构建这一公式所使用到的基础方法、图论方法以及简化计算步骤的技巧;之后,第四部分将重点介绍拉普拉斯分块矩阵公式在网络分析、信号处理和优化问题求解等实际问题中的应用案例;最后,第五部分将对全文进行总结,并对未来发展方向进行展望。

1.3 目的本文旨在提供关于拉普拉斯分块矩阵公式的详尽说明,使读者对该数学工具有更深入的了解。

通过介绍其定义、特点、构建方法和应用案例,读者将能够理解为何拉普拉斯分块矩阵公式在不同领域中被广泛使用,并且可能得到启发,将其运用到自己的实际问题中。

此外,本文还会对未来该领域的发展进行一定的预测与展望。

以上是引言部分的内容表述,在接下来的文章中,将会深入探讨这些方面,并给予进一步说明和案例支持。

2. 拉普拉斯分块矩阵公式2.1 定义拉普拉斯分块矩阵是指由多个子矩阵组成的复合矩阵,其中每个子矩阵都代表了系统中的一个子系统或者一个部分。

这些子矩阵通过对角线上的连接元素来进行关联,从而构成了一个整体的复合矩阵。

2.2 特点- 拉普拉斯分块矩阵具有模块化和层次性的特点,能够将大型问题拆解成若干个小问题进行处理,并且可以方便地对不同子系统进行扩展或者替换,从而提高了问题求解的灵活性和可行性。

图卷积神经网络(GCN)入门图卷积网络Graph Convolutional Nueral Network,简称GCN,最近两年大热,取得不少进展。

不得不专门为GCN开一个新篇章,表示其重要程度。

本文结合大量参考文献,从理论到实践,从由来到数学推导,讲述GCN的发展和应用。

综述在扎进GCN的汪洋大海前,我们先搞清楚GCN是做什么的,有什么用。

深度学习一直都是被几大经典模型给统治着,如CNN、RNN等等,它们无论再CV还是NLP领域都取得了优异的效果,而GCN主要是针对图结构的。

社交网络、信息网络中有很多类似的结构。

实际上,这样的网络结构(Non Euclidean Structure)就是图论中抽象意义上的拓扑图。

图的结构一般来说是十分不规则的,可以认为是无限维的一种数据,所以它没有平移不变性。

每一个节点的周围结构可能都是独一无二的,这种结构的数据,就让传统的CNN、RNN瞬间失效。

所以很多学者从上个世纪就开始研究怎么处理这类数据了。

这里涌现出了很多方法,例如GNN、DeepWalk、node2vec等等,GCN 只是其中一种。

图卷积神经网络,实际上跟CNN的作用一样,就是一个特征提取器,只不过它的对象是图数据。

GCN精妙地设计了一种从图数据中提取特征的方法,从而让我们可以使用这些特征去对图数据进行节点分类(nodeclassification)、图分类(graph classification)、边预测(link prediction),还可以顺便得到图的嵌入表示(graph embedding),可见用途广泛。

因此现在人们脑洞大开,让GCN到各个领域中发光发热。

我们直接看看GCN的核心部分:假设我们手头有一批图数据,其中有\(N\)个节点(node),每个节点都有自己的特征,我们设这些节点的特征组成一个\(N×D\)维的矩阵\(X\),然后各个节点之间的关系也会形成一个\(N×N\)维的矩阵\(A\),也称为邻接矩阵(adjacency matrix)。

矩阵分解拉普拉斯正则概述及解释说明1. 引言1.1 概述矩阵分解是一种重要的数学方法,用于将一个复杂的矩阵分解为多个简化的子矩阵,以便更好地理解和处理数据。

而拉普拉斯正则作为一种常见的正则化技术,则广泛应用于机器学习、数据挖掘等领域。

该正则化方法在保持模型泛化能力的同时,能够降低模型的过拟合风险。

1.2 文章结构本文将首先介绍矩阵分解的定义和背景知识,包括常见的矩阵分解方法及其应用领域。

接着,我们将详细讲解拉普拉斯正则化技术的原理与公式推导,并探讨其在机器学习中的具体应用。

随后,我们会对拉普拉斯正则化进行优缺点及改进方法的讨论。

最后,我们将概述和解释说明矩阵分解与拉普拉斯正则之间的关系,并通过实例来说明它们在实际问题中的作用和效果。

此外,我们也会对矩阵分解和拉普拉斯正则化存在的局限性和潜在问题展开讨论。

最后,我们将总结本文的主要研究结果,并提出对未来研究的建议。

1.3 目的本文的目的是全面概述和解释矩阵分解和拉普拉斯正则化技术,分析它们在不同领域中的应用,并探讨它们之间的关系。

通过对这些方法进行详细研究和讨论,旨在为读者深入了解矩阵分解和拉普拉斯正则化提供一定的理论基础和实践指导。

同时,在总结文章主要内容和提出未来研究建议之后,我们希望能够促进相关领域工作者们对这两种方法在实际问题中更深入、更广泛的应用探索。

2. 矩阵分解2.1 定义与背景矩阵分解是一种数学运算方法,用于将一个矩阵表示为几个小规模的矩阵相乘的形式。

它在数学、计算机科学和统计学领域有广泛的应用。

通过矩阵分解,我们可以将复杂的数据结构转化为易于处理和理解的形式。

2.2 常见的矩阵分解方法常见的矩阵分解方法包括奇异值分解(Singular Value Decomposition, SVD)、QR分解(QR Decomposition)、LU分解(LU Decomposition)等。

这些方法基于不同的原理和应用场景,能够帮助我们提取出矩阵中隐藏的信息,并进行数据压缩、特征提取等操作。

拉普拉斯特征向量

拉普拉斯特征向量是图论中的一个重要概念,它在图像处理、机器学习和计算机视觉等领域有广泛应用。

其本质是将图中的节点映射到一个低维向量空间中,使得节点之间的距离能够反映它们的相似性。

具体而言,拉普拉斯矩阵是一种对称正定矩阵,其特征向量和特征值能够描述图中的结构和性质。

通过求解拉普拉斯特征向量,可以进行图像分割、聚类、降维等操作,进一步挖掘图像的信息和特征。

同时,拉普拉斯特征向量也是许多机器学习算法的基础,如谱聚类、特征提取等。

因此,掌握拉普拉斯特征向量的理论和实现方法对于计算机科学和工程领域的学生和从业者来说具有重要意义。

- 1 -。

拉普拉斯矩阵特征值的图论意义第23卷第1期2006年3月江苏教育学院(自然科学版)JournalofJiangsuInstituteofEducation(NaturalSciences)V01.23No.1Mar..20o6拉普拉斯矩阵特征值的图论意义朱晓欣(南京信息工程大学数学系,江苏南京210044)摘要本文从线性代数的一道典型的特征值问题出发,首先给出其解题过程,然后介绍一些图的理论和拉普拉斯矩阵及其特征值的概念,最后从图论的角度给出该线性代数问题中两个等式的图论意义,从而得到本文中的两个结论.关键词拉普拉斯矩阵;特征值;图论设方阵为元素只能取0,1且主对角线元素均为0的n阶实对称矩阵,rg维列向量J=(1,1,…,1)且AJ=(d.,,…,d),定义对角矩阵D=diag(d,d2,…,d).若A是矩阵D—A的特征值,试证明:∑(A.)=∑(d+di).显然,这是一道考察矩阵的特征值问题.证明如下:设12维非零向量是矩阵D—A的对应于特征值A的特征向量,则有(D—A)X=fi.iX,对等式两边同时左乘矩阵D—A得到:(D—A)X=(D—a)aX=A[(D—A)X]=AX从而该式说明A是方阵(D—A)的特征值.由参考文献1可知,对任意一个n阶方阵C=(e)…,若A.是其特征值,则有∑A:护(c)=∑c于是,我们有:若A是D—A的特征值,则有∑A=打(D—A),打(D—A)=∑d,从而有n∑d(1)i=l考察方阵(D—A)的对角线元素,记=D—A=()…,L2=(D—A)=('')…则有:(D—A)=D.+A一DA—AD,其中两个方阵DA,AD的对角线元素均为零,记A=(.)…,A=(')…,则n"''=∑.o=k=1=d所以l=d+d,且∑(J)L).=tr((D—A)),从而有∑(A)=∑(十di)(2)下面我们来看看(1),(2)两个式子在图论中的意义.图论中的"图"指的是有序的三元组G=(V,E,),其中是图G的顶点集,E是图G的边集,是图G的关联函数,即从E到V中的顶点对构成的集合的映射,在现实世界中,我们可以用图中的顶点集合表示我们所研究的对象的集合,则边集E就可以是我们所研究的这些对象之间的二元关系,从而我们在研究一些二元关系时就可以用图论的方法来考虑,所以我们可以尝试着从图论的角度来理解一些问题甚至解决一些问题.若图中任两点之间无重边且不含环(端点重合的边),则称为简单图.下面我们考虑简单图G:(V,E),其中V=,,…,},E={e,e,…,e},用d表示与顶点相连的边的数目,称为顶点.的度,A(G)=(.)…表示图G的邻接矩阵,其中f1与∥相邻时【0与,不相邻或i=J时一】9一D(G)=diag(d,d2,…,d),(G)是图G的拉普拉斯矩阵,(G)=(G)一(G)若图G中的边数记为(G),由于每条边在计算度时被重复计算了一次,从而有2e(G)=∑di=I至此,由上述相关的图论概念有等式(1)的图论意义:结论1:对于方阵=D—(其中,A,D的定义与前述一致),∑Al:l=∑d即表示以A为邻接矩阵的简单图G,其拉普拉斯i=i矩阵的的特征值的和等于该简单图中边的数目的两倍,即∑A.=2s(G).下面我们继续讨论,图G的线图是指其顶点集是(G),且两点相连当且仅当它们在图G中是相邻的边,令G表示图G的线图,则图G有∑1dc()(d()一1)条边(参考文献2).I)厶从而,我们可以给出等式(2)的图论意义:结论2:对于方阵L=D—A,∑(A)=∑(d.+di)即表示以A为邻接矩阵的简单图G,其拉普拉斯矩阵的特征值的平方和等于该简单图的边数目的四倍与该图对应的线图G中边的数目的两倍的和,即∑(A.).=48(G)+2s(G,).参考文献1北京大学数学系几何与代数教研室代数小组编.高等代数.北京:高等教育出版社,1988.302~3032BondyJAandMurtyUSR.GraphTheorywithApplication[M].THEMACMIH~ANPRE SSLTD,1976.115~120placiangrapheigenvectors.LinearAlgebraAppl,1998.278,221—236 TheGraphMeaningofLaplacianMatrixEigenvalueZHUXiaoxin(NanjingUniversityofInformation~ience&Technology,Jiangsu,Nanjing210044) AbstractInthispaper,throughalinearalgebraproblemwegettwoequalitiesabouttheeigenva luesofLaplacianmatrix.Firstly,wefindthesolutionofthisproblem.Thenweintroducesoftiegraphtheo~andthedefinitionofIzplacianmatrix.Atla stwegettwoconclusionsofthetwoequ~itieswithgraphthe—ory?KeywordsLaplaeianmatrix,eigenvalue,graphytheorem(责任编辑仇惠玲) 一20—。

内容来自wikipedia链接为/wiki/Laplacian_matrix图的拉普拉斯矩阵1. In the mathematical field of graph theory , the Laplacian matrix , sometimes called admittance matrix , Kirchhoff matrix or discrete Laplacian , is a matrix representation of a graph . Together with Kirchhoff's theorem , it can be used to calculate the number of spanning trees for a given graph. The Laplacian matrix can be used to find many other properties of the graph. Cheeger's inequality from Riemannian geometry has a discrete analogue involving the Laplacian matrix; this is perhaps the most important theorem in spectral graph theory and one of the most useful facts in algorithmic applications. It approximates the sparsest cut of a graph through the second eigenvalue of its Laplacian.2.定义Given a simple graph G with n vertices, its Laplacian matrix nn L⨯ is defined as:A D L -=,where D is the degree matrix and A is the adjacency matrix of the graph. In the case of directed graphs , either the indegree or outdegree might be used, depending on the application.The elements of L are given bywhere deg(v i ) is degree of the vertex i .The symmetric normalized Laplacian matrix is defined as:The elements ofare given byThe random-walk normalized Laplacian matrix is defined as:The elements of are given by3.例子Here is a simple example of a labeled graph and its Laplacian matrix. Labeled graphDegree matrixAdjacency matrixLaplacian matrix4.性质For an (undirected) graph G and its Laplacianmatrix L with eigenvalues∙L is symmetric.∙L is positive-semidefinite (that is for all i). This is verified in the incidence matrix section (below). This can also be seen from the fact that the Laplacian is symmetric and diagonally dominant.∙L is an M-matrix (its off-diagonal entries are nonpositive, yet the real parts of its eigenvalues are nonnegative).∙Every row sum and column sum of L is zero. Indeed, in the sum, the degree of the vertex is summed with a "-1" for each neighbor∙Inconsequenc, because the vector satisfies∙T he number of times 0 appears as an eigenvalue in the Laplacian is the number of connected components in the graph.∙The smallest non-zero eigenvalue of L is called the spectral gap.∙The second smallest eigenvalue of L is the algebraic connectivity (or Fiedler value) of G.∙When G is k-regular, the normalized Laplacian is: , where A is the adjacency matrix and I is an identity matrix.5.L关联矩阵Define an||||ve⨯ oriented incidence matrix M with element M ev for edge e (connecting vertex i and j, with i > j) and vertex v given byThen the Laplacian matrix L satisfieswhere is the matrix transpose ofMNow consider an eigendecomposition of L,with unit-norm eigenvectors i v and corresponding eigenvalues iλBecause iλ can be written as the inner product of the vector i Mv with itself, this shows that and so the eigenvalues of L are all non-negative6.变形的拉普拉斯The deformed Laplacian is commonly defined aswhere I is the unit matrix, A is the adjacency matrix, and D is the degree matrix, and s is a (complex-valued) number. Note that the standard Laplacian is just .7.对称的正规拉普拉斯矩阵The (symmetric) normalized Laplacian is defined aswhere L is the (unnormalized) Laplacian, A is the adjacency matrix and D is the degree matrix. Since the degree matrix D is diagonal and positive, its reciprocal square root2/1-D is just the diagonal matrix whose diagonal entries are the reciprocals of thepositive square roots of the diagonal entries of D. The symmetric normalized Laplacian is a symmetric matrix.One has:w here S is the matrix whose rows are indexed by the vertices and whose columns are indexed by the edges of G such that each columncorresponding to an edge e = {u, v} has an entry,in the row corresponding to u,an entry.in the row corresponding to v, and has 0 entries elsewhere. (Note: denotes the transpose of S).All eigenvalues of the normalized Laplacian are real and non-negative. We can see this as follows. Since is symmetric, its eigenvalues are real. They are alsonon-negative: consider an eigenvector g of with eigenvalue λ andsuppose . (We can consider g and f as real functions on the vertices v.) Then:where we use the inner product a sum over all vertices v,and denotes the sum over all unordered pairs of adjacent vertices {u,v}. Thequantity is called the Dirichlet sum of f, whereas the expression is called the Rayleigh quotient of g.Let 1 be the function which assumes the value 1 on each vertex. Then is an eigenfunction of with eigenvalue 0.In fact, the eigenvalues of the normalized symmetric Laplacian satisfy 0 =μ0≤...≤μn-1≤ 2. These eigenvalues (known as the spectrum of the normalized Laplacian) relate well to other graph invariants for general graphs.[4] 7.解释离散拉普拉斯算子The Laplacian matrix can be interpreted as a matrix representation of a particular case of the discrete Laplace operator. Such an interpretation allows one, e.g., to generalise the Laplacian matrix to the case of graphs with an infinite number of vertices and edges, leading to a Laplacian matrix of an infinite size.To expand upon this, we can "describe" the change of some element (with some constant k) asIn matrix-vector notation,which givesNotice that this equation takes the same form as the heat equation, where the matrix L is replacing the Laplacian operator ; hence, the "graph Laplacian".To find a solution to this differential equation, apply standard techniques for solving a first-order matrix differential equation. That is, write as a linear combination ofeigenvectors of L (so that ), with time-dependentPlugging into the original expression (note that we will use the fact that because L is a symmetric matrix, its unit-norm eigenvectors are orthogonal):whose solution isAs shown before, the eigenvalues of L are non-negative, showing that the solution to the diffusion equation approaches an equilibrium, because it only exponentially decays or remains constant. This also shows that given and the initialcondition , the solution at any time t can be found.[5]To find for each in terms of the overall initial condition , simply project onto the unit-norm eigenvectors ;In the case of undirected graphs, this works because L is symmetric, and bythe spectral theorem, its eigenvectors are all orthogonal. So the projection onto the eigenvectors of L is simply an orthogonal coordinate transformation of the initial condition to a set of coordinates which decay exponentially and independently of each other.。