hadoop练习题--带答案

- 格式:doc

- 大小:24.00 KB

- 文档页数:3

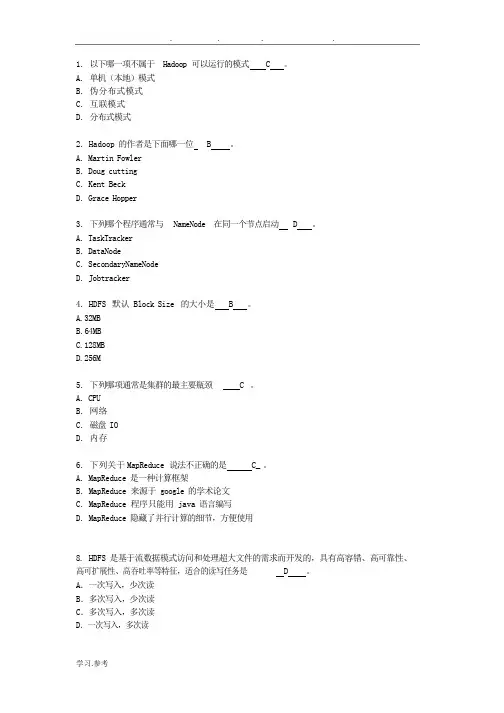

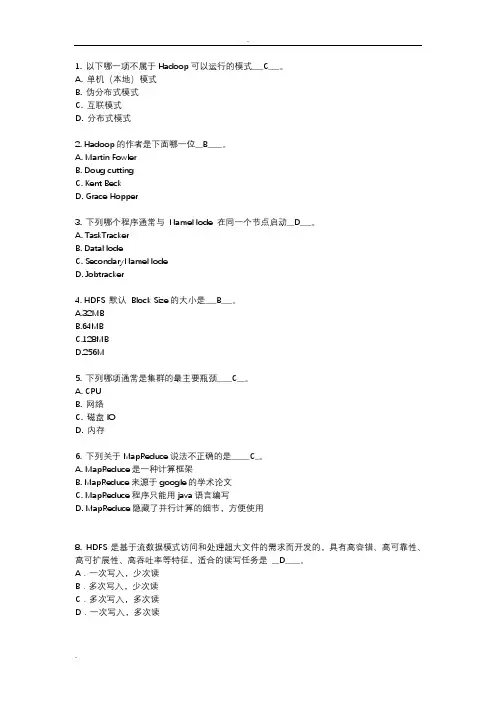

1.以下哪一项不属于Hadoop 可以运行的模式 C 。

A.单机(本地)模式B.伪分布式模式C.互联模式D.分布式模式2.Hadoop 的作者是下面哪一位 B 。

A.Martin FowlerB.Doug cuttingC.Kent BeckD.Grace Hopper3.下列哪个程序通常与NameNode 在同一个节点启动 D 。

A.TaskTrackerB.DataNodeC.SecondaryNameNodeD.Jobtracker4.HDFS 默认 Block Size 的大小是 B 。

A.32MBB.64MBC.128MBD.256M5.下列哪项通常是集群的最主要瓶颈 C 。

A.CPUB.网络C.磁盘 IOD.内存6.下列关于MapReduce 说法不正确的是C_ 。

A.MapReduce 是一种计算框架B.MapReduce 来源于 google 的学术论文C.MapReduce 程序只能用 java 语言编写D.MapReduce 隐藏了并行计算的细节,方便使用8.HDFS 是基于流数据模式访问和处理超大文件的需求而开发的,具有高容错、高可靠性、D 。

高可扩展性、高吞吐率等特征,适合的读写任务是A.一次写入,少次读B.多次写入,少次读C.多次写入,多次读D.一次写入,多次读9.HBase 依靠 A 存储底层数据。

A.HDFSB.HadoopC.MemoryD.MapReduce10.HBase 依赖 D 提供强大的计算能力。

A.ZookeeperB.ChubbyC.RPCD.MapReduce11.HBase 依赖 A 提供消息通信机制A.ZookeeperB.ChubbyC.RPCD.Socket12.下面与HDFS 类似的框架是 C ?A.NTFSB.FAT32C.GFSD.EXT313.关于 SecondaryNameNode 下面哪项是正确的 C 。

A.它是 NameNode 的热备B.它对内存没有要求C.它的目的是帮助NameNode 合并编辑日志,减少NameNode 启动时间D.SecondaryNameNode 应与 NameNode 部署到一个节点14.大数据的特点不包括下面哪一项 D 。

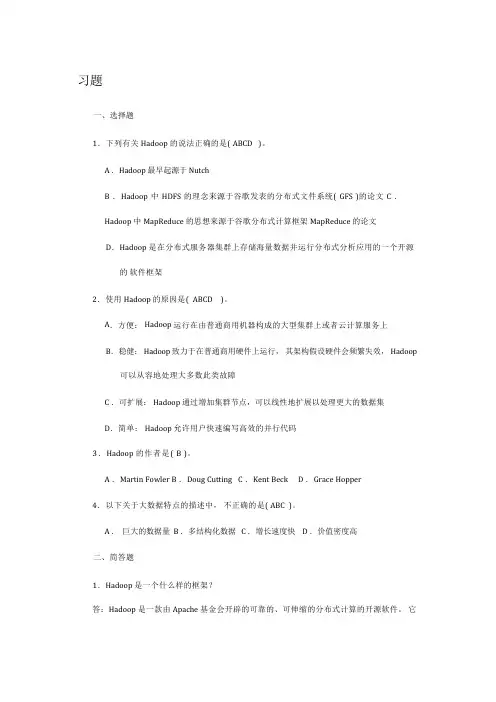

习题一、选择题1.下列有关 Hadoop 的说法正确的是( ABCD )。

A .Hadoop 最早起源于 NutchB .Hadoop 中HDFS 的理念来源于谷歌发表的分布式文件系统( GFS )的论文C .Hadoop 中 MapReduce 的思想来源于谷歌分布式计算框架 MapReduce 的论文D.Hadoop 是在分布式服务器集群上存储海量数据并运行分布式分析应用的一个开源的软件框架2.使用 Hadoop 的原因是( ABCD )。

A.方便:Hadoop 运行在由普通商用机器构成的大型集群上或者云计算服务上B.稳健:Hadoop 致力于在普通商用硬件上运行,其架构假设硬件会频繁失效,Hadoop 可以从容地处理大多数此类故障C .可扩展:Hadoop 通过增加集群节点,可以线性地扩展以处理更大的数据集D.简单:Hadoop 允许用户快速编写高效的并行代码3.Hadoop 的作者是( B )。

A .Martin FowlerB .Doug CuttingC .Kent BeckD .Grace Hopper4.以下关于大数据特点的描述中,不正确的是( ABC )。

A .巨大的数据量B .多结构化数据C .增长速度快D .价值密度高二、简答题1.Hadoop 是一个什么样的框架?答:Hadoop 是一款由Apache 基金会开辟的可靠的、可伸缩的分布式计算的开源软件。

它允许使用简单的编程模型在跨计算机集群中对大规模数据集进行分布式处理。

2.Hadoop 的核心组件有哪些?简单介绍每一个组件的作用。

答:核心组件有 HDFS 、MapReduce 、YARN 。

HDFS ( Hadoop Distributed File Sy,st doop 分布式文件系统)是 Hadoop 的核心组件之一,作为最底层的分布式存储服务而存在。

它是一个高度容错的系统,能检测和应对硬件故障,可在低成本的通用硬件上运行。

hadoop考试试题您的姓名: [填空题] *_________________________________1.Spark是用一下哪种编程语言实现的?() [单选题] *A.CB.C++;C.JAVA;(正确答案)D.Scala2.FusionInsight Manager对服务的管理操作,下面说法错误的是?() [单选题] *A.可对服务进行启停重启操作;B.可以添加和卸载服务;C.可设置不常用的服务隐藏或显示;(正确答案)D.可以查看服务的当前状态;3.FusionInsight HD集群升级,一下描述正确的是?() *A.升级过程中不可以操作准备OMS倒换;(正确答案)B.集群内所有主机的root账户密码要保持一致;(正确答案)C.保持网络通畅,避免网络问题导致升级异常;(正确答案)D.观察期不能做扩容;(正确答案)4.FusionInsight HD Loader 在创建作业时,连接器(Connector)有什么用?() [单选题] *A.确定有哪些转化步骤;B.提供优化参数,提高数据导出性能;C.配置数据如何与外部数据进行连接;(正确答案)D.配置数据如何与内部数据进行连接;5.下列哪个HDFS命令可用于检测数据块的完整性?() [单选题] *A.hdfs fsck /;(正确答案)B.hdfs fsck / -delete;C.hdfs dfsadmin -report;D.hdfs balancer -threshold 1;6.YARN中设置队列QueueA最大使用资源里,需要配置哪个参数?() [单选题] *A.yarn scheduler capacty root QueueA user-limit-factor;B.yarn scheduler capacty root QueueA minimum-user-limit-percent;C.yarn scheduler capacty root QueueA state;D.yarn scheduler capacty root QueueA maximum-capacity;(正确答案)7.Flume的数据流可以根据headers的信息发送到不同的channel中。

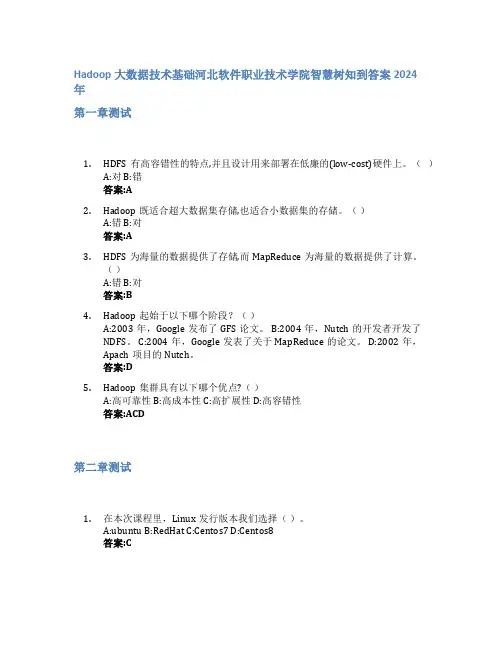

Hadoop大数据技术基础河北软件职业技术学院智慧树知到答案2024年第一章测试1.HDFS有高容错性的特点,并且设计用来部署在低廉的(low-cost)硬件上。

()A:对 B:错答案:A2.Hadoop既适合超大数据集存储,也适合小数据集的存储。

()A:错 B:对答案:A3.HDFS为海量的数据提供了存储,而MapReduce为海量的数据提供了计算。

()A:错 B:对答案:B4.Hadoop起始于以下哪个阶段?()A:2003年,Google发布了GFS论文。

B:2004年,Nutch的开发者开发了NDFS。

C:2004年,Google发表了关于MapReduce的论文。

D:2002年,Apach项目的Nutch。

答案:D5.Hadoop集群具有以下哪个优点?()A:高可靠性 B:高成本性 C:高扩展性 D:高容错性答案:ACD第二章测试1.在本次课程里,Linux发行版本我们选择()。

A:ubuntu B:RedHat C:Centos7 D:Centos8答案:C2.从哪一个Hadoop历史版本引入了yarn()。

A:1.x版本系列 B:3.x版本系列 C:4.x版本系列 D:2.x版本系列答案:B3.Hadoop部署方式分三种()。

A:伪集群模式 B:伪分布式模式 C:单机模式 D:分布式模式答案:BCD4.商业版Hadoop是指由第三方商业公司在社区版Hadoop基础上进行了一些修改、整合以及各个服务组件兼容性测试而发行的版本。

()A:对 B:错答案:A5.Hadoop一般是安装在Windows服务器上的。

()A:错 B:对答案:A第三章测试1.Hadoop 的安装部署的模式属于伪分布模式()。

A:Hadoop守护进程运行在由多台主机搭建的集群上,是真正的生产环境。

B:默认的模式,无需运行任何守护进程(daemon),所有程序都在单个JVM 上执行。

C:全分布式模式的一个特例,Hadoop的守护进程运行在一个节点上。

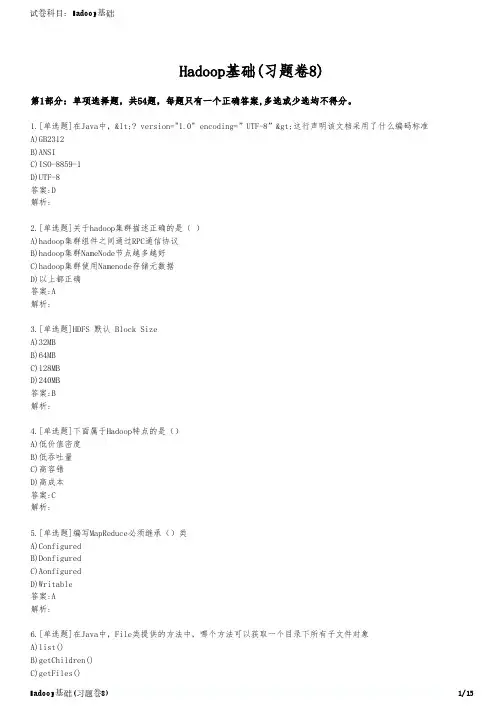

Hadoop基础(习题卷8)第1部分:单项选择题,共54题,每题只有一个正确答案,多选或少选均不得分。

1.[单选题]在Java中,<? version="1.0" encoding=”UTF-8”>这行声明该文档采用了什么编码标准A)GB2312B)ANSIC)ISO-8859-1D)UTF-8答案:D解析:2.[单选题]关于hadoop集群描述正确的是( )A)hadoop集群组件之间通过RPC通信协议B)hadoop集群NameNode节点越多越好C)hadoop集群使用Namenode存储元数据D)以上都正确答案:A解析:3.[单选题]HDFS 默认 Block SizeA)32MBB)64MBC)128MBD)240MB答案:B解析:4.[单选题]下面属于Hadoop特点的是()A)低价值密度B)低吞吐量C)高容错D)高成本答案:C解析:5.[单选题]编写MapReduce必须继承()类A)ConfiguredB)DonfiguredC)AonfiguredD)Writable答案:A解析:6.[单选题]在Java中,File类提供的方法中,哪个方法可以获取一个目录下所有子文件对象D)listFiles()答案:D解析:7.[单选题]HDFS结构不包括________。

A)Master体系结构B)主从服务器C)元数据服务器D)存储服务器答案:A解析:8.[单选题]下列哪一项不属于数据库事务具有ACID四性?A)间断性B)原子性C)一致性D)持久性答案:A解析:9.[单选题]客户端从Zookeeper获取Region的存储位置信息后,直接在_______上读写数据。

A)ZookeeperB)HMasterC)Region ServerD)HLog答案:C解析:10.[单选题]对NodeManager服务描述不正确的是( )A)NodeManager负责单节点资源管理和使用B)NodeManager管理当前节点的ContainerC)向ResourceManager汇报本节点上的资源使用情况D)NodeManager服务器不需要与ResourceManager通信答案:D解析:11.[单选题]下面对分区描述的过程正确的是( )A)merge是将多个溢写文件合并到一个文件B)merge过程不可能有Combiner处理C)缓冲区的作用不大D)以上都不正确答案:A解析:12.[单选题]云计算发展对产业的影响对一般企业和机构来说主要是( )。

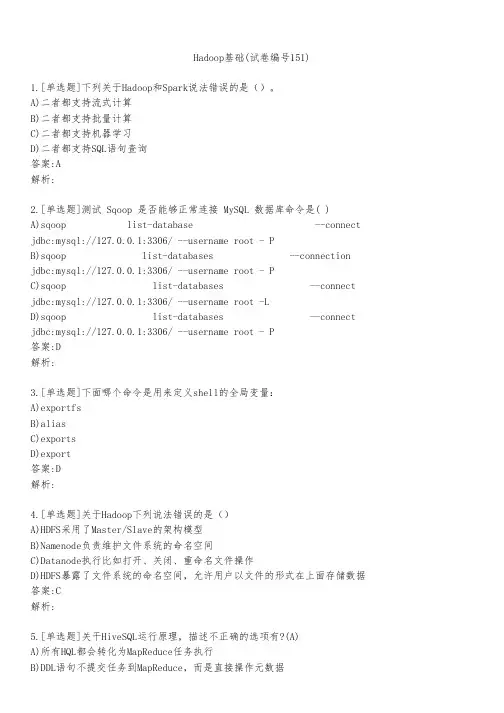

Hadoop基础(试卷编号151)1.[单选题]下列关于Hadoop和Spark说法错误的是()。

A)二者都支持流式计算B)二者都支持批量计算C)二者都支持机器学习D)二者都支持SQL语句查询答案:A解析:2.[单选题]测试 Sqoop 是否能够正常连接 MySQL 数据库命令是( )A)sqoop list-database --connect jdbc:mysql://127.0.0.1:3306/ --username root - PB)sqoop list-databases --connection jdbc:mysql://127.0.0.1:3306/ --username root - PC)sqoop list-databases --connect jdbc:mysql://127.0.0.1:3306/ --username root -LD)sqoop list-databases --connect jdbc:mysql://127.0.0.1:3306/ --username root - P答案:D解析:3.[单选题]下面哪个命令是用来定义shell的全局变量:A)exportfsB)aliasC)exportsD)export答案:D解析:4.[单选题]关于Hadoop下列说法错误的是()A)HDFS采用了Master/Slave的架构模型B)Namenode负责维护文件系统的命名空间C)Datanode执行比如打开、关闭、重命名文件操作D)HDFS暴露了文件系统的命名空间,允许用户以文件的形式在上面存储数据答案:C解析:5.[单选题]关干HiveSQL运行原理,描述不正确的选项有?(A)C)对于selectcount(*)fromtable操作,一定会启reduce任务D)对于select*fromtable语句不会启MapReduce答案:A解析:6.[单选题]调用Zookeeper对象创建的节点,不包括()。

1. 以下哪一项不属于Hadoop可以运行的模式___C___。

A. 单机(本地)模式B. 伪分布式模式C. 互联模式D. 分布式模式2. Hadoop的作者是下面哪一位__B____。

A. Martin FowlerB. Doug cuttingC. Kent BeckD. Grace Hopper3. 下列哪个程序通常与NameNode 在同一个节点启动__D___。

A. TaskTrackerB. DataNodeC. SecondaryNameNodeD. Jobtracker4. HDFS 默认Block Size的大小是___B___。

A.32MBB.64MBC.128MBD.256M5. 下列哪项通常是集群的最主要瓶颈____C__。

A. CPUB. 网络C. 磁盘IOD. 内存6. 下列关于MapReduce说法不正确的是_____C_。

A. MapReduce是一种计算框架B. MapReduce来源于google的学术论文C. MapReduce程序只能用java语言编写D. MapReduce隐藏了并行计算的细节,方便使用8. HDFS是基于流数据模式访问和处理超大文件的需求而开发的,具有高容错、高可靠性、高可扩展性、高吞吐率等特征,适合的读写任务是__D____。

A.一次写入,少次读B.多次写入,少次读C.多次写入,多次读D.一次写入,多次读9. HBase依靠__A____存储底层数据。

A. HDFSB. HadoopC. MemoryD. MapReduce10. HBase依赖___D___提供强大的计算能力。

A. ZookeeperB. ChubbyC. RPCD. MapReduce11. HBase依赖___A___提供消息通信机制A. ZookeeperB. ChubbyC. RPCD. Socket12. 下面与HDFS类似的框架是___C____?A. NTFSB. FAT32C. GFSD. EXT313. 关于SecondaryNameNode 下面哪项是正确的___C___。

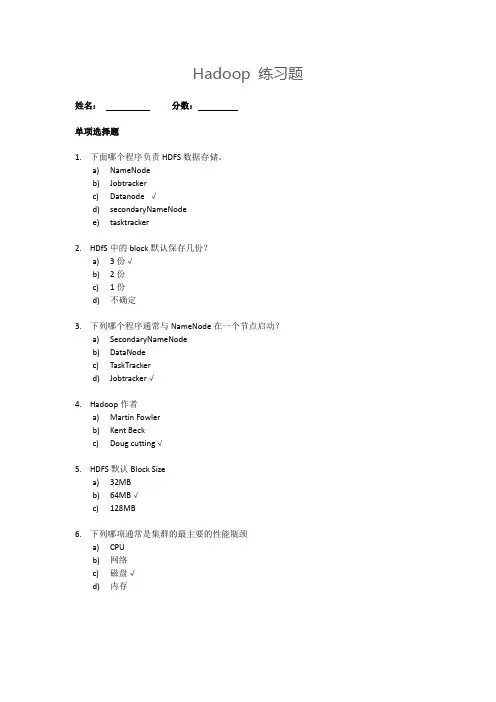

Hadoop 练习题姓名:分数:单项选择题1.下面哪个程序负责HDFS数据存储。

a)NameNodeb)Jobtrackerc)Datanode √d)secondaryNameNodee)tasktracker2.HDfS中的block默认保存几份?a)3份√b)2份c)1份d)不确定3.下列哪个程序通常与NameNode在一个节点启动?a)SecondaryNameNodeb)DataNodec)TaskTrackerd)Jobtracker√4.Hadoop作者a)Martin Fowlerb)Kent Beckc)Doug cutting√5.HDFS默认Block Sizea)32MBb)64MB√c)128MB6.下列哪项通常是集群的最主要的性能瓶颈a)CPUb)网络c)磁盘√d)内存7.关于SecondaryNameNode哪项是正确的?a)它是NameNode的热备b)它对内存没有要求c)它的目的是帮助NameNode合并编辑日志,减少NameNode启动时间√d)SecondaryNameNode应与NameNode部署到一个节点8.一个gzip文件大小75MB,客户端设置Block大小为64MB,请我其占用几个Block?a) 1b)2√c) 3d) 49.HDFS有一个gzip文件大小75MB,客户端设置Block大小为64MB。

当运行mapreduce任务读取该文件时input split大小为?a)64MBb)75MB√c)一个map读取64MB,另外一个map读取11MB10.HDFS有一个LZO(with index)文件大小75MB,客户端设置Block大小为64MB。

当运行mapreduce任务读取该文件时input split大小为?a)64MBb)75MBc)一个map读取64MB,另外一个map读取11MB√多选题:11.下列哪项可以作为集群的管理工具a)Puppet√b)Pdsh√c)Cloudera Manager√d)Rsync + ssh + scp√12.配置机架感知的下面哪项正确a)如果一个机架出问题,不会影响数据读写√b)写入数据的时候会写到不同机架的DataNode中√c)MapReduce会根据机架获取离自己比较近的网络数据√13.Client端上传文件的时候下列哪项正确a)数据经过NameNode传递给DataNodeb)Client端将文件以Block为单位,管道方式依次传到DataNode√c)Client只上传数据到一台DataNode,然后由NameNode负责Block复制工作d)当某个DataNode失败,客户端会继续传给其它DataNode √14.下列哪个是Hadoop运行的模式a)单机版√b)伪分布式√c)分布式√15.Cloudera提供哪几种安装CDH的方法a)Cloudera manager√b)Tar ball√c)Yum√d)Rpm√判断题:(全部错)16.Ganglia不仅可以进行监控,也可以进行告警。

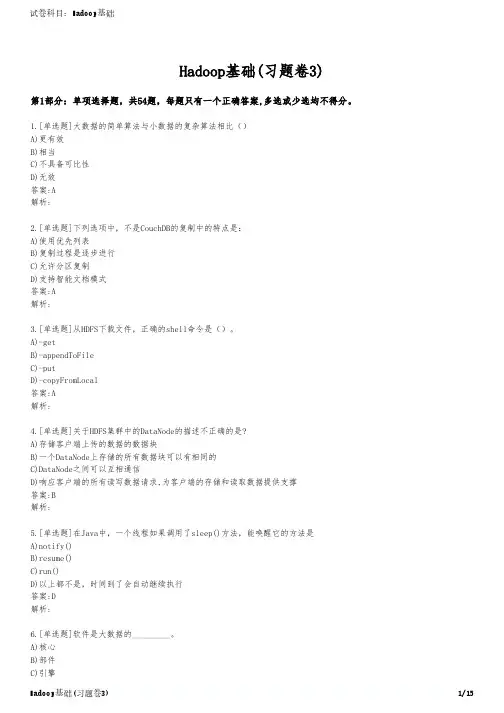

Hadoop基础(习题卷3)第1部分:单项选择题,共54题,每题只有一个正确答案,多选或少选均不得分。

1.[单选题]大数据的简单算法与小数据的复杂算法相比()A)更有效B)相当C)不具备可比性D)无效答案:A解析:2.[单选题]下列选项中,不是CouchDB的复制中的特点是:A)使用优先列表B)复制过程是逐步进行C)允许分区复制D)支持智能文档模式答案:A解析:3.[单选题]从HDFS下载文件,正确的shell命令是()。

A)-getB)-appendToFileC)-putD)-copyFromLocal答案:A解析:4.[单选题]关于HDFS集群中的DataNode的描述不正确的是?A)存储客户端上传的数据的数据块B)一个DataNode上存储的所有数据块可以有相同的C)DataNode之间可以互相通信D)响应客户端的所有读写数据请求,为客户端的存储和读取数据提供支撑答案:B解析:5.[单选题]在Java中,一个线程如果调用了sleep()方法,能唤醒它的方法是A)notify()B)resume()C)run()D)以上都不是,时间到了会自动继续执行答案:D解析:6.[单选题]软件是大数据的_________。

A)核心解析:7.[单选题]_______模式,只适合于Hive简单试用及单元测试。

A)单用户模式B)多用户模式C)多用户远程模式D)单用户远程模式答案:A解析:8.[单选题]下列关于Hive描述错误的是()。

A)hive学习成本低,支持标准的SQL语法B)hive运行效率低,延迟高C)HQL的表达能力有限D)Hive支持迭代计算答案:D解析:9.[单选题]下面哪个选项不是我们需要Hadoop的主要原因()A)我们需要处理PB级别的数据B)为每个应用建立一个可靠的系统是很昂贵的C)几乎每天都有结点坏掉D)把一个任务分割成多个子任务的方式是不好的答案:D解析:10.[单选题]为了让集群中的机器能够正常通信,所有集群的IP必须设置成静态IP,防止机器重启之后而找不到机器的情况,那么IP地址配置需要修改那个文件()A)ifcfg-loB)network-functionsC)ifcfg-ens33D)network-functions-ipv6答案:C解析:11.[单选题]Spark生态系统组件Spark Streaming的应用场景是?A)基于历史数据的数据挖掘B)图结构数据的处理C)基于历史数据的交互式查询D)基于实时数据流的数据处理答案:D解析:12.[单选题]关于HDFS集群中的DataNode的描述不正确的是?A)DataNode之间都是独立的,相互之间不会有通信B)存储客户端上传的数据的数据块C)响应客户端的所有读写数据请求,为客户端的存储和读取数据提供支撑13.[单选题]Hadoop2.x版本中的数据块大小默认是多少? ()A)64MB)128MC)256MD)512M答案:B解析:14.[单选题]HDFS分布式文件系统的特点为____________。

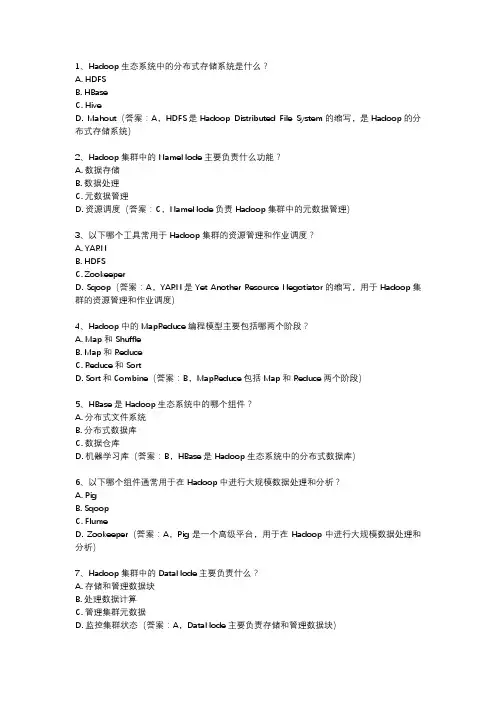

1、Hadoop生态系统中的分布式存储系统是什么?A. HDFSB. HBaseC. HiveD. Mahout(答案:A,HDFS是Hadoop Distributed File System的缩写,是Hadoop的分布式存储系统)2、Hadoop集群中的NameNode主要负责什么功能?A. 数据存储B. 数据处理C. 元数据管理D. 资源调度(答案:C,NameNode负责Hadoop集群中的元数据管理)3、以下哪个工具常用于Hadoop集群的资源管理和作业调度?A. YARNB. HDFSC. ZookeeperD. Sqoop(答案:A,YARN是Yet Another Resource Negotiator的缩写,用于Hadoop集群的资源管理和作业调度)4、Hadoop中的MapReduce编程模型主要包括哪两个阶段?A. Map和ShuffleB. Map和ReduceC. Reduce和SortD. Sort和Combine(答案:B,MapReduce包括Map和Reduce两个阶段)5、HBase是Hadoop生态系统中的哪个组件?A. 分布式文件系统B. 分布式数据库C. 数据仓库D. 机器学习库(答案:B,HBase是Hadoop生态系统中的分布式数据库)6、以下哪个组件通常用于在Hadoop中进行大规模数据处理和分析?A. PigB. SqoopC. FlumeD. Zookeeper(答案:A,Pig是一个高级平台,用于在Hadoop中进行大规模数据处理和分析)7、Hadoop集群中的DataNode主要负责什么?A. 存储和管理数据块B. 处理数据计算C. 管理集群元数据D. 监控集群状态(答案:A,DataNode主要负责存储和管理数据块)8、以下哪个是Hadoop生态系统中的数据挖掘和机器学习库?A. MahoutB. HiveC. PigD. Oozie(答案:A,Mahout是Hadoop生态系统中的数据挖掘和机器学习库)。

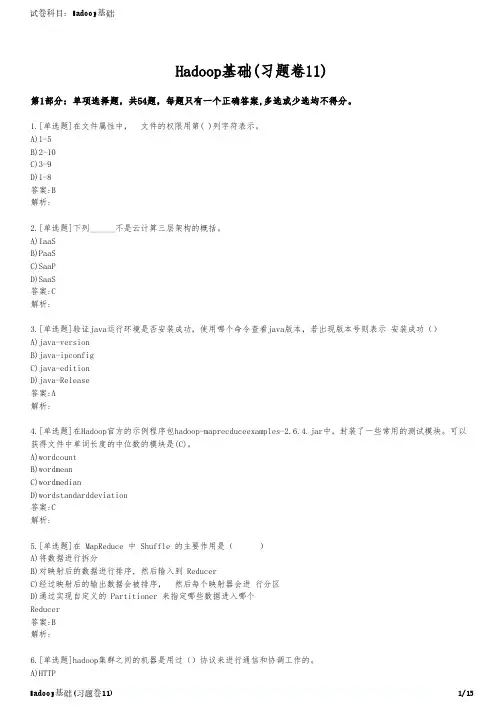

Hadoop基础(习题卷11)第1部分:单项选择题,共54题,每题只有一个正确答案,多选或少选均不得分。

1.[单选题]在文件属性中, 文件的权限用第( )列字符表示。

A)1-5B)2-10C)3-9D)1-8答案:B解析:2.[单选题]下列______不是云计算三层架构的概括。

A)IaaSB)PaaSC)SaaPD)SaaS答案:C解析:3.[单选题]验证java运行环境是否安装成功,使用哪个命令查看java版本,若出现版本号则表示 安装成功()A)java-versionB)java-ipconfigC)java-editionD)java-Release答案:A解析:4.[单选题]在Hadoop官方的示例程序包hadoop-maprecduceexamples-2.6.4.jar中,封装了一些常用的测试模块。

可以获得文件中单词长度的中位数的模块是(C)。

A)wordcountB)wordmeanC)wordmedianD)wordstandarddeviation答案:C解析:5.[单选题]在 MapReduce 中 Shuffle 的主要作用是( )A)将数据进行拆分B)对映射后的数据进行排序, 然后输入到 ReducerC)经过映射后的输出数据会被排序, 然后每个映射器会进 行分区D)通过实现自定义的 Partitioner 来指定哪些数据进入哪个Reducer答案:B解析:B)HTTPSC)SSHD)ClientProtocol答案:C解析:7.[单选题]关于ApplicationMaster组件描述错误的是()。

A)与资源管理器协商获取资源B)与节点管理器通信以启动或停止具体的任务C)监控应用程序所有任务的状态D)定时向资源管理器汇报资源使用情况答案:A解析:8.[单选题]SecondaryNameNode 是对主NameNode的一个补充,他会定期地执行对HDFS元数据的检查点。

当前设计仅允许每个HDFS只有()SecondaryNameNode节点。

选择题1、关于MapReduce的描述错误的是()A、MapReduce框架会先排序map任务的输出B、通常,作业的输入输出都会被存储在文件系统中C、通常计算节点和存储节点是同一节点D、一个Task通常会把输入集切分成若干独立的数据块2、关于基于Hadoop的MapReduce编程的环境配置,下面哪一步是不必要的()A、安装linux或者在Windows下安装CgywinB、安装javaC、安装MapReduceD、配置Hadoop参数3、关于基于Hadoop的MapReduce编程的环境配置,下面哪一步是不必要的()A、配置java环境变量B、配置Hadoop环境变量C、配置EclipseD、配置ssh4、下列说法错误的是()A、MapReduce中maperconbiner reducer 缺一不可B、在JobConf中InputFormat参数可以不设参数可以不设MapperClass中JobConf、在C.D、在JobConf中OutputKeyComparator参数可以不设5、下列关于mapreduce的key/value对的说法正确的是()A、输入键值对不需要和输出键值对类型一致B、输入的key类型必须和输出的key类型一致C、输入的value类型必须和输出的value类型一致D、输入键值对只能映射成一个输出键值对6、在mapreduce任务中,下列哪一项会由hadoop系统自动排序()A、keys of mapper's outputB、values of mapper's outputC、keys of reducer's outputD、values of reducer's output7、关于mapreduce框架中一个作业的reduce任务的数目,下列说法正确的是()A、由自定义的Partitioner来确定B、是分块的总数目一半C、可以由用户来自定义,通过JobConf.setNumReducetTask(int)来设定一个作业中reduce的任务数目D、由MapReduce随机确定其数目8、MapReduce框架中,在Map和Reduce之间的combiner的作用是()A、对Map的输出结果排序、对中间过程的输出进行本地的聚集B.C、对中间结果进行混洗D、对中间格式进行压缩9、MapReduce框架分为Map和Reduce,下列对Reduce阶段叙述正确的是()A、主要分为shuffle和sort这2个阶段B、这个阶段过程中,key的分组规则是不可更改的C、其中的shuffle 和sort是同时进行的D、Reduce 数目的增加不会增加系统的开销10、Hadoop中,Reducer的三个阶段是()A、Shuffle——Sort——ReduceB、Shuffle——Reduce——SortC、Reduce——Shuffle——SortD、Sort——Shuffle——Reduce11、请问在Hadoop体系结构中,按照由下到上顺序,排列正确的是()Pig Hive Crunch都是运行在MapReduce , Spark ,或者Tez之上的处理框架Avro是一个克服了Writable部分不足的序列化系统A、Common Hive HDFSB、Common MapReduce PigC、HDFS MapReduceHBaseHDFS Avro HBase、D.12、关于Hadoop下列说法错误的是()A、HDFS采用了Master/Slave的架构模型B、Namenode负责维护文件系统的命名空间C、Datanode执行比如打开、关闭、重命名文件操作D、HDFS暴露了文件系统的命名空间,允许用户以文件的形式在上面存储数据13、下面哪个选项不是我们需要Hadoop的主要原因()A、我们需要处理PB级别的数据B、为每个应用建立一个可靠的系统是很昂贵的C、几乎每天都有结点坏掉D、把一个任务分割成多个子任务的方式是不好的14、hadoop中下面哪项操作是不需要记录进日志的()A、打开文件B、重命名C、编译文件D、删除操作15、hadoop中,下面关于向文件系统中添加一个文件的过程,错误的是()A、需要创建路径的父目录B、需要创建一个新的INode文件C、将新的INode文件加入到name space中去中去EditLog、将所有操作记录到D.16、在安装配置好Hadoop集群后,查看Namenode节点的端口是以下哪个()A、50030B、50070C、60010D、6003017、下面哪个不是Hadoop的输出数据格式()A、文本输出B、二进制输出C、单一输出D、多输出18、要在HDFS的根目录中建立一个叫hadoo的目录,下面哪一条命令是正确的()A、mkdirhadooB、mkdir /hadooC、hadoopmkdirhadooD、hadoop fs –mkdir /hadoo19、下面有关NameNode 安全模式(safe mode)说法错误的是()A、name space处于安全模式时只能被读取B、NameNode 启动时自动进入安全模式C、调用setSafeMode()函数能够打开或关闭安全模式、安全模式下不能够复制或删除文件中的数据块D.20、以下情况除哪项发生时balancer便会自动退出()A、集群平衡或者没有数据块可以移动B、在连续三次迭代中没有块移动C、与namenode传输时发生异常D、另一个balancer在运行21、下列说法错误的是()A、Partitioner负责控制map输出结果key的分割B、Reporter用于MapReduce应用程序报告进度C、OutputCollector收集Mapper或Reducer输出数据D、Reduce的数目不可以是022、下列说法错误的是()A、JobServer是用户作业和JobTracker交互的主要接口B、JobClient为用户提供提交作业功能C、JobClient提供访问子任务报告和日志功能D、JobClient提供获取MapReduce集群状态信息功能23、Hadoop的哪个包的功能是表示层,将各种数据编码/解码,方便在网络上传输()A、fsB、ipcC、ionet、D.24、Hadoop的哪个包的功能是根据DDL(数据描述语言)自动生成他们的编解码函数()A、recordB、metricsC、utilD、tool25、hadoop中什么类提供了连接到HDFS系统并执行文件操作的基本功能()A、FSDirectoryB、DFSClientC、ClientProtocolD、FSInputStream26、MapReduce程序最基本的组成部分不包括()A、Mapper类B、Reducer类C、创建JobConf的执行程序D、Conbiner类27、下列关于Hadoop中Shell类说法错误的是()A、Shell类是一个继承类B、Shell类定义了如何在当前文件系统环境中,通过命令进行交互C、Shell类定义了静态的字符串命令类定义了与实现命令的执行相关的属性Shell、D.28、如果想在hadoop文件系统中通过键盘输入来创建一个文件,你应该使用下列哪种方法()A、copy()B、copyFromStdin()C、printToStdout()D、copyFromLocal()29、关于FsShell的说法,下面哪一项是正确的()A、FsShell和UNIX系统中的shell一样功能强大B、FsShell实际上是一个Java应用程序C、可以在FsShell中执行HDFS文件系统中的可执行文件D、FsShell实际上是调用UNIX的shell命令来实现复制操作30、当__时,HDFS启动balancer()A、threshold =<ratio(Datanode)-ratio(Rack)B、threshold=<ratio(Datanode)-ratio(Rack)C、threshold< ratio(Rack) -ratio(Datanode)D、threshold >=|ratio(Datanode)-ratio(Rack)31、执行数据块复制的任务时,是什么和什么在进行通信()A、client and namenodeB、client and datanodeC、namenode and datanodeD、datanode and datanode的说法错误的是()Secondary NameNode和NameNode、关于32.A、NameNode上实现的NamenodeProtocol用于二者命令通信B、数据的通信使用的是ftp协议(http协议)C、数据通信使用的是http协议D、协议的容器是jetty33、关于Secondary NameNode的说法错误的是()A、main方法是Secondary NameNode的入口,它启动线程执行runB、启动前的构造过程主要是创建和NameNode通信的接口和启动HTTP 服务器C、run方法每隔一段时间执行doCheckpoint()D、main方法从NameNode上取下FSImage和日志,和本地合并再传回NameNode (应该是run方法完成)34、Hadoop中节点之间的进程通信是通过什么协议来实现的()A、HTTPB、SMTPC、SSHD、RPC35、下面有关NameNode和secondary NameNode通信协议说法错误的是()A、secondary NameNode使用NamenodeProtocol协议与NameNode 进行通信B、如果文件系统处于安全模式,那么关闭当前日志并打开新的日志操作会失败.C、如果旧的编辑日志丢失了,那么滚动fsImage 日志会失败D、secondary NameNode 可以从NameNode中得到任何datanode的块及其位置36、下面有关NameNode 和 DataNode 之间的Hearbeat说法错误的是()A、DataNode 通过发送Heartbeat 告诉NameNode自己还活着,并且工作正常B、HeatBeat包含DataNode状态相关信息C、NameNode回复HeartBeat 一些DatanodeCommandD、如果NameNode在某一固定时间内没有收到Datanode的Heatbeat,那么它会要求 DataNode发送Heartbeat37、下面哪个协议用于Datanode和Namenode之间的通信()A、DatanodeProtocolB、NamenodeProcotolC、ClientProtocolD、ClientDatanodeProtocol38、下面哪个协议用于Secondary Namenode和Namenode之间的通信()A、DatanodeProtocolB、NamenodeProcotolC、ClientProtocolClientDatanodeProtocol、D.39、在Hadoop上提交Job时不涉及哪个实体()A、客户端B、HDFSC、SecondaryNodeD、JobTracker40、MapReduce处理流程中Reduce如何获取Map端结果()A、Map端发送B、Reduce端获取C、Map端发送到中间管理节点,Reduce统一获取、随机发送D.。

第一章大数据概述1. ____________________ 互联网的发展分为个阶段。

A.一 B.三 C.二 D.四2. 下列不属于大数据特点的是()。

D.价值密度高A. 种类和来源多样化B.数据量巨大C.分析处理速度快3. _________________ 互联网发展的第个时代为智能互联网。

A. 3.0B.4.0C.1.0D.2.04. 关于大数据叙述不正确的一项是()。

A. 大数据=“海量数据” +“复杂类型的数据”B. 大数据是指在一定时间对内容抓取、管理和处理的数据集合C. 大数据可以及时有效的分析海量的数据D. 数据包括结构化数据、半结构化数据、结构化数据。

5. 下列数据换算正确的一项为()。

A. 1YB=1024EBB. 1TB=1024MBC. 1PB==1024EBD. 1024ZB=1EB6. ___________________________ 结构化数据的表现形式为。

A. 文本B.视图C.二维表D.查询7. ________________________ 结构化的数据,先有,再有.A. 数据结构B. 结构数据C. 内容结构D. 结构内容8. ________________________ 结构化的数据,先有,再有.A. 数据结构B. 结构数据C. 内容结构D. 结构内容9. ______________________ 软件是大数据的。

A.核心B.部件C.引擎D.集合10. 大数据技术不包括()。

A.数据计算B.数据存储C.数据冗余D.数据采集11.大数据的特点不包括()。

A.数量大B.类型少C.速度快D.价值高第二章Hadoop 简介1. ______________________________________ 下列对云栈架构层数不正确的一项为A. 三层云栈架构B. 四层云栈架构C. 五层云栈架构D. 六层云栈架构2. _________ 下列不是云计算三层架构的概括。

1、当NameNode关闭时会发生什么?如果NameNode关闭,文件系统将脱机。

2、什么是机架感知?这是一种决定如何根据机架定义放置块的方法。

Hadoop将尝试限制存在于同一机架中的datanode之间的网络流量。

为了提高容错能力,名称节点会尽可能把数据块的副本放到多个机架上。

综合考虑这两点的基础上Hadoop设计了机架感知功能。

3、namenode的重要性是什么?namenonde的作用在Hadoop中非常重要。

它是Hadoop的大脑,主要负责管理系统上的分配块,还为客户提出请求时的数据提供特定地址。

4. 请列出你所知道的hadoop调度器,并简要说明其工作方法答:FiFo schedular :默认,先进先出的原则Capacity schedular :计算能力调度器,选择占用最小、优先级高的先执行,依此类推。

Fair schedular:公平调度,所有的job 具有相同的资源。

1 单选题1.1 下面哪个程序负责HDFS 数据存储。

a)NameNodeb)Jobtrackerc)Datanoded)secondaryNameNodee)tasktracker答案C datanode1.2 HDfS 中的block 默认保存几份?a)3 份b)2 份c)1 份d)不确定答案A 默认3份1.3 下列哪个程序通常与NameNode 在一个节点启动?a)SecondaryNameNodeb)DataNodec)TaskTrackerd)ResourceManager答案D分析:hadoop的集群是基于master/slave模式,namenode和jobtracker属于master,datanode和tasktracker属于slave,master只有一个,而slave有多个SecondaryNameNode内存需求和NameNode在一个数量级上,所以通常secondary NameNode(运行在单独的物理机器上)和NameNode运行在不同的机器上。

hadoop考试复习试题库及答案1.Spark是用一下哪种编程语言实现的?()A.CB.C++;C.JAVA;(正确答案)D.Scala2.FusionInsight Manager对服务的管理操作,下面说法错误的是?()A.可对服务进行启停重启操作;B.可以添加和卸载服务;C.可设置不常用的服务隐藏或显示;(正确答案)D.可以查看服务的当前状态;3.FusionInsight HD集群升级,一下描述正确的是?()A.升级过程中不可以操作准备OMS倒换;(正确答案)B.集群内所有主机的root账户密码要保持一致;(正确答案)C.保持网络通畅,避免网络问题导致升级异常;(正确答案)D.观察期不能做扩容;(正确答案)4.FusionInsight HD Loader 在创建作业时,连接器(Connector)有什么用?()A.确定有哪些转化步骤;B.提供优化参数,提高数据导出性能;C.配置数据如何与外部数据进行连接;(正确答案)D.配置数据如何与内部数据进行连接;5.下列哪个HDFS命令可用于检测数据块的完整性?()A.hdfs fsck /;(正确答案)B.hdfs fsck / -delete;C.hdfs dfsadmin -report;D.hdfs balancer -threshold 1;6.YARN中设置队列QueueA最大使用资源里,需要配置哪个参数?()A.yarn scheduler capacty root QueueA user-limit-factor;B.yarn scheduler capacty root QueueAminimum-user-limit-percent;C.yarn scheduler capacty root QueueA state;D.yarn scheduler capacty root QueueA maximum-capacity;(正确答案)7.Flume的数据流可以根据headers的信息发送到不同的channel中。

hadoop应用的期末考试题目及答案一、选择题(每题2分,共10分)1. Hadoop的HDFS是一种()。

A. 文件系统B. 数据库C. 缓存系统D. 操作系统答案:A2. Hadoop生态系统中,用于数据仓库的组件是()。

A. HBaseB. HiveC. PigD. Sqoop答案:B3. Hadoop的MapReduce编程模型中,Map阶段的主要任务是()。

A. 数据排序B. 数据合并C. 数据分发D. 数据处理答案:D4. Hadoop中,NameNode和DataNode分别负责()。

A. 数据存储和数据管理B. 数据管理C. 数据存储D. 数据存储和任务调度答案:A5. Hadoop的YARN是用于()。

A. 数据存储B. 数据处理C. 任务调度D. 数据传输答案:C二、填空题(每题2分,共10分)1. Hadoop的HDFS设计用于存储大规模数据集,其默认的副本因子是________。

答案:32. Hadoop的MapReduce框架中,Map任务的输出会经过________阶段,然后传递给Reduce任务。

答案:Shuffle and Sort3. Hadoop生态系统中,________组件用于处理实时数据流。

答案:Apache Storm4. Hadoop的HDFS支持________,允许用户在文件系统中存储多个版本的文件。

答案:Snapshot5. Hadoop的YARN中的________负责监控所有集群节点上的资源使用情况。

答案:ResourceManager三、简答题(每题10分,共30分)1. 简述Hadoop的HDFS的架构特点。

答案:Hadoop的HDFS(Hadoop Distributed File System)是一个分布式文件系统,设计用于存储大规模数据集。

它具有以下特点:- 高容错性:通过在多个节点上存储数据副本来实现。

- 高吞吐量:适用于大规模数据集的访问。

Hadoop 练习题姓名:分数:

单项选择题

1.下面哪个程序负责HDFS数据存储。

a)NameNode

b)Jobtracker

c)Datanode √

d)secondaryNameNode

e)tasktracker

2.HDfS中的block默认保存几份?

a)3份√

b)2份

c)1份

d)不确定

3.下列哪个程序通常与NameNode在一个节点启动?

a)SecondaryNameNode

b)DataNode

c)TaskTracker

d)Jobtracker√

4.Hadoop作者

a)Martin Fowler

b)Kent Beck

c)Doug cutting√

5.HDFS默认Block Size

a)32MB

b)64MB√

c)128MB

6.下列哪项通常是集群的最主要的性能瓶颈

a)CPU

b)网络

c)磁盘√

d)内存

7.关于SecondaryNameNode哪项是正确的?

a)它是NameNode的热备

b)它对内存没有要求

c)它的目的是帮助NameNode合并编辑日志,减少NameNode启动时间√

d)SecondaryNameNode应与NameNode部署到一个节点

8.一个gzip文件大小75MB,客户端设置Block大小为64MB,请我其占用几个Block?

a) 1

b)2√

c) 3

d) 4

9.HDFS有一个gzip文件大小75MB,客户端设置Block大小为64MB。

当运行mapreduce

任务读取该文件时input split大小为?

a)64MB

b)75MB√

c)一个map读取64MB,另外一个map读取11MB

10.HDFS有一个LZO(with index)文件大小75MB,客户端设置Block大小为64MB。

当运

行mapreduce任务读取该文件时input split大小为?

a)64MB

b)75MB

c)一个map读取64MB,另外一个map读取11MB√

多选题:

11.下列哪项可以作为集群的管理工具

a)Puppet√

b)Pdsh√

c)Cloudera Manager√

d)Rsync + ssh + scp√

12.配置机架感知的下面哪项正确

a)如果一个机架出问题,不会影响数据读写√

b)写入数据的时候会写到不同机架的DataNode中√

c)MapReduce会根据机架获取离自己比较近的网络数据√

13.Client端上传文件的时候下列哪项正确

a)数据经过NameNode传递给DataNode

b)Client端将文件以Block为单位,管道方式依次传到DataNode√

c)Client只上传数据到一台DataNode,然后由NameNode负责Block复制工作

d)当某个DataNode失败,客户端会继续传给其它DataNode √

14.下列哪个是Hadoop运行的模式

a)单机版√

b)伪分布式√

c)分布式√

15.Cloudera提供哪几种安装CDH的方法

a)Cloudera manager√

b)Tar ball√

c)Yum√

d)Rpm√

判断题:(全部错)

16.Ganglia不仅可以进行监控,也可以进行告警。

()

17.Nagios不可以监控Hadoop集群,因为它不提供Hadoop支持。

()

18.如果NameNode意外终止,SecondaryNameNode会接替它使集群继续工作。

()

19.Cloudera CDH是需要付费使用的。

()

20.Hadoop是Java开发的,所以MapReduce只支持Java语言编写。

()

21.Hadoop支持数据的随机写。

()

Node负责管理metadata,client端每次读写请求,它都会从磁盘中读取或则会写

入metadata信息并反馈client端。

()

Node本地磁盘保存了Block的位置信息。

()

24.Slave节点要存储数据,所以它的磁盘越大越好。

()

25.Hadoop默认调度器策略为FIFO,并支持多个Pool提交Job。

()

26.集群内每个节点都应该配RAID,这样避免单磁盘损坏,影响整个节点运行。

()

27.因为HDFS有多个副本,所以NameNode是不存在单点问题的。

()

28.每个map槽就是一个线程。

()

29.Mapreduce的input split就是一个block。

()

30.Hadoop环境变量中的HADOOP_HEAPSIZE用于设置所有Hadoop守护线程的内存。

它默

认是200MB。

()

31.DataNode首次加入cluster的时候,如果log中报告不兼容文件版本,那需要NameNode

执行“hadoop namenode -format”操作格式化磁盘。

()

32.Hadoop1.0和2.0都具备完善的HDFS HA策略。

()

33.GZIP压缩算法比LZO更快。

()

34.PIG是脚本语言,它与mapreduce无关。

()。