Linux共享内存编程实例

- 格式:doc

- 大小:73.00 KB

- 文档页数:6

rust shared_memory 案例Rust是一种系统级语言,支持并发编程。

其中一个强大的功能是共享内存,让多个线程可以在同一块内存区域上同时进行读写操作。

对于并发编程来说,共享内存是一种高效的数据交换方式。

在本文中,我们将探讨Rust中的共享内存案例。

Rust提供了两种主要的共享内存机制:`Arc`和`Mutex`。

Arc表示Atomically Reference Counted(原子引用计数),它允许多个线程安全地共享同一个对象。

Mutex代表Mutual Exclusion(互斥),它确保在任何给定时间只能有一个线程访问共享资源。

我们将通过一个简单的案例来演示Rust中的共享内存的使用。

假设我们有一个任务,需要计算一个数组中所有元素的总和。

我们将使用多个线程并行地计算数组的不同区域,然后将每个线程的结果相加以得到最终的总和。

首先,我们需要引入Rust的标准库中的相关模块:```rustuse std::thread;use std::sync::{Arc, Mutex};```然后,我们定义一个计算线程的函数:```rustfn calculate_sum(data: Arc<Vec<i32>>, start: usize, end: usize, result: Arc<Mutex<i32>>) {let mut sum = 0;for i in start..end {sum += data[i];}let mut result = result.lock().unwrap();*result += sum;}```在上面的代码中,我们使用了`Arc<T>`来共享数组和结果变量,以及`Mutex<T>`来确保对结果变量的线程安全访问。

在每个线程中,我们使用start和end参数指定需要计算的数组区域。

接下来,我们创建主函数来调度多个计算线程:```rustfn main() {let data = Arc::new(vec![1, 2, 3, 4, 5, 6, 7, 8, 9, 10]);let result = Arc::new(Mutex::new(0));let num_threads = 4;let chunk_size = data.len() / num_threads;let mut handles = Vec::new();for i in 0..num_threads {let start = i * chunk_size;let end = if i == num_threads - 1 {data.len()} else {(i + 1) * chunk_size};let data_clone = Arc::clone(&data);let result_clone = Arc::clone(&result);let handle = thread::spawn(move || {calculate_sum(data_clone, start, end, result_clone); });handles.push(handle);}for handle in handles {handle.join().unwrap();}let total_sum = *result.lock().unwrap();println!("Total sum: {}", total_sum);}```在上面的主函数中,我们首先创建一个包含数字1到10的vector,并使用`Arc::new`将其包装为一个在多个线程间安全共享的`Arc<Vec<i32>>`。

Linux下共享内存SUNNY.MAN共享内存允许两个或多个进程进程共享同一块内存(这块内存会映射到各个进程自己独立的地址空间) 从而使得这些进程可以相互通信,进程退出时会自动和已经挂接的共享内存区段分离,但是仍建议当进程不再使用共享区段时调用shmdt来卸载区段。

注意,当一个进程分支出父进程和子进程时,父进程先前创建的所有共享内存区段都会被子进程继承。

如果区段已经做了删除标记(在前面以IPC_RMID指令调用shmctl),而当前挂接数已经变为0,这个区段就会被移除。

Linux中通过API函数shmget创建的共享内存一般都是在程序中使用shmctl来释放的,但是有时为了调试程序,开发人员可能通过Ctrl + C等方式发送中断信号来结束程序,此时程序申请的共享内存就不能得到释放,当然如果程序没有改动的话,重新运行程序时仍然会使用上次申请的共享内存,但是如果我们修改了程序,由于共享内存的大小不一致等原因会导致程序申请共享内存错误。

因此,我们总是希望每次结束时就能释放掉申请的共享内存。

有两种方法可以用来释放共享内存:第一种:如果总是通过Crtl+C来结束的话,可以做一个信号处理器,当接收到这个信号的时候,先释放共享内存,然后退出程序。

第二种:不管你以什么方式结束程序,如果共享内存还是得不到释放,那么可以通过linux命令ipcrm shm shmid来释放,在使用该命令之前可以通过ipcs -m命令来查看共享内存。

共享内存查看使用ipcs命令,不加如何参数时,会把共享内存、信号量、消息队列的信息都打印出来,如果只想显示共享内存信息,使用如下命令:[root@localhost ~]# ipcs –m同样共享内存的大小也可以用ipcs –lm来查看它的上限下限。

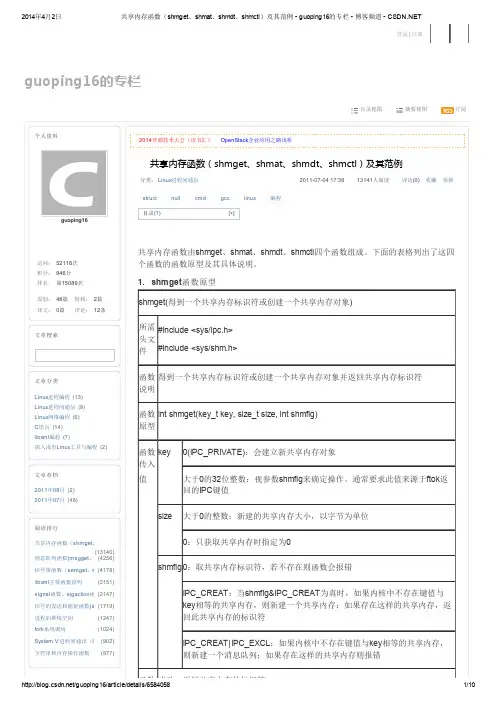

shmget( ) 创建一个新的共享内存区段取得一个共享内存区段的描述符shmctl( ) 取得一个共享内存区段的信息为一个共享内存区段设置特定的信息移除一个共享内存区段shmat( ) 挂接一个共享内存区段shmdt( ) 于一个共享内存区段的分离同样共享内存的大小也可以用ipcs –lm来查看它的上限下限。

《Linux高级系统编程》教学教案一、教学目标1. 让学生掌握Linux系统编程的基本概念和原理。

2. 培养学生熟练使用Linux系统编程API的能力。

3. 使学生了解Linux系统编程的高级主题和技巧。

4. 培养学生解决实际问题的能力,提高他们在Linux环境下的软件开发水平。

二、教学内容1. Linux系统编程概述讲解Linux系统编程的基本概念、特点和优势。

2. 文件I/O操作介绍Linux文件I/O模型,讲解文件的打开、关闭、读写、同步等操作。

3. 进程管理讲解Linux进程的概念、创建、终止、进程间通信等知识。

4. 线程管理介绍Linux线程的基本概念、创建、同步、互斥等知识。

5. 高级I/O操作讲解Linux高级I/O操作,如异步I/O、直接I/O、内存映射I/O等。

三、教学方法1. 讲授法:讲解基本概念、原理和知识点。

2. 案例教学法:通过实际案例让学生掌握编程技巧和方法。

3. 实验教学法:安排实验课程,让学生亲自动手实践,提高实际操作能力。

四、教学环境1. 教室环境:投影仪、计算机、网络等。

2. 实验环境:装有Linux操作系统的计算机、网络等。

五、教学评估1. 课堂问答:检查学生对课堂知识的理解和掌握程度。

2. 实验报告:评估学生在实验过程中的动手能力和解决问题能力。

3. 课程作业:检查学生对课程知识点的综合运用能力。

4. 期末考试:全面评估学生对本门课程的掌握程度。

六、信号处理1. 信号基本概念讲解信号的定义、作用和信号处理的基本方法。

2. 信号处理函数介绍Linux信号处理函数,如signal(), rse(), sigaction()等。

3. 信号在进程和线程中的处理讲解信号在进程和线程中的传播和处理机制。

七、同步与互斥1. 同步与互斥基本概念讲解同步与互斥的概念、作用和应用场景。

2. 互斥锁介绍Linux互斥锁的使用,如pthread_mutex_lock(), pthread_mutex_unlock()等。

linux申请numa内存方法NUMA(Non-Uniform Memory Access)是一种用来处理多处理器系统中内存访问分布不均的技术。

NUMA架构中,每个处理器都有其私有的本地内存,同时也连接到共享内存中。

这种架构的目的是使每个处理器访问其本地内存的速度更快,并在需要时与其他处理器共享内存。

在Linux操作系统中,NUMA架构的支持是通过内核模块进行实现的。

在有NUMA架构的情况下,内核会自动将系统中的内存划分为多个节点。

每个节点都有其本地内存和共享内存,而各个节点之间的内存访问延迟是不同的。

如果应用程序能够使用NUMA感知的方式进行内存分配,则可以使程序更高效地利用系统的资源。

在Linux系统中,可以使用numactl命令来管理NUMA内存。

该命令可以在不同的NUMA节点之间分配内存。

以下是在Linux系统上申请NUMA内存的步骤:1. 检查系统是否支持NUMA在终端中输入以下命令:numactl hardware若系统支持NUMA,则会输出类似以下的信息:available: 2 nodes (0-1)node 0 cpus: 0 1 2 3node 0 size: 19027 MBnode 0 free: 14982 MBnode 1 cpus: 4 5 6 7node 1 size: 20480 MBnode 1 free: 19334 MBnode distances:node 0 10: 10 201: 20 102. 安装NUMA工具包如果系统未安装NUMA工具包,可以在终端中输入以下命令进行安装:sudo apt-get install numactl3. 申请NUMA内存在终端中输入以下命令:numactl membind=0 interleave=all <command>其中,membind参数表示内存绑定,0表示绑定到第一个节点上;interleave 参数表示交错内存分配,all表示将内存分配到所有节点上;<command>表示需要运行的命令或程序。

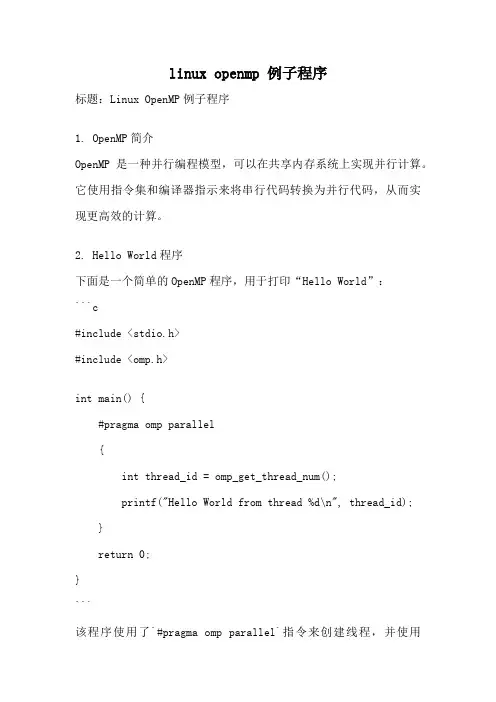

linux openmp 例子程序标题:Linux OpenMP例子程序1. OpenMP简介OpenMP是一种并行编程模型,可以在共享内存系统上实现并行计算。

它使用指令集和编译器指示来将串行代码转换为并行代码,从而实现更高效的计算。

2. Hello World程序下面是一个简单的OpenMP程序,用于打印“Hello World”:```c#include <stdio.h>#include <omp.h>int main() {#pragma omp parallel{int thread_id = omp_get_thread_num();printf("Hello World from thread %d\n", thread_id);}return 0;}```该程序使用了`#pragma omp parallel`指令来创建线程,并使用`omp_get_thread_num()`函数获取线程ID。

3. 并行for循环OpenMP可以很方便地并行化for循环。

下面是一个计算数组元素和的例子:```c#include <stdio.h>#include <omp.h>int main() {int sum = 0;#pragma omp parallel for reduction(+:sum)for (int i = 0; i < 100; i++) {sum += i;}printf("Sum: %d\n", sum);return 0;}```在上述代码中,`#pragma omp parallel for`指令将for循环并行化,`reduction(+:sum)`指示OpenMP将每个线程的局部和累加到全局和`sum`中。

4. 并行化矩阵乘法OpenMP也可以用于并行化矩阵乘法。

下面是一个简单的矩阵乘法示例:```c#include <stdio.h>#include <omp.h>#define N 100void matrix_multiply(int A[N][N], int B[N][N], int C[N][N]) {#pragma omp parallel forfor (int i = 0; i < N; i++) {for (int j = 0; j < N; j++) {C[i][j] = 0;for (int k = 0; k < N; k++) {C[i][j] += A[i][k] * B[k][j];}}}}int main() {int A[N][N];int B[N][N];int C[N][N];// 初始化A和B矩阵matrix_multiply(A, B, C);// 打印结果return 0;}```在上述代码中,`#pragma omp parallel for`指令将外层循环并行化,从而加快矩阵乘法的计算速度。

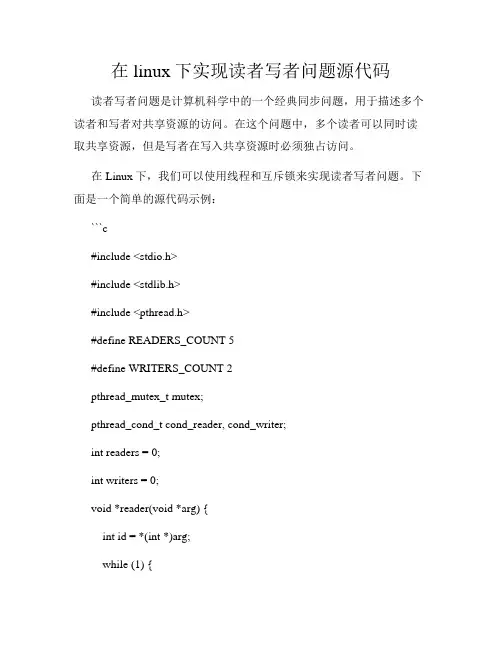

在linux下实现读者写者问题源代码读者写者问题是计算机科学中的一个经典同步问题,用于描述多个读者和写者对共享资源的访问。

在这个问题中,多个读者可以同时读取共享资源,但是写者在写入共享资源时必须独占访问。

在Linux下,我们可以使用线程和互斥锁来实现读者写者问题。

下面是一个简单的源代码示例:```c#include <stdio.h>#include <stdlib.h>#include <pthread.h>#define READERS_COUNT 5#define WRITERS_COUNT 2pthread_mutex_t mutex;pthread_cond_t cond_reader, cond_writer;int readers = 0;int writers = 0;void *reader(void *arg) {int id = *(int *)arg;while (1) {pthread_mutex_lock(&mutex);while (writers > 0) {pthread_cond_wait(&cond_reader, &mutex); }readers++;pthread_mutex_unlock(&mutex);// 读取共享资源printf("Reader %d is reading\n", id);pthread_mutex_lock(&mutex);readers--;if (readers == 0) {pthread_cond_signal(&cond_writer);}pthread_mutex_unlock(&mutex);}pthread_exit(NULL);}void *writer(void *arg) {int id = *(int *)arg;while (1) {pthread_mutex_lock(&mutex);while (readers > 0 || writers > 0) {pthread_cond_wait(&cond_writer, &mutex); }writers++;pthread_mutex_unlock(&mutex);// 写入共享资源printf("Writer %d is writing\n", id);pthread_mutex_lock(&mutex);writers--;pthread_cond_signal(&cond_writer);pthread_cond_broadcast(&cond_reader);pthread_mutex_unlock(&mutex);}pthread_exit(NULL);}int main() {pthread_t readers[READERS_COUNT];pthread_t writers[WRITERS_COUNT];int reader_ids[READERS_COUNT];int writer_ids[WRITERS_COUNT];pthread_mutex_init(&mutex, NULL);pthread_cond_init(&cond_reader, NULL);pthread_cond_init(&cond_writer, NULL);// 创建读者线程for (int i = 0; i < READERS_COUNT; i++) {reader_ids[i] = i + 1;pthread_create(&readers[i], NULL, reader, &reader_ids[i]); }// 创建写者线程for (int i = 0; i < WRITERS_COUNT; i++) {writer_ids[i] = i + 1;pthread_create(&writers[i], NULL, writer, &writer_ids[i]); }// 等待线程结束for (int i = 0; i < READERS_COUNT; i++) {pthread_join(readers[i], NULL);}for (int i = 0; i < WRITERS_COUNT; i++) {pthread_join(writers[i], NULL);}pthread_mutex_destroy(&mutex);pthread_cond_destroy(&cond_reader);pthread_cond_destroy(&cond_writer);return 0;}```在这个源代码中,我们使用了互斥锁(`pthread_mutex_t`)和条件变量(`pthread_cond_t`)来实现读者写者问题的同步。

实验报告实验题目姓名:学号:课程名称:操作系统实验所在学院:信息科学与工程学院专业班级:计算机任课教师:实验项目名称进程通信——共享存储区和信号量一、实验目的与要求:1、了解和熟悉共享存储机制2、了解和熟悉信号量机制3、熟悉信号量机制中使用的数据结构和信号量机制的操作以及控制。

4、了解共享主存段机制,学会对共享主存段的系统调用。

二、实验设备及软件:1、PC机一台2、Linux操作系统三、实验方法(原理、流程图)一、共享存储区1、共享存储区机制的概念共享存储区(Share Memory)是 UNIX 系统中通信速度最高的一种通信机制。

该机制可使若干进程共享主存中的某一个区域,且使该区域出现(映射)在多个进程的虚地址空间中。

另一方面,一个进程的虚地址空间中又可连接多个共享存储区,每个共享存储区都有自己的名字。

当进程间欲利用共享存储区进行通信时,必须先在主存中建立一共享存储区,然后将它附接到自己的虚地址空间上。

此后,进程对该区的访问操作,与对其虚地址空间的其它部分的操作完全相同。

进程之间便可通过对共享存储区中数据的读、写来进行直接通信。

图示列出二个进程通过共享一个共享存储区来进行通信的例子。

其中,进程 A 将建立的共享存储区附接到自己的 AA’区域,进程 B 将它附接到自己的 BB’区域。

应当指出,共享存储区机制只为进程提供了用于实现通信的共享存储区和对共享存储区进行操作的手段,然而并未提供对该区进行互斥访问及进程同步的措施。

因而当用户需要使用该机制时,必须自己设置同步和互斥措施才能保证实现正确的通信。

二、涉及的系统调用1、shmget( )创建、获得一个共享存储区。

系统调用格式: shmid=shmget(key,size,flag)参数定义: int shmget(key,size,flag);key_t key;int size,flag;其中,key是共享存储区的名字;size是其大小(以字节计);flag是用户设置的标志,如IPC_CREAT。

vfork + exec 是一个在 Linux 操作系统中常用的技术组合,它的作用是创建一个新的进程,然后用另一个程序替换它。

在本文中,我们将介绍这一技术的原理、用法和一个具体的例子。

一、vfork 和 exec 的原理1. vfork 是一个系统调用,它用于创建一个新的进程,但是它与 fork 不同的是,vfork 并不会复制父进程的位置区域空间,而是直接共享父进程的位置区域空间。

2. exec 也是一个系统调用,它用于加载一个新的程序到当前的进程空间中,并开始执行这个新的程序。

exec 系统调用会把当前进程的位置区域空间替换为新程序的位置区域空间,并开始执行新程序的代码。

二、vfork 和 exec 的用法1. 使用 vfork 和 exec 的一般步骤如下:1) 父进程调用 vfork,创建一个新的子进程。

2) 子进程调用 exec,加载一个新的程序到当前的进程空间中。

2. vfork 和 exec 的组合可以用于在一个进程中执行另一个程序,而不需要创建一个新的进程。

这在一些特定的场景下非常有用,比如在某个进程中执行系统命令、启动一个新的服务等。

三、vfork + exec 的例子下面我们来看一个具体的例子,来演示如何使用 vfork 和 exec 来执行一个新程序。

我们假设有一个程序 m本人n.c,它的代码如下所示:```c#include <stdio.h>#include <unistd.h>int m本人n() {printf("This is the m本人n process\n");pid_t pid = vfork();if (pid < 0) {// vfork 出错perror("vfork");return -1;}else if (pid == 0) {// 子进程execl("/bin/ls", "ls", NULL);// 如果 execl 执行成功,下面的代码不会被执行到perror("execl");_exit(1);}printf("This is still the m本人n process\n");return 0;}```在这个例子中,我们首先在 m本人n 函数中调用 vfork 创建一个新的子进程,然后在子进程中调用 exec 加载 ls 程序,并执行它。

(最终版)linux下python和c++相互调⽤共享内存通信本⽂主要⽤于python和c++相互通信,通过共享内存相互传递数据,图像,数组,结构体。

python优势在于开发快速⽅便,有很多扩展库可⽤,且深度学习很多都是python写的。

c++底层速度快,但是开发慢,尤其是很多SLAM和图像处理的只有c++版本。

为了调试开发⽅便,有时候需要嫁接两个⼯程,根据⾃⼰实际需要决定。

⼤概思路1 c++编译动态库完成各种共享内存的实际操作。

2 python端调⽤c++动态库进⾏共享内存数据交互。

3 c++端调⽤c++动态库进⾏共享内存数据交互。

主要⽤的的是ctypes资料共享内存在 Linux 实现内存共享的函数主要有 shmget、shmat、shmdt、shmctl 这么四个。

1、shmget 得到或者创建⼀个共享内存对象int shmget(key_t key, size_t size, int shmflg)其中 key_t key 的值为⼀个IPC键值,可以通过IPC_PRIVATE 建⽴⼀个新的键值为0的共享对象,但这并不能保证与IPC对象的对应关系,不同进程之间需要同⼀个且不会重复的IPC键值来完成通信,⼀般此参数使⽤ftok函数来进⾏创建IPC键值。

size_t size 是映射共享内存的⼤⼩,单位为字节 (Byte),但在创建时这⾥的最⼩分配单位是⼀页,⼤致为4KB,当你超过4KB但是⼩于8KB时会主动分配两页,也就是不⾜⼀页(4KB)的按照⼀页计算。

int shmflg 参数是需要注明的操作模式。

0:取键值对应的共享内存,若此键值相应的共享内存不存在就报错。

IPC_CREAT:存在与键值对应的共享内存则返回标识符,若不存在则创建共享内存返回标识符。

IPC_CREAT|IPC_EXCL:不存在相应键值的共享内存则创建此共享内存,若存在则报错返回值:成功返回共享内存的标识符,失败返回-1。

linux进程间通信实验心得随着对Linux系统的深入了解,我对进程间通信(IPC)的重要性有了更深刻的认识。

在这次实验中,我通过实际操作,掌握了多种Linux进程间通信的方法,并对它们的特点和应用场景有了更清晰的了解。

实验过程中,我主要接触了三种主要的进程间通信方法:管道(Pipe)、信号(Signal)和共享内存(Shared Memory)。

每种方法都有其独特的特点和使用场景。

管道是最基本的进程间通信方式,它允许父子进程之间进行通信。

通过管道,一个进程可以将数据写入到管道中,而另一个进程可以从管道中读取数据。

我在实验中创建了多个进程,并通过管道实现了它们之间的数据传递。

虽然管道简单易用,但它的通信能力有限,只能用于父子进程或兄弟进程之间的通信。

信号是一种异步的进程间通信方式,一个进程可以向另一个进程发送信号。

接收进程可以根据信号的类型采取不同的行动。

我在实验中通过信号实现了进程间的控制和同步。

虽然信号可以用于任何两个进程之间的通信,但由于它是异步的,使用起来需要小心处理信号的捕获和处理。

共享内存是一种高效的进程间通信方式,它允许多个进程访问同一块内存空间。

通过共享内存,进程可以快速地读写数据,避免了数据在进程间传递的开销。

我在实验中创建了多个进程,让它们共享一块内存区域,并通过读写共享内存实现了数据的快速传递。

共享内存的优点是通信速度快,但需要处理好同步和互斥问题,以避免数据冲突和错误。

通过这次实验,我对Linux进程间通信有了更深入的了解。

在实际应用中,需要根据具体的需求和场景选择合适的进程间通信方法。

同时,我也认识到进程间通信的复杂性和挑战性,需要仔细考虑和处理各种可能的问题。

在未来的学习和工作中,我将继续深入学习Linux系统及其相关技术,不断提高自己的技能和能力。

同时,我也将关注新技术的发展和应用,保持对行业的敏感度和竞争力。

linux 共享内存参数设置Linux共享内存是一种在多个进程之间共享数据的机制。

它允许多个进程访问同一块内存区域,从而实现高效的数据交换和通信。

在使用共享内存时,需要设置一些参数来确保其正常运行。

我们需要设置共享内存的大小。

共享内存的大小决定了可以存储的数据量。

在设置大小时,需要考虑到实际需求和系统资源的限制。

如果共享内存过小,可能会导致数据丢失或无法存储所需的数据;如果共享内存过大,可能会占用过多的系统资源。

因此,合理设置共享内存的大小非常重要。

我们需要设置共享内存的访问权限。

共享内存的访问权限可以控制哪些进程可以读取和写入共享内存。

通常,我们可以使用权限掩码来设置访问权限。

权限掩码是一个8位的二进制数,每一位代表一个权限,例如读、写、执行等。

通过设置权限掩码,可以精确地控制进程对共享内存的访问权限。

我们还可以设置共享内存的标志位。

标志位用于指定共享内存的一些额外属性,例如是否在创建时清空共享内存、是否允许多个进程同时访问共享内存等。

通过设置标志位,可以根据实际需求来调整共享内存的行为。

除了上述参数,还有一些其他参数也需要设置。

例如,我们需要设置共享内存的键值,用于唯一标识共享内存。

键值可以是一个整数或字符串,通常使用ftok()函数来生成。

此外,我们还需要设置共享内存的标识符,用于在代码中引用共享内存。

在使用共享内存时,我们需要注意一些常见的问题。

首先,由于共享内存是多个进程共享的,因此需要使用锁机制来保护共享内存的访问。

锁可以防止多个进程同时写入相同的数据,从而避免数据的不一致性。

其次,需要注意共享内存的生命周期管理。

在使用完共享内存后,需要及时释放它,以免造成资源的浪费。

最后,还需要注意共享内存的安全性。

由于多个进程可以访问共享内存,因此需要确保数据的安全性,避免数据被非法篡改。

总结一下,Linux共享内存是一种高效的进程间通信机制。

在使用共享内存时,需要设置一些参数来确保其正常运行。

linux 共享存储磁盘的用法Linux共享存储磁盘的用法共享存储磁盘是一种用于在多个计算机之间共享文件和数据的设备。

在Linux操作系统中,有几种方法可以实现共享存储磁盘的使用。

本文将一步一步详细介绍Linux共享存储磁盘的用法。

第一步:准备共享存储磁盘首先,需要准备一块磁盘作为共享存储设备。

可以使用硬盘、SSD或者NAS(网络附加存储)设备作为共享存储磁盘。

确保磁盘已经正确连入Linux系统并正确挂载。

第二步:安装必要的软件在Linux系统上,需要安装一些必要的软件来实现共享存储磁盘的使用。

常用的软件包括Samba和NFS(Network File System)。

Samba软件包用于共享存储磁盘给Windows系统,而NFS软件包用于共享存储磁盘给Unix-like系统。

使用以下命令来安装Samba和NFS软件包:sudo apt-get install sambasudo apt-get install nfs-kernel-server第三步:配置Samba共享如果你想共享存储磁盘给Windows系统,需要进行Samba的相关配置。

首先,在终端中运行以下命令来编辑Samba的主配置文件:sudo nano /etc/samba/smb.conf在配置文件中,你需要指定要共享的目录和共享的名称。

在配置文件的底部,添加以下行:[shared]comment = Shared Storagepath = /path/to/shared/directoryread only = noguest ok = yes在上述配置中,将“/path/to/shared/directory”替换为你要共享的目录的实际路径。

保存并关闭配置文件。

接下来,重新启动Samba服务以使配置生效:sudo systemctl restart smbd第四步:配置NFS共享如果你想共享存储磁盘给Unix-like系统,需要进行NFS的相关配置。

Shell脚本编写的高级技巧使用共享内存和进程间通信共享内存和进程间通信是Shell脚本编写中非常重要的技巧和概念。

它们可以帮助我们实现进程之间的数据传递和通信。

本文将介绍使用共享内存和进程间通信的高级技巧,以及如何在Shell脚本中应用这些技巧。

一、共享内存1.1 什么是共享内存共享内存是一种用于进程间通信的机制,它允许不同的进程访问同一块内存区域。

通过共享内存,多个进程可以实现数据共享,从而提高程序的效率。

1.2 在Shell脚本中使用共享内存在Shell脚本中使用共享内存需要借助一些系统命令和工具,比如ipcs、ipcrm等。

下面是一个使用共享内存实现数据传递的例子:```shell#!/bin/bash# 创建共享内存shm_id=$(ipcs -m | grep "0x" | awk '{ print $2 }')if [ -z "$shm_id" ]; thenshm_id=$(ipcmk -M | awk '{ print $NF }')fi# 写入数据data="Hello, shared memory!"echo -n "$data" > /dev/shm/$shm_id# 读取数据data=$(cat /dev/shm/$shm_id)echo "Shared memory data: $data"# 删除共享内存ipcrm -M $shm_id```这个脚本首先用ipcs命令检查是否已存在共享内存,如果不存在则用ipcmk命令创建一块共享内存。

然后,它通过echo命令将数据写入共享内存,再通过cat命令读取共享内存中的数据。

最后,使用ipcrm 命令删除共享内存。

二、进程间通信2.1 什么是进程间通信进程间通信(Inter-Process Communication,简称IPC)是指不同进程之间进行数据交换和通信的机制。

Linux命令高级技巧使用ipcs和ipcrm管理共享内存和信号量Linux命令高级技巧:使用ipcs和ipcrm管理共享内存和信号量在Linux操作系统中,共享内存和信号量是进程间通信的重要手段。

使用ipcs和ipcrm命令可以对共享内存和信号量进行管理和操作。

本文将介绍如何使用ipcs和ipcrm命令来高效管理共享内存和信号量。

一、共享内存介绍及管理共享内存是进程之间共享数据的一种方式,提高了进程间数据交换的效率。

在Linux中,使用ipcs命令可以查看当前系统中存在的共享内存情况。

```bash$ ipcs -m```上述命令将列出所有共享内存的相关信息,包括共享内存的标识符、大小、进程ID等。

通过查看这些信息,我们可以了解当前系统的共享内存使用情况。

接下来,我们可以使用ipcrm命令来删除无用的共享内存。

```bash$ ipcrm -m <共享内存标识符>```上述命令将删除指定标识符的共享内存。

需要注意的是,只有创建该共享内存的进程或具有足够权限的用户才能删除共享内存。

二、信号量介绍及管理信号量是用来协调多个进程之间对共享资源的访问的一种机制。

在Linux中,使用ipcs命令可以查看当前系统中存在的信号量。

```bash$ ipcs -s```上述命令将列出所有信号量的相关信息,包括信号量的标识符、当前值、进程ID等。

通过查看这些信息,我们可以了解当前系统的信号量使用情况。

与共享内存类似,我们可以使用ipcrm命令来删除无用的信号量。

```bash$ ipcrm -s <信号量标识符>```上述命令将删除指定标识符的信号量。

同样需要注意的是,只有创建该信号量的进程或具有足够权限的用户才能删除信号量。

三、使用案例下面以一个实际的使用案例来说明如何使用ipcs和ipcrm命令进行共享内存和信号量的管理。

假设我们有两个进程A和B,需要使用共享内存和信号量进行数据交换和同步。