第12章 python 回归分析

- 格式:pptx

- 大小:3.49 MB

- 文档页数:101

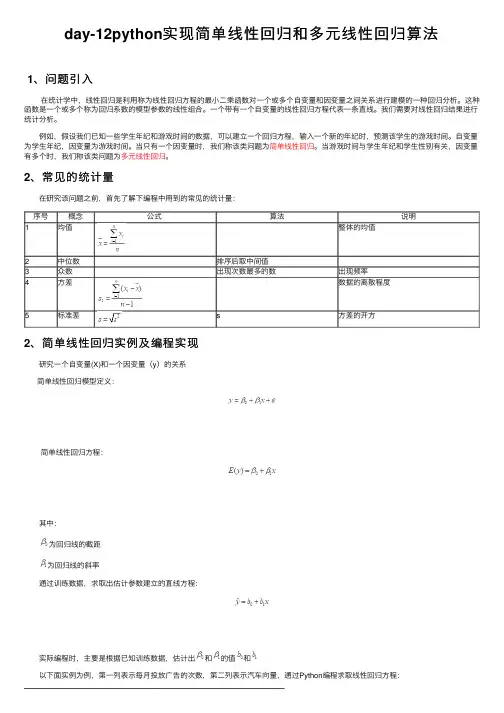

day-12python 实现简单线性回归和多元线性回归算法1、问题引⼊ 在统计学中,线性回归是利⽤称为线性回归⽅程的最⼩⼆乘函数对⼀个或多个⾃变量和因变量之间关系进⾏建模的⼀种回归分析。

这种函数是⼀个或多个称为回归系数的模型参数的线性组合。

⼀个带有⼀个⾃变量的线性回归⽅程代表⼀条直线。

我们需要对线性回归结果进⾏统计分析。

例如,假设我们已知⼀些学⽣年纪和游戏时间的数据,可以建⽴⼀个回归⽅程,输⼊⼀个新的年纪时,预测该学⽣的游戏时间。

⾃变量为学⽣年纪,因变量为游戏时间。

当只有⼀个因变量时,我们称该类问题为简单线性回归。

当游戏时间与学⽣年纪和学⽣性别有关,因变量有多个时,我们称该类问题为多元线性回归。

2、常见的统计量 在研究该问题之前,⾸先了解下编程中⽤到的常见的统计量:序号概念公式 算法说明1均值整体的均值2中位数排序后取中间值 3众数出现次数最多的数出现频率4⽅差数据的离散程度5标准差 s ⽅差的开⽅2、简单线性回归实例及编程实现 研究⼀个⾃变量(X)和⼀个因变量(y )的关系简单线性回归模型定义:简单线性回归⽅程: 其中:为回归线的截距 为回归线的斜率 通过训练数据,求取出估计参数建⽴的直线⽅程: 实际编程时,主要是根据已知训练数据,估计出和的值和 以下⾯实例为例,第⼀列表⽰每⽉投放⼴告的次数,第⼆列表⽰汽车向量,通过Python 编程求取线性回归⽅程:投放⼴告数汽车销量投放⼴告数汽车销量114324218117327编程关键在于如何求取b0和b1的值,我们引⼊⼀个⽅程(sum of square): 当上述⽅程的值最⼩时,我们认为求取到线程回归⽅程参数的值,对该⽅程求最⼩值可以进⼀步转化为求导和求极值的问题,求导过程省略,最后结论如下: 实际代码:import numpy as npfrom matplotlib import pylab as pl# 定义训练数据x = np.array([1,3,2,1,3])y = np.array([14,24,18,17,27])# 回归⽅程求取函数def fit(x,y):if len(x) != len(y):returnnumerator = 0.0denominator = 0.0x_mean = np.mean(x)y_mean = np.mean(y)for i in range(len(x)):numerator += (x[i]-x_mean)*(y[i]-y_mean)denominator += np.square((x[i]-x_mean))print('numerator:',numerator,'denominator:',denominator)b0 = numerator/denominatorb1 = y_mean - b0*x_meanreturn b0,b1# 定义预测函数def predit(x,b0,b1):return b0*x + b1# 求取回归⽅程b0,b1 = fit(x,y)print('Line is:y = %2.0fx + %2.0f'%(b0,b1))# 预测x_test = np.array([0.5,1.5,2.5,3,4])y_test = np.zeros((1,len(x_test)))for i in range(len(x_test)):y_test[0][i] = predit(x_test[i],b0,b1)# 绘制图像xx = np.linspace(0, 5)yy = b0*xx + b1pl.plot(xx,yy,'k-')pl.scatter(x,y,cmap=pl.cm.Paired)pl.scatter(x_test,y_test[0],cmap=pl.cm.Paired)pl.show() 蓝⾊表⽰测试数据,橙⾊表⽰预测数据。

python回归曲线方程概述及解释说明1. 引言1.1 概述Python回归曲线方程是一种在数据分析和数据建模中常用的技术工具。

通过拟合数据集,回归分析可以帮助我们找到数据之间的关系模式,并预测未知的变量值。

而回归曲线方程则是这个关系模式的数学表达式。

1.2 文章结构本文将从以下几个方面介绍Python回归曲线方程:基本概念、解释说明主要要点以及实现方法。

文章主要分为引言、Python回归曲线方程的基本概念、解释说明回归曲线方程的主要要点、Python实现回归曲线方程的方法及示例代码以及结论与展望五个部分。

1.3 目的本文旨在提供一个全面且系统化的介绍,帮助读者理解和掌握Python回归曲线方程。

通过阅读本文,读者将了解回归分析相关概念,理解回归曲线方程的含义以及掌握使用Python进行回归分析和实现曲线拟合的方法。

感谢您阅读本篇文章“1. 引言”部分内容,请继续阅读下一部分“2. Python回归曲线方程的基本概念”。

2. Python回归曲线方程的基本概念2.1 回归分析简介回归分析是一种统计学方法,用于研究变量之间的关系。

通过建立数学模型,回归分析可以预测一个或多个自变量(X)对因变量(Y)的影响,并找出它们之间的函数关系。

常见的回归分析模型包括线性回归、多项式回归、指数回归等。

2.2 曲线拟合与回归分析的关系曲线拟合是指在给定的数据集上找到最合适的曲线形式来表示数据点之间的趋势。

而回归分析则是在已知自变量和因变量之间存在某种函数关系时,通过拟合得到这个函数,进而预测未知因变量值。

曲线拟合通常被应用于非线性问题或者数据集中存在异常值的情况下。

通过使用非线性模型进行曲线拟合可以更好地描述数据之间复杂的关系。

在实践中,曲线拟合经常与回归分析相结合,以得到更准确和可靠的结果。

Python作为一种强大且广泛应用于科学计算和数据分析领域的编程语言,提供了多种工具和库,方便进行回归分析和曲线拟合。

2.3 Python在回归分析中的应用Python提供了多个用于回归分析的强大库,其中最常见的是NumPy、SciPy 和scikit-learn。

python二次函数回归-概述说明以及解释1.引言1.1 概述概述:二次函数回归是一种常见的数据分析方法,用于研究变量之间的非线性关系。

在实际应用中,二次函数回归可以帮助我们理解数据之间的复杂关系,并用于预测未来的趋势。

Python作为一种强大的编程语言,提供了丰富的库和工具,使得二次函数回归分析变得更加简单和高效。

本文将介绍二次函数回归的概念、Python中的二次函数回归方法以及它在实际中的应用,以及对Python二次函数回归的展望。

通过本文的学习,读者可以了解二次函数回归的优势,并深入理解Python在二次函数回归分析中的应用前景。

文章结构部分内容如下:1.2 文章结构本文将分为三个部分:引言、正文和结论。

- 引言部分将介绍二次函数回归的概念和目的,以及文章的结构安排。

- 正文部分将详细介绍二次函数回归的概念,以及Python中的二次函数回归方法及其在实际中的应用。

- 结论部分将总结二次函数回归的优势,并展望Python二次函数回归的发展趋势,最终得出结论。

通过以上结构的安排,读者可以清晰地了解本文的内容和结构,有助于更好地理解和掌握Python中的二次函数回归方法。

1.3 目的本篇文章的目的在于介绍Python中二次函数回归的方法和应用。

通过本文的阐述,读者将了解二次函数回归的概念和原理,并掌握Python 中实现二次函数回归的方法。

我们将深入探讨二次函数回归在实际中的应用场景,从而帮助读者更好地理解并运用该方法。

最终,我们将总结二次函数回归的优势,并展望Python在二次函数回归领域的未来发展。

希望通过本文的阐述,读者能够深入了解二次函数回归在数据分析和预测中的重要性,以及Python在此领域的应用前景。

2.正文2.1 二次函数回归的概念二次函数回归是一种统计分析方法,用于模拟或预测因变量与自变量之间的非线性关系。

在这种方法中,通过拟合一个二次函数模型来描述数据的趋势和模式。

二次函数的一般形式为:y = ax^2 + bx + c,其中a、b、c为需要估计的参数,x为自变量,y为因变量。

Python的OLS(Ordinary Least Squares)回归是统计学中常用的线性回归分析方法,该方法通过最小化观测值与回归线的残差平方和来估计自变量对因变量的影响程度。

在本文中,我们将深入探讨Python 中OLS回归的格式和相关内容。

一、准备工作在使用Python进行OLS回归之前,首先需要安装必要的库和模块。

常用的统计学库包括statsmodels和Pandas,通过以下代码可以轻松导入这些库:```pythonimport numpy as npimport pandas as pdimport statsmodels.api as sm```二、数据准备在进行OLS回归分析之前,需要准备好要分析的数据集。

通常情况下,数据集以DataFrame的形式存储在.csv或.xlsx文件中,可以通过Pandas库的read_csv()或read_excel()函数进行读取。

假设我们有一个包含自变量X和因变量Y的数据集data.csv,可以使用以下代码加载数据:```pythondata = pd.read_csv('data.csv')X = data['X']Y = data['Y']```三、添加截距在进行OLS回归分析时,通常会添加一个截距项。

在Python的OLS 回归中,可以通过Statsmodels库的add_constant()函数为自变量添加截距。

具体操作如下:```pythonX = sm.add_constant(X)```四、拟合模型添加截距项后,接下来就可以利用Statsmodels库的OLS()函数拟合回归模型。

该函数的参数包括因变量Y和自变量X,拟合过程如下:```pythonmodel = sm.OLS(Y, X).fit()```五、查看回归结果拟合回归模型后,可以通过summary()方法查看OLS回归结果的详细信息,包括回归系数、截距、残差、拟合优度等指标。

python多元回归的步骤和方法多元回归是一种经济学和统计学中常用的分析方法,用于研究多个自变量对一个因变量的影响关系。

在Python中,可以使用多种库来进行多元回归分析,包括statsmodels和scikit-learn等。

下面是在Python中进行多元回归分析的一般步骤和方法:步骤一:数据收集和准备1.收集与研究问题相关的数据,包括自变量和因变量的数据。

2.对数据进行处理和清洗,包括去除缺失值、异常值和重复值等。

步骤二:建立回归模型1. 导入相应的库,例如statsmodels或scikit-learn。

2.确定自变量和因变量的关系,例如线性回归、多项式回归或其他形式的回归模型。

3. 使用合适的库函数或类来建立回归模型,例如statsmodels库的OLS函数或scikit-learn库的线性回归类。

步骤三:模型拟合和评估1.使用建立好的回归模型对数据进行拟合,即计算自变量对应的因变量的预测值。

2.根据实际观测值和预测值之间的误差,评估模型的拟合程度。

3. 使用合适的评估指标,例如均方误差(Mean Squared Error,MSE)或决定系数(Coefficient of Determination,R-squared)来评估模型的性能。

步骤四:统计推断和解释模型1.进行统计推断,例如参数估计、假设检验和置信区间等,来确定自变量的影响显著性。

2.解释模型的结果,例如确定自变量对因变量的影响方向、大小和显著性等。

步骤五:模型优化和验证1.根据模型结果,进行模型的优化和改进,例如添加或删除自变量、转换变量等,以提高模型的拟合程度和预测能力。

2.使用交叉验证等方法来验证和评估优化后的模型的性能。

在Python中,有多个库可以用于多元回归分析。

下面介绍两个常用的库及其使用方法:1. statsmodelsstatsmodels是一个专门用于统计建模和推断的Python库。

使用statsmodels进行多元回归分析的步骤如下:```import numpy as npimport pandas as pdimport statsmodels.api as sm#导入数据data = pd.read_csv('data.csv')X = data[['x1', 'x2', 'x3']] # 自变量y = data['y'] # 因变量#添加截距项X = sm.add_constant(X)#建立回归模型model = sm.OLS(y, X)#拟合数据results = model.fit#查看模型摘要print(results.summary()```2. scikit-learnscikit-learn是Python中常用的机器学习库,也提供了用于多元回归分析的相应功能。

回归分析特征选择(包括Stepwise算法)python实现# -*- coding: utf-8 -*-"""Created on Sat Aug 18 16:23:17 2018@author: acadsoc"""import scipyimport numpy as npimport pandas as pdimport matplotlibimport matplotlib.pyplot as pltfrom sklearn.ensemble import RandomForestRegressorfrom sklearn.cross_validation import cross_val_predict, cross_val_score, train_test_splitfrom sklearn.metrics import accuracy_score, roc_auc_score, r2_scorefrom sklearn.grid_search import RandomizedSearchCVfrom sklearn.linear_model import Lasso, LassoCV, ElasticNetfrom sklearn.pipeline import Pipelinefrom sklearn.preprocessing import StandardScalerfrom statsmodels.formula import api as smfimport sysimport ose('ggplot') # 设置ggplot2画图风格# 根据不同平台设置其中⽂字体路径if sys.platform == 'linux':zh_font = matplotlib.font_manager.FontProperties(fname='/path/anaconda3/lib/python3.6/site-packages/matplotlib/mpl-data/fonts/ttf/STZHONGS.TTF')else:zh_font = matplotlib.font_manager.FontProperties(fname='C:\Windows\Fonts\STZHONGS.ttf') # 设置中⽂字体# 根据不同平台设定⼯作⽬录if sys.platform == 'linux':os.chdir('path/jupyternb/ml/acadsoc/rollingRegression') # Linux pathelse:os.chdir('D:/Python/rollingRegression') # Windows pathclass featureSelection():'''多元线性回归特征选择类。

Python数据分析—分段回归引言分段回归是一种在数据分析中常用的技术,它可以用于拟合不同部分具有不同趋势的数据。

Python提供了强大的数据分析工具,可以轻松地进行分段回归分析。

本文将介绍Python中进行分段回归的基本方法和步骤。

步骤1. 导入所需的库在进行分段回归之前,需要导入以下常用的Python库:numpy、pandas和matplotlib。

这些库提供了处理数据和绘制图表所需的功能。

import numpy as npimport pandas as pdimport matplotlib.pyplot as plt2. 加载数据使用pandas库的read_csv函数加载待分析的数据集。

确保数据集包含需要进行分段回归的变量。

data = pd.read_csv('data.csv')3. 数据预处理根据需要,可以对数据进行预处理,例如去除缺失值或异常值。

这可以确保分析的准确性和可靠性。

data = data.dropna() # 去除缺失值data = data[(data['column'] > lower_bound) & (data['column'] < upper_bound)] # 去除异常值4. 划分数据段根据数据的特征,将数据划分为若干段,并进行分段回归分析。

可以使用numpy库的linspace函数将数据段等间距划分。

segments = np.linspace(min(data['column']), max(data['column']), num_segments+1)5. 进行分段回归使用for循环遍历每个数据段,在每个段内进行回归分析。

可以使用numpy库的polyfit函数进行多项式回归。

res = [] # 存储每个数据段的回归结果for i in range(num_segments):segment_data = data[(data['column'] >= segments[i]) &(data['column'] < segments[i+1])]x = segment_data['column']y = segment_data['target']coef = np.polyfit(x, y, degree)res.append(coef)6. 可视化分析结果根据需要,可以使用matplotlib库绘制分段回归的结果图表。

Python中的回归分析和主成分分析Python中的回归分析和主成分分析回归分析和主成分分析是机器学习领域中的两个重要方法,它们可以用来处理和探索数据集中的关系。

Python是一门流行的编程语言,其中有许多用于回归分析和主成分分析的包和模块,使其成为处理数据集和分析数据的理想工具。

回归分析回归分析是一种用于确定变量之间关系的统计方法。

它适用于探索一个或多个自变量对因变量的影响。

这种方法的目标是构建一组方程,可以使用自变量的值预测因变量。

回归分析可以用来构建预测模型,从而了解原因和影响之间的关系。

常见的回归分析方法包括线性回归、多项式回归、逻辑回归、岭回归和Lasso回归等。

其中,线性回归是最常见的一种回归分析方法。

它假定自变量和因变量之间是线性关系,可以通过最小二乘法来估计模型参数。

在Python中,scikit-learn是一个流行的包,提供了各种回归算法的实现。

下面是使用scikit-learn进行线性回归分析的示例:```pythonfrom sklearn.linear_model import LinearRegression import numpy as np#创建一个样例数据集X = 2 * np.random.rand(100, 1)y = 4 + 3 * X + np.random.randn(100, 1)#使用scikit-learn进行线性回归分析model = LinearRegression()model.fit(X, y)#打印模型参数print(model.intercept_, model.coef_)```这个例子中,我们生成了一个包含100个样本的数据集,其中自变量X是一个2维的随机数组,而因变量y则是由X生成的。

使用scikit-learn的LinearRegression模型进行线性回归分析,我们可以得到模型的截距和系数。

主成分分析主成分分析(PCA)是一种广泛用于降维和特征提取的技术。

在Python 中,使用ols回归通常是指普通最小二乘法(Ordinary Least Squares)回归。

它是一种常用的线性回归方法,用于建立自变量和因变量之间的线性关系。

下面是对ols回归结果的解释:1.模型摘要(Model Summary):提供了回归模型的一些关键信息,如相关系数(R-squared)、调整后的相关系数(AdjustedR-squared)、均方误差(Mean Squared Error)等。

相关系数表示自变量对因变量的解释能力,取值范围在0 到 1 之间,越接近 1 表示模型的拟合效果越好。

调整后的相关系数考虑了自变量的数量,可用于比较不同模型的拟合效果。

均方误差是预测值与实际值之间的平均差异,用于衡量模型的预测误差。

2.参数估计(Parameter Estimates):列出了回归模型中每个自变量的系数估计值,以及它们的标准误差、t 统计量和p 值。

系数估计值表示自变量对因变量的影响程度,正的系数表示正相关,负的系数表示负相关。

标准误差用于衡量系数估计值的不确定性。

t 统计量用于检验系数是否显著不为零,p 值表示系数在零假设(系数为零)下的概率,p 值小于或等于显著性水平(通常为0.05)时,我们可以拒绝零假设,认为系数显著不为零。

3.残差分析(Residual Analysis):提供了残差的一些统计信息,如残差的标准差、偏度和峰度等。

残差是实际值与预测值之间的差异,可以用于检查模型是否满足假设,如正态性、等方差性等。

通过对ols回归结果的解释,我们可以了解自变量对因变量的影响程度、模型的拟合效果以及是否满足假设等信息,从而评估回归模型的可靠性和有效性。

请注意,具体的解释和分析可能会因数据和研究问题的不同而有所差异,建议结合实际情况进行详细的分析和解读。

pythonols用法随着Python的普及,越来越多的数据分析需求被提上了日程。

其中,OLS(OrdinaryLeastSquares)回归分析作为一种常用的统计方法,在Python中也有着广泛的应用。

本文将详细介绍Python中OLS 回归分析的用法,帮助读者更好地理解和应用这一方法。

一、OLS回归分析的基本原理OLS回归分析是一种通过最小化样本数据中误差平方和的方法,来估计一个线性模型参数的方法。

它通过线性方程的形式,将因变量与自变量之间的关系表示出来,从而揭示变量之间的统计关系。

二、Python中OLS回归分析的实现步骤1.导入必要的库在Python中,要进行OLS回归分析,需要导入相关的库,如NumPy、Pandas和Statsmodels等。

这些库提供了丰富的功能,可以方便地进行数据处理和统计分析。

2.读取数据读取数据是进行OLS回归分析的第一步。

可以使用Pandas库来读取各种格式的数据文件,如CSV、Excel等。

在读取数据时,需要注意数据的清洗和预处理,以保证数据的准确性和完整性。

3.建立OLS回归模型使用Statsmodels库中的OLS函数,可以方便地建立OLS回归模型。

在建立模型时,需要指定因变量和自变量,并设置其他相关的参数,如截距项、拟合度指标等。

4.模型评估和解释建立好OLS回归模型后,需要进行模型的评估和解释。

可以使用Statsmodels库中的各种统计指标,如R方、调整R方、F值等,来评估模型的拟合度。

同时,还可以使用模型的结果来解释自变量和因变量之间的关系,为实际应用提供指导。

三、Python中OLS回归分析的案例分析下面是一个简单的Python代码示例,演示了如何使用OLS回归分析来分析一个数据集。

```pythonimportnumpyasnpimportpandasaspdfromstatsmodels.linear_model.OLSimportOLS#读取数据集data=pd.read_csv('data.csv')#定义自变量和因变量X=data['independent_variable'].values.reshape(-1,1)y=data['dependent_variable'].values.reshape(-1,1)#建立OLS回归模型model=OLS(y,X)results=model.fit()#输出模型结果print(results.summary())```在这个示例中,我们使用Pandas库读取了一个数据集,并使用Statsmodels库中的OLS函数建立了OLS回归模型。

python逻辑回归结果解读在使用Python进行逻辑回归分析后,我们可以得到一系列结果和统计信息。

解读这些结果有助于理解模型的性能和变量的影响。

下面是常见的逻辑回归结果解读指标:1.回归系数(Coefficient):回归系数反映了自变量对因变量的影响程度。

回归系数可以是正数或负数,具体取决于特征与目标之间的关系。

一般而言,回归系数越大,表示自变量对因变量的影响越大。

2.偏移(Intercept):偏移是逻辑回归模型的截距项,代表当所有自变量均为0时,预测的目标变量的基准值。

3.p值(p-value):p值是用于检验回归系数是否显著的指标。

一般而言,p值小于0.05被认为是显著的。

如果p值大于0.05,说明该自变量对目标变量的影响可能不显著。

4.标准误差(Standard Error):标准误差是回归系数的估计标准差。

标准误差越小,表示回归系数的估计越稳定。

5.好坏拟合指标(Goodness of fit):逻辑回归模型通常用一些拟合指标来评估模型的好坏,常见的指标包括:AIC、BIC和Pseudo R-squared等。

这些指标越小越好,表示模型的拟合优度越高。

6.Odds比率(Odds Ratio):Odds比率反映了自变量的每单位变化对因变量概率的影响。

Odds Ratio的值大于1表示增加自变量的一个单位,增加目标变量的概率更高。

7.置信区间(Confidence Interval):置信区间是回归系数的一个区间估计,可以给出回归系数的置信范围。

一般使用95%置信水平,即对于给定的样本,回归系数在这个区间内的概率为95%。

以上是逻辑回归结果常见的解读指标,根据具体的模型和数据集,可能还会有其他的解读指标。

需要根据具体情况进行解读和分析,结合领域知识来理解这些指标的含义和影响。

回归系数检验python回归系数检验是统计学中常用的一种方法,用于检验自变量对因变量的影响程度。

在Python中,我们可以使用statsmodels库来进行回归系数检验。

下面我将介绍如何使用Python进行回归系数检验的步骤。

首先,我们需要安装statsmodels库。

可以使用以下命令来安装该库:python.pip install statsmodels.安装完成后,我们可以使用以下代码来进行回归系数检验:python.import statsmodels.api as sm.import numpy as np.# 创建自变量和因变量数据。

X = np.array([1, 2, 3, 4, 5])。

y = np.array([2, 3, 5, 4, 6])。

# 添加截距项。

X = sm.add_constant(X)。

# 拟合线性回归模型。

model = sm.OLS(y, X).fit()。

# 输出回归系数。

print(model.params)。

# 进行回归系数检验。

print(model.summary())。

在上面的代码中,我们首先创建了自变量X和因变量y的数据。

然后,我们使用add_constant函数为自变量X添加了截距项,接着使用OLS函数拟合了线性回归模型。

最后,我们输出了回归系数和进行了回归系数检验。

通过以上步骤,我们可以使用Python进行回归系数检验。

这对于分析自变量对因变量的影响程度非常有帮助,希望对你有所帮助。

Python复杂组合回归模型一、概述随着数据科学领域的发展,回归分析作为一种常用的预测建模技术,对于探索变量之间的关系以及预测目标变量的值具有重要意义。

在实际应用中,经常遇到多个自变量对目标变量的影响性非线性、交互作用复杂等情况,这时候就需要使用复杂组合回归模型来更好地拟合数据。

二、复杂组合回归模型介绍1. 传统线性回归模型传统的线性回归模型假设自变量与因变量之间的关系是线性的,即因变量与自变量之间呈现出直线关系。

但是,在实际应用中,很多情况下自变量与因变量之间的关系并非简单的线性关系,这时候需要采用更复杂的回归模型来拟合数据。

2. 多项式回归模型多项式回归模型是一种常用的复杂组合回归模型,它通过引入自变量的高次项来拟合非线性关系。

对于单一自变量x,多项式回归模型可以表示为y = β0 + β1x + β2x^2 + ... + βnx^n。

这种模型适用于因变量与自变量之间的关系呈现出曲线形状的情况。

3. 交互作用回归模型在实际应用中,自变量之间通常存在交互作用,即一个自变量的影响效果受到其他自变量的影响。

交互作用回归模型可以有效地捕捉这种复杂关系,它通过引入自变量之间的乘积项来描述交互作用的影响。

4. 岭回归和Lasso回归岭回归和Lasso回归是一种正则化的线性回归方法,通过引入惩罚项来防止过拟合和提高模型的泛化能力。

它们适用于自变量之间存在共线性或者自变量较多的情况。

5. 集成回归模型集成回归模型通过结合多个基本回归模型来提高预测性能,常见的集成方法包括随机森林回归、梯度提升回归等。

这些模型适用于处理复杂的、非线性的数据关系,并且能够有效地避免过拟合问题。

三、Python在复杂组合回归模型中的应用Python作为一种强大的数据分析和建模工具,提供了丰富的库和工具来支持各种回归模型的应用,下面介绍Python中常用的库及其应用。

1. NumPy和PandasNumPy和Pandas是Python中常用的数据处理库,它们提供了丰富的数据结构和操作函数,能够方便地进行数据的处理和转换。

python中回归数据归一化处理Title: Data Normalization for Regression in Python正文:在机器学习任务中,回归分析是一种常用的方法,用于预测依赖变量与自变量之间关系的数值。

然而,由于不同自变量之间的值范围和单位可能不同,这可能导致回归模型受到自变量之间差异的影响,从而影响预测准确性。

为了解决这个问题,我们可以使用数据归一化来将所有自变量调整到相似的尺度上。

Python提供了多种方法来进行数据归一化处理。

下面介绍两种常用的方法:1. 最小-最大归一化(Min-Max Normalization):最小-最大归一化是一种常见的归一化方法,它将自变量的值线性映射到指定的范围内,通常是0到1之间。

这种方法可以通过以下公式进行计算:\[X_{\text{norm}} = \frac{{X - X_{\text{min}}}}{{X_{\text{max}} - X_{\text{min}}}}\]其中,\(X_{\text{norm}}\)是归一化后的值,\(X\)是原始值,\(X_{\text{min}}\)和\(X_{\text{max}}\)分别是自变量的最小值和最大值。

2. 标准化(Standardization):标准化是另一种常用的归一化方法,它将自变量的值映射到均值为0,标准差为1的正态分布上。

标准化可以通过以下公式进行计算:\[X_{\text{norm}} = \frac{{X - \mu}}{{\sigma}}\]其中,\(X_{\text{norm}}\)是归一化后的值,\(X\)是原始值,\(\mu\)是自变量的均值,\(\sigma\)是自变量的标准差。

在Python中,我们可以使用scikit-learn库中的preprocessing模块来实现数据归一化。

具体示例代码如下:```pythonfrom sklearn.preprocessing import MinMaxScaler, StandardScaler# 最小-最大归一化scaler = MinMaxScaler()X_minmax = scaler.fit_transform(X)# 标准化scaler = StandardScaler()X_standardized = scaler.fit_transform(X)```通过以上代码,我们得到了归一化后的自变量,可以用于回归模型的训练和预测。

一、介绍Python作为一种功能强大的编程语言,被广泛应用于数据分析、机器学习等领域。

在数据分析中,回归分析是一种常见的统计方法,而lasso回归作为一种特殊的回归方法,具有一定的独特性和适用性。

本文将结合实际案例,介绍如何使用Python进行lasso回归分析。

二、数据准备在进行回归分析之前,首先需要准备数据。

假设我们有一份包含多个自变量和一个因变量的数据集,我们将使用这份数据集进行lasso回归分析。

数据集的格式可以是CSV、Excel或者数据库中的表格形式。

三、导入数据在Python中,我们可以使用pandas库来操作和分析数据。

我们需要使用pandas库中的read_csv()或者read_excel()方法将数据导入到Python的数据结构中,比如DataFrame。

代码示例如下:```pythonimport pandas as pddata = pd.read_csv('data.csv')```四、数据预处理在进行回归分析之前,通常需要对数据进行预处理,包括缺失值处理、异常值处理、数据标准化等。

这些步骤可以提高模型的准确性和稳定性。

下面是一些常见的数据预处理方法:1. 缺失值处理:使用fillna()方法填充缺失值或者使用dropna()方法删除缺失值所在的行或列。

2. 异常值处理:对于异常值,可以使用均值、中位数等统计量进行替换,或者直接将其删除。

3. 数据标准化:可以使用StandardScaler或MinMaxScaler对数据进行标准化或归一化。

五、模型建立在数据预处理完成之后,我们就可以开始建立lasso回归模型了。

在Python中,可以使用scikit-learn库中的Lasso类来实现lasso回归。

下面是一个简单的示例代码:```pythonfrom sklearn.linear_model import Lassomodel = Lasso(alpha=0.1)model.fit(X, y)```其中,alpha表示正则化强度,X是自变量的数据,y是因变量的数据。

回归方程的拟合度python

回归分析是统计学中常用的一种数据分析方法,用于研究变量之间的关系。

在回归分析中,拟合度是一个重要的指标,用来衡量回归方程对数据的拟合程度。

在Python中,我们可以使用各种统计包和库来进行回归分析,并计算拟合度指标。

首先,我们需要收集数据并构建回归模型。

在Python中,我们可以使用诸如Pandas和NumPy等库来处理和分析数据,使用诸如StatsModels和Scikit-learn等库来构建回归模型。

一旦我们建立了回归模型,我们就可以使用拟合度指标来评估模型的拟合程度。

常用的拟合度指标包括R平方(R-squared)和调整R平方(adjusted R-squared)。

R平方是一个衡量模型对数据拟合程度的统计量,其值介于0和1之间,越接近1表示模型对数据的拟合程度越好。

调整R平方考虑了模型中自变量的数量,因此在多元回归分析中更为准确。

在Python中,我们可以使用StatsModels或Scikit-learn等库来计算R平方和调整R平方。

这些库提供了方便的函数和方法来计算回归模型的拟合度指标。

除了R平方和调整R平方之外,我们还可以使用其他拟合度指

标来评估回归模型的拟合程度,例如均方误差(Mean Squared Error)和残差分析等。

总之,Python提供了丰富的工具和库来进行回归分析,并计算

拟合度指标。

通过这些工具,我们可以更好地理解数据之间的关系,评估回归模型的拟合程度,并做出更准确的预测。

希望本文能帮助

您更好地理解回归方程的拟合度在Python中的应用。

python回归结果置信区间问题:python回归结果置信区间导语:在统计学中,置信区间是指对于总体参数的一个区间估计,用于描述样本估计量的可信程度。

在回归分析中,回归结果的置信区间提供了对回归系数的估计误差的界定。

本文将详细介绍在使用Python进行回归分析时如何计算回归结果的置信区间。

第一步:回归模型的拟合首先,我们需要使用已知的数据集对回归模型进行拟合。

在Python中,最常用的回归模型拟合函数是`statsmodels`库中的`OLS`(Ordinary Least Squares)函数。

下面是一个拟合线性回归模型的示例代码:pythonimport statsmodels.api as sm# 准备输入数据和目标变量X = [1, 2, 3, 4, 5]y = [2, 4, 5, 4, 5]# 添加截距项X = sm.add_constant(X)# 拟合回归模型model = sm.OLS(y, X)results = model.fit()在上述代码中,我们首先准备了自变量`X`和因变量`y`,然后使用`sm.add_constant`函数将自变量`X`添加了截距项,接着使用`sm.OLS`函数构建了回归模型,最后调用`fit`函数拟合了该模型,并将结果保存在`results`变量中。

第二步:计算置信区间在完成回归模型的拟合之后,我们可以通过`results`对象的`summary`属性来获得回归结果的统计摘要。

下面是一段示例代码,展示了如何从`results`对象中提取回归系数和标准误差:python# 提取回归系数和标准误差coef = results.paramsse = results.bse在上述代码中,`params`属性返回的是回归系数的估计值,`bse`属性返回的是回归系数的标准误差。

接下来,我们可以使用这些估计值和标准误差来计算回归结果的置信区间。

置信区间的计算通常基于正态分布的假设。