计算机导论知识点整理(1)

- 格式:doc

- 大小:45.71 KB

- 文档页数:5

计算机导论知识点整理计算机导论(Introduction to Computer Science)是为计算机科学专业的学生提供的一门入门课程。

该课程涵盖了计算机科学的基本概念、原理和方法,旨在帮助学生建立对计算机科学的整体了解,并为他们后续的学习打下坚实的基础。

本文将对计算机导论的主要知识点进行整理,以帮助读者更好地理解和掌握这门课程的内容。

一、计算机的基本概念1. 计算机的定义:计算机是一种能够接受输入、运行处理程序、生成输出的电子设备。

2. 计算机的组成部分:计算机由硬件和软件两部分组成。

硬件包括中央处理器(CPU)、内存、输入设备和输出设备等,软件则包括操作系统、应用程序和编程语言等。

二、计算机的运行原理1. 数据的表示与存储:计算机使用二进制来表示和存储数据,每位二进制数字称为一个位(bit),8个位组成一个字节(byte)。

2. 计算机的运算方式:计算机通过执行指令对数据进行运算,指令由操作码和操作数组成。

三、计算机的编程语言1. 机器语言:机器语言是计算机可以直接执行的指令序列,通常为二进制代码。

2. 汇编语言:汇编语言使用助记符来代替二进制代码,更加易读和理解。

3. 高级语言:高级语言(如C、Python等)通过编译或解释器将代码转化为机器语言,提供更高级的抽象和功能。

四、计算机网络与通信1. 计算机网络的定义与分类:计算机网络是由若干计算机互联而成的系统,可以实现信息的传输和共享。

按照网络覆盖的范围可分为局域网、城域网和广域网等不同类型。

2. 网络协议与通信协议:网络协议是计算机网络中定义的通信规则,如TCP/IP协议组合;通信协议则是网络协议的具体实现,如HTTP、FTP等。

五、数据结构与算法1. 数据结构的定义与分类:数据结构是组织和存储数据的方式,包括数组、链表、栈、队列等。

常用的数据结构有线性结构和非线性结构。

2. 算法的描述与分析:算法是解决问题的方法和步骤,包括流程图、伪代码等描述方式。

计算机导论知识点总结计算机,这个在现代社会中无处不在的神奇工具,已经成为我们生活、工作和学习中不可或缺的一部分。

对于想要深入了解计算机世界的人来说,掌握计算机导论的知识是迈出的第一步。

下面就让我们来一起梳理一下计算机导论中的重要知识点。

一、计算机的发展历程计算机的发展可以追溯到很久以前。

从早期的算盘,到机械计算机,再到电子管计算机、晶体管计算机、集成电路计算机,一直到现在的超大规模集成电路计算机,计算机的性能不断提升,体积不断缩小,功能也越来越强大。

电子管计算机是第一代计算机,它体积庞大、能耗高、速度慢,但却为计算机的发展奠定了基础。

晶体管计算机则在性能和可靠性上有了很大的提高。

集成电路计算机进一步减小了计算机的体积,提高了运算速度。

而现代的超大规模集成电路计算机则让计算机变得更加普及和强大,能够处理各种复杂的任务。

二、计算机系统的组成计算机系统主要由硬件系统和软件系统两大部分组成。

硬件系统包括中央处理器(CPU)、内存、硬盘、输入设备(如键盘、鼠标)和输出设备(如显示器、打印机)等。

CPU 是计算机的核心,负责执行各种计算和控制任务。

内存用于暂时存储正在运行的程序和数据。

硬盘则用于长期存储大量的信息。

软件系统则分为系统软件和应用软件。

系统软件如操作系统(Windows、Linux 等),负责管理计算机的硬件资源和提供基本的服务。

应用软件则是为了满足各种特定的需求而开发的,比如办公软件(Word、Excel)、图像处理软件(Photoshop)等。

三、计算机中的数据表示在计算机中,数据是以二进制的形式存储和处理的。

二进制只有 0和 1 两个数字,通过不同的组合可以表示各种信息。

整数可以用原码、反码和补码来表示。

浮点数则用于表示小数,它由符号位、指数位和尾数位组成。

此外,还有字符编码,常见的如 ASCII 码用于表示英文字符,而Unicode 码则可以表示世界上几乎所有的字符。

四、操作系统操作系统是计算机系统中最重要的软件之一,它负责管理计算机的硬件和软件资源,为用户提供一个方便、高效的工作环境。

大一计算机导论知识点计算机导论是大一学生必修的一门专业课程,旨在介绍计算机科学与技术领域的基本概念和基础知识。

本文将从计算机硬件与软件、计算机网络、数据表示与存储以及算法与程序设计等方面介绍大一计算机导论的主要知识点。

一、计算机硬件与软件1. 计算机硬件的组成:主板、中央处理器、内存、硬盘等。

2. 计算机的工作原理:输入、处理、输出。

3. 计算机软件的分类:系统软件和应用软件。

4. 操作系统的作用和功能:资源管理、文件管理、用户接口等。

二、计算机网络5. 计算机网络的定义和分类:局域网、广域网、互联网等。

6. 网络的拓扑结构:总线型、星型、环型等。

7. IP地址和域名的作用与区别:用于定位网络上的设备和服务。

8. 网络协议和通信规则:TCP/IP协议、HTTP协议等。

9. 常用网络服务:电子邮件、网页浏览、文件传输等。

三、数据表示与存储10. 二进制数的表示与转换:数值的计算和逻辑运算。

11. 字符编码:ASCII码和Unicode码。

12. 存储器的层次结构:寄存器、高速缓存、内存、硬盘等。

13. 数据压缩与加密:提高存储和传输效率,保护数据安全。

四、算法与程序设计14. 算法的定义和特性:有限性、确定性、有效性、输入输出等。

15. 算法的表示方法:伪代码、流程图等。

16. 常见算法的思想:贪心算法、分治算法、动态规划等。

17. 程序设计语言和编译执行过程:C、Java等主流编程语言。

18. 程序的开发过程:需求分析、设计、编码和测试等。

总结:通过学习大一计算机导论,我们可以了解计算机的基本原理和工作方式,掌握计算机网络的基本概念和通信规则,了解数据的表示与存储方式,学习算法和程序设计的基本知识。

这些知识将为我们今后深入学习计算机科学与技术打下坚实的基础。

【本文所述的知识点,仅作为大一计算机导论的基础内容介绍,具体课程内容以教材为准。

】。

![计算机导论重点总结[1]](https://uimg.taocdn.com/591841c2fc4ffe473268ab54.webp)

计算机导论重点总结计算机导论重点总结本课程的任务是?为计算机系的新生提供一个关于计算机科学与技术的入门介绍,使他们能对该学科有一个整体的认识,并了解该专业的学生应具有的基本知识和技能,以及在该领域工作应有的职业道德和应遵守的法律准则。

计算机由哪五大部分组成,各部分的主要功能是什么?由运算器,控制器,存储器,输入设备和输入设备组成运算器:用来实现算术逻辑等各种预算。

控制器:用来实现对整个位运算过程的有规律的控制。

存储器:用来存放计算机程序及参与运算的各种数据。

输入设备:用来实现计算机程序和原始数据的输入。

输出设备:用来实现计算机结果的输出。

冯诺依曼计算机的特征是程序存储和采用二进制。

简述计算机自动计算的基本原理:1计算机的自动计算过程就是执行一段预先编制好的计算程序的过程。

2计算机程序是指令的有序集合。

因此执行计算程序的过程实际上是逐条执行指令的过程。

3指令的逐条执行是由计算机硬件来实现的,可顺序完成取指令,分析指令执行指令所规定的操作,并为取下一条指令准备好指令地址。

如此重复操作直至执行到停机指令。

第一台计算机在1946年诞生叫:电子数值积分和计算器。

以硬件分类计算机的发展阶段:电子管计算机(19461957)晶体管计算机(19571964)中小规模集成电路计算机(19641972)大规模和超大规模集成电路计算机(1972至今)计算机系统由硬件和软件组成进位制数的两要素是基数和位权什么是浮点数的格式化表示方法?将浮点数表示为N=2E*(S)E为阶码,她是一个二进制整数,E前的正负号为阶码的正负号,成为阶符Ef,S称为尾数它是一个二进制整数小数,S 前的正负号为尾数的正负号,称为尾符Sf此表示法称为记阶表示法。

ASCII码由7位二进制组成。

最多可有2的七次方种编码逻辑运算有何特点?计算机中的逻辑运算时按位计算的,它是一种比算术运算更简单的运算。

由于计算机中的基本电路都是两个状态的电子开关电路,这种极为简单的逻辑运算正式描述电子开关电路工作状态的有力工具。

引言:计算机导论是一门涵盖广泛的学科,它介绍了计算机科学的基本概念和原理。

在先前的《计算机导论知识点总结(一)》中,我们已经讨论了计算机的基本组成部分、计算机的工作原理以及计算机的历史发展。

在本文中,我们将继续探讨计算机导论的其他重要知识点。

概述:计算机导论是计算机科学的入门课程,它涵盖了众多的主题,包括计算机硬件、软件、操作系统、数据结构、算法等。

本文将从计算机网络、数据库、、计算机安全和计算机图形学等五个方面继续探讨计算机导论的知识点。

正文内容:一、计算机网络1.计算机网络的定义和作用2.计算机网络的基本组成和工作原理3.计算机网络的分类和常见的网络协议4.局域网、广域网和互联网的区别和联系5.计算机网络的安全性和网络攻击防范二、数据库1.数据库的定义、特点和作用2.数据库的基本组成和结构3.数据库管理系统的分类和功能4.数据库查询语言和数据操作语言5.数据库的备份和恢复三、1.的定义和发展历程2.的基本概念和应用3.机器学习算法和深度学习技术4.的伦理和社会影响5.的未来发展趋势四、计算机安全1.计算机安全的定义和重要性2.计算机系统的威胁和攻击类型3.计算机安全的防护措施和技术4.密码学和加密算法5.网络安全和信息安全的管理五、计算机图形学1.计算机图形学的基本概念和应用领域2.图像表示和处理的基本原理3.三维建模和渲染技术4.虚拟现实和增强现实技术5.计算机图形学的发展趋势和前景总结:计算机导论作为计算机科学的入门课程,涵盖了广泛的知识点。

在本文中,我们概述了计算机网络、数据库、、计算机安全和计算机图形学等五个重要方面的知识点。

希望通过本文的介绍,读者能够对计算机导论有更深入的了解,并能够应用这些知识点于实际问题的解决中。

计算机导论是计算机科学学习的基石,了解和掌握这些知识点对于日后的学习和工作都有着重要的意义。

计算机导论知识点总结1.计算机的定义:计算机是一种能按照事先存储的程序,自动、高速地进行大量数值计算和各种信息处理的现代化智能电子设备。

2.计算机系统的组成:硬件和软件。

3.计算机硬件的概念:由电子的、磁性的、机械的器件按照一定的体系结构连接而成的物理设备,是计算机系统赖以工作的实体。

4.计算机硬件的组成:中央处理器、存储器、输入输出控制系统和各种输入输出设备。

5.计算机软件的概念:计算机软件是计算机系统中的程序、数据和有关文档的总称,是计算机系统的灵魂,是控制和操作计算机工作的核心。

6.世界上第一台电子数字计算机是1946年美国研制出的ENIAC。

7.计算机的发展:第一代计算机——电子管计算机:以电子管作为逻辑电路的主要器件,几乎没有什么软件配置,运算速度慢,体积较大,价格昂贵;第二代计算机——晶体管计算机:逻辑元器件采用晶体管,内存储器采用磁心体,性能比第一代计算机好点,在软件方面配置了子程序和监控程序,提出了操作系统的概念,出现了高级语言;第三代计算机——集成电路计算机:逻辑元件采用集成电路,主存储器采用半导体;第四代计算机——大规模及超大规模集成电路计算机;新一代计算机——智能计算机;8.微型计算机具有体积小、重量轻、功耗小、可靠性高、使用环境要求不严格、价格低廉、易于成批生产等特点,核心部件是微处理器。

9.计算机的分类:(1)按照计算机处理数据的方式可以分为数字计算机、模拟计算机、数字模拟混合计算机;(2)按照计算机用途可分为通用计算机和专用计算机;(3)按计算机的规模和处理能力分类为巨型计算机、大中型计算机、小型计算机、微型计算机、工作站、服务器、网络计算机;10.计算机的特点:运算速度快、计算精度高、具有记忆能力、具有逻辑判断能力、具有自动控制能力。

11.计算机的用途:科学计算、数据处理、过程控制、计算机辅助系统、人工智能、电子商务。

12.美国数学家冯·诺依曼提出了计算机应由5个基本部分组成:运算器、控制器、存储器、输入、输出设备;提出了“采用二进制”和“存储程序”两个重要基本思想;“采用二进制”就是计算机中的数据和指令均以二进制形式存储和处理;“存储程序”就是将程序事先存入存储器中,使计算机在工作时能自动地从存储器中读取指令、分析后执行。

计算机导论知识点计算机导论知识点概述1. 计算机基础概念- 计算机定义:计算机是一种能够按照程序指令自动进行信息处理的电子设备。

- 计算机分类:根据性能和用途,计算机可分为个人计算机(PC)、服务器、工作站、超级计算机等。

- 计算机组成:硬件系统(包括中央处理器CPU、内存、硬盘、显卡等)和软件系统(操作系统、应用程序等)。

2. 计算机硬件- 中央处理器(CPU):计算机的核心部件,负责执行程序指令。

- 内存(RAM):用于临时存储数据和程序的硬件,断电后数据丢失。

- 存储设备:硬盘驱动器(HDD)、固态驱动器(SSD)、光盘等,用于长期保存数据。

- 输入设备:键盘、鼠标、触摸屏等,用于向计算机输入数据。

- 输出设备:显示器、打印机、扬声器等,用于从计算机获取信息。

- 网络设备:网卡、路由器、交换机等,用于实现计算机之间的数据传输。

3. 计算机软件- 操作系统:管理计算机硬件资源和软件应用的基础软件,如Windows、Linux、macOS。

- 应用软件:为特定任务设计的软件,如文字处理软件、电子表格软件、图像处理软件等。

- 编程语言:用于编写程序的语言,如C、Java、Python等。

- 数据库管理系统:用于存储、检索和管理数据的软件,如MySQL、Oracle、SQL Server。

4. 计算机网络- 网络基础:网络的基本概念、拓扑结构、网络协议等。

- 互联网:全球最大的计算机网络,基于TCP/IP协议。

- 网络安全:保护网络数据不受未授权访问、破坏或泄露的技术和措施。

- 云计算:通过互联网提供计算资源和服务的技术,如Amazon Web Services、Microsoft Azure。

5. 数据结构与算法- 数据结构:组织和存储数据的方式,如数组、链表、栈、队列、树、图等。

- 算法:解决特定问题的一系列步骤,包括排序算法、搜索算法、图算法等。

- 算法分析:评估算法性能的方法,如时间复杂度和空间复杂度。

计算机网络复习知识点总结一、计算机网络概述掌握计算机网络的基本概念、基本原理和基本方法。

掌握计算机网络的体系结构和典型网络协议,了解典型网络设备的组成和特点,理解典型网络设备的工作原理。

能够运用计算机网络的基本概念、基本原理和基本方法进行网络系统的分析、设计和应用。

计算机网络概念一些互相连接的、自治的计算机的集合。

组成从组成部分上看由硬件、软件、协议三大部分组成从工作方式上看(主要指Internet)可分为边缘部分和核心部分从功能组成上看•由通信子网和资源子网组成。

通信子网由各种传输介质、通信设备和相应的网络协议组成。

资源子网是实现资源共享功能的设备及其软件的集合。

功能数据通信(最基本和最重要的功能),资源共享,分布式处理,提高可靠性,负载均衡。

分类•按作用范围分类•广域网WAN(Wide Area Network):作用范围通常为几十到几千公里。

•城域网MAN(Metropolitan Area Network):作用范围一般是一个城市,作用距离约为5~50km。

•局域网LAN(Local Area Network):一般用微型计算机或工作站通过高速通信线路相连,地理上则局限在较小的范围(如1km左右)。

•个人局域网PAN(Personal Area Network)•按拓扑结构分类星形网络:每个终端或计算机都以单独的线路与中央设备相连。

总线形网络:用单根传输线把计算机连接起来。

环形网络:所有计算机接口设备连接成一个环。

网状形网络:一般情况下,每个结点至少有两条路径与其它结点相连,多用在局域网中。

标准体系•因特网的所有标准都以RFC(Request For Comments)的形式在因特网上发布,RFC 要上升为正式标准要经过四个阶段:•因特网草案(Internet Draft):还不是RFC 文档。

•建议标准(Proposed Standard):开始成为RFC 文档。

•草案标准(Draft Standard)•因特网标准(Internet Standard)•有许多标准化组织负责制定、实施相关网络标准,主要有:国际标准化组织(ISO):OSI 参考模型、HDLC 等。

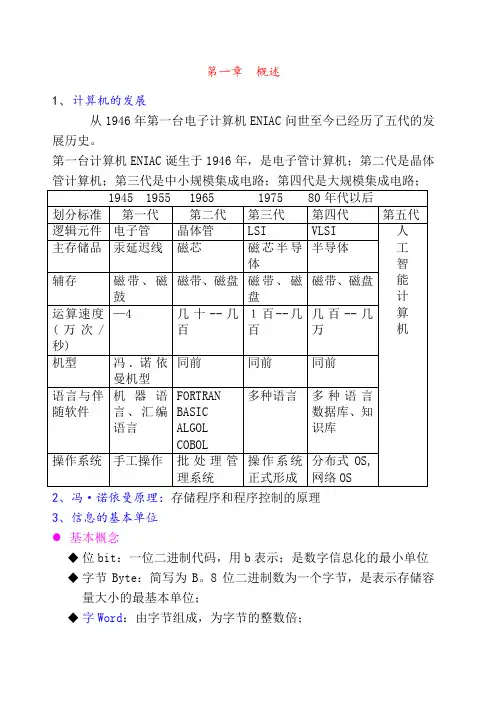

第一章概述1、计算机的发展从1946年第一台电子计算机ENIAC问世至今已经历了五代的发展历史。

第一台计算机ENIAC诞生于1946年,是电子管计算机;第二代是晶体管计算机;第三代是中小规模集成电路;第四代是大规模集成电路;2、冯·诺依曼原理:存储程序和程序控制的原理3、信息的基本单位●基本概念◆位bit:一位二进制代码,用b表示;是数字信息化的最小单位◆字节Byte:简写为B。

8位二进制数为一个字节,是表示存储容量大小的最基本单位;◆字Word:由字节组成,为字节的整数倍;◆字长●存储容量大小的换算1 B ===8bit; 1KB====1024B ;1MB====1024KB; 1GB===1024MB;1TB===1024GB; 1个汉字===2B;●几种进制数(1)十进制计数制:有0-9十个数码,逢十进一。

用D标记或加下标10(2)二进制计数制:仅有0、1两个数码,逢二进一。

(0+0=0 0+1=1 1+0=1 1+1=10)用B标记或加下标2(3)八进制计数制:有0-7共8个数码,逢八进一。

(7+1=10)用O 标记或加下标8(4)十六进制计数制:有0-9、A、B、C、D、E、F共十六个数码,逢十六进一。

(F+1=10)用H标记或加下标16●几种进制数之间的转换(1)各进位制数转换为十进制数将各进位制数按照其通式展开(个位为0位),计算出结果即可。

(2)十进制数换成二、八、十六进制数10→整数部分:采用“除—倒取余数法”(一直除到商为0,将得出的余数倒排即为转换结果。

)小数部分:采用“乘—顺取整数部分”(一直除到小数部分为0,将得出的整数部分顺序排列即为转换结果。

)(3)二进制数与八进制数转换⏹2→8采用“三位一并”法:以小数点为基点,向左右两边三位一组转为八进制数,不足三位用0补齐。

⏹8→2采用“一分为三”法。

(4)二进制数与十六进制数转换●2→16采用“四位一并”法:以小数点为基点,向左右两边四位一组转为十六进制数,不足四位用0补齐。

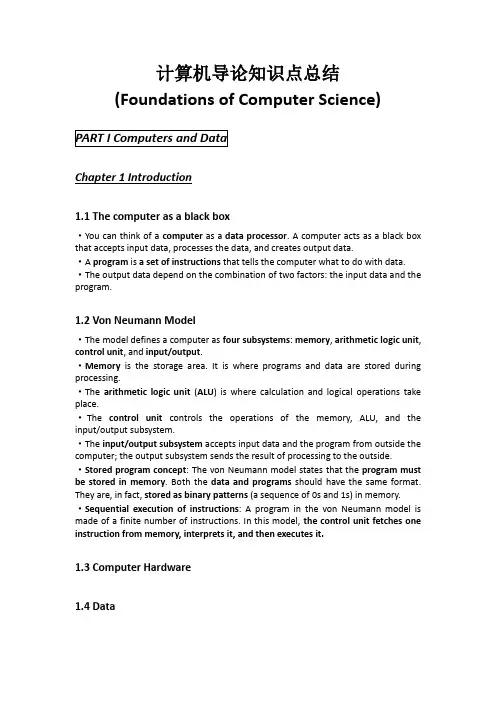

计算机导论知识点总结(Foundations of Computer Science)Chapter 1 Introduction1.1 The computer as a black box·You can think of a computer as a data processor. A computer acts as a black box that accepts input data, processes the data, and creates output data.·A program is a set of instructions that tells the computer what to do with data. ·The output data depend on the combination of two factors: the input data and the program.1.2 Von Neumann Model·The model defines a computer as four subsystems: memory, arithmetic logic unit, control unit, and input/output.·Memory is the storage area. It is where programs and data are stored during processing.·The arithmetic logic unit(ALU) is where calculation and logical operations take place.·The control unit controls the operations of the memory, ALU, and the input/output subsystem.·The input/output subsystem accepts input data and the program from outside the computer; the output subsystem sends the result of processing to the outside. ·Stored program concept: The von Neumann model states that the program must be stored in memory. Both the data and programs should have the same format. They are, in fact, stored as binary patterns (a sequence of 0s and 1s) in memory. ·Sequential execution of instructions: A program in the von Neumann model is made of a finite number of instructions. In this model, the control unit fetches one instruction from memory, interprets it, and then executes it.1.3 Computer Hardware1.4 Data1.5 Computer Software·Programs must be stored·A sequence of instructions·Algorithms: The step-by-step solution is called an algorithm.·Languages: A computer language has a more limited number of symbols and also limited number of words.·Software Engineering: Software engineering is the design and writing of structured programs. Today, it is not acceptable just to write a program that does a task; the program must follow strict principles and rules.·Operating systems: An operating system originally worked as a manager to facilitate access of the computer components for a program. Today, operating systems do much more.1.6 History·Mechanical Machines (Before 1930)·Birth of electronic computers (1930-1950)①Early electronic computers: Did not store the program in memory.②Computers based on the von Neumann model.·Computer generations (1950-Present)①First generation (1950-1959): It is characterized by the emergence of commercial computers. At this time, computers were affordable only by big organizations.②Second generation (1959-1965): It used transistors instead of vacuum tubes. This reduced the size of computers as well as their cost. Two high-level programming languages, FORTRAN and COBOL were invented and made programming easier.③Third generation (1965-1975): The invention of integrated circuit (transistors, wiring, and other components on a single chip) reduced the cost and size of computers even further. Minicomputers appeared on the market. Software industry was born.④Fourth generation (1975-1985): The fourth generation saw the appearance of microcomputers. Advances in the electronics industry allowed whole computer subsystems to fit on a single circuit board. This generation also saw the emergence of computer networks.⑤Fifth generation (1985-Now): The fifth generation witnessed the appearance of laptop and palmtop computers, improvements in secondary storage media (CD-ROM, DVD, etc.), the use of multimedia, and the phenomenon of virtual reality.Chapter 2 Data Representation2.1 Data types·Data today come in different forms such as numbers, text, images, audio, and video.2.2 Data inside the Computer·All data types from outside a computer are transformed into a uniform representation when stored in a computer and then transformed back when leaving the computer. This universal format is called a bit pattern.·A bit (binary digit) is the smallest unit of data that can be stored in a computer, it is either 0 or 1.·To represent different types of data, you use a bit pattern, a sequence, or as it is sometimes called, a string of bits.·By tradition, a bit pattern of length 8 is called a byte.2.3 Representing Data·Text: A piece of text in any language is a sequence of symbols used to represent an idea in that language. You can represent each symbol with a bit pattern. The length of the bit pattern to represent a symbol in a language depends on the number of symbols used in that language.·Codes: Different sets of bit patterns have been designed to represent text symbols. Each set is called a code, and the process of representing symbols is called coding.①ASCII: The American National Standards Institute (ANSI) developed a code called American Standard Code for Information Interchange (ASCII). This code uses 7 bits for each symbol.②Extended ASCII: To make the size of each pattern 1 byte (8 bits), the ASCII bit patterns are augmented with an extra 0 at the left. In extended ASCII, the first pattern is 00000000 and the last one is 01111111. Some manufacturers have decided to use the extra bit to create an extra 128 symbols. However, this attempt has not been very successful due to the nonstandard set created by each manufacturer.③EBCDIC: In the early age of computers, IBM developed a code called Extended Binary Coded Decimal Interchange Code (EBCDIC). (Use 8-bit patterns)④Unicode: A coalition of hardware and software manufactures have designed a code name Unicode that uses 16 bits and can represent up to 65536 (2^16) symbols. Different sections of the code are allocated to symbols from different languages in the world.⑤ISO: The International Organization for Standardization, known as ISO, has designed a code using 32-bit patterns.·Numbers: In a computer, numbers are represented using the binary system. ·Images: Images today are represented in a computer by one or two methods: bitmap graphic or vector graphic.·Bitmap Graphic: In this method, an image is divided into a matrix of pixels (picture elements), where each pixel is a small dot. The size of the pixel depends on what is called the resolution. After dividing an image into pixels, each pixel is assigned a bit pattern. The size and the value of the pattern depend on the image. To represent color images, each colored pixel is decomposed into three primary colors: red, green, and blue (RGB). Then the intensity of each color is measured, and a bit pattern (usually 8 bits) is assigned to it.·Vector Graphic: The vector graphic method, however, does not store the bit patterns. An image is decomposed into a combination of curves and lines. Each curve or line is represented by a mathematical formula. When the image is to be displayed or printed, the size of the image is given to the system as an input. The system redesigns the image with the new size and uses the same formula to draw the image. ·Audio: The analog signal is sampled first. Then the samples are quantized. The quantized values are changed to binary patterns. The binary patterns are stored. ·Video: Each image or frame is changed to a set of bit patterns and stored. The combination of the images represents the video.2.4 Hexadecimal Notation·Hexadecimal notation is based on16. There are 16 symbols (hexadecimal digits): 0, 1, 2, 3, 4, 5, 6, 7, 8, 9, A, B, C, D, E, and F.2.5 Octal Notation·Octal notation is based on8. There are eight symbols (octal digits): 0, 1, 2, 3, 4, 5, 6, and 7.Chapter 3 Number Representation3.1 Decimal and Binary·Today the world uses the decimal system for numbers.·The binary system is based on 2. There are only two digits in the binary system, 0 and 1.3.2 Conversion·Binary to Decimal Conversion: Write the bits and their weights. Multiply the bit by its corresponding weight and record the result. At the end, add the results to get the decimal number.·Decimal to Binary Conversion: Write the number at the right corner. Divide the number continuously by 2 and write the quotient and the remainder. The quotientsmove to the left, and the remainder is recorded under each operation. Stop when the quotient is 0.3.3 Integer Representation·Overflow: If you try to store a big integer in a small memory location (the integer is out of range), you get a condition called overflow.·Unsigned Integers Format: An unsigned integer is an integer without a sign.①Representation: Storing unsigned integers is a straightforward process as outlined in the following steps: 1. The number is changed to binary. 2. If the number of bits is less than N, 0s are added to the left of the binary number so that there is a total of N bits.②Range: 0 … (2N-1)③Interpretation: Just change the N bits from the binary to the decimal system.④Applications: Counting, addressing, and so on.·Sign-and-magnitude Format: Storing an integer in the sign-and-magnitude format requires 1 bit to represent the sign (0 for positive, 1 for negative). In this system, there are two 0s: +0 and -0.①Representation: 1. The number is changed to binary. 2. If the number of bits is less than N-1, 0s are added to the left of the number so that there is a total of N-1 bits. 3. If the number is positive, 0 is added to the left (to make it N bits). If the number is negative, 1 is added to the left (to make it N bits).②Range: -(2N-1-1) … +(2N-1-1)③Interpretation: 1. Ignore the first (leftmost) bit. 2. Change the N-1 bits from binary to decimal. 3. Attach a + or a – sign to the number based on the leftmost bit.④Applications: When we do not need operations on numbers.·One’s Complement Format: In one’s complement, the complement of a number is obtained by changing all 0s to 1s and all 1s to 0s.①Representation: 1. The number is changed to binary; the sign is ignored. 2. 0s are added to the left of the number to make a total of N bits. 3. If the sign is positive, no more action is needed. If the sign is negative, every bit is complemented (changed from 0 to 1 or from 1 to 0).②Range: -(2N-1-1) … +(2N-1-1)③Interpretation: 1. If the leftmost bit is 0 (positive number), change the entire number from binary to decimal, put a plus sign (+) in front of the number. 2. If the leftmost bit is 1 (negative number), complement the entire number (changing all 0s to 1s, and vice versa), Change the entire number from binary to decimal, put a negative sign (-) in front of the number.④Applications: The foundation of the next representation, error detection and correction.·Two’s Complement Format: Two’s complement is the most common, the most important, and the most widely used representation of integers today.①Representation: 1. The number is changed to binary; the sign is ignored. 2.If the number of bits is less than N, 0s are added to the left of the number so that there is a total of N bits. 3. If the sign is positive, no further action is needed. If the sign is negative, leave all the rightmost 0s and the first 1 unchanged. Complement the rest of the bits.②Range: -(2N-1) … +(2N-1-1)③Interpretation: 1. If the leftmost bit is 0 (positive number), change the whole number from binary to decimal, put a plus sign (+) in front of the number. 2. If the leftmost bit is 1 (negative number), leave the rightmost bits up to the first 1 (inclusive) unchanged, complement the rest of the bits, change the whole number from binary to decimal, put a negative sign (-) in front of the number.④Applications: It is the standard representation for storing integers in computers today.3.4 Excess system·It allows you to store both positive and negative numbers. It is easy to transform, but the operations on the number are very complicated.·In an Excess conversion, a positive number, called the magic number, is used in the conversion process. The magic number is normally (2N-1) or (2N-1-1), where N is the bit allocation.·Representation: 1. Add the magic number to the integer. 2. Change the result to binary and add 0s so that there is a total of N bits.·Interpretation: 1. Change the number to decimal. 2. Subtract the magic number from the integer.3.5 Floating-point Representation·Converting to Binary: 1. Convert the integer part to binary. 2. Convert the fraction part to binary. 3. Put a decimal point between the two parts.·Converting the Fraction Part: 1. Write the fraction at the left corner. 2. Multiply the number continuously by 2 and extract the integer part as the binary digit. 3. Stop when the number is 0.0.·Normalization: Moving the point so that there only one 1 to the left of the decimal point.·Sign, Exponent, and Mantissa: We store only three pieces of information about the number: sign, exponent, and mantissa (the bits to the right of the decimal point). ·IEEE Standards: The Instituteof Electrical and ElectronicsEngineers (IEEE) has definedthree standards for storingfloating-point numbers; two areused to store numbers inmemory (single precision anddouble precision).·Single-Precision Representation: 1. Store the sign as 0 (positive) or 1 (negative). 2. Store the exponent (power of 2) as Excess_127. 3. Store the mantissa as an unsigned integer.·Floating-Point Interpretation for Single Precision: 1. Use the leftmost bit as the sign. 2. Change the next 8 bits to decimal and subtract 127 from it. This is the exponent. 3. Add 1 and a decimal point to the next 23 bits. You can ignore any extra 0s at the right. 4. Move the decimal point to the correct position using the value of the exponent. 5. Change the whole part to decimal. 6. Change the fraction part to decimal. 7. Combine the whole and the fraction parts.Chapter 4 Operations on Bits4.1 Arithmetic operations·Addition in Two’s Complemen t: Adding numbers in two’s complement is like adding the numbers in decimal; you add column by column, and if there is a carry, it is added to the next column. Add 2 bits and propagate the carry to the next column. If there is a final carry after the leftmost column addition, discard it.·Overflow: Overflow is an error that occurs when you try to store a number that is not within the range defined by the allocation. When you do arithmetic operations on numbers in a computer, remember that each number and the result should be in the range defined by the bit allocation.·Subtraction in Two’s Complement: One of the advantages of two’s complement representation is that there is no difference between addition and subtraction. To subtract, negate (two’s complement) the second number and add.4.2 Logical Operations·A single bit can be either 0 or 1. You can interpret 0as the logical value false and 1 as the logical value true.·A logical operation can accept 1 or 2 bits to create only 1 bit. If the operation is applied to only one input, it is a unary operation, if it is applied to 2 bits, it is a binary operation.·Truth Tables: One way to show theresult of a logical operation is with atruth table. A truth table lists all thepossible input combinations with thecorresponding output.·Unary Operator: The only unaryoperator we discuss is the NOToperator.·NOT Operator: The NOT operatorhas one input (a bit pattern). It invert bits; that is, it changes 0 to 1 and 1 to 0. ·Binary Operators: There are three binary operators we discuss: AND, OR, XOR. ·AND Operator: The AND operator is a binary operator. It takes two inputs (two bit patterns) and creats one output (bit pattern). For each pair of input bits, the result is 1 if and only if both bits are 1; otherwise, it is 0.·OR Operator: The OR operator is a binary operator. It takes two inputs (two bit patterns) and creates one output (bit pattern). For each pair of input bits, the result is 0 if and only if both bits are 0; otherwise, it is 1.·XOR Operator: The XOR operator is a binary operator. It takes two inputs (two bit patterns) and creates one output (bit pattern). For each pair of input bits, the result is 0 if and only if both bits are equal; otherwise, it is 1.·Applications: The three logical binary operations can be used to modify a bit pattern. They can unset, set, or reverse specific bits. The bit pattern to be modified is ANDed, ORed, or XORed with a second bit pattern, which is called the mask. The mask is used to modify another bit pattern.·Unsetting Specific Bits: One of the applications of the AND operator is to unset (force to0) specific bits in a bit pattern. To do so, use an unsetting mask with the same bit length. The rules for constructing an unsetting mask can be summarized as follows: 1. To unset a bit in the target bit pattern, use 0 for the corresponding bit in the mask.2. To leave a bit in the target bit pattern unchanged, use 1 for the corresponding bit in the mask.·Setting Specific Bits: One of the applications of the OR operator is to set (Force to 1) specific bits in a bit pattern. To do so, use a setting mask with the same bit length. The rules for constructing a setting mask can be summarized as follows: 1. To set a bit in the target pattern, use 1 for the corresponding bit in the mask. 2. To leave a bit in the target bit pattern unchanged, use 0 for the corresponding bit in the mask. ·Flipping Specific Bits: One of the applications of XOR is to flip bits, which means to change the value of specific bits from 0s to 1s, and vice versa. The rules for constructing an XOR mask can be summarized as follows: 1. To flip a bit in the target bit pattern, use 1 for the corresponding bit in the mask. 2. To leave a bit in the target bit pattern unchanged, use 0 for the corresponding bit in the mask.4.3 Shift Operators·Another common operation on bit patterns is the shift operation.·A bit pattern can be shifted to the right or to the left.·The right-shift operation discards the rightmost bit, shift every bit to the right, and inserts 0 as the leftmost bit.·The left-shift operation discards the leftmost bit, shifts every bit to the left, and inserts 0 as the rightmost bit.Chapter 5 Computer Organization5.1 Central Processing Unit (CPU)·The central processing unit (CPU) performs operations on data. It has three parts: an arithmetic logic unit (ALU), a control unit, and a set of registers.·The arithmetic logic unit (ALU) performs arithmetic and logical operations. ·Arithmetic Operation: The simplest unary operations are increment (add 1) and decrement (subtract 1). The simplest binary operations are add, subtract, multiply, and divide.·Logical Operation: The simplest logical unary operation is the NOT operation. The simplest logical binary operations are AND, OR, and XOR.·Registers are fast stand-alone storage locations that hold data temporarily.·Data Registers: Today, computers use dozens of registers inside the CPU to speed up the operations because, increasingly, complex operations are done using hardware (instead of using software) and there is a need for several registers to hold the intermediate results.·Instruction Register: Today, computers store not only data but also the corresponding program inside memory. The CPU is responsible for fetching instructions, one by one, from memory, storing them in the instruction register, interpreting them, and executing them.·Program counter: The program counter keeps track of the instruction currently being executed. After execution of the instruction, the counter is incremented to point to the address of the next instruction in memory.·Control Unit: The control unit is like the part of the human brain that controls the operation of each part of the body. Controlling is achieved through wires that can be on (hot) or off (hold).5.2 Main Memory·Main memory is another subsystem in a computer. It is a collection of storage locations, each with a unique identifier called the address.·Data are transferred to and from memory in groups of bits called words. A word can be a group of 8 bits, 16 bits, 32 bits, or sometimes 64 bits. If the word is 8 bits, it is referred to as a byte. The term byte is so common in computer science that sometimes a 16-bit word is referred to as a 2-byte word or a 32-bit word is referred to as a 4-byte word.·Address Space: To access a word in memory requires an identifier. The total number of uniquely identifiable locations in memory is called the address space. ·Address is represented as a bit pattern. If a computer has 64 kilobytes (216= 26× 210) of memory with a word size of 1 byte, then to define an address, you need a bit pattern of 16 bits.·Memory addresses are defined using unsigned binary integers.·Two types of memory are available: RAM and ROM.·RAM: Random access memory (RAM) makes up most main memory in a computer. The user can write something to RAM and later erase it simply by overwriting it. Another characteristic of RAM is that it is volatile; the information (program or data) is erased if the system is powered down.·SRAM: Static RAM (SRAM) uses the traditional flip-flop gates to hold data; there is no need for refreshing; SRAM is fast but expensive.·DRAM: Dynamic RAM (DRAM) uses capacitors; memory cells need to be refreshed periodically; DRAM is slow but inexpensive.·ROM: The contents of read-only memory (ROM) are written by the manufacturer; the user is allowed to read but not write to ROM. Its advantage is that it is nonvolatile; its contents are not erased if you turn off the computer. Normally, it is used for programs or data that must not be erased or changed even if you turn off the computer.·PROM (programmable read-only memory)·EPROM (erasable programmable read-only memory)·EEPROM (electronically erasable programmable read-only memory)·Memory Hierarchy:·Cache Memory: Cache memory is faster than main memory but slower than the CPU and the registers inside the CPU. Cache memory, which is normally small in size, is placed between the CPU and main memory.。

计导大一知识点计算机导论是计算机科学与技术专业的一门基础课程,旨在帮助学生全面了解计算机科学与技术领域的发展历程、基本概念和常用技术。

本文将为大一学生介绍计算机导论中的一些重要知识点。

一、计算机的基本概念计算机是一种能够进行数据处理和储存的机器,它由硬件和软件两个部分组成。

硬件包括中央处理器(CPU)、内存、输入设备、输出设备和存储设备等,而软件则包括系统软件和应用软件。

学习计算机导论的过程中,我们需要了解计算机的基本组成以及各个部件的功能和特点。

二、计算机的发展历程计算机的发展经历了多个阶段,从早期的机械计算机到今天的超级计算机,计算能力和性能都有了巨大的飞跃。

了解计算机的发展历程能够帮助我们更好地理解计算机科学与技术的进步,以及未来的发展趋势。

三、计算机的操作系统操作系统是计算机系统的核心软件,它负责管理计算机硬件资源、提供人机交互界面以及支持用户程序的运行。

常见的操作系统有Windows、Linux和macOS等。

了解操作系统的基本原理和功能可以帮助我们更好地使用计算机,并理解不同操作系统之间的区别和优缺点。

四、计算机网络与互联网计算机网络是连接多台计算机的通信系统,互联网则是全球范围内的计算机网络。

学习计算机导论时,我们需要了解计算机网络的基本概念、网络拓扑结构和常用网络协议等。

同时,互联网的发展也给人们的生活带来了极大的改变,我们需要了解互联网的产生与发展,以及常用的网络服务和应用。

五、数据表示与存储计算机中的数据是以二进制形式进行存储和处理的,而数据的表示方式与数据类型有关。

在计算机导论中,我们需要了解不同数据类型的表示方法,如整数、浮点数、字符和布尔值等。

此外,数据的存储也是计算机导论中的重要内容,我们需要学习不同的存储器层次结构和存储技术。

六、计算机的编程与算法编程是计算机应用的核心技术之一,它通过编写代码来实现特定的功能。

在计算机导论中,我们需要了解不同编程语言的特点和应用场景,同时学习基本的编程思想和编程方法。

《计算机导论》知识点复习要点一、1. 进制换算、ASCII码、真值、原码、补码、反码、与或非2. 存储单位换算:位、字节、字、字长 b M G3. 冯?诺依曼体系结构计算机的主要特征4. 计算机发展方向二、计算机系统:软件、硬件1. 总线结构2. CPU3. 微型计算机的主频很大程度上决定了计算机的运行速度,它是指CPU工作频率4. cache指的是高速缓冲存储器5. 某单位的人事管理软件属于应用软件6. 内存地址7. 运算器中的运算结果可直接传送到RAM 8. 机器语言程序能被CPU直接执行9. 32位微型计算机中的32位指的是计算机的机器字长三、数据结构:1. 树、图、队列、栈2. 线性表:线性表的顺序存储结构和链式存储结构四、软件1. 程序由什么组成2. 算法设计:伪代码3. 软件生命周期包括哪几个阶段及其主要任务4. 能够将高级语言源程序翻译为目标程序的系统软件是,五、xp操作系统的操作:a) 中英文输入法切换的热键b) 启动程序c) 桌面d) “我的电脑”是一个系统文件夹e) 文件命名规则f) 文件属性g) 实现窗口的最大化5. dos命令:md、del、type、cls六、数据库常见数据库软件:联系模型:1:1、1:N、N:M七、网络:1. IP地址2. TCP/IP协议(HTTP,FTP,SMTP)3. WWW,HTML ,4. OSI模型,各层的作用5. 病毒6. 域名7. 子网掩码8. 防火墙的作用9. 局域网基本拓扑结构主要有哪几类 10. 一台计算机利用电话线路传输数据信号时,必备的设备是调制解调器八、操作系统1. 操作系统启动过程2. 进程的三个主要状态,状态转换的原因 3( 死锁九、Office操作系列1. word\Excel\ppt。

计算机导论知识点总结第1章绪论1.1 计算机的基本概念1.1.1 什么是计算机计算机的概念。

计算机系统的组成,硬件的概念,硬件的五个组成部分,软件的概念一个计算机系统包括硬件和软件两大部分。

硬件是由电子的、磁性的、机械的器件组成的物理实体,包括运算器、存储器、控制器、输入设备和输出设备等5个基本组成部分;软件则是程序和有关文档的总称,包括系统软件和应用软件两类。

什么是系统软件,常用的系统软件有哪些?什么是应用软件,常用的应用软件有哪些?1.1.2计算机的分类按规模分类有:巨型计算机,大中型计算机、小型计算机、微型计算机1.1.4 计算机的用途计算机的主要用途有哪些?科学计算,数据处理,实时控制,人工智能,计算机辅助工程和辅助教育,娱乐与游戏。

这些各用途的含义是什么CAD CAM CAI的含义1.1.5计算机的发展计算机发展史中的“代”是如何划分的?每代计算机的使用的主要器件是什么?1946年,第一台计算机ENIAC冯·诺依曼的存储程序的含义第五代计算机的主要特征是人工智能1.5 信息化社会的挑战信息化社会的特征是什么?internet的起源是什么?我国的互联网络:中国教育科研网、中国公用信息网、中国科学技术网、中国金桥信息网。

以及这几个互联网络的主要用途。

习题答案二、选择题1-6: A B D C CC 7-12: B C D B B C第2章计算机的基础知识2.1 计算机的运算基础2.1.1数制的概念2.1.2 掌握进制之间的相互转换10进制转换为2,8,16进制;2,8,16进制转换为10进制;2进制与8进制的相互转换;2进制与16进制之间的相互转换。

2,8,16à10 位权法:把各非十进制数按权展开,然后求和。

10à2,8,16 整数部分:除基取余法:“除基取余,先余为低(位),后余为高(位)”。

小数部分:乘基取整法:“乘基取整,先整为高(位),后整为低(位)”2à8:以小数点为界,将整数部分自右向左和小数部分自左向右分别按每三位为一组(不足三位用0补足),然后将各个三位二进制数转换为对应的一位八进制数。

《计算机导论——计算思维和应用技术》1.1.1 早期的计算工具计算技术是人类文明史的一个缩影。

计算机发展历程1、十进制记数法古巴比伦楔形数字,60进制古埃及十进制记数中国商朝十进制数玛雅文明象形文字,20进制3、九九乘法口诀:中国最早的算法:九九乘法口诀表。

世界上最早的十进制乘法表:清华简《算表》4、算盘:古今中外算盘类型:沙盘类,算板类,穿珠类。

1.1.2 中世纪的计算机1、机器计算的萌芽•1614年,苏格兰数学家约翰·纳皮尔(J.Napier)提出了对数。

•他发明了简化乘法运算的纳皮尔算筹。

•1623年,德国谢克卡德(W. Schickard)设计的四则运算机器)。

2、帕斯卡加法器•1642年,法国数学家帕斯卡(B.Pascal)制造了第一台加法运算机器。

3.莱布尼茨的二进制思想•莱布尼兹(G.Leibnitz)1694年研制了一台能够做加、减、乘、除运算的机器。

•莱布尼兹研究了定理证明的自动逻辑推理。

•莱布尼兹预想用机器推理演算,使科学知识的产生实现自动化。

•1679年,莱布尼兹发明了二进制记数系统。

4、巴贝奇自动计算机器(1)差分机设计制造•设计目标:•将计算到印刷表格的过程全部自动化;全面消除人为错误。

•差分机是专门用来计算特定多项式函数值的机器。

(2)分析机基本结构•目标:自动计算有100个变量的算题,每个数25位,每秒钟运算一次。

•分析机具备现代计算机的基本特征:•存储器:保存数据的齿轮式寄存器(堆栈),可存储1000个50位十进制数;•运算装置:进行各种运算的装置(工场),可进行十进制四则运算;•程序控制:对操作进行程序控制,可运行“条件”“循环”等语句;•输入输出:用穿孔卡片作为程序输入设备,有数据输出装置。

•由于巴贝奇的杰出贡献,他被称为计算机之父。

5.爱达与程序设计•爱达(Augusta Ada King)的工作:•设计世界上第一个计算机程序:用机器进行伯努利运算;•协助巴贝奇完善分析机的设计;•建立了循环和子程序的概念;•编写:三角函数、级数相乘、伯努利函数等算法程序。

计算机导论知识点整理(1)

第一章

1、什么是计算机?

计算机系统是一种能够按照事先存储的程序,自动、高速的对数据进行输入、处理、输出和存储的系统。

一个计算机系统包括硬件和软件两大部分。

2、解释冯·诺依曼所提出的“存储程序”概念。

把程序和数据都以二进制的形式同意存放在存储器中,由机器自动执行。

不同的程序解决不同的问题,实现了计算机通用计算的功能,

3、计算机有哪些主要的特点?

运算速度快`精度高

计算机的字长越长,其精度越高,现在世界上最快的计算机每秒可以运算几十万次以上。

一般计算机可以有市纪委甚至几十位(二进制)有效数字,计算精度可由千分之几到百万分之几,是任何计算工具所望尘莫及的。

具有逻辑判断和记忆能力

计算机有准确的逻辑判断能力和高超的记忆能力。

能够进行各种逻辑判断,并根据判断的结果自动决定下一步应该执行的指令。

高度的自动化和灵活性

计算机采取存储程序方式工作,即把编号的程序输入计算机,机器便可依次逐条执行,这就使计算机实现了高度的自动化和灵活性。

4、计算机发展中各个阶段的主要特点是什么?

第一代计算机特征是采用电子管作为主要元器件

第二代计算机特征是采用晶体管作为主要器件

第三代计算机特征是半导体中小规模集成电路

第四代计算机特征是大规模和超大规模集成电路

5、信息化社会对计算机人才的素质和知识结构有哪些要求?

在信息化社会中所需要的计算机人才是多方位的,不仅需要研究型、设计型的人才,而且需要应用型的人才;不仅需要开发型人才而且需要维护型、服务型、操作型的人才。

要求计算机人才具有较高的综合素质和创新能力,并对于新技术的发展具有良好的适应性。

第二章

1、十进制数转换为非十进制数的规则是什么?

答:十进制整数转换为非十进制整数的规则:除基取余法:“除基取余,先余为低(位),

后余为高(位)”。

例:(55)

10=(67)

8

余数

8 55 7

8 6 6

2、十进制小数转换为非十进制小数的规则:乘基取整法:“乘基取整,先整为高(位),后整为低(位)”。

例:(0.32)

10=(0.0101…)

2

0.32 整数

× 2

0.64 0

× 2

1.28 1

0.28

× 2

0.56 0

× 2

1.12 1

3、二进制与八进制之间如何转换?

以小数点为界,将整数部分自右向左和小数部分自左向右分别按每3位为一组(不足3位的用0补足),然后将各个3位二进制数转换为对应的1位八进制数,即得到转换的结果。

反之,若把八进制数转换为二进制数,只要把每1位八进制转换为对应的3位二进制数即可。

4、二进制与十六进制之间如何转换?

只要以小数点为界,将整数部分自右向左和小数部分自左向右分别按每4位为一组,不足4位用0补足,然后将各个4位二进制数转换为对应的1位十六进制数,即得到转换的结果。

反之,若将十六进制数转换为二进制数,只要把每1位十六进制数转换为对应的4位二进制数即可。

5、将下列二进制数转换为八进制和十六进制数:10011011.0011011,1010101010.0011001二进制数转换为八进制数:以小数点为界,将整数部分自右向左和小数部分自左向右分别按每三位为一组(不足三位用0补足),然后将各个三位二进制数转换为对应的一位八进制数。

(10011011.0011011)

2= (001 001 011.001 101 100)

2

=(113.154)

8

(1010101010.0011001)

2 =(001 010 101 010.001 100 100)

2

=(1252.144)

8

二进制数转换为十六进制:以小数点为界,将整数部分自右向左和小数部分自左向右分别按每四位为一组,不足四位用0补足,然后将各个四位二进制数转换为对应的一位十六进制数。

(10011011.0011011)

2 =(1001 1011.0011 0110)

2

=(9B.36)

16

(1010101010.0011001)

2 =(0010 1010 1010.0011 0010)

2

=(2AA.32)

16

6、将八进制或者十六进制数转换为二进制数:(75.612)8 ,(64A.C3F)16 答:八进制数转换为二进制数:把每一位八进制数转换为对应的三位二进制数。

(75.612)

8=(111 101.110 001 010)

2

十六进制数转换为二进制数:把每一位十六进制数转换为对应的四位二进制数。

(64A.C3F)

16=(0110 0100 1010.1100 0011 1111)

2

7、什么是原码、补码和反码?写出下列各数的原码、补码和反码:11001,11111,10101

答:原码表示法:用符号位和数值表示带符号数,正数的符号位用“0”表示,负数的符号位用“1”表示,数值部分用二进制形式表示。

反码表示法:正数的反码与原码相同,负数的反码为对该数的原码除符号位外各位取反。

补码表示法:正数的补码与原码相同,负数的补码为对该数的原码除符号位外各位取反,然后在最后一位加1。

原码反码补码

11001 1 0001001 1 1110110 1 1110111 11111 1 0001111 1 1110000 1 1110001 10101 1 0000101 1 1111010 1 1111011

8、计算机硬件系统由哪几部分组成?简述各部分的功能。

答:计算机硬件系统由运算器、控制器、输入设备和输出设备五个部分组成。

它们的作用如下:1运算器主要功能是算术运算和逻辑运算;2控制器功能是依次从存储器取出指令、翻译指令、分析指令,向其他部件发出控制信号,指挥计算机各部件协同工作;3存储器主要功能是存放程序和数据;4输入设备用来接收用户输入的数据和程序,并将它们转变为计算机可以识别的形式(二进制代码)存在内存中;5输出设备用于将存放在内存中由计算机处理的结果转变为人们所能接受的形式。

9、计算机的工作原理是什么?它是由谁首先提出来的?

答:计算机在运行时,先从内存中取出第一条指令,通过控制器的译码,按指令的要求,从存贮器中取出数据进行指定的运算和逻辑操作等加工,然后再按地址把结果送到内存中去。

接下来,再取出第二条指令,在控制器的指挥下完成规定操作。

依此进行下去,直至遇到停止指令。

程序与数据一样存贮,按程序编排的顺序,一步一步地取出指令,自动地完成指令规定的操作是计算机最基本的工作原理。

这一原理最初是由美籍匈牙利数学家冯.诺依曼于1945年提出来的,故称为冯.诺依曼原理。

10、在计算机系统中,位、字节、字和字长所表示的含义各是什么?

答:位:在数字电路和电脑技术中采用二进制,代码只有0和1,其中无论是0还是1在CPU中都是一位;

字节:8个二进制位为一个字节。

为了便于衡量存储器的大小,统一以字节(Byte,B)为单位;

字:不同计算机系统中字长的整数倍;

字长:CPU在单位时间内(同一时间)能一次处理的二进制数据的位数叫字长

11、什么是算法?它有那些特点?常用的算法描述工具有哪几种?

答:算法:是由一系列规则组成的过程,这些规则确定了一个操作的顺序,以便能在有限步骤内得到特定问题的解。

算法的性质:(1)确定性(2)通用性(3)有限性

算法的描述工具:(1)自然语言(2)流程图(3)决策表(4)算法描述语言

12、什么是线性表?线性表有那些运算?线性表怎样储存?

答:线性表:是n个数据元素的有限序列。

线性表的运算:设L为一个线性表(1)置空表SETNULL(L)(2)求表的长度LENGTH(L)(3)取表元素GET(L,i)(4)在表中查找特定元素LOCATE(L,x)(5)插入新元素INSERT(L,i,b)(6)删除表元素DELETE(L,i)线性表的存储结构:(1)顺序存储结构(2)链式存储结构

13、什么是堆栈?堆栈有那些运算?堆栈怎样储存?

答:堆栈(stack):是一种受限的线性表,即只能在表的一端(表尾)进行插入和删除操作。

进栈和退栈操作按“后进先出”(Last In First Out,LIFO)的原则进行。

堆栈的运算:设S为一个堆栈(1)置空栈SETNULL(S)(2)进栈PUSH(S,x)(3)退栈POP(S)(4)取栈顶元素TOP(S)(5)判断堆栈是否为空EMPTY(S)

top用来指示栈顶的位置。

14、什么是队列?队列有那些运算?队列怎样储存?

,只能在表的一端(队尾)进行插入,在表的另一端(队首)进行删除操作。

进、出队列操作按“先进先出”(First In First Out,FIFO)的原则进行。

设Q为一个队列(1)置空队列SETNULL(Q)(2)进入队列ADDQUEUE (Q,x)(3)退出队列DELQUEUE(Q)(4)取队首元素FRONTQUE(Q)(5)判断队列是否为空EMPTY(Q)

队列的存储结构:链式存储结构,一个链队列需要设置队首指针和队尾指针。