07 hadoop完全分布式安装第七步:zookeeper分布式配置

- 格式:docx

- 大小:24.64 KB

- 文档页数:5

zookeeper基本操作命令ZooKeeper是一个分布式的开源协调服务,用于管理大规模分布式系统的配置信息、命名服务、分布式锁等。

作为一个基础设施工具,ZooKeeper提供了一组简单易用的命令来进行基本操作。

本文将介绍一些常用的ZooKeeper基本操作命令。

1. 创建节点(create)在ZooKeeper中,节点是组织和存储数据的基本单元。

使用create命令可以在指定的路径下创建节点,并设置节点的值和特性。

命令格式:```create path data [acl]```其中,path表示节点的路径,data表示节点的值,acl表示节点的访问控制列表(可选)。

2. 获取节点数据(get)使用get命令可以获取指定节点的数据。

命令格式:```get path```其中,path表示节点的路径。

3. 设置节点数据(set)使用set命令可以设置指定节点的数据。

命令格式:```set path data [version]```其中,path表示节点的路径,data表示节点的新值,version表示节点的版本号(可选)。

4. 列出子节点(ls)使用ls命令可以列出指定节点的所有子节点。

命令格式:```ls path```其中,path表示节点的路径。

5. 删除节点(delete)使用delete命令可以删除指定节点及其所有子节点。

命令格式:```delete path [version]```其中,path表示节点的路径,version表示节点的版本号(可选)。

6. 监听节点变化(getWatches)使用getWatches命令可以查看当前会话中设置的所有节点监听。

命令格式:```getWatches```7. 添加节点监听(watches)使用watches命令可以在指定节点上添加监听。

命令格式:```watches path```其中,path表示节点的路径。

8. 检查节点是否存在(exists)使用exists命令可以检查指定节点是否存在。

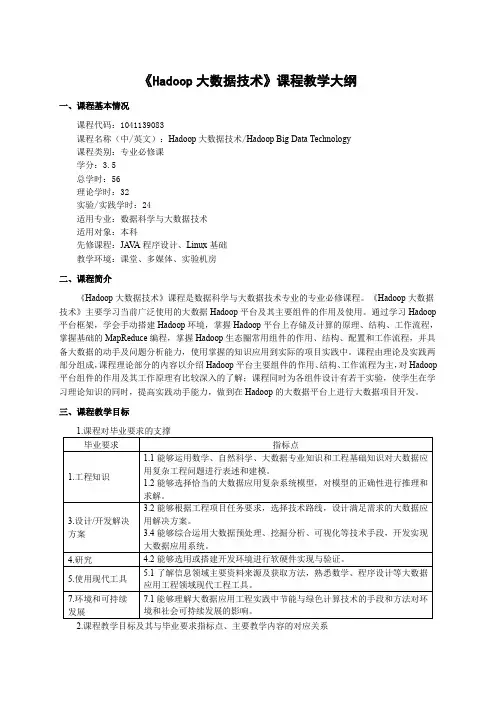

《Hadoop大数据技术》课程教学大纲一、课程基本情况课程代码:1041139083课程名称(中/英文):Hadoop大数据技术/Hadoop Big Data Technology课程类别:专业必修课学分:3.5总学时:56理论学时:32实验/实践学时:24适用专业:数据科学与大数据技术适用对象:本科先修课程:JA V A程序设计、Linux基础教学环境:课堂、多媒体、实验机房二、课程简介《Hadoop大数据技术》课程是数据科学与大数据技术专业的专业必修课程。

《Hadoop大数据技术》主要学习当前广泛使用的大数据Hadoop平台及其主要组件的作用及使用。

通过学习Hadoop 平台框架,学会手动搭建Hadoop环境,掌握Hadoop平台上存储及计算的原理、结构、工作流程,掌握基础的MapReduce编程,掌握Hadoop生态圈常用组件的作用、结构、配置和工作流程,并具备大数据的动手及问题分析能力,使用掌握的知识应用到实际的项目实践中。

课程由理论及实践两部分组成,课程理论部分的内容以介绍Hadoop平台主要组件的作用、结构、工作流程为主,对Hadoop 平台组件的作用及其工作原理有比较深入的了解;课程同时为各组件设计有若干实验,使学生在学习理论知识的同时,提高实践动手能力,做到在Hadoop的大数据平台上进行大数据项目开发。

三、课程教学目标2.课程教学目标及其与毕业要求指标点、主要教学内容的对应关系四、教学内容(一)初识Hadoop大数据技术1.主要内容:掌握大数据的基本概念、大数据简史、大数据的类型和特征、大数据对于企业带来的挑战。

了解对于大数据问题,传统方法、Google的解决方案、Hadoop框架下的解决方案,重点了解Google的三篇论文。

掌握Hadoop核心构成、Hadoop生态系统的主要组件、Hadoop发行版本的差异及如何选择;了解Hadoop典型应用场景;了解本课程内容涉及到的Java语言基础;了解本课程实验涉及到的Linux基础。

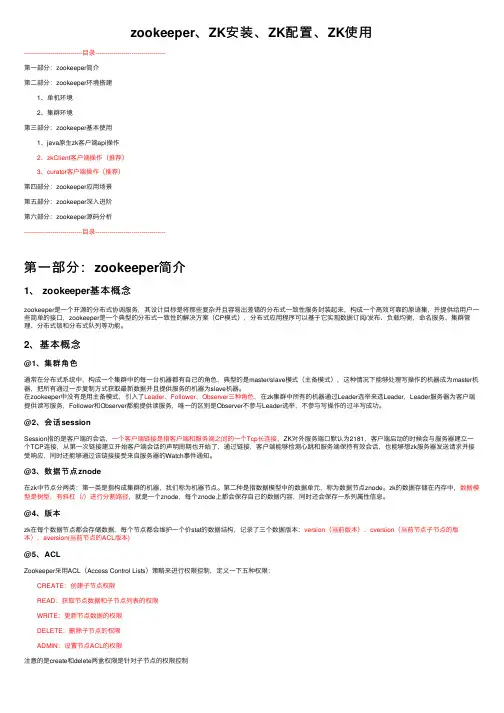

zookeeper、ZK安装、ZK配置、ZK使⽤-----------------------------⽬录-----------------------------------第⼀部分:zookeeper简介第⼆部分:zookeeper环境搭建 1、单机环境 2、集群环境第三部分:zookeeper基本使⽤ 1、java原⽣zk客户端api操作 2、zkClient客户端操作(推荐) 3、curator客户端操作(推荐)第四部分:zookeeper应⽤场景第五部分:zookeeper深⼊进阶第六部分:zookeeper源码分析-----------------------------⽬录-----------------------------------第⼀部分:zookeeper简介1、 zookeeper基本概念zookeeper是⼀个开源的分布式协调服务,其设计⽬标是将那些复杂并且容易出差错的分布式⼀致性服务封装起来,构成⼀个⾼效可靠的原语集,并提供给⽤户⼀些简单的接⼝,zookeeper是⼀个典型的分布式⼀致性的解决⽅案(CP模式),分布式应⽤程序可以基于它实现数据订阅/发布、负载均衡,命名服务、集群管理、分布式锁和分布式队列等功能。

2、基本概念@1、集群⾓⾊通常在分布式系统中,构成⼀个集群中的每⼀台机器都有⾃⼰的⾓⾊,典型的是master/slave模式(主备模式),这种情况下能够处理写操作的机器成为master机器,把所有通过⼀步复制⽅式获取最新数据并且提供服务的机器为slave机器。

在zookeeper中没有是⽤主备模式,引⼊了Leader、Follower、Observer三种⾓⾊,在zk集群中所有的机器通过Leader选举来选Leader,Leader服务器为客户端提供读写服务,Follower和Observer都能提供读服务,唯⼀的区别是Observer不参与Leader选举,不参与写操作的过半写成功。

全国职业院校技能大赛赛项规程赛项名称:大数据应用开发英文名称: Big Data Application Development 赛项组别:高等职业教育(师生同赛)赛项编号: GZ033一、赛项信息二、竞赛目标“十四五”时期,大数据产业对经济社会高质量发展的赋能作用更加突显,大数据已成为催生新业态、激发新模式、促进新发展的技术引擎。

习近平总书记指出“大数据是信息化发展的新阶段”,“加快数字化发展,建设数字中国”成为《中华人民共和国国民经济和社会发展第十四个五年规划和2035年远景目标纲要》的重要篇章。

本赛项旨在落实国家“建设数字中国”战略,协同推动大数据相关产业的创新与发展,大力推进大数据技术及相关专业的技术技能型人才培养,全面提升相关专业毕业生的综合能力,展现选手团队合作、工匠精神等职业素养,赋能经济社会高质量发展。

竞赛内容结合当前大数据相关产业中的新技术、新要求如数据湖、OLAP 数据库应用等,全面检验参赛选手的工程实践能力和创新能力,推进教学过程与生产过程对接、课程内容与职业标准对接、专业设置与产业需求对接,促进职普融通、产教融合、科教融汇,引领专业建设和教学改革。

竞赛内容围绕大数据相关产业岗位的实际技能要求进行设计,通过竞赛搭建校企合作的平台,强化竞赛成果转化,促进相关教材、资源、师资、认证、实习就业等方面的全方位建设,满足产教协同育人目标,为国家战略规划提供大数据领域高素质技能型人才。

三、竞赛内容本赛项涉及的典型工作任务包括大数据平台搭建(容器环境)、离线数据处理、数据挖掘、数据采集与实时计算、数据可视化、综合分析、职业素养,引入行业内较为前沿的数据湖架构作为创新、创意的范围与方向,考查的技术技能如下:(一)大数据平台搭建(容器环境):Docker容器基础操作、Hadoop完全分布式安装配置、Hadoop HA安装配置、Spark on Yarn 安装配置、Flink on Yarn安装配置、Hive安装配置、Flume安装配置、ZooKeeper安装配置、Kafka安装配置、HBase分布式安装配置、Cli ckHouse单节点安装配置、Hudi安装配置。

Hadoop的安装与配置及示例程序wordcount的运行目录前言 (1)1 机器配置说明 (2)2 查看机器间是否能相互通信(使用ping命令) (2)3 ssh设置及关闭防火墙 (2)1)fedora装好后默认启动sshd服务,如果不确定的话可以查一下[garon@hzau01 ~]$ service sshd status (3)2)关闭防火墙(NameNode和DataNode都必须关闭) (3)4 安装jdk1.6(集群中机子都一样) (3)5 安装hadoop(集群中机子都一样) (4)6 配置hadoop (4)1)配置JA V A环境 (4)2)配置conf/core-site.xml、conf/hdfs-site.xml、conf/mapred-site.xml文件 (5)3)将NameNode上完整的hadoop拷贝到DataNode上,可先将其进行压缩后直接scp 过去或是用盘拷贝过去 (7)4)配置NameNode上的conf/masters和conf/slaves (7)7 运行hadoop (7)1)格式化文件系统 (7)2)启动hadoop (7)3)用jps命令查看进程,NameNode上的结果如下: (8)4)查看集群状态 (8)8 运行Wordcount.java程序 (8)1)先在本地磁盘上建立两个文件f1和f2 (8)2)在hdfs上建立一个input目录 (9)3)将f1和f2拷贝到hdfs的input目录下 (9)4)查看hdfs上有没有f1,f2 (9)5)执行wordcount(确保hdfs上没有output目录) (9)6)运行完成,查看结果 (9)前言最近在学习Hadoop,文章只是记录我的学习过程,难免有不足甚至是错误之处,请大家谅解并指正!Hadoop版本是最新发布的Hadoop-0.21.0版本,其中一些Hadoop命令已发生变化,为方便以后学习,这里均采用最新命令。

Hadoop的安装与配置建立一个三台电脑的群组,操作系统均为Ubuntu,三个主机名分别为wjs1、wjs2、wjs3。

1、环境准备:所需要的软件及我使用的版本分别为:Hadoop版本为0.19.2,JDK版本为jdk-6u13-linux-i586.bin。

由于Hadoop要求所有机器上hadoop的部署目录结构要相同,并且都有一个相同的用户名的帐户。

所以在三台主机上都设置一个用户名为“wjs”的账户,主目录为/home/wjs。

a、配置三台机器的网络文件分别在三台机器上执行:sudo gedit /etc/network/interfaceswjs1机器上执行:在文件尾添加:auto eth0iface eth0 inet staticaddress 192.168.137.2gateway 192.168.137.1netmask 255.255.255.0wjs2和wjs3机器上分别执行:在文件尾添加:auto eth1iface eth1 inet staticaddress 192.168.137.3(wjs3上是address 192.168.137.4)gateway 192.168.137.1netmask 255.255.255.0b、重启网络:sudo /etc/init.d/networking restart查看ip是否配置成功:ifconfig{注:为了便于“wjs”用户能够修改系统设置访问系统文件,最好把“wjs”用户设为sudoers(有root权限的用户),具体做法:用已有的sudoer登录系统,执行sudo visudo -f /etc/sudoers,并在此文件中添加以下一行:wjsALL=(ALL)ALL,保存并退出。

}c、修改三台机器的/etc/hosts,让彼此的主机名称和ip都能顺利解析,在/etc/hosts中添加:192.168.137.2 wjs1192.168.137.3 wjs2192.168.137.4 wjs3d、由于Hadoop需要通过ssh服务在各个节点之间登陆并运行服务,因此必须确保安装Hadoop的各个节点之间网络的畅通,网络畅通的标准是每台机器的主机名和IP地址能够被所有机器正确解析(包括它自己)。

Hadoop详细安装过程一、本文思路1、安装虚拟化PC工具VMware,用于支撑Linux系统。

2、在VMware上安装Ubuntu系统。

3、安装Hadoop前的准备工作:安装JDK和SSH服务。

4、配置Hadoop。

5、为了方便开发过程,需安装eclipse。

6、运行一个简单的Hadoop程序:WordCount.java注:在win7系统上,利用虚拟工具VMware建立若干个Linux系统,每个系统为一个节点,构建Hadoop集群。

先在一个虚拟机上将所有需要配置的东西全部完成,然后再利用VMware 的克隆功能,直接生成其他虚拟机,这样做的目的是简单。

二、所需软件1、VMware:VMware Workstation,直接百度下载(在百度软件中心下载即可)。

2、Ubuntu系统:ubuntu-15.04-desktop-amd64.iso,百度网盘:/s/1qWxfxso注:使用15.04版本的Ubuntu(其他版本也可以),是64位系统。

3、jdk:jdk-8u60-linux-x64.tar.gz,网址:/technetwork/java/javase/downloads/jdk8-downloads-2133151.html注:下载64位的Linux版本的jdk。

4、Hadoop:hadoop-1.2.1-bin.tar.gz,网址:/apache/hadoop/common/hadoop-1.2.1/注:选择1.2.1版本的Hadoop。

5、eclipse:eclipse-java-mars-1-linux-gtk-x86_64.tar.gz,网址:/downloads/?osType=linux注:要选择Linux版本的,64位,如下:6、hadoop-eclipse-plugin-1.2.1.jar,这是eclipse的一个插件,用于Hadoop的开发,直接百度下载即可。

三、安装过程1、安装VMware。

hadoop安装以及配置启动命令本次安装使⽤的Hadoop⽂件是badou学院的Hadoop1.2.1.tar.gz,以下步骤都是在此版本上进⾏。

1、安装,通过下载tar.gz⽂件安装到指定⽬录2、安装好后需要配置Hadoop集群配置信息: 在hadoop的conf路径中的masters中添加master(集群机器主的hostname)在slaves中添加集群的slave的hostname名称名称对应的是各⾃机器的hostname这样通过hosts⽂件中配置的域名地址映射可以直接找到对应的机器 a、core-site.xml 在xml⽂件中添加<property><name>hadoop.tmp.dir</name><value>/usr/local/src/hadoop.1.2.1/tmp</value></property> <property><name></name><value>hdfs://192.168.79.10:9000</value></property> c、hdfs-site.xml 在⽂件中添加<property><name>dfs.replication</name><value>3</value></property><!-- 复制节点数 --> d、hadoop-env.xml 在⽂件中添加export JAVA_HOME=/usr/local/src/jdk1.6.0_45 步骤2配置好后将当前hadoop⽂件夹复制到集群中其他机器上,只需要在对应机器上修改其对应的ip、port、jdk路径等信息即可搭建集群3、配置好Hadoop环境后需要测试环境是否可⽤: a、⾸先进⼊Hadoop的安装⽬录,进⼊bin⽬录下,先将Hadoop环境初始化,命令:./hadoop namenode -format b、初始化之后启动Hadoop,命令:./start_all.sh c、查看Hadoop根⽬录下的⽂件,命令:./hadoop fs -ls/ d、上传⽂件,命令:./hadoop fs -put ⽂件路径 e、查看⽂件内容,命令:./hadoopo fs -cat hadoop⽂件地址注意:在安装Hadoop环境时先安装好机器集群,使得⾄少3台以上(含3台)机器之间可以免密互相登录(可以查看上⼀篇的linux的ssh免密登录)执⾏Python⽂件时的部分配置/usr/local/src/hadoop-1.2.1/bin/hadoop/usr/local/src/hadoop-1.2.1/contrib/streaming/hadoop-streaming-1.2.1.jar。

Hadoop集群的搭建方法与步骤随着大数据时代的到来,Hadoop作为一种分布式计算框架,被广泛应用于数据处理和分析领域。

搭建一个高效稳定的Hadoop集群对于数据科学家和工程师来说至关重要。

本文将介绍Hadoop集群的搭建方法与步骤。

一、硬件准备在搭建Hadoop集群之前,首先要准备好适合的硬件设备。

Hadoop集群通常需要至少三台服务器,一台用于NameNode,两台用于DataNode。

每台服务器的配置应该具备足够的内存和存储空间,以及稳定的网络连接。

二、操作系统安装在选择操作系统时,通常推荐使用Linux发行版,如Ubuntu、CentOS等。

这些操作系统具有良好的稳定性和兼容性,并且有大量的Hadoop安装和配置文档可供参考。

安装操作系统后,确保所有服务器上的软件包都是最新的。

三、Java环境配置Hadoop是基于Java开发的,因此在搭建Hadoop集群之前,需要在所有服务器上配置Java环境。

下载最新版本的Java Development Kit(JDK),并按照官方文档的指引进行安装和配置。

确保JAVA_HOME环境变量已正确设置,并且可以在所有服务器上运行Java命令。

四、Hadoop安装与配置1. 下载Hadoop从Hadoop官方网站上下载最新的稳定版本,并将其解压到一个合适的目录下,例如/opt/hadoop。

2. 编辑配置文件进入Hadoop的安装目录,编辑conf目录下的hadoop-env.sh文件,设置JAVA_HOME环境变量为Java的安装路径。

然后,编辑core-site.xml文件,配置Hadoop的核心参数,如文件系统的默认URI和临时目录。

接下来,编辑hdfs-site.xml文件,配置Hadoop分布式文件系统(HDFS)的相关参数,如副本数量和数据块大小。

最后,编辑mapred-site.xml文件,配置MapReduce框架的相关参数,如任务调度器和本地任务运行模式。

hadoop分布式环境搭建实验总结Hadoop分布式环境搭建实验总结一、引言Hadoop是目前最流行的分布式计算框架之一,它具有高可靠性、高扩展性和高效性的特点。

在本次实验中,我们成功搭建了Hadoop分布式环境,并进行了相关测试和验证。

本文将对实验过程进行总结和归纳,以供参考。

二、实验准备在开始实验之前,我们需要准备好以下几个方面的内容:1. 硬件环境:至少两台具备相同配置的服务器,用于搭建Hadoop 集群。

2. 软件环境:安装好操作系统和Java开发环境,并下载Hadoop 的安装包。

三、实验步骤1. 安装Hadoop:解压Hadoop安装包,并根据官方文档进行相应的配置,包括修改配置文件、设置环境变量等。

2. 配置SSH无密码登录:为了实现集群间的通信,需要配置各个节点之间的SSH无密码登录。

具体步骤包括生成密钥对、将公钥分发到各个节点等。

3. 配置Hadoop集群:修改Hadoop配置文件,包括core-site.xml、hdfs-site.xml和mapred-site.xml等,设置集群的基本参数,如文件系统地址、数据存储路径等。

4. 启动Hadoop集群:通过启动NameNode、DataNode和ResourceManager等守护进程,使得集群开始正常运行。

可以通过jps命令来验证各个进程是否成功启动。

5. 测试Hadoop集群:可以使用Hadoop自带的例子程序进行测试,如WordCount、Sort等。

通过执行这些程序,可以验证集群的正常运行和计算能力。

四、实验结果经过以上步骤的操作,我们成功搭建了Hadoop分布式环境,并进行了相关测试。

以下是我们得到的一些实验结果:1. Hadoop集群的各个节点正常运行,并且能够相互通信。

2. Hadoop集群能够正确地处理输入数据,并生成期望的输出结果。

3. 集群的负载均衡和容错能力较强,即使某个节点出现故障,也能够继续运行和处理任务。

Hadoop大数据开发实战教学设计课程名称:Hadoop大数据开发实战授课年级:______ ______________ ___ 授课学期:___ ____ ________ ________ 教师姓名:______________ ________第一课时(认识Zookeeper、Zookeeper安装和常用命令)回顾内容,引出本课时主题1.回顾内容,引出本课时的主题上节学习了MapReduce分布式计算框架,本节将介绍关于Zookeeper的现关知识。

Zoopkeeper是Hadoop集群管理中必不可少的组件,提供了一套分布式集群管理的机制。

在Zoopkeeper 的协调下,Hadoop集群可以实现高可用,保证了集群的稳定性,对于实际生产环境来说,意义重大。

本节先带领大家认识一下Zookeeper,完成Zookeeper的安装,学习一些Zookeeper常用命令。

2.明确学习目标(1)能够理解Zookeeper的设计目的(2)能够理解Zookeeper的系统模型(3)能够掌握Zookeeper中的角色(4)能够掌握Zookeeper的工作原理(5)能够掌握Zookeeper单机模式(6)能够掌握Zookeeper全分布式(7)能够掌握Zookeeper服务器常用脚本知识讲解➢Zookeeper简介Zookeeper是开源的分布式应用程序协调服务。

Zookeeper提供了同步服务、命名服务、组服务、配置管理服务,较好地解决了Hadoop中经常出现的死锁、竞态条件等问题。

死锁是在执行两个或两个以上的进程时,由竞争资源或彼此通信而造成的阻塞现象。

竞态条件是指在执行两个或两个以上的进程时,进程执行顺序对执行后的结果存在影响。

Zookeeper可以与需要保证高可用的Hadoop组件搭配使用,例如,HA模式下的HDFS、HA模式下的YARN、HBase。

➢Zookeeper的设计目的Zookeeper提供一个协调方便、易于编程的环境,能够减轻分布式应用程序所承担的协调任务,其设计的主要体现在以下几个方面。

Zookeeper 安装和配置zookeeperZookeeper的安装和配置十分简单, 既可以配置成单机模式, 也可以配置成集群模式.下面将分别进行介绍.单机模式点击这里下载zookeeper的安装包之后, 解压到合适目录. 进入zookeeper目录下的conf子目录, 创建zoo.cfg:Bash代码参数说明:∙tickTime: zookeeper中使用的基本时间单位, 毫秒值.∙dataDir: 数据目录. 可以是任意目录.∙dataLogDir: log目录, 同样可以是任意目录. 如果没有设置该参数, 将使用和dataDir 相同的设置.∙clientPort: 监听client连接的端口号.至此, zookeeper的单机模式已经配置好了. 启动server只需运行脚本:Bash代码Server启动之后, 就可以启动client连接server了, 执行脚本:伪集群模式所谓伪集群, 是指在单台机器中启动多个zookeeper进程, 并组成一个集群. 以启动3个zookeeper进程为例.将zookeeper的目录拷贝2份:Bash代码更改zookeeper0/conf/zoo.cfg文件为:新增了几个参数, 其含义如下:∙initLimit: zookeeper集群中的包含多台server, 其中一台为leader, 集群中其余的server为follower. initLimit参数配置初始化连接时, follower和leader之间的最长心跳时间. 此时该参数设置为5, 说明时间限制为5倍tickTime, 即5*2000=10000ms=10s. ∙syncLimit: 该参数配置leader和follower之间发送消息, 请求和应答的最大时间长度.此时该参数设置为2, 说明时间限制为2倍tickTime, 即4000ms.∙server.X=A:B:C 其中X是一个数字, 表示这是第几号server. A是该server所在的IP 地址. B配置该server和集群中的leader交换消息所使用的端口. C配置选举leader时所使用的端口. 由于配置的是伪集群模式, 所以各个server的B, C参数必须不同.参照zookeeper0/conf/zoo.cfg, 配置zookeeper1/conf/zoo.cfg, 和zookeeper2/conf/zoo.cfg文件. 只需更改dataDir, dataLogDir, clientPort参数即可.在之前设置的dataDir中新建myid文件, 写入一个数字, 该数字表示这是第几号server.该数字必须和zoo.cfg文件中的server.X中的X一一对应./Users/apple/zookeeper0/data/myid文件中写入0,/Users/apple/zookeeper1/data/myid文件中写入1,/Users/apple/zookeeper2/data/myid文件中写入2.分别进入/Users/apple/zookeeper0/bin, /Users/apple/zookeeper1/bin,/Users/apple/zookeeper2/bin三个目录, 启动server.任意选择一个server目录, 启动客户端:集群模式集群模式的配置和伪集群基本一致.由于集群模式下, 各server部署在不同的机器上, 因此各server的conf/zoo.cfg文件可以完全一样.下面是一个示例:示例中部署了3台zookeeper server, 分别部署在10.1.39.43, 10.1.39.47, 10.1.39.48上. 需要注意的是, 各server的dataDir目录下的myid文件中的数字必须不同.10.1.39.43 server的myid为43, 10.1.39.47 server的myid为47, 10.1.39.48 server 的myid为48.。

Hadoop详细安装过程一、本文思路1、安装虚拟化PC工具VMware,用于支撑Linux系统。

2、在VMware上安装Ubuntu系统。

3、安装Hadoop前的准备工作:安装JDK和SSH服务。

4、配置Hadoop。

5、为了方便开发过程,需安装eclipse。

6、运行一个简单的Hadoop程序:WordCount.java注:在win7系统上,利用虚拟工具VMware建立若干个Linux系统,每个系统为一个节点,构建Hadoop集群。

先在一个虚拟机上将所有需要配置的东西全部完成,然后再利用VMware 的克隆功能,直接生成其他虚拟机,这样做的目的是简单。

二、所需软件1、VMware:VMware Workstation,直接百度下载(在百度软件中心下载即可)。

2、Ubuntu系统:ubuntu-15.04-desktop-amd64.iso,百度网盘:/s/1qWxfxso注:使用15.04版本的Ubuntu(其他版本也可以),是64位系统。

3、jdk:jdk-8u60-linux-x64.tar.gz,网址:/technetwork/java/javase/downloads/jdk8-downloads-2133151.html注:下载64位的Linux版本的jdk。

4、Hadoop:hadoop-1.2.1-bin.tar.gz,网址:/apache/hadoop/common/hadoop-1.2.1/注:选择1.2.1版本的Hadoop。

5、eclipse:eclipse-java-mars-1-linux-gtk-x86_64.tar.gz,网址:/downloads/?osType=linux注:要选择Linux版本的,64位,如下:6、hadoop-eclipse-plugin-1.2.1.jar,这是eclipse的一个插件,用于Hadoop的开发,直接百度下载即可。

三、安装过程1、安装VMware。

hadoop安装与配置总结与心得安装与配置Hadoop是一个相对复杂的任务,但如果按照正确的步骤进行,可以顺利完成。

以下是我在安装与配置Hadoop 过程中的总结与心得:1. 首先,确保你已经满足Hadoop的系统要求,并且已经安装了Java环境和SSH。

2. 下载Hadoop的压缩包,并解压到你想要安装的目录下。

例如,解压到/opt/hadoop目录下。

3. 配置Hadoop的环境变量。

打开你的.bashrc文件(或者.bash_profile文件),并添加以下内容:```shellexport HADOOP_HOME=/opt/hadoopexport PATH=$PATH:$HADOOP_HOME/bin```保存文件后,执行source命令使其生效。

4. 配置Hadoop的核心文件。

打开Hadoop的配置文件core-site.xml,并添加以下内容:```xml<configuration><property><name>fs.defaultFS</name><value>hdfs://localhost:9000</value></property></configuration>```5. 配置Hadoop的HDFS文件系统。

打开Hadoop的配置文件hdfs-site.xml,并添加以下内容:```xml<configuration><property><name>dfs.replication</name><value>1</value></property></configuration>```这里的dfs.replication属性指定了数据块的副本数量,可以根据实际情况进行调整。

6. 配置Hadoop的MapReduce框架。

Hadoop大数据开发基础教案-Hadoop集群的搭建及配置教案教案章节一:Hadoop简介1.1 课程目标:了解Hadoop的发展历程及其在大数据领域的应用理解Hadoop的核心组件及其工作原理1.2 教学内容:Hadoop的发展历程Hadoop的核心组件(HDFS、MapReduce、YARN)Hadoop的应用场景1.3 教学方法:讲解与案例分析相结合互动提问,巩固知识点教案章节二:Hadoop环境搭建2.1 课程目标:学会使用VMware搭建Hadoop虚拟集群掌握Hadoop各节点的配置方法2.2 教学内容:VMware的安装与使用Hadoop节点的规划与创建Hadoop配置文件(hdfs-site.xml、core-site.xml、yarn-site.xml)的编写与配置2.3 教学方法:演示与实践相结合手把手教学,确保学生掌握每个步骤教案章节三:HDFS文件系统3.1 课程目标:理解HDFS的设计理念及其优势掌握HDFS的搭建与配置方法3.2 教学内容:HDFS的设计理念及其优势HDFS的架构与工作原理HDFS的搭建与配置方法3.3 教学方法:讲解与案例分析相结合互动提问,巩固知识点教案章节四:MapReduce编程模型4.1 课程目标:理解MapReduce的设计理念及其优势学会使用MapReduce解决大数据问题4.2 教学内容:MapReduce的设计理念及其优势MapReduce的编程模型(Map、Shuffle、Reduce)MapReduce的实例分析4.3 教学方法:互动提问,巩固知识点教案章节五:YARN资源管理器5.1 课程目标:理解YARN的设计理念及其优势掌握YARN的搭建与配置方法5.2 教学内容:YARN的设计理念及其优势YARN的架构与工作原理YARN的搭建与配置方法5.3 教学方法:讲解与案例分析相结合互动提问,巩固知识点教案章节六:Hadoop生态系统组件6.1 课程目标:理解Hadoop生态系统的概念及其重要性熟悉Hadoop生态系统中的常用组件6.2 教学内容:Hadoop生态系统的概念及其重要性Hadoop生态系统中的常用组件(如Hive, HBase, ZooKeeper等)各组件的作用及相互之间的关系6.3 教学方法:互动提问,巩固知识点教案章节七:Hadoop集群的调优与优化7.1 课程目标:学会对Hadoop集群进行调优与优化掌握Hadoop集群性能监控的方法7.2 教学内容:Hadoop集群调优与优化原则参数调整与优化方法(如内存、CPU、磁盘I/O等)Hadoop集群性能监控工具(如JMX、Nagios等)7.3 教学方法:讲解与案例分析相结合互动提问,巩固知识点教案章节八:Hadoop安全与权限管理8.1 课程目标:理解Hadoop安全的重要性学会对Hadoop集群进行安全配置与权限管理8.2 教学内容:Hadoop安全概述Hadoop的认证与授权机制Hadoop安全配置与权限管理方法8.3 教学方法:互动提问,巩固知识点教案章节九:Hadoop实战项目案例分析9.1 课程目标:学会运用Hadoop解决实际问题掌握Hadoop项目开发流程与技巧9.2 教学内容:真实Hadoop项目案例介绍与分析Hadoop项目开发流程(需求分析、设计、开发、测试、部署等)Hadoop项目开发技巧与最佳实践9.3 教学方法:案例分析与讨论团队协作,完成项目任务教案章节十:Hadoop的未来与发展趋势10.1 课程目标:了解Hadoop的发展现状及其在行业中的应用掌握Hadoop的未来发展趋势10.2 教学内容:Hadoop的发展现状及其在行业中的应用Hadoop的未来发展趋势(如Big Data生态系统的演进、与大数据的结合等)10.3 教学方法:讲解与案例分析相结合互动提问,巩固知识点重点和难点解析:一、Hadoop生态系统的概念及其重要性重点:理解Hadoop生态系统的概念,掌握生态系统的组成及相互之间的关系。

Hadoop分布式详细安装步骤版本:0.20.2准备工作:由于Hadoop要求所有主机上hadoop的部署目录结构要相同,并且都有一个相同的用户名的帐户。

二台机器上是这样的:都有一个coole的帐户,主目录是/home/coole两台机器(内存应在512以上,否则可能会出现计算极度缓慢的情况):一台机器名:master IP:211.87.239.181一台机器名:slave IP:211.87.239.182每台都建coole用户如果是ubuntu,为了便于用coole帐号修改系统设置和访问系统文件,推荐把coole也设为sudoers(有root 权限的用户),具体做法是用已有的sudoer登录系统,执行sudo visudo –f /etc/sudoers,并在此文件中添加以下一行:mapred ALL=(ALL) ALL一、更改主机名:1、修改/etc/sysconfig/networkNETWORKING=yesHOSTNAME=yourname (在这修改hostname,把yourname换成你想用的名字)NISDOMAIN=修改后机器211.87.239.181中/etc/sysconfig/network文件内容为:NETWORKING=yesHOSTNAME=master修改后机器211.87.239.182中/etc/sysconfig/network文件内容为:NETWORKING=yesHOSTNAME=slave2、最后在终端下执行:# hostname ***** (*****为修改后的hostname,即你想用的名字)例如#hostname master特别提示:各处修改的名字要保持一致,否则会出现问题。

3、修改每台机器的/etc/hosts,保证每台机器间都可以通过机器名解析配置etc/hosts文件,以root 身份打开/etc/hosts文件。

Master/slave做同样修改。

实验七 zookeeper分布式的配置

tar -zxvf zookeeper-3.4.5.tar.gz

mv zookeeper-3.4.5 zookeeper

cd zookeeper

mkdir data

mkdir logs

三、集群模式

集群模式就是在不同主机上安装zookeeper然后组成集群的模式;下边以在192.168.1.1,192.168.1.2,192.168.1.3三台主机为例。

zookeeper 配置

1.Zookeeper服务集群规模不小于三个节点,要求各服务之间系统时间要保持一致。

2.在master的/home/chenlijun目录下,解压缩zookeeper(执行命令tar –zvxf zooke eper.tar.gz)

3.设置环境变量

打开/etc/profile文件!内容如下:

1.#set java & hadoop

2.

3.export JAVA_HOME=/home/chenlijun/java/

4.

5.export HADOOP_HOME=/home/chenlijun/hadoop

6.

7.export ZOOKEEPER_HOME=/home/chenlijun/zookeeper

8.

9.export PATH=.:$HADOOP_HOME/bin:$ZOOKEEPER_HOME/bin:$JAVA_HOME/bin:$PATH

注:修改完后profile记得执行source /etc/profile

4.在解压后的zookeeper的目录下进入conf目录修改配置文件

更名操作:mv zoo_sample.cfg zoo.cfg

5.编辑zoo.cfg (vi zoo.cfg)

修改dataDir=/home/chenlijun/zookeeper/data/

新增server.0=master:2888:3888

server.1=slave1:2888:3888

server.2=slave2:2888:3888

文件如下:

1.# The number of milliseconds of each tick

2.

3.tickTime=2000

4.

5.# The number of ticks that the initial

6.

7.# synchronization phase can take

8.

9.initLimit=10

10.

11.# The number of ticks that can pass between

12.

13.# sending a request and getting an acknowledgement

14.

15.syncLimit=5

16.

17.# the directory where the snapshot is stored.

18.

19.# do not use /tmp for storage, /tmp here is just

20.

21.# example sakes.

22.

23.dataDir=/home/chenlijun/zookeeper/data

24.

25.# the port at which the clients will connect

26.

27.clientPort=2181

28.

29.#

30.

31.# Be sure to read the maintenance section of the

32.

33.# administrator guide before turning on autopurge.

34.

35.#

36.

37.# /doc/current/zookeeperAdmin.html#sc_maintenanc

e

38.

39.#

40.

41.# The number of snapshots to retain in dataDir

42.

43.#autopurge.snapRetainCount=3

44.

45.# Purge task interval in hours

46.

47.# Set to "0" to disable auto purge feature

48.

49.#autopurge.purgeInterval=1

50.

51.

52.

53.server.0=master:2888:3888

54.

55.server.1=slave1:2888:3888

56.

57.server.2=slave2:2888:3888

这三行为配置zookeeper集群的机器(master、slave1、slave2)分别用server.0和server.1、server.2标识,2888和3888为端口号(zookeeper集群包含一个leader(领导)和多个fllower(随从),启动zookeeper集群时会随机分配端口号,分配的端口号为2888的为leader,端口号为3888的是fllower)

6.创建文件夹mkdir /home/chenlijun/zookeeper/data

7.在data目录下,创建文件myid,值为0 (0用来标识master这台机器的zookeeper )

到此为止 master上的配置就已经完成;接下来配置slave1和slave2.

8.把zookeeper目录复制到slave1和slave2中

scp –r /home/chenlijun/zookeeper chenlijun@slave1:/home/chenlijun/

scp –r /home/chenlijun/zookeeper chenlijun@slave2:/home/chenlijun/

9.把修改后的etc/profile文件复制到slave1和slave2中

(复制完后记得在slave1和slave2中执行命令source /etc/profile)

10.把slave1中相应的myid中的值改为1,slave2中相应的myid中的值改为2

11.启动,在三个节点上分别执行命令zkServer.sh start

12.检验,在三个节点上分别执行命令zkServer.sh status

bin/zkCli.sh 进入shell。