第二讲决策树方法

- 格式:pptx

- 大小:834.78 KB

- 文档页数:18

管理学决策树方法一、决策树方法的基本概念。

1.1 啥是决策树呢?简单来说,这就像是咱们在森林里找路一样。

决策树是一种树形结构,它有一个根节点,就像大树的根,从这个根节点开始,会分出好多枝干,这些枝干就是不同的决策选项。

比如说,一个企业要决定是否推出一款新产品,这就是根节点的决策。

1.2 然后每个枝干又会根据不同的情况继续分叉。

就好比这新产品推向市场,可能会遇到市场反应好和市场反应不好这两种大的情况,这就像是枝干又分叉了。

这每一个分叉点都代表着一个事件或者决策的不同结果。

二、决策树方法在管理学中的重要性。

2.1 在管理里啊,决策树可太有用了。

就像那句老话说的“三思而后行”,决策树就是帮咱们管理者好好思考的工具。

它能把复杂的决策过程清晰地展现出来。

比如说,一个公司要扩大业务,是选择开拓新市场呢,还是在现有市场深耕呢?这时候决策树就能列出各种可能的结果。

如果开拓新市场,可能会面临新的竞争对手,就像进入了一片未知的丛林,充满了风险;如果在现有市场深耕,可能会面临市场饱和的问题,就像在一块已经耕种很久的土地上,肥力可能不足了。

2.2 决策树还能让咱们量化风险。

咱们不能总是靠感觉来做决策啊,那可就成了“盲人摸象”了。

通过决策树,我们可以给不同的结果赋予概率,就像给每个岔路标上成功或者失败的可能性。

这样管理者就能清楚地看到每个决策背后的风险和收益。

比如说,一个项目有60%的成功概率,但是成功后的收益很大;另一个项目有80%的成功概率,但是收益比较小。

这时候决策树就能帮我们权衡利弊。

2.3 而且啊,决策树有助于团队沟通。

大家都能看着这个树形结构,一目了然。

就像大家一起看一张地图一样,都清楚要往哪里走。

团队成员可以针对决策树上的每个节点、每个分支进行讨论。

这样就不会出现“各说各话”的情况,大家都在同一个框架下思考问题。

三、如何构建决策树。

3.1 首先要确定决策的目标。

这就像确定大树的根一样重要。

比如说,我们的目标是提高公司的利润,那所有的决策分支都要围绕这个目标来展开。

决策树的算法一、什么是决策树算法?决策树算法是一种基于树形结构的分类和回归方法,其本质是将训练数据集分成若干个小的子集,每个子集对应一个决策树节点。

在决策树的生成过程中,通过选择最优特征对数据进行划分,使得各个子集内部的样本尽可能属于同一类别或者拥有相似的属性。

在预测时,将待分类样本从根节点开始逐层向下遍历,直到到达叶节点并输出该节点所代表的类别。

二、决策树算法的基本流程1. 特征选择特征选择是指从训练数据集中选取一个最优特征用来进行划分。

通常情况下,选择最优特征需要考虑两个因素:信息增益和信息增益比。

2. 决策树生成通过递归地构建决策树来实现对训练数据集的分类。

具体实现方式为:采用信息增益或信息增益比作为特征选择标准,在当前节点上选择一个最优特征进行划分,并将节点分裂成若干个子节点。

然后对每个子节点递归调用上述过程,直到所有子节点都为叶节点为止。

3. 决策树剪枝决策树剪枝是指通过去掉一些无用的分支来降低决策树的复杂度,从而提高分类精度。

具体实现方式为:先在训练集上生成一棵完整的决策树,然后自底向上地对内部节点进行考察,若将该节点所代表的子树替换成一个叶节点能够提高泛化性能,则将该子树替换成一个叶节点。

三、常见的决策树算法1. ID3算法ID3算法是一种基于信息熵的特征选择方法。

其核心思想是在每个节点上选择信息增益最大的特征进行划分。

由于ID3算法偏向于具有较多取值的特征,因此在实际应用中存在一定局限性。

2. C4.5算法C4.5算法是ID3算法的改进版,采用信息增益比作为特征选择标准。

相比于ID3算法,C4.5算法可以处理具有连续属性和缺失值的数据,并且生成的决策树更加简洁。

3. CART算法CART(Classification And Regression Tree)算法既可以用来进行分类,也可以用来进行回归分析。

其核心思想是采用基尼指数作为特征选择标准,在每个节点上选择基尼指数最小的特征进行划分。

人教版高中选修4-9第二讲决策树方法课程设计一、课程简介在人工智能领域中,决策树方法被广泛应用于分类和回归问题。

本课程将介绍决策树的基本概念、构建方法和性质,探讨如何通过决策树实现有效的数据分类和预测。

具体来说,本课程将分以下几个方面内容:1.决策树与分类问题2.决策树的构建方法3.决策树的剪枝技术4.决策树在数据分类和预测中的应用本课程适合高中选修4-9学生学习,也适合人工智能初学者入门学习。

二、教学设计1. 教学目标本课程的教学目标如下:1.了解决策树的基本概念和构建方法;2.掌握决策树分类和预测的基本原理;3.学会使用Python实现决策树分类算法;4.了解决策树剪枝技术的基本原理和效果。

2. 教学内容和方法决策树与分类问题•决策树的基本概念和应用场景•分类问题的定义和示例•分类准确率、召回率和F1值的定义和计算方法教学方法:讲授+案例讲解决策树的构建方法•ID3算法的原理和实现•C4.5算法的原理和实现•CART算法的原理和实现教学方法:讲授+实践决策树的剪枝技术•预剪枝和后剪枝的定义和原理•剪枝方法的实现和效果比较教学方法:案例分析+讨论决策树在数据分类和预测中的应用•决策树分类算法的实现•决策树预测算法的实现•决策树分类算法在鸢尾花数据集上的应用教学方法:实践+案例讲解3. 教学流程本课程的教学流程如下:•理论讲解:介绍决策树的基本概念和构建方法,以及分类问题的定义和示例;•实践操作:使用Python实现ID3算法、C4.5算法和CART 算法,并进行实验比较;•案例讲解:讲解决策树在鸢尾花数据集上的分类问题,并介绍分类准确率、召回率和F1值的计算方法;•讨论剪枝技术:介绍决策树的预剪枝和后剪枝技术,并讨论其优缺点和应用效果;•实践操作:使用剪枝技术优化决策树模型,并比较不同剪枝方法的性能。

三、教学评估本课程的教学评估包括以下几个方面:1.理论笔试:考查学生对决策树基本概念和构建方法的掌握程度;2.实验操作:考查学生使用Python实现决策树分类和预测算法的实际能力;3.案例分析:考查学生在实际问题中使用决策树算法的能力;4.讨论小组:考查学生对决策树剪枝技术的理解和应用能力。

简述决策树方法的具体步骤。

决策树是一种常用的机器学习算法,其可以通过对数据集的特征进行划分来进行分类或预测。

决策树方法的具体步骤如下:1. 数据准备:收集需要进行分类或预测的数据,并进行数据清洗和预处理。

这包括数据的去重、缺失值处理、异常值处理等。

2. 特征选择:从数据集中选择最佳的特征作为决策树的根节点。

常用的特征选择方法有信息增益、信息增益比、基尼指数等。

3. 划分数据集:根据选择的特征,将数据集划分为多个子集。

每个子集都包含了特征取值相同的样本。

这一步骤会将数据集分为多个分支。

4. 递归构建决策树:对每个子集重复上述步骤,选择最佳的特征作为该子集的根节点,并将该子集划分为更小的子集。

这一过程会不断递归进行,直到满足停止条件为止。

5. 停止条件:构建决策树的过程中,需要设定一些停止条件,以防止过拟合。

常用的停止条件有:决策树的深度达到预定值、节点中的样本数小于阈值、节点中样本的类别完全相同等。

6. 剪枝:决策树的构建可能会过度拟合训练数据,导致泛化能力较弱。

为了解决这个问题,可以对决策树进行剪枝。

剪枝可以分为预剪枝和后剪枝两种方法。

预剪枝是在构建决策树时,在每次划分节点前进行估计,若划分后无显著提升,则停止划分。

后剪枝是在构建好决策树后,从底部开始,逐层向上对非叶节点进行剪枝操作。

7. 决策树的评估:使用测试数据集来评估决策树的性能。

常用的评估指标有准确率、召回率、精确率、F1值等。

8. 决策树的应用:使用构建好的决策树对新样本进行分类或预测。

将新样本从决策树的根节点开始,依次根据特征的取值选择分支,直到叶节点,即可得到分类或预测结果。

决策树方法是一种直观且易于理解的机器学习算法,其构建过程简单明了,并且可以处理多分类和连续型特征。

然而,决策树也有一些局限性,如容易过拟合、对数据的小变化敏感等。

为了克服这些问题,可以使用集成学习方法如随机森林、梯度提升树等来提高决策树的性能。

决策树方法是一种常用的机器学习算法,通过对数据集的特征进行划分来进行分类或预测。

管理学用决策树法进行决策在管理学中,决策是领导者们日常工作中不可或缺的一部分。

决策的质量直接影响着组织的发展和运作。

为了帮助管理者做出更科学、更合理的决策,决策树法成为了一种常用的决策工具。

什么是决策树法决策树是一种常见的分类方法,它是一个树形结构,每个内部节点表示一个特征属性的判断,每个分支代表这个特征属性的不同输出,最后的每个叶子节点代表一个类别。

在管理学中,决策树法可以帮助管理者根据已知数据和规则,以树状图的形式呈现不同决策路径,从而帮助做出决策。

决策树的优势1.简单易懂:决策树的结构清晰,易于理解,即使对于非技术人员也很容易掌握;2.易于实现:决策树算法的实现相对简单,计算速度快,适用于大规模数据;3.可解释性强:由于决策树的结构清晰,可以清晰地展示每个决策过程,方便管理者理解决策的依据和过程。

决策树法在管理学中的应用市场营销决策在市场营销决策中,通过对客户数据的分析,可以利用决策树法来预测客户的购买行为、推荐产品等,从而指导市场营销策略的制定。

人力资源管理决策在人力资源管理中,可以使用决策树法来预测员工的绩效表现,帮助确定员工的晋升与激励计划,从而提高员工激励和绩效管理的效果。

项目管理决策在项目管理中,决策树法可以帮助管理者在项目需求变更、资源分配等方面做出合理决策,优化项目执行过程,提高项目成功率。

决策树法的应用步骤1.收集数据:根据需要,收集与决策相关的数据,并进行整理和准备;2.选择特征:根据问题要求,选择合适的特征属性作为决策树的节点,即根据何种特征进行决策;3.构建决策树:通过数据训练,构建决策树模型;4.评估模型:对构建好的决策树模型进行评估,验证模型的准确性;5.应用决策树:将决策树模型应用于实际决策中,帮助管理者做出科学决策。

总结决策树法在管理学中的应用具有重要意义,通过构建决策树模型,可以帮助管理者更好地理清问题、制定合理的决策方案。

管理者在应用决策树法时,应充分了解各个步骤的实施流程,确定适用范围,确保决策的科学性和有效性。

决策树模型算法1. 引言决策树模型是一种常用的机器学习算法,它在分类和回归问题中都能够取得很好的效果。

决策树模型基于对数据集进行划分的原理,通过构建一棵树来做出决策。

本文将详细介绍决策树模型算法的原理、构建过程以及应用场景。

2. 决策树模型原理决策树模型的原理基于信息论和熵的概念。

在决策树算法中,我们希望找到一种最优的划分方式,使得划分后的子集中目标变量的不确定性减少最快。

这个减少不确定性的度量称为信息增益,用熵来表示。

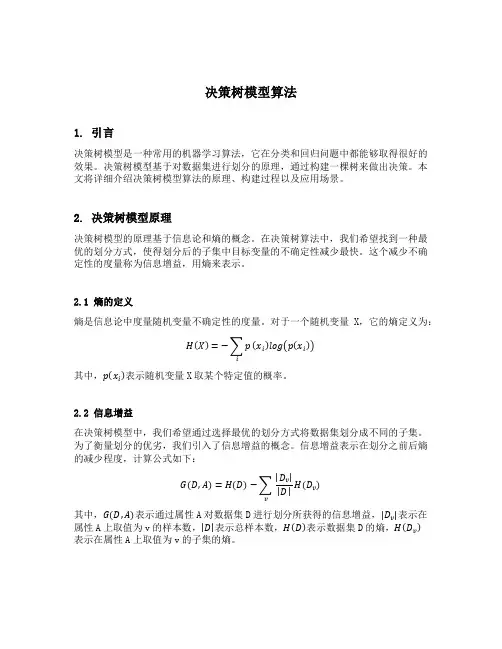

2.1 熵的定义熵是信息论中度量随机变量不确定性的度量。

对于一个随机变量X,它的熵定义为:H(X)=−∑pi(x i)log(p(x i))其中,p(x i)表示随机变量X取某个特定值的概率。

2.2 信息增益在决策树模型中,我们希望通过选择最优的划分方式将数据集划分成不同的子集。

为了衡量划分的优劣,我们引入了信息增益的概念。

信息增益表示在划分之前后熵的减少程度,计算公式如下:G(D,A)=H(D)−∑|D v| |D|vH(D v)其中,G(D,A)表示通过属性A对数据集D进行划分所获得的信息增益,|D v|表示在属性A上取值为v的样本数,|D|表示总样本数,H(D)表示数据集D的熵,H(D v)表示在属性A上取值为v的子集的熵。

2.3 构建决策树决策树的构建是一个递归的过程。

在每个节点上,我们选择使得信息增益最大的特征作为划分标准,将数据集划分成不同的子集。

然后,对于每个子集,我们继续递归地构建下一级节点,直到满足终止条件为止。

3. 决策树模型算法步骤决策树模型算法的步骤主要包括:特征选择、决策树构建和决策树剪枝。

3.1 特征选择特征选择是决策树模型算法的关键步骤。

我们需要选择最优的特征作为划分标准。

常用的特征选择方法有信息增益、增益率和基尼系数等。

3.2 决策树构建决策树的构建是一个递归的过程。

我们从根节点开始依次划分数据集,直到满足终止条件。

在每个节点上,我们选择使得信息增益最大的特征进行划分。

决策树法的基本步骤决策树法是一种基于判断树的机器学习算法,用于从一组特征中构建一个可以对实例进行分类的决策树模型。

决策树算法的基本步骤包括数据准备、选择最优特征、切分数据集、递归构建决策树,以及剪枝等。

下面将详细介绍决策树法的基本步骤。

1.数据准备2.选择最优特征决策树的构建过程中,需要选择最优的特征用来进行数据的切分。

通常采用信息增益、信息增益比、基尼指数等指标来度量特征的重要性和纯度。

选择最优特征的目标是使得每个子节点尽可能地纯净,即包含尽可能多的相同类别的实例。

3.切分数据集选择最优特征后,将数据集根据该特征的不同取值切分成多个子集。

这个过程将数据集根据特征划分为不同的分支。

每个分支对应于特征的一个取值,该分支上的数据集包含了特征取值与该分支对应的所有实例。

4.递归构建决策树对于每个子集,重复上述步骤,选择最优特征、切分数据集,直到满足终止条件。

终止条件有多种选择,包括数据集中的所有实例属于同一类别、没有更多可用的特征或者达到了预定的树深度。

5.剪枝决策树往往存在过拟合问题,为了提高决策树的泛化能力,需要对决策树进行剪枝操作。

剪枝过程有预剪枝和后剪枝两种策略。

预剪枝在树的构建过程中进行,通过设定阈值来提前停止树的生长。

后剪枝则是在树构建完成后,对树进行修剪。

通过验证集的结果来决定是否保留叶节点或者合并叶节点,以达到降低过拟合风险的目的。

6.使用决策树进行分类构建完决策树后,可以用其进行分类预测。

给定一个新的实例,从根节点开始,根据实例的特征值通过决策条件逐步向下遍历决策树,直到达到叶节点。

叶节点对应于该实例的类别,将实例分到相应的类别中。

7.决策树的评估与调优使用测试数据集对决策树进行评估,计算准确率、召回率、F1值等性能指标。

根据评估结果,可以对决策树进行调优,如调整剪枝阈值、改变特征选择方式、调整算法参数等。

总结:决策树算法的基本步骤包括数据准备、选择最优特征、切分数据集、递归构建决策树,以及剪枝等。

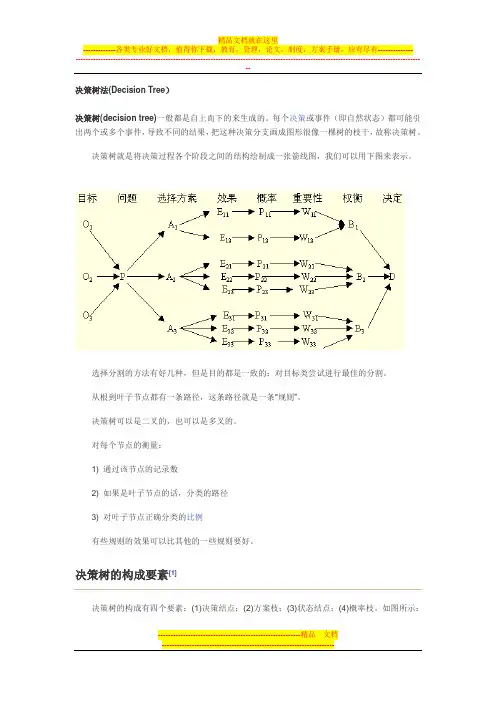

决策树法(Decision Tree)决策树(decision tree)一般都是自上而下的来生成的。

每个决策或事件(即自然状态)都可能引出两个或多个事件,导致不同的结果,把这种决策分支画成图形很像一棵树的枝干,故称决策树。

决策树就是将决策过程各个阶段之间的结构绘制成一张箭线图,我们可以用下图来表示。

选择分割的方法有好几种,但是目的都是一致的:对目标类尝试进行最佳的分割。

从根到叶子节点都有一条路径,这条路径就是一条“规则”。

决策树可以是二叉的,也可以是多叉的。

对每个节点的衡量:1) 通过该节点的记录数2) 如果是叶子节点的话,分类的路径3) 对叶子节点正确分类的比例有些规则的效果可以比其他的一些规则要好。

决策树的构成要素[1]决策树的构成有四个要素:(1)决策结点;(2)方案枝;(3)状态结点;(4)概率枝。

如图所示:总之,决策树一般由方块结点、圆形结点、方案枝、概率枝等组成,方块结点称为决策结点,由结点引出若干条细支,每条细支代表一个方案,称为方案枝;圆形结点称为状态结点,由状态结点引出若干条细支,表示不同的自然状态,称为概率枝。

每条概率枝代表一种自然状态。

在每条细枝上标明客观状态的内容和其出现概率。

在概率枝的最末稍标明该方案在该自然状态下所达到的结果(收益值或损失值)。

这样树形图由左向右,由简到繁展开,组成一个树状网络图。

决策树对于常规统计方法的优缺点优点:1)可以生成可以理解的规则;2)计算量相对来说不是很大;3) 可以处理连续和种类字段;4) 决策树可以清晰的显示哪些字段比较重要。

缺点:1) 对连续性的字段比较难预测;2) 对有时间顺序的数据,需要很多预处理的工作;3) 当类别太多时,错误可能就会增加的比较快;4) 一般的算法分类的时候,只是根据一个字段来分类。

决策树的适用范围[1]科学的决策是现代管理者的一项重要职责。

我们在企业管理实践中,常遇到的情景是:若干个可行性方案制订出来了,分析一下企业内、外部环境,大部分条件是己知的,但还存在一定的不确定因素。

决策树原理和简单例子决策树是一种常用的机器学习算法,它可以用于分类和回归问题。

决策树的原理是基于一系列的规则,通过对特征的判断来对样本进行分类或预测。

下面将通过原理和简单例子来介绍决策树。

1. 决策树的原理决策树的构建过程是一个递归的过程,它将样本集合按照特征的不同取值分割成不同的子集,然后对每个子集递归地构建决策树。

构建决策树的过程是通过对特征的选择来确定每个节点的划分条件,使得信息增益或信息增益比最大。

2. 决策树的构建假设有一个分类问题,样本集合包含n个样本,每个样本有m个特征。

决策树的构建过程如下:(1) 若样本集合中的样本都属于同一类别,则构建叶子节点,并将该类别作为叶子节点的类别标签。

(2) 若样本集合中的样本特征为空,或者样本特征在所有样本中取值相同,则构建叶子节点,并将该样本集合中出现次数最多的类别作为叶子节点的类别标签。

(3) 若样本集合中的样本特征不为空且有多个取值,则选择一个特征进行划分。

常用的划分方法有信息增益和信息增益比。

(4) 根据选择的特征的不同取值将样本集合划分成多个子集,对每个子集递归地构建决策树。

(5) 将选择的特征作为当前节点的判断条件,并将该节点加入决策树。

3. 决策树的例子假设有一个二分类问题,样本集合包含10个样本,每个样本有2个特征。

下面是一个简单的例子:样本集合:样本1:特征1=0,特征2=1,类别=1样本2:特征1=1,特征2=1,类别=1样本3:特征1=0,特征2=0,类别=0样本4:特征1=1,特征2=0,类别=0样本5:特征1=1,特征2=1,类别=1样本6:特征1=0,特征2=0,类别=0样本7:特征1=1,特征2=0,类别=0样本8:特征1=0,特征2=1,类别=1样本9:特征1=1,特征2=1,类别=1样本10:特征1=0,特征2=1,类别=1首先计算样本集合的信息熵,假设正样本和负样本的比例都是1:1,信息熵为1。

选择特征1进行划分,计算信息增益:对于特征1=0的样本,正样本有2个,负样本有2个,信息熵为1。

简单说明决策树原理决策树是一种基于树形结构的分类和回归模型,它通过对训练数据进行学习来建立一个树形模型,用于预测新的数据。

决策树模型具有易于理解、易于实现、可处理离散和连续数据等优点,因此在机器学习领域得到了广泛应用。

一、决策树的基本概念1. 节点:决策树中的每个圆圈都称为一个节点,分为两种类型:内部节点和叶节点。

2. 内部节点:表示对特征进行测试的节点。

每个内部节点包含一个属性测试,将输入实例分配到其子节点中。

3. 叶节点:表示分类结果或输出结果。

在叶子结点处不再进行属性测试,每个叶子结点对应着一种类别或值。

4. 分支:表示从一个内部节点指向其子节点的箭头,代表了样本在该特征上取某个值时所走的路径。

5. 根节点:表示整棵决策树的起始点,在分类问题中代表所有样本都未被分类时所走的路径。

6. 深度:从根结点到当前结点所经过分支数目。

叶子结点深度为0。

7. 路径:从根结点到叶子结点所经过的所有分支构成的序列。

8. 剪枝:对决策树进行简化的过程,目的是减少模型复杂度,提高泛化能力。

二、决策树的生成1. ID3算法ID3算法是一种基于信息熵来进行特征选择的决策树生成算法。

它通过计算每个特征对训练数据集的信息增益来选择最优特征作为当前节点的属性测试。

具体步骤如下:(1)计算数据集D的信息熵H(D)。

(2)对于每个特征A,计算其对数据集D的信息增益Gain(A),并选择信息增益最大的特征作为当前节点的属性测试。

其中,信息增益定义为:Gain(A)=H(D)-H(D|A),其中H(D|A)表示在已知特征A时,数据集D中所包含的各个类别所占比例对应的熵值。

(3)将数据集按照选定属性划分为多个子集,并递归地生成子树。

(4)直到所有样本都属于同一类别或者没有更多可用特征时停止递归。

2. C4.5算法C4.5算法是ID3算法的改进版,它在选择最优特征时使用了信息增益比来解决ID3算法中存在的偏向于选择取值较多的特征的问题。

决策树分类算法⼀、决策树原理决策树是⽤样本的属性作为结点,⽤属性的取值作为分⽀的树结构。

决策树的根结点是所有样本中信息量最⼤的属性。

树的中间结点是该结点为根的⼦树所包含的样本⼦集中信息量最⼤的属性。

决策树的叶结点是样本的类别值。

决策树是⼀种知识表⽰形式,它是对所有样本数据的⾼度概括决策树能准确地识别所有样本的类别,也能有效地识别新样本的类别。

决策树算法ID3的基本思想:⾸先找出最有判别⼒的属性,把样例分成多个⼦集,每个⼦集⼜选择最有判别⼒的属性进⾏划分,⼀直进⾏到所有⼦集仅包含同⼀类型的数据为⽌。

最后得到⼀棵决策树。

J.R.Quinlan的⼯作主要是引进了信息论中的信息增益,他将其称为信息增益(information gain),作为属性判别能⼒的度量,设计了构造决策树的递归算法。

举例⼦⽐较容易理解:对于⽓候分类问题,属性为:天⽓(A1) 取值为:晴,多云,⾬⽓温(A2) 取值为:冷,适中,热湿度(A3) 取值为:⾼,正常风 (A4) 取值为:有风,⽆风每个样例属于不同的类别,此例仅有两个类别,分别为P,N。

P类和N类的样例分别称为正例和反例。

将⼀些已知的正例和反例放在⼀起便得到训练集。

由ID3算法得出⼀棵正确分类训练集中每个样例的决策树,见下图。

决策树叶⼦为类别名,即P 或者N。

其它结点由样例的属性组成,每个属性的不同取值对应⼀分枝。

若要对⼀样例分类,从树根开始进⾏测试,按属性的取值分枝向下进⼊下层结点,对该结点进⾏测试,过程⼀直进⾏到叶结点,样例被判为属于该叶结点所标记的类别。

现⽤图来判⼀个具体例⼦,某天早晨⽓候描述为:天⽓:多云⽓温:冷湿度:正常风:⽆风它属于哪类⽓候呢?-------------从图中可判别该样例的类别为P类。

ID3就是要从表的训练集构造图这样的决策树。

实际上,能正确分类训练集的决策树不⽌⼀棵。

Quinlan的ID3算法能得出结点最少的决策树。

ID3算法:⒈对当前例⼦集合,计算各属性的信息增益;⒉选择信息增益最⼤的属性A k;⒊把在A k处取值相同的例⼦归于同⼀⼦集,A k取⼏个值就得⼏个⼦集;⒋对既含正例⼜含反例的⼦集,递归调⽤建树算法;⒌若⼦集仅含正例或反例,对应分枝标上P或N,返回调⽤处。

决策树算法决策树算法(DecisionTreeAlgorithm)是一种常用的数据挖掘和分类技术。

它把数据转换成一个树形结构显示出来,以便更加清楚的展示出数据的关联关系。

决策树算法是一种经典的分类算法,其将会把所有的数据属性进行分类,并根据预先定义的规则做出判定,最终将数据划分为多个分类,从而实现数据的分类鉴定和挖掘。

决策树算法是一种非常有效的机器学习算法,可以从数据中自动学习出一组规则,然后根据这些规则来做出决策。

这种算法可以很容易地理解和使用,也很适合与各种任务一起使用,如作为自动化分类和决策系统的一部分。

决策树算法建立在树状结构的基础上,它代表一组决策,每个决策有一定的判断标准,且标准是独一无二的,在每次判断时要根据训练数据里的不同情况来决定根据哪一个判断标准来进行分类。

决策树算法有着自己的优势,如它可以处理事先未知的概念的数据,比如如果有一个数据集包含多个相关的属性,而这些属性之间有着精确的联系,决策树可以非常容易地从一系列复杂的属性之中学习出一种分类规则,然后根据这些规则来做出分类决策。

此外,决策树算法的训练时间较短,而且可以很容易的显示出分类的过程,从而使得决策树算法具备可视化的优势,它可以轻松地展示出分类的结果。

决策树算法有着它自己特有的缺点,如它容易出现过拟合现象,这意味着在训练过程中,决策树可以一味地追求最大的正确率,而忽视掉样本外的情况,从而使得它在实际应用中会出现较大的偏差。

另外,与其他算法相比,决策树算法需要较多的存储空间,因为它的模型包含了很多的特征,而且这些特征也是依次建立的,这样就需要更多的存储来支持这种复杂的模型。

决策树算法日益受到人们的重视,它在数据挖掘和分类任务中发挥着重要的作用。

现在,已经有越来越多的的分类算法出现在市面上,但是决策树算法仍然是众多算法中的佼佼者,它可以从数据中自动学习出一组决策规则,并根据这些规则做出最终的决策,有助于实现有效的数据挖掘和分类。

决策树计算方法例题讲解决策树是一种常用的机器学习算法,用于分类和回归问题。

它通过构建一棵树形结构来进行决策,每个内部节点表示一个特征,每个叶子节点表示一个类别或一个数值。

下面我将通过一个具体的例题来详细讲解决策树的计算方法。

假设我们有一个数据集,其中包含了一些水果的特征(颜色、形状、纹理)以及对应的标签(是否为橙子)。

我们希望通过这些特征来构建一个决策树模型,能够根据水果的特征预测其是否为橙子。

首先,我们需要将数据集划分为训练集和测试集。

训练集用于构建决策树模型,测试集用于评估模型的性能。

1.特征选择在构建决策树之前,我们需要选择一个特征作为根节点。

常用的特征选择方法有信息增益、信息增益比、基尼指数等。

这里我们使用信息增益来选择特征。

信息增益衡量了在给定特征条件下,类别的不确定性减少的程度。

具体计算信息增益的步骤如下:-计算整个数据集的熵(entropy):-首先,统计每个类别的样本数量。

-然后,计算每个类别的概率,并求和。

-最后,根据概率计算整个数据集的熵。

-对于每个特征,计算其对应的信息增益:-首先,针对该特征的每个取值,将数据集划分为不同的子集。

-然后,计算每个子集的熵和权重,并求和。

-最后,用整个数据集的熵减去子集的熵和权重的乘积,得到信息增益。

选择具有最大信息增益的特征作为根节点。

2.构建决策树选择完根节点后,我们需要递归地构建决策树。

具体步骤如下:-对于每个内部节点,选择一个最佳的特征作为其子节点。

-将数据集根据该特征的不同取值划分为多个子集。

-对于每个子集,如果所有样本都属于同一类别,则将该子集设为叶子节点,并标记为该类别。

-否则,继续递归地构建决策树,直到满足停止条件(如达到预定深度或无法继续划分)。

3.决策树的剪枝构建完决策树后,我们需要进行剪枝操作,以避免过拟合现象。

剪枝可以通过预剪枝和后剪枝来实现。

-预剪枝:在构建决策树的过程中,在划分子集之前,先进行验证集的测试,如果测试结果不好,则停止划分,将当前节点设为叶子节点。

决策树分类方法决策树是一种常见的用于分类和回归问题的机器学习方法。

它通过构建树形结构的规则来进行预测。

本文将详细介绍决策树分类方法的原理、算法以及相关应用。

一、决策树分类方法的原理决策树分类方法遵循以下原理:1. 特征选择:通过度量特征的信息增益或信息增益比来选择最优的划分特征。

信息增益是指通过划分数据集获得的纯度提升,信息增益比则是对信息增益进行修正,避免倾向于选择取值较多的特征。

2. 决策节点:根据选择的特征创建决策节点,并将样本集划分到不同的子节点中。

3. 叶节点:当将样本划分到同一类别或达到预定的划分次数时,创建叶节点并标记为对应的类别。

4. 剪枝:为了避免过拟合,可以通过剪枝操作来简化生成的决策树。

二、决策树分类方法的算法常见的决策树分类算法包括ID3算法、C4.5算法以及CART算法。

1. ID3算法:通过计算每个特征的信息增益选择划分特征,将样本划分到信息增益最大的子节点中。

此算法对取值较多的特征有所偏好。

2. C4.5算法:在ID3算法的基础上进行改进,引入了信息增益比的概念,解决了ID3算法对取值较多的特征的偏好问题。

3. CART算法:通过计算基尼指数选择划分特征,将样本划分到基尼指数最小的子节点中。

此算法适用于分类和回归问题。

三、决策树分类方法的应用决策树分类方法广泛应用于各个领域,以下是几个常见的应用场景:1. 信用评估:通过构建决策树模型,根据客户的个人信息和历史数据预测其信用等级,用于信贷风险评估和贷款审批。

2. 疾病诊断:通过决策树模型,根据患者的病症和医学检测结果预测其患有何种疾病,用于辅助医生的诊断决策。

3. 电商推荐:通过决策树模型,根据用户的历史购买记录和个人喜好预测其对某些商品的偏好程度,从而进行个性化商品推荐。

4. 欺诈检测:通过构建决策树模型,根据用户的账户行为和交易记录预测其是否存在欺诈行为,用于金融等领域的欺诈检测。

四、决策树分类方法的优缺点决策树分类方法具有以下优点:1. 易于理解和解释:决策树模型的结果具有很好的可解释性,可以通过树形结构直观地看出预测结果的原因。

决策树公式和原理宝子,今天咱来唠唠决策树这个超酷的东西。

决策树呢,就像是一棵倒着长的树,不过这棵树可神奇啦。

它有根节点、分支和叶节点。

根节点就是最开始的那个点,就像树的根一样,所有的决策都是从这儿开始发芽的呢。

比如说你在纠结今天是出去逛街还是在家看剧,这纠结的开始就是根节点啦。

那分支是啥呢?分支就像是从根节点伸出去的小树枝。

还是拿刚刚的例子说,如果你选择出去逛街,那关于去哪儿逛街,是去商场还是去小商业街,这不同的选择就像是不同的分支。

每个分支都代表着一种可能的决策方向。

叶节点就是这些树枝的尽头啦。

比如说你最后决定去商场逛街,然后在商场里选择了一家店,买了一件超好看的衣服,这个买衣服的结果就是一个叶节点。

它的原理其实就像是我们平时做决策的思路。

我们在生活中做决定的时候,也是一个一个问题去想的。

决策树就是把这个过程给整理得清清楚楚。

从数学公式的角度看,决策树主要是通过计算信息增益或者基尼指数这些东西来确定怎么分支的。

听起来有点复杂,咱简单说。

信息增益就像是在看哪个分支能够让我们对结果了解得更多。

比如说你有一堆水果,有苹果、香蕉和橙子。

你想把它们分类,那你可能会先看颜色这个属性,因为按照颜色来分,能让你更快地把这些水果分开,这个颜色属性就有比较大的信息增益。

基尼指数呢,也是类似的作用。

它是用来衡量一个节点里的数据有多“纯”。

如果一个节点里的数据都是一样的,那基尼指数就很小,就说明这个节点很“纯”啦。

就像一盒子里都是苹果,没有其他水果,那这个盒子里的数据就很“纯”。

决策树在好多地方都能用呢。

就像在预测天气的时候,如果我们要决定今天出门要不要带伞。

根节点可能就是看天气预报怎么说。

如果天气预报说可能有雨,那一个分支就是带伞出门,另一个分支就是不带伞赌一把。

然后再根据其他的因素,像是天空的云量啊,风的方向啊,继续分更多的分支。

最后得出一个比较靠谱的决策。

还有在商业里也很有用。

比如说一个公司要决定要不要推出一款新产品。

决策树的工作原理决策树是一种常见的机器学习算法,它可以用于分类和回归问题。

它的工作原理是基于对数据特征进行分析和判断,然后生成一棵树状结构,用于预测未知数据的分类或数值。

决策树算法可以很好地解释和理解,因此在实际应用中得到了广泛的应用。

下面将详细介绍决策树的工作原理,包括如何构建决策树、如何进行分类和回归预测以及决策树的优缺点等方面。

一、决策树的构建原理1. 特征选择在构建决策树之前,首先需要选择最优的特征来进行划分。

特征选择的目标是通过选择对分类结果有最好分离作用的特征,从而使得决策树的分支更具有代表性。

在特征选择中通常会使用信息增益(ID3算法)、增益率(C4.5算法)、基尼指数(CART算法)等指标来评估特征的重要性。

2. 决策树的构建决策树的构建是通过递归地对数据集进行分裂,直到满足某种停止条件。

在每次分裂时,选择最优的特征来进行分裂,并创建相应的分支节点。

这样逐步生成一棵树,直到所有样本都被正确分类或者子节点中的样本数小于设定的阈值。

3. 剪枝处理决策树的构建可能会导致过拟合问题,为了避免过拟合,通常需要对构建好的决策树进行剪枝处理。

剪枝是通过压缩决策树的规模和深度,去除对整体分类准确性贡献不大的部分,从而提高决策树的泛化能力。

二、决策树的分类预测原理1. 决策树的分类过程在已构建好的决策树上,对未知样本进行分类预测时,从根节点开始,逐层根据特征的取值向下遍历树,直到达到叶子节点。

叶子节点的类别即为决策树对该样本的分类预测结果。

2. 决策树的优势决策树算法具有很高的可解释性,可以清晰直观地展现数据的特征和分类过程,易于理解。

决策树对特征的缺失值和异常值具有较好的鲁棒性,对数据的处理要求相对较低。

三、决策树的回归预测原理决策树不仅可以用于分类问题,也可以用于回归问题。

在回归问题中,决策树用于预测连续型的数值输出。

决策树的回归预测过程也是通过递归地在特征空间中进行划分,每次划分选择对预测结果具有最大程度分离作用的特征。