Kettle公司培训手册范本

- 格式:doc

- 大小:647.00 KB

- 文档页数:20

Kettle用户操作手册1.kettle介绍1.1 什么是kettleKettle是“Kettle E.T.T.L. Envirnonment”只取首字母的缩写,这意味着它被设计用来帮助你实现你的ETTL 需要:抽取、转换、装入和加载数据;它的名字起源正如该项目的主程序员MATT所说:希望把各种数据放到一个壶里然后以一种指定的格式流出。

Spoon是一个图形用户界面,它允许你运行转换或者任务。

1.2 Kettle 的安装要运行此工具你必须安装 Sun 公司的JAVA 运行环境1.4 或者更高版本,相关资源你可以到网络上搜索JDK 进行下载,Kettle 的下载可以到/取得最新版本。

1.3运行SPOON下面是在不同的平台上运行Spoon 所支持的脚本:Spoon.bat: 在windows 平台运行Spoon。

Spoon.sh: 在Linux、Apple OSX、Solaris 平台运行Spoon。

1.4 资源库一个Kettle资源库可以包含那些转换信息,这意味着为了从数据库资源中加载一个转换就必须连接相应的资源库。

在启动SPOON的时候,可以在资源库中定义一个数据库连接,利用启动spoon时弹出的资源库对话框来定义,如图所示:单击加号便可新增;关于资源库的信息存储在文件“reposityries.xml”中,它位于你的缺省home 目录的隐藏目录“.kettle”中。

如果是windows 系统,这个路径就是c:\Documents andSettings\<username>\.kettle。

如果你不想每次在Spoon 启动的时候都显示这个对话框,你可以在“编辑/选项”菜单下面禁用它。

admin 用户的缺省密码也是admin。

如果你创建了资源库,你可以在“资源库/编辑用户”菜单下面修改缺省密码。

1.5 定义1.5.1 转换主要用来完成数据的转换处理。

转换步骤,可以理解为将一个或者多个不同的数据源组装成一条数据流水线。

kettle使用手册Kettle使用手册一、Kettle简介1.1 Kettle概述Kettle(也被称为Pentaho Data Integration)是一款开源的ETL(Extract, Transform, Load)工具,它能够从各种数据源中提取数据,并进行各种转换和加工,最后将数据加载到指定的目的地中。

Kettle具有强大的数据处理功能和友好的图形化界面,使得数据集成和转换变得简单而高效。

1.2 功能特点- 数据抽取:从多种数据源中提取数据,包括关系型数据库、文件、Web服务等。

- 数据转换:支持多种数据转换操作,如字段映射、类型转换、数据清洗等。

- 数据加载:将转换后的数据加载到不同的目的地,如数据库表、文件、Web服务等。

- 调度管理:支持定时调度和监控,可自动执行数据集成任务。

二、安装与配置2.1 系统要求在安装Kettle之前,请确保满足以下系统要求: - 操作系统:Windows、Linux、Unix等。

- Java版本:JDK 1.8及以上。

- 内存:建议至少4GB的可用内存。

2.2 安装Kettle最新版本的Kettle安装包,并按照安装向导进行安装。

根据系统要求和个人需求进行相应的配置选项,完成安装过程。

2.3 配置Kettle在安装完成后,需要进行一些配置以确保Kettle正常运行。

具体配置步骤如下:- 打开Kettle安装目录下的kettle.properties文件。

- 根据实际需要修改配置项,如数据库连接、日志路径、内存分配等。

- 保存修改并重启Kettle。

三、Kettle基础操作3.1 数据抽取3.1.1 创建数据源连接打开Kettle,左上角的“新建连接”按钮,在弹出的窗口中选择待抽取的数据源类型(如MySQL、Oracle等),填写相关参数并测试连接。

3.1.2 设计数据抽取作业- 打开Kettle中的“转换”视图。

- 从左侧的工具栏中选择适当的输入组件(如“表输入”或“文件输入”),将其拖拽到设计区域中。

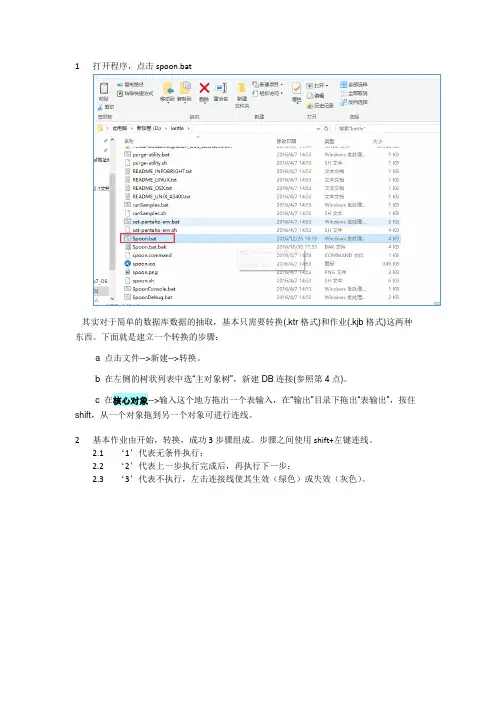

1打开程序,点击spoon.bat其实对于简单的数据库数据的抽取,基本只需要转换(.ktr格式)和作业(.kjb格式)这两种东西。

下面就是建立一个转换的步骤:a 点击文件-->新建-->转换。

b 在左侧的树状列表中选“主对象树”,新建DB连接(参照第4点)。

c 在核心对象-->输入这个地方拖出一个表输入,在“输出”目录下拖出“表输出”,按住shift,从一个对象拖到另一个对象可进行连线。

2基本作业由开始,转换,成功3步骤组成。

步骤之间使用shift+左键连线。

2.1‘1’代表无条件执行;2.2‘2’代表上一步执行完成后,再执行下一步;2.3‘3’代表不执行,左击连接线使其生效(绿色)或失效(灰色)。

3打开具体步骤中的转换流程,点击‘Transformation’跳转至相应具体转换流程,编辑此转换具体路径,双击转换,弹出窗口,‘1’为相对路径,点击‘2’选择具体Visit.ktr转换,为绝对路径。

4建立数据库连接,输入相应信息测试,成功即可图45转换具体设置,如图4,‘表输出’至‘文本文件输出’流程跳接线为错误处理步骤,当输出格式不能满足表输出的目的表结构类型时,将会将记录输出到‘文本文件输出’中的记录中。

5.1双击‘表输入’,输入相应的SSQL语句,选择配置数据库连接,或新增,预览查询生成的结果(如果数据库配置中使用变量获取,此处预览生成错误)。

5.2双击‘表输出’,选择数据库连接,‘浏览’选择相应目标表,(此处‘使用批量插入’勾选去除,目的是在错误处理步骤中无法使用批量处理,可能是插件兼容问题)6表输出插件定义a) Target Schema:目标模式。

要写数据的表的Schema的名称。

允许表明中包含“。

”对数据源来说是很重要的b) 目标表:要写数据的表名。

c) 提交记录数量:在数据表中用事物插入行。

如果n比0大,每n行提交一次连接。

否则不使用事务,速度会慢一些。

d) 裁剪表:在第一行数据插入之前裁剪表。

Kettle 培训手册一、Etl 介绍ETL(Extract-Transform-Load的缩写,即数据抽取、转换、装载的过程),对于金融IT 来说,经常会遇到大数据量的处理,转换,迁移,所以了解并掌握一种etl工具的使用,必不可少。

Kettle是一款国外开源的etl工具,纯java编写,绿色无需安装,数据抽取高效稳定。

Kettle中有两种脚本文件,transformation和job,transformation完成针对数据的基础转换,job则完成整个工作流的控制。

二、kettle 部署运行将kettle2.5.1文件夹拷贝到本地路径,例如D 盘根目录。

双击运行kettle文件夹下的spoon.bat文件,出现kettle欢迎界面:稍等几秒选择没有资源库,打开kettle主界面创建transformation,job点击页面左上角的创建一个新的transformation,点击保存到本地路径,例如保存到D:/etltest下,保存文件名为EtltestTrans,kettle默认transformation 文件保存后后缀名为ktr点击页面左上角的创建一个新的job,点击保存到本地路径,例如保存到D:/etltest下,保存文件名为EtltestJob,kettle默认job文件保存后后缀名为kjb 创建数据库连接在transformation页面下,点击左边的【Main Tree】,双击【DB连接】,进行数据库连接配置。

connection name自命名连接名称Connection type选择需要连接的数据库Method of access选择连接类型Server host name写入数据库服务器的ip地址Database name写入数据库名Port number写入端口号Username写入用户名Password写入密码例如如下配置:点击【test】,如果出现如下提示则说明配置成功点击关闭,再点击确定保存数据库连接。

一、【kettle】window安装与配置1、下载kettle包,并解压2、安装jdk,并配置java环境a).打开我的电脑--属性--高级--环境变量b).新建系统变量JA V A_HOME和CLASSPATH变量名:JA V A_HOME变量值:C:\Program Files\Java\jdk1.7.0[具体路径以自己本机安装目录为准]变量名:CLASSPATH变量值:.;%JA V A_HOME%\lib\dt.jar;%JA V A_HOME%\lib\tools.jar;c). 选择“系统变量”中变量名为“Path”的环境变量,双击该变量,把JDK安装路径中bin目录的绝对路径,添加到Path变量的值中,并使用半角的分号和已有的路径进行分隔。

变量名:Path变量值:%JA V A_HOME%\bin;%JA V A_HOME%\jre\bin;3、配置kettle环境在系统的环境变量中添加KETTLE_HOME变量,目录指向kettle的安装目录:D:\kettle\data-integration4、启动spoonWindows直接双击批处理文件Spoon.bat具体路径为:kettle\data-integration\Spoon.batLinux 则是执行spoon.sh,具体路径为:~/kettle/data-integration/spoon.sh二、使用Kettle同步数据同步数据常见的应用场景包括以下4个种类型:➢ 只增加、无更新、无删除➢ 只更新、无增加、无删除➢ 增加+更新、无删除➢ 增加+更新+删除只增加、无更新、无删除对于这种只增加数据的情况,可细分为以下2种类型:1) 基表存在更新字段。

通过获取目标表上最大的更新时间或最大ID,在“表输入”步骤中加入条件限制只读取新增的数据。

2) 基表不存在更新字段。

通过“插入/更新”步骤进行插入。

插入/更新步骤选项:只更新、无增加、无删除通过“更新”步骤进行更新。

Kettle简介:Kettle是使用Java语言开发的一个开源ETL工具(Extract--Transform--Loading),完成数据的抽取、转换、加载工作。

Kettle的意思是“水壶”,把各种各样的数据倒进水壶中,经过转换、处理,以我们所需的格式输出对我们有价值的信息。

问题:为什么要用kettle?需求:不同的数据库(同一种类型但实例不同的数据库,或者不同类型的数据库)之间、不同的数据存储形式(数据库、文本文件)之间需要协同工作,计算、处理、转换成我们需要的数据。

实际应用场景:对帐系统需要读取ATM的交易流水文件到Oracle数据库中并进行统计。

不使用kettle的情况:专门编写程序(Java或C)导入到数据库中,在Oracle中编写存储过程进行批量统计。

使用kettle的情况:通过“文本文件输入”step,指定分隔符,即可完成导入,无需编写程序;使用kettle中的各种对象可以完成统计功能,不需要编写存储过程。

两种情况对比:情况一:需要编写专门的导入程序,不具备通用性。

存储过程在不同类型的数据库中语法不同,也不具备通用性。

但不需要掌握kettle。

情况二:不需要编写专门的导入程序,不同的文件格式只需要修改“文本文件输入”step中的对应参数即可。

不需要针对不同的数据库编写不同版本的存储过程,只需要使用标准SQL 就可以具备通用性。

需要掌握kettle。

好处:跨数据库、跨平台,减少我们的工作量。

Kettle中有两种类型的对象,分别对应两种类型的文件。

一种是Transformation(以后简称Trans),即转换;一种是Job,即工作。

Trans完成具体的任务,Job用于控制转换之间的执行顺序。

第一部分:与数据库打交道1创建数据库连接<1>新建一个Transformation,在“DB连接”下创建一个“数据库连接”,如下图所示:<2>如果创建kettle不支持的数据库的连接,ConnectionType选择Generic database。

1.1数据抽取1.1.1表输入1.1.1.1功能描述通过sql语句或者界面选择的方式从数据库中抽取需要的数据。

数据库基本上包括了所有通用数据库,如sqlserver,mysql,oracle等。

1.1.1.2操作步骤及图解双击表输入界面如下图。

图11101单击‘新建’显示如下界面。

图11102输入数据库连接配置参数,单击‘Test‘验证数据源是否配置正确,配置正确后通过‘特征列表’查询数据库特征,通过‘浏览’查询数据库表,视图等资源。

单击‘ok’后回到图11101。

单击‘获取sql查询语句’显示下图.从上图选择你需要抽取数据的表或视图,双击‘student’表后如下图。

图11104单击‘是’生成sql语句如下图。

图11105单击‘预览’显示如下图,图11106显示你抽取的数据,单击‘关闭’回到图11105。

替换SQL语句里的变量:选中,则将SQL中的变量名替换成设定的值;未选中,不替换。

如图11107有变量申明。

重要点提示:1当表输入double类型时,预览时不能获得正确的值(此时并不代表值获取异常,由于预览设置double位数导致),表输出是正常值1.1.2Excel输入1.1.2.1功能描述从Excel文件中读取数据。

1.1.2.2操作步骤及图解双击Excel输入弹出界面如下图11201图11201文件:点击浏览按钮选择excel文件,点击增加按钮文件增加到选中的文件列表。

从前面的步骤获取文件名:当有数据流连接当前Excel输入时,选中,则可以选择文件。

图11202工作表,见上图11202:点击获取工作表名称会弹出框,将可用选项选到你的选择,点击确认即可。

如图11203图11203图11204内容,见上图11204:头部:检查工作表是否指定了一个头部行,该项基本要选择。

非空记录:检查是否不需要空行输出。

停在空记录:当遇空行时停止读取。

限制:0则表示内容大小无限制图11205字段,见上图11205:重要提示:类型选项要严格与Excel文件中对应字段的类型匹配,否则会报错。

史上最强Kettle培训教程一、引言Kettle是一款开源的ETL工具,具有简单易用、功能强大、扩展性强等特点。

本教程旨在帮助读者全面了解Kettle的基础知识、高级应用以及最佳实践,从而掌握这款强大的ETL工具。

二、Kettle简介1.1Kettle概述Kettle是一款基于Java开发的ETL工具,主要用于数据抽取、转换和加载。

它由Pentaho公司开发,并在2006年开源。

Kettle支持多种数据源,如关系型数据库、文本文件、Excel文件等,并且提供了丰富的转换组件,可以满足各种复杂的数据处理需求。

1.2Kettle主要组件Kettle主要包括两个组件:Spoon和Pan。

Spoon是Kettle的图形界面设计工具,用于创建和编辑ETL转换;Pan是Kettle的命令行执行工具,用于执行Spoon中创建的转换。

三、Kettle基础教程2.1环境搭建2.2Spoon界面介绍启动Spoon,看到的是欢迎界面。

“新建”按钮,创建一个转换或作业。

在转换编辑界面,左侧为组件面板,右侧为画布。

在画布上,我们可以通过拖拽组件来创建ETL流程。

2.3创建转换在本节中,我们将学习如何创建一个简单的ETL转换。

从组件面板中拖拽一个“表输入”组件到画布上,双击该组件,设置数据库连接和SQL查询。

然后,拖拽一个“表输出”组件到画布上,双击该组件,设置目标数据库连接和表名。

将“表输入”和“表输出”组件连接起来,保存并运行转换。

2.4执行转换pan.sh-file=/path/to/your/transformation.ktr其中,`/path/to/your/transformation.ktr`为转换文件的路径。

四、Kettle高级教程3.1数据类型转换在ETL过程中,我们经常需要对数据进行类型转换。

Kettle提供了丰富的类型转换组件,如“复制记录”、“字段选择”等。

在本节中,我们将学习如何使用这些组件进行数据类型转换。

Kettle 培训手册

一、Etl 介绍

ETL(Extract-Transform-Load的缩写,即数据抽取、转换、装载的过程),对于金融IT 来说,经常会遇到大数据量的处理,转换,迁移,所以了解并掌握一种

etl工具的使用,必不可少。

Kettle是一款国外开源的etl工具,纯java编写,绿色无需安装,数据抽取高

效稳定。

Kettle中有两种脚本文件,transformation和job,transformation完成针对数据的基础转换,job则完成整个工作流的控制。

二、kettle 部署运行

将kettle2.5.1文件夹拷贝到本地路径,例如D 盘根目录。

双击运行kettle文件夹下的spoon.bat文件,出现kettle欢迎界面:

稍等几秒

选择没有资源库,打开kettle主界面

创建transformation,job

点击页面左上角的创建一个新的transformation,点击保存到本地路

径,例如保存到D:/etltest下,保存文件名为EtltestTrans,kettle默认transformation

文件保存后后缀名为ktr

点击页面左上角的创建一个新的job,点击保存到本地路径,例如保

存到D:/etltest下,保存文件名为EtltestJob,kettle默认job文件保存后后缀名为kjb

创建数据库连接

在transformation页面下,点击左边的【Main Tree】,双击【DB连接】,进行

数据库连接配置。

connection name自命名连接名称

Connection type选择需要连接的数据库

Method of access选择连接类型

Server host name写入数据库服务器的ip地址

Database name写入数据库名

Port number写入端口号

Username写入用户名

Password写入密码

例如如下配置:

点击【test】,如果出现如下提示则说明配置成功

点击关闭,再点击确定保存数据库连接。

一个简单的ktr 例子

目的:

将一个数据库导入到另一个数据库中。

操作步骤:

创建一个transformation,命名为etlTestTrans.ktr,创建数据库连接ods,点击【Input】,选中【表输入】,拖到主窗口,释放鼠标,双击打开

如下图

点击【Transform】,选中【字段选择】,拖到主窗口,释放鼠标

点击【Output】,选中【表输出】,拖到主窗口,释放鼠标

建立【文本文件输入】和【字段选择】与【字段选择】和【表输出】的连接

双击【表输出】,目标表中写入ZT_TEST_KETTLE,,确定保存

双击【字段选择】,点击获取选择的字段,再点击Edlt Mapping,点击OK 确定,编辑所有字段对应关系,点确定。

点击运行这个转换。

,则将上一个ktr中生成的文本,导入到数据库当中。

一个简单的kjb例子

目的:

将上一个transformation在一个job里面调用执行。

操作步骤:

在etlTestJob页面,点击【Core Objects】,点击【Job entries】,选中【START】拖动到主窗口释放鼠标,再选中【Transformation】,拖动到主窗口释放鼠标,

建立【START】和【Transformation】之间的连接。

双击【Transformation 】,在Transformation filename 中写入

E:\kettleWorkspace\etlTestTrans.ktr,确定保存。

点击保存创建好的job。

点击运行这个转换。

待所有任务都显示成功,则为job调用transformation运行成功。

一个增量的例子

增量更新按照数据种类的不同大概可以分成:

1. 只增加,不更新,

2. 只更新,不增加

3. 即增加也更新

4. 有删除,有增加,有更新

下面针对前三种做一个增量的ETL抽取。

过程如下:

根据前面讲解的例子一样,首先建立源表(fina_test1)和目标表(fina_test2),整个设计流程如下:

其中第一个步骤(输入-目标表)的sql 大概如下模式:

select ifnull(max(date_seal),'1900-01-01 00:00:00') from fina_test2

你会注意到第二个步骤和第一个步骤的连接是黄色的线,这是因为第二个table input(输入-源表)步骤把前面一个步骤的输出当作一个参数来用,所有Kettle用黄色的线来表示,第二个table input(输入-源表)的sql 模式大概如下:SELECT * FROM fina_test1 where date_seal>?

后面的一个问号就是表示它需要接受一个参数,你在这个table input(输入-源表)下面需要指定replace variable in script 选项和执行每一行为选中状态,这样,Kettle就会循环执行这个sql , 执行的次数为前面参数步骤传入的数据集的大小。

关于第三个步骤执行插入/更新步骤需要特别解释一下,

Kettle执行这个步骤是需要两个数据流对比,其中一个是目标数据库,你在目标表里面指定的,它放在用来查询的关键字左边的表字段里面的,另外一个数据流就是你在前一个步骤传进来的,它放在用来查询的关键字的右边,Kettle首先用你传进来的key 在数据库中查询这些记录,如果没有找到,它就插入一条记录,所有的值都跟你原来的值相同,如果根据这个key找到了这条记录,kettle会比较这两条记录,根据你指定update field 来比较,如果数据完全一样,kettle就什么都不做,如果记录不完全一样,kettle就执行一个update 步骤。

备注:主键被修改得数据认为是新记录

删除的数据由在仓库中需要保留无需考虑

然后点击新建-job,然后job的核心对象job entries拉出组建,进行执行抽取。

创建kettle资料库

资源库是用来保存转换任务的,用户通过图形界面创建的的转换任务可以保存在资源库中。

资源库可以是各种常见的数据库,用户通过用户名/密码来访问资源库中的资源,默认的用户名/密码是admin/admin

资源库并不是必须的,如果没有资源库,用户还可以把转换任务保存在 xml 文件中。

如果用户需要创建一个资源库,在资源库的登录窗口(PDI 启动时的第一个窗口)

中有【新建】按钮,点击该按钮弹出新建资源库窗口,

在该窗口中选择一个数据库连接,如果没有事先定义的数据库连接,则还要点击【新建】按钮,来创建一个数据库连接。

选择数据库连接后,要为该资源库命名,作为这个资源库的唯一标志,

最后选择【创建或更新】按钮来创建这个资源库。

资源库可以使多用户共享转换任务,转换任务在资源库中是以文件夹形式分组管理的,用户可以自定义文件夹名称。

如何使用kettle读取包含多行表的Excel文件

如果 Excel 工作表的表头只有一行,使用 Kettle 读取这样的文件是很容易的.

如果 Excel 工作表的表头是多行的, 或者是分级的就需要在容标签下正确设置列名所占

行数才可以读取.

考虑这样的一个工作表

如果想把里面的 12列数据都读出来, 就要考虑如何处理多级表头.

步骤设置的详细描述:

步骤一选择文件名,现在文件或目录里到所要添加的excel文档,然后点击,确定后,点击,

步骤二选择要读取的工作表名称和要读取的容在工作表里的起始位置, 也就是表头开始的行号和列号 (这里行号和列号是以 0 开始的)

步骤三设置要读取的容的一些属性, 这里要设置表头的所占行数是 4行.

步骤四错误处理, 选择如果有错误终止还是继续, 错误信息保存的文件等.

(图略)

步骤五选择字段, 如果前面的三个步骤(不包括错误处理步骤)都设置正确, 在这个页面选择 "获取字段" 字段按钮, 就会获得所有的列名称和数据类型.

这里我们可以看到: 多级表头中各级表头的名称被叠加起来, 形成了唯一的列名.

点击 [预览] 按钮可以预览到数据

对于表头跨连续的多行, 但不分级的情况也可以使用上述方式处理.

kettle注释:

1、kettle的控制流可以设置一些简单的时间,并且可以实现隔断天、周、月(三个只

能选一个,不能选那个月的那周那日),但是kettle工具不能关,如果关了,必须重新启动。

2、kettle里面缺少一个编辑的字段的插件,导致字段编辑很麻烦,这只能先sql中进

行手写,这个对写sql的要求很高。

一个kettle字段转换(截取)的例子

大致的流程是:

表输入还是正常的sql查询,没有添加参数。

字段转换(截取)是在进行修改。

具体样式如下:

具体的用法:

transform Functions 里面包括了字符、数字的一些函数方法,这些函数方法可以解决一些字段需要转化的问题。

Input fields和 Output fields 里面包括了从表输入进来的字段(数据)。

字段主要转化的操作界面:

注意下:substr(xxx,1,2) 中的1代表是第一位开始,2代表是取2位,在这里面还可以添加if等语句,进行编写。

在字段选择那里面要配置从js过来的字段,点击列映射(前提是已经和表输出连接上),这个字段对应要根据你实际从js倒过来的字段和目标表相对应的字段一一对应。