大规模英语语料库的英文句子检索系统

- 格式:pdf

- 大小:665.10 KB

- 文档页数:52

deepl-文档翻译DeepL是一种先进的机器翻译技术,提供高质量的翻译服务。

DeepL是由DeepL GmbH开发的一种基于人工神经网络的机器翻译系统。

它使用深度学习技术和大规模的语料库进行训练,以提供准确、流畅的翻译结果。

DeepL翻译系统能够理解上下文和句子结构,从而产生更自然、更准确的翻译。

DeepL支持多种语言对,包括英语、德语、法语、西班牙语、意大利语、荷兰语、波兰语和瑞典语等。

用户可以将文本粘贴到DeepL 网站或使用DeepL的API进行翻译。

DeepL的翻译质量被广泛认为是当前最好的机器翻译系统之一。

它能够处理复杂的句子结构和上下文,提供准确的翻译结果。

与传统的统计机器翻译系统相比,DeepL的翻译结果更自然、更流畅。

使用DeepL进行翻译非常简单。

用户只需将待翻译的文本粘贴到DeepL网站或API中,选择源语言和目标语言,然后点击翻译按钮即可获得翻译结果。

用户还可以选择将结果复制到剪贴板或下载为文本文件。

下面是一些使用DeepL翻译的例句:- 英文:I love using DeepL for translation.中文:我喜欢使用DeepL进行翻译。

- 德文:Ich habe eine Frage zu DeepL.中文:我对DeepL有一个问题。

- 法文:J'ai besoin de traduire ce texte en anglais.中文:我需要将这段文字翻译成英语。

- 西班牙文:Me gusta usar DeepL para traducir.中文:我喜欢使用DeepL进行翻译。

- 意大利文:Ho bisogno di tradurre questo testo in inglese.中文:我需要将这段文字翻译成英语。

DeepL是一种高质量的机器翻译技术,提供准确、流畅的翻译结果。

无论是个人用户还是企业用户,都可以从DeepL的翻译服务中受益。

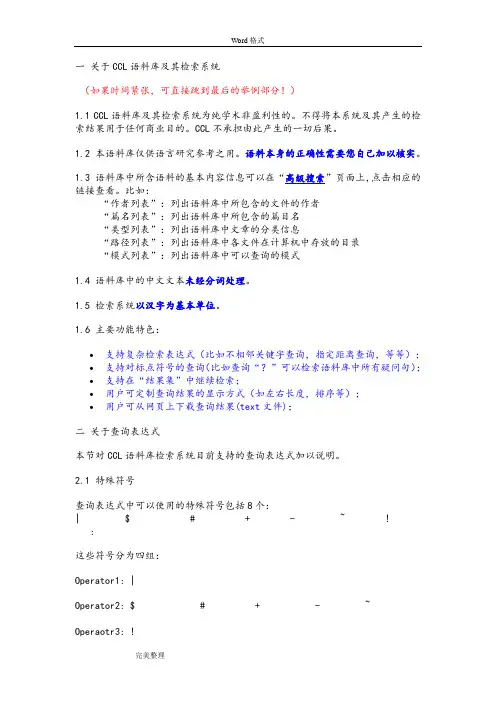

一关于CCL语料库及其检索系统(如果时间紧张,可直接跳到最后的举例部分!)1.1 CCL语料库及其检索系统为纯学术非盈利性的。

不得将本系统及其产生的检索结果用于任何商业目的。

CCL不承担由此产生的一切后果。

1.2 本语料库仅供语言研究参考之用。

语料本身的正确性需要您自己加以核实。

1.3 语料库中所含语料的基本内容信息可以在“高级搜索”页面上,点击相应的链接查看。

比如:“作者列表”:列出语料库中所包含的文件的作者“篇名列表”:列出语料库中所包含的篇目名“类型列表”:列出语料库中文章的分类信息“路径列表”:列出语料库中各文件在计算机中存放的目录“模式列表”:列出语料库中可以查询的模式1.4 语料库中的中文文本未经分词处理。

1.5 检索系统以汉字为基本单位。

1.6 主要功能特色:∙支持复杂检索表达式(比如不相邻关键字查询,指定距离查询,等等);∙支持对标点符号的查询(比如查询“?”可以检索语料库中所有疑问句);∙支持在“结果集”中继续检索;∙用户可定制查询结果的显示方式(如左右长度,排序等);∙用户可从网页上下载查询结果(text文件);二关于查询表达式本节对CCL语料库检索系统目前支持的查询表达式加以说明。

2.1 特殊符号查询表达式中可以使用的特殊符号包括8个:| $ # + - ~ !:这些符号分为四组:Operator1: |Operator2: $ # + - ~Operaotr3: !Delimiter: :符号的含义如下:(一) Operator1: Operator1是二元操作符,它的两边可以出现“基本项”(关于“基本项”的定义见2.2)(1) | 相当于逻辑中的“或”关系。

(二) Operator2:Operator2是二元操作符,它的两边可以出现“简单项”(关于“简单项”的定义见2.3)(2) $ 表示它两边的“简单项”按照左边在前、右边在后的次序出现于同一句中。

两个“简单项”之间相隔字数小于或等于Number(3) # 表示它两边的“简单项”出现于同一句中,不考虑前后次序。

常用的英语语料库English corpora, or language corpora, are collections of text samples that are used for linguistic research and analysis. These corpora serve as valuable resources for studying language patterns, trends, and usage in various contexts. In this article, we will explore some of the commonly used English language corpora and their applications.1. British National Corpus (BNC)The British National Corpus is one of the most widely used language corpora for studying contemporary British English. It contains a diverse range of texts, including spoken conversations, written documents, and academic papers. Researchers can access the BNC to examine language usage in different genres and domains, such as science, politics, and fiction. The BNC provides valuable insights into the changes in the English language over time.2. Corpus of Contemporary American English (COCA)The Corpus of Contemporary American English is a comprehensive corpus that provides a vast collection of English texts from different genres, including spoken, written, and academic. It offers researchers the opportunity to investigate various aspects of American English, including vocabulary, syntax, and discourse patterns. The COCA is frequently used in linguistic research, language teaching, and corpus-based language analysis.3. Google Books Ngram ViewerThe Google Books Ngram Viewer is a powerful tool that allows researchers to analyze the frequency of words or phrases in the vast collection of books digitized by Google. It provides a visual representation of the usage of specific terms over time, offering insights into the historical development and popularity of certain expressions. This tool is useful for investigating language change and cultural shifts through the lens of published literature.4. Corpus Linguistics Toolkit (CLAWS)The Corpus Linguistics Toolkit, also known as CLAWS, is a suite of programs specifically designed for corpus analysis. It provides researchers with tools for processing, annotating, and analyzing text corpora. CLAWS allows for the extraction of linguistic features, such as part-of-speech tags and named entities, which can be utilized for various linguistic studies. The toolkit's versatility makes it a valuable resource for researchers in the field.5. International Corpus of English (ICE)The International Corpus of English is a collection of English language corpora from different countries and regions. It aims to capture the linguistic variations within the English language across different cultures and contexts. The ICE provides researchers with valuable data for studying dialectal differences, language contact phenomena, and sociolinguistic aspects of English.6. Oxford English Corpus (OEC)The Oxford English Corpus is a corpus of contemporary English texts that serves as a reference for the analysis of language usage and trends. Itincludes a wide range of written and spoken materials from various sources, such as books, newspapers, and online platforms. The OEC is frequently used for linguistic research, lexicography, and language teaching purposes.7. Corpus Query Language (CQL)Corpus Query Language is a specialized language used to search and retrieve specific linguistic patterns within corpora. It enables researchers to formulate complex queries and retrieve relevant linguistic data for analysis. CQL is widely used in corpus linguistics and facilitates the exploration of language patterns and structures within corpora.In conclusion, English language corpora play a vital role in linguistic research and analysis. The aforementioned corpora, including the British National Corpus, Corpus of Contemporary American English, Google Books Ngram Viewer, Corpus Linguistics Toolkit, International Corpus of English, Oxford English Corpus, and Corpus Query Language, provide valuable resources for investigating language usage, trends, and patterns in various contexts. These corpora aid in the understanding of language change, societal influences, and cultural shifts, making them invaluable tools for language researchers, educators, and language enthusiasts.。

SMT分析报告一、概述SMT(Statistical Machine Translation,统计机器翻译)是一种基于统计模型的机器翻译方法。

它利用大规模的双语对照语料库,通过学习源语言和目标语言之间的统计规律,来实现自动翻译。

本文将对SMT方法进行详细分析和讨论。

二、SMT的基本原理SMT方法基于统计模型,主要分为两个阶段:训练阶段和解码阶段。

1.训练阶段:在训练阶段,SMT系统使用大规模的双语对照语料库进行训练,学习源语言和目标语言之间的翻译规律和概率模型。

常用的训练方法包括基于短语的模型和基于句子的模型。

2.解码阶段:在解码阶段,SMT系统利用训练阶段得到的翻译模型,对输入的源语言句子进行翻译。

解码过程中,系统会根据模型中的概率计算,选择最有可能的目标语言句子作为翻译结果。

常见的解码算法包括基于贪婪搜索的方法和基于束搜索的方法。

三、SMT的优点和局限性SMT方法具有以下优点和局限性。

优点:•可扩展性:SMT方法可以利用大规模的双语对照语料库进行训练,从而提高翻译的准确性和流畅性。

•灵活性:SMT方法可以根据需要进行定制和调整,适应不同领域和语种的翻译需求。

•可解释性:SMT方法基于统计模型,可以对翻译过程中的概率计算进行解释和调整。

局限性:•词序问题:SMT方法在翻译过程中容易受到词序的限制,导致翻译结果不够准确。

•语法问题:SMT方法对语法结构的处理相对较弱,容易出现语法错误。

•低频词问题:SMT方法在处理低频词时效果较差,容易导致翻译错误。

四、SMT的应用领域SMT方法在多个领域都有广泛的应用。

1.机器翻译:SMT方法最早被应用于机器翻译领域,通过学习源语言和目标语言之间的翻译规律,实现自动翻译。

2.文本摘要:SMT方法可以用于生成文本摘要,将长篇文章或文档的核心内容提取出来,生成简洁准确的摘要。

3.信息检索:SMT方法可以用于对查询语句进行翻译,将查询语句翻译为目标语言,从而实现跨语言的信息检索。

语言学常用语料库

语言学常用语料库有很多,以下是一些常用的语料库:

1. Brown语料库:美国布朗大学语言学部于1960年代编制的语料库,是英语语料库中最早的、最著名的语料库之一。

2. Penn Treebank语料库:由宾夕法尼亚大学开发的语料库,主要用于句法分析和语言学研究。

3. CoNLL语料库:共享任务(Conference on Computational Natural Language Learning)所使用的语料库,包括各种语言的语料。

4. Europarl语料库:包括欧洲议会会议的多种语言翻译版本,用于机器翻译和跨语言研究。

5. Google语料库:由Google搜索引擎收集的大规模网络文本语料库,可用于研究自然语言处理和文本挖掘等领域。

6. Corpus of Contemporary American English (COCA):包括当代美国英语的语料库,涵盖了各种不同类型的文本。

7. British National Corpus (BNC):出版物、广播和会话等来源的英国英语语料库,是英国英语的重要资源。

这些语料库提供了大量的文本数据,可用于研究不同语言的语

言学现象,如词汇使用、语法结构和语义等。

它们对于语言学研究和自然语言处理的发展起着重要作用。

英语句子语料库

英语句子语料库是用于自然语言处理和机器学习的文本数据集,其中包含大量英语句子。

以下是一些常用的英语句子语料库:

1. Brown Corpus:布朗语料库,包含一百万个单词,涵盖了多种文体和主题。

2. Penn Treebank:宾州树库,包含大量的英语句子和词性标注信息。

3. CoNLL 2003:用于命名实体识别和词性标注的语料库。

4. OntoNotes:多语言语料库,包含英语、中文、阿拉伯语等多种语言的文本和标注信息。

5. BERT Corpus:BERT模型使用的语料库,包含大量的英语句子和预训练模型。

6. OpenWebText Corpus:开源的Web文本语料库,包含大量的英语句子和网络用语。

7. Common Crawl Corpus:公共爬虫语料库,包含大量的英语句子和网页内容。

8. News Crawl Corpus:新闻爬虫语料库,包含大量的英语新闻文章和句子。

9. WikiText-103:维基百科文本语料库,包含大量的英语维基百科文章和句子。

10. BookCorpus:书籍语料库,包含大量的英语书籍和句子。

以上是一些常用的英语句子语料库,可以根据需要进行选择和使用。

这些语料库可以用于自然语言处理、机器学习、文本挖掘等领域的研究和应用。

免费的英语语料库汇总Here is a list of free English language corpora:1. British National Corpus (BNC): One of the most widely used corpora, it includes spoken and written texts from a range of genres and registers.2. Corpus of Contemporary American English (COCA): Contains over 520 million words of American English from a variety of sources, including fiction, non-fiction, newspapers, academic journals, and spoken language.3. Corpus of Historical American English (COHA): Covers American English from 1810 to 2024 and includes over 400 million words from a variety of genres.4. Corpus of Global Web-Based English (GloWbE): A web-based corpus that contains over 1.9 billion words from websites around the world. It includes texts from different countries and regions, allowing for the study of global variation in English.5. International Corpus of English (ICE): A collection of corpora representing different varieties of English, including British, American, Indian, Australian, and Hong Kong English.6. TIME Magazine Corpus: Contains articles from TIME Magazine published between 1923 and 2024. It is a useful resource for studying the use of language in news and current affairs.7. Open American National Corpus (OANC): A wide-ranging corpus that includes a variety of written and spoken texts from different sources, including newspapers, fiction, academic journals, and interviews.8. Santa Barbara Corpus of Spoken American English: A corpus of spoken American English that includes conversations between native speakers from different regions of the United States.9. EnTenTen Corpus: A web-based corpus that has over 20 billion words of English from a wide range of online sources. It is useful for studying contemporary English usage.10. BYU-BNC: A version of the British National Corpus that has been cleaned and lemmatized, making it easier to analyze.11. The Corpus of Contemporary American English under COCA: Similar to COCA, this corpus includes 560 million words of American English, allowing for detailed analysis of language use in various contexts.12. The Corpus of Contemporary American English under COCA-Spoken: Specifically focuses on spoken American English, with over 200 million words from conversations, interviews, and other spoken sources.13. The Hansard Corpus: Contains transcripts of parliamentary debates in the United Kingdom from 1803 to thepresent day. It is a valuable resource for studying political discourse and language change.14. TIMIT Corpus: A widely used speech database that contains recordings of speech from speakers of eight major American English dialects.15. The New York Times Annotated Corpus: An extensive collection of articles from The New York Times, allowing for analysis of language use in journalistic writing.。

一关于CCL语料库及其检索系统1.1 CCL语料库及其检索系统为纯学术非盈利性的。

不得将本系统及其产生的检索结果用于任何商业目的。

CCL不承担由此产生一切后果。

1.2 本语料库仅供语言研究参考之用。

语料本身的正确性需要您自己加以核实。

1.3 语料库中所含语料的基本内容信息可以在“高级搜索”页面上,点击相应的链接查看。

比如:“作者列表”:列出语料库中所包含的文件的作者“篇名列表”:列出语料库中所包含的篇目名“类型列表”:列出语料库中文章的分类信息“路径列表”:列出语料库中各文件在计算机中存放的目录“模式列表”:列出语料库中可以查询的模式1.4 语料库中的中文文本未经分词处理。

1.5 检索系统以汉字为基本单位。

1.6 主要功能特色:∙支持复杂检索表达式(比如不相邻关键字查询,指定距离查询,等等);∙支持对标点符号的查询(比如查询“?”可以检索语料库中所有疑问句);∙支持在“结果集”中继续检索;∙用户可定制查询结果的显示方式(如左右长度,排序等);∙用户可从网页上下载查询结果(text文件);二关于查询表达式本节对CCL语料库检索系统目前支持的查询表达式加以说明。

2.1 特殊符号查询表达式中可以使用的特殊符号包括8个:| $ # + -~ ! :这些符号分为四组:Operator1: |Operator2: $ # + - ~Operaotr3: !Delimiter: :符号的含义如下:(一)Operator1: Operator1是二元操作符,它的两边可以出现“基本项”(关于“基本项”的定义见2.2)(1)| 相当于逻辑中的“或”关系。

(二)Operator2:Operator2是二元操作符,它的两边可以出现“简单项”(关于“简单项”的定义见2.3)(2)$ 表示它两边的“简单项”按照左边在前、右边在后的次序出现于同一句中。

两个“简单项”之间相隔字数小于或等于Number(3)# 表示它两边的“简单项”出现于同一句中,不考虑前后次序。

语料embending语料 embending 是一种将语言转化为向量表示的技术,通过将词、句子或文档映射到一个多维空间中的向量,可以在自然语言处理任务中进行更加精确和高效的计算。

本文将介绍语料embending 的概念、应用以及一些常见的语料 embending 方法。

一、语料 embending 的概念语料 embending 是一种利用无监督学习方法,将大规模的文本语料库中的词汇或句子转化为连续的向量表示。

传统的词袋模型将单词表示为离散的符号,而语料 embending 将单词表示为连续的数值向量,这使得计算机可以更好地理解和处理语言。

语料 embending 常用于文本分类、情感分析、命名实体识别等自然语言处理任务中。

二、语料 embending 的应用1. 文本分类语料 embending 可以将文本表示为向量,使得计算机能够对文本进行分类。

通过将文本映射到向量空间中,可以使用各种机器学习算法对文本进行分类,如支持向量机、朴素贝叶斯等。

2. 句子相似度计算语料 embending 可以将句子表示为向量,从而可以计算句子之间的相似度。

通过比较句子向量的距离或夹角,可以判断句子的语义相似度,这在问答系统、搜索引擎等应用中非常有用。

3. 信息检索和推荐系统语料 embending 可以将文档表示为向量,从而可以进行快速的信息检索。

通过比较查询向量和文档向量的相似度,可以找到与查询相关的文档。

此外,语料 embending 还可以用于推荐系统,根据用户的兴趣和偏好,推荐相关的文档或商品。

三、常见的语料 embending 方法1. Word2VecWord2Vec 是一种基于神经网络的语料 embending 方法,它将每个单词表示为一个固定长度的向量。

Word2Vec 提供了两种模型:CBOW 和 Skip-gram。

CBOW(Continuous Bag of Words)模型根据上下文预测中心词,而 Skip-gram 模型则根据中心词预测上下文。

中英文常见数据库吉检索方法在当今信息爆炸的时代,数据库为我们提供了丰富的信息资源。

掌握常见的数据库检索方法,能够帮助我们更高效地获取所需信息。

本文将为您详细介绍中英文常见数据库的检索方法。

一、中文常见数据库检索方法1.中国知网(CNKI)中国知网是我国最大的学术文献数据库,主要收录了中文期刊、学位论文、会议论文等。

检索方法如下:(1)快速检索:在首页输入关键词,点击“检索”按钮。

(2)高级检索:进入高级检索页面,可设置检索范围、检索条件等。

2.万方数据万方数据包括学术期刊、学位论文、会议论文等资源。

检索方法如下:(1)简单检索:在首页输入关键词,点击“搜索”按钮。

(2)高级检索:进入高级检索页面,可设置检索条件、排序方式等。

3.维普资讯维普资讯主要收录了中文期刊、学位论文等。

检索方法如下:(1)基本检索:在首页输入关键词,点击“搜索”按钮。

(2)高级检索:进入高级检索页面,可设置检索条件、检索范围等。

二、英文常见数据库检索方法1.PubMedPubMed是生物医学领域的重要数据库,检索方法如下:(1)基本检索:在首页输入关键词,点击“Search”按钮。

(2)高级检索:点击“Advanced”进入高级检索页面,可设置检索条件、检索范围等。

2.Web of ScienceWeb of Science是涵盖多个学科领域的综合性数据库,检索方法如下:(1)基本检索:在首页输入关键词,点击“Search”按钮。

(2)高级检索:点击“Advanced Search”进入高级检索页面,可设置检索条件、检索范围等。

3.ScopusScopus是涵盖多个学科领域的综合性数据库,检索方法如下:(1)基本检索:在首页输入关键词,点击“Search”按钮。

(2)高级检索:点击“Advanced Search”进入高级检索页面,可设置检索条件、检索范围等。

总结:掌握常见数据库的检索方法,能够帮助我们快速、准确地获取所需信息。

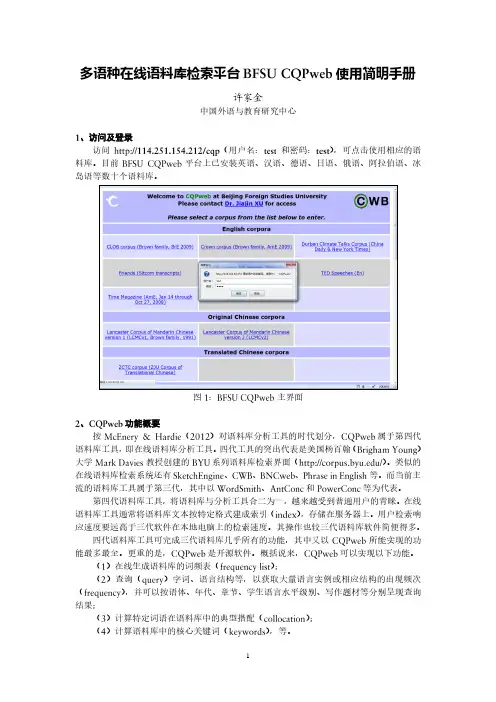

多语种在线语料库检索平台BFSU CQPweb使用简明手册许家金中国外语教育研究中心1、访问及登录访问124.193.83.252/cqp/(用户名:test和密码:test),可点击使用相应的语料库。

目前BFSU CQPweb平台上已安装英语、汉语、德语、日语、俄语、阿拉伯语、冰岛语等7个语种35个语料库。

图1:BFSU CQPweb主界面2、CQPweb功能概要按McEnery & Hardie(2012)对语料库分析工具的时代划分,CQPweb属于第四代语料库工具,即在线语料库分析工具。

四代工具的突出代表是美国杨百翰(Brigham Young)大学Mark Davies教授创建的BYU系列语料库检索界面(/)。

类似的在线语料库检索系统还有SketchEngine、CWB、BNCweb、Phrase in English等。

而当前主流的语料库工具属于第三代,其中以WordSmith、AntConc和PowerConc等为代表。

第四代语料库工具,将语料库与分析工具合二为一,越来越受到普通用户的青睐。

在线语料库工具通常将语料库文本按特定格式建成索引(index),存储在服务器上。

用户检索响应速度要远高于三代软件在本地电脑上的检索速度。

其操作也较三代语料库软件简便得多。

四代语料库工具可完成三代语料库几乎所有的功能,其中又以CQPweb所能实现的功能最多最全。

更重的是,CQPweb是开源软件。

概括说来,CQPweb可以实现以下功能。

(1)在线生成语料库的词频表(frequency list);(2)查询(query)字词、语言结构等,以获取大量语言实例或相应结构的出现频次(frequency),并可以按语体、年代、章节、学生语言水平级别、写作题材等分别呈现查询结果;(3)计算特定词语在语料库中的典型搭配(collocation);(4)计算语料库中的核心关键词(keywords),等。

3、CQPweb使用实例3.1 标准查询模式在简单查询模式(Simple query mode)下,可输入单词、短语等进行检索。

语料数据集

1. 通用语料库(Common Crawl):这是一个大规模的网页抓取数据集,包含了数十亿个网页和文档。

它可以用于训练语言模型、信息检索、机器翻译等任务。

2. 新闻语料库(Reuters Corpus):这是一个包含了数百万篇新闻文章的数据集,涵盖了多个领域和主题。

它可以用于文本分类、情感分析、信息抽取等任务。

3. 社交媒体语料库(Social Media Corpus):这是一个包含了大量社交媒体文本的数据集,例如推特、脸书等。

它可以用于情感分析、话题建模、社交网络分析等任务。

4. 学术论文语料库(Academic Paper Corpus):这是一个包含了大量学术论文的数据集,涵盖了多个学科领域。

它可以用于学术文献分析、知识图谱构建、科研趋势预测等任务。

5. 电子书语料库(Ebook Corpus):这是一个包含了大量电子书的文本数据集,可以用于自然语言处理的各种任务,例如文本分类、信息抽取、机器翻译等。

这些语料数据集都可以在互联网上找到,并可以通过一些自然语言处理工具和库进行访问和使用。

在使用这些数据集时,需要注意数据的质量、合法性和适用性,并根据具体任务进行适当的预处理和清洗。

普通人也能用的9个语料库网站,做研究、学外语的来看看提到语料库,很多人脑中浮现出这样的画面——或者这样的——但其实,语料库可以是我们做(语言)研究、学外语的好帮手。

比如,你可以在某些语料库查到最地道的英语表达,也可以听到世界各地的英语口音。

今天就为大家介绍9个语料库网站——1. 语言结构世界地图集Word Atlas of Language Structure知道阿伯卡茨语有多少元音和辅音?波罗罗语的词缀有几种形态?恰卡通戈米斯特克语有几种声调?想回答这些问题?你需要的只是登陆这个名为The World Atlas of Language Structures Online(语言结构世界地图册,简称WALS)的网站这里有各类语言分布的详细地图,有对于世界上2600多种语言192个语言学特征的详细记录,非常适合语言爱好者。

嗯,妈妈再也不用担心我被多语狂魔们实力嘲讽了,随便选出一个语言了解一下,足以技惊四座!详细的使用指南以及更多精彩内容,午餐早已备好,我不会这门语言,但我可以查到关于它的一切 | 语言学午餐2. 语言口音档案馆the Speech Accent Archive大家学英语这么多年,基本上属于身经百战了,哪个地方的英语口音没听过,什么纯正伦敦音,印度咖喱腔,苏格兰懵逼腔,布鲁克林街头腔,那是如数家珍。

但是,你听过刚果金非洲小哥的英语口语嘛?你了解玻利维亚大妈的英语口音嘛?喏,这个名为the Speech Accent Archive 的网站绝对可以满足各位英语语音控的猎奇愿望。

该数据库搜集了几百名来自世界各地,不同民族语言背景的人们针对同一段文字的录音资料,每段录音都详细记录了音频提供者的详细背景资料,每段语音也很详细的进行了转写。

对于研究者来说,可视之为研究英语使用者发音特征的独门利器;对普通人来说,则是一个了解各地英语口音的难得窗口。

3. 当代美国英语语料库COCA想知道某个单词在新闻和小说中的使用有什么差异?英文写作的时候想知道自己写出来的英语搭配够不够地道?想知道背下多少单词就可以流利阅读各类小说报纸?嗯,你需要的只是一个语料容量巨大的英语语料库,COCA恰好可以满足你的这些需求。

常见的文献检索系统有哪些在国内,经过几年的发展,全文检索从最初的字符串匹配程序已经演进到能对超大文本、语音、图像、活动影像等非结构化数据进行综合管理的大型软件。

由于内涵和外延的深刻变化,全文检索系统已成为新一代管理信息系统的代名词,目前,国内就存在多种这样的全文检索系统,其中以TRS、TRIP、TPI影响最大,普及面最广。

(1)TRS系统TRS全文检索系统是由北京易宝信息技术有限公司研制开发的。

TRS是英文Text Retrieval System(文本检索系统)的缩写,她是北京拓尔思公司的TRS注册商标,是公司的简称。

文检索系统包括检索服务器、TRS网站内容检索系统、关系数据库全文搜索引擎、中文知识管理等。

TRS站点检索系统为网站提供了信息检索功能,用户可以使用它在一个或者多个网站的站内进行搜索。

关系数据库全文搜索引擎支持Oracle、DB2、SQL、Server、Sybase和in for mix五大关系数据库,并扶持它们的多个不同的主流版本。

中文知识管理和挖掘主要是为中文文本应用提供了开发的接口。

TRS的内涵已经远远超出了全文检索的范畴,她是拓尔思公司自主研发的全文检索、搜索引擎、内容管理及知识管理核心技术和产品的统一标识。

TRS公司在信息检索、文本挖掘、搜索引擎和内容管理等领域具有长期的研发积累和丰富的成果,特别是这些研发成果的产业化已经处于国内外领先地位。

(2)TRIP系统TRIP全文数据库系统是一种面向对象的全文数据库系统,更准确的说,TRIP是一种具有非常快速查找功能的信息档案管理系统,擅长于处理那些规格不一,结构无定、类型各异、长度参差的数据。

最适用于在公网Internet上或局网Intranet上管理、检索、出版像法律法规、合同文本、技术文件、来往书信、报刊杂志、备忘录、报告、图书馆系统等任意规格的文本数据,以及照片、图像、图表等二进制数据。

TRIP 系统也同样擅长处理像日期、时间、数值(实数、虚数)、人名、地名等一般关系型数据库所擅长处理的规格化数据。

英文分词语料库

1. Penn Treebank (PTB):这是一个广泛使用的英文分词语料库,由宾夕法尼亚大学创建。

它包含了大量的文本,包括新闻、小说、论文等,并已经进行了精细的分词和词性标注。

2. British National Corpus (BNC):BNC 是一个大型的英国英语语料库,包含了各种类型的文本,如报纸、杂志、小说、论文等。

它也提供了分词和词性标注等信息。

3. Brown Corpus:这是一个早期的英文分词语料库,由布朗大学创建。

它包含了不同领域的文本,如新闻、小说、科技文献等,并已经进行了分词处理。

4. Wall Street Journal Corpus (WSJ):WSJ 是一个基于《华尔街日报》的分词语料库,包含了大量的商业、金融和经济领域的文本。

它对于处理金融和经济相关的自然语言处理任务非常有用。

5. Google Books Ngram Corpus:这是一个由谷歌创建的大型语料库,涵盖了多个语言,包括英语。

它包含了数十亿个单词,并提供了分词信息,可以用于研究词汇的使用和趋势。

这些英文分词语料库提供了丰富的文本资源和分词信息,可以用于各种自然语言处理任务,如词性标注、命名实体识别、句法分析等。

在使用这些语料库时,需要根据具体需求选择适合的语料库,并结合相关的工具和技术进行处理和分析。

哈尔滨工业大学毕业设计(论文)摘要世界上许多国家长期以来都一直在从事对机器翻译的研究,但目前机器翻译的结果很难达到人们满意的程度。

同时,基于双语语料库的句子检索系统由于语料库规模较小而受到很大限制。

在这一背景下,我们设计并实现了基于大规模英语语料库的英文句子检索系统(CESRS)。

它响应用户输入的汉语句子或短语,依次经过汉语分词转换,句子检索,相似度计算和分类排序等处理模块将与输入相匹配的英文句子返回给用户,为用户提供参考。

本文在对系统进行分析之后,对系统中各模块实现时所用的算法及数据结构进行了简要的介绍。

例如,分词模块所采用的改进最大匹配算法,句子检索模块中索引所采用的倒排表结构。

另外,本文采用基于词的计算相似度的方法,并着重介绍了词语距离的概念,编辑距离的概念以及如何引入编辑距离计算句子相似度。

在此基础上,详细介绍了动态规划算法的思想以及动态规划算法在本系统中的应用。

同时,还根据分类排序模块中数据结构的转换过程,详细地介绍了此模块所用算法的设计过程及算法执行流程。

最后,描述了对系统进行测试的方法及结果,并指出了系统的不足之处和可能的改进措施。

关键词大规模英语语料库句子检索相似度编辑距离动态规划分类排序;- -I哈尔滨工业大学毕业设计(论文)- -II AbstractMany countries in the world have been studying with Machine Translation for a long time. But the current efficiency of MT is difficult to cater to people’s need. At the same time, The Sentence Retrieval System, based on bilingual corpus, is restricted greatly because of the small size of this kind of corpus. So, we make a Chinese to English Sentence Retrieval System (CESRS) which is based on large comparable corpus. After the segment and translation module, the sentence retrieval module, the similarity measuring module and the sorting module, the system will find in corpus sentences which are the most similar to the client’s input, and provides reference to clients.After giving an analysis to CESRS, the article sketches the algorithm and the data structure which will be used in the system. Such as, the maximum matching algorithm used in segment module. The other example is the inverted data structure. In addition, the article adopts a method which is based on words to measure the similarity between two sentences. It illustrates the concept of the word distance in detail, also the concept of edit distance and how to use edit distance to measure the similarity between sentences.The article also introduces the spirit of Dynamic Programming and how to use this algorithm to measure similarity between sentences. Meanwhile, it gets use of the transparent of the data structure of the sorting module to illustrate what algorithm has been used to fulfill this module.At last, it tells a method to evaluate the system and points out some faults of the system and some means to do with these faults.Key words very large English comparable corpus, sentence retrieval,similarity, edit distance, dynamic programming, sorting ;哈尔滨工业大学毕业设计(论文)- -III 目 录摘 要...................................................................................................................I Abstract (II)第1章 绪 论 (1)1.1 课题背景 (1)1.2 机器翻译的发展和应用 (2)1.2.1 机器翻译的发展 (2)1.2.2 机器翻译的应用 (2)1.3 课题意义 (3)1.4 本章小结 (4)第2章 系统分析 (5)2.1 系统的整体描述 (5)2.2 系统的信息描述 (6)2.2.1 PAD 图元素的提取 (6)2.2.2 PAD 图的绘制 (7)2.3 系统的性能要求 (8)2.4 系统的相关研究 (8)2.4.1 语料库的建立 (8)2.4.2 句子切分方法的研究 (9)2.4.3 语料库索引表的建立 (9)2.4.4 句子相似度研究 (10)2.4.5 分类排序设计和界面设计 (10)2.5 本章小结 (10)第3章 句子相似度的研究 (11)3.1 问题的提出 (11)3.2 计算句子相似度的方法 (11)3.2.1 词语的距离 (12)3.2.2 词语的相关性 (12)3.2.3 词语相似度的计算 (13)3.3 引入编辑距离计算句子相似度 (13)3.3.1 编辑距离 (13)哈尔滨工业大学毕业设计(论文)- -IV 3.3.2 编辑距离的计算方法 (14)3.3.3 改进编辑距离算法 (15)3.4 动态规划算法在句子相似度计算中的应用 (16)3.4.1 动态规划算法 (16)3.4.2 用编辑距离计算句子相似度时动态规划算法的应用 (17)3.5 本章小结 (18)第4章 分类排序和界面的设计 (19)4.1 问题的提出 (19)4.2 分类排序的设计 (20)4.2.1 功能描述 (20)4.2.2 数据结构的描述 (20)4.2.3 程序流程的设计 (23)4.3 界面的设计 (24)4.4 本章小结 (27)第5章 系统测试与评价 (28)5.1 系统测试与数据统计 (28)5.2 系统性能分析 (29)5.3 系统的改进方案 (29)5.4 本章小结 (30)结 论 (31)致 谢 (32)参考文献 (33)附 录 (34)翻译外文资料 (37)哈尔滨工业大学毕业设计(论文)第1章绪论1.1课题背景自然语言处理是早期人工智能研究极其活跃的一个领域。

从电子计算机问世,人们就开始尝试利用计算机把一种语言翻译成另一种语言,但是由于当时主要采用逐词翻译的简单技术,仅仅利用了语言中的语法信息,因而无法达到满意的效果。

自然语言最显著的一个特点是它的歧义性,人在阅读或会话时可以根据上下文进行判断,但是计算机孤立地分析一句话是很难做出判断的。

语言信息包括语法信息、语义信息和语用信息三个层次,与此相对应,自然语言处理理论的研究也分别在这三个层次上展开。

但是由于自然语言固有的复杂性,迄今为止,自然语言处理仍然还只停留在语法信息的处理层次上。

从自然语言处理的发展史来看,无论是早期的机器翻译系统,还是后来的各种自然语言理解模型,其技术主流都是句法-语义分析,普遍依据的是人工智能中的知识表示理论和推理方法。

这就决定了在很长一段时间内,自然语言理解模型是基于规则的,而在串行的计算机上,建造一个包含大量语法规则、复杂推理机制以及庞大的知识库的自然语言处理系统,几乎是不可能的。

因此,多年来基于规则的自然语言处理系统,只能在非常有限的自然语言领域中获得一定程度成功。

在这种情况下,自然语言处理领域的两个新的分支在80年代中后期,逐步形成并迅速发展起来,这就是语料库语言学(Corpus Linguistics)和神经网络自然语言处理机制。

所谓语料库就是含有自然语言各种语言事实和规律的大规模真实文本。

语料库语言学研究机器可读的自然语言文本的采集、存储、检索、统计、语法标注、句法-语义分析,以及具有上述功能的语料库在语言定量分析、词典编撰、作品风格分析、自然语言理解和机器翻译等领域中的应用。

语料库方法有两个特点,一是依赖于语言结构的统计特征而不是完全依赖于逻辑规则,二是其处理对象是非受限领域的语言。

这一处理方法,已成为当前自然语言领域的一个非常热门的研究方向。

本文主要介绍基于语料库语言学处理机制的中英文跨语言句子检索系统的研究与实现。

- -1哈尔滨工业大学毕业设计(论文)1.2 机器翻译的发展和应用1.2.1 机器翻译的发展世界上许多国家长期以来都一直在从事机器翻译的研究。

事实上自本世纪40年代电子计算机诞生之日起就开始了将计算机应用于语言翻译的探索。

我国机器翻译的研究可以追溯到50年代中期。

半个世纪以来,世界范围和我国的机译研究都曾走过一段曲折的道路,都有过60年代中期以后约10年的停滞或沉寂。

直到70年代中期机器翻译才开始在世界范围内复苏并日趋走向兴旺。

日本却是极少数未受世界范围的停滞影响的国家。

80年代初日本几乎所有的大计算机公司都进行机器翻译系统的研究和开发,如富士通、日立、日本电气、东芝、夏普等。