数据标准化.归一化处理

- 格式:doc

- 大小:81.50 KB

- 文档页数:10

数据清洗与整理中的数据归一化与标准化分析数据的归一化与标准化是数据清洗与整理中至关重要的一环。

在大数据时代,数据来源多样,格式各异,质量参差不齐。

为了使得数据能够被准确地分析和应用,我们需要对数据进行归一化与标准化处理。

一、数据归一化数据归一化是指将具有不同量纲的数据转化为同一量纲下的数据。

在数据清洗与整理中,数据归一化能够有效消除数据之间的量纲差异,使得数据具有可比性,在后续的数据分析中更加准确。

其中常用的数据归一化方法有最小-最大归一化和z-score归一化两种方式。

最小-最大归一化方法通过对数据进行线性变换,将数据缩放到[0,1]的范围内。

公式如下:x' = (x - min(x)) / (max(x) - min(x))其中x'为归一化后的数据,x为原始数据,min(x)和max(x)分别代表原始数据x的最小值和最大值。

这种方式适用于数据分布没有明显边界的情况,能够保留数据的原始分布特性。

z-score归一化方法通过对数据进行平移和缩放,使得数据的均值为0,标准差为1。

公式如下:x' = (x - mean(x)) / std(x)其中x'为归一化后的数据,x为原始数据,mean(x)和std(x)分别代表原始数据x的均值和标准差。

这种方式适用于数据分布有明显边界的情况,能够将数据集中在均值附近。

二、数据标准化数据标准化是指使得数据呈现标准正态分布的过程。

在数据清洗与整理中,数据标准化能够有效消除数据的偏斜性,保证数据的稳定性和可靠性。

常用的数据标准化方法有log函数转换和Box-Cox变换。

log函数转换将原始数据进行对数变换,处理后的数据呈现出近似正态分布。

对于右偏数据,log函数转换能够减小极端值的影响,提高数据的稳定性。

Box-Cox变换是一种参数化的数据标准化方法,在数据的正态性检验不合格时,可以通过Box-Cox变换将数据转化为近似正态分布。

Box-Cox变换的基本公式为:y = (x^lambda - 1) / lambda其中x为原始数据,y为变换后的数据,lambda为转换参数,通过最大化对数似然函数的方法获得。

数据的标准化化准数据标常我们通需要先将,在分数据析之前数据标准,利用标准化后的数据进行数据分析。

normalization)(同趋化处化也就是统计数据的指数化数据标准化处理主要包括数据。

不同性质数据数据同趋化理和无量纲化处理处理主要解决两个方面。

问题,对不同性质指标直接加总不能正确反映不同作用力的综合结使所有指标对测评方案的作用力须先考虑改变逆指标数据性质,果,数据数据无量纲化处理主要解决再加总才能得出正确结果。

同趋化,的可比性。

去除数据的单位限制,将其转化为无量纲的纯数值,便于有很不同单位或量级的指标能够进行比较和加权。

数据标准化的方法标准化”和“按小Z-score“、多种,常用的有“最小—最大标准化”数定标标准化”等。

经过上述标准化处理,原始数据均转换为无量纲可以进行综合指标值都处于同一个数量级别上,即各化指标测评值,测评分析。

一、Min-max 标准化min-max标准化方法是对原始数据进行线性变换。

设minA和maxA 分别为属性A的最小值和最大值,将A的一个原始值x通过min-max 标准化映射成在区间[0,1]中的值x',其公式为:新数据=(原数据-极小值)/(极大值-极小值)二、z-score 标准化这种方法基于原始数据的均值(mean)和标准差(standarddeviation)进行数据的标准化。

将A的原始值x使用z-score标准化到x'。

z-score标准化方法适用于属性A的最大值和最小值未知的情况,或有超出取值范围的离群数据的情况。

新数据=(原数据-均值)/标准差spss默认的标准化方法就是z-score标准化。

用Excel进行z-score 标准化的方法:在Excel中没有现成的函数,需要自己分步计算,其实标准化的公式很简单。

步骤如下:求出各变量(指标)的算术平均值(数学期望)xi和标准差si ;为标准化后的变量zij其中:si,)/xi-xij=(zij进行标准化处理:. 值;xij为实际变量值。

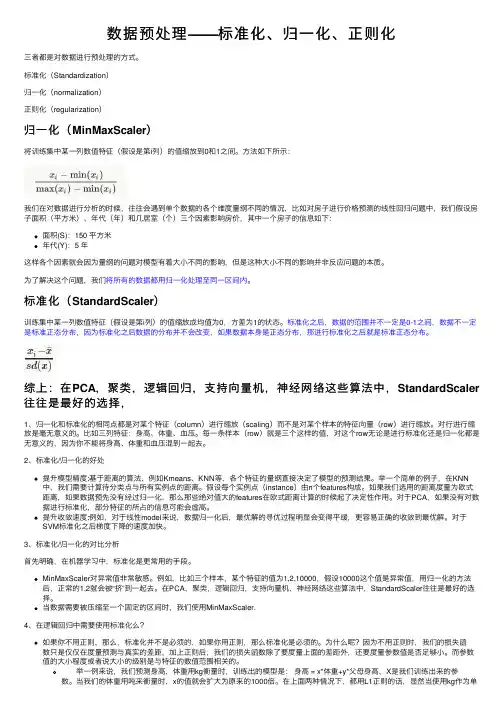

数据预处理——标准化、归⼀化、正则化三者都是对数据进⾏预处理的⽅式。

标准化(Standardization)归⼀化(normalization)正则化(regularization)归⼀化(MinMaxScaler)将训练集中某⼀列数值特征(假设是第i列)的值缩放到0和1之间。

⽅法如下所⽰:我们在对数据进⾏分析的时候,往往会遇到单个数据的各个维度量纲不同的情况,⽐如对房⼦进⾏价格预测的线性回归问题中,我们假设房⼦⾯积(平⽅⽶)、年代(年)和⼏居室(个)三个因素影响房价,其中⼀个房⼦的信息如下:⾯积(S):150 平⽅⽶年代(Y):5 年这样各个因素就会因为量纲的问题对模型有着⼤⼩不同的影响,但是这种⼤⼩不同的影响并⾮反应问题的本质。

为了解决这个问题,我们将所有的数据都⽤归⼀化处理⾄同⼀区间内。

标准化(StandardScaler)训练集中某⼀列数值特征(假设是第i列)的值缩放成均值为0,⽅差为1的状态。

标准化之后,数据的范围并不⼀定是0-1之间,数据不⼀定是标准正态分布,因为标准化之后数据的分布并不会改变,如果数据本⾝是正态分布,那进⾏标准化之后就是标准正态分布。

综上:在PCA,聚类,逻辑回归,⽀持向量机,神经⽹络这些算法中,StandardScaler 往往是最好的选择,1、归⼀化和标准化的相同点都是对某个特征(column)进⾏缩放(scaling)⽽不是对某个样本的特征向量(row)进⾏缩放。

对⾏进⾏缩放是毫⽆意义的。

⽐如三列特征:⾝⾼、体重、⾎压。

每⼀条样本(row)就是三个这样的值,对这个row⽆论是进⾏标准化还是归⼀化都是⽆意义的,因为你不能将⾝⾼、体重和⾎压混到⼀起去。

2、标准化/归⼀化的好处提升模型精度:基于距离的算法,例如Kmeans、KNN等,各个特征的量纲直接决定了模型的预测结果。

举⼀个简单的例⼦,在KNN 中,我们需要计算待分类点与所有实例点的距离。

假设每个实例点(instance)由n个features构成。

数据标准化(归一化)处理

数据标准化(归一化)处理是一种数据预处理方法,用于将数据按比例缩放,使其落入一个小的特定区间。

标准化后的数据符合某些特定的分布或统计特性,例如均值为0、标准差为1等。

数据标准化的主要目的是消除数据特征之间的量纲和数量级差异,从而避免某些特征对模型的过度影响,提高模型的稳定性和泛化能力。

常见的数据标准化方法包括:

1. Z-score 标准化:将数据减去其均值,再除以其标准差。

这种方法适用于数据分布近似于正态分布的情况。

2. Min-max 标准化:将数据按照最小值和最大值进行线性变换,使得数据范围为[0,1]。

这种方法适用于数据分布比较均匀的情况。

3. Decimal Scaling 标准化:将数据按照不同的位数进行标准化。

例如,将数据右移k位,就相当于将数据除以10k。

4. Unit Vector Normalization 标准化:将数据按照向量长度进行归一化,使得向量的模为1。

这种方法适用于文本处理和聚类分析等领域。

需要注意的是,不同的数据标准化方法适用于不同的数据类型和应用场景,选择合适的方法需要根据具体的问题进行评估和比较。

数据的归一化与标准化在数据分析和机器学习领域,数据的归一化和标准化是非常重要的步骤。

它们可以帮助我们处理不同尺度和分布的数据,提高模型的收敛速度,提高模型的准确性,并且能够使模型更加稳定和可靠。

本文将介绍数据的归一化和标准化的概念、方法和应用。

数据归一化的概念。

数据归一化是将数据按比例缩放,使之落入一个小的特定区间。

归一化是一种简化数据的方法,它可以将数据映射到0和1之间。

归一化后的数据更便于处理,可以加快模型的收敛速度,提高模型的准确性。

数据归一化的方法。

常见的数据归一化方法包括最小-最大缩放、Z-score标准化和正则化。

最小-最大缩放是将数据按比例缩放到一个特定的区间,通常是0到1或者-1到1。

Z-score标准化是将数据按照其均值和标准差进行标准化,使得数据的均值为0,标准差为1。

正则化是将每个样本按比例缩放,使得每个样本的范数为1。

数据归一化的应用。

数据归一化广泛应用于机器学习、深度学习、数据挖掘等领域。

在机器学习中,特征的尺度不一致会导致模型收敛速度慢、模型不稳定等问题,因此需要对数据进行归一化处理。

在深度学习中,归一化可以加快模型的收敛速度,提高模型的准确性。

在数据挖掘中,归一化可以提高数据的可比性,使得不同特征之间可以进行比较和分析。

数据标准化的概念。

数据标准化是将数据按照一定的标准进行处理,使得数据符合特定的分布。

标准化可以使数据更加符合正态分布,使得数据更加稳定和可靠。

标准化后的数据更适合进行统计分析和建模分析。

数据标准化的方法。

常见的数据标准化方法包括均值方差标准化、小数定标标准化和鲁棒标准化。

均值方差标准化是将数据按照其均值和标准差进行标准化,使得数据的均值为0,标准差为1。

小数定标标准化是通过移动数据的小数点位置来进行标准化,使得数据落入特定的区间。

鲁棒标准化是通过中位数和四分位数来进行标准化,使得数据更加稳健和可靠。

数据标准化的应用。

数据标准化广泛应用于统计分析、建模分析、财务分析等领域。

数据归一化和标准化的作用数据归一化(Normalization)和数据标准化(Standardization)都是对数据进行预处理的方法,目的是使得数据在某个特定的范围内,以便更好地进行分析和比较。

数据归一化通常是将数据按照一定的比例缩放到0到1的范围内,使得数据的取值范围更加统一。

数据归一化的作用包括:1. 增加模型的收敛速度:在训练模型时,如果不对数据进行归一化,不同特征的取值范围可能会有很大的差异,会导致训练过程中某些特征的权重调整过慢,从而导致模型收敛速度较慢。

通过归一化,可以缩小不同特征之间的差异,加快模型的收敛速度。

2. 防止特征间的权重不均衡:在模型中,特征的权重通常是根据它们对预测结果的贡献来确定的。

如果某个特征的取值范围较大,那么它对预测结果的贡献就会较大,而其他特征的贡献可能会被忽略。

通过归一化,可以使得不同特征的取值范围一致,以便更加准确地评估它们对预测结果的贡献。

数据标准化是将数据按照均值为0、标准差为1的标准正态分布进行缩放,使得数据围绕着均值附近分布。

数据标准化的作用包括:1. 提高模型的稳定性:标准化后的数据集更加稳定,不受极端值(outlier)的影响。

如果在模型训练过程中存在异常值,它们可能会对模型产生较大的干扰。

通过标准化,可以降低异常值的影响,提高模型的稳定性和鲁棒性。

2. 便于比较不同特征:标准化后的数据具有相同的均值和标准差,使得不同特征之间的比较更加准确。

标准化后的特征具有相同的标准差,可以避免某些特征由于取值范围较大而对模型产生较大的影响。

总而言之,数据归一化和标准化的作用是使数据具有相同的尺度,消除不同特征之间的差异,提高模型的性能和稳定性。

数据的标准化和归一化

数据的标准化和归一化是数据处理中的常见技术,它们在数据预处理中起着重要的作用。

标准化(Normalization):

标准化是一种数据预处理技术,其目的是消除数据中不同特征之间的量纲或尺度差异,使每个特征具有相同的权重。

标准化通常是通过将每个特征的值减去其均值,然后除以其标准差来实现的。

经过标准化处理后,数据的均值为0,标准差为1,从而消除了特征之间的尺度问题。

标准化在机器学习算法中很常见,特别是那些对输入特征的尺度敏感的算法,例如k-均值聚类、kNN算法等。

归一化(Normalization):

归一化是将数据调整到特定范围的过程,通常是[0,1]或[-1,1]。

与标准化不同,归一化不改变数据的原始分布,只是将数据的范围调整到指定的范围。

归一化通常用于数据压缩、数据可视化、机器学习等领域。

常见的归一化方法包括最小-最大归一化、均值归一化等。

最小-最大归一化是将原始数据减去最小值,然后除以其范围(最大值-最小值)来实现的;均值归一化则是将原始数据减去均值,然后除以其标准差来实现的。

标准化和归一化都是数据处理中的常见技术,它们的主要区别在于处理方式和目的不同。

标准化关注消除特征之间

的量纲或尺度差异,而归一化则关注调整数据的范围。

在实际应用中,根据具体的需求和场景选择合适的数据处理方法是很重要的。

标准化和归一化在数据处理和分析领域中,标准化和归一化是两个重要的概念。

它们可以帮助我们更好地理解和处理数据,从而得出更准确的结论和预测。

本文将对标准化和归一化的概念进行详细介绍,并探讨它们在实际应用中的重要性和作用。

首先,让我们来理解标准化和归一化的概念。

标准化是指将数据按照一定的标准进行处理,使得其均值为0,标准差为1。

这样做的好处是可以消除不同量纲和方差的影响,使得不同变量之间具有可比性。

而归一化则是将数据按照一定的比例缩放到一个特定的区间,通常是[0, 1]或[-1, 1]。

这样做可以使得数据落在一个相对较小的范围内,便于计算和分析。

在实际应用中,标准化和归一化有着广泛的应用。

首先,在机器学习和数据挖掘领域,标准化和归一化可以帮助算法更快地收敛,提高模型的准确性和稳定性。

其次,在统计分析中,标准化和归一化可以使得不同指标之间具有可比性,更好地反映数据的特征和规律。

此外,在金融领域,标准化和归一化可以帮助我们更好地比较不同资产的风险和回报,从而做出更明智的投资决策。

那么,如何进行标准化和归一化呢?常见的方法包括Z-score标准化、Min-Max归一化和均值方差归一化等。

其中,Z-score标准化是将原始数据减去均值,再除以标准差,从而得到标准化后的数据。

而Min-Max归一化则是将原始数据线性缩放到[0, 1]或[-1, 1]的区间内。

均值方差归一化则是将原始数据减去均值,再除以方差的平方根。

不同的方法适用于不同的数据和场景,需要根据具体情况进行选择。

在进行标准化和归一化时,需要注意一些问题。

首先,要考虑是否需要对所有变量进行处理,有些变量可能并不需要进行标准化或归一化。

其次,要注意处理后数据的可解释性和实际意义,不要盲目追求数值的变化。

最后,要注意处理后数据的稳定性和鲁棒性,避免出现过拟合或欠拟合的情况。

总之,标准化和归一化是数据处理和分析中不可或缺的步骤,它们可以帮助我们更好地理解和利用数据,从而得出更准确的结论和预测。

机器学习中的数据标准化与归一化方法详解在机器学习中,数据的标准化与归一化是非常重要的预处理步骤,它们有助于提高模型的性能和准确性。

数据标准化与归一化的目的是使数据的数值范围变得一致,消除不同特征之间的量纲差异,从而使得模型能够更好地学习数据之间的关系。

1. 数据标准化数据标准化是将原始数据转换为均值为0,方差为1的标准正态分布。

常用的数据标准化方法有以下几种:(1)Z-Score标准化:它通过去除均值并通过标准差缩放特征值,使得数据的均值为0,标准差为1。

公式如下:Z = (X - μ) / σ其中,Z是标准化后的值,X是原始值,μ是数据的均值,σ是数据的标准差。

(2)Min-Max标准化:它通过线性变换将数据映射到[0, 1]的区间内。

公式如下:X_new = (X_old - X_min) / (X_max - X_min)其中,X_new是标准化后的值,X_old是原始值,X_min是数据的最小值,X_max是数据的最大值。

(3)Max-Abs标准化:它通过线性变换将数据映射到[-1, 1]的区间内。

公式如下:X_new = X_old / max(abs(X_old))其中,X_new是标准化后的值,X_old是原始值。

数据标准化能够提高机器学习模型的稳定性和收敛速度。

例如,在梯度下降算法中,如果特征值的量级差异较大,梯度下降的收敛速度会很慢。

通过数据标准化,可以使特征值的范围限定在相对一致的区间内,从而加快模型的训练速度和收敛性。

2. 数据归一化数据归一化是将原始数据按比例缩放到一定的范围内,常用的归一化方法有以下几种:(1)峰值归一化:它通过除以数据的幅值最大值,将数据缩放到[-1, 1]的区间内。

(2)范围缩放:它通过除以数据的极差(最大值减去最小值),将数据缩放到[0, 1]的区间内。

(3)标准归一化:它通过除以数据的标准差,将数据缩放到均值为0,标准差为1的标准正态分布。

数据归一化是将数据映射到一个指定的范围内,它有助于提高模型对数据的拟合能力,使得模型能够更好地学习数据之间的关系和模式。

数据预处理中的标准化与归一化方法数据预处理是数据分析中非常重要的一环,它涉及到对原始数据进行清洗、转换和整理,以便于后续的分析和建模工作。

在数据预处理的过程中,标准化和归一化是常用的方法,它们可以使得数据更易于比较和理解。

本文将介绍数据预处理中的标准化和归一化方法,并探讨它们的应用场景和优缺点。

标准化是将数据转化为均值为0,方差为1的分布。

这种方法可以消除数据之间的量纲差异,使得不同特征的数据具有可比性。

标准化的计算方法是对每个特征的数据减去均值,再除以标准差。

例如,对于一个包含身高和体重的数据集,可以分别计算身高和体重的均值和标准差,然后对每个数据点进行标准化处理。

标准化方法适用于数据分布近似正态分布的情况,可以有效地减小异常值对数据分析的影响。

归一化是将数据转化为0到1之间的范围。

这种方法可以将数据映射到一个固定的区间,便于数据的比较和处理。

常用的归一化方法有线性归一化和最大最小归一化。

线性归一化的计算方法是对每个特征的数据减去最小值,再除以最大值和最小值之差。

最大最小归一化的计算方法是对每个特征的数据减去最小值,再除以最大值和最小值之差。

例如,对于一个包含考试成绩的数据集,可以计算最高分和最低分,然后对每个数据点进行归一化处理。

归一化方法适用于数据分布未知或不符合正态分布的情况,可以有效地缩小不同特征之间的数值差异。

标准化和归一化方法在数据预处理中有着不同的应用场景。

标准化方法适用于需要考虑数据的分布情况,以及对异常值敏感的情况。

例如,在进行聚类分析时,标准化可以保证不同特征的权重相等,避免某个特征对聚类结果产生过大的影响。

另外,在进行回归分析时,标准化可以提高模型的稳定性和可解释性。

归一化方法适用于需要将数据映射到固定区间的情况,以及对数据的比较和处理有要求的情况。

例如,在进行数据可视化时,归一化可以使得不同特征的数据具有可比性,便于观察和分析。

尽管标准化和归一化方法在数据预处理中有着各自的优势,但它们也存在一些缺点。

数据归一化和数据标准化数据归一化是一种数据预处理技术,通过对数据进行线性变换,将数据映射到一个特定的范围,通常是[0, 1]或[-1, 1]。

这种方法可以消除不同特征之间的量纲差异,使得不同特征之间的权重更加平衡,从而提高模型的训练速度和准确性。

数据归一化的常见方法包括最小-最大归一化和Z-score标准化。

最小-最大归一化是将数据线性变换到[0, 1]的范围内,其计算公式为:\[X_{norm} = \frac{X X_{min}}{X_{max} X_{min}}\]其中,\(X_{min}\)和\(X_{max}\)分别是数据的最小值和最大值。

Z-score标准化是将数据转换为均值为0,标准差为1的正态分布,其计算公式为:\[X_{norm} = \frac{X \mu}{\sigma}\]其中,\(\mu\)和\(\sigma\)分别是数据的均值和标准差。

数据标准化是另一种常用的数据预处理技术,它通过对数据进行线性变换,使得数据的均值为0,标准差为1。

这种方法可以消除不同特征之间的量纲差异,使得不同特征之间的权重更加平衡,从而提高模型的训练速度和准确性。

数据标准化的常见方法包括Z-score标准化和小数定标标准化。

小数定标标准化是将数据线性变换到[-1, 1]或[0, 1]的范围内,其计算公式为:\[X_{norm} = \frac{X}{10^k}\]其中,\(k\)是使得数据的绝对值最大的特征值转换为1的数。

数据归一化和数据标准化在数据挖掘、机器学习和统计分析中有着广泛的应用。

它们可以帮助我们更好地理解数据的特征和趋势,提高模型的训练速度和准确性,从而更好地进行数据分析和决策。

因此,掌握数据归一化和数据标准化的方法和应用是非常重要的。

数据清洗与整理中的数据归一化与数据标准化处理技巧随着数据的大量产生和广泛应用,数据清洗与整理变得尤为重要。

而其中的数据归一化和数据标准化处理技巧,则是有效提高数据质量和可靠性的关键步骤。

一、什么是数据归一化和数据标准化在进行数据处理之前,我们需要先了解数据归一化和数据标准化的概念。

数据归一化是一种通过缩放数据范围,使得输入数据在指定的范围内进行计算处理的方法。

而数据标准化则是将数据按照一定的规则进行转换,使其满足特定算法或模型的要求。

简而言之,数据归一化和数据标准化都是为了使数据整合在一定的范围内,以应用于不同的算法和模型中。

二、数据归一化的技巧数据归一化有多种常见的技巧,以下将介绍几种常用的方法。

1. 最小-最大归一化(Min-Max 归一化)最小-最大归一化是将数据线性地映射到一个特定的数值范围内。

这个数值范围常常是[0, 1]或者[-1, 1]。

具体的计算方法是将每个样本的原始值减去最小值,再除以最大值减去最小值。

这样可以保持原始数据间的相对关系。

2. Z-Score 标准化Z-Score 标准化是一种常见的数据标准化方法。

它通过计算每个样本点与整个样本的均值之间的差异,并将其除以样本的标准差,将数据转化为均值为0,标准差为1的正态分布。

这种方法将数据转化为无单位的相对值。

3. 小数定标标准化(Decimal Scaling)小数定标标准化是一种简单的归一化方法,它通过求解最大值中所包含的小数位数,将每个样本点除以10的幂次方,将数据转化为在指定范围内的小数。

尽管这种方法不一定能将数据规范到特定的范围内,但可以保留数据的更多信息。

三、数据标准化的技巧除了数据归一化之外,数据标准化也是数据清洗与整理的重要步骤。

以下将介绍几种常用的数据标准化技巧。

1. One-Hot 编码One-Hot 编码是一种将分类变量转化为二进制向量的方法。

通过为每个分类值创建一个虚拟变量,将其转为包含1和0的向量,可以更好地适应一些机器学习算法。

标准化和归一化的区别在数据处理和分析领域,标准化和归一化是两个常用的数据预处理方法,它们在数据分析、机器学习和统计建模中起着至关重要的作用。

然而,很多人对于标准化和归一化的概念存在一定的混淆,甚至认为它们是同义词。

实际上,标准化和归一化是两种不同的数据处理方法,它们有着各自独特的特点和应用场景。

本文将从概念、方法和应用等方面对标准化和归一化进行详细的比较和解释,帮助读者更好地理解它们之间的区别。

首先,我们先来看一下标准化的概念和方法。

在数据处理中,标准化是指将原始数据按照一定的比例缩放,使得数据符合标准正态分布。

通常情况下,标准化的方法是通过对原始数据减去均值,然后再除以标准差的方式来实现的。

这样可以使得数据的均值为0,标准差为1,从而使得不同维度的特征具有相同的尺度,有利于提高模型的收敛速度和精度。

标准化的应用场景主要包括在需要使用基于距离的模型(如KNN、SVM等)或者梯度下降法优化的模型(如线性回归、逻辑回归等)时,通常需要对数据进行标准化处理。

接下来,我们再来看一下归一化的概念和方法。

与标准化不同,归一化是指将原始数据按照比例缩放到一个特定的区间,通常是[0, 1]或者[-1, 1]之间。

常见的归一化方法包括最小-最大归一化和Z-Score归一化。

最小-最大归一化是通过对原始数据进行线性变换,将数据缩放到[0, 1]的区间内。

而Z-Score归一化则是通过对原始数据减去均值,然后再除以标准差的方式来实现的,与标准化的方法类似。

归一化的主要作用是消除特征之间的量纲影响,使得不同特征具有相同的尺度,有利于提高模型的收敛速度和精度。

归一化的应用场景主要包括在需要使用基于权重的模型(如神经网络、支持向量机等)或者涉及距离计算的模型时,通常需要对数据进行归一化处理。

综上所述,标准化和归一化虽然都是常用的数据预处理方法,但它们在概念、方法和应用等方面存在着明显的区别。

标准化主要是通过对原始数据进行均值和标准差的线性变换,使得数据符合标准正态分布;而归一化主要是通过对原始数据进行线性变换,将数据缩放到一个特定的区间内。

标准化和归一化区别标准化和归一化是数据处理中常见的两个概念,它们在数据分析和机器学习中扮演着重要的角色。

虽然它们有时候被用来指代相似的概念,但实际上它们有着明显的区别。

本文将对标准化和归一化进行详细解释,并对它们的区别进行深入探讨。

首先,让我们来看看标准化。

在数据处理中,标准化是指将数据按照一定的标准进行缩放,使得数据的均值为0,标准差为1。

这样做的好处是可以消除不同变量之间的量纲影响,使得不同变量之间可以进行比较和分析。

标准化的过程通常是通过减去均值,再除以标准差来实现的。

这样可以使得数据分布更加集中,更加符合正态分布的特征。

而归一化则是另外一种数据缩放的方法。

在归一化中,数据被转换到一个固定的范围内,通常是[0, 1]或者[-1, 1]。

这样做的目的是为了消除不同变量之间的量纲影响,同时保留原始数据的分布特征。

归一化的过程通常是通过找到数据的最大值和最小值,然后按照一定的比例进行缩放来实现的。

这样可以使得数据的分布范围更加统一,更加适合进行距离计算和相似度比较。

从上面的介绍可以看出,标准化和归一化虽然都是对数据进行缩放的方法,但其目的和实现方式是有所不同的。

标准化更加注重消除量纲的影响,使得数据更加符合正态分布的特征;而归一化更加注重将数据转换到一个固定的范围内,使得不同变量之间可以进行比较和分析。

在实际的数据处理和机器学习中,选择标准化还是归一化取决于具体的应用场景和数据特点。

如果数据的分布符合正态分布,那么选择标准化可能会更加合适;如果数据的分布范围比较大,那么选择归一化可能会更加合适。

当然,有时候也可以将标准化和归一化结合起来使用,以达到更好的数据处理效果。

总之,标准化和归一化虽然是类似的概念,但其在数据处理中有着不同的作用和实现方式。

合理选择和使用标准化和归一化方法,可以帮助我们更好地处理和分析数据,从而得到更加准确和可靠的结果。

希望通过本文的介绍,读者对标准化和归一化有了更加清晰的认识,能够在实际应用中更加灵活地运用这两种方法。

标准化与归一化的统计意义统计学中的标准化和归一化是两个重要的概念,它们在数据处理、模型建立、实验设计等领域均具有重要的统计意义。

本文将对标准化与归一化进行解释,并探讨它们在统计学中的应用。

什么是标准化和归一化标准化(Normalization)和归一化(Standardization)是统计学中常用的数据处理方法。

它们都涉及对数据进行转换,以便更好地理解和分析数据。

标准化是将数据按照一定的比例缩放,使其符合特定的标准。

常用的标准化方法是Z-score标准化,即将数据减去其均值,再除以其标准差。

这样处理之后,数据的均值为0,标准差为1。

归一化是将数据映射到一个特定的区间范围内。

常用的归一化方法是将数据线性缩放到[0,1]之间。

这种归一化可以更好地比较不同变量之间的差异,并消除量纲对数据分析的影响。

标准化与归一化的统计意义提高模型的稳定性和可解释性在建立统计模型时,标准化和归一化可以提高模型的稳定性和可解释性。

通过统一数据的尺度和变化范围,可以减少不同变量之间的比较偏差,避免模型受到异常值的影响。

从而提高模型的拟合效果和预测准确性。

优化特征选择和变量权重在特征选择和变量权重分析中,标准化和归一化可以帮助我们更好地评估变量的重要性。

通过将数据标准化或归一化,可以消除数据量纲的影响,使得不同变量的权重更具可比性。

这样可以更准确地选择重要的特征或评估变量对输出结果的贡献程度。

改善特征工程和模型解释在进行特征工程时,标准化和归一化可以帮助我们更好地理解数据变量的分布情况。

特征工程是通过对原始数据进行转换和提取,构造更具有代表性的特征变量集合,以提高模型的表现。

标准化和归一化可以帮助我们更好地理解原始数据的分布情况,选择更适合特征工程的方法和技术,从而提高模型的效果和解释能力。

标准化和归一化是统计学中常用的数据处理方法,它们在提高模型稳定性和可解释性、优化特征选择和变量权重分析、改善特征工程和模型解释等方面具有重要的统计意义。

数据处理-标准化归⼀化处理1.数据标准化-StandardScaler引⽤维基百科⼀句话,在统计学领域,标准化指的是向标准得分的转换在数据量⼤⼩差别很⼤,⽽且具有不同的量纲时,如果直接⽤原始数值进⾏分析,就会感觉数值较⾼的相对较低的作⽤更突出。

所以,为了保证结果的可靠性,需要对原始数据进⾏标准化处理。

数据标准化通过去除均值和缩放到单位⽅差来标准化特征。

(均值为0,⽅差为1),也叫Z-score 均值-⽅差标准化样本标准化z计算如下:z=(x−u)/s其中x是实际的样本,u的样本的均值,s是样本的标准差import pandas as pdfrom sklearn.preprocessing import StandardScalerdata = pd.DataFrame([['北京', '-5', '25', '18'],['上海', '-2', '27', '20'],['⼴州', '3', '33', '25'],['深圳', '5', '35', '28']],columns=['地区', '1⽉最低⽓温', '8⽉最⾼⽓温', '9⽉最⾼⽓温'])s_scaler = StandardScaler()df = data.iloc[:,1:]print(df)print("###### 数据标准化(StandardScaler) ######")print(s_scaler.fit_transform(df))"""1⽉最低⽓温 8⽉最⾼⽓温 9⽉最⾼⽓温0 -5 25 181 -2 27 202 3 33 253 5 35 28###### 数据标准化(StandardScaler) ######[[-1.32550825 -1.21267813 -1.19926937][-0.56807496 -0.72760688 -0.69431384][ 0.69431384 0.72760688 0.56807496][ 1.19926937 1.21267813 1.32550825]]"""2.数据归⼀化 - MinMaxScaler通过将每个特征缩放到给定范围来转换特征。

数据的标准化在数据分析之前,我们通常需要先将数据标准化(normalization),利用标准化后的数据进行数据分析。

数据标准化也就是统计数据的指数化。

数据标准化处理主要包括数据同趋化处理和无量纲化处理两个方面。

数据同趋化处理主要解决不同性质数据问题,对不同性质指标直接加总不能正确反映不同作用力的综合结果,须先考虑改变逆指标数据性质,使所有指标对测评方案的作用力同趋化,再加总才能得出正确结果。

数据无量纲化处理主要解决数据的可比性。

去除数据的单位限制,将其转化为无量纲的纯数值,便于不同单位或量级的指标能够进行比较和加权。

数据标准化的方法有很多种,常用的有“最小—最大标准化”、“Z-score标准化”和“按小数定标标准化”等。

经过上述标准化处理,原始数据均转换为无量纲化指标测评值,即各指标值都处于同一个数量级别上,可以进行综合测评分析。

一、Min-max 标准化min-max标准化方法是对原始数据进行线性变换。

设minA和maxA分别为属性A的最小值和最大值,将A的一个原始值x通过min-max标准化映射成在区间[0,1]中的值x',其公式为:新数据=(原数据-极小值)/(极大值-极小值)二、z-score 标准化这种方法基于原始数据的均值(mean)和标准差(standard deviation)进行数据的标准化。

将A的原始值x使用z-score标准化到x'。

z-score标准化方法适用于属性A的最大值和最小值未知的情况,或有超出取值范围的离群数据的情况。

新数据=(原数据-均值)/标准差spss默认的标准化方法就是z-score标准化。

用Excel进行z-score标准化的方法:在Excel中没有现成的函数,需要自己分步计算,其实标准化的公式很简单。

步骤如下:求出各变量(指标)的算术平均值(数学期望)xi和标准差si ;.进行标准化处理:zij=(xij-xi)/si,其中:zij为标准化后的变量值;xij为实际变量值。

将逆指标前的正负号对调。

标准化后的变量值围绕0上下波动,大于0说明高于平均水平,小于0说明低于平均水平。

三、Decimal scaling小数定标标准化这种方法通过移动数据的小数点位置来进行标准化。

小数点移动多少位取决于属性A的取值中的最大绝对值。

将属性A的原始值x 使用decimal scaling标准化到x'的计算方法是:x'=x/(10*j) 其中,j是满足条件的最小整数。

例如假定A的值由-986到917,A的最大绝对值为986,为使用小数定标标准化,我们用1000(即,j=3)除以每个值,这样,-986被规范化为-0.986。

注意,标准化会对原始数据做出改变,因此需要保存所使用的标准化方法的参数,以便对后续的数据进行统一的标准化。

除了上面提到的数据标准化外还有对数Logistic模式、模糊量化模式等等:对数Logistic 模式:新数据=1/(1+e^(-原数据))模糊量化模式:新数据=1/2+1/2sin[派3.1415/(极大值-极小值)*(X-(极大值-极小值)/2)] ,X为原数据数据归一化归一化是一种简化计算的方式,即将有量纲的表达式,经过变换,化为无量纲的表达式,成为纯量。

归一化是为了加快训练网络的收敛性,可以不进行归一化处理归一化的具体作用是归纳统一样本的统计分布性。

归一化在0-1之间是统计的概率分布,归一化在-1--+1之间是统计的坐标分布。

归一化有同一、统一和合一的意思。

无论是为了建模还是为了计算,首先基本度量单位要同一,神经网络是以样本在事件中的统计分别几率来进行训练(概率计算)和预测的,归一化是同一在0-1之间的统计概率分布;SVM是以降维后线性划分距离来分类和仿真的,因此时空降维归一化是统一在-1--+1之间的统计坐标分布。

当所有样本的输入信号都为正值时,与第一隐含层神经元相连的权值只能同时增加或减小,从而导致学习速度很慢。

为了避免出现这种情况,加快网络学习速度,可以对输入信号进行归一化,使得所有样本的输入信号其均值接近于0或与其均方差相比很小。

归一化是因为sigmoid函数的取值是0到1之间的,网络最后一个节点的输出也是如此,所以经常要对样本的输出归一化处理。

所以这样做分类的问题时用[0.9 0.1 0.1]就要比用要好。

但是归一化处理并不总是合适的,根据输出值的分布情况,标准化等其它统计变换方法有时可能更好。

主要是为了数据处理方便提出来的,把数据映射到0~1范围之内处理,更加便捷快速,应该归到数字信号处理范畴之内。

归一化方法(Normalization Method)1。

把数变为(0,1)之间的小数主要是为了数据处理方便提出来的,把数据映射到0~1范围之内处理,更加便捷快速,应该归到数字信号处理范畴之内。

2 。

把有量纲表达式变为无量纲表达式归一化是一种简化计算的方式,即将有量纲的表达式,经过变换,化为无量纲的表达式,成为纯量。

比如,复数阻抗可以归一化书写:Z = R + jωL = R(1 + jωL/R) ,复数部分变成了纯数量了,没有量纲。

标准化方法(Normalization Method)数据的标准化是将数据按比例缩放,使之落入一个小的特定区间。

由于信用指标体系的各个指标度量单位是不同的,为了能够将指标参与评价计算,需要对指标进行规范化处理,通过函数变换将其数值映射到某个数值区间。

关于神经网络(matlab)归一化的整理关于神经网络归一化方法的整理由于采集的各数据单位不一致,因而须对数据进行[-1,1]归一化处理,归一化方法主要有如下几种,供大家参考:(by james)1、线性函数转换,表达式如下:y=(x-MinValue)/(MaxValue-MinValue)说明:x、y分别为转换前、后的值,MaxValue、MinValue分别为样本的最大值和最小值。

2、对数函数转换,表达式如下:y=log10(x)说明:以10为底的对数函数转换。

3、反余切函数转换,表达式如下:y=atan(x)*2/PI归一化是为了加快训练网络的收敛性,可以不进行归一化处理归一化的具体作用是归纳统一样本的统计分布性。

归一化在0-1之间是统计的概率分布,归一化在-1~+1之间是统计的坐标分布。

归一化有同一、统一和合一的意思。

无论是为了建模还是为了计算,首先基本度量单位要同一,神经网络是以样本在事件中的统计分别几率来进行训练(概率计算)和预测的,归一化是统一在0-1之间的统计概率分布;当所有样本的输入信号都为正值时,与第一隐含层神经元相连的权值只能同时增加或减小,从而导致学习速度很慢。

为了避免出现这种情况,加快网络学习速度,可以对输入信号进行归一化,使得所有样本的输入信号其均值接近于0或与其均方差相比很小。

归一化是因为sigmoid函数的取值是0到1之间的,网络最后一个节点的输出也是如此,所以经常要对样本的输出归一化处理。

所以这样做分类的问题时用[0.9 0.1 0.1]就要比用[1 0 0]要好。

但是归一化处理并不总是合适的,根据输出值的分布情况,标准化等其它统计变换方法有时可能更好。

关于用premnmx语句进行归一化:Premnmx语句格式:[Pn,minp,maxp,Tn,mint,maxt]=premnmx(P,T)其中P,T分别为原始输入和输出数据,minp和maxp分别为P中的最小值和最大值(最大最小是针对矩阵的行来取,而min(p)是针对矩阵的列来取)。

mint和maxt分别为T的最小值和最大值。

premnmx函数用于将网络的输入数据或输出数据进行归一化,归一化后的数据将分布在[-1,1]区间内。

我们在训练网络时如果所用的是经过归一化的样本数据,那么以后使用网络时所用的新数据也应该和样本数据接受相同的预处理,这就要用到tramnmx。

关于用tramnmx语句进行归一化:Tramnmx语句格式:[Pn]=tramnmx(P,minp,maxp)其中P和Pn分别为变换前、后的输入数据,maxp和minp分别为premnmx函数找到的最大值和最小值。

(by terry2008)matlab中的归一化处理有三种方法1. premnmx、postmnmx、tramnmx2. restd、poststd、trastd3. 自己编程具体用那种方法就和你的具体问题有关了(by happy)pm=max(abs(p(i,:))); p(i,:)=p(i,:)/pm;和for i=1:27p(i,:)=(p(i,:)-min(p(i,:)))/(max(p(i,:))-min(p(i,:)));end 可以归一到0 1 之间0.1+(x-min)/(max-min)*(0.9-0.1)其中max和min分别表示样本最大值和最小值。

这个可以归一到0.1-0.9矩阵归一化归一化化定义:我是这样认为的,归一化化就是要把你需要处理的数据经过处理后(通过某种算法)限制在你需要的一定范围内。

首先归一化是为了后面数据处理的方便,其次是保正程序运行时收敛加快。

在matlab里面,用于:归一化的方法共有三种(1)premnmx、postmnmx、tramnmxpremnmx指的是归一到[-1 1]。

(2)prestd、poststd、trastdprestd归一到单位方差和零均值。

(3)是用matlab语言自己编程。

关于自己编程一般是归一到[0.1 0.9]。

为什么要用归一化呢?首先先说一个概念,叫做奇异样本数据,所谓奇异样本数据数据指的是相对于其他输入样本特别大或特别小的样本矢量。

下面举例:m=[0.11 0.15 0.32 0.45 30;0.13 0.24 0.27 0.25 45];其中的第五列数据相对于其他4列数据就可以成为奇异样本数据(下面所说的网络均值bp)。

奇异样本数据存在所引起的网络训练时间增加,并可能引起网络无法收敛,所以对于训练样本存在奇异样本数据的数据集在训练之前,最好先进形归一化,若不存在奇异样本数据,则不需要事先归一化。

一个小程序:p=[1.3711 1.3802 1.3636 1.3598 1.3502 1.3404 1.3284 1.3160 1.3118 1.3032 1.2989 1.2945 1.2923 1.2923 1.2856 1.2788 1.2742 1.2672 1.2577 1.2279 1.1903 1.0864 0.9956 ]; t=[0 1.38 1.68 1.98 2.08 2.23 2.53 2.83 2.93 3.13 3.23 3.33 3.43 3.53 3.63 3.73 3.83 3.93 4.03 4.13 4.23 4.33 4.43];u=p;tt=t;p=(p-min(p))/(max(p)-min(p));%g归一化t=(t-min(t))/(max(t)-min(t));net=newff(minmax(p),[23 1],{'tansig' 'purelin'},'traingdx'); net.trainParam.epochs=1000;net.trainParam.goal=0.001;net.trainParam.show=10;net.trainParam.lr=0.05;[net,tr,Y,E]=train(net,p,t);a=sim(net,p);out=a*(max(tt)-min(tt))+min(tt);%反归一化x=u;y=tt;figure(1)plot(x,y,'k*',x,y,'-k',u,out,'ko')title('70°EPDM的压缩永久变形')legend('*试验数据o预测结果')xlabel('压缩变形保持率')ylabel('时间的对数log10(t)')grid on。