双目立体视觉资料

- 格式:ppt

- 大小:1.11 MB

- 文档页数:14

双目立体视觉原理双目立体视觉是指人类通过两只眼睛同时观察同一物体时产生的立体效果。

这种视觉原理是人类视觉系统中非常重要的一部分,它使我们能够感知到物体的深度和距离,为我们的日常生活和工作提供了重要的信息。

在本文中,我们将深入探讨双目立体视觉的原理和应用。

首先,双目立体视觉的原理是基于人类两只眼睛的位置差异而产生的。

由于两只眼睛分别位于头部的两侧,它们所看到的同一物体会有微小的差异。

这种差异包括视差、视角和视线方向等,这些差异为我们的大脑提供了丰富的信息,使我们能够感知到物体的深度和距离。

其次,双目立体视觉的原理还涉及到视觉系统的处理过程。

当两只眼睛同时观察同一物体时,它们所接收到的图像会被传送到大脑的视觉皮层进行处理。

在这个过程中,大脑会将两只眼睛接收到的信息进行比对和整合,从而产生立体效果。

这种比对和整合的过程是非常复杂的,它涉及到大脑的神经元网络和神经递质的作用,是一个高度精密的生物信息处理过程。

另外,双目立体视觉的原理还与人类的视觉经验和学习有关。

通过长期的视觉训练和经验积累,人类能够更加准确地感知物体的深度和距离。

这种经验和学习会影响到我们的视觉系统的发育和功能,使我们能够更加灵活地应对各种复杂的立体环境。

在实际应用中,双目立体视觉原理被广泛应用于计算机视觉、虚拟现实、医学影像等领域。

通过模拟人类的双目立体视觉原理,计算机可以实现立体图像的获取、处理和显示,从而实现立体视觉效果。

在虚拟现实技术中,双目立体视觉原理可以为用户提供更加逼真的虚拟体验,增强沉浸感和真实感。

在医学影像领域,双目立体视觉原理可以帮助医生更加准确地诊断疾病,提高医疗水平。

总之,双目立体视觉原理是人类视觉系统中非常重要的一部分,它使我们能够感知物体的深度和距离,为我们的日常生活和工作提供了重要的信息。

通过深入研究双目立体视觉的原理和应用,我们可以更好地理解人类视觉系统的工作机制,推动计算机视觉、虚拟现实、医学影像等领域的发展和创新。

双目立体视觉匹配双目立体视觉匹配是指利用人类双眼在空间中略微不同的视角,联合大脑进行视觉信息的处理和匹配,从而获得空间的深度和立体感。

在现代科技中,利用双目立体视觉匹配可以实现很多实用的应用,比如立体影像、立体游戏、机器人视觉导航等。

双目立体视觉匹配技术是计算机视觉和人工智能领域的一个重要研究方向,具有广泛的应用前景。

一、双目立体视觉原理人类通过双眼获取的两幅视觉图像,实际上是同一个物体在不同视角下的投影。

这两幅图像之间存在视差,也就是物体在不同视角下的位置差异。

大脑通过对这些视差的处理,得出了深度信息,使我们能够感知到物体的三维空间位置。

双目立体视觉匹配主要涉及视差的计算和匹配。

在数字图像处理中,利用计算机对双眼获取的两幅图像进行处理和匹配,从而获取深度信息。

通常采用的方法包括视差计算、视差匹配和深度图生成等步骤。

1. 视差计算:通过一系列像素级的图像处理方法,计算出两幅图像之间的视差。

常见的计算方法包括半全局匹配(Semi-Global Matching, SGM)、立体匹配算法(Stereo Matching)、视差图像传感器(Depth Sensing Image Sensor)等。

2. 视差匹配:将两幅图像中对应的像素进行匹配,找到它们之间的视差值。

通常采用的方法包括基于特征点的匹配、基于像素级的匹配等。

3. 深度图生成:根据计算得出的视差信息,生成目标物体的深度图,从而实现三维空间中物体位置的感知。

双目立体视觉匹配的原理是基于人类视觉的工作原理,通过模拟人类双眼的工作方式,从而实现数字图像的深度感知和立体视觉效果。

二、双目立体视觉应用双目立体视觉匹配技术在现代科技中应用广泛,涉及到多个领域,包括计算机视觉、人工智能、机器人技术等。

以下将介绍一些典型的双目立体视觉应用。

1. 立体影像:利用双目立体视觉匹配技术,可以实现立体影像的拍摄和显示。

通过双目相机拍摄的图像以及虚拟现实(Virtual Reality, VR)或增强现实(Augmented Reality, AR)技术,可以实现逼真的立体影像体验。

双目立体视觉双目立体视觉的研究一直是机器视觉中的热点和难点。

使用双目立体视觉系统可以确定任意物体的三维轮廓,并且可以得到轮廓上任意点的三维坐标。

因此双目立体视觉系统可以应用在多个领域。

现说明介绍如何基于HALCON实现双目立体视觉系统,以及立体视觉的基本理论、方法和相关技术,为搭建双目立体视觉系统和提高算法效率。

双目立体视觉是机器视觉的一种重要形式,它是基于视差原理并由多幅图像获取物体三维几何信息的方法。

双目立体视觉系统一般由双摄像机从不同角度同时获得被测物的两幅数字图像,或由单摄像机在不同时刻从不同角度获得被测物的两幅数字图像,并基于视差原理恢复出物体的三维几何信息,重建物体三维轮廓及位置。

双目立体视觉系统在机器视觉领域有着广泛的应用前景。

HALCON是在世界范围内广泛使用的机器视觉软件。

它拥有满足您各类机器视觉应用需求的完善的开发库。

HALCON也包含Blob分析、形态学、模式识别、测量、三维摄像机定标、双目立体视觉等杰出的高级算法。

HALCON 支持Linux 和Windows ,并且可以通过C、C++、C#、Visual Basic 和Delphi 语言访问。

另外HALCON与硬件无关,支持大多数图像采集卡及带有DirectShow 和IEEE 1394 驱动的采集设备,用户可以利用其开放式结构快速开发图像处理和机器视觉应用软件。

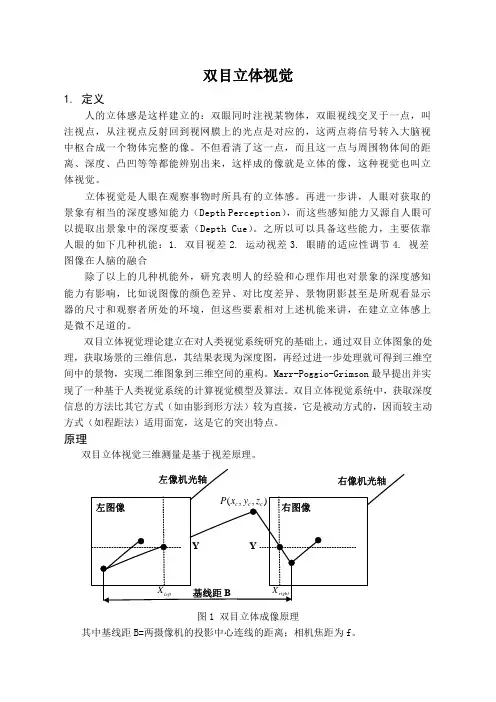

一•双目立体视觉相关基本理论说明1 . 1双目立体视觉原理双目立体视觉三维测量是基于视差原理,图1所示为简单的平视双目立体成像原理图,两摄像机的投影中心的连线的距离,即基线距为b。

摄像机坐标系的原点在摄像机镜头的光心处,坐标系如图1所示。

事实上摄像机的成像平面在镜头的光心后,图1中将左右成像平面绘制在镜头的光心前f处,这个虚拟的图像平面坐标系O1uv的u轴和v轴与和摄像机坐标系的x轴和y轴方向一致,这样可以简化计算过程。

左右图像坐标系的原点在摄像机光轴与平面的交点O1和O2。

双目立体视觉原理双目立体视觉是人类视觉系统利用双眼获取深度信息的一种视觉方式。

在日常生活中,我们常常利用双眼来感知物体的位置、距离和深度,这得益于双目立体视觉原理的作用。

双目立体视觉原理是指人类通过左右两只眼睛同时观察同一物体,由于左右眼之间存在一定的视差,从而产生了深度信息,使我们能够感知到物体的立体形状和位置。

双目立体视觉原理的实现基于人类双眼之间的视差。

当我们观察远处的物体时,左右眼所看到的图像几乎是一样的,视差较小;而当观察近处的物体时,左右眼所看到的图像会有较大的差异,视差较大。

通过比较左右眼的视差,人类大脑能够计算出物体的距离和深度信息。

双目立体视觉原理在人类视觉系统中扮演着重要的角色。

首先,双目立体视觉使我们能够更准确地感知物体的位置和距离,这对于日常生活中的行走、操纵物体等活动至关重要。

其次,双目立体视觉也为我们提供了更加生动和真实的视觉体验,使我们能够感受到物体的立体形状和空间位置,这对于艺术、设计和娱乐等领域具有重要意义。

在工程应用中,双目立体视觉原理也被广泛应用于计算机视觉、机器人技术等领域。

通过模拟人类双目视觉系统,计算机可以实现对物体的三维重建和深度感知,从而实现对环境的理解和感知。

在机器人领域,双目立体视觉也被用于实现机器人的自主导航、避障和抓取等任务,为机器人赋予了更加灵活和智能的能力。

总的来说,双目立体视觉原理是人类视觉系统中一项重要的功能,它使我们能够感知物体的立体形状和位置,为我们的日常生活、艺术创作和工程应用提供了重要的支持。

随着科学技术的不断发展,双目立体视觉原理也将继续发挥着重要的作用,并为人类带来更加丰富和多彩的视觉体验。

双目立体视觉1. 定义人的立体感是这样建立的:双眼同时注视某物体,双眼视线交叉于一点,叫注视点,从注视点反射回到视网膜上的光点是对应的,这两点将信号转入大脑视中枢合成一个物体完整的像。

不但看清了这一点,而且这一点与周围物体间的距离、深度、凸凹等等都能辨别出来,这样成的像就是立体的像,这种视觉也叫立体视觉。

立体视觉是人眼在观察事物时所具有的立体感。

再进一步讲,人眼对获取的景象有相当的深度感知能力(Depth Perception),而这些感知能力又源自人眼可以提取出景象中的深度要素(Depth Cue)。

之所以可以具备这些能力,主要依靠人眼的如下几种机能:1. 双目视差2. 运动视差3. 眼睛的适应性调节4. 视差图像在人脑的融合除了以上的几种机能外,研究表明人的经验和心理作用也对景象的深度感知能力有影响,比如说图像的颜色差异、对比度差异、景物阴影甚至是所观看显示器的尺寸和观察者所处的环境,但这些要素相对上述机能来讲,在建立立体感上是微不足道的。

双目立体视觉理论建立在对人类视觉系统研究的基础上,通过双目立体图象的处理,获取场景的三维信息,其结果表现为深度图,再经过进一步处理就可得到三维空间中的景物,实现二维图象到三维空间的重构。

Marr-Poggio-Grimson最早提出并实现了一种基于人类视觉系统的计算视觉模型及算法。

双目立体视觉系统中,获取深度信息的方法比其它方式(如由影到形方法)较为直接,它是被动方式的,因而较主动方式(如程距法)适用面宽,这是它的突出特点。

原理双目立体视觉三维测量是基于视差原理。

图1 双目立体成像原理其中基线距B=两摄像机的投影中心连线的距离;相机焦距为f。

设两摄像机在同一时刻观看空间物体的同一特征点(,,)c c c P x y z ,分别在“左眼”和“右眼”上获取了点P 的图像,它们的图像坐标分别为(,)left left left p X Y =,(,)right right right p X Y =。

双目立体视觉系统分类一、引言双目立体视觉系统是一种通过模拟人类双眼来感知物体深度的计算机视觉技术。

它模仿了人类的双眼视觉系统,并利用两个相机采集不同视角的图像,通过计算两个图像之间的视差(视点之间的差异),从而获取物体的三维信息。

本文将对双目立体视觉系统的分类进行全面、详细、完整且深入地探讨。

二、传统方法传统的双目立体视觉系统主要包括以下几种分类:1. 匹配算法匹配算法是双目立体视觉系统的核心算法之一。

它通过比较两个图像中对应的像素点(称为对极约束),找到它们之间的匹配关系,在此基础上计算视差。

常见的匹配算法包括:•基于灰度的匹配算法:使用像素灰度值进行匹配,如SAD(Sum of Absolute Differences)和SSD(Sum of Squared Differences)等。

•基于特征点的匹配算法:使用特征点提取算法,如SIFT(Scale-Invariant Feature Transform)和SURF(Speeded Up Robust Features)等,进行匹配。

2. 深度计算深度计算是双目立体视觉系统的另一个重要任务。

它通过视差计算得到每个像素点的深度信息。

常见的深度计算方法包括:•三角测量法:利用成像几何关系,利用相机的内外参,计算出像素点的三维坐标,从而得到深度信息。

•基于视差图的深度计算:根据视差图,通过一定的数学模型和滤波方法,计算出每个像素点的深度。

3. 重建方法重建方法是将双目立体视觉系统获取的二维图像信息转换为三维点云或三维模型的过程。

常见的重建方法包括:•点云重建:利用深度信息,将每个像素点转化为三维空间中的点,并通过点云生成算法,生成完整的点云模型。

•三维模型重建:利用深度信息,将每个像素点转换为三维空间中的点,并通过三维模型重建算法(如表面重建算法),生成连续的三维模型。

三、深度学习方法随着深度学习的发展,越来越多的研究者开始探索使用深度学习方法解决双目立体视觉任务。

双目立体视觉技术简介1.什么是视觉视觉不仅是一个古老的研究课题,也是人类观察和认识世界的重要功能和手段。

人类从外部世界获得的信息中,约75%来自视觉系统。

多年来,用机器模拟人类的视觉功能一直是人们的梦想。

视觉神经生理学、视觉心理学,特别是计算机技术、数字图像处理、计算机图形学、人工智能等学科的发展,使计算机模拟人类视觉成为可能。

在现代工业自动化过程中,计算机视觉正成为提高生产效率、检测产品质量的关键技术之一,如机械零件的自动检测、智能机器人控制、生产线的自动监控等;在国防和航空航天领域,计算机视觉也具有重要意义,如运动目标的自动跟踪和识别、自主车辆导航和空间机器人的视觉控制。

人类视觉过程可以看作是一个从感觉到知觉的复杂过程,从狭义上来说视觉的最终目的是要对场景作出对观察者有意义的解释和描述;从广义上说,是根据周围的环境和观察者的意愿,在解释和描述的基础上做出行为规划或行为决策。

计算机视觉研究的目的使计算机具有通过二维图像信息来认知三维环境信息的能力,这种能力不仅使机器能感知三维环境中物体的几何信息(如形状、位置、姿态运动等),而且能进一步对它们进行描述、存储、识别与理解,计算机视觉己经发展起一套独立的计算理论与算法。

2.什么是计算机双目立体视觉双目立体视觉(binocularstereovision)是机器视觉的一种重要形式,它是基于视差原理并利用成像设备从不同的位置获取被测物体的两幅图像,通过计算图像对应点间的位置偏差,来获取物体三维几何信息的方法。

融合两只眼睛获得的图像并观察它们之间的差别,使我们可以获得明显的深度感,建立特征间的对应关系,将同一空间物理点在不同图像中的映像点对应起来,这个差别,我们称作视差(disparity)图像,如图一。

图一。

视差图像双目立体视觉测量方法具有效率高、精度合适、系统结构简单、成本低等优点,非常适合于制造现场的在线、非接触产品检测和质量控制。

对运动物体(包括动物和人体形体)测量中,由于图像获取是在瞬间完成的,因此立体视觉方法是一种更有效的测量方法。

双目立体基础

双目立体视觉是计算机视觉中的一个重要分支,其原理基于人眼的立体视觉

机制。

通过模拟人眼观察世界的方式,双目立体视觉利用两个相机的视角差

异来获取场景的深度信息,从而得到场景的三维结构。

双目立体视觉系统主要由两个平行放置的相机组成,这两个相机从不同的位

置和角度拍摄同一场景。

由于相机之间的距离和角度差异,使得每只眼睛观

察到的场景都有微小的差异。

大脑会解析这两张略微不同的图像,根据这些

差异计算出物体的距离。

双目立体视觉的基本步骤包括:

1. 图像获取:使用两个相机从不同的角度拍摄同一场景。

2. 图像预处理:对获取的图像进行必要的预处理,如去噪、对比度增强等,以提高后续步骤的准确性。

3. 特征点检测与匹配:在两个图像中寻找相同或相似的特征点,并确定它

们之间的对应关系。

这一步是双目立体视觉中的关键步骤,因为只有正确匹

配的特征点才能用于计算深度信息。

4. 视差计算:根据特征点的匹配关系和相机的参数(如相机间距、焦距等),计算出每个像素点的视差。

视差是指同一物体在两个不同视角的图像

中的位置差异。

5. 深度信息提取:根据视差和相机的参数,利用三角测量原理计算出每个

像素点的深度信息。

6. 三维重建:将深度信息转换为三维坐标,从而得到场景的三维结构。

7. 后处理:对重建的三维场景进行必要的后处理,如去除噪声、平滑表面等。

双目立体视觉的应用非常广泛,包括机器人导航、增强现实、医学影像分析等。

随着计算机视觉技术的不断发展,双目立体视觉在未来的应用前景将更加广阔。

双目立体视觉,在百度百科里的解释是这样解释的:双目立体视觉(Binocular Stereo Vision)是机器视觉的一种重要形式,它是基于视差原理并利用成像设备从不同的位置获取被测物体的两幅图像,通过计算图像对应点间的位置偏差,来获取物体三维几何信息的方法。

我相信未来的世界一定是三维感知的世界,毕竟二维世界很多情况下不能满足要求的。

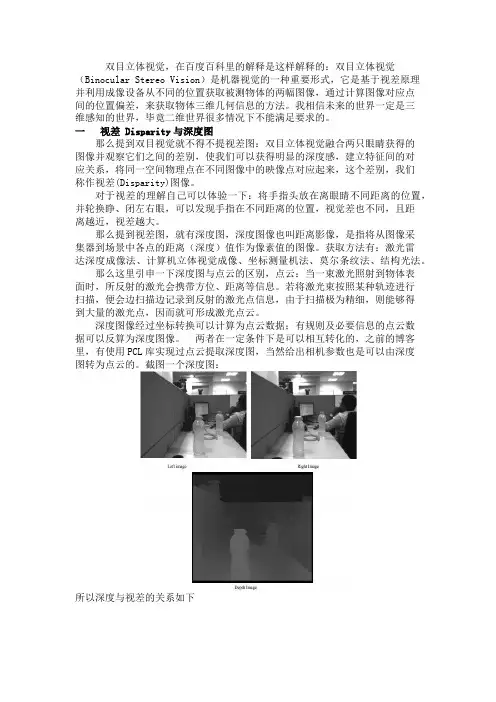

一视差 Disparity与深度图那么提到双目视觉就不得不提视差图:双目立体视觉融合两只眼睛获得的图像并观察它们之间的差别,使我们可以获得明显的深度感,建立特征间的对应关系,将同一空间物理点在不同图像中的映像点对应起来,这个差别,我们称作视差(Disparity)图像。

对于视差的理解自己可以体验一下:将手指头放在离眼睛不同距离的位置,并轮换睁、闭左右眼,可以发现手指在不同距离的位置,视觉差也不同,且距离越近,视差越大。

那么提到视差图,就有深度图,深度图像也叫距离影像,是指将从图像采集器到场景中各点的距离(深度)值作为像素值的图像。

获取方法有:激光雷达深度成像法、计算机立体视觉成像、坐标测量机法、莫尔条纹法、结构光法。

那么这里引申一下深度图与点云的区别,点云:当一束激光照射到物体表面时,所反射的激光会携带方位、距离等信息。

若将激光束按照某种轨迹进行扫描,便会边扫描边记录到反射的激光点信息,由于扫描极为精细,则能够得到大量的激光点,因而就可形成激光点云。

深度图像经过坐标转换可以计算为点云数据;有规则及必要信息的点云数据可以反算为深度图像。

两者在一定条件下是可以相互转化的,之前的博客里,有使用PCL库实现过点云提取深度图,当然给出相机参数也是可以由深度图转为点云的。

截图一个深度图:所以深度与视差的关系如下比如绝对差值法绝对差值图的计算方法如下:D=|L-R|式中,L、R和D分别代表左视图、右视图和对应的绝对差值图的亮度值。

绝对差值图并不是严格意义上的视差图,但是它的计算方法最为简单,速度快,它给出的结果可以作为参考。

双目立体视觉SLAM研究双目立体视觉SLAM(Simultaneous Localization and Mapping)是一种使用双目摄像头进行地图构建和定位的方法。

通过分析双目摄像头获取的图像以及其之间的视差信息,可以在未知环境中同时进行地图构建和机器人自身的定位。

双目立体视觉SLAM已经在机器人导航和智能车辆等领域展示出了很大的潜力,并在其中取得了很大的成功。

双目摄像头由两个摄像头组成,分别被放置在机器人的两侧。

这样做的好处是可以获取不同视角的图像,并基于两图像之间的视差信息来计算物体的深度信息。

通过物体的深度信息,可以推算出物体在空间中的位置。

双目立体视觉SLAM利用这些信息来构建三维地图,并同时对机器人的位置进行定位。

在进行双目立体视觉SLAM之前,首先需要进行摄像头的标定。

标定过程通常包括获取摄像头的内外参数以及相对位姿。

内参数包括焦距、主点位置、畸变系数等,而外参数则包括摄像头之间的相对位置和姿态信息。

标定完成后,就可以开始进行地图构建和定位。

地图构建是双目立体视觉SLAM的核心任务之一、通过分析双目图像对中的像素位移,可以计算出场景中物体的深度信息。

通过对多个图像对的深度信息进行融合,可以得到一个相对准确的三维地图。

地图构建通常使用一些特征点或者特征描述子来实现,例如SIFT、ORB等。

这些算法能够在不同图像之间找到相匹配的特征点,从而计算出视差信息。

在地图构建的同时,双目立体视觉SLAM还需要对机器人的位置进行定位。

定位过程与地图构建是相辅相成的。

通过分析机器人当前图像对与地图中已知特征点的相匹配程度,可以估计机器人当前的位置。

机器人的姿态信息也会受到图像对中相对位置的影响。

因此,双目立体视觉SLAM 通常是一个迭代的过程,不断更新地图和机器人的位置。

双目立体视觉SLAM面临一些困难和挑战。

首先,双目摄像头在使用过程中可能会出现在姿态变化、畸变、遮挡等问题,这些问题会对地图构建和定位的准确性产生影响。

《双目立体视觉三维重建的立体匹配算法研究》一、引言随着人工智能技术的不断发展和进步,双目立体视觉技术已经成为计算机视觉领域的重要研究方向之一。

其中,立体匹配算法作为双目立体视觉三维重建的核心技术,其准确性和效率直接影响到三维重建的效果。

本文旨在研究双目立体视觉三维重建中的立体匹配算法,以期提高三维重建的准确性和效率。

二、背景及意义双目立体视觉技术是通过模拟人类双眼的视觉系统,利用两个相机从不同角度获取同一场景的图像信息,进而通过立体匹配算法恢复出场景的三维信息。

立体匹配算法是双目立体视觉技术的核心,其目的是在两个相机获取的图像中寻找对应的像素点,从而得到视差图,进而实现三维重建。

因此,研究立体匹配算法对于提高双目立体视觉技术的准确性和效率具有重要意义。

三、立体匹配算法研究现状目前,立体匹配算法已经成为计算机视觉领域的热点研究方向。

常见的立体匹配算法包括基于区域的匹配算法、基于特征的匹配算法、基于相位的匹配算法等。

这些算法在不同的应用场景中各有优缺点。

近年来,随着深度学习的快速发展,基于深度学习的立体匹配算法成为研究热点。

这些算法通过训练深度神经网络来学习图像之间的对应关系,从而提高了匹配的准确性和鲁棒性。

四、本文研究的立体匹配算法本文研究的立体匹配算法是一种基于区域和特征的混合匹配算法。

该算法首先提取图像中的特征信息,如边缘、角点等,然后在特征匹配的基础上,结合基于区域的匹配算法进行像素级匹配。

具体而言,该算法包括以下步骤:1. 特征提取:利用特征检测算法提取图像中的特征点。

2. 特征匹配:通过计算特征点之间的相似性,找到两个图像中对应的特征点。

3. 基于区域的匹配:在特征匹配的基础上,利用基于区域的匹配算法对像素级进行匹配,得到视差图。

4. 优化与后处理:对得到的视差图进行优化和后处理,以提高三维重建的准确性和效果。

五、实验与分析为了验证本文研究的立体匹配算法的有效性,我们进行了大量实验。

实验数据集包括公开的立体视觉数据集以及实际拍摄的场景图像。

(16条消息)关于双目立体视觉的一些总结(一)由于项目和毕设的需要,最近在做一些立体视觉的东西,总算是把立体视觉建立起来了,中途查了很多相关资料,这里做一个总结。

1.简介:双目视觉是模拟人类视觉原理,使用计算机被动感知距离的方法。

从两个或者多个点观察一个物体,获取在不同视角下的图像,根据图像之间像素的匹配关系,通过三角测量原理计算出像素之间的偏移来获取物体的三维信息。

得到了物体的景深信息,就可以计算出物体与相机之间的实际距离,物体3维大小,两点之间实际距离。

2.建立立体视觉为了精确地求得某个点在三维空间里的深度信息,我们需要获得的参数有焦距f、视差d、摄像头中心距Tx;为了获得某个点的X坐标和Y坐标,还需要知道左右像平面的坐标系与立体坐标系中原点的偏移cx和cy。

因此我们需要进行下列三个步骤:相机标定,图像校正,立体匹配。

相机标定•标定目的:获取相机的内参(焦距,图像中心,畸变系数等)和外参(R(旋转)矩阵T(平移)矩阵)•相机标定需要采集标定数据,通常使用打印棋盘格的纸作为特制的标定参照物,摄像头获取该物体的图像,并由此计算摄像头的内外参数。

•相机标定有两种方法:•方法一:Bouguet的Matlab标定工具箱();有比较详细的介绍和使用方法,用起来还是比较方便的,只不过做完标定要继续的话要把标定结果存入xml导入OpenCV再进行。

•方法二:OpenCV的cvStereoCalibrate;在《学习OpenCV》第11,12章有比较详细的介绍。

12章后有相关程序代码。

双目图像校正双目校正是根据摄像头定标后获得的单目内参数据(焦距、成像原点、畸变系数)和双目相对位置关系(旋转矩阵和平移向量),分别对左右视图进行消除畸变和行对准,使得左右视图的成像原点坐标一致、两摄像头光轴平行、左右成像平面共面、对极线行对齐。

将左右视图调整成完全平行对准的理想形式(如下图)。

校正反映到图像上就是要把消除畸变后的两幅图像严格地行对应,使得两幅图像的对极线恰好在同一水平线上,这样一幅图像上任意一点与其在另一幅图像上的对应点就必然具有相同的行号,只需在该行进行一维搜索即可匹配到对应点。