几种最小二乘法递推算法的小结

- 格式:doc

- 大小:139.00 KB

- 文档页数:4

推导最小二乘法的两种方法最小二乘法是一种常见的数据拟合方法,用于找到一条直线,使得该直线与一组数据之间的最小距离等于零。

下面将介绍两种推导最小二乘法的方法。

方法一:基于样本点的距离我们可以从样本点出发,构造一条直线,使得该直线与样本点的距离等于零。

具体来说,设样本点为 (x_i, y_i),我们希望构造的直线为:y = ax + b其中 a 和 b 是待求的直线的参数。

为了找到 a 和 b,我们可以对样本点进行距离计算,得到:d = |y_i - ax_i + b|我们希望 d 等于零,即 y_i - ax_i + b = 0。

解这个方程,可以得到 a = (y_i - b) / x_i,b = y_i。

因此,我们得到一条直线的参数为:a = (y_i - b) / x_i,b = y_i该直线与样本点的距离就是:d = |y_i - ax_i + b| = |y_i - (y_i - b) / x_i + b| = (y_i - b) / x_i + b方法二:基于最小二乘法的公式另一种推导最小二乘法的方法是利用最小二乘法的公式。

最小二乘法的公式是:最小二乘法 = 1 / (n - 1) * Σ (y - y_i)^2 / (x - x_i)^2其中 n 是样本数,y_i 和 x_i 是样本点的坐标。

我们希望找到一条直线,使得该直线的斜率 k 满足:k * (x - x_i) = (y - y_i)即 k * (x - x_i) = y - y_i我们要求 k * (x - x_i) 最小,即要求 y - y_i 最小。

因此,我们可以构造一组数据,使得 y - y_i 最小。

具体来说,设 y_j = y_i + c,其中 c 是常数。

我们可以构造一条直线:k * (x - x_i) = y - y_i = y_j - c其中 k * (x - x_i) 就是直线的斜率。

该直线与样本点的距离就是:d = |y_i - ax_i + b| = |y_j - c - (ax_i + b)| = |ax_i - y_j - c|我们希望 d 最小,即要求 ax_i - y_j - c 最小。

最小二乘法公式的多种推导方法最小二乘法是统计学中用来求两个线性相关变量的回归直线方程的一种方法,因其推导方法比较复杂,高中数学《必修3》简单介绍了最小二乘法的思想,直接给出了回归直线斜率a和截距b的计算公式,省略了公式的推导过程。

中学数学教师没有引起足够的重视。

在文[1]中作者的困惑之一就是“公式推导,教不教?”,为了加强学生学习能力的培养和数学思想方法的渗透,让师生更好的了解数学发展的价值,公式推导,不仅要教,而且要好好的教。

下面给出几种公式推导的方法,供教学参考。

给出一组具有线性相关关系的数据(x1,y1),(x2,y2),…,(xn,yn),且实数xi不全相等,求回归直线y=ax+b的斜率a和截距b,使得所有点相对于该直线的偏差平方和达到最小。

设实数xi不全相等,所求直线方程为y=ax+b要确定a,b,使函数f(a,b)=∑ni=1(axi+b-yi)2最小。

方法1[2]由于f(a,b)=∑ni=1[yi-axi-(-a)+(-a)-b]2=∑ni=1{[yi-axi-(-a)]2+2[yi-axi-(-a)]×[(-a)-b]+[(-a)-b]2}=∑ni=1[yi-axi-(-a)]2+2∑ni=1[yi-axi-(-a)]×[(-a)-b]+n[(-a)-b]2,注意到∑ni=1[yi-axi-(-a)][(-a)-b]=(-a-b)∑ni=1[yi-axi-(-a)]=(-a-b)[∑ni=1yi-a∑ni=1xi-n(-a)]=(-a-b)[n-na-n(-a)]=0,因此f(a,b)=∑ni=1[yi-axi-(-a)]2+n[(-a)-b]2=a2∑ni=1(xi-)2-2a∑ni=1(xi-)(yi-)+∑ni=1(yi-)2+n(-a-b)2=n(-a-b)2+∑ni=1(xi-)2[a-∑ni=1(xi-)(yi-)∑ni=1(xi-)2]2-[∑ni=1(xi-)(yi-)]2∑ni=1(xi-)2+∑ni=1(yi-)2在上式中,后两项和a,b无关,而前两项为非负数,因此要使f取得最小值,当且仅当前两项的值均为0,即a=∑ni=1(xi-)(yi-)∑ni=1(xi-)2,b=-a(其中x=1n∑ni=1xi,y=1n∑ni=1yi,(x,y)称为样本点的中心。

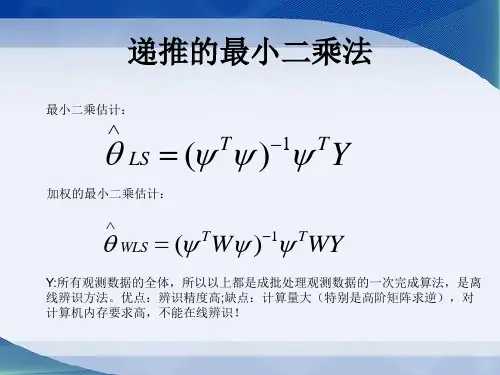

几种最小二乘法递推算法的小结最小二乘法是一种常见的参数估计方法,广泛应用于各个领域的数学和统计模型的拟合问题。

在实际应用中,我们常常需要递推地计算最小二乘法的结果,以便能够在实时数据到来的情况下,快速地更新参数估计值。

以下是几种常见的最小二乘法递推算法的小结。

1. 递推最小二乘法(Recursive least squares, RLS)递推最小二乘法是一种在线参数估计方法,可以在每次新数据到来时,快速地更新参数估计值。

RLS算法利用递推的方式,将历史数据和新数据的信息结合起来,从而得到最新的参数估计值。

该算法基于递归迭代过程,迭代公式中的权重矩阵可以由历史数据的协方差矩阵递推得到。

递推最小二乘法具有良好的收敛性和较低的计算复杂度。

2.递推最小二乘法的变种算法(RLS的变种算法)递推最小二乘法的变种算法是对传统的RLS算法进行改进和优化的方法。

其中,经典的改进算法有递归正交最小二乘法(Recursive orthogonal least squares, ROLS)和递推快速QR分解法(Recursive fast QR factorization, RFQR)。

ROLS算法通过引入正交化处理,解决了经典RLS算法中信号相关性较高时,参数估计不稳定的问题。

RFQR算法则通过对历史数据进行快速QR分解的方法,进一步提高了算法的计算速度,并降低了计算复杂度。

3. 渐进最小二乘法(Asymptotic least squares, ALS)渐进最小二乘法是一种常见的在线参数估计算法,用于解决参数估计问题的收敛速度较慢的情况。

ALS算法通过估计参数的渐进协方差矩阵,然后利用资料增益矩阵计算最新的参数估计值。

由于ALS算法不需要存储和计算全部历史数据的相关矩阵,因此可以在实时数据到来的情况下,快速地进行参数估计。

4. 数据辅助递推最小二乘法(Data-augmented recursive least squares, DARLS)数据辅助递推最小二乘法是一种常见的递推最小二乘法的改进算法,适用于当历史数据缺失或者不完整时。

广义最小二乘法和递推最小二乘法

广义最小二乘法和递推最小二乘法是最小二乘法算法的改进版本。

最小二乘法

是一种常见的统计学技术,它有效地估计未知参数集,也可以用于回归分析。

本文旨在详细介绍广义最小二乘法和递推最小二乘法。

首先让我们了解最小二乘法。

最小二乘法(Least Squares)是一种最常用的

方法,其中未知参数的估计量是穷举法的最优估计,这是一种很有效的技术。

最小二乘法的求解过程中,以平方的残差来最小化两个估计量的差异,以求得最优参数。

然而,最小二乘法有时也会出现缺陷,其中一个原因是可能会把噪声干扰包含

在结果中,另一个原因是它依赖被观测值的方差,而方差受因素影响。

因此,有了广义最小二乘法。

广义最小二乘法是在最小二乘法的基础上改进的算法。

在广义最小二乘法中,

我们通过加入惩罚参数来最小化残差,以对噪声进行抑制。

惩罚参数的加入,使得预测变更的安全降低,同时噪声的影响也可以得以抑制。

因此,广义最小二乘法在回归分析中也有广泛的应用。

此外,基于最小二乘法的另一种增强方法是“递推最小二乘法”。

递推最小二

乘法是将最小二乘法算法进行改良,从而改善对噪声的抑制能力。

和广义最小二乘法一样,递推最小二乘法也需要惩罚参数的加入。

递推最小二乘法也通过持续更新未知参数,来达到最小化残差的目的,从而能有效地抑制噪声。

以上就是本文要陈述的关于广义最小二乘法和递推最小二乘法的改进方法以及

它们的比较。

从技术上讲,广义最小二乘法和递推最小二乘法都比最小二乘法更能抑制噪声和拟合回归曲线,因此,它们在回归分析中都有广泛的应用。

递推最小二乘法原理递推最小二乘法(Recursive Least Squares, 简称RLS)是一种经典的自适应滤波算法,它在信号处理、通信系统、控制系统等领域得到了广泛的应用。

本文将介绍递推最小二乘法的原理及其在实际应用中的一些特点。

首先,让我们来了解一下最小二乘法。

最小二乘法是一种数学优化方法,用于寻找一组参数,使得给定的模型与观测数据之间的误差平方和最小。

在线性回归问题中,最小二乘法可以用来拟合一个线性模型,以最小化观测数据与模型预测值之间的差异。

最小二乘法的基本思想是通过最小化误差的平方和来寻找最优的参数。

递推最小二乘法是最小二乘法的一种变种,它的特点在于可以实时地更新参数估计,适用于需要动态调整的系统。

在实际应用中,由于系统参数可能随时间变化,传统的最小二乘法在每次参数更新时都需要重新计算整个数据集,计算复杂度较高,不适合实时性要求高的场景。

而递推最小二乘法则可以通过递推的方式,实时地更新参数估计,适用于动态环境下的参数估计问题。

递推最小二乘法的原理可以用数学公式来描述。

假设我们有一个线性模型,\[y_k = \theta^T x_k + e_k\]其中\(y_k\)是观测数据,\(x_k\)是输入向量,\(\theta\)是待估计的参数,\(e_k\)是噪声。

我们的目标是通过观测数据\(y_k\)和输入向量\(x_k\)来估计参数\(\theta\)。

递推最小二乘法的核心思想是通过递推的方式,实时地更新参数\(\theta\)的估计值。

具体来说,我们可以通过以下递推公式来更新参数\(\theta\)的估计值,\[\theta_k =\theta_{k-1} + \frac{P_{k-1}x_k}{1 + x_k^T P_{k-1} x_k}(y_k x_k^T \theta_{k-1})\]其中\(\theta_k\)是第\(k\)次的参数估计值,\(\theta_{k-1}\)是第\(k-1\)次的参数估计值,\(P_{k-1}\)是第\(k-1\)次的参数估计误差的协方差矩阵。

递推最小二乘法递推最小二乘法是一种避免精度损失的迭代计算方法,在最小二乘法的基础上加以改进,主要用于拟合复杂的数据,解决拟合时出现精度下降问题。

一、什么是递推最小二乘法递推最小二乘法是一种迭代计算方法,利用多项式曲线拟合曲线数据,对于某个曲线,只需要实施最小二乘法的迭代计算,而不需要考虑精度的损失。

递推最小二乘法的主要工作是根据给定的拟合曲线,把它拟合到数据集中,从而使数据集距离拟合曲线最小。

二、递推最小二乘法的原理递推最小二乘法的核心原理是,利用多项式拟合曲线,按照“最小二乘法”的原理,以当前拟合曲线为参照,不断进行前进和后退,以达到拟合曲线将数据集中的数据最佳拟合的目的。

这个最佳拟合目标就是实现拟合曲线与数据集之间的最小误差,其中,最小误差就是拟合曲线与实际数据集之间的最小差值。

递推最小二乘法的实现方式主要有两种,一种是基于递推的方式,另一种是基于函数的方式。

前者大致的实现方法是:先计算出多项式拟合曲线的每一个系数,然后再利用这些系数计算出多项式拟合曲线的最终拟合曲线,最后比较拟合曲线与实际数据集之间的实际差异,根据差异再调整系数,不断循环,直到最后拟合曲线与实际数据集之间的实际差异达到预期值为止。

函数的实现方式也很类似,只是在计算过程中,会使用函数的方式,将拟合曲线的系数表示为函数的形式,然后再比较拟合曲线与实际数据集之间的实际差异,根据差异再调整函数系数,最后实现拟合曲线与实际数据集之间的最小差异。

三、应用递推最小二乘法在实际应用中可以用来拟合复杂的数据曲线,以求得更好的拟合效果,解决拟合时出现精度下降问题。

它具有计算量小、运算简单、拟合结果较好的优点,因此在实际应用中得到了广泛的使用,比如在众多植物物种的遗传分析中,用递推最小二乘法来拟合植物的遗传规律,以获得更准确的估计结果;在探测地球大气层时,也可以用最小二乘法来拟合大气层中的湿度数据,以获取更加准确的湿度数据;在搜索引擎中,对查询结果也可以用最小二乘法拟合出来,以获得更准确的查询结果等等。

---------------------------------------------------------------最新资料推荐------------------------------------------------------各类最小二乘法比较最小二乘法(LS)最小二乘是一种最基本的辨识方法,最小二乘法可以用于线性系统,也可以用于非线性系统;可用于离线估计和在线估计。

在随机情况下,利用最小二乘法时,并不要求观测数据提供其概率统计方法的信息,而其估计结果,却有相当好的统计特性。

但它具有两方面的缺陷:一是当模型噪声是有色噪声时,最小二乘估计不是无偏、一致估计;二是随着数据的增长,将出现所谓的数据饱和现象。

针对这两个问题,出现了相应的辨识算法,如遗忘因子法、限定记忆法、偏差补偿法、增广最小二乘、广义最小二乘、辅助变量法、二步法及多级最小二乘法等。

广义最小二乘法(GLS)广义最小二乘法(GLS)广义最小二乘法的基本思想在于引入一个所谓成形滤波器(白化滤波器),把相关噪声转化成白噪声。

优:能够克服当存在有色噪声干扰时,基本最小二乘估计的有偏性,估计效果较好,在实际中得到较好的应用。

缺:1、计算量大,每个循环要调用两次最小二乘法及一次数据滤波,2、求差分方程的参数估值,是一个非线性最优化问题,不一定总能1 / 3保证算法对最优解的收敛性。

广义最小二乘法本质上是一种逐次逼近法。

对于循环程序的收敛性还没有给出证明。

3、GLS 算法的最小二乘指标函数 J 中可能存在一个以上局部极小值,(特别在信噪比不大时,J 可能是多举的)。

GLS 方法的估计结果往往取决于所选用参数的初始估值。

参数估计初值应选得尽量接近优参数。

在没有验前信息的情况下,最小二乘估值被认为是最好的初始条件。

4、广义最小二乘法的收敛速度不是很高。

递推最小二乘法(RLS)递推最小二乘法(RLS)优点:1、无需存储全部数据,取得一组观测数据便可估计一次参数,而且都能在一个采样周期中完成,所需计算量小,占用的存储空间小。

第一部分:程序设计思路、辨识结果分析和算法特点总结 (2)一:RLS遗忘因子法 (2)RLS遗忘因子法仿真思路和辨识结果 (2)遗忘因子法的特点: (3)二:RFF遗忘因子递推算法 (4)仿真思路和辨识结果 (4)遗忘因子递推算法的特点: (5)三:RFM限定记忆法 (5)仿真思路和辨识结果 (5)RFM限定记忆法的特点: (7)四:RCLS偏差补偿最小二乘法 (7)仿真思路和辨识结果 (7)RCLS偏差补偿最小二乘递推算法的特点: (9)五:增广最小二乘法 (9)仿真思路和辨识结果 (9)RELS增广最小二乘递推算法的特点: (11)六:RGLS广义最小二乘法 (12)仿真思路和辨识结果 (12)RGLS广义最小二乘法的特点: (14)七:RIV辅助变量法 (14)仿真思路和辨识结果 (14)RIV辅助变量法的特点: (16)八:Cor-ls相关最小二乘法(二步法) (17)仿真思路和辨识结果 (17)Cor-ls相关最小二乘法(二步法)特点: (18)九:MLS多级最小二乘法 (19)仿真思路和辨识结果 (19)MLS多级最小二乘法的特点: (22)十:yule_walker辨识算法 (23)仿真思路和辨识结果 (23)yule_walker辨识算法的特点: (24)第二部分:matlab程序 (24)一:RLS遗忘因子算法程序 (24)二:RFF遗忘因子递推算法 (26)三:RFM限定记忆法 (28)四:RCLS偏差补偿最小二乘递推算法 (31)五:RELS增广最小二乘的递推算法 (33)六;RGLS 广义最小二乘的递推算法 (36)七:Tally辅助变量最小二乘的递推算法 (39)八:Cor-ls相关最小二乘法(二步法) (42)九:MLS多级最小二乘法 (45)十yule_walker辨识算法 (49)第一部分:程序设计思路、辨识结果分析和算法特点总结一:RLS遗忘因子法RLS遗忘因子法仿真思路和辨识结果仿真对象如下:其中, v(k )为服从N(0,1)分布的白噪声。

各种最小二乘算法总结1. 一般最小二乘法例 1 考虑如下仿真对象z k 2 1.5 z k 1 0.7 z k u k1 0.5u k v k 其中,v k 为服从N 01 分布的白噪声。

输入信号u k采用M 序列,幅度为1。

M 序列由9 级移位寄存器产生,xi xi 4⊕xi 9 。

选择如下的辨识模型z k 2 a1 z k 1 a2 z k b1u k 1 b2u k vk 观测数据长度取L 400 。

加权阵取∧I 。

1.1. 一次计算最小二乘算法a1 -1.4916 θ LS a 2 H T H 1 H T Z 0.7005 1.1 L L L L 1.0364 b10.4268 b2 Z 3 hT 3 Z 2 Z 1 u 2 u 1 T其中,Z L Z 4 ,H h 4 Z 3 Z 2 u3 u 2 ... L ... ... ... ... ... Z 402 hT 402 Z 401 Z 400 u 401 u 400Matlab程序见附录1。

1.2. 递推最小二乘算法递推最小二乘算法公式:θ k θ kK k P k 1hk h k P k 1hk 1.2 ∧k Pk I K k h k Pk 11 K k z k h k θ k 1 1 13 盛晓婷最小二乘算法总结报告a1 3 初始条件θ 0 a 2 3 P0 100I 。

3 4×4 b1 3 b2经过编程计算,各个参数的估计值为a1 -1.4976 a2程序见附录2。

待估参数0.6802θ LS 1.0284 1.3 b1 0.3341 b2Matlab过渡过程 3 2.5 2 1.5 b1 1 a2 0.5 0 b2 -0.5 -1 a1 -1.5 -2 0 50 100 150200 250 300 350 400 450 图 1 一般最小二乘参数过渡过程 4 盛晓婷最小二乘算法总结报告估计方差变化过程100908070605040302010 0 0 50 100 150 200 250 300 350 400 450 图2 一般最小二乘方差变化过程 5 盛晓婷最小二乘算法总结报告 2.遗忘因子最小二乘算法采用的辨识模型与例1相同。

递推最小二乘法的一般步骤:1. 根据输入输出序列列出最小二乘法估计的观测矩阵ϕ:] )(u ... )1( )( ... )1([)(T b q n k k u n k y k y k ------=ϕ没有给出输出序列的还要先算出输出序列。

本例中, 2)]-u(k 1),-u(k 2),-1),-y(k -[-y(k )(T =k ϕ。

2. 给辨识参数θ和协方差阵P 赋初值。

一般取0θ=0或者极小的数,取σσ,20I P =特别大,本例中取σ=100。

3. 按照下式计算增益矩阵G :)()1()(1)()1()(k k P k k k P k G T ϕϕϕ-+-= 4. 按照下式计算要辨识的参数θ:)]1(ˆ)()()[()1(ˆ)(ˆ--+-=k k k y k G k k T θϕθθ5. 按照下式计算新的协方差阵P :)1()()()1()(---=k P k k G k P k P T ϕ6. 计算辨识参数的相对变化量,看是否满足停机准则。

如满足,则不再递推;如不满足,则从第三步开始进行下一次地推,直至满足要求为止。

停机准则:εϑϑϑ<--)(ˆ)1(ˆ)(ˆmax k k k i i i i 本例中由于递推次数只有三十次,故不需要停机准则。

7. 分离参数:将a 1….a na b 1….b nb 从辨识参数θ中分离出来。

8. 画出被辨识参数θ的各次递推估计值图形。

为了说明噪声对递推最小二乘法结果的影响,程序5-7-2在计算模拟观测值时不加噪声, 辨识结果为a1 =1.6417,a2 = 0.7148,b1 = 0.3900,b2 =0.3499,与真实值a1 =1.642, a2 = 0.715, b1 = 0.3900,b2 =0.35相差无几。

程序5-7-2-1在计算模拟观测值时加入了均值为0,方差为0.1的白噪声序列,由于噪声的影响,此时的结果为变值,但变化范围较小,现任取一组结果作为辨识结果。

最小二乘法超详细推导好,咱们聊聊最小二乘法,听起来是不是有点儿高大上?但其实它的原理就像是在生活中解决问题一样简单。

想象一下,你跟朋友约好一起去看电影,结果两个人的时间都不太对付,最后迟到了。

为了避免下次再犯错,你们想出一个办法:每次都提前半小时出门。

这就像最小二乘法,简单明了,追求一个更好的结果。

最小二乘法的基本思想就像是给一堆点点画线,想要找到一条“最佳”线,让这条线跟所有的点距离最小。

听上去有点抽象,但我给你举个例子。

假设你正在学习滑板,刚开始的时候,可能会摔得东倒西歪,根本控制不住。

你想要找出一个滑行的规律,比如,哪个角度、哪个姿势滑起来更顺畅。

于是你反复尝试,记录每次摔倒的位置,然后把所有这些点连起来,最后找到那个“最佳姿势”。

这就像是在求一个最小值,把每次摔倒的距离都尽量缩短。

让我们深入一点儿,最小二乘法的数学公式其实挺简单,咱们用y=ax+b来表示。

这里的y就像你想要达到的目标,比如说滑板的速度,x是你能控制的因素,比如滑板的角度。

a是斜率,代表你加速的程度,b则是你起步的高度。

听上去是不是有点像在调配一杯完美的饮料?如果把这几个变量调得刚刚好,恰到好处,那就能滑得又快又稳。

这时候,我们就要把所有的点放到图上,看看哪个点偏离得最多。

每个点到那条线的距离就像是你在追求完美的过程中产生的小失误。

咱们要做的,就是把这些距离的平方加起来,然后最小化,尽量让整体的偏差小到可忽略不计。

这个过程就像在追求一个完美的曲线,让你在滑板上飞翔的时候不再摔倒。

在实际操作中,我们往往需要用到一些数学工具,比如微积分。

听起来是不是有点吓人?别担心,其实就是为了找出那条最佳线的斜率和截距。

简单来说,就是要把所有的偏差搞清楚,给出一个准确的答案。

就像你在追求更好的生活方式,每天记录饮食和运动,最后找到那个最适合自己的节奏。

想象一下,咱们在找线的时候,就像在追寻自己的梦想。

每一次失败,每一次尝试,都是为了一条更完美的路径。

线性方程组的最优求解方法一.递推最小二乘法设线性方程组b Ax = (1)则有k b k =x :A ),(, (n k ,2,1=) (2)其中,[]kn k k a a a k ,,,:),(21 =A ,[]Tn x x x ,,,21 =x 。

设x :A ),()(k k f = (3)下面采用基于递推最小二乘法(RLS)的神经网络算法来训练权值向量x ,以获得线性方程组(1)的解x 。

由式(3)可知,若以)(k f 为神经网络输出,以k b 为神经网络训练样本,以x 为神经网络权值向量,[]kn k k a a a k ,,,:),(21 =A 为神经网络输入向量,则解线性方程组的神经网络模型如同1所示。

图1 神经网络模型采用RLS 算法训练神经网络权值向量x ,其算法如下:(1)神经网络输出:x :A ),()(k k f = (4)(2)误差函数:)()(k f b k e k -= (5)(3)性能指标:∑==n k k e J 12)(21 (6)(4)使min =J 的权值向量x ,即为所求的神经网络权值向量x ,这是一个多变量线性优化问题,为此,由0=∂∂xJ可得最小二乘递推法(RLS ):]),([1k k k k k k b x :A Q x x -+=+ (7)),(),(1),(:A P :A :A P Q k k k Tk T k k+= (8)k k k k P :A Q I P )],([1-=+ (9)()n k ,,2,1 =随机产生初始权值向量)1,(0n rand =x ,设n n ⨯∈=R I P α0(α是足够大的正数(一般取10610~10=α),n n ⨯∈R I 是单位矩阵),通过对样本数据训练,即可获得神经网络权值向量x ,此即为线性方程组(1)的解。

二.具有遗忘因子的递推最小二乘估计公式为:]),([1k k k k k k b x :A Q x x -+=+ (10)),(),(),(:A P :A :A P Q k k k Tk T k k+=λ (11)k k k k P :A Q I P )],([11-=+λ(12)式中,1:)],(:),([)(-=k A k A k T W P ,W 为加权对角阵:⎥⎥⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎢⎢⎣⎡=--10021λλλn n W(nn ⨯∈=R I P α0,10610~10=α)。

最小二乘法的公式推导嘿,咱们今天来好好唠唠最小二乘法的公式推导。

咱们先来说说为啥要研究这个最小二乘法。

就像我之前带的一个学生,小明,他特别喜欢研究植物的生长。

他每天都仔细地记录下植物的高度变化,想找出植物生长的规律。

这时候,最小二乘法就能派上用场啦。

那最小二乘法到底是个啥呢?简单来说,就是在一堆数据中找到一条最能“贴合”这些数据的直线或者曲线。

比如说,咱们有一组数据点(x1, y1),(x2, y2),(x3, y3)…… 那怎么找到那条最合适的线呢?咱们假设这条线的方程是 y = a + bx 。

那对于每个数据点(xi, yi),它到这条直线的垂直距离就是 yi - (a + bxi)。

这时候,咱们要让所有这些距离的平方和最小,这就是“最小二乘”的意思啦。

那怎么让这个和最小呢?这就得用到一些数学知识啦。

咱们先算这个距离平方和S = ∑(yi - (a + bxi))²。

接下来,咱们要分别对 a 和 b 求偏导数,让这两个偏导数都等于 0 。

对 a 求偏导数,得到:∂S/∂a = 2∑(yi - (a + bxi))(-1)。

让它等于 0 ,就有∑(yi - (a + bxi)) = 0 。

对 b 求偏导数,得到:∂S/∂b = 2∑(yi - (a + bxi))(-xi)。

让它等于 0 ,就有∑(yi - (a + bxi))xi = 0 。

把上面两个式子整理一下,就能得到关于 a 和 b 的方程组啦。

经过一番计算,咱们就能求出 a 和 b 的值,也就得到了那条最合适的直线的方程。

说回小明,他用最小二乘法处理他记录的植物生长数据,成功找到了植物生长高度和时间的关系,可把他高兴坏了。

所以啊,最小二乘法在处理数据、寻找规律方面可真是个厉害的工具。

不管是在科学研究,还是在日常生活中的数据分析,它都能帮咱们大忙。

咱们再深入琢磨琢磨。

假设咱们有另一组数据,比如说学生的考试成绩和他们的学习时间。

一、 递推最小二乘法

递推最小二乘法的一般步骤:

1. 根据输入输出序列列出最小二乘法估计的观测矩阵ϕ:

] )(u ... )1( )( ... )1([)(T b q n k k u n k y k y k ------=ϕ

没有给出输出序列的还要先算出输出序列。

本例中, 2)]-u(k 1),-u(k 2),-1),-y(k -[-y(k )(T

=k ϕ。

2. 给辨识参数θ和协方差阵P 赋初值。

一般取0θ=0或者极小的数,取σσ,20I P =特别大,本例中取σ=100。

3. 按照下式计算增益矩阵G : )

()1()(1)()1()(k k P k k k P k G T ϕϕϕ-+-= 4. 按照下式计算要辨识的参数θ:

)]1(ˆ)()()[()1(ˆ)(ˆ--+-=k k k y k G k k T θϕθθ

5. 按照下式计算新的协方差阵P :

)1()()()1()(---=k P k k G k P k P T ϕ

6. 计算辨识参数的相对变化量,看是否满足停机准则。

如满足,则不再递推;如不满足,

则从第三步开始进行下一次地推,直至满足要求为止。

停机准则:εϑϑϑ<--)

(ˆ)1(ˆ)(ˆmax k k k i i i i 本例中由于递推次数只有三十次,故不需要停机准则。

7. 分离参数:将a 1….a na b 1….b nb 从辨识参数θ中分离出来。

8. 画出被辨识参数θ的各次递推估计值图形。

为了说明噪声对递推最小二乘法结果的影响,程序5-7-2在计算模拟观测值时不加噪

声,

辨识结果为a1 =1.6417,a2 = 0.7148,b1 = 0.3900,b2 =0.3499,与真实值a1 =1.642, a2 = 0.715, b1 = 0.3900,b2 =0.35相差无几。

程序5-7-2-1在计算模拟观测值时加入了均值为0,方差为0.1的白噪声序列,由于噪

声的影响,此时的结果为变值,但变化范围较小,现任取一组结果作为辨识结果。

辨识结果为a1 =1.5371, a2 = 0.6874, b1 = 0.3756,b2 =0.3378。

程序5-7-2-2在计算模拟观测值时加入了有色噪声,有色噪声为

E(k)+1.642E(k-1)+0.715E(k-2),E(k)是均值为0,方差为0.1的白噪声序列,由于有色噪声的影响,此时的辨识结果变动范围远比白噪声时大,任取一组结果作为辨识结果。

辨识结果为a1 =1.6676, a2 = 0.7479, b1 = 0.4254,b2 =0.3965。

可以看出,基本的最小二乘法不适用于有色噪声的场合。

二、 广义最小二乘法

广义最小二乘法适用于AR 模型,它的基本思想在于对数据先进行一次白化滤波处理,然后利用基本的最小二乘法对滤波后的数据进行辨识。

广义最小二乘法的递推算法步骤如下:

1. 给定初始条件:

⎪⎪⎩⎪⎪⎨⎧====I

)0(P 0

)0(ˆ(I )0(P 0)0(ˆ(e))(2(f)e θσσθ特别大)或者极小值

2.利用

⎪⎩⎪⎨⎧==--)

()()()()()(1(f)1(f)k u z C k u k y z C k y 计算)()(k y

f 及)()(k u f 。

3.利用 ] )(...u )1( )( ... )1([)(T )()()()()(b f f q f f f n k k u n k y k y k ------=ϕ

构造滤波后的观测矩阵)()(k f ϕ。

本例中, 2)]-(k u 1),-(k u 2),-(k 1),-y -(k [-y )(T )()()()()(f f f f f k =ϕ。

4.利用下式估计递推计算1

ˆ+N θ ⎪⎪⎪⎩

⎪⎪⎪⎨⎧---=+-=--+-=)()()()()()()()()()()()()()()1()()()1()()()(1)()1()()]1(ˆ)()([)()1(ˆ)(ˆf T f f f f f N f T f f f f T f f f k P k k G k P k P k P k k k P k G k k k y k G k k ϕϕϕϕθϕθθ 5.由新得到的)(ˆk θ

计算出新的残差估计值)(ˆk e ,并构造残差数据向量 由滤波前的观测向量

] )(u ... )1( )( ... )1([)(T b a n k k u n k y k y k ------=ϕ计算出新的残差估计值)(ˆk e

)(ˆ)()()(ˆk k k y k e

T θϕ-= 残差数据向量T c e n k e k e

k )](ˆ ... )1(ˆ[)()(----=ϕ。

6. 利用下式估计递推计算)()(ˆe k θ

⎪⎪⎪⎩

⎪⎪⎪⎨⎧---=-+-=--+-=)()()()()()(1)()()()()()()()()()()1()()()1()()()1()(1)()1()(])1(ˆ)()(ˆ[)()1(ˆ)(ˆe T e e e e e e T e e e e e T e e e e k P k k G k P k P k k P k k k P k G k k k e k G k k ϕϕϕϕθϕθθ 7.返回第2步进行迭代计算,直至获得满意的辨识结果。

程序5-7-4使用广义最小二乘法,得到的结果为a1 =1.6363,a2 =0.7172,b1 = 0.3679,b2 = 0.3603,c0 =-0.6951, c1 =-0.0214,结果a1、a2、b1、b2与真实值结果a1 =1.642, a2 = 0.715, b1 = 0.39,b2 =0.35较为接近,但c0、c1与真实值1、-0.4相差较远。

三、 增广最小二乘法

增广最小二乘法是最小二乘法的一种推广,它只是扩充了参数向量θ和数据向量)(k ϕ的

维数,在辨识过程中考虑了噪声模型的参数,适用于MA 模型。

增广最小二乘法的一般步骤如下:

1.根据输入输出序列以及噪声序列列出增广最小二乘法估计的数据向量ϕ: ] )( ... )1( )( )(u ... )1( )( ... )1([)(T d b a n k k k n k k u n k y k y k --------=εεεϕ 没有给出输出序列的还要先算出输出序列。

本例中, ])2(, )1(, )( 2),-u(k 1),-u(k 2),-1),-y(k -[-y(k )(T

--=k k k k εεεϕ。

9. 给辨识参数θ和协方差阵P 赋初值。

一般取0θ=0或者极小的数,取σσ,20I P =特别大,本例中取σ=100。

10. 按照下式计算增益矩阵G : )

()1()(1)()1()(k k P k k k P k G T ϕϕϕ-+-= 11. 按照下式计算要辨识的参数θ:

)]1(ˆ)()()[()1(ˆ)(ˆ--+-=k k k y k G k k T θϕθθ

12. 按照下式计算新的协方差阵P :

)1()()()1()(---=k P k k G k P k P T ϕ

13. 计算辨识参数的相对变化量,看是否满足停机准则。

如满足,则不再递推;如不满足,

则从第三步开始进行下一次地推,直至满足要求为止。

停机准则:εϑϑϑ<--)

(ˆ)1(ˆ)(ˆmax k k k i i i i

本例中由于递推次数只有三十次,故不需要停机准则。

14. 分离参数:将a 1….a na b 1….b nb d 1…d nd 从辨识参数θ中分离出来。

15. 画出被辨识参数θ的各次递推估计值图形。

由以上可见,递推增广最小二乘法的算法与基本最小二乘法的递推算法形式是一致的,只是参数向量θ和数据向量)(k ϕ的维数扩充了m 维。

程序5-7-5在是运用增广最小二乘法来辨识系统参数,得到的结果为a1 =1.6412,a2 = 0.7144,b1 = 0.3900,b2 =0.3497,d0=0.9992,d1=1.6417,d2=0.7145与真实值a1 =1.642, a2 = 0.715, b1 = 0.3900,b2 =0.35, d0=1,d1=a1=1.642,d2=a2=0.7145相差无几。