CUDA基本介绍

- 格式:pdf

- 大小:1.02 MB

- 文档页数:73

显卡中CUDA是什么及作用介绍显卡中CUDA是什么及作用介绍自第一台计算机ENIAC发明以来,计算机系统的技术已经得到了很大的发展,但计算机硬件系统的基本结构没有发生变化,仍然属于冯·诺依曼体系计算机。

计算机硬件系统仍然由运算器,控制器,存储器,输入设备和输出设备5部分组成。

以下是小编整理的显卡中CUDA是什么及作用介绍,欢迎阅读。

CUDA(Compute Unified Device Architecture),显卡厂商NVidia推出的运算平台。

CUDA是一种由NVIDIA推出的通用并行计算架构,该架构使GPU能够解决复杂的计算问题。

它包含了CUDA 指令集架构(ISA)以及GPU内部的并行计算引擎。

计算行业正在从只使用CPU的“中央处理”向CPU与GPU并用的“协同处理”发展。

为打造这一全新的计算典范,NVIDIA(英伟达)发明了CUDA(Compute Unified Device Architecturem,统一计算设备架构)这一编程模型,是想在应用程序中充分利用CPU和GPU各自的优点。

现在,该架构现已应用于GeForce(精视)、ION(翼扬)、Quadro以及Tesla GPU(图形处理器)上,对应用程序开发人员来说,这是一个巨大的市场。

在消费级市场上,几乎每一款重要的`消费级视频应用程序都已经使用CUDA加速或很快将会利用CUDA来加速,其中不乏Elemental Technologies公司、MotionDSP公司以及LoiLo公司的产品。

在科研界,CUDA一直受到热捧。

例如,CUDA现已能够对AMBER进行加速。

AMBER是一款分子动力学模拟程序,全世界在学术界与制药企业中有超过60,000名研究人员使用该程序来加速新药的探索工作。

在金融市场,Numerix以及CompatibL针对一款全新的对手风险应用程序发布了CUDA支持并取得了18倍速度提升。

Numerix为近400家金融机构所广泛使用。

cuda constant memory上限-概述说明以及解释1.引言1.1 概述部分:在计算机科学领域,CUDA技术已经成为一种广泛应用的并行计算框架。

CUDA技术通过利用GPU的强大并行计算能力,有效提高了计算性能,加快了各种科学和工程计算任务的执行速度。

在CUDA编程中,常量内存是一种特殊的内存区域,被设计用来存储在应用程序执行过程中不会发生改变的数据。

本文将重点讨论CUDA常量内存的使用限制,即常量内存的上限,并分析影响常量内存上限的因素。

通过深入探讨这些问题,可以帮助开发者更好地使用CUDA技术,优化并发计算任务的执行效率。

1.2 文章结构本文将分为三个主要部分,即引言、正文和结论。

在引言部分,将对整篇文章进行概述,并说明文章的结构和目的。

正文部分将包括三个小节。

首先,将简要介绍CUDA技术,包括其背景和基本概念。

其次,将详细介绍CUDA常量内存的概念、特点和用途。

最后,将对CUDA常量内存的上限进行分析,探讨其影响因素和解决方法。

在结论部分,将对文章所述内容进行总结,并指出影响CUDA常量内存上限的因素。

最后,将展望CUDA常量内存技术的未来发展趋势。

1.3 目的:本文旨在探讨CUDA常量内存的上限问题,通过对CUDA技术和常量内存的介绍,分析常量内存的使用限制以及影响因素,为开发者在使用CUDA常量内存时提供参考和指导。

同时,展望未来可能的解决方案和发展趋势,以期为CUDA编程的优化和性能提升提供帮助。

}}请编写文章1.3 目的部分的内容2.正文2.1 CUDA技术简介CUDA(Compute Unified Device Architecture)是由NVIDIA推出的一种用于通用计算的并行计算架构,它允许开发人员使用基于NVIDIA GPU的并行计算能力来加速应用程序的运行速度。

CUDA技术利用GPU的大量并行处理单元,可以在处理数据密集型任务时实现比传统CPU更高的性能和效率。

CUDA编程之快速⼊门CUDA(Compute Unified Device Architecture)的中⽂全称为计算统⼀设备架构。

做图像视觉领域的同学多多少少都会接触到CUDA,毕竟要做性能速度优化,CUDA是个很重要的⼯具,CUDA是做视觉的同学难以绕过的⼀个坑,必须踩⼀踩才踏实。

CUDA编程真的是⼊门容易精通难,具有计算机体系结构和C语⾔编程知识储备的同学上⼿CUDA编程应该难度不会很⼤。

本⽂章将通过以下五个⽅⾯帮助⼤家⽐较全⾯地了解CUDA编程最重要的知识点,做到快速⼊门:1. GPU架构特点2. CUDA线程模型3. CUDA内存模型4. CUDA编程模型5. CUDA应⽤⼩例⼦1. GPU架构特点⾸先我们先谈⼀谈串⾏计算和并⾏计算。

我们知道,⾼性能计算的关键利⽤多核处理器进⾏并⾏计算。

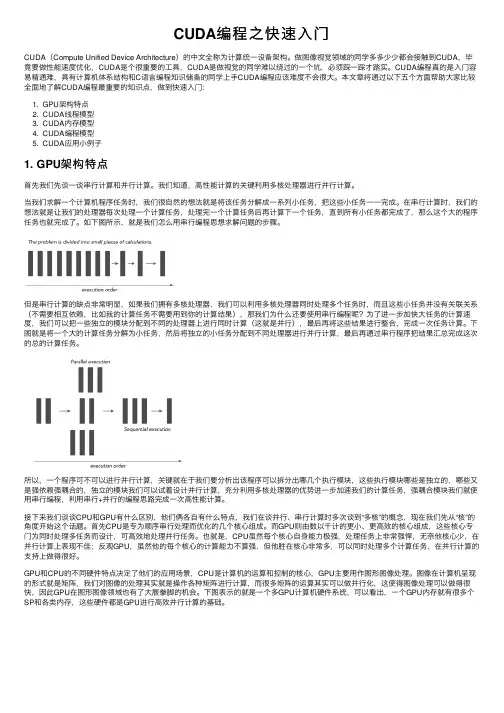

当我们求解⼀个计算机程序任务时,我们很⾃然的想法就是将该任务分解成⼀系列⼩任务,把这些⼩任务⼀⼀完成。

在串⾏计算时,我们的想法就是让我们的处理器每次处理⼀个计算任务,处理完⼀个计算任务后再计算下⼀个任务,直到所有⼩任务都完成了,那么这个⼤的程序任务也就完成了。

如下图所⽰,就是我们怎么⽤串⾏编程思想求解问题的步骤。

但是串⾏计算的缺点⾮常明显,如果我们拥有多核处理器,我们可以利⽤多核处理器同时处理多个任务时,⽽且这些⼩任务并没有关联关系(不需要相互依赖,⽐如我的计算任务不需要⽤到你的计算结果),那我们为什么还要使⽤串⾏编程呢?为了进⼀步加快⼤任务的计算速度,我们可以把⼀些独⽴的模块分配到不同的处理器上进⾏同时计算(这就是并⾏),最后再将这些结果进⾏整合,完成⼀次任务计算。

下图就是将⼀个⼤的计算任务分解为⼩任务,然后将独⽴的⼩任务分配到不同处理器进⾏并⾏计算,最后再通过串⾏程序把结果汇总完成这次的总的计算任务。

所以,⼀个程序可不可以进⾏并⾏计算,关键就在于我们要分析出该程序可以拆分出哪⼏个执⾏模块,这些执⾏模块哪些是独⽴的,哪些⼜是强依赖强耦合的,独⽴的模块我们可以试着设计并⾏计算,充分利⽤多核处理器的优势进⼀步加速我们的计算任务,强耦合模块我们就使⽤串⾏编程,利⽤串⾏+并⾏的编程思路完成⼀次⾼性能计算。

cuda中文手册

CUDA中文手册(CUDA中文手册【原创版】)包括以下内容:

1. CUDA 概述:CUDA 是 NVIDIA 推出的一种通用并行计算架构,旨在利用 NVIDIA GPU 进行高性能计算。

2. CUDA 安装与配置:介绍如何安装和配置 CUDA,以便在 NVIDIA GPU 上运行并行计算。

3. CUDA 编程模型:介绍 CUDA 的编程模型,包括线程块、线程和共享内存等概念。

4. CUDA 内存管理:介绍 CUDA 中的内存类型和内存管理机制。

5. CUDA 线程组织:介绍 CUDA 中的线程组织方式和线程同步机制。

6. CUDA 性能优化:介绍如何优化 CUDA 程序的性能,包括减少内存访问延迟、提高并行度等。

7. CUDA 应用实例:介绍一些 CUDA 的应用实例,包括科学计算、图像处理等领域。

总的来说,CUDA 中文手册是全面介绍 CUDA 的中文资料,可以帮助开发者更好地理解和使用 CUDA,提高程序的性能和效率。

cudagraphicsglregisterbuffer 使用-概述说明以及解释1.引言1.1 概述CUDA(Compute Unified Device Architecture)是一种由英伟达(NVIDIA)推出的并行计算平台和编程模型,能够利用GPU的并行计算能力来加速计算密集型应用程序。

而OpenGL(Open Graphics Library)是一种用于渲染2D和3D矢量图形的跨平台图形库。

在现代计算机应用程序中,往往需要同时利用GPU加速计算和提供图形渲染功能。

为了实现这种融合,CUDA和OpenGL提供了一种互操作性机制,使得开发人员可以在CUDA核函数中直接操作OpenGL绑定的缓冲区对象。

其中,glRegisterBuffer函数就是CUDA Graphics中的一个重要函数,用于将OpenGL的缓冲区对象注册为CUDA图形资源,实现CUDA和OpenGL之间的数据共享和互操作。

本文将介绍CUDA Graphics中的glRegisterBuffer函数的使用方法和注意事项,结合示例和应用场景,帮助读者了解如何在CUDA和OpenGL之间实现高效的数据互操作,以及未来该技术的发展方向和应用前景。

1.2 文章结构本文将首先介绍CUDA Graphics Interoperability的基本概念和原理,以及其与OpenGL之间的关系。

然后,重点讨论如何使用CUDA Graphics中的glRegisterBuffer函数来实现CUDA与OpenGL之间的数据交互。

接下来,我们将通过具体的示例和实际应用来说明glRegisterBuffer函数的使用方法和效果。

最后,我们将对CUDA Graphics与OpenGL之间的互操作性进行总结,并分析glRegisterBuffer 函数的优势和适用场景。

最后,我们将展望未来CUDA与OpenGL之间更深入的合作和发展。

1.3 目的本文的目的是介绍如何使用CUDA Graphics中的glRegisterBuffer 函数实现CUDA与OpenGL之间的数据交互,以及探讨glRegisterBuffer 的优势和适用场景。

cuda常用的数学库CUDA(Compute Unified Device Architecture)是一种并行计算平台和编程模型,用于利用GPU(图形处理器)进行高性能计算。

在CUDA编程中,数学库是非常重要的工具,它提供了丰富的数学函数来支持各种数值计算任务。

本文将介绍CUDA常用的数学库及其功能。

1. CUDA Math Library(cuBLAS):cuBLAS是CUDA的基本线性代数库,提供了丰富的线性代数运算函数,如矩阵乘法、矩阵转置、矩阵求逆等。

它能够充分利用GPU的并行计算能力,加速线性代数运算任务。

2. CUDA Random Number Generation(cuRAND):cuRAND是CUDA的随机数生成库,提供了各种随机数生成函数,如均匀分布、正态分布、泊松分布等。

它能够高效地生成大量随机数,并利用GPU的并行计算能力进行加速。

3. CUDA Fast Fourier Transform(cuFFT):cuFFT是CUDA的快速傅里叶变换库,提供了各种快速傅里叶变换函数,如一维傅里叶变换、二维傅里叶变换、多维傅里叶变换等。

它能够高效地进行信号和图像处理任务,如滤波、频域分析等。

4. CUDA Sparse Linear Algebra Library(cuSPARSE):cuSPARSE 是CUDA的稀疏线性代数库,提供了各种稀疏矩阵运算函数,如稀疏矩阵乘法、稀疏矩阵转置等。

它能够高效地处理大规模稀疏矩阵,节省内存和计算资源。

5. CUDA Performance Primitives(NPP):NPP是CUDA的性能优化库,提供了各种图像和信号处理函数,如图像滤波、图像变换、信号采样等。

它能够高效地进行图像和信号处理任务,加速计算过程。

6. CUDA Math Library(cuBLAS):cuBLAS是CUDA的基本线性代数库,提供了丰富的线性代数运算函数,如矩阵乘法、矩阵转置、矩阵求逆等。

cuda c++ 编译cmakelist 概述及解释说明1. 引言1.1 概述本文将介绍CUDA C++编译CMakeList的概述及解释说明。

随着计算机科学的快速发展,图形处理单元(GPU)已经成为并行计算领域的重要组成部分。

CUDA C++作为一种用于并行计算的编程语言,能够有效利用GPU的强大计算能力,从而提高程序的性能。

本文将重点讨论如何使用CMakeList来编译CUDA C++代码。

CMake是一个跨平台的自动化构建工具,它可以根据不同平台和编译器生成相应的构建脚本,并简化项目配置和管理过程。

通过使用CMakeList,我们可以轻松地管理项目中的源文件、头文件路径以及CUDA编译器选项和链接库依赖关系,从而方便地进行CUDA C++代码编译。

1.2 文章结构本文共分为四个部分:引言、CUDA C++ 编译CMakeList概述、CUDA C++ 编译CMakeList正文和结论。

在引言中,我们将对文章进行概述并介绍其结构。

接下来,在第二部分中,我们将详细探讨什么是CUDA C++编译以及CMakeList 简介,并对CUDA编译器选项进行解释说明。

然后,在第三部分中,我们将重点介绍如何设置项目和版本号信息、添加源文件和头文件路径以及配置CUDA 编译选项和链接库依赖关系。

最后,在结论部分,我们将总结主要要点,并对CUDA C++编译CMakeList进行展望和提出建议。

1.3 目的本文的目的是提供一个全面的指南,帮助读者了解和掌握使用CMakeList来编译CUDA C++代码的过程。

通过学习本文,读者将能够清晰地理解如何设置项目和版本号信息、添加源文件和头文件路径以及配置CUDA编译选项和链接库依赖关系。

此外,本文还将提供一些展望和建议,帮助读者进一步优化他们的CUDA C++编译CMakeList流程,并改善代码性能。

无论是初学者还是有一定经验的开发人员,都可以从本文中获得实用而宝贵的知识。

cuda标准库介绍

CUDA(Compute Unified Device Architecture)是由NVIDIA

推出的并行计算平台和编程模型,用于利用GPU进行通用目的的并

行计算。

CUDA标准库是CUDA平台提供的一组库函数,用于支持并

行计算和GPU编程。

下面我将从多个角度介绍CUDA标准库。

首先,CUDA标准库提供了一系列的数学函数,包括基本的数学

运算(如加减乘除、取模等)、三角函数、指数函数、对数函数、

双曲函数等。

这些函数可以直接在GPU上进行并行计算,加速数值

计算和科学计算应用。

其次,CUDA标准库还包括了一些图像处理相关的函数,如图像

滤波、图像转换、图像合成等。

这些函数可以帮助开发人员在GPU

上实现高效的图像处理算法,加速图像处理和计算机视觉应用。

此外,CUDA标准库还提供了一些并行算法和数据结构,如并行

排序、并行归约、并行扫描等。

这些算法和数据结构可以帮助开发

人员在GPU上实现高效的并行计算,充分发挥GPU的并行计算能力。

除此之外,CUDA标准库还包括了一些输入输出相关的函数,如

文件读写、内存拷贝等。

这些函数可以帮助开发人员在GPU和主机之间进行数据传输,实现高效的数据交换和通信。

总的来说,CUDA标准库为开发人员提供了丰富的函数库,可以帮助他们在GPU上实现高效的并行计算和并行算法,加速各种科学计算、图像处理和并行计算应用。

同时,开发人员也可以通过CUDA 标准库来充分发挥GPU的并行计算能力,实现更加复杂和高效的计算任务。

CUDA基本介绍CUDA的出现源于对传统CPU计算能力的限制。

在传统的串行计算模式下,CPU只能执行一个指令,一个时钟周期只能执行一个操作数。

随着计算需求的增加,CPU的计算性能逐渐达到瓶颈。

而GPU拥有大量的计算核心,可以并行执行大量的计算任务,提供了与CPU不同的计算模式。

CUDA利用GPU的并行计算能力,为开发人员提供了更高的计算性能和自由度。

CUDA的核心编程模型是将计算任务分解成多个线程,并交由GPU进行并行计算。

开发人员可以使用CUDA编程模型中的线程层次结构,将线程组织成线程块(block)和线程网格(grid),并根据应用的需求将任务分配给GPU执行。

每个线程都有自己的ID,可以执行独立的计算任务。

线程块是线程的集合,可以同步和共享数据。

线程网格则由多个线程块组成,可以分配和管理线程块的执行。

CUDA提供了一套丰富的编程接口和库,开发人员可以使用C、C++、Fortran等语言来编写CUDA程序。

CUDA的编程接口负责管理GPU资源、数据传输和计算任务的调度。

开发人员可以通过编写CUDA核函数,将需要大量计算的任务分配给GPU执行。

在CUDA核函数中,开发人员可以使用NVIDIA提供的GPU并行计算指令集(SIMD指令集)来执行计算任务。

此外,CUDA还提供了一些常用的数学和向量运算库,如cuBLAS、cuFFT和cuDNN,方便开发人员进行科学计算、信号处理和深度学习等应用。

CUDA的应用范围十分广泛。

首先,CUDA适用于各种科学计算和数字信号处理应用。

CUDA可以加速矩阵运算、信号滤波、图像处理等任务,提高计算速度和效率。

其次,CUDA也适用于机器学习和深度学习领域。

利用GPU的并行计算能力,CUDA可以加速神经网络的训练和推断过程,加快模型的收敛速度。

此外,CUDA还可以用于虚拟现实(VR)和游戏领域,高性能的图像处理能力可以提供更流畅和真实的视觉效果。

总之,CUDA是一种高效的并行计算平台和应用编程接口,为开发人员提供了利用GPU进行通用目的的并行计算的能力。

CUDA定义的数组最大值一、背景介绍在计算机科学和并行计算领域,CUDA(Compute Unified Device Architecture)是由NVIDIA开发的一种并行计算平台和编程模型。

它允许开发者使用C、C++、Fortran等编程语言在NVIDIA GPU上进行高性能计算。

CUDA广泛应用于科学计算、深度学习、图形处理等领域,在处理大规模数据集时具有显著的优势。

在CUDA中,数组是一种常见的数据结构,用于存储和处理大量的数据。

而寻找数组中的最大值是一个常见的问题,本文将介绍如何在CUDA中定义数组并找到其中的最大值。

二、CUDA数组定义在CUDA中,我们可以使用一维或多维数组来存储数据。

CUDA数组的定义和使用与普通的C/C++数组类似,但需要使用CUDA提供的特定语法和函数来管理和操作数组。

2.1 一维数组定义一维数组是最简单的一种数组形式,它由一个连续的内存块组成,每个元素在内存中的地址是连续的。

在CUDA中,我们可以使用以下方式定义一维数组:// 定义一维数组int array[N];上述代码中,N表示数组的大小,int表示数组元素的类型。

我们可以根据实际需要替换int为其他类型,如float、double等。

2.2 多维数组定义多维数组是由多个一维数组组成的,可以看作是一个矩阵。

在CUDA中,我们可以使用以下方式定义多维数组:// 定义二维数组int array[M][N];上述代码中,M和N分别表示数组的行数和列数,int表示数组元素的类型。

同样,我们可以根据实际需要替换int为其他类型。

三、寻找数组最大值在CUDA中,寻找数组中的最大值是一个常见的问题。

我们可以使用不同的算法和方法来实现这个目标。

3.1 串行算法串行算法是最直观和简单的方法,它通过遍历数组的所有元素来找到最大值。

以下是一个使用串行算法寻找一维数组最大值的示例代码:int findMax(int array[], int size) {int max = array[0];for (int i = 1; i < size; i++) {if (array[i] > max) {max = array[i];}}return max;}上述代码中,array表示输入的一维数组,size表示数组的大小。