八爪鱼验证码登陆-控件识别方法(7.0版本)

- 格式:docx

- 大小:817.53 KB

- 文档页数:12

微信公众号文章采集详细步骤对于某些用户来说,直接自定义规则可能有难度,所以在这种情况下,我们提供了网页简易模式,网页简易模式下存放了国内一些主流网站爬虫采集规则,在你需要采集相关网站时可以直接调用,节省了制作规则的时间以及精力。

所以本次介绍八爪鱼简易采集模式下“微信文章采集”的使用教程以及注意要点。

微信文章采集下来有很多作用,比如可以将自己行业中最近一个月之内发布的内容采集下来,然后分析文章标题和内容的一个方向与趋势。

微信公众号文章采集使用步骤步骤一、下载八爪鱼软件并登陆1、打开/download,即八爪鱼软件官方下载页面,点击图中的下载按钮。

2、软件下载好了之后,双击安装,安装完毕之后打开软件,输入八爪鱼用户名密码,然后点击登陆步骤二、设置微信文章爬虫规则任务1、进入登陆界面之后就可以看到主页上的网站简易采集了,选择立即使用即可。

2、进去之后便可以看到目前网页简易模式里面内置的所有主流网站了,需要采集微信公众号内容的,这里选择搜狗即可。

3、找到搜狗公众号这条爬虫规则,点击即可使用。

4、搜狗公众号简易采集模式任务界面介绍查看详情:点开可以看到示例网址任务名:自定义任务名,默认为搜狗公众号任务组:给任务划分一个保存任务的组,如果不设置会有一个默认组公众号URL列表填写注意事项:提供要采集的网页网址,即搜狗微信中相关公众号的链接。

多个公众号输入多个网址即可。

采集数目:输入希望采集的数据条数示例数据:这个规则采集的所有字段信息。

5、微信文章爬虫规则设置示例例如要采集相关旅游、美食的公众号文章在设置里如下图所示:任务名:自定义任务名,也可以不设置按照默认的就行任务组:自定义任务组,也可以不设置按照默认的就行商品评论URL列表:/weixin?type=1&s_from=input&query=电影&ie=utf8&_sug_=n&_sug_type_=/weixin?type=1&s_from=input&query=美食&ie=utf8&_sug_=n&_sug_type_=一行一个,使用回车(Enter)进行换行。

美团爬虫使用方法美团网拥有全网最全最多的商户信息,涵盖了美食攻略,外卖网上订餐,酒店预订,旅游团购,飞机票火车票,电影票,ktv团购等各种项目,吃喝玩乐都可以满足你。

所以无论你是商家还是用户,都可以抓取下来上面你想要的数据,再做对比,分析,做出最有利的决策。

本次介绍八爪鱼简易采集模式下“美团数据抓取”的使用教程以及注意要点。

美团爬虫使用步骤步骤一、下载八爪鱼软件并登陆1、打开/download,即八爪鱼软件官方下载页面,点击图中的下载按钮。

2、软件下载好了之后,双击安装,安装完毕之后打开软件,输入八爪鱼用户名密码,然后点击登陆步骤二、设置美团数据抓取规则任务1、进入登陆界面之后就可以看到主页上的网站简易采集了,选择立即使用即可。

2、进去之后便可以看到目前网页简易模式里面内置的所有主流网站了,需要采集美团内容的,这里选择第四个--美团即可。

3、找到美团-》商家信息-关键词搜索这条爬虫规则,点击即可使用。

4、美团-商家信息-关键词搜索简易采集模式任务界面介绍查看详情:点开可以看到示例网址任务名:自定义任务名,默认为美食商家列表信息采集任务组:给任务划分一个保存任务的组,如果不设置会有一个默认组城市页面地址:输入你要在美团网上采集的城市url(可放入多个)搜索关键词:设置你要搜索的关键词,填入即可示例数据:这个规则采集到的所有字段信息。

5、美团数据抓取规则设置示例例如要采集南昌市所有烧烤类的商家信息在设置里如下图所示:任务名:自定义任务名,也可以不设置按照默认的就行任务组:自定义任务组,也可以不设置按照默认的就行城市页面地址:/搜索关键词:烧烤注意事项:URL列表中建议不超过2万条,大量的URL可以通过八爪鱼先抓取美团里每一个城市的url,少量可直接去浏览器里获取。

步骤三、保存并运行美团数据抓取规则1、设置好爬虫规则之后点击保存。

2、保存之后,点击会出现开始采集的按钮。

3、选择开始采集之后系统将会弹出运行任务的界面,可以选择启动本地采集(本地执行采集流程)或者启动云采集(由云服务器执行采集流程),这里以启动本地采集为例,我们选择启动本地采集按钮。

贴吧采集器使用教程本文介绍使用八爪鱼采集器采集百度贴吧帖子内容的方法。

在这里仅仅以其中一个帖子举例说明:旅行贴吧的某个帖子(【集中贴】2018年1、2月出发寻同行的请进来登记)采集内容包括:贴吧帖子内容,贴吧用户昵称使用功能点:●创建循环翻页●修改Xpath步骤1:创建百度贴吧帖子内容采集任务1)进入主界面,选择“自定义采集”2)将要采集的网站URL复制粘贴到输入框中,点击“保存网址”步骤2:创建循环翻页1)网页打开以后,鼠标下拉到最底部,选择下一页,提示框中选择“循环点击下一页”2)鼠标选中帖子的回复,在右面的提示框中选择“选中全部”2)如果要采集贴吧的其他信息,也可以选择,这里选择的是贴吧昵称,贴吧昵称。

接着选择“采集元素”,把不必要的字段删除。

步骤3:修改XPATH1)保存采集后发现有些帖子内容没有正确采集,所以需要修改XPATH,打开右上角的流程按钮2)点击循环选项,“循环方式”选择“不固定元素列表”,“不固定元素列表”XPATH://div[@class="l_post j_l_post l_post_bright "]。

填入2)点击“提取数据”,修改贴吧帖子内容XPATH。

选中帖子内容字段,依次点击“自定义数据字段”->“自定义元素定位方式”,并设置:元素匹配的XPATH://div[@class="l_post j_l_post l_post_bright "]//div[@class="d_post_content j_d_post_content clearfix"]相对XPATH://div[@class="d_post_content j_d_post_content clearfix"]选中帖子内容字段自定义数据字段位置帖子内容字段数据提取xpath设置3) 修改贴吧用户昵称XPATH 。

网页指定文本提取方法如何利用工具提取指定网页文本?本文介绍采集使用八爪鱼7.0采集金融数据(以平安车险采集为例)的方法采集网站:/baoxianchanpin/index.shtml采集的内容包括:车险名称,车险价格使用功能点:●∙Ajax翻页●∙分页循环创建步骤1:创建金融数据采集任务1、进入主界面选择,选择自定义模式2、将上面网址的网址复制粘贴到网站输入框中,点击“保存网址”3、打开网页后,鼠标选中“健康保险”,在提示框中选择“更多操作”接着选择“点击该元素”步骤2:创建翻页循环●∙找到翻页按钮,设置翻页循环●∙设置ajax翻页时间1、将页面下拉到底部,找到下一页按钮,鼠标点击,在右侧操作提示框中,选择“循环点击下一页”步骤3:分页表格信息采集●∙选中需要采集的字段信息,创建采集列表●∙编辑采集字段名称2、移动鼠标选中表格里任意一个保险信息,系统会识别出其他相似的元素,选择“选中全部”。

3、点击“采集以下链接文本”。

4、相似操作,选中一个保险起价,然后点击“选中全部”5、点击“采集以下元素文本”6、点开右上角的流程按钮,修改采集任务名、字段名,并点击下方提示中的“保存并开始采集”由于页面使用了ajax加载技术,需要对点击元素及翻页步骤设置ajax延时加载(ajax判断方法:选择点击元素步骤,勾选Ajax加载数据,选择合适的超时时间,一般设置2秒;最后点击确定7、点击翻页步骤同样设置相同操作。

最后再次选择保存并启动 8、根据采集的情况选择合适的采集方式,这里选择“启动本地采集”说明:本地采集占用当前电脑资源进行采集,如果存在采集时间要求或当前电脑无法长时间进行采集可以使用云采集功能,云采集在网络中进行采集,无需当前电脑支持,电脑可以关机,可以设置多个云节点分摊任务,10个节点相当于10台电脑分配任务帮你采集,速度降低为原来的十分之一;采集到的数据可以在云上保存三个月,可以随时进行导出操作。

步骤4:金融数据采集及导出采集完成后,会跳出提示,选择导出数据。

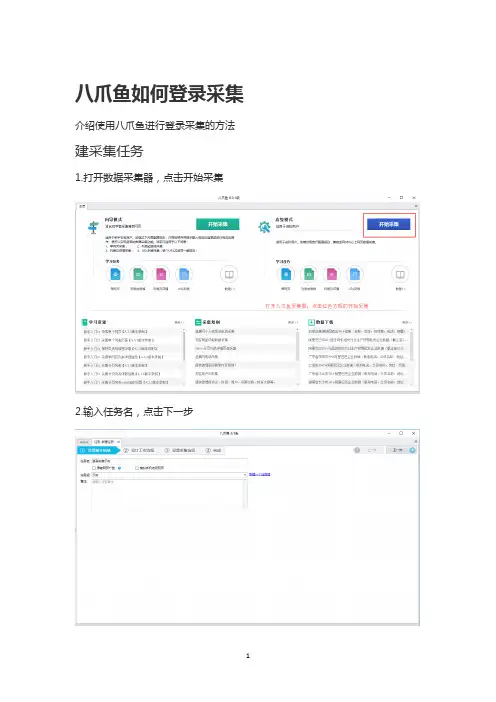

八爪鱼如何登录采集介绍使用八爪鱼进行登录采集的方法建采集任务

1.打开数据采集器,点击开始采集

2.输入任务名,点击下一步

编写采集规则

1.复制你要登录采集的网址

2.在流程设计器里选择打开网页,并拖动到设计器里,粘贴刚刚复制的网址,点击保存并打开网站

3.在下面打开的网址上找到账号输入框并点击右键,执行输入文本操作,如图所示

4.在红色方块指示区域输入登录账号,并点击保存

5.完成账号的保存好,继续右键点击密码输入框,执行输入文本操作,如图所示

6.在红色方框指示区域内输入登录密码,记得点击保存

7.最后一步,鼠标右键点击登录,再选择执行点击元素操作

8.成功登录采集页面,接下来就可以对需要采集的数据进行抓取了。

网页数据抓取方法详解互联网时代,网络上有海量的信息,有时我们需要筛选找到我们需要的信息。

很多朋友对于如何简单有效获取数据毫无头绪,今天给大家详解网页数据抓取方法,希望对大家有帮助。

八爪鱼是一款通用的网页数据采集器,可实现全网数据(网页、论坛、移动互联网、QQ空间、电话号码、邮箱、图片等信息)的自动采集。

同时八爪鱼提供单机采集和云采集两种采集方式,另外针对不同的用户还有自定义采集和简易采集等主要采集模式可供选择。

如果想要自动抓取数据呢,八爪鱼的自动采集就派上用场了。

定时采集是八爪鱼采集器为需要持续更新网站信息的用户提供的精确到分钟的,可以设定采集时间段的功能。

在设置好正确的采集规则后,八爪鱼会根据设置的时间在云服务器启动采集任务进行数据的采集。

定时采集的功能必须使用云采集的时候,才会进行数据的采集,单机采集是无法进行定时采集的。

定时云采集的设置有两种方法:方法一:任务字段配置完毕后,点击‘选中全部’→‘采集以下数据’→‘保存并开始采集’,进入到“运行任务”界面,点击‘设置定时云采集’,弹出‘定时云采集’配置页面。

第一、如果需要保存定时设置,在‘已保存的配置’输入框内输入名称,再保存配置,保存成功之后,下次如果其他任务需要同样的定时配置时可以选择这个配置。

第二、定时方式的设置有4种,可以根据自己的需求选择启动方式和启动时间。

所有设置完成之后,如果需要启动定时云采集选择下方‘保存并启动’定时采集,然后点击确定即可。

如果不需要启动只需点击下方‘保存’定时采集设置即可。

方法二:在任务列表页面,每个任务名称右方都有‘更多操作’选项,点击之后,在下拉选项中选择云采集设置定时,同样可以进行上述操作。

相关采集教程:八爪鱼数据爬取入门基础操作/tutorial/xsksrm/rmjccz八爪鱼网站抓取入门功能介绍/tutorial/xsksrm/rmgnjs八爪鱼爬虫软件功能使用教程/tutorial/gnd八爪鱼分页列表详细信息采集方法(7.0版本)/tutorial/fylbxq7八爪鱼7.0版本网页简易模式简介以及使用方法/tutorial/jyms八爪鱼7.0版本向导模式简介以及使用方法h ttp:///tutorial/xdms八爪鱼7.0版本——智能模式介绍以及使用方法/tutorial/znms按照如上方法操作,就可以对网页数据进行自动采集了。

八爪鱼采集器入门教程详细说明刚接触八爪鱼的时候,作为一个文科运营喵,还是一脸懵逼的。

爬虫是什么?采集器是什么?八爪鱼采集器怎么工作的?怎么就能采集到数据了?八爪鱼的这些高级选项,该怎么设置?一堆问题的我,上八爪鱼官网(/),啃了各种产品说明、各种教程、然后边看教程边操作......相对市面上其他采集器而言,八爪鱼的可视化流程已经降低了操作难度,即使是没有技术背景的人,也挺容易入门的。

但是,学习初期难免感到毫无头绪。

本文整理了比较系统的八爪鱼详细入门说明,希望对大家有用。

要系统的学习并掌握八爪鱼,完成从入门到采集大神的历练,需要经过以下几个阶段:一、理解八爪鱼工作的核心原理二、了解八爪鱼入门词汇(有一个初步印象)三、采集基本流程教程(明白整体架构)四、细致学习功能点教程+实战案例教程(开始实际操作)一、理解八爪鱼工作的核心原理八爪鱼采集的核心原理是:模拟人浏览网页,复制数据的行为,通过记录和模拟人的一系列上网行为,代替人眼浏览网页,代替人手工复制网页数据,从而实现自动化从网页采集数据,然后通过不断重复一系列设定的动作流程,实现全自动采集大量数据。

理解核心原理是十分必要的,只有理解了工作原理,再结合实际操作仔细体会,才会取得事半功倍的效果。

二、了解八爪鱼入门词汇(有一个初步印象)要掌握的入门词汇主要有:积分、规则、云加速、云优先、URL、单机采集、云采集、定时采集、URL循环、自动导出、COOKIE、XPATH、HTML八爪鱼入门词汇详细资料,请点击以下链接查看:/doc-wf三、了解采集基本流程教程(明白整体架构)八爪鱼在配置规则、采集数据的时候,主要会经过以下几个步骤:打开网页、点击元素、输入文本、提取数据、循环、下翻下拉列表、条件分支、鼠标悬停。

针对这些步骤,八爪鱼内置了很多高级选项。

在针对具体网页的采集过程中,网页结构、网页情况是不一样的。

我们需要观察网页结构,相应地在八爪鱼中进行高级选项的设置。

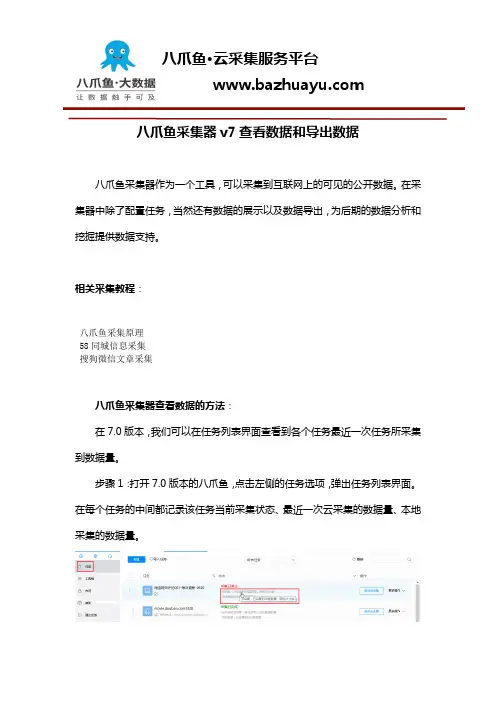

八爪鱼采集器v7查看数据和导出数据八爪鱼采集器作为一个工具,可以采集到互联网上的可见的公开数据。

在采集器中除了配置任务,当然还有数据的展示以及数据导出,为后期的数据分析和挖掘提供数据支持。

相关采集教程:八爪鱼采集原理58同城信息采集搜狗微信文章采集八爪鱼采集器查看数据的方法:在7.0版本,我们可以在任务列表界面查看到各个任务最近一次任务所采集到数据量。

步骤1:打开7.0版本的八爪鱼,点击左侧的任务选项,弹出任务列表界面。

在每个任务的中间都记录该任务当前采集状态、最近一次云采集的数据量、本地采集的数据量。

八爪鱼查看数据和导出数据-图1:云采集八爪鱼查看数据和导出数据-图2:本地采集步骤2:点击“云采集:已采集到XXX 条数据…”或是“本地采集:已采集到XXX 条数据”。

页面会直接跳转到查看数据界面。

该界面展示了当前任务所采集到的最终数据形式。

八爪鱼查看数据和导出数据-图3云数据界面:云数据界面中展示了当前任务名称(页面中间),以及该任务的总数据量和页数(页面左下方)。

同时有一个提示信息:数据只保存3个月。

(页面右上角)也就是说云采集的数据,八爪鱼采集器会在云端保存3个月,之后数据即被清除。

因此数据需要及时导出。

八爪鱼查看数据和导出数据-图4本地数据:本地数据界面与云数据界面基本没有差别。

但是本地数据是任务进行本地采集时生成,每次本地采集会将之前保存的本地数据清除,只保留最新一次运行的数据。

而云数据所保存的时每次云采集运行结束后的数据的汇总。

八爪鱼查看数据和导出数据-图5跳转任务编辑界面云数据界面中可以直接跳转到任务编辑界面,直接点击“编辑任务”(左上角的蓝色框)。

当查看到任务的数据不符合预期时,就可以执行该操作,跳转任务编辑界面,即可进行修改。

然后再次运行任务。

八爪鱼查看数据和导出数据-图6八爪鱼查看数据和导出数据-图7数据翻页、跳转在左下方可以点击翻页操作,查看后续的数据情况。

同时还是填写某一个页面数,点击“跳转”会自动跳转到相应的页面。

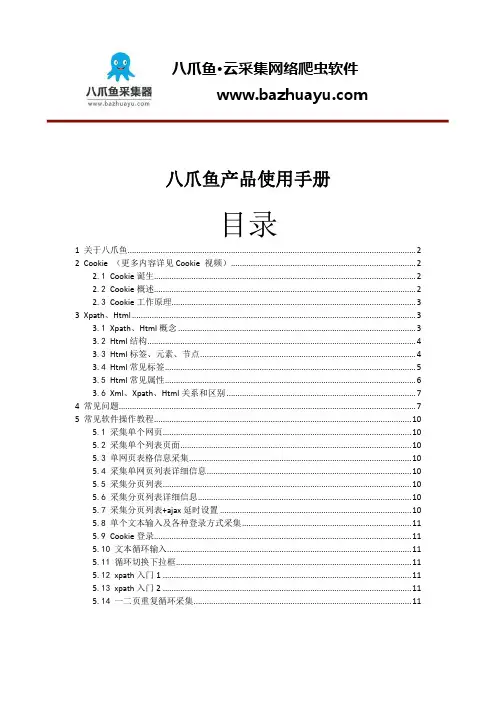

八爪鱼产品使用手册目录1关于八爪鱼 (2)2Cookie (更多内容详见Cookie 视频) (2)2.1 Cookie诞生 (2)2.2 Cookie概述 (2)2.3 Cookie工作原理 (3)3Xpath、Html (3)3.1 Xpath、Html概念 (3)3.2 Html结构 (4)3.3 Html标签、元素、节点 (4)3.4 Html常见标签 (5)3.5 Html常见属性 (6)3.6 Xml、Xpath、Html关系和区别 (7)4常见问题 (7)5常见软件操作教程 (10)5.1 采集单个网页 (10)5.2 采集单个列表页面 (10)5.3 单网页表格信息采集 (10)5.4 采集单网页列表详细信息 (10)5.5 采集分页列表 (10)5.6 采集分页列表详细信息 (10)5.7 采集分页列表+ajax延时设置 (10)5.8 单个文本输入及各种登录方式采集 (11)5.9 Cookie登录 (11)5.10 文本循环输入 (11)5.11 循环切换下拉框 (11)5.12 xpath入门1 (11)5.13 xpath入门2 (11)5.14 一二页重复循环采集 (11)关于八爪鱼八爪鱼·大数据,通过自主创新研发,以分布式云平台架构为产品核心,帮助客户通过在极短的时间内,通过简单操作即可获取想要的数据,并以结构化数据展示,为企业数据挖掘与数据分析提供基础数据源。

于2015年1月,获得国家重点软件企业上市公司“拓尔思”投资。

Cookie (更多内容详见Cookie 视频)Cookie诞生当某个用户打开浏览器发出页面请求时,web服务器只是进行简单相应,然后就关闭与该用户的连接。

所以当用户每发起一个打开网页请求到web服务器的时候,无论是否是第一次打开同一个网页,web服务器都会把这个请求当作第一次来对待,那这样的缺陷可想而知,比如每次打开登录页面的时候都需要输入用户名、密码。

网站小说抓取方法很多时候,我们有对网站小说数据采集的需要,手工复制粘贴费时费力、错误多,这时候会用到数据采集工具提高效率。

本文以八爪鱼采集器为例,介绍一下对于网站小说抓取数据的方法。

本文将以起点中文网为例,介绍使用八爪鱼采集小说文本(以鬼吹灯小说为例)的方法。

以下为具体的采集步骤:步骤1:创建采集任务1)进入主界面,选择“自定义模式”2)将要采集的网址复制粘贴到网站输入框中,点击“保存网址”小说-文章内容采集图2步骤2:创建列表循环1)在页面右上角,打开“流程”,以展现出“流程设计器”和“定制当前操作”两个板块。

选中页面里的第一条链接,系统会自动识别页面内的同类链接,选择“选中全部”小说-文章内容采集图32)选择“循环点击每个链接”小说-文章内容采集图4步骤3:采集小说内容1)选中页面内要采集的小说内容(被选中的内容会变成绿色),选择“采集该元素的文本”2)修改字段名称3)选择“启动本地采集”小说-文章内容采集图7步骤4:数据采集及导出1)采集完成后,会跳出提示,选择“导出数据。

选择“合适的导出方式”,将采集好的评论信息数据导出小说-文章内容采集图82)这里我们选择excel作为导出为格式,数据导出后如下图小说-文章内容采集图9注意:采集下来的小说文本,导出为excel格式,可能不太符合阅读习惯。

我们可以在excel 中进行符合自身阅读习惯的二次编辑。

相关采集教程:起点中文网小说采集方法以及详细步骤/tutorial/qidianstorycj欢乐书客小说采集/tutorial/hlskxscj八爪鱼7.0版本网页简易模式简介以及使用方法/tutorial/jyms八爪鱼7.0版本向导模式简介以及使用方法/tutorial/xdms八爪鱼7.0版本——智能模式介绍以及使用方法/tutorial/znms八爪鱼7.0版本——自定义模式使用方法以及介绍/tutorial/zdyms八爪鱼7.0基本排错详细教程/tutorial/jbpc_7。

如何使用八爪鱼批量下载网页八爪鱼作为一款通用的网页数据采集器,其并不针对于某一网站某一行业的数据进行采集,而是网页上所能看到或网页源码中有的文本信息几乎都能采集,有些朋友有批量下载网页的需求,其实可以使用八爪鱼采集器去实现。

下面以UC头条网页为大家详细介绍如何使用八爪鱼批量下载网页。

采集网站:https:///使用功能点:Xpathxpath入门教程1/tutorialdetail-1/xpathrm1.htmlxpath入门2/tutorialdetail-1/xpathrm1.html相对XPATH教程-7.0版/tutorialdetail-1/xdxpath-7.htmlAJAX滚动教程/tutorial/ajgd_7.aspx?t=1步骤1:创建UC头条文章采集任务1)进入主界面,选择“自定义模式”2)将要采集的网址URL复制粘贴到网站输入框中,点击“保存网址”3)在页面右上角,打开“流程”,以展现出“流程设计器”和“定制当前操作”两个板块。

网页打开后,默认显示“推荐”文章。

观察发现,此网页没有翻页按钮,而是通过下拉加载,不断加载出新的内容因而,我们选中“打开网页”步骤,在高级选项中,勾选“页面加载完成后向下滚动”,滚动次数根据自身需求进行设置,间隔时间根据网页加载情况进行设置,滚动方式为“向下滚动一屏”,然后点击“确定”(注意:间隔时间需要针对网站情况进行设置,并不是绝对的。

一般情况下,间隔时间>网站加载时间即可。

有时候网速较慢,网页加载很慢,还需根据具体情况进行调整。

具体请看:八爪鱼7.0教程——AJAX滚动教程步骤2:创建翻页循环及提取数据1)移动鼠标,选中页面里第一条文章链接。

系统会自动识别相似链接,在操作提示框中,选择“选中全部”2)选择“循环点击每个链接”3)系统会自动进入文章详情页。

点击需要采集的字段(这里先点击了文章标题),在操作提示框中,选择“采集该元素的文本”文章发布时间、文章作者、文章发布时间、文章正文内容采集方法同上。

58信息采集器使用教程作为一个综合的分类信息网,58上有很多丰富的信息,这些信息被爬虫采集下来有很多作用,比如可以分析招聘岗位的热门与否;分析房价近几年的起伏状况;分析二手车市场的发展状况,查询58上的公司黄页信息等。

数据采集是最重要的一步之一。

本次介绍八爪鱼采集器简易采集模式下“58同城爬虫规则”的使用教程以及注意要点。

58信息采集器使用步骤步骤一、下载八爪鱼采集器并登陆1、打开/download,即八爪鱼软件官方下载页面,点击图中的下载按钮。

2、软件下载好了之后,双击安装,安装完毕之后打开软件,输入八爪鱼用户名密码,然后点击登陆。

步骤二、设置58同城爬虫规则任务1、进入登陆界面之后就可以看到主页上的网站简易采集了,选择立即使用即可。

2、进去之后便可以看到目前网页简易模式里面内置的所有主流网站爬虫规则了,需要采集58同城信息的,在这里选择58即可。

3、本文仅以“58同城招聘职位”这条规则举例说明,需要采集58同城其他信息,可以选择其他爬虫规则,点击“立即使用”即可。

4、58同城招聘职位简易采集模式任务界面介绍查看详情:点开可以看到示例网址,示例网址很重要,需认真观察 任务名:自定义任务名,默认为58同城招聘职位任务组:给任务划分一个保存任务的组,如果不设置会有一个默认组招聘页面网址填写注意事项:提供要采集的网页网址,即58招聘页的链接。

这里输入的网址,需与示例网址的结构保持一致。

我们点开示例网址(如下图所示),发现职位、地点、福利有多个关键词可选择,大家可根据自己的需求,更换要采集的关键词(红框中的关键词,均可点击更换)。

采集页数:要翻页的次数示例数据:这个规则采集的所有字段信息。

5、 58同城招聘爬虫规则设置示例例如要采集北京面点师的招聘信息,打开示例网址,切换城市为北京,选择职位关键词为面点师。

在设置里如下图所示:任务名:自定义任务名,也可以不设置按照默认的就行任务组:自定义任务组,也可以不设置按照默认的就行招聘页面网址:/miandianshi/?PGTID=0d0025a8-0000-0542-d882-581fe8ed0122&C lickID=1备注:如果想要采集多个招聘页的数据,可将此任务执行多次,每次更换要采集的网址即可。

关键词提取工具本文将教您如何使用【八爪鱼数据采集】工具到关键词网站批量采集提取的方法。

对于一位站长来说,关键词挖掘是他必不可少的工作。

目前网络上有爱站、百度站长、词库等各种工具可供站长使用,这些工具对于站长来说都是非常有价值的,对于网站的内容定位、结构策划、TDK撰写等营销策略都是至关重要的。

下面以【爱站】举例,教大家如何使用【八爪鱼数据采集】进行关键词的采集提取。

采集网站:本文仅以采集“旅游”、“旅游攻略”、“旅游景点”这三个词采集长尾关键词举例说明。

大家可根据自身需要,更换不同的关键词进行挖掘长尾关键词。

使用功能点:文本输入登录方法(7.0版本)/tutorialdetail-1/srdl_v70.html●验证码登录/tutorialdetail-1/kjsb7.html●数字翻页/tutorialdetail-1/szfy_7.html●文本循环/tutorialdetail-1/wbxh_7.html步骤1:创建爱站关键词采集任务1)进入主界面,选择“自定义模式”,点击“立即使用” 2)将要采集的网址复制粘贴到网站输入框中,点击“保存网址”步骤2:登录爱站工具1)系统自动打开网页,进入爱站关键词挖掘页面。

点击“登录”按钮,选择“点击该链接”,进入爱站工具登录页面。

2)在页面右上角,打开“流程”,以展现出“流程设计器”和“定制当前操作”两个板块。

点击账号输入框,选择“输入文字” 输入爱站工具登录账号,点击“确定”3)点击爱站工具密码输入框,选择“输入文字”,输入密码,点击“确定”4)由于网站登录要输入需要验证码,点击“验证码”图片,然后点击“识别验证码”。

点击红色框中的输入框 点击登录按钮点击“确认”按钮 点击“验证码不正确”,随后选择确认按钮选择“开始配置识别成功场景” 这个时候识别验证码就配置好了5)由于爱站登录验证码是过了一定时间会失效,如果失效了,可以选中左侧设计器中的“识别验证码”,打开“辅助模式选项”,在“当前验证码”中填入正确的验证码,然后点击“应用到网页并提交”。

八爪鱼·云采集网络爬虫软件 www.bazhuayu.com

欢乐书客小说采集器使用教程 本文介绍使用八爪鱼采集器采集欢乐书客(以次元学院小说为例)的方法。 采集网站:https://www.hbooker.com/book/100040870 上述仅以次元学院小说举例,大家在采集欢乐书客小说的时候,可以更换小说书籍进行采集。

采集的内容包括:小说章节,小说内容 使用功能点: 分页列表及详细信息提取 http://www.bazhuayu.com/tutorialdetail-1/fylbxq7.html 步骤1:创建欢乐书客小说采集任务 1)进入主界面,选择“自定义模式” 八爪鱼·云采集网络爬虫软件 www.bazhuayu.com

欢乐书客小说采集步骤1 2)将要采集的欢乐书客小说网址复制粘贴到网站输入框中,点击“保存网址” 八爪鱼·云采集网络爬虫软件 www.bazhuayu.com

欢乐书客小说采集步骤2 步骤2:创建列表循环 1)在页面右上角,打开“流程”,以展现出“流程设计器”和“定制当前操作”两个板块。若章节被隐藏,点击查看全部章节并选择点击该链接。 八爪鱼·云采集网络爬虫软件 www.bazhuayu.com

欢乐书客小说采集步骤3 2)选中页面里的第一条链接,系统会自动识别页面内的同类链接,选择“选中全部”

欢乐书客小说采集步骤4 3)选择“循环点击每个链接” 八爪鱼·云采集网络爬虫软件 www.bazhuayu.com

欢乐书客小说采集步骤5 步骤3:采集欢乐书客小说内容 1)选中页面内要采集的小说内容(被选中的内容会变成绿色),选择“采集该元素的文本” 八爪鱼·云采集网络爬虫软件 www.bazhuayu.com

欢乐书客小说采集步骤6 2)修改字段名称

欢乐书客小说采集步骤7 3)选择“启动本地采集” 八爪鱼·云采集网络爬虫软件 www.bazhuayu.com

欢乐书客小说采集步骤8 步骤4:数据采集及导出 1)采集完成后,会跳出提示,选择“导出数据。选择“合适的导出方式”,将采集好的评论信息数据导出 八爪鱼·云采集网络爬虫软件 www.bazhuayu.com

八爪鱼采集器流程步骤高级选项说明1、打开网页该步骤根据设定的网址打开网页,一般为网页采集流程的第一个步骤,用来打开指定的网站或者网页。

如果有多个类似的网址需要分别打开执行同样的采集流程,则应该放置在循环的内部,并作为第一个子步骤1)页面URL页面URL,一般可以从网页浏览器地址栏中复制得到,如:/ 2)操作名自定义操作名3)超时在网页加载完成前等待的最大时间。

如果网页打开缓慢,或者长时间无法打开,则流程最多等待超时指定的时间,之后无论网页是否加载完成,都直接执行下一步骤。

应尽量避免设置过长的超时时间,因为这会影响采集速度4)阻止弹出用以屏蔽网页弹窗广告,如果打开的网页偶尔会变成另外一个广告页面,则可以使用本选项阻止广告页面弹出5)使用循环配合循环步骤来使用,用以重复打开多个类似的网页,然后执行同样的一套流程,循环打开网页时,应为作为循环步骤的第一个子步骤。

如果勾选此项,则无需手动设置网页地址,网页地址会自动显示循环设定的网址列表的当前循环项6)滚动页面个别网页在打开网页后并没有显示所有数据,需要滚动鼠标滚轮或者拖动页面滚动条到底部,才会加载没有显示的数据,使用此选项在页面加载完成后向下滚动,滚动方式有向下滚动一屏和直接滚动到底部两种7)清理缓存在八爪鱼中,如果需要切换账号,可使用清理浏览器缓存,重新设置其他账号8)自定义cookiecookie指某些网站为了辨别用户身份、进行session 跟踪而储存在用户本地终端上的数据(通常经过加密)。

在八爪鱼中,可以通过做一次预登录获取页面cookie,通过勾选打开网页时使用指定cookie获取登陆后的cookie,从而记住登录状态。

获取的当前页面cookie,可以通过点击查看cookie9)重试如果网页没有按照成功打开预期页面,例如显示服务器错误(500),访问频率太快等,或者跳转到其他正常执行不应该出现的页面,可以使用本选项进行重试,但必须配合以下几个重试参数执行,请注意以下几种判断的情况任意一种出现都会导致重试①当前网页的网址/文本/xpath,包含/不包含如果当前页面网址/文本/xpath总是出现/不出现某个特殊内容,则使用此选项可以判断有没有打开预期页面,需要重试②最大重试次数为了避免无限制重复尝试,请使用本选项限制最大重复尝试的次数,如果重试到达最大允许的次数,任然没有成功,则流程将停止重试,继续执行下一步骤③时间间隔在两次重试之间等待的时间,一般情况下,当打开网页出错时,立即重试很有可能是同样的错误,适当等待则可能成功打开预期网页,但应该尽量避免设置过长的等待时间,因为这会影响采集速度2、点击元素该步骤对网页上指定的元素执行鼠标左键单击动作,比如点击按钮,点击超链接等1)操作名自定义操作名2)执行前等待对此步骤设置执行前等待,即等待设置的时间后,再进行此步骤3)或者出现元素或者出现元素,配合执行前等待使用,在其中输入元素的xpath可以在出现该元素的时候结束执行前的等待。

视频抓取工具使用教程视频抓取工具使用教程有时候,我们浏览网页看到有价值的视频想快速的抓取下来,需要费很大的功夫,不像文本信息直接复制粘贴就可以,这个时候就需要借助视频抓取工具了,各大浏览都有插件有下载视频的功能,但是也不方便,无法进行大量操作,下面介绍一个专业软件-八爪鱼采集器让你快速高效抓取网页视频,以百度视频综艺节目为例。

常见场景:1、遇到需要采集视频时,可以采集视频的地址(URL),再使用网页视频下载器下载视频。

2、当视频链接在标签中,可切换标签进行采集。

3、当视频链接在标签中,也可采集源码后进行格式化数据。

操作示例:采集要求:采集百度视频上综艺往期视频示例网址:/show/list/area-内地+order-hot+pn-1+channel-tvshow操作步骤:1、新建自定义采集,输入网址后点击保存。

注:点击打开右上角流程按钮。

2、创建循环翻页,找到采集页面中下一页按钮,点击,执行“循环点击下一页”。

在流程中的点击翻页勾选Ajax加载数据,时间设置2-3秒。

3、创建循环点击列表。

点击第一张图片,选择“选中全部”(由于标签可能不同,会导致无法选中全部,可以继续点击没被选中的图片)继续选择循环点击每个元素4、进入详情页后,点击视频标题(从火狐中可以看到视频链接在A标签中,如图所示),所以需要手动更换到相应的A标签。

手动更换为A标签:更换为A标签后,选择“选中全部”,将所有视频标题选中,此时就可以采集视频链接地址。

5、所有操作设置完毕后,点击保存。

然后进行本地采集,查看采集结果。

6、采集完成后将URL导出,使用视频URL批量下载工具将视频下载出来就完成了。

相关采集教程:八爪鱼7.0文本循环采集教程,以采集腾讯视频举例:/tutorial/wbxh_7网页视频链接提取,以腾讯视频为例:/tutorial/txspajax点击-视频:/tutorial/ajax八爪鱼采集器URL循环-视频教程:/tutorial/urlxunhaun系统学习xpath—视频教程:/tutorial/xitongxpathxpath工具使用方法—视频教程:/tutorial/xpathgongju八爪鱼采集器——相对xpath应用——视频教程:/tutorial/xiangduixpath八爪鱼采集器——云采集原理、云采集规则加速——视频教程:/tutorial/yuncaiji八爪鱼——90万用户选择的网页数据采集器。

微博关键词爬虫抓取方法本文介绍使用八爪鱼爬虫软件采集抓取微博关键词的方法。

采集网站:https:///?sudaref=&display=0&retcode=6102本文仅以“杨幂”、郑爽、“赵丽颖”这三个关键词挖掘举例说明,大家如果有挖掘微博其他关键词的需求,可以更换关键词进行采集。

采集的内容包括:微博下拉框关键词使用功能点:●∙文本循环●∙Ajax点击●∙Cookie登陆方法(7.0版本)注:第一次用八爪鱼采集微博的童鞋,可以先制作一个简单的预登陆规则步骤1:创建微博关键词爬虫抓取任务1)进入主界面,选择“自定义模式”微博关键词爬虫使用步骤12)将要采集的网址复制粘贴到网站输入框中,点击“保存网址”微博关键词爬虫使用步骤2步骤2:登录微博1)系统自动打开网页,进入微博首页。

在页面右上角,打开“流程”,以展现出“流程设计器”和“定制当前操作”两个板块。

点击“登录”按钮,选择“点击该链接”,进入微博登录页面微博关键词爬虫使用步骤3 2)点击账号输入框,选择“输入文字”,输入账号,点击“确定”微博关键词爬虫使用步骤43)点击密码输入框,选择“输入文字”输入密码,点击“确定”微博关键词爬虫使用步骤54)点击“登录”按钮,选择“点击该链接”微博关键词爬虫使用步骤65)系统会自动登录微博微博关键词爬虫使用步骤7步骤3:设置cookie登录 1)再次选中“打开网页”步骤,打开“高级选项”,打开“缓存设置”,勾选“打开网页时使用指定Cookie ”微博关键词爬虫使用步骤82)八爪鱼会记住这个Cookie状态。

下图中新建了一个任务,打开微博首页。

可以看见,八爪鱼中以登陆之后的状态打开之后就可以正式进入采集了。

微博关键词爬虫使用步骤9步骤4:创建文本循环1)同上操作选择自定义采集复制网址打开网页之后,打开右上角的流程按钮,从左边的流程展示界面拖入一个循环的步骤,如下图微博关键词爬虫使用步骤10然后打开高级选项,在循环方式中选择文本列表,在列表下拉框中输入“杨幂”、郑爽、“赵丽颖”并用回车键隔开。

八爪鱼验证码登陆-控件识别方法(7.0版本)

本文给大家演示登陆界面有验证码或者其他验证(如滑块验证)的网站通过八爪鱼控件识别进行数据采集的方式。

所讲示例采集数据网址为/login.aspx

小贴士:通过八爪鱼的控件进行识别,这种方式如果需要自动识别,就需要购买验证码套餐,如果不购买也只能进行单机采集然后手动输入,注意这种方法只能是输入验证码的框才可以用这种方式。

步骤1 登陆八爪鱼7.0采集器→点击新建任务→自定义采集,进入到任务配置页面:然后输入网址→保存网址,系统会进入到流程设计页面并自动打开前面输入的网址。

验证码登陆-控件识别方法-图1:输入网址

接下来步骤是输入用户名密码了,八爪鱼模拟的是人的操作行为,所以这一步过程也很简单

步骤2 在浏览器中鼠标点击用户名输入框→在右边弹出的提示里面选择“输入文字”→输入自己的用户名→选择“确定”。

同样的方式输入密码,这样输入用户名密码的步骤就完成了。

验证码登陆-控件识别方法-图2:输入密码

验证码登陆-控件识别方法-图3:输入密码

这里八爪鱼采集器需要知道

1.验证码图片在哪里

2.输入框验证码的框在哪里

步骤3 点击下方浏览器中验证码图片的位置→按照提示框中的提示选择浏览器中的验证码框→再按照提示框中的提示点击浏览器中的登陆按钮

验证码登陆-控件识别方法-图4:点击验证码输入框

验证码登陆-控件识别方法-图5:点击验证码图片位置、登录按钮

接下来需要配置验证码输入失败和成功的两种场景

步骤4 点击提示框中的确认按钮,系统会自动提交一个错误的验证码→然后点击浏览器中的“验证码不正确”提示→再点击提示框中的确认按钮→选择提示框中的“开始配置识别成功场景”→在提示框中输入显示出来的验证码→选择提示框中的“应用到网页并完成配置”选项

验证码登陆-控件识别方法-图6:点击确认按钮

验证码登陆-控件识别方法-图7:配置验证码输入失败场景

验证码登陆-控件识别方法-图8:配置验证码输入成功场景

验证码登陆-控件识别方法-图9:配置验证码输入成功场景

上述操作中验证码识别就完成了,接下来需要手动执行这个流程,任务会自动进去到登陆界面

步骤5 点击“流程”按钮→进入到流程界面→手动点击流程步骤(可以看到浏览器中会按照会执行这些步骤)→点到识别验证码步骤时→在辅助模式选项中输入浏览器中当前显示的验证码→选择应用到网页并提交

验证码登陆-控件识别方法-图10:辅助模式选项

这样操作之后,可以看到任务就正常登陆进去了。

步骤6 这里我随意提取一个数据仅供演示登陆功能,具体的操作可以参考新手入门的教程。

验证码登陆-控件识别方法-图11:提取数据

步骤7 接下来选择保存并启动按钮,系统将会在本地启动一个采集流程,当执行到输入验证码操作时,如果是购买过验证码套餐的,直接勾选“自动识别验证码”即可。

如果没有购买的这里手动输入点确定也是可以的,但是这里这个规则就不能用云采集。

验证码登陆-控件识别方法-图12:启动采集

验证码登陆-控件识别方法-图13:勾选自动识别验证码

相关采集教程:

天猫商品信息采集

豆瓣电影短评采集

大众点评评价采集

八爪鱼——70万用户选择的网页数据采集器。

1、操作简单,任何人都可以用:无需技术背景,会上网就能采集。

完全可视化流程,点击鼠标完成操作,2分钟即可快速入门。

2、功能强大,任何网站都可以采:对于点击、登陆、翻页、识别验证码、瀑布流、Ajax脚本异步加载数据的网页,均可经过简单设置进行采集。

3、云采集,关机也可以。

配置好采集任务后可关机,任务可在云端执行。

庞大云采集集群24*7不间断运行,不用担心IP被封,网络中断。

4、功能免费+增值服务,可按需选择。

免费版具备所有功能,能够满足用户的基本采集需求。

同时设置了一些增值服务(如私有云),满足高端付费企业用户的需要。