基函数神经网络及应用_第二章数学基础

- 格式:pdf

- 大小:194.95 KB

- 文档页数:8

神经网络原理及应用随着科技的不断进步,人们对于人工智能的热情也日趋高涨。

人工智能有很多种算法,其中神经网络是最为基础且应用最广泛的一种。

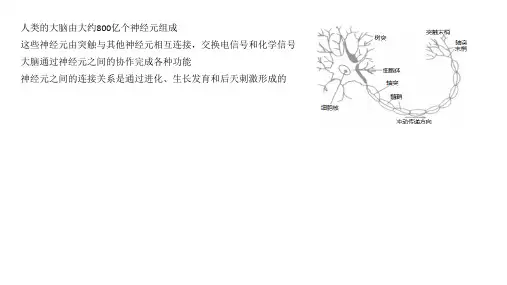

一、神经网络的原理神经网络是一种模拟人脑神经元的计算模型,它是由大量的神经元和它们之间的连接构成的。

每个神经元都有自己的输入和输出,这些输入通过一系列的“权重”给定了输入的影响程度,神经元通过函数将这些带权输入求和并送入输出函数得到输出。

其中,输入函数有不同的表现形式,一般来说,是将输入加权和的结果送入激活函数中,以输出神经元的值。

激活函数有很多种,常见有sigmoid函数、ReLU函数、tanh函数等。

而连接权重是神经网络中的一个非常重要的概念,它决定了神经元间的传递强度和方向。

在训练神经网络时,我们通常使用反向传播算法,根据训练数据来不断调整连接权重,以找到最小化损失函数的权重。

二、神经网络的应用神经网络有着广泛的应用,其中最为突出的有以下几个:1、图像识别神经网络可以对图像进行识别,这在计算机视觉和人机交互领域有着非常重要的应用。

神经网络学习识别图像的主要过程是输入训练数据,进行误差预测,然后调整网络权重以提高预测准确率。

2、自然语言处理神经网络可以通过训练学会自然语言处理任务,如语音识别、机器翻译和情感分析等。

在这些任务中,神经网络可以归纳出与自然语言相关的语法、语义和上下文信息,从而提高自然语言处理的准确性和速度。

3、推荐系统神经网络可以利用用户的历史行为和其他信息来推荐符合用户利益的商品、视频和新闻。

在这方面,神经网络可以识别隐藏在用户行为背后的模式和信号,以便提供更加精确的推荐服务。

4、游戏智能神经网络可以在游戏中进行决策,自动控制角色,提供游戏智能服务。

在这些应用中,神经网络开始了进化学习算法,以提高角色行动的判断力和反应速度,从而更好地帮助玩家取得游戏胜利。

三、神经网络的未来神经网络在许多领域的发展都取得了非常突出的成果。

随着硬件技术的不断进步和数据规模的不断增长,神经网络的未来前景也是一片光明。

神经网络基础知识教材用平常语言介绍神经网络(Neural Networks in Plain English)因为我们没有很好了解大脑,我们经常试图用最新的技术作为一种模型来解释它。

在我童年的时候,我们都坚信大脑是一部电话交换机。

(否则它还能是什么呢?)我当时还看到英国著名神经学家谢林顿把大脑的工作挺有趣地比作一部电报机。

更早些时候,弗罗伊德经常把大脑比作一部水力发电机,而莱布尼茨则把它比作了一台磨粉机。

我还听人说,古希腊人把大脑功能想象为一付弹弓。

显然,目前要来比喻大脑的话,那只可能是一台数字电子计算机了。

-John R.Searle [注1]1.神经网络介绍(Introduction to Neural Networks)曾有很长一个时期,人工神经网络对我来说是完全神秘的东西。

当然,有关它们我在文献中已经读过了,我也能描述它们的结构和工作机理,但我始终没有能“啊哈!”一声,如同你头脑中一个难于理解的概念有幸突然得到理解时的感觉那样。

我的头上好象一直有个榔头在敲着,或者像电影AnimalHouse(中文片名为“动物屋”)中那个在痛苦地尖叫“先生,谢谢您,再给我一个啊!”的可怜家伙那样。

我无法把数学概念转换成实际的应用。

有时我甚至想把我读过的所有神经网络的书的作者都抓起来,把他们缚到一棵树上,大声地向他们吼叫:“不要再给我数学了,快给我一点实际东西吧!”。

但无需说,这是永远不可能发生的事情。

我不得不自己来填补这个空隙...由此我做了在那种条件下唯一可以做的事情。

我开始干起来了。

<一笑>这样几个星期后,在一个美丽的日子里,当时我在苏格兰海边度假,当我越过一层薄雾凝视着狭长的海湾时,我的头脑突然受到一个冲击。

一下子悟到了人工神经网络是怎样工作的。

我得到“啊哈!”的感觉了!但我此时身边只有一个帐篷和一个睡袋,还有半盒子的脆玉米片,没有电脑可以让我迅速写出一些代码来证实我的直觉。

Arghhhhh!这时我才想到我应该买一台手提电脑。

神经网络的数学原理及应用一、什么是神经网络神经网络是一种模仿人脑组织结构和功能的计算模型,它由大量的人工神经元相互连接而成。

每个神经元都有一个或多个输入连接,输出信号将通过这些连接传递给其他神经元。

神经网络可以通过训练来学习和适应输入数据的特征,进而对新的数据进行预测和分类。

二、神经网络的数学原理神经网络的数学原理是其实现和应用的基础,下面将介绍神经网络的数学原理及其相关概念。

1. 激活函数激活函数是神经网络中的一个关键组件,它在神经元中引入非线性特性,使神经网络可以处理非线性关系。

常用的激活函数包括Sigmoid函数、ReLU函数和Tanh函数等。

2. 前向传播前向传播是指神经网络从输入层到输出层的信息传递过程。

在前向传播中,每个神经元将根据输入和连接权重进行加权求和,并经过激活函数得到输出。

这个过程会一直进行,直到输出层。

3. 反向传播反向传播是神经网络训练的核心算法,它通过技术称为梯度下降的方法来调整网络中神经元的连接权重,使得神经网络能够适应输入数据。

反向传播通过计算输出与标签之间的误差,并根据误差梯度来更新权重值,以减小误差。

4. 损失函数损失函数用来衡量神经网络的输出与标签之间的误差。

常见的损失函数包括均方误差(MSE)和交叉熵损失等。

5. 优化算法优化算法用于调整神经网络中的参数,以最小化损失函数。

常见的优化算法包括随机梯度下降(SGD)和Adam算法等。

三、神经网络的应用神经网络已经在各个领域取得了广泛的应用,以下是一些典型的应用领域。

1. 图像识别神经网络在图像识别领域具有非常广泛的应用。

通过训练,神经网络可以学习识别图像中的物体、场景以及人脸等特征,并且具备一定的鲁棒性和泛化能力。

2. 自然语言处理神经网络在自然语言处理中也有很多应用,如文本分类、命名实体识别、情感分析等。

通过构建适当的神经网络模型,可以从大规模文本数据中提取特征,并进行语义理解和文本生成等任务。

3. 推荐系统神经网络在推荐系统中可以发挥重要作用。

神经网络入门指南从零开始学习神经网络的基础知识神经网络入门指南:从零开始学习神经网络的基础知识神经网络作为一种模拟人脑神经系统的计算模型,已经在各个领域得到了广泛的应用。

从图像识别、语音识别、自然语言处理,到游戏智能化等,神经网络已经逐步成为机器智能领域的重要基础技术之一。

本篇文章将从零开始介绍神经网络的基础知识,帮助初学者快速掌握神经网络的基本原理及应用。

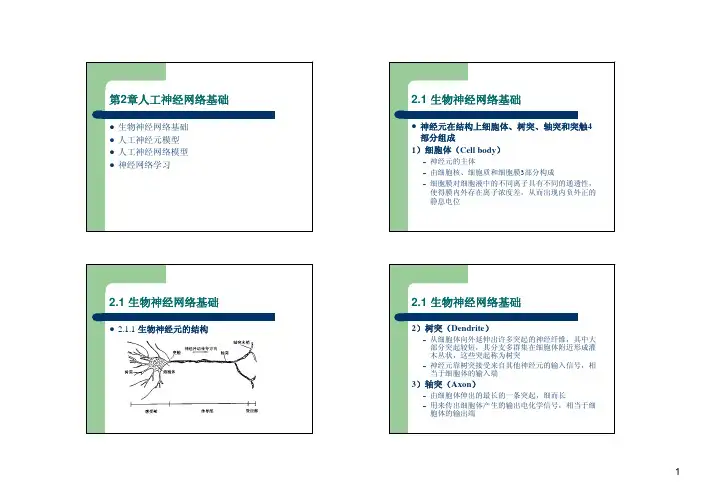

一、什么是神经网络?神经网络是一种模拟人脑神经系统的计算模型,其基本原理是通过模仿生物神经元之间的相互连接和信息传递来实现复杂的信息处理功能。

简单来说,神经网络就是由一个由神经元和神经元之间的连接组成的网络。

二、神经网络的基本结构神经网络的基本结构包括输入层、隐藏层和输出层。

其中输入层用于接受外部输入信息;隐藏层根据输入信息进行“加工”,并向下一层传递信息;输出层将隐藏层传递过来的信息进行最终的处理和输出。

三、神经网络的工作原理神经网络的工作原理可以简单概括为“学习”和“推理”两个过程。

具体来讲,它通过不断调整网络参数,使网络模型能够根据训练数据进行学习,获得越来越准确的预测结果;在真实数据到来时,神经网络便可以通过这些已经学习到的规律,对新的数据进行推理和预测。

四、神经网络的应用1. 图像识别神经网络在图像识别领域的应用已经相当成熟,它可以通过学习大量的图像数据,并利用其内部的特征分析方法来实现对图像的智能化识别。

2. 语音识别语音识别是神经网络另一个重要应用领域。

神经网络可以通过语音信号分析技术,将语音信号转化为数字信号,并通过特征提取、分类等技术,实现对语音的自动识别。

3. 自然语言处理在自然语言处理领域,神经网络已经成为了文本分类、语种识别、情感分析等关键技术之一。

通过神经网络的“学习”和“推理”能力,它可以自动地理解、分析和理解大量的自然语言文本信息。

4. 游戏智能化在大型游戏开发中,神经网络也具有非常重要的应用前景。

它可以通过学习玩家的习惯和操作行为,实现对玩家行为的预测,同时还可以对游戏场景的元素进行分析和规划,实现对游戏智能化水平的提升。

数学与机器学习神经网络的数学基础在当今科技飞速发展的时代,机器学习特别是神经网络已经成为了热门的研究领域,并在众多应用中取得了显著的成果。

然而,要深入理解和掌握机器学习中的神经网络,离不开坚实的数学基础。

这就如同建造高楼大厦需要稳固的地基一样,数学为神经网络的构建和运作提供了不可或缺的理论支撑。

首先,让我们来谈谈线性代数。

线性代数在神经网络中扮演着至关重要的角色。

向量和矩阵是线性代数中的基本概念,而在神经网络中,数据常常被表示为向量或矩阵的形式。

例如,输入的数据可以是一个向量,其中每个元素代表一个特征;而神经网络的权重则通常被组织成矩阵。

通过矩阵运算,我们能够高效地处理大量的数据,并实现神经网络中的前向传播和反向传播过程。

矩阵乘法是神经网络中常见的操作之一。

在前向传播过程中,输入向量与权重矩阵相乘,再加上偏置项,经过激活函数的处理,得到输出。

这个过程不断重复,从输入层经过隐藏层最终到达输出层,实现了对数据的学习和预测。

而在反向传播中,通过计算误差对权重的梯度,利用矩阵乘法来更新权重,从而优化神经网络的性能。

概率论和统计学也是神经网络的重要数学基石。

在训练神经网络时,我们需要处理不确定性和随机性。

例如,数据可能存在噪声,模型的预测也不是绝对准确的。

概率分布用于描述数据的不确定性,常见的如正态分布、伯努利分布等。

通过对数据的概率建模,我们可以更好地理解数据的特征和规律。

统计学中的概念如均值、方差、协方差等,帮助我们对数据进行分析和预处理。

例如,通过计算数据的均值和方差进行标准化,使得不同特征在数值上具有可比性,有助于提高神经网络的训练效果。

同时,统计学中的假设检验、置信区间等方法,可以用于评估模型的性能和可靠性。

微积分在神经网络的优化中起着关键作用。

神经网络的训练本质上是一个优化问题,即寻找最优的权重使得损失函数最小化。

而微积分中的导数和梯度概念为解决这个优化问题提供了有力的工具。

通过计算损失函数对权重的梯度,我们可以确定权重调整的方向和幅度,从而逐步优化神经网络。

本文提出了一种基于基函数神经网络的混沌加密算法。

计算机仿真和推论证明,利用一组正交函数能够良好的逼近任意非线性映射和处理系统内在的难以解析表达的规律性。

利用正交函数集作为神经网络的基函数,构造正交基函数神经网络,并应用的混沌加密中,可产生比单一混沌映射更多的、性能更接近理论值的混沌序列,同时基于该模型的混沌加密方案具有高度的保密性和灵敏性。

关键词: 正交基网络;混沌序列;加密从20世纪70年代开始,以公钥密码和数据加密标准DES为标志,现代密码学的研究进入了一个崭新的发展时代,混沌密码、神经网络密码和基因密码等各种新型的密码大量出现。

目前许多文献中讨论和给出的混沌保密通信方案都是基于单一的混沌映射模型进行设计和分析。

由于计算精度的限制,实际中只能产生有限长的混沌序列,有限长的混沌序列的统计性能与理论值(无限长时) 存在很大差异,这就限制了基于单一混沌映射产生的、能够同时满足自相关和互相关性能的混沌序列的数量。

解决此问题的可能方案是采用多个混沌系统来进行设计,但不同的混沌系统均需要单独设计,且一旦完成设计,其系统结构和参数的变更就难以实现,而且映射关系可以用显式给出,具有一定的被破译风险。

随着近年来非线性理论的发展,小波、混沌、分形和神经网络等逐渐成熟,提供了研究信息加密的理论基础。

利用神经网络产生混沌序列,只需充分利用神经网络的灵活性,在统一的系统结构下,通过变更网络的连接权值就可实现不同混沌系统产生的各种混沌序列,同时将混沌映射关系变为隐式形式,使其更具隐蔽性。

根据Shannon信息论原理,唯一能完全保密的加密算法是“一次一密”序列加密算法,但其存在着难以克服的分配大量随机密钥流和失去同步后如何同步等缺陷,本文介绍了一种基于正交基函数神经网络的新型混沌控制序列的异步加密算法,可顺利的解决这些问题。

第一节 正交基函数神经网络1.1正函数集对于0≠n a 的n次多项式∑=⋯==ni iin n x ax g 0),2,1,0()(;若满足如下内积关系:⎩⎨⎧=≠=⋅⎰nm K n m dt t g t g m t t n m ,,0)()(21(1)则称多项式序列{)(x g n ,n=0,1,2,…}在[a,b]上正交,并称)(x g n 为[a,b]上的n 次正交多项式基函数,简称n 次正交多项式。

Python深度学习02:神经网络的数学基础2.1 初始神经网络MNIST数据集:手写数字的灰度图像(28 像素×28 像素),包含 60 000 张训练图像和 10 000 张测试图像。

类:分类问题中的某个类别叫作类(class)样本:数据点叫作样本(sample)标签:某个样本对应的类叫作标签(label)损失函数(loss function):网络如何衡量在训练数据上的性能,即网络如何朝着正确的方向前进。

优化器(optimizer):基于训练数据和损失函数来更新网络的机制。

在训练和测试过程中需要监控的指标(metric):本例只关心精度,即正确分类的图像所占的比例使用 Keras 库,加载数据集,代码如下:1 from keras.datasets import mnist2 from keras import models3 from keras import layers4 from keras.utils import to_categorical56 # 加载 Keras 中的 MNIST 数据集7 (train_images, train_labels), (test_images, test_labels) = mnist.load_data()89 #标签10 train_labels = to_categorical(train_labels)11 test_labels = to_categorical(test_labels)1213 #准备图像数据14 train_images = train_images.reshape((60000, 28 * 28))15 train_images = train_images.astype('float32') / 25516 test_images = test_images.reshape((10000, 28 * 28))17 test_images = test_images.astype('float32') / 2551819 #构建网络模型20 network = models.Sequential()21 network.add(layers.Dense(512, activation='relu', input_shape=(28 * 28,)))22 network.add(layers.Dense(10, activation='softmax'))2324 #编译的三个参数25 pile(optimizer='rmsprop',26 loss='categorical_crossentropy',27 metrics=['accuracy'])2829 #拟合模型30 network.fit(train_images, train_labels, epochs=5, batch_size=128)3132 #查看测试集性能33 test_loss, test_acc = network.evaluate(test_images, test_labels)2.2 神经网络的数据表示张量:当前所有机器学习系统都使用张量作为基本数据结构,张量的维度(dimension)通常叫作轴(axis)。