神经网络C语言实现

- 格式:docx

- 大小:8.10 KB

- 文档页数:8

C语言中的人工智能算法实现C语言是一种广泛应用于系统编程和嵌入式开发领域的高级编程语言,它非常适合实现人工智能算法。

人工智能算法是近年来备受关注的一个研究领域,它涉及到模拟人类智力和思维过程的算法和技术,为计算机赋予智能。

在C语言中实现人工智能算法需要用到一些基本的数据结构和算法,在此我将介绍几种常见的人工智能算法在C语言中的实现方式。

首先是人工神经网络(Artificial Neural Network,ANN),它是一种模拟人脑神经网络的计算模型。

在C语言中实现神经网络算法时,可以使用矩阵运算库来简化计算过程,比如可以使用OpenBLAS或者Eigen等库来进行矩阵运算。

神经网络实现的关键是构建多层神经元,并定义激活函数和损失函数,通过反向传播算法调整权重和偏置,从而实现模型训练和预测。

其次是遗传算法(Genetic Algorithm,GA),它是受自然选择理论启发的一种优化算法。

在C语言中实现遗传算法时,可以定义个体的遗传编码、适应度函数和交叉、变异等操作。

通过不断进化种群中的个体,找到最优解。

在实现遗传算法时,可以使用C语言的随机数生成函数来生成随机种群,并使用适应度函数评估个体的优劣。

另外是模拟退火算法(Simulated Annealing,SA),它是一种基于退火原理的全局优化算法。

在C语言中实现模拟退火算法时,需要定义能量函数和状态转移函数,并通过控制温度参数来模拟退火过程。

模拟退火算法通过随机接受次优解的策略,逐步逼近全局最优解。

最后是强化学习算法(Reinforcement Learning,RL),它是一种基于奖励信号学习的算法。

在C语言中实现强化学习算法时,可以使用Q-learning或者Deep Q-learning等方法。

强化学习算法通过与环境的交互获得奖励信号,通过更新价值函数或策略函数来实现智能决策。

总的来说,C语言在实现人工智能算法时需要考虑如何高效利用内存和CPU资源,避免内存泄漏和性能瓶颈。

C语言机器学习算法实现决策树和神经网络在机器学习领域中,决策树和神经网络是两个广泛应用的算法。

本文将介绍如何使用C语言实现这两个算法,并讨论它们在决策问题和模式识别中的应用。

一、决策树算法的实现决策树是一种常用的分类算法,它通过树状结构来表示分类的决策过程。

在C语言中,可以使用结构来表示决策树的节点,并使用递归来构建整个树。

1. 数据结构定义首先,我们需要定义一个结构来表示决策树的节点,包含以下几个成员变量:- 分割特征:表示当前节点的特征- 分割阈值:表示当前节点的特征值划分的阈值- 左子树:表示当前节点的左子树- 右子树:表示当前节点的右子树- 叶子节点标签:表示当前节点为叶子节点时的分类标签typedef struct DecisionTreeNode {int feature;float threshold;struct DecisionTreeNode* left;struct DecisionTreeNode* right;int label;} DecisionTreeNode;2. 构建决策树使用递归的方法构建决策树,可以分为以下几个步骤:- 选择最优特征:根据某种特征选择准则,选择最能降低不纯度的特征作为当前节点的分割特征- 按特征值划分数据:根据分割特征和阈值,将数据分为左子树和右子树两部分- 递归构建子树:对左子树和右子树分别进行递归构建,直到满足停止条件(如叶子节点标签纯度达到一定阈值)3. 决策过程构建好决策树后,我们可以使用它进行分类预测。

对于待预测的样本,从根节点开始依次比较当前节点的特征和阈值,根据比较结果选择左子树或右子树,直到到达叶子节点,叶子节点的标签即为预测结果。

二、神经网络算法的实现神经网络是一种模拟人脑神经元网络的算法,它通过多层神经元和连接权值来实现信息处理和模式识别。

在C语言中,可以使用数组和矩阵来表示神经网络的结构和权值,并通过矩阵乘法和激活函数来进行计算。

C语言中的深度学习与神经网络原理

C语言是一种广泛应用于系统编程、嵌入式系统和科学计算等领域的高级编程

语言。

深度学习和神经网络则是近年来在人工智能领域取得巨大成功的技术。

在C 语言中实现深度学习和神经网络需要深入了解这些技术的原理和实现方式。

深度学习是指利用多层次的神经网络进行学习和训练来实现复杂的模式识别和

数据挖掘任务。

神经网络是深度学习的基础,它由多层神经元组成,每一层都经过非线性变换来处理输入数据。

在C语言中实现深度学习和神经网络可以通过手动

编写神经网络的结构和算法来完成。

在实现神经网络时,首先需要定义神经网络的结构,包括网络的层数、每层神

经元的数量以及激活函数的选择等。

然后需要初始化网络的权重和偏置参数,并定义损失函数和优化算法。

接下来通过反向传播算法来更新网络参数,训练网络使其能够学习输入数据的特征和模式。

最后使用训练好的神经网络进行预测和分类任务。

在C语言中实现神经网络需要自行编写神经元、层和网络的数据结构和算法,以及实现各种激活函数、损失函数和优化算法。

在实际编程时需要注意内存管理、数值计算的精度和效率等问题,确保神经网络的训练和预测过程能够顺利进行。

总之,深度学习和神经网络为C语言程序员提供了一个全新的研究和应用领域。

通过深入学习神经网络的原理和算法,结合C语言的优势和特点,可以在C语言

中实现高效的深度学习和神经网络模型,为各种领域的人工智能任务提供强大的支持和解决方案。

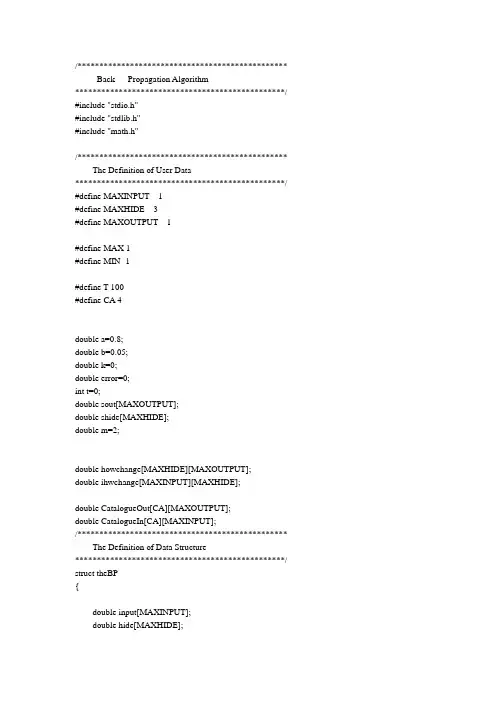

/************************************************ Back Propagation Algorithm************************************************/ #include "stdio.h"#include "stdlib.h"#include "math.h"/************************************************ The Definition of User Data************************************************/ #define MAXINPUT 1#define MAXHIDE 3#define MAXOUTPUT 1#define MAX 1#define MIN -1#define T 100#define CA 4double a=0.8;double b=0.05;double k=0;double error=0;int t=0;double sout[MAXOUTPUT];double shide[MAXHIDE];double m=2;double howchange[MAXHIDE][MAXOUTPUT];double ihwchange[MAXINPUT][MAXHIDE];double CatalogueOut[CA][MAXOUTPUT];double CatalogueIn[CA][MAXINPUT];/************************************************ The Definition of Data Structure************************************************/ struct theBP{double input[MAXINPUT];double hide[MAXHIDE];double output[MAXOUTPUT];double ihw[MAXINPUT][MAXHIDE];double how[MAXHIDE][MAXOUTPUT];};struct theBP bpa;/************************************************ Definition of Prototype************************************************/ void WeightInitial();void InitialError();void InPutCatalogue();void CalculateOut(int k);void CalculateError(int k);void ReverseHideError();void CalculateChange();void CalculateNewWeight();void Test();void TestCalculateOut();void camain();void main(){WeightInitial();// InitialError();InPutCatalogue();//doint m=0;while(1){printf("请选择要进行的操作\n");printf("0----------------学习\n");printf("1----------------测试\n");printf("2----------------退出\n");scanf("%d",&m);switch(m){case 0:camain();break;case 1:Test();break;case 2:exit(0);}//while((error)>k);;}}void camain(){for(t=0;t<T;t++){for(int k=0;k<CA;k++){CalculateOut(k);CalculateError(k);ReverseHideError();CalculateChange();CalculateNewWeight();}for(k=0;k<CA;k++){CalculateOut(k);}}}/************************************************Function:initial the weight************************************************/void WeightInitial(){//产生输入层到隐藏层的权值for(int i=0;i<MAXINPUT;i++){for(int j=0;j<MAXHIDE;j++){bpa.ihw[i][j]=0.3;//((double)rand()/(double)(RAND_MAX))*(MAX-MIN)+MIN;}}//产生从隐藏层到输出层的权值for(i=0;i<MAXHIDE;i++){for(int j=0;j<MAXOUTPUT;j++){bpa.how[i][j]=0.2;//((double)rand()/(double)(RAND_MAX))*(MAX-MIN)+MIN;}}}/************************************************Function:input the Catalogue************************************************/void InPutCatalogue(){for(int k=0;k<CA;k++){printf("请输入第%d个样本的输入值:\n",k);for(int i=0;i<MAXINPUT;i++){scanf("%lf",&bpa.input[i]);CatalogueIn[k][i]=bpa.input[i];}printf("请输入第%d个样本的输出值:\n",k);for(i=0;i<MAXOUTPUT;i++){scanf("%lf",&CatalogueOut[k][i]);}}}/************************************************Function:calculate the out************************************************/void CalculateOut(int k){//计算隐藏层的输出for(int j=0;j<MAXHIDE;j++){double sum2=0;for(int i=0;i<MAXINPUT;i++){bpa.input[i]=CatalogueIn[k][i];sum2+=bpa.ihw[i][j]*bpa.input[i];//计算输入}bpa.hide[j]=1/(1+exp(-sum2));//计算输出}//计算每输出层个单元的输入和输出for(j=0;j<MAXOUTPUT;j++){double sum3=0;for(int i=0;i<MAXHIDE;i++){sum3+=bpa.how[i][j]*bpa.hide[i];//计算输入}bpa.output[j]=m*sum3;//计算输出bpa.output[j]=1/(1+exp(-sum3))printf("第%d个样本的最后输出%lf\n",k,bpa.output[j]);}}void TestCalculateOut(){//计算隐藏层的输出for(int j=0;j<MAXHIDE;j++){double sum1=0;for(int i=0;i<MAXINPUT;i++){sum1=sum1+bpa.ihw[i][j]*bpa.input[i];//计算输入}bpa.hide[j]=1/(1+exp(-sum1));//计算输出}//计算每输出层个单元的输入和输出for(j=0;j<MAXOUTPUT;j++){double sum2=0;for(int i=0;i<MAXHIDE;i++){sum2=sum2+bpa.how[i][j]*bpa.hide[i];//计算输入}bpa.output[j]=m*sum2;//计算输出bpa.output[j]=1/(1+exp(sum2))printf("最后输出%lf\n",bpa.output[j]);}}/************************************************Function:对输出层Calculate************************************************/void CalculateError(int k){double temp=0;error=0;for(int i=0;i<MAXOUTPUT;i++){temp=(CatalogueOut[k][i]-bpa.output[i])*(CatalogueOut[k][i]-bpa.output[i]);error=(0.5)*temp+error;}for(i=0;i<MAXOUTPUT;i++){sout[i]=(CatalogueOut[k][i]-bpa.output[i])*bpa.output[i]*(1-bpa.output[i]);}}/************************************************Function: 从后向前对隐藏层************************************************/void ReverseHideError(){for(int i=0;i<MAXHIDE;i++){double sum=0;for(int j=0;j<MAXOUTPUT;j++){sum+=sout[j]*bpa.how[i][j];}shide[i]=(bpa.hide[i])*(1-bpa.hide[i])*sum;}}/************************************************Function:Calculate the 权值的变化量************************************************/void CalculateChange(){int j=0;//隐藏层到输出层for(int i=0;i<MAXHIDE;i++){for(j=0;j<MAXOUTPUT;j++){howchange[i][j]=a*(howchange[i][j])+b*(sout[i])*(bpa.hide[i]);// }}//对输入层到隐藏层for(i=0;i<MAXINPUT;i++){for(j=0;j<MAXHIDE;j++){ihwchange[i][j]=a*(ihwchange[i][j])+b*(shide[i])*(bpa.input[i]);// }}}/************************************************Function:Calculate the 新的权值************************************************/void CalculateNewWeight(){int j=0;//隐藏层到输出层for(int i=0;i<MAXHIDE;i++){for(j=0;j<MAXOUTPUT;j++){bpa.how[i][j]=bpa.how[i][j]+howchange[i][j];}}//对输入层到隐藏层for(i=0;i<MAXINPUT;i++){for(j=0;j<MAXHIDE;j++){bpa.ihw[i][j]=bpa.ihw[i][j]+ihwchange[i][j];}}}void Test(){printf("请输入测试数据的输入值:\n");for(int i=0;i<MAXINPUT;i++){scanf("%lf",&bpa.input[i]);}TestCalculateOut();}。

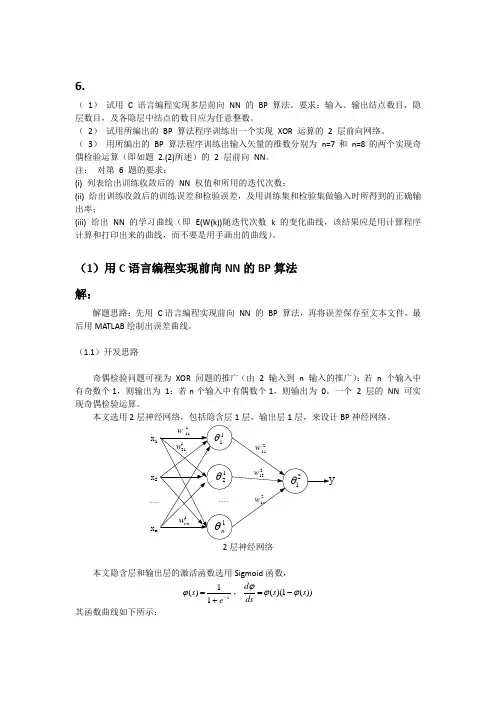

6.( 1) 试用 C 语言编程实现多层前向 NN 的 BP 算法。

要求:输入、输出结点数目,隐层数目,及各隐层中结点的数目应为任意整数。

( 2) 试用所编出的 BP 算法程序训练出一个实现 XOR 运算的 2 层前向网络。

( 3) 用所编出的 BP 算法程序训练出输入矢量的维数分别为 n=7和 n=8的两个实现奇偶检验运算(即如题 2.(2)所述)的 2 层前向 NN 。

注: 对第 6 题的要求:(i) 列表给出训练收敛后的 NN 权值和所用的迭代次数;(ii) 给出训练收敛后的训练误差和检验误差,及用训练集和检验集做输入时所得到的正确输出率;(iii) 给出 NN 的学习曲线(即 E(W(k))随迭代次数 k 的变化曲线,该结果应是用计算程序计算和打印出来的曲线,而不要是用手画出的曲线)。

(1)用C 语言编程实现前向NN 的BP 算法 解:解题思路:先用 C 语言编程实现前向 NN 的 BP 算法,再将误差保存至文本文件,最后用MATLAB 绘制出误差曲线。

(1.1)开发思路奇偶检验问题可视为 XOR 问题的推广(由 2 输入到 n 输入的推广):若 n 个输入中有奇数个1,则输出为 1;若n 个输入中有偶数个1,则输出为 0。

一个 2 层的 NN 可实现奇偶检验运算。

本文选用2层神经网络,包括隐含层1层,输出层1层,来设计BP 神经网络。

x 1x 2x n2层神经网络本文隐含层和输出层的激活函数选用Sigmoid 函数,1()1ss eϕ-=+,()(1())d s s ds ϕϕϕ=- 其函数曲线如下所示:由奇偶检验问题的定义: 可定义如下分类函数:1 y>=1/2Y()0 y<1/2y ⎧=⎨⎩其中y 为BP 神经网络的输出值,Y 为分类结果。

(1.2)运行流程本文的多层前向NN 的BP 算法用 C 语言编程实现,最后将运行结果保存成数据文件,通过MATLAB绘图显示,其运行流程图如上图所示,其源代码见附录部分。

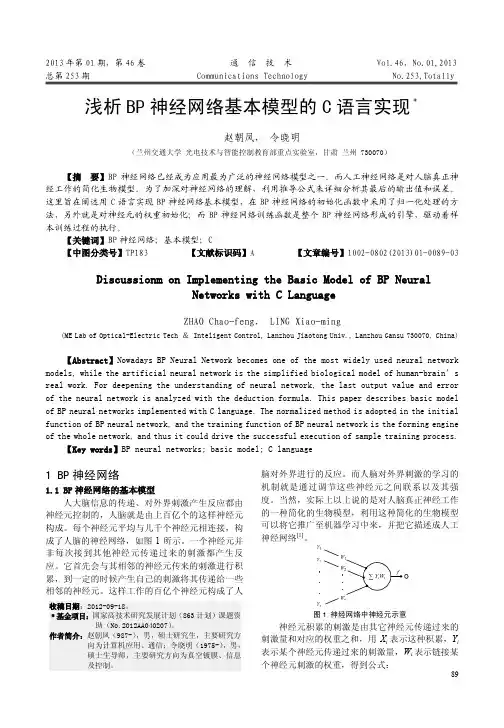

89 2013年第01期,第46卷通信技术 Vol.46,No.01,2013 总第253期 Communications Technology No.253,Totally 浅析BP神经网络基本模型的C语言实现﹡赵朝凤,令晓明(兰州交通大学光电技术与智能控制教育部重点实验室,甘肃兰州 730070)【摘要】BP神经网络已经成为应用最为广泛的神经网络模型之一。

而人工神经网络是对人脑真正神经工作的简化生物模型。

为了加深对神经网络的理解,利用推导公式来详细分析其最后的输出值和误差。

这里旨在阐述用C语言实现BP神经网络基本模型,在BP神经网络的初始化函数中采用了归一化处理的方法,另外就是对神经元的权重初始化;而BP神经网络训练函数是整个BP神经网络形成的引擎,驱动着样本训练过程的执行。

【关键词】BP神经网络;基本模型;C【中图分类号】TP183 【文献标识码】A 【文章编号】1002-0802(2013)01-0089-03 Discussionm on Implementing the Basic Model of BP NeuralNetworks with C LanguageZHAO Chao-feng, LING Xiao-ming(ME Lab of Optical-Electric Tech & Inteligent Control, Lanzhou Jiaotong Univ., Lanzhou Gansu 730070, China) 【Abstract】Nowadays BP Neural Network becomes one of the most widely used neural network models, while the artificial neural network is the simplified biological model of human-brain’s real work. For deepening the understanding of neural network, the last output value and error of the neural network is analyzed with the deduction formula. This paper describes basic model of BP neural networks implemented with C language. The normalized method is adopted in the initial function of BP neural network, and the training function of BP neural network is the forming engine of the whole network, and thus it could drive the successful execution of sample training process.【Key words】BP neural networks; basic model; C language1 BP神经网络1.1 BP神经网络的基本模型人大脑信息的传递、对外界刺激产生反应都由神经元控制的,人脑就是由上百亿个的这样神经元构成。

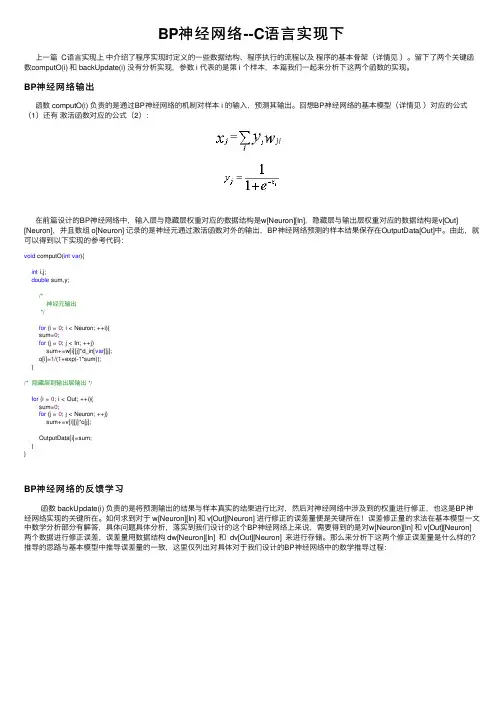

BP神经⽹络--C语⾔实现下上⼀篇 C语⾔实现上中介绍了程序实现时定义的⼀些数据结构、程序执⾏的流程以及程序的基本⾻架(详情见)。

留下了两个关键函数computO(i) 和 backUpdate(i) 没有分析实现,参数 i 代表的是第 i 个样本,本篇我们⼀起来分析下这两个函数的实现。

BP神经⽹络输出函数 computO(i) 负责的是通过BP神经⽹络的机制对样本 i 的输⼊,预测其输出。

回想BP神经⽹络的基本模型(详情见)对应的公式(1)还有激活函数对应的公式(2):在前篇设计的BP神经⽹络中,输⼊层与隐藏层权重对应的数据结构是w[Neuron][In],隐藏层与输出层权重对应的数据结构是v[Out] [Neuron],并且数组 o[Neuron] 记录的是神经元通过激活函数对外的输出,BP神经⽹络预测的样本结果保存在OutputData[Out]中。

由此,就可以得到以下实现的参考代码:void computO(int var){int i,j;double sum,y;/*神经元输出*/for (i = 0; i < Neuron; ++i){sum=0;for (j = 0; j < In; ++j)sum+=w[i][j]*d_in[var][j];o[i]=1/(1+exp(-1*sum));}/* 隐藏层到输出层输出 */for (i = 0; i < Out; ++i){sum=0;for (j = 0; j < Neuron; ++j)sum+=v[i][j]*o[j];OutputData[i]=sum;}}BP神经⽹络的反馈学习函数 backUpdate(i) 负责的是将预测输出的结果与样本真实的结果进⾏⽐对,然后对神经⽹络中涉及到的权重进⾏修正,也这是BP神经⽹络实现的关键所在。

如何求到对于 w[Neuron][In] 和 v[Out][Neuron] 进⾏修正的误差量便是关键所在!误差修正量的求法在基本模型⼀⽂中数学分析部分有解答,具体问题具体分析,落实到我们设计的这个BP神经⽹络上来说,需要得到的是对w[Neuron][In] 和 v[Out][Neuron]两个数据进⾏修正误差,误差量⽤数据结构 dw[Neuron][In] 和 dv[Out][Neuron] 来进⾏存储。

BP神经网络算法的C语言实现代码以下是一个BP神经网络的C语言实现代码,代码的详细说明可以帮助理解代码逻辑:```c#include <stdio.h>#include <stdlib.h>#include <math.h>#define INPUT_SIZE 2#define HIDDEN_SIZE 2#define OUTPUT_SIZE 1#define LEARNING_RATE 0.1//定义神经网络结构体typedef structdouble input[INPUT_SIZE];double hidden[HIDDEN_SIZE];double output[OUTPUT_SIZE];double weights_ih[INPUT_SIZE][HIDDEN_SIZE];double weights_ho[HIDDEN_SIZE][OUTPUT_SIZE];} NeuralNetwork;//激活函数double sigmoid(double x)return 1 / (1 + exp(-x));//创建神经网络NeuralNetwork* create_neural_networNeuralNetwork* nn =(NeuralNetwork*)malloc(sizeof(NeuralNetwork));//初始化权重for (int i = 0; i < INPUT_SIZE; i++)for (int j = 0; j < HIDDEN_SIZE; j++)nn->weights_ih[i][j] = (double)rand( / RAND_MAX * 2 - 1;}}for (int i = 0; i < HIDDEN_SIZE; i++)for (int j = 0; j < OUTPUT_SIZE; j++)nn->weights_ho[i][j] = (double)rand( / RAND_MAX * 2 - 1;}}return nn;//前向传播void forward(NeuralNetwork* nn)//计算隐藏层输出for (int i = 0; i < HIDDEN_SIZE; i++)double sum = 0;for (int j = 0; j < INPUT_SIZE; j++)sum += nn->input[j] * nn->weights_ih[j][i];}nn->hidden[i] = sigmoid(sum);}//计算输出层输出for (int i = 0; i < OUTPUT_SIZE; i++)double sum = 0;for (int j = 0; j < HIDDEN_SIZE; j++)sum += nn->hidden[j] * nn->weights_ho[j][i];}nn->output[i] = sigmoid(sum);}void backpropagation(NeuralNetwork* nn, double target)//计算输出层误差double output_error[OUTPUT_SIZE];for (int i = 0; i < OUTPUT_SIZE; i++)double delta = target - nn->output[i];output_error[i] = nn->output[i] * (1 - nn->output[i]) * delta;}//更新隐藏层到输出层权重for (int i = 0; i < HIDDEN_SIZE; i++)for (int j = 0; j < OUTPUT_SIZE; j++)nn->weights_ho[i][j] += LEARNING_RATE * nn->hidden[i] * output_error[j];}}//计算隐藏层误差double hidden_error[HIDDEN_SIZE];for (int i = 0; i < HIDDEN_SIZE; i++)double delta = 0;for (int j = 0; j < OUTPUT_SIZE; j++)delta += output_error[j] * nn->weights_ho[i][j];}hidden_error[i] = nn->hidden[i] * (1 - nn->hidden[i]) * delta;}//更新输入层到隐藏层权重for (int i = 0; i < INPUT_SIZE; i++)for (int j = 0; j < HIDDEN_SIZE; j++)nn->weights_ih[i][j] += LEARNING_RATE * nn->input[i] * hidden_error[j];}}void train(NeuralNetwork* nn, double input[][2], double target[], int num_examples)int iteration = 0;while (iteration < MAX_ITERATIONS)double error = 0;for (int i = 0; i < num_examples; i++)for (int j = 0; j < INPUT_SIZE; j++)nn->input[j] = input[i][j];}forward(nn);backpropagation(nn, target[i]);error += fabs(target[i] - nn->output[0]);}//判断误差是否已达到允许范围if (error < 0.01)break;}iteration++;}if (iteration == MAX_ITERATIONS)printf("Training failed! Error: %.8lf\n", error); }void predict(NeuralNetwork* nn, double input[]) for (int i = 0; i < INPUT_SIZE; i++)nn->input[i] = input[i];}forward(nn);printf("Prediction: %.8lf\n", nn->output[0]); int maiNeuralNetwork* nn = create_neural_network(; double input[4][2] ={0,0},{0,1},{1,0},{1,1}};double target[4] =0,1,1,};train(nn, input, target, 4);predict(nn, input[0]);predict(nn, input[1]);predict(nn, input[2]);predict(nn, input[3]);free(nn);return 0;```以上代码实现了一个简单的BP神经网络,该神经网络包含一个输入层、一个隐藏层和一个输出层。

C语言人工智能神经网络和机器学习人工智能(Artificial Intelligence,简称AI)作为当今科技领域的热门话题,其中的神经网络和机器学习技术更是备受关注。

在编程领域,C语言作为一种高效、灵活且广泛应用的程序设计语言,也被用于实现人工智能中的神经网络和机器学习算法。

本文将探讨C语言在人工智能神经网络和机器学习方面的应用。

一、人工智能神经网络(Artificial Neural Networks)人工智能神经网络是一种模拟人脑神经元网络工作方式的计算模型,主要通过模拟大量的人工神经元之间的连接和信息传递来实现学习和决策的功能。

使用C语言来实现神经网络,可以充分发挥其高效的计算性能和底层控制能力。

1. 神经元的模拟:C语言可以通过定义结构体来实现神经元的模拟。

结构体中包含了神经元的各个属性,如输入权重、阈值等。

通过使用指针和动态内存分配,可以方便地创建和管理神经元。

2. 神经网络的连接:C语言的指针和数据结构特性非常适合用于实现神经网络之间的连接。

可以使用链表或数组等数据结构来表示神经网络的拓扑结构,并通过指针将各个神经元连接起来。

3. 神经网络的训练:通过定义合适的激活函数、损失函数和优化算法等,可以用C语言来实现神经网络的训练过程。

例如,可以使用反向传播算法更新神经元之间的权重和阈值,并根据给定的训练数据进行优化。

二、机器学习(Machine Learning)机器学习是人工智能的一个重要分支,它的目标是让机器具备通过经验学习和不断优化自身性能的能力。

C语言可以作为一种强大的工具,用于实现各种机器学习算法。

1. 监督学习:C语言可以通过定义结构体和函数来实现监督学习中的回归和分类算法。

例如,可以使用线性回归、逻辑回归等算法来进行数据拟合和分类任务。

2. 无监督学习:C语言也可以用于实现无监督学习中的聚类和降维算法。

例如,可以使用K均值聚类算法或主成分分析算法来对数据进行聚类或降维处理。

C语言实现的人工神经网络人工神经网络(Artificial Neural Network,简称ANN)是一种受到人脑神经元启发的计算模型,用于模拟和解决复杂的计算问题。

C语言是一种高级编程语言,具有广泛的应用领域和强大的计算能力。

本文将介绍如何使用C语言来实现人工神经网络,并探讨其应用和优势。

一、人工神经网络简介人工神经网络是由大量的人工神经元组成的网络结构,其中每个神经元都与其他神经元相连。

每个神经元接收一组输入信号,并通过权重和激活函数来计算输出。

神经网络通过不断训练和调整权重,以便学习和适应输入信号的模式,最终实现对复杂问题的解决。

二、C语言实现神经网络的步骤1. 定义数据结构在C语言中,我们可以使用结构体来定义神经元和神经网络,包括神经元的输入、输出、权重等参数。

2. 初始化神经网络在使用神经网络之前,我们需要对其进行初始化。

可以随机初始化神经元的权重,并设置其他参数如学习率等。

3. 前向传播前向传播是指从输入层开始,逐层计算每个神经元的输出值,并将其传递到下一层。

通过定义激活函数,我们可以实现对神经元输出的非线性变换。

4. 反向传播反向传播是神经网络的训练过程,通过计算损失函数的导数,将误差从输出层反向传递到输入层,并根据梯度下降算法来调整权重。

5. 更新权重根据反向传播的计算结果和学习率,我们可以更新每个神经元的权重,以提高神经网络的性能和准确性。

6. 循环迭代通过多次重复执行前向传播和反向传播,直到神经网络收敛或达到预定的训练轮数。

三、C语言实现神经网络的应用1. 图像识别通过训练神经网络,可以实现对图像中物体的自动识别和分类。

利用C语言实现的神经网络可以处理大量的图像数据,并能够识别出数字、人脸、动物等特定的目标。

2. 语音识别神经网络在语音识别领域有着广泛的应用。

通过训练神经网络,可以实现对语音信号的识别和转录,将人类的语音转化为文本数据。

利用C语言实现的神经网络可以处理实时的语音数据,并能够实现语音识别的高效率和准确性。

1 1 -1 1 -1 1 0 1 0 1神经网络BP算法(C程序)文件输入输出目录为: F:\BP\训练样本文件名: 训练样本.txt值为:1 1 -1 1 -1 1 0 1 0 1 输出文件名为: 阈值.txt 权值.txt=========================#include "stdlib.h"#include "math.h"#include "conio.h"#include "stdio.h"#define N 2 /*/学习样本个数*/#define IN 3 /*/输入层神经元数目*/#define HN 3 /*/隐层神经元数目*/#define ON 2 /*/输出层神经元数目*/#define Z 20 /*旧权值保存,每次study的权值都保存下来*/ double P[IN]; /*单个样本输入数据*/double T[ON]; /*单个样本输出数据*/double W[HN][IN]; /*/输入层至隐层权值*/double V[ON][HN]; /*/隐层至输出层权值*/double X[HN]; /*/隐层的输入*/double Y[ON]; /*/输出层的输入*/double H[HN]; /*/隐层的输出*/double O[ON]; /*/输出层的输出*/double YU_HN[HN]; /*/隐层的阈值*/double YU_ON[ON]; /*/输出层的阈值*/double err m[N]; /*/第m个样本的总误差*/double a; /*/输出层至隐层的学习效率*/double b; /*/隐层至输入层学习效率*/double alpha; /*/动量因子, 改进型bp算法使用*/ double d err[ON];FILE *fp;/*定义一个放学习样本的结构*/struct {double input[IN];double teach[ON];}Study_Data[N];/*改进型bp算法用来保存每次计算的权值*/struct {double old_W[HN][IN];double old_V[ON][HN];}Old_WV[Z];显示开始界面int Start_Show(){clrscr();printf("\n ***********************\n");printf(" * Welcome to use *\n");printf(" * this program of *\n");printf(" * calculating the BP *\n");printf(" * model! *\n");printf(" * Happy every day! *\n");printf(" ***********************\n");printf("\n\n Before starting, please read the follows carefully:\n\n");printf(" 1.Please ensure the Path of the '训练样本.txt'(xunlianyangben.txt) is \n correct, like 'F:\BP\训练样本.txt'!\n");printf(" 2.The calculating results will be saved in the Path of 'F:\\BP\\'!\n");printf(" 3.The program will load 10 datas when running from 'F:\\BP\\训练样本.txt'!\n");printf(" 4.The program of BP can study itself for no more than 30000 times.\n And surpassing the number, the program will be ended by itself in\n preventing running infinitely because of error!\n");printf("\n\n\n");printf("Now press any key to start...\n");getch();getch();clrscr();}显示结束界面int End_Show(){printf("\n\n---------------------------------------------------\n");printf("The program has reached the end successfully!\n\n Press any key to exit!\n\n");printf("\n ***********************\n");printf(" * This is the end *\n");printf(" * can calculate the BP*\n");printf(" * model! *\n");printf(" ***********************\n");printf(" * Thanks for using! *\n");printf(" * Happy every day! *\n");printf(" ***********************\n");getch();exit(0);}获取训练样本GetTrainingData() /*OK*/{ int m,i,j;int datr;if((fp=fopen("f:\\bp\\训练样本.txt","r"))==NULL) /*读取训练样本*/{printf("Cannot open file and strike any key exit!");getch();exit(1);}m=0;i=0;j=0;while(fscanf(fp,"%d",&datr)!=EOF){ j++;if(j<=(N*IN)) /*N为学习样本个数;IN为输入层神经元数目*/{if(i<IN){Study_Data[m].input[i]=datr;/*printf("\nthe Study_Datat[%d].input[%d]=%f\n",m,i,Study_Data[m].input[i]);getch();*/ /*use to check the loaded training datas*/}if(m==(N-1)&&i==(IN-1)){m=0;i=-1;}if(i==(IN-1)){m++;else if((N*IN)<J&&J<=(N*(IN+ON))){if(i<ON){Study_Data[m].teach[i]=datr;/*printf("\nThe Study_Data[%d].teach[%d]=%f",m,i,Study_Data[m].teach[i]);getch();*/ /*use to check the loaded training datas*/}if(m==(N-1)&&i==(ON-1))printf("\n");if(i==(ON-1)){m++;i=-1;}}i++;}fclose(fp);printf("\nThere are [%d] datats that have been loaded successfully!\n",j);/*show the data which has been loaded!*/printf("\nShow the data which has been loaded as follows:\n");for(m=0;m<N;M++){for(i=0;i<IN;I++){printf("\nStudy_Data[%d].input[%d]=%f",m,i,Study_Data[m].input[i]);}for(j=0;j<ON;J++){printf("\nStudy_Data[%d].teach[%d]=%f",m,j,Study_Data[m].teach[j]);}}printf("\n\nPress any key to start calculating...");getch();return 1;}/*///////////////////////////////////*//*初始化权、阈值子程序*//*///////////////////////////////////*/initial(){int i;int ii;int j;/*隐层权、阈值初始化*/for(i=0;i<HN;i++){for(j=1;j<IN;j++){W[i][j]=(double)((rand()/32767.0)*2-1); /*初始化输入层到隐层的权值, 随机模拟0 和1 -1 */ printf("w[%d][%d]=%f\n",i,j,W[i][j]);}}for(ii=0;ii<ON;II++){for(jj=0;jj<HN;JJ++){V[ii][jj]= (double)((rand()/32767.0)*2-1); /*初始化隐层到输出层的权值, 随机模拟0 和1 -1*/ printf("V[%d][%d]=%f\n",ii,jj,V[ii][jj]);}}for(k=0;k<HN;K++){YU_HN[k] = (double)((rand()/32767.0)*2-1); /*隐层阈值初始化,-0.01 ~ 0.01 之间*/printf("YU_HN[%d]=%f\n",k,YU_HN[k]);}for(kk=0;kk<ON;KK++){YU_ON[kk] = (double)((rand()/32767.0)*2-1); /*输出层阈值初始化,-0.01 ~ 0.01 之间*/}return 1;}/*子程序initial()结束*//*//////////////////////////////////////////*//*第m个学习样本输入子程序*//*/////////////////////////////////////////*/input_P(int m){ int i,j;for(i=0;i<IN;I++){P[i]=Study_Data[m].input[i];printf("P[%d]=%f\n",i,P[i]);}/*获得第m个样本的数据*/return 1;}/*子程序input_P(m)结束*//*/////////////////////////////////////////*//*第m个样本教师信号子程序*//*/////////////////////////////////////////*/input_T(int m)for(k=0;k<ON;k++)T[k]=Study_Data[m].teach[k];return 1;}/*子程序input_T(m)结束*/H_I_O(){double sigma;int i,j;for(j=0;j<HN;j++){sigma=0;for(i=0;i<IN;i++){sigma+=W[j][i]*P[i];/*求隐层内积*/}X[j]=sigma-YU_HN[i];/*求隐层净输入, 为什么减隐层的阀值*/ H[j]=1.0/(1.0+exp(-X[j]));/*求隐层输出siglon算法*/}return 1;}/*子程序H_I_O()结束*/O_I_O(){int k;int j;double sigma;for(k=0;k<ON;k++){sigma=0.0;for(j=0;j<HN;j++){sigma+=V[k][j]*H[k];}Y[k]=sigma-YU_ON[k];O[k]=1.0/(1.0+exp(-Y[k]));}return 1;}int Err_O_H(int m){int k;double abs_err[ON];double sqr_err=0;for (k=0;k<ON;k++){abs_err[k]=T[k]-O[k];sqr_err+=(abs_err[k])*(abs_err[k]);err_m[m]=sqr_err/2;}return 1;}double e_err[HN];int Err_H_I(){int j,k;double sigma;for(j=0;j<HN;j++){sigma=0.0;for(k=0;k<ON;k++){sigma+=d_err[k]*V[k][j];}e_err[j]=sigma*H[j]*(1-H[j]);}return 1;}saveWV(int m){int i;int ii;int j;int jj;for(i=0;i<HN;i++){for(j=0;j<IN;j++){Old_WV[m].old_W[i][j] = W[i][j];}}for(ii=0;ii<ON;ii++){for(jj=0;jj<HN;jj++){Old_WV[m].old_V[ii][jj] = V[ii][jj];}}return 1;}int Delta_O_H(int n) /*(int m,int n)*/ {int k,j;for (k=0;k<ON;k++){for (j=0;j<HN;j++){V[k][j]=V[k][j]+a*d_err[k]*H[j];}YU_ON[k]+=a*d_err[k];}}else if(n>1){for (k=0;k<ON;k++){for (j=0;j<HN;j++){V[k][j]=V[k][j]+a*d_err[k]*H[j]+alpha*(V[k][j]-Old_WV[(n-1)].old_V[k][j]);}YU_ON[k]+=a*d_err[k];}}return 1;}Delta_H_I(int n) /*(int m,int n)*/{ int i,j;if(n<=1) /*n<=1*/{for (j=0;j<HN;j++){for (i=0;i<IN;i++){W[j][i]=W[j][i]+b*e_err[j]*P[i];}YU_HN[j]+=b*e_err[j];}}else if(n>1){for(j=0;j<HN;j++){for(i=0;i<IN;i++){W[j][i]=W[j][i]+b*e_err[j]*P[i]+alpha*(W[j][i]-Old_WV[(n-1)].old_W[j][i]);}YU_HN[j]+=b*e_err[j];return 1;}double Err_Sum(){int m;double total_err=0;for(m=0;m<N;m++){total_err+=err_m[m];}return total_err;}void savequan(){ int i,j,k;int ii,jj,kk;if((fp=fopen("f:\\bp\\权值.txt","a"))==NULL) /*save the result at f:\hsz\bpc\*.txt*/{printf("Cannot open file strike any key exit!");getch();exit(1);}fprin tf(fp,"Save the result of “权值”(quanzhi) as follows:\n");for(i=0;i<HN;i++){for(j=0;j<IN;j++)fprintf(fp,"W[%d][%d]=%f\n",i,j,W[i][j]);}fprintf(fp,"\n");for(ii=0;ii<ON;ii++){for(jj=0;jj<HN;jj++)fprintf(fp,"V[%d][%d]=%f\n",ii,jj,V[ii][jj]);}fclose(fp);printf("\nThe result of “权值.txt”(quanzhi) has been saved successfully!\nPress any key to continue..."); getch();if((fp=fopen("f:\\bp\\阈值.txt","a"))==NULL) /*save the result at f:\hsz\bpc\*/{printf("Cannot open file strike any key exit!");getch();exit(1);}fprintf(fp,"Save the result of “输出层的阈值”(huozhi) as follows:\n");for(k=0;k<ON;K++)fprintf(fp,"\nSave the result of “隐层的阈值为”(huozhi) as follows:\n");for(kk=0;kk<HN;KK++)fprintf(fp,"YU_HN[%d]=%f\n",kk,YU_HN[kk]);fclose(fp);printf("\nThe result of “阈值.txt”(huozhi) has been saved successfully!\nPress any key to continue..."); getch ();}/**********************//**程序入口, 即主程序**//**********************/void main(){double Pre_error;double sum_err;int study;int flag;flag=30000;a=0.7;b=0.7;alpha=0.9;study=0;Pre_error=0.0001;/*实际值为Pre_error=0.0001;*/Start_Show(); /*调用函数, 显示开始界面*/GetTrainingData();initial ();do{int m;++study;for(m=0;m<N;m++){input_P(m);input_T(m);H_I_O();O_I_O();Err_O_H(m);Err_H_I();saveWV(m); /****************/Delta_O_H(m); /*(m,study)*/Delta_H_I(m); /*(m,study)*/}sum_err=Err_Sum();printf("sum_err=%f\n",sum_err);printf("Pre_error=%f\n\n",Pre_error);if(study>flag){printf("\n*******************************\n");printf("*****************************\n");getch();break;}} while (sum_err>Pre_error);printf("\n****************\n");printf("\nThe program have studyed for [%d] times!\n",study); printf("\n****************\n");savequan(); /*save the results, 保存计算权值*/End_Show();}==========================权值.txt{Save the result of “权值”(quanzhi) as follows:W[0][0]=0.350578W[0][1]=-1.008697W[0][2]=-0.962250W[1][0]=0.055661W[1][1]=-0.372367W[1][2]=-0.890795W[2][0]=0.129752W[2][1]=-0.332591W[2][2]=-0.521561V[0][0]=-2.932654V[0][1]=-3.720583V[0][2]=-2.648183V[1][0]=2.938970V[1][1]=1.633281V[1][2]=1.944077}阈值.txt{Save the result of “输出层的阈值”(huozhi) as follows:YU_ON[0]=-4.226843YU_ON[1]=1.501791Save the result of “隐层的阈值为”(huozhi) as follows:YU_HN[0]=-0.431459YU_HN[1]=0.452127YU_HN[2]=0.258449}==================================。

C语言中的深度学习和神经网络编程深度学习和神经网络编程在C语言中的应用深度学习和神经网络已成为当今计算机科学领域的热门话题。

随着人工智能的发展,越来越多的开发者开始关注如何在自己的项目中融入深度学习和神经网络。

本文将重点介绍C语言中的深度学习和神经网络编程的基本概念和常用技术。

1. 神经网络基础神经网络是一种模仿人类神经系统工作方式的算法模型。

它由大量的人工神经元组成,通过彼此之间的连接实现信息的传递和处理。

常见的神经网络结构包括前馈神经网络、循环神经网络和卷积神经网络等。

2. C语言中的神经网络库C语言作为一种高效的编程语言,为进行深度学习和神经网络编程提供了广泛的支持。

一些开源的神经网络库如TensorFlow、Caffe和Theano等都提供了C语言的接口,使得开发者可以方便地进行模型的构建和训练。

3. C语言中的深度学习框架除了神经网络库,还有一些专门针对深度学习的框架也提供了C语言的支持。

这些框架通常集成了各种神经网络库,并提供了更加简洁易用的API接口。

例如,DeepLearning4j和Keras等就是C语言中常用的深度学习框架。

4. C语言中的神经网络算法神经网络的核心在于算法的实现。

C语言作为一种底层的编程语言,为开发者提供了更多的自由度来实现自己的神经网络算法。

例如,你可以通过编写C语言代码来实现基本的激活函数、损失函数和优化算法等。

5. C语言中的深度学习案例研究有许多成功的深度学习案例都是使用C语言实现的。

例如,AlphaGo使用了深度神经网络来实现自动下棋,FaceNet使用了卷积神经网络进行人脸识别等。

这些案例为我们提供了宝贵的经验和思路,可以借鉴到我们自己的项目中。

6. C语言中的深度学习资源在进行深度学习和神经网络编程时,有许多优质的资源可以帮助我们更好地学习和实践。

例如,书籍《Deep Learning》和《Neural Networks and Deep Learning》都是非常好的入门资料;同时,许多在线的课程和教程也提供了丰富的学习资源。

基于C语言的神经网络实现研究引言神经网络是一种模仿生物神经系统的计算模型,通过模拟人脑的学习和决策过程,使计算机能够处理复杂的非线性问题。

近年来,随着人工智能的快速发展,神经网络已经成为了一种重要的机器学习方法,并在各个领域取得了广泛应用。

C语言作为一种经典的编程语言,具有高效、灵活和可移植的特点,被广泛应用于系统级开发、嵌入式开发等领域。

在神经网络的实现过程中,C语言提供了丰富的库和工具,能够方便地操作和优化神经网络的计算过程。

因此,基于C语言的神经网络实现研究具有重要的理论意义和实用价值。

本文将从神经网络的基本原理入手,介绍基于C语言的神经网络实现的方法和技术,并深入探讨其中的关键问题和挑战。

通过分析和比较不同的实现方式,提出一种高效和可行的C语言神经网络实现方案。

神经网络基本原理神经网络是由神经元(neuron)构成的网络,每个神经元接收多个输入信号,并根据一定的权重和激活函数进行计算,最终输出一个结果。

多个神经元通过连接形成多层神经网络,其中输入层接收外部输入信号,输出层产生最终的输出结果。

神经网络的训练过程是通过调整神经元之间的连接权重,使得网络能够通过输入信号预测输出结果。

训练过程一般使用反向传播算法,通过比较预测结果和真实结果之间的差距,以最小化误差为目标,更新权重值。

C语言神经网络的实现方法数据结构的设计在C语言中,实现神经网络首先需要设计和定义相应的数据结构。

常用的数据结构包括神经元的结构体、网络层的结构体等。

初始化和销毁网络在使用神经网络之前,需要对网络进行初始化,包括设置输入层的大小、隐藏层和输出层的大小,以及初始化权重和偏置等参数。

网络的销毁操作一般在使用完毕后进行,释放内存资源。

前向传播过程前向传播过程是神经网络的重要计算过程,通过对输入信号进行计算和传递,得到最终的输出结果。

在C语言中,可以通过逐层计算神经元的输入和激活函数,实现前向传播过程。

反向传播过程反向传播过程是神经网络的训练过程,通过比较预测结果和真实结果之间的差距,以最小化误差为目标,更新权重值。

#i n c l u d e"" #include <>const double e = ;//设置一个神经网络//有一个隐藏层(含有两个节点)//输出层有一个节点//输入数据是二维(两个节点)//一个样本数据为:x = , 标签为//初始权值输入节点1到隐藏层:,//输入节点2到隐藏层:,//隐藏层到输出层初始权值为:,//学习速率为1double changeWeightFromHiddenToOutput(double cost,double output,double hiddenLayerCode){double result=0;result = cost*output*(1-output)*hiddenLayerCode;return result;}double changeWeightFromInputToHidden(double cost,double output,double weightOfHiddenCodeToOutput,double weightOfHiddenCode,double inputNum)double result=0;result = cost*output*(1-output)*weightOfHiddenCodeToOutput*weightOfHiddenC ode*(1-weightOfHiddenCode)*inputNum;return result;}double sigmoidFunction(double x){double result=0;result = 1/(1+pow(e,-x));return result;}double costFunction(double originalSignal,double outputOfOurCalculation){//此处采取的损失函数是最小二乘法double cost=0;cost = (1/*(originalSignal-outputOfOurCalculation)*(originalSignal-outpu tOfOurCalculation);return cost;double upDateWeightFunction(double originalValue,double gradient) {double updatedWeight=originalValue;updatedWeight = updatedWeight - fabs(gradient);return updatedWeight;}int main(void){double weightFromInputToHidden[][2]={,,,};double weightFromHiddenToOutput[]={,};double firstHiddenCode,secondHiddenCode,outputCode;double inputValue[] ={,};double originalSignal = ;double cost=0;double weightChangeNum=0;double addWeightSum = 0;firstHiddenCode = 0;secondHiddenCode = 0;outputCode = 0;//前向传播addWeightSum = weightFromInputToHidden[0][0]*inputValue[0] +weightFromInputToHidden[1][0]*inputValue[1];firstHiddenCode = sigmoidFunction(addWeightSum);addWeightSum = weightFromInputToHidden[0][1]*inputValue[0] + weightFromInputToHidden[1][1]*inputValue[1];secondHiddenCode = sigmoidFunction(addWeightSum);addWeightSum = weightFromHiddenToOutput[0]*firstHiddenCode + weightFromHiddenToOutput[1]*secondHiddenCode;outputCode = sigmoidFunction(addWeightSum);//计算误差cost = costFunction(originalSignal,outputCode);printf("\n\n(0)firNode:[%f] secNode:[%f] outNode:[%f] cost:%f",firstHiddenCode,secondHiddenCode,outputCode,cost);printf("\n\n\t\t输入到隐藏层的权值:\t\t");for(int i=0;i<2;i++){printf("\n\t\t");for(int j=0;j<2;j++)printf(" %lf ",weightFromInputToHidden[i][j]);}printf("\n\n\t\t隐藏层到输出的权值:\n\t\t");for(i=0;i<2;i++){printf(" {%lf} ",weightFromHiddenToOutput[i]);}for(int iteration = 0;iteration<1;iteration++){//更新隐藏层到输出层权值//weightChangeNum为相应权值的梯度weightChangeNum = changeWeightFromHiddenToOutput(cost,outputCode,firstHiddenCode);weightFromHiddenToOutput[0] = upDateWeightFunction(weightFromHiddenToOutput[0],weightChangeNum) ;weightChangeNum = changeWeightFromHiddenToOutput(cost,outputCode,secondHiddenCode);weightFromHiddenToOutput[1] = upDateWeightFunction(weightFromHiddenToOutput[1],weightChangeNum) ;//更新输入层到隐藏层的权值weightChangeNum = changeWeightFromInputToHidden(cost,outputCode,weightFromHiddenToO utput[0],firstHiddenCode,inputValue[0]);weightFromInputToHidden[0][0] = upDateWeightFunction(weightFromInputToHidden[0][0],weightChangeNum);weightChangeNum = changeWeightFromInputToHidden(cost,outputCode,weightFromHiddenToO utput[1],secondHiddenCode,inputValue[0]);weightFromInputToHidden[0][1] = upDateWeightFunction(weightFromInputToHidden[0][1],weightChangeNu m);weightChangeNum = changeWeightFromInputToHidden(cost,outputCode,weightFromHiddenToO utput[0],firstHiddenCode,inputValue[1]);weightFromInputToHidden[1][0] = upDateWeightFunction(weightFromInputToHidden[1][0],weightChangeNu m);weightChangeNum = changeWeightFromInputToHidden(cost,outputCode,weightFromHiddenToO utput[1],secondHiddenCode,inputValue[1]);weightFromInputToHidden[1][1] = upDateWeightFunction(weightFromInputToHidden[1][1],weightChangeNu m);//再次进行前向传播addWeightSum = weightFromInputToHidden[0][0]*inputValue[0] + weightFromInputToHidden[1][0]*inputValue[1];firstHiddenCode = sigmoidFunction(addWeightSum);addWeightSum = weightFromInputToHidden[0][1]*inputValue[0] + weightFromInputToHidden[1][1]*inputValue[1];secondHiddenCode = sigmoidFunction(addWeightSum);//输出addWeightSum = weightFromHiddenToOutput[0]*firstHiddenCode + weightFromHiddenToOutput[1]*secondHiddenCode;outputCode = sigmoidFunction(addWeightSum);//计算误差cost = costFunction(originalSignal,outputCode);printf("\n\n(%d)firNode:[%f] secNode:[%f] outNode:[%f] cost:%f",iteration+1,firstHiddenCode,secondHiddenCode,outputCode, cost);printf("\n\n\t\t输入到隐藏层的权值:\t\t");for(int i=0;i<2;i++){printf("\n\t\t");for(int j=0;j<2;j++)printf(" %lf ",weightFromInputToHidden[i][j]);}printf("\n\n\t\t隐藏层到输出的权值:\n\t\t");for(i=0;i<2;i++){printf(" {%lf} ",weightFromHiddenToOutput[i]);}if(cost<{printf("\n\n误差已经小于了!停止^_^\n");break;}}printf("\n\n\t\t");}。