HBase之Spark操作

- 格式:docx

- 大小:16.17 KB

- 文档页数:5

Spark系列:Python版Spark编程指南⽬录⼀、介绍⼆、连接Spark三、创建RDD四、RDD常⽤的转换 Transformation五、RDD 常⽤的执⾏动作 Action⼆、连接SparkSpark1.3.0只⽀持Python2.6或更⾼的版本(但不⽀持Python3)。

它使⽤了标准的CPython解释器,所以诸如NumPy⼀类的C库也是可以使⽤的。

通过Spark⽬录下的bin/spark-submit脚本你可以在Python中运⾏Spark应⽤。

这个脚本会载⼊Spark的Java/Scala库然后让你将应⽤提交到集群中。

你可以执⾏bin/pyspark来打开Python的交互命令⾏。

如果你希望访问HDFS上的数据,你需要为你使⽤的HDFS版本建⽴⼀个PySpark连接。

常见的HDFS版本标签都已经列在了这个第三⽅发⾏版页⾯。

最后,你需要将⼀些Spark的类import到你的程序中。

加⼊如下这⾏:from pyspark import SparkContext, SparkConf在⼀个Spark程序中要做的第⼀件事就是创建⼀个SparkContext对象来告诉Spark如何连接⼀个集群。

为了创建SparkContext,你⾸先需要创建⼀个SparkConf对象,这个对象会包含你的应⽤的⼀些相关信息。

conf = SparkConf().setAppName(appName).setMaster(master)sc = SparkContext(conf=conf)appName参数是在集群UI上显⽰的你的应⽤的名称。

master是⼀个Spark、Mesos或YARN集群的URL,如果你在本地运⾏那么这个参数应该是特殊的”local”字符串。

在实际使⽤中,当你在集群中运⾏你的程序,你⼀般不会把master参数写死在代码中,⽽是通过⽤spark-submit运⾏程序来获得这个参数。

但是,在本地测试以及单元测试时,你仍需要⾃⾏传⼊”local”来运⾏Spark程序。

spark submit 参数

spark submit参数是用于配置Apache Spark程序的命令行选项,该命令用于提交应

用程序到Spark集群,也可在本地模式下运行。

spark submit参数可分为常用参数和调优参数,两者的作用都是让应用程序运行的更加顺利。

1. 常用参数:

(1)--class/-C参数:用来指定应用程序要执行的主类入口,也就是Spark应用程

序开始运行的地方,该参数是必须指定的。

(2)--master/-M参数:用来指定master节点地址,但也可以在环境变量中设置,

如果未在命令中指定,会从环境变量中读取。

(3)--deploy-mode/-d参数:指定程序的部署模式,生产环境之中用cluster模式,本地环境运行的话用client模式。

(4)--executor-memory/-em参数:指定每个executor的内存,一般来说至少20g

以上。

(5)--conf/-co参数:指定额外的配置参数,用于覆盖Spark缺省配置,增强应用

程序的可配置性。

(6)--name/-n参数:指定应用程序的名称,可通过这个名称来在spark web UI上

查看应用程序的执行进程。

2. 调优参数:

总之,spark submit参数可以帮助我们快速高效地完成应用程序,保证程序运行的顺利。

在使用spark submit参数时,除了要了解参数的含义外,还应该遵守它们之间的兼

容性和互斥性,这样才能更好地提高程序性能。

SparkStreaming实时数据分析与处理Spark Streaming是基于Apache Spark的分布式实时数据处理引擎,允许用户在实时处理中使用Spark的强大算法和可扩展性。

Spark Streaming可以从多种数据源接收数据,如Kafka、Flume、Twitter和网络套接字,并可将处理后的数据发送到HDFS、Cassandra、HBase和其他数据存储或查询系统中。

本文将介绍Spark Streaming的基础知识、架构、应用场景和优势,并展示如何利用Spark Streaming进行实时数据分析与处理。

一、Spark Streaming的基础知识Spark Streaming是Spark的一部分,它利用Spark的核心计算引擎实现了实时数据处理。

Spark Streaming将数据流划分为一系列小的批处理作业,这些批处理作业在Spark引擎上运行,可以使用全面的Spark API、Streaming API和第三方库。

Spark Streaming允许与许多数据源和数据存储系统进行无缝集成,包括Kafka、Flume、Twitter、HDFS、Cassandra和HBase等。

Spark Streaming的目标是为大规模实时数据处理提供高性能、低延迟和易于开发的平台。

二、Spark Streaming的架构Spark Streaming的架构基于微批处理模型,其核心是DStream (离散流),DStream是一组连续的RDD(弹性分布式数据集),RDD是Spark计算引擎的基本抽象。

每个DStream都代表一个由连续数据组成的流,其RDD是离散的,每个RDD包含一定的数据,它们被分配给Spark集群中的不同计算节点进行并行处理。

Spark Streaming中的每个批处理作业都由一个或多个RDD组成,这些作业可以使用全面的Spark API编写。

Spark Streaming还提供了内置的窗口和滑动窗口运算功能,使用户可以对时间序列数据进行聚合、过滤、转换和操作。

Spark实践1.1 避免使⽤ GroupByKey 让我们看⼀下使⽤两种不同的⽅式去计算单词的个数,第⼀种⽅式使⽤reduceByKey,另外⼀种⽅式使⽤groupByKey:val words = Array("one", "two", "two", "three", "three", "three")val wordPairsRDD = sc.parallelize(words).map(word => (word, 1))//reduceval wordCountsWithReduce = wordPairsRDD.reduceByKey(_ + _).collect()//groupval wordCountsWithGroup = wordPairsRDD.groupByKey().map(t => (t._1, t._2.sum)).collect() 虽然两个函数都能得出正确的结果,reduceByKey更适合使⽤在⼤数据集上。

这是因为Spark知道它可以在每个分区shuffle数据之前,聚合key值相同的数据。

借助下图可以理解在reduceByKey⾥发⽣了什么。

注意在数据对被shuffle前同⼀机器上同样key的数据是怎样被组合的(reduceByKey中的lamdba函数)。

然后lamdba函数在每个区上被再次调⽤来将所有值reduce成⼀个最终结果。

但是,当调⽤groupByKey时,所有的键值对(key-value pair) 都会被shuffle。

在⽹络上传输这些数据⾮常没有必要。

为了确定将数据对shuffle到哪台主机,Spark会对数据对的key调⽤⼀个分区函数。

当shuffle的数据量⼤于单台执⾏机器内存总量时,Spark会把数据保存到磁盘上。

hbase常用查询方法

HBase是一个分布式、面向列的NoSQL数据库,常用于存储大规模的结构化数据。

在HBase中,常用的查询方法包括使用Scan操作和Get操作。

首先,让我们来看看Scan操作。

Scan操作允许用户按照指定的条件扫描整个表或者指定的行范围,以获取符合条件的数据。

用户可以指定起始行键和结束行键,也可以设置过滤器来筛选需要的数据。

Scan操作可以用于批量读取大量数据,适用于需要对整个表或者大范围数据进行分析的场景。

其次,Get操作是针对单行数据的查询操作。

用户可以通过指定行键来获取对应行的数据。

Get操作非常适合用于需要快速获取特定行数据的场景,比如根据唯一标识获取特定的记录。

除了Scan和Get操作,HBase还支持使用过滤器来进行更精细化的数据查询。

过滤器可以基于行键、列族、列限定符等条件来过滤数据,从而实现更精确的查询需求。

此外,HBase还提供了针对时间戳的查询功能,用户可以根据

时间范围来获取历史数据或者实现数据版本控制。

总的来说,HBase常用的查询方法包括Scan操作、Get操作、

过滤器查询以及针对时间戳的查询。

这些方法可以满足不同场景下

的数据查询需求,同时也可以通过合理的设计和优化来提高查询性

能和效率。

希望这些信息能够帮助你更好地理解HBase的查询方法。

前端大数据实践利用Hadoop与Spark进行数据处理与分析的教程大数据在现代信息技术中扮演着至关重要的角色,而前端开发人员可以通过利用Hadoop和Spark来进行数据处理和分析,从而更好地满足不断增长的信息需求。

本教程将指导你如何使用Hadoop和Spark进行前端大数据实践。

一、概述随着互联网的迅猛发展,前端应用程序收集到的数据量不断增加。

为了更好地处理和分析这些海量数据,使用Hadoop和Spark是一个明智的选择。

Hadoop是一个优秀的开源框架,可以分布式存储和处理大规模数据集。

而Spark则提供了快速的数据处理和分析能力,能够高效地处理前端收集到的海量数据。

二、环境搭建与配置在开始使用Hadoop和Spark之前,我们需要先搭建和配置相应的环境。

首先,确保你的机器上已经安装了Java开发环境。

然后,下载并安装Hadoop和Spark的最新版本。

根据官方文档配置相关参数,确保Hadoop和Spark可以正常运行。

接下来,创建一个适当的文件夹结构,以便存储和管理你的数据。

三、数据准备在进行数据处理和分析之前,需要准备好相应的数据集。

可以使用Web日志、用户行为数据等前端收集到的数据作为样本。

确保数据集包含足够的样本量和多样性,以便进行准确和有意义的分析。

四、数据预处理在将数据加载到Hadoop和Spark中进行处理和分析之前,需要进行数据预处理。

这一步骤包括数据清洗、去除重复项、处理异常值等。

可以使用Hadoop的MapReduce来实现数据预处理的任务。

五、数据处理与分析一旦数据完成预处理,就可以使用Hadoop和Spark进行数据处理和分析了。

Hadoop的分布式文件系统(HDFS)可以存储海量数据,而Hadoop的MapReduce框架可以进行数据处理和计算。

利用Spark的强大功能,我们可以进行更复杂的数据处理和分析任务,如数据聚合、数据挖掘、机器学习等。

可以编写相应的MapReduce程序或Spark应用程序,使用它们来处理和分析前端收集到的大数据。

两个月前使用过hbase,现在最基本的命令都淡忘了,留一个备查~要注意shutdown与exit之间的不同:shutdown表示关闭hbase服务,必须重新启动hbase才可以恢复,exit只是退出hbase shell,退出之后完全可以重新进入。

hbase使用坐标来定位表中的数据,行健是第一个坐标,下一个坐标是列族。

hbase是一个在线系统,和hadoop mapreduce的紧密结合又赋予它离线访问的功能。

hbase接到命令后存下变化信息或者写入失败异常的抛出,默认情况下。

执行写入时会写到两个地方:预写式日志(write-ahead log,也称hlog)和memstore,以保证数据持久化。

memstore是内存里的写入缓冲区。

客户端在写的过程中不会与底层的hf ile直接交互,当menstore写满时,会刷新到硬盘,生成一个新的hfile.hfile是hbase使用的底层存储格式。

menstore的大小由hbase-site.xml文件里的系统级属性h base.hregion.memstore.flush.size来定义。

hbase在读操作上使用了lru缓存机制(blockcache),blockcache设计用来保存从hfile里读入内存的频繁访问的数据,避免硬盘读。

每个列族都有自己的blockcache。

b lockcache中的block是hbase从硬盘完成一次读取的数据单位。

block是建立索引的最小数据单位,也是从硬盘读取的最小数据单位。

如果主要用于随机查询,小一点的block会好一些,但是会导致索引变大,消耗更多内存,如果主要执行顺序扫描,大一点的bloc k会好一些,block变大索引项变小,因此节省内存。

LRU是Least Recently Used 近期最少使用算法。

内存管理的一种页面置换算法,对于在内存中但又不用的数据块(内存块)叫做LRU,操作系统会根据哪些数据属于LRU而将其移出内存而腾出空间来加载另外的数据。

hbase运⾏模式Hbase有两种运⾏模式:standalone和distributed。

standalone模式参见Quick Start Guide。

以distributed模式设置Hbase,需要编辑Hbase conf⽬录中⽂件。

⽆论哪种模式,都需要编辑conf/hbase-evn.sh来告诉使⽤哪个java。

并且可以设置Hbase环境变量如heap size、JVM的其他选项等。

设置JAVA_HOME来指定java的安装⽬录。

Standalone Mode默认的运⾏模式。

在该模式下,Hbase不会使⽤HDFS,⽽是使⽤本地⽂件系统。

它在同⼀个虚拟机中运⾏所有Hbase daemon和本地ZooKeeper 。

ZooKeeper绑定⼀个众所周知的端⼝,所以客户端可以和Hbase通讯。

Distributed Modedistributed mode可以被进⼀步分成伪分布式(所有daemons运⾏在⼀个节点上)和完全分布式(所有daemons分布在集群上多个机器上)。

distributed modes需要⼀个HDFS实例。

Pseudo-distributed Mode⼀旦HDFS安装好了,边界conf/hbase-site.xml。

设定hbase.rootdir来指定Hbase运⾏在哪个HDFS上。

Fully-distributed Modefully-destributed mode,需要在hbase-site.xml中添加属性hbase.cluster.distributed,并设定为true,hbase.rootdir指向HDFS。

另外,fully-distributed mode需要修改conf/regionservers,它列出了你运⾏HRegionServer daemons的主机。

⼀⾏⼀个主机。

hbase 语法HBase是一种列式非关系型数据库,它的语法略有不同于关系型数据库,主要可以分为以下几类:1. 创建表HBase的创建表语法与关系型数据库的不同,它使用CREATE TABLE语句创建表,语法如下:CREATE TABLE [table_name] ([column_family], [column], [column_family], [column]...)其中table_name表示表名,column_family和column分别表示表的列族和列,它们之间可以有多组,但必须以逗号分隔。

2. 添加/修改数据HBase的添加/修改数据的语法与关系型数据库也不同,它使用PUT语句添加/修改数据,语法如下:PUT ‘[table_name]’, ‘[row_key]’, ‘[column_family]’:’[column]’, ‘[value]’其中table_name表示表名,row_key表示行键,column_family 和column分别表示列族和列,value表示要添加/修改的值。

3. 查询数据HBase使用Scan语句查询数据,语法如下:SCAN ‘[table_name]’, {COLUMNS =>‘[column_family]:[column]’, COLUMNS =>‘[column_family]:[column]’,...}其中table_name表示表名,column_family和column分别表示列族和列,可以指定多个列族和列查询。

4. 删除数据HBase使用DELETE语句删除数据,语法如下:DELETE ‘[table_name]’, ‘[row_key]’, ‘[column_family]’:’[column]’其中table_name表示表名,row_key表示行键,column_family 和column分别表示列族和列。

基于Spark的实时大数据处理与可视化分析系统设计随着大数据时代的到来,对大规模数据的实时处理与可视化分析需求日益增长。

基于Spark的实时大数据处理与可视化分析系统设计应运而生。

本文将从系统架构、功能实现、性能优化和应用场景等方面进行探讨。

一、系统架构基于Spark的实时大数据处理与可视化分析系统设计的架构主要包括以下几个组件:1.数据采集与存储模块:负责数据的采集和存储。

可以利用Flume、Kafka等工具进行数据的实时采集,将数据存储在分布式文件系统(如HDFS)或NoSQL数据库(如HBase)中。

2.数据处理模块:利用Spark Streaming进行数据的实时处理。

Spark Streaming支持批处理和流处理的混合模式,可以对实时数据进行持续的、可扩展的处理和分析。

3.数据可视化模块:利用可视化工具(如ECharts、D3.js)进行数据的可视化展示。

通过图表、地图等形式,将处理后的数据以直观易懂的方式展示出来,方便用户进行数据分析和决策。

4.系统管理与监控模块:负责系统的管理和监控。

可以通过配置管理工具(如Zookeeper)实现集群的配置和管理,利用监控工具(如Ganglia)对系统进行监控和性能调优。

二、功能实现基于Spark的实时大数据处理与可视化分析系统设计具备以下功能:1.数据实时采集和存储:可以实时采集和存储海量数据,同时支持数据的扩展性和容错性。

2.数据实时处理:能够对实时数据进行实时处理,包括数据清洗、转换、聚合和计算等操作,提供灵活的数据处理能力。

3.数据可视化展示:能够将处理后的数据以各种图表、地图等可视化形式展示出来,方便用户进行数据的可视化分析。

4.实时监控与报警:能够实时监控数据处理的状态和性能,并及时报警和处理异常情况,保证系统的稳定性和可靠性。

三、性能优化为提高基于Spark的实时大数据处理与可视化分析系统的性能,可以从以下几个方面进行优化:1.数据分区与并行处理:根据数据的特性进行合理的数据分区和任务调度,实现数据的并行处理,提高处理效率。

hbase工作原理HBase是一个开源的分布式列存储数据库,它是建立在Hadoop HDFS之上的。

HBase能够处理海量数据,具有高可靠性、高可扩展性和高性能等特点,因此被广泛应用于大数据领域。

HBase的工作原理如下:1. 数据模型HBase的数据模型类似于一个多维数组,其中每个单元格都由行键、列族、列限定符和时间戳组成。

行键是唯一标识符,用于识别每个单元格。

列族是一组相关的列,它们共享相同的前缀,并且在存储时被一起压缩。

列限定符是列族下面的子列,用于进一步标识单元格。

时间戳用于区分同一单元格中不同版本的数据。

2. 架构HBase采用Master-Slave架构,其中Master节点负责管理集群状态和元数据信息,而RegionServer节点负责存储和检索数据。

每个RegionServer可以管理多个Region(类似于表中的分区),每个Region由一个或多个Store组成(类似于表中的列族),每个Store包含一个MemStore(内存中排序结构)和多个HFile(磁盘上排序结构)。

3. 写入流程当客户端向HBase写入数据时,首先会将数据写入客户端本地的Write-Ahead-Log(WAL)中,以确保数据不会丢失。

然后,客户端会向Master节点请求要写入的RegionServer地址,并将数据发送给该RegionServer。

RegionServer接收到数据后,将其存储在相应的MemStore中,并定期将MemStore中的数据刷写到磁盘上的HFile 中。

4. 读取流程当客户端向HBase读取数据时,首先会向Master节点请求要读取的RegionServer地址,并根据行键范围和列族限定符过滤要读取的数据。

然后,RegionServer从磁盘上的HFile中读取数据,并将其合并到一个内存中的结果集中。

最后,结果集按照时间戳排序并返回给客户端。

5. 数据分布式存储为了实现高可扩展性和负载均衡,HBase采用了分布式存储策略。

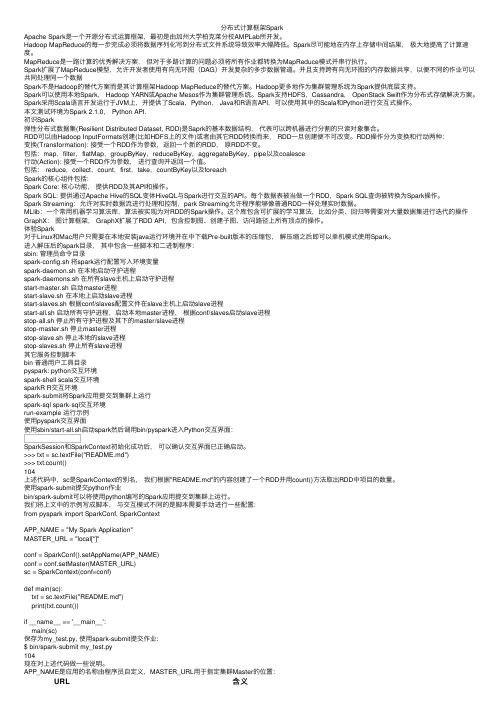

Spark基本概念及⼊门sparkspark背景什么是sparkSpark是⼀种快速、通⽤、可扩展的⼤数据分析引擎,2009年诞⽣于加州⼤学伯克利分校AMPLab,2010年开源,2013年6⽉成为Apache孵化项⽬,2014年2⽉成为Apache顶级项⽬。

⽬前,Spark⽣态系统已经发展成为⼀个包含多个⼦项⽬的集合,其中包含SparkSQL、Spark Streaming、GraphX、MLlib等⼦项⽬,Spark是基于内存计算的⼤数据并⾏计算框架。

Spark基于内存计算,提⾼了在⼤数据环境下数据处理的实时性,同时保证了⾼容错性和⾼可伸缩性,允许⽤户将Spark部署在⼤量廉价硬件之上,形成集群。

Spark与HadoopSpark是⼀个计算框架,⽽Hadoop中包含计算框架MapReduce和分布式⽂件系统HDFS,Hadoop更⼴泛地说还包括在其⽣态系统上的其他系统.为什么使⽤Spark?Hadoop的MapReduce计算模型存在问题:Hadoop的MapReduce的核⼼是Shuffle(洗牌).在整个Shuffle的过程中,⾄少产⽣6次I/O流.基于MapReduce计算引擎通常会将结果输出到次盘上,进⾏存储和容错.另外,当⼀些查询(如:hive)翻译到MapReduce任务是,往往会产⽣多个Stage,⽽这些Stage有依赖底层⽂件系统来存储每⼀个Stage的输出结果,⽽I/O的效率往往较低,从⽽影响MapReduce的运⾏速度.Spark的特点: 快, 易⽤, 通⽤,兼容性快:与Hadoop的MapReduce相⽐,Spark基于内存的运算要快100倍以上,基于硬盘的运算也要快10倍以上。

Spark实现了⾼效的DAG执⾏引擎,可以通过基于内存来⾼效处理数据流。

易⽤:Spark⽀持Java、Python和Scala的API,还⽀持超过80种⾼级算法,使⽤户可以快速构建不同的应⽤。

⽽且Spark⽀持交互式的Python和Scala的shell,可以⾮常⽅便地在这些shell中使⽤Spark集群来验证解决问题的⽅法。

Spark基础知识详解Apache Spark是⼀种快速通⽤的集群计算系统。

它提供Java,Scala,和R中的⾼级API,以及⽀持通⽤执⾏图的优化引擎。

它还⽀持⼀组丰富的⾼级⼯具,包括⽤于SQL和结构化数据处理的Spark SQL,⽤于机器学习的MLlib,⽤于图形处理的GraphX和Spark Streaming。

Spark优点:减少磁盘I/O:随着实时⼤数据应⽤越来越多,Hadoop作为离线的⾼吞吐、低响应框架已不能满⾜这类需求。

HadoopMapReduce的map端将中间输出和结果存储在磁盘中,reduce端⼜需要从磁盘读写中间结果,势必造成磁盘IO成为瓶颈。

Spark允许将map端的中间输出和结果存储在内存中,reduce端在拉取中间结果时避免了⼤量的磁盘I/O。

Hadoop Yarn中的ApplicationMaster申请到Container后,具体的任务需要利⽤NodeManager从HDFS的不同节点下载任务所需的资源(如Jar包),这也增加了磁盘I/O。

Spark将应⽤程序上传的资源⽂件缓冲到Driver本地⽂件服务的内存中,当Executor执⾏任务时直接从Driver的内存中读取,也节省了⼤量的磁盘I/O。

增加并⾏度:由于将中间结果写到磁盘与从磁盘读取中间结果属于不同的环节,Hadoop将它们简单的通过串⾏执⾏衔接起来。

Spark把不同的环节抽象为Stage,允许多个Stage 既可以串⾏执⾏,⼜可以并⾏执⾏。

避免重新计算:当Stage中某个分区的Task执⾏失败后,会重新对此Stage调度,但在重新调度的时候会过滤已经执⾏成功的分区任务,所以不会造成重复计算和资源浪费。

可选的Shuffle排序:HadoopMapReduce在Shuffle之前有着固定的排序操作,⽽Spark则可以根据不同场景选择在map端排序或者reduce端排序。

灵活的内存管理策略:Spark将内存分为堆上的存储内存、堆外的存储内存、堆上的执⾏内存、堆外的执⾏内存4个部分。

Hbase_02、Hbase的常⽤的shell命令Hbase的DDL操作Hbase的DML。

阅读⽬录前⾔笔者在分类中的Hbase栏⽬之前已经分享了hbase的安装以及⼀些常⽤的shell命令的使⽤,这⾥不仅仅重新复习⼀下shell命令,还会介绍hbase的DDL以及DML的相关操作。

⼀、hbase的shell操作1.1启动hbase shell在hbase的安装⽬录的bin⽬录下⾯启动我们的hbase,执⾏命令:hbase shell,执⾏效果以>结束,如下执⾏效果:hbase shell1.2执⾏hbase shell的帮助⽂档输⼊help并按Enter键,可以显⽰HBase Shell的基本使⽤信息,和我们接下来会列举的⼀些命令类似。

需要注意的是,表名,⾏,列都必须包含在引号内。

执⾏效果:help1.3退出hbase shell使⽤quit命令,退出HBase Shell 并且断开和集群的连接,但此时HBase仍然在后台运⾏。

1.4使⽤status命令查看hbase现在的状态hbase(main):004:0> status1 active master, 0 backup masters,2 servers, 0 dead, 1.0000 average load从上⾯可以看出⼀个master在运⾏,并且下⾯有两个服务器...没有备份的master,没有死亡的服务。

1.5使⽤version命令查看hbase的相关的版本hbase(main):005:0> version1.3.1, r930b9a55528fe45d8edce7af42fef2d35e77677a, Thu Apr 6 19:36:54 PDT 2017从上⾯可以看出版本是1.3.1版本的。

1.6table_help此命令将引导如何使⽤表引⽤的命令。

下⾯给出的是使⽤这个命令的语法:table_help1.7whoami该命令返回HBase⽤户详细信息。

分布式计算框架SparkApache Spark是⼀个开源分布式运算框架,最初是由加州⼤学柏克莱分校AMPLab所开发。

Hadoop MapReduce的每⼀步完成必须将数据序列化写到分布式⽂件系统导致效率⼤幅降低。

Spark尽可能地在内存上存储中间结果,极⼤地提⾼了计算速度。

MapReduce是⼀路计算的优秀解决⽅案,但对于多路计算的问题必须将所有作业都转换为MapReduce模式并串⾏执⾏。

Spark扩展了MapReduce模型,允许开发者使⽤有向⽆环图(DAG)开发复杂的多步数据管道。

并且⽀持跨有向⽆环图的内存数据共享,以便不同的作业可以共同处理同⼀个数据Spark不是Hadoop的替代⽅案⽽是其计算框架Hadoop MapReduce的替代⽅案。

Hadoop更多地作为集群管理系统为Spark提供底层⽀持。

Spark可以使⽤本地Spark, Hadoop YARN或Apache Mesos作为集群管理系统。

Spark⽀持HDFS,Cassandra, OpenStack Swift作为分布式存储解决⽅案。

Spark采⽤Scala语⾔开发运⾏于JVM上,并提供了Scala,Python, Java和R语⾔API,可以使⽤其中的Scala和Python进⾏交互式操作。

本⽂测试环境为Spark 2.1.0, Python API.初识Spark弹性分布式数据集(Resilient Distributed Dataset, RDD)是Saprk的基本数据结构,代表可以跨机器进⾏分割的只读对象集合。

RDD可以由Hadoop InputFormats创建(⽐如HDFS上的⽂件)或者由其它RDD转换⽽来, RDD⼀旦创建便不可改变。

RDD操作分为变换和⾏动两种:变换(Transformation): 接受⼀个RDD作为参数,返回⼀个新的RDD,原RDD不变。

包括:map,filter,flatMap,groupByKey,reduceByKey,aggregateByKey,pipe以及coalesce⾏动(Action): 接受⼀个RDD作为参数,进⾏查询并返回⼀个值。

hbase的应用场景

HBase是Apache Hadoop生态系统中的一个分布式数据库,具有高可靠性、高扩展性等特点。

随着大数据时代的到来,HBase的应用越来越广泛。

HBase适用于以下场景:

1. 低延迟读写的场景

HBase是一种基于列簇存储的数据库,适用于快速读写场景。

HBase 可以将数据存放在内存中,通过快速检索索引进行读写操作,实现低延迟读写。

2. 海量数据存储的场景

HBase可以扩展到数百个节点,可以存储PB级别的海量数据。

由于HBase支持分布式的存储和计算,可以将数据分散到多个节点上进行存储和处理,从而实现横向的扩展。

3. 日志处理的场景

HBase适合于存放日志信息、事件信息等类型的数据。

通过HBase可以进行快速的检索和统计,处理日志数据。

4. 索引建立的场景

HBase支持快速的索引建立,可以通过索引实现快速的数据查询。

对

于需要实时查询数据的场景,使用HBase建立索引可以提升查询效率。

5. 实时计算的场景

HBase可以与Hadoop生态中的其他组件集成,如Storm、Spark等,实现实时计算。

通过实时计算可以获取数据的实时情况,为企业提供

更准确的数据分析和决策依据。

总之,HBase是一种高可靠性、高扩展性、低延迟的分布式数据库,

适用于海量数据存储、实时计算、索引建立等场景。

随着大数据时代

的到来,HBase的应用将越来越广泛。

⼤数据Spark实时处理--架构分析Spark是⼀个实时处理框架Spark提供了两套实施解决⽅案:Spark Streaming(SS)、Structured Streaming(SSS)然后再结合其它框架:Kafka、HBase、Flume、Redis项⽬流程:架构分析、数据产⽣、数据采集、数据收集、数据实时交换、实时流处理、结果可视化、调优1)【项⽬启动】架构分析2)【环境部署】基础开发环境搭建2)【数据产⽣】3)【数据采集】构建⽇志服务器(偏重于⽇志产⽣及存储)4)【数据收集】基于Flume构建分布式⽇志收集(偏重于数据从A地⽅到B地⽅的操作)5)【消息队列】基于Kafka构建实时数据交换6)【实时流处理】Spark Streaming核⼼API7)【实时流处理】应⽤Spark Streaming实现数据分析及调优8)【实时流处理】Structured Streaming应⽤9)【实时流处理】应⽤Structured Streaming实现数据分析及调优10)【数据可视化】使⽤Echarts完成数据展⽰架构图1)⽇志采集:⾃定义⼀个⽇志服务2)数据收集交换:使⽤Flume将⽇志服务数据收集过来,落在Kafka上3)实时处理:基于Spark Streaming(SS)、Structured Streaming(SSS)来对接Kafka的数据4)数据存储:第3)步处理后的数据,Spark Streaming处理的数据存储⾄HBase中,Structured Streaming处理的数据存储⾄Redis 5)查询API:页⾯的请求通过API,即使⽤Spring Boot、Spring Data来查询HBase和Redis⾥的数据,并把数据放置可视化⾥。

在可视化⾥是通过Echarts来展⽰。

也会使⽤到React来封装Echarts。

6)整个项⽬的运⾏环境:产商云主机、物理机、虚拟机更详细的流程1)客户端所产⽣的⽇志,通过Nginx协议端过来后,给它负载均衡落在LogServer上,其中LogServer是⾃定义开发的。

HBase之Spark操作Scala版本操作HBaseimport org.apache.spark.SparkContextimport org.apache.spark._import org.apache.hadoop.hbase.HBaseConfigurationimport org.apache.hadoop.hbase.HTableDescriptorimport org.apache.hadoop.hbase.client.HBaseAdminimport org.apache.hadoop.hbase.mapreduce.TableInputFormatimport org.apache.hadoop.hbase.HColumnDescriptorimport org.apache.hadoop.hbase.util.Bytesimport org.apache.hadoop.hbase.client.Putimport org.apache.hadoop.hbase.client.HTableimport org.apache.hadoop.hbase.client.Resultimport org.apache.hadoop.hbase.io.ImmutableBytesWritableimport org.apache.hadoop.hbase.client.Deleteobject SparkHBase1 extends Serializable {def main(args: Array[String]) {val sc = new SparkContext("spark://centos.host1:7077", "SparkHBase")val conf = HBaseConfiguration.create()conf.set("hbase.zookeeper.property.clientPort", "2181")conf.set("hbase.zookeeper.quorum", "centos.host1")conf.set("hbase.master", "centos.host1:60000")conf.addResource("/home/hadoop/software/hbase-0.92.2/conf/hbase-site.xml")conf.set(TableInputFormat.INPUT_TABLE, "user")val admin = new HBaseAdmin(conf)if (!admin.isTableAvailable("test")) {print("Table Not Exists! Create Table")val tableDesc = new HTableDescriptor("test")tableDesc.addFamily(new HColumnDescriptor("basic".getBytes()))admin.createTable(tableDesc)}//Put操作val table = new HTable(conf, "user");for (i <- 1 to 5) {var put = new Put(Bytes.toBytes("row" + i))put.add(Bytes.toBytes("basic"), Bytes.toBytes("name"), Bytes.toBytes("value " + i))table.put(put)}table.flushCommits()//Delete操作val delete = new Delete(Bytes.toBytes("row1"))table.delete(delete)//Scan操作val hbaseRDD = sc.newAPIHadoopRDD(conf, classOf[TableInputFormat], classOf[org.apache.hadoop.hbase.io.ImmutableBytesWritable],classOf[org.apache.hadoop.hbase.client.Result])val count = hbaseRDD.count()println("HBase RDD Count:" + count)hbaseRDD.cache()val res = hbaseRDD.take(count.toInt)for (j <- 1 until count.toInt) {println("j: " + j)var rs = res(j - 1)._2var kvs = rs.rawfor (kv <- kvs)println("rowkey:" + new String(kv.getRow()) +" cf:" + new String(kv.getFamily()) +" column:" + new String(kv.getQualifier()) +" value:" + new String(kv.getValue()))}System.exit(0)}}Java版本操作HBaseimport java.io.ByteArrayOutputStream;import java.io.DataOutputStream;import java.util.List;import org.apache.hadoop.conf.Configuration;import org.apache.hadoop.hbase.HBaseConfiguration;import org.apache.hadoop.hbase.KeyValue;import org.apache.hadoop.hbase.client.Delete;import org.apache.hadoop.hbase.client.HTable;import org.apache.hadoop.hbase.client.Put;import org.apache.hadoop.hbase.client.Result;import org.apache.hadoop.hbase.client.Scan;import org.apache.hadoop.hbase.io.ImmutableBytesWritable;import org.apache.hadoop.hbase.mapreduce.TableInputFormat;import org.apache.hadoop.hbase.util.Base64;import org.apache.hadoop.hbase.util.Bytes;import org.apache.solr.util.IOUtils;import org.apache.spark.SparkConf;import org.apache.spark.api.java.JavaPairRDD;import org.apache.spark.api.java.JavaSparkContext;import scala.Tuple2;public class SparkHBase {public static void main(String[] args) throws Exception {SparkConf sparkConf = new SparkConf();sparkConf.setMaster("spark://centos.host1:7077");sparkConf.setAppName("Spark HBase");JavaSparkContext context = new JavaSparkContext(sparkConf);Configuration conf = HBaseConfiguration.create();conf.set("hbase.zookeeper.property.clientPort", "2181");conf.set("hbase.zookeeper.quorum", "centos.host1");conf.set("hbase.master", "centos.host1:60000");//Put操作HTable table = new HTable(conf, "user");Put put = new Put(Bytes.toBytes("row6"));put.add(Bytes.toBytes("basic"), Bytes.toBytes("name"), Bytes.toBytes("value6")); table.put(put);table.flushCommits();//Delete操作Delete delete = new Delete(Bytes.toBytes("row1"));table.delete(delete);table.close();//Scan操作Scan scan = new Scan();scan.setStartRow(Bytes.toBytes("0120140722"));scan.setStopRow(Bytes.toBytes("1620140728"));scan.addFamily(Bytes.toBytes("basic"));scan.addColumn(Bytes.toBytes("basic"), Bytes.toBytes("name"));String tableName = "user";conf.set(TableInputFormat.INPUT_TABLE, tableName);ByteArrayOutputStream out = new ByteArrayOutputStream();DataOutputStream dos = new DataOutputStream(out);scan.write(dos);String scanStr = Base64.encodeBytes(out.toByteArray());IOUtils.closeQuietly(dos);IOUtils.closeQuietly(out);//高版本可以用如下方式://ClientProtos.Scan proto = ProtobufUtil.toScan(scan);//String scanStr = Base64.encodeBytes(proto.toByteArray());conf.set(TableInputFormat.SCAN, scanStr);JavaPairRDD<ImmutableBytesWritable, Result> hBaseRDD = context.newAPIHadoopRDD(conf, TableInputFormat.class,ImmutableBytesWritable.class, Result.class);Long count = hBaseRDD.count();System.out.println("count: " + count);List<Tuple2<ImmutableBytesWritable, Result>> tuples = hBaseRDD.take(count.intValue());for (int i = 0, len = count.intValue(); i < len; i++) {Result result = tuples.get(i)._2();KeyValue[] kvs = result.raw();for (KeyValue kv : kvs) {System.out.println("rowkey:" + new String(kv.getRow()) + " cf:"+ new String(kv.getFamily()) + " column:"+ new String(kv.getQualifier()) + " value:"+ new String(kv.getValue()));}}}}打包成jar包后执行如下命令bin/spark-submit --class org.platform.modules.hbase.SparkHBase --master spark://centos.host1:7077 /home/hadoop/temp/spark.jar注意需要将依赖的HBase jar包添加到Spark的CLASSPATH下,打开conf/spark-env.sh,添加如下内容SPARK_CLASSPATH=/home/hadoop/software/hbase-0.92.2/hbase-0.92.2.jar:/home/hadoop/software/hbase-0.92.2/lib或者也可以在执行命令的时候加一个jars参数,如下bin/spark-submit --jars $(echo /home/hadoop/software/hbase-0.96.0/lib/*.jar | tr ' ' ',') --class org.platform.modules.hbase.SparkHBase --master spark://centos.host1:7077 /home/hadoop/temp/spark.jar。