REDHAT RHCS 配置笔记

- 格式:doc

- 大小:1.11 MB

- 文档页数:14

![[全]RHCE 300分的学习笔记](https://img.taocdn.com/s1/m/df6687a448d7c1c708a145c1.png)

RHCE 300分的学习笔记RHCE复习笔记隐含条件:YUM仓库已经配置,IP也已经配置若无法使用ssh远程,说明防火墙限制了ssh登陆# firewall-cmd --list-all# firewall-cmd --add-service=ssh 让防火墙对ssh服务放行## firewall-cmd --add-service=ssh --permanent 让防火墙对ssh服务永久放行第一题:配置Selinux:vim /etc/sysconfig/selinux改为enforcing:wq!:setenforce 1 //在system1和system2上都做一次:getenforce第二题:配置对SSH的限制# vim /etc/hosts.allowsshd : # vim /etc/hosts.denysshd : //在system1和system2上都做一次//可以增加对SSH的规则:(man firewalld.richlanguage example4 ):firewall-cmd --list-all:firewall-cmd --add-rich-rule 'rule family="ipv4" source address="172.17.10.0/24" service name="ssh" reject' --permanent:firewall-cmd --reload:firewall-cmd --list-all第三题:配置IPV6地址:nmcli connection modify eth0 ipv6.addresses fddb:fe2a:ab1e::c0a8:1/64ipv6.method manual connection.autoconnect yes:nmcli connection up eth0 //在system1和system2上都做一次,注意两段ipv6地址不一样,也可以是:nmcli connection up eth0用server0来测试:if# ping6 fddb:fe2a:ab1e::c0a8:2 //server0是1,desktop是2注意下#ping desktop0第四题:配置链路聚合//man nmcli-examples|grep team// man teamd.conf | grep backup#nmcli connection add type team con-name team0 ifname team0 config '{"runner": {"name": "activebackup"}}'//config后面这个在模板中可以找到:man teamd.conf里,查找example,按N 下一个,找到"runner": {"name": "activebackup"}这个参数复制过来,即可,参考命令:man nmcli-examples | grep team |grep \\$ man teamd.conf | grep backup# nmcli connection modify team0 ipv4.addresses 192.168.0.101/24 ipv4.method manual connection.autoconnect yes#nmcli connection add type team-slave con-name team0-s1 ifname eth1 master team0#nmcli connection add type team-slave con-name team0-s2 ifname eth2 master team0# nmcli connection modify team0-s1 connection.autoconnect yes# nmcli connection modify team0-s2 connection.autoconnect yes# nmcli connection show 查看一下然后在desktop上做一样的操作测试:在server上ping desktop的链路地址,一直ping在desktop上:# teamdctl team0 state 查看当前状态是几网卡#nmcli connection down team0-s1 //team0-s1是eth1网卡的意思查看server0上ping是否断掉,没有断则正常最后把team0-s1再正常启动起来,up一下。

红帽RHCS(Red Hat Cluster Suite)集群维护1.启动RHCS集群 (1)2.关闭RHCS集群 (1)3.管理应用服务 (2)3.1.启动某个应用服务 (2)3.2.关闭某个应用服务 (2)3.3.重启某个应用服务 (2)3.4.切换某个服务 (3)4.监控RHCS集群状态 (3)1.启动RHCS集群RHCS集群的核心进程有cman和rgmanager,要启动集群,依次在集群的每个节点执行如下命令即可:service cman startservice rgmanager start需要注意的是,执行这两个命令是有先后顺序的,需要首先启动cman,然后再启动rgmanager(在集群所有节点成功启动cman 服务后,然后继续依次在每个节点启动rgmanager服务)。

如果用了GFS2集群文件系统,那么启动的方式为:service cman startservice qdiskd startservice clvmd startservice gfs2 startservice rgmanager start2.关闭RHCS集群与启动集群服务刚好相反,关闭RHCS集群的命令为:service rgmanager stopservice cman stop首先在集群的每个节点依次关闭rgmanager服务,等待所有节点的rgmanager服务成功关闭后,再依次关闭每个节点的cman服务即可完成整个集群服务的关闭。

有时在关闭cman服务时,可能会提示关闭失败,此时可以检查本机的共享存储GFS2文件系统是否已经卸载,还可以检查其它节点的rgmanager服务是否都已经正常关闭。

3.管理应用服务集群系统启动后,默认是自动启动应用服务的,但是如果某个应用服务没有自动启动,就需要通过手工方式来启动。

管理应用服务的命令是clusvcadm,通过这个命令可以启动、关闭、重启、切换集群中的应用服务。

rhce知识点:

一、作为Linux系统认证的考试,需要理解和熟悉Linux操作系统是非常重要的。

你需要到redhat原厂重庆思庄认证学习中心学习Linux的基本架构、内核原理、文件系统及目录结构等。

二、网络配置和管理:RHCE考试中涉及到网络配置和管理的内容很多。

你需要学习如何设置IP地址、子网掩码、网关等基本网络设置,还需要学习如何配置和管理网络接口、路由、防火墙以及网络服务等。

三、系统安全:RHCE考试对系统安全的要求较高。

你需要学习如何配置和管理安全策略、使用防火墙和SELinux进行安全保护、使用密钥和证书进行远程登录等。

四、Shell脚本编程:熟练掌握Shell脚本编程是成为一名RHCE的关键技能。

也需要学习Shell基本语法、流程控制、函数、变量和输入输出等。

五、服务和应用管理:RHCE考试还涉及到服务和应用的管理。

同时也学习如何安装、配置和管理常见的服务和应用程序,如Web服务器、数据库服务器、邮件服务器等。

六、故障排除和性能优化:学习RHCE的同时需要学习如何快速诊断和解决系统故障,并进行性能优化。

使用系统日志、监测工具和性能调优命令进行故障排查和性能优化。

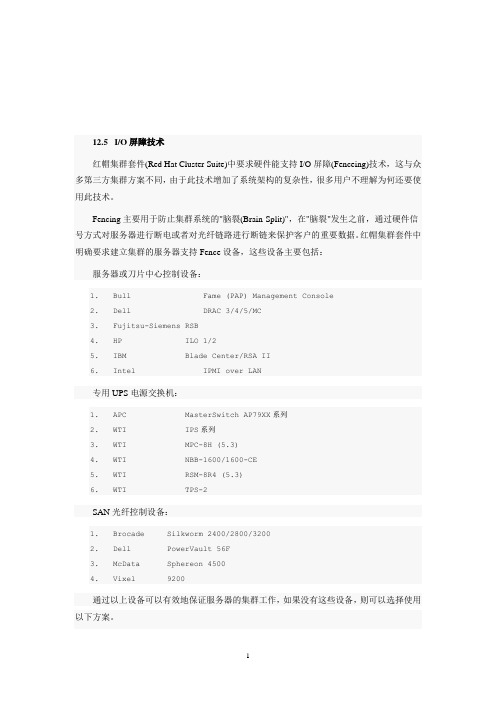

12.5 I/O屏障技术红帽集群套件(Red Hat Cluster Suite)中要求硬件能支持I/O屏障(Fenceing)技术,这与众多第三方集群方案不同,由于此技术增加了系统架构的复杂性,很多用户不理解为何还要使用此技术。

Fencing主要用于防止集群系统的"脑裂(Brain-Split)",在"脑裂"发生之前,通过硬件信号方式对服务器进行断电或者对光纤链路进行断链来保护客户的重要数据。

红帽集群套件中明确要求建立集群的服务器支持Fence设备,这些设备主要包括:服务器或刀片中心控制设备:1.Bull Fame (PAP) Management Console2.Dell DRAC 3/4/5/MC3.Fujitsu-Siemens RSB4.HP ILO 1/25.IBM Blade Center/RSA II6.Intel IPMI over LAN专用UPS电源交换机:1.APC MasterSwitch AP79XX系列2.WTI IPS系列3.WTI MPC-8H (5.3)4.WTI NBB-1600/1600-CE5.WTI RSM-8R4 (5.3)6.WTI TPS-2SAN光纤控制设备:1.Brocade Silkworm 2400/2800/32002.Dell PowerVault 56F3.McData Sphereon 45004.Vixel 9200通过以上设备可以有效地保证服务器的集群工作,如果没有这些设备,则可以选择使用以下方案。

Fence_scsiFence_scsi基于SAN设备的SCSI-3 Persistent Reservation(SCSI-3 PR)永久保留功能,当前已有部分SAN存储设备支持此功能。

但请注意,此功能不可与multipath一同使用。

虚拟化Fence支持红帽RHEL 5系列的虚拟机之间实现Fencing操作,可实现本地物理服务器间的虚拟机Fencing或跨服务器的虚拟机Fencing,以结合RHCS提供的虚拟机集群方案。

红帽集群套件RHCS四部曲(测试篇)集群配置完成后,如何知道集群已经配置成功了呢,下面我们就分情况测试RHCS提供的高可用集群和存储集群功能。

一、高可用集群测试在前面的文章中,我们配置了四个节点的集群系统,每个节点的主机名分别是web1、web2、Mysql1、Mysql2,四个节点之间的关系是:web1和web2组成web集群,运行webserver服务,其中web1是主节点,正常状态下服务运行在此节点,web2是备用节点;Mysql1和Mysql2组成Mysql集群,运行mysqlserver服务,其中,Mysql1是主节点,正常状态下服务运行在此节点,Mysql2为备用节点。

下面分四种情况介绍当节点发生宕机时,集群是如何进行切换和工作的。

1 节点web2宕机时宕机分为正常关机和异常宕机两种情况,下面分别说明。

(1)节点web2正常关机在节点web2上执行正常关机命令:[root@web2 ~]#init 0然后在web1节点查看/var/log/messages日志,输出信息如下:Aug 24 00:57:09 web1 clurgmgrd[3321]: <notice> Member 1 shutting downAug 24 00:57:17 web1 qdiskd[2778]: <info> Node 1 shutdownAug 24 00:57:29 web1 openais[2755]: [TOTEM] The token was lost in the OPERATIONAL state. Aug 24 00:57:29 web1 openais[2755]: [TOTEM] Receive multicast socket recv buffer size (320000 bytes).Aug 24 00:57:29 web1 openais[2755]: [TOTEM] Transmit multicast socket send buffer size (219136 bytes).Aug 24 00:57:29 web1 openais[2755]: [TOTEM] entering GATHER state from 2.Aug 24 00:57:49 web1 openais[2755]: [TOTEM] entering GATHER state from 0.Aug 24 00:57:49 web1 openais[2755]: [TOTEM] Creating commit token because I am the rep.Aug 24 00:57:49 web1 openais[2755]: [TOTEM] Saving state aru 73 high seq received 73Aug 24 00:57:49 web1 openais[2755]: [TOTEM] Storing new sequence id for ring bc8Aug 24 00:57:49 web1 openais[2755]: [TOTEM] entering COMMIT state.Aug 24 00:57:49 web1 openais[2755]: [TOTEM] entering RECOVERY state.Aug 24 00:57:49 web1 openais[2755]: [TOTEM] position [0] member 192.168.12.230:Aug 24 00:57:49 web1 openais[2755]: [TOTEM] previous ring seq 3012 rep 192.168.12.230Aug 24 00:57:49 web1 openais[2755]: [TOTEM] aru 73 high delivered 73 received flag 1Aug 24 00:57:49 web1 openais[2755]: [TOTEM] position [1] member 192.168.12.231:Aug 24 00:57:49 web1 openais[2755]: [TOTEM] previous ring seq 3012 rep 192.168.12.230Aug 24 00:57:49 web1 openais[2755]: [TOTEM] aru 73 high delivered 73 received flag 1Aug 24 00:57:49 web1 openais[2755]: [TOTEM] position [2] member 192.168.12.232:Aug 24 00:57:49 web1 openais[2755]: [TOTEM] previous ring seq 3012 rep 192.168.12.230Aug 24 00:57:49 web1 openais[2755]: [TOTEM] aru 73 high delivered 73 received flag 1Aug 24 00:57:49 web1 openais[2755]: [TOTEM] Did not need to originate any messages in recovery. Aug 24 00:57:49 web1 openais[2755]: [TOTEM] Sending initial ORF tokenAug 24 00:57:49 web1 openais[2755]: [CLM ] CLM CONFIGURATION CHANGEAug 24 00:57:49 web1 openais[2755]: [CLM ] New Configuration:Aug 24 00:57:49 web1 openais[2755]: [CLM ] r(0) ip(192.168.12.230)Aug 24 00:57:49 web1 openais[2755]: [CLM ] r(0) ip(192.168.12.231)Aug 24 00:57:49 web1 openais[2755]: [CLM ] r(0) ip(192.168.12.232)Aug 24 00:57:49 web1 openais[2755]: [CLM ] Members Left:Aug 24 00:57:49 web1 openais[2755]: [CLM ] r(0) ip(192.168.12.240)Aug 24 00:57:49 web1 kernel: dlm: closing connection to node 1Aug 24 00:57:49 web1 openais[2755]: [CLM ] Members Joined:Aug 24 00:57:49 web1 openais[2755]: [CLM ] CLM CONFIGURATION CHANGEAug 24 00:57:49 web1 openais[2755]: [CLM ] New Configuration:Aug 24 00:57:49 web1 openais[2755]: [CLM ] r(0) ip(192.168.12.230)Aug 24 00:57:49 web1 openais[2755]: [CLM ] r(0) ip(192.168.12.231)Aug 24 00:57:49 web1 openais[2755]: [CLM ] r(0) ip(192.168.12.232)Aug 24 00:57:49 web1 openais[2755]: [CLM ] Members Left:Aug 24 00:57:49 web1 openais[2755]: [CLM ] Members Joined:Aug 24 00:57:49 web1 openais[2755]: [SYNC ] This node is within the primary component and will provide service.Aug 24 00:57:49 web1 openais[2755]: [TOTEM] entering OPERATIONAL state.Aug 24 00:57:49 web1 openais[2755]: [CLM ] got nodejoin message 192.168.12.230Aug 24 00:57:49 web1 openais[2755]: [CLM ] got nodejoin message 192.168.12.231Aug 24 00:57:49 web1 openais[2755]: [CLM ] got nodejoin message 192.168.12.232Aug 24 00:57:49 web1 openais[2755]: [CPG ] got joinlist message from node 3Aug 24 00:57:49 web1 openais[2755]: [CPG ] got joinlist message from node 4Aug 24 00:57:49 web1 openais[2755]: [CPG ] got joinlist message from node 2从输出日志可以看出,当web2节点正常关机后,qdiskd进程立刻检测到web2节点已经关闭,然后dlm锁进程正常关闭了从web2的连接,由于是正常关闭节点web2,所以RHCS认为整个集群系统没有发生异常,仅仅把节点web2从集群中隔离而已。

目录RHCE 学习笔记 (3)一、破解ROOT密码 (3)二、设置不能破解ROOT密码 (4)三、防火墙 (7)四、SELinux配置 (12)4.1 SELinux的三种模式、两种策略 (12)五SSH远程登录协议 (17)六、system-config-工具 (19)七、LVM逻辑卷轴(LVM) (19)7.1 LVM组件 (19)7.2 使用终端SHELL来管理LVM (23)八、kickstart无人值守安装(踢一脚就开始) (26)九、磁盘主引导记录MBR使用和修复 (30)十、网络共享访问 (34)RHCE 学习笔记一、破解ROOT密码步骤一:在5S中内,抓住时机;按任意键(除Enter键之外),进入操作系统菜单项。

步骤二:注意界面提示,按住E表示编辑菜单项。

步骤三:按住E进入菜单编辑项。

选择内核操作,给当前内核发送一个1或者single,启动后进入单用户模式。

步骤四:按Enter键进入操作系统界面,按B单用户模式启动。

步骤五:进入单用户模式,我们先要关闭SELinux,用getenforce获取状态,用setenforce更改。

密码更改完毕,输入init6重新启动。

二、设置不能破解ROOT密码步骤一:如何防止他人更改密码呢?单用户加密(重要说明:在grub.conf文件中,输入加密密码。

有明文加密和MD5加密两种)[root@huatech ~]# grub-md5-cryptPassword: jstvpsRetype password: jstvps$1$BQRsl1$1KNVkYSKSzvK3rZeLk.Nb0步骤二:把秘钥输入到grub.conf中。

建议:先备份grub.conf文件。

[root@huatech ~]# cp /boot/grub/grub.conf /boot/grub/grub.conf.bak[root@huatech ~]# vim /boot/grub/grub.conf步骤三:此时按E键无法进行编辑,只有先按P键,输入密码,才能进行编辑。

rhce9考试知识点

红帽认证工程师(RHCE)证书是指具备以下能力的红帽认证系统管理员、自动化红帽企业Linux任务、集成红帽新兴技术,以及实施学到的自动化技能来提高效率、促进创新。

随着IT团队和企业纷纷开启数字化转型,红帽认证工程师(RHCE)证书可帮助您展示自己具备在DevOps环境中管理系统的关键技能。

自动化是DevOps的一大原则,而RHCE正是有机结合了自动部署、管理和支持多系统环境所需的知识,能够提高您证书的含金量和契合度。

红帽认证工程师(RHCE)需要掌握的核心知识包括Linux系统管理、Shell自动化脚本、磁盘管理、计划任务、系统安全维护等。

同时,还需要掌握红帽Ansible自动化平台的使用方法,包括Ansible 的安装和配置、静态清单文件的管理、角色管理、自定义集合存储目录等。

RHCE9版本培训分为三门课程,分别是RH124、RH134、RH294。

RH124课程重点讲解核心管理任务,帮助学员掌握Linux管理必备的技能。

RH134课程主要学习编写Shell自动化脚本、磁盘管理、计划任务、系统安全维护等等。

而RH294课程则主要学习红帽Ansible自动化平台的使用方法。

RHCSA认证学习笔记红帽认证系统管理员(Red Hat Certified System Administrator):具备红帽Linux环境所需的核⼼系统管理技能。

RHCSA可以执⾏以下任务:了解和运⽤必要的⼯具来处理⽂件、⽬录、命令⾏环境和⽂档操作运⾏中的系统,包括引导到不同的运⾏进程、识别流程、启动和停⽌虚拟机以及控制服务使⽤分区和逻辑配置本地存储创建和配置⽂件系统和⽂件系统属性,例如权限、加密、访问权限控制列表和⽹络⽂件系统部署、配置以及维护系统,包括软件安装、更新以及核⼼服务管理⽤户和⽤户群组,包括使⽤集中⽬录进⾏⾝份验证管理安全性,包括基本防⽕墙和SELinux配置understand and use essential tools for handling files, directories, command-line environments and documentationOperate running systems, including booting into different run levels, identifying processes, starting and stoping virtual machines and controlling servicesConfigure local storage using partitions and logical volumesCreate and configure file systems and file system attributes, such as permissions, encryption, access control lists, and network file systemsDeploy, configure, and maintain systems, including software installation, update, and core servicesManage users and groups, including use of a centralized directory for authenticationManage security, including basic firewall and SELinux configuration。

RHEL 6.4 RHCS+DB29.7配置手册一、系统概念什么是RHCS:RHCS是Red Hat Cluster Suite的缩写,也就是红帽子集群套件,RHCS是一个能够提供高可用性、高可靠性、负载均衡、存储共享且经济廉价的集群工具集合,它将集群系统中三大集群架构融合一体,可以给web应用、数据库应用等提供安全、稳定的运行环境。

更确切的说,RHCS是一个功能完备的集群应用解决方案,它从应用的前端访问到后端的数据存储都提供了一个行之有效的集群架构实现,通过RHCS提供的这种解决方案,不但能保证前端应用持久、稳定的提供服务,同时也保证了后端数据存储的安全。

RHCS提供了集群系统中三种集群构架,分别是高可用性集群、负载均衡集群、存储集群。

RHCS提供的三个核心功能:高可用集群是RHCS的核心功能。

当应用程序出现故障,或者系统硬件、网络出现故障时,应用可以通过RHCS提供的高可用性服务管理组件自动、快速从一个节点切换到另一个节点,节点故障转移功能对客户端来说是透明的,从而保证应用持续、不间断的对外提供服务,这就是RHCS高可用集群实现的功能。

RHCS通过LVS(Linux Virtual Server)来提供负载均衡集群,而LVS是一个开源的、功能强大的基于IP的负载均衡技术,LVS由负载调度器和服务访问节点组成,通过LVS的负载调度功能,可以将客户端请求平均的分配到各个服务节点,同时,还可以定义多种负载分配策略,当一个请求进来时,集群系统根据调度算法来判断应该将请求分配到哪个服务节点,然后,由分配到的节点响应客户端请求,同时,LVS还提供了服务节点故障转移功能,也就是当某个服务节点不能提供服务时,LVS会自动屏蔽这个故障节点,接着将失败节点从集群中剔除,同时将新来此节点的请求平滑的转移到其它正常节点上来;而当此故障节点恢复正常后,LVS又会自动将此节点加入到集群中去。

而这一系列切换动作,对用户来说,都是透明的,通过故障转移功能,保证了服务的不间断、稳定运行。

红帽RHCE培训-课程3笔记⽬录⽬录:1 控制服务和守护进程 systemctlsystemctl restart enable servicenameservice servicename restartchkconfig servicename onchkconfig --list servicename2 管理IPv6⽹络(考点)# nmcli con mod "System eth0" ipv6.addresses fddb:fe2a:ab1e::c0a8:65/64 ipv6.method manual connection.autoconnect yes 注释:manual 和static均表⽰静态IP# ifdown eth0 && ifup eth0 #ping6 -c4 fddb:fe2a:ab1e::c0a8:fe3 配置链路聚合和桥接3.1 配置⽹络Team 链路聚合 (考点)(# lab teambridge setup)使⽤两个man⼿册:man teamd.conf | grep activeman nmcli-examples | grep team | grep \\$# nmcli con add type team con-name t1 ifname t1 config '{"runner": {"name": "activebackup"}}'# nmcli con add type team-slave con-name t1s1 ifname eno1 master t1# nmcli con add type team-slave con-name t1s2 ifname eno2 master t1# nmcli con mod t1 connection.autoconnect yes ipv4.method static ipv4.addresses 192.168.0.100/24# systemctl restart NetworkManager 或network# teamdctl t1 state3.2 配置⽹卡Bridge ⾃整理未讲man nmcli-examples || grep bridge4 ⽹络端⼝安全4.1 iptables 规则链4.2 iptables课程命令:# iptables -L 列出各链及其规则# iptables -F 清除规则链内的规则# iptables -X 删除⾃定义的规则链# iptables -A INPUT -s 1.1.1.1 -j DROP 在INPUT链尾增加⼀条规则,来⾃1则策略drop# iptables -R INPUT 3 -s 1.1.1.3 -j ACCEPT 替换指定位置3的规则(位置从上向下数)# iptables -L --line-number 标记各规则的位置# iptables -I INPUT 2 -s 1.1.1.4 -j DROP 在位置2插⼊⼀条规则,其他>2规则位置+1# iptables -I INPUT -s 1.1.1.5 -j DROP 在链⾸,位置1插⼊⼀条规则# iptables -P FORWARD ACCEPT 修改FORWARD链默认策略# iptables -N cooper 创建⾃定义链# iptables -E cooper sven 修改⾃定义链名# iptables-save > /root/iptables.160924 保存规则⾄指定⽂件# iptables -F; iptables -X 删除全部规则全部链# iptables-restore < /root/iptables.160924 恢复# vim /etc/sysconfig/iptables# systemctl status iptables4.3 firewalld (考试:端⼝转发 rich规则)图形:firewall-config &permanent <Zones>--<Rich Rules>--Addipv4--forward-port --{tcp 5423 80}source--172.25.0.0/16--<OK>命令:# man firewalld.richlanguage | grep forward# firewall-cmd --permanent --add-rich-rule 'rule family="ipv4" source address="172.25.0.0/16" forward-port to-port="80" protocol="tcp" port="5423"'# firewall-cmd --reload5 管理DNS服务器(了解)nslookup 主机名或IP 根据IP/主机名查看主机名/IP linux windows均适⽤5.1 相关配置⽂件5.2 ⽬标理论查看5.3 实验设置server为主DNS# yum -y install bind # rpm -qc bind # systemctl restart named# firewall-cmd --permanent --add-service=dns6 脚本 (考点,2题) ⽰例/etc/bashrc;case if#!/bin/bash...参考/etc/bashrc$0 脚本本⾝;$1 脚本后的第⼀个参数;$2 脚本后的第⼆个参数;$# 脚本后参数的个数;$* 脚本后所有的参数;$? 最后⼀条命令返回值;if [ ]-f file;-d directory;-r read;-w write;-x execute整数值⽐较[ 整数1 操作符整数2]:-eq 等于 -ne不等于 -gt ⼤于 -lt ⼩于 -le⼩于或等于 -ge ⼤于或等于字符串 = !=7 配置邮件传输(考点 1题配置本地邮件服务) postfixlab smtp-nullclient setup• /etc/postfix/master.cf – master主程序的配置⽂件• /etc/postfix/main.cf – postfix服务的配置⽂件inet_interfaces = loopback-only ##修改此条,即可⽆法接受外部发来的邮件mynetworks = 127.0.0.0/8, [::1]/128 ##或localhostmydestination = ##⽬标没有relayhost = [] ##使⽤什么服务器转发,需重启postfix服务myorigin = ##欺骗,伪装发件服务器local_transport = error: sui bian ##不允许向本机其他⽤户发邮件,错误⽇志在/var/log/maillog systemctl restart postfixsystemctl enable postfix# mail -s bt student@测试:yum list mutt ;mutt -f imaps://8 提供远程块存储(考点配置iSCSI 2题)8.1 理论8.2 iSCSi配置思路1. 使⽤root账户进⾏配置2. 安装iscsi target服务,名称为targetcli3. 开启targetcli服务,并定义开机⾃动加载服务名 target4. 配置firewall,使⽤格式为firewall-cmd --permanent --add-port=3260/tcp5. 重新加载firewall服务6. 准备磁盘存储(标准分区或逻辑卷)7. 创建逻辑卷8. 在block下,使⽤targetcli命令将配置好的块设备定义到block⽬录中并命名create serverX .disk1 /dev/vg/lv9.在iscsi⽬录创建iscsi iqn 描述格式为create .example:serverX10.在iscsi⽬录中创建iscsi ACL 描述格式为.example:serverX/tpg1/acls/ create iqn.2014-.example:desktopX(备注:tgp1 是iqn时⾃动⽣成的)11.在iscsi⽬录中创建LUN与存储块的映射.example:serverX/tgp1/luns create/backstores/block/serverX.disk112.在iscsi⽬录中创建端⼝与主机地址的映射.example:serverX/tgp1/portals create 172.25.x.118.3 实验yum list targetcli服务端# fdisk /dev/vdb# yum list target*# yum -y install targetd targetcli# systemctl start (enable) target# targetcli /b /i在block下,使⽤targetcli命令将配置好的块设备定义到block⽬录中并命名/>/b<tab>/b<tab><tab><tab>/>/backstores/block create b1 /dev/vdb1 ##按题意,此处名称b1应为iscsi_store在iscsi⽬录创建iscsi iqn 描述格式为create .example:serverX/>/i<tab> create 黏贴/> /iscsi create .example:server0#created LUN 0. 在iscsi⽬录中创建LUN与存储块的映射,和存储块绑定/>/i<tab> <tab><tab>.. ..<tab><tab>/> /iscsi/.example:server0/tpg1/luns create /backstores/block/b1在iscsi⽬录中创建iscsi ACL 描述格式,限定谁能访问/> /iscsi/.example:server0/tpg1/acls create .example:desktop0 #此处iqn...为⾃定义(允许谁),和客户端配置⽂件中保持⼀致(我是谁)vim /etc/iscsi/initiatorname.iscsi在iscsi⽬录中创建端⼝与主机地址的映射/> /iscsi/.example:server0/tpg1/portals create 0.0.0.0 #此处因默认端⼝就是3260 或ip_port=3260/> ls 查看/> exit# firewall-cmd --permanent --add-port=3260/tcp# firewall-cmd --reload服务端的操作,创建并配置了/etc/target/saveconfig.json3260默认端⼝,若不是3260端⼝,需新增⼀步:semanage port -a -t iscsi_port_t -p tcp 3261客户端# rpm -qa | grep iscsi# vim /etc/iscsi/initiatorname.iscsi# systemctl restart iscsid# systemctl enable iscsid# man iscsiadm | grep \\-mode# iscsiadm --mode discoverydb --type sendtargets --portal 172.25.0.11 –discover发现共享: 172.25.0.11:3260,1 .example:server0# iscsiadm --mode node --targetname .example:server0 --portal 172.25.0.11:3260 –login--使⽤共享# fdisk /dev/sda# mkfs.ext4 /dev/sda1# blkid /dev/sda1# mkdir /mnt/data# man mount | grep netdev# vim /etc/fstab 必须使⽤UUID值...UUID=423c522b-7ee8-4372-8df0-56680ca8a0bc /mnt/data ext4 defaults,_netdev 0 0_netdev提⽰系统,先启动⽹络再挂载此设备# mount -a重启⼀次,客户端 reboot重启问题解决: rht-vmctl poweroff desktop 客户端总结:启动iscsi服务;发现iscsi⽬标;连接iscsi⽬标9 NFS (考点 2题)9.1 NFS基础9.2 NFS配置实验命令考点# yum list nfs-utils# vim /etc/exports/public *(ro) ##只读# systemctl restart nfs-server# systemctl enable nfs-server# firewall-cmd --permanent --add-service=nfs# firewall-cmd --permanent --add-service=rpc-bind# firewall-cmd --permanent --add-service=mountd# showmount -e客户端# vim /etc/fstab:/public /mnt/nfsmount nfs defaults 0 0# mount -a9.3 配置基于Kerberos验证的NFS 考点# lab nfskrb5 setupserver client/etc/exportsec=krb5p/etc/sysconfig/nfs /etc/fstab-V 4.2 v4.2,sec=krb5p/etc/krb5.keytab /etc/krb5.keytabnfs-secure-server nfs-secure服务端:man exports /sec=①修改配置⽂件# vim /etc/exports.../protected *(rw,sec=krb5p)②修改配置⽂件:/etc/sysconfig/nfs# Optional arguments passed to rpc.nfsd. See rpc.nfsd(8) RPCNFSDARGS="" #修改为:RPCNFSDARGS="-V 4.2"③下载keytab⽂件# wget -O /etc/krb5.keytab④启动nfs-secure-server 服务# systemctl restart nfs-server# systemctl restart nfs-secure-server enable# chown ldapuser0 /protected/project客户端:①下载keytab⽂件# wget -O /etc/krb5.keytab②启动nfs-secure服务# systemctl start nfs-secure③修改配置⽂件# vim /etc/fstab:/protected /mnt/nfssecure nfs defaults,sec=krb5p,v4.2 0 0。

hp-dl580G7 RHCS安装步骤一.安装RedHat-AS-5.7-64(两台)二.配置心跳地址与ilo3地址server1心跳地址:192.168.1.1 255.255.255.0 192.168.1.254(网关)server1 ilo3地址192.168.1.10 255.255.255.0 192.168.1.254(网关)server2 心跳地址:192.168.1.2 255.255.255.0 192.168.1.254(网关)server2 ilo3地址192.168.1.11 255.255.255.0 192.168.1.254(网关)三.配置两台主机host文件#vi /etc/host加入两台的心跳地址与ilo地址以及主机名称例如:server1 192.168.1.1页脚内容1server2 192.168.1.2ilo3-1 192.168.1.10ilo3-2 192.168.1.11四.配置共享存储a)从存储分配所需共享磁盘给两台机器(两台机器共享一个磁盘)b)存储若是多路径,两台机器分别安装multipath软件(HP官网下载)c)HP multipath软件只支持5.5以下版本,需要修改/etc/redhat-release文件,把版本改为5.5以下即可,等软件安装好后,再改回来d)创建pvpvcreate /dev/mapper/mpath(n)e)创建vgvgcreate vg01 /dev/mapper/mpath(n)f)创建lvlvcreate –l 10240 –n lv01 vg01g)格式化lv(若是裸设备的话,跳过)mkfs.ext3 /dev/vg01/lv01h)两台机器创建存储挂载点页脚内容2mkdir sybase五.yum安装RHCS所需的安装包yum cman六.rpm安装RHCS所需的依赖的包安装cman(光盘的Server目录下)rpm -ivh perl-XML-NamespaceSupport-1.09-1.2.1.noarch.rpm rpm -ivh perl-XML-SAX-0.14-8.noarch.rpmrpm -ivh perl-XML-LibXML-Common-0.13-8.2.2.x86_64.rpmrpm -ivh perl-XML-LibXML-1.58-6.x86_64.rpmrpm -ivh perl-Net-Telnet-3.03-5.noarch.rpmrpm -ivh pexpect-2.3-3.el5.noarch.rpmrpm -ivh openais-0.80.6-30.el5.x86_64.rpmrpm -ivh python-pycurl-7.15.5.1-8.el5.x86_64.rpm rpm -ivh python-suds-0.4.1-2.el5.noarch.rpmrpm -ivh cman-2.0.115-85.el5.x86_64.rpm安装rgmanger(Cluster目录下)rpm -ivh rgmanager-2.0.52-21.el5.x86_64.rpm安装system-config-cluster(Cluster目录下)rpm -ivh system-config-cluster-1.0.57-9.noarch.rpm页脚内容3安装ricci(光盘的Server目录下)rpm -ivh oddjob-0.27-11.el5.x86_64.rpm oddjob-libs-0.27.11.el5.x86_64.rpm(需要同时安装,要不然装不想上)(Cluster目录下)rpm -ivh modcluster-0.12.1-2.el5.x86_64.rpmrpm -ivh ricci-0.12.2-32.el5.x86_64.rpm安装luci(光盘的Server目录下)rpm -ivh tix-8.4.0-11.fc6.x86_64.rpmrpm -ivh tkinter-2.4.3-44.el5.x86_64.rpmrpm -ivh python-imaging-1.1.5-7.el5.x86_64.rpm(Cluster目录下)rpm -ivh luci-0.12.2-32.el5.x86_64.rpm七.安装HPSUM(psp)安装方法省略八.配置IPMIa)检测是否安装页脚内容4b)rpm –qa |grep IPMI若是没安装,加载安装光盘安装(安装好HPSUM后,会更新IPMI)c)配置ipmi自启动d)chkconfig --level 2345 ipmi onservice ipmi starte)IPMI检测ipmitool -v -H 192.168.1.10 -I lanplus -U admin mc info(ip地址为对方的地址,都互相检测下)九.配置集群system-config-cluster注:先配置集群信息才能启动集群服务(/etc/cluster/cluster.conf)页脚内容5a)选择Create New Configurationb)页脚内容6选择合适的集群名称点击okc)点击Add a Cluster Node,添加节点页脚内容7d)输入集群节点名称,点击OK若有多个节点,依次增加页脚内容8e)点击Add a Fence Device添加Fence设备页脚内容9f)点击OK继续,若有多个Fence设备,依次添加(名字不能与主机相同)页脚内容10页脚内容11g)点击Manage Fencing For This Node实现节点与fence绑定点击cluster nodes-----选择server1----选择“Manager Fenceing for This node”---选择“add a new fence level”----选择“Fence-Lenvel-1”----选择“Add a New Fence to this level”“server1-ipm”页脚内容12h)页脚内容13选中上图中Use lanplus注:每个节点加入自己的Fence设备依次绑定server2的Fence设备页脚内容14i)点击Create a Failover Domain 配置失效切换域页脚内容15输入好名称,点击OK继续点击Available Cluster Nodes选中两个节点页脚内容16Restrict Failover To This Domains Members:指派给这个Failover Domain 的Service 只可以在当前加入的成员上执行;如果不选此项,Service 将允许在本集群中的任何节点进行Failover 切换。

rhcsa阶段笔记RHCSA(Red Hat Certified System Administrator)是Red Hat认证系统管理员的简称,它是Red Hat公司推出的认证体系之一。

通过RHCSA认证可以证明考生在Linux系统管理方面具有一定的技能和经验,尤其是在Red Hat Enterprise Linux(RHEL)系统上。

以下是一些RHCSA阶段考试的复习笔记,供您参考:1. 考试概述RHCSA考试主要考察考生在Linux系统管理方面的技能,包括系统安装、配置、维护和故障排除等方面的能力。

考试内容涉及Red Hat Enterprise Linux 7或更高版本。

2. 考试要求考生需要掌握以下方面的技能:- 系统安装和配置- 存储管理- 文件和目录管理- 用户和组管理- 软件包管理- 系统监控和维护- 网络配置和管理- 安全配置和管理3. 考试形式RHCSA考试采用闭卷、单选题形式,共有60道题目,考试时间为2小时。

考试难度为中等,需要考生熟练掌握Linux系统管理方面的技能。

4. 备考建议为了顺利通过RHCSA考试,考生需要掌握以下方面的知识:- Red Hat Enterprise Linux的安装和配置- 存储管理(如磁盘分区、文件系统挂载等)- 文件和目录权限管理- 用户和组管理(如创建、删除用户和组,配置用户权限等)- 软件包管理(如使用RPM包管理器,安装、更新、卸载软件包等)- 系统监控和维护(如查看系统资源使用情况,进行系统性能优化等)- 网络配置和管理(如配置网络接口、防火墙等)- 安全配置和管理(如配置SELinux、设置账户密码策略等)希望以上信息可以帮助到您,如有其他问题,可以查阅红帽官方教材或者咨询培训机构,也可以找专业的题库网站去进行有针对性的学习。

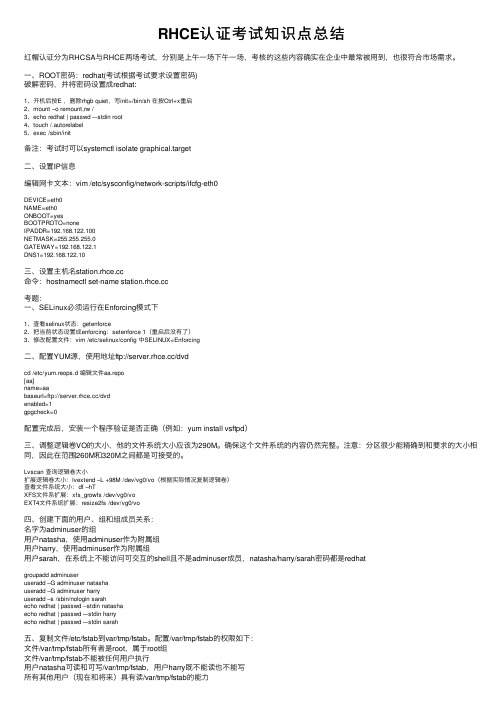

RHCE认证考试知识点总结红帽认证分为RHCSA与RHCE两场考试,分别是上午⼀场下午⼀场,考核的这些内容确实在企业中最常被⽤到,也很符合市场需求。

⼀、ROOT密码:redhat(考试根据考试要求设置密码)破解密码,并将密码设置成redhat:1、开机后按E ,删除rhgb quiet,写init=/bin/sh 在按Ctrl+x重启2、mount –o remount,rw /3、echo redhat | passwd –-stdin root4、touch /.autorelabel5、exec /sbin/init备注:考试时可以systemctl isolate graphical.target⼆、设置IP信息编辑⽹卡⽂本:vim /etc/sysconfig/network-scripts/ifcfg-eth0DEVICE=eth0NAME=eth0ONBOOT=yesBOOTPROTO=noneIPADDR=192.168.122.100NETMASK=255.255.255.0GATEWAY=192.168.122.1DNS1=192.168.122.10三、设置主机名命令:hostnamectl set-name 考题:⼀、SELinux必须运⾏在Enforcing模式下1、查看selinux状态:getenforce2、把当前状态设置成enforcing:setenforce 1(重启后没有了)3、修改配置⽂件:vim /etc/selinux/config 中SELINUX=Enforcing⼆、配置YUM源,使⽤地址ftp:///dvdcd /etc/yum.reops.d 编辑⽂件aa.repo[aa]name=aabaseurl=ftp:///dvdenabled=1gpgcheck=0配置完成后,安装⼀个程序验证是否正确(例如:yum install vsftpd)三、调整逻辑卷VO的⼤⼩,他的⽂件系统⼤⼩应该为290M。

RedHat Linux Ent 5.6安装手册/RHCS安装与配置手册目录一、RHEL5.6系统安装 (2)二、RHEL5.6系统配置 (17)2.1 设置时间同步 (17)2.2 建立useradmin、sysoper、sysadmin用户管理用户与系统监控 (17)2.3 部署sysoper与useradmin维护脚本 (17)2.4配置sudo (17)三、RHEL5.6系统安全加固与系统优化 (18)四、RHEL5.6 YUM配置 (18)五、RHCS 5.6 安装与配置 (19)5.1 服务器设置 (19)5.2 安装Cluster软件(linux1、linux2) (20)5.3 在所有节点上配置CLUSTER(linux1、linux2) (20)5.4 在所有节点上执行如下命令,启动CLUSTER服务 (24)5.5 查看集群状态 (24)5.6 手动切换集群服务 (24)一、RHEL5.6系统安装1.1将RHEL 5.6光盘放入光驱,设置从光驱启动,如下图按回车。

1.2选择‘Skip’回车1.3点‘Next’1.4点‘Next’1.5点‘Next’1.6选择‘Skip entering Installation Number’,点‘OK’1.7选择‘Skip’1.8选择‘Y es’,再选择‘Create custom layout’,点‘Next’按同样的方法建立swap、/ 分驱,大小分别为:物理内存2位、10G1.10分驱完成之后选择‘Next’1.11选择‘Next’1.12设置IP地址,选择‘Edit’,选择‘Enable IPV4 support’,Manual Configuration,设置IP地址,点“OK”1.13Hostname,选择‘manually’输入主机名:,Gateway:xxx.xxx.xxx.xxx Primary DNS:xxx.xxx.xxx.xxx Secondary DNS:xxx.xxx.xxx.xxx,点‘Next’1.14时区:选择“Asia/Shanghai”,点Next1.15输入ROOT密码:****,点next1.16选择‘Customize now’,点Next1.17 选择Languages,选中‘Chinese Support’点Next.1.18点‘Next’1.19等待大约三十分钟安装完成。

RHCS红帽集群套件一、概述•RedHat Cluster Suite即红帽集群套件•能够提供高可用性、高可靠性、负载均衡、存储共享且经济实用•可以为Web应用、数据库应用等提供安全、稳定的运行环境•RHCS提供了从前端负载均衡到后端数据存储的完整解决方案,是企业级应用的首选二、RHCS的功能•高可用–核心功能–系统硬件或网络出现故障时,应用可以自动、快速地从一个节点切换到另一个节点•负载均衡–通过LVS提供负载均衡–LVS将负载通过负载分配策略,将来自于客户端的请求分配到服务器节点–当某个服务节点无法提供服务,节点将被从集群中剔除•存储集群功能–RHCS通过GFS文件系统提供存储集群功能–GFS即Global File System,允许多个服务同时读写一个单一的共享文件系统–通过GFS消除在应用程序间同步数据的麻烦–通过锁管理机制来协调和管理多个服务节点对同一个文件系统的读写操作三、RHCS组成•集群架构管理器–RHCS的基础,提供集群基本功能–包括CMAN、成员关系管理、DLM、CCS和FENCE等•高可用服务管理器–提供节点服务监控和服务故障转移功能•集群配置管理工具–System-config-cluster–luci,最新版本默认的Web管理工具•LVS•GFS–红帽公司开发,最新版本是GFS2–GFS不能孤立存在,需要RHCS底层组支持•CLVM–集群逻辑卷管理–是LVM的扩展,允许集群中的机器使用LVM来管理共享存储•iSCSI–即internet SCSI,是IETF制订的标准–将SCSI数据块映射为以太网数据包–是基于IP Storage理论的新型存储技术•GNBD–全局网络模块–是GFS的一个补充组件,用于RHCS分配和管理共享存储四、RHCS运行原理•RHCS由多个部分组成,熟练应用RHCS集群需要了解各个组件的原理、功能•分布式集群管理器CMAN–运行在全部节点上,提供集群管理任务–用于管理集群成员、消息和通知。

REDHAT RHCS 配置笔记

铁钉写于2007-07-08

MSN:gao2000g@

转贴请留以上信息

配置环境:

OS:Redhat AS4U5 (在Windows :Vmware GSX Server 3.1中虚拟的系统)

主机名:AS41, AS42

IP信息: AS41:10.10.10.1 (心跳线) 192.168.1.91 (接局域网)

AS42:10.10.10.2(心跳线) 192.168.1.92 (接局域网) 集群对外提供服务的IP: 192.168.1.95

磁盘信息:两个系统名自将Linux全部安装在: /dev/sda1 (8G)

用于集群共享存储Oracle数据文件: /dev/sdb1 (5G)

******************以下只在Vmware中配置************************

安装好系统后,在Vmware中。

给每个Linux添加两块网卡,添加一个共享磁盘。

共享磁盘会被第一个启动的Linux被锁定了,第二个就起不来了,因此必须做一下设置,用编辑器打开两个虚拟文件夹的“虚拟机名.vmx”文件,最后增加一行:

Disk.locking = false

****************** **********************************************

在vmware Linux 系统中,请一定使用date命令设置Linux系统的时间,怕因为时间问题,引起配置RHCS不成功。

设置日期:date -s 20060925

设置时间:date -s 21:19:50

配置Oracle的RHCS

1. 两台Linux都正常启动,以root身份进行系统,都不要mount oracle共享存储的

分区/dev/sdb1

2. 只需要在AS41上配置RHCS,然后将配置文件复制到AS42上即可。

3. 在AS41里的终端里输入命令:system-config-cluster即可调出配置界面,当然从

主菜单中也能找到启动配置的图标。

4. 初次配置RHCS因为在/etc/cluster下没有cluster.conf会弹出一个对话框,单

击Create New Configuration,如下图所示:

5. 接着会问一个在关锁机制的对话框,选择 DLM即可,如下图:

6. 此时我们看到的主界面如下图所示:

7. 先配置Cluster Nodes,选中左边的“Cluster Nodes” 再单击右边的 Add a Cluster nodes,分别添加AS41,AS42两个节点,两个节点方法完全一样,如下图所示:

8. 先建立好Fence Device,然后再编辑节点的失效设备配置.在配置主界面选择 Fence Device 再点击右下角的“Add a Fence Device”,如下图所示

9. 编辑Fence Devic。

因为我们没有使用专用的Fence Device,可以选择Manual Fencing类型。

名字随便取一个,本例取的是sdb,如下图所示:

10. 编辑完“Fence Device”后,再回过头编辑节点的失效属性。

选择刚建立好的节点:AS41 点击右下角“Manage Fencing For This Node”

11. 弹出编辑节点AS41的新窗口,点击“Add a New Fence Level”,如下图所示

12. 为AS41添加失效级别后,选择窗口中的失效级别,然后点击 “Add a New Fence to this Level ”如下图所示:

13. 点击“Add a New Fence to this Level”,弹出新窗口,选择刚才建立的失效设备sdb作为该失效级别下的失效设备,如下图所示:

14. 编辑完节点AS41的失效级别和失效设备后,如下图所示:

15. 对另一节点AS42也用相同的方法进行配置,AS42的失效级别和失效设备配置好后如下图所示:

16. 建立失效域,点击右边的“Failover Domains”建立一个失效域,如下图所示:

17. 域名随便定义一个,本例取的是AS,如下图所示:

18. 在失效域中,将两个节点都加到同一个域中,如下图所示:

19. 失效域建立好后,选择左边的“Managed Resources” Services,建立一个服务,此例取的服务名是“oraserver”,如下图所示:

20. 然后编辑建立的 oraserver服务,选择失效域为刚才建立的AS域,如下图所示:

21. 在上图的“oraserver服务”中,选择“Create a new resource for this service”先建立集群服务IP如下图所示:

22. 然后再建立自动mount磁盘阵列柜的Oracle数据库文件共享分区 /dev/sdb1,如下图:

23. 建立自动启动和关闭oracle数据库的服务,即指定刚才建立的/etc/rc.d/init.d/oracle服务脚本文件即可,如下图所示:

24. 建立好后的服务如下图所示:

25.RHCS所有都配置好后,主界面如下图所示:

26. 所有的配置都建立完成后,将当前配置信息保存在 /etc/cluster/cluster.conf

27.将当前的AS41系统中的 /etc/cluster/cluster.conf 文件复制到

AS42 Linux

系统中的/etc/cluster/下即可。

28. 然后,分别重启AS41,AS42的 Linux系统,在启动的过程中,会看到有关RHCS

的服务都启动成功:

ccsd 成功

cman 成功

lock_gulmd 警告

fence domain 成功

29. RHCS启动好后,可以在管理器中看到当前是哪个节点在提供服务,本例是AS41在服务(图片是后来补上的,所以和前面的服务名不相同)

30. 当前是AS41在提供服务,可以用 ip addr命令查看,集群服务的ip是否成功,

如下图:

31. 查看当前正在服务的AS41,自动挂载磁盘阵列的共享分区是否成功,如下图:

32.将AS41系统关机后,可以在AS42的RHCS管理器中,看到AS41已死掉,AS42会自动接管集群。