基于条件随机场的多标签图像分类

- 格式:pdf

- 大小:843.36 KB

- 文档页数:5

条件随机场在计算机视觉中的应用计算机视觉是人工智能领域的一个重要分支,旨在使计算机能够对图像和视频进行理解和分析。

条件随机场(Conditional Random Field,CRF)是一种经典的概率图模型,它在计算机视觉中具有广泛的应用。

本文将探讨条件随机场在计算机视觉中的应用,介绍其基本原理和具体应用场景。

一、条件随机场的基本原理条件随机场是一种无向图模型,用于建模一组随机变量之间的依赖关系。

在计算机视觉中,这些随机变量通常代表图像中的像素或者图像中的对象。

条件随机场的目标是利用这些随机变量之间的关系,对给定的输入进行推断或者分类。

条件随机场的基本原理可以简单地概括为利用特征函数对每个可能的标记序列进行打分,然后根据得分来进行推断或者分类。

特征函数是对输入的特征进行描述的函数,它可以包括像素的颜色、纹理、空间位置等信息。

通过对特征函数进行适当的选择和组合,可以有效地捕捉图像中的语义信息和结构信息。

二、条件随机场在图像分割中的应用图像分割是计算机视觉中的一个重要任务,旨在将图像分割成具有语义信息的区域。

条件随机场在图像分割中有着广泛的应用,其核心思想是将像素的标记序列作为随机变量,利用条件随机场对这些标记序列进行建模,从而实现对图像的分割。

在图像分割中,条件随机场可以利用像素之间的相似性和空间关系,对图像进行更加准确的分割。

通过合理选择特征函数,条件随机场能够充分利用图像中的结构信息和语义信息,从而得到更加准确的分割结果。

因此,条件随机场在图像分割中具有很高的应用价值。

三、条件随机场在目标检测中的应用目标检测是计算机视觉中的另一个重要任务,旨在从图像中检测出特定的目标对象。

条件随机场在目标检测中也有着重要的应用,其核心思想是将目标的位置和特征作为随机变量,利用条件随机场对这些随机变量进行建模,从而实现对目标的检测。

在目标检测中,条件随机场可以充分利用目标的特征和上下文信息,从而实现对目标的更加准确的检测。

条件随机场(Conditional Random Field, CRF)是一种概率图模型,用于对序列数据的建模和预测。

它在自然语言处理、计算机视觉和生物信息学等领域有着广泛的应用。

本文将介绍条件随机场的基本原理和应用场景。

首先,我们来了解一下条件随机场的基本原理。

条件随机场是一种判别式模型,用于对标注序列(例如词性标注、命名实体识别)或序列分类(例如分割、分块、分词)进行建模和预测。

它的输入是一组观测序列,输出是对应的标注序列。

条件随机场的特点是能够对输入序列的局部特征进行建模,并且考虑了输入序列之间的依赖关系。

它采用了对数线性模型,利用特征函数对输入序列和标注序列之间的关系进行建模,然后通过对数线性模型的参数估计和条件概率的计算,实现对标注序列的预测。

条件随机场的应用场景非常广泛。

在自然语言处理领域,条件随机场被广泛应用于词性标注、命名实体识别、句法分析等任务。

在计算机视觉领域,条件随机场被用于图像分割、目标检测、人体姿态估计等任务。

此外,在生物信息学、医学影像分析、金融风控等领域,条件随机场也得到了广泛的应用。

具体来说,在自然语言处理领域,条件随机场被广泛应用于词性标注任务。

词性标注是将单词按照它们在句子中的语法功能进行分类的任务。

例如,在句子“他们在公园散步”中,“他们”对应代词,应该被标注为“代词”类别。

“在”对应介词,应该被标注为“介词”类别。

条件随机场能够考虑上下文中单词的特点,从而提高词性标注的准确性。

在计算机视觉领域,条件随机场被广泛应用于图像分割任务。

图像分割是将图像中的像素按照它们所属的对象进行分类的任务。

条件随机场可以考虑像素之间的空间关系和颜色特征,从而提高图像分割的准确性。

在生物信息学领域,条件随机场被应用于蛋白质结构预测任务。

蛋白质结构预测是根据蛋白质的氨基酸序列,预测蛋白质的三维结构。

条件随机场可以考虑氨基酸之间的相互作用和结构特点,从而提高蛋白质结构预测的准确性。

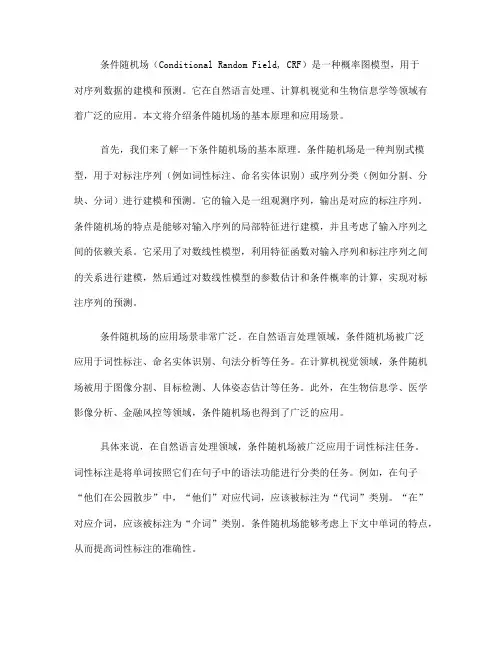

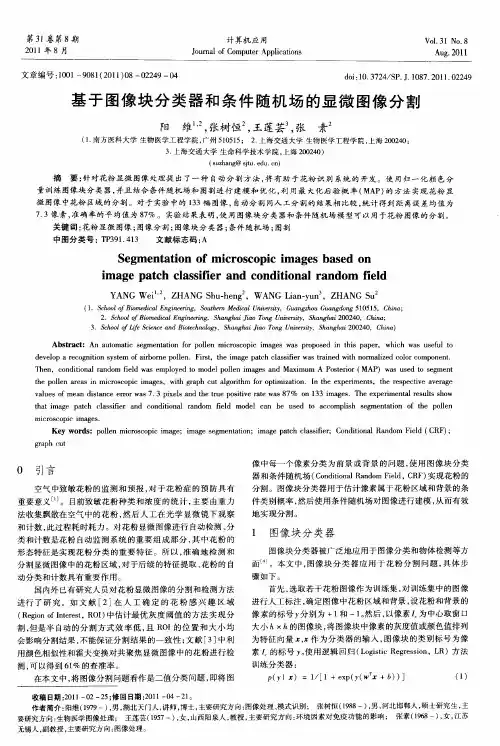

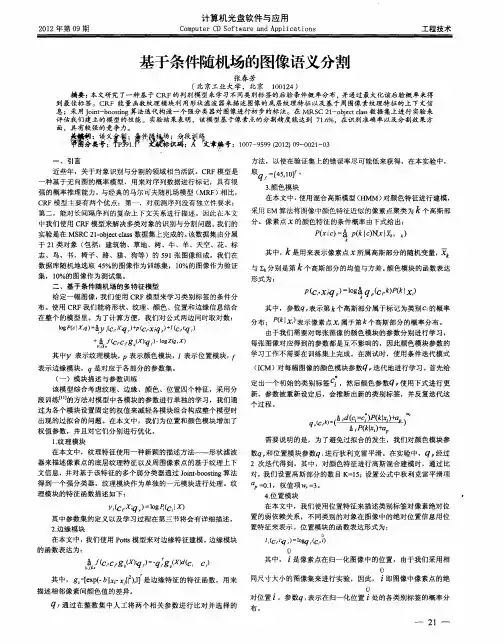

第33卷第1期计算机辅助设计与图形学学报Vol.33No.1 2021年1月Journal of Computer-Aided Design & Computer Graphics Jan. 2021基于注意力和多标签分类的图像实时语义分割高翔, 李春庚*, 安居白(大连海事大学信息科学技术学院大连116026)(********************.cn)摘要: 针对现阶段很多实时语义分割算法分割精度低, 尤其对边界像素分割模糊的问题, 提出一种基于跨级注意力机制和多标签分类的高精度实时语义分割算法. 首先基于DeepLabv3进行优化, 使其达到实时运算速度. 然后在此网络基础上增加跨级注意力模块, 使深层特征为浅层特征提供像素级注意力, 以抑制浅层特征中不准确语义信息的输出; 并在训练阶段引入多标签分类损失函数辅助监督训练. 在Cityscapes数据集和CamVid数据集上的实验结果表明, 该算法的分割精度分别为68.1%和74.1%, 分割速度分别为42帧/s和89帧/s, 在实时性与准确性之间达到较好的平衡, 能够优化边缘分割, 在复杂场景分割中具有较好的鲁棒性.关键词: 卷积神经网络; 实时语义分割; 多标签分类; 跨级注意力机制中图法分类号: TP391.4 DOI: 10.3724/SP.J.1089.2021.18233Real-Time Image Semantic Segmentation Based on Attention Mechanism and Multi-Label ClassificationGao Xiang, Li Chungeng*, and An Jubai(College of Information Sciences and Technology,Dalian Maritime University,Dalian 116026)Abstract:Improving the accuracy is the goal in real-time semantic segmentation, especially for fuzzy boundary pixel segmentation. We proposed a high-precision and real-time semantic segmentation algorithm based on cross-level attention mechanism and multi-label classification. The procedure started with an optimi-zation of DeepLabv3 to achieve real-time segmentation speed. Then, a cross-level attention module was added, so that the high-level features provided pixel-level attention for the low-level features, so as to inhibit the out-put of inaccurate semantic information in the low-level features. In the training phase, the multi-label classifi-cation loss function was introduced to assist the supervised training. The experimental results on Cityscapes dataset and CamVid dataset show that the segmentation accuracy is 68.1% and 74.1% respectively, and the segmentation speed is 42frames/s and 89frames/s respectively. It achieves a good balance between segmenta-tion speed and accuracy, can optimize edge segmentation, and has strong robustness in complex scene seg-mentation.Key words: convolutional neural networks; real-time semantic segmentation; multi-label classification; cross-level attention mechanism收稿日期: 2020-02-16; 修回日期: 2020-05-23. 基金项目: 国家自然科学基金(61471079). 高翔(1994—), 女, 硕士研究生, 主要研究方向为深度学习图像语义分割; 李春庚(1969—), 男, 博士, 副教授, 硕士生导师, 论文通讯作者, 主要研究方向为数字图像处理、基于视频的运动目标追踪; 安居白(1958—), 男, 博士, 教授, 博士生导师, 主要研究方向为模式识别、海上遥感图像分析.60 计算机辅助设计与图形学学报第33卷图像语义分割是计算机视觉的一项重要技术, 相比图像分类和目标检测, 它是一种更细粒度的像素级分类技术[1], 该技术在生产环境中具有实现成本低、部署方便的优点, 因此在无人驾驶、机器人视觉等领域[2-3]常常被应用于可行驶区域的感知系统, 这些应用领域对快速交互或响应速度有很高的要求.文献[4]提出使用全卷积神经网络(fully con-volutional networks, FCN)实现端到端的语义分割, 通过卷积和池化层对输入图像逐步下采样获得具有强鲁棒性的特征, 但也导致特征分辨率降低, 对目标边界的分割不够精细. 此后, 为更加精确地恢复高分辨率的特征, 文献[5-6]使用编码器来获得深层特征的语义信息, 使用解码器融合浅层和深层特征, 逐步恢复空间和细节信息. 此外, 文献[7]提出放弃编码器最后2次下采样操作, 使用空洞卷积保持算法的整体感受野不变, 并在网络末端增加全连接条件随机场进一步精细化网络的分割结果. 为避免特征图分辨率变小、定位精度过低等问题, DeepLabv2[8]将空洞卷积与空间金字塔池化方法结合, 提出空洞空间金字塔池化(atrous spatial pyramid pooling, ASPP)模块整合多尺度特征、增大感受野, 进而提高分割精度. 基于以上2种方法, DeepLabv3[9]进一步讨论了空洞卷积的并联和串联方式对算法分割效果的影响, 改进ASPP模块, 进而获取不同感受野信息, 提高了分割不同尺度目标的能力, 取得更好的语义分割效果. 文献[10]认为, 丰富的上下文信息可以增强网络的信息丰富度与类别区分度, 使得网络模型具有更好的语义分割能力.以上工作主要解决因网络下采样造成特征的空间信息丢失问题, 虽然提高了分割精度, 但是分割速度较慢, 无法满足实时分割任务需求. 目前实时语义分割算法大都以牺牲分割精度为前提达到实时分割速度. 实时语义分割算法SegNet[11]采用编码器-解码器结构, 在编码过程中通过多次卷积与池化运算提取特征, 在解码过程中使用池化索引执行非线性上采样, 减少内存占用并提升了速度. 为追求模型轻量化, 实时语义分割算法ENet[12]放弃最后下采样阶段, 感受野不足以覆盖比较大的对象, 导致算法分割精度较低, 但是该算法具有分割速度快的优点. 实时语义分割算法BiSeNet[13]使用浅层网络处理高分辨率图像, 并提出一种快速下采样的深层网络以平衡分类能力和感受野大小, 此算法可取得较高的分割速度和分割精度.文献[14]指出浅层特征中存在不准确的语义信息, 将深层和浅层特征直接叠加会产生大量噪声, 导致模型分割精度降低. 为解决此问题, 本文使用注意力机制为浅层特征分配像素级权重可抑制不准确语义信息的输出. 除此之外, 本文认为输入图像在神经网络中经下采样后得到的特征图中, 每个特征点在空间位置上与图像中的若干个像素点组成的区域相对应, 而这些像素点所属的类别可能不同, 因此采用多标签分类损失函数显式地监督训练网络, 使每个特征点可以具有多种类别信息, 提升特征语义信息的准确性, 进而提升算法分割精度.1本文算法为使本文算法具有实时分割速度且具有较高分割精度, 本文在当前最先进的语义分割算法DeepLabv3基础上轻量化特征提取网络, 即使用ResNet34[15]作为基础网络结构; 使用特征金字塔结构为其增加解码结构, 使其具有实时分割速度; 将优化后的网络结构作为本文算法的基础网络, 同时增加注意力机制模块和多标签损失函数监督训练, 进一步提升算法分割精度. 本节将详细介绍这3点改进.本文算法整体结构如图1所示, 其中backbone 表示ResNet34, /2和×2分别表示特征图下采样2倍和特征图上采样2倍, 虚线箭头表示在该阶段使用多标签分类损失监督网络训练, “+”表示特征图以相加的方式融合.1.1神经网络结构在自然图像中的对象往往具有不同尺度和纵横比, 如街景图像中天空、建筑、马路与路灯、广告牌尺度差别较大, 具有不恰当感受野的神经网络将无法给不同尺度目标均衡的关注. 比如, 具有小感受野的神经网络将会更加关注小目标或者将大目标分割成多个部分, 相反, 具有大感受野的神经网络将忽视小目标. 因此, 获得多感受野网络对于精细分割具有重要的意义, 而DeepLabv3利用图像的空间局部关联性和空洞卷积的采样特点对图像进行卷积运算, 既可以获取多种感受视野信息, 又可以保留特征的空间信息; 但这导致大量参数与高分辨率特征作点积运算, 降低分割速度. 而本文在保留DeepLabv3多感受野性能的前提下对分割速度进行优化. 本文算法整体结构如图1所示, 首先使用相对轻量级的ResNet34代替DeepLabv3第1期高翔, 等: 基于注意力和多标签分类的图像实时语义分割 61图1 本文算法整体结构中的ResNet101[15]作为特征编码器, 其次增加特征金字塔网络(feature pyramid networks, FPN)[16]作为解码器逐层上采样恢复特征空间信息和语义信息, 最后压缩空洞金字塔池化网络中的参数数量. 其中, ResNet34残差连接单元可避免梯度在反向传播阶段消失; FPN 是一种融合不同层级特征图的方式, 解码阶段使用FPN 重用浅层特征修复深层特征图的空间细节信息, 可以进一步增强特征图鲁棒性. 如图2所示, ASPP 由不同空洞率r 的卷积并联组成, 特征经过FPN 处理之后具有较强的鲁棒性, 因此只需要较少参数的ASPP 模块即可实现多尺度目标分割.图2 ASPP从网络组成方面来讲, 本文算法的网络主要由卷积层、激活层、空洞卷积层和批标准化层(batch normalization, BN)[17]共4种基础单元堆叠而成, 其中卷积层负责提取图像特征, 激活层负责提高网络的非线性程度, 空洞卷积层负责在保留特征空间信息的前提下增大算法感受野、提升特征的鲁棒性[7], 而BN 通过对网络不同层之间传递的数据进行标准化以消除内部协变量移位现象[17], 进而提高算法的收敛速度和精度.1.2 跨级注意力模块文献[14]指出, 浅层特征中存在不准确的语义信息, 而FPN 将深浅特征图直接相加, 这种特征融合方式将浅层特征中错误信息或冗余信息加到深层特征, 影响了算法分割精度. 鉴于此, 在深浅层特征融合的过程中, 本文引入跨级注意力模块(cross-level attention mechanism, CAM)抑制错误信息或冗余信息的输出. 注意力机制[18]的作用机制类似人类观察环境, 往往只关注某些特别重要的局部, 获取不同局部的重要信息, 抑制对当前识别作用不大的特征, 增强有效特征的作用. 注意力特征有助于增强模型的特征表达能力, 综合不同信息, 提高模型的理解能力[19].本文提出的CAM 如图3所示, 深层特征经过3×3卷积、BN 、激活处理后, 得到与编码器中浅层特征图尺度相对应的可解释权重矩阵, 然后与浅层特征图相乘, 最后将加权后的浅层特征图与深层特征图相加. 该模块以一种简单的方式使用深层特征指导浅层特征加权, 为浅层特征图提供像素级注意力, 使其关注更加具有信息量的特征点, 即在有限参数量下尽可能表达重要的信息. 该模块能够更好地平衡修剪模型架构与增强模型表达力.图3 CAM1.3 联合多标签分类监督训练不同于传统的单标签学习任务中每个样本只与一种类别信息有关, 多标签学习[20]需要输出多个标签信息, 其中每个实例可以与一组标签相关联. 假设n X = 表示n 维实例空间, {}12,,,= q Y y y y 表示标签空间, 该标签空间有q 种可能的标签类62计算机辅助设计与图形学学报 第33卷别. 多标签学习的任务是从多标签训练数据集D =(){},|1i i x Y i m ≤≤中学习一个函数:2Y f X →, 对于任意一个测试实例x X ∈, 多标签分类器()f ⋅预测x 的标签集合()f x Y ∈. 如图4所示, 在单标签分类任务中, 可能将图4中箭头所指位置的标签分配为马或者人, 但是在多标签分类任务中, 将会同时分配这2种类别, 并以此作为神经网络的标签, 监督网络同时学习这2种类别的特征.图4 多标签分类图示在当前语义分割技术中, 使用线性插值对特征进行上采样恢复语义信息类似于多标签分类任务中提取特征的过程. 如图4所示, 在语义分割编码阶段, 输入图像经卷积和下采样运算后输出原图像1/K 大小的特征图, 其中, K 为下采样倍数. 图4中本文根据下采样倍数对图像按照空间位置划分多个网格, 根据卷积神经网络输出特征与原图的映射关系可知, 特征图中的每个特征点与每个网格一一对应, 与网格中的像素点为一对多的关系. 通过图4可以发现, 在一部分网格中只存在背景类别的像素, 另一部分网格中存在马、人、背景共3种类别像素, 因此, 在某些网格内部存在多种类别目标的边界交汇. 在解码器上采样阶段使用线性插值对特征点采样提高特征图分辨率, 由于线性插值是基于空间不变模型的方法, 无法捕捉边缘快速变化的信息, 会产生边缘模糊效果[21].因此, 为进一步提高解码阶段上采样特征的准确性, 本文在特征图分辨率为原图1/32和1/16大小的特征图上进行上采样时, 引入多标签分类损失函数显式地监督网络训练. 这样可以使特征点包含的语义信息与图像中对应网格区域中的像素类别信息一致, 进而可以在恢复特征图分辨率的同时保证类别信息准确性, 并且不会降低算法的分割速度. 本文使用多标签分类损失函数和交叉熵损失函数共同监督网络学习, 修正目标边界信息. 损失函数描述为()()()1CE 2BCE 16163BCE 3232ˆˆ,,ˆ ,.=++L L y y L s s L s sλλλ其中, CE L 表示交叉熵损失函数; BCE L 表示多标签损失函数, 本文中多标签损失函数使用二进制交叉熵损失函数; 1632, , ⨯∈ H W y s s 表示真实标签;16s 和32s 表示标签分辨率大小分别为原标签分辨率大小的1/16和1/32; 1632ˆˆˆ, , ⨯∈ H W ys s 表示对应预测值; 123, , λλλ表示控制3个损失函数权重的3个超参数.2 实验与分析2.1 评价指标在本文实验中使用平均交并比(mean intersec-tion-over-union, mIoU), 处理每幅图像所用时间t (ms)和图像处理速度v (帧/s)作为算法性能评价指标.mIoU 为语义分割的标准度量, 计算2个集合的交集与并集之比, 在每个像素类别内计算交并比(intersection-over-union, IoU), 然后计算平均值. 使用处理每幅图像所用的时间t (ms)和图像处理速度v (帧/s)来衡量算法的速度, mIoU 和v 计算公式分别为001mIoU ,1kiik ki ij ji iij j p k p p p ====++-∑∑∑.NiiNv t =∑其中, ii p 表示分割正确的数量; ij p 表示本属于i 类但预测为j 类的像素数量; ji p 表示本属于j 类被预测为i 类的像素数量; N 表示图像数量; t 表示处理每幅图像所用的时间.2.2 实验数据与实验环境Cityscapes 数据集[22]包含来自不同城市、不同季节拍摄的5 000幅精确标注和20 000幅粗略标注的街景图像, 每幅图像分辨率为1 024像素×2 048像素. 数据集共19个街景类别. 在本文实验中, 仅使用精确标注的5 000幅图像, 其中3 475幅用于训练模型, 1 525幅用于测试, 测试数据没有提供真实标签, 需要提交其官方服务器测评.CamVid 数据集[23]包含从视频序列中提取的701幅分辨率为760像素×960像素的图像, 其中367幅用于训练, 101幅用于验证, 233幅用于测试,第1期高翔, 等: 基于注意力和多标签分类的图像实时语义分割 63在本文实验中共测试11个语义类别.本文所有实验的仿真实验环境为Ubuntu18.04, Python3.7.4, Pytorch1.1.0, 显卡为NVIDIA Titan RTX 和GTX1060. 模型编码器基础网络是在ImageNet 数据集[24]上预训练的ResNet34. 初始学习速率设置为0.005, 学习速率调整策略使用多项式衰减策略, 权重衰减使用L 2正则化, 衰减系数设置为0.000 5, 动量设置为0.9.2.3 算法性能分析与比较首先, 本文基于Cityscapes 和CamVid 数据集的分割结果在速度和精度2个方面进行模块有效性评估, 之后与模型FCN-8s, DeepLabv2, ENet, SegNet, ICNet [25]和BiSeNet 对比, 最后通过可视化结果进一步分析算法的分割性能. 2.3.1 模块有效性评估为评估本文提出的CAM 的效果, 首先对轻量化后的DeepLabv3模型进行评估, 记为Baseline, 然后对应用了本文CAM 模型进行评估, 记为Baseline+CAM. 表1所示为在显卡为NVIDIA Titan RTX 的实验环境下的消融实验结果, 在Cityscapes 和CamVid 数据集上的实验结果显示, 引入该CAM 后mIoU 分别提高了1.2%和1.4%, 处理每幅图像的运算时间分别增加1.7 ms 和1.4 ms, 证明该注意力模块可以在消耗很少运算时间的前提下提高模型分割精度, 并且说明深层特征图可以有效地指导浅层特征图保留有效信息, 防止传入过多干扰信息.表1 各模块有效性评估对比表Cityscapes(768×1536) CamVid(720×960)算法mIoU/%/ms t mIoU/% /ms t Baseline 65.3 21.9 71.5 9.8 Baseline+CAM 66.5 23.6 72.9 11.2Baseline+CAM+L ML68.123.674.111.2为评估本文提出的多标签分类损失函数辅助监督算法(记为Baseline+CAM+L ML )的有效性, 将仅使用交叉熵损失函数的算法与在解码器阶段使用多标签分类损失函数的算法对比. 其中, 关于多标签损失函数的超参数设定, 本文通过经验方式人为确定几组不同超参数值对比网络性能, 从中选取一组较优的超参数作为本文多标签损失函数的超参数, 最终超参数设定为121, 0.3,==λλ30.7=λ. 由表1可以看出, 相对于仅使用交叉熵损失函数的算法, 使用多标签分类函数监督网络训练的精度在Cityscapes 和CamVid 数据集上分别提高了1.6%和1.2%, 并且对网络运行速度没有影响, 可以说明本文采用多标签分类损失函数监督网络解码训练的有效性. 此外, 通过改变网络监督方式提升网络性能, 对于图像实时语义分割是一种非常有效的方式, 既能提高分割精度又不会影响分割速度.2.3.2 算法整体分析与比较为验证本文算法的有效性, 实验将本文算法与DeepLabv2, FCN-8s, SegNet, ENet 在Cityscapes 和CamVid 数据集上进行分割精度和速度的对比, 统一采用mIoU 衡量语义分割精度, 训练参数设置见第2.2节.从算法分割精度和处理速度上分析, 在Cityscapes 数据集上使用分辨率为768像素×1 536像素, 512像素×1 024像素进行训练、测试, 在CamVid 数据集上分别使用720像素×960像素, 384像素×480像素图像进行训练和测试. 表2是在显卡为NVIDIA Titan RTX 的实验环境下的部分实验结果. 其中, 本文算法在2个数据集上的处理速度分别为42帧/s 和89帧/s, 虽然分割速度略慢于ENet, 但是在2个数据集上的mIoU 比ENet 分别提高了9.8%和5.8%. 与SegNet 相比, 在速度更快的前提下, 在2个数据集上的mIoU 提高了11.1%和8.9%. 可见, 本文算法在速度与精度上与现有的实时分割算法相比有较好的表现. 与DeepLabv2和FCN-8s 非实时语义分割模型相比, 本文算法的分割精度也具有较大优势. 综合分析, 本文算法可以在分割速度与分割精度之间取得较好的平衡, 可以实现精确高效的分割.表2 不同算法在2个数据集上的性能对比Cityscapes(768×1 536) CamVid(720×960) 算法mIoU/%/ms t v /(帧·s –1) mIoU/% /ms t v /(帧·s –1)DeepLabv2[8] 63.1 4 000.2<1 71.3 830.0 1 FCN-8s [4] 60.4 250.0 4 66.9 76.913 SegNet [11] 57.0 31.332 65.2 13.574 ENet [12]58.3 11.983 68.3 7.3136 本文-ResNet3468.123.64274.111.289图5所示为本文算法在2个数据集上训练的损失函数曲线, 其中非联合多标签分类的交叉熵损失仅使用交叉熵损失. 可以看出, 使用本文提出的多标签分类损失函数作为损失函数辅助训练的算法在训练过程中损失值平稳下降, 相较于仅使用交叉熵损失函数有更好的表现, 进而可有效地监督算法在低分辨率特征图上进行多标签分类.64计算机辅助设计与图形学学报 第33卷a. Cityscapes 数据集b. CamVid 数据集图5 不同算法在2个数据集上的损失对比曲线表3和表4为6 GB 显存GTX1060显卡实验环境下的实验性能对比, 训练过程中无任何数据扩充, 图6~图8所示为相应分割效果展示图. 表3和图6分别展示本文算法(本文-ResNet34)与ICNet, BiSeNet 在Cityscapes 数据集上的分割结果对比. 根据表3在Cityscapes 和CamVid 数据集上的分割实验数据可知, 相比于ICNet, 本文算法在分割精度和分割速度上均有较大优势. 相比于BiSeNet, 本文算法分割精度有所提高, 但是分割速度稍慢. 根据图6分割效果图可以看出, 从分割细节来讲, ICNet 丢失细节较多, BiSeNet 对细节分割好于ICNet, 而本文算法好于BiSeNet, 这一点可以通过图6中的杆状目标分割效果看出; 另一方面, 这3种实时分割算法对图像的整体均能取得较好的分割效果, 但依据图6第2行和第3行的展示图可以看出, 本文算法和BiSeNet 对马路的分割效果好于ICNet. 而Baseline-ResNet34虽然对细节分割效果好于ICNet, 但对图像整体分割效果较差.表3 不同算法在2个数据集上性能对比Cityscapes(512×1 024) CamVid(360×480)mIoU/%/ms t v /(帧·s −1) mIoU/% /ms t v /(帧·s −1)ICNet [25] 65.3 60.016 63.4 40.025 BiSeNet [13] 66.2 20.651 65.1 14.967 本文-ResNet3466.823.04365.317.059表4 本文算法和DeepLabv3使用MobileNetv2性能对比mIoU/%t/msv/(帧·s −1) mIoU/%t/msv/(帧·s −1)Deeplabv3- MobileNetv2 64.330.2 31 62.3 22.245 本文-MobileNetv265.420.05063.9 15.963a. 输入图像b. Baseline-ResNet34c. ICNet [25]d. BiSeNet [13]e. 本文-ResNet34图6 实时语义分割算法结果对比算法算法Cityscapes(512×1 024) CamVid(360×480)第1期高翔, 等: 基于注意力和多标签分类的图像实时语义分割65本文算法与DeepLabv3使用MobileNetv2[26]作为特征提取网络的分割效果对比如图7所示, 其对应的实验数据如表4所示. 从图7可以看出, 本文算法在分割细节方面稍好于DeepLabv3, 但DeepLabv3的分割效果表现出该模型丢失了图像中更多的小目标和细节现象; 从图像整体分割效果来看, 这2种模型均能取得较好的分割效果.再结合图6和图7分析ResNet34和MobileNetv2作为特征提取网络对本文算法分割性能的影响. 可以看出, 使用ResNet34作为特征提取网络的模型在图像细节分割效果上要好于使用MobileNetv2的模型, 在图像整体分割效果上二者分割效果大体相似. 而结合表3和表4数据可以看出, 本文- ResNet34与本文-MobileNetv2模型分割速度相近. 本文分析这与测试Batch大小有关, 本文实验测试Batch为1, 当Batch增大, 本文-MobileNetv2模型占用显存少的优势更明显, 可被并行处理的图像数量增多, 其分割速度会有显著提升.a. 输入图像b. Deeplabv3-MobileNetv2c. 本文-MobileNetv2图7 Deeplabv3与本文算法在Cityscapes数据集上的对比接下来通过图8分析本文算法性能. 图8c所示为Baseline, 其提取特征网络为ResNet34, 该模型不含有CAM和多标签分类; 图8d所示为使用MobileNetv2作为提取特征网络的DeepLabv3模型; 图8e和图8f分别为使用MobileNetv2和ResNet34作为提取特征网络并与CAM和多标签分类相结合的模型, 即本文最终模型. 对于CamVid数据集, 其图像中细节部分较多, 实验中的图像分辨率只有360像素×480像素, 此分辨率较低, 因此在该数据集进行实验更加考察模型分割图像细节的能力. 从图8可以看出, Baseline对细节丢失最多, 而本文算法和DeepLabv3对细节的分割要好于Baseline, 可见本文算法的有效性.3 结语本文提出了一种基于注意力机制和多标签分类的实时图像语义分割网络, 首先优化DeepLabv3神经网络架构至满足实时分割的要求, 在此基础上设计了跨级特征注意力模块和多标签分类损失函数. CAM利用蕴含丰富语义信息的深层特征对浅层特征进行像素级加权, 实现更精确的空间信息选取, 同时, 使用多标签分类损失函数辅助监督网络学习, 在恢复特征图分辨率时有效提高类别信息准确性, 二者共同作用使得类别边界像素分割更精细. 最后, 在Cityscapes数据集和CamVid数据集上进行了一系列对比实验, 实验结果表明,本文算法能够更加准确地处理复杂场景图像中图66计算机辅助设计与图形学学报 第33卷a. 输入图像b. 真实标签c. Baselined. DeepLabv3e. 本文-MobileNetv2f. 本文-ResNet34图8 DeepLabv3与本文算法在CamVid 数据集上的对比像分割问题, 显著改善类别边缘区域分割效果, 同时证明本文算法是一种分割精度高、分割速度快的图像实时语义分割算法.参考文献(References):[1] Csurka G , Perronnin F. An efficient approach to semantic seg-mentation[J]. International Journal of Computer Vision, 2011, 95(2): 198-212[2] He Y H, Wang H, Zhang B. Color-based road detection in ur-ban traffic scenes[J]. IEEE Transactions on Intelligent Trans-portation Systems, 2004, 5(4): 309-318[3] An Zhe, Xu Xiping, Yang Jinhua, et al . Design of augmentedreality head-up display system based on image semantic seg-mentation[J]. Acta Optica Sinica, 2018, 38(7): 77-83(in Chi-nese)(安喆, 徐熙平, 杨进华, 等. 结合图像语义分割的增强现实型平视显示系统设计与研究[J]. 光学学报, 2018, 38(7):77-83)[4] Long J, Shelhamer E, Darrell T. Fully convolutional networksfor semantic segmentation[C] //Proceedings of the IEEE Con-ference on Computer Vision and Pattern Recognition. Los Alamitos: IEEE Computer Society Press, 2015: 3431-3440 [5] Lin G S, Milan A, Shen C H, et al . Refinenet: multi-path re-finement networks for high-resolution semantic segmenta-tion[C] //Proceedings of the IEEE Conference on Computer Vi-sion and Pattern Recognition. Los Alamitos: IEEE Computer Society Press, 2017: 5168-5177[6] Ronneberger O, Fischer P, Brox T. U-Net: convolutional net-works for biomedical image segmentation[C] //Proceedings ofMedical Image Computing and Computer Assisted Interven-tion. Heidelberg: Springer, 2015: 234-241[7] Chen L C, Papandreou G , Kokkinos I, et al . Semantic imagesegmentation with deep convolutional nets and fully connected crfs[OL]. [2020-02-16]. https:///abs/1412.7062, 2014 [8] Chen L C, Papandreou G , Kokkinos I, et al . DeepLab: semanticimage segmentation with deep convolutional nets, atrous con-volution, and fully connected CRFs[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 40(4): 834-848 [9] Chen L C, Papandreou G , Schroff F, et al . Rethinking atrousconvolutionforsemanticimagesegmentation[OL].[2020-02-16]. https:///abs/1706.05587[10] Yue Shiyi. Image semantic segmentation based on hierarchicalcontext information[J]. Laser & Optoelectronics Progress, 2019, 56(24): 107-115 (in Chinese)(岳师怡. 基于多层级上下文信息的图像语义分割[J]. 激光与光电子学进展, 2019, 56(24): 107-115)[11] Badrinarayanan V , Kendall A, Cipolla R. SegNet: a deep con-volutional encoder-decoder architecture for image segmenta-tion[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(12): 2481-2495[12] Paszke A, Chaurasia A, Kim S, et al . ENet: a deep neural net-work architecture for real-time semantic segmentation[OL]. [2020-02-16]. https:///abs/1606.02147[13] Yu C Q, Wang J B, Peng C, et al. BiSeNet: bilateral segmen-tation network for real-time semantic segmentation[C] //Proceedings of the European Conference on Computer Vision. Heidelberg: Springer, 2018: 334-349[14] Ghiasi G , Fowlkes C C. Laplacian pyramid reconstruction andrefinement for semantic segmentation[C] //Proceedings of the European Conference on Computer Vision. Heidelberg: Springer, 2016: 519-534。

multi-labelimageclassification:多标签图像分类总结多标签图像分类总结⽬录1.简介2.现有数据集和评价指标3.学习算法4.总结(现在存在的问题,研究发展的⽅向)简介 传统监督学习主要是单标签学习,⽽现实⽣活中⽬标样本往往⽐较复杂,具有多个语义,含有多个标签。

荷兰城市图⽚ (1)传统单标签分类 city(person) (2)多标签分类 city , river, person, European style (3)⼈的认知 两个⼈在河道边⾛路 欧洲式建筑,可猜测他们在旅游 天很蓝,应该是晴天但不是很晒 相⽐较⽽⾔,单标签分类需要得到的信息量最少,⼈的认知得到的信息量最多,多标签分类在它们两者之间 问题描述: X=R d表⽰d维的输⼊空间,Y={y1,y2,...,yq}表⽰带有q个可能的标签的标签空间 训练集D={(x i,y i)|1≤ i ≤ m},m表⽰训练集的⼤⼩,上标表⽰样本序数 x i∈ X,是⼀个d维向量。

y i⊆Y,是Y的⼀个标签⼦集 任务就是学习要学习⼀个多标签集的分类器h(x),预测h(x)⊆Y作为x的正确标签集。

常见的做法是学习⼀个衡量x和y相关性的函数f(x,y j),希望f(x,y j1)>(x,y j2),其中y j1∈y,y j2∉y。

现有数据集和评价指标1.现有数据集 NUS-WIDE 是⼀个带有⽹络标签标注的图像数据,包含来⾃⽹站的 269648张图像,5018类不同的标签。

从这些图像中提取的六种低级特征,包括64-D颜⾊直⽅图,144-D颜⾊相关图,73-D边缘⽅向直⽅图,128-D⼩波纹理,225-D块颜⾊矩和500-D 基于SIFT描述的词袋。

⽹址:.sg/research/NUS-WIDE.htm MS-COCO 数据集包括91类⽬标,328,000影像和2,500,000个label。

所有的物体实例都⽤详细的分割mask进⾏了标注,共标注了超过 500,000 个物体实体. ⽹址:/ PASCAL VOC数据集该挑战的主要⽬标是在真实场景中识别来⾃多个视觉对象类的对象。

基于机器学习的图像分类教程图像分类是机器学习中的一个重要任务,在计算机视觉和模式识别领域有着广泛的应用。

本文将介绍基于机器学习的图像分类教程,旨在帮助读者了解图像分类的基本概念、常见的算法和实现方法。

一、图像分类的基本概念图像分类是指将输入的图像分为不同的预定义类别。

它是监督学习问题的一种形式,其中训练集包含已经标记了类别的图像样本。

图像分类的目标是训练一个模型,能够对新的未标记图像进行准确分类。

二、常见的图像分类算法1. 支持向量机(Support Vector Machine,SVM)SVM是一种常用的图像分类算法,它通过在特征空间中构建一个超平面来进行分类。

SVM可以用于线性分类和非线性分类,具有高效、精确的特点。

2. 卷积神经网络(Convolutional Neural Network,CNN)CNN是近年来非常流行的图像分类算法,它模拟了人类视觉系统的工作原理。

CNN通过堆叠多个卷积层、池化层和全连接层,逐层提取图像的特征,并进行分类预测。

它在图像分类任务上取得了很好的效果。

3. k近邻算法(k-Nearest Neighbor,k-NN)k-NN算法是一种简单而有效的图像分类算法。

对于每个测试样本,k-NN算法通过计算其与训练集中各样本的距离,选择与其距离最近的k个样本,根据这k个样本的类别进行投票分类。

三、基于机器学习的图像分类实现方法1. 数据集准备首先,我们需要准备一个包含标记类别的图像训练集。

这可以是从网上下载的公共数据集,也可以是自己手动标注的图像集。

确保每个图像样本都有正确的标签。

2. 特征提取从图像中提取有意义的特征是图像分类的关键步骤。

常用的特征提取方法包括颜色直方图、梯度直方图和深度特征等。

选择适合应用场景的特征提取方法,将图像转化为机器学习算法可以处理的数值特征。

3. 模型训练选择适合图像分类任务的算法模型,并将其与特征向量的训练数据拟合。

这个过程称为模型训练,目的是通过学习训练数据的特征-标签关系,来构建一个能够预测新图像类别的模型。

crf mask的理解CRF Mask是一种基于条件随机场(Conditional Random Fields, CRF)的图像分割方法,它能够在像素级别准确地识别图像中的目标物体并进行分割。

在本文中,我们将详细介绍CRF Mask的原理和应用。

我们来了解一下CRF。

CRF是一种统计模型,用于对有标签的数据进行建模和预测。

在图像分割中,CRF被广泛应用于像素级别的标注和分割任务。

CRF Mask的核心思想是将图像分割问题转化为像素级别的标签预测问题,并利用CRF模型对每个像素进行分类。

CRF Mask主要由两个部分组成:特征提取网络和CRF模型。

特征提取网络通常是一个深度卷积神经网络(Convolutional Neural Network, CNN),用于从图像中提取特征。

这些特征包括像素的颜色、纹理、形状等信息,能够帮助CRF模型更好地理解图像。

CRF 模型则利用这些特征对每个像素进行分类,从而实现图像分割。

CRF Mask的工作流程如下:1. 输入图像:首先,将待分割的图像作为输入。

2. 特征提取:通过特征提取网络,提取图像中每个像素的特征。

3. CRF模型:利用CRF模型对每个像素进行分类,并生成像素级别的标签。

4. 分割结果:根据标签,将图像中的目标物体进行分割,并生成分割结果。

CRF Mask相较于传统的图像分割方法具有以下优势:1. 准确性高:CRF Mask能够在像素级别对图像进行分类和分割,因此可以得到更加准确的分割结果。

2. 鲁棒性强:CRF Mask利用深度学习网络提取特征,能够对图像中的复杂目标进行有效识别和分割。

3. 可扩展性好:CRF Mask的网络结构可以进行灵活的调整和优化,适应不同的图像分割任务。

CRF Mask在实际应用中有着广泛的应用,例如医学影像分析、自动驾驶、智能安防等领域。

在医学影像分析中,CRF Mask可以帮助医生更好地识别病变区域,提高诊断效果;在自动驾驶中,CRF Mask可以帮助车辆识别和分割道路和障碍物,提高驾驶安全性;在智能安防中,CRF Mask可以帮助监控系统识别人体和物体,实现智能报警和追踪。

随机森林是一种强大的机器学习算法,可以用于多标签分类问题。

本文将介绍如何使用随机森林进行多标签分类,并探讨该算法的优势和局限性。

1. 多标签分类概述多标签分类是指一个样本可以属于多个类别。

与传统的单标签分类不同,多标签分类需要预测每个样本的多个类别。

这种问题在许多实际场景中都是非常常见的,比如文本分类、图像标注等。

2. 随机森林简介随机森林是一种集成学习算法,通过构建多个决策树来进行预测。

每棵决策树都是基于不同的随机子样本和特征进行训练,然后将它们的预测结果进行组合,从而得到最终的预测结果。

随机森林具有很好的鲁棒性和泛化能力,通常能够取得较好的性能。

3. 随机森林在多标签分类中的应用在多标签分类问题中,可以使用随机森林来进行预测。

首先,需要对每个类别训练一个独立的二元分类器。

然后,将这些分类器组合成一个随机森林模型,用于预测每个样本的多个类别。

4. 随机森林的优势相比其他多标签分类算法,随机森林具有以下优势:- 鲁棒性强:随机森林能够处理大量的特征和样本,对噪声和异常值有较好的鲁棒性。

- 高效性能:随机森林通常能够取得较好的性能,即使在高维空间和非线性可分的情况下也能够取得良好的效果。

- 可解释性:由于随机森林是基于决策树的集成模型,因此可以提供特征重要性等解释性信息。

5. 随机森林的局限性然而,随机森林也存在一些局限性:- 计算开销:随机森林需要构建多棵决策树,因此在大规模数据集上会有较大的计算开销。

- 随机性影响:由于随机森林是基于随机子样本和特征进行训练的,因此可能会受到随机性的影响,导致不稳定的预测结果。

6. 如何使用随机森林进行多标签分类在实际应用中,可以按照以下步骤来使用随机森林进行多标签分类:- 数据准备:首先需要准备多标签分类的数据集,确保每个样本都有对应的多个类别标签。

- 特征工程:对数据进行特征提取、选择和转换,以便用于随机森林模型的训练。

- 模型训练:按照前述步骤,对每个类别训练一个独立的二元分类器,并将它们组合成随机森林模型。

条件随机场模型在图像分割中的应用图像分割是计算机视觉领域的一项重要任务,它旨在将图像中的像素分成几个不同的区域或对象。

条件随机场模型(CRF)是一种概率图模型,已经被广泛应用于图像分割任务中。

本文将探讨条件随机场模型在图像分割中的应用,并讨论其优势和局限性。

条件随机场模型是一种用于建模相互依赖关系的概率图模型。

在图像分割中,像素之间存在着空间上的相关性和语义上的相关性,条件随机场模型可以很好地建模这些相关性。

通过考虑像素之间的相互依赖关系,CRF能够更准确地捕捉图像中的语义信息,从而提高图像分割的准确性。

在图像分割任务中,条件随机场模型通常与其他技术结合使用,例如卷积神经网络(CNN)。

CNN能够提取图像特征,而CRF能够利用这些特征来进行像素级别的分类。

通过结合这两种模型,可以实现更精确的图像分割结果。

此外,条件随机场模型还可以通过引入额外的约束或先验知识来进一步提高分割结果的质量。

然而,条件随机场模型也存在一些局限性。

首先,CRF模型的训练和推理过程通常比较复杂,需要大量的计算资源和时间。

其次,CRF模型的性能很大程度上依赖于特征的选择和参数的设置,这对于实际应用来说可能是一个挑战。

此外,CRF模型在处理大规模图像时可能会面临效率低下的问题。

尽管存在一些局限性,条件随机场模型仍然在图像分割任务中发挥着重要的作用。

近年来,许多研究人员致力于改进条件随机场模型,以解决其存在的问题,并使其更适用于实际应用。

例如,一些研究正在探索如何通过并行计算和深度学习技术来加速CRF模型的训练和推理过程。

另外,还有一些研究致力于改进CRF模型的特征选择和参数设置,以提高其性能和适用性。

总的来说,条件随机场模型在图像分割中的应用具有重要意义,并且在不断得到改进和完善。

通过结合条件随机场模型与其他技术,并不断改进模型本身,我们有望实现更精确、高效的图像分割结果。

未来,随着计算机技术的发展和研究的不断深入,条件随机场模型在图像分割领域的应用前景将更加广阔。

多标记分类算法在图像识别中的应用图像识别技术是当今最火热的人工智能领域之一,它可以在不需要人类干预的情况下对图像进行分类、定位、分割等操作。

传统的图像识别方法主要基于手动生成特征的方式,但这种方式存在着一些不足之处,比如很难找到一个能适应所有场景的特征,而且人工生成特征需要大量的时间和精力。

因此,越来越多的研究人员开始使用机器学习的方法解决图像识别问题。

其中,多标记分类算法是图像识别中一种十分常见的机器学习算法,它已经被广泛应用于图像识别领域。

本文将阐述多标记分类算法的原理、实现方法以及其在图像识别中的应用。

一、多标记分类算法的原理多标记分类算法是一种能够对含有多种特征的对象进行分类的机器学习算法。

相对于传统的单标记分类算法,多标记分类算法可以在同一张图像中识别出多个目标,比如在一张农田的照片中识别出既有麦田、又有麦穗。

多标记分类算法的实现依赖于一个非常重要的概念,即“标记”。

标记是指一个对象的属性或特征,一个对象可能会有多个标记。

在图像识别中,每一个图像都有一系列的标记,这些标记可以表示图像中出现的不同物体,比如一辆汽车、一个行人、一座建筑物等等。

在多标记分类算法中,通常使用一些特征提取算法,比如 SIFT、HOG 等来从原始图像中提取特征。

然后将得到的特征放入分类器中进行训练,以获得一个可以对图像进行多目标分类的模型。

二、多标记分类算法的实现方法多标记分类算法的实现方法主要有两种:基于单标记分类器的方法和基于二元分类器的方法。

基于单标记分类器的方法是将多标记分类问题转化为一个单标记分类问题。

这种方法将每一个标记作为一个二元变量,并利用单标记分类算法训练多个分类器,来判断图像中是否存在某个特定的标记。

在识别时,将不同分类器预测的标记组合起来,就可以获得该图像的所有标记。

基于二元分类器的方法则是将多标记分类问题转化为若干个二元分类问题。

这种方法将每一个标记作为一个二元变量,使用二元分类器来训练每个变量,以判断图像中是否具有该标记。

随机森林是一种常用的机器学习算法,它在解决多标签分类问题上表现出色。

本文将详细介绍如何使用随机森林进行多标签分类,并探讨其优缺点以及应用场景。

1. 随机森林简介随机森林是一种集成学习方法,它由多个决策树组成。

每个决策树都是独立训练的,且从数据集中随机选择特征进行分裂。

最终,随机森林通过投票或平均值等方式综合所有决策树的结果,以达到降低过拟合风险、提高泛化能力的目的。

2. 多标签分类问题多标签分类是指一个实例可以被分配多个标签。

与传统的单标签分类问题不同,多标签分类需要考虑多个输出变量之间的相关性。

例如,对于一张图片来说,可以同时预测出其中包含的物体种类、颜色、形状等多个标签。

3. 使用随机森林进行多标签分类随机森林可以很好地解决多标签分类问题。

首先,通过对每个标签分别构建一个决策树,可以减小标签之间的相关性对结果的影响。

其次,随机森林对大量特征和样本的处理能力较强,适用于高维数据的多标签分类任务。

在实际应用中,可以通过调用Python中sklearn库的MultiOutputClassifier类来实现基于随机森林的多标签分类模型。

同时,还可以通过交叉验证、调参等方式对模型进行优化,以提高多标签分类的准确性和泛化能力。

4. 随机森林的优缺点随机森林作为一种强大的机器学习算法,在多标签分类问题上有着诸多优点。

首先,它能够有效处理高维数据和大规模数据集,适用于实际场景中复杂的多标签分类任务。

其次,随机森林具有较好的鲁棒性,对异常值和噪声的影响较小。

然而,随机森林也存在一些不足之处。

首先,随机森林在处理高维稀疏数据时效果不佳,需要进行特征选择和降维等预处理工作。

其次,随机森林算法的训练和预测过程相对耗时,需要付出一定的计算代价。

5. 随机森林在多标签分类中的应用随机森林在多标签分类问题上有着广泛的应用场景。

例如,在图片标注、音乐推荐、文本分类等任务中,随机森林都可以通过训练多个决策树并综合它们的结果来实现对多个标签的准确预测。

如何处理机器学习中的多标签分类问题机器学习中的多标签分类问题是指一个样本可以属于多个类别,而不仅仅是单个类别。

这在许多现实世界的应用中都是常见的,例如图像分类中的多物体识别和文本分类中的多标签标注。

对于这类问题,我们需要采取特定的方法来处理多标签分类任务。

下面将介绍一些常用的方法,以帮助您处理机器学习中的多标签分类问题。

1. 转化为多个独立的二分类问题:一种常见的处理策略是将多标签分类问题转化为多个独立的二分类问题。

对于每个类别,我们训练一个二分类模型,该模型仅判断样本是否属于该类别。

这些独立的二分类模型可以使用逻辑回归、支持向量机等机器学习算法进行训练和预测。

最终的类别预测由这些独立的模型组合而成。

2. 使用适当的损失函数:对于多标签分类问题,我们需要使用适当的损失函数来衡量模型的性能。

例如,常用的损失函数有交叉熵损失函数和平均汉明损失函数。

交叉熵损失函数广泛用于多分类问题,而平均汉明损失函数则适用于多标签问题,它能够考虑到样本属于多个标签的情况。

3. 考虑类别之间的相关性:在多标签分类问题中,类别之间往往存在相关性。

考虑到这个因素可以提高模型的性能。

一种常用的方法是使用图模型,如条件随机场(CRF)或者图卷积网络(GCN)。

这些模型可以捕捉到类别之间的关联关系,并将其应用于多标签分类任务中。

4. 特征选择和特征表示:在处理多标签分类问题时,合适的特征选择和特征表示对模型的性能至关重要。

可以使用特征选择算法,如互信息、卡方检验等来选择与标签相关的特征。

同时,使用合适的特征表示方法,如词袋模型、TF-IDF等,能够改善分类性能。

5. 数据平衡处理:在多标签分类问题中,不同类别的样本分布可能不平衡,这会对模型的训练和预测产生负面影响。

因此,我们需要采取一些方法来平衡数据。

常用的方法包括欠采样、过采样和类别权重调整等。

6. 模型评估和调优:对于多标签分类问题,模型的评估需要考虑到多个标签。

常用的评估指标有准确率、召回率、F1值等。

条件随机场模型在医学影像分割中的应用随着医学影像技术的不断发展,医学影像分割成为了医学影像处理中的一个重要环节。

医学影像分割是指将医学影像中感兴趣的区域从背景中准确分割出来,以便进一步进行病灶诊断、手术规划等。

然而,由于医学影像本身的复杂性和噪声干扰的存在,传统的分割方法在处理医学影像时往往效果不佳。

条件随机场模型作为一种概率图模型,近年来在医学影像分割中得到了广泛的应用。

条件随机场是一种用于建模多维随机变量之间关系的图模型,它能够对不同特征之间的依赖关系进行建模,并能够充分考虑局部像素之间的关联性。

在医学影像分割中,条件随机场模型能够很好地克服传统方法中对噪声敏感、对图像纹理和边缘信息利用不足等问题,从而提高分割的准确性和稳定性。

首先,条件随机场模型能够很好地融合不同特征信息。

在医学影像中,通常会包含丰富的像素特征信息,如图像强度、纹理、形状等。

传统方法往往只能利用其中的部分信息进行分割,而条件随机场模型能够将不同特征之间的关系进行建模,充分利用多种特征信息,从而提高了医学影像分割的准确性。

其次,条件随机场模型能够很好地考虑像素之间的空间关系。

在医学影像中,像素之间的空间关系往往十分重要。

条件随机场模型能够对像素之间的空间关系进行建模,并考虑到邻近像素之间的相互作用,从而能够更好地保持分割结果的空间连续性,避免出现过分割或欠分割的情况。

此外,条件随机场模型还能够很好地处理不均匀背景和噪声干扰的情况。

在医学影像中,由于影像本身的复杂性,往往会存在不均匀的背景以及各种噪声的干扰。

传统的分割方法往往对此类情况处理效果不佳,而条件随机场模型能够很好地利用像素之间的关联信息,对不均匀背景和噪声进行建模,提高了分割结果的稳定性和鲁棒性。

除了以上几点优势外,条件随机场模型还具有较强的泛化能力和灵活性。

它能够很好地适应不同类型的医学影像,且能够方便地融入到其他医学影像处理算法中,如图像配准、分类等,为医学影像处理的其他环节提供支持。

densecrf原理

DenseCRF是一种用于图像分割和标注的技术,它基于条件随机

场(CRF)模型。

CRF是一种概率图模型,用于建模变量之间的关系,特别适用于对图像等二维数据进行建模。

DenseCRF特别适用于像素

级别的标注和分割任务。

DenseCRF的原理可以分为两个主要部分,势能函数和推断算法。

势能函数用于定义变量之间的关系,推断算法用于根据观察数据计

算变量的后验概率。

在DenseCRF中,势能函数通常包括两部分,数据项势能和平滑

项势能。

数据项势能用于衡量每个像素的标签与观察数据的一致性,通常基于像素的颜色、纹理等特征计算。

平滑项势能用于衡量相邻

像素之间的标签一致性,促使相邻像素具有相似的标签。

这样一来,DenseCRF能够结合像素级别的特征和全局一致性来进行标注和分割。

在推断算法方面,DenseCRF通常使用迭代的方法,如迭代条件

模式翻译(Iterated Conditional Modes, ICM)或信念传播

(Belief Propagation, BP),来计算变量的后验概率。

这些算法

通过最大化势能函数来寻找最可能的标签分布,从而完成图像分割

和标注的任务。

总的来说,DenseCRF通过定义适当的势能函数和使用有效的推

断算法,能够在像素级别上结合局部特征和全局一致性,从而实现

准确的图像分割和标注。

该技术在计算机视觉领域有着广泛的应用,包括语义分割、边缘检测、目标识别等任务中发挥着重要作用。

multilabel classification多标签分类(MultilabelClassification)是机器学习中实现”标签”和”分类”之间的关联关系的一种技术。

它有助于对数据进行分析,并为业务提供有用的指导和信息。

多标签分类的概念可以追溯到19世纪,但直到20世纪末,它才被广泛采用。

多标签分类的基本思想是将数据中的项目分类成一组可以分析的标签。

简单来说,多标签分类是指把每个类别文件都分配一组标签,每个标签都表达不同的信息。

标签可以是相关词汇,关键字,属性,类别,时间戳等等。

多标签分类只有在每个类别下都有足够的标签可用时才能实现。

它还可以无限延伸,比如可以以层级结构的形式设计出更多的标签组合。

多标签分类的应用领域非常广泛,涉及计算机视觉,自然语言处理,文本挖掘,社交媒体,生物学和其他各种领域。

例如,在文本挖掘中,多标签分类可以用于对文档或评论进行标签分类;在计算机视觉领域,它可以用于图像分类;在自然语言处理中,它可以用于语义分析;社交媒体中,多标签分类可以应用于推文收集。

多标签分类有两种主要方法,一种是基于决策树的类型,另一种是基于支持向量机的类型。

决策树是一种以决策为基础的机器学习技术,通过构建决策树模型可以解释一组特征的相互关系,以达到对数据做出判断的目的。

而支持向量机的思想是,在数据空间中,可以找到一条超平面,将样本分成正确和错误两类,超平面相隔越远更容易分辨样本,可以通过不同的核函数,去拟合多维数据,来实现分类效果。

此外,多标签分类还有一些发展潜力,包括更高精度的分类性能和新的标签数据集的探索。

与传统的分类类似,多标签分类的错误也可以根据数据集的大小,模型的准确性等因素来衡量,也存在一些改进的方法,比如增强设计,模型集成,转移学习等等。

随着技术的进步,多标签分类技术将有望被应用到更多的场景中。

总之,多标签分类是机器学习中一个重要的技术,它可以将数据分类成一组标签,从而为业务提供有用的指导和信息。