Latent Regression Forest Structured Estimation of 3D Articulated Hand Posture

- 格式:pdf

- 大小:937.04 KB

- 文档页数:8

Swissmodel蛋⽩三维结构预测swiss-model蛋⽩三维结构预测蛋⽩三维结构模型预测LHCGR基因NM_000233,c.547G>A,p.G183R蛋⽩质三维结构预测⽅法概览⽐较建模法⽐较建模⼜称同源建模,原理简单,是基于计划相关的序列具有相似的三维结构且进化过程中三维结构⽐序列保守的原理,利⽤计划相关模板结构信息建模。

基本步骤:1)将⽬标序列作为查询序列,在已知蛋⽩结构数据中搜索,确定和识别出⼀个同源模板。

2)将⽬标序列和模板结构进⾏⽐对。

3)以模板结构⾻架为模型,建⽴⽬标蛋⽩质⾻架模型。

4)对模型结果进⾏评价,确定模板的实⽤性。

查找蛋⽩序列LHCGR基因,NM_000233;exon14;c.547G>A(p.G183R);699aaNCBI数据库:https://w /查找蛋⽩序列LHCGR基因,NM_000233;exon14;c.547G>A(p.G183R);699aaSWISS-MODEL同源建模法--swiss-model:⽬前应⽤最⼴泛的⽐较建模法蛋⽩结构预测⼯具https://查询到的氨基酸序列复制到输⼊框,开始建模输⼊蛋⽩全序列构建模型,共2个结果页⾯解读:(1)⾸先看搜到的模板是否覆盖当前变异位点;(2)检查搜到的模板与输⼊序列⼀致度是否>30%(2)如果可⽤,再看swissmodel评分⾼低情况。

GMQE:可信度范围为0-1,值越⼤表明质量越好QMEAN4:区间-4-0,越接近0,评估待测蛋⽩与模板蛋⽩的匹配度越好。

模型下载下载后的蛋⽩结构预测模型可以⽤Swiss-pdbviewer查看ATCG⽤Swiss-pdbviewer打开pdb模型⽂件,在controlpanel⾥去掉氨基酸⾻架和side显⽰,添加ribn显⽰在controlpanel的colR ⾥选择添加ribbon(colR->ribbon)。

Color栏下选择SecondaryStructureSuccession根据⼆级机构进⾏着⾊进⾏着⾊。

r代码潜变量增长模型潜变量增长模型 (Latent Variable Growth Model, LVGM) 是一种统计模型,用于研究个体或群体的潜在特质随时间的变化。

在 R 中实现 LVGM 通常使用 "gllm" 包。

以下是一个基本的例子,假设我们有一个名为 "data" 的数据框,其中包含两个潜在变量"latent1" 和"latent2",以及时间变量"time"。

首先,你需要安装并加载 "gllm" 包:```r("gllm")library(gllm)```然后,你可以使用以下代码拟合 LVGM:```r拟合模型lvgm_model <- gllm(latent1 ~ time 0 + latent2, data = data)输出模型摘要,包括参数估计、标准误差、z 值和 p 值summary(lvgm_model)```在这个模型中,`latent1 ~ time` 表示 "latent1" 是关于 "time" 的函数,`0 + latent2` 表示 "latent1" 的变化不受 "latent2" 的影响(或者说"latent2" 的影响被固定为0)。

你可以根据实际需要修改这个模型。

注意:在使用任何统计模型时,都应确保你的数据满足该模型的假设。

例如,LVGM 假设潜在变量是连续的,且误差项是随机的。

如果这些假设不成立,那么你的结果可能会有偏差。

第47卷第1期Vol.47No.1计算机工程Computer Engineering2021年1月January2021基于姿态估计与GRU网络的人体康复动作识别闫航1,2,陈刚1,2,佟瑶2,3,姬波1,胡北辰1(1.郑州大学信息工程学院,郑州450001;2.郑州大学互联网医疗与健康服务协同创新中心,郑州450001;3.郑州大学护理与健康学院,郑州450001)摘要:康复锻炼是脑卒中患者的重要治疗方式,为提高康复动作识别的准确率与实时性,更好地辅助患者在居家环境中进行长期康复训练,结合姿态估计与门控循环单元(GRU)网络提出一种人体康复动作识别算法Pose-AMGRU。

采用OpenPose姿态估计方法从视频帧中提取骨架关节点,经过姿态数据预处理后得到表达肢体运动的关键动作特征,并利用注意力机制构建融合三层时序特征的GRU网络实现人体康复动作分类。

实验结果表明,该算法在KTH和康复动作数据集中的识别准确率分别为98.14%和100%,且在GTX1060显卡上的运行速度达到14.23frame/s,具有较高的识别准确率与实时性。

关键词:康复训练;动作识别;姿态估计;门控循环单元;注意力机制开放科学(资源服务)标志码(OSID):中文引用格式:闫航,陈刚,佟瑶,等.基于姿态估计与GRU网络的人体康复动作识别[J].计算机工程,2021,47(1):12-20.英文引用格式:YAN Hang,CHEN Gang,TONG Yao,et al.Human rehabilitation action recognition based on pose estimation and GRU network[J].Computer Engineering,2021,47(1):12-20.Human Rehabilitation Action Recognition Based onPose Estimation and GRU NetworkYAN Hang1,2,CHEN Gang1,2,TONG Yao2,3,JI Bo1,HU Beichen1(1.College of Information Engineering,Zhengzhou University,Zhengzhou450001,China;2.Internet Medical and Health Service Collaborative Innovation Center,Zhengzhou University,Zhengzhou450001,China;3.College of Nursing and Health,Zhengzhou University,Zhengzhou450001,China)【Abstract】Rehabilitation exercise is an important treatment method for stroke patients.This paper proposes a rehabilitation action recognition algorithm,Pose-AMGRU,which combines pose estimation with Gated Recurrent Unit (GRU)in order to improve the accuracy and real-time performance of rehabilitation action recognition,and thus assist patients in in-home long-term rehabilitation training.The algorithm uses OpenPose pose estimation method to extract the skeleton joints from video frames,and the pose data is preprocessed to obtain the key action features that represent body movement.Then a GRU network with three-layer time series features is constructed by using the attention mechanism to realize rehabilitation action classification.Experimental results on KTH dataset and rehabilitation action dataset show that the proposed algorithm increases the recognition accuracy to98.14%and100%,and its running speed on GTX1060 reaches14.23frame/s,which demonstrates its excellent recognition accuracy and real-time performance.【Key words】rehabilitation training;action recognition;pose estimation;Gated Recurrent Unit(GRU);attention mechanism DOI:10.19678/j.issn.1000-3428.00582010概述脑卒中发病人数逐年上升,已成为威胁全球居民生命健康的重大疾病,具有极高的致残率,其中重度残疾者约占40%[1]。

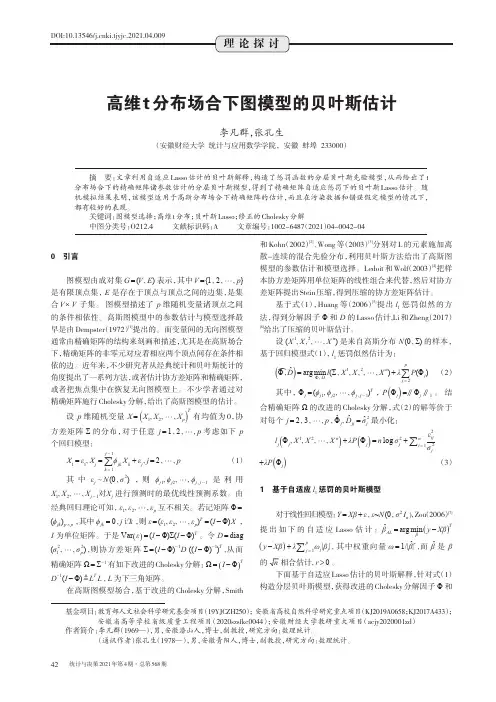

统计与决策2021年第4期·总第568期理论探讨0引言图模型由成对集G =(V E )表示,其中V ={1 2 p }是有限顶点集,E 是存在于顶点与顶点之间的边集,是集合V ´V 子集。

图模型描述了p 维随机变量诸顶点之间的条件相依性。

高斯图模型中的参数估计与模型选择最早是由Dempster (1972)[1]提出的。

而变量间的无向图模型通常由精确矩阵的结构来刻画和描述,尤其是在高斯场合下,精确矩阵的非零元对应着相应两个顶点间存在条件相依的边。

近年来,不少研究者从经典统计和贝叶斯统计的角度提出了一系列方法,或者估计协方差矩阵和精确矩阵,或者把焦点集中在恢复无向图模型上。

不少学者通过对精确矩阵施行Cholesky 分解,给出了高斯图模型的估计。

设p 维随机变量X =()X 1 X 2 X pT有均值为0,协方差矩阵Σ的分布,对于任意j =1 2 p 考虑如下p 个回归模型:X 1=ε1 X j =åk =1j -1ϕjk X k +εj j =2 p(1)其中εj N (0 σ2),则ϕj 1 ϕj 2 ϕj j -1是利用X 1 X 2 X j -1对X j 进行预测时的最优线性预测系数。

由经典回归理论可知,ε1 ε2 εp 互不相关。

若记矩阵Φ=(ϕjk )p ´p ,其中ϕjk =0 j k ,则ε=(ε1 ε2 εp )T=(I -Φ)X ,I 为单位矩阵。

于是Var ()ε=(I -Φ)Σ(I -Φ)T。

令D =diag(σ21 σ2p),则协方差矩阵Σ=(I -Φ)-1D ((I -Φ)-1)T ,从而精确矩阵Ω=Σ-1有如下改进的Cholesky 分解:Ω=()I -ΦTD -1(I -Φ) L T L ,L 为下三角矩阵。

在高斯图模型场合,基于改进的Cholesky 分解,Smith和Kohn (2002)[2]、Wong 等(2003)[3]分别对L 的元素施加离散-连续的混合先验分布,利用贝叶斯方法给出了高斯图模型的参数估计和模型选择。

transformer decoder,生成式,自回归,因果掩码和概率模型Transformer Decoder是一种语言模型结构,属于生成式模型,采用自回归的方式进行预测。

因果掩码和概率模型是其中的重要概念。

在自回归模型中,当前单词的预测是基于之前已知的单词,而因果掩码则是在预测过程中,将当前单词之前的信息进行掩盖,从而避免模型对已知信息的依赖。

概率模型则是通过计算预测结果的概率分布,来反映模型的不确定性。

Transformer Decoder是一种广泛应用于自然语言处理任务的模型,具有很高的灵活性和适应性。

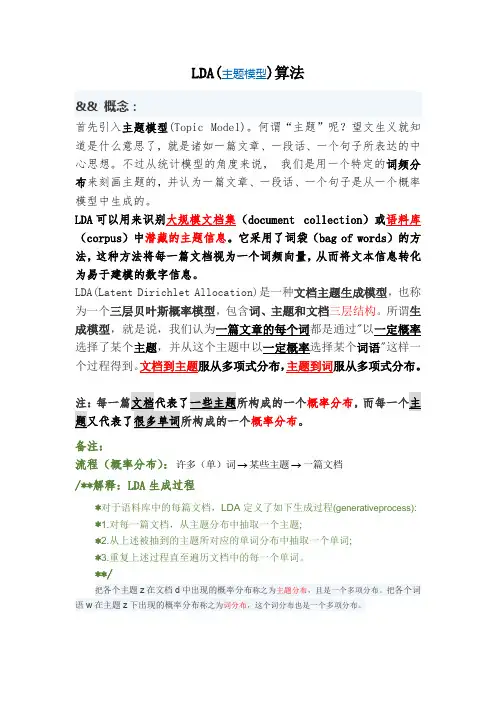

LDA(主题模型)算法&&概念:首先引入主题模型(Topic Model)。

何谓“主题”呢?望文生义就知道是什么意思了,就是诸如一篇文章、一段话、一个句子所表达的中心思想。

不过从统计模型的角度来说,我们是用一个特定的词频分布来刻画主题的,并认为一篇文章、一段话、一个句子是从一个概率模型中生成的。

LDA可以用来识别大规模文档集(document collection)或语料库(corpus)中潜藏的主题信息。

它采用了词袋(bag of words)的方法,这种方法将每一篇文档视为一个词频向量,从而将文本信息转化为易于建模的数字信息。

LDA(Latent Dirichlet Allocation)是一种文档主题生成模型,也称为一个三层贝叶斯概率模型,包含词、主题和文档三层结构。

所谓生注:每一篇文档代表了一些主题所构成的一个概率分布,而每一个主题又代表了很多单词所构成的一个概率分布。

备注:流程(概率分布):→→许多(单)词某些主题一篇文档/**解释:LDA生成过程*对于语料库中的每篇文档,LDA定义了如下生成过程(generativeprocess): *1.对每一篇文档,从主题分布中抽取一个主题;*2.从上述被抽到的主题所对应的单词分布中抽取一个单词;*3.重复上述过程直至遍历文档中的每一个单词。

**/把各个主题z在文档d中出现的概率分布称之为主题分布,且是一个多项分布。

把各个词语w在主题z下出现的概率分布称之为词分布,这个词分布也是一个多项分布。

&&深入学习:理解LDA,可以分为下述5个步骤:1.一个函数:gamma函数2.四个分布:二项分布、多项分布、beta分布、Dirichlet分布3.一个概念和一个理念:共轭先验和贝叶斯框架4.两个模型:pLSA、LDA(在本文第4 部分阐述)5.一个采样:Gibbs采样本文便按照上述5个步骤来阐述,希望读者看完本文后,能对LDA有个尽量清晰完整的了解。

SEM of Latent Interaction and Quadratic Effects潜变量交互作用和二次效应结构方程Herbert W. MarshOxford UniversityZhonglin WenSouth China Normal UniversityHong Kong Examinations AuthorityKit-Tai HauThe Chinese University of Hong Kong AERA Extended Course ◦San Francisco ◦April 7 & 8, 2006 ◦Structural Equation Modeling: A Second CourseLatent Interaction --Marsh, Wen, Hau 2Latent Interaction --提要传统方法显变量(方差分析,回归分析)潜变量(因子得分, 2SLS, 多组SEM)约束方法的演变约束方法、部分约束方法和无约束方法非正态分布:方法的稳健性乘积指标的类型二次效应其他方法(如QML,2SMM)总结Latent Interaction --交互作用例子教育心理:教学方法与学生个性对教学效果发展心理:年龄与某个给定的变量对因变量期望值理论:期望与价值对动机自我概念:自我概念分量与对该分量的重视程度对整体自尊Latent Interaction --二次效应二次效应的例子作业量增加,学业成绩提高,但到达一定作业量后反而降低开始时,压力的增加会提高成绩,但压力太大成绩反而下降低水平上的焦虑有利于表现,但高水平的焦虑却相反自我概念随儿童年龄而降低,少年时期最低,青年初期有所提高先降后升,二次效应是非线性效应最简单的例子强大的二次效应会给人有交互效应的错觉Latent Interaction --交互效应传统分析方法显变量的交互效应分析方法,(X 1, X 2) 对结果(Y )当X 1, X 2是类别变量,方差分析(ANOVA )当X 1, X 2是连续变量,回归分析当X 2类别变量, X 1是连续变量, 对X 2的不同类别,做Y 对X 1的回归分析,比较回归系数。

Logit回归模型(Logit model)也译作“评定模型”,“分类评定模型”,又作Logistic regression,“逻辑回归”,是离散选择法模型之一,属于多重变量分析范畴,是社会学、生物统计学、临床、数量心理学、计量经济学、市场营销等统计实证分析的常用方法。

逻辑分布(Logistic distribution)公式其中参数β常用极大似然估计。

具体解释如下:

逻辑分布:假设我们有一个线性回归模型,预测值是介于0和1之间的概率。

当这个线性回归模型的预测值被转换为分类标签时,它被称为逻辑回归模型。

逻辑回归模型的预测值通常通过将预测值与0.5阈值进行比较来转换为二进制分类标签。

参数β:在逻辑回归模型中,参数β被称为逻辑回归系数。

它表示线性回归模型中的斜率,用于解释输入特征对预测结果的影响。

极大似然估计:在统计推断中,极大似然估计是一种参数估计方法,它通过最大化样本数据的似然函数来估计参数的值。

在逻辑回归模型中,极大似然估计用于估计逻辑回归系数β的值。

总之,Logit回归模型是一种用于处理二元分类问题的统计模型,它通过逻辑函数将线性回归模型的预测值转换为介于0和1之间的概率,从而可以用于预测二元分类标签。

位姿回归,场景回归的学术英文表示英语## Pose Regression and Scene Regression.Introduction.Pose regression and scene regression are two important tasks in computer vision. Pose regression aims to estimate the pose of an object or a human body from images or videos. Scene regression aims to estimate the scene context of an image or a video, which can include the location, time, and activity.Pose Regression.Pose regression is a challenging task due to the high dimensionality of the pose space and the large variationsin appearance of objects and human bodies. Early approaches to pose regression used hand-crafted features and linear models. However, these approaches were limited in their accuracy and generalization ability.More recently, deep learning has been successfully applied to pose regression. Deep learning models can learn complex features from data and can handle high-dimensional input data. Convolutional neural networks (CNNs) are a particularly popular type of deep learning model for pose regression.CNNs have been used to achieve state-of-the-art results on a variety of pose regression datasets. For example, on the MPII Human Pose dataset, CNNs have achieved an accuracy of over 90%.Scene Regression.Scene regression is a more complex task than pose regression, as it requires understanding the semantics of the scene. Early approaches to scene regression used hand-crafted features and probabilistic models. However, these approaches were limited in their accuracy andgeneralization ability.More recently, deep learning has been successfully applied to scene regression. Deep learning models can learn complex features from data and can handle high-dimensional input data. Convolutional neural networks (CNNs) are a particularly popular type of deep learning model for scene regression.CNNs have been used to achieve state-of-the-art results on a variety of scene regression datasets. For example, on the Places365 dataset, CNNs have achieved an accuracy of over 80%.Applications.Pose regression and scene regression have a wide range of applications, including:Object recognition.Human-computer interaction.Robotics.Autonomous driving.Conclusion.Pose regression and scene regression are two important tasks in computer vision. Deep learning has been successfully applied to both tasks, and has achieved state-of-the-art results on a variety of datasets. These tasks have a wide range of applications, and are likely to continue to be an important area of research in the future.。

人体姿态估计算法回归Human body pose estimation algorithm is a fundamental task in computer vision that aims to estimate the pose of humans in images or videos with various applications such as activity recognition, human-computer interaction, and sports analysis. 人体姿势估计算法是计算机视觉中的一项基本任务,旨在估计图像或视频中人体的姿势,具有各种应用,如活动识别、人机交互和体育分析。

There are several approaches to tackle the problem of human pose estimation, including model-based methods, which rely on an explicit model of the human body and optimize it to fit the image data, and model-free methods, which learn the pose from data without an explicit model. 有几种方法可以应对人体姿势估计的问题,包括基于模型的方法,依赖于人体的显式模型并对其进行优化以适应图像数据,以及基于无模型的方法,其从数据中学习姿势而无需显式模型。

Model-based approaches often involve fitting a parametric model of the human body to the input image using techniques like iterative optimization or neural networks. These methods can achieve high accuracy but may struggle with complex poses or occluded bodyparts. 基于模型的方法通常涉及使用迭代优化或神经网络等技术将人体的参数模型拟合到输入图像中。

经典的自然语言处理模型

1. 隐马尔可夫模型(Hidden Markov Model,HMM)

- HMM是一种基于状态转移概率和观测概率对序列进行分析

和预测的统计模型,常用于语音识别和自然语言处理中的分词、标注和语法分析等任务。

- HMM的基本思想是将待分析的序列看作是由一系列不可观

测的隐含状态和一系列可观测的输出状态组成的,通过观测状态推断隐含状态,从而实现对序列的分析和预测。

2. 最大熵模型(Maxent Model)

- 最大熵模型是一种用于分类和回归分析的统计模型,常用于

文本分类、情感分析、命名实体识别等自然语言处理任务中。

- 最大熵模型的核心思想是最大化熵的原则,即在满足已知条

件的前提下,使模型的不确定性最大化,从而得到最优的预测结果。

3. 支持向量机(Support Vector Machine,SVM)

- SVM是一种用于分类和回归分析的机器学习模型,常用于文本分类、情感分析、命名实体识别等自然语言处理任务中。

- SVM的基本思想是将特征空间映射到高维空间,通过寻找能够最大化不同类别之间的margin(间隔)的超平面来完成分

类或回归分析,从而实现优秀的泛化能力和低复杂度。

4. 条件随机场(Conditional Random Field,CRF)

- CRF是一种用于标注和序列预测的统计模型,常用于实体识别、词性标注、句法分析等自然语言处理任务中。

- CRF的基本思想是基于马尔可夫假设,采用条件概率模型来

表示序列中每个位置的标签和相邻位置的标签间的依赖关系,从而实现对序列的标注和预测。

shap模型解释方法r语言R语言是一种用于统计分析和数据可视化的编程语言。

它具有丰富的数据处理和分析功能,能够处理大规模数据集,并提供了众多的统计模型和机器学习算法。

其中,shap模型是一种用于解释机器学习模型预测结果的方法。

shap模型(SHapley Additive exPlanations)是由Lundberg等人于2017年提出的一种解释机器学习模型预测结果的方法。

该方法通过计算特征的SHAP值,来解释模型在不同特征值下的预测结果。

SHAP值是一种基于博弈论的概念,用于衡量每个特征对于模型输出的贡献程度。

在R语言中,我们可以使用shap包来计算和可视化模型的SHAP 值。

首先,我们需要加载shap包并准备数据。

假设我们有一个二分类的机器学习模型,可以使用以下代码加载并准备数据:```{r}library(shap)# 准备数据data <- read.csv("data.csv")x <- data[, -ncol(data)] # 特征数据y <- data[, ncol(data)] # 标签数据```接下来,我们可以使用shap包提供的函数来计算SHAP值。

在计算之前,我们需要将模型转换为函数的形式。

假设我们的模型是一个逻辑回归模型,可以使用以下代码进行转换:```{r}# 转换模型为函数形式model <- glm(y ~ ., data = data, family = binomial)model_func <- function(x) {predict(model, newdata = x, type = "response")}```然后,我们可以使用shap函数来计算SHAP值,并可视化解释结果。

以下代码演示了如何计算并可视化模型的SHAP值:```{r}# 计算SHAP值explainer <- shap(model_func, x)shap_values <- explainer$x()base_value <- explainer$expected_value# 可视化解释结果plot(shap_values, x, plot_type = "bar")```通过上述代码,我们可以得到每个特征的SHAP值,并将其可视化为条形图。

logisticregression()参数logisticregression()函数的参数包括:1. `solver`:指定使用的优化算法。

可选值有"newton-cg"、"lbfgs"、"liblinear"、"sag"和"saga"。

默认值为"lbfgs"。

2. `penalty`:指定正则化项。

可选值有"l1"、"l2"、"elasticnet"和"none"。

默认值为"l2"。

3. `C`:指定正则化强度的倒数。

较小的值表示更强的正则化。

默认值为1.0。

4. `fit_intercept`:指定是否拟合截距。

如果为True,则模型会拟合一个截距。

如果为False,则模型不会拟合截距。

默认值为True。

5. `class_weight`:指定类别权重。

可选值有"balanced"和None。

默认值为None。

6. `max_iter`:指定最大迭代次数。

默认值为100。

7. `random_state`:指定随机数生成器的种子。

默认值为None。

8. `multi_class`:指定多分类问题的策略。

可选值有"auto"、"ovr"和"multinomial"。

默认值为"auto"。

9. `verbose`:指定是否输出详细信息。

如果为0,则不输出任何信息。

如果为1,则输出部分信息。

如果为大于1的整数,则输出更详细的信息。

默认值为0。

10. `n_jobs`:指定并行计算的任务数。

默认值为None,表示使用一个任务。

等等。

mediapipe人体姿态估计原理

Mediapipe是Google开发的机器学习框架,可用于实现各种计算机视觉任务,包括人体姿态估计。

人体姿态估计是指从图像或视频中识别和跟踪人体的姿态,例如身体的姿势、身体的部位和动作。

在Mediapipe中,人体姿态估计基于深度学习模型,这些模型使用卷积神经网络(CNN)和其他技术来分析输入图像,并输出关节位置和身体姿势信息。

Mediapipe的人体姿态估计模型使用了一种称为'BlazePose'的技术,这是一种基于CNN的姿态估计算法。

该算法通过将输入图像分成许多小块,并使用CNN对这些块进行分类来进行人体姿态估计。

BlazePose算法还使用了一种称为'框架'的技术,该技术将输入图像中的人体部位分为不同的关节,并使用CNN模型来预测这些关节的位置。

这些关节的位置信息可以用来计算人体的姿势。

人体姿态估计模型还使用了一种称为'Kalman滤波器'的技术,这种技术可以平滑不同帧中的关节位置,以提高估计的准确性和稳定性。

该模型还使用了'非极大抑制'的技术,这种技术可以减少重复检测,提高检测的速度。

总的来说,Mediapipe的人体姿态估计模型是一种高效、精准的深度学习算法,可以用于实现各种计算机视觉应用程序,例如人体动作捕捉、虚拟试衣间和体育分析。

- 1 -。