D篇 材料和焊接-第1章 总的要求

第2节 材料试验程序

1总则

1.1适用范围

1.1.1 本节规定了对材料的机械性能和工艺试验在试验程序、试验机械和试样方面的要求。

有关焊接的试验程序和试样规定在D篇第5章中。

涉及各种制品的规范条文指出需要的检验和试验,以及应得到的结果。

在第1章第1节中规定的一般要求也都适用。

1.2试验机械

1.2.1 试验机械应是一种认可的类型,保持令人满意的状态并由本船级社或某一认可的团体按照认可的标准,大致每年标定一次。尤其是拉力机,其容许读数误差应在ISO 7500中对1级规定的范围之内。

标定的记录应制成验船师可用的形式,并保存在试验室内。

1.3试样的准备

1.3.1 用以割取试样的样品应与从中取出样品的制品处于同一状态,因而处在同一热处理状态,如果有的话。

1.3.2 如试样是从制品中用火焰切割(在材料品种允许时)或剪切取得,则要求边缘留有合理的余量,以便在最终机加工时能从切割或剪切边缘去除足够的材料。

试样是从样品中机械切割取得,制取时务必细心,以免产生可能改变材料性能的明显变形或受热。

2拉伸试验

2.1试样

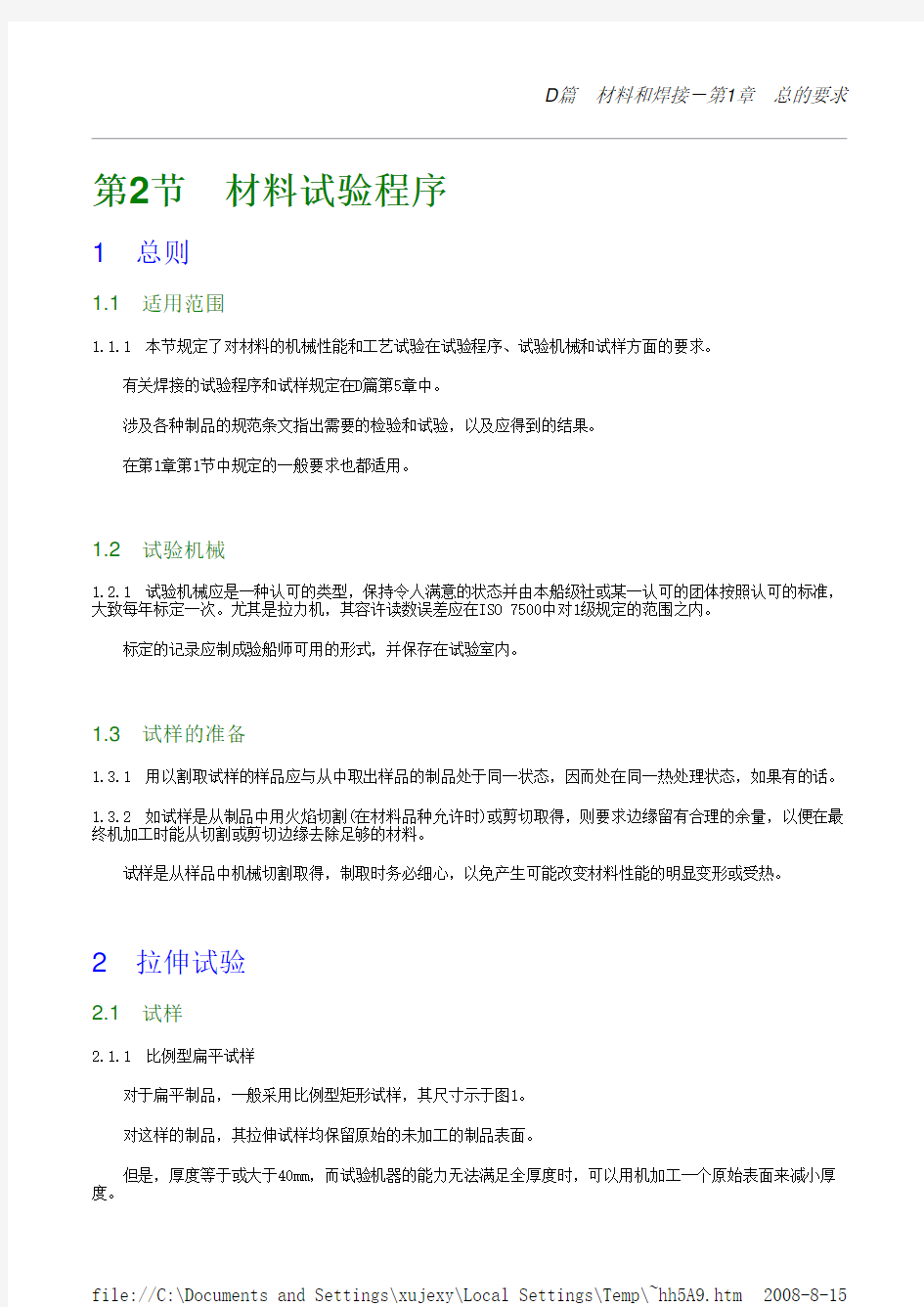

2.1.1 比例型扁平试样

对于扁平制品,一般采用比例型矩形试样,其尺寸示于图1。

对这样的制品,其拉伸试样均保留原始的未加工的制品表面。

但是,厚度等于或大于40mm,而试验机器的能力无法满足全厚度时,可以用机加工一个原始表面来减小厚

图1比例型扁平试样

t:所试验的扁平试样的厚度,mm b.R:均等于25mm

L

:计量长度,mm,等于:

其中S

为试样横截面积,单位mm2

L 0可以取整至最靠近的5mm,但是取整后的值与计算值之差要小于L

的10%

L

C

:平行试验长度,mm,等于:

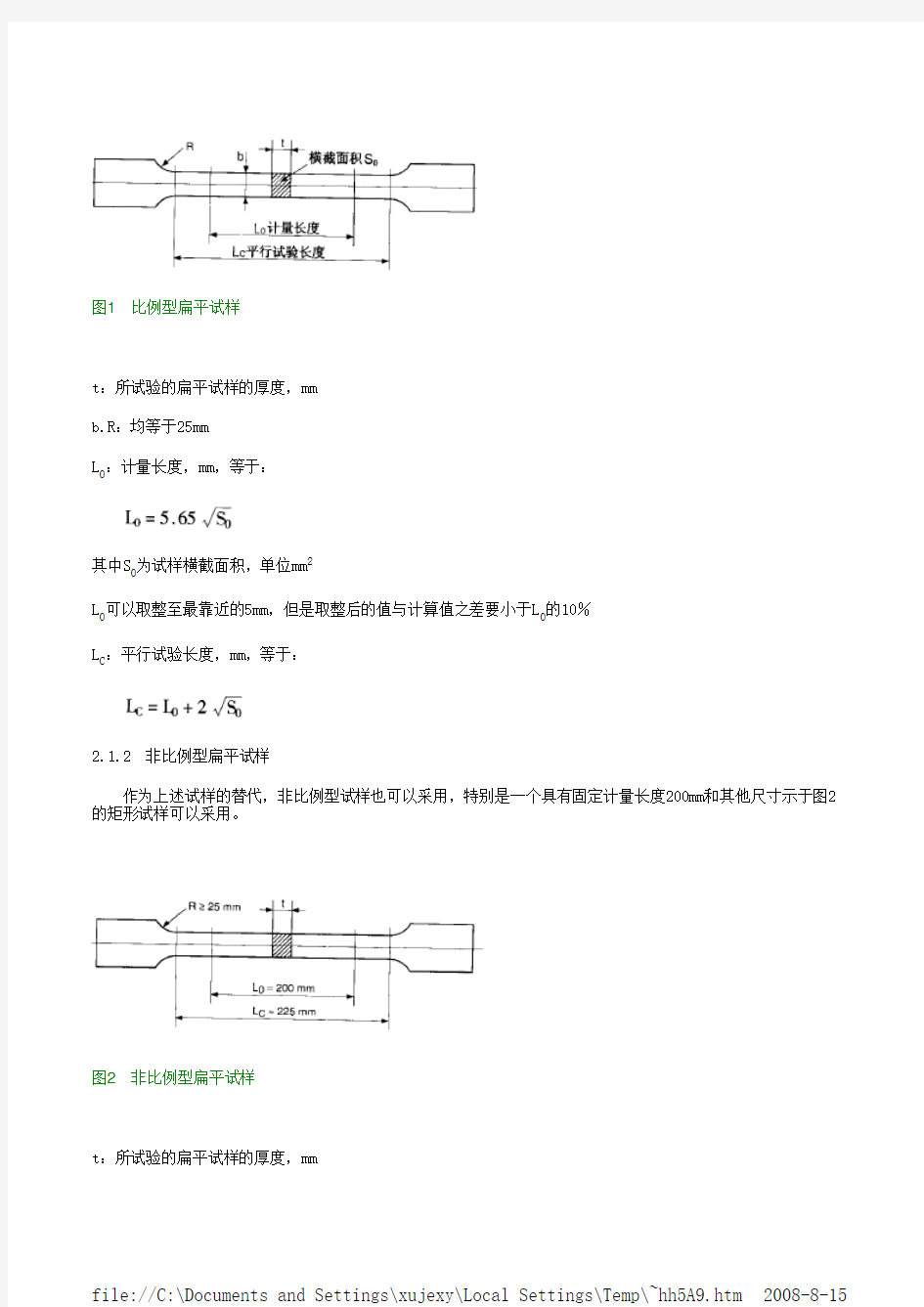

2.1.2 非比例型扁平试样

作为上述试样的替代,非比例型试样也可以采用,特别是一个具有固定计量长度200mm和其他尺寸示于图2的矩形试样可以采用。

图2非比例型扁平试样

t:所试验的扁平试样的厚度,mm

2.1.3 圆柱试样

或者可以采用另一种机加工的比例型圆柱试样,其尺寸示于图3。

图3比例型圆柱试样

如[2.1.1]所述,对轧制制品,除棒材外,其拉伸试样均要保留原始的未加工表面。

不过,厚度等于或大于40mm,而试验机器的能力无法满足全厚度时,可以用机加工一个原始表面来减小厚度。

对于长的轧制制品(棒材和型材),锻件和铸件(灰口铸铁除外),可采用比例型柱状试样,其直径通常为10或14mm。

2.1.4 圆柱试样的直径

比例型圆柱拉伸试样的直径通常为10或14mm。

若正常的试验无法取得时,在特殊情况下,通常8或6mm的尺寸也可以采用。

2.1.5 圆柱试样的位置

对厚度等于或大于40mm的轧制制品(板),圆柱试样的中心线应位于距一轧制表面约1/4厚度处。

对棒和相似的制品,圆柱试样的中心线应位于距外表面1/3半径处。

对锻制品,圆柱试样的中心线应位于认为是锻件典型截面的部件中心(或内表面)至其外表面间距离的外面1/3处。

2.1.6 灰口铸铁试样

对灰口铸铁,可采用图4所示的试样。

图4灰口铸铁试样

2.1.7 管和管状物的试样

对于管和管状物的试验,其试样可以是有适当长度的全部横截面,其两端堵塞以便固定在机器上,如图5所示。

图5全部横截面的试样

计量长度L

等于:

应不小于计量长度加D,其中D是管或管状物的外径。

且其二夹紧件间的长度L

C

塞物伸出夹紧件的长度,在计量标记方向,应不大于外径D,而且塞物的形状不应阻碍计量长度的伸长。

也可从管或管状物壁上选取如图6所示的另一件试样,其中:

图6取自管或管状物壁的试样

若壁的厚度足以允许机加工,则图3所示的圆型试样可以采用,其中心线位于管壁厚度的中间。

2.1.8 线材试样

其计量长度是200mm,其平行试验长度(二夹紧件间的距离)是250mm。

2.1.9 尺寸公差

试件的尺寸公差应符合ISO6892-84或其他公认的合适标准。

2.2试验程序

2.2.1 一般规定

各种制品要求具有下列性能的,均应由试验测定:

a)R

eH

:屈服应力(屈服点),N/mm2

b)R

p0.2R

p0.5

R

p1.0

:验证应力(屈服强度),N/mm2

c)R

m

:抗拉强度,N/mm2

d)A:断裂时的相对延伸率

e)Z:断面收缩率

2.2.2 屈服和验证应力的测定

对具有较明确屈服现象的材料,其屈服应力R

eH

是在室温下拉伸试验时,相应于试验机施加的载荷出现第一次停顿或跌落时的数值。

除非另有规定,上述定义适用于碳钢,碳-锰钢和合金钢制品,奥氏体和双炼不锈钢除外。

对那些并不出现如上所述的明显屈服应力的材料,则要求测量约定的验证应力R

p

。

通常,对钢来讲,约定的应力采用0.2%验证应力或0.5%验证应力,分别以符号R

p0.2和R

p0.5

标示,其中0.2和

0.5是永久变形的百分比。

对于奥氏体和双炼不锈钢制品,以及相关的焊接消耗品可补充1.0%验证应力,用符号R

p1.0

标示,或者以此代替。

2.2.3 载荷施加速率

对于延展性材料,其载荷施加速率在达到实际或约定的屈服应力之前,应不超过每秒30N/mm2,而以后在接近破坏应力时,要使计量长度的变形速率不超过每分钟40%。

对于脆性材料,如铸铁和非铁金属,其载荷施加速率在到达破坏应力之前应不超过每秒10N/mm2。

2.2.4 延伸率

通常延伸率以计量长度L

0的一比例数确定。L

由下式确定:

对于实心圆试样,L

等于5倍直径。

延伸率也可定义成短比例延伸或A

5

。

若使用L

0以外的计量长度,其相当的相对延伸率A

X

从下式得出:

式中:

A

5

:图1,图3和图6所示的比例型试样,按规范要求所得的最小延伸率,%

S:实际试样的初始横截面积,mm2

L:实际采用的计量长度,mm

上述转换公式仅可用于其抗拉强度不超过700N/mm2的非冷成型的铁素体制品。

若要将公式应用于诸如冷加工钢,奥氏体钢或有色金属,则要取得本船级社验船师的同意。

若不同意时则采用按比例型试样计算所得的延伸率值。

涉及到延伸率的计量长度应在试验报告中指明。

对具有计量长度50mm和200mm的非比例型试样,其相当的延伸率值指示在ISO 2566中。

如破坏处距计量长度端点不小于1.25倍试样直径(用于圆形截面),或不小于宽度与厚度之和(用于矩形截面),则延伸率值可认为是有效的。

抗伸试验后,试样破坏的状态都应予以检验,其破坏截面的状态要坚实,且没有缺陷和参差不齐。

2.2.5 高温试验

对于高温试验,在0.2%验证应力的测定时用于测量变形的计量长度应不小于50mm及横截面积应不小于

65mm2。但是,如果制品的尺寸或现有的试验设备不能满足这样的要求,则可以采用最大的允许尺寸。

通常取0.2%验证应力的约定值作为屈服应力;在即将达到屈服应力之前的变形速率应在每分钟0.1%和0.3%的计量长度之间。

评估上述速率的变形测量间隔应不超过6秒。

设备允许试验温度控制在容许偏差±5℃范围内。

3弯曲试验

3.1平面弯曲试验试样

3.1.1 应采用图7所示的平面弯曲试样。

试样的长度至少是厚度的11倍或厚度的9倍加心轴直径,取大者。

图7平面弯曲试样

3.1.2 对于铸件、锻件和半粗糙制品,其他尺寸应如下:

厚度:t=20mm

宽度:W=25mm

3.1.3 对于轧制制品,其他尺寸应如下:

厚度:t=制品厚度

宽度:W=30mm

若轧制制品的厚度大于25mm,则可用机加工试样受压缩表面将厚度减少至25mm。

3.2试验程序

3.2.1 弯曲试验的实施通常在试样的一个表面持续施加一机械压缩力。

要求的心轴直径和最小的弯曲角度均规定在涉及各制品的条款中。

如果达到要求的弯曲角度而未出现初始裂缝,则试验是令人满意的。

4冲击试验

4.1采样

4.1.1 冲击试验通常应以一组三件带切口的试样进行。

带切口试样的纵轴可以是:

a)平行于板、型材或部件的轧制方向(纵向L)

c)平行于其他选择的方向

根据不同制品的说明书中的规定,试样应作V形切口或U形切口,且分别以KV和KU标志。

不论夏比试样取的是纵向(L)还是横向(T),符号L或T均要分别加到夏比标记中。

4.1.2 切口中心线要垂直于板、型材或部件的表面。

切口的位置距火焰切割或剪切边缘的距离应不小于25mm。

4.1.3 对于轧制制品,在厚度不超过40mm时,冲击试样应保留制品原始的未加工表面或距它2mm以内截取。

在厚度超过40mm时,试样的纵轴要位于制品厚度1/4处,或尽可能接近该位置。

对于锻造制品,试样的纵轴应位于认为是锻件典型截面的部件中心(或内表面)至其外表面间的外面1/3处。

4.2夏比V形切口试样

4.2.1 试样要完全机械加工,其尺寸和容许偏差示于图8和表1。

图8夏比V型缺口试样

4.2.2 若制品厚度不能机加出标准尺寸时,则可以采用减小截面积10×7.5或10×5的试样。

要求的能量值示于表2。

表1夏比V型缺口试样

表2减小型试样的平均能量值

4.3夏比U形切口试样

4.3.1 试样要完全机械加工,其尺寸和容许偏差示于图9和表3。 表3夏比U形切口试样

图9夏比U形切口试样

4.4试验程序

4.4.1 除非有特殊规定,U形切口试样的试验应在室温下进行。

术语“室温”的意思是指温度在18至28℃范围之内。

按照本规范中涉及各制品及其使用的各部分的要求,V形切口试样应在室温或低于室温下进行。

若试验温度低于室温,试样在破损时的温度应为规定的试验温度正负2℃。

试验温度要清晰地记载入试验文件中。

4.4.2 冲击试验以一组三个试件进行,夏比冲击韧性是从这组试样得到的吸收能量的平均值,用焦耳(J)表示。

三个试样结果的平均值要达到对所研究制品要求的值,其中一个试验结果可以小于要求的平均值,但不能小于70%。

5落锤试验

5.1定义和试样尺寸

5.1.1 按照ASTM标准E208的落锤试验是为了确定NDT(零延展性转变)温度。

按照标准的条款,NDT是落锤试样试验破裂时的最大温度。

落锤试样的尺寸取下列诸尺寸之一(厚度×宽度×长度,mm3):

型:25×90×360

a)P

1

型:19×50×130

b)P

2

c)P

型:16×50×130

3

5.1.2 如无另外约定,使用下列规定:

b)为得到要求的试样厚度,对样品机加工只能在一面进行;另一面轧屑表面予以保留

c)试样的方向与轧制方向的关系并不重要,但同一批试验的所有试样要有相同的方向。

5.2试验程序

5.2.1 两件试样要在规定的试验温度下试验。

压缩面应是机加工面。

两试样均要在规定的温度下不出现裂缝。

6CTOD试验

6.1

6.1.1 除非另有约定,试验应按国家或国际标准采用全截面厚度的试样进行。

注1:国际上接受的标准包括BS 7448第1部分(1991)和ASTM E 1290(1989)。

6.1.2 根据本船级社的要求,可以进行其他断裂力学试验,以检验材料的抗脆性断裂能力。

7管状物和管的延展性试验

7.1压扁试验

7.1.1 试样为两端垂直于管状物或管轴线割下的圆环。二端面与管试样的长度等于管状物或管的外径的1.5倍,但既不要小于10mm也不大于100mm;作为替代,可采用固定长度40mm。

试件的边缘在试验前应锉圆。

7.1.2 试验为试样在两片刚性,平行且垂直于其纵轴的平板之间受压;该两板要能覆盖压扁后的整个试样。

试验应持续到两板间的距离Z(带载荷测量)达到规定的值为止。 如管状物或管是焊接的,则试验要在焊缝位于与压扁力呈90°和0°时进行。

压扁后,试样应不出现任何开裂或其他伤痕,但是,在端面的微小裂纹可以允许。

7.2扩口试验

7.2.1 试样为两端垂直于管中心线的管段,试验端的边缘可锉圆。

7.2.2 对于钢管,如扩口角度是30°,试样长度为管外径的两倍,如扩口角度是45°,60°或120°,则等于管的外径。

7.2.3 对于铜和铜合金管,试样长度应不小于管外径的两倍也不大于管外径的三倍。

7.2.4 对于铝和轻合金管,试样长度应不小于外径的两倍。

7.2.5 试验是藉助于一具有[7.2.2](图10)中规定的角度,用淬火钢制的截头锥体芯棒,将试样端部在室温下匀称地扩张。

图10扩口试验

芯棒要润滑,但在试验期间不能在管内转动。

芯棒要持续压入,直到扩张区端面的外径达到对各种制品所规定的值。

试样的扩张区不应出现任何开裂或其他伤痕。

7.3翻口试验

7.3.1 试样为两端垂直于管中心线割下的管段,且其长度至少等于管的外径;试验端面的边缘可锉圆。

7.3.2 试验分二阶段进行,藉助于一用淬火钢制的特殊芯棒将试样一端部匀称地形成一翻口;芯棒要润滑,但在试验期间不得在管内转动。

翻口的第一阶段藉助于一具有90°角的截头锥体芯棒扩张试样端部;在其后继续的第二阶段,使用一专门加工的芯棒完成翻口。

试验持续到扩张区形成一垂直于试样纵轴的翻口,试样端面的外径增大应不小于规定的值(图11)。

图11翻口试验

试样的圆柱部分和翻口部分均应不出现任何开裂或其他伤痕。

试验后,保持圆柱状的部分应不少于管外径的一半。

7.4环的扩张试验

7.4.1 试样为两端垂直于管中心线割下的管段,且其长度在10和16mm之间。

图12环的扩张试验

7.4.2 将试样扩张到规定的直径,或者直到破裂发生(图12)。

已扩张的试样应不出现不可接受的缺陷,诸如裂纹,裂缝或分层,并要达到规定的扩张。

7.5环的拉伸试验

7.5.1 试样为平整的两端面垂直于管中心线割下的管段,其长度约15mm。

7.5.2 试验藉助于两个芯棒,在拉伸试验机上拉伸直到破裂,芯棒的直径至少等于三倍管壁厚度。

如管是焊接的,则其焊缝应与拉伸载荷的方向成90°。

破裂后的试样应不出现不可接受的缺陷,诸如裂纹、裂缝或分层,并且在破裂点出现明显的变形。

7.6管状物和管的弯曲试验

7.6.1 如可行的话,试样是垂直于管中心线割下的。全厚度条状物,其宽度不小于40mm(对大厚度管,宽度可以机加工到20mm)。

试样的边缘可以倒圆至半径1.5mm。

如在初始曲率方向弯曲到要求的角度后,试样没有裂纹和分层,那结果被认为是令人满意的,边缘的小裂纹可以忽略。

7.6.2 对于小直径管子,通常直径不超过50mm时,试样为有足够的长度的管段。

依照制品说明书,试样采用下述适当的程序在芯棒上弯曲:

a)在一个直径是管子公称直径12倍的芯棒上弯曲90°角

b)在一个直径是管子公称直径8倍的芯棒上弯曲180°角

弯曲后,试样应不出现任何裂纹或其他伤痕。

8其他试验和检查

8.1应变时效致脆试验

8.1.1 试验按下列要求进行:

a)材料通常用压缩使其变形(在特殊情况下可以采用拉伸变形),直至获得要求的缩短(或伸长)(通常3%,5%或10%)

b)然后,将材料放在250℃的炉子里热处理半小时(除非另有要求)

c)夏比冲击试样均从已变形且已处理的材料获得,并在规定的温度下断裂。

当变形是由横向压缩得到时,上述的人工时效程序可以直接应用于个别试样。

8.2宏观检查和微观检查

8.2.1 对于特殊的钢制品,下列检查可要求作为随机检查进行:

a)按照ISO 4968,宏观查验硫的偏析(硫的痕迹或“Baumann试验”)

b)按照ASTM E 112 58 T标准的“McQuaid Ehn试验”,评定基本奥氏体晶粒尺寸。对于细晶粒钢,当晶粒尺寸是5或更细时,“细晶粒”状态是令人满意的。

按照其他公认标准的试验方法也可接受。

8.2.2 进行检查的试验室要颁发一份检查结果的证书,并附入典型区段的照相记录。

中文文本挖掘预处理流程总结 2017-09-22 12:14 编程派 0 0 阅读 15 作者:刘建平 来源:https://www.doczj.com/doc/d95956288.html,/pinard/p/6744056.html 在对文本做数据分析时,我们一大半的时间都会花在文本预处理上,而中文和英文的预处理流程稍有不同,本文就对中文文本挖掘的预处理流程做一个总结。 1. 中文文本挖掘预处理特点 首先我们看看中文文本挖掘预处理和英文文本挖掘预处理相比的一些特殊点。 首先,中文文本是没有像英文的单词空格那样隔开的,因此不能直接像英文一样可以直接用最简单的空格和标点符号完成分词。所以一般我们需要用分词算法来完成分词,在文本挖掘的分词原理中,我们已经讲到了中文的分词原理,这里就不多说。 第二,中文的编码不是utf8,而是unicode。这样会导致在分词的时候,和英文相比,我们要处理编码的问题。 这两点构成了中文分词相比英文分词的一些不同点,后面我们也会重点讲述这部分的处理。当然,英文分词也有自己的烦恼,这个我们在以后再讲。了解了中文预处理的一些特点后,我们就言归正传,通过实践总结下中文文本挖掘预处理流程。 2. 中文文本挖掘预处理一:数据收集 在文本挖掘之前,我们需要得到文本数据,文本数据的获取方法一般有两种:使用别人做好的语料库和自己用爬虫去在网上去爬自己的语料数据。 对于第一种方法,常用的文本语料库在网上有很多,如果大家只是学习,则可以直接下载下来使用,但如果是某些特殊主题的语料库,比如"机器学习"相关的语料库,则这种方法行不通,需要我们自己用第

对于第二种使用爬虫的方法,开源工具有很多,通用的爬虫我一般使用beautifulsoup。但是我们我们需要某些特殊的语料数据,比如上面提到的"机器学习"相关的语料库,则需要用主题爬虫(也叫聚焦爬虫)来完成。这个我一般使用ache。 ache允许我们用关键字或者一个分类算法来过滤出我们需要的主题语料,比较强大。 3. 中文文本挖掘预处理二:除去数据中非文本部分 这一步主要是针对我们用爬虫收集的语料数据,由于爬下来的内容中有很多html的一些标签,需要去掉。少量的非文本内容的可以直接用Python的正则表达式(re)删除, 复杂的则可以用beautifulsoup来去除。去除掉这些非文本的内容后,我们就可以进行真正的文本预处理了。 4. 中文文本挖掘预处理三:处理中文编码问题 由于Python2不支持unicode的处理,因此我们使用Python2做中文文本预处理时需要遵循的原则是,存储数据都用utf8,读出来进行中文相关处理时,使用GBK之类的中文编码,在下面一节的分词时,我们再用例子说明这个问题。 5. 中文文本挖掘预处理四:中文分词 常用的中文分词软件有很多,个人比较推荐结巴分词。安装也很简单,比如基于Python的,用"pip install jieba"就可以完成。下面我们就用例子来看看如何中文分词。 首先我们准备了两段文本,这两段文本在两个文件中。两段文本的内容分别是nlp test0.txt和 nlp test2.txt: 1. 沙瑞金赞叹易学习的胸怀,是金山的百姓有福,可是这件事对李达康的触动很大。易学习又回忆起他们三人分开的前一晚,大家一起喝酒话别,易 学习被降职到道口县当县长,王大路下海经商,李达康连连赔礼道歉,觉得对不起大家,他最对不起的是王大路,就和易学习一起给王大路凑了5万块钱,王大路自己东挪西撮了5万块,开始下海经商。没想到后来王大路竟然做得风生水起。沙瑞金觉得他们三人,在困难时期还能以沫相助,很不容易。 沙瑞金向毛娅打听他们家在京州的别墅,毛娅笑着说,王大路事业有成之后,要给欧阳菁和她公司的股权,她们没有要,王大路就在京州帝豪园买了三套别墅,可是李达康和易学习都不要,这些房子都在王

中文汉语语法 一、语素 语素和语素分类语素是最小的语音语义结合体,是最小的语言单位。语素按音节分类可以分成:单音节 语素,双音节语素,多音节语素。 ①单音节语素如土、人、水、风、子、民、大、海等。 ②双音节语素组成该语素的两个音节合起来才有意思,分开来没有与该语素有关的意义,双音节语素主要包括联绵字、外来词和专用名词。 A.双声,声母相同的联绵字:如琵琶、乒乓、澎湃、鞑靼、尴尬、荆棘、蜘蛛、踯躅、踌躇、仿佛、瓜葛、忐忑、淘汰、饕餮、倜傥、含糊、慷慨、叮当、蹊跷、玲珑、犹豫等。 B.叠韵,韵母相同的联绵字:如从容、葱茏、葫芦、糊涂、匍匐、灿烂、蜿蜒、苍茫、朦胧、苍莽、邋遢、罗嗦、怂恿、螳螂、桫椤、倥侗、蜻蜓、轰隆、当啷、惝恍、魍魉、缥缈、飘渺、耷拉等。 C.非双声叠韵联绵字:如蜈蚣、蓊郁、珊瑚、疙瘩、蚯蚓、惺忪、铃铛、奚落、褡裢、茉莉、蚂螂、窟窿、伉俪、蝴蝶、笊篱、蹦达、蟪蛄、狡狯、狡猾、蛤蚧、蛤蜊、牡丹、磅礴、提溜等。 D.外来词,由汉语以外的其他语种音译过来的词语。如干部、涤纶、甲克(夹克)、的士、巴士、尼龙、吉普、坦克、芭蕾、哒爹等。 E.专用名词,主要是地名、人和事物名称。如纽约、巴黎、北京、苏轼、李白、孔子、萝卜、菠菜、番茄、红薯等。 ③多音节语素 主要是拟声词、专用名词和音译外来词。如:喜马拉雅、珠穆朗玛、安迪斯、法兰克福、奥林匹克、白兰地、凡士林、噼里啪啦、淅淅沥沥、马克思主义、中华人民共和国。 二、词 词是由语素组成的最小的造句单位。有两种分类方式,1、按构成方式分单纯词和合成词;2、按词性分为实词和虚词。 从构成方式来看,可以分成: ①单纯词:由一个语素组成的词,自由的单音节语素和所有的双音节、多音节语素都可以组成单纯词。如:山、水、天、地、人、有、土、红、凑;仿佛、苍茫、蜈蚣、琉璃、参差、蹉跎;敌敌畏、阿司匹林、萨克斯、麦克风等。 ②合成词:由两个或两个以上的语素组成的词。 从词性来看,可以分成:实词共6个有实际意义的词,包括: (1)名词:表示人或事物名称的词。 有人物名词:如学生、群众、老头、妇女、同志、叔叔、维吾尔族、酒鬼等; 有事物名词:如笔、杉木、蜗牛、猎豹、奥托、棒球、战斗机、冥王星、思想、中学、物理、过程等; 有时间名词:如上午、过去、将来、午夜、三更、甲戊、世纪等; 有方位名词:如东南、上面、前方、内部、中间等。 (2)动词:表示动作行为及发展变化的词。 有行为动词:如跑、唱、喝、敲、吆喝、盯、踢、闻、听、摸; 有发展动词:如生长、枯萎、发芽、结果、产卵; 有心理动词:如喜欢、恨、气愤、觉得、思考、厌恶; 有存现动词:如消失、显现、有、丢失、幻灭; 有使令动词:如使、让、令、禁止、勒令;

词法分析小结 词法分析是编译器工作的第一阶段,它的工作就是从输入(源代码)中取得token,以作为parser(语法分析)的输入,一般在词法分析阶段都会把一些无用的空白字符(whitespace,即空格、tab和换行)以及注释剔除,以降低下一步分析的复杂度,词法分析器一般会提供一个gettoken()这样的方法,parser可以在做语法分析时调用词法分析器的这个方法来得到下一个token,所以词法分析器并不是一次性遍历所有源代码,而是采取这种on-demand的方式:只在parser需要时才工作,并且每次只取一个token。 token和lexeme 首先,token不等于lexeme。token和lexeme的关系就类似于面向对象语言中“类”和“实例”(或“对象”)之间的关系,这个用中文不知该如何解释才好,比如语言中的变量a和b,它们都属于同一种token:identifier,而a的lexeme是”a”,b则是”b”,而每个关键字都是一种token。token可以附带有一个值属性,例如变量a,当调用词法分析器的gettoken()时,会返回一个identifier类型的token,这个token带有一个属性“a”,属性可以是多样的,例如表示数字的token

可以带有一个表示数字值的属性,它是整型的。 如下代码: intage=23; intcount=50; 可以依次提取出8个token:int(值为”int”),id(值为”age”),assign(值为”=”),number(值为整型数值23),int(值为”int”),id(值为”count”),assign(值为”=”),number(值为50) 正则表达式 正则表达式可以用来描述字符串模式,例如我们可以用digit+来表示number的token,其中digit表示单个数字(这里说正则表达式并不完全和实现的正则引擎所识别的正则表达式等价,这里只是为了描述问题而已)。 然而像c语言的的多行注释,用正则表达式来描述就比较麻烦,此时更倾向于直接用有穷自动机(finiteautomaton)来描述,因为用它来描述非常直观且很容易。

WEKA 3-5-5 Explorer 用户指南 原文版本 3.5.5 翻译王娜 校对 C6H5NO2 Pentaho 中文讨论组 QQ 群:12635055 论坛:https://www.doczj.com/doc/d95956288.html,/bipub/index.asp https://www.doczj.com/doc/d95956288.html,/ 目录 1 启动WEKA (3) Explorer (5) 2 WEKA 2.1 标签页 (5) 2.2 状态栏 (5) 按钮 (5) 2.3 Log 状态图标 (5) 2.4 WEKA 3 预处理 (6) 3.1 载入数据 (6) 3.2 当前关系 (6) 3.3 处理属性 (7) 3.4 使用筛选器 (7) 4 分类 (10) 4.1 选择分类器 (10) 4.2 测试选项 (10) 4.3 Class属性 (11) 4.4 训练分类器 (11) 4.5 分类器输出文本 (11) 4.6 结果列表 (12) 5 聚类 (13) 5.1 选择聚类器(Clusterer) (13) 5.2 聚类模式 (13) 5.3 忽略属性 (13) 5.4 学习聚类 (14) 6 关联规则 (15) 6.1 设定 (15) 6.2 学习关联规则 (15) 7 属性选择 (16) 7.1 搜索与评估 (16) 7.2 选项 (16) 7.3 执行选择 (16) 8 可视化 (18)

8.1 散点图矩阵 (18) 8.2 选择单独的二维散点图 (18) 8.3 选择实例 (19) 参考文献 (20)

启动WEKA WEKA中新的菜单驱动的 GUI 继承了老的 GUI 选择器(类 weka.gui.GUIChooser)的功能。它的MDI(“多文档界面”)外观,让所有打开的窗口更加明了。 这个菜单包括六个部分。 1.Program z LogWindow打开一个日志窗口,记录输出到 stdout或stderr的内容。在 MS Windows 那样的 环境中,WEKA 不是从一个终端启动,这个就比较有 用。 z Exit关闭WEKA。 2.Applications 列出 WEKA 中主要的应用程序。 z Explorer 使用 WEKA 探索数据的环境。(本 文档的其它部分将详细介绍这个环境) z Experimenter 运行算法试验、管理算法方案 之间的统计检验的环境。 z KnowledgeFlow 这个环境本质上和 Explorer 所支持的功能是一样的,但是它有一个可以拖放 的界面。它有一个优势,就是支持增量学习 (incremental learning)。 z SimpleCLI 提供了一个简单的命令行界面,从而可以在没有自带命令行的操作系统中直接执行 WEKA 命令。 3.Tools 其他有用的应用程序。 z ArffViewer一个 MDI 应用程序,使用电子 表格的形式来查看 ARFF 文件。 z SqlViewer一个 SQL 工作表,用来通过 JDBC 查询数据库。 z EnsembleLibrary 生成集成式选择 (Ensemble Selection)[5] 所需设置的界面。 4.Visualization WEKA 中数据可视化的方法。 z Plot作出数据集的二维散点图。 z ROC显示预先保存的 ROC 曲线。

第2章文本素材处理 学习指南:本章介绍文本素材采集、编辑、加工处理的有关知识。主要内容有:文本素材的基础知识,文本素材的采集与处理方法,文本素材创作实例。学习本章,要求掌握以下知识: 掌握文本在计算机中的表示方法,了解文本素材的主要特点; 熟悉常见的文本文件的格式,并能正确地选择文本文件的存储格式; 了解常用的文本素材采集方式,熟悉扫描仪+OCR文字识别输入方法; 了解常用的文字处理软件,掌握Word文字处理的方法; 会用相关的文字处理软件制作多媒体作品中需要的文本素材。 在多媒体作品中,文本是最基本也是最常用的素材。一些说明、介绍、作品中的文字资料都会用到文本,作为多媒体系统的组成元素,它和其它素材同样重要。文本素材处理包含文本的采集、录入、编辑等加工处理,本章将介绍文本素材处理的相关知识。 2.1 文本素材概述 文本是人们早已熟知的信息表示方式,如一篇文章、一段程序、一个文件都可用文本描述。它通常以字、句子、段落、节、章为单位,记录自然现象、表述思想感情、传达某种信息。人们在阅读时,通常是一字一句、一行一页顺序地浏览。 文本是文字、字母、数字和各种功能符号的集合。在现实生活中,人们对事情的讲述、逻辑的推理、数学公式的表述等都主要用文字和数字来准确的表达。在多媒体应用系统中,虽然有图形、声音、视频影像等多种媒体形式,但是对于一些复杂而抽象的事件,文本表达却有它不可替代的独到之处。 2.1.2 文本素材基础知识 在多媒体应用系统中,文本作为重要的基本素材而被广泛应用,它具有信息表达清楚、计算机处理方便、存储容易、传输快捷等优势。具体来说: (1)编码形式简单 在计算机中,西文字符最常用的编码是ASCII码,即American Standard Code For Information Interchange(美国信息交换标准代码)。它用7位二进制数进行编码,可以表示27即128个字符,其中包括数字字符0~9、大小写英文字符、运算符号、标点符号、标识符号和一些控制符号。这些字符种类大致能够满足各种计算机语言、西方文字、常见命令的需要。一个ASCII码字符在内存中占一个字节。 汉字字符在计算机中也是以编码形式处理的,汉字输入用输入编码,汉字存储用机内码,汉字输出用字型码。在计算机中存储时,一个汉字占2个字节。 (2)易于获取,存储、处理和传输容易 多媒体计算机系统中,文本资料可以用多种方式获取,可采用多种输入编码录入,还

第30卷第1期计算机学报v01.30No.12007年1月CHINESEJOURNAL0FCOMPUTERSJan.2007 基于多知识源的中文词法分析系统 姜维王晓龙关毅赵健 (哈尔滨工业大学计算机科学与技术学院哈尔滨150001) 摘要汉语词法分析是中文自然语言处理的首要任务.文中深入研究中文分词、词性标注、命名实体识别所面临的问题及相互之间的协作关系,并阐述了一个基于混合语言模型构建的实用汉语词法分析系统.该系统采用了多种语言模型,有针对性地处理词法分析所面临的各个问题.其中分词系统参加了2005年第二届国际汉语分词评测,在微软亚洲研究院、北京大学语料库开放测试中,分别获得F量度为97.2%与96.7%.而在北京大学标注的《人民日报》语料库的开放评测中,词性标注获得96.1%的精确率,命名实体识别获得的F量度值为88.6%. 关键词词法分析;汉语分词;词性标注;命名实体识别;语言模型 中图法分类号TP391 ResearchonChineseLexicalAnalysisSystemby FusingMultipleKnowledgeSources JIANGWeiWANGXiao—LongGUANYiZHAOJian (Sc^oozo,Com户“ferSciPncBn咒d:I。≥c^720fogy,Har6f雄j知s£it“抛o,T奢c^竹。zogy,H口r6in150001) AbstractChineselexicalanalysisisthefoundationtaskformostChinesenaturallanguagepro—ces8ing,Inthispaper,wordsegmentation,POStagging,namedentityrecognitionandtheirrela—tion-arewelldiscussed.IⅥoreover,apragmaticlexicalanalysissystembasedonmixedlanguagemodelsispresented,whichadoptsmanymodels,suchas以一gram,hiddenIⅥarkovmodel,maxi—mumentropymodel,supportvectormachineandconditionalrandomfields,theyhavegoodper~formanceinthespecialsub—tasks.TheWordSegmenterparticipatedintheSecondInternationalChineseWordSegmentationBakeoffin2005,andachieved97.2%and96.7%intermsofF~measureinMSRandPKUopentestrespectively.WhilethePOSta套gingandnamedentityrecog~nitionmodulesachieved96.1%inprecisionand88.6%inF—measurerespectivelyinopentestwiththecorpusthatcamefromsiX-monthcorporaofChinesePeoples’Daily. KeywordslexicalanaIysis;Chinesewordsegmentation;part—of—speechtagging;namedentityrecognition;languagemodel 引 词法分析主要包括分词、词性标注与命名实体识别三项子任务,它是句法分析与语义分析的基础,其性能将直接影响到后续应用,如机器翻译、信息抽取、问答系统的性能.本文以国家自然科学基金重点项目“问答式信息检索的理论与方法”为背景,全面 收稿日期:2005—11一15;修改稿收到日期:2006一06一06.本课题得到国家自然科学基金重点项目“问答式信息检索的理论与方法”(60435020)及国家自然科学基金(60504021)资助.姜维,男,1978年生,博士研究生,研究方向为自然语言处理、词法分析、信息抽取.Bmail:jwSeaBreeze@hit.edu.cn.王晓龙,男,1955年生,教授,博士生导师,主要研究领域为人工智能、自然语言处理.关毅,男,1970年生,博士,副教授,研究方向为问答系统、web挖掘.赵健,男,1975年生,博士,研究方向为中文命名实体识别、信息抽取.吉目 万方数据

昆明理工大学信息工程与自动化学院学生实验报告 (2012 —2013 学年第 1 学期) 课程名称:编译原理开课实验室:信自楼44 年月日 一、实验目的及内容 设计、编制、调试一个词法分析子程序-识别单词,加深对词法分析原理的理解。 二、实验原理及基本技术路线图(方框原理图或程序流程图) 对给定的程序通过词法分析器弄够识别一个个单词符号,并以二元式(单词种别码,单词符号的属性值)显示。而本程序则是通过对给定路径的文件的分析后以单词符号和文字提示显示。 三、所用仪器、材料(设备名称、型号、规格等或使用软件) W INDOWS下的VISUAL C++6.0; 四、实验方法、步骤(或:程序代码或操作过程) #include

#define MAX 22 char ch =' '; string key[15]={"begin","end","if","then","else","while","write","read", "do", "call","const","char","until","procedure","repeat"}; int Iskey(string c){ //关键字判断 int i; for(i=0;i Weka 数据挖掘软件使用指南 1.Weka简介 该软件是WEKA的全名是怀卡托智能分析环境(Waikato Environment for Knowledge Analysis),它的源代码可通过https://www.doczj.com/doc/d95956288.html,/ml/weka得到。Weka作为一个公开的数据挖掘工作平台,集合了大量能承担数据挖掘任务的机器学习算法,包括对数据进行预处理,分类,回归、聚类、关联规则以及在新的交互式界面上的可视化。如果想自己实现数据挖掘算法的话,可以看一看Weka的接口文档。在Weka中集成自己的算法甚至借鉴它的方法自己实现可视化工具并不是件很困难的事情。 2.Weka启动 打开Weka主界面后会出现一个对话框,如图: 主要使用右方的四个模块,说明如下: ?Explorer:使用Weka探索数据的环境,包括获取关联项,分类预测,聚簇等; ?Experimenter:运行算法试验、管理算法方案之间的统计检验的环境; ?KnowledgeFlow:这个环境本质上和Explorer所支持的功能是一样的,但是它有一个可以拖放的界面。它有一个优势,就是支持增量学习; ?SimpleCLI:提供了一个简单的命令行界面,从而可以在没有自带命令行的操作系统中直接执行Weka命令(某些情况下使用命令行功能更好一些)。 3.主要操作说明 点击进入Explorer模块开始数据探索环境。 3.1主界面 进入Explorer模式后的主界面如下: 3.1.1标签栏 主界面最左上角(标题栏下方)的是标签栏,分为五个部分,功能依次是: ?Preprocess(数据预处理):选择和修改要处理的数据; ?Classify(分类):训练和测试关于分类或回归的学习方案; ?Cluster(聚类):从数据中学习聚类; ?Associate(关联):从数据中学习关联规则; ?Select attributes(属性选择):选择数据中最相关的属性; ?Visualize(可视化):查看数据的交互式二维图像。 3.1.2载入、编辑数据 标签栏下方是载入数据栏,功能如下: ?Open file:打开一个对话框,允许你浏览本地文件系统上的数据文件(.dat); ?Open URL:请求一个存有数据的URL 地址; ?Open DB:从数据库中读取数据; ?Generate:从一些数据生成器中生成人造数据。 3.1.3其他界面说明 接下来的主界面中依次是Filter(筛选器),Currtent relation(当前关系)、Attributes(属性信息)、Selected attribute(选中的属性信息)以及Class(类信息),分别介绍如下: ?Filter 在预处理阶段,可以定义筛选器来以各种方式对数据进行变换。Filter 一栏用于对各种筛选器进行必要设置。Filter一栏的左边是一个Choose 按钮。点击这个按钮就可选择Weka中的某个筛选器。用鼠标左键点击这个choose左边的显示框,将出现GenericObjectEditor对话框。用鼠标右键点击将出现一个菜单,你可从中选择,要么在GenericObjectEditor对话框中显示相关属性,要么将当前的设置字符复制到剪贴板。 ?Currtent relation 显示当前打开的数据文件的基本信息:Relation(关系名),Instances(实例数)以及Attributes (属性个数)。 为保证校对工作的有序进行,减少出版印刷错误,提高校对质量,应从以下几个方面把握:―、明确校对目的 校对是保证学报质量的重要环节,是对编辑工作的继续和补充。校对必须高度负责,认 真细致,树立严谨周密,一丝不苟的作风。 1.根据原稿,核对并清除校样上的差错。 2?改正在政治思想上和科学性上遗留的不准确的提法和词句。 3?清除语法修辞上遗留的差错和毛病。 4 ?清除错别字。 5.解决和消除任何疑点。 二、把握校对标准 1 ?编辑负责校对、印刷工作的组织和实施,及时送取稿件和校样,做好与印刷厂的业 务联系。 2 ?校对以原稿为准,不得在校样上随意增补、删减,发现原稿错误及编辑处理的疏漏 和失误做出标示,由编辑对原稿、校样予以处理。若作者提出修改时,要尽量坚持不动版面、不动字数的原则,减少改版的麻烦。 3 ?准确使用校对符号,消灭错字,补齐遗漏,纠正版式错误,严格执行三校加点校制 度,保证期刊质量。 4-校对以对校、折校为主,根据实际情况,部分稿件由作者校对一次,校后由编辑对 格式、质量复校一次。 5 ?校对时要注意版面的规范、美观,排版的合理。校对差错率要保持在万分之二以下。 三、遵循校对的程序,交叉三校制 1.—校(作者、责任编辑各校一次):侧重对原稿校对,力求校样与原稿的一致,纠 正版式错误,对有疑问处作出标示。校后通读一遍。要求作者不能对原稿作大的改动。 2 ?二校(责任编辑、执行编辑各校一次):校对时要确定一校校出错误已改正,纠正版式错误,并对文稿中的疑问予以处理,填补遗缺,统一体例。 3 ?三校(执行编辑校一次):校对时要确定二校校出错误已改正,对校样进行综合检查,清理差错,确定版面格式。 4 .点校:对三校校出错误予以核对,并对文章、版式作最后通校,确保清样无差错。 5 .校对签名。校对者应在每次校样上签名,并标明校次,以防差错。 6 ?责任编辑甩开原稿和三校样,对清样进行阅读,寻找差错。在读样后,进行总体扫描,检查有无错字、漏字、表格与插图是否合乎规范,字体、字号使用是否正确等。 四、明确校对内容 1 ?检查多、漏、错文字及标点、符号错误;核对标题、署名,文中人名、地名、数字、公式。 2 ?检查版面、格式,图表位置及表题、图题,字体、字号、字距和行距。 3 .检查标题位置、层次及转行,注释、参考文献及序号,核对中英文目录及页码与文章的一致。 4 ?检查目录及对应的页码、刊眉、页码顺序、版权,封面、封二、封三、封底的文字、刊号、年月期号。 中文语法的基本知识 一.语素和语素分类: 语素是最小的语音语义结合体,是最小的语言单位。语素按音节分类可以分成: ①单音节语素:如土、人、水、风、子、民、大、海等。 ②双音节语素,组成该语素的两个音节合起来才有意思,分开来没有与该语素有关的意义,双音节语素主要包括联绵字、外来词和专用名词。 A.双声,声母相同的联绵字:如琵琶、乒乓、湃、鞑靼、尴尬、荆棘、蜘蛛、踯躅、踌躇、仿佛、瓜葛、忐忑、淘汰、饕餮、倜傥、含糊、慷慨、叮当、蹊跷、玲珑、犹豫等。 B.叠韵,韵母相同的联绵字:如从容、葱茏、葫芦、糊涂、匍匐、灿烂、蜿蜒、苍茫、朦胧、苍莽、邋遢、罗嗦、怂恿、螳螂、桫椤、倥侗、蜻蜓、轰隆、当啷、惝恍、魍魉、缥缈、飘渺、耷拉等。 C.非双声叠韵联绵字:如蜈蚣、蓊郁、珊瑚、疙瘩、蚯蚓、惺忪、铃铛、奚落、褡裢、茉莉、蚂螂、窟窿、伉俪、蝴蝶、笊篱、蹦达、蟪蛄、狡狯、狡猾、蛤蚧、蛤蜊、牡丹、磅礴、提溜等。 D.外来词,由汉语以外的其他语种音译过来的词语。如干部、涤纶、甲克(夹克)、的士、巴士、尼龙、吉普、坦克、芭蕾、哒爹等。 E.专用名词,主要是地名、人和事物名称。如纽约、巴黎、北京、苏轼、李白、孔子、萝卜、菠菜、番茄、红薯等。 ③多音节语素,主要是拟声词、专用名词和音译外来词。如:喜马拉雅、珠穆朗玛、安迪斯、法兰克福、奥林匹克、白兰地、凡士林、噼里啪啦、淅淅沥沥、马克思主义、中华人民共和国 词 二.词和词的分类。 词是由语素组成的最小的造句单位。 (“单位”是名词类。) 从构成方式来看,可以分成: ①单纯词:由一个语素组成的词,自由的单音节语素和所有的双音节、多音节语素都可以组成单纯词。如:山、水、天、地、人、有、土、红、凑;仿佛、苍茫、蜈蚣、琉璃、参差、蹉跎;敌敌畏、阿司匹林、萨克斯、麦克风等。 ②合成词:由两个或两个以上的语素组成的词。 词法分析器实验报告 词法分析器设计 一、实验目的: 对C语言的一个子集设计并实现一个简单的词法分析器,掌握利用状 态转换图设计词法分析器的基本方法。利用该词法分析器完成对源程 序字符串的词法分析。输出形式是源程序的单词符号二元式的代码, 并保存到文件中。 二、实验内容: 1. 设计原理 词法分析的任务:从左至右逐个字符地对源程序进行扫描,产生一个个单词符号。 理论基础:有限自动机、正规文法、正规式 词法分析器(Lexical Analyzer) 又称扫描器(Scanner):执行词法分析的程序 2. 词法分析器的功能和输出形式 功能:输入源程序、输出单词符号 程序语言的单词符号一般分为以下五种:关键字、标识符、常数、运算符,界符 3. 输出的单词符号的表示形式: 单词种别用整数编码,关键字一字一种,标识符统归为一种,常数一种,各种符号各一种。 4. 词法分析器的结构 单词符号 5. 状态转换图实现 三、程序设计 1.总体模块设计 /*用来存储目标文件名*/ string file_name; /*提取文本文件中的信息。*/ string GetText(); /*获得一个单词符号,从位置i开始查找。并且有一个引用参数j,用来返回这个单词最后一个字符在str的位置。*/ string GetWord(string str,int i,int& j); /*这个函数用来除去字符串中连续的空格和换行 int DeleteNull(string str,int i); /*判断i当前所指的字符是否为一个分界符,是的话返回真,反之假*/ bool IsBoundary(string str,int i); /*判断i当前所指的字符是否为一个运算符,是的话返回真,反之假*/ bool IsOperation(string str,int i); WEKA汉化教程 图1 这里我们要介绍一下WEKA中的术语。表格里的一个横行称作一个实例(Instance),相当于统计学中的一个样本,或者数据库中的一条记录。竖行称作一个属性(Attrbute),相当于统计学中的一个变量,或者数据库中的一个字段。这样一个表格,或者叫数据集,在WEKA看来,呈现了属性之间的一种关系(Relation)。图1中一共有14个实例,5个属性,关系名称为“weather”。 WEKA存储数据的格式是ARFF(Attribute-Relation File Format)文件,这是一种ASCII文本文件。图1所示的二维表格存储在如下的ARFF文件中。这也就是WEKA自带的“weather.arff”文件,在WEKA安装目录的“data”子目录下可以找到。 代码: % ARFF file for the weather data with some numric features % @relation weather @attribute outlook {sunny, overcast, rainy} @attribute temperature real @attribute humidity real @attribute windy {TRUE, FALSE} @attribute play {yes, no} @data % % 14 instances % sunny,85,85,FALSE,no sunny,80,90,TRUE,no overcast,83,86,FALSE,yes rainy,70,96,FALSE,yes rainy,68,80,FALSE,yes rainy,65,70,TRUE,no overcast,64,65,TRUE,yes sunny,72,95,FALSE,no sunny,69,70,FALSE,yes rainy,75,80,FALSE,yes sunny,75,70,TRUE,yes overcast,72,90,TRUE,yes overcast,81,75,FALSE,yes rainy,71,91,TRUE,no 1中文文本预处理 1.1分词软件调用(中科院分词系统) 1.1.1软件下载:https://www.doczj.com/doc/d95956288.html,/ 1.1.2软件包目录&介绍 | Readme.txt-------------------------->介绍 | +---bin | +---DocExtractor----------->文档篇章语义抽取系统 | | DocExtractor.bat-->批处理,可以针对指定的文件夹进行语义抽取 | | DocExtractor.dll-->支撑的动态链接库,基于分词基础上 | | DocExtractorSample.exe-->应用程序 | | | \---ICTCLAS2015----------->分词系统 | ICTCLAS-tools.exe-->分词的支撑工具,可用于测试,本处主要用来做用户词典导入 | importuserdict.bat-->可将用户词典自动导入到系统内 | NLPIR.dll-->Win32下的支撑动态链接库,其他环境的库,可以访问lib对应环境的库文件 | NLPIR.lib | NLPIR_WinDemo.exe-->Win32下的演示程序,在Win8 32位下编译而成,部分环境可能不支持,或者显示异常 | userdic.txt-->用户词典,用户可以自行编辑 | +---Data-->系统核心词库 | \---English-->英文处理的支持知识库,如果不需要英文处理的功能,可以不加载本库。 | +---doc-->相关文档支持 | ICTPOS3.0.doc-->我们的词性标注集说明 | NLPIR-ICTCLAS2015分词系统开发手册.pdf-->开发使用手册 | +---include-->系统头文件 | NLPIR.h | +---lib-->不同环境下的支撑库,每一种库,同时支持C/C++/C#/Java库。其他小众化的环境支持,请联系我们 | +---linux32-->Linux 32bit操作系统下的支持库 | | libNLPIR.so | | | +---linux64-->Linux 64bit操作系统下的支持库 | | libNLPIR.so | | Readme.txt | | 汉语语法基础知识 词类和词性 (一)知识概述 词类是指词在语法上的分类,也就是把汉语里的所有词,根据它们的词汇意义和语法特点进行分类,这样得出的结果就是词类。现代汉语教学系统把词分为十二类: 实词可以分为: 1、名词:表示人或事物名称的词叫名词。 (1)表示人:老师、学生、作家、工人、鲁迅 (2)具体事物:天、地、花、草、天空、海洋 (3)抽象概念:方法、科学、法律、事业 (4)处所:北京、青岛、黄河、长江、三味书屋 (5)方位:东、西、南、北、上、下、前、后、左、右、里、外、内、中、间、旁、以前、以南、之下、之后、东边、西面、里头。 (6)时间:早晨、正午、晚上、半夜、上午、白天、夏天、立秋、今天、星期二 2、动词:表示动作行为、发展变化、心理活动等意义的词叫动词。 (1) 动作行为:穿、跳、走、纪念、朗诵。 (2) 存在变化:有、增加、缩小、扩大、发生。 (3) 心理活动:想、懊悔、喜欢、担心。 (4) 可能意愿:应该、应当、能够、愿意、必须、敢、肯、会、能、要、可以。 (5) 趋向:上、下、来、去、上去、下去、进来、进去、起来、上来。 (6) 判断:是、就是、正是 (7) 使令:使、让、派、请、叫、要求、命令、推举、允许、鼓动、鼓励。 3、形容词:表示事物的形状、性质或状态的词叫形容词。 (1)形状:大、小、高、圆、长、短、高大、肥胖。 (2)性质:好、坏、镇定、勇敢、乐观、伟大、优秀 (3)状态:愉快、慌张、急躁、迅速、朦胧、桔红 4、数词:表示数目的词叫数词。 (1)基数(确数)一、二、千、万、亿 (2)序数:第一、三叔、三年级、六楼、初五、老三。 (3)分数:三分之一、九成 (4)倍数:三倍、十倍、翻一番 (5)概数:十几概数、十余人、三十多岁、两三个、成千上万、很多人 5、量词:表示事物单位或行为、动作单位的词叫量词。 无量(表示人或事物单位的词) (1)个体:个、位、尺、只、台、条 (2)集体:批、帮、群、套、双、副、对、类 (3)不定量:些、点 (4)度量衡:丈、尺、里、亩 动量(表示动作行为的单位)次、回、下、趟、遍、阵、场、遭、焉 动量词也可以借用跟动作有关的事物的名词。如:画一笔、切一刀、工作一星期、学习一下午、踢一脚、送一车 说明:在现代汉语中,数词本身只表示抽象的数的概念,在计算事物或动作的数量时,数词的后面必须加上量词。数词跟量词连用就是数量词。 6、代词:具有指示、代替作用的词叫代词。代词可分为人称代词、指示代词、疑问代词。 ⑴人称代词:代替人或事物的名称的代词。 理工大学信息工程与自动化学院学生实验报告 (2012 —2013学年第一学期) 一、实验目的及容 编译技术是理论与实践并重的课程,而其实验课要综合运用所学的多门课程的容,用来完成一个小型编译程序。从而巩固和加强对词法分析、语法分析、语义分析、代码生成和报错处理等理论的认识和理解;培养学生对完整系统的独立分析和设计的能力,进一步培养学生的独立编程能力。 调试并完成一个词法分析程序,加深对词法分析原理的理解。 二、实验原理及基本技术路线图(框原理图或程序流程图) 1、待分析的简单语言的词法 (1)关键字: begin if then while do end 所有关键字都是小写。 (2)运算符和界符: := + –* / < <= <> > >= = ; ( ) # (3)其他单词是标识符(ID)和整型常数(NUM),通过以下正规式定义:ID=letter(letter| digit)* NUM=digit digit * (4)空格由空白、制表符和换行符组成。空格一般用来分隔ID、NUM,运算符、界符和关键字,词法分析阶段通常被忽略。 2、各种单词符号对应的种别码 3、词法分析程序的功能 输入:所给文法的源程序字符串。 输出:二元组(syn,token或sum)构成的序列。 其中:syn为单词种别码; token为存放的单词自身字符串; sum为整型常数。 二、所用仪器、材料(设备名称、型号、规格等或使用软件) 1台PC以及VISUAL C++6.0软件。 三、实验法、步骤(或:程序代码或操作过程) (1)程序代码: #include WEKA入门教程 2007-04-26 16:40 1. 简介 WEKA的全名是怀卡托智能分析环境(Waikato Environment for Knowledge Analysis),它的源代码可通过https://www.doczj.com/doc/d95956288.html,/ml/weka得到。同时weka也是新西兰的一种鸟名,而WEKA的主要开发者来自新西兰。 WEKA作为一个公开的数据挖掘工作平台,集合了大量能承担数据挖掘任务的机器学习算法,包括对数据进行预处理,分类,回归、聚类、关联规则以及在新的交互式界面上的可视化。 如果想自己实现数据挖掘算法的话,可以看一看weka的接口文档。在weka中集成自己的算法甚至借鉴它的方法自己实现可视化工具并不是件很困难的事情。 2005年8月,在第11届ACM SIGKDD国际会议上,怀卡托大学的Weka小组荣获了数据挖掘和知识探索领域的最高服务奖,Weka系统得到了广泛的认可,被誉为数据挖掘和机器学习历史上的里程碑,是现今最完备的数据挖掘工具之一(已有11年的发展历史)。Weka的每月下载次数已超过万次。 --整理自https://www.doczj.com/doc/d95956288.html,/computers/common/info.asp?id=29304 2. 数据格式 巧妇难为无米之炊。首先我们来看看WEKA所用的数据应是什么样的格式。 跟很多电子表格或数据分析软件一样,WEKA所处理的数据集是图1那样的一个二维的表格。 图1 新窗口打开 这里我们要介绍一下WEKA中的术语。表格里的一个横行称作一个实例(Instance),相当于统计学中的一个样本,或者数据库中的一条记录。竖行称作一个属性(Attrbute),相当于统计学中的一个变量,或者数据库中的一个字段。这样一个表格,或者叫数据集,在WEKA看来,呈现了属性之间的一种关系(Relation)。图1中一共有14个实例,5个属性,关系名称为“weather”。 WEKA存储数据的格式是ARFF(Attribute-Relation File Format)文件,这是一种ASCII文本文件。图1所示的二维表格存储在如下的ARFF文件中。这也就是WEKA自带的“weather.arff”文件,在WEKA安装目录的“data”子目录下可以找到。 代码: % ARFF file for the weather data with some numric features % @relation weather @attribute outlook {sunny, overcast, rainy} @attribute temperature real @attribute humidity real @attribute windy {TRUE, FALSE} @attribute play {yes, no} @data % % 14 instances % sunny,85,85,FALSE,no sunny,80,90,TRUE,no overcast,83,86,FALSE,yes rainy,70,96,FALSE,yes rainy,68,80,FALSE,yes rainy,65,70,TRUE,no overcast,64,65,TRUE,yes sunny,72,95,FALSE,no sunny,69,70,FALSE,yes rainy,75,80,FALSE,yes sunny,75,70,TRUE,yes overcast,72,90,TRUE,yes overcast,81,75,FALSE,yesWeka_数据挖掘软件使用指南

如何做好文字校对工作

中文语法的基本知识

词法分析器实验报告

2020年整理WEKA汉化教程.pdf

中文文本预处理

(完整版)汉语语法基础知识

编译原理实验报告一 简单样本语言的词法分析器

WEKA入门教程