MapReduce教程

- 格式:doc

- 大小:348.00 KB

- 文档页数:40

简述mapreduce的shuffle过程。

MapReduce是一种用于处理大规模数据的并行计算模型,其核心思想是将任务分为两个阶段:Map阶段和Reduce阶段。

在Map阶段,数据被划分为多个独立的片段,每个Map任务对每个数据片段进行处理并生成若干键值对。

而在Reduce阶段,输入键值对按照键的哈希值被分配给特定的Reduce任务进行处理。

而在MapReduce的过程中,Shuffle过程是连接Map阶段和Reduce 阶段的重要步骤。

Shuffle过程主要负责将Map任务生成的中间键值对按照键重新分发给特定的Reduce任务,以便进行后续的处理。

Shuffle过程涉及到三个主要的操作:分区(Partitioning),排序(Sorting)和合并(Merging)。

首先,分区操作用于确定每个中间键值对应该被发送给哪个Reduce 任务。

通常情况下,分区操作会根据中间键的哈希值和Reduce任务的数量进行计算,以确保相同键的键值对被发送到同一个Reduce任务。

这个过程可以保证相同键的键值对在Reduce阶段被正确地聚合和处理。

其次,排序操作用于对每个分区中的键值对进行排序。

这是为了确保Reduce任务能够按照键的顺序进行处理,从而方便后续的聚合操作。

排序可以提高Reduce任务的处理效率,因为相同键的键值对会被连续地处理,减少了数据的读取和写入操作。

最后,合并操作用于将排序后的键值对进行合并,以减少数据的传输量和磁盘IO。

合并操作会将具有相同键的键值对进行合并,生成更少的键值对。

这样可以减少Reduce任务之间的数据传输量,并提高整个MapReduce过程的效率。

总的来说,Shuffle过程在MapReduce中起到了连接Map阶段和Reduce阶段的桥梁作用。

通过分区、排序和合并操作,Shuffle过程可以确保中间键值对被正确地分发给特定的Reduce任务,并按照键的顺序进行处理,从而提高整个MapReduce过程的效率。

简述mapreduce的工作原理

MapReduce是一种分布式计算模型,它的工作原理如下:

1. 将大规模数据集分成若干个小数据片段。

2. 将每个小数据片段传给不同的计算节点。

3. 计算节点使用Map函数对每个小数据片段进行处理,将每个

数据片段转换成多个键值对。

4. 将输出的键值对按照键进行排序,以便于后续的Reduce操作。

5. 将排序后的键值对传给不同的计算节点。

6. 计算节点使用Reduce函数对每个键值对进行处理,将相同键的所有值合并在一起。

7. 最终输出Reduce函数的结果。

MapReduce的工作原理是基于分布式计算的思想,它将大规模数据集分成若干个小数据片段,通过Map和Reduce函数分别对每个数

据片段进行处理,最终将所有处理结果合并起来得到最终结果。

这种计算模型具有高可扩展性和高效性,可以在大规模数据处理方面发挥重要作用。

- 1 -。

dolphinscheduler mapreducer任务主程序参数和选项参数-回复DolphinScheduler是一个开源的分布式任务调度系统,用于实现大规模数据处理和分析。

其中,mapreducer任务是其中非常重要的一种任务类型。

在使用DolphinScheduler的mapreducer任务时,我们可以通过主程序参数和选项参数来进行配置和设置。

本文将介绍mapreducer任务的主程序参数和选项参数,并逐步解释其使用方法和作用。

首先,我们来了解一下mapreducer任务的基本概念。

MapReduce是一种用于大规模数据集上的并行处理编程模型,它通过将任务分解成Map 和Reduce两个阶段来实现并行计算。

在DolphinScheduler中,mapreducer任务可以通过配置主程序参数和选项参数来指定Map和Reduce的具体实现方式和参数配置。

一、主程序参数1. 地址参数(address):用于指定执行mapreducer任务的地址,可以是任意有效的网络地址,例如IP地址或域名。

2. 输入路径参数(input):用于指定输入数据的路径,可以是本地文件路径或Hadoop分布式文件系统(HDFS)路径。

3. 输出路径参数(output):用于指定输出结果的路径,可以是本地文件路径或HDFS路径。

4. Map类参数(mapper):用于指定Map类的名称,该类负责数据的切分和映射。

5. Reduce类参数(reducer):用于指定Reduce类的名称,该类负责数据的合并和计算。

6. 输入格式参数(inputFormat):用于指定输入数据的格式,例如TextInputFormat或SequenceFileInputFormat。

7. 输出格式参数(outputFormat):用于指定输出结果的格式,例如TextOutputFormat或SequenceFileOutputFormat。

分布式数据处理技术mapreduce名词解释MapReduce是一种分布式数据处理技术,它可以用于处理大规模数据集。

下面是对MapReduce相关名词的解释:1. Map阶段:Map阶段是MapReduce的第一个阶段,它将输入数据分割成小块,并将每个小块交给Map函数进行处理。

Map函数将每个小块转换为一系列键值对,其中键表示数据的某个属性,值表示该属性的值。

2. Reduce阶段:Reduce阶段是MapReduce的第二个阶段,它将Map阶段输出的键值对进行合并和排序,并将相同键的值合并成一个列表。

Reduce函数接收每个键和其对应的值列表,并将它们转换为输出键值对。

3. 分布式文件系统:分布式文件系统是一种可以在多台计算机上存储和访问文件的文件系统。

MapReduce使用分布式文件系统来存储输入数据和输出结果。

4. Hadoop:Hadoop是一个开源的分布式计算框架,它实现了MapReduce算法和分布式文件系统。

Hadoop可以在大规模集群上运行,处理PB级别的数据。

5. YARN:YARN是Hadoop的资源管理器,它负责管理集群中的资源,并将它们分配给不同的应用程序。

YARN可以同时支持MapReduce和其他分布式计算框架。

6. Shuffle阶段:Shuffle阶段是MapReduce的一个重要阶段,它将Map阶段输出的键值对按照键进行分组,并将相同键的值发送到同一个Reduce任务中进行处理。

7. Combiner函数:Combiner函数是一个可选的函数,它可以在Map阶段输出的键值对进行本地合并,减少数据传输量和网络带宽的消耗。

8. Partitioner函数:Partitioner函数是一个可选的函数,它可以将Map阶段输出的键值对按照键进行分区,将相同键的值发送到同一个Reduce任务中进行处理。

9. JobTracker:JobTracker是Hadoop中的一个组件,它负责管理MapReduce任务的执行。

阐述mapreduce的map函数输入输出格式MapReduce 是一种编程模型,用于处理和生成大数据集。

在 MapReduce 中,数据集被分成小块,然后由多个 map 任务并行处理。

这些 map 任务的输出再经过 shuffle 和 sort,然后由 reduce 任务处理。

MapReduce 的 Map 函数的输入和输出格式如下:

1. 输入格式:

Map 函数的输入通常是一个键值对(key-value)的集合。

键和值可以是任何数据类型,但最常见的是字符串。

例如,一个简单的 MapReduce 任务可能处理文本文件,其中每行都是一个值,整行的内容作为键。

2. 输出格式:

Map 函数的输出也是键值对(key-value)的集合。

这些键值对会被排序和分区,然后传递给 Reduce 函数。

Map 函数输出的键值对的键会被用作Reduce 函数的输入键。

例如,考虑一个简单的单词计数任务。

Map 函数的输入可能是一个句子(作为键)和文本文件中的行(作为值)。

Map 函数的输出可能是每个单词(作为键)和该单词的出现次数(作为值)。

在 MapReduce 的执行过程中,Map 函数的输出会经过 shuffle 和 sort 阶段,以便相同的键值对能够被聚集在一起并传递给相应的 Reduce 任务。

Hadoop MapReduce简介本节首先简单介绍大数据批处理概念,然后介绍典型的批处理模式MapReduce,最后对Map 函数和Reduce 函数进行描述。

批处理模式批处理模式是一种最早进行大规模数据处理的模式。

批处理主要操作大规模静态数据集,并在整体数据处理完毕后返回结果。

批处理非常适合需要访问整个数据集合才能完成的计算工作。

例如,在计算总数和平均数时,必须将数据集作为一个整体加以处理,而不能将其视作多条记录的集合。

这些操作要求在计算进行过程中数据维持自己的状态。

需要处理大量数据的任务通常最适合用批处理模式进行处理,批处理系统在设计过程中就充分考虑了数据的量,可提供充足的处理资源。

由于批处理在应对大量持久数据方面的表现极为出色,因此经常被用于对历史数据进行分析。

为了提高处理效率,对大规模数据集进行批处理需要借助分布式并行程序。

传统的程序基本是以单指令、单数据流的方式按顺序执行的。

这种程序开发起来比较简单,符合人们的思维习惯,但是性能会受到单台计算机的性能的限制,很难在给定的时间内完成任务。

而分布式并行程序运行在大量计算机组成的集群上,可以同时利用多台计算机并发完成同一个数据处理任务,提高了处理效率,同时,可以通过增加新的计算机扩充集群的计算能力。

Google 最先实现了分布式并行处理模式MapReduce,并于2004 年以论文的方式对外公布了其工作原理,Hadoop MapReduce 是它的开源实现。

Hadoop MapReduce 运行在HDFS 上。

MapReduce 简释如图1 所示,如果我们想知道相当厚的一摞牌中有多少张红桃,最直观的方式就是一张张检查这些牌,并且数出有多少张是红桃。

这种方法的缺陷是速度太慢,特别是在牌的数量特别高的情况下,获取结果的时间会很长。

图1 找出有多少张红桃MapReduce 方法的规则如下。

∙把这摞牌分配给在座的所有玩家。

∙让每个玩家数自己手中的牌中有几张是红桃,然后把这个数目汇报上来。

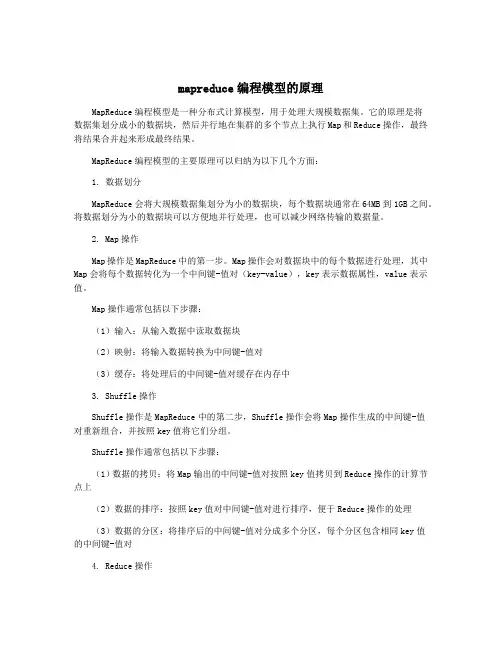

mapreduce编程模型的原理MapReduce编程模型是一种分布式计算模型,用于处理大规模数据集。

它的原理是将数据集划分成小的数据块,然后并行地在集群的多个节点上执行Map和Reduce操作,最终将结果合并起来形成最终结果。

MapReduce编程模型的主要原理可以归纳为以下几个方面:1. 数据划分MapReduce会将大规模数据集划分为小的数据块,每个数据块通常在64MB到1GB之间。

将数据划分为小的数据块可以方便地并行处理,也可以减少网络传输的数据量。

2. Map操作Map操作是MapReduce中的第一步。

Map操作会对数据块中的每个数据进行处理,其中Map会将每个数据转化为一个中间键-值对(key-value),key表示数据属性,value表示值。

Map操作通常包括以下步骤:(1)输入:从输入数据中读取数据块(2)映射:将输入数据转换为中间键-值对(3)缓存:将处理后的中间键-值对缓存在内存中3. Shuffle操作Shuffle操作是MapReduce中的第二步,Shuffle操作会将Map操作生成的中间键-值对重新组合,并按照key值将它们分组。

Shuffle操作通常包括以下步骤:(1)数据的拷贝:将Map输出的中间键-值对按照key值拷贝到Reduce操作的计算节点上(2)数据的排序:按照key值对中间键-值对进行排序,便于Reduce操作的处理(3)数据的分区:将排序后的中间键-值对分成多个分区,每个分区包含相同key值的中间键-值对4. Reduce操作Reduce操作是MapReduce中的第三步。

在Reduce操作中,Map操作生成的中间键-值对被分成多个分区,每个分区都包含相同key值的键值对。

在Reduce操作中,对每个分区中的中间键-值对进行处理,并生成一个输出结果。

Reduce操作通常包括以下步骤:(1)输入:从Map操作的输出获取中间键-值对分组信息(2)缓存:将Map操作输出的中间键-值对缓存到内存中(3)分组:将缓存中的中间键-值对按照key值分组(4)Reduce:对每个分组中的中间键-值对进行Reduce操作,并将结果输出5. 在Master节点上进行控制和协调MapReduce编程模型中,由Master节点来进行任务的分配、管理和协调。

《大数据技术基础》

实验7 MapReduce编程初级实践

1.实验目的

1.通过实验掌握基本的MapReduce编程方法;

2.掌握用MapReduce解决一些常见的数据处理问题,包括数据统计、求最值及排序等。

2.实验平台

已经配置完成的Hadoop伪分布式环境。

3.实验内容和要求

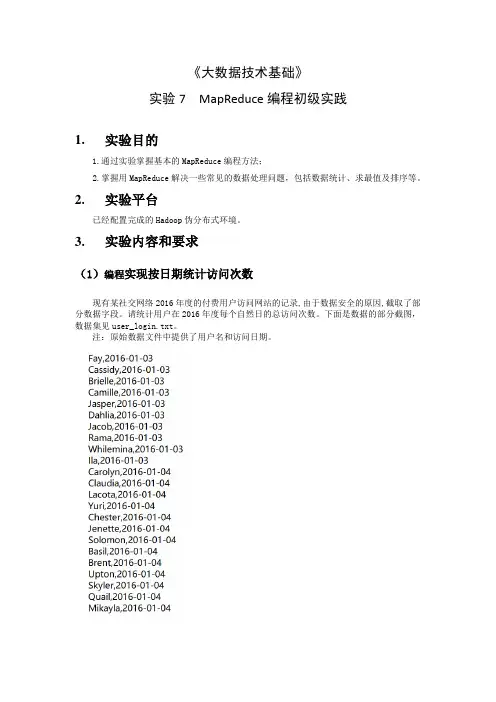

(1)编程实现按日期统计访问次数

现有某社交网络2016年度的付费用户访问网站的记录,由于数据安全的原因,截取了部分数据字段。

请统计用户在2016年度每个自然日的总访问次数。

下面是数据的部分截图,数据集见user_login.txt。

注:原始数据文件中提供了用户名和访问日期。

(2)编写程序实现按访问次数排序

在(1)的基础上,要对数据按访问次数进行排序。

并将排序后的结果存储在HDFS目录的/user/hadoop/TimeSort中。

4.实验报告。

![动态计数器_MapReduce 2.0源码分析与编程实战_[共2页]](https://uimg.taocdn.com/46094ffae2bd960591c677b9.webp)

第8章 MapReduce 相关特性详解184 if(key.toString().equals("hello")){ //判断计数条件 context.setStatus("BadKey is coming!"); //写入Reduce 状态context.getCounter(ReportTest.ReduceReport).increment(1); //计数增加 }context.write(key, new IntWritable(sum));};}}从以上程序的黑体部分中可以看到,使用了大量的关键字进行计数器的设置,因此可以通过触发条件对计数值进行增加。

图8-4展示了最终结果。

图8-4 程序8-1运行结果计数器视图最上面部分是设置的计数器计数,根据获取条件产生了若干个计数器对结果进行输出。

8.1.3 动态计数器对于设定的计数器,可以通过在初始处设置枚举,使得计数器能够引用枚举中的类型,从而提供计数的功能。

小提示:有些时候,某些问题的产生并不适合在枚举处提供,例如一些产生的错误并不能在一开始定义,因此需要一个动态定义计数器的方法对数据进行定义。

除了前面所述的使用getCounter 方法获取枚举中值的方式外,Context 类中还有一个重载的方法能够对当前计数器进行动态定义,其源码如下所示:public Counter getCounter(String groupName, String counterName) { return reporter.getCounter(groupName, counterName);}此方法通过重新动态定义计数器实现对信息的动态捕获。

代码如程序8-2所示。

MapReduce名词解释

MapReduce是一种用于并行处理大规模数据的编程模型和算法。

它采用了分布式计算的思想,将数据分成若干个小块,然后分配给不同的计算节点进行处理。

MapReduce包括两个主要阶段:Map(映射)和Reduce(归约)。

在Map阶段,输入的数据会被拆分成一个个的键值对,并由多个Map任务并行处理。

每个Map任务会对输入的键值对进行处理,并生成中间结果。

在Reduce阶段,相同键的中间结果会被分组到同一个Reduce任务,并按照一定的规则进行处理和合并。

最终,Reduce任务会输出最终结果。

例如,统计一篇文档中每个单词的出现次数,就可以使用MapReduce来实现。

MapReduce的优点包括:

•可扩展性强:能够处理大规模数据集,并充分利用分布式计算的优势。

•容错性好:蜗牛节点的存在,即使有计算节点发生故障,整个任务也不会失败。

•简化并行计算:开发者只需要关注数据的映射和归约逻辑,而不用担心细节。

MapReduce的应用场景包括:

•大规模数据处理和分析

•搜索引擎索引构建

•推荐系统

•日志分析

•图计算等。

北京尚学堂提供Hadoop从这里开始!和我一起学习下使用Hadoop的基本知识,下文将以Hadoop Tutorial为主体带大家走一遍如何使用Hadoop分析数据!这个专题将描述用户在使用Hadoop MapReduce(下文缩写成MR)框架过程中面对的最重要的东西。

Mapreduce由client APIs和运行时(runtime)环境组成。

其中client APIs用来编写MR程序,运行时环境提供MR运行的环境。

API有2个版本,也就是我们通常说的老api和新api。

运行时有两个版本:MRv1和MRv2。

该教程将会基于老api和MRv1。

其中:老api在org.apache.hadoop.mapred包中,新api在 org.apache.hadoop.mapreduce中。

前提首先请确认已经正确安装、配置了CDH,并且正常运行。

MR概览Hadoop MapReduce 是一个开源的计算框架,运行在其上的应用通常可在拥有几千个节点的集群上并行处理海量数据(可以使P级的数据集)。

MR作业通常将数据集切分为独立的chunk,这些chunk以并行的方式被map tasks处理。

MR框架对map的输出进行排序,然后将这些输出作为输入给reduce tasks处理。

典型的方式是作业的输入和最终输出都存储在分布式文件系统(HDFS)上。

通常部署时计算节点也是存储节点,MR框架和HDFS运行在同一个集群上。

这样的配置允许框架在集群的节点上有效的调度任务,当然待分析的数据已经在集群上存在,这也导致了集群内部会产生高聚合带宽现象(通常我们在集群规划部署时就需要注意这样一个特点)。

MapReduce框架由一个Jobracker(通常简称JT)和数个TaskTracker(TT)组成(在cdh4中如果使用了Jobtracker HA特性,则会有2个Jobtracer,其中只有一个为active,另一个作为standby处于inactive状态)。

mapreduce中shuffle过程MapReduce 中的 Shuffle 过程,就像是一场数据的大冒险!你想啊,在 MapReduce 这个庞大的数据处理世界里,Shuffle 可不是个小角色。

它就像一个神奇的桥梁,连接着 Map 阶段和 Reduce 阶段。

在 Map 阶段,数据被切割、处理,就好像是把一堆杂乱无章的拼图碎片准备好。

那这些碎片怎么到 Reduce 阶段去拼成完整的图画呢?这就得靠 Shuffle 啦!Shuffle 首先要做的就是对 Map 输出的结果进行分区。

这分区就好比把不同类型的水果放进不同的篮子里。

比如说,苹果放一个篮子,香蕉放另一个篮子。

这样,相同类型的数据就能被分到一起,为后续的处理做好准备。

然后呢,Shuffle 还得对数据进行排序。

这排序可重要了,就像给一群小朋友按照身高排好队,整整齐齐的,方便管理。

经过排序的数据,在 Reduce 阶段处理起来可就轻松多啦!还有啊,Shuffle 还得负责把数据从 Map 端传输到 Reduce 端。

这传输过程就像是快递员送包裹,得保证包裹不丢失、不损坏,准时准点地送到目的地。

你说,要是 Shuffle 过程出了岔子,会怎么样?那可不得了!就好比快递员送错了包裹,或者把包裹弄丢了,整个数据处理的流程不就乱套了嘛!所以啊,Shuffle 过程可得精心设计和优化。

比如说,合理设置分区的数量,让数据分布更均匀;优化排序的算法,提高效率;加强数据传输的可靠性,确保数据的安全。

总之,Shuffle 过程在 MapReduce 中起着至关重要的作用,它就像是一个默默无闻的幕后英雄,为数据处理的顺利进行保驾护航。

咱们可不能小瞧了它!。

MapReduce编程:最⼤值、最⼩值、平均值、计数、中位数、标准差MapReduce编程最基础的范例应该就是Wordcount了,然后⼤部分就是要做⼀遍最⼤值最⼩值的计算。

课上⽼师⽤的课本是《MapReduce编程与设计模式》,⾥⾯第⼀章就介绍了Wordcount ,接下来就是最⼤值最⼩值平均值标准差,其数据来源于Stack Overflow⽹站上的评论内容,包括评论时间、评论⽤户ID,评论⽂本。

并且是以.xml⽂件形式做输⼊⽂件。

因此读⼊到mapper时需要先将xml转化为map的键值对形式。

transformXmlToMap(value.toString());以下是输⼊⽂件的形式,随便造的⼏组数据,只改动了评论时间与⽤户ID,评论⽂本内容是直接粘的。

<row Id="1" PostId="35314" Score="39" Text="not sure why this is getting downvoted -- it is correct! Double check it in your compiler if you don't believe him!" CreationDate="2018-09-06T08:07:10.730" UserId="1" /> <row Id="1" PostId="35315" Score="39" Text="not sure why this is getting downvoted -- it is correct! Double check it in your compiler if you don't believe him!" CreationDate="2007-09-06T08:05:33.730" UserId="1" /> <row Id="1" PostId="35316" Score="39" Text="not sure why this is getting downvoted -- it is correct! Double check it in your compiler if you don't believe him!" CreationDate="2008-09-06T08:07:10.730" UserId="1" /> <row Id="1" PostId="35317" Score="39" Text="not sure why this is getting downvoted -- it is correct! Double check it in your compiler if you don't believe him!" CreationDate="2008-08-06T08:07:26.730" UserId="1" /> <row Id="2" PostId="35318" Score="39" Text="not sure why this is getting downvoted -- it is correct! Double check it in your compiler if you don't believe him!" CreationDate="2008-05-06T08:11:10.730" UserId="1" /> <row Id="2" PostId="35319" Score="39" Text="not sure why this is getting downvoted -- it is correct! Double check it in your compiler if you don't believe him!" CreationDate="2008-09-06T08:12:10.730" UserId="1" /> <row Id="2" PostId="35320" Score="39" Text="not sure why this is getting downvoted -- it is correct! Double check it in your compiler if you don't believe him!" CreationDate="2008-06-06T08:03:10.730" UserId="1" /> <row Id="2" PostId="35321" Score="39" Text="not sure why this is getting downvoted -- it is correct! Double check it in your compiler if you don't believe him!" CreationDate="2008-09-06T08:07:10.880" UserId="1" /> <row Id="2" PostId="35322" Score="39" Text="not sure why this is getting downvoted -- it is correct! Double check it in your compiler if you don't believe him!" CreationDate="2016-09-06T08:07:39.730" UserId="1" /> <row Id="2" PostId="35323" Score="39" Text="not sure why this is getting downvoted -- it is correct! Double check it in your compiler if you don't believe him!" CreationDate="2008-03-06T08:07:10.730" UserId="1" /> <row Id="3" PostId="35324" Score="39" Text="not sure why this is getting downvoted -- it is correct! Double check it in your compiler if you don't believe him!" CreationDate="2007-09-06T08:00:22.730" UserId="1" />这在课本上是没有看到这个函数的内部实现的,但是仍是⼀个基本的⼯具类,可以⾃⼰实现,⽬的就是将⽂本抠出来转换成map形式存储。

mapreduce 原理MapReduce是一个分布式计算模型,旨在解决当今海量数据处理需求的问题。

由Google发明,并被广泛应用于大数据领域。

MapReduce原理涉及到两个阶段:Map和Reduce。

Map阶段是将数据分片并交给多个Map节点进行处理。

每个Map节点都将数据处理成键值对形式,并且根据初始的设定对指定的键和值进行分类。

其作用是把大量数据切割成若干小块,在分布式集群中并行运行,减少数据交换和通信的代价。

Reduce阶段是对Map节点进行的进一步操作,将Map节点输出的键值对按照特定的规则分组,然后将不同组中同一键值的数据进行合并。

Reduce过程是对中间结果的合并和汇总,将多个Map节点输出的结果合并成最终的结果。

MapReduce的原理在处理海量数据时具有很强的优势。

在Map阶段,数据被分散在集群中的多个节点上,不同节点的处理结果互不影响,处理速度快。

在Reduce阶段,数据的汇总和合并减少了数据间的传输,极大地降低了网络传输的代价。

此外,MapReduce还提供了一些高级API,可以使开发者更方便地进行数据处理。

例如,Hadoop就是一个使用MapReduce作为计算模型的分布式计算框架,提供了多个API,如HDFS、MapReduce和YARN。

总之,MapReduce的分布式计算原理为处理海量数据提供了很大的帮助。

它将数据切分成若干小块,使得不同节点可以并行处理,同时,其Reduce阶段还可以对数据进行合并和汇总。

这一特性在目前大数据处理业务中可以发挥巨大的优势,而且还可以使用MapReduce提供的API进行更加便捷的操作。

Hadoop Map/Reduce教程[一]今天浏览了下hadoop的 map/reduce文档,初步感觉这东西太牛逼了,听我在这里给你吹吹。

你可以这样理解,假设你有很多台烂机器(假设1000台)1.利用hadoop他会帮你组装成一台超级计算机(集群),你的这台计算机是超多核的(很多个CPU),一个超级大的硬盘,而且容错和写入速度都很快。

2.如果你的计算任务可以拆分,那么通过map/Reduce,他可以统一指挥你的那一帮烂机器,让一堆机器帮你一起干活(并行计算),谁干什么,负责什么,他来管理,通常处理个几T的数据,只要你有机器那就小CASE。

3.hadoop要分析的数据通常都是巨大的(T级),网络I/O开销不可忽视,但分析程序通常不会很大,所以他传递的是计算方法(程序),而不是数据文件,所以每次计算在物理上都是在相近的节点上进行(同一台机器或同局域网),大大降低的IO消耗,而且计算程序如果要经常使用的话也是可以做缓存的。

4.hadoop是一个分布式的文件系统,他就像一个管家,管理你数据的存放,在物理上较远的地方会分别存放(这样一是不同的地方读取数据都很快,也起到了异地容灾的作用),他会动态管理和调动你的数据节点,高强的容错处理,最大程度的降低数据丢失的风险。

比较著名的应用:nutch搜索引擎的蜘蛛抓取程序,数据的存储以及pageRank(网页重要程序)计算。

QQ空间的日志分析处理(PV,UV)咋样,给他吹的够牛了吧。

下面是别人翻译的官方文档,经常做日志分析处理的同学可以研究下。

目的这篇教程从用户的角度出发,全面地介绍了Hadoop Map/Reduce框架的各个方面。

先决条件请先确认Hadoop被正确安装、配置和正常运行中。

更多信息见:∙Hadoop快速入门对初次使用者。

∙Hadoop集群搭建对大规模分布式集群。

概述Hadoop Map/Reduce是一个使用简易的软件框架,基于它写出来的应用程序能够运行在由上千个商用机器组成的大型集群上,并以一种可靠容错的方式并行处理上T级别的数据集。

一个Map/Reduce 作业(job)通常会把输入的数据集切分为若干独立的数据块,由map任务(task)以完全并行的方式处理它们。

框架会对map的输出先进行排序,然后把结果输入给reduce任务。

通常作业的输入和输出都会被存储在文件系统中。

整个框架负责任务的调度和监控,以及重新执行已经失败的任务。

通常,Map/Reduce框架和分布式文件系统是运行在一组相同的节点上的,也就是说,计算节点和存储节点通常在一起。

这种配置允许框架在那些已经存好数据的节点上高效地调度任务,这可以使整个集群的网络带宽被非常高效地利用。

Map/Reduce框架由一个单独的master JobTracker 和每个集群节点一个slave TaskTracker共同组成。

master负责调度构成一个作业的所有任务,这些任务分布在不同的slave上,master监控它们的执行,重新执行已经失败的任务。

而slave仅负责执行由master指派的任务。

应用程序至少应该指明输入/输出的位置(路径),并通过实现合适的接口或抽象类提供map和reduce函数。

再加上其他作业的参数,就构成了作业配置(job configuration)。

然后,Hadoop的job client提交作业(jar包/可执行程序等)和配置信息给JobTracker,后者负责分发这些软件和配置信息给slave、调度任务并监控它们的执行,同时提供状态和诊断信息给job-client。

虽然Hadoop框架是用Java TM实现的,但Map/Reduce应用程序则不一定要用 Java 来写。

∙Hadoop Streaming是一种运行作业的实用工具,它允许用户创建和运行任何可执行程序(例如:Shell工具)来做为mapper和reducer。

∙Hadoop Pipes是一个与SWIG兼容的C++ API (没有基于JNI TM技术),它也可用于实现Map/Reduce应用程序。

输入与输出Map/Reduce框架运转在<key, value> 键值对上,也就是说,框架把作业的输入看为是一组<key, value> 键值对,同样也产出一组 <key, value> 键值对做为作业的输出,这两组键值对的类型可能不同。

框架需要对key和value的类(classes)进行序列化操作,因此,这些类需要实现Writable接口。

另外,为了方便框架执行排序操作,key类必须实现WritableComparable接口。

一个Map/Reduce 作业的输入和输出类型如下所示:(input) <k1, v1> -> map -> <k2, v2> -> combine -> <k2, v2> -> reduce -> <k3, v3> (output)例子:WordCount v1.0在深入细节之前,让我们先看一个Map/Reduce的应用示例,以便对它们的工作方式有一个初步的认识。

WordCount是一个简单的应用,它可以计算出指定数据集中每一个单词出现的次数。

这个应用适用于单机模式,伪分布式模式或完全分布式模式三种Hadoop安装方式。

源代码WordCount.java1.package org.myorg;2.3.import java.io.IOException;4.import java.util.*;5.6.import org.apache.hadoop.fs.Path;7.import org.apache.hadoop.conf.*;8.import org.apache.hadoop.io.*;9.import org.apache.hadoop.mapred.*;10.import org.apache.hadoop.util.*;11.12.public class WordCount {13.14.public static class Map extends MapReduceBase implements Mapper<LongWritable, Text, Text, IntWritable> {15.private final static IntWritable one = new IntWritable(1);16.private Text word = new Text();17.18.public void map(LongWritable key, Text value, OutputCollector<Text, IntWritable> output, Reporter reporter) throws IOException {19.String line = value.toString();20.StringTokenizer tokenizer = new StringTokenizer(line);21.while (tokenizer.hasMoreTokens()) {22.word.set(tokenizer.nextToken());23.output.collect(word, one);24.}25.}26.}27.28.public static class Reduce extends MapReduceBase implements Reducer<Text, IntWritable, Text, IntWritable> {29.public void reduce(Text key, Iterator<IntWritable> values, OutputCollector<Text, IntWritable> output, Reporter reporter) throws IOException {30.int sum = 0;31.while (values.hasNext()) {32.sum += values.next().get();33.}34.output.collect(key, new IntWritable(sum));35.}36.}37.38.public static void main(String[] args) throws Exception {39.JobConf conf = new JobConf(WordCount.class);40.conf.setJobName("wordcount");41.42.conf.setOutputKeyClass(Text.class);43.conf.setOutputV alueClass(IntWritable.class);44.45.conf.setMapperClass(Map.class);46.conf.setCombinerClass(Reduce.class);47.conf.setReducerClass(Reduce.class);48.49.conf.setInputFormat(TextInputFormat.class);50.conf.setOutputFormat(TextOutputFormat.class);51.52.FileInputFormat.setInputPaths(conf, new Path(args[0]));53.FileOutputFormat.setOutputPath(conf, new Path(args[1]));54.55.JobClient.runJob(conf);57.}58.}59.用法假设环境变量HADOOP_HOME对应安装时的根目录,HADOOP_VERSION对应Hadoop 的当前安装版本,编译WordCount.java来创建jar包,可如下操作:$ mkdir wordcount_classes$ javac -classpath ${HADOOP_HOME}/hadoop-${HADOOP_VERSION}-core.jar -d wordcount_classes WordCount.java$ jar -cvf /usr/joe/wordcount.jar -C wordcount_classes/ .假设:/usr/joe/wordcount/input - 是HDFS中的输入路径/usr/joe/wordcount/output - 是HDFS中的输出路径用示例文本文件做为输入:$ bin/hadoop dfs -ls /usr/joe/wordcount/input//usr/joe/wordcount/input/file01/usr/joe/wordcount/input/file02$ bin/hadoop dfs -cat /usr/joe/wordcount/input/file01Hello World Bye World$ bin/hadoop dfs -cat /usr/joe/wordcount/input/file02Hello Hadoop Goodbye Hadoop运行应用程序:$ bin/hadoop jar /usr/joe/wordcount.jar org.myorg.WordCount/usr/joe/wordcount/input /usr/joe/wordcount/output输出是:$ bin/hadoop dfs -cat /usr/joe/wordcount/output/part-00000Bye 1Goodbye 1Hadoop 2Hello 2World 2应用程序能够使用-files选项来指定一个由逗号分隔的路径列表,这些路径是task的当前工作目录。