全文搜索引擎 Elasticsearch 入门教

程 全文搜索属于最常见的需求,开源的 Elasticsearch (以下简称 Elastic )是目前全文搜索引擎的首选。

它可以快速地储存、搜索和分析海量数据。维基百科、Stack Overflow 、Github 都采用它。

Elastic 的底层是开源库 Lucene 。但是,你没法直接用 Lucene ,必须自己写代码去调用它的接口。Elastic 是 Lucene 的封装,提供了 REST API 的操作接口,开箱即用。

本文从零开始,讲解如何使用 Elastic 搭建自己的全文搜索引擎。每一步都有详细的说明,大家跟着做就能学会。

一、安装

Elastic 需要 Java 8 环境。如果你的机器还没安装 Java ,可以参考这篇文章,注意要保证环境变量JAVA_HOME 正确设置。

安装完 Java ,就可以跟着官方文档安装 Elastic 。直接下载压缩包比较简单。

1 2 $ wget

https://artifacts.elastic.co/downloads/elasticsearch/elasticsearch-

3 5.5.1.zip

$ unzip elasticsearch-5.5.1.zip

$ cd elasticsearch-5.5.1/

接着,进入解压后的目录,运行下面的命令,启动 Elastic 。

1 $ ./bin/elasticsearch

如果这时报错“max virtual memory areas vm.max map count [65530] is too low”,要运行下面的命令。

1 $ sudosysctl -w vm.max_map_count=262144

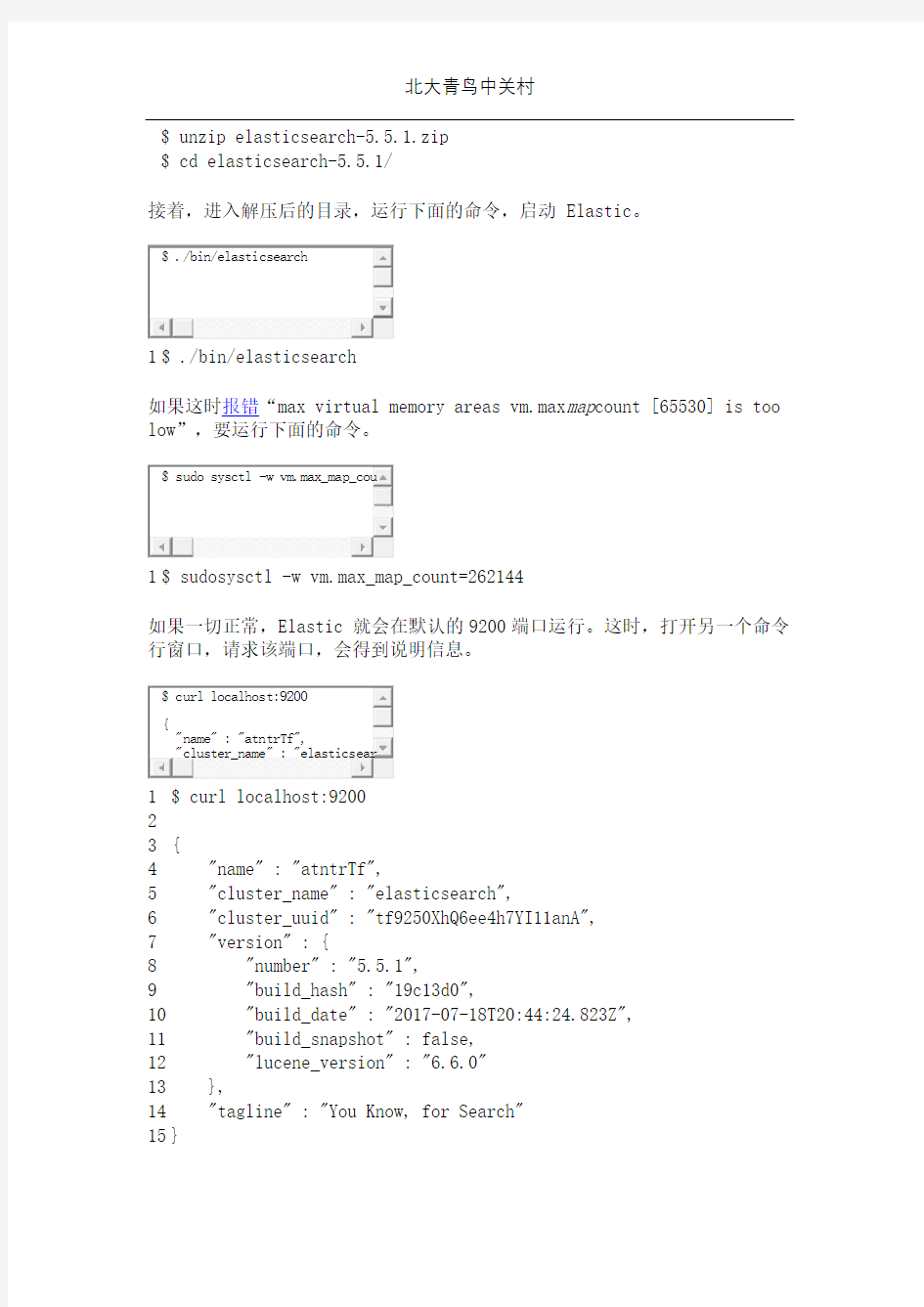

如果一切正常,Elastic 就会在默认的9200端口运行。这时,打开另一个命令行窗口,请求该端口,会得到说明信息。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 $ curl localhost:9200

{

"name" : "atntrTf",

"cluster_name" : "elasticsearch",

"cluster_uuid" : "tf9250XhQ6ee4h7YI11anA",

"version" : {

"number" : "5.5.1",

"build_hash" : "19c13d0",

"build_date" : "2017-07-18T20:44:24.823Z",

"build_snapshot" : false,

"lucene_version" : "6.6.0"

},

"tagline" : "You Know, for Search"

}

上面代码中,请求9200端口,Elastic 返回一个 JSON 对象,包含当前节点、集群、版本等信息。

按下 Ctrl + C,Elastic 就会停止运行。

默认情况下,Elastic 只允许本机访问,如果需要远程访问,可以修改 Elastic 安装目录的config/elasticsearch.yml文件,去掉network.host的注释,将它的值改成0.0.0.0,然后重新启动 Elastic。

1 network.host: 0.0.0.0

上面代码中,设成0.0.0.0让任何人都可以访问。线上服务不要这样设置,要设成具体的 IP。

二、基本概念

2.1 Node 与 Cluster

Elastic 本质上是一个分布式数据库,允许多台服务器协同工作,每台服务器可以运行多个 Elastic 实例。

单个 Elastic 实例称为一个节点(node)。一组节点构成一个集群(cluster)。

2.2 Index

Elastic 会索引所有字段,经过处理后写入一个反向索引(Inverted Index)。查找数据的时候,直接查找该索引。

所以,Elastic 数据管理的顶层单位就叫做 Index(索引)。它是单个数据库的同义词。每个 Index (即数据库)的名字必须是小写。

下面的命令可以查看当前节点的所有 Index。

1 $ curl -X GET 'http://localhost:9200/_cat/indices?v'

2.3 Document

Index 里面单条的记录称为 Document (文档)。许多条 Document 构成了一个 Index 。

Document 使用 JSON 格式表示,下面是一个例子。

1 2 3 4 5 {

"user": "张三",

"title": "工程师",

"desc": "数据库管理"

}

同一个 Index 里面的 Document ,不要求有相同的结构(scheme ),但是最好保持相同,这样有利于提高搜索效率。

2.4 Type

Document 可以分组,比如weather 这个 Index 里面,可以按城市分组(北京和上海),也可以按气候分组(晴天和雨天)。这种分组就叫做 Type ,它是虚拟的逻辑分组,用来过滤 Document 。

不同的 Type 应该有相似的结构(schema ),举例来说,id 字段不能在这个组是字符串,在另一个组是数值。这是与关系型数据库的表的一个区别。性质完全不同的数据(比如products 和logs )应该存成两个 Index ,而不是一个 Index 里面的两个 Type (虽然可以做到)。

下面的命令可以列出每个 Index 所包含的 Type 。

1 $ curl 'localhost:9200/_mapping?pretty=true'

根据规划,Elastic 6.x 版只允许每个 Index 包含一个 Type ,7.x 版将会彻底移除 Type 。

三、新建和删除 Index

新建 Index ,可以直接向 Elastic 服务器发出 PUT 请求。下面的例子是新建一个名叫weather 的 Index 。

1 $ curl -X PUT 'localhost:9200/weather'

服务器返回一个 JSON 对象,里面的acknowledged 字段表示操作成功。

1 2 3 4 {

"acknowledged":true,

"shards_acknowledged":true

}

然后,我们发出 DELETE 请求,删除这个 Index 。

1 $ curl -X DELETE 'localhost:9200/weather'

四、中文分词设置

首先,安装中文分词插件。这里使用的是 ik ,也可以考虑其他插件(比如 smartcn )。

1 $ ./bin/elasticsearch-plugin install

https://https://www.doczj.com/doc/cd8947036.html,/medcl/elasticsearch-analysis-ik/releases/download /v5.5.1/elasticsearch-analysis-ik-5.5.1.zip

上面代码安装的是5.5.1版的插件,与 Elastic 5.5.1 配合使用。

接着,重新启动 Elastic ,就会自动加载这个新安装的插件。

然后,新建一个 Index ,指定需要分词的字段。这一步根据数据结构而异,下面的命令只针对本文。基本上,凡是需要搜索的中文字段,都要单独设置一下。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 $ curl -X PUT 'localhost:9200/accounts' -d '

{

"mappings": {

"person": {

"properties": {

"user": {

"type": "text",

"analyzer": "ik_max_word",

"search_analyzer": "ik_max_word"

},

"title": {

"type": "text",

"analyzer": "ik_max_word",

"search_analyzer": "ik_max_word"

},

"desc": {

"type": "text",

"analyzer": "ik_max_word",

"search_analyzer": "ik_max_word"

}

}

}

}

}'

上面代码中,首先新建一个名称为accounts 的 Index ,里面有一个名称为person 的 Type 。person 有三个字段。

1 2 3 user

title

desc

这三个字段都是中文,而且类型都是文本(text ),所以需要指定中文分词器,不能使用默认的英文分词器。

Elastic 的分词器称为analyzer 。我们对每个字段指定分词器。

1 2 3 4 5 "user": {

"type": "text",

"analyzer": "ik_max_word",

"search_analyzer": "ik_max_word"

}

上面代码中,analyzer 是字段文本的分词器,search_analyzer 是搜索词的分词器。ik_max_word 分词器是插件ik 提供的,可以对文本进行最大数量的分词。

五、数据操作

5.1 新增记录

向指定的 /Index/Type 发送 PUT 请求,就可以在 Index 里面新增一条记录。比如,向/accounts/person 发送请求,就可以新增一条人员记录。

1 2 3 4 5 $ curl -X PUT 'localhost:9200/accounts/person/1' -d '

{

"user": "张三",

"title": "工程师",

"desc": "数据库管理"

6 }'

服务器返回的 JSON 对象,会给出 Index 、Type 、Id 、Version 等信息。

1 2 3 4 5 6 7 8 9 {

"_index":"accounts",

"_type":"person",

"_id":"1",

"_version":1,

"result":"created",

"_shards":{"total":2,"successful":1,"failed":0},

"created":true

} 如果你仔细看,会发现请求路径是/accounts/person/1,最后的1是该条记录的 Id 。它不一定是数字,任意字符串(比如abc )都可以。

新增记录的时候,也可以不指定 Id ,这时要改成 POST 请求。

1 2 3 4 5 6 $ curl -X POST 'localhost:9200/accounts/person' -d '

{

"user": "李四",

"title": "工程师",

"desc": "系统管理"

}'

上面代码中,向/accounts/person 发出一个 POST 请求,添加一个记录。这时,服务器返回的 JSON 对象里面,_id 字段就是一个随机字符串。

1 2 {

"_index":"accounts",

3 4 5 6 7 8 9

"_type":"person",

"_id":"AV3qGfrC6jMbsbXb6k1p",

"_version":1,

"result":"created",

"_shards":{"total":2,"successful":1,"failed":0},

"created":true

} 注意,如果没有先创建 Index (这个例子是accounts ),直接执行上面的命令,Elastic 也不会报错,而是直接生成指定的 Index 。所以,打字的时候要小心,不要写错 Index 的名称。

5.2 查看记录

向/Index/Type/Id 发出 GET 请求,就可以查看这条记录。

1 $ curl 'localhost:9200/accounts/person/1?pretty=true'

上面代码请求查看/accounts/person/1这条记录,URL 的参数pretty=true 表示以易读的格式返回。

返回的数据中,found 字段表示查询成功,_source 字段返回原始记录。

1 2 3 4 5 6 7 8 9 10 11 12 {

"_index" : "accounts",

"_type" : "person",

"_id" : "1",

"_version" : 1,

"found" : true,

"_source" : {

"user" : "张三",

"title" : "工程师",

"desc" : "数据库管理"

}

}

如果 Id 不正确,就查不到数据,found 字段就是false 。

1 2 3 4 5 6 7 8 $ curl 'localhost:9200/weather/beijing/abc?pretty=true'

{

"_index" : "accounts",

"_type" : "person",

"_id" : "abc",

"found" : false

}

5.3 删除记录

删除记录就是发出 DELETE 请求。

1 $ curl -X DELETE 'localhost:9200/accounts/person/1'

这里先不要删除这条记录,后面还要用到。

5.4 更新记录

更新记录就是使用 PUT 请求,重新发送一次数据。

1 2 3 4 5 6 7 $ curl -X PUT 'localhost:9200/accounts/person/1' -d '

{

"user" : "张三",

"title" : "工程师",

"desc" : "数据库管理,软件开发"

}'

8 9 10 11 12 13 14 15 16 {

"_index":"accounts",

"_type":"person",

"_id":"1",

"_version":2,

"result":"updated",

"_shards":{"total":2,"successful":1,"failed":0},

"created":false

} 上面代码中,我们将原始数据从”数据库管理”改成”数据库管理,软件开发”。 返回结果里面,有几个字段发生了变化。

1 2 3 "_version" : 2,

"result" : "updated",

"created" : false

可以看到,记录的 Id 没变,但是版本(version )从1变成2,操作类型(result )从created 变成updated ,created 字段变成false ,因为这次不是新建记录。

六、数据查询

6.1 返回所有记录

使用 GET 方法,直接请求/Index/Type/_search ,就会返回所有记录。

1 2 3 4 5 6 7 8 $ curl 'localhost:9200/accounts/person/_search'

{

"took":2,

"timed_out":false,

"_shards":{"total":5,"successful":5,"failed":0},

"hits":{

"total":2,

9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35

"max_score":1.0,

"hits":[

{

"_index":"accounts",

"_type":"person",

"_id":"AV3qGfrC6jMbsbXb6k1p",

"_score":1.0,

"_source": {

"user": "李四",

"title": "工程师",

"desc": "系统管理"

}

},

{

"_index":"accounts",

"_type":"person",

"_id":"1",

"_score":1.0,

"_source": {

"user" : "张三",

"title" : "工程师",

"desc" : "数据库管理,软件开发"

}

}

]

} } 上面代码中,返回结果的 took 字段表示该操作的耗时(单位为毫秒),timed_out 字段表示是否超时,hits 字段表示命中的记录,里面子字段的含义如下。

1 2 3 total :返回记录数,本例是2条。

max_score :最高的匹配程度,本例是1.0。

hits :返回的记录组成的数组。

返回的记录中,每条记录都有一个_score 字段,表示匹配的程序,默认是按照这个字段降序排列。

6.2 全文搜索

Elastic 的查询非常特别,使用自己的查询语法,要求 GET 请求带有数据体。

1 2 3 4 $ curl 'localhost:9200/accounts/person/_search' -d '

{

"query" : { "match" : { "desc" : "软件" }}

}'

上面代码使用 Match 查询,指定的匹配条件是desc 字段里面包含”软件”这个词。返回结果如下。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 {

"took":3,

"timed_out":false,

"_shards":{"total":5,"successful":5,"failed":0},

"hits":{

"total":1,

"max_score":0.28582606,

"hits":[

{

"_index":"accounts",

"_type":"person",

"_id":"1",

"_score":0.28582606,

"_source": {

"user" : "张三",

"title" : "工程师",

"desc" : "数据库管理,软件开发"

}

}

]

}

} Elastic 默认一次返回10条结果,可以通过size 字段改变这个设置。

1 2 3 4 5 $ curl 'localhost:9200/accounts/person/_search' -d ' {

"query" : { "match" : { "desc" : "管理" }},

"size": 1

}'

上面代码指定,每次只返回一条结果。

还可以通过from 字段,指定位移。

1 2 3 4 5 6 $ curl 'localhost:9200/accounts/person/_search' -d ' {

"query" : { "match" : { "desc" : "管理" }},

"from": 1,

"size": 1

}'

上面代码指定,从位置1开始(默认是从位置0开始),只返回一条结果。

6.3 逻辑运算

如果有多个搜索关键字, Elastic 认为它们是or 关系。

1 2 3 4 $ curl 'localhost:9200/accounts/person/_search' -d ' {

"query" : { "match" : { "desc" : "软件 系统" }}

}'

上面代码搜索的是软件 or 系统。

如果要执行多个关键词的and 搜索,必须使用布尔查询。

1 2 3 4 5 6 7 8 9 10 11 $ curl 'localhost:9200/accounts/person/_search' -d ' {

"query": {

"bool": {

"must": [

{ "match": { "desc": "软件" } },

{ "match": { "desc": "系统" } }

]

} }

}'

2011-2012学年度高一级电脑作业(1) 班级高一27班姓名颜奕钦坐号54 利用网络搜索有关知识,回答下列问题。(注意作业提交时,要以班级号+座号命名,如24班3号,其作业的文件名为2403) 1)搜索引擎的发展史 互联网发展早期,以雅虎为代表的网站分类目录查询非常流行。网站分类目录由人工整理维护,精选互联网上的优秀网站,并简要描述,分类放置到不同目录下。用户查询时,通过一层层的点击来查找自己想找的网站。也有人把这种基于目录的检索服务网站称为搜索引擎,但从严格意义上讲,它并不是搜索引擎。 1990年,加拿大麦吉尔大学(University of McGill)计算机学院的师生开发出Archie。当时,万维网(World Wide Web)还没有出现,人们通过FTP来共享交流资源。Archie能定期搜集并分析FTP服务器上的文件名信息,提供查找分别在各个FTP主机中的文件。用户必须输入精确的文件名进行搜索,Archie告诉用户哪个FTP服务器能下载该文件。虽然Archie 搜集的信息资源不是网页(HTML文件),但和搜索引擎的基本工作方式是一样的:自动搜集信息资源、建立索引、提供检索服务。所以,Archie被公认为现代搜索引擎的鼻祖 。 2)搜索引擎的工作原理 在搜索引擎分类部分我们提到过全文搜索引擎从网站提取信息建立网页数据库的概念。搜索引擎的自动信息搜集功能分两种。一种是定期搜索,即每隔一段时间(比如Google一般是28天),搜索引擎主动派出“蜘蛛”程序,对一定IP地址范围内的互联网站进行检索,一旦发现新的网站,它会自动提取网站的信息和网址加入自己的数据库。 另一种是提交网站搜索,即网站拥有者主动向搜索引擎提交网址,它在一定时间内(2天到数月不等)定向向你的网站派出“蜘蛛”程序,扫描你的网站并将有关信息存入数据库,以备用户查询。由于近年来搜索引擎索引规则发生了很大变化,主动提交网址并不保证你的网站能进入搜索引擎数据库,因此目前最好的办法是多获得一些外部链接,让搜索引擎有更多机会找到你并自动将你的网站收录。 当用户以关键词查找信息时,搜索引擎会在数据库中进行搜寻,如果找到与用户要求内容相符的网站,便采用特殊的算法——通常根据网页中关键词的匹配程度,出现的位置/频

搜索引擎基本工作原理 目录 1工作原理 2搜索引擎 3目录索引 4百度谷歌 5优化核心 6SEO优化 ?网站url ? title信息 ? meta信息 ?图片alt ? flash信息 ? frame框架 1工作原理 搜索引擎的基本工作原理包括如下三个过程:首先在互联网中发现、搜集网页信息;同时对信息进行提取和组织建立索引库;再由检索器根据用户输入的查询关键字,在索引库中快速检出文档,进行文档与查询的相关度评价,对将要输出的结果进行排序,并将查询结果返回给用户。 1、抓取网页。每个独立的搜索引擎都有自己的网页抓取程序爬虫(spider)。爬虫Spider顺着网页中的超链接,从这个网站爬到另一个网站,通过超链接分析连续访问抓取更多网页。被抓取的网页被称之为网页快照。由于互联网中超链接的应用很普遍,理论上,从一定范围的网页出发,就能搜集到绝大多数的网页。 2、处理网页。搜索引擎抓到网页后,还要做大量的预处理工作,才能提供检索服务。其中,最重要的就是提取关键词,建立索引库和索引。其他还包括去除重

复网页、分词(中文)、判断网页类型、分析超链接、计算网页的重要度/丰富度等。 3、提供检索服务。用户输入关键词进行检索,搜索引擎从索引数据库中找到匹配该关键词的网页;为了用户便于判断,除了网页标题和URL外,还会提供一段来自网页的摘要以及其他信息。 搜索引擎基本工作原理 2搜索引擎 在搜索引擎分类部分我们提到过全文搜索引擎从网站提取信息建立网页数据库 的概念。搜索引擎的自动信息搜集功能分两种。一种是定期搜索,即每隔一段时间(比如Google一般是28天),搜索引擎主动派出“蜘蛛”程序,对一定IP 地址范围内的互联网站进行检索,一旦发现新的网站,它会自动提取网站的信息和网址加入自己的数据库。 另一种是提交网站搜索,即网站拥有者主动向搜索引擎提交网址,它在一定时间内(2天到数月不等)定向向你的网站派出“蜘蛛”程序,扫描你的网站并将有关信息存入数据库,以备用户查询。由于搜索引擎索引规则发生了很大变化,主动提交网址并不保证你的网站能进入搜索引擎数据库,因此目前最好的办法是多获得一些外部链接,让搜索引擎有更多机会找到你并自动将你的网站收录。 当用户以关键词查找信息时,搜索引擎会在数据库中进行搜寻,如果找到与用户要求内容相符的网站,便采用特殊的算法——通常根据网页中关键词的匹配程度,

搜索引擎基本原理 一.全文搜索引擎 在搜索引擎分类部分我们提到过全文搜索引擎从网站提取信息建立网页数据库的概念。搜索引擎的自动信息搜集功能分两种。一种是定期搜索,即每隔一段时间(比如Google一般是28天),搜索引擎主动派出“蜘蛛”程序,对一定IP地址范围内的互联网站进行检索,一旦发现新的网站,它会自动提取网站的信息和网址加入自己的数据库。 另一种是提交网站搜索,即网站拥有者主动向搜索引擎提交网址,它在一定时间内(2天到数月不等)定向向你的网站派出“蜘蛛”程序,扫描你的网站并将有关信息存入数据库,以备用户查询。由于近年来搜索引擎索引规则发生了很大变化,主动提交网址并不保证你的网站能进入搜索引擎数据库,因此目前最好的办法是多获得一些外部链接,让搜索引擎有更多机会找到你并自动将你的网站收录。 当用户以关键词查找信息时,搜索引擎会在数据库中进行搜寻,如果找到与用户要求内容相符的网站,便采用特殊的算法——通常根据网页中关键词的匹配程度,出现的位置/频次,链接质量等——计算出各网页的相关度及排名等级,然后根据关联度高低,按顺序将这些网页链接返回给用户。 二.目录索引 与全文搜索引擎相比,目录索引有许多不同之处。 首先,搜索引擎属于自动网站检索,而目录索引则完全依赖手工操作。用户提交网站后,目录编辑人员会亲自浏览你的网站,然后根据一套自定的评判标准甚至编辑人员的主观印象,决定是否接纳你的网站。 其次,搜索引擎收录网站时,只要网站本身没有违反有关的规则,一般都能登录成功。而目录索引对网站的要求则高得多,有时即使登录多次也不一定成功。

尤其象Yahoo!这样的超级索引,登录更是困难。(由于登录Yahoo!的难度最大,而它又是商家网络营销必争之地,所以我们会在后面用专门的篇幅介绍登录Yahoo雅虎的技巧) 此外,在登录搜索引擎时,我们一般不用考虑网站的分类问题,而登录目录索引时则必须将网站放在一个最合适的目录(Directory)。 最后,搜索引擎中各网站的有关信息都是从用户网页中自动提取的,所以用户的角度看,我们拥有更多的自主权;而目录索引则要求必须手工另外填写网站信息,而且还有各种各样的限制。更有甚者,如果工作人员认为你提交网站的目录、网站信息不合适,他可以随时对其进行调整,当然事先是不会和你商量的。 目录索引,顾名思义就是将网站分门别类地存放在相应的目录中,因此用户在查询信息时,可选择关键词搜索,也可按分类目录逐层查找。如以关键词搜索,返回的结果跟搜索引擎一样,也是根据信息关联程度排列网站,只不过其中人为因素要多一些。如果按分层目录查找,某一目录中网站的排名则是由标题字母的先后顺序决定(也有例外)。 目前,搜索引擎与目录索引有相互融合渗透的趋势。原来一些纯粹的全文搜索引擎现在也提供目录搜索,如Google就借用Open Directory目录提供分类查询。而象 Yahoo! 这些老牌目录索引则通过与Google等搜索引擎合作扩大搜索范围。在默认搜索模式下,一些目录类搜索引擎首先返回的是自己目录中匹配的网站,如国内搜狐、新浪、网易等;而另外一些则默认的是网页搜索,如Yahoo。

谷歌搜索引擎优化初学者指南

本文档起初只是在谷歌内部使用 , 但是我们考虑到 , 也许它对那些刚刚接触搜索引擎优化、并且希望提高网站与用户和搜索引擎交互性的网站站长们也一样会有帮助 , 所以我们对其进行进一步整理完善 , 发表出来供大家参考。尽管这个指南不会告诉您怎样做才能使自己的网站排在谷歌搜索结果的第一位 , 但是遵循下文介绍的一些推荐做法会使搜索引擎更容易抓取和索引您网站的内容。搜索引擎优化通常是指对您网站的某些部分做一些小的改进。如果个别来看 , 这些改进的效果可能并不那么明显。但是当和其他的优化结合起来看时 , 它们将对您网站的用户体验以及在搜索结果中的表现有显著的影响。您可能对此指南中的相当一部分话题已经比较熟悉了 , 因为它们都是构成网页的基本元素 , 但是您可能并没有非常充分地利用这些基本元素。 尽管这个指南的标题含有“搜索引擎”这个词 , 但是我们想说的是您应该将您优化的重心和出发点主要放在用户体验上 , 因为用户才是您网站内容的主要受众 , 是他们通过搜索引擎找到了您的网站。过度专注于用特定的技巧获取搜索引擎自然搜索结果的排名不一定能够达到您想要的结果。通俗地讲 , 搜索引擎优化就是让您的网站以最理想的姿态出现在搜索引擎的结果中 , 但是您的最终的服务对象是您的用户而不是搜索引擎。 您的网站可能比我们作为例子的网站大也可能比它小 , 网站的内容也可能有很大不同 , 但是我们下面讨论的优化主题将适用于所有不同大小和类型的网站。我们希望我们的指南能够给您在如何改进您的网站方面提供一些启发。我们会非常乐意在谷歌网站管理员支持论坛上听到您的问题、反馈以及您的成功案例的。 欢迎来到谷歌搜索引擎优化初学者指南。 2

实验一:全文搜索引擎和目录索引引擎的区别是什么? 全文搜索引擎因为依靠软件进行,所以数据库的容量非常庞大,但是,它的查询结果往往不够准确。 分类目录依靠人工收集和整理网站,能够提供更为准确的查询结果,但收集的内容却非常有限。 1搜索引擎属于自动网站检索,而目录索引则完全依赖手工操作。 2搜索引擎收录网站时,只要网站本身没有违反有关的规则,一般都能登录成功;而目录索引对网站的要求则高得多,有时即使登录多次也不一定成功。 3当用于在登录搜索引擎时,我们一般不用考虑网站的分类问题,而登录目录索引时则必须将网站放在一个最合适的目录(Directory)。 4搜索引擎中各网站的有关信息都是从用户网页中自动提取的,所以用户的角度看,我们拥有更多的自主权;而目录索引则要求必须手工另外填写网站信息,而且还有各种各样的限制。因此,分类目录型搜索引擎营销方法与技术性搜索引擎的方式有很大的不同,需要充分了解这种区别,才能充分发挥各种不同搜索引擎的作用。 实验二:百度的广告策略如何策划的。谈谈你的看法。 百度的广告策略主要是通过搜索推广、网盟推广、增值服务(百度指数、百度统计、百度推广助手、百度商桥)、其他推广服务(百度图片推广、百度品牌专区、百度火爆地带)、专业客户服务等几项来进行的。 百度推广流程是: 1. 搜索:网民在百度搜索自己关注的关键词信息 2. 推广:企业的推广信息展现在关键词对应的搜索结果页 3. 点击:用户点击推广信息进入企业网站 4. 成交:通过沟通了解,双方达成交易 百度将互联网众多内容网站整合,建立了国内最具实力的联盟体系;百度联盟囊括了24个行业类别的优质网站,加盟合作网站累计超过30万家,影响力覆盖95%以上的中国网民。 百度品牌专区是在网页搜索结果最上方为著名品牌量身定制的资讯发布平台,是为提升网民搜索体验而整合文字、图片、视频等多种展现结果的创新搜索模式。 百度火爆地带是一种针对特定关键词的网络推广方式,按时间段固定付费,出现在百度网页搜索结果第一页的右侧,不同位置价格不同。 百度图片推广是一种针对特定关键词的网络推广方式,按时间段固定付费,出现在百度图片搜索结果第一页的结果区域,不同词汇价格不同。企业购买了图片推广关键词后,就会被主动查找这些关键词的用户找到并向其展示企业推广图片,给企业带来商业机会! 实验三:各个搜索引擎对同类网站的收录情况是否相同?如果不相同,各个搜索引擎有什么特点? 各个搜索引擎对同类网站的收录情况不尽相同。百度与谷歌属于全文引擎搜索,其网页数据库的更新速度也不相同,但收录网页数与更新的速度是谷歌比百度更快,内容更丰富。而雅

百度互联网创业俱乐部搜索引擎优化指南 版本号:V1.0 @ Baidu 2010

前言 SEO(Search engine optimization,搜索引擎优化),指为了提升网页在搜索引擎自然搜索结果中(非商业性推广结果)的收录数量以及排序位置而做的优化行为,这一行为的目的,是为了从搜索引擎中获得更多的免费流量,以及更好的展现形象。而SEM(Search engine marketing,搜索引擎营销),则既包括了SEO,也包括了付费的商业推广优化。 毋庸讳言,SEO自从1997年左右出现以来,就和搜索引擎处于某种对立状态。这种对立源于两方面: 一方面,大量SEO行为只考虑了如何获得更多的“免费”流量,至于多的这些流量是否符合搜索用户价值,则不在考虑范围之内。这种SEO被称为“黑帽”,历来受到搜索引擎的严厉打击。 另一方面,SEO的目的是为了获取更多的“免费”流量,这和搜索引擎的商业推广是对立的。所以很多SEO的从业者,包括相当多的搜索引擎从业者,从心底里认为,两者的利益就是不可调和的。 但如果从更加长远的角度来看,搜索引擎和SEO从业者的利益,实际是有高度一致的地方的: 首先,搜索引擎的搜索质量改善,很大程度上受到资源形态的影响。比如很多优质资源,是用Flash或者Ajax做的,搜索引擎就无法很好的爬取和索引。搜索引擎无法独立承担起这个引导教育职责,有了SEO参与其中,这些优质资源就可以更好的发挥其检索效果,改善用户搜索体验。 其次,SEO从业者也是搜索引擎商业价值很好的布道者。尤其对于中国这样的新兴市场,传统的中小企业对于如何触网,如何做互联网营销,并无多少经验。SEO在其中可以扮演非常重要的角色。而这种布道,对于搜索引擎产业价值的拓展,是很有好处的。 基于以上原因,我们需要重新审视搜索引擎和SEO之间的关系。两者宜建立起一种更加良性的共生关系,驱逐劣币,提携良币,以使互联网生态圈得到更加健康有序的发展。百度作为中文搜索领域的领导者,有责任和义务来推进这个事情。这也是本文档发布的初衷。 我们先来看一下过去的问题所在。 (1)黑帽SEO大行其道,占据了SEO主流话语权 黑帽SEO行为,通常就是一般所谓的“搜索引擎作弊”。利用和放大搜索引擎的策略缺陷(实际上完美的系统是不存在的)获取更多用户访问量。而这种更多的访问量,是以伤害

作者声明 本人郑重声明:所呈交的学位是本人在导师的指导下独立进行研究所取得的研究成果。除了文中特别加以标注引用的内容外,本不包含任何其他个人或集体已经发表或撰写的成果作品。 本人完全了解有关保障、使用学位的规定,同意学校保留并向有关学位管理机构送交的复印件和电子版。同意省级优秀学位评选机构将本学位通过影印、缩印、扫描等方式进行保存、摘编或汇编;同意本被编入有关数据库进行检索和查阅。 本学位内容不涉及国家机密。 题目:全文搜索引擎的设计与实现 作者单位:江汉大学数学与计算机科学学院 作者签名:XXX 20XX年 5 月 20 日

学士学位 题目全文搜索引擎的设计与实现 (英文) Full-text search engine design and Implementation 学院数学与计算机科学学院 专业计算机科学与技术 班级 B09082021 姓名 XXX 学号 20XX08202137 指导老师 YYY 20XX 年5月20日

摘要 目前定制和维护搜索引擎的需求越来越大,对于处理庞大的网络数据,如何有效的去存储它并访问到我们需要的信息,变得尤为重要。Web搜索引擎能有很好的帮助我们解决这一问题。 本文阐述了一个全文搜索引擎的原理及其设计和实现过程。该系统采用B/S模式的Java Web平台架构实现,采用Nutch相关框架,包括Nutch,Solr,Hadoop,以及Nutch 的基础框架Lucene对全网信息的采集和检索。文中阐述了Nutch相关框架的背景,基础原理和应用。 Nutch相关框架的出现,使得在java平台上构建个性化搜索引擎成为一件简单又可靠的事情。Nutch 致力于让每个人能很容易, 同时花费很少就可以配置世界一流的Web 搜索引擎。目前国内有很多大公司,比如百度、雅虎,都在使用Nutch相关框架。由于Nutch是开源的,阅读其源代码,可以让我们对搜索引擎实现有更加深刻的感受,并且能够更加深度的定制需要的搜索引擎实现细节。 本文首先介绍了课题研究背景,然后对系统涉及到的理论知识,框架的相关理论做了详细说明,最后按照软件工程的开发方法逐步实现系统功能。 关键词 Nutch、Solr、Hadoop、Lucene、搜索引擎

全文搜索引擎的设计与实现 前言 面对海量的数字化信息,搜索引擎技术帮助我们在其中发现有价值的信息与资源。我们可以通过google、百度这样的搜索引擎服务提供商帮助我们在Internet上搜索我们需要的信息。但是在一些没有或不便于连入Internet的内部网络或者是拥有海量数据存储的主机,想要通过搜索来发现有价值的信息和资源却不太容易。所以开发一个小型全文搜索引擎,实现以上两种情况下的信息高效检索是十分有必要的。本设计着眼于全文搜索引擎的设计与实现,利用Java ee结合Struts,Spring,Hibernates以及Ajax等框架技术,实现基于apache软件基金会开源搜索引擎框架Lucene下的一个全文搜索引擎。 正文 搜索引擎技术起源1990年,蒙特利尔大学学生Alan Emtage、Peter Deutsch和Bill Wheelan出于个人兴趣,发明了用于检索、查询分布在各个FTP主机中的文件Archie,当时他们的目的仅仅是为了在查询文件时的方便,他们未曾预料到他们的这一创造会成就日后互联网最的广阔市场,他们发明的小程序将进化成网络时代不可或缺的工具——搜索引擎。1991年,在美国CERFnet、PSInet及Alternet网络组成了CIEA (商用Internet 协会)宣布用户可以把它们的Internet子网用于商业用途,开始了Internet商业化的序幕。商业化意味着互联网技术不再为科研和军事领域独享,商业化意味着有更多人可以接触互联网,商业化更意味着潜在的市场和巨大的商机。1994年,Michael Mauldin推出了最早的现代意义上的搜索引擎Lycos,互联网进入了搜索技术的应用和搜索引擎快速发展时期。以上是国际互联网和搜索引擎发展历史上的几个重要日子。互联网从出现至今不过15年左右时间,搜索引擎商业化运作也就10年左右。就在这短短的10年时间里,互联网发生了翻天覆地的变化,呈爆炸性增长。于此同时也成就了google、百度这样的互联网巨头。今天,当我们想要在这片广阔的信息海洋中及时获得想要查找的信息时,已经离不开搜索引擎了。 相关技术

搜索引擎最重要的是什么?有人会说是查询结果的准确性,有人会说是查询结果的丰富性,但其实这些都不是搜索引擎最最致命的地方。对于搜索引擎来说,最最致命的是查询时间。试想一下,如果你在百度界面上查询一个关键词,结果需要5分钟才能将你的查询结果反馈给你,那结果必然是你很快的舍弃掉百度。 搜索引擎为了满足对速度苛刻的要求(现在商业的搜索引擎的查询时间单位都是微秒数量级的),所以采用缓存支持查询需求的方式,也就是说我们在查询搜索时所得到的结果并不是及时的,而是在其服务器已经缓存好了的结果。那么搜索引擎工作的大体流程是什么样子呢?我们可以理解为三段式。 本文仅仅是对着三段工作流程进行大体上的讲解与综述,其中一些详细的技术细节将会用其它的文章进行单独的讲解。 一.网页搜集 网页搜集,其实就是大家常说的蜘蛛抓取网页。那么对于蜘蛛(google称之为机器人)来说,他们感兴趣的页面分为三类: 1.蜘蛛从未抓去过的新页面。 2.蜘蛛抓取过,但页面内容有改动的页面。 3.蜘蛛抓取过,但现在已删除了的页面。 那么如何行之有效的发现这三类页面并进行抓取,就是spider程序设计的初衷与目的。那么这里就涉及到一个问题,蜘蛛抓取的起始点。 每一位站长只要你的网站没有被严重降权,那么通过网站后台的服务器,你都可以发现勤劳的蜘蛛光顾你的站点,但是你们有没有想过从编写程序的角度上来说,蜘蛛是怎么来的呢?针对于此,各方有各方的观点。有一种说法,说蜘蛛的抓取是从种子站(或叫高权重站),依照权重由高至低逐层出发的。另一种说法蜘蛛爬在URL集合中是没有明显先后顺序的,搜索引擎会根据你网站内容更新的规律,自动计算出何时是爬取你网站的最佳时机,然后进行抓取。其实对于不同的搜索引擎,其抓取出发点定然会有所区别,针对于百度,笔者较为倾向于后者。在百度官方博客发布的《索引页链接补全机制的一种办法》一文中,其明确指出“spider 会尽量探测网页的发布周期,以合理的频率来检查网页”,由此我们可以推断,在百度的索引库中,针对每个URL集合,其都计算出适合其的抓取时间以及一系列参数,然后对相应站点进行抓取。 在这里,我要说明一下,就是针对百度来说,site的数值并非是蜘蛛已抓取你页面的数值。比如site:https://www.doczj.com/doc/cd8947036.html,,所得出的数值并不是大家常说的百度收录数值,想查询具体的百度收录量应该在百度提供的站长工具里查询索引数量。那么site是什么?这个我会在今后的文章中为大家讲解。 那么蜘蛛如何发现新链接呢?其依靠的就是超链接。我们可以把所有的互联网看成一个有向集合的聚集体,蜘蛛由起始的URL集合A沿着网页中超链接开始不停的发现新页面。在这个过程中,每发现新的URL都会与集合A中已存的进行比对,若是新的URL,则加入集合A

搜索引擎发展状态及未来趋势 【摘要】 搜索引擎包括图片搜索引擎、全文索引、目录索引等,其发展历史可分为五个阶段,目前企业搜索引擎和网站运营搜索引擎运用范围较广。在搜索引擎的未来发展中,呈现出个性化,多元化,智能化,移动化,社区化等多个趋势。 【关键词】 发展起源、索引、数据库、网站运营、未来趋势 【参考文献】 《个性化搜索引擎原理与技术》《搜索引擎的设计与实现》搜索引擎是指根据一定的策略、运用特定的计算机程序从互联网上搜集信息,在对信息进行组织和处理后,为用户提供检索服务,将用户检索相关的信息展示给用户的系统。其工作作原理分为抓取网页,处理网页和提供检索服务。抓取每个独立的搜索引擎都有自己的网页抓取程序,它顺着网页中的超链接,连续地抓取网页。由于互联网中超链接的应用很普遍,理论上,从一定范围的网页出发,就能搜集到绝大多数的网页。搜索引擎抓到网页后,还要做大量的预处理工作,才能提供检索服务。其中,最重要的就是提取关键词,建立索引文件。 搜索引擎的发展起源可以追溯到第一个Gopher搜索工具Veronica。后来的搜索引擎的发展分为五个阶段。第一阶段,出现World wide Web Wanderer,用于追踪互联网发展规模。刚开始它只用来统

计互联网上的服务器数量,后来则发展为也能够捕获网址。第二阶段,出现了以概念搜索闻名的Excite以及元搜索引擎Dogpile。第三阶段,即yahoo的出现。随着访问量和收录链接数的增长,Yahoo目录开始支持简单的数据库搜索。Yahoo以后陆续有Google等提供搜索引擎服务,但不可否认的是,Yahoo几乎成为20世纪90年代的因特网的代名词。第四阶段,一种新的搜索引擎形式出现了,即元搜索引擎。用户只需提交一次搜索请求,由元搜索引擎负责转换处理后提交给多个预先选定的独立搜索引擎,并将从各独立搜索引擎返回的所有查询结果,集中起来处理后再返回给用户。第五阶段的代表是智能检索的产生:它利用分词词典、同义词典,同音词典改善检索效果,进一步还可在知识层面或者说概念层面上辅助查询,给予用户智能知识提示,最终帮助用户获得最佳的检索效果。 搜索引擎目前包括图片搜索引擎、全文索引、目录索引、元搜索引擎、垂直搜索引擎等。全文索引引擎是名副其实的搜索引擎,国外代表有Google,国内有百度、搜狐等。它们从互联网提取各个网站的信息,建立起数据库,并能检索与用户查询条件相匹配的记录,按一定的排列顺序返回结果。搜索引擎的自动信息搜集功能分为定期搜索和提交网站搜索。它的特点是搜全率比较高。目录索引,就是将网站分门别类地存放在相应的目录中,因此用户在查询信息时,可选择关键词搜索,也可按分类目录逐层查找。与全文搜索引擎相比,目录索引有许多不同之处。首先,搜索引擎属于自动网站检索,而目录索引则完全依赖手工操作。其次,搜索引擎收录网站时,只要网站本身

参数,然后对相应站点进行抓取。 在这里,我要说明一下,就是针对百度来说,site的数值并非是蜘蛛已抓取你页面的数值。比 如site:https://www.doczj.com/doc/cd8947036.html,,所得出的数值并不是大家常说的百度收录数值,想查询具体的百度收录量应该在百度提供的站长工具里查询索引数量。那么site是什么?这个我会在今后的文章中为大家讲解。 那么蜘蛛如何发现新链接呢?其依靠的就是超链接。我们可以把所有的互联网看成一个有向集合的聚集体,蜘蛛由起始的URL集合A沿着网页中超链接开始不停的发现新页面。在这个过程中,每发现新的URL都会与集合A中已存的进行比对,若是新的URL,则加入集合A中,若是已在集合A中存在,则丢弃掉。蜘蛛对一个站点的遍历抓取策略分为两种,一种是深度优先,另一种就是宽度优先。但是如果是百度这类商业搜索引擎,其遍历策略则可能是某种更加复杂的规则,例如涉及到域名本身的权重系数、涉及到百度本身服务器矩阵分布等。 二.预处理。 预处理是搜索引擎最复杂的部分,基本上大部分排名算法都是在预处理这个环节生效。那么搜索引擎在预处理这个环节,针对数据主要进行以下几步处理: 1.提取关键词。 蜘蛛抓取到的页面与我们在浏览器中查看的源码是一样的,通常代码杂乱无章,而且其中还有很多与页面主要内容是无关的。由此,搜索引擎需要做三件事情:代码去噪。去除掉网页中所有的代码,仅剩下文本文字。②去除非正文关键词。例如页面上的导航栏以及其它不同页面共享的公共区域的关键词。③去除停用词。停用词是指没有具体意义的词汇,例如“的”“在”等。 当搜索引擎得到这篇网页的关键词后,会用自身的分词系统,将此文分成一个分词列表,然后储存在数据库中,并与此文的URL进行一一对应。下面我举例说明。 假如蜘蛛爬取的页面的URL是https://www.doczj.com/doc/cd8947036.html,/2.html,而搜索引擎在此页面经过上述操作后提取到的关键词集合为p,且p是由关键词p1,p2,……,pn组成,则在百度数据库中,其相互间的关系是一一对应,如下图。

《搜索引擎优化指南》 版本号:V1.0@ Baidu 2010 https://www.doczj.com/doc/cd8947036.html,/ 前言 SEO(Search engine optimization,搜索引擎优化),指为了提升网页在搜索引擎 自然搜索结果中(非商业性推广结果)的收录数量以及排序位置而做的优化行为,这一行为的目的,是为了从搜索引擎中获得更多的免费流量,以及更好的展现形象。而SEM (Search engine marketing,搜索引擎营销),则既包括了SEO,也包括了付费的商业推广优化。 毋庸讳言,SEO自从1997 年左右出现以来,就和搜索引擎处于某种对立状态。这种 对立源于两方面: 一方面,大量SEO行为只考虑了如何获得更多的“免费”流量,至于多的这些流量是否 符合搜索用户价值,则不在考虑范围之内。这种SEO被称为“黑帽”,历来受到搜索引擎的 严厉打击。 另一方面,SEO的目的是为了获取更多的“免费”流量,这和搜索引擎的商业推广是对立的。所以很多SEO的从业者,包括相当多的搜索引擎从业者,从心底里认为,两者的利益就是不可调和的。 但如果从更加长远的角度来看,搜索引擎和SEO从业者的利益,实际是有高度一致的 地方的: 首先,搜索引擎的搜索质量改善,很大程度上受到资源形态的影响。比如很多优质资源,是用Flash或者Ajax做的,搜索引擎就无法很好的爬取和索引。搜索引擎无法独立承担起这个引导教育职责,有了SEO参与其中,这些优质资源就可以更好的发挥其检索效果,改善用户搜索体验。 其次,SEO从业者也是搜索引擎商业价值很好的布道者。尤其对于中国这样的新兴市 场,传统的中小企业对于如何触网,如何做互联网营销,并无多少经验。SEO在其中可以扮演非常重要的角色。而这种布道,对于搜索引擎产业价值的拓展,是很有好处的。 基于以上原因,我们需要重新审视搜索引擎和SEO之间的关系。两者宜建立起一种更 加良性的共生关系,驱逐劣币,提携良币,以使互联网生态圈得到更加健康有序的发展。百度作为中文搜索领域的领导者,有责任和义务来推进这个事情。这也是本文档发布的初衷。我们先来看一下过去的问题所在。 (1)黑帽SEO大行其道,占据了SEO主流话语权 黑帽SEO行为,通常就是一般所谓的“搜索引擎作弊”。利用和放大搜索引擎的策略缺 陷(实际上完美的系统是不存在的)获取更多用户访问量。而这种更多的访问量,是以伤害3 百度搜索引擎优化指南 用户体验为代价的,而这会危及一个搜索引擎的生存基础。所以,面对这样的行为,如果短

认识搜索引擎 作者:中国点击金灵 发布日期:10-14-2003 发送本文给你的朋友生成打印机友好页面 从用户角度来看,搜索引擎(Search Engine)是互联网上查找信息的重要工具,帮助人们在茫茫网海中搜寻到所需要的信息;从技术角度来看,搜索引擎一个对互联网上的信息资源进行搜集整理,然后供用户查询的技术和系统,它包括信息搜集、信息整理和用户查询三部分。 按照搜索引擎的工作方式,分为下列4种类型的搜索引擎: (一)以蜘蛛程序为基础的全文搜索引擎(Crawler Based Search Engine) 这种搜索引擎通过蜘蛛程序(英文叫做Robot,Spider或Crawler)自动收录网页,是真正意义上的搜索引擎,国外的Google、Fast(AllTheWeb)、AltaVista、Inktomi都是属于这种类型的搜索引擎。国内的百度过去也是纯粹的全文搜索引擎,后来在搜索结果中引入竞价排名收费模式,当有关键字广告时,所有关键字广告出现在自然搜索结果的前面,国外还没有一个全文搜索引擎敢这么做,因为这会影响搜索引擎的质量。如果百度把关键字广告放在自然搜索结果的边上,而不是直接出现在自然搜索结果中,将是既不影响赚钱又不影响搜索质量的完美做法。 它的工作原理如下: 1.收集网页 搜索引擎定期派出蜘蛛程序自动访问互联网及网站,并沿着网页中的链接爬到其它网页,把爬过的所有网页收集回来。 2.建立网页索引数据库 由搜索引擎的分析索引系统程序对收集回来的网页进行分析,提取相关网页信息(包括网页所在URL、编码类型、页面内容包含的所有关键词、关键词位置、生成时间、大小、与其它网页的链接关系等),根据搜索引擎的相关法算法进行大量复杂的计算,得到每一个网页针对网页内容中及超链中关键词的相关度,然后用这些相关信息建立网页索引数据库。 3.在网页索引数据库中搜索排序 当用户在搜索引擎网站输入关键词搜索后,由搜索引擎的搜索系统程序从网页索引数据库中找到符合该关键词的所有相关网页。因为所有相关网页针对该关键词的相关度早已算好,所以只需按照现成的相关度数值排序,相关度越高,排名越靠前。最后,由搜索引擎的页面生成系统将搜索结果的链接地址和页面内容摘要等内容组织起来返回给用户。 (二)以人工为基础的分类目录(Editor Based Directory) 分类目录索完全依赖手工操作,用户提交网站后,目录编辑人员会亲自浏览所递交的网站,然后根据一套自定的评判标准甚至编辑人员的主观印象,来决定是否接纳所递交的网站,只有接纳的网站才被按照分类存入网址数据库中。分类目录将网站分门别类地存放在相应的目录中,因此用户在查询信息时,可选择关键词搜索,也可按分类目录逐层查索引找。分类目录虽然有搜索功能,但在严格意义上算不上是真正的搜索引擎,仅仅是按目录分类的网站链接列表而已。用户完全可以不用进行关键词查询,仅靠分类目录也可找到需要的信息。具有代表性的分类目录有雅虎(https://www.doczj.com/doc/cd8947036.html,),Open Directory Project(https://www.doczj.com/doc/cd8947036.html,)、LookSmart(https://www.doczj.com/doc/cd8947036.html,),国内的搜狐、新浪、网易上的目录索引服务也都属于这一类。 (三)以其它搜索引擎为基础的元搜索引擎(Meta Search Engine)

《搜索引擎营销》教学大纲 课程编号: 适用专业:09网络营销 学时数:36(实践:18,理论学习:18)学分数:2 执笔者:邹立达编写日期:2010年6月 一、课程的性质和任务 本课程作为网络营销的必修课,是一门工具课,其原则是实用。 通过企业网站推广实践,掌握网站推广方法与技巧,搜索引擎的基本用法、高级应用,SEO技术,网络营销与搜索引擎的关系,了解网络信息资源的分布,熟练掌握在因特网上查找知识的技能,掌握搜索排名技术,从而实现网站的排名优化。 本课程的主要任务是:进行企业网站推广;掌握关键字的选择与布尔操作符的运用,懂得利用搜索引擎快速找到所要的资源;掌握域名选择、主机选择、关键字选择、网页优化等搜索引擎优化技术;学会有效的搜索引擎优化管理来进行企业网站推广应用。 二、课程内容和要求 项目一:搜索引擎的基本操作 了解企业网站推广的方法,熟练掌握搜索引擎的基本操作。 理论企业网站推广方法 介绍企业网站推广方法,搜索引擎的概念,搜索引擎优化的主要内容,SEO技术的应用与发展。掌握信息的概念及搜索引擎优化的主要内容。

介绍搜索引擎的基本用法、高级应用。掌握关键字的选择与布尔操作符的运用,懂得利用搜索引擎快速找到所要的资源。 项目二:搜索引擎优化技术 通过实践,了解关键字选择的重要性,明确公司的宗旨、市场定位、产品的卖点、确定公司的目标及市场号召力,学会为企业网站选择合适的关键字。 理论搜索引擎优化技术 介绍搜索引擎优化技术的分类,掌握域名选择、主机选择、关键字选择、网页优化等搜索引擎优化技术。 项目三:链接策略 通过实验,了解搜索引擎分类目录、高质量导入链接、导出链接和内部链接、关键词链接文本及上下文语意等方法,要求掌握各种链接策略的实现方法。 理论搜索引擎优化的重点--链接策略 介绍搜索引擎分类目录、高质量导入链接、导出链接和内部链接、关键词链接文本及上下文语意等方法,要求掌握各种链接策略。 项目四:搜索引擎优化管理 通过实验,了解搜索引擎优化管理的方法,学会有效的搜索引擎优化管理的方法。 理论搜索引擎优化管理 介绍搜索引擎优化诊断分析、Google沙盒效应(Sandbox Effect)、网站数据更新、Google Dance 、网站流量分析、SEO工具/系统。 了解掌握搜索引擎优化管理的方法,学会有效的搜索引擎优化管理的方法。

搜索引擎按其工作方式主要可分为三种,分别是全文搜索引擎(Full Text Search Engine)、目录索引类搜索引擎(Search Index/Directory)和元搜索引擎(Meta Search Engine)。 全文搜索引擎是名副其实的搜索引擎,国外具代表性的有Google、Fast/AllTheWeb、AltaVista、Inktomi、Teoma、WiseNut等,国内著名的有百度(Baidu)。它们都是通过从互联网上提取的各个网站的信息(以网页文字为主)而建立的数据库中,检索与用户查询条件匹配的相关记录,然后按一定的排列顺序将结果返回给用户,因此他们是真正的搜索引擎。 从搜索结果来源的角度,全文搜索引擎又可细分为两种,一种是拥有自己的检索程序(Indexer),俗称“蜘蛛”(Spider)程序或“机器人”(Robot)程序,并自建网页数据库,搜索结果直接从自身的数据库中调用,如上面提到的7家引擎;另一种则是租用其他引擎的数据库,并按自定的格式排列搜索结果,如Lycos引擎。 目录索引 目录索引虽然有搜索功能,但在严格意义上算不上是真正的搜索引擎,仅仅是按目录分类的网站链接列表而已。用户完全可以不用进行关键词(Keywords)查询,仅靠分类目录也可找到需要的信息。目录索引中最具代表性的莫过于大名鼎鼎的Yahoo雅虎。其他著名的还有

Open Directory Project(DMOZ)、LookSmart、About等。国内的搜狐、新浪、网易搜索也都属于这一类。 元搜索引擎 (META Search Engine) 元搜索引擎在接受用户查询请求时,同时在其他多个引擎上进行搜索,并将结果返回给用户。著名的元搜索引擎有InfoSpace、Dogpile、Vivisimo等(元搜索引擎列表),中文元搜索引擎中具代表性的有搜星搜索引擎。在搜索结果排列方面,有的直接按来源引擎排列搜索结果,如Dogpile,有的则按自定的规则将结果重新排列组合,如Vivisimo。 搜索引擎?有哪些分类? 1、全文搜索引擎又成为“关键字查询” 原理:参看以下资料 方法:参看以下资料 代表性的网站:百度

SEOer利用三要素,四处方把搜索引擎玩转于你的股掌之中认为其实从SEO优化的入门到精通,只有严格遵守三个要素和四个“处方”,你会发现学习的特别轻松,而且能够把搜索引擎玩转于自己的手掌之中。下面霜刀伊郎就来和大家分享一下搜索引擎的三个要素: 一:初探搜索引擎原理 很多站长朋友可能认为搜索引擎原理一定很神秘,很深奥,其实只要找一些相关的SEO 优化教程,比如在A5站长站,就有很多涉及到有关搜索引擎原理的教程,写的都是比较通俗易懂的,无非是通过机器人围绕互联网抓取内容,然后进行索引,再把内容收录到自己的数据库里面,通过内容的质量,和物以类聚人以群分的原则,对于搜索的结果进行排名,从而让用户通过关键词的搜索,就能够找到更加符合用户需求的内容,这就是大概的基本原理,从这些方面了解这些原理对于网站的SEO优化来说就已经足够了! 二:开始分析自己的网站和竞争对手 做网站SEO优化,一定要同时分析自己的优势和竞争对手的优势,因为SEO优化说白了,就是一种竞争的方法,谁的SEO优化水平高,其竞争力就高,所以我们可以通过建设网站的技术比拼,内容更新比拼,网站外链建设比拼等等方面,全方位的分析自己和竞争对手,从而实现快速的超越竞争对手,让自己的网站排名获得更高一点! 不过在这一项的研究中,一定要注意不能够误入歧途,因为现在互联网上有了太多的诱惑,比如黑链诱惑,比如黑帽诱惑,虽然这些方法对于某些类型的网站而言,非常的合适,但是如果你要做一个正规的网站的话,那么选择这样的黑帽优化方法,往往会让自己后悔的,因为现在百度对于黑帽的优化方法比较的反感,这是因为黑帽优化方法,妨碍了百度提供更好的内容给用户,从而影响到自己的权威性,所以一定会严厉的打击,所以如果要想正儿八经的运营网站,最好的方法还是走白帽优化方法! 三:要不断的总结观测

【关键字】教学 全国中小学“教学中的互联网搜索”优秀教学案例评选 《全文搜索引擎的使用技巧》教案设计 一、教案背景 1、面向学生:中学 2、学科:信息技术 2、课时:1 二、教材分析 本节是宁夏回族自治区教育厅中小学教材审查委员会审定,电子工业出版社的《信息技术》八年级上第3单元利用网络资源中获得因特网上的资源,搜索引擎的使用技巧这一内容。在网络成为人们获得信息的主要来源之一的今天,利用网络来获得信息,也必然是学生必须学习的重要手段。搜索引擎的使用在小学四年级下册教材中学生已经学习过了,学生已经知道如何使用搜索引擎进行信息和资源的检索,在本课中教材着重要求学生归纳网络搜索引擎的使用技巧,并引导学生形成合法使用网络的意识,培养学生使用网络获得信息的能力。 三、教学目标: 1、知识与技能 ⑴了解搜索引擎的概念。 ⑵掌握全文搜索引擎的使用方法。 ⑶培养查找信息时关键词的提取和搜索方法的使用素养。 2、过程与方法 创设情境引入搜索引擎的使用,以任务驱动展开搜索引擎的学习。 3、情感态度与价值观 ⑴在日常生活和学习中遇到的问题我们可以使用搜索引擎来解决。 ⑵关注家乡,热爱生活,激发学生学习兴趣。 四、教学重点与难点: 全文搜索引擎的使用方法。(重点) 对查询信息关键词的分析提取及搜索引擎的使用方法的选择。(难点) 五、教学方法 任务驱动法,分组合作学习 导入:进入了信息时代,利用互联网帮助我们解决在学习和生活中遇到的问题,已经成为了现代人必须掌握的一项基本技能。如何通过搜索引擎在海量的网络世界中快速、准确地找到我们需要的信息则是这项技能的最高要求。中学生对网络已有所接触,不少学生可能也使用过搜索引擎,但事实上许多初中生对搜索引擎的基础知识和使用方法还只是一知半解,因此,通过信息技术课的学习使初中生对搜索引擎有一个简单的了解,并掌握搜索引擎基本的使用方法显得非常及时和必要。

Sphinx 全文搜索引擎 1:索引与全文索引的概念 数据库中,表中的行特别多,如何快速的查询某一行,或者某一个文章中的单词, 索引--->查询速度快 全文索引-->针对文章内容中的单词各做索引 2:mysql支不支持全文索引? 答:支持, 但是 A:innoDB引擎在5.5,及之前的版本不支持(5.7实测可以在innodb上建fulltext),只能在myisam 引擎上用fulltext B: mysql的全文索引功能不够强大 C: 无法对中文进行合理的全文索引----- mysql.无法进行中文分词. 注意: 全文索引的停止词 停止词是指出现频率极高的单词, 不予索引. 如果某单词出现频率50%以上,列为停止词 或者是经过统计的常用词,也列为停止词---如is, are , she, he, this 等等 就像中文中: “的”,”是”,”呵呵” 总结: 我们要对中文做全文搜索引擎,需要解决2个问题 1: 性能提高,用第3方的全文搜索引擎工具,如sphinx, solr等 2: 中文分词! (如mmseg)

编译安装sphinx+mmseg == coreseek 官网: https://www.doczj.com/doc/cd8947036.html, 0: 安装工具包 yum install make gcc gcc-c++ libtool autoconf automake imake libxml2-devel expat-devel 1: 下载解压源码,ls查看 csft-4.1 mmseg-3.2.14 README.txt testpack 其中-- csft-4.1是修改适应了中文环境后的sphinx Mmseg 是中文分词插件 Testpack是测试用的软件包 2: 先安装mmseg 2.1: cd mmseg 2.2: 执行bootstrap脚本 2.3: ./configure --prefix=/usr/local/mmseg 2.4: make && make install 3: 再安装sphinx(coreseek) 3.1: 到其目录下执行buildconf.sh 3.2: ./configure --prefix=/usr/local/sphinx --with-mysql=/usr/local/mysql --with-mmseg --with-mmseg-includes=/usr/local/mmseg/include/mmseg/ --with-mmseg-libs=/usr/local/mmseg/lib/ 3.3: make install Sphinx的使用 分三个部分: 1: 数据源---要让sphinx知道,查哪些数据,即针对哪些数据做索引(可以定义多个源) 2: 索引配置--针对哪个源做索引, 索引文件放在哪个目录?? 等等 3: 搜索服务器----sphinx可以在某个端口(默认9312),以其自身的协议,与外部程序做交互. 具体的步骤: 1: 数据源典型配置 source test { type = mysql sql_host = localhost sql_user = root