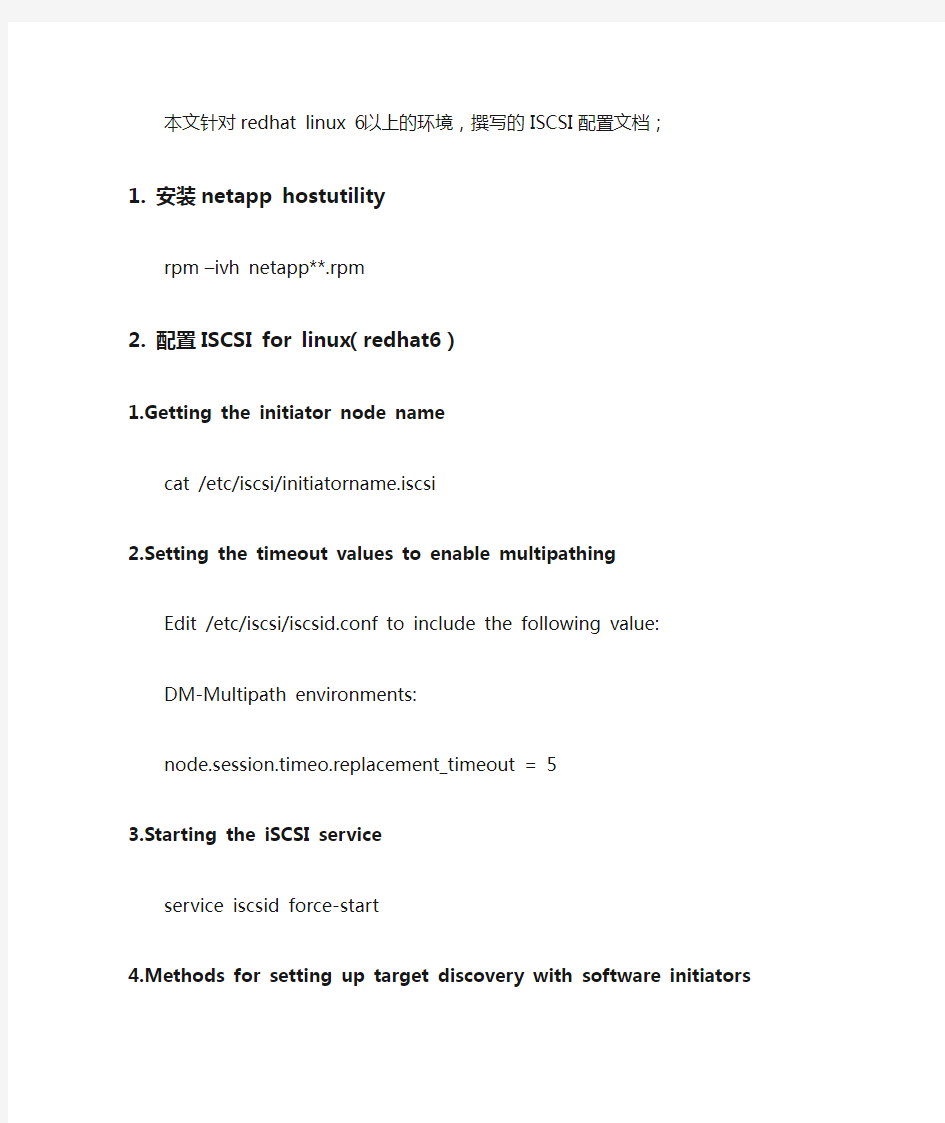

本文针对redhat linux 6以上的环境,撰写的ISCSI配置文档;

1.安装netapp hostutility

rpm –ivh netapp**.rpm

2.配置ISCSI for linux(redhat6)

1.Getting the initiator node name

cat /etc/iscsi/initiatorname.iscsi

2.Setting the timeout values to enable multipathing

Edit /etc/iscsi/iscsid.conf to include the following value:

DM-Multipath environments:

node.session.timeo.replacement_timeout = 5

3.Starting the iSCSI service

service iscsid force-start

4.Methods for setting up target discovery with software initiators iscsiadm --mode discovery --op update --type sendtargets --portal 10.212.50.12 iscsiadm --mode node -l all

iscsiadm --mode session

chkconfig iscsi on

#10.212.50.12——tartget IP

5.Configuring manual or automatic node login

a. Modify the /etc/iscsi/iscsid.conf file to add the following line.

You must specify either manual or automatic:

node.startup = automatic

b. Rediscover the iSCSI target.

iscsiadm --mode discovery --op update --type sendtargets --portal 10.212.50.12 iscsiadm --mode node -l all

iscsiadm --mode session

c. Restart the iSCSI service.

service iscsid restart

3.linux multipath安装配置

1.检查是否安装dm-multipath

rpm -q device-mapper

2.编辑多路径软件配置文件

vi /etc/multipath.conf

With ALUA, use the value ——Set prio to:“alua”

Without ALUA, use the value——Set prio to:“ontap”

3.启动多路径软件

/etc/init.d/multipathd start

chkconfig --add multipathd

chkconfig multipathd on

4.验证多路径软件配置

multipath -v3 -d -ll

/etc/init.d/multipathd status

multipath -ll

4.发现lun

1.(FC, Hardware iSCSI) Discovering new LUNs

To discover a new LUN, enter the following

command:/usr/bin/rescan-scsi-bus.sh

If you do not have a copy of the rescan script, get one. The rescan script is available with the sg3_utils package

2.(Software iSCSI, multipathing) Discovering new LUNs

方法一:

To discover a new LUN,enter the following command:/usr/bin/rescan-scsi-bus.sh

If you do not have a copy of the rescan script, get one. The rescan script is available with the sg3_utils package

方法二:

To discover a new LUN on a system running DM-Multipath, enter one of the following commands:

3.To verify that the new LUNs have been discovered, use the sanlun

command or the iscsiadm command.

1)Viewing a list of LUNs

iscsiadm -m session -P 3 -r 2

2)(Native multipathing) Using sanlun to display M-Multipath information sanlun lun show –p

You can also use the sanlun lun show all command to display more information about your LUN setup, such as whether you are using LUNs mapped with clustered Data ONTAP or Data ONTAP operating in 7-Mode.

5.查看linux主机的FC WWPN号

cat /sys/class/fc_host/host*/port_name

分布式存储平台建设方案 1.分布式存储平台简介 Hadoop的目的是基于一种新的方法来存储和处理复杂的数据。通过把数据均衡分布 到集群上,通过复制副本以确保数据的可靠性和容错。存储和计算都分布到多个机器, 充分体现数据的本地性,现在的很多数据库也都支持数据分片技术, Hadoop可以运行在低配置的Pc Server服务器上面的分布式集群技术,通过把海量数据分布式存储后,通过分布式计算模型来进行海量数据分析。 优势明显: - 效率提高 - 弹性扩容 - 弹性计算 2.分布式存储的趋势 ?Data Scalability: 单台机器的容量不足以(经济的) 承载所有资料,所以需要分散。如:NoSQL ?Computing Scalability: 单台机器的运算能力不足以(经济的) 及时完成运算所以需要分散。 3.分布式存储平台搭建 分布式数据处理框架为用户提供容易使用的并行编程模式、处理海量数据的处理框架,用于对大规模数据集的并行处理。处理能力可以通过增加或减少机器达到动态调整。分布式数据处理框架采用先进的容错技术,确保处理任务的可靠性,即使在异常情况下,如机器宕机、断网的情况下,确保处理任务的实时性和准确性。

分布式数据处理框架是建立在分布式存储和分布式数据库的基础之上。 分布式数据处理框架具有如下特点: ●在高效率并行分布式软件的支撑下,可以实时完成数据处理和分析工作, 如数据处理、数据查询、和统计分析等。数据处理不会出现数据堆积现 象,各类分析和查询工作基本都在秒级完成,具有前所未有的高效性。 ●响应速度快速:采用分布式处理的方式,性能与节点数成正比,通过增 加节点的方式,可将性能提升,以达到满足需求的处理要求。 ●高可靠性:任何一个节点出现故障,系统将自动屏蔽,而且不会出现丢 失数据的现象。 ●可伸缩性:在不停机的情况下,增加节点,平台的处理能力自动增加; 减少节点,平台的处理能力自动缩减。这样,可以做到与资源池的无缝 对接,根据处理和存储任务动态地申请或释放资源,最大限度地提高资 源利用率。 ●高性价比:采用X86架构廉价处理机构建云处理平台,用软件容错替代 硬件容错,大大节省成本。在目标性能和可靠性条件下,可比传统的小 型机加商用数据库方案节省10倍左右的成本。 4.分布式存储平台同步 大数据基础平台的数据库服务包括传统的关系型数据库服务和分布式数据库。 分布式数据库系统使用计算机网络将物理位置分散而管理和控制又需要不同程度集中的多个逻辑单位(通常是集中式数据库系统)连接起来,共同组成一个统一的数据库系统,因此,分布式数据库系统可以看成是计算机网络与数据库系统的有机结合。 分布式数据库具有如下特点: 1、物理分布性:分布式数据库系统中的数据不是存储在一个站点上,而是分散存储在由计算机网络联结起来的多个站点上。 2、逻辑整体性:分布式数据库系统中的数据物理上是分散在各个站点中的,

根据did you know(https://www.doczj.com/doc/cc17292130.html,/)的数据,目前互联网上可访问的信息数量接近1秭= 1百万亿亿 (1024)。毫无疑问,各个大型网站也都存储着海量的数据,这些海量的数据如何有效存储,是每个大型网站的架构师必须要解决的问题。分布式存储技术就是为了解决这个问题而发展起来的技术,下面让将会详细介绍这个技术及应用。 分布式存储概念 与目前常见的集中式存储技术不同,分布式存储技术并不是将数据存储在某个或多个特定的节点上,而是通过网络使用企业中的每台机器上的磁盘空间,并将这些分散的存储资源构成一个虚拟的存储设备,数据分散的存储在企业的各个角落。 具体技术及应用: 海量的数据按照结构化程度来分,可以大致分为结构化数据,非结构化数据,半结构化数据。本文接下来将会分别介绍这三种数据如何分布式存储。 结构化数据的存储及应用 所谓结构化数据是一种用户定义的数据类型,它包含了一系列的属性,每一个属性都有一个数据类型,存储在关系数据库里,可以用二维表结构来表达实现的数据。 大多数系统都有大量的结构化数据,一般存储在Oracle或MySQL的等的关系型数据库中,当系统规模大到单一节点的数据库无法支撑时,一般有两种方法:垂直扩展与水平扩展。 ? 垂直扩展:垂直扩展比较好理解,简单来说就是按照功能切分数据库,将不同功能的数据,存储在不同的数据库中,这样一个大数据库就被切分成多个小数据库,从而达到了数据库的扩展。一个架构设计良好的应用系统,其总体功能一般肯定是由很多个松耦合的功能模块所组成的,而每一个功能模块所需要的数据对应到数据库中就是一张或多张表。各个功能模块之间交互越少,越统一,系统的耦合度越低,这样的系统就越容易实现垂直切分。 ? 水平扩展:简单来说,可以将数据的水平切分理解为按照数据行来切分,就是将表中的某些行切分到一个数据库中,而另外的某些行又切分到其他的数据库中。为了能够比较容易地判断各行数据切分到了哪个数据库中,切分总是需要按照某种特定的规则来进行的,如按照某个数字字段的范围,某个时间类型字段的范围,或者某个字段的hash值。 垂直扩展与水平扩展各有优缺点,一般一个大型系统会将水平与垂直扩展结合使用。 实际应用:图1是为核高基项目设计的结构化数据分布式存储的架构图。

数据存储解决方案: DAS:直接连接存储(Direct Attached Storage) 定义:是将存储设备通过SCSI(小型计算机系统接口)Small Computer System Interface直接连接到计算机主机上(服务器)。是大容量设备到服务器和LAN的最主要方法。在该连接方式中,一组磁盘直接附加到服务器。 目的:为服务器有效拓展存储空间 优点:1.成本比较低廉,部署快捷简单。这是DAS附加存储最大的特点之一。 2.通过简单快捷的方式即可实现大容量存储。 3.可以实现应用服务器与存储设备的分离。 在DAS解决方案中,应用服务器与存储设备是相对独立的。如此可以对数据进行 集中的管理及备份。而且当应用服务器出现故障时,数据也不会丢失。还可以通 过代用的服务器,直接连接到存储设备中,减少系统的宕机时间。 缺点:直连式存储与服务器主机之间的连接通道通常采用SCSI连接,随着服务器CPU的处理能力越来越强,存储硬盘空间越来越大,阵列的硬盘数量越来越多,SCSI通道 将会成为IO瓶颈;服务器主机SCSI ID资源有限,能够建立的SCSI通道连接有限。 NAS:网络连接存储(Network Attached Storage) 定义:将存储设备通过一定的网络拓扑结构(以太网)连接到一群计算机上。在NAS方式下,存储设备直接连接到LAN,存储数据直接在LAN上流动。适用成熟的TCP/IP技术,可以实现远距离的数据存储。 目的:企业数据保护;不同操作系统的文件级共享。 优点:.1.为业务关键数据提供有效保障,可有效避免因为系统硬件故障、应用程序或操作系统出错所导致的数据丢失。 2.部署非常简单,低成本,与TCP/IP网络集成。 3.可实现不同操作系统级的文件级共享。 缺点:.备份过程带宽消耗大,难以在应用层上进行扩展,安全性较差。 适用范围:部门级的存储方法,在于帮助工作组和部门级机构解决迅速增加存储容量的要求。 NAS数据保护型:

NETAPP FAS系列安装配置手册 赞融电子上海分公司 2003年11月

修订控制 1简介 1.1说明 本文简要说明了Network Appliance公司FAS系列存储产品配置过程。 本手册基于DataOntap 6.4.2P6操作系统 1.2适用对象和前提 本文是针对赞融电子的内部人员。要求阅读者具有以下方面的专业能力:熟悉Unix操作系统;熟悉Windows操作系统;具有NETAPP FAS系统的基本知 识. 1.3参考资料 Data ONTAP? System Administrator’s Guide Data ONTAP? Software Setup Guide 1.4术语表 NFS:Network File System 网络文件系统 CIFS:Common Internet File System 通用 Internet文件系统 NAS:Network Attached Storage 网络附加存储 WAFL:Write Anywhere File Layout 随地写入文件格式

2配置过程 2.1检查Filer硬件安装 2.2设置Filer 使用计算机串口连接Filer背板上的Console口 使用Windows附件中的超级终端建立连接,参数如下: 每秒位数 9600,数据位 8,奇偶校验无,停止位 1,数据流控制无 建立连接 依次打开Disk Shelf和Filer电源 使用setup命令配置Filer fas940> setup Please enter the new hostname []: fas940 Do you want to configure virtual network interfaces? [n]: y Number of virtual interfaces to configure? [0] 3 Name of virtual interface #1 []: vif1 Is vif1 a single [s] or multi [m] virtual interface? [m] s Number of links for vif1? [0] 2 Name of link #1 for vif1 []: e5a Name of link #2 for vif1 []: e5b Name of virtual interface #2 []: vif2 Is vif2 a single [s] or multi [m] virtual interface? [m] s Number of links for vif2? [0] 2 Name of link #1 for vif2 []: e9a Name of link #2 for vif2 []: e9b Name of virtual interface #3 []: vif3 Is vif3 a single [s] or multi [m] virtual interface? [m] s Number of links for vif3? [0] 2 Name of link #1 for vif3 []: e11a Name of link #2 for vif3 []: e11b Please enter the IP address for Network Interface vif1 []: 165.204.224.173 Please enter the netmask for Network Interface vif1 [255.255.0.0]: 255.255.254.0 Please enter media type for vif1 {100tx-fd, tp-fd, 100tx, tp, auto (10/100/1000)} [auto]: Enter Please enter the IP address for Network Interface vif2 []: 165.204.224.174 Please enter the netmask for Network Interface vif2 [255.255.0.0]: 255.255.254.0 Please enter media type for vif2 {100tx-fd, tp-fd, 100tx, tp, auto (10/100/1000)} [auto]: Please enter the IP address for Network Interface vif3 []: 165.204.224.175

分布式存储系统的一些理解和实践 张建伟 一、分布式存储系统介绍 1.简介 互联网数据规模越来越大,并发请求越来越高,传统的关系数据库,在很多使用场景下并不能很好的满足需求。分布式存储系统应运而生。它有良好的扩展性,弱化关系数据模型,甚至弱化一致性要求,以得到高并发和高性能。按功能分类,主要有以下几种: ?分布式文件系统 hdfs ceph glusterfs tfs ?分布式对象存储 s3(dynamo) ceph bcs(mola) ?分布式表格存储 hbase cassandra oceanbase ?块存储 ceph ebs(amazon) 分布式存储系统,包括分布式系统和单机存储两部分;不同的系统,虽在功能支持、实现机制、实现语言等方面是有差异的,但其设计时,关注的关键问题是基本相同的。单机存储的主流实现方式,有hash引擎、B+树引擎和LSM树(Log Structured Merge Tree)三种,不展开介绍。本文第二章节,主要结合hbase、cassandra和ceph,讲下分布式系统设计部分,需要关注的关键问题。 2.适用场景 各分布式存储系统功能定位不尽相同,但其适用和不适用的场景,在一定程度上是相同的,如下。

1)适用 大数据量(大于100T,乃至几十PB) key/value或者半结构化数据 高吞吐 高性能 高扩展 2)不适用 Sql查询 复杂查询,如联表查询 复杂事务 二、分布式存储系统设计要点 1.数据分布 分布式存储,可以由成千甚至上万台机器组成,以实现海量数据存储和高并发。那它最先要解决的就是数据分布问题,即哪些数据存储在哪些机器(节点)上。常用的有hash类算法和用meta表映射两种方式。一般完全分布式的设计(无master节点),会用hash类算法;而集中式的设计(有master节点)用meta表映射的方式。两者各有优缺点,后面讲到具体问题时再做比较。 1)一致性hash 将存储节点和操作的key(key唯一标识存储的object,有时也叫object name)都hash到0~2的32次方区间。映射到如下环中的某个位置。沿操作key的位置顺时针找到的第一个节点即为此key的primary存储节点。如下图所示:

1DFS系统 (DFS) 是AFS的一个版本,作为开放软件基金会(OSF)的分布 分布式文件系统 式计算环境(DCE)中的文件系统部分。 如果文件的访问仅限于一个用户,那么分布式文件系统就很容易实现。可惜的是,在许多网络环境中这种限制是不现实的,必须采取并发控制来实现文件的多用户访问,表现为如下几个形式: 只读共享任何客户机只能访问文件,而不能修改它,这实现起来很简单。 受控写操作采用这种方法,可有多个用户打开一个文件,但只有一个用户进行写修改。而该用户所作的修改并不一定出现在其它已打开此文件的用户的屏幕上。 并发写操作这种方法允许多个用户同时读写一个文件。但这需要操作系统作大量的监控工作以防止文件重写,并保证用户能够看到最新信息。这种方法即使实现得很好,许多环境中的处理要求和网络通信量也可能使它变得不可接受。 NFS和AFS的区别 NFS和AFS的区别在于对并发写操作的处理方法上。当一个客户机向服务器请求一个文件(或数据库记录),文件被放在客户工作站的高速缓存中,若另一个用户也请求同一文件,则它也会被放入那个客户工作站的高速缓存中。当两个客户都对文件进行修改时,从技术上而言就存在着该文件的三个版本(每个客户机一个,再加上服务器上的一个)。有两种方法可以在这些版本之间保持同步: 无状态系统在这个系统中,服务器并不保存其客户机正在缓存的文件的信息。因此,客户机必须协同服务器定期检查是否有其他客户改变了自己正在缓存的文件。这种方法在大的环境中会产生额外的LAN通信开销,但对小型LAN来说,这是一种令人满意的方法。NFS 就是个无状态系统。 回呼(Callback)系统在这种方法中,服务器记录它的那些客户机的所作所为,并保留它们正在缓存的文件信息。服务器在一个客户机改变了一个文件时使用一种叫回叫应答(callbackpromise)的技术通知其它客户机。这种方法减少了大量网络通信。AFS(及OSFDCE的DFS)就是回叫系统。客户机改变文件时,持有这些文件拷贝的其它客户机就被回叫并通知这些改变。 无状态操作在运行性能上有其长处,但AFS通过保证不会被回叫应答充斥也达到了这一点。方法是在一定时间后取消回叫。客户机检查回叫应答中的时间期限以保证回叫应答是当前有效的。回叫应答的另一个有趣的特征是向用户保证了文件的当前有效性。换句话说,若

华为存储解决方案

————————————————————————————————作者:————————————————————————————————日期:

华为存储解决方案包括企业级数据备份解决方案、企业级数据容灾解决方案、广域网低带宽环境下的备份解决方案 企业级数据备份解决方案 随着信息技术的不断发展,计算机的存储信息量不断增长,数据备份变的越来越重要。因而,如何保护好计算机系统里存储的数据,保证系统稳定可靠地运行,并为业务系统提供快捷可靠的访问,是系统建设中最重要的问题之一。华为公司针对目前IT信息系统发展的现状,采用华为OceanStor系列存储产品和企业备份恢复领域处于领先的赛门铁克NetBackup平台,提供市场领先的数据备份解决方案。通过对软硬件产品的整合,华为公司致力于向客户提供完备的、智能的、易管理的数据保护解决方案,全面解决客户因新业务的增长而带来的数据保护难题。 解决方案: 华为针对目前企业客户复杂的IT应用特点,根据客户不同需求,定制客户备份策略,全面保护客户的应用,为客户业务系统的健康稳定运行,提供坚实的后盾。主要可以实现以下功能: 集中管理功能 企业的小型机、服务器,工作站等常常分布在多个地点,通过华为的企业级备份方案,可以实现数据备份工作的远程集中管理和维护,并可以实现备份介质集中存放,自动管理,

减少了管理维护的复杂度。 支持多种组网架构 企业客户的业务系统,组网都比较复杂,而且对备份窗口的要求不尽相同。华为企业级备份方案可实现数据LAN-Base、LAN-Free等的备份方式,为不同的数据制定不同的备份方式,不仅满足客户对备份窗口的需求,而且降低了客户总体成本。 全面保护客户数据 ?保护主流的数据库以及其他常用IT应用; ?实现操作系统的快速的灾难恢复; ?从桌面应用到数据中心应用提供端到端的数据保护 ?备份数据生命周期管理 ?确保数据在合适时间存储在恰当的位置; ?将重要数据存储在磁盘上,而将不重要数据存储在磁带上; ?确保从磁盘中删除数据之前,已将数据迁移到磁带; ?利用生命周期策略自动执行数据管理 方案特点: ?华为提供软硬件结合的方案,提供包括备份服务器,软件,存储一体化的方案。通过预配置对产品进行打包,从而降低用户项目的管理风险,减少实施时间,为客户提供统一的服务; ?采用业界兼容性最好、成功应用案例最广泛的NetBackup数据保护软件,可以保护几乎所有的操作系统平台和数据库、应用; ?提供最宽广的数据保护平台:在同一平台上可以提供包括备份、重复数据删除、连续数据保护等数据保护方案; ?基于磁盘的数据保护:除了传统磁带解决方案之外,NetBackup结合OceanStor磁盘阵列等存储设备,使用磁盘来提供数据保护,充分发挥了磁盘在备份领域的优势。其中包括支持智能磁盘设备或环境中日常使用的现有磁盘。

由于用户数量的不断攀升,我对访问量大的应用实现了可扩展、高可靠的集群部署(即lvs+keepalived的方式),但仍然有用户反馈访问慢的问题。通过排查个服务器的情况,发现问题的根源在于共享存储服务器NFS。在我这个网络环境里,N个服务器通过nfs方式共享一个服务器的存储空间,使得 NFS服务器不堪重负。察看系统日志,全是nfs服务超时之类的报错。一般情况下,当nfs客户端数目较小的时候,NFS性能不会出现问题;一旦NFS服务器数目过多,并且是那种读写都比较频繁的操作,所得到的结果就不是我们所期待的。 下面是某个集群使用nfs共享的示意图: 这种架构除了性能问题而外,还存在单点故障,一旦这个NFS服务器发生故障,所有靠共享提供数据的应用就不再可用,尽管用rsync方式同步数据到另外一个服务器上做nfs服务的备份,但这对提高整个系统的性能毫无帮助。基于这样一种需求,我们需要对nfs服务器进行优化或采取别的解决方案,然而优化并不能对应对日益增多的客户端的性能要求,因此唯一的选择只能是采取别的解决方案了;通过调研,分布式文件系统是一个比较合适的选择。采用分布式文件系统后,服务器之间的数据访问不再是一对多的关系(1个NFS服务器,多个NFS 客户端),而是多对多的关系,这样一来,性能大幅提升毫无问题。 到目前为止,有数十种以上的分布式文件系统解决方案可供选择,如 lustre,hadoop,Pnfs等等。我尝试了 PVFS,hadoop,moosefs这三种应用,参看了lustre、KFS等诸多技术实施方法,最后我选择了moosefs(以下简称MFS)

这种分布式文件系统来作为我的共享存储服务器。为什么要选它呢?我来说说我的一些看法: 1、实施起来简单。MFS的安装、部署、配置相对于其他几种工具来说,要简单和容易得多。看看lustre 700多页的pdf文档,让人头昏吧。 2、不停服务扩容。MFS框架做好后,随时增加服务器扩充容量;扩充和减少容量皆不会影响现有的服务。注:hadoop也实现了这个功能。 3、恢复服务容易。除了MFS本身具备高可用特性外,手动恢复服务也是非常快捷的,原因参照第1条。 4、我在实验过程中得到作者的帮助,这让我很是感激。 MFS文件系统的组成 1、元数据服务器。在整个体系中负责管理管理文件系统,目前MFS只支持一个元数据服务器master,这是一个单点故障,需要一个性能稳定的服务器来充当。希望今后MFS能支持多个master服务器,进一步提高系统的可靠性。 2、数据存储服务器chunkserver。真正存储用户数据的服务器。存储文件时,首先把文件分成块,然后这些块在数据服务器chunkserver之间复制(复制份数可以手工指定,建议设置副本数为3)。数据服务器可以是多个,并且数量越多,可使用的“磁盘空间”越大,可靠性也越高。 3、客户端。使用MFS文件系统来存储和访问的主机称为MFS的客户端,成功挂接MFS文件系统以后,就可以像以前使用NFS一样共享这个虚拟性的存储了。 元数据服务器安装和配置

IBM数据中心存储解决方案 数据集中 数据是企业最宝贵的资产 数据集中可以使企业充分利用信息资源 数据中心的核心是数据 数据存储需要存储设备 存储设备的安全性决定着企业数据的安全性 存储设备的性能决定着企业数据的效率 当前,我们正处在一个信息爆炸的时代,数据的存储量已经不仅仅是用 KB、MB、GB甚至TB来计算,在不远的将来,人们所谈论的将是PB(1petabyte=1,000terabytes)甚至 EB(1exabyte=1,000petabytes)。根据IDC公司的统计报告,企业数据的增长速度是每九个月增长100%。在企业的作业系统和数据采掘中,大量的、频繁的数据移动将会对用户的区域网或者广域网造成巨大的影响。此外,如何使分布的存储设备(存储农场,Storage Farm)更加有效的运行,也是摆在每个用户的问题。 从计算机的发展历史来看,从最早的服务器 /客户机模式,到今天的网络计算环境,今后的移动计算环境,对数据的请求不再受时间和空间的限制。随之而来的问题是,当前的数据多分布在与服务器相连的独立存储之上,从而造成所谓的“信息孤岛”的现象。这使数据的存储、利用、分析和管理都非常地复杂。

越来越多的用户已经意识到这种数据分散带来的问题: 总拥有成本的升高和信息技术系统效率的降低;技术支持与行政管理人员的增加;缺乏统一的标准;系统安全与数据完整性的风险增加;软件投入与硬件维护费用呈螺旋上升的趋势;计算机资源利用的低效率;无法在企业整体围实行应用与数据的统一;为财务管理、数据分析和资产控制带来困难;用户虽然拥有的数据,但是无法将这些数据发挥更大的效益,难以实现数据分析、数据采掘、决策支持等商务智能的工作。 存储区域网 采用存储区域网,可以通过快速的、专用的光纤网络,将上百个甚至几千个存储设备连接起来,组成低成本的、易于管理的存储区域网络。存储区域网不仅可以减少数据移动对现有的网络系统的压力,从而降低存储的成本,而且可以通过将存储设备的集中,方便地进行监视和调整,从而实现灵活方便的管理。 从业务集中的步骤来看,存储集中是企业进行数据集中的基础,只有实现了存储集中,即数据的集中,才能实现今后的数据中心大集中。采用存储集中后,企业将能够更有效地利用数据,从而实现:

目录

第1章存储高可用性给业务连续运营提供保障 (1) 1.1为什么要构建存储高可用性解决方案 (1) 1.2存储高可用性解决方案简述 (2) 1.3存储高可用性解决方案价值 (2) 第2章IBM存储高可用性解决方案介绍 (3) 2.1存储高可用性的内容 (3) 2.2存储高可用性方案的主要实现方式 (4) 第3章IBM高可用性存储产品介绍 (11) 3.1 IBM SYSTEM STORGE DS8000 TURBO系列存储产品 (11) 3.2 IBM SYSTEM STORAGE DS5000系列存储产品 (17) 3.3 IBM SYSTEM STORAGE DS4000系列存储产品 (20) 第4章为什么选择IBM (22) 第5章IBM中国公司简介 (23) 第1章存储高可用性给业务连续运营提供保障 1.1 为什么要构建存储高可用性解决方案 随着社会的发展和科技的进步,企业越来越依赖于数据处理来进行业务运营,对IT 系统的依赖性也随之增加。一旦数据由于某种原因丢失,就有可能造成整个组织在运营上的重大不便和经济损失,企业的信誉也将受到

影响。如果核心数据丢失,严重时完全有可能造成整个企业的瘫痪。所以保证企业的业务连续运营及数据处理的高可靠性和高可用性,就成为所有IT 人员在建设IT 基础架构中首先要考虑的问题。 显然,企业所面临的风险和挑战来自多方面: ?无法预知的IT 硬件设备的损坏、断电、火灾、自然灾害、恐怖袭击等,造成数据丢失或业务的突然中断; ?系统人员误操作造成意外宕机或关键数据丢失,无法避免; ?手段频多的黑客攻击、病毒入侵、垃圾邮件、网络与系统的漏洞,造成网络瘫痪、系统崩溃; ?用户需要实时应用与访问机密、关键数据,向企业的服务提出更高的要求; ?行业与政府的标准与法规的不断变化,进一步增加了企业的压力与成本。 信息是企业的最宝贵的资产之一;集中的数据备份、恢复和管理已经成为企业数据存储管理的重要任务。企业需要的是: ?数据与存储系统的高可用性,保证数据7X24 小时的连续访问; ?将现有的存储技术集成,创造出一种更有效的数据存储管理,实现高效、高可靠性、低成本的数据管理; ?需要一套成熟度高,业内应用广泛的企业级软硬件整体解决方案; ?需要对企业现有的数据库、邮件系统、文件服务器以及各种应用系统进行集中化、自动化的基于策略的保护; ?易于IT部门日常的管理维护,界面友好,可操作性强; ?能够符合企业日后发展需求,对异构平台有很好的支持,可以满足将来远程数据灾备的需求;

海量图片的分布式存储设计与实现 一、研究背景:性能与资金,二者可兼得? 1.1 那么问题来了? 随着互联网的发展,许多大中型的网站都保存了大量的图片资源,用户在访问这些图片资源异常丰富的网站(如淘宝、京东等电子商务网站)时,网页中的图片信息占据了页面数据流量的很大部分,那么问题也来了: (1)由于受客户端浏览器限制,无法从一台服务器上同时下载页面中所有图片信息; PS:当一个网页被浏览时,Web服务器与浏览器建立连接,每个连接表示一个并发。当页面包含多个图片时,Web服务器与浏览器会产生多个连接,同时发送文字和图片以提高浏览速度。因此,页面中图片越多Web服务器受到的压力也就越大。同时由于受到浏览器本身的并发连接数限制(2个~6个并发),意味着页面上有多于并发连接数限制的图片时,也不能并行地把所有图片同时下载和显示。 (2)由于图片保存在物理服务器上,访问图片需要频繁进行I/O操作:因此当并发用户数越来越多时,I/O操作就会成为整个系统的性能瓶颈; (3)由于受操作系统的限制,一个目录中能存放的图片文件数量也是有限的:随着图片资源不断增加,如何有效管理和维护图片也是一个难题; 1.2 如何解决问题? (1)对于少数大型网站系统,由于自身具有雄厚的资金和人力资源,可采用NFS、CDN、Lighttpd、反向代理、负载均衡等技术提高用户访问速度;但是,这些技术需要庞大的资金来支持。 (2)对于多数中小型网站系统,有没有一种方案适用于中等规模商务网站的海量图片数据分布式动态存储及负载均衡的解决方案?该方案可否只需增加很少的硬件成本,即可提升网站的访问速度,并且可以根据需要动态调整图片服务器的数量及图片的存储目录,确保系统具有可扩展性和伸缩性。 二、架构设计:构建图片服务器集群 对于小型网站,由于数据规模小,可以把网站所有页面和图片统一存放在一

汉柏科技 分布式存储系统要点 王智民 汉柏科技有限公司

分布式存储系统 分布式存储系统,有块存储、对象存储、文件存储,有不同的开源项目如Ceph、GlusterFS、Sheepdog、Swift,还有不同的商业实现如Google、AWS、微软、金山、七牛、又拍、阿里云还有Qingcloud 首先对象存储和文件存储的区别是不大的,存储的都是一样的东西,只是抛弃了统一 的命名空间和目录树的结构,使得扩展起来桎梏少一些。 独立的互联网存储服务一般都是做对象存储的,因为块存储是给计算机用的,对象存 储是给浏览器等HTTP客户端用的。

分布式存储系统的三个问题 ?对于一套分布式存储的方案,怎样评估它是好还是不好? ?如何对分布式存储的不同实现进行分类? ?分布式存储中的“数据可靠性”是如何计算的? 1.运行或在线系统需要高性能 2.离线或备份数据需要高容量,低价格 3.所有的数据都必须是可靠的,绝对不能丢 ?对于块存储,要求的访问时延是 10ms 级的,因为给虚拟机用的,传统硬盘也是 10ms 级的时延,请求尺寸都很小,但qps(iops)可能会很高,那么在这种情况下: ?异地多中心是不现实的,存储要和主机尽量接近,相应地可靠性必然会有所打折 ?强一致副本不会过多,强一致要求对时延有影响 ?对于对象存储,要求的访问时延是 100ms - 1s 级的,请求一般是中到大尺寸,低 qps 的,在这种情况下 ?可以用更多的分散副本数来换取更高的可靠性,但过多副本增加维持一致性的难度,需要折衷

分布式存储系统的三个问题 ?对于一套分布式存储的方案,怎样评估它是好还是不好? ?如何对分布式存储的不同实现进行分类? ?分布式存储中的“数据可靠性”是如何计算的? 按照存储接口来划分 1.对象存储: 也就是通常意义的键值存储,其接口就是简单的GET、PUT、DEL和其他扩展,如七牛、又拍、Swift、S3 2.块存储: 这种接口通常以QEMU Driver或者Kernel Module的方式存在,这种接口 需要实现Linux的Block Device的接口或者QEMU提供的Block Driver接口,如Sheepdog,AWS的EBS,青云的云硬盘和阿里云的盘古系统,还有Ceph的RBD(RBD是Ceph面向块存储的接口) 3.文件存储: 通常意义是支持POSIX接口,它跟传统的文件系统如Ext4是一个类型的,但区别在于分布式存储提供了并行化的能力,如Ceph的CephFS(CephFS是Ceph面向文件存储的接口),但是有时候又会把GFS,HDFS这种非POSIX接口的类文件存储接口归入此类。

1.非结构化数据存储 在上图中,描述了非结构化数据存储架构的基本组成部分,其中: 1. 文件存取统一接口,封装了对数据中心所以非结构化数据的读写操作接口。 2. Hadoop HDFS 负责对大文件的存储,以HDFS:为文件协议标准 3. HBase 通过维护一张文件表完成对小文件的存储,以HBase:为文件协议标识1.1文件存取统一接口 1.1.1 文件存储接口 对文件进行存储前,接口根据文件的大小和HDFS文件分块的配置大小进行比较,当文件超过设定大小时,接口认为该文件是大文件,直接分配到HDFS文件存储接口进行写入;否则当文件小与块大小时,根据系统维护的Hbase小文件存储通用存储表进行存储管理。

1. 对直接存储到HDFS的文件,则文件路径以HDFS为中心存储文件协议头,文件路径则根据该文件的业务属性做完文件的路径,文件名称保留原有名称,例如:HDFS://aaa/bbb.zip 2. 对通过Hbase管理的小文件,则文件路径以HBASE为中心存储文件协议头,文件路径不需要分文件夹,直接以文件的唯一标识标识即可,例如:HBASE://uuid 1.1.2 文件读取接口 文件读取时,通过识别URL,确定文件的存储方式,然后找到对应的存储接口获取文件。

1.1H adoop HDFS存储接口 完成大文件的存储与读取接口操作。 1.2H base存储接口 文件通用存储表结构: 表存在两个列簇,default列簇负责存储基础属性信息,用一个单独的列簇存储图片内容。 HBase是采用面向列的存储模型,按列簇来存储和处理数据,即同一列簇的数据会连续存储。HBase在存储每个列簇时,会以Key-Value的方式来存储每行单元格(Cell)中的数据,形成若干数据块,然后把数据块保存到HFile中,最后把HFile保存到后台的HDFS 上。由于用单元格 (Cell)存储图片小文件的内容,上述存储数据的过程实际上隐含了把图片小文件打包的过程。默认情况下,HBase数据块限制为64KB。由于图片内容作为单元格(Cell)的值保存,其大小受制于数据块的大小。在应用中需根据最大图片大小对HBase数据

基于HDFS的分布式文件系统存储研究与优化传统的存储系统无法满足呈爆炸性增长的海量数据存储需求,分布式文件系统应运而生,如今已得到广泛应用。传统的分布式文件系统通常采用多副本技术来保证数据的可靠性。 对于副本系数为3的系统,一份数据被切分为几个块,每个块的3个副本分别存储在不同的数据节点。这种备份方法最大的缺点是需要极大的额外存储开销。 随着数据量的增长,所需的存储空间增长速度将远远大于硬件设备的扩展速度,存储开销将成为数据中心的一个主要成本瓶颈。纠删码技术只需要较少的额外开销就可以获得很高的数据可靠性。 而所有的纠删码中,里德所罗门码(Reed-Solomon Codes,RS码)最为常用。纠删码技术应用于分布式文件系统能显著降低存储开销、提高数据可靠性,但在修复丢失的数据时,需要付出极大的代价。 就修复单个块而言,部署了里德所罗门码系统的带宽和I/O开销甚至达到了三副本系统的12倍。为此,本文提出了一个改进的RS码方案。 在RS码的基础上,通过添加额外的校验块,改善RS码的局部性。对于 RS(12,4)码,12个数据块生成4个校验块(全局校验块),我们仅需在这个基础上将12个数据块分成3组,每组4个块,每4个块生成一个额外校验块(局部校验块),就能使原RS码的局部性由12降为4。 这意味着原来修复单个块需要读取和传输12个块,现在仅需4个块,极大的降低了修复所需的磁盘I/O和网络带宽开销。另外,本文证明了当丢失单个全局校验块时,同样能够利用三个局部校验块进行快速恢复。 因为系统无需为全局校验块生成额外的校验块,因此提高了存储效率。我们

通过标准马尔可夫模型估算两种不同方案的平均数据丢失时间,来进行可靠性比较,结果表明改进后的方案可靠性达到了原RS码将近100倍。 同时,我们将优化方案的代码部署到了Hadoop HDFS中,并和部署了RS码的HDFS做比较。实验结果表明,优化后的方案仅以19%的额外存储空间为代价,使系统修复单个块错误时的磁盘I/O和网络开销降为原来的39%。 因为修复效率更高,所以改进后的方案同时能为系统提供更高的可靠性。

块存储与分布式存储 块存储,简单来说就是提供了块设备存储的接口。通过向内核注册块设备信息,在Linux 中通过lsblk可以得到当前主机上块设备信息列表。 本文包括了单机块存储介绍、分布式存储技术Ceph介绍,云中的块存储Cinder,以及华为软件定义的存储解决方案。 单机块存储 一个硬盘是一个块设备,内核检测到硬盘然后在/dev/下会看到/dev/sda/。因为需要利用一个硬盘来得到不同的分区来做不同的事,通过fdisk工具得到/dev/sda1, /dev/sda2等,这种方式通过直接写入分区表来规定和切分硬盘,是最死板的分区方式。 分布式块存储 在面对极具弹性的存储需求和性能要求下,单机或者独立的SAN越来越不能满足企业的需要。如同数据库系统一样,块存储在scale up的瓶颈下也面临着scale out的需要。 分布式块存储系统具有以下特性: 分布式块存储可以为任何物理机或者虚拟机提供持久化的块存储设备; 分布式块存储系统管理块设备的创建、删除和attach/detach; 分布式块存储支持强大的快照功能,快照可以用来恢复或者创建新的块设备; 分布式存储系统能够提供不同IO性能要求的块设备。 现下主流的分布式块存储有Ceph、AMS ESB、阿里云磁盘与sheepdog等。 1Ceph 1.1Ceph概述 Ceph目前是OpenStack支持的开源块存储实现系统(即Cinder项目backend driver之一) 。Ceph是一种统一的、分布式的存储系统。“统一的”意味着Ceph可以一套存储系统同时提供对象存储、块存储和文件系统存储三种功能,以便在满足不同应用需求的前提下简化部署

技术层次图 各技术简介 1.1mybatis简介 MyBatis 是支持普通SQL查询,存储过程和高级映射的优秀持久层框架。MyBatis 消除

了几乎所有的JDBC代码和参数的手工设置以及结果集的检索。MyBatis 使用简单的XML 或注解用于配置和原始映射,将接口和Java 的POJOs(Plain Old Java Objects,普通的Java对象)映射成数据库中的记录。 每个MyBatis应用程序主要都是使用SqlSessionFactory实例的,一个SqlSessionFactory实例可以通过SqlSessionFactoryBuilder获得。SqlSessionFactoryBuilder可以从一个xml配置文件或者一个预定义的配置类的实例获得。 用xml文件构建SqlSessionFactory实例是非常简单的事情。推荐在这个配置中使用类路径资源(classpath resource),但你可以使用任何Reader实例,包括用文件路径或file://开头的url创建的实例。MyBatis有一个实用类----Resources,它有很多方法,可以方便地从类路径及其它位置加载资源。 1.2webservice简介 Web service是一个平台独立的,低耦合的,自包含的、基于可编程的web的应用程序,可使用开放的XML(标准通用标记语言下的一个子集)标准来描述、发布、发现、协调和配置这些应用程序,用于开发分布式的互操作的应用程序。 1.3jquery简介

jQuery UI 是以jQuery 为基础的开源JavaScript 网页用户界面代码库。包含底层用户交互、动画、特效和可更换主题的可视控件。我们可以直接用它来构建具有很好交互性的web应用程序。所有插件测试能兼容 jQuery UI包含了许多维持状态的小部件(Widget),因此,它与典型的jQuery 插件使用模式略有不同。所有的jQuery UI 小部件(Widget)使用相同的模式,所以,只要您学会使用其中一个,您就知道如何使用其他的小部件(Widget)。 1.4springmvc简介 Spring MVC属于SpringFrameWork的后续产品,已经融合在Spring Web Flow里面。Spring 框架提供了构建Web 应用程序的全功能MVC 模块。使用Spring 可插入的MVC 架构,可以选择是使用内置的Spring Web 框架还可以是Struts 这样的Web 框架。通过策略接口,Spring 框架是高度可配置的,而且包含多种视图技术,例如JavaServer Pages(JSP)技术、Velocity、Tiles、iText 和POI。Spring MVC 框架并不知道使用的视图,所以不会强迫您只使用JSP 技术。Spring MVC 分离了控制器、模型对象、分派器以及处理程序对象的角色,这种分离让它们更容易进行定制。 1.5spring简介 Spring是一个开源框架,Spring是于2003 年兴起的一个轻量

分布式存储技术及应用 根据did you know(https://www.doczj.com/doc/cc17292130.html,/)的数据,目前互联网上可访问的信息数量接近1秭= 1百万亿亿 (1024)。毫无疑问,各个大型网站也都存储着海量的数据,这些海量的数据如何有效存储,是每个大型网站的架构师必须要解决的问题。分布式存储技术就是为了解决这个问题而发展起来的技术,下面让将会详细介绍这个技术及应用。 分布式存储概念 与目前常见的集中式存储技术不同,分布式存储技术并不是将数据存储在某个或多个特定的节点上,而是通过网络使用企业中的每台机器上的磁盘空间,并将这些分散的存储资源构成一个虚拟的存储设备,数据分散的存储在企业的各个角落。 具体技术及应用: 海量的数据按照结构化程度来分,可以大致分为结构化数据,非结构化数据,半结构化数据。本文接下来将会分别介绍这三种数据如何分布式存储。 结构化数据的存储及应用 所谓结构化数据是一种用户定义的数据类型,它包含了一系列的属性,每一个属性都有一个数据类型,存储在关系数据库里,可以用二维表结构来表达实现的数据。 大多数系统都有大量的结构化数据,一般存储在Oracle或MySQL的等的关系型数据库中,当系统规模大到单一节点的数据库无法支撑时,一般有两种方法:垂直扩展与水平扩展。 ?垂直扩展:垂直扩展比较好理解,简单来说就是按照功能切分数据库,将不同功能的数据,存储在不同的数据库中,这样一个大数据库就被切分成多个小数据库, 从而达到了数据库的扩展。一个架构设计良好的应用系统,其总体功能一般肯定 是由很多个松耦合的功能模块所组成的,而每一个功能模块所需要的数据对应到 数据库中就是一张或多张表。各个功能模块之间交互越少,越统一,系统的耦合 度越低,这样的系统就越容易实现垂直切分。 ?水平扩展:简单来说,可以将数据的水平切分理解为按照数据行来切分,就是将表中的某些行切分到一个数据库中,而另外的某些行又切分到其他的数据库中。为 了能够比较容易地判断各行数据切分到了哪个数据库中,切分总是需要按照某种 特定的规则来进行的,如按照某个数字字段的范围,某个时间类型字段的范围, 或者某个字段的hash值。 垂直扩展与水平扩展各有优缺点,一般一个大型系统会将水平与垂直扩展结合使用。 实际应用:图1是为核高基项目设计的结构化数据分布式存储的架构图。