●唐晓波,房小可(武汉大学信息资源研究中心,湖北武汉430072)

基于文本聚类与LDA 相融合的微博主题检索模型研究

*

*

本文为国家自然科学基金项目“社会化媒体集成检索与语义分

析方法研究”的成果,项目编号:71273194。

摘

要:伴随着微博的日趋流行,对微博信息的检索逐渐成为人们获取第一消息的手段。其中文本聚类和主题发现

是信息检索领域的有效方法,采用适当的方法是影响微博短文本信息检索质量的关键因素。文章针对文本聚类和LDA 主题模型的互补特征,综合考虑了微博特殊文体和短文本聚类效率问题,提出了基于频繁词集的文本聚类和基于类簇的LDA 主题挖掘相融合的微博检索方法,给出了针对微博文体的一种新的主题检索模型。实验表明,该方法不仅能有效地划分微博文本,并且能清晰地挖掘类簇中潜在主题。

关键词:文本聚类;主题检索;微博

Abstract :With the daily popularity of micro-blog ,the search of micro-blog information has gradually become the method of people to obtain the first-hand news.Text clustering and topic discovery are the effective methods in the information retrieval https://www.doczj.com/doc/cf9264604.html,ing the appropriate method is the key factor affecting the information retrieval quality of micro-blog short text.Based on the com-plementary characteristics of text clustering and LDA topic model ,and considering the special style of micro-blog and the clustering efficiency of short text comprehensively ,this paper proposes a micro-blog retrieval method integrating the text clustering based on frequent word set with the LDA topic excavation based on class cluster ,and gives a new topic retrieval model for micro-blog style.The experiment shows that this method can not only divide micro-blog text effectively ,but also excavate the latent topic in the class cluster clearly.

Keywords :text clustering ;topic retrieval ;micro-blog 随着信息技术和互联网的发展,社会化媒体以各种形式迅速发展并崛起。这标志着以“社会网络”为核心的新一代互联网服务正在壮大,并逐渐融入到人们的日常生活中。微博以其强大的用户群,已经成为一个巨大的装载信息的平台,是用户传播和获取信息的重要途径之一。新浪微博在2011年10月20日推出独立的微博搜索(ht-tp ://https://www.doczj.com/doc/cf9264604.html, );腾讯的搜搜检索推出微博实时搜索(http ://https://www.doczj.com/doc/cf9264604.html, )功能。但是目前微博的搜索采取的方式与传统的关键词搜索方式区别不大,加之微博内容本身具有文本短小特征,传统的搜索方式不足以满足用户的需求。因此,对微博这种具备特殊特征的文体,选取有效的方法对微博信息进行检索,最大程度地满足用户需求是当前亟待解决的重要问题。

针对文本聚类检索和主题检索,国内外已经开展了许多研究工作,都是目前信息检索领域的热点研究内容。与检索密切相关的文本聚类的近期研究成果以文献[1-5]为代表,实现了算法的应用或在原有研究的基础上进行算法改进,有效地提高了对海量数据检索效果。徐硕等人提

出了共现聚类分析的新方法:最大频繁项集挖掘[6]

,在这

之前的研究表明,利用频繁词集性质针对短文本进行聚类

的效果显著

[7-8]

。然而,文本聚类算法中的很多参数是人

为确定的,即聚类后的主题数目一般是确定的,很难发现簇中潜在的主题。在主题模型LDA (Latent Dirichlet Allo-cation )提出以后,以其可以发现潜在主题等优势,被广泛地用于文本主题挖掘,弥补了前文阐述的文本聚类的不足。张晨逸、孙建伶等人通过对LDA 模型的改进,提出了基于MB-LDA 模型的微博主题挖掘[9]

。王力、李培峰等

人提出了基于LDA 模型的主题句抽取方法,取得了较好

的效果

[10]

。但是,在国内极少有学者研究基于LDA 模型

的检索。在国外,Ma Dashun 等人对单个文档建立LDA 主题模型,实现了信息检索[11]

。Wei Xing 和W.B.Croft 对

LDA 模型进行改进,提出了用于检索的LDA 文档模型,

实现了有效检索

[12]

。然而,实际研究表明,单纯地使用

LDA 进行检索效果并不理想,正因为如此,本文用文本聚类的方法给予弥补,实现类簇中的主题发现。综上所述,对于微博短文本,关键词出现的次数很少,仅仅依靠关键词的比较无法获得较好的检索效果。因此,本文在已有的研究基础上,利用文本聚类和LDA 主题模型互补的优势,提出了基于频繁词集文本聚类与LDA 潜在主题发现相结

合的检索模型,以期缩小检索空间,使其适用于中文微博短文本的处理和分析,实现微博信息的有效检索。

1

相关理论基础

1.1

文本聚类的基本原理

聚类技术是信息检索领域的一个重要方面,利用它可

以有效缩减搜索空间,加快检索速度,提高检索精度。文本聚类主要是依据著名的聚类假设:同类的文档相似度大,而不同类的文档相似度较小。快速和高质量的文本聚类可以将大量信息组织成若干个有意义的簇,从而改善检索性能

[13]

。文本聚类方法通常先利用向量空间模型,把

文档转换成高维空间中的向量,然后对这些向量聚类。由于中文文档没有词的边界,所以一般先用中文分词软件对文档进行分词处理,然后再把文档转换成向量,通过特征词抽取后形成样本矩阵,最后进行聚类,文本聚类的一般输出为文档集合的一个划分[14]

。

1.2

LDA 主题模型的基本原理

主题模型是一种使用概率的产生式模型来挖掘文本主

题的新方法[15]

。LDA 是Blei 等在2003年提出的一种统计

主题模型

[16]

,是近年发展起来的一种重要提取潜在主题

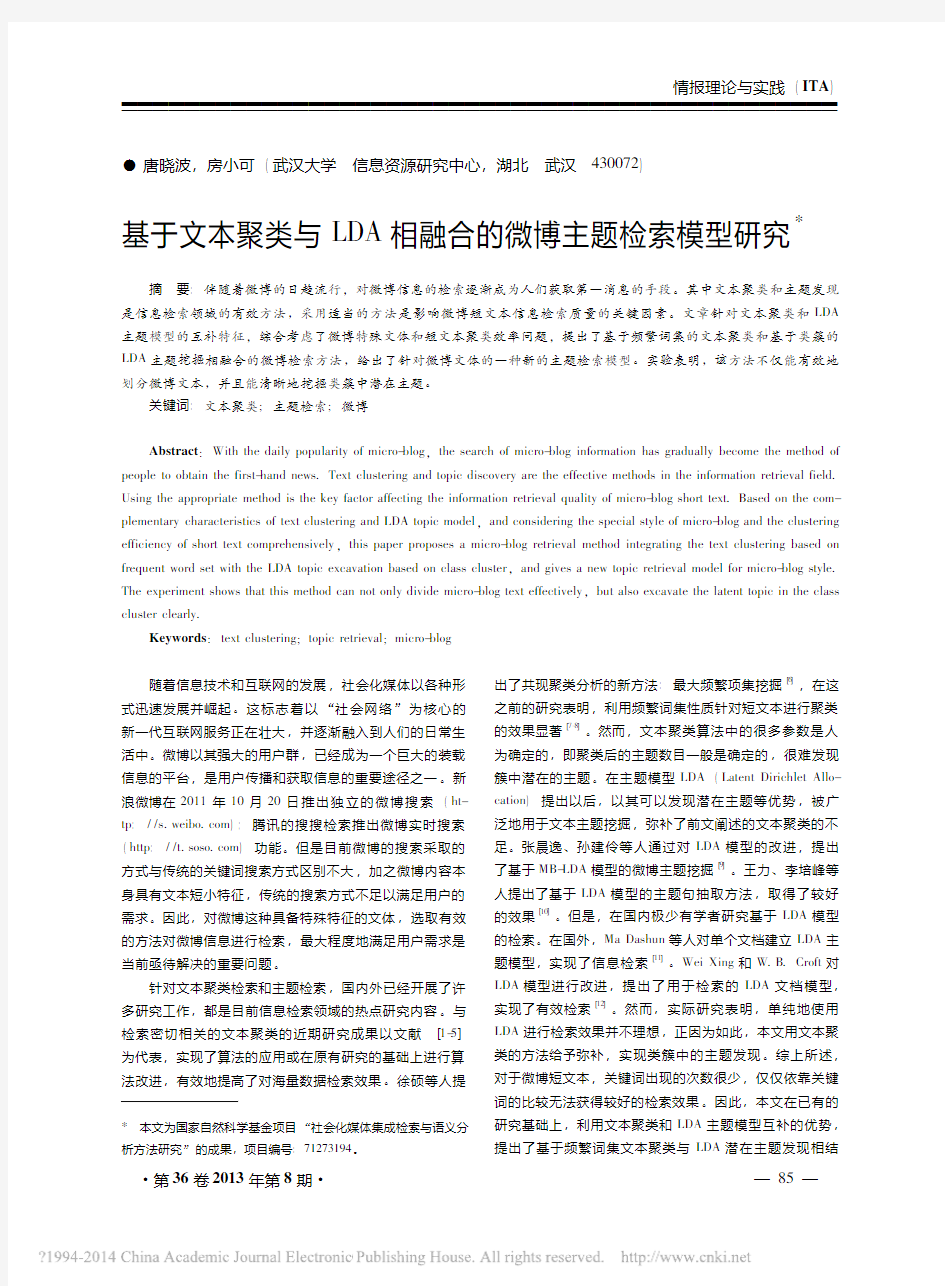

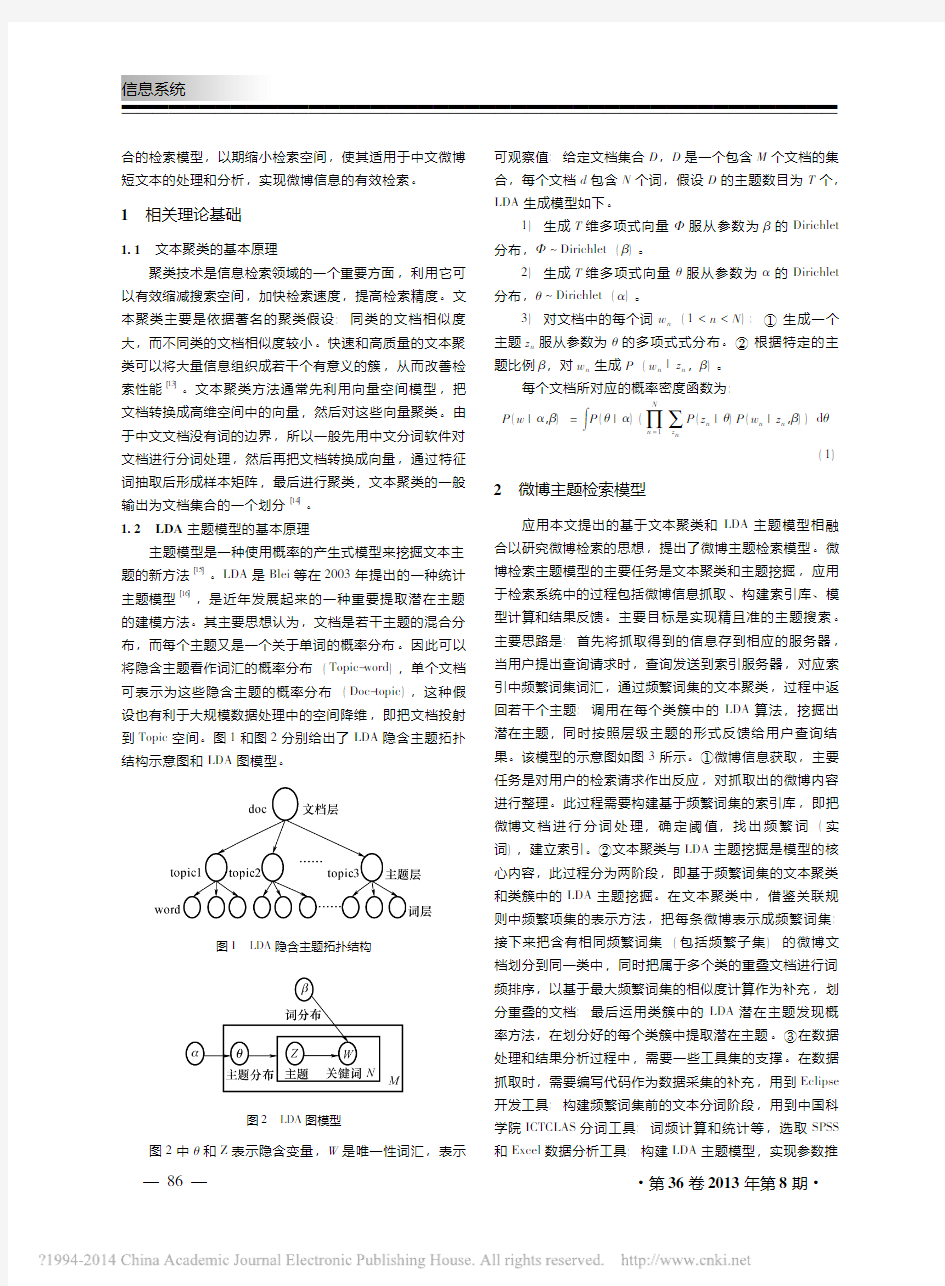

的建模方法。其主要思想认为,文档是若干主题的混合分布,而每个主题又是一个关于单词的概率分布。因此可以将隐含主题看作词汇的概率分布(Topic-word ),单个文档可表示为这些隐含主题的概率分布(Doc-topic ),这种假设也有利于大规模数据处理中的空间降维,即把文档投射到Topic 空间。图1和图2分别给出了LDA 隐含主题拓扑结构示意图和LDA 图模型

。

图1LDA

隐含主题拓扑结构

图2LDA 图模型

图2中θ和Z 表示隐含变量,W 是唯一性词汇,表示

可观察值;给定文档集合D ,D 是一个包含M 个文档的集合,每个文档d 包含N 个词,假设D 的主题数目为T 个,LDA 生成模型如下。

1)生成T 维多项式向量Φ服从参数为β的Dirichlet 分布,Φ Dirichlet (β)。

2)生成T 维多项式向量θ服从参数为α的Dirichlet 分布,θ Dirichlet (α)。

3)对文档中的每个词w n (1<n <N ):①生成一个主题z n 服从参数为θ的多项式式分布。②根据特定的主题比例β,对w n 生成P (w n |z n ,β)。

每个文档所对应的概率密度函数为:

P (w |α,β)=∫

P (θ|α)(∏N

n =1

∑z n

P (z n |θ)P (w n |z n ,β))d θ

(1)

2微博主题检索模型

应用本文提出的基于文本聚类和LDA 主题模型相融

合以研究微博检索的思想,提出了微博主题检索模型。微博检索主题模型的主要任务是文本聚类和主题挖掘,应用于检索系统中的过程包括微博信息抓取、构建索引库、模型计算和结果反馈。主要目标是实现精且准的主题搜索。主要思路是:首先将抓取得到的信息存到相应的服务器,当用户提出查询请求时,查询发送到索引服务器,对应索引中频繁词集词汇,通过频繁词集的文本聚类,过程中返回若干个主题;调用在每个类簇中的LDA 算法,挖掘出潜在主题,同时按照层级主题的形式反馈给用户查询结果。该模型的示意图如图3所示。①微博信息获取,主要任务是对用户的检索请求作出反应,对抓取出的微博内容进行整理。此过程需要构建基于频繁词集的索引库,即把微博文档进行分词处理,确定阈值,找出频繁词(实词),建立索引。②文本聚类与LDA 主题挖掘是模型的核心内容,此过程分为两阶段,即基于频繁词集的文本聚类和类簇中的LDA 主题挖掘。在文本聚类中,借鉴关联规则中频繁项集的表示方法,把每条微博表示成频繁词集;接下来把含有相同频繁词集(包括频繁子集)的微博文档划分到同一类中,同时把属于多个类的重叠文档进行词频排序,以基于最大频繁词集的相似度计算作为补充,划分重叠的文档;最后运用类簇中的LDA 潜在主题发现概率方法,在划分好的每个类簇中提取潜在主题。③在数据处理和结果分析过程中,需要一些工具集的支撑。在数据抓取时,需要编写代码作为数据采集的补充,用到Eclipse 开发工具;构建频繁词集前的文本分词阶段,用到中国科

学院ICTCLAS 分词工具;词频计算和统计等,选取SPSS 和Excel 数据分析工具;构建LDA 主题模型,实现参数推

图3基于文本聚类与LDA的微博主题检索模型理,用到数学软件Matlab工具;同时,在数据清洗、词语

过滤等阶段除了用编码实现外,还需要人工的参与,进一

步判断。下面对模型中的关键技术进行进一步阐释。

2.1基于频繁词集的微博文本聚类

目前,国内对中文文本聚类的研究主要包括利用概率

统计的方法、基于训练学习的方法生成概念空间,或通过

自定义模糊概念图描述概念空间、潜在语义分析技术等。

采用传统的数据挖掘方法处理文本数据前,必须先将文本

数据转化为一定意义的向量空间模型或后缀树模型等。其

中,用TF-IDF(Term Frequency Inerse Document Frequen-

cy)将文档转化为向量模式,并计算文本相似度的方法被

大量应用。但是由于针对类似微博内容的中文短文本形式

的聚类,其上的关键词出现的次数是很少的,直接运用该

方法得到的相似度与实际情况偏离比较严重,不能达到预

期的聚类效果。因此,本文实现基于频繁词集的微博文本

聚类,以该方法作为补充,进而进行重叠文档的相似度计

算。借鉴文献[8]的思想,并对其进行了扩展,实际包

括两部分内容,其一为基于频繁词集的文本压缩,其二为

基于最大频繁词集的相似度文档去重。

2.1.1基于频繁词集的微博文本压缩微博作为具有代

表性的社会化媒体,以其高关注度成为海量信息的载体,

因此对这样的数据进行基于频繁词集的压缩后,对于后期

的数据处理具有重要的意义。首先给出频繁词集相关

定义。

定义1(支持度):给定文本集合D,词集X的支持度为同时包含X中所有词语的文本数量,其中X表示文档中的一系列词,记为sup(X)。

定义2(频繁词集):设一个文本数据库TDB由一系列的文档构成,每个文档表示为<tid,X>。其中tid 为文档的唯一ID。设T={t

1

,t

2

,…,t

n

}为词的集合,Y是T的第一个非空子集。如果sup(Y)≥α,则称Y为一个频繁词集,其中α为一个阈值(最小支持度)。如果对于Y的任意超级Z,均有sup(Z)<α,则称Y为集合D上的最大频繁词集。

微博文本压缩的基本思想可描述为以下3个过程。

1)对每个微博文本进行分词处理,对应语料库去除无实际意义的虚词和代词,得到每个文档的词集,记作

D

i ={t

1

,t

2

,…,t

n

}。其中D

i

表示第i个文档的词集。2)设定阈值α,计算每个微博文档词集中的频繁词

集,记作T i={t1,t2,…,t n}。其中T i表示第i个微博文档的频繁词集。

3)为每个频繁词集创建一个簇,所有包含了该频繁词集的文档都划分到该簇中,每个频繁词集所覆盖的文档,用频繁词集和文档数量来表示;当微博文档出现第二次被划分,则标记2,同时调用词频排序算法,实现词频由高到低的序列。

2.1.2基于最大频繁词集的相似度文档去重在完成文本压缩之后,比较容易从大规模微博信息中,获取频繁词集所覆盖的文档划分。对于重叠的文档部分(交集),当用户输入检索词的时候,该部分所在词指向的文档并没有明确的划分,导致检索结果过大,查准率低。需要适当的方法去除文档的重叠,使得重叠的文档划分到适当类簇中。

根据关联规则中,最大频繁项集的任何子集都是频繁项集这个性质,易得出重叠的文档中必定存在词数相对较多的最大频繁词集。此外,由于最大频繁词集隐含了高频词语(只含有一个词汇的频繁词集),而且在该集合中高频词语并不独立出现,避免了高频孤立的词语,这也给文

档进行相似度计算提供了更加准确的条件。在第一次划分的时候,重叠的文档已被标记,这里选取与所涉及类簇中频繁词集相同的词数(从高词频开始计数)为特征向量的数目。例如:文档D i被同时划分到C a和C b两个类簇中,其中C a存在频繁词集Y a={w2,w3},C b存在频繁词集Y b={w1,w2},D i存在最大频繁词集Y i={w1,

w 2,w

3

},计算过程当中可得到D

i

中最大频繁词集中的词

频排序,假设排序结果为w1,w3,w2,根据所涉及类簇中频繁项数,取w1,w3为待相似度计算的特征向量。在基于传统的向量空间模型和频繁词集的文本特征向量表示的基础上,得到D a,和D b两个文档的相似度计算公式:

cos(D

a ,D

b

)=

∑n

i=1

w'

ai

w'

bi

∑n

i=1

w2

槡ai∑n i=1w2

槡bi

(2)

其中,w'ai和w'bi为频繁词集中高频词语的权重,可分别用TF-IDF计算得出,这里不再赘述。

2.2基于类簇中LDA的微博潜在主题挖掘

至此已经完成了微博文本的第一层聚类,即利用频繁词集进行聚类。由于微博数据的数量巨大,因此第一次聚类后所得的簇中内容相对比较多,很多潜在主题并未被充分挖掘。此外,考虑到微博信息的书写方式不如传统文本的书写正式,用户的随意性比较大,语义信息较为分散,主题性和主题域较为不明显,因此考虑从基于领域的角度对微博信息进行主题建模,可以加强聚类后领域特性主题的区分度。相同领域用户的微博信息主题提取使得文本信息更完善,专业性主题信息较强的词汇在文档中的比例更高,一定程度上可以提高检索性能,这也是本文提出基于类簇中LDA的主题挖掘的原因之一。接下来就类簇中LDA建模方法和模型推导进行阐述。

2.2.1建模方法LDA模型采用概率的方式生成模型,以此实现文档的建模。对微博进行文本分析主题建模时,微博中的一条消息为一篇文档,微博消息中所描述的语义为需要分析挖掘的主题结构,即每条微博文本都可以表示成一系列主题的混合分布,记为P(z);同时每个主题是频繁词表中所有词语上的概率分布,由于LDA模型采用词袋方法,需要考虑文本的词频,从之前的基于频繁词集聚类过程中可得到频繁词,得到的频繁词即为LDA模型中所指的词汇,记为P(w|z)。由此,一条微博文本中每个单词的概率分布如下所示:

P(w

i

)=∑T

j=1P(w

i

|z

i

=j)P(z

i

=j)(3)

LDA是一个完备的主题模型,它生成文本的过程可以用上面介绍的图1来表示。首先,LDA从频繁词集聚类中所得的β的Dirichlet分布中抽取主题与词汇关系;LDA 生成一个文本时,再从参数为α的Dirichlet分布中抽样出该微博文本与各个主题之间的关系θd;从参数为θd的多项式分布中抽样出当前词汇所属的主题z dn;最后从参数主题与词汇关系的多项式分布中抽取具体的词汇w dn。

LDA模型下,类簇中微博信息进一步的生成过程表示如下:

1)For each topic

Draw a distribution over wordsβ

k

Dirichlet(η);

2)For each microblog d

Draw a vector of topic proportionsθ

d

Dirichlet(α);

For each word

Draw a topic assignment z

dn

Multinomial(θ

d

);

Draw a word w

dn

Multinomial(β

z dn

);

2.2.2模型推导对于LDA生成模型,能通过文档基于主题的分布选择一个主题,然后根据主题基于词汇的分布生成一个词语,不断重叠最终生成一篇文档。但是对于已知的微博信息,词汇是可以观察得到的信息,而主题是隐藏的变量信息,是未知的。因此需要通过概率后验推断出能合理生成该文档的主题模型,同时得出每个主题基于词汇的分布。对于微博每个类簇中的文档的词汇信息,通过概率后验分布挖掘出文档的主题信息的概率后验分布公式如下:

P(θ,z|w,α,β)=

P(θ,z,w|α,β)

P(w|α,β)

(4)式子中分子展开如下:

P(θ,z,w|α,β)=P(θ|α)∏N

n=1

P(z

n

|θ)P(w

n

|z

n

,β)

(5)计算上式边缘分布,可得:

P(D|α,β)=∏M

d=1

∫P(θd|α)(∏N d

n=1

∑

z dn

P(z

dn

|θ

d

)

?P(w

dn

|z

dn

,β))dθ

d

(6)然而,该后验概率的计算十分复杂,难以实现,需要通过近似求解的方法。本文采用Gibbs抽样的方法进行推导。Gibbs抽样是一种MCMC(Markov chain Monte Carlo)的抽样方法,常被用于贝叶斯图模型中的求解,能有效地获得模型中的文档主题概率分布和主题词汇分布。例如,要获取高维分布中样本X的值,X为N维变量,对于X的样本值x,x i的值通过条件概率分布P(x i|x1,x2,…,

x

i-1

,x

i+1

,…,x

n

)得到公式如下:

P(z

i

=j|z

-i

,w

i

,d

i

)∝

C WT

w i j

+β

∑W

w=1

C WT

w i j

+Wβ

?

C DT

d i j

+α

∑T

t=1

C DT

d i j

+Tα

(7)

在Gibbs抽样过程中,通过对上述公式反复迭代使得抽样结果达到稳定。

3实验及结果分析

3.1实验工具

实验工具为中国科学院分词软件ICTCLAS,统计分析工具SPSS和Excel,Java集成工具Eclipse3.7.3和JDK 1.6.0,以及数值矩阵工具Matlab7.6.0。

3.2实验结果分析

对于上述模型,笔者并没有应用于检索系统,而是验证了方法的可行性。本文的样本来自于“新浪微博”,它

是由新浪公司开发的一款国内主流的微博产品,作为样本具有一定的代表性。新浪微博分有很多版块,如“微博达人”、“微话题”等,属于微博本身的应用。为了更清晰地支持本文的方法,笔者选取自己关注的微博作为实验数据。抓取工具采用火狐浏览器的两个插件Datascraper和Metastudio来获取新浪微博数据,爬取的数据为XML格式文档,编写Java程序将其合并,形成语料库。从2012年10月8日至2012年10月12日,每天上午9点至10点随机抓取微博内容,共得到微博数量10127条。为了便于后续分析,对微博文档集合进行分词,共得到14682个词(包括单个词语),最高词频达到5763次,而词频在4以下的词语占语料库的78.8%。这是因为微博的发布者为普通用户,微博中的词语为日常用语,比较少的使用术语,因此微博的长尾特征非常明显。本文选取词频为40以上的词语为特征词(不包括单个字词语),且只保留动词和名词。通过前文介绍的基于频繁词集的文本聚类方法,得到“音乐”、“手机”、“旅游”等类簇,其中类簇为“音乐”的频繁词集共2492条,部分频繁词集挖掘结果如表1所示。

表1部分频繁词集挖掘结果

ID频繁词集

1{分享,百度}

2{音乐,分享}

3{古典,音乐}

4{喜欢,放松,音乐}

5{歌曲,分享,高潮}

6{歌曲,摇滚,声音,金属}

7{音乐会,国际,旋律,现场}

8{音乐会,俄罗斯,盛典,古典}

9{免费,下载,收费,唱片,

国际}

10{喜欢,支持,纯正,摇滚,音质,现场}…………

此时,每条微博由频繁词集表示,当用户输入检索词时,进入索引库,通过链接便可以搜索到相关信息。然而,当用户想进一步得知“音乐会”方面信息时,由于关键词的限制,使得搜索得到的结果并不令人满意。因此,需要对“音乐”类簇进一步挖掘主题。

通过对“音乐”类簇的挖掘,构建特征词文档(words.txt)和词频文档(word_frequent.txt),其中词频文档以词语ID号和频数为元数据(ID:Frequent)。设Gibbs 抽样的主题数目T为3,每个初始值最多迭代100次收敛,运用公式(7)进行反复迭代,得到的主题和主题下词的概率如图4所示。

图4基于“音乐”类簇的LDA主题挖掘结果从挖掘的结果中可知,对于“音乐”类簇,存在3个潜在主题,图4中只展示了每个主题的一部分信息,即一部分关键词和隶属于该主题的概率信息。根据各个主题的高频关键词可以发现,Topic1是音乐会相关信息的主题,Topic2是歌曲本身相关信息的主题,Topic3是唱片公司相关信息的主题。这说明基于类簇的LDA主题模型挖掘得到的主题,其关键词准确率高,主题之间的独立性强,很容易根据关键词得出相关主题。

综合以上实验可知,将文本聚类和LDA相结合的方法,不仅能够比较准确地得出海量微博短文本的划分类簇,而且能够实现在类簇上进一步挖掘主题的目的,能很好地将复杂信息层次化地显示出来,实现用户对实时信息的搜索和利用。

4结束语

微博自出现到被用户广泛使用,并作为表达观点及分享信息的平台,已有近6年光阴。国外很多网站如https://www.doczj.com/doc/cf9264604.html,,已经基本实现了社会化媒体的集成搜索,国内虽然推出了相应的微博搜索,但由于微博文体的特殊性,传统算法得到的搜索结果并不十分令用户满意。基于此,本文引入了一种新的微博主题检索模型,即运用基于频繁词集的文本聚类与类簇内LDA主题模型相

融合的方法,实现了海量微博短文本的精且准的主题检索。运用频繁词构建索引库,并通过基于频繁词集的文本聚类,省去了构建向量空间模型和复杂的计算,充分利用了可以利用的信息。通过基于类簇的主题发现,可以挖掘出领域中的潜在主题,对于检索的准确性作出了一定程度的贡献;通过参数的设定,基本上可以得到比较满意的结果。今后,笔者将对微博检索相关内容作进一步研究。包括对上述算法进行改进,降低算法复杂度,提高算法效率;建立该算法的社会化媒体搜索系统,实现主题内容的深度搜索;引入用户信息,将用户的知名度等因子加入到检索因素中,实现检索结果重排;对各种社交媒体,如SNS、博客、微博等实现集成检索,充分利用社会化媒体的信息资源,为用户提供实时信息等。□

参考文献

[1]赵学锋,陈传红,等.基于文本聚类的电子零售商信誉维度发现研究[J].情报学报,2011,30(1):69-75.[2]徐斌,张玉峰.基于语义准则函数的中文评论性文本极性聚类算法研究[J].情报学报,2011,30(5):451-455.[3]庞观松,蒋盛益,等.Web搜索结果多层聚类方法研究[J].情报学报,2011,30(5):464-470.

[4]吴江宁,王桂才.文本聚类分析结果可视化方法研究[J].情报学报,2011,30(2):115-120.

[5]李凤林,何洲芳.基于关键词共现分析的检索结果聚类研究[J].情报学报,2011,30(8):819-825.

[6]徐硕,乔晓东,等.共现聚类分析的新方法:最大频繁项集挖掘[J].情报学报,2012,31(2):143-150.

[7]王永恒,贾焰,等.基于频繁词集聚类的海量短文分类方法[J].计算机工程与设计,2007,28(8):1744-1746.[8]王永恒,贾焰,等.海量短语信息文本聚类技术研究[J].计算机工程,2007,33(14):38-40.

[9]张晨逸,孙建伶,等.基于MB-LDA模型的微博主题挖掘[J].计算机研究与发展,2011,48(10):1795-1802.[10]王力,李培峰,等.一种基于LDA模型的主题句抽取方法[EB/OL].http://https://www.doczj.com/doc/cf9264604.html,/kcms/detail/11.2127.

TP.20111024.1013.054.html/2011,10,24.

[11]MA Dashun,RAO Lan,WANG Ting.An empirical study of SLDA for information retrieval[J].InformationRetrieval

Technology,2011(1):84-92.

[12]WEI Xing,CROFT W B.LDA-based document models for Ad-hoc retrieval[C]//Proceeding of the29th Annual Interna-

tional ACM SIGIRConference onResearch and Development in

InformationRetrieval,2006.

[13]黄如花.信息检索[M].武汉:武汉大学出版社,2010.[14]吴启明,易云飞.文本聚类综述[J].河池学院学报,2008,28(2):86-91.

[15]LUKINS S K,KRAFT N A,ETZKORN L H.Source code re-trieval for bug localization using latent dirichlet allocation[C].

Working Conference onReverse Engineering,2008.

[16]BLEI D,NG A,JORDAN https://www.doczj.com/doc/cf9264604.html,tent dirichlet allocation[J].Journal of Machine LearningResearch,2003(3).

作者简介:唐晓波,男,教授,博士生导师。

房小可,女,博士生。

收稿日期:2012-03-04

(上接第98页)

[4]SHARIFI H,ZHANG Z.A methodology for achieving agility in manufacturing organizations:an introduction[J].Internation-

al Journal of Production Economics,1999,62(112).[5]SARKIS.Benchmarking for agility[J].Benchmarking,2001,8(2):88-117.

[6]LIANG D,WILHELM W E.Decomposition schemes and ac-celeration techniques in application to production-assembly-dis-

tribution system design[J].Computers&OperationsRe-

search,2008,35:10-26.

[7]DAVIDSON III W N,WORRELL D L.Research notes and communications:the effect of product recall announcements on

shareholder wealth[J].Strategic Management Journal,1992

(3):467-473.

[8]KORETZ G.How recalls shake stocks[J].Business Week,1997,13(1):30.

[9]路琨,赵涛.企业缺陷产品的召回管理机制[J].经济管理,2004(23):22-26.

[10]GUNASEKARAN.Agile manufacturing:a framework for re-search and development[J].International Journal of Produc-

tion Economics,1999,62:87-105.

[11]石磊.敏捷与精敏供应链范式研究评介[J],外国经济与

管理,2007,29(5):16-22.

[12]ABAIRRA.Agile manufacturing:this is not just repackaging of material requirements planning and just-in-time[C]//An-

nual International Conference Proceedings-American Produc-

tion and Inventory Control Society,1995:196-198.

[13]DOWLATSHAHI S,CAO Qing.The relationships among virtu-al enterprise,information technology,and business perform-

ance in agile manufacturing:an industry perspective[J].Eu-

ropean Journal of OperationalResearch,2006,174(2).[14]FORSYTHE S.Human factors in agile manufacturing:a brief overview with emphasis on communications and information in-

frastructure[J].Human Factors and Ergonomics in Manufac-

turing,1997,7(1):3-10.

[15]张光明.缺陷产品召回管理预警体系研究[D].青岛:青岛大学,2009.

[16]黄继鸿,雷战波,凌超.经济预警方法研究综述[J].系统工程,2003,21(2):64-70.

[17]李明,基于批次管理的产品追踪技术及溯源机理研究[D].重庆:重庆大学,2008.

作者简介:李春好,男,1967年生,博士,教授。

代磊,男,1982年生,博士生。

收稿日期:2013-02-26