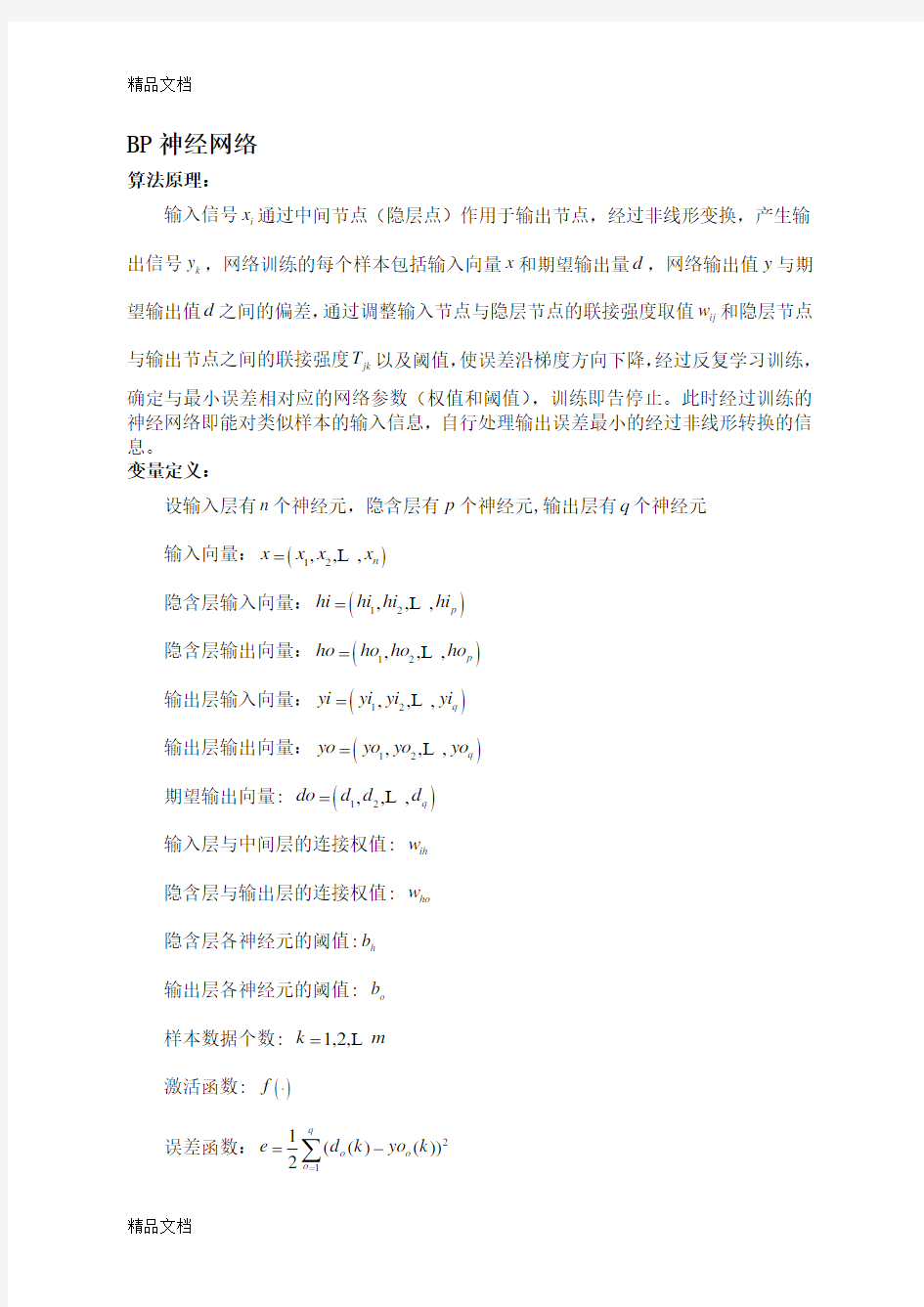

BP 神经网络

算法原理:

输入信号i x 通过中间节点(隐层点)作用于输出节点,经过非线形变换,产生输出信号k y ,网络训练的每个样本包括输入向量x 和期望输出量d ,网络输出值y 与期望输出值d 之间的偏差,通过调整输入节点与隐层节点的联接强度取值ij w 和隐层节点与输出节点之间的联接强度jk T 以及阈值,使误差沿梯度方向下降,经过反复学习训练,确定与最小误差相对应的网络参数(权值和阈值),训练即告停止。此时经过训练的神经网络即能对类似样本的输入信息,自行处理输出误差最小的经过非线形转换的信息。

变量定义:

设输入层有n 个神经元,隐含层有p 个神经元,输出层有q 个神经元 输入向量:()12,,,n x x x x =L

隐含层输入向量:()12,,,p hi hi hi hi =L 隐含层输出向量:()12,,,p ho ho ho ho =L 输出层输入向量:()12,,,q yi yi yi yi =L 输出层输出向量:()12,,,q yo yo yo yo =L 期望输出向量: ()12,,,q do d d d =L 输入层与中间层的连接权值: ih w 隐含层与输出层的连接权值: ho w 隐含层各神经元的阈值:h b 输出层各神经元的阈值: o b 样本数据个数: 1,2,k m =L 激活函数: ()f ?

误差函数:21

1(()())2q

o o o e d k yo k ==-∑

算法步骤:

Step1.网络初始化 。给各连接权值分别赋一个区间(-1,1)内的随机数,设定误差函数e ,给定计算精度值ε和最大学习次数M 。

Step2.随机选取第k 个输入样本()12()(),(),,()n x k x k x k x k =L 及对应期望输出

()12()(),(),,()q d k d k d k d k =L o

Step3.计算隐含层各神经元的输入()1()()1,2,,n

h ih i h i hi k w x k b h p ==-=∑L 和输出

()

()(())1,2,,h h ho k f hi k h p ==L 及

输出层各神经元的输入

()1

()()1,2,p

o ho h o h yi k w ho k b o q ==-=∑L 和输出()()(())1,2,,o o yo k f yi k o p ==L

Step4.利用网络期望输出和实际输出,计算误差函数对输出层的各神经元的偏导数()o k δ。

o

ho o ho

yi e e w yi w ???=??? (())

()

()p

ho h o o h

h ho

ho

w ho k b yi k ho k w w ?-?==??∑

2

1

1((()()))2(()())()(()())f (())()

q

o o o o o o

o o

o o o o d k yo k e d k yo k yo k yi yi d k yo k yi k k δ=?-?'==--??'=---∑@ Step5.利用隐含层到输出层的连接权值、输出层的()o k δ和隐含层的输出计算误差函数对隐含层各神经元的偏导数()h k δ。

()()o

o h ho o ho

yi e e k ho k w yi w δ???==-??? 1()

()(())

()

()

h ih h ih n

ih i h h i i ih

ih

hi k e e w hi k w w x k b hi k x k w w =???=

????-?==??∑

21

21

211

1

1((()()))

()2()()()

1((()f(())))

()2()()

1(((()f(())))

()2()()

(()())f (())q

o o o h h h h q

o o o h h h q

p

o ho h o o h h h h o o o ho

o d k yo k ho k e hi k ho k hi k d k yi k ho k ho k hi k d k w ho k b ho k ho k hi k d k yo k yi k w =====?-??=

????-?=

???--?=

??'=--∑∑∑∑1

()

()

(())f (())()

q

h h q

o ho h h o ho k hi k k w hi k k δδ=??'=--∑∑@ Step6.利用输出层各神经元的()o k δ和隐含层各神经元的输出来修正连接权值

()ho w k 。

1()()()()()

ho o h ho N N

ho ho o h e

w k k ho k w w w k ho k μ

μδηδ+??=-=?=+

Step7.利用隐含层各神经元的()h k δ和输入层各神经元的输入修正连接权()ih w k 。

1()

()()()()()()

h ih h i ih h ih N N

ih ih h i hi k e e w k k x k w hi k w w w k x k μ

μδηδ+????=-=-=???=+

Step8.计算全局误差。

211

1(()())2q

m o o k o E d k y k m ===-∑∑ Step9.判断网络误差是否满足要求。当误差达到预设精度或学习次数大于设定的

最大次数,则结束算法。否则,选取下一个学习样本及对应的期望输出,返回到第三步,进入下一轮学习。

算法流程图:

参数确定:

确定了网络层数、每层节点数、传递函数、初始权系数、学习算法等也就确定了BP网络。确定这些选项时有一定的指导原则,但更多的是靠经验和试凑。

1. 样本数据

采用BP神经网络方法建模的首要和前提条件是有足够多典型性好和精度高的样本。而且,为监控训练(学习)过程使之不发生“过拟合”和评价建立的网络模型的性能和泛化能力,必须将收集到的数据随机分成训练样本、检验样本(10%以上)和

测试样本(10%以上)3部分。

2.输入/输出变量 一般地,BP 网络的输入变量即为待分析系统的内生变量(影响因子或自变量)数,一般根据专业知识确定。若输入变量较多,一般可通过主成份分析方法压减输入变量,也可根据剔除某一变量引起的系统误差与原系统误差的比值的大小来压减输入变量。输出变量即为系统待分析的外生变量(系统性能指标或因变量),可以是一个,也可以是多个。一般将一个具有多个输出的网络模型转化为多个具有一个输出的网络模型效果会更好,训练也更方便。

3.数据的预处理

由于BP 神经网络的隐层一般采用Sigmoid 转换函数,为提高训练速度和灵敏性以及有效避开Sigmoid 函数的饱和区,一般要求输入数据的值在0~1之间。因此,要对输入数据进行预处理。一般要求对不同变量分别进行预处理,也可以对类似性质的变量进行统一的预处理。如果输出层节点也采用Sigmoid 转换函数,输出变量也必须作相应的预处理,否则,输出变量也可以不做预处理。但必须注意的是,预处理的数据训练完成后,网络输出的结果要进行反变换才能得到实际值。再者,为保证建立的模型具有一定的外推能力,最好使数据预处理后的值在0.2~0.8之间。

标准化:

min

max min

d d d d d αβ-'=

?+-

4.隐层数

一般认为,增加隐层数可以降低网络误差,提高精度,但也使网络复杂化,从而增加了网络的训练时间和出现“过拟合(overfitting)” 造成网络的性能脆弱,泛化能力(generalization ability)下降。Hornik 等早已证明:若输入层和输出层采用线性转换函数,隐层采用Sigmoid 转换函数,则含一个隐层的MLP 网络能够以任意精度逼近任何有理函数。显然,这是一个存在性结论。在设计BP 网络时可参考这一点,应优先考虑3层BP 网络(即有1个隐层)。

图 三层BP 网络的拓扑结构

5.隐层节点数

1 x

2 x 1

N

x

在BP 网络中,若隐层节点数太少,网络可能根本不能训练或网络性能很差;若隐层节点数太多,虽然可使网络的系统误差减小,但一方面使网络训练时间延长,另一方面,训练容易陷入局部极小点而得不到最优点,也是训练时出现“过拟合”的内在原因,但是目前理论上还没有一种科学的和普遍的确定方法。为尽可能避免训练时出现“过拟合”现象,保证足够高的网络性能和泛化能力,确定隐层节点数的最基本原则是:在满足精度要求的前提下取尽可能紧凑的结构,即取尽可能少的隐层节点数。因此,合理隐层节点数应在综合考虑网络结构复杂程度和误差大小的情况下用节点删除法和扩张法确定。

6.传递函数

图BP网络常用的传递函数

BP网络的传递函数有多种。Log-sigmoid型函数的输入值可取任意值,输出值在0和1之间;tan-sigmod型传递函数tansig的输入值可取任意值,输出值在-1到+1之间;线性传递函数purelin的输入与输出值可取任意值。BP网络通常有一个或多个隐层,该层中的神经元均采用sigmoid型传递函数,输出层的神经元则采用线性传递函数,整个网络的输出可以取任意值。

7.学习率

学习率影响系统学习过程的稳定性。大的学习率可能使网络权值每一次的修正量过大,甚至会导致权值在修正过程中超出某个误差的极小值呈不规则跳跃而不收敛;但过小的学习率导致学习时间过长,不过能保证收敛于某个极小值。所以,一般倾向选取较小的学习率以保证学习过程的收敛性(稳定性),通常在0.01~0.8之间。

8.网络的初始连接权值

BP算法决定了误差函数一般存在(很)多个局部极小点,不同的网络初始权值直接决定了BP算法收敛于哪个局部极小点或是全局极小点。因此,要求计算程序必须能够自由改变网络初始连接权值。由于Sigmoid转换函数的特性,一般要求初始权值分布在-0.5~0.5之间比较有效。

10.收敛误差界值Emin

在网络训练过程中应根据实际情况预先确定误差界值。误差界值的选择完全根据网络模型的收敛速度大小和具体样本的学习精度来确定。当Emin 值选择较小时,学习效果好,但收敛速度慢,训练次数增加。如果Emin值取得较大时则相反。

网络模型的性能和泛化能力:

训练神经网络的首要和根本任务是确保训练好的网络模型对非训练样本具有好的泛化能力(推广性),即有效逼近样本蕴含的内在规律,而不是看网络模型对训练样本的拟合能力。判断建立的模型是否已有效逼近样本所蕴含的规律, 主要不是看测

试样本误差大小的本身,而是要看测试样本的误差是否接近于训练样本和检验样本的误差。非训练样本误差很接近训练样本误差或比其小,一般可认为建立的网络模型已有效逼近训练样本所蕴含的规律,否则,若相差很多(如几倍、几十倍甚至上千倍)就说明建立的网络模型并没有有效逼近训练样本所蕴含的规律,而只是在这些训练样本点上逼近而已,而建立的网络模型是对训练样本所蕴含规律的错误反映。

算法的特点:

1.非线性映照能力。神经网络能以任意精度逼近任何非线性连续函数。在建模过程中的许多问题正是具有高度的非线性。

2.并行分布处理方式。在神经网络中信息是分布储存和并行处理的,这使它具有很强的容错性和很快的处理速度。

3.自学习和自适应能力。神经网络在训练时,能从输入、输出的数据中提取出规律性的知识,记忆于网络的权值中,并具有泛化能力,即将这组权值应用于一般情形的能力。神经网络的学习也可以在线进行。

4.数据融合的能力。神经网络可以同时处理定量信息和定性信息,因此它可以利用传统的工程技术(数值运算)和人工智能技术(符号处理)。

5.多变量系统。神经网络的输入和输出变量的数目是任意的,对单变量系统与多变量系统提供了一种通用的描述方式,不必考虑各子系统间的解耦问题

算法的缺点:

收敛速度缓慢;容易陷入局部极小值;难以确定隐层数和隐层节点个数。

算法的改进:

1. 利用动量法改进BP 算法

标准BP 算法实质上是一种简单的最速下降静态寻优方法,在修正()w k 时,只按照第k 步的负梯度方向进行修正,而没有考虑到以前积累的经验,即以前时刻的梯度方向,从而常常使学习过程发生振荡,收敛缓慢。动量法权值调整算法的具体做法是:将上一次权值调整量的一部分迭加到按本次误差计算所得的权值调整量上,作为本次的实际权值调整量,即:

()()()

1w n E n w n ηα?=-?+?-

其中:α为动量系数,通常0<α<0.9;η—学习率,范围在0.001~10之间。这种方法所加的动量因子实际上相当于阻尼项,它减小了学习过程中的振荡趋势,从而改善了收敛性。动量法降低了网络对于误差曲面局部细节的敏感性,有效的抑制了网络陷入局部极小。

2.自适应调整学习速率

标准BP 算法收敛速度缓慢的一个重要原因是学习率选择不当,学习率选得太小,收敛太慢;学习率选得太大,则有可能修正过头,导致振荡甚至发散。可采用下图所示的自适应方法调整学习率。

调整的基本指导思想是:在学习收敛的情况下,增大η,以缩短学习时间;当η偏大致使不能收敛时,要及时减小η,直到收敛为止。

3. 动量-自适应学习速率调整算法

采用动量法时,BP 算法可以找到更优的解;采用自适应学习速率法时,BP 算法可以缩短训练时间。将以上两种方法结合起来,就得到动量-自适应学习速率调整算法。

4. L-M 学习规则

L-M (Levenberg-Marquardt )算法比前述几种使用梯度下降法的BP 算法要快得多,但对于复杂问题,这种方法需要相当大的存储空间。L-M(Levenberg-Marquardt)优化方法的权值调整率选为:

()1

T T w J J I J e

μ-?=+?

其中:e —误差向量;J —网络误差对权值导数的雅可比(Jacobian )矩阵;μ—标量,当μ很大时上式接近于梯度法,当μ很小时上式变成了Gauss-Newton 法,在这种方法中,μ也是自适应调整的。

年份 (年) 1(1988) 2(1989) 3(1990) 4(1991) 5(1992) 6(1993) 7(1994) 8(1995) 实际值 (ERI) 年份 (年) 9(1996) 10(1997) 11(1998) 12(1999) 13(2000) 14(2001) 15(2002) 16(2003) 实际值 (ERI) BP 神经网络的训练过程为: 先用1988 年到2002 年的指标历史数据作为网络的输入,用1989 年到2003 年的指标历史数据作为网络的输出,组成训练集对网络进行训练,使之误差达到满意的程度,用这样训练好的网络进行预测. 采用滚动预测方法进行预测:滚动预测方法是通过一组历史数据预测未来某一时刻的值,然后把这一预测数据再视为历史数据继续预测下去,依次循环进行,逐步预测未来一段时期的值. 用1989 年到2003 年数据作为网络的输入,2004 年的预测值作为网络的输出. 接着用1990 年到2004 年的数据作为网络的输入,2005 年的预测值作为网络的输出.依次类推,这样就得到2010 年的预测值。 目前在BP 网络的应用中,多采用三层结构. 根据人工神经网络定理可知,只要用三层的BP 网络就可实现任意函数的逼近. 所以训练结果采用三层BP模型进行模拟预测. 模型训练误差为,隐层单元数选取8个,学习速率为,动态参数,Sigmoid参数,最大迭代次数3000.运行3000次后,样本拟合误差等于。 P=[。。。];输入T=[。。。];输出 % 创建一个新的前向神经网络 net_1=newff(minmax(P),[10,1],{'tansig','purelin'},'traingdm') % 当前输入层权值和阈值 inputWeights={1,1} inputbias={1} % 当前网络层权值和阈值 layerWeights={2,1} layerbias={2} % 设置训练参数 = 50; = ; = ; = 10000; = 1e-3;

神经网络模式识别Matlab程序识别加入20%噪声的A-Z26个字母。(20%噪声情况下,完全能够识别)clear;close all; clc; [alphabet,targets]=prprob; [R,Q]=size(alphabet); [S2,Q]=size(targets); S1=10; P=alphabet; net=newff(minmax(P),[S1,S2],{'logsig''logsig'},'traingdx'); net.LW{2,1}=net.LW{2,1}*0.01; net.b{2}=net.b{2}*0.01; T=targets; net.performFcn='sse'; net.trainParam.goal=0.1; net.trainParam.show=20; net.trainParam.epochs=5000; net.trainParam.mc=0.95; [net,tr]=train(net,P,T); netn=net; netn.trainParam.goal=0.6; netn.trainParam.epochs=300; T=[targets targets targets targets]; for pass=1:10; P=[alphabet,alphabet,... (alphabet+randn(R,Q)*0.1),... (alphabet+randn(R,Q)*0.2)]; [netn,tr]=train(netn,P,T); end netn.trainParam.goal=0.1; netn.trainParam.epochs=500; netn.trainParam.show=5; P=alphabet; T=targets; [netn,tr]=train(netn,P,T); noise_percent=0.2; for k=1:26 noisyChar=alphabet(:,k)+randn(35,1)*noise_percent; subplot(6,9,k+floor(k/9.5)*9); plotchar(noisyChar); de_noisyChar=sim(net,noisyChar); de_noisyChar=compet(de_noisyChar);

高等教育学费标准的研究 摘要 本文从搜集有关普通高等学校学费数据开始,从学生个人支付能力和学校办学利益获得能力两个主要方面出发,分别通过对这两个方面的深入研究从而制定出各自有关高等教育学费的标准,最后再综合考虑这两个主要因素,进一步深入并细化,从而求得最优解。 模块Ⅰ中,我们将焦点锁定在从学生个人支付能力角度制定合理的学费标准。我们从选取的数据和相关资料出发,发现1996年《高等学校收费管理暂行办法》规定高等学校学费占生均教育培养的成本比例最高不得超过25%,而由数据得到图形可知,从2002年开始学费占教育经费的比例超过了25%,并且生均学费和人均GDP 的比例要远远超过美国的10%到15%。由此可见,我国的学费的收取过高。紧接着,我们从个人支付能力角度出发,研究GDP 和学费的关系。并因此制定了修正参数,由此来获取生均学费的修正指标。随后,我们分析了高校专业的相关系数,从个人支付能力角度,探讨高校收费与专业的关系,进一步得到了高校收费标准1i i y G R Q = 。 在模块Ⅱ中,我们从学校办学利益获得能力出发,利用回归分析对学生应交的学杂费与教育经费总计、国家预算内教育经费、社会团体和公民个人办学经验、社会捐投资和其他费用的关系,发现学杂费与教育经费总计成正相关,与其他几项费用成负相关。对此产生的数据验证分析符合标准。然后,再根据专业相关系数来确定学校收取学费的标准。从而,得到了学校办学利益的收费标准2i i i y y R = 。 在模块Ⅲ中,为了获取最优解,我们综合了前面两个模块所制定的收费指标,并分别给予不同权系数,得到最终学费的表达式12i i C ay by =+。然后,我们从学校收费指标的权系数b 考虑,利用神经网络得到的区域划分,根据不同区域而计算出的权系数b 的范围。最终得到的表达式 ]12345**(1)(1.0502 1.1959 1.3108 1.36360.7929)**b i i C R G Q b x x x x x R =-+----;由此便可得到综合学费标准C 的取值范围。然后,我们随机选取了同一区域不同专业,并根据表达式计算这些专业的学费,结果发现对社会收益大,个人收益小的专业如地质学的学费范围为:3469.8~3506.3元之间;对社会收益小,个人收益大的专业如广告设计的学费范围为:7931.0~8014.5元之间。与通常高校实现的一刀切政策有了明显的优点。 最后,我们从本论文研究方向考虑,为优化高校费用标准的制定提出参考意见,如建立反馈制度和特殊生补贴制度的建议。 【关键字】相关系数 回归模型 自组织竞争神经网络

1.1 BP 神经网络原理简介 BP 神经网络是一种多层前馈神经网络,由输入、输出、隐藏层组成。该网络的主要特点是信号前向传递,误差反向传播。在前向传递中,输入信号从输入层经隐藏层逐层处理,直至输出层。每一层的神经元状态只影响下一层神经元状态。如果输出层得不到期望输出则转入反向传播,根据预测误差调整网络权值和阈值,从而使BP 神经网络预测输出不断逼近期望输出。结构图如下: 隐藏层传输函数选择Sigmoid 函数(也可以选择值域在(-1,1)的双曲正切函数,函数‘tansig ’),其数学表达式如下: x e 11)x ( f α-+=,其中α为常数 输出层传输函数选择线性函数:x )x (f = 1.隐藏层节点的选择 隐藏层神经元个数对BP 神经网络预测精度有显著的影响,如果隐藏层节点数目太少,则网络从样本中获取信息的能力不足,网络容易陷入局部极小值,有时可能训练不出来;如果隐藏层节点数目太多,则学习样本的非规律性信息会出现“过度吻合”的现象,从而导致学习时间延长,误差也不一定最佳,为此我们参照以下经验公式: 12+=I H ]10,1[ ,∈++=a a O I H I H 2log = 其中H 为隐含层节点数,I 为输入层节点数,O 为输出层节点数,a 为常数。 输入层和输出层节点的确定: 2.输入层节点和输出层节点的选择 输入层是外界信号与BP 神经网络衔接的纽带。其节点数取决于数据源的维数和输入特征向量的维数。选择特征向量时,要考虑是否能完全描述事物的本质特征,如果特征向量不能有效地表达这些特征,网络经训练后的输出可能与实际有较大的差异。因此在网络训练前,应全面收集被仿真系统的样本特性数据,并在数据处理时进行必要的相关性分析,剔除那些边沿和不可靠的数据,最终确定出数据源特征向量的维度。对于输出层节点的数目,往往需要根据实际应用情况灵活地制定。当BP 神经网络用于模式识别时,模式的自身特性就决定了输出的结果数。当网络作为一个分类器时,输出层节点数等于所需信息类别数。(可有可无) 训练好的BP 神经网络还只能输出归一化后的浓度数据,为了得到真实的数据

人工神经网络模式识别 一、人工神经网络模式识别 1、人工神经网络的概述 人工神经网络从人脑的生理学和心理学角度出发,通过模拟人脑的工作机理,实现机器的部分智能行为,是从微观结构和功能上对人脑进行抽象和简化,是模拟人类智能的一条重要途径。具体的模式识别是多种多样的,如果从识别的基本方法上划分,传统的模式识别大体分为统计模式识别和句法模式识别,在识别系统中引入神经网络是一种近年来发展起来的新的模式识别方法。尽管引入神经网络的方法和引入网络的结构可以各不相同,但都可称为神经网络模式识别。而且这些识别方法在解决传统方法较难处理的某些问题上带来了新的进展和突破,因而得到了人们越来越多的重视和研究。 人工神经元网络(Artificial Neural Network)简称神经网络,是基于日前人们对自然神经系统的认识而提出的一些神经系统的模型,一般是由一系列被称为神经元的具有某种简单计算功能的节点经过广泛连接构成的一定网络结构,而其网络连接的权值根据某种学习规则在外界输入的作用下不断调节,最后使网络具有某种期望的输出特性。神经网络的这种可以根据输入样本学习的功能使得它非常适合于用来解决模式识别问题,这也是神经网络目前最成功的应用领域之一。 2、神经网络进行模式识别的方法和步骤 神经网络模式识别的基本方法是,首先用己知样本训练神经网络,使之对不同类别的己知样本给出所希望的不同输出,然后用该网络识别未知的样本,根据各样本所对应的网络输出情况来划分未知样本的类别。神经网络进行模式识别的一般步骤如图2-1所示,分为如下几个部分: 预处理 样本获取常规处理特征变换神经网络识别 图 2-1 神经网络模式识别基本构成 1、样本获取 这一步骤主要是为了得到一定数量的用于训练和识别的样本。

摘要:基于视觉理论的神经网络模式识别理论的研究一直是非常活跃的学科,被认为是神经网络应用最成功的一个方面,它的发展与神经网络理论可以说是同步的。几乎所有现有的神经网络物理模型都在模式识别领域得到了成功的应用,神经网络理论取得进步会给模式识别理论的发展带来鼓舞;相反,模式识别理论的进步又会大大推动神经网络理论的长足发展。它们的关系是相互渗透的。 关键词:神经网络;模式识别 Abstract: The research of pattern recognition theories according to the neural network mode of sense of vision theories has been very active in academics, neural network has been thought one of the most successful applications , its development can been seen as the same step with the neural network theories.Almost all existing physics model of the neural network all identified realm to get success in the mode of application, neural network theories' progress will give the development of the pattern recognition theories much encourage;Contrary, the pattern recognition theories of progress again consumedly push neural network theories of substantial development.Their relations permeate mutually. Key word: neural network; pattern recognition

实验七基于神经网络的模式识别实验 一、实验目的 理解BP神经网络和离散Hopfield神经网络的结构和原理,掌握反向传播学习算法对神经元的训练过程,了解反向传播公式。通过构建BP网络和离散Hopfield 网络模式识别实例,熟悉前馈网络和反馈网络的原理及结构。 二、实验原理 BP学习算法是通过反向学习过程使误差最小,其算法过程从输出节点开始,反向地向第一隐含层(即最接近输入层的隐含层)传播由总误差引起的权值修正。BP网络不仅含有输入节点和输出节点,而且含有一层或多层隐(层)节点。输入信号先向前传递到隐节点,经过作用后,再把隐节点的输出信息传递到输出节点,最后给出输出结果。 离散Hopfield神经网络的联想记忆过程分为学习和联想两个阶段。在给定样本的条件下,按照Hebb学习规则调整连接权值,使得存储的样本成为网络的稳定状态,这就是学习阶段。联想是指在连接权值不变的情况下,输入部分不全或者受了干扰的信息,最终网络输出某个稳定状态。 三、实验条件 Matlab 7.X 的神经网络工具箱:在Matlab 7.X 的命令窗口输入nntool,然后在键盘上输入Enter键,即可打开神经网络工具箱。 四、实验内容 1.针对教材P243例8.1,设计一个BP网络结构模型(63-6-9),并以教材图8.5 为训练样本数据,图8.6为测试数据。 (1)运行train_data.m和test_data.m文件,然后从Matlab工作空间导入(Import)训练样本数据(inputdata10,outputdata10)和测试数据(testinputdata,testoutputdata),其次新建一个神经网络(New Network),选择参数如下表1,给出BP神经网络结构图。

神经网络 例 解:设计BP网,编写文件ch14eg4.m,结构和参数见程序中的说明。clear;close all; x = [0:0.25:10]; y = 0.12*exp(-0.213*x)+0.54*exp(-0.17*x).*sin(1.23*x); % x,y分别为输入和目标向量 net=newff(minmax(x),[20,1],{'tansig','purelin'}); % 创建一个前馈网络 y0 = sim(net,x); % 仿真未经训练的网络net net.trainFcn='trainlm'; % 采用L-M优化算法TRAINLM net.trainParam.epochs = 500; net.trainParam.goal = 1e-6; % 设置训练参数[net,tr]=train(net,x,y); % 调用相应算法训练网络 y1 = sim(net,x); % 对BP网络进行仿真 E = y-y1; MSE=mse(E) % 计算仿真误差

figure; % 下面绘制匹配结果曲线 plot(x,y0,':',x,y1,'r*',x,0.12*exp(-0.213*x)+0.54*exp(-0.17*x).*sin(1.23*x),'b'); 运行如下: >> ch14eg4 MSE =9.6867e-007 例14.6 蠓虫分类问题。两种蠓虫Af和Apf已由生物学家W.L.Grogan和W.W.Wirth(1981)根据他们的触角长度和翅长加以区分。现测得6只Apf蠓虫和9只Af蠓虫的触长、翅长的数据如下: Apf: (1.14,1.78),(1.18,1.96),(1.20,1.86),(1.26,2.),(1.28,2.00),(1.30,1.96). Af: (1.24,1.72),(1.36,1.74),(1.38,1.64),(1.38,1.82),(1.38,1.90),(1.4,1.7), (1.48,1.82),(1.54,1.82),(1.56,2.08) 请用恰当的方法对触长、翅长分别为(1.24,1.80),(1.28,1.84),(1.40,2.04)的3个样本进行识别。 解:设计一个Lvq神经网络进行分类。编写m文件ch14eg6.m clear; close all; Af=[1.24,1.36,1.38,1.38,1.38,1.4,1.48,1.54,1.56;1.27,1.74,1.64,1.82, 1.9,1.7,1.82,1.82,2.08]; Apf=[1.14 1.18 1.20 1.26 1.28 1.30;1.78 1.96 1.86 2.00 2.00 1.96]; x=[Af Apf];%输入向量 y0=[2*ones(1,9) ones(1,6)];%类2表示Af, 类1表示Apf y=ind2vec(y0);%将下标向量转换为单值向量作为目标向量 net = newlvq(minmax(x),8,[0.6,0.4]);%建立LVQ网络 net.trainParam.show=100; net.trainParam.epochs = 1000;%设置参数 net = train(net,x,y); ytmp=sim(net,x);%对网络进行训练并用原样本仿真 y1=vec2ind(ytmp);%将单值向量还原为下标向量作为输出向量 xt=[1.24,1.28,1.40;1.80,1.84,2.04];%测试输入样本 yttmp=sim(net,xt)%对网络用新样本进行仿真 yt=vec2ind(yttmp)%输出新样本所属类别 figure;%打开一个图形窗口 plot(Af(1,:),Af(2,:),'+',Apf(1,:),Apf(2,:),'o',xt(1,:),xt(2,:),'*');

BP神经网络 算法原理: 输入信号 x i通过中间节点(隐层点)作用于输出节点,经过非线形变换,产生输 出信号 y k,网络训练的每个样本包括输入向量x 和期望输出量d,网络输出值y 与期望输出值 d 之间的偏差,通过调整输入节点与隐层节点的联接强度取值w ij和隐层节点与输出节点之间的联接强度T jk以及阈值,使误差沿梯度方向下降,经过反复学习训练, 确定与最小误差相对应的网络参数(权值和阈值),训练即告停止。此时经过训练的神经网络即能对类似样本的输入信息,自行处理输出误差最小的经过非线形转换的信息。 变量定义: 设输入层有 n 个神经元,隐含层有p 个神经元 , 输出层有 q 个神经元 输入向量: x x1 , x2 ,L , x n 隐含层输入向量:hi hi1, hi2 ,L , hi p 隐含层输出向量:ho ho1 , ho2 ,L ,ho p 输出层输入向量:yi yi1, yi2 ,L , yi q 输出层输出向量:yo yo1, yo2 ,L , yo q 期望输出向量 : do d1, d2 ,L , d q 输入层与中间层的连接权值:w ih 隐含层与输出层的连接权值:w ho 隐含层各神经元的阈值: b h 输出层各神经元的阈值:b o 样本数据个数 :k1,2,L m 激活函数 : f 误差函数: e 1 q(d o (k )yo o (k )) 2 2 o1

算法步骤: Step1. 网络初始化 。给各连接权值分别赋一个区间( -1 , 1)内的随机数,设定 误差函数 e ,给定计算精度值 和最大学习次数 M 。 Step2. 随机选取第 k 个输入样本 x( k) x 1( k ), x 2 (k),L , x n (k ) 及对应期望输出 d o ( k) d 1 (k ), d 2 ( k),L , d q (k) Step3. 计算隐含层各神经元的输入 n hi h ( k) w ih x i (k ) b h h 1,2,L , p 和输出 i 1 ho h (k) f (hi h (k )) h 1,2, L , p 及 输 出 层 各 神 经 元 的 输 入 p yi o (k ) w ho ho h (k) b o o 1,2,L q 和输出 yo o ( k) f ( yi o (k )) o 1,2, L , p h 1 Step4. 利用网络期望输出和实际输出, 计算误差函数对输出层的各神经元的偏导 数 o (k ) 。 e e yi o w ho yi o w ho p yi o ( k) ( h w ho ho h (k ) b o ) ho h (k ) w ho w ho e ( 1 q (d o ( k) yo o (k))) 2 2 o 1 ( d o (k ) yi o yi o (d o (k) yo o (k ))f ( yi o (k )) @ o (k ) Step5. 利用隐含层到输出层的连接权值、输出层的 差函数对隐含层各神经元的偏导数 h (k ) 。 e e yi o o ( k) ho h (k ) w ho yi o w ho e e hi h (k) w ih hi h ( k) w ih n hi h (k ) ( w ih x i (k ) b h ) i 1 x i ( k) w ih w ih yo o (k )) yo o (k ) o ( k) 和隐含层的输出计算误

实验七:基于神经网络的模式识别实验 一、实验目的 理解BP神经网络和离散Hopfield神经网络的结构和原理,掌握反向传播学习算法对神经元的训练过程,了解反向传播公式。通过构建BP网络和离散Hopfield网络模式识别实例,熟悉前馈网络和反馈网络的原理及结构。 综合掌握模式识别的原理,了解识别过程的程序设计方法。 二、实验内容 熟悉模式识别的理论方法,用选择一种合适的识别方法,对图像中的字符(英文字母)进行识别,能够区分出不同的形态的26个字母。 在Matlab中,采用BP神经网络,对读取的数据进行训练,进而识别。 1. 程序设计 (1)程序各流程图 实验中主程序流程图如图4-1所示:

图4-1主程序流程图 其中图像预处理的流程如图4-2 所示: 图4-2图像预处理的流程神经网络训练的具体流程如图4-3所示:

图4-3 神经网络训练流程 (2)程序清单 %形成用户界面 clear all; %添加图形窗口 H=figure('Color',[0.85 0.85 0.85],... 'position',[400 300 500 400],... 'Name','基于BP神经网络的英文字母识别',... 'NumberTitle','off',... 'MenuBar','none'); %画坐标轴对象,显示原始图像 h0=axes('position',[0.1 0.6 0.3 0.3]); %添加图像打开按钮 h1=uicontrol(H,'Style','push',... 'Position',[40 100 80 60],... 'String','选择图片',... 'FontSize',10,... 'Call','op'); %画坐标轴对象,显示经过预处理之后的图像 h2=axes('position',[0.5 0.6 0.3 0.3]); %添加预处理按钮

基于BP神经网络的国际黄金价格预测模型 公文易文秘资源网顾孟钧张志和陈友2009-1-2 13:35:26我要投稿添加到百度搜藏 [摘要] 为了寻找国际黄金价格与道琼斯工业指数、美国消费者指数,国际黄金储备等因素之间的内在关系,本文对1972年~2006年间的各项数据首先进行归一化处理,利用MATLAB神经网络工具箱进行模拟训练,建立了基于BP神经网络的国际黄金价格预测模型 [摘要] 为了寻找国际黄金价格与道琼斯工业指数、美国消费者指数,国际黄金储备等因素之间的内在关系,本文对1972年~2006年间的各项数据首先进行归一化处理,利用MATLAB神经网络工具箱进行模拟训练,建立了基于BP神经网络的国际黄金价格预测模型。 [关键词] MATLAB BP神经网络预测模型数据归一化 一、引言 自20世纪70年代初以来的30多年里,世界黄金价格出现了令人瞠目的剧烈变动。20 世纪70年代初,每盎司黄金价格仅为30多美元。80年代初,黄金暴涨到每盎司近700美元。本世纪初,黄金价格处于每盎司270美元左右,此后逐年攀升,到2006年5月12日达到了26年高点,每盎司730美元,此后又暴跌,仅一个月时间内就下跌了约160美元,跌幅高达21.9%。最近两年,黄金价格一度冲高到每盎司900多美元。黄金价格起伏如此之大,本文根据国际黄金价格的影响因素,通过BP神经网络预测模型来预测长期黄金价格。 二、影响因素 刘曙光和胡再勇证实将观察期延长为1972年~2006年时,则影响黄金价格的主要因素扩展至包含道琼斯指数、美国消费者价格指数、美元名义有效汇率、美国联邦基金利率和世界黄金储备5个因素。本文利用此观点,根据1972年~2006年各因素的值来建立神经网络预测模型。 三、模型构建

BP 神经网络 算法原理: 输入信号i x 通过中间节点(隐层点)作用于输出节点,经过非线形变换,产生输出信号k y ,网络训练的每个样本包括输入向量x 和期望输出量d ,网络输出值y 与期望输出值d 之间的偏差,通过调整输入节点与隐层节点的联接强度取值ij w 和隐层节点与输出节点之间的联接强度jk T 以及阈值,使误差沿梯度方向下降,经过反复学习训练,确定与最小误差相对应的网络参数(权值和阈值),训练即告停止。此时经过训练的神经网络即能对类似样本的输入信息,自行处理输出误差最小的经过非线形转换的信息。 变量定义: 设输入层有n 个神经元,隐含层有p 个神经元,输出层有q 个神经元 输入向量:()12,, ,n x x x x = 隐含层输入向量:()12,,,p hi hi hi hi = 隐含层输出向量:()12,,,p ho ho ho ho = 输出层输入向量:()12,,,q yi yi yi yi = 输出层输出向量:()12,,,q yo yo yo yo = 期望输出向量: ()12,, ,q do d d d = 输入层与中间层的连接权值: ih w 隐含层与输出层的连接权值: ho w 隐含层各神经元的阈值:h b 输出层各神经元的阈值: o b 样本数据个数: 1,2,k m = 激活函数: ()f ? 误差函数:2 1 1(()())2q o o o e d k yo k ==-∑

算法步骤: Step1.网络初始化 。给各连接权值分别赋一个区间(-1,1)内的随机数,设定误差函数e ,给定计算精度值ε和最大学习次数M 。 Step2.随机选取第k 个输入样本()12()(),(), ,()n x k x k x k x k =及对应期望输出 ()12()(),(),,()q d k d k d k d k =o Step3.计算隐含层各神经元的输入()1 ()()1,2, ,n h ih i h i hi k w x k b h p ==-=∑和输出 () ()(())1,2, ,h h ho k f hi k h p ==及 输出层各神经元的输入 ()1 ()()1,2, p o ho h o h yi k w ho k b o q ==-=∑和输出()()(())1,2, ,o o yo k f yi k o p == Step4.利用网络期望输出和实际输出,计算误差函数对输出层的各神经元的偏导数()o k δ。 o ho o ho yi e e w yi w ???=??? (()) () ()p ho h o o h h ho ho w ho k b yi k ho k w w ?-?==??∑ 2 1 1((()()))2(()())()(()())f (()) () q o o o o o o o o o o o o d k yo k e d k yo k yo k yi yi d k yo k yi k k δ=?-?'==--??'=---∑ Step5.利用隐含层到输出层的连接权值、输出层的()o k δ和隐含层的输出计算误差函数对隐含层各神经元的偏导数()h k δ。 ()()o o h ho o ho yi e e k ho k w yi w δ???==-??? 1() ()(()) () () h ih h ih n ih i h h i i ih ih hi k e e w hi k w w x k b hi k x k w w =???= ????-?==??∑

神经网络的应用及其发展

神经网络的应用及其发展 来源:辽宁工程技术大学作者: 苗爱冬 [摘要] 该文介绍了神经网络的发展、优点及其应用和发展动向,着重论述了神经网络目前的几个研究热点,即神经网络与遗传算法、灰色系统、专家系统、模糊控制、小波分析的结合。 [关键词]遗传算法灰色系统专家系统模糊控制小波分析 一、前言 神经网络最早的研究20世纪40年代心理学家Mcculloch和数学家Pitts 合作提出的,他们提出的MP模型拉开了神经网络研究的序幕。神经网络的发展大致经过三个阶段:1947~1969年为初期,在这期间科学家们提出了许多神经元模型和学习规则,如MP模型、HEBB学习规则和感知器等;1970~1986年为过渡期,这个期间神经网络研究经过了一个低潮,继续发展。在此期间,科学家们做了大量的工作,如Hopfield教授对网络引入能量函数的概念,给出了网络的稳定性判据,提出了用于联想记忆和优化计算的途径。1984年,Hiton教授提出Boltzman机模型。1986年Kumelhart等人提出误差反向传播神经网络,简称BP网络。目前,BP网络已成为广泛使用的网络;1987年至今为发展期,在此期间,神经网络受到国际重视,各个国家都展开研究,形成神经网络发展的另一个高潮。神经网络具有以下优点: (1) 具有很强的鲁棒性和容错性,因为信息是分布贮于网络内的神经元中。 (2) 并行处理方法,使得计算快速。 (3) 自学习、自组织、自适应性,使得网络可以处理不确定或不知道的系统。 (4) 可以充分逼近任意复杂的非线性关系。 (5) 具有很强的信息综合能力,能同时处理定量和定性的信息,能很好地协调多种输入信息关系,适用于多信息融合和多媒体技术。 二、神经网络应用现状 神经网络以其独特的结构和处理信息的方法,在许多实际应用领域中取得了显著的成效,主要应用如下: (1) 图像处理。对图像进行边缘监测、图像分割、图像压缩和图像恢复。 (2) 信号处理。能分别对通讯、语音、心电和脑电信号进行处理分类;可用于海底声纳信号的检测与分类,在反潜、扫雷等方面得到应用。 (3) 模式识别。已成功应用于手写字符、汽车牌照、指纹和声音识别,还可用于目标的自动识别和定位、机器人传感器的图像识别以及地震信号的鉴别

第1章引言 1.1 人工神经网络的介绍 人工神经网络(Artificial Neural Networks, ANN),亦称为神经网络(Neural Networks,NN),是由大量的处理单元(神经元Neurons)广泛互联而成的网络,是对大脑的抽象、简化和模拟,反映人脑的基本特性.人工神经网络的研究是从人脑的生理结构出发来研究人的智能行为,模拟人脑信息处理的功能.它是根植于神经科学、数学、物理学、计算机科学及工程等科学的一种技术. 人工神经网络是由简单的处理单元所组成的大量并行分布的处理机,这种处理机具有储存和应用经念知识的自然特性,它与人脑的相似之处概括两个方面:一是通过学习过程利用神经网络从外部环境中获取知识;二是内部神经元(突触权值)用来存储获取的知识信息. 人工神经网络具有四个基本特征: (1)非线性非线性关系是自然界的普遍特性.大脑的智慧就是一种非线性现象.人工神经元处于激活或抑制二种不同的状态,这种行为在数学上表现为一种非线性关系.具有阈值的神经元构成的网络具有更好的性能,可以提高容错性和存储容量. (2)非局限性一个神经网络通常由多个神经元广泛连接而成.一个系统的整体行为不仅取决于单个神经元的特征,而且可能主要由单元之间的相互作用、相互连接所决定.通过单元之间的大量连接模拟大脑的非局限性.联想记忆是非局限性的典型例子. (3)非常定性人工神经网络具有自适应、自组织、自学习能力.神经网络不但处理的信息可以有各种变化,而且在处理信息的同时,非线性动力系统本身也在不断变化.经常采用迭代过程描写动力系统的演化过程. (4)非凸性一个系统的演化方向,在一定条件下将取决于某个特定的状态函数.例如能量函数,它的极值相应于系统比较稳定的状态.非凸性是指这种函数有多个极值,故系统具有多个较稳定的平衡态,这将导致系统演化的多样性. 人工神经网络是近年来的热点研究领域,涉及到电子科学技术、信息与通讯工程、计算机科学与技术、电器工程、控制科学与技术等诸多学科,其应用领域包括:建模、时间序列分析、模式识别和控制等,并在不断的拓展.本文正是居于数学建模的神经网路应用. 1.2人工神经网络发展历史 20世纪40年代中期期,在科学发展史上出现了模拟电子计算机和数字电子计算机两种新的计算工具和一种描述神经网络工作的数学模型.由于电子技术(特别是大规模、超大规模集成电路)的发展,使数字电子计算机作为高科技计算工具已发展到当今盛世地步,而人工神经网络模拟仿真生物神经网络的探索则经历了半个世纪的曲折发展道路.

数学建模B P神经网 络论文

BP 神经网络 算法原理: 输入信号i x 通过中间节点(隐层点)作用于输出节点,经过非线形变换,产生输出信号k y ,网络训练的每个样本包括输入向量x 和期望输出量d ,网络输出值y 与期望输出值d 之间的偏差,通过调整输入节点与隐层节点的联接强度取值ij w 和隐层节点与输出节点之间的联接强度jk T 以及阈值,使误差沿梯度方向下降,经过反复学习训练,确定与最小误差相对应的网络参数(权值和阈值),训练即告停止。此时经过训练的神经网络即能对类似样本的输入信息,自行处理输出误差最小的经过非线形转换的信息。 变量定义: 设输入层有n 个神经元,隐含层有p 个神经元,输出层有q 个神经元 输入向量:()12,, ,n x x x x = 隐含层输入向量:()12,,,p hi hi hi hi = 隐含层输出向量:()12,,,p ho ho ho ho = 输出层输入向量:()12,,,q yi yi yi yi = 输出层输出向量:()12,,,q yo yo yo yo = 期望输出向量: ()12,, ,q do d d d = 输入层与中间层的连接权值: ih w 隐含层与输出层的连接权值: ho w 隐含层各神经元的阈值:h b 输出层各神经元的阈值: o b 样本数据个数: 1,2, k m =

激活函数: ()f ? 误差函数:21 1(()())2q o o o e d k yo k ==-∑ 算法步骤: Step1.网络初始化 。给各连接权值分别赋一个区间(-1,1)内的随机数,设定误差函数e ,给定计算精度值ε和最大学习次数M 。 Step2.随机选取第k 个输入样本()12()(),(), ,()n x k x k x k x k =及对应期望输出 ()12()(),(),,()q d k d k d k d k =o Step3.计算隐含层各神经元的输入()1 ()()1,2, ,n h ih i h i hi k w x k b h p ==-=∑和输出 ()()(())1,2, ,h h ho k f hi k h p ==及输出层各神经元的输入 ()1 ()()1,2, p o ho h o h yi k w ho k b o q ==-=∑和输出()()(())1,2, ,o o yo k f yi k o p == Step4.利用网络期望输出和实际输出,计算误差函数对输出层的各神经元的偏导数()o k δ。 o ho o ho yi e e w yi w ???=??? (()) () ()p ho h o o h h ho ho w ho k b yi k ho k w w ?-?==??∑ 2 1 1((()()))2(()())()(()())f (()) () q o o o o o o o o o o o o d k yo k e d k yo k yo k yi yi d k yo k yi k k δ=?-?'==--??'=---∑ Step5.利用隐含层到输出层的连接权值、输出层的()o k δ和隐含层的输出计算误差函数对隐含层各神经元的偏导数()h k δ。

数学建模参赛真实经验 一、如何准备数学建模竞赛 一般,可以把参加数学建模竞赛的过程分成三个阶段:第一阶段,是个人的入门和积累阶段,这个阶段关键看个人的主观能动性;第二阶段,就是通常各学校都进行的集训阶段,通过模拟实战来提高参赛队员的水平;第三阶段是实际比赛阶段。这里讲的如何准备数学建模竞赛是针对第一阶段来讲的。 回顾作者自己的参赛过程,认为这个阶段是真正的学习阶段,就像是修炼内功一样,如果在这个阶段打下深厚的基础,对后面的两个阶段非常有利,也是个人是否能在建模竞赛中占优势的关键阶段。下面就分几个方面谈一下如何准备数学建模竞赛。 首先是要有一定的数学基础,尤其是良好的数学思维能力。并不是数学分数高就说明有很高的数学思维能力,但扎实的数学知识是数学思维的根基。对大学生来说,有高等数学、概率和线性代数就够了,当然其它数学知识知道的越多越好了,如图论、排队论、泛函等。我大一下学期开始接触数学建模,大学的数学课程只学习过高等数学。说这一点,主要想说明只要数学基础还可以,平时的数学考试都能在80分以上就可以参加数学建模竞赛了,数学方面的知识可以在以后的学习中逐渐去提高,不必刻意去补充单纯的数学理论。 真正准备数学建模竞赛应该从看数学建模书籍开始,要知道什么是数学建模,有哪些常见的数学模型和建模方法,知道一些常见的数学建模案例,这些方面都要通过看建模方面的书籍而获得。现在数学建模的书籍也比较多,图书馆和互联网上都有丰富的数学建模资料。作者认为姜启源、谢金星、叶齐孝、朱道元等老师的建模书籍都非常的棒,可以先看二三本。刚开始看数学建模书籍时,一定会有很多地方看不懂,但要知道基本思路,时间长了就知道什么问题用什么建模方法求解了。这里面需要提的一点是,运筹学与数学建模息息相关,最好再看一二本运筹学著作,仍然可以采取诸葛亮的看书策略,只观其大略就可以了,等知道需要具体用哪块知识后,再集中精力将其消化,然后应用之。 大家都知道,参加数学建模竞赛一定要有些编程功底,当然现在有Matlab这种强大的工程软件,对编程的的要求就降低了,至少入门容易多了,因为很容易用1条Matlab命令

模糊神经网络模式识别 function retstr = FnnTrain(dt,ld,tt,sp) retstr=-1; %%%% 输入参数赋值开始%%%%%%%%%%%%%%%%%%%%%%% % 方便调试程序用,程序调试时去掉这部分的注释 % dt=4; %学习阈值 % ld=0.05; %学习进度 % tt=10; %训练次数 % sp='data\sample.txt'; %一个点的监测数据 %%%% 输入参数赋值结束%%%%%%%%%%%%%%%%%%%%%%%% global recordDimention; global sampleNumber; global weightNumber; global distanceThread; global WW; global learningDegree; global epochsNumber; distanceThread=dt; learningDegree=ld; traintimes=tt; A=load(sp); [Arow Acol]=size(A); %样本个数 sampleNumber=Arow; recordDimention=Acol; disp(sampleNumber); WW=A(1,:); WW=[WW [1]]; weightNumber=1; epochsNumber=1; for jj=2:1:sampleNumber TrainNN2(A(jj,:)); end for jt=1:traintimes-1 for jt2=1:sampleNumber TrainNN2(A(jj,:)); end end % 将训练结果写入权值文件 dlmwrite('data\w.dat',WW,'\t'); % % 训练子函数

神经网络 神经网络不需要做许多假设和和复杂的数学表达式,只用通过学习样本进行训练。 一、BP 神经网络 1.1简介 BP 神经网络由输入层、隐层和输出层三层构成。对于BP 神经网络,网络的性能受局部不准确试验数据的影响很小。所以BP 神经网络有很强的容错性。 缺点:训练时间较长,求得的解可能是局部极小解。 若R 是输入量的个数,il W 是隐层第i 个神经元与输出层第K 个神经元的连接权值,i b 是阈值。则通用神经元模型如下: ... ∑f 将多个神经元模型串起来会得到n 个神经元输出,第i 个神经元输出为 1R i ik k i k n x b ω==+∑ 第i 个神经元经过任意传递函数后得到输出为 ()log ()|tan ()|()i i i i i y f n sig n sig n purelin n == BP 神经网络的应用 ①沼泽草炭土结构特性及模型研究(下载文档) 2.1步骤 ①构造建模方案 根据输入与输出关系写出表达式,如三输入,一输出的非线性函数表达式为 (,,)f d q σε= 相对应的BP 神经网络结构为

设j x ,i y ,l o 分别表示BP 网络三层节点的输入节点,隐节点,输出节点。ij ω表示输入节点和隐节点之间的网络权值,li T 表示隐节点和输出节点之间的网络权值,我们用梯度法对BP 网络的权值进行修正,采用sigmoid 函数。若输出节点期望输出l t ,则有 输入节点至隐节点的公式为: 阈值修正:(1)()i i i j k k θθηδγ''+=+ 误差:(1)i i i l li l y y T δδ'=-∑ 权值修正:(1)()ij ij i j k k ωωηδγ''+=+ 隐节点至输出节点的公式为: 若有p 个样本数,n 个输出节点数,则一个样本的误差为()(k)1||,n k k l l l e t o ==-∑控 制误差范围是1,p k k E e ζ==<∑ 阈值修正:(1)()l l l k k θθηδ''+=+ 权值修正:(1)(),(li li l i T k T k y k ηδ+=+为迭代次数) 误差:()(1)l l l l l t o o o δ=-??- 输出节点的计算公式为: