2018/01/DTPT

——————————

收稿日期:2017-11-10

0引言

随着互联网业务的发展,网络中的流量急剧增加。异地获取服务会带来巨大的骨干网流量,并且服务质量会受到省际链路质量的影响,尤其是省际时延会对服务造成不小的影响,且由于物理距离的存在,省际时延是难以避免的。因此,服务本地化是未来网络必然的发展趋势之一,建设本地IDC ,资源内容下移,使得内容本地化,是目前网络建设的重要方向。城域IDC 的主要作用是为本地(市)及其周边地区

提供内容和资源。不过从IDC 规模和用途上看,城域IDC 也有着不同的定位和作用。重点城市的大型IDC ,通常要为全省地(市)提供内容资源,如省会城市的IDC ;甚至部分地(市)的IDC 还要为多个省甚至全国提供资源,如北上广等城市的IDC ,此类IDC 的出城流量会非常大;而另外部分地(市)的IDC 则是主要供本地自用,其城域IDC 较小,主要用于热点内容的引入。

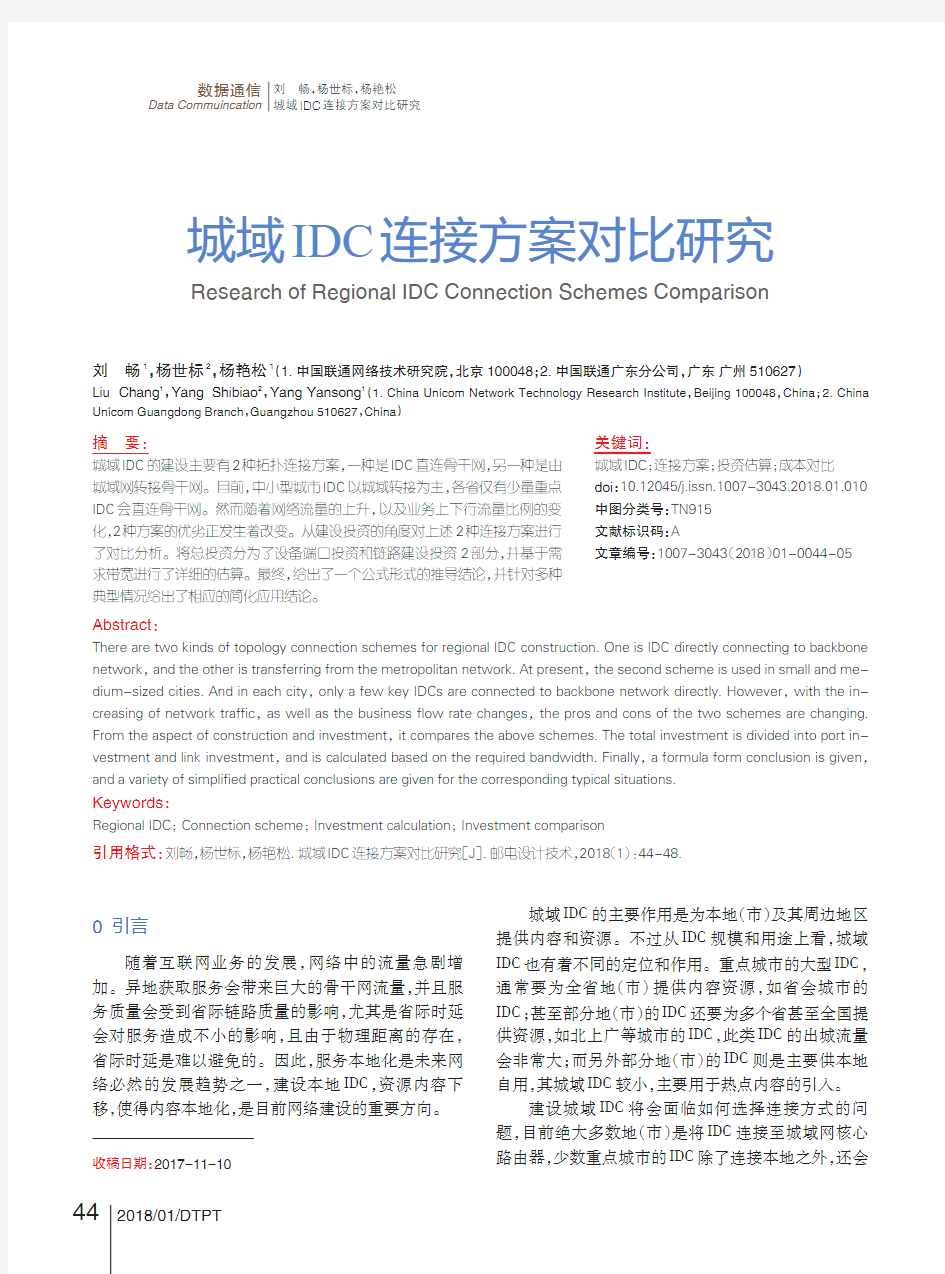

建设城域IDC 将会面临如何选择连接方式的问题,目前绝大多数地(市)是将IDC 连接至城域网核心路由器,少数重点城市的IDC 除了连接本地之外,还会

城域IDC 连接方案对比研究

关键词:

城域IDC;连接方案;投资估算;成本对比doi :10.12045/j.issn.1007-3043.2018.01.010中图分类号:TN915文献标识码:A

文章编号:1007-3043(2018)01-0044-05

摘要:

城域IDC 的建设主要有2种拓扑连接方案,一种是IDC 直连骨干网,另一种是由城域网转接骨干网。目前,中小型城市IDC 以城域转接为主,各省仅有少量重点IDC 会直连骨干网。然而随着网络流量的上升,以及业务上下行流量比例的变化,2种方案的优劣正发生着改变。从建设投资的角度对上述2种连接方案进行了对比分析。将总投资分为了设备端口投资和链路建设投资2部分,并基于需求带宽进行了详细的估算。最终,给出了一个公式形式的推导结论,并针对多种典型情况给出了相应的简化应用结论。

Abstract :

There are two kinds of topology connection schemes for regional IDC construction.One is IDC directly connecting to backbone network,and the other is transferring from the metropolitan network.At present,the second scheme is used in small and me-dium-sized cities.And in each city,only a few key IDCs are connected to backbone network directly.However,with the in-creasing of network traffic,as well as the business flow rate changes,the pros and cons of the two schemes are changing.From the aspect of construction and investment,it compares the above schemes.The total investment is divided into port in-vestment and link investment,and is calculated based on the required bandwidth.Finally,a formula form conclusion is given,and a variety of simplified practical conclusions are given for the corresponding typical situations.

Keywords :

Regional IDC;Connection scheme;Investment calculation;Investment comparison

刘畅1,杨世标2,杨艳松1(1.中国联通网络技术研究院,北京100048;2.中国联通广东分公司,广东广州510627)

Liu Chang 1,Yang Shibiao 2,Yang Yansong 1(1.China Unicom Network Technology Research Institute ,Beijing 100048,China ;2.China

Unicom Guangdong Branch ,Guangzhou 510627,China )

Research of Regional IDC Connection Schemes Comparison

引用格式:刘畅,杨世标,杨艳松.城域IDC 连接方案对比研究[J].邮电设计技术,2018(1):44-48.

数据通信

Data Commuincation 刘畅,杨世标,杨艳松

城域IDC 连接方案对比研究

44

目录 第1章概述.................................................................................................................... 错误!未指定书签。 1.1数据集中阶段的数据中心建设 ......................................................................... 错误!未指定书签。 1.1.1 传统架构存在的问题.................................................................................. 错误!未指定书签。 1.1.2 H3C全融合虚拟化架构 .............................................................................. 错误!未指定书签。 1.2双活数据中心建设目标 ..................................................................................... 错误!未指定书签。第2章双活数据中心业务部署 .................................................................................... 错误!未指定书签。 2.1基于的业务部署模式 ......................................................................................... 错误!未指定书签。 2.1.1 模式简介 ..................................................................................................... 错误!未指定书签。 2.1.2 企业数据中心业务典型部署...................................................................... 错误!未指定书签。 2.2基于的业务部署模式 ......................................................................................... 错误!未指定书签。 2.2.1 技术简介 ..................................................................................................... 错误!未指定书签。 2.2.2 企业数据中心典型部署.............................................................................. 错误!未指定书签。 2.2.3 与 ................................................................................................................. 错误!未指定书签。第3章双活数据中心设计............................................................................................ 错误!未指定书签。 3.1网络结构 ............................................................................................................. 错误!未指定书签。 3.2双活数据中心部署 ............................................................................................. 错误!未指定书签。

双活数据中心(业务层)方案 一、需求背景: 随着数据的大集中,银行纷纷建设了负责本行各业务处理的生产数据中心机房(一般称为数据中心),数据中心因其负担了全行业务,所以其并发业务负荷能力和不间断运行能力是评价一个数据中心成熟与否的关键性指标。 近年来,随着网上银行、手机银行等各种互联网业务的迅猛发展,银行数据中心的业务压力业成倍增加,用户对于业务访问质量的要求也越来越高,保障业务系统的7*24小时连续运营并提升用户体验成为信息部门的首要职责。 商业银行信息系统的安全、稳定运行关系着国家金融安全和社会稳定,监管机构也十分重视商业银行的灾难备份体系建设,多次发布了商业银行信息系统灾难备份的相关标准和指引,对商业银行灾备系统建设提出了明确的要求。 为适应互联网业务的快速增长,保障银行各业务安全稳定的不间断运行,提高市场竞争力,同时符合监管机构的相关要求,建设灾备、双活甚至多活数据中心正在成为商业银行的共同选择。 二、发展趋势: 多数据中心的建设需要投入大量资金,其项目周期往往很长,涉及的范围也比较大。从技术上来说,要实现真正意义上的双活,就要求网络、应用、数据库和存储都要双活。就现阶段来看,大多数客户的多数据中心建设还达不到完全的双活要求,主流的建设目标是实现应用双活。目前客户建设多数据中心的模型可以归纳为以下几种: 1.单纯的数据容灾: 正常情况下只有主数据中心投入运行,备数据中心处于待命状态。发生灾难时,灾备数据中心可以短时间内恢复业务并投入运行,减轻灾难带来的损失。这种模式只能解决业务连续性的需求,但用户无法就近快速接入。灾备中心建设的投资巨大且运维成本高昂,正常情况下灾备中心不对外服务,资源利用率偏低,造成了巨大的浪费。

双活数据中心方案 一、需求背景: 随着数据的大集中,银行纷纷建设了负责本行各业务处理的生产数据中心机房(一般称为数据中心),数据中心因其负担了全行业务,所以其并发业务负荷能力和不间断运行能力是评价一个数据中心成熟与否的关键性指标。 近年来,随着网上银行、手机银行等各种互联网业务的迅猛发展,银行数据中心的业务压力业成倍增加,用户对于业务访问质量的要求也越来越高,保障业务系统的7*24小时连续运营并提升用户体验成为信息部门的首要职责。 商业银行信息系统的安全、稳定运行关系着国家金融安全和社会稳定,监管机构也十分重视商业银行的灾难备份体系建设,多次发布了商业银行信息系统灾难备份的相关标准和指引,对商业银行灾备系统建设提出了明确的要求。 为适应互联网业务的快速增长,保障银行各业务安全稳定的不间断运行,提高市场竞争力,同时符合监管机构的相关要求,建设灾备、双活甚至多活数据中心正在成为商业银行的共同选择。 二、发展趋势: 多数据中心的建设需要投入大量资金,其项目周期往往很长,涉及的范围也比较大。从技术上来说,要实现真正意义上的双活,就要求网络、应用、数据库和存储都要双活。就现阶段来看,大多数客户的多数据中心建设还达不到完全的双活要求,主流的建设目标是实现应用双活。目前客户建设多数据中心的模型可以归纳为以下几种: 1.单纯的数据容灾: 正常情况下只有主数据中心投入运行,备数据中心处于待命状态。发生灾难时,灾备数据中心可以短时间内恢复业务并投入运行,减轻灾难带来的损失。这种模式只能解决业务连续性的需求,但用户无法就近快速接入。灾备中心建设的投资巨大且运维成本高昂,正常情况下灾备中心不对外服务,资源利用率偏低,造成了巨大的浪费。

目录 第1章概述 (2) 1.1数据集中阶段的数据中心建设 (2) 1.1.1 传统架构存在的问题 (2) 1.1.2 H3C全融合虚拟化架构 (3) 1.2双活数据中心建设目标 (3) 第2章双活数据中心业务部署 (5) 2.1基于IP的业务部署模式 (5) 2.1.1 模式简介 (5) 2.1.2 企业数据中心IP业务典型部署 (5) 2.2基于DNS的业务部署模式 (7) 2.2.1 DNS技术简介 (7) 2.2.2 企业数据中心DNS典型部署 (8) 2.2.3 GSLB与SLB (10) 第3章XXXX双活数据中心设计 (13) 3.1XXXX网络结构 (13) 3.2XXXX双活数据中心部署 (13)

第1章概述 为进一步推进XXXX信息化建设,以信息化推动XXXX业务工作的改革与发展,XXXX在科技楼建有核心机房和一个小的本地容灾备份中心,现在在干保楼又新建了容灾网,实现同城双中心布局。 为提高业务可靠性与双中心设备资源的利用率,XXXX拟建同城双活数据中心,达到双中心同时对外提供同种业务的目标,同时实现业务切换无感知、计算资源灵活调度的功能目标。 1.1 数据集中阶段的数据中心建设 1.1.1传统架构存在的问题 传统数据中心网络采用传统以太网技术构建,随着各类业务应用对IT需求的深入发展,业务部门对资源的需求正以几何级数增长,传统的IT基础架构方式给管理员和未来业务的扩展带来巨大挑战。具体而言存在如下问题: 维护管理难:在传统构架的网络中进行业务扩容、迁移或增加新的服务功能越来越困难,每一次变更都将牵涉相互关联的、不同时期按不同初衷建设的多种 物理设施,涉及多个不同领域、不同服务方向,工作繁琐、维护困难,而且容 易出现漏洞和差错。比如数据中心新增加一个业务类型,需要调整新的应用访 问控制需求,此时管理员不仅要了解新业务的逻辑访问策略,还要精通物理的 防火墙实体的部署、连接、安装,要考虑是增加新的防火墙端口、还是需要添 置新的防火墙设备,要考虑如何以及何处接入,有没有相应的接口,如何跳线,以及随之而来的VLAN、路由等等,如果网络中还有诸如地址转换、7层交换

曙光DS800-G25 双活数据中心解决案介绍 曙光信息产业股份有限公司

1解决案概述 在信息社会里,数据的重要性已经毋容置疑,作为数据载体的存储阵列,其可靠性更是备受关注。尤其在一些关键应用中,不仅需要单台存储阵列自身保持高可靠性,往往还需要二台存储阵列组成高可靠的系统。一旦其中一台存储阵列发生故障,另一台可以无缝接管业务。这种两台存储都处于运行状态,互为冗余,可相互接管的应用模式一般称之为双活存储。 由于技术上的限制,传统的双活存储案无法由存储阵列自身直接实现,更多的是通过在服务器上增加卷镜像软件,或者通过增加额外的存储虚拟化引擎实现。通过服务器上的卷镜像软件实现的双活存储,实施复杂,对应用业务影响大,而且软件购买成本较高。通过存储虚拟化引擎实现的双活存储,虽然实施难度有一定降低,但存储虚拟化引擎自身会成为性能、可靠性的瓶颈,而且存在兼容性的限制,初次购买和维护成本也不低。 曙光DS800-G25双活数据中心案采用创新技术,可以不需要引入任第三软硬件,直接通过两台DS800-G25存储阵列实现两台存储的双活工作,互为冗余。当其中一台存储发生故障时,可由另一台存储实时接管业务,实现RPO、RTO为0。这是一种简单、高效的新型双活存储技术。

2产品解决案 曙光DS800-G25双活数据中心案由两台存储阵列组成,分别对应存储引擎A、引擎B。存储引擎A 和B上的卷可配置为双活镜像对,中间通过万兆以太网链路进行高速数据同步,数据完全一致。由于采用虚拟卷技术,双活镜像对中的两个卷对外形成一个虚拟卷。对服务器而言,双活镜像对就是可以通过多条路径访问的同一个数据卷,服务器可以同时对双活镜像对中两个卷进行读写访问。组成双活镜像系统的两台存储互为冗余,当其中一台存储阵列发生故障时,可由另一台存储阵列直接接管业务。服务器访问双活存储系统可根据实际需要,选用FC、iSCSI式,服务器访问存储的SAN网络与数据同步的万兆网络相互独立,互不干扰。 组网说明: 1)服务器部署为双机或集群模式,保证服务器层的高可用, 2)存储与服务器之间的连接可以采用FC、iSCSI链路,建议部署交换机进行组网; 3)存储之间的镜像通道采用10GbE链路,每个控制器上配置10GbE IO接口卡,采用光纤交叉直连的式,共需要4根直连光纤; 4)组网拓扑

双活数据中心建设方案建议书

前言 信息是用户的命脉。在过去的十年中,信息存储基础架构的建设为用户带来了长足的进步。从内置存储到外部RAID存储,从共享外部RAID阵列的多台服务器,到通过SAN共享更大存储服务器的更多服务器。在存储服务器容量不断扩展的同时,其功能也在不断增强。从提供硬件级RAID保护到跨磁盘阵列的独立于服务器的数据镜像,存储服务器正逐渐偏离服务器外围设备的角色,成为独立的“存储层”,以为服务器提供统一的数据存储,保护和共享服务。在数据中心。 随着用户服务的不断发展,对IT系统尤其是存储系统的要求越来越高。考虑到用户服务的重要性,由于信息的重要性,需要多个中心来防止单个数据中心的操作风险。 多数据中心建设计划可以防止出现单个数据中心的风险,但是面对建设多个数据中心的巨额投资,如何同时使用多个数据中心已成为IT部门的首要问题。决定者。同时,必须使用多个数据中心在各个中心之间传输和共享生产数据。众所周知,服务器性能的瓶颈主要在IO部分。不同中心之间的数据传输和共享将导致IO延迟,这将影响数据中心整体表现。 同时,各种制造商继续引入新技术,新产品,不断扩大容量,不断提高性能以及越来越多的功能。但是,由于不同存储供应商的技术实现方式不同,因此用户需要使用不同的管理界面来使用不同的供应商。存储资源。这样,也给用户行业的用户带来很多问题。首先,不可能使用统一的接口来允许服务器使用不同制造商的存储服务器,并且不同制造商的存储服务器之间的数据迁移也将导致业务中断。 针对用户跨数据中心信息传输和共享的迫切需求,推出存储解决方案,很好的解决了这些问题。

第一章.方案概述 1.需求 计划建设两个数据中心,构成同城双生产系统,两中心之间距离不超过100公里;要求数据零丢失,系统切换时间小于5分钟; 2.方案简介 为了满足客户建设容灾系统的需求,我们设计了本地双活数据中心。整体架构如下: 上图是双活数据中心总体框架,包括双活存储系统、双活数据库系统、双活应用系统和双活网络系统。 我们将利用存储双活技术和主机集群技术实现数据库系统的双活,利用负载均衡设备实现应用系统在两个数据中心内的负载均衡,利用动态域名确保两个数据中心的网络双活。 双活数据中心可以实现业务系统同时在两个节点同时工作,达到负载均衡的目的。当生产节点出现故障时,业务系统还能够在第二生产节点上正常工作,实现业务零切换。

银行双活数据中心建设方案

目录 1数据中心现状 (1) 2项目规划 (1) 数据中心改造方案 (1) 2.1业务互联网接入区域高可用设计 (1) 2.2业务互联网接入区域双活设计 (2) 2.3业务区高可用设计 (4) 2.4业务区综合前置区域基于IP的双活设计 (5) 2.5业务区OA区域基于IP的双活设计 (6) 2.6测试区域应用高可用设计 (8) 2.7项目利旧设备调换说明 (8) 3实施计划 (9) 3.1互联网接入区F5LC替换说明 (9) 3.2互联网接入区F5LC替换业务影响 (9) 3.3应用区F5LTM替换说明 (10) 3.4应用区F5LTM替换业务影响 (10)

1数据中心现状 目前有番禺生产机房和柯子岭灾备机房,两个数据中心采用裸纤DWDM互联。 数据中心按其所部署业务属性不同,划分为外网网银区、内网综合前置区、内网OA区以及负责办公用户上网的互联网接入区。 2项目规划 为提升数据中心IT资源利用效率,同时保障业务灾难时的平滑切换,计划将两中心建设为双活数据中心,并对原机房中部署的F5设备进行升级。 数据中心改造方案 2.1业务互联网接入区域高可用设计 ?网银区域高可用包括了接入互联网链路的高可用和Web/App应用的高可用。?在链路高可用上采用F5互联网融合解决方案,通过部署F5 BR-4000S,实现链路负载均衡、多数据中心负载均衡、DNS server、DDOS防护、数据中心防火墙等诸多L4-L7 Services,解决了传统架构中的“糖葫芦串”的复杂部署,简化了网络架构,降低了后期的运维管理成本。在番禺生产机房部署2台BR-4000s,通过Scale N+M集群保证网银出口的高可靠性; ?互联网出口处F5实现的DDOS防护功能有效保护了外网DNS系统的安全; ?将外网DNS迁移部署到F5设备上,为广州农商银行实现了高性能的智能DNS系统; ?在应用高可用方面,Web层使用LTM4000s,App层使用LTM2000s,实现对应用的负载均衡、SSL Offload、健康检查和会话保持等功能。 业务互联网接入区域改造后拓扑示意图如下所示:

XX 医院灾备建设灾备技术建议书 2016 年 1 月 5 日

1 项目概述 (5) 1.1 项目背 景 (5) 1.2 系统现状描 述 (5) 1.2.1 应用系统现 状 (5) 1.2.2 IT 系统现 状 (6) 1.3 需求分 析 (7) 1.3.1 行业发展要 求 (8) 1.3.2 灾备建设需 求 (9) 2 系统总体设计原则 (11) 3 容灾建设方案 (13) 3.1 业务系统特征及灾备需 求 (13) 3.1.1 HIS 门诊 类 (13) 3.1.2 HIS 住院 类 (13) 3.1.3 EMR 电子病历系 统 (14) 3.1.4 PACS 影像系 统 (14) 3.1.5 LIS 实验室检验系 统 (15) 3.1.6 医院各类经营管理系 统 (15) 3.1.7 业务需求分析汇 总 (16) 3.2 总体架构设 计 (17) 3.3 应用双活架构设 计 (18) 4 关键技术 (20) 4.1 存储层解决方 案 (20) 4.1.1 VIS 虚拟化技术.......................................................................错误!未定义书 签。 4.2 数据库层解决方 案 (25)

4.2.1 Oracle RAC 技术...................................................................... 错误!未定义 书签。 4.3 管理层解决方 案 (29) 4.3.1 灾备决策支持平台方 案 (30) 5 容灾相关产品及规格 (40) 5.1 Tecal RH5885 V3 机架服务 器 (40) 5.1.1 功能和价 值 (40) 5.1.2 规格参 数 (41) 5.2 OceanStor V3 系列存 储 (43) 5.2.1 功能和价 值 (43) 5.2.2 规格参 数 (44) 5.3 FusionSphere 云操作系 统 (46) 5.3.1 FusionCompute 虚拟 化 (46) 5.3.2 FusionManager 云管 理 (49) 5.4 SNS 系 列 (52) 5.4.1 功能和价 值 (52) 5.4.2 规格参 数 (53) 5.5 BIG-IP 本地流量管理器平 台 (58) 5.5.1 功能和价 值 (58) 5.5.2 规格参 数 (59) 5.6 OceanStor ReplicationDirector 管理软 件 (61)

双活数据中心解决方案

目录 1 用户面临的挑战和需求 (3) 1.1面临的挑战 (3) 1.2迫切需求 (3) 2NetApp双活数据中心解决方案 (4) 3NetApp解决方案优势 (5)

1 用户用户面临的挑战面临的挑战面临的挑战和需求和需求 1.1 面临的挑战 ? 目前几乎所有金融行业用户的业务正常开展都离不开后端IT 环境的支持,一旦IT 环境由于各种原因不能正常提供支撑服务,就会对用户的业务造成巨大影响。因此金融用户对后端IT 系统的可靠性和可用性的要求越来越高,需要保证IT 系统7×24的运行能力。 ? 虽然目前大部分的专业存储系统均实现了硬件容灾保护,单个部件的失效不会导致其数据访问能力的失效。但是一旦某套存储系统由于一些严重故障或灾难性事故导致其整体性失效,则会导致前端应用系统的宕机从而影响业务系统的正常运行。因此金融用户需要在硬件冗余的基础上提供更高的可靠性保证。 ? 目前很多金融用户已经采取了多数据中心的架构,并且在多个数据中心之间进行了数据容灾保护架构的建设。但是由于传统的容灾架构基本上采用了Active-Standby 的方式,因此一方面限制了数据中心的角色和功能,另一方面也限制了用户在各个数据中心部署应用系统的灵活性。最重要的一点,传统的容灾架构在进行容灾恢复的时候过程复杂且冗长,缺乏足够的智能化。因此金融用户需要一种更加灵活更加智能化的多数据中心架构。 1.2 迫切需求 ? 后端存储系统在硬件冗余保护的基础上,需要提供更高级别的可靠性保证,能在存储系统发生整体性故障的时候还能保证数据访问的正常进行,从而防止这些严重故障或灾难性事故对业务系统造成严重影响。 ? 实现双活的数据中心架构替代原有的Active-Standby 架构,双活数据中心架构必须提供如下的功能: o 前端应用服务器可以从两个数据中心均能对同一份数据进行正常访问,同一个应用的服务器可以根据实际需要部署在两个中心当中的任何一个或同时部署在两个中心,部署在两个中心的应用服务器均可以处于服务提供状态

两地三中心分布式双活数据中心技术发展趋势 2016-06-20 作者:赵培(中兴通讯) 业务连续性保障一直是IT运维的热点话题,随着近几年政企IT系统集中化的建设发展思路的确定,在数据中心层面的业务连续性保障成为了重中之重。上到国家、行业主管单位,下到企业,都在数据中心层面制定了相关的数据中心业务连续性建设标准、行业指导意见、企业规范等。2007年,国家发布了国标GB20988-2007(信息系统灾难恢复规范);2009年6月,银监会发布《商业银行信息科技风险管理指引》,要求商业银行按照两地三中心的模式建设数据中心。最近两年,随着云计算技术的发展和逐步应用,政府在智慧城市和电子政务云的建设方面也采用了集约化集中建设的思路,为保证集中化建设的数据中心可以为政务应用提供高业务连续性,双活数据中心也基本成为智慧城市和电子政务云解决方案的基本要求。 虽然两地三中心模式的概念频频被提及,但目前仅仅在金融行业中的大体量商业银行和股份银行做得好一些,基本建设了两地三中心的模式。中型金融机构(如城商行、农信行)正在按照监管单位要求,逐步建设自己的灾备体系。据统计在国内的160家城市商业银行中,70%以上的银行没有灾备中心,这些银行目前仅有一些简单的数据备份措施,整个系统存在较大风险。而建设灾备中心对于这些体量较小的金融机构也存在投资规模大、选址要求高、运行成本的问题。 最近两年,在金融监管部门的要求下,部分规模较大的金融机构采用了双活数据中心的建设方案,但由于故障导致的宕机仍然时有发生,如支付宝由于一根光纤被挖断,从而导致了大规模的网络故障和服务长时间阻断。 业界现有的各类双活两地三中心解决方案并不完美,根本无法达到国家关于RTO(故障恢复时间)小于数分钟,RPO(故障恢复点)等于0的要求。通过对淘宝光纤故障、携程程序员误删数据、西部某地方银行37小时服务中断等事故的分析,我们分析发现现有的两地三中心双活数据中心方案存在以下一些问题:

构建永不宕机的信息系统 ——双活数据中心

双活数据中心解决方案目录 案例分享 12

存储层 应用层 双活数据中心端到端技术架构 数据中心A 数据中心B 双活存储层双活访问、数据零丢失 异构阵列 双活应用层 Oracle RAC 、VMware 、FusionSphere 跨DC 高可用、 负载均衡、迁移调度 双活网络层高可靠、优化的二层互联 最优的访问路径 ≤100km 裸光纤 Fusion Sphere Fusion Sphere 接入层 汇聚层核心层DC 出口网络层 GSLB SLB GSLB SLB

前端应用的双活(VMware ) vm vm vm vm vm vm vm vm vm vm vm vm AD vm vm vm vm SQL node1MSCS vCenter Server vm vm vm vm APP……. APP……. SQL node2MSCS vm vm vm vm vm vm vm vm vm 大二层互通网络,跨数据中心VM 配置双活应用,使用虚拟化网关提供的镜像卷作为共享存储 Weblogic 业务集群 管理集群 vm Weblogic ?vSphere Cluster HA ?vSphere Cluster DRS ?配置PDL 参数 ?Huawei OceanStor UltraPath for vSphere ? 配合负载均衡设备实现 Weblogic 访问自动漂移和均衡 VMware 配置要点 业务访问效果 ?业务访问负载均衡 ?虚拟机分布按业务压力自动均衡 ?故障自动切换访问?Weblogic 可动态扩展 ? 单数据中心故障恢复后,虚拟机自动回切

1.逻辑架构 2.方案简述 某客户为了保证业务的连续性,需要部署双活数据中心,传统的数据中心解

决方案,正常情况下只有主数据中心投入运行,备数据中心处于待命状态。发生灾难时,灾备数据中心可以短时间内恢复业务并投入运行,减轻灾难带来的损失。这种模式只能解决业务连续性的需求,但用户无法就近快速接入。灾备中心建设的投资巨大且运维成本高昂,正常情况下灾备中心不对外服务,资源利用率偏低,造成了巨大的浪费。 两个数据中心(同城/异地)的应用都处于活动状态,都有业务对外提供服务且互为备份。但出于技术成熟度、成本等因素考虑,数据库采用主备方式部署,数据库读写操作都在主中心进行,灾备中心进行数据同步。发生灾难时,数据中心间的数据库可以快速切换,避免业务中断。双活数据中心可充分盘活闲置资源,保证业务的连续性,帮助用户接入最优节点,提高用户访问体验。 3.实施方案详述 真正的双活,要在数据中心的从上到下各个层面,都要实现双活。网络、应用、数据库、存储,各层面都要有双活的设计,这样才能真正意义上实现数据中心层面的双活。 从某种程度上说,双活数据中心可以看做是一个云数据中心,因为它具有云计算所需的高可靠性、灵活性、高可用性和极高的业务连续性水平。不仅能够满足应用对性能、可用性的需求,而且还可以灵活动态扩展。 3.1网络子系统 3.1.1简述 从网络上来看,双活数据中心需要将同一个网络扩展到多个数据中心,在数据中心间需要大二层网络连接并且实现服务器和应用的虚拟化数据中心互联技术。 大二层的网络技术有IRF、TRILL、SPB、EVI等。IRF是将多台网络设备(成员设备)虚拟化为一台网络设备(虚拟设备),并将这些设备作为单一设备管理和使用。

EMC数据中心容灾系统 建设方案建议书 EMC电脑系统(中国)有限公司 Version 1.0,2014/10

前言 信息是用户的命脉, 近十年来信息存储基础设施的建设在用户取得长足的进步。从内置存储转向外置RAID存储,从多台服务器共享一台外置RAID阵列,再到更多台服务器通过SAN共享更大型存储服务器。存储服务器容量不断扩大的同时,其功能也不断增强,从提供硬件级RAID保护到独立于服务器的跨磁盘阵列的数据镜像,存储服务器逐渐从服务器外设的角色脱离出来,成为单独的“存储层”,为数据中心的服务器提供统一的数据存储,保护和共享服务。 随着用户业务的不断发展,对IT系统尤其是存储系统的要求越来越高,鉴于用户业务由于信息的重要性,要求各地各用户多中心来预防单一数据中心操作性风险。 多数据中心建设方案可以预防单数据中心的风险,但面对多数据中心建设的巨额投资,如何同时利用多数据中心就成为IT决策者的首要问题。同时利用多数据中心就必需实现生产数据跨中心的传输和共享,总所周知,服务器性能的瓶颈主要在IO部分,数据在不同中心之间的传输和共享会造成IO延时,进而影响数据中心的总体性能。 同时,各家厂商不断推出新技术,新产品,容量不断扩展,性能不断提高,功能越来越丰富,但由于不同存储厂商的技术实现不尽相同,用户需要采用不同的管理界面来使用不同厂商的存储资源。这样,也给用户业用户带来不小的问题,首先是无法采用统一的界面来让服务器使用不同厂商的存储服务器,数据在不同厂商存储服务器之间的迁移也会造成业务中断。 作为信息存储行业的领先公司,EMC公司针对用户跨数据中心信息传输和共享的迫切需求,推出存储VPlex解决方案,很好的解决了这些问题。本文随后将介绍VPlex产品及其主要应用场景,供用户信息存储管理人士参考。

基于存储的双活数据中心建设方案

最近频繁接触双活数据中心,因为我们主要的客户是金融客户,很多客户对于其业务系统的的RPO与RTO要求都非常高,极端的要求RPO/RTOR近似于0。那么对于极端要求的数据中心双活存储层面的双活,并配合应用层如:VMware的VMSC,Oracle的跨站点RAC等,来实现当生产中心发生故障后实现业务的自动切换。 那么对于主流存储的双活架构主要是以下几个实现形式: 基于存储网关

即在控制器存储上层增加一套存储网关,存储将自己的lun映射给虚拟化存储网关在网关上层做LUN的Mirror以实现底层存储双活以SVC 为例,本地数据中心的双活及跨中心的同城集群双活Metro模式。 这种存储网关的模式即采用如下模式(SVC举例): 每个网关Owen相应的LUN举例如下: 主机A(系统1)写入网关---网关入写控制器---控制器写入LUN---LUN与同城存储对应的LUN实现镜像。 主机B(系统2)写入网关---网关入写控制器---控制器写入LUN---LUN与同城存储对应的LUN实现镜像。 两套网关是互备关系,系统1或2是无法同时写入到一个LUN的,这点很重要,另外为了解决高可用问题每个存储网关均是双控制器,一般至少会部署4控制器存储网关。 如果要构建一个高性能的双活存储网络,服务器写入到的网关引擎的性能就是重中的之重,SVC就是两台IBM X3550的服务器,性能堪忧,我经常遇到SVC+DS8000做同城双活的奇葩方案,典型的小驴拉高铁。

接下来我们来聊一下控制器采用A-P集群的双活模式 我们以Hp 3par存储为例,3Par不需要上层的存储网关,在控制器层直接做底层磁盘的双活,两端LUN的镜像是主站点与备站点间的Remote Copy顾名思义和SVC的双活类似,1个LUN只能被一个控制器主写入,并通过远程镜像的方式Mirror至同城站点。

分布式双活数据中心部署模式 传统主备模式是一个业务只在一个数据中心运行,企业结合灾备等级需求和业务需求,在备份中心部署了大量的备份服务器,但备份中心仅为该业务提供灾备服务,只有当灾难发生、生产数据中心瘫痪时,灾备中心的业务系统才启动这些服务器,造成备份中心服务器资源浪费,广域网链路也无法得到充分的利用。 分布式双活数据中心(如图1所示)可以使分布在多个数据中心的同一类业务同时运行,也可以将一个业务分布在不同数据中心层次化的运行,其特点如下:充分利用资源,避免了一个数据中心常年处于闲置状态而造成浪费,通过资源整合,“分布式双/多活”数据中心的服务能力是双倍的; 如果中断了一个数据中心,其他的数据中心仍可独立响应业务,对用户来说业务切换是无感知的。 图1 分布式双/多活数据中心模型 分布式双活数据中心建设是一个复杂的系统工程,包括数据、系统、业务、网络、服务器等基础设施资源多个方面,并且很多客户的需求是交杂在一起的,建设异常复杂,分布式双活数据中心的需求主要体现在以下三个方面。 广域网链路:企业的两个数据中心都具有丰富的广域网联路,分别为Internet 用户和内网用户提供服务。为了提高用户的快速体验和链路的利用率,企业往往希望用户可以通过任意一条链路访问到数据中心的业务。 服务器/存储:数据中心的服务器年年扩容,需要备份中心该业务的备份服务器也能提供业务负载,使得整个企业IT系统在不增加额外投资的前提下,性

能可以提升接近一倍。 机房基础设施:数据中心基础设施资源消耗殆尽,无法为某类业务提供扩容保障,亟待为其建设一个资源扩展机房,但周期长、成本高。如果可以将扩容资源直接建设在备份机房就方便了。另外,该企业每年年终结算时办公类业务计算量是平时的3~5倍,往往需要临时加载计算资源,过后再下线,给维护带来了压力。 针对上述的不同需求,数据中心部署模式包括网络双活、业务双活、资源双活等,三者间没有必然的联系,均可以独立建设,也可以组合建设,以满足不同用户的对性能、投资保护以及业务部署灵活性的需求。当三种方案混合使用时,则组成了分布式多活方案。由于上述三种方案以及方案的搭配经常被混淆,下面将分别独立介绍各方案。 一、网络双活--应用最成熟 该方案主要解决其广域网链路复用的问题,降低备份链路的成本从及提升网络性能,基本可以适用于所有的业务系统。 图2 典型网络双活中心部署方案 注:灰色的S1'、S2'是备份系统,不响应业务请求。 如图2所示,业务服务器在同一个数据中心或不在同一个数据中心的情况下,用户到两个数据中心的所有链路都可以得到充分的利用,如果每条链路都是按照业务流量峰值设计,网络双活方案则可以为用户/分支提供最佳的网络性能。网络双活方案不会对原有业务分区的设置、原有的IP地址策略有任何影响。

医院双活数据中心 建设方案 2013年7月

1.需求和目标 数字化医院是我国现代医疗发展的趋势。“数字化医院”是指将先进的网络及数字技术应用于医院及相关医疗工作, 实现医院内部医疗和管理信息的数字化采集、存储、传输及后处理,以及各项业务流程数字化运作的医院信息体系。“数字化医院”是由数字化医疗设备、计算机网络平台和医院业务软件所组成的三位一体的综合信息系统。数字化医院工程体现了现代信息技术在医疗卫生领域的充分应用,有助于医院实现资源整合、流程优化,降低运行成本,提高服务质量、工作效率和管理水平。 信息系统建设作为医疗行业信息化的核心内容,在近几年的发展中经历了不同的阶段。随着国家新医改方案的实施,对国内传统医院信息系统发展带来前所未有的机遇与挑战,现有的信息系统已难以全面适应医院的需求。因此,一个全新的数字化医院解决方案是当前国内医院信息化行业的迫切需求。 1.1项目需求分析 医疗行业信息系统中最重要的是信息,包括病人临床信息和医院管理信息等。医疗行业IT部门面临的最明显挑战是由信息数字化造成的信息量持续增长带来的,这些增长来源于: ●每个医疗过程涉及大量图像加上每年要执行大量扫描,使得存储的医疗 记录以超过 70% 的年增长率在增长; ●更多类型的数据:财务、临床、图像管理,结构化数据(如数据库)及 非结构化数据(如数字影像、报告、视频、演示文稿等); ●更多用途的数据:HIS、EMR/EHR、PACS、知识管理以及数据挖掘 ●更多设备产生的数据:药征、患者监视、仪器 ●更多管理法规:国家医疗记录保留要求 医疗行业中不同业务应用系统的需求不尽相同。我们以医院的两个最有代表性的应用为例,分析其来自医院业务的需求: ●HIS/EMR系统 –随着就诊人数的增长,需要保证系统的性能满足业务发展的需要;

曙光 D S 8 0 0 - G 2 5 双活数据中心解决方案介绍曙光信息产业股份有限公司

在信息社会里,数据的重要性已经毋容置疑,作为数据载体的存储阵列,其可靠性更是备受关注。尤其在一些关键应用中,不仅需要单台存储阵列自身保持高可靠性,往往还需要二台存储阵列组成高可靠的系统。一旦其中一台存储阵列发生故障,另一台可以无缝接管业务。这种两台存储都处于运行状态,互为冗余,可相互接管的应用模式一般称之为双活存储。 由于技术上的限制,传统的双活存储方案无法由存储阵列自身直接实现,更多的是通过在服务器上增加卷镜像软件,或者通过增加额外的存储虚拟化引擎实现。通过服务器上的卷镜像软件实现的双活存储,实施复杂,对应用业务影响大,而且软件购买成本较高。通过存储虚拟化引擎实现的双活存储,虽然实施难度有一定降低,但存储虚拟化引擎自身会成为性能、可靠性的瓶颈,而且存在兼容性的限制,初次购买和维护成本也不低。 曙光DS800-G25双活数据中心方案采用创新技术,可以不需要引入任何第三方软硬件,直接通过两台 DS800-G25存储阵列实现两台存储的双活工作,互为冗余。当其中一台存储发生故障时,可由另一台存储实时接管业务,实现RPQ RTO为0。这是一种简单、高效的新型双活存储技术。

曙光DS800-G25双活数据中心方案由两台存储阵列组成,分别对应存储引擎A、引擎B。存储引擎A 和B上的卷可配置为双活镜像对,中间通过万兆以太网链路进行高速数据同步,数据完全一致。由于采用虚拟卷技术,双活镜像对中的两个卷对外形成一个虚拟卷。对服务器而言,双活镜像对就是可以通过多条路径访问的同一个数据卷,服务器可以同时对双活镜像对中两个卷进行读写访问。组成双活镜像系统的两台存储互为冗余,当其中一台存储阵列发生故障时,可由另一台存储阵列直接接管业务。服务器访问双活存储系统可根据实际需要,选用FC iSCSI方式,服务器访问存储的SAN网络与数据同步的万 兆网络相互独立,互不干扰。 组网说明: 1)服务器部署为双机或集群模式,保证服务器层的高可用, 2)存储与服务器之间的连接可以采用FC、iSCSI 链路,建议部署交换机进行组网; 3)存储之间的镜像通道采用10GbE链路,每个控制器上配置1OGbE 10接口卡,采用光纤交叉直连的方式,共需要4 根直连光纤; 4)组网拓扑 5)故障组A和故障组B之间距离不超过1KM 300米以内存储私有网络连接使用多模模块,超过300 米存储私有网络连接使用单模模块; 6)配置上要求镜像对的所有主LUN位于一台引擎上,所有镜像LUN位于另外一台引擎上,当服务器组发起写IO请求时,多路径软件会自动选择最优路径至主引擎端,主引擎会统一分配写IO请求,将数据同时写入主备引擎,之后返回写完成信号给服务器。 注:只有当数据都写入主备引擎后才返回写完成信号,因此对应用而言,会有一定的延时等待,性 能约降低30%左右!

双活数据中心方案

双活数据中心方案 一、需求背景: 随着数据的大集中,银行纷纷建设了负责本行各业务处理的生产数据中心机房(一般称为数据中心),数据中心因其负担了全行业务,因此其并发业务负荷能力和不间断运行能力是评价一个数据中心成熟与否的关键性指标。 近年来,随着网上银行、手机银行等各种互联网业务的迅猛发展,银行数据中心的业务压力业成倍增加,用户对于业务访问质量的要求也越来越高,保障业务系统的7*24小时连续运营并提升用户体验成为信息部门的首要职责。 商业银行信息系统的安全、稳定运行关系着国家金融安全和社会稳定,监管机构也十分重视商业银行的灾难备份体系建设,多次发布了商业银行信息系统灾难备份的相关标准和指引,对商业银行灾备系统建设提出了明确的要求。 为适应互联网业务的快速增长,保障银行各业务安全稳定的不间断运行,提高市场竞争力,同时符合监管机构的相关要求,建设灾备、双活甚至多活数据中心正在成为商业银行的共同选择。 二、发展趋势:

多数据中心的建设需要投入大量资金,其项目周期往往很长,涉及的范围也比较大。从技术上来说,要实现真正意义上的双活,就要求网络、应用、数据库和存储都要双活。就现阶段来看,大多数客户的多数据中心建设还达不到完全的双活要求,主流的建设目标是实现应用双活。当前客户建设多数据中心的模型能够归纳为以下几种: 1.单纯的数据容灾: 正常情况下只有主数据中心投入运行,备数据中心处于待命状态。发生灾难时,灾备数据中心能够短时间内恢复业务并投入运行,减轻灾难带来的损失。这种模式只能解决业务连续性的需求,但用户无法就近快速接入。灾备中心建设的投资巨大且运维成本高昂,正常情况下灾备中心不对外服务,资源利用率偏低,造成了巨大的浪费。

双活数据中心解决方案 V100R002C10 方案描述 文档版本 01 发布日期 2015-01-30 华为技术有限公司

版权所有? 华为技术有限公司2015。保留一切权利。 非经本公司书面许可,任何单位和个人不得擅自摘抄、复制本文档内容的部分或全部,并不得以任何形式传播。 商标声明 和其他华为商标均为华为技术有限公司的商标。 本文档提及的其他所有商标或注册商标,由各自的所有人拥有。 注意 您购买的产品、服务或特性等应受华为公司商业合同和条款的约束,本文档中描述的全部或部分产品、服务或特性可能不在您的购买或使用范围之内。除非合同另有约定,华为公司对本文档内容不做任何明示或默示的声明或保证。 由于产品版本升级或其他原因,本文档内容会不定期进行更新。除非另有约定,本文档仅作为使用指导,本文档中的所有陈述、信息和建议不构成任何明示或暗示的担保。 华为技术有限公司 地址:深圳市龙岗区坂田华为总部办公楼邮编:518129 网址:https://www.doczj.com/doc/b915718698.html,

方案描述目录 目录 1 前言 (1) 2 方案描述 (3) 2.1 方案定位 (3) 2.2 方案组网 (4) 2.3 方案特点 (5) 2.4 产品介绍 (5) 2.4.1 存储阵列OceanStor 18000系列 (6) 2.4.2 存储阵列OceanStor V3系列 (6) 2.4.3 存储阵列OceanStor T系列 (7) 2.4.4 虚拟化存储网关OceanStor VIS6600T (7) 2.4.5 FC交换机OceanStor SNS系列 (8) 2.4.6 多路径软件OceanStor UltraPath (9) 2.4.7 容灾管理软件OceanStor ReplicationDirector (9) 2.4.8 负载均衡器L2800 (9) 3 术语表 (11)

双活数据中心建设方案

一、需求背景: 随着数据的大集中,银行纷纷建设了负责本行各业务处理的生产数据中心机房(一般称为数据中心),数据中心因其负担了全行业务,所以其并发业务负荷能力和不间断运行能力是评价一个数据中心成熟与否的关键性指标。 近年来,随着网上银行、手机银行等各种互联网业务的迅猛发展,银行数据中心的业务压力业成倍增加,用户对于业务访问质量的要求也越来越高,保障业务系统的7*24小时连续运营并提升用户体验成为信息部门的首要职责。 商业银行信息系统的安全、稳定运行关系着国家金融安全和社会稳定,监管机构也十分重视商业银行的灾难备份体系建设,多次发布了商业银行信息系统灾难备份的相关标准和指引,对商业银行灾备系统建设提出了明确的要求。 为适应互联网业务的快速增长,保障银行各业务安全稳定的不间断运行,提高市场竞争力,同时符合监管机构的相关要求,建设灾备、双活甚至多活数据中心正在成为商业银行的共同选择。 二、发展趋势: 多数据中心的建设需要投入大量资金,其项目周期往往很长,涉及的范围也比较大。从技术上来说,要实现真正意义上的双活,就要求网络、应用、数据库和存储都要双活。就现阶段来看,大多数客户的多数据中心建设还达不到完全的双活要求,主流的建设目标是实现应用双活。目前客户建设多数据中心的模型可以归纳为以下几种: 1.单纯的数据容灾: 正常情况下只有主数据中心投入运行,备数据中心处于待命状态。发生灾难时,灾备数据中心可以短时间内恢复业务并投入运行,减轻灾难带来的损失。这种模式只能解决业务连续性的需求,但用户无法就近快速接入。灾备中心建设的投资巨大且运维成本高昂,正常情况下灾备中心不对外服务,资源利用率偏低,造成了巨大的浪费。