Columbia-UCF TRECVID2010 Multimedia Event Detection:

Combining Multiple Modalities, Contextual Concepts, and

Temporal Matching

Yu-Gang Jiang1, Xiaohong Zeng1, Guangnan Ye1, Subhabrata Bhattacharya2,

Dan Ellis1, Mubarak Shah2, Shih-Fu Chang1

1 Department of Electrical Engineering, Columbia University

2 Department of EECS, University of Central Florida

Summary

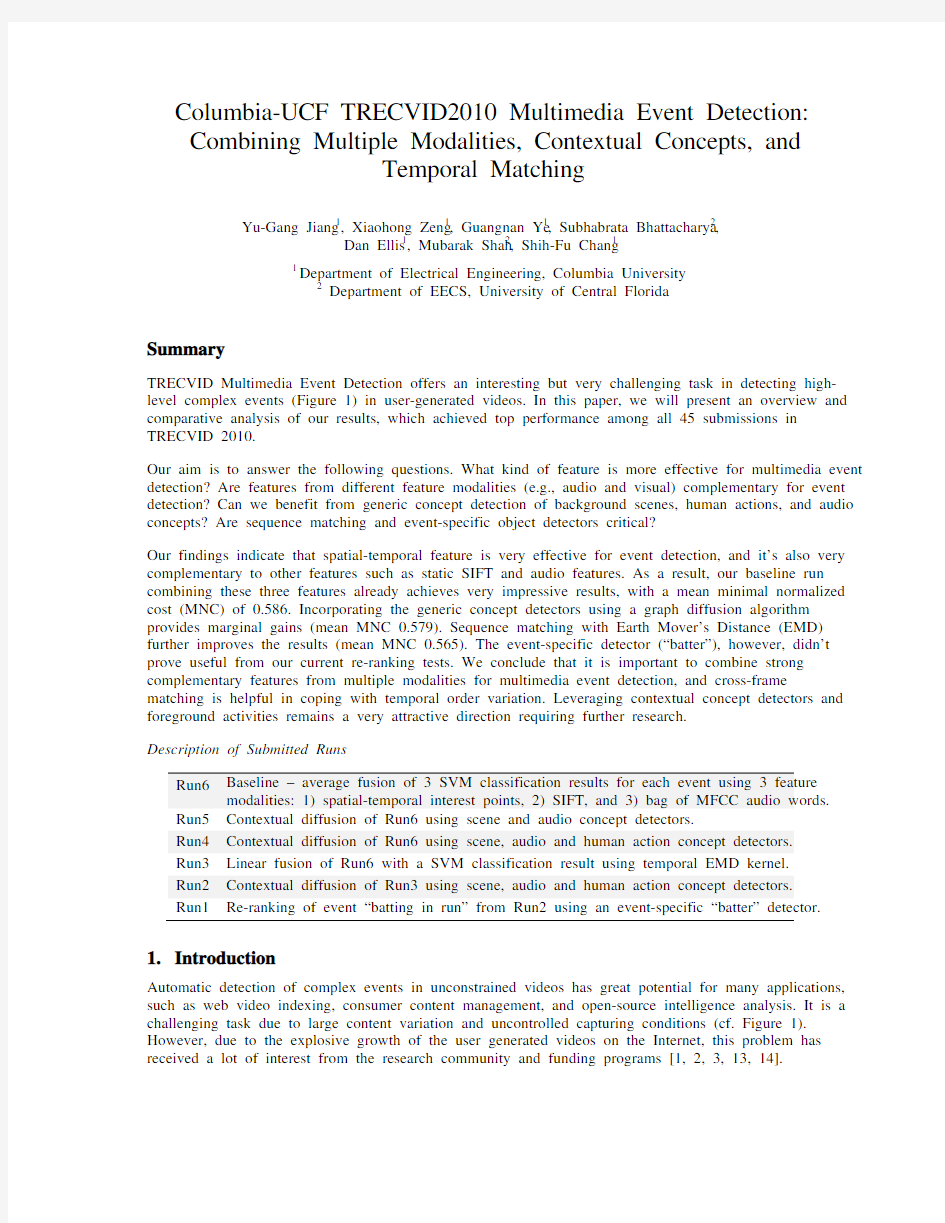

TRECVID Multimedia Event Detection offers an interesting but very challenging task in detecting high-level complex events (Figure 1) in user-generated videos. In this paper, we will present an overview and comparative analysis of our results, which achieved top performance among all 45 submissions in TRECVID 2010.

Our aim is to answer the following questions. What kind of feature is more effective for multimedia event detection? Are features from different feature modalities (e.g., audio and visual) complementary for event detection? Can we benefit from generic concept detection of background scenes, human actions, and audio concepts? Are sequence matching and event-specific object detectors critical?

Our findings indicate that spatial-temporal feature is very effective for event detection, and it’s also very complementary to other features such as static SIFT and audio features. As a result, our baseline run combining these three features already achieves very impressive results, with a mean minimal normalized cost (MNC) of 0.586. Incorporating the generic concept detectors using a graph diffusion algorithm provides marginal gains (mean MNC 0.579). Sequence matching with Earth Mover’s Distance (EMD) further improves the results (mean MNC 0.565). The event-specific detector (“batter”), however, didn’t prove useful from our current re-ranking tests. We conclude that it is important to combine strong complementary features from multiple modalities for multimedia event detection, and cross-frame matching is helpful in coping with temporal order variation. Leveraging contextual concept detectors and foreground activities remains a very attractive direction requiring further research.

Description of Submitted Runs

Run6 Baseline – average fusion of 3 SVM classification results for each event using 3 feature modalities: 1) spatial-temporal interest points, 2) SIFT, and 3) bag of MFCC audio words.

Run5 Contextual diffusion of Run6 using scene and audio concept detectors.

Run4 Contextual diffusion of Run6 using scene, audio and human action concept detectors.

Run3 Linear fusion of Run6 with a SVM classification result using temporal EMD kernel.

Run2 Contextual diffusion of Run3 using scene, audio and human action concept detectors.

Run1 Re-ranking of event “batting in run” from Run2 using an event-specific “batter” detector.

1.Introduction

Automatic detection of complex events in unconstrained videos has great potential for many applications, such as web video indexing, consumer content management, and open-source intelligence analysis. It is a challenging task due to large content variation and uncontrolled capturing conditions (cf. Figure 1). However, due to the explosive growth of the user generated videos on the Internet, this problem has received a lot of interest from the research community and funding programs [1, 2, 3, 13, 14].

In TRECVID 2010, a new Multimedia Event Detection (MED) task is established to advance research and development in this area. The aim of MED is to develop systems that can automatically find video clips containing any event of interest, assuming only a limited amount of training exemplars are given. Figure 1 displays a few example video frames of the three events evaluated in TRECVID MED 2010.

Making a cake

Batting a run in

Assembling a shelter

Figure 1: Example frames of the three events evaluated in TRECVID MED 2010. Content of the same event class can be very different.

In our MED 2010 system, we explored several interesting and important issues including video feature representation, temporal matching, event contexts, and reranking by event-specific object detector. In the following we discuss each of the components in detail.

2.Feature Representation

Feature representation is critical for video content understanding. In TRECVID 2010, we explore three feature modalities for multimedia event detection.

Static SIFT feature

We adopt two sparse keypoint detectors: Difference of Gaussian (DoG) [4] and Hessian Affine [5]. Since the two detectors extract keypoints of different properties, we expect that they are complementary. Using multiple keypoint detectors is also suggested by many previous works [e.g., 6] for better performance. SIFT [4] is then adopted to describe each keypoint as a 128 dimensional vector. For each type of keypoints, we generate a visual vocabulary of 500 words using k-means. The visual words were found using features extracted from the web videos of TRECVID 2010 concept detection task. As processing all MED video frames will be computationally very expensive, we sample one frame from every two seconds.

Spatial-temporal interest points

While SIFT describes 2D local structures in images, spatial-temporal interest points (STIP) capture space-time volumes where the image values have significant local variations in both space and time. We use Laptev’s method [7] to compute locations and descriptors for STIPs in video. The detector is based on an extension of Harris operator to space-time as described in [7]. Their code does not contain scale selection; instead interest points are detected at multiple spatial and temporal scales. HOG (Histograms of Oriented Gradients; 72 dimensions) and HOF (Histograms of Optical Flow; 72 dimensions) descriptors are computed for the 3D video patches in the neighborhood of the detected STIPs. We use concatenated HOGHOF feature (144 dimensions) as the final descriptor for each STIP.

MFCC audio feature

In addition to visual features like SIFT and STIP, audio is another important cue for detecting events in videos. We expect it to be complementary to the visual features. In audio processing, the mel-frequency cepstrum (MFC) is a representation of the short-term power spectrum of a sound. Mel-frequency cepstral coefficients (MFCC) are coefficients that collectively make up an MFC. They are derived from a type of cepstral representation of the audio clip (a nonlinear "spectrum-of-a-spectrum"). MFCC has been very

popular in a large variety of audio related applications such as speech recognition. For TRECVID MED task, we compute MFCC feature over every 32ms time-window with 50% (16ms) overlap.

2.1 Bag-of-X Representation

Given a video clip, we extract three sets of features (SIFT, STIP, and MFCC). Due to the variations in length and content complexity, the sets of the same feature differ in cardinality across different video clips. This creates difficulties for learning methods (e.g., classifiers) which usually demand feature vectors of fixed dimension as input. To address this problem, we adopt vector quantization (VQ) technique to cluster each type of feature descriptors in feature space into a large number of clusters (i.e., “words”) using the k-means clustering algorithm, and then encode each descriptor by the index of the cluster to which it belongs. The features extracted from each frame or audio time window are collapsed into a single bag. At the end, each video clip will be represented by a fixed dimensional histogram, one for each descriptor type. This forms the popular Bag-of-X framework which has been widely used for representing documents (bag-of-word), images (bag-of-visual-word), as well as audio sounds (bag-of-audio-word).

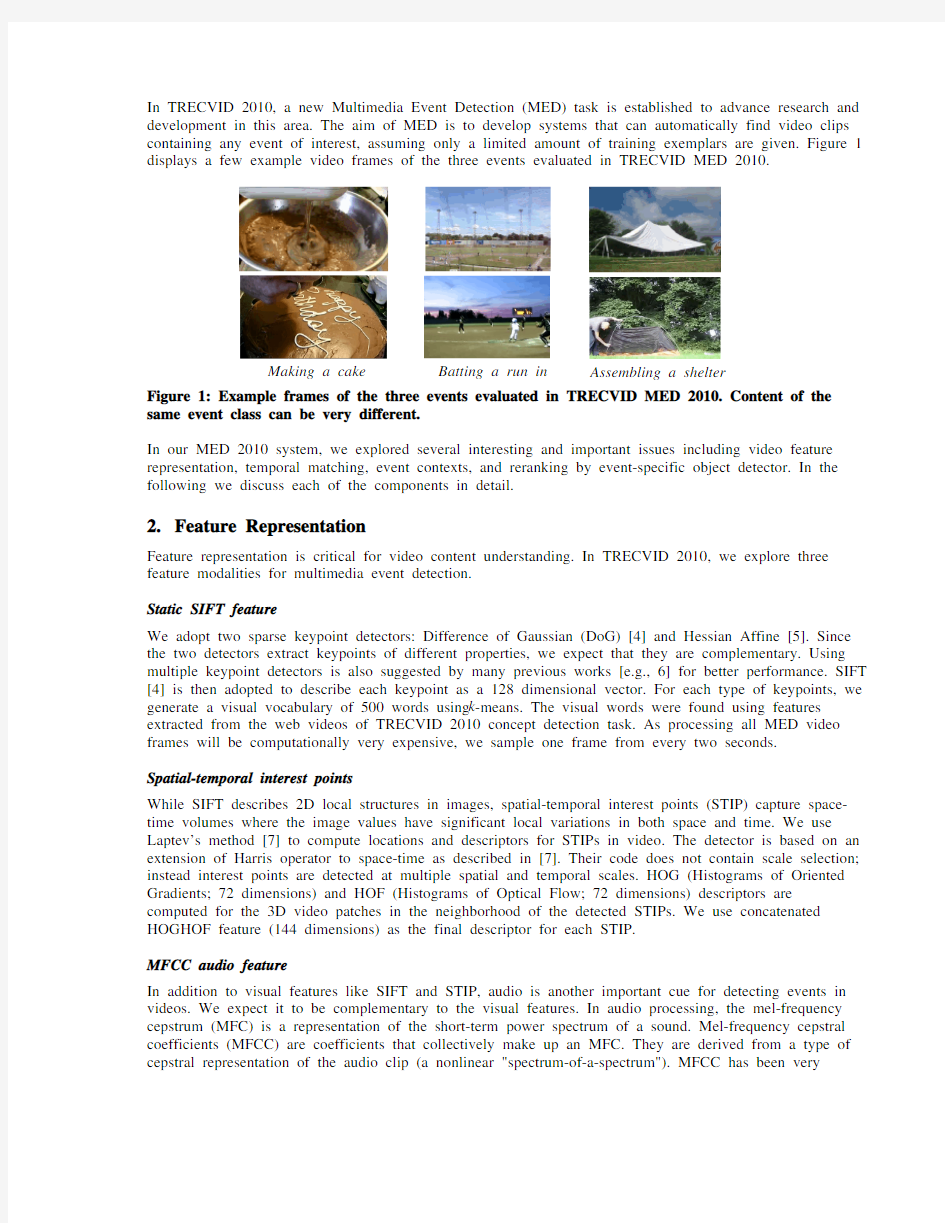

A fundamental difference of Bag-of-X representation for images or audio sounds is that the visual/audio words are the outcome of clustering algorithms (as opposed to the natural word entities in text documents). As a result, the performance of Bag-of-X image/sound representation is subject to several representation choices, such as vocabulary size (the number of clusters/words) and word weighting scheme in VQ. Different from the SIFT feature for which 500-d vocabularies are chosen, we empirically generate a vocabulary of 4000 words for the STIP and MFCC feature. Smaller vocabularies are used for SIFT because we also applied spatial partitioning (a.k.a. spatial pyramid; Figure 2) of the video frames which prefers compact vocabularies [6, 8]. While for STIP, no spatial partitioning is used as we have found it unhelpful from our previous internal studies. For all the three features, we adopt a soft-weighting strategy for VQ which has been proved very useful for alleviating the quantization effect caused by clustering [9].

Figure 2: Image representation using static SIFT features with spatial partitioning (1x1 and 2x2).

The two histograms are concatenated into a 5000-d feature vector as the final representation for each video frame. Given a video clip, we aggregate the 5000-d features from its sampled frames together as our clip-level feature representation. The clip-level features are then L-2 normalized before classification by SVM.

Baseline classifiers

With the three feature modalities (SIFT: 5000-d; STIP: 4000-d; MFCC: 4000-d), we train three baseline SVM classifiers using χ2 kernel for each of the events over MED 2010 development set (1700+ web videos). The average fusion of probability predictions from the three SVM classifiers forms our baseline submission run6.

3. Classification with Temporal Matching

While accumulating all the SIFT/STIP/MFCC features from a video clip into a single feature vector seems a reasonable choice, it neglects the temporal information within the video clip. We therefore apply the earth mover’s distance (EMD) [10] to measure video clip similarity, which was used in our previous work in [3]. We only adopt SIFT feature in this experiment, and thus each video clip is represented by a sequence of 5000-d bag-of-visual-word feature vectors (cardinality equals to the number of sampled frames). As shown in Figure 3, EMD computes the optimal flows between two sets of frames/features, producing the optimal match between both sets. Specifically, let a video clip be P = {(p 1, w p 1), ... , (p m ,w pm )} of m frames, where p i is the index of the i th frame, and w pi is the corresponding weight (uniformly set as 1/m in this experiment). To match P with another video clip Q = {(q 1, w q 1), ... , (q n ,w qn )} of n frames, the EMD is computed as

EMD (P, Q) = Σi Σj f ij d ij / Σi Σj f ij , (1)

where the ground distance d ij between frames p i and q j is measured by the χ2 distance of their corresponding bag-of-visual-word features. The flow f ij representing the amount of weight transferred from frames p i and q j is optimized in EMD by minimizing the overall transportation workload Σi Σj f ij d ij , subject to the following constraints:

f ij ≥0 (2)

Σj f ij ≤w pi Σi f ij ≤w qj Σi Σj f ij = min(Σi w pi , Σj w qj ).

The EMD is then used in a generalized form of Gaussian kernel for SVM classification:

K(P,Q)=exp -ρEMD (P,Q), (3)

where ρ is the kernel width parameter.

P

Q Figure 3: Toy example of EMD-based temporal matching between two sets of frames P and Q ; lines indicate the presence of nonzero flows between corresponding frame pairs.

4. Diffusion with Generic Contextual Concept Detectors

Events are mostly defined by several (moving) objects such as “person”, and generally occur under particular scene settings with certain audio sounds. For example, as shown in Figure 1, “batting a run in” contains people of various actions in the baseball field scene with typically some cheering or clapping sounds. Such event-scene-object-sound dependency provides rich contextual information for understanding the events. Most previous approaches, however, handled events, scenes, objects, and audio sounds separately without considering their relationship. Our intuition is that once the contextual cues can be computed, they can be utilized to make the event detection more robust. We therefore explore such contexts in MED 2010.

4.1 Building Contextual Concept Detectors

To build detectors (classifiers) for a large number of contextual concepts, we first need to collect enough training samples. To this end, we defined 22 contextual concepts as listed in Table 1, and designed an annotation tool to label the development videos (but not the test videos) for 20 contextual concepts. Each video is divided to multiple 10-sec clips, and the annotation is conducted at clip-level. Note that this annotation work is not just for this year’s MED, but is a part of a long-lasting effort of building many contextual detectors for event detection.

With the labeled training data, we train SVM classifiers for detecting the concepts. For Human Action concepts, we use the bag-of-X representation of the STIP feature. Here we use a hierarchical k-means implementation to generate visual vocabularies of sizes 100, 200, 500, and 1000. Then a histogram intersection kernel multi-class SVM classifier is trained per action and vocabulary. Average fusion is used to combine classification outputs from different vocabulary sizes for each action. For the scene and audio concepts, we adopt similar classification framework based on the SIFT and MFCC features respectively. One difference in the audio concept classifiers is that we use a representation based on MFCC mean and covariance for each 10-sec clip, not the VQ histograms as in the event classifiers. From our evaluation, these context concept detectors worked fairly well. Figure 4 shows some top ranked frames (with high prediction scores) in the test video dataset.

Human Action Concepts

Scene Concepts

Audio Concepts

Person walking Person running Person squatting Person standing up Person making/assembling stuffs with hands (hands visible) Person batting baseball Indoor kitchen Outdoor with grass/trees visible Baseball field Crowd (a group of 3+ people) Cakes (close-up view) Outdoor rural

Outdoor urban

Indoor quiet

Indoor noisy

Original audio

Dubbed audio

Speech comprehensible Music

Cheering

Clapping

Table 1: Contextual Concept Names.

Baseball field

Cakes

(close-up view)

Crowd

(3+ people)

Grass/trees

Indoor kitchen

Figure 4: Top results of scene concept detection in MED 2010 test set. For each concept, frames of the top 16 detected video clips are shown, ordered from left to right and top to bottom.

4.2 Contextual Diffusion

To utilize these contextual detectors, we apply a contextual diffusion algorithm DASD (domain adaptive semantic diffusion) proposed in our prior work [11]. One underlying assumption of DASD is that detectors of frequently concurrent concepts/events should produce highly correlated scores. For example, the detection result of “baseball field” and “batting a run in” should be highly consistent as they frequently co-occur.

We therefore construct an undirected and weighted graph, namely semantic graph, to model the relationship between (and within) the events and the contextual concepts, where the relationship is estimated according to ground-truth labels of the events/concepts over the development dataset. In MED 2010, the graph contains 24 nodes (3 events and 21 contextual concepts). A part of the graph node relationship (only the event to concept relationship) is visualized in Figure 5. The graph is then applied to refine the detection scores using a function level diffusion process, where the aim is to recover the consistency of the detection scores w.r.t. the pair-wise relationship. More formally, the cost function of DASD is defined as:

E(g, W) = 1/2 Σij W ij ||g(c i) – g(c j)||2 (4) where g(c i) and g(c j) are the detection score vectors over a set of testing samples (video clips) for concepts/events c i and c j, and W ij indicates the affinity (i.e., weight on the corresponding graph edge) between the two concepts/events.

Apparently, this cost function evaluates the smoothness of g over the semantic graph. Therefore, reducing the function value of E makes the detection results g more consistent with the concept affinities captured by W. Specifically, we use gradient descent to reduce E by updating g iteratively. Interested readers are referred to [11] for more details of the DASD method. In the original DASD algorithm, it also involves a graph adaptation process which adapts W according to test data distribution. This process was not applied in MED 2010 as the development and test data are from similar domains.

Assembling a

Batting a run

Figure 5: Estimated relationship (correlation) between the 3 events and the 21 contextual concepts according to ground-truth annotations. Note that the semantic graph not only models these event-concept relationships shown in this figure, but also the event-event and concept-concept correlations.

The color-highlighted cells indicate the strong correlations discovered between events and the concepts.

5.Reranking with Event-Specific Object Detector

Besides the generic methods mentioned above, we are also interested in evaluating some ad-hoc ideas that are specific to individual events only. For event “batting a run in”, videos usually contain certain human objects (e.g., batters) of familiar gestures and similar clothing. Assuming that videos of this event should have a high ratio of frames with batter visible, we trained a “batter” detector as an additional clue for detecting this specific event.

In order to train the detector, we manually labeled 800 positive frames in the development set by marking the bounding boxes of the whole body of batters. Negative samples (image patches) are randomly drawn

from the other parts of the frames. Harr feature is extracted for each image patch. Other features such as HOG can also be applied but is not included in our current implementation. Training of the detector is based on the popular AdaBoost framework proposed in [12]. We found such specialized detectors to be reasonably effective in the small validation data set. Figure 6 shows a few examples of the detection results. The batter detector is applied as a post-processing reranking step. For every test video, the ratio of frames that have positive detection of the batter object is first computed. If the ratio is larger than a threshold (its optimal value determined over a separate validation set), the event score of the video clip will be multiplied with the ratio and the video will be moved up to the top of the ranked list. Event detection scores of other videos are not modified.

Figure 6: “batter” detection results.

6.Results and Analysis

Our MED system is designed to combine each of the core components introduced above. We submitted 6 runs to by incrementally adding in new components in order to study their effectiveness. Aside from the official submissions, we have also conducted evaluations over the dry-run validation set to analyze the contribution of each feature modality.

Figure 7 shows our six official submissions and all of the official TRECVID-2010 MED submissions. Performance is measured by mean Minimal Normalized Cost (MNC) over the three events. The MNC is computed based on the best (oracle) threshold of the detection scores, reflecting the best possible detection performance a system can reach. Detailed evaluation framework and description of the metrics can be found at https://www.doczj.com/doc/b212393993.html,/itl/iad/mig/med10.cfm. From the figure we can see that a judicious approach using average fusion of the three feature modalities (Run6) already achieves very impressive results, with a mean MNC at 0.586. Incorporating the generic concept detectors (run4&5) using the graph diffusion algorithm provides moderate gains (run4 mean MNC 0.579). In addition, temporal matching with EMD kernel (run2&3) further improves the results (run2 mean MNC 0.565). The event-specific “batter” detector used in run1, however, didn’t prove useful from our current re-ranking tests. We conclude that event detection using multiple feature modalities is effective. While temporal matching with EMD kernel shows some noticeable gain, the contextual graph diffusion didn’t show significant improvements as we expected. This may be due to the fact that our event baseline has already used all three features combining different modalities (both visual and audio) In addition, our current implementation of concept detectors uses only single feature type (either visual or audio) and thus their performance may not be as strong as the multi-modal baseline detectors for events. Therefore, adding such relatively weak concept classifiers as context did not prove to be significantly beneficial in our current implementation.

Table 2 gives the performance of each feature component over the dry-run validation set. We see that all the three features perform fairly well, and the fusion of them significantly improves the results. Comparing the individual feature performance, STIP is slightly better than SIFT in terms of mean AP. This is consistent with the observations in recent works on action/event recognition [13]. For event “batting a run in”, SIFT outperforms STIP – which is probably because this event contains more consistent background scenes (“baseball field”), for which static SIFT features are very discriminative.

Another very interesting observation from our experiments is that standard audio feature MFCC, modeled

in a bag-of-audio-word framework, demonstrates an impressive capability for event detection in unconstrained videos (though still lower than the visual counterparts). It is quite complementary to the state-of-the-art visual features used for event detection, as shown in the consistent accuracy improvement

after fusing the audio-based detectors with the visual approaches. This shows the potential of jointly using

both visual and audio features for multimedia event detection, which was only investigated in very few

prior works [15].

vertical axis shows the performance measured by mean minimal normalized cost (mean MNC). This figure is best viewed in color.

Assembling a shelter Batting a run in Making a cake Mean AP Visual STIP 0.468 0.719 0.476 0.554

Visual SIFT 0.353 0.787 0.396 0.512

Audio MFCC 0.249 0.692 0.270 0.404

0.593

STIP+SIFT 0.508 0.796 0.476 STIP+SIFT+MFCC 0.533 0.873

0.633

0.493

Table 2: Average precision (AP) performance of event detectors based on features of different modalities and their combinations. Note higher AP means better performance.

Figure 8 further displays the per-event performance of all the submissions. In addition to MNC, actual normalized cost (ANC) is also computed based on our provided threshold value. To determine the threshold, we simply treat the top 40 videos with the highest scores as positive and all the remaining ones

as negative. In terms of both MNC and ANC, the runs we submitted demonstrate the best performance over

all the submitted runs. In addition, from the results we also observed that different events favor different components or combination strategies. For example, the EMD-based temporal matching is helpful for “assembling a shelter” and “making a cake”, but not for “batting a run in”. Therefore another very interesting research direction is to investigate an adaptive method to automatically find out the best component and/or combinations for each event.

Figure 8: Per-event performance of our submitted MED runs (circled) and all 45 official submissions, measured by both minimal normalized cost (MNC) and actual normalized cost (ANC). We obtained top performance for all the three events. Note lower cost values mean better performance.

7. Acknowledgement

Many thanks to Yan Wang for developing the concept annotation tool and all the members of Columbia’s Digital Video and Multimedia Lab for their help in the annotation effort.

8. References

[1] S.-F. Chang, D. Ellis, W. Jiang, K. Lee, A. Yanagawa, A.C. Loui, J. Luo, “Large-scale multimodal

semantic concept detection for consumer video”, ACM MIR, 2007.

[2] J. Liu, J. Luo, M. Shah, “Recognizing realistic actions from videos ‘in the wild’”, CVPR, 2009.

[3] D. Xu, S.-F. Chang, “Video event recognition using kernel methods with multi-level temporal

alignment”, IEEE Trans. on PAMI, vol. 30, no. 11, pp. 1985-1997, 2008.

[4] D. G. Lowe, “Distinctive image features from scale-invariant keypoints”, IJCV, vol. 60, no. 2, pp. 91-

110, 2004.

[5] K. Mikolajczyk, C. Schmid, “Scale and affine invariant interest point detectors”, IJCV, vol. 60, no. 1,

pp. 63-86, 2004.

[6] Y.-G. Jiang, J. Yang, C.-W. Ngo, A. G. Hauptmann, “Representations of keypoint-based semantic

concept detection: a comprehensive study”, IEEE Trans. on Multimedia, vol. 12, no. 1, pp. 42-53, 2010.

[7]I. Laptev, “On space-time interest points”, IJCV, vol. 64, no. 2, pp. 107-123, 2005.

[8]S. Lazebnik, C. Schmid, J. Ponce, “Beyond bags features: spatial pyramid matching for recognizing

natural scene categories”, CVPR, 2006.

[9]Y.-G. Jiang, C.-W. Ngo, J. Yang, “Towards optimal bag-of-features for object categorization and

semantic video retrieval”, ACM CIVR, 2007.

[10]Y. Rubner, C. Tomasi, L. J. Guibas, “A metric for distributions with applications to image databases”,

ICCV, 1998.

[11]Y.-G. Jiang, J. Wang, S.-F. Chang, C.-W. Ngo, “Domain adaptive semantic diffusion for large scale

context-based video annotation”, ICCV, 2009.

[12]P. Viola, M. Jones, “Rapid object detection using a boosted cascade of simple features”, CVPR, 2001.

[13]M. Marszalek, I. Laptev, C. Schmid, “Actions in context”, CVPR, 2009.

[14]J. Liu, Y. Yang, M. Shah, “Learning semantic visual vocabularies using diffusion distance”, CVPR,

2009.

[15]W. Jiang, C. Cotton, S.-F. Chang, D. Ellis, A. C. Loui, “Short-term audio-visual atoms for generic

video concept classification”, ACM Multimedia, 2009.

说明: 一、论文的内容及顺序 (一)中文论文的内容及顺序为: 1、论文封面 2、中文摘要 3、英文摘要 4、论文主体部分 5、参考文献 6、致谢(中文论文的致谢) 7、附录 其中1不编页码,2--7用阿拉伯数字编排页码。 二、除封面外每页都要有页眉,页眉在每一页的最上方,页眉内容为“河南师范大学本科毕业论文(设计)”。用小五号宋体,居中排列,论文、设计二选一。 三、论文全文要求单面打印。 (二)外文论文的内容及顺序为: 1、论文封面 2、致谢(外文论文的致谢) 3、中文摘要 4、英文摘要 5、论文主体部分 6、参考文献 7、附录

学号: XXXXXXXX (四号黑体) /AC Sn(IV)掺杂纳米TiO 2 降解橙黄G的动力学与机理研究(20磅字号,华文中宋,加粗,居中) 学院名称:化学与环境科学学院 专业名称: XXXX 年级班别: XXXX级XXXXX 姓名: XXX 指导教师: XXX (黑体,小三,居中,上面横线上内容要居中) XXXX年XX月

Sn(IV)掺杂纳米TiO2/AC降解橙黄G的动力学与机理研究 (黑体小三,1.5倍行距,居中) /AC 摘要(黑体,小四,1.5倍行距)采用溶胶-凝胶法制备了掺杂Sn(IV)的TiO 2 光催化剂,以生物染料橙黄G为目标降解物,研究了多相光催化降解橙黄G的动力学规律┅┅┅(300字左右)(宋体,小四,1.5倍行距) 关键词(黑体,小四,1.5倍行距) Sn(IV)+ TiO /AC;橙黄G;动力学;┅┅┅(3-6 2 个)(宋体,小四,1.5倍行距) Research on the Degrdation Kinetics and Mechanism of OG over Sn(IV) Doped TiO2/AC (Times New Roman,小三号,单倍行距,加黑,首字母大写) /AC Abstract(Times New Roman,小四号,1.5倍行距,加黑) Sn(IV) doped TiO 2 photocatalyst was prepared by Sol-gel method. The different initial concentration of OG were used to study the degration kinetics of Orange G. The results showed that, the kinetics of this reaction was in accordance with Langmuir-Hinshelwood equation┅┅(Times New Roman,小四号,1.5倍行距) /AC;Orange Keywords(Times New Roman,小四号,1.5倍行距,加黑) Sn(IV)+ TiO 2 G;kinetics;┅┅┅(Times New Roman,小四号,1.5倍行距) 前言(黑体,小三,1.5倍行距,居中)染料废水的处理是大家颇为关注的课题之一,而偶氮染料是染料中品种最多的一类,约占染料总量的50%以上。染料废水色度高,有机污染物浓度大┅┅┅且具有无毒、反应速度快、降解效率高、无二次污染等优点,是近年来环境污染治理技术的研究热点[1](引用参考文献需以上标[1]形式标注出来,并在文后将此参考文献列出来)。┅┅┅(宋体,小四,1.5倍行距) 1 实验部分(黑体,小三,1.5倍行距,顶格) 1.1 试剂与仪器(二级标题,黑体,小四,1.5倍行距,顶格) 主要仪器:光催化反应仪(自制);300W高压汞灯(上海亚明灯泡厂有限公司);磁力

大学毕业生登记表填写说明 大学毕业生登记表是毕业生档案的重要组成部分,一定意义上讲也是毕业生自身能力和态度的具体表现,更是毕业生走上工作岗位后组织考核的一项基本依据。为规范我校有正式学籍应届毕业生登记表的填写格式,防止出现填写错误,特做如下说明和要求: 一、各学院(系)一定要从为毕业生负责的角度重视该项工作,精心组织,严格把关,使每个毕业生严肃认真对待,保证填写质量。《登记表》的填写工作由毕业生辅导员组织进行,向学生讲明该表的重要性和有关要求。每个毕业生填表前要认真阅读表中的“填写说明”,根据要求,如实填写。 二、表中除“班级意见”、“辅导员意见”、“学院(系)意见”和“学校意见”等栏目须分别由班集体、学院(系)和学校组织填写外,其余栏目均须由毕业生本人填写。 三、本表一律使用黑色钢笔或中性笔填写,使用铅笔或圆珠笔以及其它颜色的钢笔、中性笔填写无效,不得使用两种颜色的笔填写,要求字迹清楚、整齐,不得涂改。不出现错别字及不规范的简化字。 四、表中所列项目要求全部填写,不留空白,如有情况不明无法填写时,应写“不清”、“不祥”及其原因,如无该项情况,应写“无”。 五、表中“出生年月”、“入学时间”、“填表时间”等涉及填写数字的栏目,一律使用阿拉伯数字。 六、具体填写内容说明 1.表格封面和第一页“姓名”一栏的填写必须和身份证、户籍卡以及学籍卡一致。曾用名如有则如实填写,无则填写“无”。 2.表格封面“学院(系)”、“专业”:按全称填写,不得

简写。 3.表格封面“学号”:填写完整学号。 4.表格封面“学历”:填写“大学本科”或“大学专科”。 5.封面填表日期统一填写为:2018年6月1日。 6.“出生年月”填写格式:****年*月 7.“出生地”填写格式:**省**县或**省**市 8.“政治面貌”分为:中共党员、中共预备党员、群众等(加入民主党派的如实填写) 9.“家庭出身”分为:农民、工人、军人、干部、其他等。 10.“个人成分”:高考入学者填写“学生”;在职人员可根据自身实际情况填写。 11.“学制”:学历为大学本科者,学制填“四年”,学历为大学专科者,学制填“三年” 12.授予学位填写“**学学士”。 13.照片:统一粘贴2寸彩色照 14.“入学前所在单位”:高考入学者填写高中名称,在职 人员可根据自身实际情况填写。15.学生在校期间所获奖励、处分应如实填写。 16.“本人学历及社会经历”自小学填起,依时间顺序详细填写,年月要衔接,中途间断学习和工作的时间也要填上,并加说明。 17.家庭成员是指直系亲属(父母、兄弟姐妹、爱人和子女),主要社会关系是指对本人影响较大,关系密切的亲人。 18.“大学期间取得的学术科研成果”:主要填写毕业生在校期间发表论文论著、参与课题、发明专利等学术科研成果。 19.“何时何地何人介绍加入何种政治团体或组织”:填

金融学院2014级本科生毕业论文选题指南 注:以下题目只是选题的提示性方向,所有方向均需再细化,切勿直接以方向为题。也可以自己拟定题目,但是必须经指导老师的同意,必须符合专业培养目标要求。 第一部分金融学专业参考方向 1. 金融科技背景下商业银行转型策略研究 2. 互联网金融对我国商业银行的影响研究 3. 金融脱媒与我国商业银行的转型研究 4. 供给侧改革背景下我国商业银行信贷风险的防控 5. 我国商业银行投贷联动业务问题研究 6. 我国商业银行投贷联动模式研究 7. 我国商业银行投贷联动的实践研究 8. 我国商业银行个人理财业务问题研究 9. 我国商业银行私人银行业务问题研究 10. 我国商业银行小微企业金融服务研究 11. 我国商业银行社会责任研究 12. 我国商业银行信用风险管理研究 13. 我国商业银行利率风险管理研究 14. 我国商业银行操作风险防范研究 15. 我国商业银行零售业务发展研究 16. 我国商业银行住房按揭贷款风险管理研究 17. 外资银行进入对我国商业银行竞争行为影响研究 18. 我国农村商业银行贷款风险管理研究 19. 我国发展多层次资本市场问题研究 20. 构建服务实体经济多层次资本市场的路径选择 21. 中小企业在新三板市场融资效率研究 22. 我国新三板市场现行交易制度研究 23. 我国上市公司融资结构与公司治理绩效研究 24. 上市公司管理层收购及其对公司绩效的影响 25. 我国上市公司信息披露问题研究 26. 我国公司债券市场发展研究 27. 我国债券市场的流动性研究 28. 我国中小企业债券市场发展问题研究 29. 我国债券市场分割问题研究 30. 我国证券投资基金业绩评价研究 31. 我国上市公司关联交易类型和效应分析 32. 中国投资者风险偏好研究 33. 我国证券公司重组模式研究 34. 我国证券投资基金创新研究

大学本科毕业生登记表自我鉴定 大学本科毕业生登记表自我鉴定模板 导语:大学生活即将结束,在毕业之即,对自已三年的学习和生活做一个作一个总结和鉴定。下面就由小编为大家带来大学本科毕业生登记表自我鉴定模板,欢迎参考借鉴! 大学本科毕业生登记表自我鉴定模板(一) 四年的大学生活就这样匆匆忙忙的结束了,发现自己也长大成熟了好多。四年来点点滴滴的磨练成为我生活中的一个个关键的起点。有的辉煌,值得你记住一辈子的。我不怕苦,我只是怕我们没有挑战自我、充实自我和实现人生价值的勇气和机遇。所以我一直在努力着,一直在努力。刚上大一的时候,学校有好多的社团可以加入,比较好的就有广播站、学习部等。由于自己的害怕而放弃了加入学校这些优秀的社团。也许还要怪自己当时的想法,就是不在学校社团难道就不能发展自己了吗?难道作为一名普通的学生就不能学校做出贡献了吗?就这样机会与我擦肩而过。当我清楚知道加入社团的好处的时候,我其实也不是很后悔,而是自己默默的在心里发誓,做一名学生也要出类拔萃。 没有加入社团对我来说其实就是比别人晚了一步要进入所谓大学

的半个社会。我经常会利用课余时间去外系旁听学习,虽然没有他们专业,但总比普通学生多学习了一点。就这样我不放弃任何学习的机会,有一点就学习一点。我知道我在某些方面不如那些同学,所以我就拼命的学习,人家都说“学习能改变命运”,也许我就是冲着学习的优秀能祢补我的不足吧。所以在大一的下学期我就通过了英语四级考试,我也正准备着向高一层次发展。也准备考一些对我以后发展有用证件。当然我也不放弃在假期和空闲时间去社会实践来提高自己,比如去苏宁打工,去一些专卖店促销商品。这不仅提高了我的思想觉悟,也使我对社会有了更深刻的认识。 我的优点是诚实、热情、性格坚毅。我认为诚信是立身之本,所以我一直是以言出必行来要求自己的,答应别人的事一定按时完成。由于待人热情诚恳,所以从小学到大学一直与同学和老师相处得很好,而且也很受周围同学的欢迎,与许多同学建立起深厚的友谊。在学习知识的同时,我更懂得了,考虑问题应该周到。我这个人有个特点,就是不喜欢虎头蛇尾,做事从来都是有始有终,就算再难的事也全力以赴,追求最好的结果,正因为如此,我把自己的意志视为主要因素,相信只要有恒心铁棒就能磨成针。一个人最大的敌人不是别的什么人,而是我们自己。这么多年来,我一直都是在跟自己作战,准确地说,是和自己的意志战斗。现在回想起来,我确实比以前坚毅了许多,但我不会松懈下来的。以上这些优点,是我今后立身处世的根本,我应该继续保持,并不

西南财经大学硕士开题报告 篇一:西南财经大学本科学生毕业论文开题报告表 西南财经大学本科学生毕业论文开题报告表(小二黑体)论文类型:A—理论研究;B—应用研究;C—软件设计等; 篇二:西南财经大学本科毕业论文范例 西南财经大学 Southwestern University of Finance and Economics XX届 本科毕业论文 论文题目:互联网金融对商业银行的影响 ---以余额宝为例 学生姓名:黄月 所在学院:金融学院专业:金融学学号:41028081 指导教师:卢岚成绩: XX年 5月 西南财经大学 本科毕业论文原创性及知识产权声明 本人郑重声明:所呈交的毕业论文是本人在导师的指导下取得的成果。对本论文的研究做出重要贡献的个人和集体,均已在文中以明确方式标明。因本毕业论文引起的法律结果完全由本人承担。

本毕业论文成果归西南财经大学所有。 特此声明 毕业论文作者签名: 作者专业: 作者学号: XX年5 月 1日 西南财经大学本科学生毕业论文开题报告表 论文类型:A—理论研究;B—应用研究;C—软件设计等; 中文摘要 随着互联网金融对传统金融业务的不断渗透,以支付宝公司的余额宝为代表的互联网基金短期内吸纳了巨量的活期资金,对商业银行造成了显著冲击。本文在介绍了互联网金融的定义、互联网金融发展历程及国内外现有的互联网金融模式(包括我国现在最热门的余额宝和P2P)的基础上,以余额宝的视角,分别从定性 和定量两个角度分析其对商业银行的冲击。以中国人民银行统计司里国有大型银行存款量为数据,通过绘图定性地分析存款走势,通过比较剔除季节影响后同一时间段的存款增幅,得出余额宝对我国商业银行的个人存款有一定程度的冲击。最后对商业银行提出几点应对策略。 【关键词】互联网金融余额宝影响对策

《高等学校毕业生登记表》填写指南 《高等学校毕业生登记表》是装入学生档案中的必装材料之一,是严格按照毕业生人数征订和发放的,原则上丢失不予以补办。毕业生务必保管好登记表,并认真阅读填表说明,认真填写。为避免填错,建议拟稿后填写。各年级办应指导学生毕业生如实填写登记表,同时严格审查毕业生填写内容。如因毕业生登记表内容不实造成的后果,属毕业生责任的,其后果由毕业生个人负责;属学校老师责任的,由毕业生辅导员负责。 《填表说明》如下: 1.毕业生必须实事求是地填写本表,填写时一律用钢笔或签字笔,字迹要清楚。 2.表内所列项目,要全部填写,不留空白,如有情况不明无法填写时,应写“不清”、“不详”及其原因,如无该项情况,亦应写“无”。 3.“本人学历及社会经历”自入小学时起,以时间顺序详细填写,年月要衔接。中途间断学习和工作的时间也要填入,并加以说明。 4.“家庭主要成员”是指直系亲属(父母和爱人、子女)。“主要社会关系”一般是指家庭的直系亲属(兄弟姐妹等)。 5.“本人健康状况”主要填写有无疾病和体质强弱状况,无特殊情况填写“良好”。 6.贴最近一寸正面半身免冠照片。 7.如有其他问题,需要说明时,可加纸附上。 具体填写要求如下: 1、学校:填写“济南大学泉城学院” 2、系科:填写所在学院名称的全称,如“经济系”; 3、专业:填写所学专业全称,如“经济学”; 4、姓名、曾用名:姓名应写法定姓名(须与高考录取通知书上姓名一致)。有曾用名者可填写,没有写“无”; 5、出生年月:应用阿拉伯数字,格式“ΧΧΧΧ年ΧΧ月ΧΧ日”,如“1983年11月30日”; 6、“籍贯”:系指学生祖籍的地方,自已出生时的父母户口所在地为准,按现在的行政区划详细填写,只填写省(自治区、自辖市)县两级。 7、“民族”:须填写全称。 8、“现在家庭住址”:要具体到寄信能收到的通信地址,后面写邮政编码。如“山东省日照市翟营南大南389号卓达小区书香园一区Χ栋Χ单元ΧΧ室。(050033)”; 9、是否华侨,侨居何处。不是则填“否”,是则填“是”及“侨居地址”。 10、何时何地何人介绍参加共产党或共青团:如“2005年5月1日在济南大学泉城学院由ΧΧΧ介绍加入共产党”; 11、本人身体健康情况:应分别填写“良好”、“较弱”,有慢性病或身体伤残者,应具体填写。 12、婚否情况:一般填写“未婚”,已结婚者填写“已婚”;其他情况要详细。 13、家庭经济情况及主要经济来源:按较好、一般、较困难、特困四个层次选一填写,如“家庭经济情况为人均元/月,主要经济来源为父母工资”;。 14、何时何地何原因受过何种奖励或处分:填写校级和校级以上获奖情况;如“2001—2002学年度在济南大学泉城学院获一等奖学金”、“2003—2004学年度在济南大学泉城学院获三好学生称号”等。处分情况本人不填写,统一由学生处填写。 15、本人学历及社会经历:应从小学开始填写,统一用“ΧΧΧΧ年ΧΧ月至ΧΧΧΧ年ΧΧ月”的格式,时间要衔接。如“1989年9月——1995年8月在ΧΧΧ省ΧΧΧ县

河南师范大学文学院汉语言文学专业培养方案 一、专业代码及专业名称、修业年限、授予学位、最低学分要求 050101 汉语言文学 3-7年文学学士 160学分 二、专业介绍和特点 该专业现为省级特色专业,是河南师范大学文学院最早设立的专业,前身是创建于1951年的平原师范学院中国语文系。1985年复建,现有一级学科硕士学位授权点,并设有在职教育硕士、研究生课程进修班等不同层次的学历教育。“中国现当代文学”为省级重点学科,“中国古代文学”、“语文课程与教学论”为省级精品课程。中国古代文学、古代汉语、现代汉语为校级优秀课程,中国现当代文学和语文课程与教学论为省级优秀课程。该专业主要培养具有汉语言文学基本理论、基本知识和基本技能,德智体全面发展的优秀中学语文教师,为其成为中等教育的骨干教师和优秀的教育管理人才奠定基础,同时也为其他有关部门培养具有综合素质的优秀人才。该专业具有良好的教学科研设施,资料室藏书5 万册,期刊310种,建有多媒体教室,拥有现代化教学设备和成套的音像资料。该专业师资力量雄厚,学术交流广泛。先后聘请《人民日报》高级记者徐放,著名语言学家张静、王宁、戴庆厦、陈绂,中国古典文学研究专家詹福瑞、莫砺峰,现代文学研究专家王富仁、刘增杰等为兼职教授,著名作家二月河、刘震云、张承志、周大新等先后来院讲学。该专业已为国家培养了上万名各类毕业生,他们能力强、素质高,深受用人单位欢迎。近年来,毕业生考研率在30%左右,就业率在全省本科院校中名列前茅。 三、培养目标 本专业培养具备扎实的汉语言文学基础和良好的人文素养,熟悉汉语及中国文学的基础知识,具有较强的审美能力和中文表达能力,具有初步的语言文学研究能力,同时具有一定的跨文化交流能力,能在文化、教育、出版、传媒机构以及政府机关等企事业部门从事与汉语言文字运用相关工作的中国语言文学学科复合型人才。 四、培养要求 本专业学生主要学习汉语言文学方面的基础理论和基本知识,接受人文社会

浙江树人大学专业建设与人才培养规划 (—年) 为促进我校今后十年专业建设发展与人才培养,深化教学改革,积极培育特色,提升“高级应用型”人才培养质量,面向浙江经济转型升级、战略性新兴产业发展以及区域经济社会发展需求,根据《浙江树人大学中长期发展规划(—年)》文件精神,特制定本规划。 一、教学现状分析 (一)主要成绩 、推进转型,不断完善本科教学体系 学校“升本”后不久,确定了“基础扎实、知识面宽、人格健全、适应能力强,具有较强实践能力和创新创业精神的高级应用型人才”的人才培养定位;开展了“第二层面”(培养计划)、“第三层面”(即主干课程的)设计工作,构建了“平台+模块”的本科教育课程体系;先后讨论、制定和实施了第二、三个专业建设规划,确立了专业方向模块建设逐步从“供给驱动”转向“需求驱动”的专业建设思路;以建迎评,积极推进学校转型发展。 、有序扩展,确保教学秩序良性运行 十年来,本科教育规模有序扩展,为社会各行各业输送人才达到万人。专业结构由较为单一的学科布局迅速发展成为涵盖经济、管理、文学、工学、法学与艺术兼具的多学科的综合性构架,现有本科专业个,办学规模达到万人。学校加大对教学工作的投入,教学经费占公用经费比例达,生均设备值已达余元。校院两级二级教学管理与运行模式日渐完善。 、提升内涵,全面实施教学质量工程 学校一直以来十分重视教学质量的提升。年全面启动“教学质量工程”,成效显著。目前学校拥有国家特色专业个、省级重点专业个,省级精品课程门,省级重点教材门,省级教学团队个,省级人才培养模式创新实验区个,省教学名师名,省教坛新秀名,省级实验教学示范中心建设点个,省级教学成果奖项,省新世纪教改项目项,学生先后在省级及以上学科竞赛中累计获得国家级奖项项、省一等奖项、省二等奖项、省三等奖项。 、培育特色,开展人才培养模式改革 学校先后进行了个人才培养模式特色培养专业试点,在校企合作钢结构人才培养、社会工作职业化人才培养、服务业学院“”“”人才培养、订单式“红石梁”市场营销人才培养、互动新媒体创新实验班、考研班以及服务外包人才培养等方面初步彰显了人才培养特色。年,学校正式启动了《浙江树人大学课程改革三年行动计划()》,进一步深化人才培养模式改革。 (二)主要困难 、在专业建设与发展方面:专业数量相对不足,品牌专业偏少;专业结构尚待优化,群落关系仍未形成,工科专业比例较高,经济类专业数量偏少。专业内涵与特色优势不明显,师资队伍的整体实力和水平仍需提高,专业教学质量评价尚不够完善。 、在培养目标方面:“高级应用型人才”培养目标落实不彻底:学校与地方经济互动的开放服务合作体系还没有真正建立;人才培养的实践教学体系落实难度较大;课堂教学的内容、方式与方法改革离实践性导向的要求仍有差距。 、在教学改革方面:教学改革仍未能很好地满足社会需求,部分试点专业改革的辐射面和推广度明显不够,一些课程改革、教学研究与改革项目,因教师教学理念、评价机制等因素的制约,改革力度不足。 、教学条件与资源方面:在进一步深化高级应用型人才培养模式改革中,实践教学条件与资

附件: 西南财经大学本科毕业论文(设计)管理办法 第一章总则 第一条为加强学校本科毕业论文管理工作,提高毕业论文质量,根据教育部《关于加强普通高等学校毕业设计工作的通知》和《学位论文作假行为处理办法》等规定,特制订本办法。 第二条本科生毕业论文(含毕业设计,以下统称毕业论文),是本科人才培养的重要组成部分,是培养学生创新能力、实践能力和创业精神的重要环节,是衡量学校培养水平的重要依据。 第三条毕业论文工作应贯彻党和国家的教育方针,坚持社会主义办学方向,坚持立德树人根本任务,着力培养德智体美全面发展,具有社会责任感、创新精神、国际视野的财经领域的卓越人才。 第四条本办法适用于学校全日制普通高等教育本科专业人才培养方案所规定的毕业论文。 第二章组织管理 第五条教务处负责学校毕业论文工作的统一管理,学院负责具体组织和实施。 第六条教务处制定学校毕业论文的工作原则,组织校内外专家对毕业论文进行校级公开答辩、抽查和监督,负责校级优秀毕业论文评选。 第七条学院应高度重视毕业论文工作,制订本学院毕业论文工作实施办法,强化毕业论文工作过程管理,监督和检查毕业论文质量。

第三章指导教师 第八条毕业论文指导教师原则上应由中级及以上职称的教师担任,学院也可聘请实务界优秀专家担任指导教师。 第九条指导教师基本职责 (一)坚持立德树人,帮助学生树立正确的世界观、价值观、人生观,培养学生的诚信品质、创新能力和科学精神; (二)注重培养学生发现问题、分析问题、解决问题的能力; (三)指导学生做好选题、开题; (四)检查督促学生毕业论文进度; (五)审阅学生毕业论文,对学生毕业论文答辩资格进行预审,指导学生参加毕业答辩; (六)其他与毕业论文指导相关的工作。 第十条学院对指导教师的工作进行考核。对不履行指导教师职责或有其他违规行为的教师给予批评教育,直至暂停或取消其指导教师资格。 第四章基本要求 第十一条毕业论文应在教师指导下由学生本人独立完成。 第十二条毕业论文应遵守学术道德和学术规范,观点明确、论据翔实、条理清楚、言之成理、语句通顺,能反映学生掌握本专业知识的广度和深度及综合分析解决问题的能力。 第十三条毕业论文的行文格式和引文规范应遵照《西南财经大学本科生毕业论文(设计)撰写与印制规范》中的相关要求执行,指导教师应严格把关。 第十四条同一人的双学位专业毕业论文与主修专业毕业论文内容

浙江树人大学办公室文件 浙树办教〔2011〕41号 关于印发《浙江树人大学 学士学位授予工作细则(修订)》的通知 各学院、各部门: 现将《浙江树人大学学士学位授予工作细则(修订)》印发给你们,请遵照执行。 二Ο一一年七月十四日

浙江树人大学学士学位授予工作细则(修订) 根据《中华人民共和国学位条例》、《中华人民共和国学 位条例暂行实施办法》及《普通高等学校学生管理规定》等有 关文件精神,结合我校实际情况,特制定本细则。 第一条 凡符合下列条件的本科毕业生,可授予学士学 位: 1、 坚持四项基本原则,遵纪守法,品行端正,原则上在 大学期间未受过记过及以上处分; 2、在规定年限内修满专业培养计划规定的学分,经审核 准予毕业; 3、具有从事科学研究工作或担负专门技术工作的能力, 毕业环节成绩中等及以上; 4、英语水平达到学校规定的要求,即本科生(不含艺术 类、外语类专业)毕业前全国大学英语四级等级考试成绩达到 总分的百分之五十。 第二条 因第一条第1款原因不能授予学学士位但满足毕 业条件的毕业生,有下列情况之一者,经本人申请,校学位评 定委员会审议同意后可授予学士学位: 1、受处分后曾获得过校级及以上奖学金或先进等荣誉称 号者(其中校级先进指校级三好学生、校优秀毕业生、校优秀 党员、校级优秀学生干部、校级优秀团干部等个人荣誉称号 等); 2、有重大立功表现者(要求提供县级及以上相关政府部

门出具的证明材料)。 第三条 因第一条第3款原因不能授予学学士位的毕业生,有下列情况之一者,经本人申请,校学位评定委员会审议同意后可授予学士学位: 1、获省级及以上科技竞赛三等奖及以上者(其中省级科技竞赛是指省教育厅组织的数学建模、电子设计、程序设计、多媒体作品设计、机械设计、结构设计、财会信息化、电子商务、英语演讲、工业设计、生命科学、大学生广告艺术设计、大学生职业生涯规划大赛等科技竞赛以及 “挑战杯”大赛等项目); 2、研究生考试成绩达到国家分数线; 3、在公开出版刊物上以第一作者身份发表专业相关的学术论文1篇及以上; 4、其他学业上或学术上有突出成绩。 第四条 授予学士学位的组织机构为学院学位评审组和学校学位评定委员会。校学位评定委员会的办事机构设在教务处。 学院学位评审组一般由学院领导和学科带头人3~5人组成,设主任1人。主要职责是:逐个审核本科毕业生的政治表现、学习成绩和毕业鉴定材料,向教务处提出本学院授予学士学位和不授予学士学位的学生建议名单。 教务处对各学院提出授予学士学位和不授予学士学位的学生建议名单及材料进行复查后,提交校学位评定委员会审

20XX最新大学本科毕业登记表自我鉴定(4 篇) 大学本科毕业生自我鉴定范文一 悄然溜走的岁月,转瞬即逝的年华。曾有的美好,今朝的梦。怀想是因为离别的钟声已经敲响。大学,我以拼搏的汗水洗净了知识的尘埃,去卩忘记到了作别的长亭,离去的码头。暮然回首,得失之间。惆怅与欢悦羁绊着前行的心。惟有追忆,方觉拥有的永恒!收获是对奋斗的馈赠,四年的点点汇集,四个春夏秋冬的孜孜以求,日以夜继的孤身书海,心领神会的倾听慧语,兢兢业业的投身事业,我学会了珍惜,懂得了追求。失去,是因时间的无情与付出的匮乏而酸楚,。独思的天性,丢失了对智慧的交流,对精华的吸收。 时光已逝,良晨难在,获取超于失去,何乐而不为,憧憬,是因为新的梦想在开启斗士的豪情! 如果再给我一个上大学的机会,我会更珍惜,让她更精彩。因为我体会到了大学对人生的重要性,在我离开学校后, 我又将开始自己的更精彩的征程!我要努力去拼搏,直到成功! 大学本科毕业生自我鉴定范文二 四年的大学生活就这样匆匆忙忙的结束了,发现自己也长大成熟了好多。四年来点点滴滴的磨练成为我生活中的一个个关键的起点。有的辉煌,值得你记住一辈子的。我不怕苦,我只是怕我们没有挑战自我、充实自我和实现人生价值的勇气和机

遇。所以我一直在努力着,一直在努力。刚上大一的时候,学校有好多的社团可以加入,比较好的就有广播站、学习部等。 由于自己的害怕而放弃了加入学校这些优秀的社团。也许还要怪自己当时的想法,就是不在学校社团难道就不能发展自己了吗?难道作为一名普通的学生就不能学校做出贡献了吗?就这样机会与我擦肩而过。当我清楚知道加入社团的好处的时 候,我其实也不是很后悔,而是自己默默的在心里发誓,做一名学生也要出类拔萃。 没有加入社团对我来说其实就是比别人晚了一步要进入所谓大学的半个社会。我经常会利用课余时间去外系旁听学习,虽然没有他们专业,但总比普通学生多学习了一点。就这样我不放弃任何学习的机会,有一点就学习一点。我知道我在某些方面不如那些同学,所以我就拼命的学习,人家都说“学习能改变命运”,也许我就是冲着学习的优秀能祢补我的不足吧。所以在大一的下学期我就通过了英语四级考试,我也正准备着向高一层次发展。也准备考一些对我以后发展有用证件。当然我也不放弃在假期和空闲时间去社会实践来提高自己,比如去苏宁打工,去一些专卖店促销商品。 这不仅提高了我的思想觉悟,也使我对社会有了更深刻的认我的优点是诚实、热情、性格坚毅。我认为诚信是立身之本,所以我一直是以言出必行来要求自己的,答应别人的事一定按时完成。由于待人热情诚恳,所以从小学到大学一直与同学和老师相处得很好,而且也很受周围同学的欢迎,与许多同学建立起深厚的友谊。在学习知识的同时,我更懂得了,考虑问题应该周到。我这个人有个特点,就是不喜欢虎头蛇尾,做事从来都是有始有终,就算再难的事也全力以赴,追求最好的结果,正因为如此,我把自己的意志视为主

邮编:100084 北京市海淀区清华大学清华大学人文学院中国语言文学系院长 邮编:100871 北京市海淀区颐和园路5号北京大学人文学部中国语言文学系院长 邮编:100191 北京市海淀区学院路37号北京航空航天大学文学院院长 邮编:100872 北京市海淀区中关村大街59号中国人民大学文学院院长 邮编:100088 北京市海淀区西土城路25号中国政法大学人文学院院长 邮编:100875 北京市新街口外大街19号北京师范大学文学院院长 邮编:100081 北京海淀区中关村南大街5号北京理工大学人文与社会科学学院院长 邮编:100089 北京市海淀区西三环北路2号北京外国语大学中国语言文学学院院长 邮编:100029 北京市惠新东街12号对外经贸大学对外经济贸易大学中国语言文学学院院长邮编:100024 北京市朝阳区定福庄东街一号中国传媒大学文学院院长 邮编:102206 北京市海淀区学院南路39号中央财经大学文化与传媒学院院长 邮编:100083 北京市海淀区学院路29号中国地质大学人文经管学院院长 邮编:100083 北京市海淀区学院路30号北京科技大学文法学院院长 邮编:102206 北京市昌平区北农路2号华北电力大学人文社会科学学院院长 邮编:100081 海淀区中关村南大街27号中央民族大学文学与新闻传播学院院长 邮编:100048 北京市西三环北路105号首都师范大学文学院院长 邮编:100083 北京市海淀区清华东路35号北京林业大学人文社会科学学院院长 邮编:100083 北京市海淀区清华东路17号中国农业大学人文与发展学院院长 邮编:100083 北京市海淀区学院路15号北京语言大学人文学院院长 邮编:100070 北京市丰台区花乡张家路口121号首都经济贸易大学文化与传播学院院长 邮编:100083 北京市海淀区学院路丁11号中国矿业大学文法学院院长 邮编:100029 北京市朝阳区北三环东路15号北京化工大学文法学院院长 邮编:100124 北京市朝阳区平乐园100号北京工业大学人文社会科学学院院长 邮编:200433 上海市杨浦区邯郸路220号复旦大学中国语言文学系院长 邮编:200240 上海市东川路800号上海交通大学人文学院院长 邮编:200092 上海市四平路1239号同济大学人文学院院长 邮编:200241 东川路500号华东师范大学中国语言文学系院长 邮编:200433 上海市国定路777号上海财经大学人文学院院长 邮编:201620 上海市松江区人民北路2999号东华大学人文学院院长 邮编:200234 上海市徐汇区桂林路100号上海师范大学人文与传播学院院长 邮编:200444 上海市宝山区上大路99号上海大学中文系院长 邮编:201620 松江大学园区龙源路555号华东政法学院人文学院院长 邮编:710049 陕西省西安市咸宁西路28号西安交通大学人文学院院长

河南师范大学成人高等学历教育 毕业论文 题目 院(部) 专业 年级 形式 层次 学号 姓名 指导教师(签名) 年月日

河南师范大学本科生毕业论文格式规定 本科生毕业论文是实现人才培养目标的重要实践环节,对巩固、深化和升华学生所学理论知识,培养学生创新精神、独立工作能力、分析和解决问题能力起着重要作用。做好本科生毕业论文指导工作,是培养学生科学精神、科学作风、良好的思想品德以及事业心和责任感等综合素质所不可缺少的环节,毕业论文的质量直接影响到人才培养的质量。为了统一学位论文的撰写、编辑、印刷,便于处理、储存、检索和交流,根据国家制订的有关标准和学校的有关规定,特对本科生毕业论文的编写格式及打印提出如下具体要求。 一、编写及打印要求 1.学位论文必须打印,不接受手写稿,一律用Microsoft Word编辑。 2.论文正文必须用阿拉伯数字连续编排页码。封面、任务书和封底不编入页码。致谢、英汉语摘要、关键词和目录采用罗马数字编排页码,即致谢为第I页,汉语摘要及关键词为第II页,英语摘要、关键词为第III页;目录为第IV页。正文页码从阿拉伯数字1开始直到论文结束。页码居中。 4.学位论文必须用A4纸打印,左侧装订。 5.学位论文打印时,要求纸的四周留足空白边缘,以便装订、复制和指导教师批注。每一页的上方和左侧应分别留边25mm,下方和右侧分别留边20mm;论文全文采用两边对齐格式,每段开始左缩进3-5个字符。 6.学位论文可用英文也可用中文撰写。论文正文部分采用四号Times New Roman字体,1.5倍行距打印。学位论文一律单面印刷。 7.论文必须附中英文摘要。 8.论文不得少于3000字,以3000-5000字为宜。 二、论文编写基本格式 1.封面与首页:具体字体、字号要求见论文模板。 内容:英文部分Times New Roman四号 汉语部分宋体四号 2.注释(本部分可选可不选):注释可用脚注,也可用尾注。用脚注时,字体为Times New Roman,四号,标注时用上标的阿拉伯数字;用尾注时,字体为Times New Roman四号字,标注时用带圈的阿拉伯数字即①②(上标)等符号。 三、各部分具体要求 1.论文封面与首页:采用统一印制的封面。题目:应在20个单词以内,能简明、具体、确切地表达论文的特定内容。必要时可使用副标题; 2.致谢:即Acknowledgement,此部分不宜过长,最长不超过120个单词; 3.中英文摘要:以简洁的语言介绍文章的概要,突出作者的主要论点和发现性成果,中文在前,英文在后,中文摘要字数应控制在200字之内,英文摘要一般在250个 词左右; 4.关键词:提供3-5个关键词,中英文对应,关键词之间用分号隔开; 5.目录:由论文的各部分标题、小标题、附录、参考文献等序号、标题名和页码组成; 6.正文:论点正确、逻辑性强、文理通顺、层次分明、表达确切。把实践结果上升到

大学本科毕业生登记表自我鉴定 四年的大学本科生活就这样结束了。回顾一下四年 的大学生活,朋友,你有哪些感慨呢?以下是由为大家 精心整理的“大学本科毕业生登记表自我鉴定”,仅供 参考,欢迎大家阅读,希望能够对大家有所帮助哦。 大学本科毕业生登记表自我鉴定【一】 当我怀揣大学录取通知书走进大学校门的那一刻起,我就成为一名大学生了。四年后,当我又要离开的时候,放眼望去,楼还是那楼,树还是那树,漫步于中的却不 是了自己。即将离开大学,我有必要对自己这四年的大 学学习生活进行自我鉴定。 在思想政治方面,本人具有优秀道德修养,并有坚 定的政治方向。我热爱祖国,热爱人民,坚决拥护中国 共产党领导和社会主义制度,努力学习马克思列宁主义、毛泽东思想和*****,不断提高自己的政治觉悟和道德修养,严格遵守国家宪法及其它各项法律规定。同时我遵 守社会公德,爱护公共财产,团结同学,乐于助人,并 以务实求真的精神热心参予学校的公益宣传和爱国主义 活动。 在专业学习方面,我学习的是国际经济与贸易专业。本专业培养德、智、体全面发展的能够胜任外向型经济

工作和适应国际竞争的专门人才。通过四年学习,我学 习了微观经济学、宏观经济学、市场营销、国际贸易、 国际金融、国际贸易实务、国际结算、外贸英语函电、 电子商务、会计学、财政与税收等专业课程。其中四门 学位课程以优异的成绩通过,同时顺利通过国家英语四 级考试,学业平均成绩超过xx分即将取得xx大学学士学位证书。本人学习态度端正,由于大学的授课和高中时 有很大区别,这就要求在课下巩固课堂上所学的知识, 须自己钻研并时常去图书馆查一些相关资料。而我也非 常喜欢去图书馆学习,迄今为止大学阶段已看课外书籍 一百多本。大学以前,一般学生都是死读书的典范,老 师教什么,学生学什么。进入大学后,随着年龄的增长,思想也在不断地成熟。毫不夸张地说,大学四年没有安 心地在图书馆好好看基本书,那就绝对没有真正意义上 读过大学。图书馆就是这样一个改变人思想的地方。本 人还注重实践活动能力的培养,每逢假期,积极参加社 会实践活动,认真完成实践报告。 在综合能力方面,本人大学四年来一直担任班级组 织委员。尽管有时候会比其他同学付出更多,更累一些,但我自己对此很是满意。毕竟在这锻炼中提升了自己的 各方面能力,包括思考问题解决问题的能力,理论和实 际结合的能力,做人与处世的能力等等。另外组织协调

河南师范大学研究生学位论文格式要求 为了统一学位论文的撰写、编辑、印刷,便于处理、储存、检索和交流,根据国家制定的有关标准,特对学位论文的格式提出如下要求: 1学位论文的基本格式 学位论文一般用中文撰写(外语专业除外)。学位论文一般应由以下四个部分组成: (1) 前置部分:封面、扉页、致谢(仅限外语专业)、摘要、ABSTRACT、目录、附表与插图清单(必要时)、主要符号表(必要时); (2) 主体部分:引言(或绪论)、正文、结论(或建议)、参考文献; (3) 附录部分(必要时); (4) 结尾部分:后记(或致谢)、攻读学位期间发表的学术论文目录、独创性声明和关于论文使用授权的说明。 各部分的具体要求如下: 1.1 前置部分 1.1.1 封面和扉页 论文封面和扉页用学校统一规定的样式(可从学校研究生处网站下载)。 封面上的分类号可通过《中国图书馆图书分类法》(北京图书馆出版社,第四版)进行检索,也可登录上海交通大学图书馆网站查阅(https://www.doczj.com/doc/b212393993.html,/view.do?id=516)。 论文题目字数一般应在20字以内,能简明、具体、确切地表达论文的特定内容,避免使用不常见的缩略词、首字母缩写字、字符、代号和公式等,必要时可使用副标题。 封面上的学科、专业以国务院学位委员会1997年颁布的《授予博士、硕士学位和培养研究生的学科、专业目录》为准。 封面上的日期为论文答辩前提交付印日期,用中文表示,如“二〇〇八年四月”。

扉页上的英文论文题目用大写字母。 1.1.2 摘要 摘要是对学位论文内容不加注释和评论的简短陈述,具有独立性和自含性,即不阅读论文全文,就能获得必要的信息。摘要应突出作者的论点,尤其是具有创新性的成果和新见解。除了实在无变通办法可用外,摘要中不得使用图、表、化学结构式、非公知公用的符号和术语。摘要内容不要写成说明性的介绍,如“本文分几章,第一章说明课题来源,最后一章给出了全文结论,提出了今后研究方向等”。 关键词是为了便于做文献索引和检索工作而从论文中选取出来用以表示全文主题内容信息的单词或术语,一般为3~5个。 硕士学位论文的中文摘要为1000字左右;博士学位论文的中文摘要为1500字左右。 1.1.3ABSTRACT 英文摘要应与中文摘要相对应,要符合英语语法,语句通顺,文字流畅。 1.1.4 目录 目录由论文的章节以及摘要、ABSTRACT、参考文献、附录、后记(或致谢)、攻读学位期间发表的学术论文目录、独创性声明和关于论文使用授权的说明等的序号、题名和页码组成。 1.1.5 插图和附表清单 如果学位论文的插图和附表太多,可以分别列出清单,置于目录之后。插图清单包括图号、图题及其页码;附表清单包括表号、表题及其页码。 1.1.6 主要符号表 符号、标志、缩略语、首字母缩写、计量单位、名词、术语等的注释说明,如需汇集,可集中置于图表清单之后。 1.2 主体部分 1.2.1 论文字数 学位论文主体部分(不包括参考文献)的字数:自然科学博士学位论文一般不少于

浙江树人大学素质拓展学分管理系统 操作手册 阅读对象:学生用户 覆盖内容:登录、系统首页、用户功能

目录 一登录 (3) 1.1 登陆系统 (3) 1.1.1 打开一个浏览器窗口 (3) 1.1.2 在地址栏输入网络地址 (3) 1.1.3 输入正确的登录信息 (3) 1.1.4 登陆成功,进入系统 (4) 二首页 (5) 2.1 查看通知安排 (5) 2.2 修改个人密码.................................................................................. 错误!未定义书签。 2.3 首页其余按键介绍.......................................................................... 错误!未定义书签。 三用户功能................................................................................................... 错误!未定义书签。 3.1 个人信息.......................................................................................... 错误!未定义书签。 3.1.1 个人信息查看....................................................................... 错误!未定义书签。 3.1.2 个人信息修改....................................................................... 错误!未定义书签。 3.2 学分申报.......................................................................................... 错误!未定义书签。 3.2.1 学分申报 (10) 3.3流程跟踪 (10) 3.3.1 申报项目查看 (10) 3.3.2 申报项目修改/删除 (11)

大学本科毕业生登记表自我鉴定范文 我们应从中继承做得好的方面改进不足的地方,使自己回顾走过的路,也更是为了看清将来要走的路。下面是由我为大家整理的“大学本科毕业生登记表自我鉴定范文”,仅供参考,欢迎大家阅读。 大学本科毕业生登记表自我鉴定范文(一) 四年的大学生活,使我对人生观,价值观,世界观都有了更深的认识。我的为人之道——以诚待人,待事、坚持信念行动创造价值、自我创新。 如今回首,是对过去的审视和总结,亦是对未来的憧憬和希望,即将踏出校门的我,满心期待大千世界的挑战和磨练。 深知性命相托的重要,从踏入学校门槛的那天起,在良师的精心指导下,自己奋力拼搏,自强不息,逐渐成为了一个能适应社会要求的大学生,并为做一个知识型的社会主义建设者打下坚实的基础。生活方面,自从来到湖南第一师范学院,我的生活充满了爱,充满了情。同学之间的情犹如亲情但更胜亲情,朋友之间的情犹如手足之情,湖南第一师范学院事我都很是关心,就这样我爱上了湖南第一师范学院的每个人,每件事物。同时独立自主的生活在我的美好的大学三年中也就这样成熟了起来,我也就体会到了大学独立自主的生活是我们进入社会的生活的根本。 学习方面,自我进湖南第一师范学院的第一天起,我就没有忘记我来湖南第一师范学院的目的——学好知识,学会做人。在湖南第一师范学院,虽然我在有些方面得到了肯定,但我真正实现自我价值还需要更加努力,读到到老,学到老也就成了我最基本的思想。 思想方面,我经过班级的初选,到系审核,再到院的批准,我成了湖南第一师范学院美术系第12期入积极分子党培训中的一员,并经过学习与考核,成绩合格成为了入党积极分子。我就由一个对我们党了解一点到了解了我们党的人。