NLB群集的两种操作模式

NLB群集的操作模式

最近很多学员都在问我NLB群集两种操作模式的区别,所以今天特地写一篇关于NLB群集操作模式的一篇博文,供大家参考,也希望论坛中各位高手给予指点。

Windows NLB群集有两种操作模式:单播模式、多播模式。

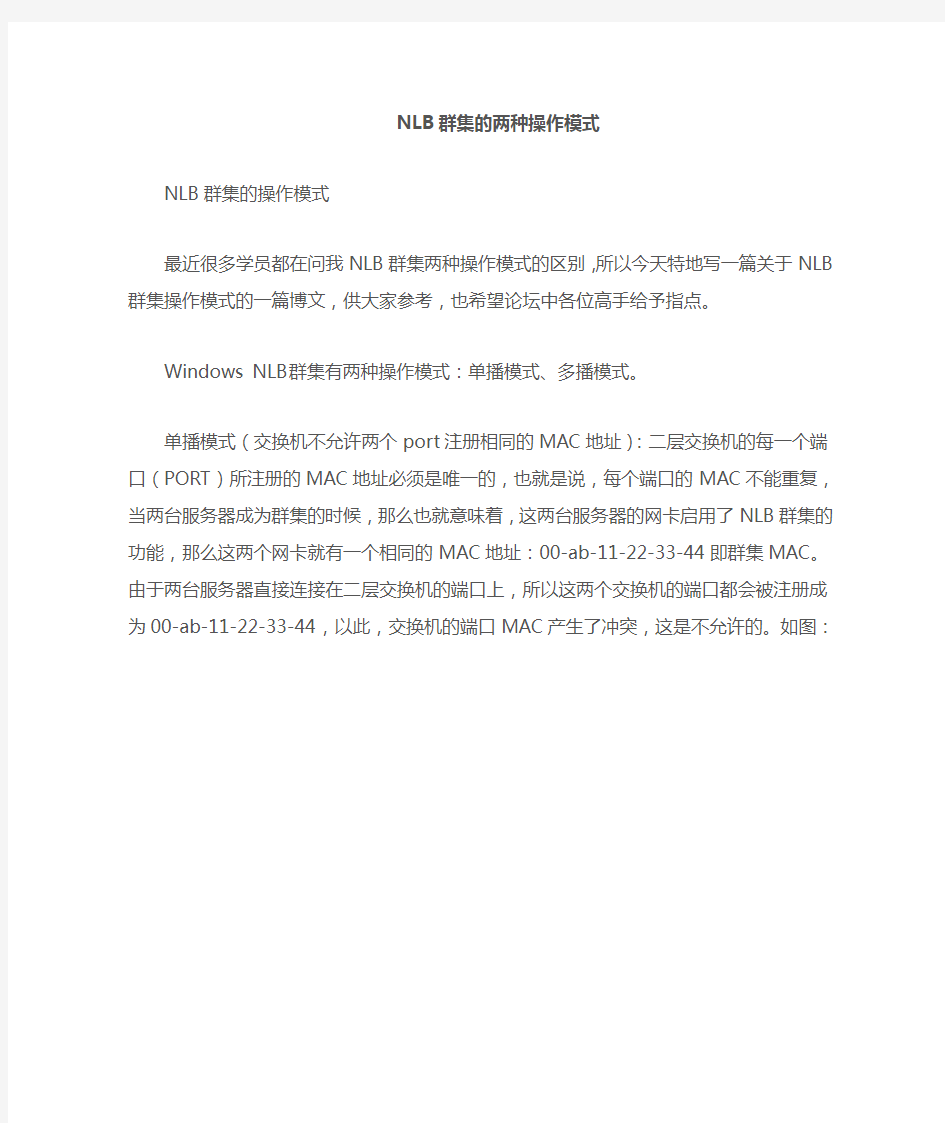

单播模式(交换机不允许两个port注册相同的MAC地址):二层交换机的每一个端口(PORT)所注册的MAC地址必须是唯一的,也就是说,每个端口的MAC不能重复,当两台服务器成为群集的时候,那么也就意味着,这两台服务器的网卡启用了NLB群集的功能,那么这两个网卡就有一个相同的MAC地址:00-ab-11-22-33-44即群集MAC。由于两台服务器直接连接在二层交换机的端口上,所以这两个交换机的端口都会被注册成为00-ab-11-22-33-44,以此,交换机的端口MAC产生了冲突,这是不允许的。如图:

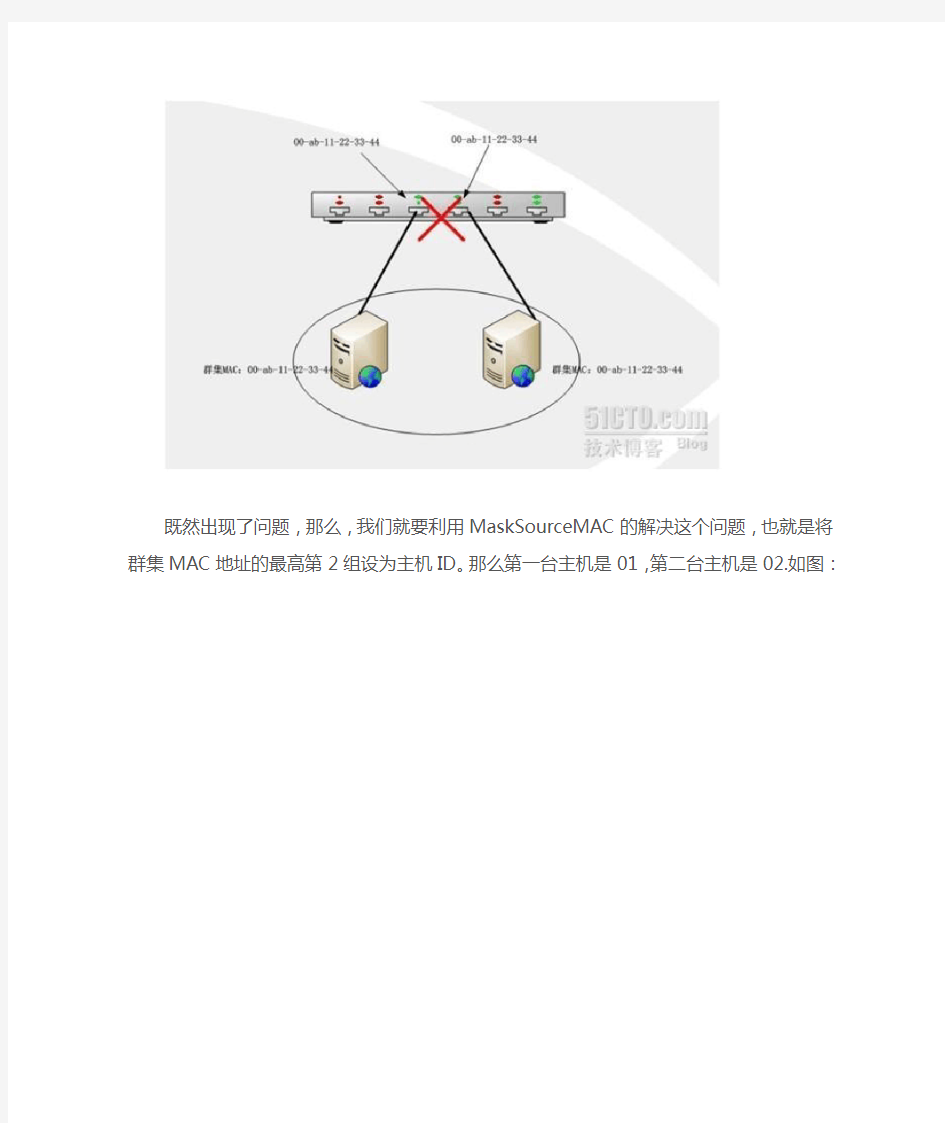

既然出现了问题,那么,我们就要利用MaskSourceMAC的解决这个问题,也就是将群集MAC 地址的最高第2组设为主机ID。那么第一台主机是01,第二台主机是02.如图:

单播模式(Switch Flooding——交换机泛红):我们已经知道,交换机的每一个端口都是唯一的,路由器接收到群集IP的数据包时,它会通过ARP地址来查询群集MAC地址,不过,交换机端口(port)没有群集MAC地址,因为我们已经通过MaskSourceMAC功能解决交换机端口MAC相同的问题,当然交换机端口也没有所谓的群集MAC地址,这个时候,交换机就会进行泛红,其实说白了,就是向每个端口除接收端口进行广播,这样会造成额外的网络负担,说的通俗点就是,会造成大大的占用网络带宽。如图:

虽然泛红现象可以造成额外的网络负担,不过,群集中的主机都能接收到发来的数据包。那么我们如何解决交换机泛红问题呢?我们可以先将两台群集主机连接在一台HUB(集线器)上,然后再禁用MaskSourceMAC功能,这样,只有HUB连接的交换机端口注册群集MAC,这样就不会产生泛红问题了。如图:

禁用MaskSourceMAC功能的方法:开始——运行——regedit——

HKEY_LOCAL_MACHINE\SYSTEM\CurrentControlSet\Services\WLBS\Parameters\Interface\ Adapter-GUID,将Adapter-GUID值改为0即可。

单播模式(群集服务器之间无法相互通信的问题):既然是NLB群集,并且支持着WEB服务,也就意味着,每一台群集主机上的web内容都是一样的,我们可以利用DFS复制技术将两台群集里的web内容进行同步,那么就必须让两台主机进行通信。如果我们选择单播模式,并且选择一块网卡,那么就会产生两台群集主机不通信的问题。如图:

上图所示,当左边的主机要与右边的主机进行通信的时候,它会通过ARP请求数据包来询问其主机的MAC地址,而右边主机回复的MAC地址是群集MAC,也就是和左边的MAC是一样的,所以这个时候,无法进行通信。那么解决方法就是,将每台群集主机安装两块网卡,并且安装的两块网卡不启用群集服务,这样通信就不会出现问题了。如图:

多播模式的概念:多播,说白了,就是将数据包发送给多台计算机,这些计算机同属于一个个多播组,他们拥有一个共同的多播MAC地址。

多播模式的特点:1、NLB群集中每一台服务器的网卡仍然会保留原来的唯一的MAC地址,所以,群集成员服务器之间是可以正常通信的,那么这么一来,在交换机的端口上注册的就是原来的唯一的MAC地址。2、NLB群集的服务器都共用一个群集MAC地址,这是一个多播MAC地址,群集里的服务器都是通过多播MAC地址来监听外部的请求的。

多播的缺点:1、有的路由器不支持,当路由器接收到送往群集IP地址202.106.0.100的数据包时,路由器就会进行ARP广播,来查询202.106.0.100的MAC地址,其实就是ARP广播群集MAC,此时,我们选择的是多播,所以群集的MAC也就是一个多播(群集)MAC地址,而回复给路由器的就是一个多播MAC地址,那么路由器有可能不承认这个回复信息,换句话说,路由器有可能不接受这样的结果,因为,路由器要解析的是单播地址202.106.0.100,现在解析到的是一个多播MAC,那么,要想解决这个问题,我们可以手动在路由器上新建一个静态的ARP条目,202.106.0.100对应一个群集MAC——00-ab-11-22-33-44,这是一个解决办法,但是,如果路由器不支持这样的做法,那么我们只好更换路由器,或改为单播模式。如下图。2、依然存在我们前面所说过的Switch Flooding现象,当我们选择多播模式以后,每个交换机的端口都是唯一的,但是,路由器接收到送往群集的数据包时,路由器依然会ARP广播,欲广播群集的MAC地址,那么现在有这样的一个情况,交换机的任何一个端口都没有群集MAC,所以,这个时候,交换机只能进行广播来获取群集MAC地址,这样就产生了泛红的问题,依然会增大网络带宽,增加了网络负载。在多播模式下如何解决这个问题呢,那么就是利用一台支持IGMP snooping(Internet group membership protocol窥探)的交换机来解决,这个协议可以自动的发现,连接在交换机上的哪个服务器属于一个多播组,那么只要交换机接收到送往群集的数据包,直接会被送往交换机的部分端口,也就是属于多播组的服务器。如下图。

VMware Workstation 中故障转移集群配置指南

目录 一、群集介绍 (3) 二、群集专业术语 (3) 三、实验环境介绍及要求 (4) 1、拓扑图 (4) 2、软件配置说明 (4) (1) DC软件配置信息 (4) (2) Cluster Node A软件配置信息 (4) (3) Cluster Node B软件配置信息 (5) 3、硬件配置要求 (5) (1) 网卡 (5) (2) 共享磁盘 (5) 四、安装群集前的准备工作 (6) 1、创建共享磁盘 (6) (1) 创建用来保存共享磁盘的目录 (6) (2) 创建仲裁磁盘 (6) (3) 创建数据共享磁盘 (7) (4) 验证共享磁盘是否成功创建 (7) (5) 附加共享磁盘 (8) 2、网络及系统配置 (10) (1) 创建群集服务帐户 (10) (2) 添加群集A记录 (12) (3) ClusterNodeA上的共享磁盘配置 (12) (4) 网络配置 (16) (5) ClusterNodeB上的共享磁盘配置 (21) 五、安装群集服务 (24) 1、在A节点上新建一个群集 (24) 2、将B节点加入现有群集 (29) 六、配置群集服务 (35) 1、群集网络配置 (35) 2、心跳适配器优先化 (37) 3、仲裁磁盘配置 (38) 4、创建一个启动延迟(此操作非必需) (39) 5、测试群集安装 (40) 七、故障转移测试 (42) 1、初级测试 (42) 2、高级测试 (44) (1) 手工模拟故障1次 (44) (2) 手工连续模拟故障4次 (45) (3) 停止群集服务测试 (47) (4) 模拟意外断电时故障转移 (49) 八、结束语 (50)

Introduction to Load Balancing

BRKAPP-1001

BRKAPP-1001 14503_04_2008_c2

? 2008 Cisco Systems, Inc. All rights reserved.

Cisco Public

2

? 2006, Cisco Systems, Inc. All rights reserved. 14503_04_2008_c2.scr

1

Agenda

Introduction Load Balancing and Health Monitoring Flow Management Server Offload High Availability Deployments Geographic Load Balancing What’s Next ?

BRKAPP-1001 14503_04_2008_c2

? 2008 Cisco Systems, Inc. All rights reserved.

Cisco Public

3

Cisco Application Delivery Networks

Network Classification

Quality of service Network-based app recognition Queuing, policing, shaping Visibility, monitoring, control

Application Scalability

Server load-balancing Site selection SSL termination and offload Video delivery

Application Networking

Message transformation Protocol transformation Message-based security Application visibility

WAN

Application Acceleration

Latency mitigation Application data cache Meta data cache Local services

BRKAPP-1001 14503_04_2008_c2 ? 2008 Cisco Systems, Inc. All rights reserved.

WAN Acceleration

Data redundancy elimination Window scaling LZ compression Adaptive congestion avoidance

Cisco Public

Application Optimization

Delta encoding FlashForward optimization Application security Server offload

4

? 2006, Cisco Systems, Inc. All rights reserved. 14503_04_2008_c2.scr

2

w i n d o w s s e r v e r无域配置故障转移群集帮助集团标准化工作小组 [Q8QX9QT-X8QQB8Q8-NQ8QJ8-M8QMN]

准备工作软件准备 (1)SQLServer2016 (2)WindowsServer2016DataCenter64 位 (3)VMware-workstation12 Pro 操作系统:都是WindowsServer2016DataCenter(只有WindowsServer2016才能无域配置集群) 计算机名 node1:WIN-VF232HI2UR6 node2:WIN-1MCR65603IJ IP规划

第一步:安装故障转移集(所有节点均需要此操作) 第二步:添加DNS后缀(所有节点均需要此操作,且后缀需一致) 第三步:所有节点上以管理员方式运行Powershell,然后执行以下命令 new-itemproperty -path HKLM:\SOFTWARE\Microsoft\Windows\CurrentVersion\Policies\System -Name LocalAccountTokenFilterPolicy -Value 1 或者也可以手动添加此注册表项(项名:LocalAccountTokenFilterPolicy,DWEORD(32位)值,值为1)

HKEY_LOCAL_MACHINE\SOFTWARE\Microsoft\Windows\CurrentVersion\Policies\System 第四步:添加用户名,名称、密码均要一致,且隶属于Administrators 第五步:添加节点映射(注意要把集群名以及虚拟IP加上) C:\Windows\System32\drivers\etc\host

vSphere 虚拟化下windows 2008 server NLB 问题如何解决 拓扑图: 前提说明: Windows 2008 server 两台虚拟服务器做成了集群(选择NLB 类型),相关配置请参考相关资料,此处略去。 问题: 1、 因此架构中无负载均衡相关的设备,当配置集群,启用VIP 时,不能实现BLB 的功能。不能实现Ha 的功能。 2、 由于 NLB 数据包不合常规,即 IP 地址采用单播模式而其 MAC 地址则采用多播模式,

因此交换机和路由器会删除NLB 数据包。 3、路由器和交换机删除NLB 多播数据包后,会导致交换机的ARP 表中未填入群集的IP 和MAC 地址。 解决方法: 1、网络设备上配置如下: 第一步 arp 172.30.0.13 03bf.ac1e.000d ARPA 第二步 mac address-table static 03bf.ac1e.000d vlan 930 interface Port-channel10 Gigab tEthernet0/1 GigabitEthernet0/2 GigabitEthernet0/3 GigabitEthernet0/4 mac address-table static 03bf.ac1e.000d vlan 930 interface GigabitEthernet0/5 说明:两台核心交换机上都需要进行这样的配置。 Vlan 930 为VIP及实际ip所在的vlan号; 在mac绑定时,使用VIP及对应的虚MAC; 做mac静态映射到接口的时候,一定需要将port-channel口也包括进去,否则还是有问题。(以上功能cisco只是部份交换机支持,其他厂家交换机未测试,特别说明)。 如下: 第一台交换机: CISCO-S3560X_01#show mac address-table ad 03bf.ac1e.000d Mac Address Table ------------------------------------------- Vlan Mac Address Type Ports ---- ----------- -------- ----- 930 03bf.ac1e.000d STATIC Gi0/1 Gi0/2 Gi0/3 Gi0/4 Gi0/5 Po10 Total Mac Addresses for this criterion: 1 第二台交换机: CISCO-S3560X_02#show ip arp 172.30.0.13 Protocol Address Age (min) Hardware Addr Type Interface Internet 172.30.0.13 - 03bf.ac1e.000d ARPA CISCO-S3560X_02#show mac address-table ad 03bf.ac1e.000d Mac Address Table ------------------------------------------- Vlan Mac Address Type Ports ---- ----------- -------- -----

Windows server 2008虚拟化群集部署计划及操作流程 中企虚机搬迁架构调整,虚拟化群集部署操作流程如下: 1.硬件准备 2.整体规划 3.域控制器安装 4.节点服务器加域 5.为节点服务器安装群集功能 6.存储挂接 7.故障转移群集的配置 1.硬件准备: 初次先准备5台服务器,重新安装windows server 2008 R2操作系统。 一台做域控制器,4台部署群集。建议初次配置时先使用品牌和配置相同的服务器,待群集配置成功,再陆续添加其他品牌和配置的服务器。首次的4台服务器中,三台用来运行Hyper-V虚拟机服务,提供CE的虚机服务。剩余的一台做备用,当群集中运行服务的服务器有问题时,将服务迁移到备用机上。 2.整体规划: 硬件准备完毕,操作系统安装好之后,为机器配置IP,开启远程桌面,更新最新补丁。域控制器安装域服务,安装活动目录。群集节点服务器挂载存储。由于节点数是4,偶数节点数需要挂载一个仲裁磁盘,所以需要挂载两个lun,一个存放虚拟机的配置文件及VHD磁盘文件,一个做仲裁磁盘,该磁盘不需要太大空间,5G就够。配置群集前,为群集准备一个IP,这个IP和节点服务器的IP在同一网段。再配群集服务之前,任何服务器不要做安全设置或者域策略,一切按默认的安装,以避免配置群集出错误。下图是群集部署架构图

3.域控制器安装: 服务器全部准备完毕,操作系统安装完成,补丁更新至最新。开始安装 域服务。首先在服务器管理器中添加服务器角色。 图1:添加域服务角色

图2:勾选域服务 图3:安装域服务 安装完域服务后,运行dcpromo安装活动目录向导,进行域控制器的安装。

快速实验winNLB负载均衡

————————————————————————————————作者:————————————————————————————————日期:

客户的web服务器是2003系统,为了保证业务的正常运行,一直有另一台相同的web服务器做冷备。然而冷备的缺点就是假如生产机宕掉或者服务停掉,就需要手工的将冷备的机器切换上线;这样便造成了业务正常运行的断点。 为保证业务的正常连续运行,需要做负载均衡同时也是双机热备,此次先在非生产环境做好实验。 一、环境描述: VMware Workstation版本:10.0.0 build-1295980 操作系统:win2003企业版 每台虚机需要两块网卡,一块网卡用于绑定群集ip,实验中称为公网网卡;另一块用于节点间相互通讯,试验中称为内网网卡。 计算机a:公网地址:192.168.137.19 内网地址:100.0.0.1 计算机b:公网地址:192.168.137.29 内网地址:100.0.0.2 集群ip地址:192.168.137.39 两台虚机的管理员Administrator密码需一致,不能为空,否则会在添加主机到群集时需添加用户名/密码,出现未知错误。 二、具体实施 1、先做好一台win2003的虚拟机,需要注意的是网卡设置成桥接模式,存放虚机的文件夹命名为cp1。 2、复制做好的虚机 3、打开虚机1,需再添加一块网卡,同样是桥接模式。

4、打开虚机2(即复制过的虚机),需先添加两块网卡,同样是桥接模式。然后再把原先的网卡删掉。 5、开机,提示如下选项时,选择复制 6、配置管理员密码并安装IIS,记得选择https://www.doczj.com/doc/b65700752.html,,否则容易出错误。

windows网络服务之配置网络负载均衡(NLB)群集 实验背景:公司有一个Web站点,由于客户访问量逐渐增多,网站响应越来越慢。公司决定用两台WEB服务器供客户访问,这两台服务器提供相同的网站内容,利用网络负载平衡群集技术,根据每台服务器的负载情况来决定客户机具体访问哪台服务器。配置群集的两台计算机在一个windows域中,一台为DC,IP为20.1.1.1(内网卡)10.1.1.10(外网卡),另外一台为成员服务器,IP为20.1.1.2(内网卡)10.1.1.20(外网卡),NLB群集使用的IP地址为10.10.10.10,主机名为https://www.doczj.com/doc/b65700752.html,,客户端的DNS指向DC的外网卡10.1.1.10 实验的目的:理解NLB群集的概念,掌握NLB群集的准备,掌握NLB群集的配置,掌握NLB群集的验证。 实验环境:在VMWARE中打开三台(2003企业版)虚拟机。分别作为域控,成员服务器,客户端 相关概念的介绍 网络负载均衡群集一般用于访问量大,面向前台的服务,增强了WEB FTP ISA VPN 等服务的可靠性,有别于服务器群集,服务器群集一般用于访问量较少的企业内网,面向后台,服务器群集实现DHCP、文件共享、后台打印、MS SQL Server、Exchange Server等服务的可靠性。 配置网络负载均衡群集需要注意:网络负载平衡并不为经过负载的主机提供额外的安全保护,也不可以将其用于防火墙,因此,正确地保护经过负载平衡的应用程序和主机是很重要的。如果可能,在每个群集的主机上至少要使用两个网络适配器,但并非必要条件,在群集适配器上只使用TCP/IP协议,确保群集

故障转移群集 一、实验拓扑图 二、实验环境 1.配置节点环境 服务器名称、域环境、网卡信息等 计算机名角色群集网卡心跳网卡 iscsi连接 DNS服务器 NS1 DC、DNS 192.168.1.1 10.10.10.1 172.16.10.1 192.168.1.1 NS2 域成员192.168.1.2 10.10.10.2 172.16.10.2 192.168.1.1 *注:只配置群集网卡的DNS信息,其他网卡不能配置 2.配置公共存储环境 服务器名称、网卡信息等 3.关闭3台服务器上windows防火墙 三、实验步骤 1.配置公共存储服务器 (1)安装iSCSI Soft Target软件按照提示采用默认安装即可 (2)配置Microsoft iSCSI Soft Target软件管理工具—Microsoft iSCSI Soft Target —创建iscsi目标

输入iscsi目标名称——下一步 然后选择高级——添加——IQN和域名——确定——下一步 (3)安装虚拟磁盘 选择iscsiserver右键——为iscsi目标添加虚拟磁盘——下一步——输入虚拟磁盘文件存储的物理路径c:\qdisk.vhd——下一步

分配空间大小500M(范围为100-1000M) 配置虚拟磁盘的名称——仲裁盘——下一步——完成 同样的方法添加第二块虚拟磁盘 注意:1)物理路径c:\ddisk.vhd 2)空间大小适当大一些2000M 3)虚拟磁盘描述:数据盘

(4)添加可以访问iscsi服务器的发起程序服务器名称 选中iscsiserver节点属性——iscsi发起程序——添加——IP和172.16.10.1、172.16.10.2 2、配置两个节点的iSCSI发起程序 (1)分别在节点1、2上服务器管理工具——iscsi发起程序——发现门户——172.16.10.3和端口——目标——选中内容——连接——目标——设备(显示两个disk磁盘设备)(2)在节点1上服务器管理器——磁盘管理——对磁盘1、2——联机、初始化、新建简单卷(卷标:qdisk 盘符:q 大小500M;卷标:ddisk 盘符:m 大小:2000M) (3)在节点2上服务器管理器——磁盘管理——联机——选中磁盘右键——更改驱动器号和路径(修改为如下图所示) 3、配置故障转移群集 (1)在两个节点上安装故障转移群集功能 (2)在节点1(NS1)上管理工具——故障转移群集——创建一个群集——下一步——浏览找到节点1(NS1)的名称、添加进来——下一步——配置验证测试——运行所有测试——下一步——下一步(显示通过测试)——下一步——输入群集名称和地址(名称不能与域名相同、IP地址不能与其他任何地址相冲突)(mscs和192.168.1.200)——下一步——下一

2008 NLB群集王力 1.网络负载均衡,主要用于web、ftp、isa、vpn等,提高网站的可靠性,实现24小时内不间断工作。具有可伸缩性,当一台服务器出现问题,也不会影响网站的运行,同时可以将大量的连接平均分给各服务器。 2.网络负载均衡,最大支持32个节点,集群中的每台服务器是一个节点。2008自带有NLB 网络负载均衡 测试环境:2008标准版64位,以下是本次测试环境的拓扑 NLB,集群主机共同虚拟出一个IP地址,客户端直接访问集群主机虚拟的ip地址即可。 SERVER1网卡配置: 192.168.1.1为外网地址10.0.0.1为服务器直间的心跳线

Server2网卡配置: 192.1.8.1.2为外网地址10.0.0.2为服务器之间的心跳线网络配置完后测试使用PING测试是否可以通信 SERVER1安装IIS服务:

为了达到测试目的,在SERVER1上创建一个站点内容为AAAAAAAAAAAAAAAAAAAAA SERVER2跟SERVER1一样安装IIS服务,并在自己的磁盘下建立站点,网站的内从显示为BBBBBBBBBBBBBBBBBBBBBB 各自互相访问,测试,网络保证正常通信,OK. 注意: 1.使用虚拟机做的,如果网络不能通信,查看网卡桥接是否正确。 2.在安装搭建的时候,最好先将防火墙关闭

SERVER1安装NLB服务: 安装后在开始-------管理工具-------网络负载均衡管理器中打开,右击新建集群,并在主机栏中写上心跳线地址,写着外网的IP地址 单机下一步继续。

这里的优先级是从1---32,1代表优先级是最高的。这里我默认,下一步 注意:这里很重要,这里是填写集群虚拟IP地址。

山西青年职业学院 毕业设计开题报告 题目简述负载均衡在网络中的应用 专业计算机网络技术 姓名00 指导教师00 2017年11月22日

开题报告 一、论文题目 简述负载均衡在网络系统中的应用 二、选题依据 随着internet的快速发展和业务量的不断提高,基于网络的数据访问流量迅速增长,特别是各大运营商的数据访问、大型门户网站的访问及各大B2C 电商平台的访问。例如2017双十一全网销售2025.3亿,淘宝占66.23%,其中天猫11秒破亿,3分钟突破100亿,40分钟突破500亿交易额,交易峰值达到每秒25.6亿笔。在这些数据刷新的同时,是用户每秒上百万次的点击。 再例如2016年春运期间12306网站奔溃,原因是12306后台无法满足大量用户同时进行的数据访问需求。 第一:是网络应用业务量快速增加,用户访问流量快速增长,其服务器处理能力和计算强度无法满足需求。 第二:单一设备无法满足访问需求,大量的硬件升级又需要高额成本投入,峰值过后还会造成资源浪费, 第三:这时就需要用一种廉价有效的发放扩展网络带宽和吞吐量,加强网络数据处理能力,提高网络的灵活性和可用性。 三、选题在国内、外的发展趋势 在网络的快速发展的同时,大量用户发起的请求的情况下,服务器负载过高,导致用户请求出现无法响应的情况。就出现了国内深信服,天融信,国外redware,F5这类专门做负载均衡的企业。 四、问题的提出 4.1 负载均衡需要解决的问题 4.2 负载均衡的层次结构 4.3 常见的负载均衡技术 4.4 应用Cisco设备实现负载均衡 五、对企业络设计分析 随着互联网的普及,利用网络传输声音与视频信号的需求也越来越大。广播电视等媒体上网后,也都希望通过互联网来发布自己的节目。很多媒体网站都因为用户网络流量增加,出现了网络访问速度慢等问题。 六、简要结构图

大家都知道一台服务器的处理能力,主要受限于服务器自身的可扩展硬件能力。所以,在需要处理大量用户请求的时候,通常都会引入负载均衡器,将多台普通服务器组成一个系统,来完成高并发的请求处理任务。 之前负载均衡只能通过DNS来实现,1996年之后,出现了新的网络负载均衡技术。通过设置虚拟服务地址(IP),将位于同一地域(Region)的多台服务器虚拟成一个高性能、高可用的应用服务池;再根据应用指定的方式,将来自客户端的网络请求分发到

服务器池中。网络负载均衡会检查服务器池中后端服务器的健康状态,自动隔离异常状态的后端服务器,从而解决了单台后端服务器的单点问题,同时提高了应用的整体服务能力。 网络负载均衡主要有硬件与软件两种实现方式,主流负载均衡解决方案中,硬件厂商以F5为代表目前市场占有率超过50%,软件主要为NGINX与LVS。但是,无论硬件或软件实现,都逃不出基于四层交互技术的“转发”或基于七层协议的“代理”这两种方式。四层的转发模式通常性能会更好,但七层的代理模式可以根据更多的信息做到更智能地分发流量。一般大规模应用中,这两种方式会同时存在。 2007年F5提出了ADC(Application delivery controller)的概念为传统的负载均衡器增加了大量的功能,常用的有:SSL卸载、压缩优化和TCP连接优化。NGINX也支持很多ADC的特性,但F5的中高端型号会通过硬件加速卡来实现SSL卸载、压缩优化这一类CPU密集型的操作,从而可以提供更好的性能。 F5推出ADC以后,各种各样的功能有很多,但其实我们最常用的也就几种。这里我也简单的总结了一下,并和LVS、Nginx对比了一下。

目前,网络应用正全面向纵深发展,企业上网和政府上网初见成效。随着网络技术的发展,教育信息网络和远程教学网络等也得到普及,各地都相继建起了教育信息网络,带动了网络应用的发展。 一个面向社会的网站,尤其是金融、电信、教育和零售等方面的网站,每天上网的用户不计其数,并且可能都同时并发访问同一个服务器或同一个文件,这样就很容易产生信息传输阻塞现象;加上Internet线路的质量问题,也容易引起出 现数据堵塞的现象,使得人们不得不花很长时间去访问一个站点,还可能屡次看到某个站点“服务器太忙”,或频繁遭遇系统故障。因此,如何优化信息系统的性能,以提高整个信息系统的处理能力是人们普遍关心的问题。 一、负载均衡技术的引入 信息系统的各个核心部分随着业务量的提高、访问量和数据流量的快速增长,其处理能力和计算强度也相应增大,使得单一设备根本无法承担,必须采用多台服务器协同工作,提高计算机系统的处理能力和计算强度,以满足当前业务量的需求。而如何在完成同样功能的多个网络设备之间实现合理的业务量分配,使之不会出现一台设备过忙、而其他的设备却没有充分发挥处理能力的情况。要解决这一问题,可以采用负载均衡的方法。 负载均衡有两个方面的含义:首先,把大量的并发访问或数据流量分担到多台节点设备上分别处理,减少用户等待响应的时间;其次,单个重负载的运算分担到多台节点设备上做并行处理,每个节点设备处理结束后,将结果汇总,再返回给用户,使得信息系统处理能力可以得到大幅度提高。 对一个网络的负载均衡应用,可以从网络的不同层次入手,具体情况要看对网络瓶颈所在之处的具体情况进行分析。一般来说,企业信息系统的负载均衡大体上都从传输链路聚合、采用更高层网络交换技术和设置服务器集群策略三个角度实现。 二、链路聚合——低成本的解决方案 为了支持与日俱增的高带宽应用,越来越多的PC机使用更加快速的方法连入网络。而网络中的业务量分布是不平衡的,一般表现为网络核心的业务量高,而边缘比较低,关键部门的业务量高,而普通部门低。伴随计算机处理能力的大幅度提高,人们对工作组局域网的处理能力有了更高的要求。当企业内部对高带宽应用需求不断增大时(例如Web访问、文档传输及内部网连接),局域网核心部位的数据接口将产生瓶颈问题,因此延长了客户应用请求的响应时间。并且局域网具有分散特性,网络本身并没有针对服务器的保护措施,一个无意的动作,像不小心踢掉网线的插头,就会让服务器与网络断开。 通常,解决瓶颈问题采用的对策是提高服务器链路的容量,使其满足目前的需求。例如可以由快速以太网升级到千兆以太网。对于大型网络来说,采用网络系统升级技术是一种长远的、有前景的解决方案。然而对于许多企业,当需求还没有大到非得花费大量的金钱和时间进行升级时,使用升级的解决方案就显得有些浪费

服务器网络负载均衡实施方案 一、技术方案 使用Windows Server 2003 网络负载平衡技术,可以实现WWW等诸多系统服务的负载平衡功能。 网络负载均衡是由多台服务器以对称的方式组成一个服务器集合,每台服务器都具有等价的地位,都可以单独对外提供服务而无须其他服务器的辅助。通过某种负载分担技术,将外部发送来的请求均匀分配到对称结构中的某一台服务器上,而接收到请求的服务器独立地回应客户的请求。均衡负载能够平均分配客户请求到服务器列阵,籍此提供快速获取重要数据,解决大量并发访问服务问题。 二、配置要求 1.服务器需要安装双网卡,一块用于负载平衡,一块用于服务器内部通讯。 2.用于集群的服务器,系统管理员密码最好一致,以免引起不必要的麻烦。 3.将网络属性中,不必要的协议都去掉,只保留TCP/IP 和Microsoft 的协议。 4.两台服务器的应用程序用IIS发布。 三、实施步骤 准备两台应用服务器,并配上两个IP地址,在其中一台服务器设置新建群集,步骤如下:1.点击开始→程序→管理工具→网络负载平衡管理器,如下图所示: 2.选择网络负载平衡集群→鼠标右键→新建集群,如下图所示: 3. 配置群集参数 IP 地址: 指对外提供服务的虚拟IP地址。 完整的Internet名:指对外服务的域名,最好和真实环境配置一致。 其余的保持默认设置,如下图示例:

4. 本例中的集群对外只提供一个服务IP地址,所以“附加群集IP地址”不需要再添加,如下图示例: 5.端口规则中,默认是允许所有的TCP,UDP,如下图所示: 6. 本例中,我们只希望实现80端口的集群,我们可以编辑规则,如下图示例:

国内外主流负载均衡产品对比分析

负载均衡设备厂家对比分析 厂商 名称 深信服radware F5 公司介绍 深信服科技目前是中国成长最快、创新能力 最强的前沿网络设备供应商,致力于通过创新和 技术领先的网络产品,帮助用户提升网络带宽的 价值。 目前其产品已经应用于1万4千多家客户, 主要在政府单位和大型企业中应用,其中包括公 安部在内,近200家省厅及国家部委单位。 深信服的VPN产品国内市场占有率第一,是 国家VPN加密标准的起草单位。 Radware 是以色列一家领先的智能化 解决方案供应商,致力于确保在IP上快速、 可靠而安全地交付网络或基于Web的应用 程序。产品系列中包括为满足IP应用服务 器、防火墙、cache 服务器和W AN 链接 而开发和设计的产品。 其在国内的客户主要集中在运营商、金 融、电子商务企业。 F5是美国著名的应用交付设备厂家,致 力于帮助客户在整个企业范围发挥虚拟 化的威力,提高业务水平。解决方案可以 优化网络、服务器、以及存储环境。 目前其在国内主要的客户群主要包括 了金融、大型企业集团、网站等。 服务介绍 深信服是总部设于深圳的中国企业,在全国 有30多个办事处。设有中国负载均衡行业最大 的CTI呼叫中心,拥有坐席70人,提供7*24小 时服务。而在河南郑州设有直属办事处,以及一 个服务中心,有专业产品工程师5人。 Radware 目前在国内有4个办事处, 分别位于上海、广州、北京、成都。为所 有用户提供5*8小时本地电话及在线支持 服务。目前在河南还没有建立直属办事处, 售后服务主要由其代理商负责。 F5 目前在国内有4个办事处,分别位 于上海、广州、北京、成都。为所有用户 提供5*8小时本地电话及在线支持服务。 目前在河南还没有建立直属办事处,售后 服务主要由其代理商的认证工程师负责。 提供收费的原厂售后支持服务。

Vmware Vcenter6.5 全新安装及群集配置介绍 【摘要】 VMware vCenterServer 提供了一个可伸缩、可扩展的平台,为虚拟化管理奠定了基础。可集中管理VMware vSphere环境,与其他管理平台相比,极大地提高了IT 管理员对虚拟环境的控制。 VMware vCenter Server:提高在虚拟基础架构每个级别上的集中控制和可见性,通过主动管理发挥vSphere 潜能,是一个具有广泛合作伙伴体系支持的可伸缩、可扩展平台。 无论您拥有十几个虚拟机,还是几千个虚拟机,VMware vCenter Server 都是管理VMware vSphere 最简单、最有效的方法。借助VMware vCenter Server,可从单个控制台统一管理数据中心的所有主机和虚拟机,该控制台聚合了集群、主机和虚拟机的性能监控功能。VMware vCenter Server 使管理员能够从一个位置深入了解虚拟基础架构的集群、主机、虚拟机、存储、客户操作系统和其他关键组件等所有信息。 借助VMware vCenter Server,虚拟化环境变得更易于管理,一个管理员就能管理100 个以上的工作负载,在管理物理基础架构方面的工作效率比通常情况提高了一倍。 准备环境和工具: 1、两台ESXi6.5主机; 2、准备一台Windows Server 2012 R2系统的虚拟机; 3、 VMware-VIM-all-6.5.0.iso 一、完成VMware vCenterServer安装 二、完成VMware vCenterServer 群集的配置 步骤及容 容1:新建数据中心,命名:vCenter-zhou,新建群集,命名:vCenter-zhou,并启动vSphere HA、DRS的功能;添加两台ESXi6.5主机,主机分别为:172.18.10.20,172.18.10.21; 容2: A、配置两台ESXi6.5主机的VMkernel网络接口,设置IP:172.18.10.22;并启动vMotion,在主 机之间移动虚拟机称为迁移。使用vMotion,可以在不停机的情况下迁移已打开电源的虚拟机; B、两台ESXi6.5主机网卡冗余配置。

由于公司最近网站流量暴增,单台服务器的连接数经常过2W,为了让用户获得更好的性能和网站的容灾型,配置负载平衡(负载均衡、NLB) 也成了首要任务。公司服务器 是 Windows 2003 英文版本,用2台服务器来配置负载均衡。 在 Google 和 Baidu 上面看了2天,发现有一些负载平衡(负载均衡、NLB) 的配置经验还是蛮不错的,所以把这些摘录过来,做下备忘,并希望能帮助更多的人配置。 网络负载平衡(网络负载均衡、NLB、集群)概述 首先,我们先了解下 Windows 2003 自带的负载平衡(负载均 衡)——Network Load Balancing,简称NLB。NLB是一种集成高可用性,高可靠性和高扩展性的集群。它不但能实现均衡负载,而且还能实现多种形式的冗余。NLB主要用于那些文件改动不大,并且不常驻内存的环境,比如WEB服务、FTP服务、和VPN服务等。NLB 不适合用于数据库、邮件等服务,因为不能保证每个节点的数据是一样的。 当用户访问集群的时候,集群能将访问请求分摊到集群中的每个服务器上,以达到均衡负载的效果。这些服务器被称为集群节点。在负载平衡(负载均衡、NLB) 中,每个节点的文件一般都要求是一样的。这样每个节点返回给客户的结果都是一致的。一般来说组建一个NLB 要求至少两个节点,其中一个节点不能使用,这全部负载将落入到剩下的那个节点上,即全载。Windows server 2003 最多支持32个节点。节点越多,可用性(availability),可靠性(reliability)就越高。 NLB能提供三种冗余功能,软件冗余、硬件冗余、站点冗余。 网络负载平衡(网络负载均衡、NLB、集群)工作原理

Cisco路由器转发数据包时常用的五种交换方式 进程交换(Process Switching) 这是一种最基本的交换模式,在这种模式下,一条数据流(Flow)中的第一个包(Packet)将被置入系统缓存(System Buffer)。其目的地址将会拿到路由表中去查询比对,路由器的处理器(CPU or Processer)同时将进行CRC校验,检查包是否正确。然后数据包的二层MAC地址将会被重写,替换为下一跳接口的MAC地址。对这条数据流(Flow)中的第2个、第3个数据包……将会继续这样相同的操作,包括查询路由表、重写MAC地址,CRC校验等。这种方式无疑是延迟最大的,因为它要利用System Buffer以及Processor去处理每个收到的包。但是我们仍然有机会使用这种交换方式,比如在进行基于数据包的负载均衡,或是debug ip packet时。因为默认情况下,思科路由器会启用Fast Switching或Optimum Switching或是CEF Switching,而不是Process Switching,所以我们只能通过:no ip route-cache来禁用Fast Switching,这在另一种意义上正是开启Process Switching。 命令:R1(config-if)#no ip route-cache //启用进程交换(禁用快速交换) 注意:命令debug ip packet仅允许观察进程交换的数据包,将启用进程交换,所有数据包都被送至进程记录,CEF交换、快速交换等的数据包将不被显示出来。 快速交换(Fash Switching)/路由缓存交换(Route-Cache Switching) 快速交换要优于Process Switching,它采用了路由缓存(Route Cache)来存储关于某条数据流(Flow)的特定信息,当然会包括诸如目的MAC地址,目的接口等内容。这时我们只需要对一条数据流(Flow)中的第一个包做Process Switching,并把信息存入Cache,所有后续数据包,可以不必再中断System Processor去执行查询等操作,直接从Cache中提取目的接口,目的MAC地址等,这样大大加速了包转发速度。Fast Switching在某些资料上可能被称为Route-Cache Switching。思科1600、1700、2500、2600系列路由器的Ethernet、Fast Ethernet、Serial接口默认采用的就是Fast Switching。 命令:R1(config-if)#ip route-cache //启用快速交换 R1#show ip cache //查看快速交换 最优交换(Optimum Switching) 和分布式交换(Distributed Switching) 这两种交换模式,从原理上来讲都与Fast Switching极为相似,比如Optimum Switching 其实采用了一种经过优化的交换缓存(Optimumed Switching Cache),它的速度要较平常Cache要快。Distributed Switching需要使用Versatile Interface Card这种硬件卡,又称VIP Card。它会自已保存一份Route Cache,这样查询时就不必等待使用共享的系统缓存(Shared System Buffer)了,无论相对于Fast Switching还是Optimum Switching来讲,都是比较快的。这两种模式一般只在思科高端设备上有所应用,比如7200系列的路由器或12000系列的路由器。 命令:R1(config-if)#ip route-cache optimum //启用最优交换 R1(config-if)#ip route-cache distributed //启用分布式交换 R1#show ip cache optimum //查看最优交换 Netflow交换(Netflow Switching) 这种模式是最值得参考的,它完全基于其它Switching Mode,重点在于对流经的数据包进行计费、监控、网管。但值得提的是,这种模式也要存储相关信息,据统计大致65536条数据流(Flow)会耗费4MB的System Buffer。

DOMINO群集配置方法 1、注册新服务器 administrator - 配置- 注册- 服务器 注册一个你要新增的服务器。 2、安装配置附加服务器 1:拷贝新的SERVER ID到新服务器数据目录; 2:拷贝主服务器上的names.nsf到新的服务器数据目录; 3:修改主服务器配置文档,将新的服务器加入可以访问主服务器的权限里面; 4:配置的时候,选择添加附加服务器,服务器id为你拷贝过去的serverid。 3、新建群集(cluster),并将两个服务器加入这个群集 administrator - 配置- 所有服务器文档- 选中一个服务器然后点击添加到群集- 如果当前没有群集那么选择新建- 加入第二、第二...个服务器。 4、建立两个服务器连接 aministrator - 配置- 连接- 添加连接- 添加一个从附加服务器到主服务器的连接。5、建立群集cluster端口并修改服务器文档和notes.ini文件 1:分别为两个服务器添加群集连接端口: administrator - 配置- 右边工具栏- 服务器- 设置端口- 新建一个端口比如cluster,类型为tcp; 2:修改两个服务器配置文档,在端口-Notes网络端口里面添加cluster,网络地址为当前服务器的ip或主机名,并启用他; 3:修改notes.ini文件,添加如下配置: Server_Cluster_Default_Port=cluster TCPIP_TcpIPAddress=0,10.0.1.1:1352 //根据你自己的服务器ip地址来设置 cluster_TcpIPAddress=0,10.0.1.1:1352 ////根据你自己的服务器ip地址来设置 4:重起两个domino服务器。

一、简单介绍负载均衡 负载均衡也称负载共享,它是指负载均衡是指通过对系统负载情况进行动态调整,把负荷分摊到多个操作节点上执行,以减少系统中因各个节点负载不均衡所造成的影响,从而提高系统的工作效率。在常用的大型服务器系统当中都存在着负载均衡组件,常用的像微软的网络负载平衡NLB、甲骨文的Oracle RAC、思科的负载均衡(SLB),Apach+Tomcat 负载均衡,它们能从硬件或软件不同方面实现系统各节点的负载平衡,有效地提高大型服务器系统的运行效率,从而提升系统的吞吐量。本篇文章以微软的网络负载平衡NAT为例子,简单介绍Windows Server 2008 R2 负载平衡的安装与使用方式。在Windows Server 2008 R2当中,存在着“网络负载平衡”功能 (简称 NLB, Network Load Balancing),它以TCP/IP 为基础的服务,可以将一个已注册的IP地址映射到多个内部域的IP地址当中,让多台主机为同时对网络请求作出反应。使用NLB网络负载均衡最多可以连接到32台主机上,让32台主机共同分担大量的服务压力。在Windows Server 2008 R2 中还具备“故障转移群集”功能,它是利用负载共享的方式,把多台服务器的共用信息进行持久化储存,当其中某台服务器出现问题时,请求会自动分摊到其他服务器当中。使用“故障转移群集”功能,更能保证“网络负载平衡集群”的正常运行,有利于统筹管理分布式系统中的各种资源,利用共享信息及其服务机制扩大系统的处理能力。“故障转移群集”功能将在下一篇文章再作详细介绍。

二、NLB 主要功能 1.支持群集功能,一个群集最多支持32台服务器。 2.支持网络地址转换(NAT)功能,能把请求自动转发到 NLB 群集上对各台服务器。 3.实现管道化式管理,允许向 NLB 群集同时发送多个请求。 4.支持多地址多端口管理,每台服务器可以绑定多个虚拟 IP,每个虚拟 IP 可建立多 个开放式端口。 5.支持故障快速恢复功能,当服务器出现故障重启后将自动恢复群集联机。 6.支持单播、多播、IGMP多播多种群集操作模式。 7.支持事件日志管理,可以快速查阅群集事件记录。 三、NLB 使用方式 3.1. 打开“服务管理器”,添加“网络负载平衡”功能。 3.2. 安装完成后,打开“网络负载平衡管理器”