单层感知器

- 格式:doc

- 大小:150.50 KB

- 文档页数:11

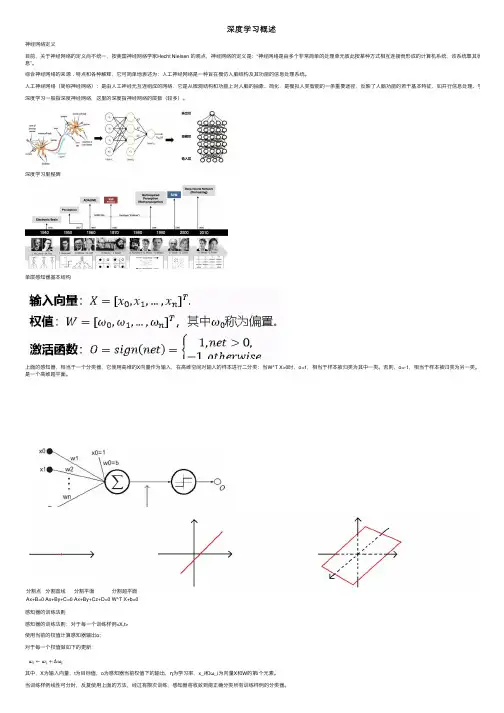

深度学习概述神经⽹络定义⽬前,关于神经⽹络的定义尚不统⼀,按美国神经⽹络学家Hecht Nielsen 的观点,神经⽹络的定义是:“神经⽹络是由多个⾮常简单的处理单元彼此按某种⽅式相互连接⽽形成的计算机系统,该系统靠其状态对外部输息”。

综合神经⽹络的来源﹑特点和各种解释,它可简单地表述为:⼈⼯神经⽹络是⼀种旨在模仿⼈脑结构及其功能的信息处理系统。

⼈⼯神经⽹络(简称神经⽹络):是由⼈⼯神经元互连组成的⽹络,它是从微观结构和功能上对⼈脑的抽象、简化,是模拟⼈类智能的⼀条重要途径,反映了⼈脑功能的若⼲基本特征,如并⾏信息处理、学习、联想、深度学习⼀般指深度神经⽹络,这⾥的深度指神经⽹络的层数(较多)。

深度学习⾥程碑单层感知器基本结构上⾯的感知器,相当于⼀个分类器,它使⽤⾼维的X向量作为输⼊,在⾼维空间对输⼊的样本进⾏⼆分类:当W^T X>0时,o=1,相当于样本被归类为其中⼀类。

否则,o=-1,相当于样本被归类为另⼀类。

这两类的边是⼀个⾼维超平⾯。

分割点分割直线分割平⾯分割超平⾯Ax+B=0Ax+By+C=0Ax+By+Cz+D=0W^T X+b=0感知器的训练法则感知器的训练法则:对于每⼀个训练样例<X,t>使⽤当前的权值计算感知器输出o;对于每⼀个权值做如下的更新:其中,X为输⼊向量,t为⽬标值,o为感知器当前权值下的输出,η为学习率,x_i和ω_i为向量X和W的第i个元素。

当训练样例线性可分时,反复使⽤上⾯的⽅法,经过有限次训练,感知器将收敛到能正确分类所有训练样例的分类器。

在训练样例线性不可分时,训练很可能⽆法收敛。

因此,⼈们设计了另⼀个法则来克服这个不⾜,称为delta法则。

它使⽤梯度下降(Gradient Descent)的⽅法在假设空间中所有可能的权向量,寻找到最佳拟合训练样梯度下降与损失函数l对于多元函数o=f(x)=f(x_0,x_1,…,x_n ),其在X^′=〖[〖x_0〗^′,〖x_1〗^′,…,〖x_n〗^′]' ' 〗^T处的梯度为:梯度向量的⽅向,指向函数增长最快的⽅向。

基于BP神经⽹络的PID控制器设计基于BP神经⽹络的PID控制器设计班级:21班学号:2014561姓名:常临妍摘要常规PID控制技术是⼯业控制中⼀种常⽤的控制⽅法。

其结构简单、容易实现、控制效果良好,且能对相当⼀些⼯业对象或过程进⾏有效的控制,已得到⼴泛应⽤。

但其局限性在于:当控制对象不同,或被控对象具有复杂的⾮线性特性时,难以建⽴精确的数学模型。

控制器的参数难以⾃动调整以适应外界环境的变化。

且由于对象和环境的不确定性,往往难以达到满意的控制效果。

为了使控制器具有较好的⾃适应性,实现控制器参数的⾃动调整,可以借助BP神经⽹络控制的⽅法。

BP神经⽹络已被证明具有逼近任意连续有界⾮线性函数的能⼒,给⾮线性控制带来了新的思路。

利⽤⼈⼯神经⽹络的⾃适应能⼒,并结合传统的PID控制理论,构造神经⽹络PID控制器,实现控制器参数的⾃动调整。

本⽂研究了基于BP神经⽹络的PID控制器设计,利⽤BP神经⽹络的⾃适应能⼒进⾏在线参数整定。

其实现具有⾃适应性等特点,⽹络的收敛速度快,能够对⾮线性对象有很好的控制,系统的跟踪性能好。

其参数设定⽆需知道被控对象的具体参数及其数学模型,对不同的对象具有适应性。

关键词:PID控制BP神经⽹络控制器设计⼀.绪论1.1神经元⽹络PID的发展历程1934年,美国⼼理学家W.McCulloch和数学家W.Pitts⽤数学模型对神经系统中的神经元进⾏理论建模,建⽴了MP神经元模型。

MP神经元模型⾸次⽤简单的数学模型模仿出⽣物神经元活动功能,并揭⽰了通过神经元的相互连接和简单的数学计算,可以进⾏相当复杂的逻辑运算这⼀事实。

1957年,美国计算机学家F.Rosenblatt提出了著名的感知器模型。

它是⼀个具有连续可调权值⽮量的MP神经⽹络模型,经过训练可达到对⼀定输⼊⽮量模型进⾏识别的⽬的。

1959年,美国⼯程师B.Widrow和M.Hoff提出了⾃适应线性元件。

它与感知器的主要不同之处在于其神经元有⼀个线性激活函数,这允许输出可以是任意值,⽽不仅仅只是像感知器中那样只能取0或1。

智能控制智能控制试卷(练习题库)1、简述智能控制的概念。

2、比较智能控制和传统控制的特点?3、智能控制的概念首次由著名学者()提出的。

4、经常作为智能控制典型研究对象的是()。

5、智能自动化开发与应用应当面向()。

6、不属于智能控制是()。

7、以下不属于智能控制主要特点的是()。

8、以下不属于智能控制的是()。

9、地质探矿专家系统常使用的知识表示方法为()。

10、自然语言问答专家系统使用的知识表示方法为()。

11、专家系统中的自动推理是基于O的推理。

12、适合专家控制系统的是()。

13、直接式专家控制通常由O组成。

14、产生式系统的推理方式不包括()。

15、黑板专家控制系统的组成有O16、建立专家系统,最艰难(“瓶颈”)的任务是()。

17、产生式系统包含的基本组成O18、下列概念中不能用普通集合表示的是()。

19、以下应采用模糊集合描述的是()。

20、某模糊控制器的语言变量选为实际温度与给定温度之差即误差e、误差变化率4e;以及加热装置中可控硅导通角21、在论域U中,模糊集合A的支集只包含一个点u,且OAum=I,则A称为()。

22、在模糊控制中,隶属度()。

23、在模糊控制器的推理输出结果中,取其隶属度最大的元素作为精确值, 去执行控制的方法称为()。

24、在温度模糊控制系统中,二维模糊控制器的输出是()。

25、以下的集合运算性质中,模糊集合不满足的运算性质()。

26、模糊控制方法是基于()。

27、以下应采用模糊集合描述的是()。

28、模糊隶属度函数曲线的形状可以为()。

29、某模糊控制器的语言变量选为实际水位与给定水位之差即误差e,以及调节阀门开度的变化量u,故该模糊控制器30、某一隶属度函数曲线的形状可以选为()。

31、模糊控制器的术语“正中”,可用符合O表示。

32、在模糊控制器的推理输出结果中,取其隶属度函数曲线与横坐标围成面积的重心作为输出值,去执行控制的方法称33、下列概念中不能用普通集合表示的是()。

为什么三层感知器能够解决任意区域组合的分类问题(不同隐层数的感知器的分类能⼒)主要内容有:1. 单层感知器的迭代学习算法(包含代码)2. 两层感知器解决异或问题3. 解释两层感知器分类能⼒有限的问题4. 解释为什么三层感知器能够解决任意区域组合的分类问题访问我的博客有更好的展⽰效果。

最近在准备模式识别考试,关于三层感知器能够解决任意区域组合的分类问题解释甚是有趣,这两天考完试了在此对这些内容做个总结。

单层感知器的迭代算法感知器算法属于线性分类器,单层感知器在给定数据线性可分的情况下,可以经过有限次迭代使得算法收敛我曾经写过关于感知器迭代计算学习的代码,是找到⼀个平⾯,将三维空间的两类线性可分的点分隔开来。

感知器算法的更新过程(2类问题)如下:N个属于w1,w2类的模式样本构成训练样本集{X1,X2,....X N}1. 将原始数据写成增⼴向量形式,并规范化构成增⼴向量形式是指添加⼀个维度为1的向量,如三维的样本的话,我们将会这样设置:X=[x1,x2,x3,1]T写成增⼴向量形式是为了让我们的运算能够执⾏矩阵乘法,便于编程实现。

规范化是指将w2类样本×−1接下来任取权向量初始值W(1),开始迭代2.⽤全部训练样本进⾏⼀轮迭代,计算W T(k)X i的值,并修正权向量。

分两种情况,更新权向量的值:若W^T (k) X_i \leq 0表明分类器对第i个模式做了错误分类,我们将进⾏校正,权向量校正为:W(k+1)=W(k)+cX_i \ , \quad c>0若W^T (k) X_i > 0表明分类正确,权向量不变。

W(k+1)=W(k)因此我们可以将权向量的更新规则统⼀写为:W(k+1) = \left\{\begin{matrix} W(k) \quad if \ W^{T}(k)X_i > 0 \\ W(k) + cX_i \quad if \ W^{T}(k)X_i \leq 0 \end{matrix}\right.3.分析分类结果:只要有⼀个错误分类,回到2,直⾄对所有样本正确分类。

单层感知器

一 、与运算

1.程序

function main()

close all

rand ('state',sum(100*clock));

X=[-1,0,0;-1,0,1;-1,1,0;-1,1,1];D=[0,0,0,1];q=1;W=[0.1,rand(1,2)];

O=[0,0,0,0];ERROR=[];R2=[0,0,0,1];t=1;

for j=1:100

for p=1:4

if W(t,:)*X(p,:)'>0

O(1,p)=1;

else

O(1,p)=0;

end

R2(1,p)=D(1,p)-O(1,p)

M=W(t,:)+q* R2(1,p)*X(p,:)

W=[W;M]

if abs(R2(1,1))+abs(R2(1,2))+abs(R2(1,3))+abs(R2(1,4))==0 ,break,end

t=t+1

end

ERROR=[ERROR R2(1,1)+R2(1,2)+R2(1,3)+R2(1,4)]

if abs(R2(1,1))+abs(R2(1,2))+abs(R2(1,3))+abs(R2(1,4))==0 ,break,end

end

for i=1:3

figure

hold on

grid on

x=1:t

y=W(x,i)

plot(x,y,'b--');

ylabel('w')

end

figure

hold on

grid on

for i=1:4

x=X(i,2)

y=X(i,3)

plot(x,y,'*')

end

axis([-1 2 -1 2])

a=0:1

b=[W(t,1)-W(t,2)*a]/W(t,3)

plot(a,b,'b--')

figure

hold on

grid on

x=1:j

y=ERROR(1,x);

plot(x,y,'b--')

end

2.训练结果

最终误差:0

迭代次数:8

最终权值:2.6416 1.3022

最终阈值:3.1000

误差收敛曲线

权值变化曲线

W1变化曲线

W2变化曲线

3 样本分布及分界线

阈值=0.1时 平均迭代次数

学习率

0.01 0.05 0.1 0.5 1 2 10

迭代次数

24.4 5.7 4.4 4.8 6.2 6.8 7.8

学习率=0.1时 平均迭代次数

阈值

0.01 0.05 0.1 0.5 1 2 10

迭代次数

4.8 4.1 5.1 3.1 2.4 5.2 31.5

阈值=0.1 学习率=0.1

变换函数 单极点二值函数 单极点Sigmoid 函数

迭代次数

4.8 1691.9

二 或运算

1编程

function main()

close all

rand ('state',sum(100*clock));

X=[-1,0,0;-1,0,1;-1,1,0;-1,1,1];

D=[0,1,1,1];q=0.1;

W=[0.1,rand(1,2)];

O=[0,0,0,0];

ERROR=[];R2=[0,0,0,1];

t=1;

for j=1:1000

for p=1:4

if W(t,:)*X(p,:)'>0

O(1,p)=1;

else

O(1,p)=0;

end

R2(1,p)=D(1,p)-O(1,p)

M=W(t,:)+q* R2(1,p)*X(p,:)

W=[W;M]

if abs(R2(1,1))+abs(R2(1,2))+abs(R2(1,3))+abs(R2(1,4))==0 ,break,end

t=t+1

end

ERROR=[ERROR abs(R2(1,1))+abs(R2(1,2))+abs(R2(1,3))+abs(R2(1,4))]

if abs(R2(1,1))+abs(R2(1,2))+abs(R2(1,3))+abs(R2(1,4))==0 ,break,end

end

for i=1:3

figure

hold on

grid on

x=1:t

y=W(x,i)

plot(x,y,'b--');

ylabel('w')

end

figure

hold on

grid on

for i=1:4

x=X(i,2)

y=X(i,3)

plot(x,y,'*')

end

axis([-1 2 -1 2])

a=0:1

b=[W(t,1)-W(t,2)*a]/W(t,3)

plot(a,b,'b--')

figure

hold on

grid on

x=1:j

y=ERROR(1,x);

plot(x,y,'b--')

end

2.训练结果

误差收敛曲线

权值变化曲线

W1变化曲线

W2变化曲线

3 样本分布及分界线

三 异或

1编程

function main()

close all

rand ('state',sum(100*clock));

X=[-1,0,0;-1,0,1;-1,1,0;-1,1,1];

D=[0,1,1,0];q=1;

W=[0.1,rand(1,2)];

O=[0,0,0,0];

ERROR=[];R2=[0,0,0,1];

t=1;

for j=1:20

for p=1:4

if W(t,:)*X(p,:)'>0

O(1,p)=1;

else

O(1,p)=0;

end

R2(1,p)=D(1,p)-O(1,p);

M=W(t,:)+q* R2(1,p)*X(p,:);

W=[W;M];

if abs(R2(1,1))+abs(R2(1,2))+abs(R2(1,3))+abs(R2(1,4))==4 ,break,end

t=t+1;

end

ERROR=[ERROR abs(R2(1,1))+abs(R2(1,2))+abs(R2(1,3))+abs(R2(1,4))];

if abs(R2(1,1))+abs(R2(1,2))+abs(R2(1,3))+abs(R2(1,4))==4 ,break,end

end

j

ERROR

for i=1:3

figure

hold on

grid on

x=1:t;

y=W(x,i);

plot(x,y,'b--');

ylabel('w')

end

figure

hold on

grid on

for i=1:4

x=X(i,2);

y=X(i,3);

plot(x,y,'*')

end

axis([-1 2 -1 2])

a=0:1;

b=[W(t,1)-W(t,2)*a]/W(t,3);

plot(a,b,'b--')

figure

hold on

grid on

x=1:j;

y=ERROR(1,x);

plot(x,y,'b--')

end

2.训练结果

最终误差=4

误差收敛曲线

权值变化曲线

W1变化曲线

W2变化曲线