读写hdf5文件编程用户指南

- 格式:pdf

- 大小:1.05 MB

- 文档页数:36

hdfview 用法-回复HDFView是用于浏览和编辑HDF(Hierarchical Data Format,分层数据格式)文件的工具。

HDF是一种用于存储大型科学和工程数据的文件格式,它可以存储多种类型的数据和元数据,并以层次结构的方式组织数据。

在本文中,我们将一步一步地介绍如何使用HDFView浏览和编辑HDF 文件。

第一步:安装HDFView首先,我们需要前往HDFView官方网站(第二步:打开HDF文件一旦启动HDFView,我们可以在主界面上看到菜单栏和工具栏。

要打开一个HDF文件,我们可以通过菜单栏中的“File”选项,然后选择“Open File”来打开一个HDF文件。

在文件对话框中,浏览到文件所在的位置,并选择要打开的HDF文件。

点击“打开”按钮后,HDF文件将在HDFView 的主界面中加载并显示。

第三步:浏览数据集在打开的HDF文件中,我们可以看到文件的层次结构。

层次结构以树状形式显示在左侧的“对象视图”窗口中。

我们可以展开不同的节点以查看数据集、组、数据类型等。

当我们选择一个数据集时,该数据集的内容将显示在右侧的“数据集视图”窗口中。

第四步:查看和编辑数据在数据集视图窗口中,我们可以查看数据集的数据内容。

根据数据集的类型,我们可以选择以表格、图表或其他适当的方式显示数据。

同时,我们还可以对数据集进行编辑,包括添加、删除、修改数据。

要编辑数据,我们可以选择一个特定的数据项,然后使用工具栏上的相关按钮执行相应的操作。

第五步:导出数据如果我们想将数据导出到其他格式,如CSV或Excel,HDFView也提供了这样的功能。

通过使用菜单栏中的“File”选项,然后选择“Export”子选项,我们可以选择将数据导出为所需的格式。

在导出对话框中,指定目标文件的名称和保存位置,然后点击“导出”按钮即可完成导出过程。

第六步:保存修改当我们对HDF文件进行修改后,通常需要将修改保存回原始文件中。

如何使用通用磁盘格式UDF在多种操作系统下读写通用磁盘格式UDF在多种操作系统下读写指南随着存储技术的发展和普及,人们的数据储存需求越来越高。

但是由于不同操作系统之间的文件系统存在差异,同时还有一些特定的存储需要,比如大容量光盘或者蓝光光盘,在不同的操作系统之间进行读写会遇到很多的困难。

这时,通用磁盘格式UDF就成为了一种很好的解决方法。

本文将为您介绍如何使用UDF格式在多种操作系统下进行读写。

一、什么是UDF格式UDF是Universal Disk Format的缩写,中文名为通用磁盘格式。

UDF格式作为新一代光盘文件系统,被广泛应用于光盘储存领域。

它的优势在于它对于存储得到把握很大,同时在不同的操作系统之间能够进行多平台的文件共享,并且对于大容量光盘的存储也具有很好的支持。

UDF格式是非常适合在不同操作系统之间进行读取和写入的。

二、UDF格式的特点UDF格式的最大特点就是在多种操作系统之间进行读写时,它能够很好地完成操作。

UDF格式支持windows、Linux、MacOS和Unix等多种不同操作系统,同时也支持不同设备之间的数据交换,比如PC、移动硬盘、光盘等。

而且,UDF格式可以很好地支持大容量储存,比如蓝光盘、超级视频光盘等,从而满足用户对于大容量储存的需求。

三、如何在不同的操作系统下读写UDF格式1.在Windows系统下读写UDF格式Windows操作系统默认只支持读取UDF格式,如果想要写入,则需要安装第三方驱动程序才行。

其中比较常见的有两种驱动程序。

一种是Imgburn,该驱动支持烧录CUE,ISO等格式文件。

安装后启动软件,选择Write image file to disk,选择ISO文件进行烧录即可。

另外一种是UDF Reader,它是一种免费的UDF阅读器,能够实现对于UDF 格式文件的读写,为Windows系统提供了很好的支持。

2.在Linux系统下读写UDF格式UDF对于Linux来说,是一种默认支持的文件系统。

importh5pyimportmeshio转换数据原理h5py和meshio是常用的Python库,用于处理和转换3D网格数据。

下面将详细介绍h5py和meshio的基本原理和使用方法。

1. h5py的原理:h5py是一个用于读取和写入HDF5格式文件的Python库。

HDF5(Hierarchical Data Format version 5)是一种用于存储和组织大型科学数据集的文件格式。

h5py库提供了一个简单的方式来读取和写入HDF5文件中的数据。

h5py库的主要原理如下:- h5py库利用HDF5文件的层次结构,将数据组织成一个树形结构。

文件中的数据可以通过路径访问,类似于文件系统。

- h5py库提供了一个高级的接口来读取和写入数据。

可以使用创建文件、创建组、创建数据集等功能来组织数据。

- h5py库支持多种数据类型,包括标量、多维数组等。

可以方便地读取和写入不同类型的数据。

- h5py库可以利用HDF5文件的压缩功能,对数据进行压缩以减少文件的大小。

使用h5py库的基本流程如下:1)导入h5py库:使用`import h5py`语句导入h5py库。

2)打开HDF5文件:使用`h5py.File(`函数打开一个HDF5文件。

3)读取数据:使用创建的文件对象访问文件中的数据集,可以通过路径访问。

数据集可以以数组的形式返回。

4)写入数据:利用创建的文件对象可以创建新的数据集,并将数据写入其中。

2. meshio的原理:meshio是一个用于处理各种3D网格文件格式的Python库。

它可以读取和写入包括STL、PLY、VTK、OBJ、Gmsh等在内的多种网格文件格式。

meshio库提供了一个统一的接口来处理各种格式的网格数据。

meshio库的主要原理如下:- meshio库将各种网格文件格式的读取和写入功能封装成统一的函数接口。

用户只需调用相应的函数,即可实现读取和写入不同格式的网格数据。

WRF 模式操作指南The Institute of Atmospheric Physics, Chinese Academy of Sciences Northeast Institute of Geography and Agroecology, Chinese Academy of Sciences中国科学院大气物理研究所中国科学院东北地理与农业生态研究所二○一七年三月二十日目录1. WRF模式简介 (1)2. WRF模式的安装 (2)2.1 安装环境 (2)2.2 模式源程序 (2)2.3 NetCDF函数库的安装 (2)2.4 标准初始化(SI)的安装 (6)2.5 WRF模式的安装 (9)3. WRF模式与T213模式嵌套 (17)3.1 嵌套方案 (17)3.2 嵌套程序设计 (17)3.3编译嵌套程序 (21)3.4 嵌套的实现 (22)4. WRF模式系统的运行 (29)4.1 理想大气方案 (29)4.2 真实大气方案 (32)5. WRF模式系统作业卡 (47)5.1 源程序 (47)5.2 真实大气方案 (48)6. 模式结果的显示处理 (61)6.1 Vis5D格式 (61)6.2 MICAPS格式 (62)6.2 GrADS格式 (65)附录1. WRF模式参数配置说明 (68)附录2. T213场库参数表 (78)WRF模式系统安装/调试技术报告1. WRF模式简介WRF(Weather Research Forecast)模式系统是由许多美国研究部门及大学的科学家共同参与进行开发研究的新一代中尺度预报模式和同化系统。

WRF模式系统的开发计划是在1997年由NCAR中小尺度气象处、NCEP的环境模拟中心、FSL 的预报研究处和奥克拉荷马大学的风暴分析预报中心四部门联合发起建立的,并由国家自然科学基金和NOAA共同支持。

现在,这项计划,得到了许多其他研究部门及大学的科学家共同参与进行开发研究。

h5dump用法-回复h5dump是一个命令行工具,用于将HDF5格式的数据文件转换为文本格式,以便于查看和分析。

HDF5(Hierarchical Data Format 5)是一种用于存储和管理大规模科学数据的文件格式,它具有多种数据类型和数据结构,能够存储多维数组、表格、图像等复杂的数据结构。

而h5dump则为我们提供了一种查看和理解HDF5数据文件内容的方式。

本文将一步一步回答关于h5dump的使用方法并介绍其常见的参数设置。

第一步:安装h5dump工具要使用h5dump工具,我们首先需要将其安装到我们的计算机系统中。

h5dump是HDF5软件库的一部分,因此我们需要先安装HDF5软件库。

你可以从HDF5的官方网站(安装完HDF5软件库后,我们就可以使用其中的工具h5dump了。

第二步:打开命令行界面在开始使用h5dump之前,我们需要打开一个命令行界面。

在Windows 系统中,可以按下Win + R键,然后输入cmd并按下回车键来打开命令提示符窗口。

在Linux系统中,可以通过选择终端或者键盘快捷键(如Ctrl + Alt + T)来打开命令行界面。

第三步:进入HDF5数据文件所在的目录接下来,我们需要进入存储HDF5数据文件的目录。

使用cd命令进入目标目录,如cd D:\HDF5Data。

第四步:使用h5dump命令在命令行中输入"h5dump"命令,然后紧跟需要转换的HDF5数据文件的路径和文件名,以及其他参数。

例如,要转换名为data.h5的HDF5数据文件,我们可以输入以下命令:h5dump data.h5第五步:阅读h5dump输出h5dump会将HDF5数据文件的内容以文本格式输出到命令行界面。

我们可以根据输出的内容,了解数据文件中存储的数据结构、数据类型以及数据的具体值。

除了常见的使用方法外,h5dump还提供了一些有用的参数,用于定制化输出内容的格式和范围。

datax hdfswriter参数标题:DataX HDFSWriter参数详解引言:DataX是一个开源的数据同步工具,用于大数据领域的数据交互和同步。

其中,HDFSWriter是DataX中用于将数据写入HDFS(Hadoop分布式文件系统)的插件。

本文将详细介绍DataX HDFSWriter的参数,帮助读者更好地理解和使用该插件。

正文内容:一、HDFSWriter参数概述1.1 文件系统类型(fileType)1.2 文件路径(path)1.3 文件命名规则(fileName)1.4 文件压缩格式(compress)1.5 文件写入模式(writeMode)二、文件系统类型(fileType)2.1 HDFS文件系统类型(hdfs)2.2 本地文件系统类型(local)三、文件路径(path)3.1 HDFS文件路径(hdfsPath)3.2 本地文件路径(localPath)四、文件命名规则(fileName)4.1 文件名前缀(namePrefix)4.2 文件名后缀(nameSuffix)五、文件压缩格式(compress)5.1 不压缩(none)5.2 Gzip压缩(gzip)5.3 Bzip2压缩(bzip2)5.4 Snappy压缩(snappy)六、文件写入模式(writeMode)6.1 覆盖模式(truncate)6.2 追加模式(append)总结:DataX HDFSWriter参数的详细介绍如上所述。

通过了解这些参数,用户可以根据自身需求进行配置,实现数据写入HDFS的个性化操作。

在实际使用中,应根据具体场景选择合适的参数值,以获得最佳的性能和效果。

(注:本文以DataX版本为基准进行介绍,不同版本的DataX可能存在参数差异,请以实际情况为准。

)以上是一篇关于DataX HDFSWriter参数的详细介绍,希望对您有所帮助。

如有任何疑问或需要进一步了解,请随时与我们联系。

常见数据集文件格式常见的数据集文件格式是指存储和组织数据的方式。

不同类型的数据集可能以不同的格式存储,这些格式通常具有不同的特点和用途。

下面是一些常见的数据集文件格式及其相关参考内容。

1. CSV文件格式(逗号分隔值):CSV是一种简单的文本格式,数据以逗号分隔。

CSV文件可以通过文本编辑器打开,并且由于其简单的格式,可以与各种软件和编程语言兼容。

CSV文件适用于存储表格数据,例如用途广泛的Excel软件可以读取和处理CSV文件。

参考内容:CSV文件格式指南、CSV文件格式教程2. JSON文件格式(JavaScript对象表示):JSON是一种用于存储和传输数据的文本格式,常用于Web应用程序中。

JSON文件使用键值对的方式组织数据,具有易读和易解析的特点。

JSON文件通常用于存储结构化数据,例如API的响应结果。

参考内容:JSON文件格式说明、JSON文件格式介绍3. XML文件格式(可扩展标记语言):XML是一种常用的文本文件格式,用于存储和传输数据。

XML文件使用标记来定义和组织数据,可支持自定义结构和数据类型。

XML文件通常用于存储复杂的结构化数据,例如配置文件和文档。

参考内容:XML文件格式教程、XML文件格式解析器4. HDF5文件格式(层次型数据格式):HDF5是一种用于存储大型和复杂数据集的文件格式。

HDF5文件格式可以存储多种数据类型和维度的数据,并支持数据压缩和高效读写操作。

HDF5文件适用于科学和工程领域,例如存储实验数据和模型输出。

参考内容:HDF5文件格式指南、HDF5文件格式文档5. SQL数据库文件格式(结构化查询语言):SQL数据库文件是一种用于存储结构化数据的文件格式。

常见的SQL数据库文件格式包括SQLite、MySQL、PostgreSQL 等。

SQL数据库文件具有事务处理功能,并支持复杂的查询和数据关联操作。

参考内容:SQL数据库文件格式说明、SQL数据库文件管理除了上述常见的数据集文件格式,还有许多其他特定领域或特定软件的数据集文件格式。

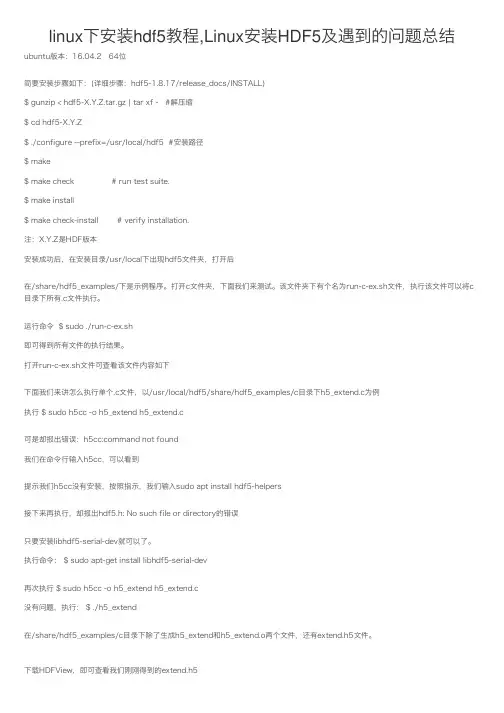

linux下安装hdf5教程,Linux安装HDF5及遇到的问题总结ubuntu版本:16.04.2 64位简要安装步骤如下:(详细步骤:hdf5-1.8.17/release_docs/INSTALL)$ gunzip < hdf5-X.Y.Z.tar.gz | tar xf - #解压缩$ cd hdf5-X.Y.Z$ ./configure --prefix=/usr/local/hdf5 #安装路径$ make$ make check # run test suite.$ make install$ make check-install # verify installation.注:X.Y.Z是HDF版本安装成功后,在安装⽬录/usr/local下出现hdf5⽂件夹,打开后在/share/hdf5_examples/下是⽰例程序。

打开c⽂件夹,下⾯我们来测试。

该⽂件夹下有个名为run-c-ex.sh⽂件,执⾏该⽂件可以将c ⽬录下所有.c⽂件执⾏。

运⾏命令 $ sudo ./run-c-ex.sh即可得到所有⽂件的执⾏结果。

打开run-c-ex.sh⽂件可查看该⽂件内容如下下⾯我们来讲怎么执⾏单个.c⽂件,以/usr/local/hdf5/share/hdf5_examples/c⽬录下h5_extend.c为例执⾏ $ sudo h5cc -o h5_extend h5_extend.c可是却报出错误:h5cc:command not found我们在命令⾏输⼊h5cc,可以看到提⽰我们h5cc没有安装,按照指⽰,我们输⼊sudo apt install hdf5-helpers接下来再执⾏,却报出hdf5.h: No such file or directory的错误只要安装libhdf5-serial-dev就可以了。

执⾏命令: $ sudo apt-get install libhdf5-serial-dev再次执⾏ $ sudo h5cc -o h5_extend h5_extend.c没有问题,执⾏: $ ./h5_extend在/share/hdf5_examples/c⽬录下除了⽣成h5_extend和h5_extend.o两个⽂件,还有extend.h5⽂件。

hdf5storage.savemat用法-回复如何使用hdf5storage.savemat函数。

HDF5是一种用于组织和存储大规模科学数据的文件格式。

hdf5storage.savemat是Python中的一个函数,用于将Python对象保存到HDF5文件中。

本文将详细介绍hdf5storage.savemat函数的用法,以及如何一步一步使用该函数。

首先,要使用hdf5storage.savemat函数,我们需要安装hdf5storage 库。

可以通过运行以下命令来安装该库:pythonpip install hdf5storage安装完成后,我们可以在代码中导入hdf5storage.savemat函数:pythonfrom hdf5storage import savemat接下来,我们需要创建我们要保存的Python对象。

这可以是一个字典、一个数组、一个嵌套结构等等。

让我们以一个字典作为例子:pythondata = {'name': 'John', 'age': 25, 'city': 'New York'}现在,我们可以使用hdf5storage.savemat函数来保存这个字典到HDF5文件中。

该函数接受两个参数:文件名和要保存的对象。

在文件名参数中,我们应该指定希望保存的文件名和路径。

在对象参数中,我们应该提供要保存的Python对象。

pythonsavemat('data.h5', data)以上代码将创建一个名为"data.h5"的HDF5文件,并将字典"data"保存到该文件中。

除了基本的用法之外,hdf5storage.savemat函数还有一些可选参数,可以用来自定义保存行为。

其中一些常用的参数包括:格式版本、指定要保存的变量和禁用压缩。

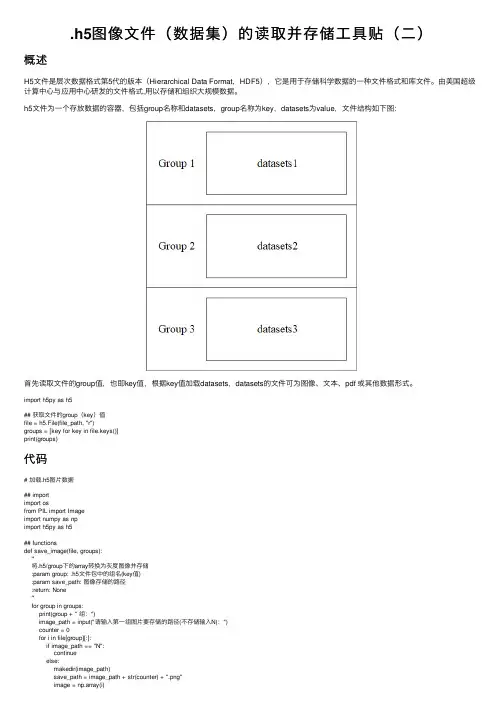

.h5图像⽂件(数据集)的读取并存储⼯具贴(⼆)概述H5⽂件是层次数据格式第5代的版本(Hierarchical Data Format,HDF5),它是⽤于存储科学数据的⼀种⽂件格式和库⽂件。

由美国超级计算中⼼与应⽤中⼼研发的⽂件格式,⽤以存储和组织⼤规模数据。

h5⽂件为⼀个存放数据的容器,包括group名称和datasets,group名称为key,datasets为value,⽂件结构如下图:⾸先读取⽂件的group值,也即key值,根据key值加载datasets,datasets的⽂件可为图像、⽂本、pdf 或其他数据形式。

import h5py as h5## 获取⽂件的group(key)值file = h5.File(file_path, "r")groups = [key for key in file.keys()]print(groups)代码# 加载.h5图⽚数据## importimport osfrom PIL import Imageimport numpy as npimport h5py as h5## functionsdef save_image(file, groups):'''将.h5/group下的array转换为灰度图像并存储:param group: .h5⽂件包中的组名(key值):param save_path: 图像存储的路径:return: None'''for group in groups:print(group + " 组:")image_path = input("请输⼊第⼀组图⽚要存储的路径(不存储输⼊N):")counter = 0for i in file[group][:]:if image_path == "N":continueelse:makedir(image_path)save_path = image_path + str(counter) + ".png"image = np.array(i)image *= 255 # 变换为0-255的灰度值image = Image.fromarray(image)image = image.convert('L') # 灰度为L,彩⾊为RGB’image.save(save_path)print(counter + 1)counter += 1print("done!")def makedir(dir_path):'''创建⽂件夹:param dir_path: ⽂件夹路径:return: None'''isExists = os.path.exists(dir_path)if not isExists: # 判断如果⽂件不存在,则创建os.makedirs(dir_path)def load_h5(file_path):'''加载.h5数据:param file_path: .h5⽂件路径:return: groups, file'''file = h5.File(file_path, "r")groups = [key for key in file.keys()]print("该⽂件共有以下⼏组:", groups)return groups, file## mainif __name__ == "__main__":h5_file = input("输⼊.h5⽂件路径:")groups, file = load_h5(h5_file)save_image(file, groups)操作说明输⼊.h5⽂件路径根据提⽰输⼊每组的存储路径 (注意路径最后要加 \ )⽆需创建⽂件夹,输⼊路径会⾃动创建提取的图⽚如下。

Python数据存储之h5py详解1、Python数据存储(压缩)(1)numpy.save , numpy.savez , scipy.io.savematnumpy和scipy内建的数据存储⽅式。

(2)cPickle + gzipcPickle是pickle内建的数据存储⽅式,gzip是常⽤的⽂件压缩模块。

(3)h5pyh5py是对HDF5⽂件格式进⾏读写的python包,关于h5py更多介绍与安装,参考关于HDF5,参考。

:⼀个HDF5⽂件就是⼀个由两种基本数据对象(groups and datasets)存放多种科学数据的容器:HDF5 dataset: 数据元素的⼀个多维数组以及⽀持元数据(metadata); HDF5 group: 包含0个或多个HDF5对象以及⽀持元数据(metadata)的⼀个群组结构;总之,dataset是类似于数组的数据集,⽽group是类似⽂件夹⼀样的容器,存放dataset和其他group;group和dataset在h5py 中的使⽤有点类似于词典和Numpy中数组的⽤法。

h5py的优势:速度快、压缩效率⾼,总之,numpy.savez和cPickle存储work或不work的都可以试⼀试h5py!2、h5py读取和存储数据⽰例import h5pyX= np.random.rand(100, 1000, 1000).astype('float32')y = np.random.rand(1, 1000, 1000).astype('float32')# Create a new filef = h5py.File('data.h5', 'w')f.create_dataset('X_train', data=X)f.create_dataset('y_train', data=y)f.close()# Load hdf5 datasetf = h5py.File('data.h5', 'r')X = f['X_train']Y = f['y_train']f.close()详细使⽤⽅法,。

Hadoop读写过程详细代码【必掌握】一、文件的打开1.1、客户端HDFS打开一个文件,需要在客户端调用DistributedFileSystem.open(Path f, int bufferSize),其实现为:public FSDataInputStream open(Path f, int bufferSize) throws IOException { return new DFSClient.DFSDataInputStream( dfs.open(getPathName(f), bufferSize, verifyChecksum, statistics));}其中dfs为DistributedFileSystem的成员变量DFSClient,其open函数被调用,其中创建一个DFSInputStream(src, buffersize, verifyChecksum)并返回。

在DFSInputStream的构造函数中,openInfo函数被调用,其主要从namenode中得到要打开的文件所对应的blocks的信息,实现如下:synchronized void openInfo() throws IOException {LocatedBlocks newInfo = callGetBlockLocations(namenode, src, 0, prefetchSize);this.locatedBlocks = newInfo;this.currentNode = null;}private static LocatedBlocks callGetBlockLocations(ClientProtocolnamenode,String src, long start, long length) throws IOException {return namenode.getBlockLocations(src, start, length);}LocatedBlocks主要包含一个链表的List blocks,其中每个LocatedBlock 包含如下信息:Block b:此block的信息long offset:此block在文件中的偏移量DatanodeInfo[] locs:此block位于哪些DataNode上上面namenode.getBlockLocations是一个RPC调用,最终调用NameNode类的getBlockLocations函数。

hdf格式气溶胶数据读取清洗pythonHDF格式是一种常用的数据存储格式,常用于存储科学数据,包括气溶胶数据。

在Python中,我们可以使用h5py库来读取和处理HDF格式的数据。

首先,我们需要安装h5py库。

可以使用以下命令在命令行中安装h5py:```bashpip install h5py```安装完成后,我们可以开始读取和清洗HDF格式的气溶胶数据。

首先,我们需要导入h5py库:```pythonimport h5py```然后,我们可以使用h5py库中的File类来打开HDF文件:```pythonwith h5py.File('气溶胶数据.hdf', 'r') as f:# 读取数据data = f['数据集名称'][:]```在上面的代码中,我们使用了`with`语句来打开HDF文件,并使用`[:]`来读取整个数据集。

如果需要读取特定的数据集,可以将数据集名称替换为实际的数据集名称。

接下来,我们可以对读取的数据进行清洗。

清洗数据的具体步骤会根据数据的具体情况而定,通常包括去除缺失值、异常值处理、数据转换等操作。

以下是一个简单的数据清洗示例,假设我们需要去除缺失值:```pythonimport numpy as np# 去除缺失值cleaned_data = data[~np.isnan(data).any(axis=1)]```在上面的代码中,我们使用了NumPy库来去除数据中包含缺失值的行。

根据实际情况,可能需要进行更复杂的数据清洗操作。

最后,我们可以将清洗后的数据保存到新的HDF文件中:```pythonwith h5py.File('清洗后的气溶胶数据.hdf', 'w') as f:f.create_dataset('cleaned_data', data=cleaned_data)```在上面的代码中,我们使用了`create_dataset`方法来创建新的数据集,并将清洗后的数据保存其中。

caffe hdf5实例Caffe是一种流行的深度学习框架,它支持使用HDF5(Hierarchical Data Format 5)格式来存储和管理训练数据。

HDF5是一种用于存储和组织大规模科学数据的文件格式,它具有高效的I/O操作和灵活的数据结构,因此非常适合在深度学习中使用。

在Caffe中使用HDF5格式进行数据管理具有很多优点。

首先,HDF5格式允许我们将训练数据和标签存储在一个文件中,方便数据的读取和管理。

其次,HDF5格式支持灵活的数据结构,可以存储多维数组和高维矩阵,适用于各种类型的深度学习任务。

此外,HDF5格式还支持数据压缩和并行读取,可以提高数据的传输效率。

在使用Caffe和HDF5进行深度学习任务时,首先需要将原始数据转换为HDF5格式。

Caffe提供了一个Python脚本`convert_imageset.py`,可以将图像数据转换为HDF5格式。

该脚本需要指定输入图像文件夹、输出HDF5文件、标签文件等参数。

通过运行该脚本,可以将图像数据转换为HDF5格式,并生成相应的标签文件。

在训练过程中,可以使用Caffe提供的`HDF5DataLayer`来加载HDF5数据。

该层可以指定HDF5文件的路径和标签文件的路径,并将数据读取到Caffe的内存中。

通过配置网络模型文件,可以将HDF5DataLayer与其他层(如卷积层、全连接层等)连接起来,构建完整的深度学习网络。

使用HDF5格式进行数据管理的一个重要优势是可以在训练过程中动态调整数据。

例如,可以在每个迭代中随机选择一部分数据作为训练样本,以增加模型的泛化能力。

此外,还可以通过增加数据增强操作(如随机裁剪、翻转等)来扩充训练数据,提高模型的鲁棒性。

除了训练数据,HDF5格式还可以用于存储模型参数和训练状态。

在模型训练过程中,可以将模型参数保存为HDF5文件,以便后续的预测和推理任务。

此外,还可以将训练状态保存为HDF5文件,以便在训练过程中进行断点续训或模型调优。

矿产资源开发利用方案编写内容要求及审查大纲

矿产资源开发利用方案编写内容要求及《矿产资源开发利用方案》审查大纲一、概述

㈠矿区位置、隶属关系和企业性质。

如为改扩建矿山, 应说明矿山现状、

特点及存在的主要问题。

㈡编制依据

(1简述项目前期工作进展情况及与有关方面对项目的意向性协议情况。

(2 列出开发利用方案编制所依据的主要基础性资料的名称。

如经储量管理部门认定的矿区地质勘探报告、选矿试验报告、加工利用试验报告、工程地质初评资料、矿区水文资料和供水资料等。

对改、扩建矿山应有生产实际资料, 如矿山总平面现状图、矿床开拓系统图、采场现状图和主要采选设备清单等。

二、矿产品需求现状和预测

㈠该矿产在国内需求情况和市场供应情况

1、矿产品现状及加工利用趋向。

2、国内近、远期的需求量及主要销向预测。

㈡产品价格分析

1、国内矿产品价格现状。

2、矿产品价格稳定性及变化趋势。

三、矿产资源概况

㈠矿区总体概况

1、矿区总体规划情况。

2、矿区矿产资源概况。

3、该设计与矿区总体开发的关系。

㈡该设计项目的资源概况

1、矿床地质及构造特征。

2、矿床开采技术条件及水文地质条件。