一体化高性能计算平台采购项目

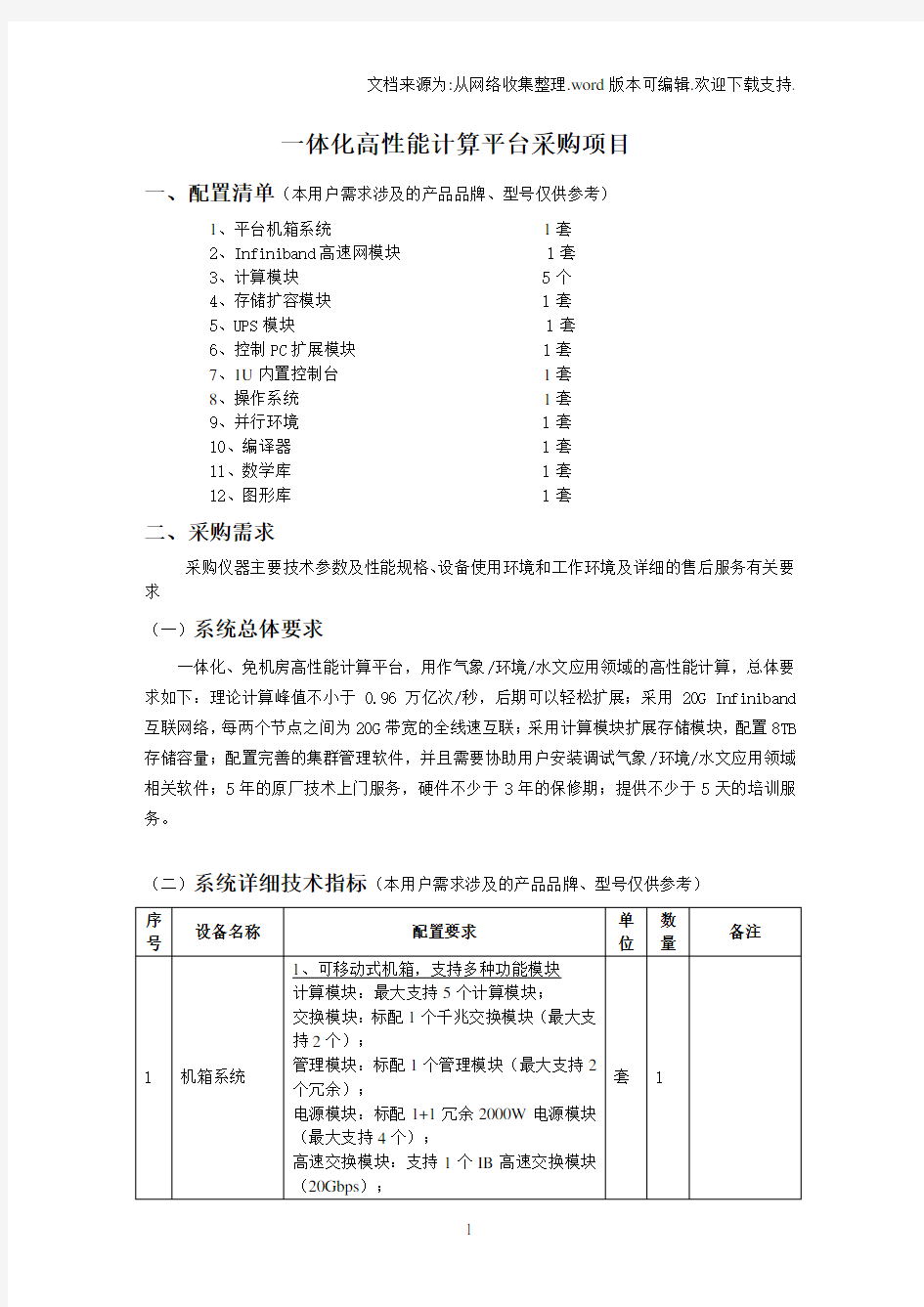

一、配置清单(本用户需求涉及的产品品牌、型号仅供参考)

1、平台机箱系统1套

2、Infiniband高速网模块 1套

3、计算模块 5个

4、存储扩容模块 1套

5、UPS模块 1套

6、控制PC扩展模块 1套

7、1U内置控制台1套

8、操作系统1套

9、并行环境 1套

10、编译器 1套

11、数学库 1套

12、图形库 1套

二、采购需求

采购仪器主要技术参数及性能规格、设备使用环境和工作环境及详细的售后服务有关要求

(一)系统总体要求

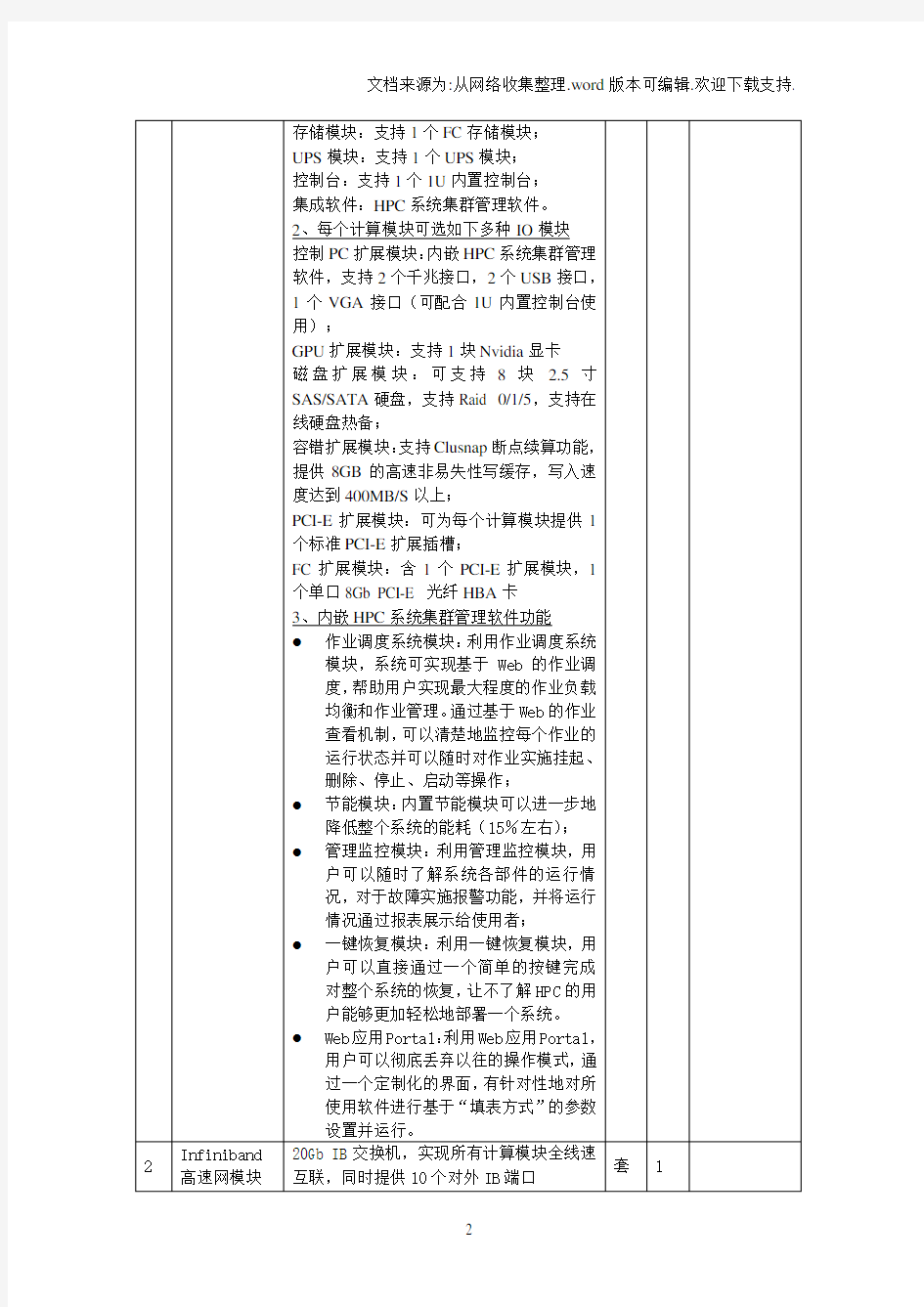

一体化、免机房高性能计算平台,用作气象/环境/水文应用领域的高性能计算,总体要求如下:理论计算峰值不小于0.96万亿次/秒,后期可以轻松扩展;采用20G Infiniband 互联网络,每两个节点之间为20G带宽的全线速互联;采用计算模块扩展存储模块,配置8TB 存储容量;配置完善的集群管理软件,并且需要协助用户安装调试气象/环境/水文应用领域相关软件;5年的原厂技术上门服务,硬件不少于3年的保修期;提供不少于5天的培训服务。

(二)系统详细技术指标(本用户需求涉及的产品品牌、型号仅供参考)

XXXX 高性能计算平台建设方案 XXXXX 2013年4月

目录 1 概述 (2) 1.1 背景概况 (2) 1.2 建设内容 (3) 1.3 设计原则 (3) 2 总体架构 (5) 3 高性能计算平台硬件系统 (6) 3.1 平台架构图 (6) 3.2 主要设备选型 (8) 3.3 Cluster集群系统 (9) 3.4 计算节点 (10) 3.5 管理节点 (10) 3.6 I/O存储节点 (11) 3.7 网络系统方案............................................................................... 错误!未定义书签。 3.8 管理网络 (12) 3.9 监控网络 (12) 3.10 存储系统 (12) 4 高性能计算平台软件系统 (13) 4.1 64位Linux操作系统 (13) 4.2 集群管理软件 (14) 4.3 作业调度系统 (14) 4.4 并行文件系统 (15) 4.5 集群并行计算环境 (15) 4.6 标准库函数 (16) 4.7 标准应用软件 (16) 5 项目经费预算 (17) 5.1 经费来源 (17) 5.2 经费支出预算 (17) 附页——高性能计算平台技术参数要求 (18)

1概述 1.1背景概况 20世纪后半期,全世界范围掀起第三次产业革命的浪潮,人类开始迈入后 工业社会——信息社会。在信息经济时代,其先进生产力及科技发展的标志就是 计算技术。在这种先进生产力中高性能计算机(超级计算机)更是具有代表性。 时至今日,计算科学(尤其是高性能计算)已经与理论研究、实验科学相并列,成为现代科学的三大支柱之一。 三种科研手段中,理论研究为人类认识自然界、发展科技提供指导,但科学 理论一般并不直接转化为实用的技术;实验科学一方面是验证理论、发展理论的重要工具,另一方面,它是在理论的指导下发展实用技术,直接为经济发展服务;计算科学的发展也有相当悠久的历史,只是在计算机这一强大的计算工具问世之前,计算只能利用人类的大脑和简单的工具,计算应用于科学研究有天然的局限性,限制了它作用的发挥;随着计算机技术的发展,使用科学计算这一先进的技术手段不断普及,逐渐走向成熟。科学计算可以在很大程度上代替实验科学,并能在很多情况下,完成实验科学所无法完成的研究工作。科学计算也直接服务于实用科技,并为理论的发展提供依据和机会。在许多情况下,或者理论模型过于复杂甚至尚未建立,或者实验费用过于昂贵甚至不允许进行,此时计算模拟就成为求解问题的唯一或主要手段了。 目前,高性能计算已广泛应用于国民经济各领域,发挥着不可替代的重要作用: a) 基础学科中深入的知识发现,问题规模的扩大和求解精度的增加需要更 高性能的计算资源。例如,计算立体力学、计算材料学、计算电磁学。 b) 多学科综合设计领域中大量多部门协同计算需要构建高性能的综合平 台。例如,汽车设计、船舶设计。 c) 基于仿真的工程科学结合传统工程领域的知识技术与高性能计算,提供 经济高效地设计与实践方法。例如,基于仿真的医学实践、数字城市模拟、核电、油田仿真工具、新材料开发、碰撞仿真技术、数字风洞。

LSF高性能分布运算解决方案 一、系统组成 速度系统主要由IBM X3850 X5集群计算机、IBM X3650 M3 虚拟化服务器、Dell R5100图形工作站、存储系统组成。 IBM X3850 X5集群计算机:每个节点 4 颗CPU,每个 CPU 8核,主频 2.26GHz,节点内存 128GB。 IBM X3650 M3虚拟化服务器:每个节点 2 个 CPU,每个 CPU4核,主频 2.66GHz,节点内存 48GB。 Dell R5100图形工作站:每个节点包括 1个NVIDIA Quadro 6000 显示卡,主机CPU 主频为3.06 GHz,内存为 8GB,硬盘为 4*146GB。 存储系统:IBM DS5020 可用容量约为 12TB,由集群计算机、虚拟化服务器和图形工作站共享。 IBM X3850 X5计算集群运行用户的程序。 LSF高性能分布运算解决方案系统示意图 二、主要软件

1.操作系统:IBM X3850 X5集群计算机安装 64 位Windows2008 系统,IBM X3650 M3 安装Vmware ESX4.1系统,图形工作站安装64 位Windows2008 系统。 2.作业调度系统:Platform 公司的LSF。 3.应用软件:如表 1 所示。 名称厂家 LightTools ORA ZEMAX-EE Focus Software PADS ES Suite Ap SW Mentor Graphics Expedition PCB Pinnacle Mentor Graphics DxDesigner ExpPCB Bnd SW Mentor Graphics I/O Designer Ap SW Mentor Graphics Multi-FPGA Optimization Op S Mentor Graphics HyperLynx SI PI Bnd SW Mentor Graphics Questa Core VLOG Ap SW Mentor Graphics Precision RTL Plus Ap SW Mentor Graphics SystemVision 150 Ap SW Mentor Graphics FlowTHERM Parallel Ap SW Mentor Graphics Labview NI Code Composer Studio TI Quartus II Altera ISE Xilinx Vxworks Wind River Intel C++ Studio XE Intel MatLab及相关工具箱Mathworks Maple MapleSoft Oracle Oracle NX Mach 3 Product Design Siemens PLM Software ADAMS MSC

高性能计算集群(HPC CLUSTER) 1.1什么是高性能计算集群? 简单的说,高性能计算(High-Performance Computing)是计算机科学的一个分支,它致力于开发超级计算机,研究并行算法和开发相关软件。 高性能集群主要用于处理复杂的计算问题,应用在需要大规模科学计算的环境中,如天气预报、石油勘探与油藏模拟、分子模拟、基因测序等。高性能集群上运行的应用程序一般使用并行算法,把一个大的普通问题根据一定的规则分为许多小的子问题,在集群内的不同节点上进行计算,而这些小问题的处理结果,经过处理可合并为原问题的最终结果。由于这些小问题的计算一般是可以并行完成的,从而可以缩短问题的处理时间。 高性能集群在计算过程中,各节点是协同工作的,它们分别处理大问题的一部分,并在处理中根据需要进行数据交换,各节点的处理结果都是最终结果的一部分。高性能集群的处理能力与集群的规模成正比,是集群内各节点处理能力之和,但这种集群一般没有高可用性。 1.2 高性能计算分类 高性能计算的分类方法很多。这里从并行任务间的关系角度来对高性能计算分类。 1.2.1 高吞吐计算(High-throughput Computing) 有一类高性能计算,可以把它分成若干可以并行的子任务,而且各个子任务彼此间没有什么关联。因为这种类型应用的一个共同特征是在海量数据上搜索某些特定模式,所以把这类计算称为高吞吐计算。所谓的Internet计算都属于这一类。按照Flynn的分类,高吞吐计算属于SIMD(Single Instruction/Multiple Data,单指令流-多数据流)的范畴。 1.2.2 分布计算(Distributed Computing) 另一类计算刚好和高吞吐计算相反,它们虽然可以给分成若干并行的子任务,但是子任务间联系很紧密,需要大量的数据交换。按照Flynn的分类,分布式的高性能计算属于MIMD (Multiple Instruction/Multiple Data,多指令流-多数据流)的范畴。 1.3高性能计算集群系统的特点 可以采用现成的通用硬件设备或特殊应用的硬件设备,研制周期短; 可实现单一系统映像,即操作控制、IP登录点、文件结构、存储空间、I/O空间、作业管理系统等等的单一化; 高性能(因为CPU处理能力与磁盘均衡分布,用高速网络连接后具有并行吞吐能力); 高可用性,本身互为冗余节点,能够为用户提供不间断的服务,由于系统中包括了多个结点,当一个结点出现故障的时候,整个系统仍然能够继续为用户提供服务; 高可扩展性,在集群系统中可以动态地加入新的服务器和删除需要淘汰的服务器,从而能够最大限度地扩展系统以满足不断增长的应用的需要; 安全性,天然的防火墙; 资源可充分利用,集群系统的每个结点都是相对独立的机器,当这些机器不提供服务或者不需要使用的时候,仍然能够被充分利用。而大型主机上更新下来的配件就难以被重新利用了。 具有极高的性能价格比,和传统的大型主机相比,具有很大的价格优势; 1.4 Linux高性能集群系统 当论及Linux高性能集群时,许多人的第一反映就是Beowulf。起初,Beowulf只是一个著名的科学计算集群系统。以后的很多集群都采用Beowulf类似的架构,所以,实际上,现在Beowulf已经成为一类广为接受的高性能集群的类型。尽管名称各异,很多集群系统都是Beowulf集群的衍生物。当然也存在有别于Beowulf的集群系统,COW和Mosix就是另两类著名的集群系统。 1.4.1 Beowulf集群 简单的说,Beowulf是一种能够将多台计算机用于并行计算的体系结构。通常Beowulf系统由通过以太网或其他网络连接的多个计算节点和管理节点构成。管理节点控制整个集群系统,同时为计算节点提供文件服务和对外的网络连接。它使用的是常见的硬件设备,象普通PC、以太网卡和集线器。它很少使用特别定制的硬件和特殊的设备。Beowulf集群的软件也是随处可见的,象Linux、PVM和MPI。 1.4.2 COW集群 象Beowulf一样,COW(Cluster Of Workstation)也是由最常见的硬件设备和软件系统搭建而成。通常也是由一个控制节点和多个计算节点构成。

附件1 “高性能计算”重点专项2016年度 项目申报指南 依据《国家中长期科学和技术发展规划纲要(2006—2020年)》,科技部会同有关部门组织开展了《高性能计算重点专项实施方案》编制工作,在此基础上启动“高性能计算”重点专项2016年度项目,并发布本指南。 本专项总体目标是:在E级计算机的体系结构,新型处理器结构、高速互连网络、整机基础架构、软件环境、面向应用的协同设计、大规模系统管控与容错等核心技术方面取得突破,依托自主可控技术,研制适应应用需求的E级(百亿亿次左右)高性能计算机系统,使我国高性能计算机的性能在“十三五”末期保持世界领先水平。研发一批重大关键领域/行业的高性能计算应用 精品资料

软件,建立适应不同行业的2—3个高性能计算应用软件中心,构建可持续发展的高性能计算应用生态环境。配合E级计算机和应用软件研发,探索新型高性能计算服务的可持续发展机制,创新组织管理与运营模式,建立具有世界一流资源能力和服务水平的国家高性能计算环境,在我国科学研究和经济与社会发展中发挥重要作用,并通过国家高性能计算环境所取得的经验,促进我国计算服务业的产生和成长。 本专项围绕E级高性能计算机系统研制、高性能计算应用软件研发、高性能计算环境研发等三个创新链(技术方向)部署20个重点研究任务,专项实施周期为5年,即2016年—2020年。 按照分步实施、重点突出原则,2016年启动项目的主要研究内容包括:E级计算机总体技术及评测技术与系统,高性能应用软件研发与推广应用机制,重大行业高性能数值装置和应用软件,E级高性能应用软件编程框架及应用示范,国家高性能计算环境服务化机制与支撑体系,基于国家高性能计算环境的服务系统等 —2—

中国科学院国家天文台高性能计算集群使用及付费协议 甲方(项目/课题名称): 乙方:国家天文台信息与计算中心 经友好协商,乙方向甲方提供高性能计算机计算服务,签订本协议。一. 项目说明及所需计算资源情况 项目/课题简介:(项目来源、名称、研究内容、手段,及计算方法) 项目/课题类别 科学研究( ) 数据处理( ) 应用软件 自行开发( ) 名称: 商业软件( ) 名称: 计算资源需求 使用时间 20 年 月 日 至 20 年 月 日 集群名称 深腾6800 使用帐号 CPU数(颗) 计算核心数(个) 内存总量(G) 单节点内存量(G) 计算节点个数 8G内存节点( ) 个 16G内存节点 ( ) 个 计算节点名 机时总量 (CPU小时) 技术支持 需求情况 操作系统( ) 远程环境( ) 并行开发( ) 应用软件使用( )

详细说明: 甲方使用乙方提供的计算机资源,需要支付相应的机时费用,付款方式及协议金额如下: 付费方式预付费()后付费()计费方式0.5元/CPU小时 支付方式 内部转账( )汇款( ) 付费金额 (元/CPU小时) 付费约定 可供选择的付费方式有:①预付费;②后付费; 针对预付费:一次性购入或定期续费。 针对后付费:机时用完后5个工作日内付清款额。 注:国台内部课题组,收取费用?%以发展基金的形式返还课题。 二.权利和义务 1.甲方权利和义务 (1)甲方不得利用乙方提供的计算资源从事与其申请计算内容无关的计算活动,不得从事危害国家安全和其它违反中华人民共和国有关法律法规 的活动。 (2)甲方不得恶意耗费乙方计算资源与网络流量;否则乙方有权单独解除协议,不退回相关费用,由此造成的经济损失及法律责任一律由甲方承担。(3)甲方不得盗用计算主机超级用户、其他用户帐号、资料,否则应承担由此造成的一切经济损失及法律责任。 (4)甲方保证不进行影响主机正常运行的操作,如果发生上述操作,乙方有权终止甲方操作。 (5)甲方不得使用依据本协议租赁所获得的计算资源进行转租等不在本协议约定范围内的业务。否则,乙方有权随时收回为甲方提供的计算资源, 由此造成的经济损失和法律责任均由甲方承担。

高性能计算云平台 解决方案

目录 1概述 (3) 1.1建设背景 (3) 1.2设计范围 (3) 1.3总体设计原则 (3) 2系统平台设计 (4) 2.1项目需求 (4) 2.2设计思想 (5) 2.3云存储系统方案 (6) 2.4系统优势和特点 (6) 2.5作业调度系统方案 (8) 3系统架构 (9) 3.1cStor系统基本组成 (9) 3.2cStor系统功能描述 (10) 3.3Jobkeeper系统基本组成 (17) 4系统安全性设计 (20) 4.1安全保障体系框架 (20) 4.2云计算平台的多级信任保护 (21) 4.3基于多级信任保护的访问控制 (25) 4.4云平台安全审计 (28) 5工作机制 (31) 5.1数据写入机制 (31) 5.2数据读出机制 (32) 6关键技术 (33) 6.1负载自动均衡技术 (33) 6.2高速并发访问技术 (33) 6.3高可靠性保证技术 (33) 6.4高可用技术 (34) 6.5故障恢复技术 (34) 7接口描述 (35) 7.1POSIX通用文件系统接口访问 (35) 7.2应用程序API接口调用 (35) 8本地容错与诊断技术 (36) 8.1 cStor高可靠性 (36) 8.2 cStor数据完整性 (36) 8.3 cStor快照技术 (37) 8.4 Jopkeeper故障处理技术 (37) 9异地容灾与恢复技术 (39) 9.1cStor数据备份与恢复系统功能 (39) 9.2cStor异地文件恢复 (40)

1概述 1.1建设背景 云存储平台与作业调度为本次高性能计算总体解决方案的一部分。主要针对海量的数据的集中存储、共享、计算与挖掘,建立一套具有高可靠、可在线弹性伸缩,满足高吞吐量并发访问需求的云存储与计算平台。为数据存储和高效计算提供便捷、统一管理和高效应用的基础平台支撑。 1.2设计范围 本技术解决方案针对海量数据集中存储、共享与计算,提供从系统软硬件技术架构、原理、硬件选型、网络接入以及软件与应用之间的接口等方面的全面设计阐述。 1.3总体设计原则 针对本次工程的实际情况,充分考虑系统建设的建设发展需求,以实现系统统一管理、高效应用、平滑扩展为目标,以“先进、安全、成熟、开放、经济”为总体设计原则。 1.3.1先进性原则 在系统总体方案设计时采用业界先进的方案和技术,以确保一定时间内不落后。选择实用性强产品,模块化结构设计,既可满足当前的需要又可实现今后系统发展平滑扩展。 1.3.2安全性原则 数据是业务系统核心应用的最终保障,不但要保证整套系统能够7X24运行,而且存储系统必须有高可用性,以保证应用系统对数据的随时存取。同时配置安全的备份系统,对应用数据进行更加安全的数据保护,降低人为操作失误或病毒袭击给系统造成的数据丢失。 在进行系统设计时,充分考虑数据高可靠存储,采用高度可靠的软硬件容错设计,进行有效的安全访问控制,实现故障屏蔽、自动冗余重建等智能化安全可靠措施,提供

高性能计算集群项目采购需求 以下所有指标均为本项目所需设备的最小要求指标,供应商提供的产品应至少大于或等于所提出的指标。系统整体为“交钥匙”工程,厂商需确保应标方案的完备性。 投标商在投标方案中须明确项目总价和设备分项报价。数量大于“1”的同类设备,如刀片计算节点,须明确每节点单价。 硬件集成度本项目是我校校级高算平台的组成部分,供应商提供的硬件及配件要求必须与现有相关硬件设备配套。相关系统集成工作由供应商负责完成。 刀片机箱供应商根据系统结构和刀片节点数量配置,要求电源模块满配,并提供足够的冗余。配置管理模块,支持基于网络的远程管理。配置交换模块,对外提供4个千兆以太网接口,2个外部万兆上行端口,配置相应数量的56Gb InfiniBand接口 刀片计算节点双路通用刀片计算节点60个,单节点配置2个CPU,Intel Xeon E5-2690v4(2.6GHz/14c);不少于8个内存插槽,内存64GB,主频≥2400;硬盘裸容量不小于200GB,提供企业级SAS或SSD 硬盘;每节点配置≥2个千兆以太网接口,1个56Gb InfiniBand 接口;满配冗余电源及风扇。 刀片计算节点(大内存)双路通用刀片计算节点5个,单节点配置2个CPU,Intel Xeon E5-2690v4;不少于8个内存插槽,内存128GB,主频≥2400;硬盘裸容量不小于200GB,提供企业级SAS或SSD硬盘;每节点配置≥2个千兆以太网接口,1个56Gb InfiniBand接口;满配冗余电源及风扇。 GPU节点2个双路机架GPU节点;每个节点2个Intel Xeon E5-2667 v4每节点2块NVIDIA Tesla K80GPU加速卡;采用DDR4 2400MHz ECC内存,每节点内存16GB*8=128GB;每节点SSD 或SAS硬盘≥300GB;每节点配置≥2个千兆以太网接口,1个56Gb/s InfiniBand接口;满配冗余电源及风扇。 数据存储节点机架式服务器2台,单台配置2颗Intel Xeon E5-2600v4系列CPU;配置32GB内存,最大支持192GB;配置300GB 2.5" 10Krpm

精心整理 云计算与大数据基础知识 一、云计算是什么? 云计算就是统一部署的程序、统一存储并由相关程序统一管理着的数据! 云计算cloudcomputing是一种基于因特网的超级计算模式,在远程的数据中心里,成千上万台电脑和服务器连接成一片电脑云。因此,云计算甚至可以让你体验每秒超过10万亿次的运算能力,拥有这么强大的计算能力可以模拟核爆炸、预测气候变化和市场发展趋势。用户通过电脑、笔记本、手机等方式接入数据中心,按自己的需求进行运算。 二、 三、 1 );软件2 任一资源节点异常宕机,都不会导致云环境中的各类业务的中断,也不会导致用户数据的丢失。这里的资源节点可以是计算节点、存储节点和网络节点。而资源动态流转,则意味着在云计算平台下实现资源调度机制,资源可以流转到需要的地方。如在系统业务整体升高情况下,可以启动闲置资源,纳入系统中,提高整个云平台的承载能力。而在整个系统业务负载低的情况下,则可以将业务集中起来,而将其他闲置的资源转入节能模式,从而在提高部分资源利用率的情况下,达到其他资源绿色、低碳的应用效果。 3、支持异构多业务体系 在云计算平台上,可以同时运行多个不同类型的业务。异构,表示该业务不是同一的,不是已有的或事先定义好的,而应该是用户可以自己创建并定义的服务。这也是云计算与网格计算的一个重要差异。 4、支持海量信息处理 云计算,在底层,需要面对各类众多的基础软硬件资源;在上层,需要能够同时支持各类众多的异构的业务;

而具体到某一业务,往往也需要面对大量的用户。由此,云计算必然需要面对海量信息交互,需要有高效、稳定的海量数据通信/存储系统作支撑。 5、按需分配,按量计费 按需分配,是云计算平台支持资源动态流转的外部特征表现。云计算平台通过虚拟分拆技术,可以实现计算资源的同构化和可度量化,可以提供小到一台计算机,多到千台计算机的计算能力。按量计费起源于效用计算,在云计算平台实现按需分配后,按量计费也成为云计算平台向外提供服务时的有效收费形式。 四、云计算按运营模式分类 1、公有云 公有云通常指第三方提供商为用户提供的能够使用的云,公有云一般可通过Internet使用,可能是免费或成本低廉的。 烦。B 2 3 五、 六、 1、传统的IT部署架构是“烟囱式”的,或者叫做“专机专用”系统。 图2传统IT基础架构 这种部署模式主要存在的问题有以下两点: 硬件高配低用。考虑到应用系统未来3~5年的业务发展,以及业务突发的需求,为满足应用系统的性能、容量承载需求,往往在选择计算、存储和网络等硬件设备的配置时会留有一定比例的余量。但硬件资源上线后,应用系统在一定时间内的负载并不会太高,使得较高配置的硬件设备利用率不高。 整合困难。用户在实际使用中也注意到了资源利用率不高的情形,当需要上线新的应用系统时,会优先考虑部署在既有的基础架构上。但因为不同的应用系统所需的运行环境、对资源的抢占会有很大的差异,更重要的是考虑到可靠性、稳定性、运维管理问题,将新、旧应用系统整合在一套基础架构上的难度非常大,更多的用户往往选择新增与应用系统配套的计算、存储和网络等硬件设备。

AA大学高性能计算校级公共平台技术服务合同 项目名称: 委托方(甲方): 受托方(乙方): 签订时间:年月日 签订地点: 有效期限:年月日至年月日 AA大学高性能计算校级公共平台印制 年月日

技术服务合同 委托方(以下简称甲方): 所在地址: 法定代表人或负责人: 联系人: 联系电话: 通讯地址:邮编: 受托方(以下简称乙方): 所在地址: 法定代表人或负责人: 联系人: 联系电话: 通讯地址:邮编: 甲、乙双方就乙方向甲方提供高性能计算服务的各项事宜,依照中华人民共和国相关法律法规及工作规范,本着平等互利的原则,签订协议如下: 第一条甲方委托乙方进行技术服务的内容如下: (1)技术服务的目标:乙方为甲方开展“”所需的大规模科学计算应用提供高性能计算服务和相应的系统软硬件服务。 (2)技术服务的内容: 在合同有效期内,乙方为甲方提供CPU核的计算资源,收费方式为节点共享包年/节点独享包年/标准机时费,同时乙方为甲方提供软硬件方面的支持技术服务,帮助甲方顺利开展相关的科研工作。

在合同有效期间,乙方为甲方提供T的存储资源,供甲方使用。 (3)技术服务的方式:根据甲方测试计划和计算机资源要求,乙方在AA大学高性能计算校级公共平台上指定相应的资源,并安排相应技术人员提供计算机系统技术支持,配合甲方技术人员完成应用软件的安装调试运行,保障顺利开展大规模科学计算工作。 第二条甲方在合同履行期间具有以下的义务和权利: (一)甲方的义务 1、甲方需根据AA大学高性能计算校级公共平台的相关管理条例使用乙方提供的计算资源; 2、甲方在平台使用过程中,需保存好自己的账号密码,确保账号不被他人使用; 3、计算平台自身具有不稳定性,甲方须自行备份重要的数据及其相关文件; 4、甲方在使用乙方提供的AA大学高性能计算校级公共平台的过程中,如遇到高性能计算平台软硬件方面的技术问题,甲方有义务向乙方报告,并书面记录发生问题、报错信息等说明,以帮助乙方改善系统; 5、甲方需根据使用乙方提供的计算资源情况,向乙方支付相关的服务 (平台管理、计算资源、存储)费用; 6、甲方利用乙方的软硬件资源所取得成果,在研究成果发布时甲方要在论文中注明“本研究工作得到AA大学高性能计算校级公共平台支持”(Supported by High-performance Computing Platform of Peking University)。 (二)甲方的权利 1、甲方根据项目需求利用乙方提供的计算资源完成相关计算工作; 2、甲方有权要求乙方及时提供相关技术支持服务和使用的相关咨询; 3、甲方就利用乙方高性能计算平台取得的科研成果具有决定权。 第三条乙方在合同执行期间具有以下的权利与义务: (一)乙方的义务

“云服务平台”合作协议 甲方: 乙方: #########技术有限公司(以下简称“甲方”)与########科技有限公司(以下简称“乙方”)本着优势互补、平等互利、合作共赢的原则,签订本协议。 一、合作背景 #######技术有限公司借助多年在高性能计算、服务器、存储、安全等方面的经验,在云服务器、云存储、云安全、云操作系统、云应用支撑平台、云中间件聚合平台等方面有深厚的积累技术积累和完整的解决方案,为用户提供计算平台服务。 ########科技有限公司作为国内领先的虚拟桌面厂商,拥有完全自主知识产权,为各行业提供云计算桌面虚拟化解决方案,满足各行业领域用户对虚拟化的多方位需求。伸得纬领先的虚拟化技术与成熟的桌面云办公解决方案,在同等服务器设备下,支持的并发虚拟桌面用户数量可达其他国际虚拟化大厂的十倍,是全球唯一能以低成本运营大规模全功能云平台的虚拟化厂商。 二、合作宗旨 1、双方在合作中建立的互信、惯例与默契是商业合作战略伙伴关系的基础,提高效率与共 同发展是双方合作的目标和根本利益。 2、本协议的基本原则是自愿、双赢、互惠互利、相互促进、共同发展、保守秘密、保护协 作市场。 3、充分发挥双方优势,优势互补,提高竞争力,共同进行市场开拓。 4、本协议为框架协议,应是双方今后长期合作的指导性文件,也是双方签订相关合同的基 础。 三、合作内容与合作方式 1、甲乙双方结合各自优势展开合作,实现互惠互利目的。 2、乙方ShadoWin桌面云企业版产品和服务模式纳入到甲方“中小企业科技园区云服务平 台”的总体方案中,利用甲方的渠道进行推广。 3、合作项目规模:个终端用户 4、合作项目规划:项目预计分期进行实施 2019年月日之前,甲方协助乙方完成个终端用户的部署和云桌面平台基础建设; 2019年月日之前,甲方协助乙方完成个终端用户的部署…… 5、2019年月日之前,甲方协助乙方完成个终端用户的部署……甲乙双方共同开

https://www.doczj.com/doc/8a9471078.html,/sige_online/blog/item/d6aa74a9106a10ff1f17a224.html 和卫星遥测,遥感等探矿技术的发展,促使油气勘探的数据量爆炸性地增长, 要求信息系统能够获取,存储和处理TB级的巨量数据; 使用更精确的模型:为了提高探矿水平,必须使用规模更大,更精确数值模型来模拟地下矿藏的分布.5年前,模型的节点数一般不超过10万个;现在,经常需要使用节点数超过百万的3维模型来进行数值模拟; 提供更强的计算和数据管理能力:模型规模的扩大要求使用处理能力指数增长的计算机系统和更复杂的算法快速和精确地求解,同时也要求更强的数据管理能力来建立历史数据库,并把当前数据与长期积累的历史数据相比较,得到精确的综合预测结果; 支持功能丰富的应用软件:现代的油气探测应用软件必须具有直观的3维图象显示和输出,人机交互功能, 以提高工作效率; 降低成本:经济效益和市场竞争压力还迫使油气行业的信息系统在严格控制开支,降低总拥有成本条件下满足上述要求当前,传统的巨型机已经很难全面满足上述要求.油气行业要求使用更经济实惠的新解决方案来全面满足应用需求.Schluberger信息系统公司(SIS)是油气勘探信息处理领域中领先的厂商,也是HP在高性能技术计算领域重要的合作伙伴.该公司在使用基于安腾2的HP Integrity 服务器为计算节点的Linux集群上开发的面向油气矿藏模拟的ECLIPSE Parallel解决方案,能够全面满足油气矿藏勘探信息系统在性能和成本两方面的需求,提供解决人类社会现代化进程中能源问题的利器. 目标市场 ECLIPSE Parallel解决方案使用数值模拟方法满足油气行业探测石油和天然气地下分布状况和预测储量的需要, 油气公司从低级经理到高级主管各种类型的人员都可以得益于这一解决方案,包括:负责提供优化的矿藏分布和产量预测评估人员和经济分析师,负责作出开采决策的经理,信息系统管理人员;需要得到直观和实时矿藏信息的首席信息官(CIO)和首席执行官(CEO),负责监管的政府机构等等. 这一解决方案特别适合于要求打破油气行业使用巨型机传统,采用性能更高,价格/性能最佳的新颖解决方案的油气公司. 解决方案概貌 SIS ECLIPSE Parallel是一个基于英特尔和HP工业标准技术的成套解决方案,便于实施和灵活配置,提供先进的油气矿藏模拟功能.这一解决方案由系统平台和模拟软件两大部分组成(见下图). HP Linux ClusterBlocks集群系统是第一个经过认证的系统平台.这一Linux集群包括如下的层次: 计算节点:采用基于安腾2的HP Integrity rx2600服务器,使用新一代安腾2提供强大的64位处理能力; 互联设备:采用工业标准的高速Myrinet把计算节点联成一体,以太网联接管理节点; 操作环境:采用应用最广泛的RedHat Linux Advanced Server操作系统建立集群运行的操作环境; 集群管理和作业调度:采用Scali, Scyld或ClusterWare 公司著名的Linux工具软件管理集群系统;采用业界领先的Platform Computing的LSF 5.0软件来实现负载平衡,提高集群的工作效率上层的ECLIPSE Parallel模拟软件负责完成矿藏模拟的数值计算,它把整个数值求解问题分解成一系列较小的子问题,送到各个计算节点上并行地求解,然后再合成完整的结果. ECLIPSE Parallel解决方案这一基于Linux集群并行计算的设计思想,在性能,性价比,可伸缩性和可用性等方面都超过基于巨型机的传统解决方案,具有广阔的发展前途. 组成部件 SIS ECLIPSE Parallel软件与HP ClusterBlocks 集群结合在一起形成了一个把最先进硬件和软件完美地结合在一起的油气储藏模拟解决方案,它的主要组成部件有: 基于安腾2处理器的HP Integrity rx2600服务器; 工厂组装的基于Myrinet高速互联网络的16-128节点 Linux集群系统; RedHat Linux Advanced Server 2.1操作系统; Platform Computing的负载调度软件(LSF) 5.0:用于平衡集群内各节点的工作负载,提供运行效率; 消息传递接口(MPICH/GM):用于支持基于集群架构系统内的并行计算; 集群管理软件:允许采用Scali, Scyld, ClusterWareLinux 等公司的软件管理集群系统运行和资源共享; SIS ECLIPSE Parallel 油气储藏模拟软件 SIS ECLIPSE Parallel解决方案的硬件系统使用HP Integrity rx2600服务器作为计算节点,高速的Myrinet作为互联设备组成Linux集群,为油气储藏模拟软件提供高性能运行平台. ECLIPSE Parallel软件把整个模拟模型分解成若干个子区域.

CAE对高性能计算平台的选择 高性能计算(HPC)正逐步进入制造行业,承担诸多关键的计算应用。该领域中用户主要分成两类,一类是实际制造企业,如汽车设计制造厂商、航空工业企业、电力企业及消费产品生产商等。这一类用户通过高性能计算技术来提高产品的性能,减低成本,同时缩短产品的设计、生产周期,以使企业在市场上更具竞争力,另一类是研发单位,如政府、国防和大学中涉及制造行业的部门或专业。这一类用户的目标是利用高性能计算技术改善设计方法,提高设计水平从而为实际生产服务。 下图给出了制造行业中采用计算机进行产品开发的流程,包括建模、前处理(模型修改和网格生成)、计算分析、交叉学科综合及后处理几个部分。其中高性能计算主要应用于计算分析部分,统称为计算机辅助工程(CAE)。 制造行业CAE应用程序的特点 制造行业CAE的应用可以分为隐式有限元分析(IFEA)、显式有限元分析(EFEA)和计算流体动力学(CFD)三个子学科。几乎所有的制造企业的高性能计算都依赖于独立软件开发商(ISV)提供的商业软件,只有计算流体动力学中结构网格计算类型的部分软件是

用户自己开发的。因此制造行业中的用户在购买硬件平台的同时通常会购买相应的科学计算软件产品。而在某种程度上,往往是应用软件的特性决定了硬件平台的选择。 下表中给出了CAE常用的应用软件,并列出这些软件的特点,包括并行方式和可扩展性。 从上表中我们可以了解到CAE应用软件具有以下特点: 特点1:IFEA类应用软件(如ABAQUS, ANSYS和MSC Nastran)的可扩展性不是很好。当使用超过8个CPU来处理一个任务时,通常不会再有性能上的提升; 特点2:IFEA类应用软件通常使用共享内存方式(pthreads或OpenMP)进行并行处理,其中ABAQUS不支持消息传递方式(MPI)的并行; 特点3:EFEA类应用软件(如LS-DYNA, PAM-CRASH和RADIOSS)和计算流体动力学软件(如FLUENT, STAR-CD和PowerFlow)的扩展性相对较好; 特点4:EFEA类应用软件和CFD软件以采用消息传递并行方式(MPI)为主。 高性能计算(HPC)服务器体系结构分类及特点 目前市场上常用的高性能计算服务器大致可以分为以下3种体系结构,即: 并行向量处理机(PVP): PVP系统含有为数不多、功能强大的定制向量处理器(VP),定制的高带宽纵横交叉开关及高速的数据访问。由于这类系统对程序编制的要求较高,价格很昂贵且难于管理,因此,这种类型计算机主要集中在一些大型国家关键部门,在本文中不再赘述。 对称多处理机(SMP):

哈尔滨工业大学高性能计算服务收费方案(试行) 一、收费标准 哈尔滨工业大学高性能计算中心具备每秒万亿次以上的计算峰值,计算机集群系统投入大、运行和维护费用高,拟对使用高性能计算的校内外用户进行有偿服务,收费标准如下: ●帐号管理费:校内用户1000元/帐号;校外用户2000元/帐号; ●付费排队方式:校内用户0.5元/CPU核小时;校外用户1元/CPU核小 时 ●付费独占方式:校内用户40元/节点/天;校外用户80元/节点/天。根据 用户需要进行资源配置,无需排队。 *付费排队用户的程序运行时间按Walltime统计为标准,Walltime=(作业结束时间-作业开始时间) CPU核占用数量 条款说明: 1.本平台严禁用于涉密科研项目使用; 2.受停电、设备故障等因素影响的作业机时不计费; 3.付费排队用户使用的最大核数不超过32个; 4.缴费方式:付费排队用户根据计算需求预存一定费用,以100小时为最小单 位,若预缴费用不足时,须在计算完毕15天内补交;若预缴费用有剩余时,可保留至下次计算时使用,注销账号时可申请退还剩余费用; 5.用户项目完成后或因某些特殊原因需停止使用时,可以按实际使用的CPU 核小时数进行结算;

6.在帐号有效期内,为付费排队用户提供50G,付费独占方式用户提供100G 免费存储空间,超出部分按照具体情况收取费用; 7.用户计算结果最长保存时间为20天; 8.用户提交的作业,应服从系统管理员的调度、管理。 二、经费用途 机器运行所收费用主要用于补充维持机器正常运行所需经费的不足,如水电费、设备维护费、机房条件保障所需费用、引进新软件、以及软件升级等。 三、激励政策 1.注重社会效益,优先保证对高性能计算需求迫切的用户使用,特别是冲击国 际前沿水平的、涉及重大基础理论研究或涉及国民经济重大应用的国家级课题。 2.为了满足部分院系、研究所、研究中心及国家重大科研项目组和国际合作项 目组对高性能计算资源的需求,经“哈工大高性能计算平台专家组”评议以及高性能计算中心审批,可申请专用计算资源,申请的计算资源一般不超过本系统总计算资源的20%。 3.免费提供必要的技术支持和相应服务。 4.对于有合作研发和编程需求的用户(包括程序移植、优化、并行工作),将视 成果预期和可能,酌情而定,并采取有偿服务方式。 本《收取方案》的解释权属哈尔滨工业大学高性能计算中心,并将在实施过程中不断完善。

云计算平台 技术服务合同 甲方: 乙方:上海交通大学网络信息中心 签订地点:上海市闵行区 签订日期:年月日

(以下简称“甲方”) 上海交通大学网络信息中心(以下简称“乙方”) 甲乙双方依据《中华人民共和国合同法》的相关规定,经双方协商达成一致,就云计算平台技术服务事宜,特授权双方代表签订本合同,以期共同遵照履行。 一、合同内容 1.甲方因自身业务需求,同意租用乙方云计算平台软硬件资源及配套技术支 持服务。 2.乙方将根据合同约定,为甲方提供云计算平台软硬件资源及配套技术支持 服务。 3.甲方向乙方预付费用,获得乙方提供的云计算平台上等值云计算资源的使 用权利。 4.签署本合同后将视为甲乙双方均同意本合同中的内容和约定,同时同意 《上海交通大学云平台服务协议》。 5.甲方权利与义务 1)甲方可通过网络远程登录并使用乙方提供的云计算平台服务。 2)甲方需遵守《中华人民共和国计算机信息网络国际联网管理暂行规 定》。 3)甲方需遵守《上海交通大学用户入网安全责任书》。 6.乙方权利与义务 1)乙方为甲方提供云计算平台服务。 2)乙方在收到甲方支付的费用后,为甲方开通云计算账号,并解决甲方在

使用云计算平台服务过程中遇到的基本问题。 3)当甲方违反约定义务,乙方有权关闭甲方账号以及相应软硬件资源使用 权利。 4)当本合同中止后,乙方有权关闭甲方账号以及相应软硬件资源使用权 利。 5)当甲方预付费用使用完且未再续费,乙方有权关闭甲方账号以及相应软 硬件资源使用权利。 6)关闭账号90个工作日后,乙方有权删除甲方放在云计算平台上的所有 资源和数据。 7.以下情况乙方将不对甲方的行为负有责任 1)由于甲方密码告知他人或未保管好自己的密码或与他人共享账户或任 何其他非交大云的过错,导致甲方的个人资料泄露; 2)任何由于黑客攻击、计算机病毒侵入或发作、电信部门技术调整导致 之影响、因政府管制而造成的暂时性关闭、由于第三方原因(包括不可 抗力,例如国际出口的主干线路及国际出口电信提供商一方出现故障、 火灾、水灾、雷击、地震、洪水、台风、龙卷风、火山爆发、瘟疫和 传染病流行、罢工、战争或暴力行为或类似事件等)及其他非因交大云 过错而造成的甲方认证信息泄露、丢失、被盗用或被篡改等; 3)如有第三方基于甲方侵犯版权、侵犯第三人之权益或违反中国法律法 规或其他适用的法律等原因而向交大云提起索赔、诉讼或可能向其提 起诉讼, 则甲方应赔偿交大云因此承担的费用或损失,并使交大云完 全免责。 二、租用价格及支付方式

1.背景: 云计算的优势 共享的计算设备 多租户的使用模型 可高度适配的资源分配 按需定制的HPC环境开始流行 2.挑战 虚拟化的开销 CPU, 内存, 驱动等 通信网络的区别 万兆以太网vs. Infiniband 并行IO的配置选项 设备, 文件系统和IO库的选择 3.CCI: Amazon的HPC解决方案 4. 虚拟化对HPC的影响 虚拟设备和物理设备有巨大的性能差别 虚拟机并没有引入很大的开销 对于直接分配给客户机的千兆网卡结论如此, 我们正在研究万兆网卡和IB 网卡的性能结果 5. 性能评价——结论 本地集群在通信上有巨大优势 对于CPU和内存密集型程序,CCI的性能和本地集群相似 究竟使用云还是本地集群,需要研究二者的性价比 6. I/O系统的可配置性:背景 I/O是很多高性能应用程序的性能瓶颈 应用程序的读写密集和并发度差别较大 传统高性能平台只提供通用的、统一的I/O系统 一些高性能程序开始考虑向云计算平台迁移 云计算平台可以带来I/O系统的高可配性 完全受控的虚拟机环境,自定义配置成为可能

弹性的资源申请和方便的部署方式 可选多种存储资源进行搭配 I/O系统的可配置性在于 可以在虚拟集群上选择不同的文件系统 可以利用多种底层存储设备进行组合 可以充分调节文件系统参数,专门为特定的某一个高性能应用程序进行配置 I/O系统可配置性的挑战 最优配置需要根据不同应用程序进行选择 需要平衡性能和总成本 7. I/O系统的可配置性:文件系统 网络文件系统(NFS) 使用简单,只有POSIX系统调用接口 对I/O需求较低的应用程序已经足够 存在单点瓶颈,扩展性差 并行文件系统(如PVFS) MPI-IO接口,对并行读写支持良好 可以使用更多的IO节点,扩展性好 8. I/O系统的可配置性:存储设备、 单实例临时存储设备(Ephemeral) 块设备,每节点2*800 GB, 非持久化存储 弹性块设备(EBS) 每个实例可挂载任意多块,可跨实例挂载 持久化,生命期与虚拟机实例无关 云端数据库存储服务(S3) 键值存储,面向数据库和互联网应用 9. I/O系统的可配置性:文件系统参数 10. I/O系统的可配置性:结论 针对不同的HPC应用配置I/O系统很有必要 不同HPC应用对I/O的需求不一样 性能和价格需要折中 I/O配置的挑战

随着计算机应用的广泛深入,不同领域处理问题的规模也越来越大,对计算速度的追求也在不断增长。例如,在气象预报、流体力学、能源工程、生物制药、图像处理等领域的问题都涉及到海量的计算数据,并且计算必须在能接收的时间内完成。所以,如何在短时间内完成计算任务,提高并行计算的效率已经成为这些领域要解决的问题。 商用CAE软件现在发展的非常之迅速,而且都致力于软件的并行化开发。目前,市场上的通用CAE软件都实现了集群中的并行运行,而且效果都非常良好。以ANSYS为例,作为目前最常用的有限元求解软件之一,它的求解模块种类多,多物理场实现耦合求解以及实现协同仿真技术等优点受到广大用户的欢迎。因此,通用CAE已经成为今后工程计算领域的重要工具。 1 CAE通用软件的发展 20世纪在50年代末、60年代初就投入大量的人力和物理开发具有强大功能的有限元分析程序。其中最为著名的是由美国国家宇航局在1965年委托美国计算科学公司和贝尔航空系统公司开发的NASTRAN有限元分析系统。此后有德国的ASKA、英国的PAFEC等公司的产品。 CAE在工程上初步开始使用一直到今天,已经经历了50多年的发展历史,其理论和算法都经历了从蓬勃发展到日趋成熟的过程。在航天、航空、机械、土木机构等领域的工程和产品结构分析中已经成为必不可少的数值计算工具,同时也是分析连续力学各类问题的一种重要手段。随着计算机技术的普及和不断提高,CAE系统的功能和计算精度都有很大提高,

各种基于产品数字建模的CAE系统应运而生,并已成为结构分析和结构优化的重要工具,同时也是计算机辅助4C系统(CAD/CAE/CAPP/CAM)的重要环节。CAE系统的核心思想是结构的离散化,即将实际结构离散为有限数目的规则单元组合体,实际结构的物理性能可以通过对离散体进行分析,得出满足工程精度的近似结果来替代对实际结构的分析,这样可以解决很多实际工程需要解决而理论分析又无法解决的复杂问题。 正因为CAE在制造企业中承担着关键的工具的作用,所以其高性能平台的选择也非常的重要,这个平台直接影响CAE的运行性能表现、整体成本和系统等方面的问题。所以,高性能计算平台与CAE软件的如何更好的配合要进行一个全面的权衡。 2 CAE模拟的步骤 2.1 建立物理模型 在研究一项具体的问题的时候,首先必须要明确研究对象及其物理特性。确定出一个具有特定便捷的研究区域,分析的特征与特性。其次根据研究内容的特征,做出简化假定和近似,忽略非本质的物理过程来简化整个物理模型。从而得出一个经过简化,比较有研究特点的物理模型。 2.2 建立数学模型 物理模型确定以后就要建立相应的数学模型,也就是用数学模型来反映问题各量之间的