基于一种新的组合核函数的最小二乘支持向量机结构损伤检测的机器学习方法

- 格式:pdf

- 大小:2.24 MB

- 文档页数:16

基于支持向量机的结构损伤识别研究*福州大学土木工程学院吴思瑶姜绍飞傅大宝[摘要]支持向量机(SV M )是一种针对分类和回归问题的统计学习理论,能有效地解决模式识别中的分类问题。

该文提出了基于支持向量机的结构损伤识别方法:以归一的频率变化比(N F C R )和归一的损伤指标(N D SI )作为特征参数,训练支持向量机进行损伤识别。

用一个12层钢混框架有限元数值模型进行验证,同时分析了影响SV M 模型性能的主要因素。

结果表明,本文提出的方法具有较高的损伤识别能力,而核参数的选择对识别精度有较大影响。

[关键词]支持向量机损伤识别核函数参数选择近年来,建筑物使用性能的退化和各种灾害的频繁发生,使得对大型结构进行健康监测和安全性评估成为国内外研究的热点。

结构健康监测系统的研发虽然为之提供了保障,但是如何利用海量、不确定的数据,进而寻求有效的损伤识别方法仍是急需解决的难题。

由Vapnik 的统计学习理论[1]发展而来的支持向量机克服了人工神经网络的局限性且具有结构简单、推广能力好等优点,能够解决非线性、高维数问题,已被成功地应用于模式识别的众多领域,如交通异常诊断[2]、文本识别[3]、人脸检测[4]等。

基于此,本文提出了一种基于支持向量机的损伤识别方法,并用一个数值算例验证了所提方法的有效性,探讨了噪声、核函数及核参数的选择对SVM 模型性能的影响。

1基本原理支持向量机(SVM)[5]是一种针对分类和回归问题的统计学习理论,能有效解决模式识别中的分类问题。

通过在支持向量机中引入核函数,将输入空间的非线性可分的训练样本集映射到高维特征空间,再在其中求得最优分类面来分离训练样本点,可以有效解决非线性分类问题。

给定样本集,其中,x i R N,表示输入矢量;y i {+1,-1},表示对应的期望输出;m 为样本数。

通过非线性映射函数,将输入数据从原空间映射到高维特征空间,在高维特征空间中构造最优分类超平面为:1))(()(..0)()()(1b x w y x f y t s bx w bx w x f i i i i i i mi i (1)式中:w 为权值矢量,b 为偏置项,w 和b 确定了分类面的位置。

支持向量机算法的改进与应用调研支持向量机(Support Vector Machine,简称SVM)是一种常用的机器学习算法,广泛应用于分类和回归问题。

它的核心思想是将数据映射到高维空间中,寻找一个超平面,将不同类别的样本分开。

然而,随着机器学习领域的发展,研究人员不断提出改进和优化支持向量机算法的方法,以提高其性能和应用范围。

一方面,对支持向量机算法的改进主要集中在以下几个方面:1. 核函数的选择:支持向量机算法通过核函数将原始数据映射到高维特征空间中,使得数据更容易分离。

常用的核函数有线性核、多项式核和径向基核等。

然而,对于复杂的非线性问题,选择合适的核函数至关重要。

因此,研究人员提出了改进的核函数,如谱核函数和局部敏感核函数,以适应不同类型的数据和问题。

2. 正则化参数的调节:支持向量机算法中的正则化参数C用于平衡模型的拟合程度和泛化能力。

当C较小时,模型更倾向于选择更多的支持向量,更加关注较小的错误分类。

而当C较大时,模型更加关注分类的边界和较大的间隔。

然而,在实际应用中,如何选择合适的正则化参数C仍然是一个挑战。

因此,研究人员提出了改进的正则化方法,如自适应正则化和核函数相关性分析等,以提高模型的性能和鲁棒性。

3. 高效的算法实现:支持向量机算法的核心是求解最优超平面的问题,通常采用二次规划方法进行优化求解。

然而,对于大规模数据集和高维特征空间来说,传统的求解算法效率低下。

因此,研究人员提出了改进的算法实现,如序列最小优化算法和块坐标下降算法等,以提高模型的训练和预测速度。

另一方面,支持向量机算法在实践中有着广泛的应用。

以下是一些典型的应用领域:1. 文本分类:支持向量机算法在文本分类问题中有着广泛的应用。

通过将文字特征映射到高维空间中,支持向量机能够捕捉到文本中的关键信息,并对文本进行分类。

因此,支持向量机在垃圾邮件过滤、情感分析和文本检索等领域有着重要的应用。

2. 图像识别:支持向量机算法也被广泛应用于图像识别问题。

基于机器学习的结构损伤识别与评估技术研究随着科技的不断发展,建筑结构的损伤识别与评估变得越来越关键。

传统的损伤检测方法需要大量的人力和时间,而且结果可能不够精确。

然而,近年来,基于机器学习的结构损伤识别与评估技术逐渐成为了研究的热点。

本文将探讨基于机器学习的结构损伤识别与评估技术的原理和应用。

一、机器学习在结构损伤识别中的应用机器学习是一种人工智能的分支,它通过从数据中学习并建立模型,对未知数据进行预测和分类。

在结构损伤识别中,机器学习可以通过分析结构的振动特征,识别和评估结构的损伤情况。

以下是机器学习在结构损伤识别中的几种常见方法:1. 支持向量机(Support Vector Machine,SVM)支持向量机是一种监督学习方法,它通过寻找最佳的超平面,将不同类别的数据点分隔开。

在结构损伤识别中,SVM可以通过分析振动信号的特征参数,如频率和振幅,判断结构的损伤程度。

2. 随机森林(Random Forest)随机森林是一种集成学习方法,它通过构建多个决策树并综合它们的结果来进行预测。

在结构损伤识别中,随机森林可以通过分析结构的振动响应和频谱特征,判断结构的损伤位置和类型。

3. 深度学习(Deep Learning)深度学习是一种基于神经网络的机器学习方法,它模仿人脑神经元的工作方式,通过多层次的神经元网络来提取和学习数据的特征。

在结构损伤识别中,深度学习可以通过分析结构的振动信号和图片信息,实现对结构损伤的自动识别和评估。

二、基于机器学习的结构损伤识别与评估技术的优势基于机器学习的结构损伤识别与评估技术相比传统方法具有以下几个优势:1. 自动化:机器学习可以通过对大量数据的学习和分析,实现对结构损伤的自动识别和评估,大大减少了人力成本。

2. 高效性:机器学习算法可以快速处理大量的数据,并在短时间内给出准确的结果。

3. 精确性:机器学习可以通过建立合适的模型,从大量的数据中提取有用的特征,并实现对结构损伤的精确识别和评估。

第 43 卷第 6 期2023 年 12 月振动、测试与诊断Vol. 43 No. 6Dec.2023 Journal of Vibration,Measurement & Diagnosis基于DK‑SVDD的轮毂电机轴承状态识别方法∗李仲兴,郗少华,薛红涛,刘炳晨,朱方喜(江苏大学汽车与交通工程学院镇江,212013)摘要为了进一步提高电动汽车轮毂电机轴承状态识别技术的高效可靠性,提出一种基于双核支持向量数据描述(double kernel based support vector data description,简称DK⁃SVDD)的轮毂电机轴承状态识别方法。

首先,针对轮毂电机轴承样本数据结构混杂致使SVDD识别率较低问题,通过一定的比例权重将径向基(radial basis function,简称RBF)核函数和高斯差分(difference of Gaussians,简称DOG)核函数结合构建DK核函数;其次,根据最优二叉树原理逐层设计状态识别分类器,并搭建DK⁃SVDD轮毂电机轴承状态识别模型,同时使用粒子群优化算法对模型参数寻优以提高DK⁃SVDD的学习能力和泛化能力;最后,基于轮毂电机轴承台架试验数据,验证所提方法的有效性和优越性。

结果表明:针对轮毂电机轴承目标状态识别,DK⁃SVDD方法平均训练时间为0.065 5 s,平均状态识别率为97.06%;与采用RBF或DOG核函数相比,DK⁃SVDD方法在多种工况下可以有效提高状态识别率并降低训练时间。

关键词轮毂电机轴承;支持向量数据描述;DK核函数;双核支持向量数据描述;状态识别中图分类号TH17;U472.9引言随着国家大力推进“双碳”战略,新能源汽车成为更加绿色、环保及低碳的出行方式。

轮毂电机作为电动汽车主要驱动部件,具有结构紧凑、灵活布置和高效节能等优点。

电动汽车的行驶工况复杂多变,轮毂电机易受到来自路面的间歇性强冲击载荷[1]。

基于机器学习的创伤伤员检伤分类预测模型构建及验证张睿智;罗瑞虹;卢志林;李春平;卢兵;邢家溢;黎檀实【期刊名称】《解放军医学院学报》【年(卷),期】2024(45)3【摘要】背景创伤现场批量伤员的检伤分类是现场急救中的关键环节,探索如何更加高效准确地对伤员进行检伤分类具有重要意义。

目的基于生命体征数据和机器学习算法建立并验证创伤伤员检伤分类预测模型。

方法回顾性分析美国创伤数据库2017—2019年的院前急救创伤伤员数据,采用支持向量机(support vector machine,SVM)、随机森林(random forest,RF)、梯度提升决策树(gradient boosting decision tree,GBDT)、极端梯度提升(eXtreme gradient boosting,XGBoost)和多层感知机(multi-layer perceptron,MLP)5种机器学习算法开发创伤伤员检伤分类预测模型并验证。

采用准确率、精准度、召回率、F1值和AUC值(ROC曲线下面积)进行结果评价,使用ROC曲线进行可视化,并在解放军总医院第一医学中心急诊创伤数据集中对最优模型结果进行验证。

结果共选取伤员数据24948例,基于ISS分级标准分为轻伤9496例,中等伤9532例,重伤5496例,危重伤424例。

ROC曲线分析显示,相较于其他四种模型,GBDT算法预测上述ISS 分级的效能最好,准确率为82.63%,精确度为68.21%,召回率为60.92%,F1值为61.91%,AUC为90.38%。

在解放军总医院第一医学中心急诊创伤数据集中验证GBDT模型,准确率为83.15%,精确度为77.38%,召回率为59.89%,F1值为55.26%,AUC为90.38%。

结论本研究成功开发并验证了一组检伤分类机器学习预测模型,未来可应用于创伤伤员现场检伤分类辅助决策。

【总页数】7页(P223-229)【作者】张睿智;罗瑞虹;卢志林;李春平;卢兵;邢家溢;黎檀实【作者单位】解放军医学院;解放军总医院第一医学中心急诊医学科;清华大学软件学院【正文语种】中文【中图分类】R641【相关文献】1.扩展创伤超声重点评估在大批量伤员检伤分类中的研究进展2.一种便携式伤员体征监测与检伤分类掌上电脑系统的研发与验证3.基于机器学习糖尿病并发视网膜病变风险预测模型的构建及验证4.三种创伤评分对于芦山地震伤员在一线医院的院内检伤分类应用价值5.基于机器学习的养老床位需求预测模型构建与验证因版权原因,仅展示原文概要,查看原文内容请购买。

基于支持向量机的故障诊断方法研究近年来,基于机器学习的故障诊断方法已经成为了诊断领域的研究热点。

其中,支持向量机(Support Vector Machine, SVM)被广泛应用于故障诊断领域,并已经取得了不错的结果。

本文将对基于支持向量机的故障诊断方法进行研究,旨在探讨其优势和应用前景。

一、SVM的原理SVM是一种二分类模型,其目的是在特征空间中找到一个最优超平面,将不同类别的样本分开。

SVM的决策函数为:f(x)=sign(w·x+b)其中,w是法向量,b是偏置,x是特征向量,f(x)为预测值,sign(·)为符号函数。

SVM方法利用Kernel技巧将非线性问题转化为线性问题,进而解决二分类问题。

其核函数的选择在一定程度上决定了SVM的性能,不同的核函数适用于不同的数据分布。

二、基于SVM的故障诊断方法在故障诊断中,SVM主要应用于分类问题。

具体而言,将已知状态的数据分为正常数据和故障数据,通过训练建立分类模型。

其流程如下:(1)收集数据。

通过传感器、监控设备等手段,获取机器设备的运行参数,构成数据集。

(2)数据处理。

对数据进行预处理、特征提取等操作,建立特征向量。

(3)划分数据集。

将数据集划分为训练集和测试集,用训练集来训练模型,用测试集来测试模型的预测性能。

(4)模型训练。

利用SVM算法对训练集进行拟合,得到分类器。

(5)模型测试。

用测试集对分类器进行测试,评价模型的分类性能。

(6)模型优化。

在模型的训练和测试过程中,通过不断优化模型参数,提高模型的分类性能。

三、SVM在故障诊断中的优势(1)数据处理简单。

SVM对数据质量的要求不高,可以处理各种数据类型和数据分布,降低了对数据预处理的要求。

(2)分类性能强。

SVM可以非常有效地解决线性和非线性分类问题,且对噪声数据有较强的容错能力。

(3)适应小样本数据。

SVM对于数据量较小的情况下,仍然可以取得很好的分类效果。

(4)泛化能力强。

核偏最小二乘法核偏最小二乘法(KPLS)是一种经典的多元统计分析方法,在多个学科领域中被广泛使用。

本文将分步骤阐述KPLS的基本原理和实现流程。

一、KPLS是什么?KPLS是一种基于最小二乘回归的线性预测模型。

与普通的最小二乘回归相比,KPLS在回归预测过程中通过核函数将样本数据从原空间映射到高维特征空间,进而在新的特征空间中进行数据建模和预测。

KPLS的优势在于它可以用于处理非线性关系的数据,并且能够同时处理多个自变量和多个因变量之间的关系。

二、KPLS的基本原理1. 核函数KPLS使用的核函数是一种非线性函数,它将样本数据从原始空间映射到高维特征空间。

常用的核函数有径向基函数和多项式核函数等。

径向基函数的形式如下:K(xi,xj) = exp(-||xi-xj||^2/2σ^2)其中||xi-xj||表示向量xi和xj之间的欧几里得距离,σ表示一个控制局部图形的参数,它控制着核函数的光滑性。

2. KPLS模型的建立KPLS模型的建立分为两个步骤:训练模型和模型预测。

训练模型的过程是将样本数据通过核函数映射到新的高维特征空间中,进而捕捉自变量和因变量之间的非线性关系,使用PLS算法来对模型进行优化。

模型的预测过程是将测试数据通过核函数映射到新的特征空间中,并利用训练模型得到的权值和因子对其进行预测。

3. KPLS的优点及应用领域KPLS相较于普通的最小二乘回归以及一般的PLS方法具有更好的非线性建模能力。

它可以用于处理复杂的数据结构,包括光谱、化学反应等众多领域。

在生物医学领域中,KPLS被广泛用于预测蛋白质结构、药物毒理学研究等方面。

在化学领域中,KPLS用于预测物质的光谱响应、分子结构等方面。

三、KPLS的实现流程KPLS的实现需要以下步骤:1. 加载数据并划分数据集为训练集和测试集。

2. 选择核函数类型,并将训练集和测试集数据通过核函数映射到新的特征空间中。

3. 使用PLS算法对样本数据进行建模,得到权值和因子。

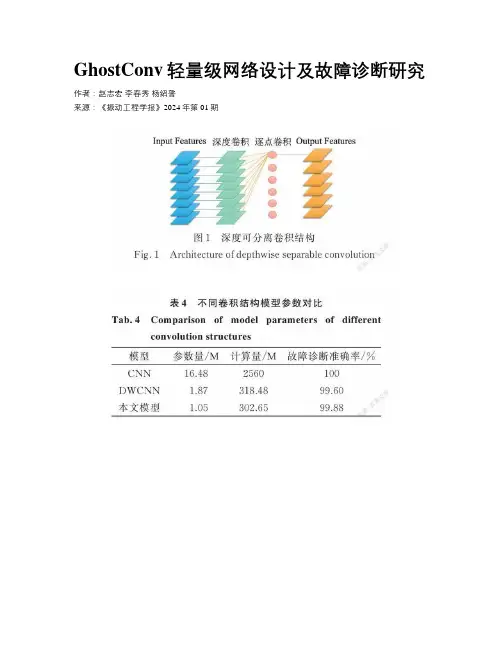

GhostConv轻量级网络设计及故障诊断研究作者:赵志宏李春秀杨绍普来源:《振动工程学报》2024年第01期摘要提出一种GhostConv轻量级网络模型并将其用于故障诊断。

GhostConv利用常规卷积生成一小部分特征图,然后在生成的特征图上进行多次特征提取来生成其余特征图,最大程度地节约了常规卷积中生成冗余特征图的成本,减少了模型参数,保证了模型的性能。

采用连续小波变换对振动信号进行时频变换生成二维时频图,之后利用设计的GhostConv搭建轻量级网络模型进行故障诊断。

采用凯斯西储大学轴承数据集进行验证,并与其他卷积结构网络模型进行参数量、计算量以及识别准确率的对比。

实验结果表明,与其他模型相比,所使用的网络模型在参数量和计算量较少的条件下依旧有较高的识别精度,且具有较好的鲁棒性和泛化能力,具有一定的工程应用价值。

关键词故障诊断; 滚动轴承; 轻量级网络; GhostConv; 时频图引言轴承作为旋转机械最重要的组成部分,在运行过程中出现故障会导致安全事故的发生,造成巨大的经济损失。

因此,对滚动轴承的故障诊断越来越受到研究人员的重视[1]。

目前,关于轴承故障诊断的研究已有多种方法,例如,Lu等[2]使用遗传算法和经验模式分解提取特征,然后使用支持向量机对故障进行分类和识别。

Mao等[3]提出了一种结合多孔排列熵和支持向量机的诊断方法,对轴承故障类型进行分类。

随着计算机技术的发展,基于深度学习的智能故障诊断方法受到越来越多的关注[4]。

这些方法将故障特征提取和特征分类相结合,从原始信号数据中自动提取出代表性特征,然后进行分类。

在深度学习中,卷积神经网络、长短期记忆网络以及自编码器等神经网络在机械故障诊断领域的应用都取得了进展。

侯文擎等[5]提出了一种改进堆叠降噪自编码器的方法,将其应用于轴承故障诊断中。

Pan等[6]建立了基于长短期记忆网络和卷积神经网络的模型以进行轴承的故障诊断,取得了较好的诊断结果。

《供配电系统中短引线保护误动分析及改进》摘要本文通过对供配电系统中短引线保护引起的停电范围的扩大进行了详细分析,发现供配电系统中线路与上级线路的短路电流非常相似经常会引起保护的误动,并提出了整改措施以备消除同类型事故的隐患,杜绝了同类事故的发生,提高了电网运行的可靠性。

关键词供配电系统;短引线保护;误动分析中图分类号tm7文献标识码a文章编号1674-6708(xx)45-0139-02 供配电自动化系统是智能小区的重要组成部分,小区供配电系统运行的可靠性和安全性直接关系到居民正常生活、工作和社会稳定。

为了确保设计方案的可靠性、先进性,我们借鉴了国内外先进的小区供配电自动化系统设计思想和技术,针对兴隆园小区供配电系统的特点进行方案设计,主要包括该系统的一次配电设备改造、保护测控系统、系统通讯方式以及控制中心的设计。

1供配电系统基本情况供配电系统由2条10kv进线做为小区供电电,2座10kv开闭所做为配电枢纽,由10座终端变电所覆盖整个小区(4区、5区立体车库)。

目前,1#开闭所已完成自动化改造,实现了微机监控。

2#开闭所10kv二次保护设备采用电磁继电器,整定误差大、动作时间长、调试校验复杂,属于淘汰产品。

低压配电采用gcs柜体,没有测控功能。

1#、2#、7#、8#、9#、锅炉房变电所为xx建设,10kv负荷开关均为手动操作,没有配电监测单元。

4#变电所为xx年建设,设备状况同1#变电所。

5#变电所为xx年建设,高压负荷开关为手动操作的sf6负荷开关,低压采用gcs柜,无配电监测单元。

新建的4区、5区以及立体车库变电所,所采用的10kv负荷开关均为电动操作机构,低压采用gcs柜,但没有配置配电监测单元。

2供配电系统事故及其存在问题鉴于现状,小区供配电系统存在以下3个主要问题:1)10kv电网故障时易出现越级跳,导致大范围停电小区配电线路短,靠故障电流很难区分故障区域,只能靠时间级差进行配合。

由于供电局出线保护速断延时定值短,使1#开闭所进出线和2#开闭所进出线保护无法通过时间级差进行配合。

最小二乘支持向量机算法及应用研究最小二乘支持向量机算法及应用研究引言:在机器学习领域中,支持向量机(Support Vector Machines, SVM)算法是一种广泛应用于分类和回归分析的监督学习方法。

而最小二乘支持向量机算法(Least Square Support Vector Machines, LS-SVM)则是支持向量机算法的一种变种。

本文将首先简要介绍支持向量机算法的原理,然后重点探讨最小二乘支持向量机算法的基本原理及应用研究。

一、支持向量机算法原理支持向量机是一种有效的非线性分类方法,其基本思想是找到一个超平面,使得将不同类别的样本点最大程度地分开。

支持向量是指离分类超平面最近的正负样本样本点,它们对于分类的决策起着至关重要的作用。

支持向量机算法的核心是通过优化求解问题,将原始样本空间映射到更高维的特征空间中,从而实现在非线性可分的数据集上进行线性分类的目的。

在支持向量机算法中,线性可分的数据集可以通过构建线性判别函数来实现分类。

但是,在实际应用中,往往存在非线性可分的情况。

为了克服这一问题,引入了核技巧(Kernel Trick)将样本映射到更高维的特征空间中。

通过在高维空间中进行线性判别,可以有效地解决非线性可分问题。

二、最小二乘支持向量机算法基本原理最小二乘支持向量机算法是一种通过最小化目标函数进行求解的线性分类方法。

与传统的支持向量机算法不同之处在于,最小二乘支持向量机算法将线性判别函数的参数表示为样本点与分类超平面的最小误差之和的线性组合。

具体而言,最小二乘支持向量机算法的目标函数包括一个平滑项和一个约束条件项,通过求解目标函数的最小值,得到最优解。

最小二乘支持向量机算法的求解过程可以分为以下几个步骤:1. 数据预处理:对原始数据进行标准化或归一化处理,以确保算法的稳定性和准确性。

2. 求解核矩阵:通过选取适当的核函数,将样本点映射到特征空间中,并计算核矩阵。

3. 构建目标函数:将目标函数表示为一个凸二次规划问题,包括平滑项和约束条件项。

支持向量机算法理论与算法研究摘要支持向量机是建立在统计学习理论VC维理论和结构风险最小化原理基础上的机器学习方法。

它在解决小样本、非线性和高维模式识别问题中表现出许多特有的优势,并在很大程度上克服了“维数灾难”和“过学习”等问题。

此外,它具有坚实的理论基础,简单明了的数学模型,因此,在模式识别、回归分析、函数估计、时间序列预测等领域都得到了长足的发展,并被广泛应用于文本识别、手写字体识别、人脸图像识别、基因分类及时间序列预测等。

标准的支持向量机学习算法问题可以归结为求解一个受约束的二次型规划问题。

对于小规模的二次优化问题,禾I」用牛顿法、内点法等成熟的经典最优化算法便能够很好的求解。

但是当训练集规模很大时,就会出现训练速度慢、算法复杂、效率低下等问题。

目前一些主流的训练算法都是将原有大规模的QP问题分解成一系列小的QP问题,按照某种迭代策略,反复求解小的QP问题,构造出原有大规模的QP问题的近似解,并使该近似解逐渐收敛到最优解。

但是如何对大规模的QP问题进行分解以及如何选择合适的工作集是当前训练算法所面临的主要问题,并且也是各个算法优劣的表现所在。

另外,现有的大规模问题训练算法并不能彻底解决所面临的问题,因此,在原有算法上进行合理的改进或研究新的训练算法势在必行。

本文首先对支持向量机的理论进行系统的介绍,进而对当今SVM训练算法进行综述,并对未来的研究方向进行展望。

关键词模式识别;支持向量机;支持向量分类;支持向量回归1统计学习理论(SLT简介[13]1.1背景现实世界中存在大量我们尚无法准确认识但却可以进行观测的事物,如何从一些观测数据(样本)出发得出目前尚不能通过原理分析得到的规律,进而利用这些规律预测未来的数据,这是统计模式识别(基于数据的机器学习的特例)需要解决的问题。

统计是我们面对数据而又缺乏理论模型时最基本的(也是唯一的)分析手段。

Vapnik等人早在20世纪60年代就开始研究有限样本情况下的机器学习问题,但这些研究长期没有得到充分的重视。