LSTM网络的制造工具

摘要

我们提出两种减少参数和加速大型长短期存储器(LSTM)网络的训练的简单方法:第一个是将LSTM矩阵的矩阵因式分解为两个较小矩阵的乘积,第二个是将LSTM矩阵,其输入和状态分为独立团体。这两种方法使我们能够更快地训练大型LSTM网络,使其成为最先进的困惑。在十亿字的基准测试中,我们将单个模型的困惑度提高到24.29。

1引言

LSTM网络(Hochreiter&Schmidhuber,1997)已经成功地用于语言建模(Jozefowicz等,2016; Shazeer等,2017),语音识别(Xiong et al.,2016),机器翻译(Wu et al.,2016)以及许多其他任务。然而,这些网络具有数百万个参数,并且需要在多GPU系统上进行数周的培训。我们引入LSTM单元与LSTMP(Sak等人,2014年)的两个修改,以减少参数数量和加速训练。第一种方法,分解LSTM(F-LSTM)使用两个较小矩阵的乘积近似大LSTM矩阵。第二种方法,组LSTM(G-LSTM)将LSTM单元分成独立组。我们使用十亿字基准测试F-LSTM 和G-LSTM体系结构语言建模任务(Chelba等,2013)。作为基准,我们使用了由Jozefowicz 等人(2016)描述的没有CNN输入的BIGLSTM模型。我们使用8台特斯拉P100 GPU在DGX-1系统上训练所有网络1周,之后BIGLSTM的评估困惑度为31.0,而两种新型号的困惑度都更好:F-LSTM为28.11,G-LSTM为28.17。我们在一个DGX-1上用4组训练了一个星期的G-LSTM,并且实现了24.29的新的单一模式的最先进的困惑。

1.1长期记忆概述

学习与循环神经网络(RNN)的远程依赖是具有挑战性的,因为消失和爆炸的梯度问题(Bengio等人,1994; Pascanu等人,2013)。为了解决这个问题,LSTM单元由Hochreiter &Schmidhuber(1997)引入,并进行以下循环计算:

其中为输入,是单元格的状态,是单元格的内存。我们考虑具有大小p,LSTMP

的投影的LSTM单元,其中等式(1)计算如下(Sak等人,2014; Zaremba等人,2014)。首先,计算单元格栅(i,f, o, g):

其中,和是仿射变换。

。

使用以下等式计算下一个状态和存储器:

其中是线性投影。LSTMP单元计算的主要部分是计算仿射变换T,因为它涉及乘法与矩阵W.因此,我们专注于减少W中的参数数量。

1.2相关工作

由Krizhevsky等人介绍了将层分成平行组。(2012)在AlexNet中,其中一些卷积层被分为两组,以在两个GPU之间分割模型。已被广泛用于减少网络权重并需要计算的多组信号,例如Esser等人(2016)。Coughlet(2016)在Xception架构中扩展了这种多组的方法。例如,在VGG网络(Simonyan&Zisserman,2014)和ResNet“瓶颈设计”(He等人,2016)中使用了将较大卷积层分解为具有较小滤波器的层叠层的思想。Denil等人(2013)已经表明,可以通过仅学习少量的权重并预测其余的来训练几种不同的深层结构。在LSTM网络的情况下,ConvLSTM(Shi 等人,2015)被引入以更好地利用可能的时空相关性,这在概念上类似于分组。

2模型

2.1生产的LSTM细胞

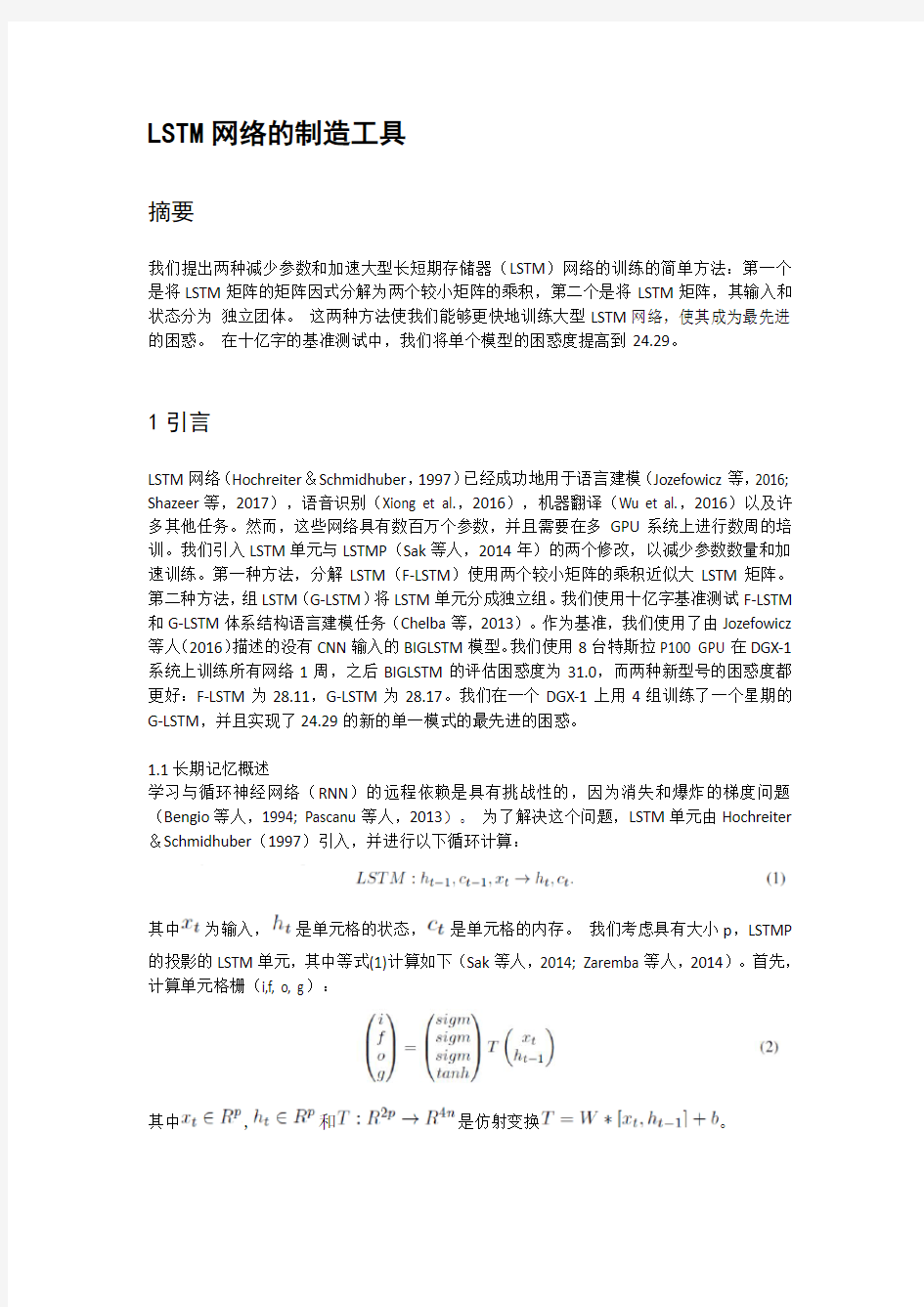

因式分解的LSTM(F-LSTM)将矩阵W替换为基本上尝试将W近似为W≈W2*W1的两个较小矩阵的乘积。,其中W1大小为2p*r,W2是r*4n,r

图1:语言模型,使用:(a)2个常规LSTM层,(b)2个F-LSTM层,(c)2个GLSTM层,每层2组。单元格内的等式显示在每个时间步长中这些单元格计算出哪种仿射变换。对于没有组的模型,d =(x,h),对于具有两组的模型,d1 =(x1,h1),d2 =(x2,h2)而时间指数却下降了。

2.2组长细胞

这种方法是由Alexnet组织(Krizhevsky等,2012)启发的。我们假设一些输入和隐藏状态的部分可以被认为是独立的特征组。例如,如果我们使用两组,则和都有效地分成两个向量,分别连接在一起和,其中只取决于

和单元格的记忆状态。因此,对于k组,公式2变为:

其中,是从到的组j的仿射变换。分区T现在有参数。该单元架构非常适合于模型并行性,因为每个组计算是独立的。G-LSTM层的另一种解释如图1(c)所示。虽然这可能看起来类似于合奏(Shazeer等,2017)或多塔(Ciregan等人,2012)模型,但主要差异是:(1)对不同组的输入是不同的,假定是独立的,(2 )而不是计算集合输出,它被连接成独立的部分。

3实验和结果

对于测试,我们使用学习任意长度的字序列联合概率的任务,使得“真实的“句子与单词的随机序列相比具有很高的概率。图1(a)显示了典型的基于LSTM的模型,其中首先将这些词嵌入到RNN的低维密集输入中,然后通过步数学习使用

RNN的“上下文”,最后,softmax层转换RNN输出到概率分布。我们测试

以下型号:

>BIGLSTM - 具有预测但没有来自Jozefowicz等人的CNN输入的模型。(2016)

>BIG F-LSTM F512 - LSTM矩阵W的中间等级为512,

>BIG-LSTM G-4,两层4组

>BIG-LSTM G-16,两层共16组。

我们使用Adagrad优化器,投影大小为1024,单元格大小为8192,每个GPU 128个小批量,8192个样本的采样软件,为DGX-1上的所有型号提供8个GP100 GPU,和0.2学习率。请注意,投影的使用至关重要,因为它有助于防止嵌入和softmax层大小。表1总结了我们的实验。

从训练损失来看,附录中的图2显然可以看出,在同一步骤中,具有更多参数的型号胜利。然而,考虑到相同的时间,分解模型训练更快。虽然BIGLSTM和BIG G-LSTM-G4的区别是清晰可见的,但是BIG GLSTM-G4比BIGLSTM包含2.4个RNN参数,火车快2倍,结果,在同一训练时间预算(1周)内实现更好的评估困惑。由于BIG GLSTM-G4的结果看起来和BIG F-LSTM-F512一样好,但是它具有较少的参数,我们就可以了再运行一个星期,实现24.29的新的单一模式的艺术困惑。

我们的代码可以在https://https://www.doczj.com/doc/873021630.html,/okuchaiev/f-lm获得

3.1未来研究

虽然可以进一步尝试使用具有2p输入和4n输出的任意前馈神经网络近似变换T,但在我们的初始实验中,我们没有看到这样做的直接好处。因此,它仍然是未来研究的主题。

通过将G-LSTM层叠加在一起,可以进一步减少RNN参数的数量。在我们的第二个较小的实验中,我们用8组而不是4代替BIG G-LSTM-G4网络的第二层,称之为BIG G-LSTM-G4-G8。我们让BIG G-LSTM-G4和BIG G-LSTM-G4-G8分别在4个GPU上运行1周,相应地实现了29.09和28.47的困惑。因此,具有“等级”组的模型并没有失去太多的准确性,运行速度更快,困惑度更高。这种“层次化”组层看起来很有趣,因为它们可能为学习不同层次的抽象提供了一种方式,但这仍然是未来研究的主题。

附录:4类LSTM模型的训练损失

图2:Y轴:对于(A)和(B)- 训练损失对数尺度,X轴:对于(A)- 步骤或小批量计数,对于(B)- 小时(wg wall time )的培训。BIGLSTM基线,BIG G-LSTM-G4,BIG G-LSTM-G16和BIG F-LSTM-F512都训练了一周。显而易见的是,在相同的步数下,具有更多参数的模型赢了。另一方面,因子分解模型可以在给定的时间内进行更多的迭代,因此在给定相同的时间量的情况下获得更好的结果。(A)和(B)的X轴全部为1周)。

1:工资就像大姨妈,一个月一次,一周左右就没了 2:.我平胸我骄傲,我为国家省布料。 3:人生就像打电话,不是你先挂,就是我先挂。 4:长寿秘诀——保持呼吸,不要断气。 5:因为以前太掏心掏肺了,所以搞的现在没心没肺。 6:晚上不要讲鬼故事,因为人爱听,鬼也爱听。 7:.亲爱的,你可得一定要相信我啊,我连坐船都头晕,更何况是脚踏两只船呢? 8:距离产生旳不是美、而是第三者。 9:.代沟就是,你问老爸:你觉得《菊花台》怎么样?老爸想想说:没喝过~~~~ 10:请不要叫我宅男,请叫我闭家锁;请不要叫我宅女,请叫我居里夫人 11:.夏天就是不好,穷的时候我连西北风都没得喝…… 12:我喝水只喝纯净水,牛奶只喝纯牛奶,所以我很单纯...... 13:男人的双手不是用来洗衣服的,而是用来拥抱女人的。 14:人人都说我很听话,其实我只听自己的话… 15:人和猪的区别就是:猪一直是猪,而人有时却不是人! 16:爷爷说:周杰伦出家一定是个好和尚,因为他念的经实在太好听了…… 17:五毛和五毛是最幸福的因为他们凑成了一块 18:或许有一天,当你披上婚纱的时候,我已披上了袈裟。 19:刷牙是一件悲喜交加的事情,因为一手拿着杯具,一手拿着洗具。 20:.走自己的路、让猫和狗说去吧 21:.那天,你说你讨厌我,我笑了,笑的撕心裂肺。 22:原来,爱情从来没有离开过,只是我记得,你忘了。 23:所谓情话,就是说了一些连你自己都不相信的话,却希望对方相信 1.别和我谈恋爱,虚伪。有本事咱俩结婚。 2.你情敌和曾经背叛你的人同时掉入河中,并且他们不会游泳,你是选择蹦迪还是去KTV? 3.love your mother who who…... 4.别做点错事就把什么脏水都往自己身上泼,姐还要留着冲厕所呢。 5.新闻联播的牛X之处在于就算你一直在换台,也能完整的看完一条新闻。 6.你跟谁俩整那表情呢。。我欠你贷款要到期了还是怎么的。 7.爷不是你的小浣熊,玩不出你的其乐无穷。 8.人生苦短,必须性感。 9.不是所有看上去风骚的美女都是婊子,还有可能是推销员。 10.我不整理房间,我是乱室佳人。 11.法律规定:男人23岁才能结婚,可是18岁就能当兵。这说明了3个问题:一是杀人比做丈夫容易;二是过日子比打仗难;三是女人比敌人更难对付。 12.姐不是客服人员,你没权要求姐答这答那。 13.别人的钱财乃我的身外之物。

. 2012 网络流行语和流行词 (1)给力:一般理解为有帮助、有作用、给面子。 (2)囧:被形容为“ 21 世纪最风行的一个汉字”,它的本义为“光明”,从 2008 年开始在网络社群成为一种流行的表情符号,成 为网络聊天、论坛、博客中使用最频繁的字之一,被赋予“尴尬、 郁闷、悲伤、无奈”等意义。 (3)神马都是浮云:“神马”并非一匹马,而是“什么”的谐音。网友打字飞快,常在用拼音打“什么”时,打出“神马”来。“浮云”的意思即虚无缥缈,转瞬即逝,意为“都不值得一提”。它的 流行源于红遍网络的“小月月”事件。 (4)你 out 了:其意思等于你落伍了,跟不上潮流了!out 是简写,原为“ out of time”(时间之外),即不合时宜。 (5)织围脖:微博是 2009 年的产物,但在 2010 年因为明星喜爱微博而大火特火,织围脖就是写微博。 (6)杯具:因与“悲剧”一词谐音,成为网络流行语,词性多变,可作形容词、名词等等。 (7)雷人:这是个非常有名的网络词,在现代网络语言中,“雷”可以说成是惊吓、被吓到了或被震撼的意思。

. (8)PK:即 Player Killing 的缩写,原指在游戏中高等级玩家随意 杀害低等级玩家的行为,后引申发展为“对决”等含义,并且用法 更加广泛。 (9)我勒个去:“呜呼哀哉”。 (10)鸭梨:压力。 (11)织毛衣:源自一首网络歌曲《织毛衣》。后来就是指在微 博上提出建设性和批评性意见。 (12)羡慕嫉妒恨:恨源于嫉妒,嫉妒源于羡慕。 (13)非常艰难的决定:续 2010 年 11 月 3 日晚间腾讯发表了“致 广大 QQ用户的一封信”称“将在装有 360 软件的电脑上停止运行QQ 软件”,随后网民开始模仿腾讯公开信改写“ QQ体”,其中最经典台词为“我们作出了一个非常艰难的决定”令人啼笑皆非。艰难 的决定原文:当您看到这封信的时候,我们刚刚作出了一个非常艰 难的决定。在 360 公司停止对 QQ进行外挂侵犯和恶意诋毁之前,我们决定将在装有360 软件的电脑上停止运行QQ软件。我们深知这样会给您造成一定的不便,我们诚恳地向您致歉。同时也把作出这一 决定的原因写在下面,盼望得到您的理解和支持。 (14)有关部门:有关部门就是什么都管、什么也都不管的部门。 有了成绩和好处的时候,这些部门就会明确地站出来,这些成绩与 其有关,所以好处也应当有份;当出现问题和需要处罚时,这些部

循环神经网络(RNN, Recurrent Neural Networks)介绍 标签:递归神经网络RNN神经网络LSTMCW-RNN 2015-09-23 13:24 25873人阅读评论(13) 收藏举报分类: 数据挖掘与机器学习(23) 版权声明:未经许可, 不能转载 目录(?)[+]循环神经网络(RNN, Recurrent Neural Networks)介绍 这篇文章很多内容是参考: https://www.doczj.com/doc/873021630.html,/2015/09/recurrent-neural-networks-tutorial-part-1-introd uction-to-rnns/,在这篇文章中,加入了一些新的内容与一些自己的理解。 循环神经网络(Recurrent Neural Networks,RNNs)已经在众多自然语言处理(Natural Language Processing, NLP)中取得了巨大成功以及广泛应用。但是,目前网上与RNNs有关的学习资料很少,因此该系列便是介绍RNNs的原理以及如何实现。主要分成以下几个部分对RNNs进行介绍: 1. RNNs的基本介绍以及一些常见的RNNs(本文内容); 2. 详细介绍RNNs中一些经常使用的训练算法,如Back Propagation Through Time(BPTT)、Real-time Recurrent Learning(RTRL)、Extended Kalman Filter(EKF)等学习算法,以及梯度消失问题(vanishing gradient problem) 3. 详细介绍Long Short-Term Memory(LSTM,长短时记忆网络);

b p神经网络及m a t l a b实现

图1. 人工神经元模型 图中x1~xn是从其他神经元传来的输入信号,wij表示表示从神经元j到神经元i的连接权值,θ表示一个阈值 ( threshold ),或称为偏置( bias )。则神经元i的输出与输入的关系表示为: 图中 yi表示神经元i的输出,函数f称为激活函数 ( Activation Function )或转移函数 ( Transfer Function ) ,net称为净激活(net activation)。若将阈值看成是神经元i的一个输入x0的权重wi0,则上面的式子可以简化为: 若用X表示输入向量,用W表示权重向量,即: X = [ x0 , x1 , x2 , ....... , xn ]

则神经元的输出可以表示为向量相乘的形式: 若神经元的净激活net为正,称该神经元处于激活状态或兴奋状态(fire),若净激活net为负,则称神经元处于抑制状态。 图1中的这种“阈值加权和”的神经元模型称为M-P模型 ( McCulloch-Pitts Model ),也称为神经网络的一个处理单元( PE, Processing Element )。 2. 常用激活函数 激活函数的选择是构建神经网络过程中的重要环节,下面简要介绍常用的激活函数。 (1) 线性函数 ( Liner Function ) (2) 斜面函数 ( Ramp Function ) (3) 阈值函数 ( Threshold Function ) 以上3个激活函数都属于线性函数,下面介绍两个常用的非线性激活函数。 (4) S形函数 ( Sigmoid Function ) 该函数的导函数:

Computer Science and Application 计算机科学与应用, 2020, 10(6), 1277-1285 Published Online June 2020 in Hans. https://www.doczj.com/doc/873021630.html,/journal/csa https://https://www.doczj.com/doc/873021630.html,/10.12677/csa.2020.106132 Multilayer Recurrent Neural Network for Action Recognition Wei Du North China University of Technology, Beijing Received: Jun. 8th, 2020; accepted: Jun. 21st, 2020; published: Jun. 28th, 2020 Abstract Human action recognition is a research hotspot of computer vision. In this paper, we introduce an object detection model to typical two-stream network and propose an action recognition model based on multilayer recurrent neural network. Our model uses three-dimensional pyramid di-lated convolution network to process serial video images, and combines with Long Short-Term Memory Network to provide a pyramid convolutional Long Short-Term Memory Network that can analyze human actions in real-time. This paper uses five kinds of human actions from NTU RGB + D action recognition datasets, such as brush hair, sit down, stand up, hand waving, falling down. The experimental results show that our model has good accuracy and real-time in the aspect of monitoring video processing due to using dilated convolution and obviously reduces parameters. Keywords Action Recognition, Dilated Convolution, Long Short-Term Memory Network, Deep Learning 多层循环神经网络在动作识别中的应用 杜溦 北方工业大学,北京 收稿日期:2020年6月8日;录用日期:2020年6月21日;发布日期:2020年6月28日 摘要 人体动作识别是目前计算机视觉的一个研究热点。本文在传统双流法的基础上,引入目标识别网络,提出了一种基于多层循环神经网络的人体动作识别算法。该算法利用三维扩张卷积金字塔处理连续视频图

[话题]本年度“十大网络流行用语” 网络评选的年度“十大网络流行用语”结果本周揭晓,“偶稀饭”、“弓虽”等语汇入选“十大”之列。这次网络流行用语评选是猫扑网和天涯在线在网上联合举办的,据主办方介绍,在几天里有数千网友参与了评选活动。最后得出本年度10个最流行用语分别是:“做人要厚道” (电影《手机》里的台词)“沙发” (指论坛上第一个回帖的人)“汗或寒” (起鸡皮疙瘩)“百度一下” (用搜索引擎找东西)“潜水” (表示在论坛只看帖不回复)“顶” (支持)“出来混,迟早都是要还的” (电影《无间道》的台词,报应的意思)“弓虽” (强字拆写,还表示强的意思)“偶稀饭” (我喜欢)“FB” (“腐败”拼音缩写,意指吃饭、聚聚等轻松活动)。 网络评选的年度“十大网络流行用语”结果本周揭晓,“偶稀饭”、“弓虽”等语汇入选“十大”之列。这次网络流行用语评选是猫扑网和天涯在线在网上联合举办的,据主办方介绍,在几天里有数千网友参与了评选活动。最后得出本年度10个最流行用语分别是:“做人要厚道” (电影《手机》里的台词)“沙发” (指论坛上第一个回帖的人)“汗或寒” (起鸡皮疙瘩)“百度一下” (用搜索引擎找东西)“潜水” (表示在论坛只看帖不回复)“顶” (支持)“出来混,迟早都是要还的” (电影《无间道》的台词,报应的意思)“弓虽” (强字拆写,还表示强的意思)“偶稀饭” (我喜欢)“FB” (“腐败”拼音缩写,意指吃饭、聚聚等轻松活动)。 网络评选的年度“十大网络流行用语”结果本周揭晓,“偶稀饭”、“弓虽”等语汇入选“十大”之列。这次网络流行用语评选是猫扑网和天涯在

线在网上联合举办的,据主办方介绍,在几天里有数千网友参与了评选活动。最后得出本年度10个最流行用语分别是:“做人要厚道” (电影《手机》里的台词)“沙发” (指论坛上第一个回帖的人)“汗或寒” (起鸡皮疙瘩)“百度一下” (用搜索引擎找东西)“潜水” (表示在论坛只看帖不回复)“顶” (支持)“出来混,迟早都是要还的” (电影《无间道》的台词,报应的意思)“弓虽” (强字拆写,还表示强的意思)“偶稀饭” (我喜欢)“FB” (“腐败”拼音缩写,意指吃饭、聚聚等轻松活动)。 网络评选的年度“十大网络流行用语”结果本周揭晓,“偶稀饭”、“弓虽”等语汇入选“十大”之列。这次网络流行用语评选是猫扑网和天涯在线在网上联合举办的,据主办方介绍,在几天里有数千网友参与了评选活动。最后得出本年度10个最流行用语分别是:“做人要厚道” (电影《手机》里的台词)“沙发” (指论坛上第一个回帖的人)“汗或寒” (起鸡皮疙瘩)“百度一下” (用搜索引擎找东西)“潜水” (表示在论坛只看帖不回复)“顶” (支持)“出来混,迟早都是要还的” (电影《无间道》的台词,报应的意思)“弓虽” (强字拆写,还表示强的意思)“偶稀饭” (我喜欢)“FB” (“腐败”拼音缩写,意指吃饭、聚聚等轻松活动)。 网络评选的年度“十大网络流行用语”结果本周揭晓,“偶稀饭”、“弓虽”等语汇入选“十大”之列。这次网络流行用语评选是猫扑网和天涯在线在网上联合举办的,据主办方介绍,在几天里有数千网友参与了评选活动。最后得出本年度10个最流行用语分别是:“做人要厚道” (电影《手机》里的台词)“沙发” (指论坛上第一个回帖的人)“汗或寒” (起鸡皮疙瘩)“百度一下” (用搜索引擎找东西)“潜水” (表示在论坛只看

正确理解规范使用 ——对近几年网络流行语的调查分析及思考 一、调查原因 随着计算机的不断普及和互联网的广泛使用,我国网民数量也在逐年增加。据有关统计,中国网民规模达到亿,我国网民规模、宽带网民数、域名注册量三项指标稳居世界第一,其中手机上网的网民占总网民的46%。上网聊天和获取信息,已成为人们日常生活中不可或缺的一部分,网民在互联网闲聊和发表意见的过程中,形成了一种有特殊意义的语言文字,一种带有较大局限性但同时又具有固定模式的语言——网络用语。其中,有些网络用语在网络上流行起来,点击率、使用率日益提高,在表情达意中成为大多数网民约定俗成的表达方式,这些用语就成为网络流行语。中国中文信息学会常务理事张普教授认为,网络流行语有一定的社会文化研究价值,是应用语言学和社会语言学的研究重点之一,其研究对于各类媒体用语有相当的参考价值和现实意义。网络流行语作为一种流变的符号,是最能敏锐反映人们心理的变迁的。网络流行语也体现了网民的创造性,因为网络是个虚拟的空间,表达思想方式与日常生活有所不同,而且中学生主要是网络流行语的使用者,如何正确理解和规范使用它是我们应该探讨的问题。

二、调查过程 (一)确定探讨内容(2010年5月) 1、2007年—2010年,中国网络流行语的归类; 2、分析网络流行语的特点; 3、探讨网络流行语产生的原因; 4、探讨中学生该如何正确认识和使用网络流行语。 (二)主要步骤(2010年5月—2011年3月) 1、利用网络、报刊、杂志等搜集2007—2010年网络流行语; 2、将网络流行语按一定标准进行分类; 3、采用问卷调查了解中学生理解、运用网络流行语的现状; 4、分析、研究,形成调查报告。 三、调查结果 (一)网络流行语的主要类型 1、反映重大事件类 伴随着网络对社会事件的关注和近几年来网络民意的崛起,许多热词不断涌现,被网友反复套用、化用、夺人耳目,甚至延伸到现实语境中。如:2007年的“正龙拍虎”,2008年的“做人不要太CNN”“范跑跑”、“猪坚强”,2009年的“躲猫猫”“做噩梦”,2010年的“我爸是李刚”等这些网络热词以具体事件作为依据,时代特色鲜明,俏皮中暗含生活哲学,

Matlab神经网络工具箱 2010-7-21 今天学的是BP神经网络,首先看的是一个关于非线性函数逼近的例子,最后得出一个心得:在使用newff函数生成一个新的网络时,神经元的层数和每一层的神经元数会对结果造成不小的影响,一般都采用[n,1]的建立方法,其中n为隐层的神经元数,1为输出层的神经元数。 然后是做了一个识别系统,算是一个较大的神经网络,具体的代码解释和分析如下: [alphabet,targets]=prprob; [R,Q]=size(alphabet); [S2,Q]=size(targets); S1=10; [R,Q]=size(alphabet); [S2,Q]=size(targets); P=alphabet; net=newff(minmax(P),[S1,S2],{'logsig','logsig'},'traingdx'); net.LW{2,1}=net.LW{2,1}*0.01; net.b{2}=net.b{2}+0.01; 其中的proprob是matlab自带的一个生成字母表布尔值的函数。可以具体查看。 T=targets; net.performFcn='sse'; net.trainParam.goal=0.1; net.trainParam.show=20; net.trainParam.epochs=5000; net.trainParam.mc=0.95; [net,tr]=train(net,P,T) 接下来首先进行无噪声训练。 netn.trainParam.goal=0.6; netn.trainParam.epochs=300; T=[targets targets targets targets]; for pass=1:10 P=[alphabet,alphabet,(alphabet+randn(R,Q)*0.1),(alphabet+randn(R,Q)*0.2) ]; [netn,tr]=train(net,P,T); end 接下来是有噪声训练,采用随机数生成影响输入矩阵的方式。这里收敛的有点慢,在

循环神经网络注意力的模拟实现 我们观察PPT的时候,面对整个场景,不会一下子处理全部场景信息,而会有选择地分配注意力,每次关注不同的区域,然后将信息整合来得到整个的视觉印象,进而指导后面的眼球运动。将感兴趣的东西放在视野中心,每次只处理视野中的部分,忽略视野外区域,这样做最大的好处是降低了任务的复杂度。 深度学习领域中,处理一张大图的时候,使用卷积神经网络的计算量随着图片像素的增加而线性增加。如果参考人的视觉,有选择地分配注意力,就能选择性地从图片或视频中提取一系列的区域,每次只对提取的区域进行处理,再逐渐地把这些信息结合起来,建立场景或者环境的动态内部表示,这就是本文所要讲述的循环神经网络注意力模型。 怎么实现的呢? 把注意力问题当做一系列agent决策过程,agent可以理解为智能体,这里用的是一个RNN 网络,而这个决策过程是目标导向的。简要来讲,每次agent只通过一个带宽限制的传感器观察环境,每一步处理一次传感器数据,再把每一步的数据随着时间融合,选择下一次如何配置传感器资源;每一步会接受一个标量的奖励,这个agent的目的就是最大化标量奖励值的总和。 下面我们来具体讲解一下这个网络。 如上所示,图A是带宽传感器,传感器在给定位置选取不同分辨率的图像块,大一点的图像块的边长是小一点图像块边长的两倍,然后resize到和小图像块一样的大小,把图像块组输出到B。 图B是glimpse network,这个网络是以theta为参数,两个全连接层构成的网络,将传感器输出的图像块组和对应的位置信息以线性网络的方式结合到一起,输出gt。 图C是循环神经网络即RNN的主体,把glimpse network输出的gt投进去,再和之前内部信息ht-1结合,得到新的状态ht,再根据ht得到新的位置lt和新的行为at,at选择下一步配置传感器的位置和数量,以更好的观察环境。在配置传感器资源的时候,agent也会

网络流行语主要特点 时效性 很好很强大(时间不详):最初来源据称源自马克思在1845写成的重要著作Theses on Feuerbach 《关于费尔巴哈的提纲》中有提到工人阶级在兴登,卡瓦仑切以及莱茵地区的斗争时说“sehr gut, sehr beeindruckend, sehr harmonisch.”翻译成中文就是“很好,很深刻,很和谐”。其作为的使用则最早源自猫扑,其最初使用则有以下几种说法: 1、在猫扑网使用了关键字屏蔽之后,诸如“SB”一类的词汇均无法打出。于是猫扑的网友便用“NB”来代替原来“SB”的含义,而“NB”的原本含义则使用“很好很强大”一词来代替; 2、在天涯有一位网友在数年之前发表了一个贴子,但无人问津;数年之后,此人自问自答地回复了这个帖子(一说为此人自己都忘记了这贴是自己发的)。于是此后跟贴的网友们惊呼:“自挖自坟、自问自答、自娱自乐,很好,很强大”。 很黄很暴力:北京某小学生在接受央视采访时说出的一句话,迅速成为网络! 很傻很天真:出处艳照门,阿娇用于形容自己的话。 斯巴达(2007年上旬):原自电影《》,指进入极端亢奋的脑残状态。 Nice Boat(2007年下旬):原自《school days》最终话停播事件,属于广义形容词,也可扩展为“Nice XXX”。 失态(2007年末):原自《高达00》第十话中某人台词:“这是何等的失态”,属于广义动词,也写作“师太”“湿态”。 回老家结婚(2008年春):在很多影视作品及ACG的场景都有类似的语句,但是通常说出此话的人都不会有好下场...而将此话发扬光大的则是龙之塔(ドルアーガの塔~the Aegis of URUK~),此句共出现于第一集8分50秒及13分55秒(SOSG字幕组)...说出此话之人果然下一幕立马挂掉,真可谓是禁句啊!此话现在更多是用来表达对现实情况的无可奈何。 (2008年夏):源自广东电视台的某次采访。被问及对艳照门的看法时,受访人的回答“我只是出来打酱油的”,现在在网上一般用来代替“路过”用来进行快速回复。 (2008-5-20):一位网名叫“毒死狗熊”的百度吧友在魔兽世界贴吧发帖子问"LZSB"是什么意思,另一位百度吧友回复了四个字“兰州烧饼”成此典故,之后广为流传,成为一个新生词语。 兰州烧饼,首字母为“LZSB”LZ可以引申为楼主。回复此词语后,表示对楼主的鄙视,对楼主智商的怀疑。但本词的语气较之“LZSB”稍轻。 (2008年夏):据调查,最早恶搞“做俯卧撑”的帖子出现在7月1日19时59分,网友“流芳苑主”发表了《吃面要吃雪菜肉丝,运动要做俯卧撑!身体倍儿棒!》的帖子,网友纷纷效仿恶搞“做俯卧撑”。释义:①增强臂力的一种辅助性体育运动。两手和双前脚掌撑地,身体俯卧,两臂反复弯曲和撑起,使全身平起平落。②对某事不便或不愿发表意见。

近年来网络流行语对现代汉语发展的影响 摘要 当前,网络已成为现代人不可缺少的交际工具。伴随着网络的普及和网民的剧增,网络语言也以前所未有的速度产生、发展和传播。本文探讨了网络语言的特征及其对现代汉语所产生的影响和冲击,并提出了对网络语言应持的辩证态度。 关键词:网络语言现代汉语发展影响 Abstract:Nowadays,the nets are very popular in use and unavoidable。This leads to the arouse of net-languages and their development。We studied the appearance and the development of them,and the shocks they have brought to the modern Chinese,to which we ought to pay much attention reasonably Keywords:net-languages; modern Chinese;development; influence 一、引言: 随着互联网技术的普及和网络时代的来临,网络成为了人们生活中不可或缺的重要部分,这种有史以来规模最大的文明集结和全然不同于任何方式的文化交流与融合,正悄然改变着人类信息交流和生活方式。伴随网络出现而产生的网络语言应运而生并迅速广泛传播于社会。网络语言作为现代汉语的一种社会变异,是传统语言与现代高科技产品相结合的一种新的语言体系,是由于计算机输入方式的特殊性,伴随网民这一群体的出现一种深受社会的影响的社会方言。 二、网络语言的特征 网络语言从本质上说是现代汉语的一种社会变异,是伴随着网民这一群体的出现而产生的社会语言现象,其特征主要有以下表现: (一)表达方式新颖、简约、形象、幽默 网络语言中所使用的各类词汇大多借助于汉字、数字、字母和键盘符号的缩

XINWEN AIHAOZHE2010·8(下半月) 新闻与传播研究 网络流行语的含义及特点 “网络流行语”,就是在网络上流行的语言,是网民们约定俗成的表达方式。它有两大特征:一是年轻化,二是有文化。“网络流行语”是网民在网络的虚拟世界里,所运用的区别于现实生活语言的一种特殊语言符号,它来源于现实社会,又影响着现实社会。 近年来,“网络流行语”正迅速发展。比如,2008年在网上广泛流行的“躲猫猫”、“做人不要太CNN”、“叉腰肌”、“囧”、“打酱油”,等等,它们区别于现实生活语言,有自身的特殊性。 网络流行语的产生及迅速流行的原因网络媒体的出现引起了人们认知方式改变的外在表现。语言学家认为,语言表达的不仅仅是内容,它同时和人们的生活方式、经济水平、当前政治有着密切联系。上个世纪的“文化大革命”时期,人们口中不离“文革语言”;改革开放以后,电视里广告盛行,人们口中又充满了“广告语言”;近几年网络盛行,人们自然是满口的“网语”。 任何社会行为的变革总能推动语言的变革,语言的发展变化随着社会的不断发展变化,语言的流变是人们社会行为的外在表现。 传播学家麦克卢汉认为,每一种新媒介的产生,都开创了人类认知世界的方式。认知包括感觉、知觉、记忆、想象、思维和语言等。因此,新媒介的产生,有可能影响着人们语言的表达方式。纵观人类传播史,传播媒介的变革引起的传播方式变革,改变了人类的感觉,改变了人与人之间的关系,并创造出新的社会行为类型。原始社会,人类是“口语社会”;文字和印刷媒介产生之后,人类转向“眼睛社会”;广播电视产生之后,人们 的关系开始疏远。而网络产生之后,人类 开始“参与社会”。在网络制造的“参与社 会”里,每一个人都能参与到媒介环境中 来,自由发挥,表达思想,传播观点。于 是,网络语言应运而生。网络语言的出 现,是网络传媒引起人们认知世界方式 发生改变的外在表现。 网络流行语是网民表达思想过程中 必然出现的现象。网络的出现为人类改变 语言表达方式提供了可能,如果没有网络 媒体为信息提供传播形式,也不可能有 “网络流行语”的产生和存在。网络的出 现,使人类社会成为一种“参与社会”,人 人都可以参与到互联网中来,表达思想, 传播观点。据DCCI互联网数据中心 2007年中国互联网调查数据统计显示, 当年中国互联网用户规模达1.82亿, 2008年中国内地网民达2.1亿,2009年 网民已达3.8亿。在这些网民中,年龄在 19~35岁的占83.1%,学历在大专以上的 占64.7%,上网地点在家、网吧、网校、网络 咖啡馆等休闲场所的占60.3%。由以上统 计数据可以得知,我国上网人口基数大, 上网者大多是高学历的年轻人,上网时间 多为休闲时光。这些年轻人思想活跃,思 维灵活,喜欢新生事物,渴望交流,崇尚创 新,追逐时尚,而不愿意承受现实生活中 太多的约束。他们在休闲时光上网,在这 样一个具有匿名性的网络虚拟世界,无疑 给自己提供了一个尽情发挥的空间;他们 熟悉英语及计算机语言,使“网络流行语” 的产生具有了必然性和可能性。 以社会上出现的有强大影响力的事 件为背景。每一句风靡网络的流行语,背 后都有一个事件发生。比如,“做人不要太 CNN”,源自在报道“3·14”拉萨打砸抢烧 事件中,美国CNN对中国的歪曲报道; “躲猫猫”,源自2009年2月12日云南省 晋宁县看守所里一男子离奇死亡;上溯 2005年的“凉粉”、“玉米”,源自当年娱乐 界的大事件“超女”;等等。 无论是哪一个网络流行语的产生,都 是以现实社会的大事件为母体,每一个网 络流行语的背后都隐藏着一个引人注目 的社会事件,它与现实社会存在着千丝万 缕的联系。在网络时代,网民对当下现实 社会中发生的大事件发表自己的观点,谈 自己的看法。有些观点、看法在当时的语 境下传播,容易引起大多数网民的共鸣。 网络流行语对社会产生的正负效应 网络流行语产生于虚拟的网络世界, 但它以现实社会为背景。因此,它对现实 社会的影响也在不断地渗透。任何事物的 产生都存在两面性,网络流行语对现实社 会的影响也存在正效应和负效应。网络流 行语给社会带来的正效应: 社会历史的记录者。“打酱油”、“躲猫 猫”、“做人不要太CNN”,这些特殊、简单、 幽默的语言背后,都蕴涵着或者复杂或者 重大的新闻事件。在这些事件中,有些体 现国际关系的改变,有些记录人们生活观 念的改变,有些在展示经济方向的变革。 网络流行语用自己独有的简单、幽默、生 动、隐喻的方式,记录着社会历史的发展 变化。虽然它不同于传统的大众传媒,没 有传统大众传媒那种语言严谨、完整的叙 事方式,但它同样担负着记录事实的角 色。 公众的解压阀。网络流行语承担着 “解压阀”的作用。部分网络流行语透露了 网民对现实社会的思考、不满和发泄。中 国内地的网民中19~35岁的占83.1%,学 历在大专以上的占64.7%,这部分人年轻 网络流行语的传播原因及效应 □逯彦萃 摘要:近几年,随着新媒体网络的兴起和普及,越来越多的人使用和依赖网络。网民在利用网络进行信息传递的过程中,网络也在悄悄地改变着人们的语言表达方式。于是,在网络上出现了区别于现实生活中人与人交流所使用的语言符号,即“网络语言”。这些网络语言在网络世界迅速传播,甚至流行开来,形成一个特殊的“网络流行语”现象,影响着现实社会。 关键词:网络流行语产生原因正负效应发展趋势 44

人工神经网络及其应用实例人工神经网络是在现代神经科学研究成果基础上提出的一种抽 象数学模型,它以某种简化、抽象和模拟的方式,反映了大脑功能的 若干基本特征,但并非其逼真的描写。 人工神经网络可概括定义为:由大量简单元件广泛互连而成的复 杂网络系统。所谓简单元件,即人工神经元,是指它可用电子元件、 光学元件等模拟,仅起简单的输入输出变换y = σ (x)的作用。下图是 3 中常用的元件类型: 线性元件:y = 0.3x,可用线性代数法分析,但是功能有限,现在已不太常用。 2 1.5 1 0.5 -0.5 -1 -1.5 -2 -6 -4 -2 0 2 4 6 连续型非线性元件:y = tanh(x),便于解析性计算及器件模拟,是当前研究的主要元件之一。

离散型非线性元件: y = ? 2 1.5 1 0.5 0 -0.5 -1 -1.5 -2 -6 -4 -2 2 4 6 ?1, x ≥ 0 ?-1, x < 0 ,便于理论分析及阈值逻辑器件 实现,也是当前研究的主要元件之一。 2 1.5 1 0.5 0 -0.5 -1 -1.5 -2 -6 -4 -2 2 4 6

每一神经元有许多输入、输出键,各神经元之间以连接键(又称 突触)相连,它决定神经元之间的连接强度(突触强度)和性质(兴 奋或抑制),即决定神经元间相互作用的强弱和正负,共有三种类型: 兴奋型连接、抑制型连接、无连接。这样,N个神经元(一般N很大)构成一个相互影响的复杂网络系统,通过调整网络参数,可使人工神 经网络具有所需要的特定功能,即学习、训练或自组织过程。一个简 单的人工神经网络结构图如下所示: 上图中,左侧为输入层(输入层的神经元个数由输入的维度决定),右侧为输出层(输出层的神经元个数由输出的维度决定),输入层与 输出层之间即为隐层。 输入层节点上的神经元接收外部环境的输入模式,并由它传递给 相连隐层上的各个神经元。隐层是神经元网络的内部处理层,这些神 经元在网络内部构成中间层,不直接与外部输入、输出打交道。人工 神经网络所具有的模式变换能力主要体现在隐层的神经元上。输出层 用于产生神经网络的输出模式。 多层神经网络结构中有代表性的有前向网络(BP网络)模型、

对网络流行语的评价 网络是信息社会的一个标志,它具有开放、自由等特点,这些特点为网络流行语的产生提供了良好的条件。网络流行语的生成与流行既是一种语言现象,也是一种社会现象。网络流行语的生成和发展,反映了现代化发展过程中的社会文化特点。 在网络中,一些看似普通的词语却有着特别的意思。如“灌水”是发无聊帖子的意思;“抛砖、踢一脚”是跟贴的意思;“偶”是我的意思;“9494”是就是、就是的意思;“拍砖头”是批评某帖的意思;“路过”是随便看了一下帖子的意思。它们或是从现代汉语的现有词汇中引申出新的义项,或是创造出的新词新语。这些流行语的生命力姑且不论,但它们均体现了标新立异的特点,体现了一种先锋意识。这种树异于人的用法,还体现在一些句子中,如:“鸟大了什么林子都有”,这是对“林子大了,什么鸟都有”的创新用法,意指人的能力和名气如果足够大,就会有好的舞台供他(她)施展自己的才华;“一大学生最低奋斗目标:农妇、山泉、有点田”这句话源自“农夫山泉”的广告词——“农夫山泉有点甜”,后被改编成“农妇、山泉、有点田”,并借此理解为一个大学生的最低奋斗目标。这些富有个性的网络流行语不断产生并快速流行。 当然,在网络中,也存在着语言借用的现象。如“顶你个肺”原来是广东方言,周星驰的电影里曾出现过这样的台词。这些网络流行语的大量出现,和网络环境的特点密不可分。网络环境具有开放性和自由性的特点,这为不同语言的接触、借用、流行提供了得天独厚的便利条件,而基于这种基础生成的网络流行语,则体现了多元文化彼此接触的特点,使得不同的文化成分可能为对方所吸收、借用。 人类对世界的认识是永无止境的,而处于社会中的心理也在不断地发展、变化。在现实社会中,人们已经形成了某种社会心理或诉求,但并未找到合适的词汇表达出来,从而形成了矛盾。网络自由的环境和富有创造性的群体,使得这些空缺得到补充。如“顶你个肺”这旬网络流行语表示惊讶、不满的意思,而更多的是表达了无奈。在汉语中,原来就有很多表示“惊讶、不满、无奈”的多种语言表达形式,但是《疯狂的石头》的热播,加之齐达内在世界杯上的以头顶人,让这句台词成为网络流行语。究其原因,大概是一些人不再满足默默无闻的生活方式,而想要彰显自我,展示个性。这些流行语很好的满足了人们的心理诉求,因而异常受欢迎。 同时,我们也要意识到,语言往往承载着特定的人生观、价值观、道德观、伦理观。个体特别是青少年在学习掌握语言的过程中或多或少会受其影响。一些网络流行语有益于个体正确的人生观、价值观、道德观、伦理观的形成,但不可否认的是,一些网络流行语对个体正确的人生观、价值观、道德观、伦理观的形成具有负面影响。“人不为己,天诛地灭”之类的流行语体现了不良的思想倾向,如果频繁接触这些词语,就有可能潜移默化地受到其不良影响。再者,严格地说,在网络流行语中有不少错别字或语法不通的句子。如果不加以正确引导,会严重影响青少年的语言水平和能力。特别是用网络流行语与人交流,虽然形成了个体的话语风格,但会时常造成交际障碍,而且更易形成代沟。 希腊有“凡事勿过度”的思想,意指过分的放纵或节制都有损健康发展,只有取其中,才是正当的态度,才有益于人的身心健全。所以,借用过来,希望提醒大家,对网络流行语保持一个正确而又清醒的认识,这样我们在取其精华的同时,才能保护自己不受其糟粕的影响。

2012网络流行语和流行词(1)给力:一般理解为有帮助、有作用、给面子。 (2)囧:被形容为“21世纪最风行的一个汉字”,它的本义为“光明”,从2008年开始在网络社群成为一种流行的表情符号,成为网络聊天、论坛、博客中使用最频繁的字之一,被赋予“尴尬、郁闷、悲伤、无奈”等意义。 (3)神马都是浮云:“神马”并非一匹马,而是“什么”的谐音。网友打字飞快,常在用拼音打“什么”时,打出“神马”来。“浮云”的意思即虚无缥缈,转瞬即逝,意为“都不值得一提”。它的流行源于红遍网络的“小月月”事件。 (4)你out了:其意思等于你落伍了,跟不上潮流了!out是简写,原为“out of time”(时间之外),即不合时宜。 (5)织围脖:微博是2009年的产物,但在2010年因为明星喜爱微博而大火特火,织围脖就是写微博。 (6)杯具:因与“悲剧”一词谐音,成为网络流行语,词性多变,可作形容词、名词等等。 (7)雷人:这是个非常有名的网络词,在现代网络语言中,“雷”可以说成是惊吓、被吓到了或被震撼的意思。

(8)PK:即Player Killing的缩写,原指在游戏中高等级玩家随意杀害低等级玩家的行为,后引申发展为“对决”等含义,并且用法更加广泛。(9)我勒个去:“呜呼哀哉”。 (10)鸭梨:压力。 (11)织毛衣:源自一首网络歌曲《织毛衣》。后来就是指在微博上提出建设性和批评性意见。 (12)羡慕嫉妒恨:恨源于嫉妒,嫉妒源于羡慕。 (13)非常艰难的决定:续2010年11月3日晚间腾讯发表了“致广大QQ用户的一封信”称“将在装有360软件的电脑上停止运行QQ软件”,随后网民开始模仿腾讯公开信改写“QQ体”,其中最经典台词为“我们作出了一个非常艰难的决定”令人啼笑皆非。艰难的决定原文:当您看到这封信的时候,我们刚刚作出了一个非常艰难的决定。在360公司停止对QQ进行外挂侵犯和恶意诋毁之前,我们决定将在装有360软件的电脑上停止运行QQ软件。我们深知这样会给您造成一定的不便,我们诚恳地向您致歉。同时也把作出这一决定的原因写在下面,盼望得到您的理解和支持。 (14)有关部门:有关部门就是什么都管、什么也都不管的部门。有了成绩和好处的时候,这些部门就会明确地站出来,这些成绩与其有关,所以好处也应当有份;当出现问题和需要处罚时,这些部门就马上不见了踪

递归神经网络概述 一、引言 人工神经网络的发展历史己有60多年,是采用物理可实现的系统模仿人脑神经细胞的结构和功能,是在神经生理学和神经解剖学的基础上,利用电子技术、光学技术等模拟生物神经网络的结构和功能原理而发展起来的一门新兴的边缘交叉学科,(下面简称为神经网络,NeuralNetwork)。这些学科相互结合,相互渗透和相互推动。神经网络是当前科学理论研究的主要“热点”之一,它的发展对目前和未来的科学技术的发展将有重要的影响。神经网络的主要特征是:大规模的并行处理、分布式的信息存储、良好的自适应性、自组织性、以及很强的学习能力、联想能力和容错能力。神经网络在处理自然语言理解、图像识别、智能机器人控制等方面具有独到的优势。与冯·诺依曼计算机相比,神经网络更加接近人脑的信息处理模式。 自从20世纪80年代,Hopfield首次提出了利用能量函数的概念来研究一类具有固定权值的神经网络的稳定性并付诸电路实现以来,关于这类具有固定权值神经网络稳定性的定性研究得到大量的关注。由于神经网络的各种应用取决于神经网络的稳定特性,所以,关于神经网络的各种稳定性的定性研究就具有重要的理论和实际意义。递归神经网络具有较强的优化计算能力,是目前神经计算应用最为广泛的一类神经网络模型。 根据不同的划分标准,神经网络可划分成不同的种类。按连接方式来分主要有两种:前向神经网络和反馈(递归)神经网络。前向网络主要是函数映射,可用于模式识别和函数逼近。递归神经网络因为有反馈的存在,所以它是一个非线性动力系统,可用来实现联想记忆和求解优化等问题。由于神经网络的记亿信息都存储在连接权上,根据连接权的获取方式来划分,一般可分为有监督神经网络、无监督神经网络和固定权值神经网络。有监督学习是在网络训练往往要基于一定数量的训练样木。在学习和训练过程中,网络根据实际输出与期望输出的比较,进行连接权值和阂值的调节。通常称期望输出为教师信号,是评价学习的标准。最典型的有监督学习算法是BP(BackProPagation)算法。对于无监督学习,无教

浅谈神经网络 先从回归(Regression)问题说起。我在本吧已经看到不少人提到如果想实现强AI,就必须让机器学会观察并总结规律的言论。具体地说,要让机器观察什么是圆的,什么是方的,区分各种颜色和形状,然后根据这些特征对某种事物进行分类或预测。其实这就是回归问题。 如何解决回归问题?我们用眼睛看到某样东西,可以一下子看出它的一些基本特征。可是计算机呢?它看到的只是一堆数字而已,因此要让机器从事物的特征中找到规律,其实是一个如何在数字中找规律的问题。 例:假如有一串数字,已知前六个是1、3、5、7,9,11,请问第七个是几? 你一眼能看出来,是13。对,这串数字之间有明显的数学规律,都是奇数,而且是按顺序排列的。 那么这个呢?前六个是0.14、0.57、1.29、2.29、3.57、5.14,请问第七个是几? 这个就不那么容易看出来了吧!我们把这几个数字在坐标轴上标识一下,可以看到如下图形: 用曲线连接这几个点,延着曲线的走势,可以推算出第七个数字——7。 由此可见,回归问题其实是个曲线拟合(Curve Fitting)问题。那么究竟该如何拟合?机器不

可能像你一样,凭感觉随手画一下就拟合了,它必须要通过某种算法才行。 假设有一堆按一定规律分布的样本点,下面我以拟合直线为例,说说这种算法的原理。 其实很简单,先随意画一条直线,然后不断旋转它。每转一下,就分别计算一下每个样本点和直线上对应点的距离(误差),求出所有点的误差之和。这样不断旋转,当误差之和达到最小时,停止旋转。说得再复杂点,在旋转的过程中,还要不断平移这条直线,这样不断调整,直到误差最小时为止。这种方法就是著名的梯度下降法(Gradient Descent)。为什么是梯度下降呢?在旋转的过程中,当误差越来越小时,旋转或移动的量也跟着逐渐变小,当误差小于某个很小的数,例如0.0001时,我们就可以收工(收敛, Converge)了。啰嗦一句,如果随便转,转过头了再往回转,那就不是梯度下降法。 我们知道,直线的公式是y=kx+b,k代表斜率,b代表偏移值(y轴上的截距)。也就是说,k 可以控制直线的旋转角度,b可以控制直线的移动。强调一下,梯度下降法的实质是不断的修改k、b这两个参数值,使最终的误差达到最小。 求误差时使用累加(直线点-样本点)^2,这样比直接求差距累加(直线点-样本点) 的效果要好。这种利用最小化误差的平方和来解决回归问题的方法叫最小二乘法(Least Square Method)。 问题到此使似乎就已经解决了,可是我们需要一种适应于各种曲线拟合的方法,所以还需要继续深入研究。 我们根据拟合直线不断旋转的角度(斜率)和拟合的误差画一条函数曲线,如图: