下面我们举一个例子——Betsy 的旅行(USACO)。

题目简述:一个正方形的小镇被分成N 2个小方格,Betsy 要从左上角的方格到达左下角的方格,并且经过每个方格恰好一次。编程对于给定的N ,计算出Betsy 能采用的所有的旅行路线的数目。

实际上,由于Betsy 的每一次移动,只会影响到附近的格子,所以每次执行剪枝判断时,应当只对她附近的格子进行检查:

对于第一个剪枝条件,我们可以设一个整型标志数组,分别保存与每个格子相邻的没被经过的格子的数目,Betsy 每次移动到一个新位置,都只会使与之相邻的至多4个格子的标志值发生变化,只要检查它们的标志值即可。

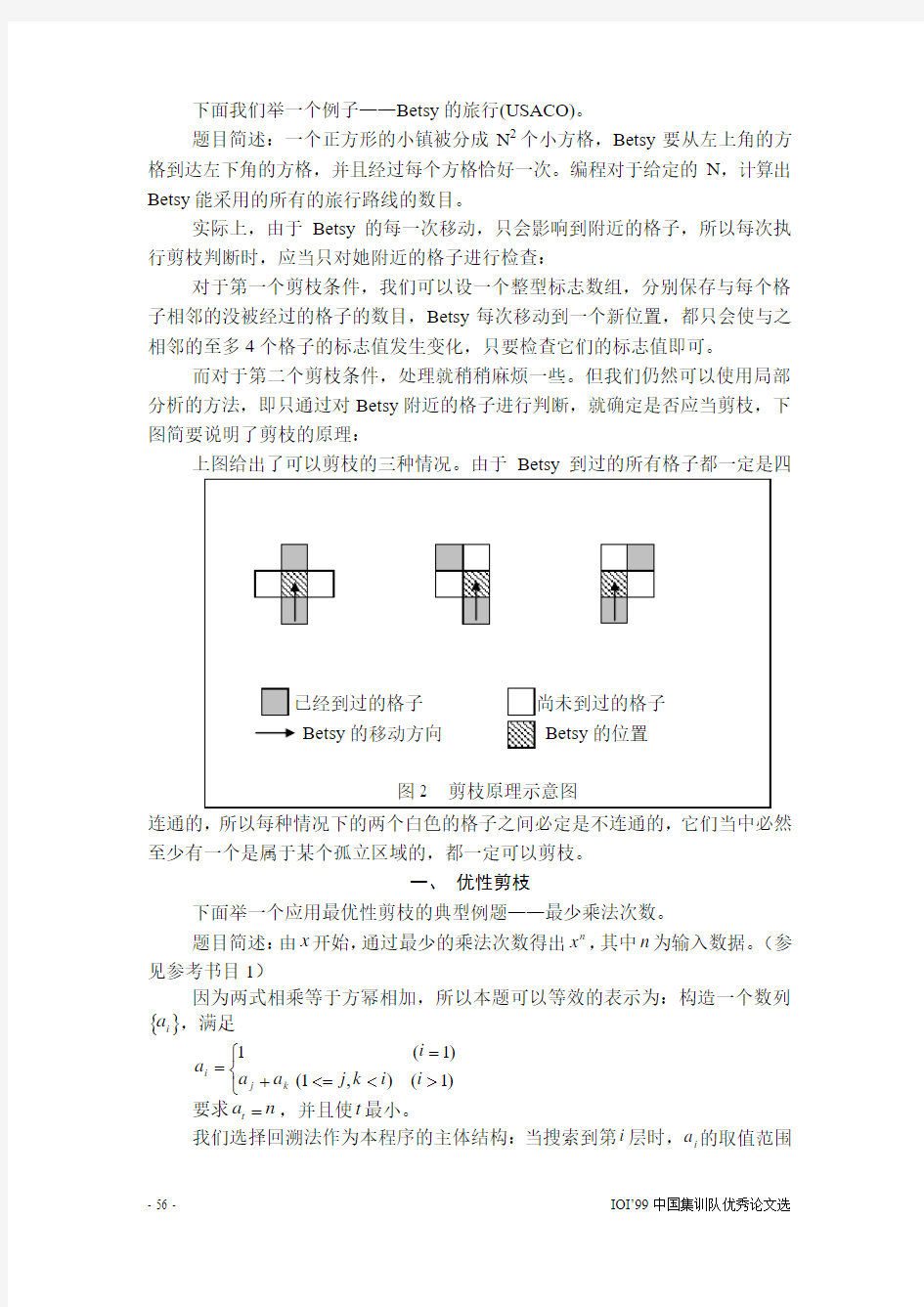

而对于第二个剪枝条件,处理就稍稍麻烦一些。但我们仍然可以使用局部分析的方法,即只通过对Betsy 附近的格子进行判断,就确定是否应当剪枝,下图简要说明了剪枝的原理:

上图给出了可以剪枝的三种情况。由于Betsy 到过的所有格子都一定是四连通的,所以每种情况下的两个白色的格子之间必定是不连通的,它们当中必然至少有一个是属于某个孤立区域的,都一定可以剪枝。

一、 优性剪枝

下面举一个应用最优性剪枝的典型例题——最少乘法次数。

题目简述:由x 开始,通过最少的乘法次数得出n x ,其中n 为输入数据。(参见参考书目1)

因为两式相乘等于方幂相加,所以本题可以等效的表示为:构造一个数列{}i a ,满足

???><<=+==)1(),1()1(1i i k j a a i a k j

i 要求n a t =,并且使t 最小。

我们选择回溯法作为本程序的主体结构:当搜索到第i 层时,i a 的取值范围

搜索中的剪枝优化

在11+-i a 到2*1-i a 之间,为了尽快接近目标n ,应当从2*1-i a 开始从大到小为i a 取值,当然,选取的数都不能大于n 。当搜索到n 出现时,就得到了一个解,与当前保存的解比较取优。最终搜索结束之后,即得到最终的最优解。

如果按上述结构直接进行搜索,效率显然很低。因此,我们可以考虑使用最优性剪枝进行优化:

优化之一:当然首先要建立估价函数。由于使数列中的最大数加倍无疑是最快的增长方式,所以一种最简单的估价函数为(设数列中当前的最大者是i a ,即当前搜索深度为i ):

?????

?=i a n h 2log 然而,这个估价函数的准确性太差,特别是当i a 大于2

n 时,h 只能等于1,根本不能发挥剪枝的作用。因此,无论是深度优先的回溯法还是宽度优先的A*搜索方法,只要还使用这个估价函数,其优化效果都比较有限。

下面,我们再讨论一些进一步的优化手段——

优化之五:当数列中的当前最大数i a 超过2

n 后,原估价函数就难以发挥作用了。但是,此后的最优方案,实际上就等价于从1a 到i a 这i 个数中,选出尽可能少的数(可重复),使它们的和等于n 。这个问题已经可以使用动态规划方法来解决。这样得到的“估价函数”不但完全准确,甚至直接就可以代替后面的搜索过程。这里也体现出了搜索和动态规划的优势互补。

二、“最少乘法次数”的估价函数的改进:

最初的估价函数的设计思路实际上是在当前数列i a a ,,1 的基础上理想化的构造i p i i a a a 2,,4,2 ,当i p i p a n a 122+<<时,原估价方法认为只需再进行一次加法,即找一个数与i p a 2相加就够了。

然而,这只是保证了能够得到大于等于n 的数,并不一定恰好得到n 。我们可以作如下分析:

首先,任何一个自然数i 都可以表示成),()12(2___-∈+Z m k m k 的形式,我们可以设)(i k 表示一个自然数i 所对应的k 值。显然,对于任何两个自然数a 和b ,都有()()(){}b k a k b a k ,min ≥+(我们由此可以很容易的联想到“奇+奇=偶,偶+偶=偶,奇+偶=奇”的性质)。

然后,我们再研究前述估价时所构造的数列:

i p i i i a a a a a a 2,,4,2,,,,21 (其中,i p i p a n a 122+<<)

在应用新的剪枝判断之前,我们应当先检验()()??p a a n i i ≥+-12/log ,这个条件可以保证只有构造上述数列才是最优的。

若存在自然数()p j j ≤≤1,使得()

()n k a k i j >2,由()()(){}b k a k b a k ,min ≥+, 则有()()()()()p t j n k a k a k a a k i j i t i p i t ≤≤>≥≥+2222

n a a i p i t ≠+∴22 (()()b k a k =是b a =的必要条件)

即i p i j a a 2,,2 中的任何一个数与i p a 2相加都不可能得到n 。

所以,如果i j i p a a n 122->-,则在得到i p a 2后,至少还需要再进行两次加法

搜索中的剪枝优化

才有可能得到n。

一、“Betsy的旅行”的程序(使用两种剪枝):

{$A+,B-,D-,E+,F-,G+,I-,L-,N+,O-,P-,Q-,R-,S-,T-,V+,X+,Y-}

{$M 65520,0,655360}

program Betsy;{IOI'99集训队论文例题1:Betsy的旅行}

{说明:

1.为了便于测试计时,本程序采用命令行输入的方式。

2.为了处理的方便,程序中在地图的最外层补了一圈标志格。

3.程序中,将逻辑上相对独立的程序段用空行分开。

}

const

max=7;{本程序所能处理的最大的数据规模}

delta:array[1..4,1..2]of shortint=((-1,0),(0,1),(1,0),(0,-1));{方向增量}

var

map:array[0..max+1,0..max+1]of integer;

{用于标记Betsy的移动路线的地图:

没有到过的位置标记-1,

最外层的标志格标记0,

其它格子标记Betsy到达该格子时的移动步数

}

left:array[0..max+1,0..max+1]of shortint;

{标志数组:记录每个格子相邻的四个格子中尚未被Betsy经过的格子的数目} n:1..max;{地图边长}

n2:integer;{N*N}

s:longint;{累加器,记录Betsy的移动路线的总数}

procedure init;{读入数据,初始化}

var

i:integer;{循环变量}

temp:integer;{临时变量}

begin

val(paramstr(1),n,temp);{从命令行读入n}

n2:=n*n;

fillchar(map,sizeof(map),255);

for i:=0 to n+1 do begin

map[0,i]:=0;

map[i,0]:=0;

map[n+1,i]:=0;

map[i,n+1]:=0;

end;

map[1,1]:=1;

{以上程序段为对地图的初始化}

fillchar(left,sizeof(left),4);

for i:=2 to n-1 do begin

left[1,i]:=3;left[n,i]:=3;

搜索中的剪枝优化

left[i,1]:=3;left[i,n]:=3;

end;

left[1,1]:=2;left[1,n]:=2;left[n,1]:=3;left[n,n]:=2;

dec(left[1,2]);dec(left[2,1]);

{以上程序段是对标志数组的初始化}

s:=0;{累加器清零}

end;

procedure change(x,y,dt:integer);{给(x,y)相邻的四个格子的left标志值加上dt} {设标志时,dt取-1;回溯时,dt取1}

var

k:integer;{循环变量}

a,b:integer;{临时坐标变量}

begin

for k:=1 to 4 do begin

a:=x+delta[k,1];b:=y+delta[k,2];

inc(left[a,b],dt);

end;

end;

procedure expand(step,x,y:integer);{搜索主过程:搜索第step步,扩展出发位置(x,y)}

var

nx,ny:integer;{Betsy的新位置}

dir:byte;{Betsy的移动方向}

function able(x,y:integer):boolean;{判断Betsy是否可以进入(x,y)}

begin

able:=not((map[x,y]<>-1)or((step<>n2)and(x=n)and(y=1)));

end;

function cut1:boolean;{剪枝判断1}

var

i:integer;{循环变量}

a,b:integer;{临时坐标变量}

begin

for i:=1 to 4 do begin

a:=x+delta[i,1];b:=y+delta[i,2];

if (map[a,b]=-1)and((a<>nx)or(b<>ny))and(left[a,b]<=1) then begin

cut1:=true;

exit;

end;

end;

cut1:=false;

end;

function cut2:boolean;{剪枝判断2}

var

d1,d2:integer;{相对于当前移动方向的"左右"两个方向}

fx,fy:integer;{Betsy由当前位置,沿原方向,再向前移动一步的位置}

搜索中的剪枝优化

begin

if (dir=2)or(dir=4) then begin

d1:=1;d2:=3;

end

else begin

d1:=2;d2:=4;

end;

fx:=nx+delta[dir,1];fy:=ny+delta[dir,2];

if (map[fx,fy]<>-1)and(map[nx+delta[d1,1],ny+delta[d1,2]]=-1)

and(map[nx+delta[d2,1],ny+delta[d2,2]]=-1) then begin

cut2:=true;

exit;

end;

if

(map[fx+delta[d1,1],fy+delta[d1,2]]<>-1)and(map[nx+delta[d1,1],ny+delta[d1,2]]=-1 )

and(map[fx,fy]=-1) then begin

cut2:=true;

exit;

end;

if

(map[fx+delta[d2,1],fy+delta[d2,2]]<>-1)and(map[nx+delta[d2,1],ny+delta[d2,2]]=-1 )

and(map[fx,fy]=-1) then begin

cut2:=true;

exit;

end;

{以上程序段中的三个条件判断分别对应论文剪枝原理图中所列的三种情况}

cut2:=false;

end;

begin{Expand}

if (step>n2)and(x=n)and(y=1) then begin{搜索到最底层,累加器加1}

inc(s);

exit;

end;

for dir:=1 to 4 do begin{循环尝试4个移动方向}

nx:=x+delta[dir,1];ny:=y+delta[dir,2];

if able(nx,ny) then begin

if cut1 then continue;{调用剪枝判断1}

if cut2 then continue;{调用剪枝判断2}

change(nx,ny,-1);

map[nx,ny]:=step;

expand(step+1,nx,ny);{递归调用下一层搜索}

map[nx,ny]:=-1;

change(nx,ny,1);

搜索中的剪枝优化

end;

end;

end;

begin{主程序}

init;{初始化}

expand(2,1,1);{调用搜索过程}

writeln('The number of tours is ',s);{输出结果}

end.

二、“最少乘法次数”的程序(即附录中的程序6):

{$A+,B-,D-,E+,F-,G+,I-,L-,N+,O-,P-,Q-,R-,S-,T-,V+,X+,Y-}

{$M 65520,0,655360}

program LeastMultiply;{IOI'99集训队论文例题2:最少乘法次数}

{说明:

1.为了测试计时的方便,本程序从命令行读入n值。

2.程序结束后,在output.txt中给出执行乘法的方式,并给出总的乘法次数。

3.在搜索过程中,由于与动态规划结合,所以在没有搜索到底层的时候,就可以得到最优解的数列长度(但此时没有得到完整的最优幂次数列),所以在搜索结束后,程序中调用formkeep过程在keep中生成完整的构造数列。

4.由于程序中的搜索过程生成的是最优幂次数列,而没有直接给出乘法的进行方式,所以在输出结果的过程output中,对其进行了转换。

5.为了尽可能的提高程序的时间效率,程序中有几处细节上的优化,请参见

程序内的注释。

6.程序中,逻辑上相对独立的程序段用空行分开。

}

const

max=20;{数列最大长度}

maxr=2000;{动态规划计数数组的最大长度(输入的n不能超过maxr的2倍)} mp=100;{预处理估价时,可以直接搜索处理的数的范围上限}

power2:array[0..12]of integer= (1,2,4,8,16,32,64,128,256,512,1024,2048,4096); {2的方幂}

type

atype=array[0..max]of integer;{用于记录构造的幂次数列的数组类型,0号元素记录数列长度}

var

n:integer;{读入的目标数字}

time:array[0..maxr]of integer;

{动态规划计数数组,time[i]表示在当前构造数列的基础上,组成数i至少需要的加数个数}

range:integer;{使用动态规划处理的范围:range=[n/2]}

a:atype;{搜索中记录数列}

搜索中的剪枝优化

kp:atype;{预处理估界时,记录结果数列的临时数组}

keep:atype;{记录最优结果数列的数组}

best:integer;{当前最优解}

f:text;{输出文件}

procedure init;{初始化}

var

temp:integer;{临时变量}

begin

val(paramstr(1),n,temp);{从命令行读入n}

keep[0]:=1;

keep[1]:=1;

best:=maxint;{最优数列长度的初值}

assign(f,'output.txt');{连接输出文件}

end;

procedure search(n:integer;var best:integer;var keep:atype);{搜索主过程}

{搜索之前,给出的搜索目标为n;

在best中存放搜索前已经给出的优度下界;

在keep中存放初始优度下界对应的最优幂次数列。

搜索结束之后,在best中给出的是构造的最优幂次数列的长度,即最少乘法次数加1;

在keep中给出所构造的最优幂次数列。

}

var

kn:integer;{n所含的2的方幂的次数}

i:integer;{循环变量}

function getk(num:integer):integer;{求num所含的2的方幂次数,即论文中所设的k(num)}

var

i:integer;{循环变量}

begin

i:=0;

while not odd(num) do begin

num:=num shr 1;

inc(i);

end;

getk:=i-1;

end;

procedure find(step:integer);{递归搜索过程}

var

i:integer;{循环变量}

k:integer;{本层搜索的循环范围上限}

function ok(num:integer):boolean;{判断数num能否在当前被构造出来}

搜索中的剪枝优化

{为了提高程序的效率,这里利用了动态规划的结果}

var

i,j:integer;{循环变量}

begin

if num<=range then begin{待判断数num在[n/2]以内}

ok:=(time[num]=2);{直接利用最少需要的加数是否为2来判断}

exit;

end;

for i:=step-1 downto 1 do begin

if a[i]+a[i] if time[num-a[i]]=1 then begin {time[t]=1表明数t在已有数列中出现过,这样可以避免使用循环判断} ok:=true; exit; end; end; ok:=false; end; procedure evltime;{动态规划子过程} var i,j:integer;{循环变量} p:integer;{本次动态规划递推的上限} begin p:=k; if p>range then p:=range; for i:=a[step-1]+1 to p do begin time[i]:=time[i-a[step-1]]+1;{目标函数赋初值} for j:=step-2 downto 2 do{决策枚举} if time[i-a[j]]+1 end; end; function h(num:integer):byte;{最初的简单估价函数h} var i:integer;{循环计数变量} begin i:=0; while num num:=num shl 1; inc(i); end; h:=i; end; function cut1:boolean;{最初的剪枝判断,直接调用估价函数h} begin 搜索中的剪枝优化 if h(a[step])+step>=best then cut1:=true else cut1:=false; end; function cut2:boolean;{使用改进的估价函数的剪枝判断} var pt:integer;{k(a[step])的值,即a[step]中所含的2的幂的次数} rest:integer;{新构造的数列中,满足k(rest)=k(n)的数} i:integer;{循环计数变量} begin if h(a[step]+a[step-1])+step+1 {如果新构造数列的第一步选择a[step]+a[step-1],而不是2*a[step],就必然导致剪枝, 这是新的估价函数起作用的必要条件。 } cut2:=false; exit; end; pt:=getk(a[step]);{求k(a[step])} if pt>kn then rest:=a[step-1] else if pt=kn then rest:=a[step] else rest:=maxint; {给rest赋初值,以防新构造的数列中的所有数的k值都小于k(n)} i:=0; repeat a[step+i+1]:=a[step+i] shl 1; inc(i); if pt+i=kn then rest:=a[step+i]; until a[step+i]>n; dec(i); {以上程序段为构造数列的过程} if (n-a[step+i]>rest)and(step+i+2>=best) then cut2:=true else cut2:=false;{剪枝判断} end; begin{Find} if a[step-1]+a[step-1]>=n then begin {数列中的当前最大数已经超过[n/2],则直接引用动态规划的结果} if time[n-a[step-1]]+step-1 best:=time[n-a[step-1]]+step-1; keep:=a; end; exit; end; 搜索中的剪枝优化 k:=a[step-1]+a[step-1];{计算a[step]的可选范围的上限} evltime;{调用动态规划子过程} inc(a[0]); for i:=k downto a[step-1]+1 do if ok(i) then begin if i<=range then time[i]:=1; a[step]:=i; if cut1 then break;{调用剪枝判断1} if cut2 then continue;{调用剪枝判断2} find(step+1);{递归调用下一层搜索} end; dec(a[0]); end; procedure formkeep;{生成最优数列keep} {由于在搜索时,如果a[step]>[n/2]则直接引用动态规划的结果,所以最优结果数列的最后一 部分实际上并未得到,所以需要在本过程中将其补充完整。 这里还需要使用递归和回溯(实际上就是一个小规模的搜索),不过,由于动态规划给出的结 果表示的是从已有数列中,选出最少的数求和而得到n,所以对这些数是可以定序的。 } var found:boolean;{找到最优数列的标志} procedure check(from,left:integer);{回溯法生成最优数列的最后一部分} {from表示当前层内循环的上界(用于定序),left表示剩余的需要通过求和而得到的数} var i:integer;{循环变量} begin if keep[0]=best then begin if left=0 then found:=true;{找到最优数列} exit; end; inc(keep[0]); for i:=from downto 1 do{循环枚举数列中的数} if keep[i]<=left then begin keep[keep[0]]:=keep[keep[0]-1]+keep[i]; check(i,left-keep[i]);{调用下一层搜索,但所使用的数不能再超过keep[i](定序)} if found then exit; end; dec(keep[0]); 搜索中的剪枝优化 end; begin{FromKeep} found:=false; check(keep[0],n-keep[keep[0]]);{调用搜索过程} end; begin{Search} kn:=getk(n);{计算k(n)} time[0]:=0; time[1]:=1; a[0]:=1; a[1]:=1; range:=n div 2; {以上程序段为搜索前的初始化} find(2);{调用搜索过程} formkeep;{搜索结束后,在keep中生成完整的构造数列} end; function guess(n:integer):integer;{递归方式实现的预处理估界} {说明: 1.子程序guess运行结束后,返回的值即为对n估价的结果;同时,在keep 数组中得到对应的数列。 2.为了能够使估价尽可能准确,guess中同时考虑了两种分解策略,即使用了回溯结构。 3.由于每次递归调用guess,其最终结果都必须记入keep数组,所以每次guess运行都只操作keep数组的一部分,同时还要借助于kp,kpt等临时数组。} var num:integer;{将n中的所有2的因子都提出后剩下的数} pfact:integer;{表示num的素因子的变量} best:integer;{向下调用时记录返回的估价值} b2:integer;{记录num中的2的因子的数目} s:integer;{对n的估价步数} i:integer;{循环变量} sq:integer;{num的平方根的整数部分,分解素因子时作为上界} s1,k2,k:integer;{临时变量} kpt:atype;{临时记录最优结果数列} begin num:=n; b2:=0; while not odd(num) do begin num:=num div 2; inc(b2); inc(keep[0]); 搜索中的剪枝优化 keep[keep[0]]:=power2[b2]; end; s:=b2+1; k2:=keep[0]; {以上程序段的作用是将n中所含的2的因子全部提出,剩下的部分即num} if num<=mp then begin{如果num足够小(小于等于mp),则直接调用搜索过程处理} best:=maxint; search(num,best,kp);{对n调用搜索过程,得到的数列存放在kp中} inc(s,best-1); for i:=2 to best do keep[i+keep[0]-1]:=kp[i]; inc(keep[0],best-1); end else begin{使用估价方法处理} k:=keep[0]; best:=guess(num-1);{递归调用guess} keep[keep[0]+1]:=keep[keep[0]]+1; inc(keep[0]); inc(s,best); {以上程序段为估价的第一种策略:将num减1后,对num-1进行估价} sq:=trunc(sqrt(num)); pfact:=3; while (pfact<=sq)and(num mod pfact>0) do inc(pfact,2); if pfact<=sq then begin kpt:=keep; keep[0]:=k2; s1:=b2+1; {以上程序段为使用第二种策略前的初始化} k:=keep[0]; best:=guess(pfact); inc(s1,best-1); {以上程序段中递归调用guess,对质因数pfact进行估价} k:=keep[0]; best:=guess(num div pfact); for i:=k+1 to keep[0] do keep[i]:=pfact*keep[i]; inc(s1,best-1); {以上程序段对[num/pfact]进行估价} if s1 end; {以上程序段是估价的第二种策略:将num分解出一个较小的质因数后再处理。 估价的结果存放在s1中,使用kpt临时存放第一种策略所构造的数列。 } 搜索中的剪枝优化 end; for i:=k2+1 to keep[0] do keep[i]:=keep[i]*power2[b2]; guess:=s;{返回估价结果} end; procedure output;{输出结果} var i,j,k:integer;{循环变量} begin rewrite(f); writeln(f,'X1'); for i:=2 to best do begin for j:=1 to i-1 do begin for k:=j to i-1 do if keep[j]+keep[k]=keep[i] then break; if keep[j]+keep[k]=keep[i] then break; end; writeln(f,'X',i,'=X',j,'*X',k); end; writeln(f,'Times of multiplies=',best-1); close(f); end; begin{主程序} init;{读入数据,初始化} best:=guess(n);{调用预处理估界} search(n,best,keep);{调用搜索主过程} output;{输出结果} end. 目标跟踪算法的分类 主要基于两种思路: a)不依赖于先验知识,直接从图像序列中检测到运动目标,并进行目标识别,最终跟踪感兴趣的运动目标; b)依赖于目标的先验知识,首先为运动目标建模,然后在图像序列中实时找到相匹配的运动目标。 一.运动目标检测 对于不依赖先验知识的目标跟踪来讲,运动检测是实现跟踪的第一步。运动检测即为从序列图像中将变化区域从背景图像中提取出来。运动目标检测的算法依照目标与摄像机之间的关系可以分为静态背景下运动检测和动态背景下运动检测 (一)静态背景 1.背景差 2.帧差 3.GMM 4.光流 背景减算法可以对背景的光照变化、噪声干扰以及周期性运动等进行建模,在各种不同情况下它都可以准确地检测出运动目标。因此对于固定 个关键技术: a)匹配法则,如最大相关、最小误差等 b)搜索方法,如三步搜索法、交叉搜索法等。 c) 块大小的确定,如分级、自适应等。 光流法 光流估计的方法都是基于以下假设:图像灰度分布的变化完全是目标或者场景的运动引起的,也就是说,目标与场景的灰度不随时间变化。这使得光流方法抗噪声能力较差,其应用范围一般局限于目标与场景的灰度保持不变这个假设条件下。另外,大多数的光流计算方法相当复杂,如果没有特别的硬件装置,其处理速度相当慢,达不到实时处理的要求。 二.目标跟踪 运动目标的跟踪,即通过目标的有效表达,在图像序列中寻找与目标模板最相似候选目标区位置的过程。简单说,就是在序列图像中为目标定位。运动目标的有效表达除了对运动目标建模外,目标跟踪中常用到的目标特性表达主要包括视觉特征 (图像边缘、轮廓、形状、纹理、区域)、统计特征 (直方图、各种矩特征)、变换系数特 实验名称:启发式搜索算法 1、实验环境 Visual C++ 6.0 2、实验目的和要求 (复述问题)使用启发式算法求解8数码问题 (1)编制程序实现求解8数码问题A*算法,采用估价函数 f(n)=d(n)+p(n) 其中:d(n)是搜索树中结点n的深度;w(n)为节点n的数据库中错放的旗子个数; p(n)为结点n的数据库中每个棋子与其目标位置之间的距离总和。 (2)分析上述(1)中两种估价函数求解8数码问题的效率差别,给出一个是p(n)的上界h(n)的定义,并测试该估价函数是否使算法失去可采纳性。 实验目的:熟练掌握启发式搜索A*算法及其可采纳性。 3、解题思路、代码 3.1解题思路 八数码问题的求解算法 (1)盲目搜索 宽度优先搜索算法、深度优先搜索算法 (2)启发式搜索 启发式搜索算法的基本思想是:定义一个评价函数f,对当前的搜索状态进行评估,找出一个最有希望的节点来扩展。 先定义下面几个函数的含义: f*(n)=g*(n)+h*(n) (1) 式中g*(n)表示从初始节点s到当前节点n的最短路径的耗散值;h*(n)表示从当前节点n到目标节点g的最短路径的耗散值,f*(n)表示从初始节点s经过n到目标节点g的最短路径的耗散值。 评价函数的形式可定义如(2)式所示: f(n)=g(n)+h(n) (2) 其中n是被评价的当前节点。f(n)、g(n)和h(n)分别表示是对f*(n)、g*(n)和h*(n)3个函数值的估计值。 利用评价函数f(n)=g(n)+h(n)来排列OPEN表节点顺序的图搜索算法称为算法A。在A算法中,如果对所有的x,h(x)<=h*(x) (3)成立,则称好h(x)为h*(x)的下界,它表示某种偏于保守的估计。采用h*(x)的下界h(x)为启发函数的A算法,称为A*算法针对八数码问题启发函数设计如下: F(n)=d(n)+p(n) (4) iSIGHT中优化方法种类 iSIGHT里面的优化方法大致可分为三类: 1 数值优化方法 数值优化方法通常假设设计空间是单峰值的,凸性的,连续的。iSIGHT中有以下几种: (1)外点罚函数法(EP): 外点罚函数法被广泛应用于约束优化问题。此方法非常很可靠,通常能够在有最小值的情况下,相对容易地找到真正的目标值。外点罚函数法可以通过使罚函数的值达到无穷值,把设计变量从不可行域拉回到可行域里,从而达到目标值。 (2)广义简约梯度法(LSGRG2): 通常用广义简约梯度算法来解决非线性约束问题。此算法同其他有效约束优化一样,可以在某方向微小位移下保持约束的有效性。 (3)广义虎克定律直接搜索法: 此方法适用于在初始设计点周围的设计空间进行局部寻优。它不要求目标函数的连续性。因为算法不必求导,函数不需要是可微的。另外,还提供收敛系数(rho),用来预计目标函数方程的数目,从而确保收敛性。 (4)可行方向法(CONMIN): 可行方向法是一个直接数值优化方法,它可以直接在非线性的设计空间进行搜索。它可以在搜索空间的某个方向上不断寻求最优解。用数学方程描述如下: Design i = Design i-1 + A * Search Direction i方程中,i表示循环变量,A表示在某个空间搜索时决定的常数。它的优点就是在保持解的可行性下降低了目标函数值。这种方法可以快速地达到目标值并可以处理不等式约束。缺点是目前还不能解决包含等式约束的优化问题。 (5)混合整型优化法(MOST): 混合整型优化法首先假定优化问题的设计变量是连续的,并用序列二次规划法得到一个初始的优化解。如果所有的设计变量是实型的,则优化过程停止。否则,如果一些设计变量为整型或是离散型,那么这个初始优化解不能满足这些限制条件,需要对每一个非实型参数寻找一个设计点,该点满足非实型参数的限制条件。这些限制条件被作为新的约束条件加入优化过程,重新优化产生一个新的优化解,迭代依次进行。在优化过程中,非实型变量为重点考虑的对象,直到所有的限制条件都得到满足,优化过程结束,得到最优解。 (6)序列线性规划法(SLP):序列线性规划法利用一系列的子优化方法来解决约束优化问题。此方法非常好实现,适用于许多工程实例问题。 (7)序列二次规划法(DONLP): 此方法对拉各朗日法的海森矩阵进行了微小的改动,进行变量的缩放,并且改善了armijo型步长算法。这种算法在设计空间中通过梯度投影法进行搜索。 (8)序列二次规划法(NLPQL): 这种算法假设目标函数是连续可微的。基本思想是将目标函数以二阶拉氏方程展开,并把约束条件线性化,使得转化为一个二次规划问题。二阶方程通过quasi-Newton公式得到了改进,而且加入了直线搜索提高了算法的稳定性。 (9)逐次逼近法(SAM): 逐次逼近法把非线性问题当做线性问题来处理。使用了稀疏矩阵法和单纯形法求解线性问题。如果某个变量被声明成整型,单纯形法通过重复大量的矩阵运算来达到预期的最优值。逐次逼近法是在M. Berkalaar和J.J. Dirks提出的二次线性算法。 2 探索优化方法 探索优化法避免了在局部出现最优解的情况。这种方法通常在整个设计空间中搜索全局最优值。iSIGHT中有以下两种: (1)多岛遗传算法(MIGA): 在多岛遗传算法中,和其他的遗传算法一样每个设计点都有一个适应度值,这个值是建立在目标函 1、程序源代码 #include 分类算法小结 分类算法小结 学号:12013120116 李余芳 分类是数据挖掘中比较重要的一类,它的算法也有很多。在此,我将一些常用的算法做一个简单的小结。 一、决策树 决策树技术是用于分类和预测的主要技术,决策树学习是以实例为基础的归纳学习算法。它着眼于从一组无次序、无规则的事例中推理除决策树表示形式的分类规则。它采用自顶向下的递归方式,在决策树的内部节点进行属性值的比较并根据不同属性判断从该节点向下的分支,然后进行剪枝,最后在决策树的叶节点得到结论。所以从根到叶节点就对应着一条合取规则,整棵树就对应着一组析取表达式规则。树的每一个结点上使用信息增益度量选择测试属性。可以从生成的决策树中提取规则。。 优点: 1、易于理解和解释.人们在通过解释后有能力去理解决策树所表达的意义。 2、能够同时处理数据型和常规型属性。其他技术往往要求数据属性的单一。 3、易于通过静态测试来对模型进行评测。表示有可能测量该模型的可信度。 4、在相对短的时间内能够对大型数据源做出可行且效果良好的结果。 5、可以对有许多属性的数据集构造决策树。 6、决策树可很好地扩展到大型数据库中,它的大小独立于数据库的大小。 缺点: 1、对于各类别样本数量不一致的数据,在决策树中,信息增益的结果偏向于那些具有更多数值的特征。 2、决策树处理缺失数据时的困难。 3、过度拟合问题的出现。 4、忽略数据集中属性之间的相关性。 应用 1、决策树是用二叉树形图来表示处理逻辑的一种工具。可以直观、清晰地表 达加工的逻辑要求。特别适合于判断因素比较少、逻辑组合关系不复杂的情况。 2、决策树提供了一种展示类似在什么条件下会得到什么值这类规则的方法。比如,在贷款申请中,要对申请的风险大小做出判断。 3、决策树很擅长处理非数值型数据,这与神经网络只能处理数值型数据比起来,就免去了很多数据预处理工作等等。 二、K最近邻法(KNN) KNN法即K最近邻法,最初由Cover和Hart于1968年提出的,是一个理论上比较成熟的方法。该方法的思路非常简单直观:如果一个样本在特征空间中的k个最相似(即特征空间中最邻近)的样本中的大多数属于某一个类别,则该样本也属于这个类别。该方法在定类决策上只依据最邻近的一个或者几个样本的类别来决定待分样本所属的类别。KNN方法虽然从原理上也依赖于极限定理,但在类别决策时,只与极少量的相邻样本有关。因此,采用这种方法可以较好地避免样本的不平衡问题。另外,由于KNN方法主要靠周围有限的邻近的样本,而不是靠判别类域的方法来确定所属类别的,因此对于类域的交叉或重叠较多的待分样本集来说,KNN方法较其他方法更为适合。 优点: 1、简单、有效。 2、K最近邻算法是一种非参数的分类技术,在基于统计的模式识别中非常有效,并对未知和非正态分布可取得较高的分类准确率。 3、在类别决策时,只与极少量的相邻样本有关,可以较好地避免样本的不平衡问题。 4、该算法比较适用于样本容量比较大的类域的自动分类,而那些样本容量较小的类域采用这种算法比较容易产生误分。 缺点: 1、KNN算法是建立在VSM模型上的,其样本距离测度使用欧式距离。若各维权值相同,即认定各维对于分类的贡献度相同,显然这不符合实际情况。 2、KNN是懒散的分类算法,对于分类所需的计算均推迟至分类进行,故在其分 编号 南京航空航天大学毕业论文 题目启发式搜索算法在N数码问 题中的应用 学生姓名 学号 学院 专业 班级 指导教师 二〇一三年六月 南京航空航天大学 本科毕业设计(论文)诚信承诺书本人郑重声明:所呈交的毕业设计(论文)(题目:启发式搜索算法在N数码问题中的应用)是本人在导师的指导下独立进行研究所取得的成果。尽本人所知,除了毕业设计(论文)中特别加以标注引用的内容外,本毕业设计(论文)不包含任何其他个人或集体已经发表或撰写的成果作品。 作者签名:年月日 (学号): 启发式搜索算法在N数码问题中的应用 摘要 N数码问题是人工智能领域中的经典问题,N数码可以有效的判断一个搜索算法的优劣。在低阶数码问题中,使用简单的宽搜或深搜就可以解决问题,但在高阶数码中,由于其巨大的搜索规模,我们必须采用更加智能的算法才能解决问题。与传统搜索相比,启发式搜索当前搜索过程中的信息,选择最为可行的状态进行拓展,从而大大提高了搜索的质量和效率。 本文通过建立N数码问题的存储机制和移动规则,使得N数码问题转化为了一个标准的搜索问题。并着重分析了A*算法和遗传算法在N数码中的应用,在A*算法中使用了两种不同的估价函数,目的是比较不同估价函数在N数码问题中的表现。在最后,本文进行了大量实验,综合分析了A*算法和遗传算法在不同规模数据下的优劣。 关键词:启发式搜索,数码问题,A*算法,遗传算法 The Application of Heuristic Search Algorithm on N-Puzzle Problem Abstract N-puzzle problem is a classic problem in artificial intelligence. N-puzzle problem can effectively judge the merits of a search algorithm. In the low order puzzle problem, using a Depth-First-Search or Breadth-First-Search can solve the problem, but in the higher order digital, because of the huge search space area,we must adopt a more intelligent https://www.doczj.com/doc/8118438938.html,pared with the traditional search method, heuristic search uses the information in the search process, and it will choose the most feasible state, thus greatly improves the search quality and efficiency. This paper designs the storage mechanism and movement rules of N-puzzle problem, making the N-puzzle problem transforms to a standard search problem. This paper focuses on the application of A* algorithm and genetic algorithm in N-puzzle problem, and two different evaluation function used in A* algorithm. The objective is to compare the performance of different valuation function in N digital problem. In the end, this paper carries out a large number of experiments, a comprehensive analysis of the A* algorithm and genetic algorithm in different scale of data. Key Words:Heuristic Search;N-puzzle Problem;A* algorithm; Genetic algorithm 运动目标跟踪就是在一段序列图像中的每幅图像中实时地找到所感兴趣的运动目标 (包括位置、速度及加速度等运动参数)。在运动目标跟踪问题的研究上,总体来说有两种思路: a)不依赖于先验知识,直接从图像序列中检测到运动目标,并进行目标识别,最终跟踪感兴趣的运动目标; b)依赖于目标的先验知识,首先为运动目标建模,然后在图像序列中实时找到相匹配的运动目标。 一、运动目标检测 对于不依赖先验知识的目标跟踪来讲,运动检测是实现跟踪的第一步。运动检测即为从序列图像中将变化区域从背景图像中提取出来。运动目标检测的算法依照目标与摄像机之间的关系可以分为静态背景下运动检测和动态背景下运动检测。 静态背景下运动检测就是摄像机在整个监视过程中不发生移动,只有被监视目标在摄像机视场内运动,这个过程只有目标相对于摄像机的运动;动态背景下运动检测就是摄像机在整个监视过程中发生了移动 (如平动、旋转或多自由度运动),被监视目标在摄像机视场内也发生了运动,这个过程就产生了目标与摄像机之间复杂的相对运动。 1、静态背景 背景差分法 背景差分法是利用当前图像与背景图像的差分来检测运动区域的一种技术。它一般能够提供最完全的特征数据,但对于动态场景的变化,如天气、光照、背景扰动及背景物移入移出等特别敏感,运动目标的阴影也会影响检测结果的准确性及跟踪的精确性。其基本思想就是首先获得一个背景模型,然后将当前帧与背景模型相减,如果像素差值大于某一阈值,则判断此像素属于运动目标,否则属于背景图像。背景模型的建立与更新、阴影的去除等对跟踪结果的好坏至关重要。 帧间差分法 相邻帧间差分法是通过相邻两帧图像的差值计算,获得运动物体位置和形状等信息的运动目标检测方法。其对环境的适应性较强,特别是对于光照的变化适应性强,但由于运动目标上像素的纹理、灰度等信息比较相近,不能检测出完整 实验一启发式搜索算法 学号:2220103430 班级:计科二班 姓名:刘俊峰 一、实验内容: 使用启发式搜索算法求解8数码问题。 1、编制程序实现求解8数码问题A *算法,采用估价函数 ()()()()w n f n d n p n ??=+??? , 其中:()d n 是搜索树中结点n 的深度;()w n 为结点n 的数据库中错放的棋子个数;()p n 为结点n 的数据库中每个棋子与其目标位置之间的距离总和。 2、 分析上述⑴中两种估价函数求解8数码问题的效率差别,给出一个是()p n 的上界 的()h n 的定义,并测试使用该估价函数是否使算法失去可采纳性。 二、实验目的: 熟练掌握启发式搜索A * 算法及其可采纳性。 三、实验原理: (一)问题描述 在一个3*3的方棋盘上放置着1,2,3,4,5,6,7,8八个数码,每个数码占一格,且有一个空格。这些数码可以在棋盘上移动,其移动规则是:与空格相邻的数码方格可以移入空格。现在的问题是:对于指定的初始棋局和目标棋局,给出数码的移动序列。该问题称八数码难题或者重排九宫问题。 (二)问题分析 八数码问题是个典型的状态图搜索问题。搜索方式有两种基本的方式,即树式搜索和线式搜索。搜索策略大体有盲目搜索和启发式搜索两大类。盲目搜索就是无“向导”的搜索,启发式搜索就是有“向导”的搜索。 启发式搜索:由于时间和空间资源的限制,穷举法只能解决一些状态空间很小的简单问题,而对于那些大状态空间的问题,穷举法就不能胜任,往往会导致“组合爆炸”。所以引入启发式搜索策略。启发式搜索就是利用启发性信息进行制导的搜索。它有利于快速找到问题的解。 由八数码问题的部分状态图可以看出,从初始节点开始,在通向目标节点的路径上,各节点的数码格局同目标节点相比较,其数码不同的位置个数在逐渐减少,最后为零。所以,这个 深度学习模型剪枝的评述 摘要 近年来,深度神经网络在机器视觉和自然语言处理领域都取得了巨大的成功。然而,要将这些模型部署到诸如机器人芯片、智能手机等微型嵌入式设备上仍是一个巨大的挑战。因此,对于这样的平台,模型压缩是一种降低内存消耗和计算复杂度的合理解决方案,目前处理这一问题的技术手段仍然是模型剪枝,而通道级别的模型剪枝又是最有效的手段之一。因此如何有效的实现通道级别的模型剪枝是至关重要的,并且一直是一个具有大量研究成果的主题。 本文阐述了近年来出现的通道级别模型剪枝的主要技术手段,我们主要讨论各个论文的研究成果和遇到的问题,以及根据共同的特点按类别组织的解决方案列表,并且还列出了各个实验结果之间的比较。 关键词:深度学习,模型压缩,通道剪枝 一.引言 在最近这几年中,深度学习赢得了越来越多的关注,并且促进了非常多领域的突破,这依赖于深度神经网络百万甚至千万级别的参数量,和图形处理器的高速计算能力都起着至关重要的作用。 然而,深度学习模型不管在训练还是在部署到设备上时都存在需要问题。比如,[1]在2012年的ImageNet Challenge中取得了突破性的成果,使用了包含6000万个参数的5个卷积层和3个全连接层的网络。通常需要两到三天的时间在NVIDIA K40机器来训练整个模型的ImagetNet数据集。有时在仅依赖于全连接层的架构中,参数的数量可以增长到数十亿[2]。另一方面,卷积运算消耗了大量的计算资源,而这在移动设备上是非常稀缺的,数十亿的网络参数对于嵌入式设备来说也是高存储开销。以VGG-16模型为例,它拥有超过1.38亿个参数,占用超过500MB的内存空间。同时,224×224图像的分类需要300亿次浮点运算(FLOPs)。显然,将如此大的模型直接部署到嵌入式设备中是不切实际的。 因此,在精度没有明显下降的情况下压缩深度模型是一个关键问题。在这种情况下,许多模型压缩方法也相继被提出。最近的一些压缩和加速方法,包括权值剪枝[3-5]、网络量化[6-8]、低秩近似[9,10]、高效模型设计[11-12]。神经元剪枝方法[3]通过去除一些不那么重要的连接,使权值变得稀疏。网络量化针对存储空间压缩问题,提出了一种降低参数表示精度的网络量化[7]算法。低秩近似[9]利用低秩矩阵技术将权值矩阵分解成几个存储空间较小的小矩阵。但是以上方法或多或少存在一些问题,权值剪枝与网络量化需要特殊的软硬件结合使用才能达到好的效果,低秩近似对于1*1的卷积并无效果。而高效模型设计更多关注设计一些不同的网络模型而不是优化已有的卷积运算或者网络架构来压缩加速。 通道剪枝[4,5]是另一种权值剪枝方法,不同于神经元剪枝。与去除单个神经元连接相比,修剪整个通道有两个优点。首先,它不引入原始网络结构的稀疏性,因此不需要对生成的模型进行特殊的软硬件实现。其次,推理阶段不需要庞大的磁盘存储和运行时内存。 本文综述了近年来通道剪枝在深神经网络的压缩和加速研究进展,这些研究引起了深度 分类算法综述 1 分类算法分类是数据挖掘中的一个重要课题。分类的目的是学会一个分类函数或分类模型(也常常称作分类器),该模型能把数据库中的数据项映射到给定类别中的某一个。分类可用于提取描述重要数据类的模型或预测未来的数据趋势。分类可描述如下:输入数据,或称训练集(Training Set),是一条条的数据库记录(Record)组成的。每一条记录包含若干个属性(Attribute),组成一个特征向量。训练集的每条记录还有一个特定的类标签(Class Label)与之对应。该类标签是系统的输入,通常是以往的一些经验数据。一个具体样本的形式可为样本向量:(v1,v2,…, vn ;c)。在这里vi表示字段值,c表示类别。分类的目的是:分析输入数据,通过在训练集中的数据表现出来的特性,为每一个类找到一种准确的描述或者模型。这种描述常常用谓词表示。由此生成的类描述用来对未来的测试数据进行分类。尽管这些未来的测试数据的类标签是未知的,我们仍可以由此预测这些新 数据所属的类。注意是预测,而不能肯定,因为分类的准确率不能达到百分之百。我们也可以由此对数据中的每一个类有更好的理解。也就是说:我们获得了对这个类的知识。 2 典型分类算法介绍解决分类问题的方法很多,下面介绍一些经典的分类方法,分析 各自的优缺点。 2.1 决策树分类算法决策树(Decision Tree)是一种有向无环图(Directed Acyclic Graphics,DAG)。决策树方法是利用信息论中 的信息增益寻找数据库中具有最大信息量的属性字段,建立决策树的一个结点,在根据该属性字段的 不同取值建立树的分支,在每个子分支子集中重复 建立树的下层结点和分支的一个过程。构造决策树 的具体过程为:首先寻找初始分裂,整个训练集作 为产生决策树的集合,训练集每个记录必须是已经 分好类的,以决定哪个属性域(Field)作为目前最 好的分类指标。一般的做法是穷尽所有的属性域, 对每个属性域分裂的好坏做出量化,计算出最好的 一个分裂。量化的标准是计算每个分裂的多样性(Diversity)指标。其次,重复第一步,直至每个叶 节点内的记录都属于同一类且增长到一棵完整的树。 AlphaBeta剪枝算法 关于AlphaBeta剪枝的文章太多,这个方法是所有其它搜索方法的基础,得多花些时间认真地理解。 先把基本概念再回顾一遍: 节点:在中国象棋中就是一个棋盘的当前局面Board,当然该轮到谁走棋也是确定的。这里的圆形节点表示终止节点,在中国象棋里就是一方被将死的情况(或者到达了搜索的最大深度),后续不会再有着法产生,游戏如果走到这里就会结束。在引擎里通常给红方一个很大的评估值,如+30000,给黑方一个很小的评估值,如-30000,来方便地判断这种结束局面。(胜利局面有稍微不同的表示法,用-30000+层数ply来表示) 连线:表示一步着法Move,通过这步着法后,局面发生变化,先后手也要交换。 层:通常的术语是ply,复数形式是plies,也有称为levels,当然与depth也是对应的。这个术语是为了与比赛里常说的回合相区分,一个回合通常包含2步,这个ply就表示某一方走了一步。根节点记为0层,以下的层数递增。 深度depth:要注意是从下到上的,还是从上到下的。(1)通常的算法书中都是从下到上递增的,即根节点为最大搜索深度,走到最底部的叶子结点为0,这种算法只要记住一个depth 值就可以了。(2)而另一种记法是根部结点为0,越向下depth增加,这时在搜索时就要传递2个参数值,depth和maxDepth,稍微有点啰嗦,应该也会影响一点效率。另外在探查置换表中的结点时,用第(1)种记法也方便一些,因为要知道从当前节点迭代的深度值,否则还要在置换表中保存depth和maxDepth两个值。 AlphaBeta剪枝方法是对Minimax方法的优化,它们产生的结果是完全相同的,只不过运行效率不一样。 这种方法的前提假设与Minimax也是一样的: 1)双方都按自己认为的最佳着法行棋。 2)对给定的盘面用一个分值来评估,这个评估值永远是从一方(搜索程序)来评价的,红方有利时给一个正数,黑方有利时给一个负数。(如果红方有利时返回正数,当轮到黑方走棋时,评估值又转换到黑方的观点,如果认为黑方有利,也返回正数,这种评估方法都不适合于常规的算法描述) 3)从我们的搜索程序(通常把它称为Max)看来,分值大的数表示对己方有利,而对于对方Min来说,它会选择分值小的着法。 但要注意:用Negamax风格来描述的AlphaBeta中的评估函数,对轮到谁走棋是敏感的。 也就是说: 在Minimax风格的AlphaBeta算法中,轮红方走棋时,评估值为100,轮黑方走棋评估值仍是100。 但在Negamax风格的AlphaBeta算法中,轮红方走棋时,评估值为100,轮黑方走棋时评估值要为-100。 近似算法和概率算法的特点与计算方法、分类及概率算法的计算过程 与应用 1.近似算法 1近似算法的计算方法 设D是一个最优化问题,A是一个算法,若把A用于D的任何一个实例I,都能在|I|的多项式时间内得到I的可行解,则称算法A为问题D的一个近似算法,其中|I|表示实例I的规模或输入长度,进而,设实例I的最优值为OP(I),而算法A所得到实例I的可行解之值为A(I),则称算法A解实例I的性能比为R A(I)的性能比为R A(D),同时称D有R A—近似解.其中 A ( I) OP(I) ,若D为最小化问题. R A ( I) = OP(I) ,若D为最大化问题. A ( I) R A(D)=inf{r≥|R A(I)≤r,I∈D} 2近似算法的特点 (1)解同一个问题的近似算法可能有多个 (2)算法的时间复杂性:近似算法的时间复杂性必须是多项式阶的,这是设计近似算法的基本目标。 (3)解的近似程度:近似最优解的近似程度也是设计近似算法的重要目标。近似程度可能与近似算法本身、问题规模,乃至不同的输入实例都有关。 3近似算法的分类 (1)基于线性规划的近似算法 (2)基于动态规划的近似算法 (3)绝对近似类 (4)相对近似类 (5)PTAS类和FPTAS类 (6)随机近似算法 2.概率算法 1概率算法的计算方法 概率算法允许算法在执行的过程中随机选择下一个计算步骤。许多情况下,当算法在执行过程中面临一个选择时,随机性选择常比最优选择省时。 2概率算法的特点 (1)不可再现性。概率算法的一个特点是对所求解问题的同一实例用同一概率算法求解两次可能得到完全不同的效果。 (2)分析困难。要求有概率论、统计学和数论的知识。 3概率算法的分类 (1)数值概率算法。数值概率算法常用于数值问题的求解。这类算法所得到的往往是近似解。而且近似解的精度随计算时间的增加不断提高。在许多情况下,要计算出问题的精确解是不可能或没有必要的,因此用数值概率算法可得到相当满意的解。 (2)蒙特卡罗(Monte Carlo)算法。蒙特卡罗算法用于求问题的准确解。对于许多问题来说,近似解毫无意义。例如,一个判定问题其解 为“是”或“否”,二者必居其一,不存在任何近似解答。又如,我们要求一个整数的因子时所给出的解答必须是准确的,一个整数的近似因子没有任何意义。用蒙特卡罗算法能求得问题的一个解,但这个解未必是正确的。求得正确解的概率依赖于算法所用的时间。算法所用的时间越多,得到正确解的概率就越高。蒙特卡罗算法的主要缺点就在于此。一般情况下,无法有效判断得到的解是否肯定正确。 Monte Carlo 算法偶然会犯错,但它无论对何实例均能以高概率找到正确解。当算法出错时,没有警告信息。偏真偏假的概念只在Monte Carlo 算法里出现。 Def1:设 p 是一个实数,且 1/2 谈搜索算法的剪枝优化 许晋炫 【摘要】本文讨论了搜索算法中“剪枝”这一常见的优化技巧。首先由回溯法解决迷宫问题展开论述,介绍了什么是剪枝;而后分析剪枝的三个原则棗正确、准确、高效,并分别就剪枝的两种思路:可行性剪枝及最优性剪枝,结合例题作进一步的阐述;最后对剪枝优化方法进行了一些总结。 【关键字】搜索、优化、剪枝、时间复杂度 引论 在竞赛中,我们有时会碰到一些题目,它们既不能通过建立数学模型解决,又没有现成算法可以套用,或者非遍历所有状况才可以得出正确结果。这时,我们就必须采用搜索算法来解决问题。 搜索算法按搜索的方式分有两类,一类是深度优先搜索,一类是广度优先搜索。我们知道,深度搜索编程简单,程序简洁易懂,空间需求也比较低,但是这种方法的时间复杂度往往是指数级的,倘若不加优化,其时间效率简直无法忍受;而广度优先搜索虽然时间复杂度比前者低一些,但其庞大的空间需求量又往往让人望而却步。 所以,对程序进行优化,就成为搜索算法编程中最关键的一环。 本文所要讨论的便是搜索算法中优化程序的一种基本方法棗“剪枝”。 什么是剪枝 相信刚开始接触搜索算法的人,都做过类似迷宫这样的题目吧。我们在“走迷宫”的时候,一般回溯法思路是这样的: 1、这个方向有路可走,我没走过 2、往这个方向前进 3、是死胡同,往回走,回到上一个路口 4、重复第一步,直到找着出口 这样的思路很好理解,编程起来也比较容易。但是当迷宫的规模很大时,回溯法的缺点便暴露无遗:搜索耗时极巨,无法忍受。 我们可不可以在向某个方向前进时,先一步判断出这样走会不会走到死胡同里呢?这样一来,搜索的时间不就可以减少了吗? 答案是:可以的。 剪枝的概念,其实就跟走迷宫避开死胡同差不多。若我们把搜索的过程看成是对一棵树的遍历,那么剪枝顾名思义,就是将树中的一些“死胡同”,不能到达我们需要的解的枝条“剪”掉,以减少搜索的时间。 搜索算法,绝大部分需要用到剪枝。然而,不是所有的枝条都可以剪掉,这就需要通过设计出合理的判断方法,以决定某一分支的取舍。在设计判断方法的时候,需要遵循一定的原则。 剪枝的原则 1、正确性 正如上文所述,枝条不是爱剪就能剪的。如果随便剪枝,把带有最优解的那一分支也 启发式搜索——初识A*算法 A*在游戏中有它很典型的用法,是人工智能在游戏中的代表。 A*算法在人工智能中是一种典型的启发式搜索算法,为了说清楚A*算法,先说说何谓启发式算法。 一、何谓启发式搜索算法 在说它之前先提提状态空间搜索。状态空间搜索,如果按专业点的说法,就是将问题求解过程表现为从初始状态到目标状态寻找这个路径的过程。通俗点说,就是在解一个问题时,找到一个解题的过程,应用这个过程可以从求解的开始得到问题的结果。由于求解问题的过程中分支有很多,主要是求解过程中求解条件的不确定性、不完备性造成的,使得求解的路径很多,这样就构成了一个图,我们说这个图就是状态空间。问题的求解实际上就是在这个图中找到一条路径可以从开始到结果。这个寻找的过程就是状态空间搜索。常用的状态空间搜索有深度优先和广度优先。广度优先是从初始状态一层一层向下找,直到找到目标为止。 深度优先是按照一定的顺序,先查找完一个分支,再查找另一个分支,直至找到目标为止。这两种算法在数据结构书中都有描述,可以参看这些书得到更详细的解释。 前面说的广度和深度优先搜索有一个很大的缺陷就是:他们都是在一个给定的状态空间中穷举。这在状态空间不大的情况下是很合适的算法,可是当状态空间十分大,且不可预测的情况下就不可取了。他们的效率实在太低,甚至不可完成。在这里就要用到启发式搜索了。 启发式搜索就是在状态空间中搜索时,对每一个搜索的位置进行评估,得到最好的位置,再从这个位置进行搜索直至找到目标。这样可以省略大量无谓的搜索路径,提高了效率。在启发式搜索中,对位置的估价是十分重要的。采用了不同的估价可以有不同的效果。我们先看看估价是如何表示的。 启发中的估价是用估价函数表示的,如: f(n) = g(n) + h(n) 其中f(n)是节点n的估价函数,g(n)是在状态空间中从初始节点到n节点的实际代价,h(n)是从n节点到目标节点最佳路径的估计代价。在这里主要是h(n)体现了搜索的启发信息,因为g(n)是已知的。 网络社区划分算法 目录 ?1简介 ?2构建一个点击流网络 ?3网络社区划分的两种主要思路:拓扑分析和流分析 ?4拓扑分析 o 4.1计算网络的模块化程度Q-Modularity o 4.2计算网络的连边紧密度Edge betweenness o 4.3计算网络拉普拉斯矩阵的特征向量Leading eigenvector o 4.4通过fast greedy方法搜索网络模块化程度Q-Modularity的最大值 o 4.5通过multi level方法搜索网络模块化程度Q-Modularity的最大值 ?5流分析 o 5.1随机游走算法Walk Trap o 5.2标签扩散算法label propagation o 5.3流编码算法 the Map Equation o 5.4流层级算法 Role-based Similarity ?6总结 []简介 使用许多互联网数据,我们都可以构建出这样的网络,其节点为某一种信息资源,如图片,视频,帖子,新闻等,连边为用户在资源之间的流动。对于这样的网络,使用社区划分算法可以揭示信息资源之间的相关性,这种相关性的发现利用了用户对信息资源的处理信息,因此比起单纯使用资源本身携带的信息来聚类(例如,使用新闻包含的关键词对新闻资源进行聚类),是一种更深刻的知识发现。 假设我们手头有一批用户在一段期间内访问某类资源的数据。为了减少数据数理规模,我们一般只考虑最经常被访问的一批资源。因此在数据处理中,我们考虑UV(user visit)排名前V的资源,得到节点集合|V|,然后对于一个用户i在一段时间内(例如一天)内访问的资源,选择属于|V|的子集vi。如果我们有用户访问资源的时间,就可以按照时间上的先后顺序,从vi中产生vi-1条有向边。如果我们没有时间的数据,可以vi两两间建立联系,形成vi(vi-1)/2条无向边。因为后者对数据的要求比较低,下文中,暂时先考虑后者的情况。对于一天内的n个用户做这个操作,最后将得到的总数为的连边里相同的边合并,得到|M|个不同的边,每条边上都带有权重信息。 这样,我们就得到了V个节点,M条边的一个加权无向网络,反应的是在一天之内用户在主要的信息资源间的流动情况。在这个网络上,我们可以通过社区划分的算法对信息资源进行分类。 分类算法 目录 1.分类算法 (3) 2.典型分类算法 (3) 2.1 决策树分类算法 (3) 2.1.1 算法概述 (3) 2.1.2 算法优缺点 (3) 2.1.3 算法分类介绍 (4) 2.1.3.1 ID3(C4.5)算法 (4) 2.1.3.2 SLIQ分类算法 (4) 2.1.3.3 SPRINT分类算法 (5) 2.2 三种典型贝叶斯分类器 (5) 2.2.1 算法概述 (5) 2.2.2 算法分类介绍 (5) 2.2.2.1 朴素贝叶斯算法 (5) 2.2.2.2 TAN算法 (6) 2.2.2.3 贝叶斯网络分类器 (7) 2.2.3 三类方法比较 (7) 2.3 k-近邻 (8) 2.4 基于数据库技术的分类算法 (9) 2.4.1 MIND算法 (9) 2.4.2 GAC-RDB算法 (9) 2.5 基于关联规则的分类算法 (10) 2.5.1 Apriori算法 (10) 2.6 支持向量机分类 (11) 2.7 基于软计算的分类方法 (11) 2.7.1 粗糙集 (12) 2.7.2 遗传算法 (12) 2.7.3 模糊逻辑 (13) 2.7.4 人工神经网络算法 (14) 2.7.4.1 算法概述 (14) 2.7.4.2 算法优缺点 (14) 2.7.4.3 算法分类 (15) 2.7.4.3.1 BP神经网络分类算法 (15) 2.7.4.3.2 RBF神经网络 (16) 2.7.4.3.3 SOFM神经网络 (17) 2.7.4.3.4 学习矢量化(LVQ)神经网络 (17) 3 其他分类算法 (18) 3.1 LB算法 (18) 3.2 CAEP算法 (18) ISSN 1000-0054CN 11-2223/N 清华大学学报(自然科学版)J T singh ua Un iv (Sci &Tech ),2005年第45卷第S1期 2005,V o l.45,N o.S15/39 1748-1752 最大频繁项集挖掘中搜索空间的剪枝策略 马志新, 陈晓云, 王 雪, 李龙杰 (兰州大学信息科学与工程学院,兰州730000) 收稿日期:2005-05-20 基金项目:国家自然科学基金资助项目(60473095)作者简介:马志新(1973-),男(汉),甘肃,副教授。 E-mail:mazhx@lz https://www.doczj.com/doc/8118438938.html, 摘 要:最大频繁项集挖掘可以广泛应用在多种重要的Web 挖掘工作中。为了有效地削减搜索空间,提出了一种新的最大频繁项集挖掘中的搜索空间剪枝策略。这种策略基于深度优先遍历词典序子集枚举树,利用树中子节点与父节点扩展集中相同项的扩展支持度相等的特性,对搜索空间进行剪枝。应用该策略,对M A FI A 算法进行改进优化。实验结果表明,该剪枝策略可以有效削减搜索空间,尤其在稀疏但包含长频繁项集的数据集上,搜索空间削减掉2/3,算法的时间效率比原M AF IA 算法提高3~5倍。 关键词:W eb 挖掘;最大频繁项集;剪枝策略;搜索空间中图分类号:T P 311文献标识码:A 文章编号:1000-0054(2005)S 1-1748-05 Pruning strategy for mining maximal frequent itemsets MA Zhixin ,CHE N Xiaoyun ,WANG Xue ,LI Lon gjie (School of I nformation Science and Engineering ,Lanzhou University ,Lanzhou 730000,China ) Abstract :M in ing maximal frequent itemsets is a fundamental problem in man y practical w eb m ining ap plications.T his paper presen ts ESEquivPS (exten sion sup por t equivalency pruning strategy),a n ew search space p runing s trategy for mining m axim al frequent itemsets to effectively reduce the s earch s pace.ESE qu ivPS w as based on a depth-first travers al of lexicographic su bset en umer ation tree and uses equivalency of item's ex tension supports to pru ne s earch space.Furthermore,th e M AFIA (m axim al frequen t items et alg or ith m)w as improved by u sing ESEquivPS.T he ex perimental r esu lts show that ES EquivPS can efficiently redu ce the search space.E specially on s pars e dataset w ith longer items ets ,the siz e of search s pace can be trimmed off by 2/3and n ew algorithm runs around three to five times fas ter th an previou s M AFIA algorithm. Key words :w eb m ining; maximal frequent items ets ; pruning strategy;search space 频繁项集挖掘是一类重要的数据挖掘问题,可以广泛应用在客户行为模式分析、网页关联分析、日志分析和网络入侵检测等重要的Web 挖掘工作中。 该问题描述如下:给定事务数据库D ,项目集合I 和用户指定的支持度阈值 ,频繁项集挖掘是在D 中找出支持度大于或等于阈值 的所有项集。 典型的频繁项集挖掘算法是A priori 以及在此基础上的各种改进算法[1],该类算法采用自底向上广度优先的思想,依次计算出所有的频繁1项集,频繁2项集,直到找出所有的频繁项集。当出现大量长的频繁项集时,该类算法代价很高,需要多次扫描数据库并且产生大量的候选项集,对于长度为m 的频繁项集需要枚举出所有可能的2m -2个子集,出现组合问题,导致算法效率低下或无法计算。因此,最大频繁项集挖掘和封闭频繁项集挖掘方法受到该研究领域的重视,先后提出多种重要的最大频繁项集挖掘算法和封闭频繁项集挖掘算法[27]。 如何有效地进行搜索空间剪枝是最大频繁项集挖掘研究工作的一个核心[6]。本文提出了一种新的搜索空间剪枝策略:扩展支持度相等性剪枝策略ESEquivPS (ex tension support equivalency pruning strateg y ),该策略基于词典序子集枚举树,利用树中子节点与父节点的扩展集中相同项的扩展支持度相等的特性,对搜索空间进行削减。该策略可以方便的应用到各种最大频繁项集挖掘算法中,大幅度提高算法的效率。本文结合ESEquivPS 对MA FIA 算法进行了优化改进,并在不同特征的Web 数据集上进行了实验验证。实验结果表明,该剪枝策略可以有效削减搜索空间,改进后的算法效率明显优于原有的MAFIA 算法。 1 最大频繁项集挖掘与搜索空间剪枝策略 最大频繁项集挖掘问题具体描述如下。目标跟踪算法的分类

《人工智能基础》实验报告-实验名称:启发式搜索算法

iSIGHT中优化算法分类

启发式搜索算法解决八数码问题(C语言)

分类算法小结

启发式搜索算法在N数码问题中的应用

目标跟踪算法的分类

实验一 启发式搜索算法

剪枝综述

分类算法综述

AlphaBeta剪枝算法

近似算法的特点与计算方法、分类及概率算法的计算过程与应用

谈搜索算法的剪枝优化

启发式搜索A星算法

网络社区划分算法

分类算法

最大频繁项集挖掘中搜索空间的剪枝策略