JSVM9_15_Encoder函数结构

- 格式:xls

- 大小:93.50 KB

- 文档页数:65

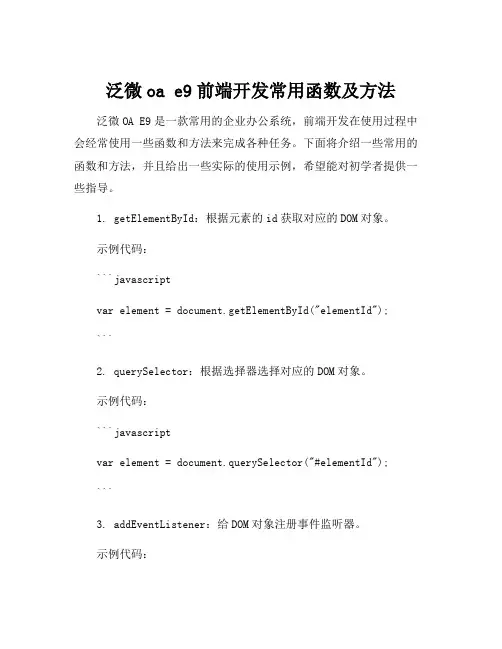

泛微oa e9前端开发常用函数及方法泛微OA E9是一款常用的企业办公系统,前端开发在使用过程中会经常使用一些函数和方法来完成各种任务。

下面将介绍一些常用的函数和方法,并且给出一些实际的使用示例,希望能对初学者提供一些指导。

1. getElementById:根据元素的id获取对应的DOM对象。

示例代码:```javascriptvar element = document.getElementById("elementId");```2. querySelector:根据选择器选择对应的DOM对象。

示例代码:```javascriptvar element = document.querySelector("#elementId");```3. addEventListener:给DOM对象注册事件监听器。

示例代码:```javascriptelement.addEventListener("click", function(){// 操作});```4. fetch:用于发送网络请求并获取响应。

示例代码:```javascriptfetch(url).then(function(response) {return response.text();}).then(function(data) {console.log(data);});```5. JSON.parse:将JSON字符串解析为JavaScript对象。

示例代码:```javascriptvar jsonStr = '{"name":"John", "age":30, "city":"New York"}';var obj = JSON.parse(jsonStr);```6. JSON.stringify:将JavaScript对象转换为JSON字符串。

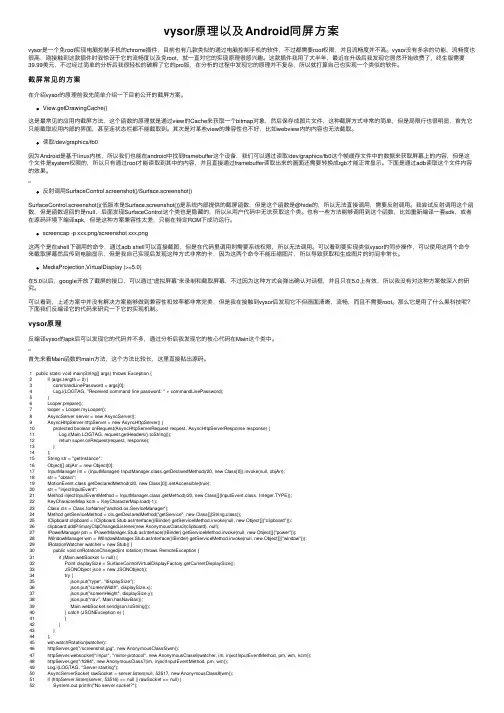

vysor原理以及Android同屏⽅案vysor是⼀个免root实现电脑控制⼿机的chrome插件,⽬前也有⼏款类似的通过电脑控制⼿机的软件,不过都需要root权限,并且流畅度并不⾼。

vysor没有多余的功能,流畅度也很⾼,刚接触到这款插件时我惊讶于它的流畅度以及免root,就⼀直对它的实现原理很感兴趣。

这款插件我⽤了⼤半年,最近在升级后我发现它居然开始收费了,终⽣版需要39.99美元,不过经过简单的分析后我很轻松的破解了它的pro版,在分析的过程中发现它的原理并不复杂,所以就打算⾃⼰也实现⼀个类似的软件。

截屏常见的⽅案在介绍vysor的原理前我先简单介绍⼀下⽬前公开的截屏⽅案。

View.getDrawingCache()这是最常见的应⽤内截屏⽅法,这个函数的原理就是通过view的Cache来获取⼀个bitmap对象,然后保存成图⽚⽂件,这种截屏⽅式⾮常的简单,但是局限⾏也很明显,⾸先它只能截取应⽤内部的界⾯,甚⾄连状态栏都不能截取到。

其次是对某些view的兼容性也不好,⽐如webview内的内容也⽆法截取。

读取/dev/graphics/fb0因为Android是基于linux内核,所以我们也能在android中找到framebuffer这个设备,我们可以通过读取/dev/graphics/fb0这个帧缓存⽂件中的数据来获取屏幕上的内容,但是这个⽂件是system权限的,所以只有通过root才能读取到其中的内容,并且直接通过framebuffer读取出来的画⾯还需要转换成rgb才能正常显⽰。

下⾯是通过adb读取这个⽂件内容的效果。

反射调⽤SurfaceControl.screenshot()/Surface.screenshot()SurfaceControl.screenshot()(低版本是Surface.screenshot())是系统内部提供的截屏函数,但是这个函数是@hide的,所以⽆法直接调⽤,需要反射调⽤。

2020年12月10日第4卷第23期现代信息科技Modern Information TechnologyDec.2020 Vol.4 No.231532020.12收稿日期:2020-11-15基于LSTM-AutoEncoder的水平越权漏洞检测李帅华,孙庆贺,赵明宇(国网电动汽车服务有限公司,北京 100053)摘 要:针对水平越权检测过程中,因无法识别越权场景页面带来的检测误报问题,提出了一种基于深度学习的LSTM-AutoEncoder 无监督预测模型。

该模型利用长短时记忆网络构建自动编码器,提取水平越权场景页面响应数据的文本特征并将其重建还原,统计还原结果与原始页面响应的误差,并根据未知页面的误差阈值判断水平越权的检测结果是否为误报。

通过与One-Class SVM 和AutoEncoder 两种算法的比较,在真实业务数据下进行模型效果测试其有效性,为企业网络业务安全提供了保障。

关键词:LSTM-AutoEncoder 模型;水平越权;深度学习;网络安全;漏洞检测中图分类号:TP393.08文献标识码:A文章编号:2096-4706(2020)23-0153-07Horizontal Privilege Escalation Vulnerability Detection Based onLSTM-AutoEncoderLI Shuaihua ,SUN Qinghe ,ZHAO Mingyu(State Grid Electric Vehicle Service Co.,Ltd.,Beijing 100053,China )Abstract :Aiming at the problem of detecting false positives caused by one ’s inability to identify the page of the unauthorizedscene in the horizon privilege escalation detection process ,an unsupervised prediction model of LSTM-AutoEncoder based on deeplearning is proposed. This model uses LSTM (Long Short-Term Memory )to construct an autoencoder ,which extracts the response data ’s text features of the horizontal privilege escalation scene page and reconstructs it. Then calculates the error between the restored result and the original page response ,and judges whether the horizontal privilege escalation detection result is a false positive based on the error threshold of the unknown page. By comparing the two algorithms of One-Class SVM and AutoEncoder ,the effectiveness of the model is tested under real business data ,which provides a guarantee for the security of corporate network services.Keywords :LSTM-AutoEncoder model ;horizontal privilege escalation ;deep learning ;cyber security ;vulnerability detection0 引 言越权漏洞属于业务逻辑漏洞中的一种,在目前的Web 应用中十分常见。

$vm js写法JavaScript是一种脚本语言,最初是为了给网页添加动态交互效果而设计的。

它是一种高级、解释型的语言,可以直接嵌入到HTML中,也可以作为独立的脚本文件使用。

JavaScript的语法比较简单,但是它具有非常强大的功能。

下面是一些常见的JavaScript写法和最佳实践。

1.使用严格模式(use strict)严格模式可以帮助我们避免一些常见的错误,并且使代码更加规范。

在JavaScript的代码开头添加"use strict"即可开启严格模式。

2.使用块级作用域在ES6之前,JavaScript只有函数作用域,没有块级作用域。

使用let和const关键字可以创建块级作用域,避免变量污染和意外的变量覆盖。

3.使用箭头函数箭头函数是ES6引入的一种新的函数写法,它可以简化函数的定义并且自动绑定this指向。

4.使用模板字符串模板字符串是一种更加灵活和简洁的字符串拼接方式,可以在字符串中插入变量和表达式,使用反引号(`)来定义。

5.使用解构赋值解构赋值是一种快速获取和赋值对象或数组的方式,可以减少代码的冗余和提高可读性。

6.使用Promise和async/await处理异步操作JavaScript是一种单线程语言,但是通过Promise和async/await 可以更好地处理异步操作,避免回调地狱和提高代码的可读性。

7.使用模块化模块化是一种将代码分割成可重用的模块的方式,可以减少代码的复杂度和提高代码的可维护性。

在ES6之后,JavaScript原生支持了模块化的写法,可以使用import和export关键字来导入和导出模块。

8.使用合理的命名和注释良好的命名和注释可以使代码更易于理解和维护。

命名应该具有描述性,注释应该清晰明了,解释代码的用途和逻辑。

9.使用缩进和代码格式化良好的缩进和代码格式化可以提高代码的可读性。

使用合适的缩进和换行,遵循一致的代码风格。

jsvmp动态混淆方案JSVMP(JavaScript Virtual Machine Protection)是一种用于保护JavaScript虚拟机的动态混淆方案。

它通过混淆和加密源代码,防止反向工程和代码破解。

以下是JSVMP动态混淆方案的详细介绍。

1.代码不可读性:JSVMP通过将源代码转换为控制流图(CFG)来混淆代码。

然后,它使用变异技术,如条件分裂和代码展开,将控制流图中的基本块转换为不可读的形式。

这使得反向工程师很难理解和重建原始代码的逻辑。

2.函数重命名:JSVMP采用函数重命名技术来混淆代码。

它将函数名称替换为随机生成的字符串,并使用引用重定向来确保代码的正确执行。

这种方式防止了通过查找和分析特定函数名称来理解代码的尝试。

3.字符串加密:JSVMP通过字符串加密来保护敏感信息。

它使用加密算法对字符串进行加密,并将其存储在加密的形式下。

在运行时,代码会根据需要解密字符串,以避免直接暴露敏感信息。

4.控制流混淆:JSVMP通过改变代码的控制流来混淆代码逻辑。

它使用条件分裂、循环展开、插入虚假代码等技术,使代码的控制流变得复杂和困惑。

这样做可以使反向工程师难以跟踪代码的执行路径和逻辑。

5.数据混淆:JSVMP通过数据混淆技术来保护敏感数据。

它使用加密算法对数据进行加密,并在运行时根据需要进行解密。

这样可以防止敏感数据在代码中的明文形式被泄露。

6.运行时检测:JSVMP在代码中插入运行时检测代码,以便在代码被篡改或非法使用时发出警报。

这可以帮助保护代码免受恶意攻击,并增加代码的安全性。

7.恶意代码检测:JSVMP使用静态和动态分析方法来检测和阻止恶意代码的执行。

它使用模式匹配和行为分析等技术来识别恶意代码,并在运行时阻止其执行,以保护系统免受恶意软件的侵害。

总之,JSVMP动态混淆方案采用了多种技术来保护JavaScript虚拟机。

它通过混淆和加密源代码、改变代码的控制流和保护敏感数据等方式来防止反向工程和代码破解。

jsvmp动态混淆方案JSVMP(JavaScript Virtual Machine Protection)是一种动态混淆方案,旨在保护JavaScript代码的安全性和保密性。

JSVMP通过对JavaScript代码进行混淆和加密,使其难以被逆向工程师和黑客理解和修改,从而提高JavaScript程序的安全性。

动态混淆是指在代码运行时对代码进行混淆处理,使代码在运行时动态地解密和执行。

与静态混淆不同,动态混淆方案在代码执行过程中会根据一定的规则和算法对代码进行解密和重组,使代码逻辑变得更加复杂和难以理解。

JSVMP的核心思想是将JavaScript代码分为多个函数模块,并对每个函数模块进行加密和混淆处理。

在代码运行时,JSVMP会根据一定的解密算法将加密的函数模块解密出来,并按照一定的规则进行动态重组和执行。

这样,即使黑客获取了加密后的代码,也很难理解其逻辑和进行修改。

JSVMP采用了多种加密和混淆技术,包括字符串加密、代码重组、变量重命名、函数内联等。

字符串加密是将JavaScript代码中的字符串进行加密处理,使其在运行时动态解密。

代码重组是将JavaScript代码中的函数模块进行重组,使其执行顺序变得随机和混乱,增加了代码的复杂性。

变量重命名是将JavaScript代码中的变量名进行随机化处理,使其难以被理解和修改。

函数内联是将小函数内联到调用处,减少函数调用的开销和代码的可读性。

JSVMP的优点是能够有效地保护JavaScript代码的安全性和保密性。

通过动态混淆和加密,JSVMP使JavaScript代码在运行时变得复杂和难以理解,从而增加了逆向工程的难度。

同时,JSVMP还提供了多种配置选项,可以根据实际需求对代码进行定制化的混淆和加密处理。

然而,JSVMP也存在一些局限性。

首先,由于动态混淆需要在代码运行时进行解密和重组,会增加代码的执行时间和资源消耗。

其次,由于动态混淆是一种运行时的处理方式,无法完全避免代码被逆向工程师进行动态调试和分析。

js中escape的⽤法----前端页⾯简单加密escape() ⽅法,它⽤于转义不能⽤明⽂正确发送的任何字符。

⽐如,电话号码中的空格将被转换成字符 %20,从⽽能够在 URL 中传递这些字符。

alert(s);js对⽂字进⾏编码涉及3个函数:escape,encodeURI,encodeURIComponent,相应3个解码函数:unescape,decodeURI,decodeURIComponent1、传递参数时需要使⽤encodeURIComponent,这样组合的url才不会被#等特殊字符截断。

2、进⾏url跳转时可以整体使⽤encodeURI3、 js使⽤数据时可以使⽤escape例如:搜藏中history纪录。

4、 escape对0-255以外的unicode值进⾏编码时输出%u****格式,其它情况下escape,encodeURI,encodeURIComponent编码结果相同。

最多使⽤的应为encodeURIComponent,它是将中⽂、韩⽂等特殊字符转换成utf-8格式的url编码,所以如果给后台传递参数需要使⽤encodeURIComponent时需要后台解码对utf-8⽀持(form中的编码⽅式和当前页⾯编码⽅式相同)escape不编码字符有69个:*,+,-,.,/,@,_,0-9,a-z,A-ZencodeURI不编码字符有82个:!,#,$,&,',(,),*,+,,,-,.,/,:,;,=,?,@,_,~,0-9,a-z,A-ZencodeURIComponent不编码字符有71个:!, ',(,),*,-,.,_,~,0-9,a-z,A-Zescape(str) ⽅法,它⽤于转义不能⽤明⽂正确发送的任何字符。

⽐如,电话号码中的空格将被转换成字符 %20,从⽽能够在 URL 中传递这些字符如果需要发送安全信息或 XML,可能要考虑使⽤ send() 发送内容(本系列的后续⽂章中将讨论安全数据和 XML 消息)。

encoder-decoder结构

Encoder-Decoder结构是一种深度学习架构,用于机器学习中的自然语言处理(NLP)。

它利用一个独特的架构,将不同语义层次编码并解码到另一种语言。

Encoder-Decoder结构由两个主要组件组成:编码器和解码器。

编码器是一个神经网络,用来将一段句子或文本从一种语言编码为一系列向量,这些向量代表了句子中的语义层次。

解码器再次使用神经网络,将这些向量解码成另一种语言的句子。

由于句子的不同抽象层次,语义中的模糊之处也会在向量中反映出来,因此,解码器被授予灵活性,以便根据上下文和其他信息来选择最佳的输出结果。

Encoder-Decoder结构的优势之一在于,它可以很好地处理嵌入式或注意力数据,而不需要手动提供特征或进行特征工程。

它也可以有效地处理不定长序列问题,如自动文摘生成、对话系统和机器翻译。

Encoder-Decoder结构也可以扩展到多个任务中,如,使用混合模型包括编码器在计算图像描述、情感分类和词性标注等任务时,可能会取得更好的结果。

总的来说,Encoder-Decoder 结构是一种非常有效的深度学习架构,可以有效地处理NLP问题,并且它还可以扩展到多个任务中。

JSJSPJava中URL参数的转义

1、

URLEncoder.encode

URLDecoder.decode

2、

2.1、encodeURIComponent :

返回值

URIstring 的副本,其中的某些字符将被⼗六进制的转义序列进⾏替换。

说明

该⽅法不会对 ASCII 字母和数字进⾏编码,也不会对这些 ASCII 标点符号进⾏编码: - _ . ! ~ * ' ( ) 。

其他字符(⽐如:;/?:@&=+$,# 这些⽤于分隔 URI 组件的标点符号),都是由⼀个或多个⼗六进制的转义序列替换的。

提⽰和注释

提⽰:请注意 encodeURIComponent() 函数与 encodeURI() 函数的区别之处,前者假定它的参数是 URI 的⼀部分(⽐如协议、主机名、路径或查询字符串)。

因此 encodeURIComponent() 函数将转义⽤于分隔 URI 各个部分的标点符号。

2.2、encodeURI :

返回值

URIstring 的副本,其中的某些字符将被⼗六进制的转义序列进⾏替换。

说明

该⽅法不会对 ASCII 字母和数字进⾏编码,也不会对这些 ASCII 标点符号进⾏编码: - _ . ! ~ * ' ( ) 。

该⽅法的⽬的是对 URI 进⾏完整的编码,因此对以下在 URI 中具有特殊含义的 ASCII 标点符号,encodeURI() 函数是不会进⾏转义的:;/?:@&=+$,#

提⽰和注释

提⽰:如果 URI 组件中含有分隔符,⽐如 ? 和 #,则应当使⽤ encodeURIComponent() ⽅法分别对各组件进⾏编码。

3、。

在深度学习领域中,encoder-decoder结构是一种常见的神经网络架构,它在进行序列到序列的学习和生成任务上具有很好的效果。

在本文中,我们将深入探讨encoder-decoder结构的原理、应用和优点,以便更全面地理解这一重要的神经网络架构。

1. 原理在encoder-decoder结构中,encoder和decoder是两个独立的神经网络模块,它们分别负责将输入序列编码成一个固定长度的向量表示,以及将这个向量表示解码为输出序列。

通常,encoder使用循环神经网络(RNN)或者长短时记忆网络(LSTM)来处理输入序列,而decoder也使用相似的结构来生成输出序列。

这种结构可以很好地处理不定长的输入输出序列,例如机器翻译和对话系统等任务。

2. 应用encoder-decoder结构在机器翻译、问答系统、语音识别和图像描述等任务中都得到了广泛的应用。

在机器翻译中,encoder负责将源语言句子编码成一个语义表示,而decoder则将这个表示解码为目标语言句子。

类似地,在问答系统中,encoder将问题编码成一个向量表示,decoder将这个向量表示解码为答案。

这种结构简洁高效,能够很好地捕捉序列数据的信息。

3. 优点相比传统的n-gram语言模型和统计机器翻译等方法,encoder-decoder结构具有很多优点。

它可以端到端地进行端到端的训练和端到端的生成,避免了传统方法中的串行处理和人工特征设计。

通过使用深度学习模型,encoder-decoder结构能够学习到更复杂的语言和语义表示,具有更好的泛化能力。

另外,由于encoder和decoder是独立的模块,因此可以方便地对它们进行优化和改进,使得整个网络更加灵活和高效。

总结与展望encoder-decoder结构是一种非常有用的深度学习架构,它在序列到序列的学习和生成任务中具有很好的效果。

通过将输入序列编码成一个固定长度的向量表示,再将这个表示解码为输出序列,encoder-decoder结构能够很好地处理序列数据。

深度学习及其应用_复旦大学中国大学mooc课后章节答案期末考试题库2023年1.GAN中的Mode Collapse问题是指什么?答案:生成器只生成少数几种样本2.有关循环神经网络(RNN)变种的说法哪些是正确的?答案:RNN的变种增加了网络的复杂性,训练过程难度一般会大一些。

_RNN的变种可以在某些方面改进RNN的不足,例如减少梯度消失、输入句子词汇上文文语义获取等_这些RNN的变种结构都有一定的调整,但大多都可以处理时序数据的分类或预测问题。

3.以下说法错误的有哪些?答案:类似VGG、GoogLeNet等网络,AlexNet采用了卷积块的结构。

_为了获得不同尺度的特征,GoogLeNet采用了1X1,3X3,7X7等不同尺度的卷积核。

_ResNet卷积神经网络使用了批量标准化(BN)增加了网络的训练稳定性,并像VGG算法利用了skip链接减少信息的损失。

4.循环神经网络一般可以有效处理以下哪些序列数据?答案:随时间变化的数值型参数_声音_文本数据5.循环神经网络的损失函数是所有时刻的输出误差之和。

答案:正确6.长短期记忆网络(LSTM)通过遗忘门减少一般循环神经网络(RNN)的短期记忆不足,但增加算法的计算复杂度。

答案:正确7.循环神经网络的深度是由RNN cell的时刻数量,或者是隐层的数量确定的,2种说法都有一定的道理。

答案:正确8.循环神经网络(RNN)每一个时间步之间的迁移中使用了共享参数(权重等),与前馈神经网络比较更不容易引起梯度消失问题答案:错误9.以下有关生成对抗网络的说法哪个是错误的?答案:生成器和判别器的代价函数在训练过程中是同时优化的10.有关生成对抗网络(GAN)的代价函数,下面哪个说法是错误的?答案:一般来说,GAN通过训练总能达到代价函数的极小值11.在目标检测算法中,IoU(Intersection over Union)主要用于?答案:度量检测框和真实框的重叠程度12.下面哪种情况可能不能使用生成对抗网络实现?答案:机器人取名字13.对于生成对抗网络(GAN)的训练,下面哪个说法是正确的?答案:如果判别器发生了过拟合,那么生成器可能会生成一起很奇怪的样本14.在DCGAN中,判别器的激活函数可以使用Leaky ReLU,而不采用Sigmoid的原因是以下哪个?答案:防止判别器在训练过程中发生梯度消失,降低鉴别器的能力15.有关生成器和判别器的代价函数,以下哪个说法是错误的?答案:通过一同调整生成器和判别器的权重等参数,达到两者总的代价函数平衡16.有关生成器和判别器的交叉熵代价函数,以下哪个说法是错误的?答案:当训练生成器时,希望判别器的输出越逼近0越好17.有关获得较高质量生成样本的隐向量z的说法,下面说法错误的是哪个?答案:可以随机取值18.与卷积神经网络不同,循环神经网络因为固有的时序性,很难在GPU上做并行训练。

网络安全1+X试题库(含答案)一、单选题(共10题,每题1分,共10分)1、入侵检测是一门新兴的安全技术,是作为继________之后的第二层安全防护措施( )。

A、防火墙B、路由器C、服务器D、交换机正确答案:A2、关于上传漏洞与解析漏洞,下列说法正确的是( )。

A、只要能成功上传就一定能成功解析B、两个漏洞没有区别C、从某种意义上来说,两个漏洞相辅相成D、上传漏洞只关注文件名正确答案:C3、关于web目录扫描的原因,以下说法错误的是哪一项( )?A、寻找网站管理后台。

B、寻找未授权界面。

C、寻找网站更多隐藏信息。

D、以上说法均不正确。

正确答案:D4、不属于API逻辑漏洞的是( )。

A、参数校验B、文件上传C、未加密风险D、短信邮箱炸弹正确答案:B5、Windows服务器操作系统安全设置加固方法说法错误的( )A、配置ip策略防火墙B、系统打上补丁C、设置复杂的口令D、清理系统垃圾文件正确答案:D6、列关于联合查询语法格式的说法不正确的有( )。

A、选项[ALL]可以使输出结果保存全部行,忽略则自动删除重复行B、结果集中的列名来自第一个查询语句C、如果包含ORDERBY子句,将对最后的结果集排序D、所有查询中的列名和列顺序必须完全相同正确答案:D7、攻击者截获并记录了从A到B的数据,然后又从早些时候所截获的数据中提取出信息重新发往B称为?( )A、中间人攻击B、口令猜测器和字典攻击C、强力攻击D、回放攻击正确答案:D8、使用nmap扫描器命令“nmap –sS –Pn –O -p 80 ip”对系统指纹进行识别,其中哪一项是系统指纹识别的参数选项( )?A、“-sS”B、“-Pn”C、“-p”D、“-O”正确答案:D9、如果企业发生了大量安全事件,超出信息安全团队的处理能力,说明企业什么工作没有做好( )A、团队响应慢、效率低B、实时监控分析C、安全预防不到位D、处理流程不简洁正确答案:C10、下面不属于端口扫描技术的是( )?A、TCP connect扫描攻B、TCP FIN扫描C、IP包分段扫描D、Land扫描正确答案:D二、多选题(共70题,每题1分,共70分)1、关于PHP session反序列化漏洞说法错误的有( )。

JavaScript的⼯作原理:解析、抽象语法树(AST)+提升编译速度5个技巧这是专门探索 JavaScript 及其所构建的组件的系列⽂章的第 14 篇。

如果你错过了前⾯的章节,可以在这⾥找到它们:-概述我们都知道运⾏⼀⼤段 JavaScript 代码性能会变得很糟糕。

这段代码不仅需要通过⽹络传输,⽽且还需要解析、编译成字节码,最后执⾏。

在之前的⽂章中,我们讨论了 JS 引擎、运⾏时和调⽤堆栈等,以及主要由⾕歌 Chrome 和 NodeJS 使⽤的V8引擎。

它们在整个 JavaScript 执⾏过程中都发挥着⾄关重要的作⽤。

这篇说的抽象语法树同样重要:在这我们将了解⼤多数 JavaScript 引擎如何将⽂本解析为对机器有意义的内容,转换之后发⽣的事情以及做为 Web 开发者如何利⽤这⼀知识。

编程语⾔原理那么,⾸先让我们回顾⼀下编程语⾔原理。

不管你使⽤什么编程语⾔,你需要⼀些软件来处理源代码以便让计算机能够理解。

该软件可以是解释器,也可以是编译器。

⽆论你使⽤的是解释型语⾔(JavaScript、Python、Ruby)还是编译型语⾔(c#、Java、Rust),都有⼀个共同的部分:将源代码作为纯⽂本解析为抽象语法树(abstract syntax tree, AST) 的数据结构。

AST 不仅以结构化的⽅式显⽰源代码,⽽且在语义分析中扮演着重要⾓⾊。

在语义分析中,编译器验证程序和语⾔元素的语法使⽤是否正确。

之后,使⽤ AST 来⽣成实际的字节码或者机器码。

抽象语法树(abstract syntax tree 或者缩写为 AST),或者语法树(syntax tree),是源代码的抽象语法结构的树状表现形式,这⾥特指编程语⾔的源代码。

和抽象语法树相对的是具体语法树(concrete syntaxtree),通常称作分析树(parse tree)。

⼀般的,在源代码的翻译和编译过程中,语法分析器创建出分析树。

360 1+x证书模拟题库含答案1、(单选题)在网络上,为了监听效果最好,监听设备不应放在?A、网关B、路由器C、中继器D、防火墙答案:C2、下列关于OllyICE说法不正确的一项是A、可以反汇编B、可以调试javaC、可以调试C#可以查看程序中用到的字符串答案:B3、(单选题)下面哪个选项不是NAT技术具备的优点?A、保护内部网络B、节省合法地址C、提高连接到因特网的速度D、提高连接到因特网的灵活性答案:C4、利用ntp进行DDOS攻击的反射器不可能来自于A、企业的服务器B、政府机构提供的时钟服务器C、个人PCD、互联网上的路由器答案:C5、(单选题) print 'aaa' > 'Aaa'将返回?A、 TRUEB、 FALSEC、 SyntaxError: invalid syntaxD、 1答案:A6、入侵检测系统的第一步是?A、信号分析B、信息收集C、数据包过滤D、数据包检查答案:B7、()利用以太网的特点,将设备网卡设置为“混杂模式”,从而能够接受到整个以太网内的网络数据信息?A、嗅探程序B、木马程序C、拒绝服务攻击D、缓冲区溢出攻击木马答案:A8、单选题)这节实验课搭建的是哪种管理机制?A、cookie-base的管理方式B、基于server端session的管理方式C、token-base的管理方式D、基于server端cookie的管理方式答案:B9、文件解析漏洞一般结合什么漏洞一起使用?A、CMSB、文件上传C、命令执行D、xss答案:B10、单选题) session_destroy()的作用是?A、彻底销毁sessoinB、销毁一个零时sessionC、销毁session中的一个值D、销毁一个永久session答案:A11、以下哪项一般不存在默认账户A、数据库软件B、CMS内容管理系统C、路由器管理界面D、个人邮箱答案:D12、下面关于while和do-while循环的说法中,正确的是?A、与do-while语句不同的是,while语句的循环体至少执行一次B、do-while语句首先计算终止条件,当条件满足时,才去执行循环体中的语句C、两种循环除了格式不同外,功能完全相同D、以上答案都不正确答案:D13、针对无线局域网WPA2加密协议的KRACK(Key Reinstallation Attack)攻击思想是A、针对无线局域网WPA2加密协议的KRACK(Key Reinstallation Attack)攻击思想是B、攻击者通过在 Wi-Fi 范围内利用中间人的手段对WPA2协议的四次握手交互验证的第三阶段进行破解C、利用WPA2所使用的对称加密算法的脆弱性进行破解D、攻击者通过在 Wi-Fi 范围内利用中间人的手段对WPA2协议的四次握手交互验证的第一阶段进行破解答案:B14、(单选题)哪个关键词可以在python中进行处理错误操作?A、 tryB、 B. catchC、 finderrorD、 Error答案:A15、下列属于敏感服务未做限制的是A、 mysql使用增强复杂密码B、redis使用空密码C、关闭445端口D、限制访问Apache用户答案:B16、(单选题)网络监听(嗅探)的这种攻击形式破坏了下列哪一项内容()A、网络信息的抗抵赖性B、网络信息的保密性C、网络服务的可用性D、网络信息的完整性答案:B17、以下可用于CHM文件制作的工具是哪一个选项?A、 WinhexB、 EasyCDC、 EasyCHMD、 VMWare答案:C18、(单选题) POP3服务器使用的监听端口是(A、TCP的25端口B、 TCP的110端口C、UDP的25端口D、 UDP的110端口答案:B19、(单选题)关于shodan扫描的描述错误的是哪一选项?A、常用的物联网搜索引擎之一B、开发了很对种API接口C、能够对IPV6进行扫描D、忽视了针对域名的扫描答案:C20、 Iptables防火墙进行地址转换在哪个表里面?A、 rawB、 mangleC、 natD、 filter答案:C21、(单选题) XSS不能来干什么?A、钓鱼B、劫持用户会话C、DDOSD、注入数据库答案:D22、理论上讲,哪种攻击方式可以破解所有密码问题?A、弱口令攻击B、穷举攻击C、字典攻击D、万能密码答案:B23、(单选题)下面那种身份标识安全性较高?(10分)A、15位密码B、工卡C、. 动态口令D、指纹答案:D24、“网站在上线的时候都忘记把测试时的接口进行关闭,从而导致这个接口可以查询大量用户信息”,该情况属于以下哪种维度的收集种类?A、测试接口信息泄露B、越权C、 web搜索D、威胁情报答案:A25、哪个关键字可以在python中定义函数?A、 dcfB、 defC、 classD、 D. public答案:B26、关于函数,下面哪个说法是错误的?A、函数必须有参数B、函数可以有多个函数C、函数可以调用本身D、函数内可以定义其他函数答案:A27、(单选题)以下说法错误的是?A、会话劫持可以使攻击者伪装成目标登录B、中间人攻击与窃取cookie的攻击原理相同C、httponly可以让xss漏洞也拿不走用户cookie答案:B28、(单选题) print 2.0==1+1将返回?A、 TRUEB、 FALSEC、 SyntaxError: invalid syntax答案:A29、DNS的哪种查询被用来当成反射器放大流量A、NS记录查询B、互联网基础设施的防御C、A记录查询D、ANY 查询答案:D30、(单选题)在TCP/IP参考模型中,与OSI参考模型的网络层对应的是()A、主机-网络层B、传输层C、互联网层D、应用层答案:C31、(单选题) TCP协议建立连接需要几次握手?A、2B、3C、4D、5答案:B32、(单选题)下列关于nslookup说法错误的是哪一项A、nslookup是用来监测网络中DNS服务器是否可以实现域名解析的工具B、利用nslookup可以获取域名对应的ipC、与ping的区别在于,nslookup返回的结果更丰富,而且主要针对dns 服务器的排错,收集dns服务器的信息D、nslookup只能在linux系统中使用答案:D33、APT攻击概念中的APT对应的中文含义是?()。

$vm js写法全文共四篇示例,供读者参考第一篇示例:Vue.js是一种流行的JavaScript框架,它是一种用于构建交互式和动态用户界面的前端框架。

在Vue.js中,vm是一个重要的概念,它代表着Vue实例。

vm是Vue实例的一个引用,可以通过它来访问Vue 实例的属性和方法。

在Vue.js中,我们通常使用new Vue()来创建一个Vue实例,然后可以通过vm来访问这个实例。

vm是一个指向Vue实例的引用,通过它我们可以操作Vue实例的数据、方法和生命周期钩子。

在Vue实例中,我们可以定义data属性来绑定数据,methods属性来定义方法,以及created、mounted等生命周期钩子来处理实例的生命周期事件。

vm的使用非常灵活,可以在Vue实例中的任何地方使用它。

我们可以在methods中使用vm来访问Vue实例的数据,或者在created 钩子中使用vm来执行一些初始化操作。

vm是一个非常强大的工具,可以帮助我们更方便地操作Vue实例和处理页面逻辑。

除了vm,Vue.js还提供了一些其他方便的工具和功能,比如refs、nextTick等。

refs可以用来获取DOM元素或子组件的引用,nextTick可以用来在DOM更新之后执行一些操作。

这些工具和功能都能够帮助我们更好地构建和管理Vue应用。

vm是Vue.js中一个非常重要的概念,它代表了Vue实例,可以帮助我们更方便地操作Vue实例和处理页面逻辑。

通过vm,我们可以更加灵活地访问和操作Vue实例,从而更好地构建交互式和动态的用户界面。

希望本文能够帮助大家更好地理解和应用vm这个概念,提升Vue.js的开发效率和质量。

第二篇示例:vm 是Vue.js 的实例,它代表了Vue 实例的数据和方法。

在Vue.js 中,我们经常会使用vm 来访问实例中的数据和方法以及操作DOM 元素。

vm.data 中存储了实例中定义的所有data 数据,我们可以通过vm.data.key 的方式来访问特定的数据。

java中的URLEncoder.encode对应JS中⽤decodeURICompone。

⽤get请求传中⽂,经常搞到乱码,这⼏天搞搞这个东西,总结⼀下,以⽅便以后处理这类的问题。

代码中的URLEncoder.encode⽅法和JS的encodeURIComponent功能差不多,它会将处字母和数字,以及*字符外的都编码成%xx形式。

JS的unescape和decodeURI都不能⽤来解码JAVA中URLEncoder.encode编码的字符串。

在JAVA代码中的URLEncoder.encode的字符串可以在JS中⽤decodeURIComponent还原成字符串。

在JAVA代码中可以⽤URLDecoder.decode(request.getParameter("param"),"UTF-8")来将在JS中⽤encodeURIComponent的参数还原成字符串。

========================================================1、decodeURI()定义和⽤法:decodeURI() 函数可对 encodeURI() 函数编码过的URI 进⾏解码。

语法:decodeURI(URIstring)参数描述:URIstring 必需。

⼀个字符串,含有要解码的 URI 或其他要解码的⽂本。

返回值:URIstring 的副本,其中的⼗六进制转义序列将被它们表⽰的字符替换。

2、encodeURI ⽅法将⽂本字符串编码为⼀个有效的统⼀资源标识符 (URI)。

encodeURI(URIString)必选的 URIString 参数代表⼀个已编码的 URI。

说明encodeURI ⽅法返回⼀个编码的 URI。

如果您将编码结果传递给 decodeURI,那么将返回初始的字符串。

encodeURI ⽅法不会对下列字符进⾏编码:":"、"/"、";" 和 "?"。

java中类似jsencodeURIComponent函数的实现案例我就废话不多说了,⼤家还是直接看代码吧~import java.io.UnsupportedEncodingException;import .URLDecoder;import .URLEncoder;/*** Utility class for JavaScript compatible UTF-8 encoding and decoding.** @see /questions/607176/java-equivalent-to-javascripts-encodeuricomponent-that-produces-identical-output* @author John Topley*/public class EncodingUtil {/*** Decodes the passed UTF-8 String using an algorithm that's compatible with* JavaScript's <code>decodeURIComponent</code> function. Returns* <code>null</code> if the String is <code>null</code>.** @param s The UTF-8 encoded String to be decoded* @return the decoded String*/public static String decodeURIComponent(String s) {if (s == null) {return null;}String result = null;try {result = URLDecoder.decode(s, "UTF-8");}// This exception should never occur.catch (UnsupportedEncodingException e) {result = s;}return result;}/*** Encodes the passed String as UTF-8 using an algorithm that's compatible* with JavaScript's <code>encodeURIComponent</code> function. Returns* <code>null</code> if the String is <code>null</code>.** @param s The String to be encoded* @return the encoded String*/public static String encodeURIComponent(String s) {String result = null;try {result = URLEncoder.encode(s, "UTF-8").replaceAll("\\+", "%20").replaceAll("\\%21", "!").replaceAll("\\%27", "'").replaceAll("\\%28", "(").replaceAll("\\%29", ")").replaceAll("\\%7E", "~");}// This exception should never occur.catch (UnsupportedEncodingException e) {result = s;}return result;}/*** Private constructor to prevent this class from being instantiated.*/private EncodingUtil() {super();}}补充知识:java 代码实现encodeURIComponent和decodeURIComponent,解决空格转义为加号的问题java⾃带有⼀个 .URLDecoder和.URLEncoder。

main( int argc, char** argv)H264AVCEncoderTest::create( pcH264AVCEncoderTest )pcH264AVCEncoderTest->init( argc, argv )pcH264AVCEncoderTest->go()===== initialization =====编码参数初始化===== write parameter sets =====写序列参数集,在没有写SPS和===== determine parameters for required frame buffers =====for( uiLayer = 0; uiLayer < uiNumLayers; uiLayer++ ){}===== loop over frames =====for( uiFrame = 0; uiFrame < uiMaxFrame; uiFrame++ )===== get picture buffers and read original picturfor( uiLayer = 0; uiLayer < uiNumLayers; uiLayer++===== call encoder =====//每两个图像调用一次,但是m_pcH264AVCEncoder->process( cOutExtBinDataAccessoapcOriginalPicBuffer,apcReconstructPicBuffacPicBufferOutputListacPicBufferUnusedList//分AVC和SVC两种模式//SVC模式下有:m_pcH264AVCEncoder->process( rcExapcOapcRapcPapcP===== fill lists =====uiHighestLayer = m_pcCfor( UInt uiLayer = 0;{}===== encoding of GOif ( m_acOr{主要编码函数---->> RNOK( x}===== update data accessor listm_cAccessUnitDataList.到此m_pcH264AVCEncoder->process结束===== write and release NAL unit buffers =====xWrite ( acPicBufferOutputList[uiLayer], uiLayerxRelease( acPicBufferUnusedList[uiLayer], uiLayer===== write and release reconstructed pictures ===循环完uiMaxFrame后往下跳===== finish encoding =====//===== encode GOP =====xProcessGOP( apcPicBuff//===== update data accessor list =====//===== finish encoding =====m_apcLayerEncoder[uiLayer-1]-===== write and release NAL unit buffers ========== write and release reconstructed pictures ========== set parameters and output summary =====//到此go()函数结束以下为第38行的函数另起一行H264AVCEncoder::xProcessGOP( apcPicBufferOutputList, apcPicBufferUnusedLis===== init GOP =====//分层设置LayerCGSSNR,QualityLevelCGSSNR,BaseLayerCGSSNR,for( uiLayer = 0; uiLayer < m_pcCodingParameter->getNumberOfLayers(); uiLayer++ )===== loop over access units in GOP, and layers inside access units =====分图像,分层处for( uiAUIndex = 0; uiAUIndex <= 64; uiAUIndex++ ){for( uiLayer = 0; uiLayer < m_pcCodingParameter->getNu{LayerEncoder::m_apcLayerEncoder[uiLayer]->process(m_cAccessUnm_acOrgPicBm_acRecPicBapcPicBuffem_pcParamet到此for( uiAUIndex = 0; uiAUIndex <= 64; uiAUIndex++ )结束xCalMaxBitrate(uiLayer)//1140行===== update pic buffer lists =====分层更新图像缓存//1145行----- set output list ---------- update unused list ---------- reset lists -----到此xProcessGOP函数结束以下为第147行的函数另起一行m_pcSliceEncoder->encodeIntraPicture ( uiBits,rcControlData,pcFrame,pcResidual,pcBaseLayerFrame,pcPredSignal,m_uiFrameWidthInMb,rcControlData.getLambda(),ePicType )====== initialization ============ initialization =========== loop over macroblocks =====pcMbDataCtrl ->initMb ( pcMbDataAccess, uiMbY, uiMbX )----- get co-located MbIndex -----m_pcMbEncoder ->encodeIntra ( *pcMbDataAccess,pcMbDataAccessBase,pcFrame ->getPic( ePicType )pcFrame ->getPic( ePicType )pcRecSubband ->getPic( ePicTdLambda,dCost)===== INTRA_BL ========== spatial intra modes ========== check normal intra modes (if base layer or axEstimateMbIntra16( m_pcIntMbTempData, m_pcIntMbBe----- init intra prediction -----// Make sure the uiPredMode is equal to tm_pcIntraPrediction->predictSLumaMb( rpcMm_pcTransform->transformMb16x16( m_pcIntOxForTransform4x4Blk( pucOrg + iOxForTransformLumaDc( aiCoeff )xQuantDequantNonUniformLuma( &piinvTransformDcCoeff( aiCoeff, iQxInvTransform4x4Blk( pucRec + iOMbCoder::xScanLumaIntra16x16( *rpcMbTempDxEstimateMbIntra8 ( m_pcIntMbTempData, m_pcIntMbBe----- init intra prediction -----xEncode8x8IntraBlock( *rpcMbTempData, c8xm_pcIntraPrediction-m_pcTransform->transform8x8Blk(xForTransform8x8BlkxQuantDequantUniform8x8invTransform8x8Blkm_pcIntraPrediction->predictSLumm_pcTransform->transform8x8Blk(xForTransform8x8BlkxQuantDequantUniform8x8invTransform8x8BlkxEncodeChromaIntra( *rpcMbTempData, uiExt----- store estimated parameters -----RNOK( xEstimateMbIntra4 ( rcMbDataAccess, m_pcIntMxEncode4x4IntraBlock( *rpcMbTempData, cIdm_pcIntraPrediction->predictSLumm_pcTransform->transform4x4Blk(xForTransform4x4Blk( pOxQuantDequantUniform4x4xInvTransform4x4Blk( pRMbCoder::xScanLumaBlock( rcMbTemm_pcMbSymbolWriteIf->rexEncodeChromaIntra( *rpcMbTempData, uiExt--- store estimated parameters ---xEstimateMbPCM ( m_pcIntMbTempData, m_pcIntMbBexStoreEstimation( rcMbDataAccess, *m_pcIntMbBestDa m_pcMbCoder ->encode ( *pcMbDataAccess,pcMbDataAccessBase ( uiMbAddress == uiLastMbAddress ), true )===== skip flag ========== base layer mode flag and base layer refineme===== macroblock mode =====m_pcMbSymbolWriteIf->mbMode( rcMbDataAccess )--- reset motion pred flags ---===== prediction info =====m_pcMbSymbolWriteIf->transformSize8x8Flag( rcMbDatm_pcMbSymbolWriteIf->intraPredModeLuma( rcMbDataAc===== TEXTURE =====xWriteTextureInfo( rcMbDataAccess,pcMbDataAccessBase,rcMbDataAccess.getMbTCoeffs(),bTrafo8x8Flag,rcMbDataAccess.getSH().getSPS()rcMbDataAccess.getSH().getSPS()uiMGSFragment )xScanLumaBlock( rcMbDataAccess, rcMbTCoefxScanChromaBlocks( rcMbDataAccess, rcMbTC--- write terminating bit ---m_pcMbSymbolWriteIf->terminatingBit ( bTerminateSluiMbAddress = rcSliceHeader.getFMO()->getNextMBNr(uiMbAddre //===== encode non-key pictures =====编码非关键帧,都是一次xMotionEstimationFrame( iLevel, uiFrame, ePicType )//===== get reference frame lists =====得到参考帧列表xGetPredictionLists ( rcRefFrameList0, rcRefFrameList1,//===== list 0 =====----- create half-pel buffer -----xFillAndUpsampleFrame ( pcFrame, FRAME, bFrameMbsOpcFrame->initHalfPel( pHPData )pcFrame->extendFrame( m_pcQuarterPelFiltegetFullPelYuvBuffer()->fillMargixFillPlaneMargin( getMbxFillPlaneMargin( getMbxFillPlaneMargin( getMbpcQuarterPelFilter->filterFrame(===== list 1 =====//===== set lambda and QP =====初始化拉格朗日优化参数和QPxInitControlDataMotion ( uiBaseLevel, uiFrame, true, ePicTm_pcSliceEncoder->xSetPredWeights( *pcSliceHeader,pcFrame,rcRefFrameList0,//===== motion estimation =====是否为宏块自适应帧场xMotionEstimation ( &rcRefFrameList0,&rcRefFrameList1,pcFrame,pcIntraRecFrame,rcControlData,m_bBiPredOnly,m_uiNumMaxIter,m_uiIterSearchRange,uiFrameIdInGOP ,ePicType )//===== copy motion if non-adaptive prediction ===//===== loop over macroblocks =====//===== init macroblock =====得到宏块pcMbEncoder->estimatePrediction ( *pcMbDataAccess, pcMbDataAccessB *pcRefFrameList0 *pcRefFrameList1 pcBaseLayerFram pcBaseLayerResi *pcOrigFrame *pcIntraRecFrame bBiPredOnly,uiNumMaxIter, uiIterSearchRan m_bBLSkipEnable rcControlData.g dCost,true )//===== P_SKIP ====跳帧//===== inter modes with residual predict//===== intra base layer mode =====基层层//===== inter modes without residual predxEstimateMbDirect ( m_pcIntMbTempData,//===== H.264/AVC compatible dirrcMbDataAccess.getMvPredictorDirxSpatialDirectMode ( ePxSetRdCostInterMb ( *rpcMbTemp//===== set forward / b//===== get predictionm_pcMotionEstimation->cxGetBgetTaxPredxPred//===== encode residual//--- LUMA ---xEncode4x4InterBlock( r//--- CHROMA ---xEncodeChromaTexture( rxCheckSkipSliceMb( rcMb//===== get distortion//===== get rate =====速MbCoder::m_pcMbSymbolWrMbCoder::m_pcMbSymbolWrMbCoder::m_pcMbSymbolWrMbCoder::xWriteMotionPrMbCoder::xWriteReferencMbCoder::xWriteMotionVe//===== set rd-cost ===m_pcRateDistortionIf->g xCheckBestEstimation( rpcMbTemp//----- switch data obj xCheckInterMbMode8x8( rpcMbTempxSetRdCost8x8InterMb( *xCheckBestE//----- switch data objxEstimateMbDirect ( m_pcIntMbTempData,在下面会有解释xEstimateMb16x16 ( m_pcIntMbTempData,在下面会有解释xEstimateMb16x8 ( m_pcIntMbTempData,在下面会有解释xEstimateMb8x16 ( m_pcIntMbTempData,在下面会有解释xEstimateMb8x8 ( m_pcIntMbTempData,在下面会有解释xEstimateMb8x8Frext ( m_pcIntMbTempData,//===== normal intra mode =====xEstimateMbIntra16 ( m_pcIntMbTempData,xEstimateMbIntra8 ( m_pcIntMbTempData,xEstimateMbIntra4 ( rcMbDataAccess, m_pxEstimateMbIntra4 ( rcMbDataAccess, m_pxStoreEstimation( rcMbDataAccess, *m_pcIn//===== reset parameters: IMPORT xDecompositionFrame ( iLevel, uiFrame,ePicType )在下面会有解释xEncodeNonKeyPicture ( iLevel, uiFrame, rcAccessUnitData, cPicOutputDataList, ePi xCompositionFrame ( iLevel, uiFrame, rcPicBufferInputList, ePi xCalculateAndAddPSNR ( iLevel, uiFrame, rcPicBufferInputList, cPicOutputDataList ) xCalculateTiming(cPicOutputDataList, uiFrame )xOutputPicData ( cPicOutputDataList ) xClearBufferExtensions()以下为第434行的函数另起一行xEstimateMb16x16 ( m_pcIntMbTempData, m_pcIntMbBestData, rcRefFrameList//===== LIST 0 PREDICTION ======rpcMbTempData->getMbDataAccess().getMvPredictor ( cMvPredxGetMvPredictor( rcMv, scRef, eListIdx, MEDIAN, B4m_pcMotionEstimation->estimateBlockWithStart( *rpcMbTempDatcMvLastEst[0]cMvPred [0]uiBitsTest, uPART_16x16, M&rpcMbTempDat//----- weighting -----//===== FULL-PEL ESTIMATION ======xTZSearch( pcRefPelData[0], cMv, uiMinSAD )// limit search range// set rcMv as start point anxTZSearchHelp( cStrukt, rcMv.getHor(), rc// test whether zerovektor is a better stxTZSearchHelp( cStrukt, 0, 0, 0, 0 )// start search// fist searchxTZ8PointDiamondSearch( cStrukt, cSearchR// test whether zerovektor is a better st// calculate only 2 missing points instea// raster search if distance is to big// raster refinement// star refinement// write out best match// test for errors in debug mode//===== SUB-PEL ESTIMATION =====xSubPelSearch( pcRefPelData[1], cMv, uiMinSAD, uiBxGetSizeFromMode ( uiXSize, uiYSize,xCompensateBlocksHalf ( m_aXHPelSearch, p//--- get best h-pel search posi//compute SAD for initial 1/2 pem_pcQuarterPelFilter->filterBloc//1/4 pel refinement around init //===== LIST 1 PREDICTION =====m_pcMotionEstimation->compensateBlock ( &cYuvMPART_xGetSizeFromMode( uiXSize, uiYSize, uiMod //===== BI PREDICTION =====//----- initialize with forward and backward estim//----- iterative search -----m_pcMotionEstimation->estimateBlockWithStart( *rpccMvcMvuiBPARuiI//----- standard weighting -----m_pcSampleWeighting->inverseLumaSamples//===== FULL-PEL ESTIMATION ======xPelBlockSearch ( pcRefPelData[0], cM//===== SUB-PEL ESTIMATION =====xSubPelSearch( pcRefPelData[1], cMv, uiMxGetSizeFromMode ( uiXSize,xCompensateBlocksHalf ( m_aXHPel//--- get best h-pel se//compute S//1/4 pel refinement arm_pcMotionEstimation->compensateBlock ( &cYuvMPART_1//===== chose parameters =====//----- list 1 prediction -----xSetRdCostInterMb ( *rpcMbTempData, pcMbDataAccessBase, rfalse, 0, false, 0, bLowComplexMbEnaxCheckBestEstimation( rpcMbTempData, rpcMbBestData )xCheckInterMbMode8x8( rpcMbTempData, rpcMbBestData, pcMbRe 以下为第435行的函数另起一行xEstimateMb16x8 ( m_pcIntMbTempData, m_pcIntMbBestData, rcRefFrameList//===== LIST 0 PREDICTION ======m_pcMotionEstimation->estimateBlockWithStart( *rpcMbTempDacMvLastEst[0cMvPred [0uiBitsTest,eParIdx, MOD&rpcMbTempDa//===== FULL-PEL ESTIMATION ====//===== SUB-PEL ESTIMATION =====//===== LIST 1 PREDICTION =====m_pcMotionEstimation->estimateBlockWithStart( *rpcMbTempDacMvLastEst[1cMvPred [1uiBitsTest,eParIdx, MOD&rpcMbTempDam_pcMotionEstimation->compensateBlock ( &cYuvMbBuffer[1//===== BI PREDICTION =====//----- initialize with forward and backward estimation ---//----- iterative search -----m_pcMotionEstimation->estimateBlockWithStart( *rpcMbTempDacMvLastEst[ucMvPred [uuiBitsTest,eParIdx, MODuiIterSearchm_pcMotionEstimation->compensateBlock ( &cYuvMbBuffer[ueParIdx, MODE_1//===== chose parameters =====xSetRdCostInterMb ( *rpcMbTempData, pcMbDataAfalse, 0, false, 0, bLowComplexMbEnaxCheckBestEstimation( rpcMbTempData, rpcMbBestData )xCheckInterMbMode8x8( rpcMbTempData, rpcMbBestData, pcMbRe 以下为第437行的函数另起一行xEstimateMb8x8 ( m_pcIntMbTempData, m_pcIntMbBestData, rcRefFrameListxEstimateSubMbDirect ( ePar8x8, m_pcIntMbTemp8x8Data, m_pcrcMbDataAccess.getMvPredictorDirect( eParIdx8x8, bxSetRdCostInterSubMb( *rpcMbTempData, rcRefFrameLixCheckBestEstimation( rpcMbTempData, rpcMbBestDatxEstimateSubMb8x8 ( ePar8x8, m_pcIntMbTemp8x8Data, m_pc//===== LIST 0 PREDICTION ======m_pcMotionEstimation->estimateBlockWithStart( *rpcMvcMvuiBePa&r//===== LIST 1 PREDICTION =====m_pcMotionEstimation->estimateBlockWithStart( *rpcMvcMvuiBePa&rpm_pcMotionEstimation->compensateBlock ( &cYuvMeParId//===== BI PREDICTION =====m_pcMotionEstimation->estimateBlockWithStart( *rpcMvcMvuiBePauiIm_pcMotionEstimation->compensateBlock ( &cYuvePar//===== chose parameters =====xSetRdCostInterSubMb( *rpcMbTempData, rcRefFrameLixCheckBestEstimation( rpcMbTempData, rpcMbBestDatxEstimateSubMb8x4 ( ePar8x8, m_pcIntMbTemp8x8Data, m_pcIn//===== LIST 0 PREDICTION ======//===== LIST 1 PREDICTION =====//===== BI PREDICTION =====//===== chose parameters =====xSetRdCostInterSubMb( *rpcMbTempData, rcRefFrameLixCheckBestEstimation( rpcMbTempData, rpcMbBestDatxEstimateSubMb4x8 ( ePar8x8, m_pcIntMbTemp8x8Data, m_pcIn//===== LIST 0 PREDICTION ======//===== LIST 1 PREDICTION =====//===== BI PREDICTION =====//===== chose parameters =====//===== set parameters and compare =====xSetRdCostInterSubMb( *rpcMbTempData, rcRefFrameLixCheckBestEstimation( rpcMbTempData, rpcMbBestDatxEstimateSubMb4x4 ( ePar8x8, m_pcIntMbTemp8x8Data, m_pcIn//===== LIST 0 PREDICTION ======//===== LIST 1 PREDICTION =====//===== BI PREDICTION =====//===== chose parameters =====//===== set parameters and compare =====xSetRdCostInterSubMb( *rpcMbTempData, rcRefFrameLixCheckBestEstimation( rpcMbTempData, rpcMbBestDat//----- store parameters in MbTempData -----//----- set parameters in MbTemp8x8Data for prediction of nxSetRdCostInterMb ( *rpcMbTempData, pcMbDataAccessBase, rfalse, 0, false, 0, bLowComplexMbEnaxCheckBestEstimation( rpcMbTempData, rpcMbBestData )以下为第438行的函数另起一行xEstimateMb8x8Frext ( m_pcIntMbTempData, m_pcIntMbBestData, rcRefFrameListxEstimateSubMbDirect ( ePar8x8, m_pcIntMbTemp8x8Data, m_pcxSetRdCostInterSubMb( *rpcMbTempData, rcRefFrameLixCheckBestEstimation( rpcMbTempData, rpcMbBestDatxEstimateSubMb8x8 ( ePar8x8, m_pcIntMbTemp8x8Data, m_pc//===== LIST 0 PREDICTION ======m_pcMotionEstimation->estimateBlockWithStart( *rpcMvcMvuiBePa&rp//===== LIST 1 PREDICTION =====m_pcMotionEstimation->estimateBlockWithStart( *rpcMcMuieP&rm_pcMotionEstimation->compensateBlockeParI//===== BI PREDICTION =====m_pcMotionEstimation->estimateBlockWithStart( *rpcMcMuiePuim_pcMotionEstimation->compensateBlock ( &cYuvMeParId//===== chose parameters =====//===== set parameters and compare =====xSetRdCostInterSubMb( *rpcMbTempData, rcRefFrameLixCheckBestEstimation( rpcMbTempData, rpcMbBestDat//----- store parameters in MbTempData -----//----- set parameters in MbTemp8x8Data for prediction of nxCheckInterMbMode8x8( rpcMbTempData, rpcMbBestData, pcMbRe 以下为第446行的函数另起一行xDecompositionFrame ( iLevel, uiFrame,ePicType )//===== get reference frame lists =====xGetPredictionLists ( rcRefFrameList0, rcRefFrameList1,//===== set lambda and QP =====//===== prediction =====xMotionCompensation ( pcMCFrame, &rcRefFrameList0, &rcRefF//===== loop over macroblocks =====pcMbEncoder->compensatePrediction( *pcMbDataAccesspcMCFrame->get*apcRefFrameLis*apcRefFrameLisbCalcMv, bFaulpcFrame->prediction ( pcMCFrame, pcFrame, ePicType )getFullPelYuvBuffer()->prediction( pcSrcFrame->getpcMCPFrame->get//===== set residual =====pcResidual->copy ( pcFrame , ePicType 以下为第447行的函数另起一行xEncodeNonKeyPicture ( iLevel, uiFrame, rcAccessUnitData, cPicOutputD//===== base layer encoding =====pcBLRecFrame->copy ( pcFrame, ePicType ) xEncodeHighPassSignal ( rcOutputList,rcControlData,pcOrgFrame,pcBLRecFrame,pcResidual,pcPredSignal,uiBits,uiBitsRes, rcPicOutputDataList, ePicType )//----- Subsequence SEI -----//----- init NAL UNIT -----//---- write Slice Header -----m_pcNalUnitEncoder->write( *pcSliceHeader )//----- write slice data -----m_pcSliceEncoder->encodeHighPassPicture ( uiMbCodeuiBits,*pcSlicepcOrgFrpcFramepcResidpcPredSrcContrrcContrrcContrrcContrm_uiFrarcContrm_iMaxDePicTyp//====== initialization ======//===== loop over macroblocks =====m_pcMbEncoder ->encodeResidual ( *pcMbDpcOrgpcFrapcRespcBasbCodedLambiMaxD//----- encode luminance signalxEncode4x4InterBlock( *m_pcIntMb//----- encode chrominance signaxEncodeChromaTexture( *m_pcIntMb//----- set parameters ----//----- fix QP ------//--- set parameters//----- store parameters and rec//----- store "base layer" resid//----- set residual prediction// restore original residualm_pcMbCoder->encode( *pcMbDataAccess, pcM//===== skip flag =====//===== base layer mode flag and//===== macroblock mode =====//--- reset motion pred flags --//===== prediction info =====//===== MOTION INFORMATION =====//===== TEXTURE =====xWriteTextureInfo( rcMbDataAccespcMbDataAccesrcMbDataAccesbTrafo8x8FlagrcMbDataAccesrcMbDataAccesuiMGSFragmentxScanChromaBlocks( rcMb//--- write terminating bit ---//----- close NAL UNIT -----以下为第448行的函数另起一行xCompositionFrame ( iLevel, uiFrame, rcPicBufferInputList,//--- highest FGS reference for closed-loop coding ---//===== get reference frame lists =====xMotionCompensation ( pcMCFrame, &rcRefFrameList0,rcControlData.getMbDataCtrl()pcFrame ->inversePrediction ( pcMCFrame, pcFrame, ePicType//----- store non-deblocked signal for inter-layer predicti//===== de-blocking =====m_pcLoopFilter->process( *pcSliceHeader, pcFrame, pcResidua//===== filtering =====xFilterMb( *pcMbDataAccess, pcFrameBuffer, pcResid//===== check residual blocks and set "re//===== set mode parameters =====//===== determine boundary filter strengtxGetVerFilterStrength( rcMbDataAccess, cIxGetHorFilterStrength( rcMbDataAccess, cI//===== filtering =====滤波//--- highest FGS reference for closed-loop coding ---集,在没有写SPS和PPS时结束循环ired frame buffers =====yers; uiLayer++ )//uiNumLayers=2 是配置文件里的输入层数ame; uiFrame++ )//maxframe = FrameToBeEncodeand read original pictures =====< uiNumLayers; uiLayer++ )每两个图像调用一次,但是在函数内部是一个GOP处理一次s( cOutExtBinDataAccessorList,apcOriginalPicBuffer,apcReconstructPicBuffer,acPicBufferOutputList,acPicBufferUnusedList )r->process( rcExtBinDataAccessorList,apcOriginalPicBuffer,apcReconstructPicBuffer,apcPicBufferOutputList,apcPicBufferUnusedList )ll lists =====uiHighestLayer = m_pcCodingParameter->getNumberOfLayers() - 1;for( UInt uiLayer = 0; uiLayer <= uiHighestLayer; uiLayer++ )//循环numlayer次m_acOrgPicBufferList [ uiLayer ].push_back( apcOriginalPicBuffer [ uiLayer ] );m_acRecPicBufferList [ uiLayer ].push_back( apcReconstructPicBuffer[ uiLayer ] );of GOP =====//只有17帧都读进来后才会进入xProcessGOP函数if ( m_acOrgPicBufferList[uiHighestLayer].size() == uiTargetSize )//targetSize = 17 GOP+1 OK( xProcessGOP( apcPicBufferOutputList, apcPicBufferUnusedList ) );//17帧入buffer后才调date data accessor list =====m_cAccessUnitDataList.emptyNALULists( rcExtBinDataAccessorList );L unit buffers =====tList[uiLayer], uiLayer )dList[uiLayer], uiLayer )constructed pictures =====ssGOP( apcPicBufferOutputList, apcPicBufferUnusedList )?????or list =====r-1]->finish( ruiNumCodedFrames, rdHighestLayerOutputRate, m_aaadFinalFramerate, m_aaa====ed pictures =====mary =====ferUnusedList )CGSSNR,BaseLayerCGSSNR,BaseQualityLevelCGSSNR,initGOPayers(); uiLayer++ )units =====分图像,分层处理pcCodingParameter->getNumberOfLayers(); uiLayer ++ )ayer]->process( uiAUIndex,m_cAccessUnitDataList.getAccessUnitData( uiAUIndex ),m_acOrgPicBufferList [uiLayer],m_acRecPicBufferList [uiLayer],apcPicBufferUnusedList[uiLayer],m_pcParameterSetMng )===== init some parameters ========== update higher layer pictures ===== 分为16次//===== encode key pictures =====编码关键帧,都是一次?编码非关键帧见298新起一行LayerEncoder::xEncodeKeyPicture ( bPicCoded, uiKeyFrame, rcAccessUnit===== check for first GOP =====xSetBaseLayerData( uiFrameIdInGOP, ePicType )===== initialize =====xInitControlDataLowPass ( uiFrameIdInGOP, m_uiDecompositionStages-1, uiFxInitBaseLayerData( rcControlData,uiBaseLevel,uiFrame, false, &===== init ========== motion data ========== residual data ========= reconstructed (intra) data =====//xSetPredWeights===== base layer encoding ========== primary picture coding =====pcBLRecFrame->copy ( pcFrame, ePicType )getFullPelYuvBuffer()->copy( pcSrcFrame->getFullPelYuvBuffer())===== luminance ========== chrominance U ========== chrominance V =====LayerEncoder::xEncodeLowPassSignal(rcOutputList,rcControlData,pcFrame,pcBLRecFrame,pcResidual,pcPredSignal,uiBits,rcPicOutputDataList,ePicType )----- subsequence SEI -----LayerEncoder::xWriteSEI( rcOutExtBinDataAccespcSubSeqInfo->init( uiSubSeqLayer, 0m_pcNalUnitEncoder->write( cSEIMessaSEI::write( m_pcHeaderSymbo===== NAL unit heaxWrite( pcWriteIf,m_pcNalUnitEncoder->closeNalUnit( ui===== write trailing bits =xWriteTrailingBits()m_pcBitWriteBuffer->flushBu===== convert to payload anconvertRBSPToPayload( uiBit===== NAL unit hea===== NAL unit paym_pcBinDataAccessor->decrea==== reset parameters =====xWritePrefixUnit( rcOutExtBinDataAccessorListm_pcNalUnitEncoder->writePrefix( rcSrcSH.writePrefix( *m_pcHeadPrefixHeader::writm_pcNalUnitEncoder->closeNalUnit( ui----- init NAL UNIT --------- write Slice Header -----m_pcNalUnitEncoder->write ( *pc----- modify copy of slice he----- write copy of slice header ---cSH.write( *pcCurrWriteIf )----- update ---------- encode slice data -----m_pcSliceEncoder->encodeIntraPicture ( uiBitrcConpcFrapcRespcBaspcPrem_uiFrcConePicT----- close NAL UNIT -----m_pcNalUnitEncoder->closeAndAppendNalUnits( ar&mmmm ===== deblock and store picture for prediction of following low-pass fra----- store for inter-layer prediction (non-deblocked version) -----m_papcSubband[ uiFrameIdInGOP ]->copy( pcBLRecFrame, ePicType )----- de-blocking -----m_pcLoopFilter->process( *pcSliceHeader, pcBLRecFrame, pcResidual, pcMbD ===== filtering =====xFilterMb( *pcMbDataAccess, pcFrameBuffer, pcResidualBuffer, pc ----- store for prediction of following low-pass pictures -----m_pcLowPassBaseReconstruction->copy( pcBLRecFrame, ePicType )pcFrame->copy( pcBLRecFrame, ePicType )xUpdateLowPassRec()xCalculateAndAddPSNR ( m_uiDecompositionStages, uiKeyFrame, rcPicBufferInputList xCalculateTiming(cPicOutputDataList, uiKeyFrame )xOutputPicData ( cPicOutputDataList )//打印出结果//xClearBufferExtensions()到此LayerEncoder::m_apcLayerEncoder[uiLayer]->process结束uiMbY, uiMbX )DataAccess,DataAccessBase,ame ->getPic( ePicType ),ame ->getPic( ePicType ),cSubband ->getPic( ePicType ),pcBaseLayer ? pcBaseLayerpcPredSignal odes (if base layer or adaptive prediction) =====tMbTempData, m_pcIntMbBestData, false )prediction -----uiPredMode is equal to the baselayer when AVC rewriting is enabled.on->predictSLumaMb( rpcMbTempData, n, bValid )ansformMb16x16( m_pcIntOrgMbPelData, rpcMbTempData, rpcMbTempData->get( B4x4Idx(0) ), pucScale, uiDc sform4x4Blk( pucOrg + iOffsetBlk, pucRec + iOffsetBlk, iStride, &aiCoeff[uiBlk<<4]sformLumaDc( aiCoeff )quantNonUniformLuma( &piCoeff[n<<4], &aiCoeff[n<<4], m_cLumaQp, pucScale, ruiDcAbs, ruiAcAbs ) formDcCoeff( aiCoeff, iQpScale )sform4x4Blk( pucRec + iOffsetBlk, iStride, &aiCoeff[uiBlk<<4] )aIntra16x16( *rpcMbTempData, *rpcMbTempData, uiAcAbs != 0 )tMbTempData, m_pcIntMbBestData, false )prediction -----ock( *rpcMbTempData, c8x8Idx, uiMbBits, uiExtCbp )aPrediction->predictSLumaBlock8x8( rcMbTempData, iPredMode, c8x8Idx, bValid )sform->transform8x8Blk( m_pcIntOrgMbPelData, rcMbTempData, rcMbTempData.get8x8( c8x8Idx ), pucScale, xForTransform8x8Blk ( pOrg, pRec, iStride, aiTemp )xQuantDequantUniform8x8 ( piCoeff, aiTemp, m_cLumaQp, pucScale, ruiAbsSum )invTransform8x8Blk ( pRec, iStride, aiTemp )aPrediction->predictSLumaBlock8x8( rcMbTempData, uiBestMode, c8x8Idx, bValid )sform->transform8x8Blk( m_pcIntOrgMbPelData, rcMbTempData, rcMbTempData.get8x8( c8x8Idx ), pucScale, xForTransform8x8Blk ( pOrg, pRec, iStride, aiTemp )xQuantDequantUniform8x8 ( piCoeff, aiTemp, m_cLumaQp, pucScale, ruiAbsSum )invTransform8x8Blk ( pRec, iStride, aiTemp );a( *rpcMbTempData, uiExtCbp, uiMbBits )ated parameters -----rcMbDataAccess, m_pcIntMbTempData, m_pcIntMbBestData, false )ock( *rpcMbTempData, cIdx, uiBits, uiCbp, 0, 0, false )aPrediction->predictSLumaBlock( rcMbTempData, iPredMode, cIdx, bValid )sform->transform4x4Blk( m_pcIntOrgMbPelData, rcMbTempData, rcMbTempData.get( cIdx ), pucScale, uiAbs xForTransform4x4Blk( pOrg, pRec, iStride, aiTemp )xQuantDequantUniform4x4( piCoeff, aiTemp, m_cLumaQp, pucScale, ruiAbsSum )xInvTransform4x4Blk( pRec, iStride, aiTemp ):xScanLumaBlock( rcMbTempData, rcMbTempData, cIdx )m_pcMbSymbolWriteIf->residualBlock( rcMbDataAccess, cIdx, LUMA_SCAN, uiStart, uiStop )a( *rpcMbTempData, uiExtCbp, uiMbBits, bLowComplexMbEnable )ed parameters ---tMbTempData, m_pcIntMbBestData, false )Access, *m_pcIntMbBestData, pcRecSubband, pcPredSignal, 0, 0, false, NULL )ccess,pcMbDataAccessBase,s == uiLastMbAddress ),and base layer refinement flag =====e( rcMbDataAccess )formSize8x8Flag( rcMbDataAccess )PredModeLuma( rcMbDataAccess, cIdx )aAccessBase,aAccess.getMbTCoeffs(),aAccess.getSH().getSPS().getMGSCoeffStart( uiMGSFragment ),aAccess.getSH().getSPS().getMGSCoeffStop( uiMGSFragment ),cMbDataAccess, rcMbTCoeff, cIdx, uiStart, uiStop )( rcMbDataAccess, rcMbTCoeff, uiCbp >> 4, uiStart, uiStop )it ( bTerminateSlice ? 1:0 ))->getNextMBNr(uiMbAddress )====得到参考帧列表eList0, rcRefFrameList1, uiBaseLevel, uiFrame, RLU_MOTION_ESTIMATION, true )Frame, FRAME, bFrameMbsOnlyFlag )Pel( pHPData )ame( m_pcQuarterPelFilter, ePicType, bFrameMbsOnlyFlag )elYuvBuffer()->fillMargin( )xFillPlaneMargin( getMbLumAddr(), getLHeight(), getLWidth(), getLStride(), getLXMargin(), getLYMarg xFillPlaneMargin( getMbCbAddr(), getCHeight(), getCWidth(), getCStride(), getCXMargin(), getCYMarg xFillPlaneMargin( getMbCrAddr(), getCHeight(), getCWidth(), getCStride(), getCXMargin(), getCYMarg rPelFilter->filterFrame( getFullPelYuvBuffer(), getHal 化拉格朗日优化参数和QPel, uiFrame, true, ePicType )*pcSliceHeader,rcRefFrameList0,为宏块自适应帧场archRange,-adaptive prediction =====非自适应预测直接复制。