第三章 前馈型神经网络模型

3.1 感知器(Perception )

感知器(Perception )是由美国学者F.Rosenblatt 于1957年提出的一个具有单层计算单元的神经网络。它在识别印刷体字符方面表现出了良好的性能,引起人们很多兴趣。后来许多改进型的感知器在文字识别、语音识别等应用领域取得了进展,使得早期的神经网络的研究达到了高潮。

感知器的输入可以是非离散量,它的权向量不仅是非离散量,而且可以学习调整。感知器是一个线性阈值单元组成的网络,可以对输入样本进行分类,而且多层感知器,在某些样本点上对函数进行逼近,虽然在分类和逼近的精度上都不及非线性单元组成的网络,但是可以对其他网络的分析提供依据。

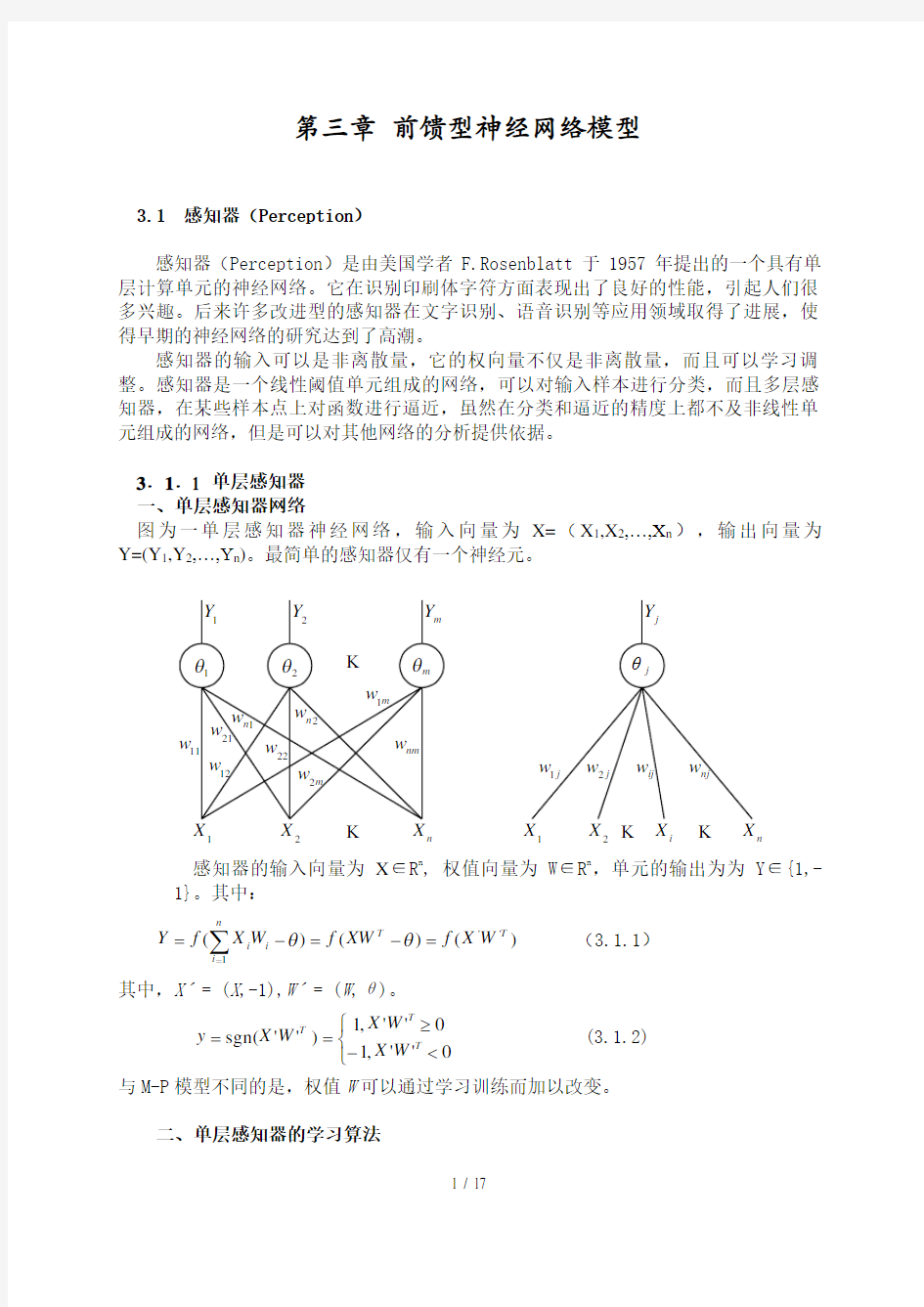

3.1.1 单层感知器 一、单层感知器网络

图为一单层感知器神经网络,输入向量为X=(X 1,X 2,…,X n ),输出向量为Y=(Y 1,Y 2,…,Y n )。最简单的感知器仅有一个神经元。

1

122i

n n

感知器的输入向量为X ∈R n , 权值向量为W ∈R n ,单元的输出为为Y ∈{1,-1}。其中:

∑==-=-=n

i T T i i W X f XW f W X f Y 1

'')()()(θθ (3.1.1)

其中,X ˊ= (X ,-1),W ˊ= (W ,θ)。

???<-≥==0

'',10

'',1)''sgn(T

T T

W X W X W X y (3.1.2) 与M-P 模型不同的是,权值W 可以通过学习训练而加以改变。

二、单层感知器的学习算法

令W n+1=θ, X n+1=-1, 则, )(

1

1

∑+==

n i i i W X f y (3.1.3)

具体算法如下:

①初始化 给W i (0)各赋一个较小的随机非零值。这里W i (t)为t 时刻第i 个输入的权值(1≤i ≤n ),W n+1(t)为t 时刻的阈值。

②输入样本 X=(X 1,X 2,…,X n ,T),T 称为教师信号,在两类样本分类中,如果X ∈A 类,则T=1;如果X ∈B 类,则T=-1。 ③计算实际输出

))(()(1

1t W X f t Y n i i i ∑+== (3.1.4)

④修正权值

W i (t+1)= W i (t)+η(T-Y(t))X i i=(1,2,…,n,n+1) (3.1.5)

其中,0<η≤1用于控制修正速度,通常η不能太大,会影响W i (t)的稳定,也不能太小,会使W i (t)的收敛速度太慢。

⑤转到②直到W 对一切样本均稳定不变为止。

用单层感知器可实现部分逻辑函数,如: X 1∧X 2: Y=1·X 1+1·X 2-2 即W 1=W 2=1,θ=2

X 1∨X 2: Y=1·X 1+1·X 2-0.5 即W 1=W 2=1,θ=0.5

: Y=(-1)·X 1+0.5 即W 1=-1,θ=-0.5 三、单层感知器的局限性

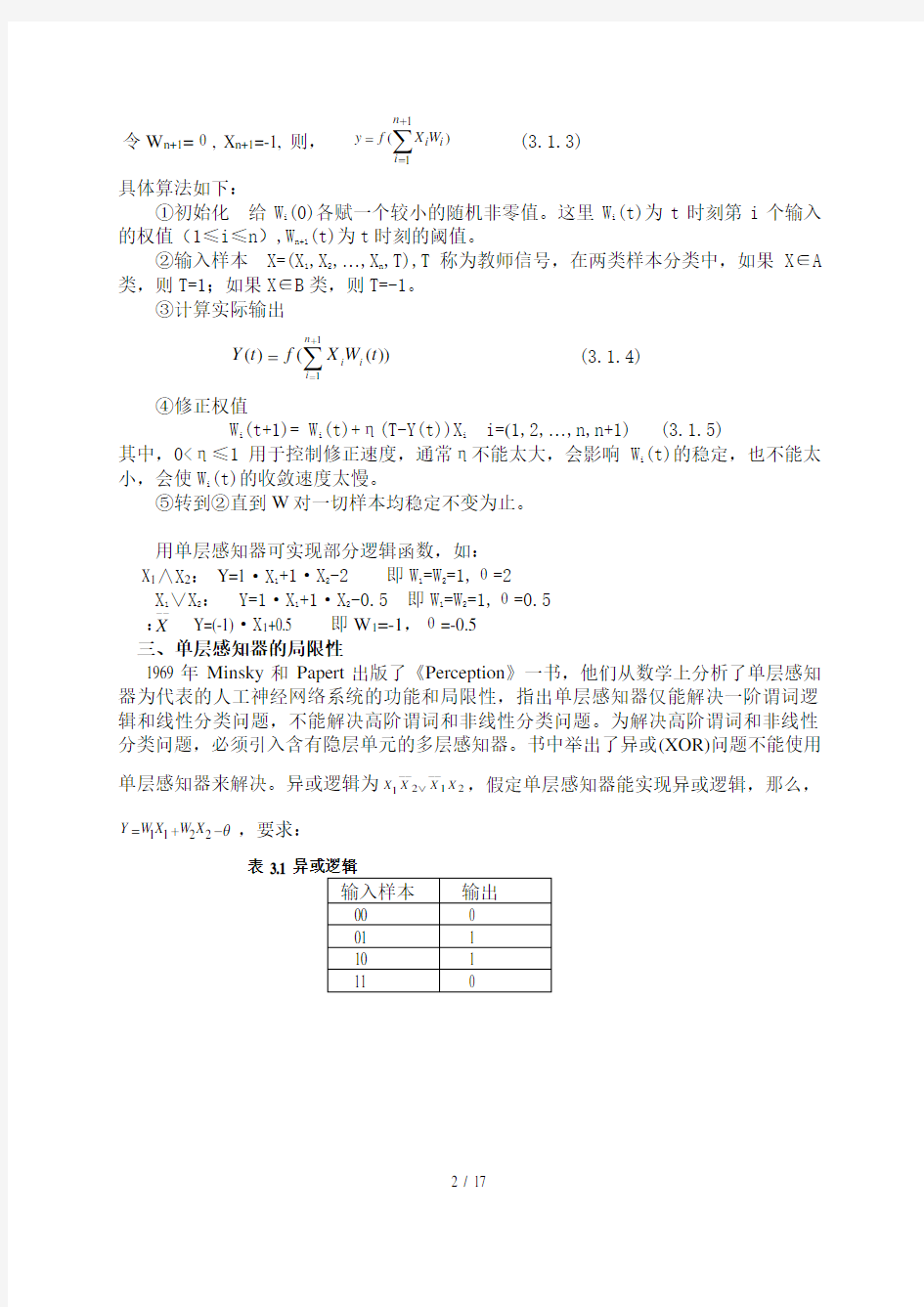

1969年Minsky 和Papert 出版了《Perception 》一书,他们从数学上分析了单层感知器为代表的人工神经网络系统的功能和局限性,指出单层感知器仅能解决一阶谓词逻辑和线性分类问题,不能解决高阶谓词和非线性分类问题。为解决高阶谓词和非线性分类问题,必须引入含有隐层单元的多层感知器。书中举出了异或(XOR)问题不能使用单层感知器来解决。异或逻辑为2121X X X X -

--

-∨,假定单层感知器能实现异或逻辑,那么,

θ-+=2211X W X W Y ,要求:

表 3.1

-

-X

θ

W 0θW 0θW 0θ0W θ00θ00θW W 0θW W 22112121>→≥-+>→≥-+<→<-+<+→<-+

(a) XOR 逻辑 (b)AND 逻辑 (c) OR 逻辑

图 3.3 线性可分性

3.1.2 感知器的收敛定理 一、线性可分函数

对给定的X 和Y ,存在W 和θ和线性映像函数f ,使得: f :R n → {1,-1}, X ∈R n , 则称f 为线性可分函数。

所谓的线性可分是指存在一个超平面(二 维为一条直线)能将两类样本分开。 对于上面的异或逻辑可用一个平面将其输出类别分开。平面方程为:

X 1W 1+X 2W 2+X 3W 3=θ,X 1W 1+X 2W 2+(X 1∧X 2)W 3=θ其输入输出关系,见表3.2。

从表上可以看出前两维为异或,后一维是前两维的“与”。 图3.4给出了其三维表示。

(0,1(0,1

年份 (年) 1(1988) 2(1989) 3(1990) 4(1991) 5(1992) 6(1993) 7(1994) 8(1995) 实际值 (ERI) 年份 (年) 9(1996) 10(1997) 11(1998) 12(1999) 13(2000) 14(2001) 15(2002) 16(2003) 实际值 (ERI) BP 神经网络的训练过程为: 先用1988 年到2002 年的指标历史数据作为网络的输入,用1989 年到2003 年的指标历史数据作为网络的输出,组成训练集对网络进行训练,使之误差达到满意的程度,用这样训练好的网络进行预测. 采用滚动预测方法进行预测:滚动预测方法是通过一组历史数据预测未来某一时刻的值,然后把这一预测数据再视为历史数据继续预测下去,依次循环进行,逐步预测未来一段时期的值. 用1989 年到2003 年数据作为网络的输入,2004 年的预测值作为网络的输出. 接着用1990 年到2004 年的数据作为网络的输入,2005 年的预测值作为网络的输出.依次类推,这样就得到2010 年的预测值。 目前在BP 网络的应用中,多采用三层结构. 根据人工神经网络定理可知,只要用三层的BP 网络就可实现任意函数的逼近. 所以训练结果采用三层BP模型进行模拟预测. 模型训练误差为,隐层单元数选取8个,学习速率为,动态参数,Sigmoid参数,最大迭代次数3000.运行3000次后,样本拟合误差等于。 P=[。。。];输入T=[。。。];输出 % 创建一个新的前向神经网络 net_1=newff(minmax(P),[10,1],{'tansig','purelin'},'traingdm') % 当前输入层权值和阈值 inputWeights={1,1} inputbias={1} % 当前网络层权值和阈值 layerWeights={2,1} layerbias={2} % 设置训练参数 = 50; = ; = ; = 10000; = 1e-3;

基于BP神经网络的国际黄金价格预测模型 公文易文秘资源网顾孟钧张志和陈友2009-1-2 13:35:26我要投稿添加到百度搜藏 [摘要] 为了寻找国际黄金价格与道琼斯工业指数、美国消费者指数,国际黄金储备等因素之间的内在关系,本文对1972年~2006年间的各项数据首先进行归一化处理,利用MATLAB神经网络工具箱进行模拟训练,建立了基于BP神经网络的国际黄金价格预测模型 [摘要] 为了寻找国际黄金价格与道琼斯工业指数、美国消费者指数,国际黄金储备等因素之间的内在关系,本文对1972年~2006年间的各项数据首先进行归一化处理,利用MATLAB神经网络工具箱进行模拟训练,建立了基于BP神经网络的国际黄金价格预测模型。 [关键词] MATLAB BP神经网络预测模型数据归一化 一、引言 自20世纪70年代初以来的30多年里,世界黄金价格出现了令人瞠目的剧烈变动。20 世纪70年代初,每盎司黄金价格仅为30多美元。80年代初,黄金暴涨到每盎司近700美元。本世纪初,黄金价格处于每盎司270美元左右,此后逐年攀升,到2006年5月12日达到了26年高点,每盎司730美元,此后又暴跌,仅一个月时间内就下跌了约160美元,跌幅高达21.9%。最近两年,黄金价格一度冲高到每盎司900多美元。黄金价格起伏如此之大,本文根据国际黄金价格的影响因素,通过BP神经网络预测模型来预测长期黄金价格。 二、影响因素 刘曙光和胡再勇证实将观察期延长为1972年~2006年时,则影响黄金价格的主要因素扩展至包含道琼斯指数、美国消费者价格指数、美元名义有效汇率、美国联邦基金利率和世界黄金储备5个因素。本文利用此观点,根据1972年~2006年各因素的值来建立神经网络预测模型。 三、模型构建

OpenCV的ml模块实现了人工神经网络(Artificial Neural Networks,ANN)最典型的多层感知器(multi-layer perceptrons, MLP)模型。由于ml模型实现的算法都继承自统一的CvStatModel基类,其训练和预测的接口都是train(),predict(),非常简单。 下面来看神经网络CvANN_MLP 的使用~ 定义神经网络及参数: [cpp]view plain copy 1.//Setup the BPNetwork 2. CvANN_MLP bp; 3.// Set up BPNetwork's parameters 4. CvANN_MLP_TrainParams params; 5. params.train_method=CvANN_MLP_TrainParams::BACKPROP; 6. params.bp_dw_scale=0.1; 7. params.bp_moment_scale=0.1; 8.//params.train_method=CvANN_MLP_TrainParams::RPROP; 9.//params.rp_dw0 = 0.1; 10.//params.rp_dw_plus = 1.2; 11.//params.rp_dw_minus = 0.5; 12.//params.rp_dw_min = FLT_EPSILON; 13.//params.rp_dw_max = 50.; 可以直接定义CvANN_MLP神经网络,并设置其参数。BACKPROP表示使用 back-propagation的训练方法,RPROP即最简单的propagation训练方法。 使用BACKPROP有两个相关参数:bp_dw_scale即bp_moment_scale: 使用PRPOP有四个相关参数:rp_dw0, rp_dw_plus, rp_dw_minus, rp_dw_min, rp_dw_max:

神经网络模型预测控制器 摘要:本文将神经网络控制器应用于受限非线性系统的优化模型预测控制中,控制规则用一个神经网络函数逼近器来表示,该网络是通过最小化一个与控制相关的代价函数来训练的。本文提出的方法可以用于构造任意结构的控制器,如减速优化控制器和分散控制器。 关键字:模型预测控制、神经网络、非线性控制 1.介绍 由于非线性控制问题的复杂性,通常用逼近方法来获得近似解。在本文中,提出了一种广泛应用的方法即模型预测控制(MPC),这可用于解决在线优化问题,另一种方法是函数逼近器,如人工神经网络,这可用于离线的优化控制规则。 在模型预测控制中,控制信号取决于在每个采样时刻时的想要在线最小化的代价函数,它已经广泛地应用于受限的多变量系统和非线性过程等工业控制中[3,11,22]。MPC方法一个潜在的弱点是优化问题必须能严格地按要求推算,尤其是在非线性系统中。模型预测控制已经广泛地应用于线性MPC问题中[5],但为了减小在线计算时的计算量,该部分的计算为离线。一个非常强大的函数逼近器为神经网络,它能很好地用于表示非线性模型或控制器,如文献[4,13,14]。基于模型跟踪控制的方法已经普遍地应用在神经网络控制,这种方法的一个局限性是它不适合于不稳定地逆系统,基此本文研究了基于优化控制技术的方法。 许多基于神经网络的方法已经提出了应用在优化控制问题方面,该优化控制的目标是最小化一个与控制相关的代价函数。一个方法是用一个神经网络来逼近与优化控制问题相关联的动态程式方程的解[6]。一个更直接地方法是模仿MPC方法,用通过最小化预测代价函数来训练神经网络控制器。为了达到精确的MPC技术,用神经网络来逼近模型预测控制策略,且通过离线计算[1,7.9,19]。用一个交替且更直接的方法即直接最小化代价函数训练网络控制器代替通过训练一个神经网络来逼近一个优化模型预测控制策略。这种方法目前已有许多版本,Parisini[20]和Zoppoli[24]等人研究了随机优化控制问题,其中控制器作为神经网络逼近器的输入输出的一个函数。Seong和Widrow[23]研究了一个初始状态为随机分配的优化控制问题,控制器为反馈状态,用一个神经网络来表示。在以上的研究中,应用了一个随机逼近器算法来训练网络。Al-dajani[2]和Nayeri等人[15]提出了一种相似的方法,即用最速下降法来训练神经网络控制器。 在许多应用中,设计一个控制器都涉及到一个特殊的结构。对于复杂的系统如减速控制器或分散控制系统,都需要许多输入与输出。在模型预测控制中,模型是用于预测系统未来的运动轨迹,优化控制信号是系统模型的系统的函数。因此,模型预测控制不能用于定结构控制问题。不同的是,基于神经网络函数逼近器的控制器可以应用于优化定结构控制问题。 在本文中,主要研究的是应用于非线性优化控制问题的结构受限的MPC类型[20,2,24,23,15]。控制规则用神经网络逼近器表示,最小化一个与控制相关的代价函数来离线训练神经网络。通过将神经网络控制的输入适当特殊化来完成优化低阶控制器的设计,分散和其它定结构神经网络控制器是通过对网络结构加入合适的限制构成的。通过一个数据例子来评价神经网络控制器的性能并与优化模型预测控制器进行比较。 2.问题表述 考虑一个离散非线性控制系统: 其中为控制器的输出,为输入,为状态矢量。控制

b p神经网络及m a t l a b实现

图1. 人工神经元模型 图中x1~xn是从其他神经元传来的输入信号,wij表示表示从神经元j到神经元i的连接权值,θ表示一个阈值 ( threshold ),或称为偏置( bias )。则神经元i的输出与输入的关系表示为: 图中 yi表示神经元i的输出,函数f称为激活函数 ( Activation Function )或转移函数 ( Transfer Function ) ,net称为净激活(net activation)。若将阈值看成是神经元i的一个输入x0的权重wi0,则上面的式子可以简化为: 若用X表示输入向量,用W表示权重向量,即: X = [ x0 , x1 , x2 , ....... , xn ]

则神经元的输出可以表示为向量相乘的形式: 若神经元的净激活net为正,称该神经元处于激活状态或兴奋状态(fire),若净激活net为负,则称神经元处于抑制状态。 图1中的这种“阈值加权和”的神经元模型称为M-P模型 ( McCulloch-Pitts Model ),也称为神经网络的一个处理单元( PE, Processing Element )。 2. 常用激活函数 激活函数的选择是构建神经网络过程中的重要环节,下面简要介绍常用的激活函数。 (1) 线性函数 ( Liner Function ) (2) 斜面函数 ( Ramp Function ) (3) 阈值函数 ( Threshold Function ) 以上3个激活函数都属于线性函数,下面介绍两个常用的非线性激活函数。 (4) S形函数 ( Sigmoid Function ) 该函数的导函数:

BP神经网络模型 第1节基本原理简介 近年来全球性的神经网络研究热潮的再度兴起,不仅仅是因为神经科学本身取得了巨大的进展.更主要的原因在于发展新型计算机和人工智能新途径的迫切需要.迄今为止在需要人工智能解决的许多问题中,人脑远比计算机聪明的多,要开创具有智能的新一代计算机,就必须了解人脑,研究人脑神经网络系统信息处理的机制.另一方面,基于神经科学研究成果基础上发展出来的人工神经网络模型,反映了人脑功能的若干基本特性,开拓了神经网络用于计算机的新途径.它对传统的计算机结构和人工智能是一个有力的挑战,引起了各方面专家的极大关注. 目前,已发展了几十种神经网络,例如Hopficld模型,Feldmann等的连接型网络模型,Hinton等的玻尔茨曼机模型,以及Rumelhart等的多层感知机模型和Kohonen的自组织网络模型等等。在这众多神经网络模型中,应用最广泛的是多层感知机神经网络。多层感知机神经网络的研究始于50年代,但一直进展不大。直到1985年,Rumelhart等人提出了误差反向传递学习算法(即BP算),实现了Minsky的多层网络

设想,如图34-1所示。 BP 算法不仅有输入层节点、输出层节点,还可有1个或多个隐含层节点。对于输入信号,要先向前传播到隐含层节点,经作用函数后,再把隐节点的输出信号传播到输出节点,最后给出输出结果。节点的作用的激励函数通常选取S 型函数,如 Q x e x f /11)(-+= 式中Q 为调整激励函数形式的Sigmoid 参数。该算法的学习过程由正向传播和反向传播组成。在正向传播过程中,输入信息从输入层经隐含层逐层处理,并 传向输出层。每一层神经元的状态只影响下一层神经

前馈神经网络 前馈神经网络的结构一般包含输入层、输出层、及隐含层,隐含层可以是一层或多层。各神经元只接收前一层的输出作为自己的输入,并且将其输出给下一层,整个网络中没有反馈。每一个神经元都可以有任意多个输入,但只允许有一个输出。图1选择只含一个隐含层的前馈神经网络。其原理框图如图1所示。 图中,只有前向输出,各层神经元之间的连接用权值表示。设输入层有M 个输入信号,其中任一输入信号用i ()M i ,2,1 =表示;隐含层有N 个神经元,任一隐含层神经元用j ()N j ,2,1 =表示;输入层与隐含层间的连接权值为()n w ij , ()N j M i ,2,1;,2,1 ==;隐含层与输出层的连接权值为()n w j 。假定隐含层神 经元的输入为()n u j ,输出为()n v j ;输出层神经元的输入为()n o ,网络总输出为 ()n x ~。则此神经网络的状态方程可表示为: ()()()∑+-==M i ij j i n y n w n u 11 ()()[] ()()?? ? ???∑+-===M i ij j j i n y n w f n u f n v 11 ()()()∑==N j j j n v n w n o 1 ()()[]()()?? ????==∑=N j j j n v n w f n o f n x 1~ 图1 三层前馈神经网络结构图 输入层 隐含层 输出层 (y n (1y n -(1y n M -+

式中,()?f 表示隐含层、输出层的输入和输出之间的传递函数,也称为激励函数。 定义代价函数为瞬时均方误差: ()()()()[] ()()()2 12 2~?? ? ????? ????????-=-==∑=N j j j n v n w f n d n x n d n e n J 式中,()n d 为训练信号。 递归神经网络 对角递归神经网络 图2为典型的对角递归神经网络,它具有三层结构,分别为输入层,隐层和输出层,在隐层的权值叠加中,引入了输入的前一时刻的输出作为反馈控制信号。选用这种网络的优点是结构简单,易于实现,可以直观的体现反馈神经网络的结构模式和工作方式。 设输入层与隐层间的连接权值为()n w h ij ()k j m i ,2,1;,,1,0==,隐层与输 出层之间的权值为()n w o j ,递归层的权值为()n w d j 。设输入层的输入为()i n y -, 隐层的输入为()n u j ,输出为()n I j ,输出层的输入为()n v ,输出层的输出为()n x ~,则对角递归神经网络的状态方程为 ()()()()()10-+-=∑=n I n w i n y n w n u j d j m i h ij j 输入层 输出层 隐层 图2 对角递归神经网络的结构 ()y n ()1y n - ()1y n m -+ ()y n m - mj d

几种神经网络模型及其应用 摘要:本文介绍了径向基网络,支撑矢量机,小波神经网络,反馈神经网络这几种神经网络结构的基本概念与特点,并对它们在科研方面的具体应用做了一些介绍。 关键词:神经网络径向基网络支撑矢量机小波神经网络反馈神经网络Several neural network models and their application Abstract: This paper introduced the RBF networks, support vector machines, wavelet neural networks, feedback neural networks with their concepts and features, as well as their applications in scientific research field. Key words: neural networks RBF networks support vector machines wavelet neural networks feedback neural networks 2 引言 随着对神经网络理论的不断深入研究,其应用目前已经渗透到各个领域。并在智能控制,模式识别,计算机视觉,自适应滤波和信号处理,非线性优化,语音识别,传感技术与机器人,生物医学工程等方面取得了令人吃惊的成绩。本文介绍几种典型的神经网络,径向基神经网络,支撑矢量机,小波神经网络和反馈神经网络的概念及它们在科研中的一些具体应用。 1. 径向基网络 1.1 径向基网络的概念 径向基的理论最早由Hardy,Harder和Desmarais 等人提出。径向基函数(Radial Basis Function,RBF)神经网络,它的输出与连接权之间呈线性关系,因此可采用保证全局收敛的线性优化算法。径向基神经网络(RBFNN)是 3 层单元的神经网络,它是一种静态的神经网络,与函数逼近理论相吻合并且具有唯一的最佳逼近点。由于其结构简单且神经元的敏感区较小,因此可以广泛地应用于非线性函数的局部逼近中。主要影响其网络性能的参数有3 个:输出层权值向量,隐层神经元的中心以及隐层神经元的宽度(方差)。一般径向基网络的学习总是从网络的权值入手,然后逐步调整网络的其它参数,由于权值与神经元中心及宽度有着直接关系,一旦权值确定,其它两个参数的调整就相对困难。 其一般结构如下: 如图 1 所示,该网络由三层构成,各层含义如下: 第一层:输入层:输入层神经元只起连接作用。 第二层:隐含层:隐含层神经元的变换函数为高斯核. 第三层:输出层:它对输入模式的作用做出响应. 图 1. 径向基神经网络拓扑结构 其数学模型通常如下: 设网络的输入为x = ( x1 , x2 , ?, xH ) T,输入层神经元至隐含层第j 个神经元的中心矢 为vj = ( v1 j , v2 j , ?, vIj ) T (1 ≤j ≤H),隐含层第j 个神经元对应输入x的状态为:zj = φ= ‖x - vj ‖= exp Σx1 - vij ) 2 / (2σ2j ) ,其中σ(1≤j ≤H)为隐含层第j个神

基于神经网络的股票预测 【摘要】: 股票分析和预测是一个复杂的研究领域,本论文将股票技术分析理论与人工神经网络相结合,针对股票市场这一非线性系统,运用BP神经网络,研究基于历史数据分析的股票预测模型,同时,对单只股票短期收盘价格的预测进行深入的理论分析和实证研究。本文探讨了BP神经网络的模型与结构、BP算法的学习规则、权值和阈值等,构建了基于BP神经网络的股票短期预测模型,研究了神经网络的模式、泛化能力等问题。并且,利用搭建起的BP神经网络预测模型,采用多输入单输出、单隐含层的系统,用前五天的价格来预测第六天的价格。对于网络的训练,选用学习率可变的动量BP算法,同时,对网络结构进行了隐含层节点的优化,多次尝试,确定最为合理、可行的隐含层节点数,从而有效地解决了神经网络隐含层节点的选取问题。 【abstract] Stock analysis and forecasting is a complex field of study. The paper will make research on stock prediction model based on the analysis of historical data, using BP neural network and technical analysis theory. At the same time, making in-depth theoretical analysis and empirical studies on the short-term closing price forecasts of single stock. Secondly, making research on the model and structure of BP neural network, learning rules, weights of BP algorithm and so on, building a stock short-term forecasting model based on the BP neural network, related with the model of neural network and the ability of generalization. Moreover, using system of multiple-input single-output and single hidden layer, to forecast the sixth day price by BP neural network forecasting model structured. The network of training is chosen BP algorithm of traingdx, while making optimization on the node numbers of the hidden layer by several attempts. Thereby resolve effectively the problem of it. 【关键词】BP神经网络股票预测分析 1.引言 股票市场是一个不稳定的非线性动态变化的复杂系统,股价的变动受众多因素的影响。影响股价的因素可简单地分为两类,一类是公司基本面的因素,另一类是股票技术面的因素,虽然股票的价值是公司未来现金流的折现,由公司的基本面所决定,但是由于公司基本面的数据更新时间慢,且很多时候并不能客观反映公司的实际状况,采用适当数学模型就能在一定

神经网络 在石灰窑炉的建模与控制中的应用神经网络应用广泛,尤其在系统建模与控制方面,都有很好应用。下面简要介绍神经网络在石灰窑炉的建模与控制中的应用,以便更具体地了解神经网络在实际应用中的具体问题和应用效果。 1 石灰窑炉的生产过程和数学模型 石灰窑炉是造纸厂中一个回收设备,它可以使生产过程中所用的化工原料循环使用,从而降低生产成本并减少环境污染。其工作原理和过程如图1所示,它是一个长长的金属圆柱体,其轴线和水平面稍稍倾斜,并能绕轴线旋转,所以又 CaCO(碳酸钙)泥桨由左端输入迴转窑,称为迴转窑。含有大约30%水分的 3 由于窑的坡度和旋转作用,泥桨在炉内从左向右慢慢下滑。而燃料油和空气由右端喷入燃烧,形成气流由右向左流动,以使泥桨干燥、加热并发生分解反应。迴转窑从左到右可分为干燥段、加热段、煅烧段和泠却段。最终生成的石灰由右端输出,而废气由左端排出。 图1石灰窑炉示意图 这是一个连续的生产过程,原料和燃料不断输入,而产品和废气不断输出。在生产过程中首先要保证产品质量,包括CaO的含量、粒度和多孔性等指标,因此必须使炉内有合适的温度分布,温度太低碳酸钙不能完全分解,会残留在产品中,温度过高又会造成生灰的多孔性能不好,费燃料又易损坏窑壁。但是在生产过程中原料成分、含水量、进料速度、燃油成分和炉窑转速等生产条件经常会发生变化,而且有些量和变化是无法实时量测的。在这种条件下,要做到稳定生产、高质量、低消耗和低污染,对自动控制提出了很高的要求。 以前曾有人分析窑炉内发生的物理-化学变化,并根据传热和传质过程来建立窑炉的数学模型,认为窑炉是一个分布参数的非线性动态系统,可以用二组偏

多层前馈神经网络 5 多层前馈网络及BP算法 多层前馈网络的反向传播 (BP)学习算法,简称BP算法,是有导师的学习,它是梯度下降法在多层前馈网中的应用。 (a) 网络结构 yu 见下图,、是网络的输入、输出向量,神经元用节点表示,网络由输入层、隐层和输出层节点组成,隐层可一层,也可多层(图中是单隐层),前层至后层节点通过权联接。由于用BP学习算法,所以常称BP神经网络。 I:y:x:每个神经元(节点)的输入;每个神经元(节点)的输出;神经元j w:jji的第个输入。神经元到神经元的连接权 ij ,,y,f(x,,)节点的作用函数:, 为阈值(可设置一个偏置节点代替) 1,f可为线性函数,一般取为Sigmoid函数 , 为很小的数,如0.1 ,x/,1,e (b) BP学习算法 ? 已知网络的输入/输出样本,即导师信号。 ? BP学习算法由正向传播和反向传播组成: ? 正向传播是输入信号从输入层经隐层,传向输出层,若输出层得到了期望

的输出,则学习算法结束;否则,转至反向传播。 ? 反向传播是将误差(样本输出与网络输出之差)按原联接通路反向计算, 由梯度下降法调整各层节点的权值和阈值,使误差减小。 BP学习算法步骤如下: W(0)(1) 设置初始权值,它是较小的随机非零值。 (2) 给定输入/输出样本对,计算网络的输出。 ,,u,u,u,...,u设第p组样本输入: p1p2pnp ,,d,d,d,...,d,p,1,2,..,L 输出: p1p2pmp ypi节点在第组样本输入时,输出为 : ip ,, ,,y(t),fx(t),fw(t)I ----(1式) ,,,ipipijjpj,, Ijpi式中,是在第组样本输入时,节点的第个输入。 jp 1f(,)f(x)s取可微的型作用函数式 = -------(2式) ,x1,e可由输入层隐层至输出层,求得网络输出层节点的输出。 J(1) 计算网络的目标函数 ELp设为在第组样本输入时,网络的目标函数,取范数,则 p2 111222E(t),||d,y(t)||,[d,y(t)],e(t)--------(3式) ,,pppkpkpkp2222kk y(t)pkt式中,是在第组样本输入时,经次权值调整后网络的输出:是p k输出层第个节点。 E(t)J(t),网络的总目标函数: = ----------(4式) p p 作为对网络学习状况的评价。 (2) 判别 J(t),若 ? -------(5式)

BP 神经网络模型 近年来全球性的神经网络研究热潮的再度兴起,不仅仅是因为神经科学本身取得了巨大的进展.更主要的原因在于发展新型计算机和人工智能新途径的迫切需要.迄今为止在需要人工智能解决的许多问题中,人脑远比计算机聪明的多,要开创具有智能的新一代计算机,就必须了解人脑,研究人脑神经网络系统信息处理的机制.另一方面,基于神经科学研究成果基础上发展出来的人工神经网络模型,反映了人脑功能的若干基本特性,开拓了神经网络用于计算机的新途径.它对传统的计算机结构和人工智能是一个有力的挑战,引起了各方面专家的极大关注. 目前,已发展了几十种神经网络,例如Hopficld 模型,Feldmann 等的连接型网络模型,Hinton 等的玻尔茨曼机模型,以及Rumelhart 等的多层感知机模型和Kohonen 的自组织网络模型等等。在这众多神经网络模型中,应用最广泛的是多层感知机神经网络。多层感知机神经网络的研究始于50年代,但一直进展不大。直到1985年,Rumelhart 等人提出了误差反向传递学习算法(即BP 算),实现了Minsky 的多层网络设想,如图34-1所示。 BP 算法不仅有输入层节点、输出层节点,还可有1个或多个隐含层节点。对于输入信号,要先向前传播到隐含层节点,经作用函数后,再把隐节点的输出信号传播到输出节点,最后给出输出结果。节点的作用的激励函数通常选取S 型函数,如 Q x e x f /11 )(-+= 式中Q 为调整激励函数形式的Sigmoid 参数。该算法的学习过程由正向传播和反向传播组成。在正向传播过程中,输入信息从输入层经隐含层逐层处理,并传向输出层。每一层神经元的状态只影响下一层神经元的状态。如果输出层得不到期望的输出,则转入反向传播,将误差信号沿原来的连接通道返回,通过修改各层神经元的权值,使得误差信号最小。 社含有n 个节点的任意网络,各节点之特性为Sigmoid 型。为简便起见,指定网络只有一个输出y ,任一节点i 的输出为O i ,并设有N 个样本(x k ,y k )(k =1,2,3,…,N ),对某一输入x k ,网络输出为y k 节点i 的输出为O ik ,节点j 的输入为net jk = ∑i ik ij O W 并将误差函数定义为∑=-=N k k k y y E 12 )(21

神经网络算法详解 第0节、引例 本文以Fisher的Iris数据集作为神经网络程序的测试数据集。Iris数据集可以在https://www.doczj.com/doc/7215901541.html,/wiki/Iris_flower_data_set 找到。这里简要介绍一下Iris数据集: 有一批Iris花,已知这批Iris花可分为3个品种,现需要对其进行分类。不同品种的Iris花的花萼长度、花萼宽度、花瓣长度、花瓣宽度会有差异。我们现有一批已知品种的Iris花的花萼长度、花萼宽度、花瓣长度、花瓣宽度的数据。 一种解决方法是用已有的数据训练一个神经网络用作分类器。 如果你只想用C#或Matlab快速实现神经网络来解决你手头上的问题,或者已经了解神经网络基本原理,请直接跳到第二节——神经网络实现。 第一节、神经网络基本原理 1. 人工神经元( Artificial Neuron )模型 人工神经元是神经网络的基本元素,其原理可以用下图表示: 图1. 人工神经元模型 图中x1~xn是从其他神经元传来的输入信号,wij表示表示从神经元j到神经元i的连接权值,θ表示一个阈值( threshold ),或称为偏置( bias )。则神经元i的输出与输入的关系表示为:

图中yi表示神经元i的输出,函数f称为激活函数 ( Activation Function )或转移函数( Transfer Function ) ,net称为净激活(net activation)。若将阈值看成是神经元i的一个输入x0的权重wi0,则上面的式子可以简化为: 若用X表示输入向量,用W表示权重向量,即: X = [ x0 , x1 , x2 , ....... , xn ] 则神经元的输出可以表示为向量相乘的形式: 若神经元的净激活net为正,称该神经元处于激活状态或兴奋状态(fire),若净激活net 为负,则称神经元处于抑制状态。 图1中的这种“阈值加权和”的神经元模型称为M-P模型 ( McCulloch-Pitts Model ),也称为神经网络的一个处理单元( PE, Processing Element )。 2. 常用激活函数 激活函数的选择是构建神经网络过程中的重要环节,下面简要介绍常用的激活函数。 (1) 线性函数 ( Liner Function ) (2) 斜面函数 ( Ramp Function ) (3) 阈值函数 ( Threshold Function )

人工神经网络在蕨类植物生长中的应用 摘要:人工神经网络(ARTIFICIAL NEURAL NETWORK,简称ANN)是目前国际上一门发展迅速的前沿交叉学科。为了模拟大脑的基本特性,在现代神经科学研究的基础上,人们提出来人工神经网络的模型。根据此特点结合蕨类植物的生长过程进行了蕨类植物生长的模拟。结果表明,人工神经网络的模拟结果是完全符合蕨类植物的生长的,可有效的应用于蕨类植物的生长预测。 关键词:人工神经网络;蕨类植物;MATLAB应用 一人工神经网络的基本特征 1、并行分布处理:人工神经网络具有高度的并行结构和并行处理能力。这特别适于实时控制和动态控制。各组成部分同时参与运算,单个神经元的运算速度不高,但总体的处理速度极快。 2、非线性映射:人工神经网络具有固有的非线性特性,这源于其近似任意非线性映射(变换)能力。只有当神经元对所有输入信号的综合处理结果超过某一门限值后才输出一个信号。因此人工神经网络是一种具有高度非线性的超大规模连续时间动力学系统。 3、信息处理和信息存储合的集成:在神经网络中,知识与信息都等势分布贮存于网络内的各神经元,他分散地表示和存储于整个网络内的各神经元及其连线上,表现为神经元之间分布式的物理联系。作为神经元间连接键的突触,既是信号转换站,又是信息存储器。每个神经元及其连线只表示一部分信息,而不是一个完整具体概念。信息处理的结果反映在突触连接强度的变化上,神经网络只要求部分条件,甚至有节点断裂也不影响信息的完整性,具有鲁棒性和容错性。 4、具有联想存储功能:人的大脑是具有联想功能的。比如有人和你提起内蒙古,你就会联想起蓝天、白云和大草原。用人工神经网络的反馈网络就可以实现这种联想。神经网络能接受和处理模拟的、混沌的、模糊的和随机的信息。在处理自然语言理解、图像模式识别、景物理解、不完整信息的处理、智能机器人控制等方面具有优势。 5、具有自组织自学习能力:人工神经网络可以根据外界环境输入信息,改变突触连接强度,重新安排神经元的相互关系,从而达到自适应于环境变化的目的。 二人工神经网络的基本数学模型 神经元是神经网络操作的基本信息处理单位(图1)。神经元模型的三要素为: (1) 突触或联接,一般用,表尔神经元和神经元之间的联接强度,常称之为权值。 (2) 反映生物神经元时空整合功能的输入信号累加器。 图1 一个人工神经元(感知器)和一个生物神经元示意图 (3) 一个激活函数用于限制神经元输出(图2),可以是阶梯函数、线性或者是指数形式的

基于神经网络的预测控制模型仿真 摘要:本文利用一种权值可以在线调整的动态BP神经网络对模型预测误差进行拟合并与预测模型一起构成动态组合预测器,在此基础上形成对模型误差具有动态补偿能力的预测控制算法。该算法显著提高了预测精度,增强了预测控制算法的鲁棒性。 关键词:预测控制神经网络动态矩阵误差补偿 1.引言 动态矩阵控制(DMC)是一种适用于渐近稳定的线性或弱非线性对象的预测控制算法,目前已广泛应用于工业过程控制。它基于对象阶跃响应系数建立预测模型,因此建模简单,同时采用多步滚动优化与反馈校正相结合,能直接处理大时滞对象,并具有良好的跟踪性能和较强的鲁棒性。 但是,DMC算法在实际控制中存在一系列问题,模型失配是其中普遍存在的一个问题,并会不同程度地影响系统性能。DMC在实际控制中产生模型失配的原因主要有2个,一是诸如建模误差、环境干扰等因素,它会在实际控制的全程范围内引起DMC的模型失配;二是实际系统的非线性特性,这一特性使得被控对象的模型发生变化,此时若用一组固定的阶跃响应数据设计控制器进行全程范围的控制,必然会使实际控制在对象的非建模区段内出现模型失配。针对DMC模型失配问题,已有学者进行了大量的研究,并取得了丰富的研究成果,其中有基于DMC控制参数在线辨识的智能控制算法,基于模型在线辨识的自校正控制算法以及用神经元网络进行模型辨识、在辨识的基础上再进行动态矩阵控制等。这些算法尽管进行在线辨识修正对象模型参数,仍对对象降阶建模误差(结构性建模误差)的鲁棒性不好,并对随机噪声干扰较敏感。针对以上问题,出现了基于误差校正的动态矩阵控制算法。这些文献用基于时间序列预测的数学模型误差代替原模型误差,得到对未来误差的预测。有人还将这种误差预测方法引入动态矩阵控制,并应用于实际。这种方法虽然使系统表现出良好的稳定性,但建立精确的误差数学模型还存在一定的困难。 本文利用神经网络通过训练学习能逼近任意连续有界函数的特点,建立了一种采用BP 神经网络进行预测误差补偿的DMC预测控制模型。其中神经网络预测误差描述了在预测模型中未能包含的一切不确定性信息,可以归结为用BP神经网络基于一系列过去的误差信息预测未来的误差,它作为模型预测的重要补充,不仅降低建立数学模型的负担,而且还可以弥补在对象模型中已简化或无法加以考虑的一切其他因素。 本文通过进行仿真,验证了基于神经网络误差补偿的预测控制算法的有效性及优越性,

人工神经网络及其应用实例人工神经网络是在现代神经科学研究成果基础上提出的一种抽 象数学模型,它以某种简化、抽象和模拟的方式,反映了大脑功能的 若干基本特征,但并非其逼真的描写。 人工神经网络可概括定义为:由大量简单元件广泛互连而成的复 杂网络系统。所谓简单元件,即人工神经元,是指它可用电子元件、 光学元件等模拟,仅起简单的输入输出变换y = σ (x)的作用。下图是 3 中常用的元件类型: 线性元件:y = 0.3x,可用线性代数法分析,但是功能有限,现在已不太常用。 2 1.5 1 0.5 -0.5 -1 -1.5 -2 -6 -4 -2 0 2 4 6 连续型非线性元件:y = tanh(x),便于解析性计算及器件模拟,是当前研究的主要元件之一。

离散型非线性元件: y = ? 2 1.5 1 0.5 0 -0.5 -1 -1.5 -2 -6 -4 -2 2 4 6 ?1, x ≥ 0 ?-1, x < 0 ,便于理论分析及阈值逻辑器件 实现,也是当前研究的主要元件之一。 2 1.5 1 0.5 0 -0.5 -1 -1.5 -2 -6 -4 -2 2 4 6

每一神经元有许多输入、输出键,各神经元之间以连接键(又称 突触)相连,它决定神经元之间的连接强度(突触强度)和性质(兴 奋或抑制),即决定神经元间相互作用的强弱和正负,共有三种类型: 兴奋型连接、抑制型连接、无连接。这样,N个神经元(一般N很大)构成一个相互影响的复杂网络系统,通过调整网络参数,可使人工神 经网络具有所需要的特定功能,即学习、训练或自组织过程。一个简 单的人工神经网络结构图如下所示: 上图中,左侧为输入层(输入层的神经元个数由输入的维度决定),右侧为输出层(输出层的神经元个数由输出的维度决定),输入层与 输出层之间即为隐层。 输入层节点上的神经元接收外部环境的输入模式,并由它传递给 相连隐层上的各个神经元。隐层是神经元网络的内部处理层,这些神 经元在网络内部构成中间层,不直接与外部输入、输出打交道。人工 神经网络所具有的模式变换能力主要体现在隐层的神经元上。输出层 用于产生神经网络的输出模式。 多层神经网络结构中有代表性的有前向网络(BP网络)模型、

前饋式類神經網路 1前言 前饋式類神經網路是第一個也是最簡單的類神經網路,它是由多層的神經元所組成,其訊息傳遞的方式是從輸入層經由隱藏層往輸出層的方向傳送,每一層神經元只會接受上層神經元所傳送過來的輸出值,不同於循環式網路(Recurrent network)。 2神經元 類神經網路最基本單位的是神經元(如圖1),神經元主要負責對資料的處理行為。在類神經網路中的某個神經元,可能接收一個到數個不等的輸入變數,變數的多寡取決於傳送到該神經元的輸入值個數。神經元接收輸入變數(I)後,視輸入變數的重要性,給予一個改變比重的參數,這些參數稱為配重值(Weight, ω),神經元會將所有輸入變數經由配重值的加權後累加,然後再與神經元中的偏移量(Bias, B)相加,會產生一個淨值(n),這個淨值將經由轉換函數的轉換,轉換出來的數值當成該神經元的輸出值。神經元的輸出值可以傳送到一個以上的神經元當作該神經元的輸入變數,或是當成網路的輸出值,一切依網路結構的情況而定。雖然,每個神經元可以同時接收一至多個不等的輸入變數,卻只有一個輸出值。神經元的計算公式如式(1)、(2)所示, ∑= +? = R j j j B I n 1 ω(1) ) (n f Y=(2)式中R為神經元輸入變數的個數,I1,I2,?,I R為神經元的輸入變數,ω1,ω2,?,ωR為神經元各個輸入變數的配重值,B為該神經元的偏移量,) (? f為神經元的轉換函數。

1 Y 輸入值單位神經元 Y=f(Wp+b) 圖.1神經元 神經元的轉換函數可能是線性函數或是非線性函數,依問題的需求不同所選擇的轉換函數也會不同,選擇一個適合特定問題的轉換函數,對描述輸入變數與輸出值之關係,是非常重要的。可是,轉換函數的種類有很多,要選擇一個最適合特定問題的轉換函數,需要藉由不斷的嘗試才能獲得。以下列出本研究所使用的十種轉換函數: 1. 硬限制函數(Hard Limit transfer function) ? ? ? ≥ < = 1 ) ( n if n if n f 2. 對稱硬限制函數(Symmetrical Hard Limit transfer function) ? ? ? ≥ < - = 1 1 ) ( n if n if n f 3. 飽和線性函數(Saturating Linear transfer function) ? ? ? ? ? > ≤ ≤ < = 1 1 1 ) ( n if n if n n if n f 4. 對稱飽和線性函數(Symmetrical Saturating Linear transfer function) ? ? ? ? ? > ≤ ≤ - - < - = 1 1 1 1 1 1 ) ( n if n if n n if n f 5. 正線性函數(Positive Linear transfer function) ? ? ? ≥ < = ) ( n if n n if n f 6. 線性函數(Linear transfer function) n n f= ) ( 7. S形函數(Sigmoid transfer function)

第三章常用神经网络 3.1前馈型人工神经网络 前馈神经网络是神经网络中的一种典型分层结构,信息从输入层进入网络后逐层向前传递至 输出层。根据前馈网络中神经元转移函数、隐层数以及权值调整规则的不同,可以形成具有各种功 能特点的神经网络。 例如,如果转移函数采用线性阈值函数或符号函数且只有一个输出层(无隐层),或有一个以上的隐层,则分别称为单层感知器和多层感知器;如果转移函数采用非线性连续有界函数且只有一个输出层(无隐层),或有一个以上的隐层,则分别称为单层BP网络和多层BP网络。 3.1.1 线性阈值单元组成的前馈网络 这类前馈网络的转移函数采用线性阈值函数或符号函数。 1.单层感知器 1958年,美国心理学家Frank Rosenblat提出一种具有单层计算单元的神经网络,称为Perception,即感知器。感知器是模拟人的视觉接受环境信息,并由神经冲动进行信息传递。感知器研究中首次提出了自组织、自学习的思想,而且对所能解决的问题存在着收敛算法,并能从数学上严格证明,因而对神经网络的研究起了重要推动作用。单层感知器的结构与功能都非常简单,以 单层感知器(图3-1 神经元基本模型(即MP 基本模型。 1) 图3-1 为第j(j=1,2,…m x n)T,通过一个阈值函数f( 从数学观点来说, 等于0时,输出为1 神经元的连接权值w ji 当输入为X,对于j n i i ji j x w s=∑ =1其输出为:

2 )(1 j n i i ji j x w f y θ+=∑= (3-1) 转移函数f (?)是阈值函数(即单位阶跃函数),故: ??? ??? ? <+≥+=∑∑==0 ,00,11 1j n i i ji j n i i ji j x w x w y θθ (3-2) 通过转移函数,其输出只有两个状态,“1”或“0”,所以,它实际上是输入模式的分类器,即可以辨识输入模式属两类中的那一类。 当单层感知器模型只有1个输出结点时,称为简单感知器,其实就是MP 模型。 对于输出结点为的简单感知器,若输入向量的维数n=2,则向量X 用两维平面上的一个点来表示。设被观察的模式只有A 、B 两类,则: (3-3) A 、 B 两类分别属于集合R 1 (A ∈R 1)、R 2(B ∈R 2),且R 1与R 2是 线性可分的,如图3-2所示。 利用简单感知器的计算式(3-3)可以实现逻辑代数中的一些运算: (1)当取w 1=w 2=1, θ=-1.5时, 完成逻辑“与”的运算功 能,即 x 1∧x 2; (2)当取w 1=w 2=1, θ=-0.5时,完成逻辑“或”的运算功能, 即x 1∨x 2; (3)当取w 1= -1,w 2=0, θ= 1时,完成逻辑“非”的运算功能, 即x 。 若x 1与x 2分别取布尔值,逻辑运算列入表3-1中。 表3-1 逻辑运算表 若净输入为零,便得到一条线性的模式判别函数: ?? ?→→=++=+=∑ =类类 B A x w x w f x w f y i i i 01)()(2 12211θθ图3-2 线性可分两维模式